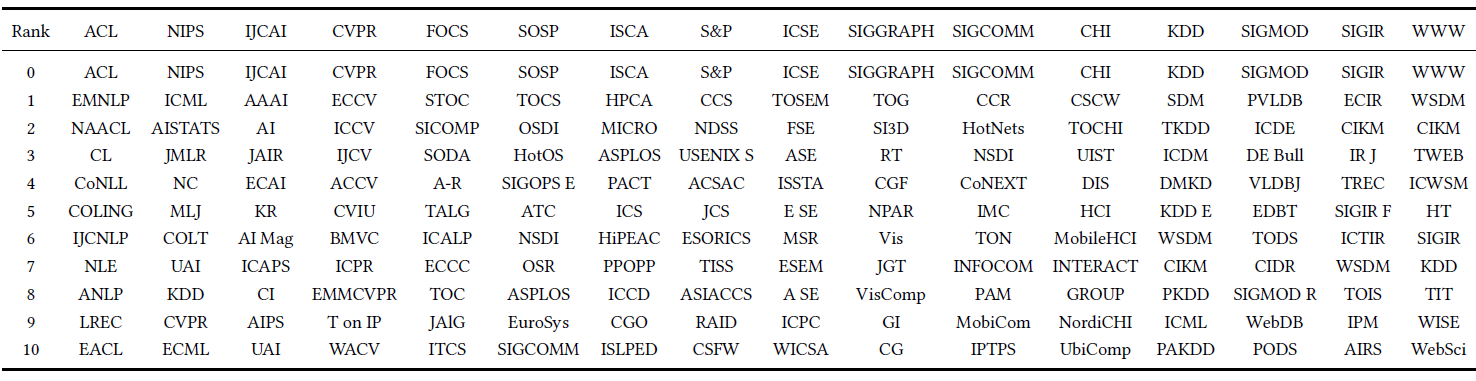

图的表达

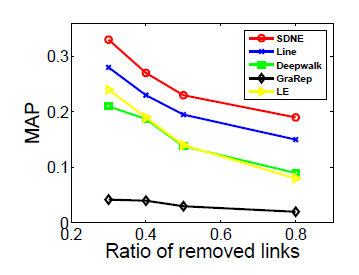

Graph Embedding可用于可视化、结点分类、链接预测link prediction、推荐等任务中。- 网络表示学习

network representation learning :NRL:将网络的每个顶点编码到一个统一的低维空间中。

一、DeepWalk[2014]

network representation的稀疏性既是优点、也是缺点。稀疏性有助于设计高效的离散算法,但是会使统计学习中的泛化变得更加困难。network中的机器学习应用(例如network classification、内容推荐、异常检测、缺失链接预测)必须能够处理这种稀疏性才能生存。在论文

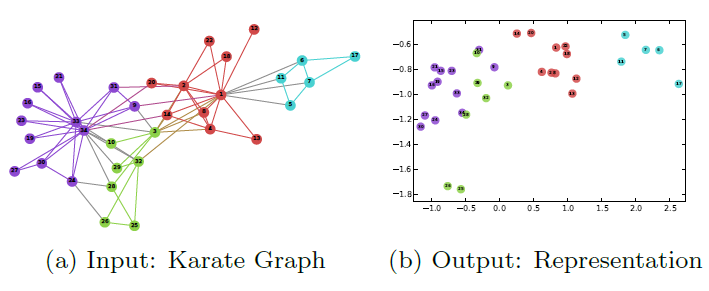

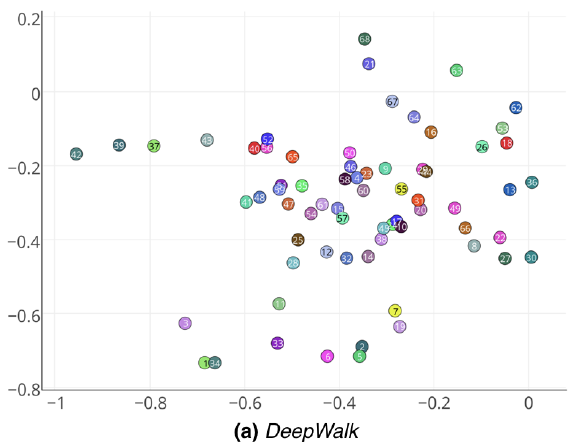

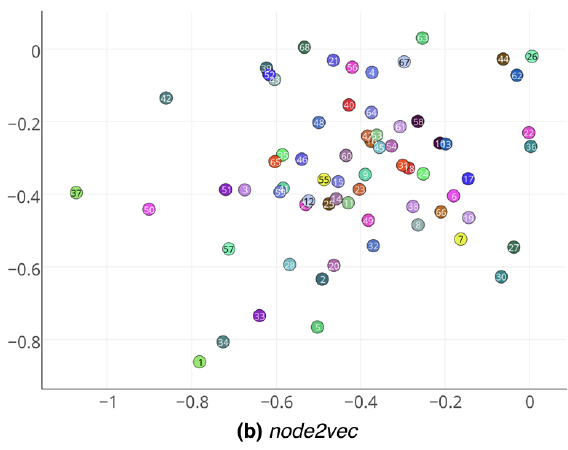

《DeepWalk: Online Learning of Social Representations》中,作者首次将深度学习(无监督特征学习)技术引入到网络分析network analysis中,而深度学习技术已经在自然语言处理中取得了成功。论文开发了一种算法(DeepWalk),它通过对短short的随机游走流a stream of short random walks进行建模,从而学习图顶点的社交表示social representation。social representation是捕获邻域相似性neighborhood similarity和社区成员关系community membership的顶点的潜在特征。这些潜在representation在低维的、连续的向量空间中对社交关系social relation进行编码。DeepWalk将神经语言模型推广为处理由一组随机生成的游走walks组成的特殊语言。这些神经语言模型已被用于捕获人类语言的语义结构semantic structure和句法结构syntactic structure,甚至是逻辑类比logical analogies。DeepWalk将图作为输入,并生成潜在representation作为输出。论文的方法应用于经过充分研究的空手道网络

Karate network,其结果如下图所示。Karate network通常以force-directed布局呈现,如图a所示。图b展示了论文方法的输出,其中具有两个潜在维度。除了惊人的相似性之外,我们注意到(图b)的线性可分部分对应于通过输入图(图a)中的modularity maximization发现的clusters(以不同顶点颜色表示)。下图中,注意输入图中的社区结构和embedding之间的对应关系。顶点颜色表示输入图的modularity-based clustering。

为了展示

DeepWalk在现实世界场景中的潜力,论文评估了它在大型异质图large heterogeneous graph中具有挑战性的multi-label network classification问题的性能。在关系分类relational classification问题中,特征向量之间的链接links违反了传统的独立同分布的假设。解决这个问题的技术通常使用近似推断技术approximate inference technique来利用依赖信息dependency information从而改善分类结果。论文通过学习图的label-independent representation来远离这些方法。论文的representation质量不受标记顶点选择的影响,因此它们可以在任务之间共享。DepWalk在创建社交维度social dimensions方面优于其它潜在representation方法,尤其是在标记顶点稀疏的情况下。论文的representation可以通过非常简单的线性分类器(例如逻辑回归)获得强大的性能。论文的representation是通用的,可以与任何分类方法(包括迭代式推断方法iterative inference method)结合使用。DeepWalk实现了所有的这些,同时是一种可简单并行的在线算法。论文的贡献如下:

- 我们引入深度学习作为分析图的工具,从而构建适用于统计建模的鲁棒的

representation。DeepWalk学习短的随机游走中存在的结构规律structural regularity。 - 我们在多个社交网络上广泛评估了我们在多标签分类任务上的表现。在标签稀疏的情况下,我们展示了显著提高的分类性能。在最稀疏的问题上,我们获得了

Micro F1的5% - 10%的提升。在某些情况下,即使训练数据减少60%,DeepWalk的representation也可以胜过其它竞争对手。 - 我们通过使用并行实现

parallel implementation来构建web-scale图(例如YouTube) 的representation,从而证明了我们算法的可扩展性。此外,我们描述了所需的最小修改从而构建我们方法的streaming版本。

- 我们引入深度学习作为分析图的工具,从而构建适用于统计建模的鲁棒的

DeepWalk是一种学习网络中顶点潜在representation的新方法。这些潜在representation在连续向量空间中编码社交关系social relation,从而很容易被统计模型所利用。DeepWalk推广了语言模型和无监督特征学习(或深度学习)从单词序列到graph的最新进展。DeepWalk使用从截断的随机游走中获得的局部信息,通过将随机游走视为等价的sentence来学习潜在representation。DeepWalk也是可扩展scalable的。它是一种在线学习算法online learning algorithm,可以构建有用的增量结果,并且可以简单地并行化。这些品质使其适用于广泛的现实世界application,例如network classification和异常检测。DeepWalk与以前的工作之间的主要区别可以总结如下:DeepWalk学习潜在的social representation,而不是计算中心统计量centrality statistics(如《Leveraging label-independent features for classification in sparsely labeled networks: An empirical study》)、或者分区统计量partitioning statistics(如《Leveraging social media networks for classification》)。DeepWalk不尝试扩展分类程序本身(通过集体推断collective inference如《Collective classification in network data》,或者graph kernel如《Diffuusion kernels on graphs and other discrete input spaces》)。DeepWalk提出了一种仅使用局部信息的、可扩展的、在线方法。大多数方法需要全局信息、并且是离线的。DeepWalk将无监督representation learning应用于图。

接下来,我们讨论

network classification和无监督feature learning方面的相关工作。相关工作:

关系学习

Relational Learning:关系分类relational classification(或者集体分类collective classification)方法使用数据item之间的链接links作为分类过程的一部分。集体分类问题中的精确推断exact inference是NP-hard问题,其解决方案主要集中在近似推断算法。这些近似推断算法可能无法保证收敛。与我们的工作最相关的关系分类算法包括:学习

clusters(《Leveraging relational autocorrelation with latent group models》)、在附近节点之间添加边(《Using ghost edges for classification in sparsely labeled networks》)、使用PageRank(《Semi-supervised classification of network data using very few labels》)、通过扩展关系分类来考虑额外的特征(《Multi-label relational neighbor classification using social context features》),通过这些方法从而合并社区信息community information。我们的工作采取了截然不同的方法。我们提出了一种学习网络结构

representation的程序,而不是新的近似推断算法,然后可以由现有的推断程序inference procedure(包括迭代式推断程序)来使用。人们还提出了很多从图中生成特征的技术。和这些技术相比,我们将特征创建过程构建为

representation learning问题。人们也 提出了

graph kernel(《Graph kernels》) ,从而将关系数据用作分类过程的一部分。但是,除非近似(《Fast random walk graph kernel》),否则它的速度非常慢。我们的方法与graph kernel是互补的:我们没有将结构编码为核函数kernel function的一部分,而是学习一种representation,从而允许该representation直接用于任何分类方法的特征。无监督特征学习

Unsupervised Feature Learning:人们已经提出分布式representation learning来建模概念之间的结构关系structural relationship。这些representation通过反向传播和梯度下降来进行训练。由于计算成本和数值不稳定,这些技术被放弃了十几年。最近,分布式计算允许训练更大的模型,并且用于无监督学习的数据出现增长。分布式

representation通常通过神经网络进行训练,这些神经网络在计算机视觉、语音识别、自然语言处理等不同领域取得了进步。

DeepWalk可以挖掘图 的局部结构,但是无法挖掘图 的整体结构。

1.1 模型

1.1.1 问题定义

考虑社交网络成员的分类问题。正式地,令 ,其中 为图中所有的顶点(也称为网络的成员

member), 为所有的边。给定一个部分标记的social network,其中:- 特征 , 为属性空间的维度, 为顶点数量。

- , 为

label空间, 为分类类别数量。

在传统的机器学习分类

setting中,我们的目标是学习将 的元素映射到标签集合 的假设hypothesis。在我们的例子中,我们可以利用嵌入在 结构中的样本依赖性example dependence的重要信息,从而实现卓越的性能。在文献中,这被称作关系分类relational classification(或者集体分类collective classification)问题。关系分类的传统方法提出将问题作为无向马尔科夫网络

undirected Markov network中的推断inference,然后使用迭代式近似推断算法(例如迭代式分类算法《Iterative classi fication in relational data》、吉布斯采样《Stochastic relaxation, gibbs distributions, and the bayesian restoration of images》、或者标签松弛算法《On the foundations of relaxation labeling processes》)来计算给定网络结构下标签的的后验分布。我们提出了一种不同的方法来捕获网络拓扑信息

network topology information。我们没有混合label空间从而将其视为特征空间的一部分,而是提出了一种无监督方法,该方法学习了捕获独立于label分布的、图结构的特征。结构表示

structural representation和标记任务labeling task的这种分离避免了迭代式方法中可能发生的级联错误cascading error。此外,相同的representation可以用于与该网络有关的多个分类任务(这些分类任务有各自不同的label)。我们的目标是学习 ,其中 是一个较低的潜在维度。这些低维

representation是分布式的,意味着每个社交概念social concept都由维度的某个子集来表达,每个维度都有助于低维空间所表达的一组社交概念的集合。使用这些结构特征

structural feature,我们将扩充属性空间从而帮助分类决策。这些结构特征是通用的,可以与任何分类算法(包括迭代式方法)一起使用。然而,我们相信这些特征的最大效用是:它们很容易与简单的机器学习算法集成。它们在现实世界的网络中可以适当地scale,正如我们在论文中所展示的。

1.1.2 基础知识

我们寻求具有以下特性的

learning social representation:- 适应性

adaptability:真实的社交网络在不断演变,新的社交关系不应该要求一遍又一遍地重新训练整个网络。 - 社区感知

community aware:潜在维度之间的距离应该能够代表评估网络成员之间社交相似性social similarity的指标。 - 低维

low dimensional:当标记数据稀疏时,低维模型泛化效果更好,并且加快收敛和推断速度。 - 连续

continuous:除了提供社区成员community membership的精细的视图之外,continuous representation在社区之间具有平滑的决策边界,从而允许更鲁棒的分类。

我们满足这些要求的方法从短期随机游走的

stream中学习顶点的representation,这是最初为语言建模而设计的优化技术。在这里,我们首先回顾随机游走和语言建模language modeling的基础知识,并描述了它们的组合如何满足我们的要求。- 适应性

随机游走

random walk:我们将以顶点 为root的随机游走表示为 。 是一个随机游走过程,其中包含随机变量 。 是一个顶点,它是从顶点 的邻居中随机选中的。随机游走已被用作内容推荐

content recommendation和社区检测community detection中各种问题的相似性度量similarity measure。随机游走也是一类输出敏感算法output sensitive algorithm的基础,这类算法使用随机游走来计算局部社区结构信息local community structure,并且计算时间复杂度为input graph规模的亚线性sublinear。正是这种与局部结构的联系促使我们使用短的随机游走流

stream of short random walks作为从网络中提取信息的基本工具。除了捕获社区信息之外,使用随机游走作为我们算法的基础还为我们提供了另外两个理想的特性:- 首先,局部探索很容易并行化。多个随机游走器

random walkers(在不同的线程、进程、或者机器中)可以同时探索同一个图的不同部分。 - 其次,依靠从短的随机游走中获得的信息,可以在不需要全局重新计算的情况下适应图结构的微小变化。我们可以使用新的随机游走,从图变更的区域游走到整个图,从而以亚线性时间复杂度来更新已经训练好的模型。

- 首先,局部探索很容易并行化。多个随机游走器

幂律

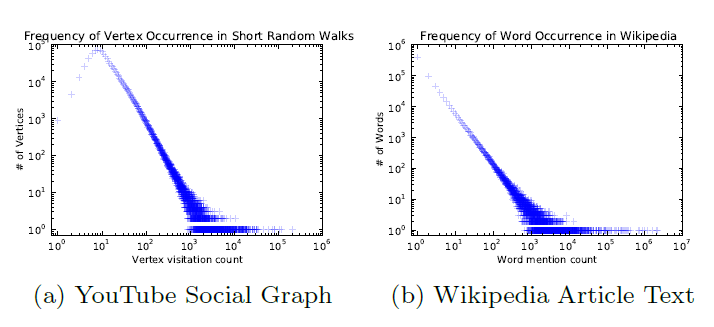

power law分布:选择在线随机游走作为捕获图结构的原语primitive之后,我们现在需要一种合适的方法来捕获这些图结构信息。如果连通图的

degree分布遵循幂律分布power law(也叫作Zipf定律),那么我们观察到顶点出现在短随机游走中的频率也遵循幂律分布。自然语言中的单词遵循类似的分布,语言模型language modeling技术解释了这种分布行为。为了强调这种相似性,我们在下图中展示了两个不同的幂律分布:第一个来自一个图上的一系列短随机游走,第二个来自于英文维基百科的100,000篇文章的文本。图a给出了short random walk中,顶点出现频次的分布。图b给出了英文维基百科的10万篇文章中,单词的频次分布。

我们工作的一个核心贡献是这样的一种思想:用于建模自然语言(其中单词频率遵循幂律分布)的技术也可以复用于建模网络中的社区结构。

接下来我们将回顾语言建模中不断发展的工作,并将其转换为学习满足我们标准的顶点

representation。

1.1.3 语言模型

语言模型的目标是估计特定单词序列在语料库

corpus中出现的可能性。正式地,给定一个单词序列 ,其中 ( 为词典vocabulary),我们希望在整个训练语料库上最大化 。最近在

representation learning方面的工作聚焦于使用概率神经网络probabilistic neural network来构建单词的general representation,从而将语言建模的范围扩展到其原始目的之外。在这项工作中,我们提出了语言建模的泛化,以通过短随机游走流

stream来探索图。这些随机游走可以被认为是一种特殊语言的短句short sentence和短语short phrase。我们进行直接的类比,从而在随机游走中,给定到目前为止访问的所有顶点序列来估计观察到顶点 的可能性,即 。我们的目标是学习潜在

representation,而不仅仅是节点共现node co-occurrence的概率分布,因此我们引入一个映射函数 。该映射函数 将图中每个顶点 映射到一个潜在的social representation。即:我们想要的是顶点

representation,而不是预估这个随机游走序列出现的概率。实际上,我们使用

free parameters的矩阵 来表达 ,这在稍后将被用作我们的 。然后,问题变成了似然估计:然而,随着游走序列长度的增加,计算这个目标函数变得不可行。

因为

sentence越长,它出现的频次越低,样本过于稀疏。最近,在语言模型中的放松条件使得这个预测问题得到了解决。

- 首先,我们不是使用上下文来预测缺失单词

missing word,而是使用一个单词来预测上下文。 - 其次,上下文由出现在给定单词左侧和右侧的单词组成。

- 最后,我们消除了对问题的顺序约束

ordering constraint。即,模型需要最大化任何单词出现在上下文中的概率,而无需知道上下文与目标单词的偏移量。

应用到顶点建模中,这得到了优化问题:

其中 为上下文窗口尺寸。

我们发现这些放松条件对于

social representation learning是特别理想的。- 首先,顺序独立性假设

order independence assumption更好地捕获了随机游走的nearness的sense。 - 其次,这种松弛条件对于通过构建一大批小模型来加速训练非常有用,因此一次给定一个顶点。

解决上式中的优化问题将得顶点

representation,这些representation捕获了顶点之间在局部图结构local graph structure中的相似性。具有相似邻域的顶点将获得相似的representation(编码了co-citation相似性),并允许对机器学习任务进行泛化。- 首先,我们不是使用上下文来预测缺失单词

通过结合截断的随机游走和神经语言模型,我们制定了一种满足我们所有期望特性的方法。

- 该方法生成低维的社交网络

representation,并存在于连续向量空间中。 - 该方法生成的

representation对社区成员的潜在形式latent form进行编码。 - 并且,由于该方法输出有用的

intermediate representation,因此它可以适应不断变化的网络拓扑结构。

- 该方法生成低维的社交网络

1.1.4 DeepWalk

与任何语言建模算法一样,

DeepWalk唯一需要的输入是语料库和词表 。DeepWalk将一组截断的短随机游走视为语料库,将图的顶点视为词表() 。虽然在训练之前知道随机游走中顶点集合 和顶点的频率分布是有益的,但是DeepWalk在不知道顶点集合的情况下也可以工作。DeepWalk算法主要由两部分组成:随机游走生产器、更新过程。随机游走生成器

random walk generator:以图 作为输入并均匀随机采样一个顶点 作为随机游走 的root。随机游走从最近访问的顶点的邻域中均匀采样,直到游走序列长度达到最大长度 。虽然在我们的实验中,随机游走序列的长度设置为固定的(固定为 ),但是理论上没有限制它们都是相同的长度。这些随机游走可能会重启(即返回

root的传送概率teleport probability),但是我们的初步结果并为表明使用重启能带来任何优势。更新过程:基于

SkipGram语言模型来更新参数 。SkipGram是一种语言模型,可最大化在一个句子中出现在窗口 内的单词之间的共现概率。在随机游走中,对于出现在窗口 中的所有上下文,我们最大化给定当前顶点 的

representation的条件下,上下文顶点 出现的概率。

DeepWalk算法:输入:

- 图

- 上下文窗口尺寸

embedding size- 每个节点开始的随机游走序列数量

- 每条随机游走序列长度

输出:顶点

representation矩阵算法步骤:

representation初始化:从均匀分布中采样,得到初始的 。从 构建一颗二叉树

binary tree建立二叉树是为了后续

SkipGram算法采用Hierarchical Softmax遍历,,遍历过程:

随机混洗顶点:

每次遍历的开始,随机混洗顶点。但是这一步并不是严格要求的,但是它可以加快随机梯度下降的收敛速度。

对每个顶点 :

- 利用随机游走生成器生成随机游走序列:

- 采用

SkipGram算法来更新顶点的representation:

SkipGram算法:输入:

- 当前的顶点

representation矩阵 - 单条随机游走序列

- 上下文窗口尺寸

- 学习率

- 当前的顶点

输出:更新后的顶点

representation矩阵算法步骤:

对每个顶点 :

对窗口内每个顶点 :

Hierarchical Softmax: 计算 是不容易的,因为这个概率的分母(归一化因子)计算代价太高(计算复杂度为 )。如果我们将顶点分配给二叉树的叶节点,那么预测问题就变为最大化树中特定路径的概率。如果到顶点 的路径由一系列树节点 ( 为root,)标识,则有:现在 可以通过分配给节点 的父节点的二分类器来建模。这降低了计算 的复杂度,计算复杂度从 降低到 。

我们可以通过为随机游走中的高频顶点分配树中更短的路径来进一步加快训练过程。霍夫曼编码用于减少树中高频元素的访问次数。

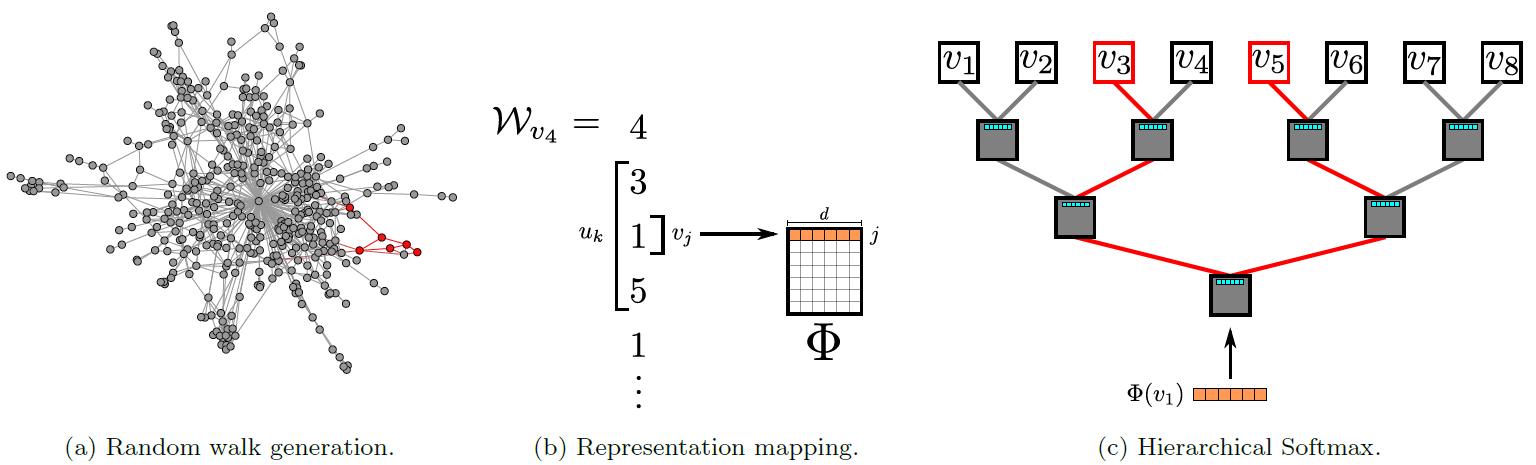

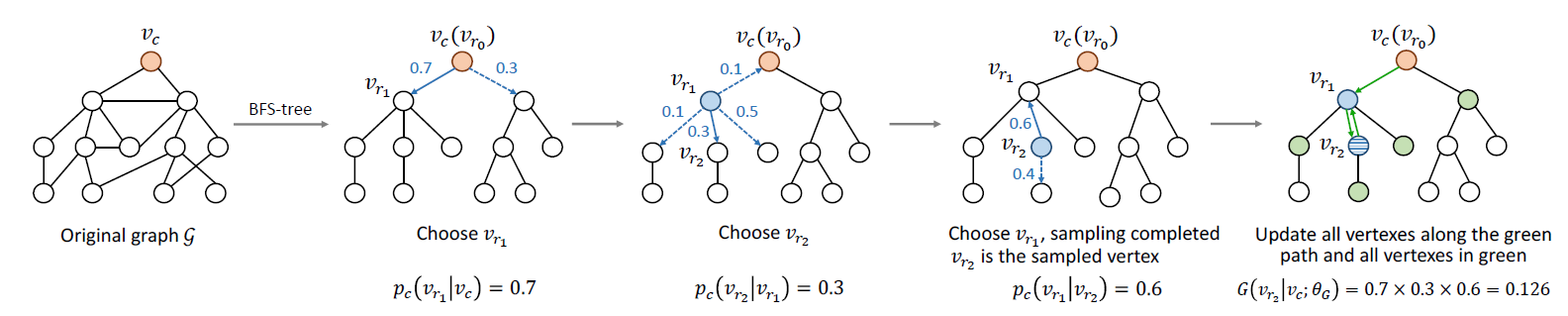

DeepWalk模型参数规模为 ,并且使用随机梯度下降来优化这些参数。导数是通过反向传播算法来估计的。SGD的学习率在最初时设置为0.025,然后随着目前为止看到的顶点数量呈线性下降。DeepWalk算法整体如下图所示。图

a:短随机游走序列的生成过程。图

b:在随机游走 上滑动一个长度为 的窗口,将中心顶点 映射到它的representation。图

c:Hierarchical Softmax在对应于从root到 的路径上的概率序列来分解 。 也是类似的。representation被更新从而最大化中心顶点 与它的上下文 共现的概率。

1.1.5 并行化

社交网络随机游走中的顶点频率分布和语言中的单词分布都遵循幂律分布。这会导致低频顶点的长尾效应,因此,对 的更新本质上将是稀疏的(即,同时对同一个顶点进行更新的概率很低)。 这将允许我们在多个

worker的情况下使用随机梯度下降的异步版本ASGD。鉴于我们的更新是稀疏的,并且我们没有利用锁来访问模型共享参数,

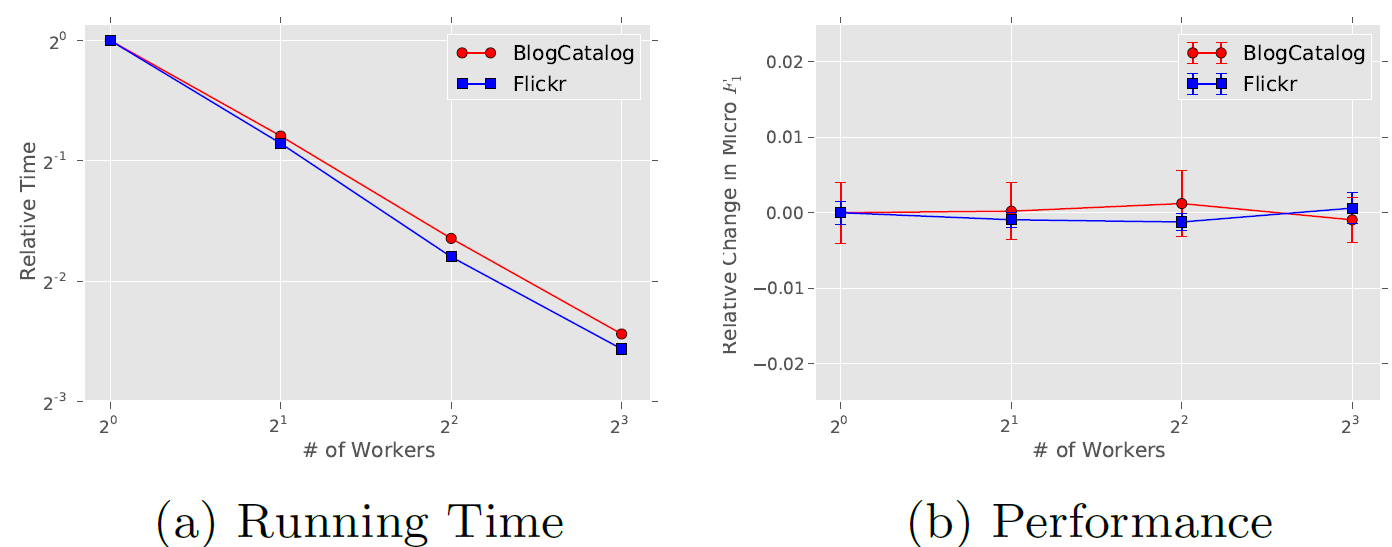

ASGD将实现最佳收敛速度。虽然我们在单台机器上使用多线程进行实验,但是已经证明了ASGD具有高度可扩展性,可用于非常大规模的机器学习。下图展示了并行化

DeepWalk的效果。结果表明:随着我们将worker数量增加到8,处理BlogCatalog和Flickr网络的加速是一致的。结果还表明,与串行执行DeepWalk相比,并行化DeepWalk的预测性能没有损失。

1.1.6 变体

这里我们讨论我们方法的一些变体,我们认为这些变体可能会引起人们的兴趣。

流式

streaming:我们方法的一个有趣变体是流式方法,它可以在不了解整个图的情况下实现。在这个变体中,来自图中的短随机游走直接传递给representation learning代码,并直接更新模型。这里需要对学习过程进行一些修改:

- 首先,不再使用衰减的学习率。相反,我们可以将学习率 初始化为一个小的常量。这需要更长的时间来学习,但是在某些

application中可能是值得的。 - 其次,我们不能再构建参数树

tree of parameters。如果 的基数cardinality是已知的(或者有界),我们可以为这个最大值构建Hierarchical Softmax tree。当首次看到顶点时,可以将它分配给剩余的叶节点之一。如果我们有能力估计顶点分布的先验,我们仍然可以使用霍夫曼编码来减少高频元素的访问次数。

- 首先,不再使用衰减的学习率。相反,我们可以将学习率 初始化为一个小的常量。这需要更长的时间来学习,但是在某些

非随机的游走:有些图是用户与一系列元素(如网站上页面的导航)交互的副产品而创建的。当通过这种非随机游走的

stream来创建图时,我们可以使用这个过程直接为建模阶段提供游走数据。以这种方式采样的图不仅会捕获与网络结构相关的信息,还会捕获与路径遍历频率相关的信息。以我们的观点来看,这个变体还包括语言建模。

sentence可以被视为经过适当设计的语言网络的、有目的的游走,而像SkipGram这样的语言模型旨在捕获这种行为。这种方法可以与流式变体结合使用,从而在不断演化的网络上训练特征,而无需显式地构建整个图。使用这种技术维护的

representation可以实现web-scale的分类,而无需处理web-scale图的麻烦。

1.2 实验

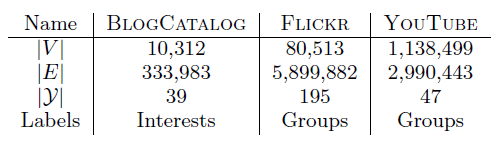

数据集:

BlogCatalog数据集:由博客作者提供的社交关系网络。标签代表作者提供的主题类别。Flickr数据集:Flickr网站用户之间的关系网络。标签代表用户的兴趣组,如“黑白照片”。YouTube数据集:YouTube网站用户之间的社交网络。标签代表用户的视频兴趣组,如“动漫、摔跤”。

baseline方法:为了验证我们方法的效果,我们和一些baseline方法进行比较。谱聚类

SpectralClustering:从图 的normalized graph Laplacian矩阵 中计算到的 个最小的特征向量,构成图的representation。使用 的特征向量隐含地建设图割graph cuts对分类有用。Modularity:从图 的Modularity计算得到top-d个特征向量,构成了图的representation。 的特征向量编码了关于 的modular graph partition信息。使用它们作为特征假设modular graph partition对于分类有用。EdgeCluster:基于k-means聚类算法对图 的邻接矩阵进行聚类。事实证明它的性能可以和Modularity相比,并且可以扩展到那些超大规模的图,这些图太大而难以执行谱分解spectral decomposition。wvRN:weighted-vote Relational Neighbor是一个关系分类器relational classi er。给定顶点 的邻居 ,wvRN通过邻居结点的加权平均来预估 :其中 为归一化系数。

该方法在实际网络中表现出惊人的良好性能,并被推荐为优秀的关系分类

relational classification的baseline。Majority:选择训练集中出现次数最多的标签作为预测结果(所有样本都预测成一个值)。

评估指标:对于多标签分类问题

multilabel classi cation,我们采用Macro-F1和Micro-F1作为评估指标。Macro-F1:根据整体的混淆矩阵计算得到的 值。micro-F1:先根据每个类别的混淆矩阵计算得到各自的 值,然后对所有 值取平均。

另外我们采用模型提取的特征训练

one-vs-rest逻辑回归分类器,根据该分类器来评估结果。我们随机采样一个比例为 的带标签顶点作为训练集,剩余标记节点作为测试集。我们重复该过程

10次,并报告Macro-F1的平均性能和Micro-F1的平均性能。注意,

DeepWalk是无监督的representation learning方法,因此训练过程是无需label数据的。这里的标记数据是在无监督学习之后,利用学到的顶点representation进行有监督分类,分类算法为逻辑回归,从而评估顶点representation的效果。实验配置:

- 对所有模型,我们使用由

LibLinear实现的one-vs-rest逻辑回归进行分类。 DeepWalk的超参数为 。- 对于

SpectralClustering, Modularity, EdgeCluster等方法,我们选择 。

- 对所有模型,我们使用由

1.2.1 实验结果

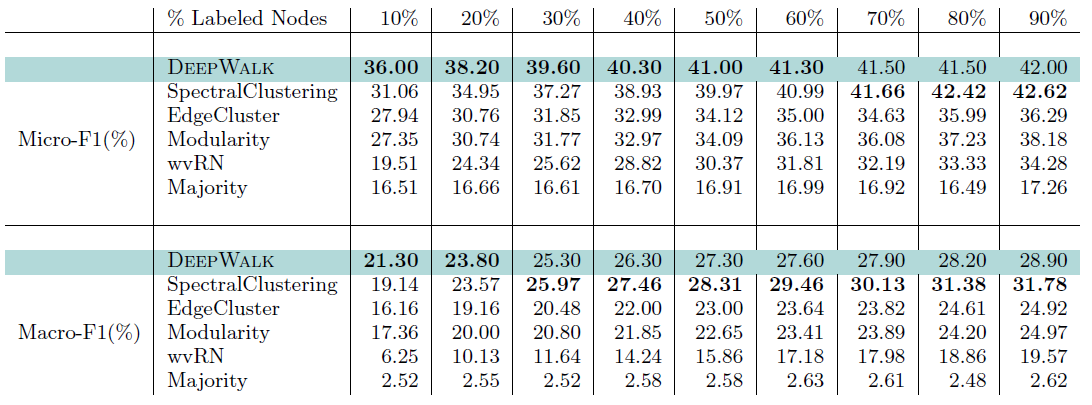

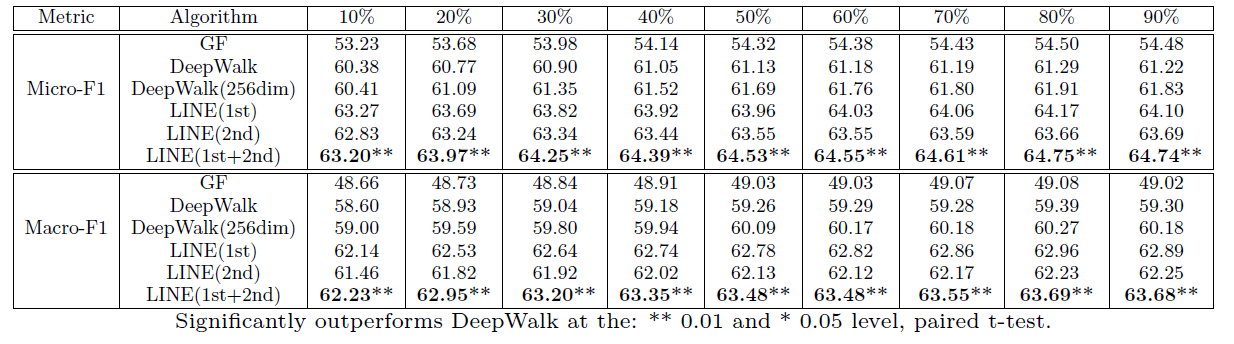

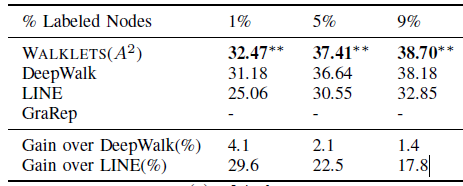

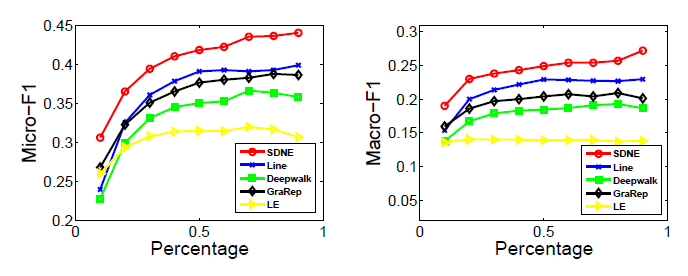

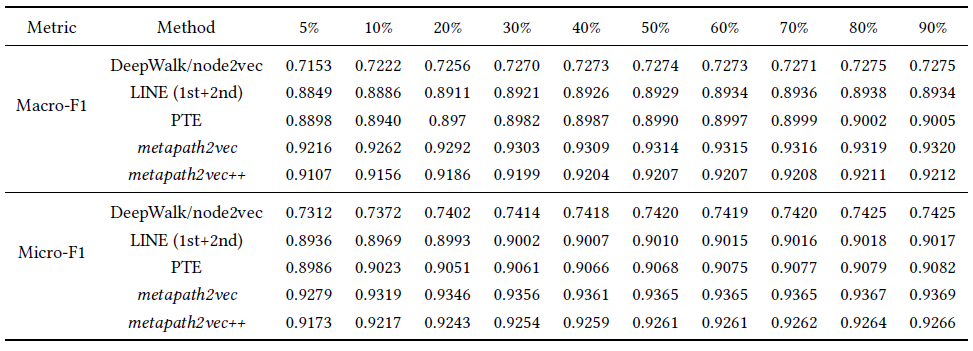

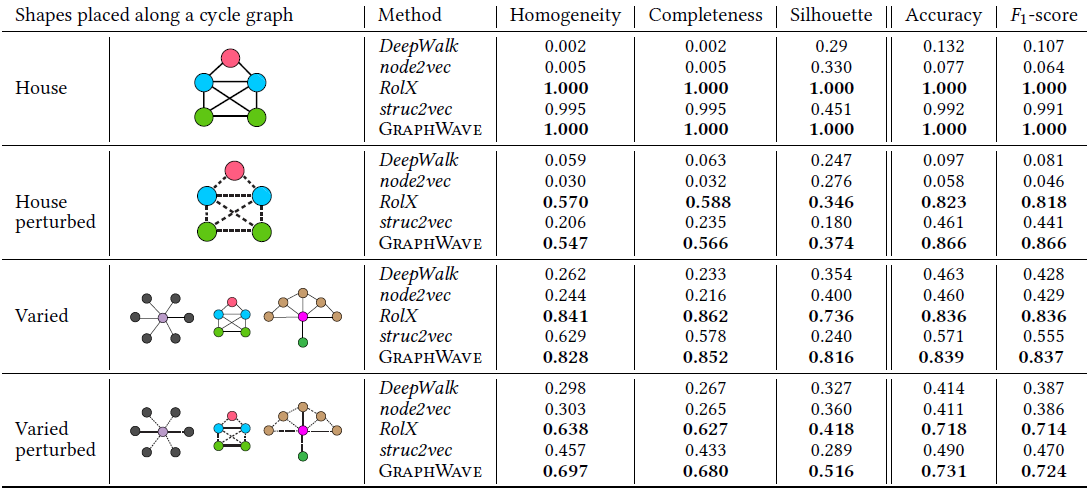

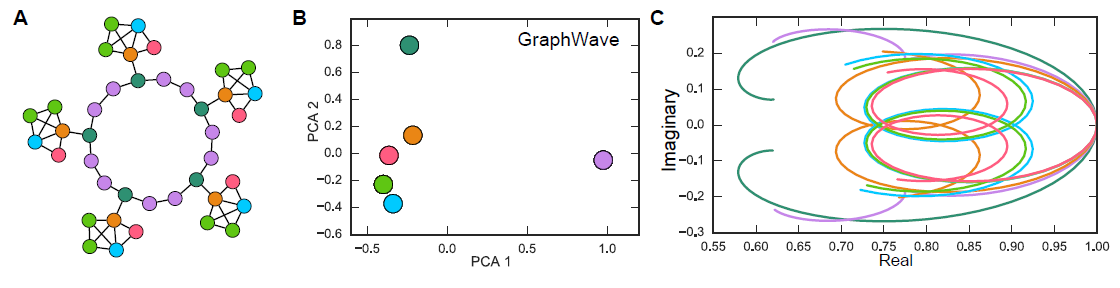

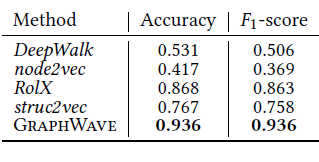

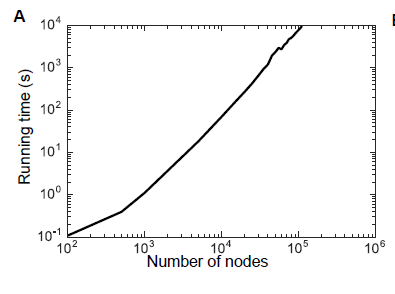

BlogCatalog数据集:我们评估 的结果。结果如下表,粗体表示每一列最佳结果。结论:

DeepWalk性能始终优于EdgeCluster,Modularity,wvRN。事实上当

DeepWalk仅仅给出20%标记样本来训练的情况下,模型效果优于其它模型90%的标记样本作为训练集。虽然

SpectralClustering方法更具有竞争力,但是当数据稀疏时DeepWalk效果最好:对于Macro-F1指标, 时DeepWalk效果更好;对于Micro-F1指标, 时DeepWalk效果更好。当仅标记图中的一小部分时,

DeepWalk效果最好。因此后面实验我们更关注稀疏标记图sparsely labeled graph。

Flickr数据集:我们评估 的结果。结果如下表,粗体表示每一列最佳结果。结论与前面的实验一致。- 在

Micro-F1指标上,DeepWalk比其它基准至少有3%的绝对提升。 - 在

Micro-F1指标上,DeepWalk只需要3%的标记数据就可以打败其它方法10%的标记数据,因此DeepWalk的标记样本需求量比基准方法少60%。 - 在

Macro-F1指标上,DeepWalk性能接近SpectralClustring,击败了所有其它方法。

- 在

YouTube数据集:我们评估 的结果。结果如下表,粗体表示每一列最佳结果。由于

YouTube规模比前面两个数据集大得多,因此我们无法运行两种基准方法SpecutralClustering, Modularity。DeepWalk性能远超EdgeCluster基准方法:- 当标记数据只有

1%时,DeepWalk在Micro-F1指标上相对EdgeCluster有14%的绝对提升,在Macro-F1指标上相对EdgeCluster有10%的绝对提升。 - 当标记数据增长到

10%时,DeepWalk提升幅度有所下降。DeepWalk在Micro-F1指标上相对EdgeCluster有3%的绝对提升,在Macro-F1指标上相对EdgeCluster有4%的绝对提升。

- 当标记数据只有

DeepWalk能扩展到大规模网络,并且在稀疏标记环境中表现出色。

1.2.2 参数敏感性

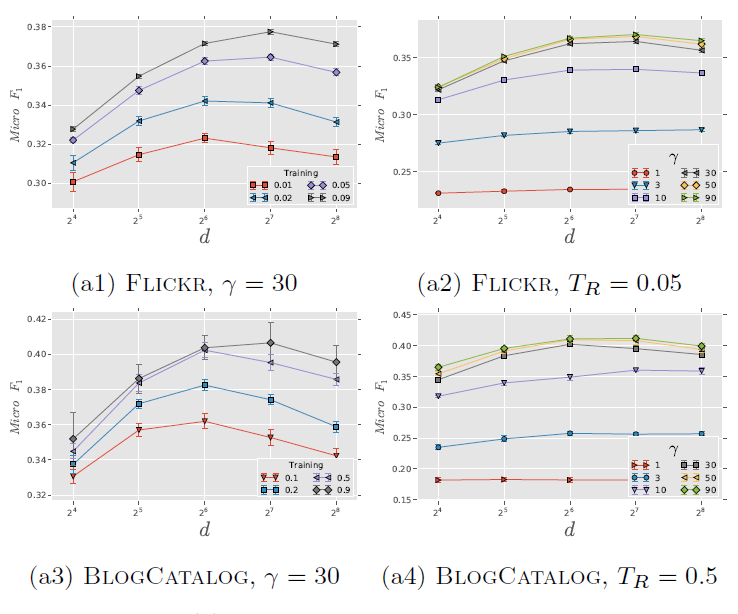

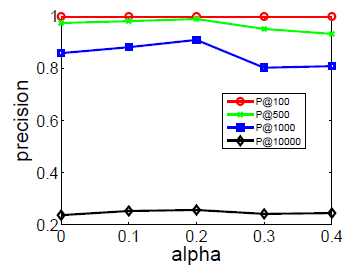

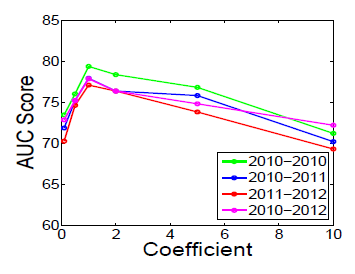

为评估超参数的影响,我们在

Flickr和BlogCatalog数据集上进行实验。我们固定窗口大小 和游走长度 。然后我们改变潜在维度 、每个顶点开始的随机游走数量 、可用的训练数据量 ,从而确定它们对于网络分类性能的影响。考察不同 的效果:

图

a1和 图a3考察不同 和不同 的效果。Flickr和BlogCatalog数据集上模型的表现一致:模型最佳尺寸 取决于训练样本的数量。注意:

Flickr的1%训练样本和BlogCatalog的10%训练样本,模型的表现差不多。图

a2和图a4考察不同 和不同 的效果。在不同 取值上,模型性能对于不同 的变化比较稳定。- 从 开始继续提高 时模型的效果提升不大,因此 几乎取得最好效果。继续提升效果,计算代价上升而收益不明显。

- 不同的数据集中,不同 值的性能差异非常一致,尽管

FLICKR包含边的数量比BLOGCATALOG多一个数量级。

这些结论表明:我们的方法可以得到各种size 的有用模型。另外,模型性能取决于模型看到的随机游走数量,模型的最佳维度取决于可用的训练样本量。

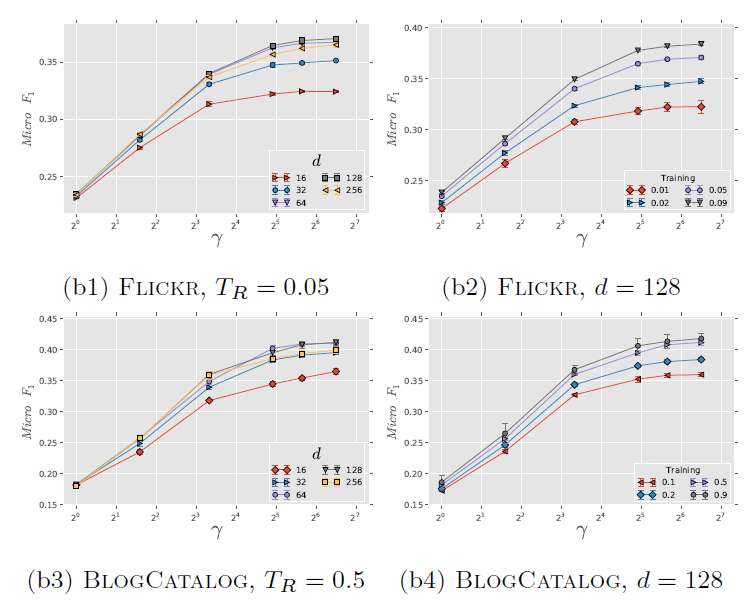

考察不同 的影响。图

b1和b3考察不同 的效果,图b2和b4考察了不同 的效果。实验结果表明,它们的表现比较一致:增加 时开始可能有巨大提升,但是当 时提升效果显著下降。

这些结果表明:仅需要少量的随机游走,我们就可以学习有意义的顶点潜在表示。

二、LINE[2015]

信息网络

information network在现实世界中无处不在,例如航空网络、出版物网络、社交网络、通信网络、以及万维网。这些信息网络的规模从数百个节点到数百万、甚至数十亿个节点不等。分析大型信息网络已经引起学术界和工业界越来越多的关注。论文《LINE: Large-scale Information Network Embedding》研究了将信息网络嵌入到低维空间中的问题,其中每个顶点都表示为一个低维向量。这种低维embedding在各种application中非常有用,例如可视化visualization、节点分类node classi fication、链接预测link prediction、推荐recommendation。机器学习文献中已经提出了各种

graph embedding方法。它们通常在较小的网络上表现良好。当涉及现实世界的信息网络时(这些网络通常包含数百万节点、数十亿条边),这个问题变得更具挑战性。例如,2012年Twitter的followee-follower网络包含1.75亿活跃用户、大约200亿条边。大多数现有的graph embedding算法无法针对这种规模的网络进行扩展。例如,MDS、IsoMap、Laplacian eigenmap等经典graph embedding算法的时间复杂度至少是顶点数量的二次方,这对于具有数百万个节点的网络来说是不可行的。尽管最近的一些工作研究了大规模网络的

embedding,但是这些方法要么采用了不是为网络而设计的间接方法(如《Distributed large-scale natural graph factorization》),要么缺乏为网络embedding量身定制的、明确的目标函数(如《Deepwalk: Online learning of social representations》)。论文《LINE: Large-scale Information Network Embedding》预计:具有精心设计的、保持图属性的目标函数和有效优化技术的新模型,应该可以有效地找到数百万个节点的embedding。因此在该论文中,作者提出了一种称为LINE的network embedding模型,它能够扩展到非常大的、任意类型的网络:无向/有向图、无权/有权图。该模型优化了一个目标函数,该目标函数同时保持了局部网络结构local network structure和全局网络结构global network structure。局部网络结构(一阶邻近性):自然地,局部网络结构由网络中观察到的链接来表示,它捕获顶点之间的一阶邻近性

first-order proximity。大多数现有的graph embedding算法都旨在保持这种一阶邻近性,例如IsoMap、Laplacian eigenmap,即使这些算法无法扩展。全局网络结构(二阶邻近性):作者观察到:在现实世界的网络中,实际上很多合法的链接都未被观测到。换句话讲,在现实世界数据中观察到的一阶邻近性不足以保持全局网络结构。作为补充,作者探索了顶点之间的二阶邻近性

second-order proximity,这是通过顶点的共享邻域结构shared neighborhood structure来确定的,而不是通过观察到的直接连接强度来确定。二阶邻近性的通用概念可以解释为:具有共享邻居的节点之间可能是相似的。这种直觉可以在社会学和语言学的理论中找到。例如:在社交网络中,“两个人的社交网络的重叠程度与他们之间的联系强度相关”(

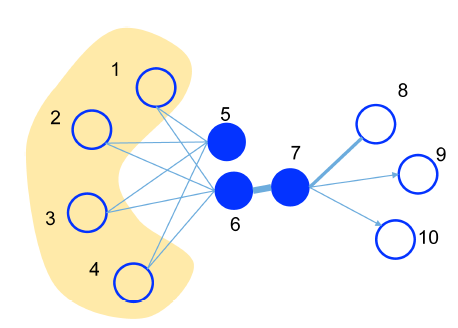

the degree of overlap of two people's friendship networks correlates with the strength of ties between them);在文本网络中,“一个词的意思是由它的使用环境所形成的”(You shall know a word by the company it keeps)。确实,有很多共同好友的人很可能有相同的兴趣并成为朋友,而与许多相似词一起使用的单词很可能具有相似的含义。下图展示了一个说明性的例子,其中边越粗权重越大:

- 由于顶点

6和顶点7之间的边的权重很大,即顶点6和顶点7具有较高的一阶邻近性,因此它们的representation应该在embedding空间中彼此靠近。 - 另一方面,虽然顶点

5和顶点6之间没有直接链接,但是它们共享了许多共同的邻居,即它们具有很高的二阶邻近性,因此它们的representation应该在embedding空间中彼此靠近。

论文期望对二阶邻近性的考虑能够有效地补充一阶邻近性的稀疏性,从而更好地保持网络的全局结构。在论文中,作者将展示精心设计的目标函数,从而保持一阶邻近性和二阶邻近性。

- 由于顶点

即使找到了一个合理的目标函数,为一个非常大的网络优化该目标函数也是具有挑战性的。近年来,引起大家关注的一种优化方法是随机梯度下降。然而,论文表明:直接部署随机梯度下降对现实世界的信息网络是有问题的。这是因为在许多网络中,边是加权的,并且权重通常呈现高方差

high variance。考虑一个单词共现网络word co-occurrence network,其中word pair的权重(共现)可能从 “一” 到 “几十万” 不等。这些边的权重将乘以梯度,导致梯度爆炸从而影响模型性能。因为

LINE的目标函数是加权的交叉熵,权重为word pair共现次数。为了解决这个问题,论文提出了一种新的边采样方法

edge-sampling method,该方法提高了推断的效率efficiency和效果effectiveness。作者以与边权重成正比的概率对边进行采样,然后将采样后的边视为用于模型更新的二元边binary edge。通过这个采样过程,目标函数保持不变,边的权重不再影响梯度。这可能会导致数据稀疏性问题:即一些权重很小的边未被采样到。

LINE非常通用,适用于有向/无向图、加权/未加权图。论文使用各种真实世界的信息网络(包括语言网络language network、社交网络social network、引文网络citation network)来评估LINE的性能。论文在多个数据挖掘任务中评估了学到的embedding的有效性,包括单词类比word analogy、文本分类text classification、节点分类node classification。结果表明,LINE模型在效果和效率方面都优于其它竞争baseline。LINE能够在几个小时内在单台机器上学习具有数百万个节点、数十亿条边的网络的embedding。总而言之,论文主要贡献:

- 论文提出了一个叫做

LINE的、新的network embedding模型,该模型适用于任意类型的信息网络,并可轻松地扩展到数百万个节点。该模型有一个精心设计的目标函数,可以同时保持一阶邻近性和二阶邻近性。 - 论文提出了一种边采样算法来优化目标函数,该算法解决了经典随机梯度下降的局限性,提高了推断的效率和效果。

- 论文对现实世界的信息网络进行了广泛的实验,实验结果证明了

LINE模型的效率和效果。

相关工作:

我们的工作通常与

graph embedding或降维的经典方法有关,例如多维缩放multidimensional scaling: MDS、IsoMap、LLE、Laplacian Eigenmap。这些方法通常首先使用数据点data point的特征向量feature vector构建affinity graph,例如数据的K-nearest neighbor graph,然后将affinity graph嵌入到低维空间中。然而,这些算法通常依赖于求解

affinity matrix的top-n eigenvectors,其复杂度至少是节点数量的二次方,使得它们在处理大规模网络时效率很低。最近的文献中有一种叫做图分解

graph factorization(《Distributed large-scale natural graph factorization》) 的技术。该方法通过矩阵分解找到大规模图的低维embedding,并使用随机梯度下降进行优化。这是可行的,因为图可以表示为affinity matrix。然而,矩阵分解的目标不是为网络设计的,因此不一定保持了全局网络结构。直觉上,图分解预期具有较高一阶邻近性的节点的

representation彼此靠近。相反,LINE模型使用了一个专门为网络设计的目标函数,该目标函数同时保持了一阶邻近性和二阶邻近性。另外,图分解方法仅适用于无向图,而LINE方法适用于无向图和有向图。与我们最相关的、最新的工作是

DeepWalk,它通过截断的随机游走truncated random walk来学习社交网络的embedding。尽管在经验上是有效的,但是DeepWalk并为提供明确的目标来阐明保持哪些网络属性。直觉上,DeepWalk期望具有较高二阶邻近性的节点产生相似的低维representation,而LINE同时保持一阶邻近性和二阶邻近性。DeepWalk使用随机游走来扩展顶点的邻域,这类似于深度优先搜索depth-first search: DFS。LINE使用广度优先搜索breadth- first search: BFS策略,这是一种更合理的二阶邻近性方法。另外,DeepWalk仅适用于无权图,而LINE适用于加权图和无权图。

在实验中,我们使用各种真实世界的网络来评估

LINE和这些方法的效果。

2.1 模型

2.1.1 问题定义

信息网络

information network的定义:一个信息网络定义为 ,其中:为顶点集合,每个元素代表一个数据对象

data object。为边集合,每个元素代表两个数据对象之间的关系。

每条边 是一个有序的

pair,它关联一个权重 表示关系的强度。- 如果 是无向图,则有 且 ;如果 是有向图,则有 且 。

- 如果 是无权图,则 ,这种边称作二元边

binary edge,权重表示相连/不相连;如果 是带权图,则 则边的取值是实数,这种边表示连接的紧密程度。

这里所有权重都是非负的,并不考虑负权重。

在实践中,信息网络可以是有向的(如引文网络),也可以是无向的(如

Facebook的用户社交网络)。边的权重可以是二元binary的,也可以是任何实际值。注意,虽然边的权重理论上也可以是负的,但是这里我们仅考虑非负的权重。例如,在引文网络和社交网络中, 是二元的。在不同共现网络中, 可以取任何非负值。某些网络中的边的权重方差可能很大,因为某些对象会多次共现、而其它对象可能很少共现。将信息网络嵌入到低维空间在各种

application中都很有用。为了进行embedding,网络结构必须被保持。第一个直觉是必须保持局部网络结构,即顶点之间的局部pairwise邻近性。我们将局部网络结构定义为顶点之间的一阶邻近性。一阶邻近性

first-order proximity的定义:网络中的一阶邻近性是两个顶点之间的局部pairwise邻近性。对于边 连接的顶点pair,边上的权重 表示顶点 和顶点 之间的一阶邻近性。如果在顶点 和顶点 之间没有观察到边,则它们之间的一阶邻近性为0。一阶邻近性通常意味着现实世界网络中两个节点的相似性

similarity。例如:在社交网络中彼此成为好友的人往往有相似的兴趣,在万维网中相互链接的网页倾向于谈论相似的话题。由于这种重要性,许多现有的graph embedding算法(如IsoMap、LLE、Laplacian eigenmap、graph factorization)都以保持一阶邻近性为目标。然而,在现实世界的信息网络中,观察到的链接仅是一小部分,还有许多其他链接发生了缺失

missing。缺失链接上的顶点pair之间的一阶邻近性为零,尽管它们本质上彼此非常相似。因此,仅靠一阶邻近性不足以保持网络结构,重要的是寻找一种替代的邻近性概念来解决稀疏性问题。一个自然的直觉是:共享相似邻居的顶点往往彼此相似。例如:在社交网络中,拥有相同朋友的人往往有相似的兴趣,从而成为朋友;在单词共现网络中,总是与同一组单词共现的单词往往具有相似的含义。因此,我们定义了二阶邻近性,它补充了一阶邻近性并保持了网络结构。二阶邻近性

second-order proximity的定义:网络中一对顶点 之间的二阶邻近性是它们的邻域网络结构之间的相似性。数学上,令 为顶点 和所有顶点的一阶邻近性向量,然后顶点 和顶点 之间的二阶邻近性由 和 的相似性来确定。如果没有任何顶点同时与 和 相连,则 和 之间的二阶邻近性为0。我们研究了

network embedding的一阶邻近性和二阶邻近性,定义如下。大规模信息网络嵌入

Large-scale Information Network Embedding:给定一个大型网络 ,大规模信息网络嵌入的问题旨在将每个顶点 映射到一个低维空间 中,即学习一个函数 ,其中 。在空间 中,顶点之间的一阶邻近性和二阶邻近性都可以得到保持。现实世界信息网络的理想

embedding模型必须满足几个要求:- 首先,它必须能够同时保持顶点之间的一阶邻近性和二阶邻近性。

- 其次,它必须针对非常大的网络可扩展,比如数百万个顶点、数十亿条边。

- 第三,它可以处理具有任意类型边的网络:有向/无向、加权/无权的边。

这里,我们提出了一个叫做

LINE的新型network embedding模型,该模型满足所有这三个要求。我们首先描述了LINE模型如何分别保持一阶邻近性和二阶邻近性,然后介绍一种简单的方法来组合这两种邻近性。

2.1.2 保持一阶邻近性的 LINE

一阶邻近性是指网络中顶点之间的局部

pairwise邻近性。为了对一阶邻近性建模,对于每条无向边 ,我们定义顶点 和 之间的联合概率为:其中 为顶点 的低维

representation向量。上式定义了 空间上的一个概率分布 ,它的经验概率

empirical probability定义为:其中 为所有边权重之和。

为了保持一阶邻近性,一个直接的方法是最小化以下目标函数:

其中 为两个概率分布之间的距离。这里我们选择

KL散度作为距离函数,因此有:注意,上述一阶邻近性仅适用于无向图,而无法适用于有向图。

通过最小化 从而得到 ,我们可以得到每个顶点在 维空间中的

representation。读者注:

- 上式的物理意义为:观测边的加权负对数似然,每一项权重为边的权重。

- 上式并不是严格的

KL散度,它用到的是两个非归一化概率 和 。 - 最小化

KL散度等价于最小化交叉熵:

其中省略了常数项 。

2.1.3 保持二阶邻近性的 LINE

二阶邻近性适用于有向图和无向图。给定一个网络,不失一般性,我们假设它是有向的(一条无向边可以被认为是两条方向相反、权重相等的有向边)。二阶邻近性假设:共享邻域的顶点之间彼此相似。

在这种情况下,每个顶点也被视为一个特定的 “上下文”(

context)。我们假设:如果两个顶点的上下文相似,则这两个顶点是相似的。因此,每个顶点扮演两个角色:顶点本身、以及其它顶点的特定上下文。我们引入两个向量 和 ,其中 为顶点 作为顶点本身时的

representation, 为顶点 作为其它顶点的特定上下文时的representation。对于每条有向边 ,我们首先定义由顶点 生成上下文顶点 的概率为:其中 为顶点集合的大小。

对于每个顶点 ,上式实际上定义了上下文(即网络上整个顶点集合)中的条件分布 。如前所述,二阶邻近性假设具有相似上下文分布的顶点之间彼此相似。为了保持二阶邻近性,我们应该使得由低维

representation指定的上下文条件分布 接近经验分布 。因此,我们最小化以下目标函数:其中:

为顶点 的重要性。由于网络中顶点的重要性可能不同,我们在目标函数中引入了 来表示顶点 在网络中的重要性。 可以通过顶点的

degree来衡量,也可以通过PageRank等算法进行估计。注意:目标函数 中并未引入顶点重要性,而目标函数 中引入了顶点重要性。这里引入顶点重要性是为了得到 的一个简洁的公式。

是两个概率分布之间的距离。

经验分布 定义为 ,其中 是边 的权重, 是顶点 的出度

out-degree,即 , 为顶点 的out-neighbors。

在本文中,为简单起见,我们将 设为顶点 的

out-degree,即 。这里我们也采用KL散度作为距离函数。忽略一些常量,则我们得到:通过最小化 从而得到 ,我们可以得到顶点 在 维空间中的

representation。读者注:

- 上式的物理意义为:条件概率的加权负对数似然,每一项权重为边的权重。

- 与 相反,这里是严格的

KL散度,它用到的是两个归一化概率 和 。 - 同样地,最小化

KL散度等价于最小化交叉熵。 - 二阶邻近性

LINE类似于上下文窗口长度为1的DeepWalk,但是DeepWalk仅用于无权图而LINE可用于带权图。

2.1.4 组合一阶邻近性和二阶邻近性

为了通过同时保持一阶邻近性和二阶邻近性来嵌入网络,我们在实践中发现一种简单的、有效的方法是:分别训练一阶邻近性

LINE模型、二阶邻近性LINE模型;然后对于每个顶点,拼接这两种方法得到的embedding。实验部分作者提到:需要对拼接后的向量各维度进行加权从而平衡一阶

representation向量和二阶representation向量的关系。在监督学习任务中,可以基于训练数据自动得到权重;在无监督学习任务中,无法配置这种权重。因此组合一阶邻近性和二阶邻近性仅用在监督学习任务中。组合一阶邻近性和二阶邻近性的更合理的方法是联合训练目标函数 和 ,我们将其留作未来的工作。

2.1.5 模型优化

负采样:优化目标函数 的计算量很大,在计算条件概率 时需要对整个顶点集合进行求和。为了解决这个问题,我们采用了负采样方法,它对每条边 根据一些噪声分布

noisy distribution来负采样多条负边negative edge。具体而言,我们为每条边 指定以下目标函数:其中:

- 为

sigmoid函数。 - 为期望。

- 为噪声分布。

注意:目标函数 中的概率 不涉及对整个顶点集合进行求和。

第一项对观察到的边进行建模,第二项对从噪声分布中采样的负边进行建模, 是负边的数量。我们根据

Word2Vec的建议设置 ,其中 为顶点 的出度out-degree。- 为

对于目标函数 ,存在一个平凡解

trivial solution:此时 ,使得 取最小值。

为了避免平凡解,我们也可以利用负采样方法,对于每条边 :

第一项对观察到的边进行建模,第二项对从噪声分布中采样的负边进行建模, 是负边的数量。

注意这里没有上下文顶点,因此没有 。

2.1.6 边采样

我们采用异步随机梯度算法

ASGD来优化目标函数。在每一步中,ASGD算法采样了一个mini-batch的边,然后更新模型参数。假设采样到边 ,则顶点 的embedding向量 被更新为:注意,梯度将乘以边的权重。当边的权重具有高方差时,这将成为问题。例如,在一个单词共现网络中,一些词会共现很多次(例如,数万次),而另一些词只会共现几次。在这样的网络中,梯度的

scale不同,很难找到一个好的学习率:- 如果我们根据权重小的边选择较大的学习率,那么权重大的边上的梯度将会爆炸。

- 如果我们根据权重大的边选择较小的学习率,那么权重小的边上的梯度会非常小。

基于边采样

edge-sampling的优化:解决上述问题的直觉是,如果所有边的权重相等(例如,具有二元边binary edge的网络),那么如何选择合适的学习率将不再成为问题。因此,一个简单的处理是将加权边展开为多个二元边。例如,将权重为 的边展开为 条二元边。虽然这能够解决问题,但是会显著增加内存需求,尤其是当边的权重非常大时,因为这显著增加边的数量。为此,可以从原始边中采样,并将采样后的边视为二元边,采样概率与原始边的权重成正比。通过这种边采样处理,整体目标函数保持不变。问题归结为如何根据权重对边进行采样。

令 为边权重的序列。

- 首先,简单地计算权重之和 。

- 然后,在 范围内随机采样一个值,看看这个随机值落在哪个区间 。

该方法需要 的时间来采样,当边的数量 很大时,其代价太高。我们使用

alias table方法来根据边的权重来采样。当从相同的离散分布中重复采样时,其平摊的时间复杂度为 。从

alias table中采样一条正边需要 时间。此外,负采样优化需要 时间,其中 为负采样数量。因此,每个step都需要 时间。在实践中,我们发现用于优化的

step数量通常与边的数量 成正比。因此,LINE的整体时间复杂度为 ,与边的数量 成线性关系,而不依赖于顶点数量 。边采样在不影响效率的情况下提高了随机梯度下降的效果。

2.1.7 讨论

我们讨论了

LINE模型的几个实际问题。低度

low degree顶点 :一个实际问题是如何准确地嵌入degree较小的顶点。由于此类顶点的邻居数量非常少,因此很难准确地推断其representation,尤其是使用严重依赖于 “上下文” 数量的二阶邻近性方法。一种直觉的解决方案是通过添加更高阶的邻居(如邻居的邻居)来扩展这些顶点的邻居。在本文中,我们只考虑向每个顶点添加二阶邻居,即邻居的邻居。顶点 和它的二阶邻居 之间的权重被设置为:

其中:

- 为顶点 的一阶邻居集合。

- 为顶点 的二阶邻居集合。

实践中,只能添加与

low degree顶点 具有最大邻近性 的二阶邻居顶点子集 。新顶点:另一个实际问题是如何找到新顶点的

representation。对于一个新顶点 ,如果它与现有顶点存在链接,则我们可以获得新顶点在现有顶点上的经验分布 。为了获得新顶点的

embedding,根据目标函数 和 ,一个直接方法是最小化以下目标函数之一:我们更新新顶点的

embedding,并保留现有顶点的embedding。注意,对于有向边的图,需要考虑新顶点到已有顶点的链接、以及已有顶点到新顶点的链接,一共两个方向。

如果新顶点和现有顶点之间不存在链接,则我们必须求助于其它信息,如顶点的文本信息。我们将其留作我们未来的工作。

未来工作:

- 研究网络中一阶邻近性和二阶邻近性以外的高阶邻近性。

- 研究异质信息网络的

embedding,例如具有多种类型的顶点。

2.2 实验

我们通过实验评估了

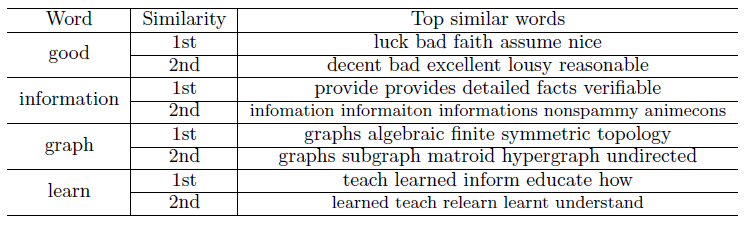

LINE的效果和效率。我们将LINE应用于几个不同类型的、大型的现实世界网络,包括一个语言网络language network、两个社交网络social network、两个引文网络citation network。数据集:

- 语言网络

Language Network数据集:我们从整个英文维基百科页面构建了一个单词共现网络。我们选择滑动窗口为5,并认为滑动窗口内的单词是共现的。出现频次小于5的单词被过滤掉。 - 社交网络

Social Network数据集:和DeepWalk一致,我们也采用Flickr和Youtube数据集。Flickr网络比Youtube网络更稠密。 - 引文网络

Citation Network数据集:使用DBLP数据集构建的作者引文网络author citation network、论文引用网络paper citation network。作者引文网络记录了一位作者撰写、并被另一位作者引文的论文数量。

这些数据集的统计见下表,其中:

- 所有这些网络囊括了有向图/无向图,带权图/无权图。

- 每个网络至少包含

50万顶点和数百万条边,最大的网络包含200万顶点和十亿条边。

- 语言网络

baseline方法:我们将LINE模型与几种现有的graph embedding方法进行比较,这些方法能够扩展到非常大的网络。我们没有与一些经典的graph embedding算法(如MDS、IsoMap、Laplacian eigenmap)进行比较,因为这些算法无法处理如此规模的网络。Graph Factorization:GF:一个信息网络可以表示为一个亲和度矩阵affinity matrix,并通过矩阵分解来获取每个顶点的低维representation。GF方法通过随机梯度下降法进行优化,因此可以处理大型网络。但是它仅适合无向图。DeepWalk:DeepWalk是最近提出的、一种用于社交网络embedding的方法,它仅适用于无权网络。对每个顶点,DeepWalk使用从该顶点开始的截断随机游走来获取上下文信息,基于上下文信息建模来获取每个顶点的低维表达。因此,该方法仅利用二阶邻近性。LINE-SGD:直接通过SGD来优化目标函数的LINE模型。在优化过程中并没有使用边采样策略,因此对于采样到的正边,我们需要将边的权重直接乘以梯度。该方法有两个变种:

LINE-SGD(1st):LINE-SGD的一阶邻近模型,它的优化目标是 。该模型仅适用于无向图。LINE-SGD(2nd):LINE-SGD的二阶邻近模型,它的优化目标是 。该模型可用于无向图和有向图。

LINE:标准的LINE模型。在优化过程中使用了边采用策略。该方法也有两个变种,分别为:

LINE(1st):LINE的一阶邻近模型,它的优化目标是 。该模型仅适用于无向图。LINE(2nd):LINE的二阶邻近模型,它的优化目标是 。该模型可用于无向图和有向图。

LINE(1st+2nd):同时拼接了LINE(1st)和LINE(2nd)学到的representation向量,得到每个顶点的一个拼接后的、更长的representation向量。需要对拼接后的向量各维度进行加权从而平衡一阶

representation向量和二阶representation向量的关系。在监督学习任务中,可以基于训练数据自动得到权重;在无监督学习任务中,无法配置这种权重。因此LINE(1st+2nd)仅用在监督学习任务中。

参数配置:

所有方法都统一的配置:

- 随机梯度下降的

batch-size = 1,即每个批次一个样本。因此迭代的样本数量就等于更新的step数量。 - 学习率 ,其中: 为初始化学习率; 表示第 个更新

step; 为总的更新step数量。 - 所有得到的

embedding向量都进行归一化: 。 - 为公平比较,语言网络数据集的

embedding向量维度设为200(因为word2vec方法采用该配置);其它网络数据集的embedding向量维度默认设为128。

- 随机梯度下降的

对于

LINE及其变种,负采样比例 。对于

LINE(1st)、LINE(2nd)及其变种,总迭代步数 等于100亿 ;对于GF,总迭代步数 等于200亿。对于

DeepWalk窗口大小win=10,游走序列长度t=40,每个顶点出发的序列数量 。

2.2.1 语言网络

语言网络:语言网络数据集包含

200万顶点和10亿条边。我们使用两个任务来评估学到的embedding的有效性:单词类比word analogy、文档分类document classification。单词类比

word analogy:给定一对单词(a,b)和一个单词c,该任务的目标是寻找单词d,使得c和d的关系类比于a和b的关系。记作:如:“(中国,北京 )” 对应于 “(法国,?)” ,这里的目标单词为 “巴黎”。

因此给定单词

a,b,c的embedding向量,该任务的目标是寻找单词 ,使得该单词的embedding尽可能与 相似:在这个任务中使用了两种类型的单词类比:语义

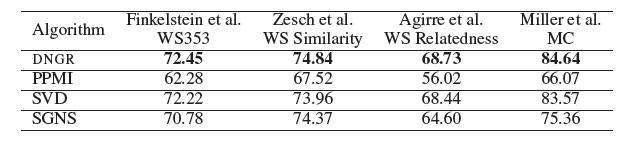

semantic、句法syntactic。在维基百科语言网络上的单词类比结果如下表所示。其中:

- 对

GF方法,边的权重定义为单词共现次数的对数,这比直接采用单词共现次数更好的性能。 - 对

DeepWalk方法,尝试使用不同的截断阈值从而将网络权重二元化binarize。最终当所有边都被保留下来时,模型性能最好。 SkipGram直接从原始维基百科页面内容文本而不是语言网络来学习词向量。窗口大小设置为5。- 所有模型都是在单机上运行

16个线程来计算,机器配置:1T内存、2.0GHZ的40个CPU。

结论:

LINE(2nd)优于所有其它方法。LINE(2nd)优于GF,LINE(1st)等一阶方法。这表明:和一阶邻近性相比,二阶邻近性更好的捕获了单词的语义。因为如果单词

a和b的二阶邻近性很大,则意味着可以在相同上下文中可以相互替换单词a和b。这比一阶邻近性更能说明相似语义。虽然

DeepWalk也探索了二阶邻近性,但是其性能不如LINE(2nd),甚至不如一阶方法的GF,LINE(1st)。这是因为

DeepWalk忽略了单词共现次数的原因,事实上语言网络中单词共现频次非常重要。这个解释不通。单词共现次数隐含在随机游走过程中:单词共现次数越大,则随机游走被采样到的概率越大。

在原始语料上训练的

SkipGram模型也不如LINE(2nd),原因可能是语言网络比原始单词序列更好的捕获了单词共现的全局信息。

采用

SGD直接优化的LINE版本效果要差得多。这是因为语言网络的边的权重范围从个位数到上千万,方差很大。这使得最优化过程受到严重影响。在梯度更新过程中进行边采样处理的

LINE模型有效解决了该问题,最终效果要好得多。LINE(1st)和LINE(2nd)的训练效率很高,对于两百万顶点、十亿边的网络只需要不到3个小时。LINE(1st),LINE(2nd)训练速度比GF至少快10%,比DeepWalk快5倍。LINE-SGD版本要稍慢,原因是在梯度更新过程中必须应用阈值截断技术防止梯度爆炸。

- 对

文档分类:另一种评估

word embedding质量的方法是使用word embedding来计算document representation,然后通过文档分类任务评估效果。为了获得文档向量,我们选择了一种非常简单的方法,即选取该文档中所有单词的word embedding的均值。这是因为我们的目标是将不同方法得到的word embedding进行对比,而不是寻找document embedding的最佳方法。我们从维基百科种选择

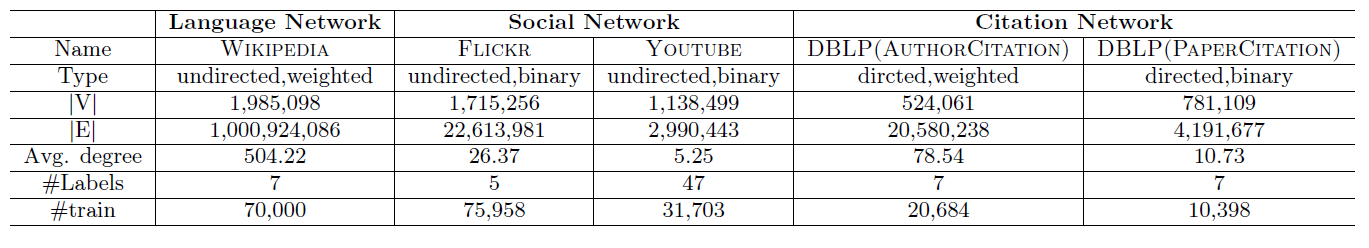

7种不同的类别 “艺术、历史、人类、数学、自然、技术、体育”,对每个类别随机抽取1万篇文章,其中每篇文章都只属于单个类别(如果文章属于多个类别就丢掉)。所有这些文章及其类别就构成了一个带标记的多类别语料库。我们随机抽取不同百分比的标记文档进行训练,剩余部分进行评估。所有文档向量都使用

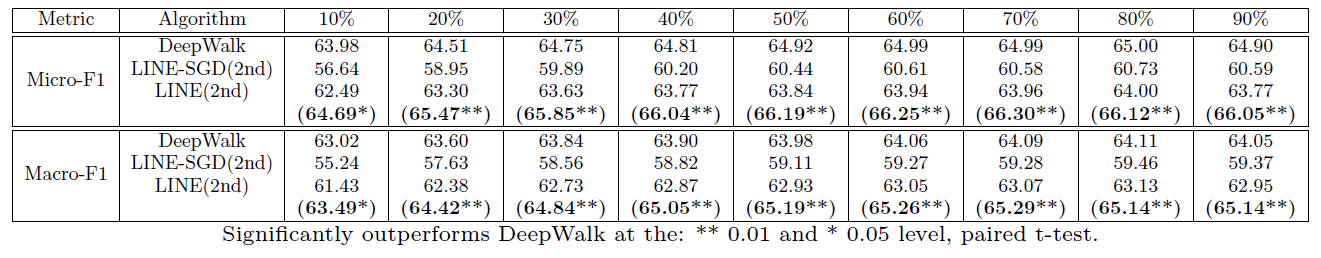

LibLinear package训练one-vs-rest逻辑回归分类器。我们报告了分类结果的Micro-F1和Macro-F1指标。在维基百科语言网络上的文本分类结果如下表所示。其中我们分别抽取

10%~90%的标记样本作为训练集,剩余部分作为测试集。对每一种拆分我们随机执行10轮取平均结果。结论:

GF方法优于DeepWalk,因为DeepWalk忽略了单词共现次数。LINE-SGD性能较差,因为边权重方差很大所以LINE-SGD的梯度更新过程非常困难。采用边采样的

LINE模型优于LINE-SGD,因为梯度更新过程中使用边采样能解决边权重方差很大带来的学习率选择问题。LINE(1st) + LINE(2nd)性能明显优于其它所有方法,这表明一阶邻近度和二阶邻近度是互补的。注意,对于监督学习任务,拼接了

LINE(1st)和LINE(2nd)学到的embedding是可行的。

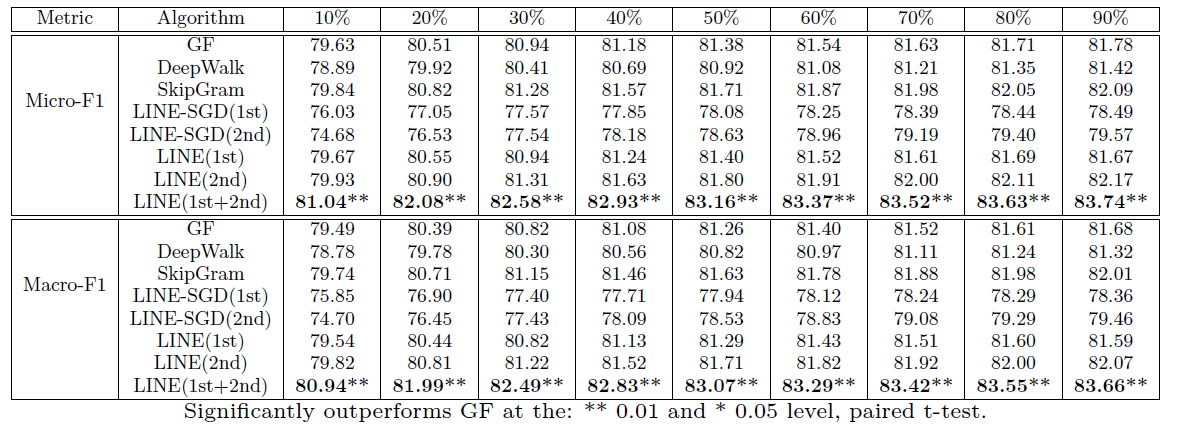

为了更深入地了解一阶邻近性和二阶邻近性,下表对给定单词,分别采用一阶邻近性模型和二阶邻近性模型召回其最相似的

top单词。可以看到:- 二阶邻近度召回的最相似单词都是语义相关的单词。

- 一阶邻近度召回的最相似单词是语法相关、语义相关的混合体。

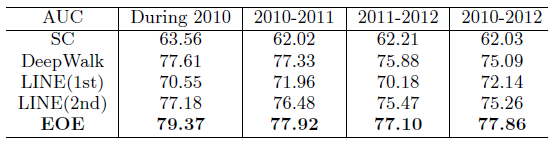

2.2.2 社交网络

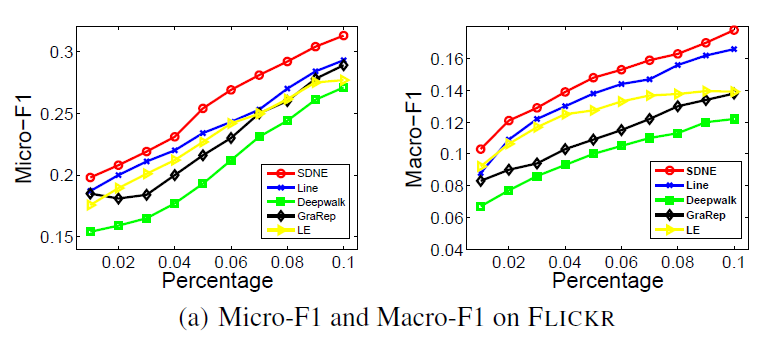

相比语言网络,社交网络更为稀疏,尤其是

YouTube网络。我们通过多标签分类任务来评估每个模型的embedding效果。多标签分类任务将每个顶点分配到一个或者多个类别,每个类别代表一个社区community。最终评估分类结果的Micro-F1和Macro-F指标。我们分别抽取

10%~90%的标记样本作为训练集,剩余部分作为测试集。对每一种拆分随机执行10轮取平均结果。Flickr Network数据集:我们选择最热门的5个类别作为分类的类别,评估结果如下表。LINE(1st)模型优于GF模型,这表明LINE(1st)模型比GF模型具有更好的一阶邻近性建模能力。LINE(2nd)模型优于DeepWalk模型,这表明LINE(2nd)模型比DeepWalk模型具有更好的二阶邻近性建模能力。LINE(1st)模型略微优于LINE(2nd)模型,这和语言网络的结论相反。原因有两个:- 社交网络中,一阶邻近性比二阶邻近性更重要,因为一阶关系表明两个顶点的关系更紧密。

- 当网络非常稀疏并且顶点的平均邻居数太小时,二阶邻近性可能不太准确。

LINE(1st) + LINE(2nd)性能明显优于其它所有方法,这表明一阶邻近性和二阶邻近性是互补的。

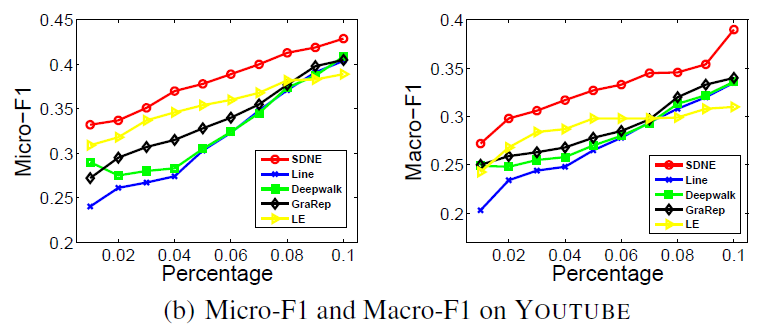

YouTube数据集:YouTube网络非常稀疏,每个顶点的平均degree小于5。对该数据集的评估结果如下表。- 在不同规模训练集上,

LINE(1st)一致性的优于LINE(2nd)。这和Flickr数据集一致。

- 在不同规模训练集上,

由于极度稀疏性,

LINE(2nd)性能甚至不如DeepWalk。- 在

128维或256维上,LINE(1st) + LINE(2nd)优于DeepWalk。这表明一阶邻近性和二阶邻近性是互补的,并能够缓解网络稀疏问题。

考察

DeepWalk是如何通过截断的随机游走来解决网络稀疏性问题的。随机游走类似于深度优先搜索,这种方式可以通过引入间接邻居来迅速缓解邻域稀疏的问题。但是这种方式也可能引入距离较远的顶点,距离较远意味着相关性不大。一种更合理的方式是采用广度优先搜索策略来扩展每个稀疏顶点的邻域,如二阶邻域策略。下表中,括号中的指标是二阶邻域策略的表现。其中我们对邻居数量少于

1000的顶点扩展其二阶邻域,直到扩展邻域集合规模达到1000。我们发现添加超过1000个顶点并不会进一步提高性能。采用二阶邻域策略的网络称作重构网络reconstructed network。可以看到:采用二阶邻域策略之后

GF,LINE(1st),LINE(2nd)的性能都得到提升,其中LINE(2nd)的性能提升最为明显。采用二阶邻域策略之后

LINE(2nd)大多数情况下都优于DeepWalk。采用二阶邻域策略之后

LINE(1st+2nd)性能并没有提升太多。这意味着原始网络的一阶邻近性和二阶邻近性组合已经捕获了大部分信息。因此,

LINE(1st+2nd)是一个非常有效的Graph Embedding方式,适用于dense网络和sparse网络。

注意:二阶邻域策略中,新增邻域顶点的权重需要重新计算,并且优先添加权重最大的顶点。

- 在

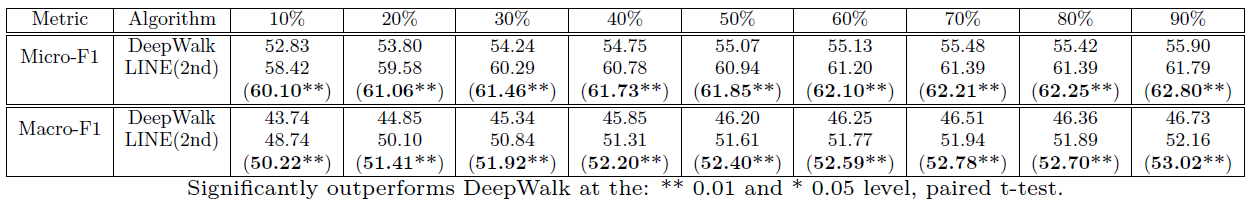

2.2.3 引文网络

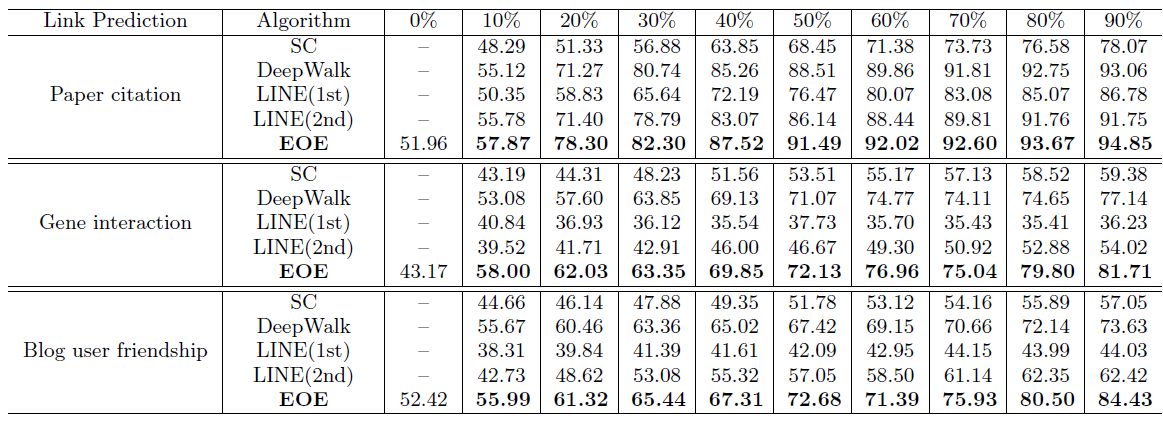

引文网络数据集包括作者引文网络、论文引用网络,它们都是有向图。由于

GF和LINE(1st)都无法应用于有向图,因此这里仅仅比较DeepWalk和LINE(2nd)。我们还通过多标签分类任务评估顶点

embedding的效果。我们选择7个热门的会议(AAAI,CIKM,ICML,KDD,NIPS,SIGIR,WWW)作为分类类别,在会议中发表的作者或者论文被标记为对应类别。最终评估分类结果的Micro-F1和Macro-F指标。我们分别抽取

10%~90%的标记样本作为训练集,剩余部分作为测试集。对每一种拆分随机执行10轮取平均结果。作者引用网络数据集的评估结果如下表所示。

- 由于网络稀疏,因此

DeepWalk性能优于LINE(2nd)。 - 通过二阶邻域策略重构网络,邻域规模的阈值设定为

500,最终LINE(2nd)性能大幅提升并且优于DeepWalk。 LINE-SGD(2nd)性能较差,因为边权重方差很大所以LINE-SGD的梯度更新过程非常困难。

- 由于网络稀疏,因此

论文引用网络数据集的评估结果如下所示。

LINE(2nd)的性能明显优于DeepWalk。这是由于在论文引用网络中的随机游走只能沿着引用路径来游走,这使得一些时间比较久远的、相关性不大的论文被作为上下文。相比之下,

LINE(2nd)的上下文都是最近的、密切相关的参考文献,因此更为合理。通过二阶邻域策略重构网络,邻域规模的阈值设定为

200,最终LINE(2nd)性能得到进一步提升。

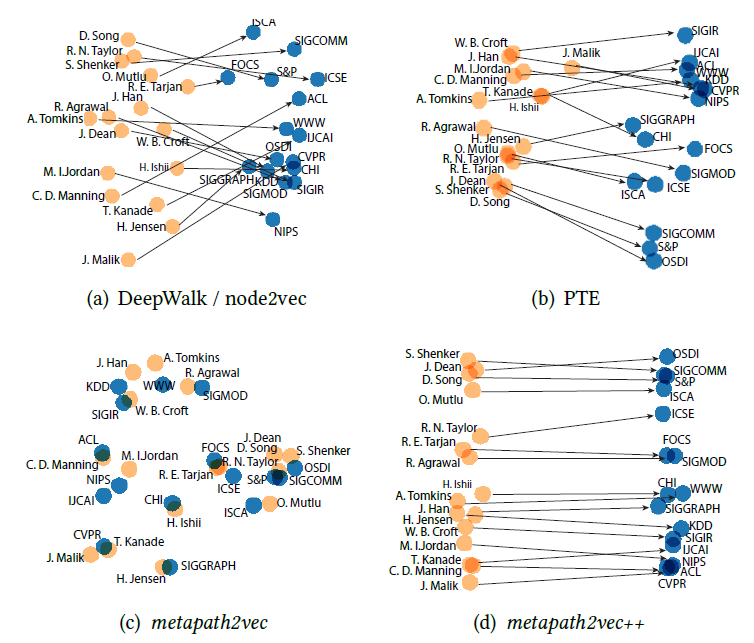

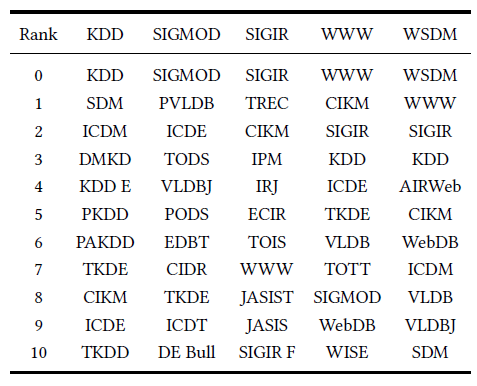

2.2.4 可视化

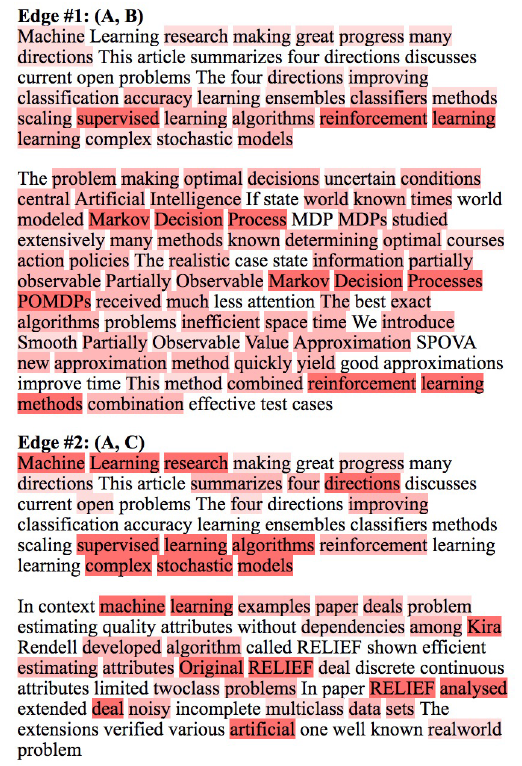

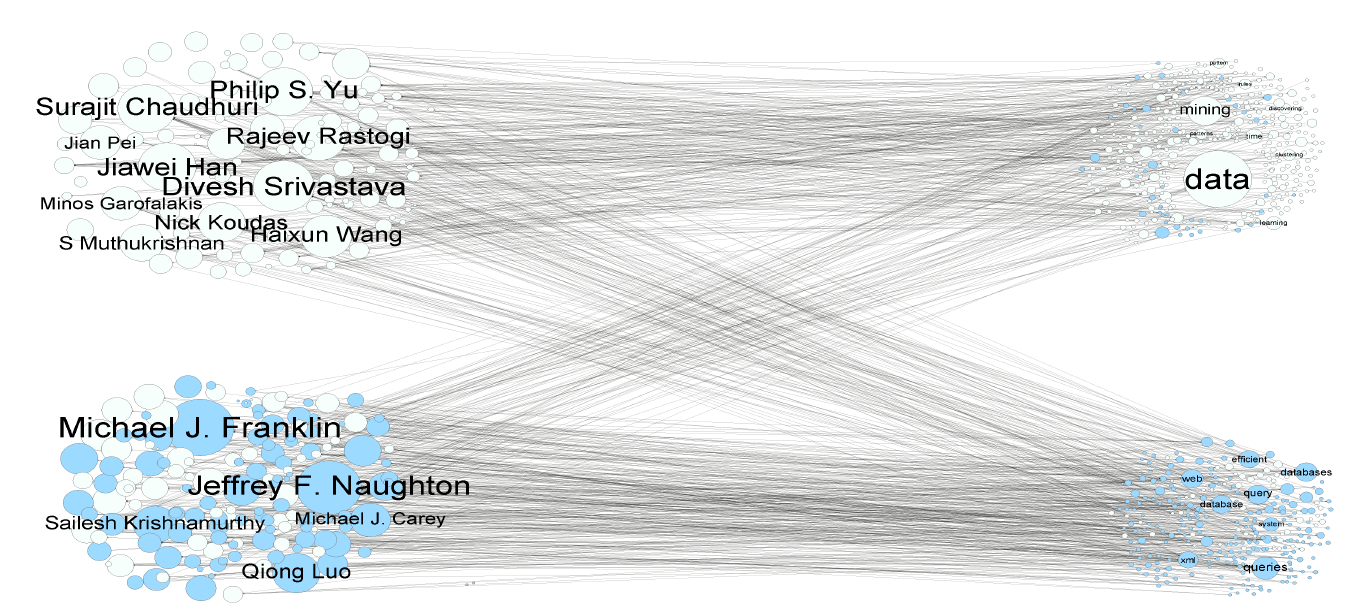

graph embedding的一个重要用途是输出有意义的Graph可视化。我们选择作者引文网络数据集来可视化,选择了三个领域的不同会议:数据挖掘data mining领域的WWW,KDD会议、机器学习machine learning领域 的NIPS,IML 会议、计算机视觉computer vision领域的CVPR,ICCV会议。作者引用网络基于这些会议公开发表的文章来构建,丢弃

degree < 3的作者(表明这些作者不怎么重要),最终得到一个包含18561个顶点、207074条边的网络。可视化这个作者引文网络非常具有挑战性,因为这三个研究领域彼此非常接近。我们首先通过不同的模型来得到

graph embedding,然后将顶点的embedding向量通过t-SNE进行可视化。下图中不同颜色代表不同的领域:红色代表数据挖掘,蓝色代表机器学习,绿色代表计算机视觉。GF模型的可视化结果不是很有意义,因为不同领域的顶点并没有聚集在一起。DeepWalk模型的可视化结果要好得多,但是很多不同领域的顶点密集的聚集在中心区域,其中大多数是degree较高的顶点。这是因为:

DeepWalk使用基于截断随机游走的方式来生成顶点的邻居,由于随机性这会带来很大的噪声。尤其是degree较高的顶点,因为对于degree较高的顶点和大量其它顶点共现。LINE(2nd)模型的可视化结果更好、更具有意义。

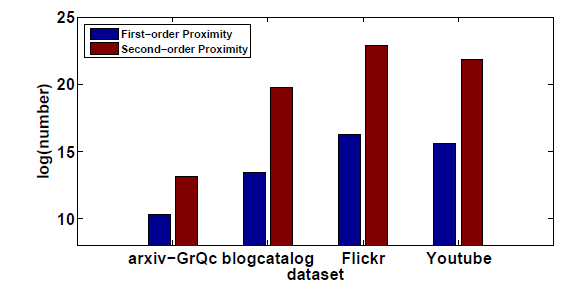

2.2.5 网络稀疏性

以社交网络为例,我们分析了模型性能和网络稀疏性的影响。

我们首先研究网络的稀疏性如何影响

LINE(1st)和LINE(2nd)。图a给出了Flickr网络链接的百分比和LINE模型性能的关系。选择Flickr的原因是它比YouTube网络更密集。我们从原始网络中随机采样不同比例的链接从而构建具有不同稀疏性的网络。可以看到:- 一开始网络非常稀疏时,

LINE(1st)的性能好于LINE(2nd)。 - 当网络逐渐密集时,

LINE(2nd)的性能超越了LINE(1st)。

这表明:当网络极其稀疏时二阶邻近性模型受到影响;当每个顶点附近有足够的邻居时,二阶邻近性模型优于一阶邻近性模型。

- 一开始网络非常稀疏时,

图

b给出了YouTube数据集原始网络和二阶邻域策略重构网络中,顶点degree和模型性能指标的关系。我们将顶点根据degree来分组:: 。然后评估每个分组的顶点分类结果指标。可以看到:- 总体而言,当顶点的

degree增加时,所有模型的效果都得到提升。

- 总体而言,当顶点的

在原始网络中除第一个分组之外,

LINE(2nd)的性能始终优于LINE(1nd)。这表明二阶邻近性模型不适用于degree较小的点。- 在重构网络中,

LINE(1st)和LINE(2nd)都得到了改善,尤其是LINE(2nd)。 - 在重构网络中,

LINE(2nd)始终优于DeepWalk。

- 在重构网络中,

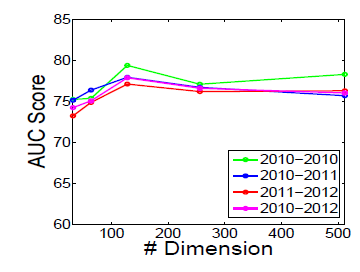

2.2.6 参数敏感性

我们在重建的

Youtube网络上考察了不同的embedding维度 和LINE模型性能的关系,以及样本数量和模型收敛速度的关系。图

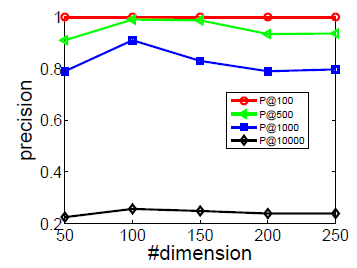

a给出了不同维度 时模型的性能。可以看到:当 过大时,LINE(1st)和LINE(2nd)性能有所下降。图

b给出了LINE和DeepWalk在优化过程中收敛速度和样本数量的关系。可以看到:LINE(2nd)始终优于LINE(1st)和DeepWalk,并且LINE(1st)和LINE(2nd)收敛速度都快于DeepWalk。注意:这里的样本量指的是模型训练过程中见过的总样本量,包括重复的样本。由于

batch-size = 1,因此每个sample需要一个迭代step,因此样本数量也等于迭代step。

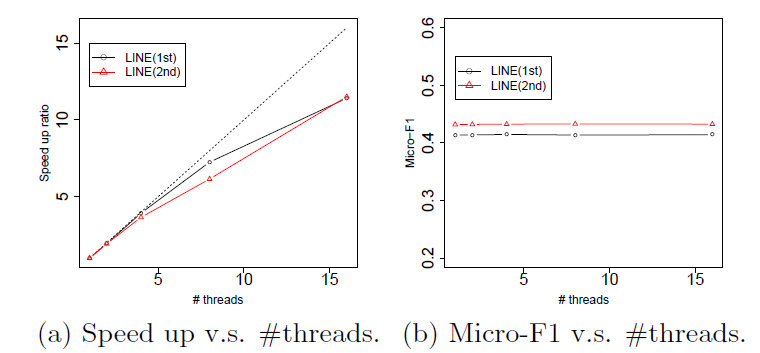

2.2.7 可扩展性

最后,我们研究了采用边采样和异步随机梯度下降法的

LINE模型的可扩展性scalability。我们部署了多线程进行优化。- 图

a给出了在YouTube数据集上的线程数及其加速比。可以看到线程加速比接近线性。 - 图

b给出了使用多线程进行模型更新时,模型性能的波动。可以看到采用多线程训练模型时,模型的最终性能保持稳定。

这两个结果表明:

LINE模型具有很好的可扩展性(即并行度)。

- 图

三、GraRep[2015]

在许多实际问题中,信息通常是使用图来组织的。例如,在社交网络研究中,基于社交图

social graph将用户分类为有意义的社交群组social group在很多实际application中有用,例如用户搜索user search、定向广告targeted advertising、以及推荐recommendation。因此,从图中准确地学习有用的信息至关重要。一种策略是学习图的graph representation:图中的每个顶点都用一个低维向量来表达,这个低维向量可以准确地捕获图所传达的语义信息semantic information、关系信息relational information、以及结构信息structural information。最近,人们对从数据中学习

graph representation的兴趣激增。例如,最近的一个模型DeepWalk使用均匀采样(也称作截断的随机游走truncated random walk)将图结构转换为由顶点组成的线性序列的样本集合。SkipGram模型最初设计用于从线性序列中学习word representation,也可用于从此类样本(即顶点组成的线性序列的样本)中学习顶点的representation。尽管这种方法在经验上是有效的,但是人们并不清楚在学习过程中所涉及的、图上定义的、确切exact的损失函数是什么。在论文

《GraRep: Learning Graph Representations with Global Structural Information》中,作者首先提出了在图上定义的SkipGram模型的显式损失函数。论文表明:本质上,我们可以使用SkipGram模型以不同的 值来捕获图中每个顶点与其k-step邻居之间的k-step关系()。SkipGram模型的一个缺陷是:它将所有这些k-step关系信息投影到一个公共子空间中。论文认为,这种简单的处理可能会导致潜在的问题。通过在不同的子空间中保存不同的k-step关系信息,论文提出的模型GraRep克服了上述限制。最近人们提出的另一个工作是

LINE,它有一个损失函数来同时捕获1-step局部关系信息local relational information和2-step局部关系信息。为了捕获此类局部信息中的某些复杂关系,他们还从此类数据中学习非线性变换(LINE用到了sigmoid函数,但是本质上LINE是广义线性函数)。虽然他们的模型不能很容易地扩展到捕获k-step()关系信息来学习他们的graph representation,但是他们提出了一个重要策略来提高模型的效果:对于degree较小的顶点,考虑高阶邻域。这一策略在某种程度上隐式地将某些k-step信息捕获到他们的模型中。GraRep的作者相信:对于不同的k值,不同顶点之间的k-step关系型信息揭示了与图相关的、有用的全局结构信息,并且在学习良好的graph representation时显式地充分利用这一点至关重要。在论文

《GraRep: Learning Graph Representations with Global Structural Information》中,作者提出了GraRep,这是一种为知识管理knowledge management学习graph representation的新模型。该模型通过操作在图中定义的、不同的全局转移矩阵global transition matrix,直接从图中的顶点中捕获具有不同 值的、不同k-step关系信息,而不涉及缓慢slow的、复杂complex的采样过程。与现有工作不同,GraRep模型定义了不同的损失函数来捕获不同的k-step局部关系信息(即不同的 )。论文使用矩阵分解matrix factorization技术优化每个模型,并通过组合从不同模型中学到的不同representation来构建每个顶点的全局representation。这种学到的全局represetnation可以用作下游任务的特征。论文对

GraRep模型进行了正式的处理formal treatment,并展示了GraRep模型与之前几个模型之间的联系。论文还通过实验证明了学到的representation在解决几个现实世界问题中的有效性。具体而言,论文对语言网络聚类任务、社交网络多标签分类任务、以及引文网络可视化任务进行了实验。在所有这些任务中,GraRep优于其它graph representation方法,从而证明了GraRep学到的全局representation可以有效地用作聚类、分类、可视化等任务的特征。并且,GraRep可以简单地并行化。论文贡献如下:

论文引入了一种新模型来学习图上顶点的潜在

representation,该模型可以捕获与图相关的全局结构信息。论文从概率的角度提供了对

DeepWalk中用于学习graph representation的均匀采样方法的理解,该均匀采样方法将图结构转换为线性序列。此外,论文在图上显式定义了

DeepWalk的损失函数,并将其扩展为支持加权图。论文正式分析了带有负采样

SkipGram模型(skip-gram model with negative sampling: SGNS)相关的缺陷。论文的模型定义了一个更准确accurate的损失函数,该损失函数允许集成不同局部关系信息的非线性组合。

相关工作:

线性的序列

representation方法Linear Sequence Representation Method:由单词的stream组成的自然语言语料库可以视为一种特殊的图结构,即线性链linear chain。目前,学习word representation有两种主流方法:神经嵌入neural embedding的方法、基于矩阵分解matrix factorization based的方法。神经嵌入方法采用固定长度的滑动窗口捕获当前单词的

context words。人们提出了像SkipGram这样的模型,这些模型提供了一种学习word representation的有效方法。虽然这些方法可能会在某些任务上产生良好的性能,但是它们不能很好地捕获有用的信息,因为它们使用独立的、局部的上下文窗口,而不是全局共现计数global co-occurrence count。另一方面,矩阵分解方法可以利用全局统计。先前的工作包括潜在语义分析

Latent Semantic Analysis: LSA,该方法分解term-document矩阵从而产生潜在语义representation。《Producing high-dimensional semantic spaces from lexical co-occurrence》提出了Hyperspace Analogue to Language: HAL,它分解一个word-word共现计数矩阵来生成word representation。《Extracting semantic representations from word co-occurrence statistics: A computational study》提出了用于学习word representation的、shifted positive Pointwise Mutual Information: PMI矩阵的矩阵分解,并表明带负采样的SkipGram模型(Skip-Gram model with Negative Sampling: SGNS)可以视为隐式的这样的一个矩阵。

图表示

Graph Representation方法:存在几种学习低维graph representation的经典方法,如多维缩放multidimensional scaling: MDS、IsoMap、LLE、Laplacian Eigenmaps。最近,

《Relational learning via latent social dimensions》提出了学习图的潜在representation向量的方法,然后可以用于社交网络分类。《Distributed large-scale natural graph factorization》提出了一种图分解方法,该方法使用随机梯度下降来优化大型图中的矩阵。《Deepwalk:Online learning of social Representations》提出了DeepWalk方法,该方法通过使用截断的随机游走算法将图结构转换为多个线性的顶点序列,并使用SkipGram模型生成顶点的representation。《Line: Large-scale information network embedding》提出了一种大规模信息网络的embedding,它优化了一个损失函数从而可以在学习过程中同时捕获1-step关系信息和2-step关系信息。

3.1 模型

3.1.1 图及其 Representation

给定一个图 ,其中 为顶点集合, 为顶点数量, 为边集合。路径

path定义为连接一个顶点序列的边序列。邻接矩阵:定义邻接矩阵为 。

- 对于无权图,如果顶点 到 之间存在边,那么 ,否则 。

- 对于带权图, 为顶点 到 之间边的权重。

尽管边的权重可以为负值,但是这里我们仅考虑正的权重。

度矩阵

degree matrix:定义度矩阵degree matrix为 ,其中:转移概率矩阵

probability transition matrix:假设我们想要捕获从一个顶点到另一个顶点的转移,并假设顶点 转移到顶点 的概率正比于 ,则定义转移概率矩阵probability transition matrix: 。其中 定义了从顶点 经过一步转移到顶点 的概率,因此也称为一阶转移概率矩阵。显然 可以认为是对 按 ”行“ 进行的归一化。

带全局结构信息的

graph representation:给定一个图 ,学习带全局结构信息的graph representation的任务旨在学习图的全局represetation矩阵 ,其中第 行 为图 中顶点 的 维向量,并且这些representation向量可以捕获图的全局结构信息global structural information。在本文中,全局结构信息有两个功能:捕获两个不同顶点之间的长距离关系、根据不同的转移

steps考虑不同的链接。我们将在后面进一步地说明。正如我们之前讨论过的,我们认为在构建这样的全局

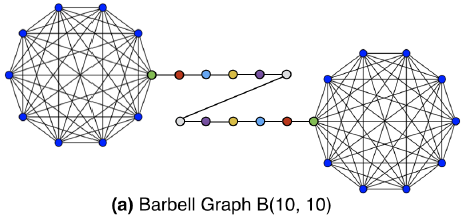

graph representation时需要从图中捕获k-step(具有不同的 )的关系信息。为了验证这一点,下图给出了一些说明性的示例,展示了需要在两个顶点A1和A2之间捕获的、k-step(其中 ) 的关系信息的重要性。图中,粗线表示两个顶点之间的关系较强、细线表示两个顶点之间的关系较弱。在

(a)和(e)中显示了捕获彼此直接连接的、顶点之间简单的1-step信息的重要性,其中(a)具有较强的关系,(e)具有较弱的关系。在

(b)和(f)中显示了2-step信息,其中(b)中两个顶点A1和A2共享许多共同的邻居,而(f)中两个顶点A1和A2仅共享一个邻居。显然,

2-step信息对于捕获两个顶点之间的连接强度很重要:顶点之间共享的共同邻居越多,则它们之间的关系就越强。在

(c)和(g)中显示了3-step信息。具体而言:- 在

(g)中,尽管A1和B之间的关系很强,但是由于连接B和C、以及C和A2的两条较弱的边,A1和A2之间的关系可能会减弱。 - 相比之下,在

(c)中,A1和A2之间的关系仍然很强,因为B和A2之间有大量的共同邻居,这加强了它们的关系。

显然,在学习具有全局结构信息的良好

graph representation时,必须捕获此类3-step信息。- 在

类似地,如

(d)和(h)所示,4-step信息对于揭示图的全局结构特性也至关重要。在(d)中,A1和A2之间的关系明显很强。而在(h)中,A1和A2明显不相关,因为从一个顶点到另一个顶点之间不存在路径。在缺乏4-step关系信息的情况下,无法捕获这种重要的区别important distinction。

我们还认为:在学习

graph representation时,必须区别对待不同的k-step信息。我们在下图的(a)中展示了一个简单的例子。让我们专注于学习图中顶点A的representation。可以看到,A在学习其representation时接收到两种类型的信息:来自顶点B的1-step信息、以及来自顶点C的2-step信息。我们注意到,如果我们不区分这两种不同类型的信息,我们可以构建如图

(b)所示的替代品,其中顶点A接受与(a)完全相同的信息。但是,图(b)具有完全不同的结构。这意味着如何使用

k-step信息很重要,它们位于不同的子空间,应该区别对待。

在本文中,我们提出了一种用于学习准确

graph representation的新的框架,它集成了各种k-step信息,这些信息共同捕获了与图相关的全局结构信息。

3.1.2 图上的损失函数

我们将在这里讨论用于学习具有全局结构信息的

graph representation的损失函数。对于图 ,考虑两个顶点 和 。为了学习全局representation来捕获它们之间的关系,我们需要了解这两个顶点之间的连接强度。让我们从几个问题开始。是否存在从顶点 到顶点 的路径?如果存在,那么假设我们随机采样一条从顶点 开始的路径,我们到达顶点 的可能性有多大?

为了回答这些问题,我们首先令 表示从顶点 刚好通过 步到达顶点 的转移概率。我们已经知道了

1-step转移概率(即矩阵 ),为了计算k-step转移概率,我们引入k-step转移概率矩阵probability transition matrix:可以看到 表示从顶点 刚好通过 步到达顶点 的转移概率。这直接得到 ,其中 为矩阵 的第 行、第 列的元素。

现在考虑一个给定的 。给定一个图 ,考虑从顶点 开始到顶点 结束、并且长度为

k-step的所有路径的集合。这里我们称 为current vertex、 为context vertex。我们的目标旨在最大化:这些pair来自图中的概率、以及其它pair不来自图中的概率。受到

SkipGram模型的启发,我们采用了《Noise-contrastive estimation of unnormalized statistical models, with applications to natural image statistics》提出的噪声对比估计noise contrastive estimation: NCE来定义我们的目标函数。遵循《Neural word embedding as implicit matrix factorization》中提出的类似讨论,我们首先介绍我们在图上定义的k-step损失函数为:其中:

- 描述了顶点 和顶点 之间的

k-step关系,即从顶点 到顶点 的k-step转移概率。 - 为

sigmoid函数,定义为 。 - 表示顶点 作为

current vertex时的representation, 表示顶点 作为context vertex时的representation。二者采用了不同的representation矩阵。 - 为超参数,表示负样本的数量。

- 为

k-step负采样分布, 表示当 服从分布 时的期望值, 是从负采样中获得的负样本。

上式物理意义:

- 第一项为 “正样本” 的加权对数似然,权重为

k-step转移概率,“正样本”为从顶点 所有经过k-step能够到达的顶点集合。 - 第二项为 “负样本”的对数似然。这里负样本没有加权。

和

DeepWalk相比,GraRep的重要区别在于它对正样本进行了加权。期望部分可以重写为:

因此对于特定的顶点

pair对 ,定义其局部损失函数local loss为:其物理意义为:

- 对于从 经过

k-step到达的顶点 ,其损失为作为正样本的加权对数似然(权重为k-step转移概率),加上作为负样本的加权对数似然(权重为k-step采样概率)。 - 对于从 无法经过

k-step到达的顶点 ,其损失为作为负样本的加权对数似然(权重为k-step采样概率)。

k-step负采样分布 可以计算为:其物理意义为:以概率 随机选择一个顶点,然后经过

k-step转移到顶点 的概率。这里 是选择 作为路径中第一个顶点的概率,我们假设它服从均匀分布,即 。因此得到:则

k-step损失函数为:为最小化 则只需要最小化每个成分,即求解: 。令 ,求解:

得到最优解:

其中 。

可以得到结论:我们本质上需要将矩阵 分解为两个矩阵 和 ,其中 的每一行和 的每一行分别由顶点 和顶点 的向量

representation组成。其中矩阵 的元素定义为:现在我们已经定义了我们的损失函数,并表明优化该损失函数本质上涉及到矩阵分解问题。

- 描述了顶点 和顶点 之间的

在这项工作中,我们为每条路径设置最大长度。换句话讲,我们假设 。实际上,当 足够大时,转移概率会转移到某些固定值。

3.1.3 矩阵分解的最优化

遵从

《Neural word embedding as implicit matrix factorization》的工作,为了降低噪音,我们将 中的所有负数都替换为0。因为若存在负数,则图中存在的 阶顶点pair对的概率 。这使得我们得到一个正的k-step概率矩阵 ,其中:虽然存在各种矩阵分解技术,但是在这项工作中,由于其简单性,我们将重点放在流行的奇异值分解

singular value decomposition: SVD方法上。SVD已经在多个矩阵分解任务中取得成功,被认为是可用于降维的重要方法之一。对于矩阵 ,

SVD分解为:其中:

- 均为正交矩阵。

- 为对角矩阵,对角线元素为按降序排列的矩阵奇异值。

我们可以用 来近似原始的矩阵 ,即:

其中: 为最大的 个奇异值, 为 的前 列, 为 的前 列。它们的物理意义为: 、 最大的

d个特征值对应的特征向量。通过这种方式,我们可以分解我们的矩阵 为:

其中 。 的每一行给出了各顶点作为当前顶点的

representation向量, 的每一行给出了各顶点作为上下文顶点的representation向量。最终我们返回矩阵 作为顶点的 维representation,它在图中捕获了k-step全局结构信息。在我们的算法中,我们考虑所有 阶转移,其中 是预定义的常数。我们在学习

graph representation时整合了所有这些k-step信息,这将在接下来讨论。注意,这里我们实际上是在寻找从 的行空间到具有低秩的 的行空间的投影。因此,也可以利用流行的

SVD以外的替代方法,包括incremental SVD、独立成分分析independent component analysis: ICA、神经网络DNN。 我们这项工作的重点是学习graph representation的新模型,因此矩阵分解技术不是我们的重点。事实上,如果在这一步使用诸如稀疏自编码器之类的替代方法,则相对难以证明我们

representation的实验效果是由于我们的新模型、还是由于降维步骤引入的任何非线性。为了保持与《Neural word embedding as implicit matrix factorization》工作的一致性,这里我们只使用了SVD。

3.1.4 GraRep 算法

这里我们详细介绍我们的学习算法。通常,

graph representation被提取为其它任务的特征,例如分类、聚类。在实践中,编码k-step representation的一种有效方法是将k-step representation拼接起来作为每个顶点的全局特征,因为每个不同的step representation反映了不同的局部信息。GraRep算法:算法输入:

- 图的邻接矩阵

- 最大转移阶数

- 对数偏移系数

- 维度

算法输出:顶点的

representation矩阵算法步骤:

计算 阶转移概率矩阵 。计算流程:

首先计算 ,然后依次计算 。

对于带权图, 是一个实数矩阵;对于无权图, 是一个

0-1矩阵。算法都能够处理。对 迭代计算每个顶点的

k-step representation,计算流程:获取正的对数概率矩阵 :

首先计算 ,其中 ;然后计算:

计算

representation矩阵 :

拼接所有的 阶表达:

未来工作:

- 研究矩阵操作有关的近似计算和在线计算。

- 研究通过深度架构代替

SVD矩阵分解来学习低维representation。

3.1.5 SkipGram 作为 GraRep 特例

GraRep旨在学习grap representation,并且我们基于矩阵分解来优化损失函数。另一方面,SGNS已被证明在处理线性结构(如自然语言的句子)方面是成功的。GraRep和SGNS之间有内在的联系吗?这里我们将SGNS视为GraRep模型的一个特例。

a. 图 SkipGram 模型的损失函数

SGNS旨在以线性序列的方式来表达单词,因此我们需要将图结构转换为线性结构。DeepWalk揭示了一种均匀采样(截断的随机游走)的有效方法。该方法首先从图中随机均匀采样一个顶点,然后随机游走到它的一个邻居并重复这个随机游走过程。如果顶点序列长度达到某个预定值,则停止随机游走并开始生成新的序列。该过程可用于从图中生成大量序列。本质上,对于无权图,这种均匀采样的策略是有效的。但是对于加权图,需要一种基于边权重的概率性采样方法,而

DeepWalk中没有采用这种方法。在本文中,我们提出了一种适用于加权图的增强型SGNS方法Enhanced SGNS: E-SGNS。我们还注意到,DeepWalk优化了一个不同于负采样的、替代的损失函数alternative loss function(即hierarchical softmax)。首先,我们考虑图上的、所有

K-step的损失 :其中 为一个线性函数: 。

我们关注特定于

pair的损失,它们是图中第 个顶点和第 个顶点。定义 ,其中 。这里 为 步之内的概率转移矩阵, 表示从顶点 不超过 步转移到顶点 的概率。

则损失函数重写为:

同样的推导过程可以解得最优解:

其中其中 。

定义矩阵 ,其中:

则 为

E-SGNS的被分解矩阵factorized matrix。E-SGNS和GraRep模型的区别在于 的定义:E-SGNS可以认为是K-step loss的线性组合,每个loss的权重相等。E-SGNS和SGNS的主要区别在于对正样本的加权:E-SGNS的正样本权重为 ,即从顶点 不超过 步转移到顶点 的概率。我们的

GraRep模型没有做出如此强的假设,但允许在实践中从数据中学习它们的关系(比如,潜在的非线性关系)。直觉上,不同的

k-step转移概率应该有不同的权重。对于异质网络数据heterogeneous network dat,这些损失的线性组合可能无法达到理想的效果。

b. 采样与转移概率之间的内在联系

在我们的方法中,我们使用转移概率来衡量顶点之间的关系。这合理吗?在这里,我们阐明了采样了转移概率之间的内在联系。

在随机游走生成的序列中,我们假设顶点 一共出现的次数为:

其中 是与 相关的变量。

我们将顶点 视为当前顶点,则顶点 为 直接邻居(

1-step距离)的次数的期望为:这对于无权图的均匀采样、或者对于加权图的非均匀采样都成立。

进一步地,顶点 为 二阶邻居(

2-step距离)的次数的期望为:其中 为连接顶点 和 的任意其它顶点,即 为顶点 和 的共享邻居。

类似地,我们可以推导出 的方程:

然后,我们将它们相加并除以 ,得到:

其中 为顶点 和顶点 在 步内共现的期望次数。

根据 的定义,我们有: 。

现在,我们可以计算将顶点 作为上下文顶点的期望次数 为: ,其中我们考虑从所有可能顶点 到顶点 的转移。

最后,我们将所有这些期望计数代入 的方程,得到:

定义数据集中所有观察到的

pair的集合为 ,则 ,因此有:矩阵 变得与

《Neural word embedding as implicit matrix factorization》中描述的SGNS完全相同。这表明

SGNS本质上是我们GraRep模型的一个特殊版本,它可以处理从图中采样的线性序列。我们的方法相比缓慢的、昂贵的采样过程有若干优点,并且采样过程通常涉及几个要调整的超参数,例如线性序列的最大长度、每个顶点开始的序列数量等等。

3.2 实验

这里我们通过实验评估

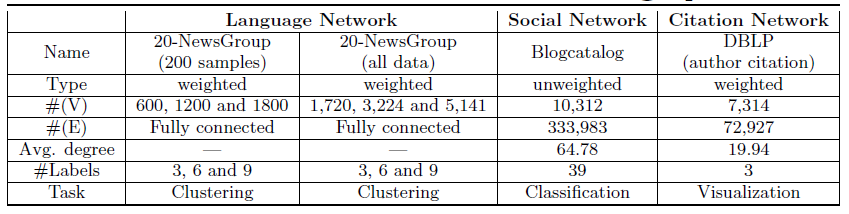

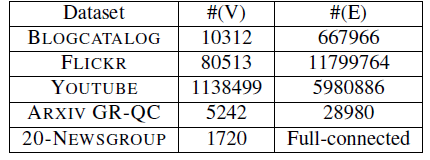

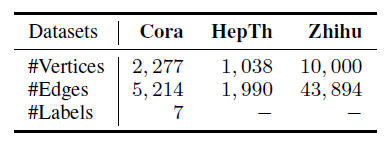

GraRep模型的有效性。我们针对几个不同的任务在几个真实世界数据集上进行了实验,并与baseline算法进行了比较。数据集和任务:为了证明

GraRep的性能,我们在三种不同类型的图上进行了实验,社交网络social network、语言网络language network、引文网络citation network,其中包括加权图和无权图。我们对三种不同类型的任务进行了实验,包括聚类clustering、分类classification,、以及可视化visualization。正如我们前面提到的,我们工作的重点是提出一个新的框架,用于学习具有全局结构信息的、图的良好representation,旨在验证我们提出的模型的有效性。因此,除了SVD之外,我们不采用其它更有效的矩阵分解方法,并重点关注以下三个真实世界的数据集:语言网络数据集

20-Newsgroup:包含2万篇新闻组文档,并分类为20个不同的组。每篇文档由文档内单词的tf-idf组成的向量来表示,并根据余弦相似度计算得到文档的相似度。根据文档的这些相似度构建语言网络,该网络是一个全连接的带权图,用于聚类效果的评估。为验证模型的鲁棒性,论文分别从

3/6/9个不同的新闻组构建了三个更小规模的语言网络(NG代表Newsgroups):3-NG:由comp.graphics, comp.graphics and talk.politics.guns这三个新闻组的文档构成。6-NG:由alt.atheism, comp.sys.mac.hardware, rec.motorcycles, rec.sport.hockey, soc.religion.christian and talk.religion.misc这六个新闻组的文档构成。9-NG:由talk.politics.mideast, talk.politics.misc, comp.os.ms- windows.misc, sci.crypt, sci.med, sci.space, sci.electronics, misc.forsale, and comp.sys.ibm.pc.hardware这九个新闻组的文档构成。

这些小网络分别使用所有文档

all data,以及每个主题随机抽取200篇文档两种配置。每个文档上的topic label被认为是ground truth。这些

toplic label被认为是聚类的真正cluster id。社交网络数据集

Blogcatalog:它是一个社交网络,每个顶点表示一个博客作者,每条边对应作者之间的关系。每个作者都带有多个标签信息,标签来自39种主题类别。该网络是一个无权图,用于多标签分类效果的评估。我们的模型以及

baseline算法生成的graph representation被视为特征。引文网络数据集

DBLP Network:它是一个引文网络,每个顶点代表一个作者,边代表一个作者对另一位作者的引用次数。我们选择六个热门会议并分为三组:数据挖掘

data mining领域的WWW,KDD会议、机器学习machine learning领域 的NIPS,IML 会议、计算机视觉computer vision领域的CVPR,ICCV会议。我们使用可视化工具

t-SNE来可视化所有算法学到的representation,从而提供学到的representation的定性结果和定量结果。

总而言之,我们对加权图和无权图、稀疏图和稠密图进行了实验,其中执行了三种不同类型的学习任务。这些数据集的更多细节如下表所示。

baseline方法:我们使用以下graph representation方法作为baseline。LINE:LINE是最近提出的一种在大规模信息网络上学习graph representation的方法。LINE根据顶点之间的1-step和2-step关系信息定义了一个损失函数。一种提升small degree顶点的性能的策略是:扩展它们的邻域使得图更稠密。如果将1-step关系信息的representation和2-step关系信息的representation拼接起来,并调节邻域最大顶点的阈值,则LINE将获得最佳性能。DeepWalk:DeepWalk是一种学习社交网络representation的方法。原始模型仅适用于无权图。对于每个顶点,截断的随机游走用于将图结构转换为线性序列。带hierarchical softmax的SkipGram模型用作损失函数。E-SGNS:SkipGram是一种有效的模型,可以学习大型语料库中每个单词的representation。对于这个增强版本,我们首先对无权图使用均匀采样、对加权图使用与边权重成正比的概率性采样(即随机游走),从而生成顶点序列。然后引入SGNS进行优化。这种方法可以视为我们模型的一个特例,其中每个

k-step信息的不同representation向量进行均值池化。Spectral Clustering:谱聚类是一种合理的baseline算法,旨在最小化归一化割Normalized Cut:NCut。与我们的方法一样,谱聚类也对矩阵进行分解,但是它侧重于图的不同矩阵:拉普拉斯矩阵Laplacian Matrix。本质上,谱聚类和E-SGNS的区别在于它们的损失函数不同。

参数配置:

对于

LINE模型:batch-size=1,学习率为0.025,负采样系数为5,迭代step总数为百亿级。我们还还将

1-step关系信息representation和2-step关系信息representation拼接起来 ,并针对degree较小的顶点执行重构策略来达到最佳性能。对于

DeepWalk和E-SGNS模型:窗口大小为10,序列最长长度为40,每个顶点开始的游走序列数量为80。正则化:

LINE,GraRep模型进行 正则化可以达到最佳效果,DeepWalk,E-SGNS模型没有正则化也能达到最佳效果。embedding维度 :为公平比较,Blogcatalog和DBLP数据集的 ,而20-NewsGroup数据集的 。GraRep模型: ;Blogcatalog和DBLP数据集的 ,20-NewsGroup数据集的 。

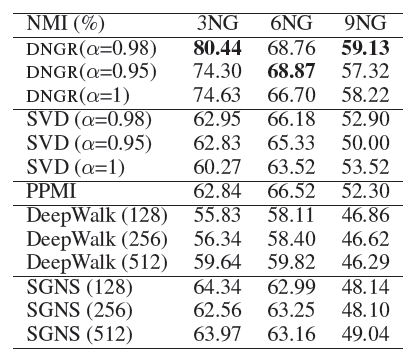

3.3.1 语言网络

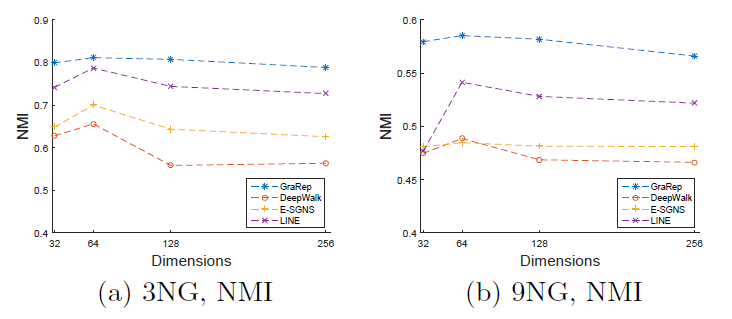

我们通过在

k-means算法中使用学到的representation,通过聚类任务在语言网络上进行实验。为了评估结果的质量,我们报告了每个算法在10次不同运行中的平均归一化互信息Normalized Mutual Information (NMI)得分。为了理解不同维度 在最终结果中的影响,我们还展示了

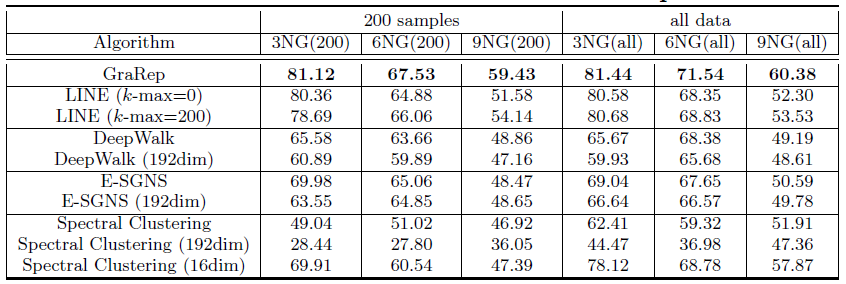

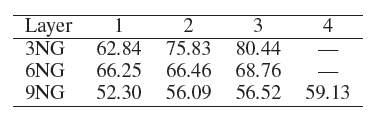

DeepWalk、E-SGNS、Spectral Clustering在 的结果(除了 之外)。对于LINE模型这里采用了重构策略,邻居数量阈值分别设定为k-max = 0,200,500,1000取最佳阈值(最佳阈值为200)。最终结果如下表所示,每列的最佳结果用粗体突出显示。结论:

GraRep模型在所有实验中都优于其它baseline方法。- 对于

DeepWalk, E-SGNS和Spectral Clustering,增加维度 似乎并不能有效提高性能。我们认为:较高的维度并不会为representation提供额外的补充信息。

- 对于

对于

LINE模型采用重建策略确实有效,因为它可以捕获图的额外结构信息,例如超出1-step、2-step的局部信息。- 值得一提的是,

GraRep和LINE模型在很小的Graph上就可以得到良好的性能。我们认为:即使在图很小的条件下,这两个模型也可以捕获丰富的局部关系信息。 - 此外,对于标签较多的任务,例如

9GN,GraRep和LINE可以提供比其它方法更好的性能。 - 一个有趣的发现是:当 时

Spectral Clustering达到最佳性能,但是对其它算法 达到最佳性能。

由于篇幅所限,我们没有报告所有

baseline方法在 时的详细结果,也没有报告LINE的k-max=500, 1000以及没有重建策略的结果。因为这些结果并不比下表的效果更好。后面的实验会进一步探究参数敏感性问题。

- 值得一提的是,

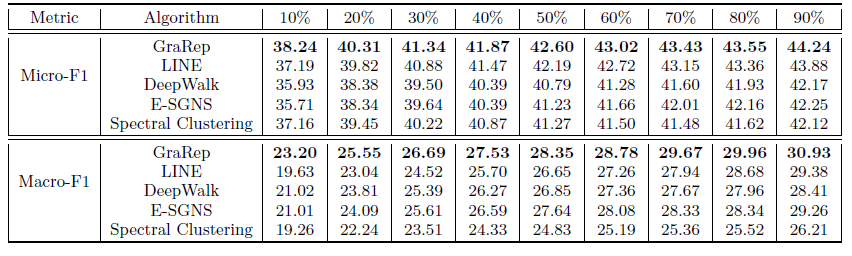

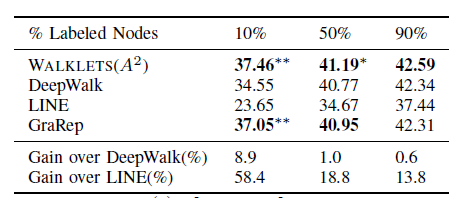

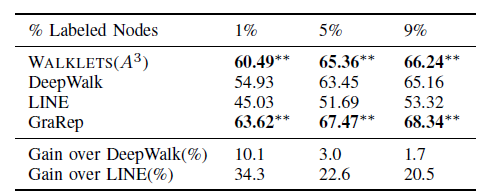

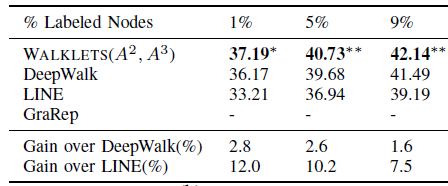

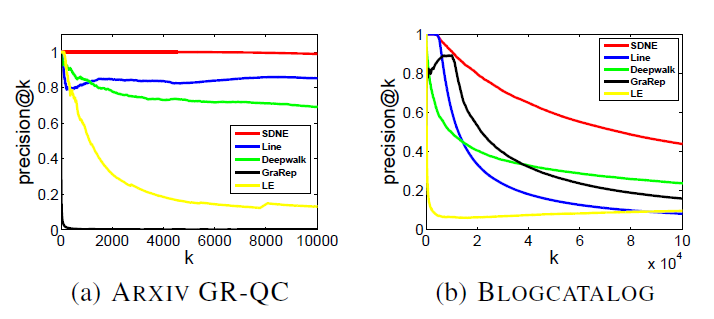

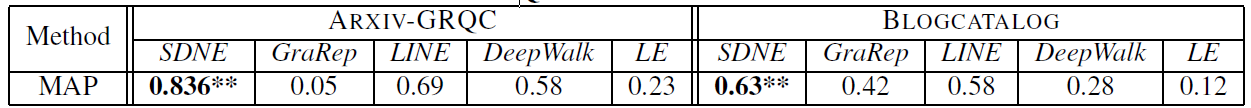

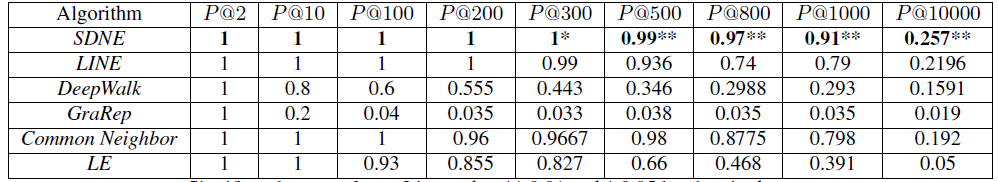

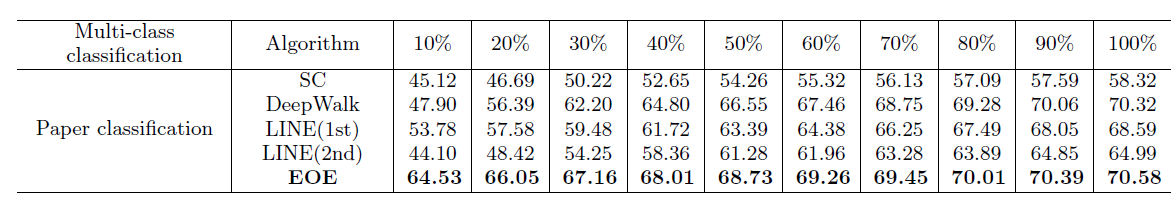

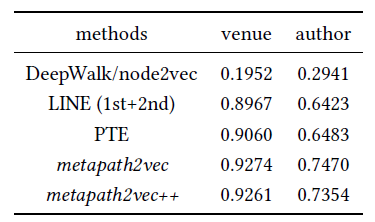

3.3.2 社交网络

在这个实验中,我们专注于社交网络上的监督任务。我们将学到的

representation视为特征,通过多标签分类任务评估不同算法得到的graph representation的有效性。我们使用

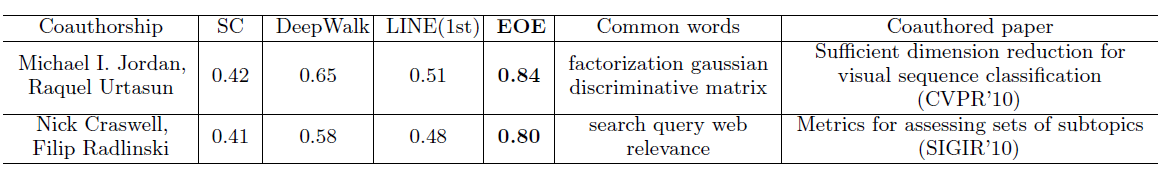

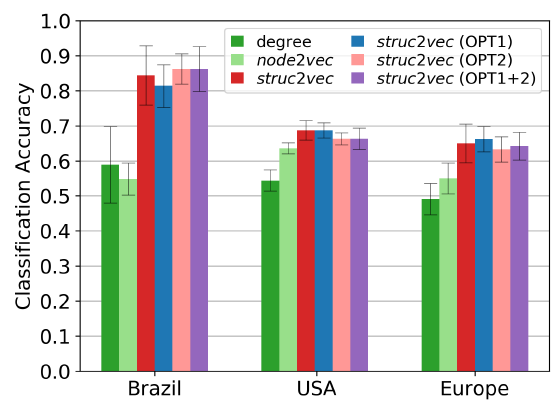

LibLinear package来训练one-vs-rest逻辑回归分类器。我们将这个过程运行10轮并报告平均Micro-F1和Macro-F1指标。对于每一轮,我们随机采样10%~90%的顶点来训练,剩下的顶点作为测试集 。 这里LINE模型采用了重构策略,邻居数量阈值分别设定为k-max = 0,200,500,1000取最佳阈值(最佳阈值为500)。最终结果如下表所示,每列的最佳结果用粗体突出显示。结论:总体上

GraPep性能远超过其它方法,尤其是仅使用10%样本训练。这表明

GraRep学到的不同类型的、丰富的局部结构信息可以相互补充从而捕获到全局结构信息。在与现有的baseline相比具有明显的优势,尤其是在数据稀疏时。

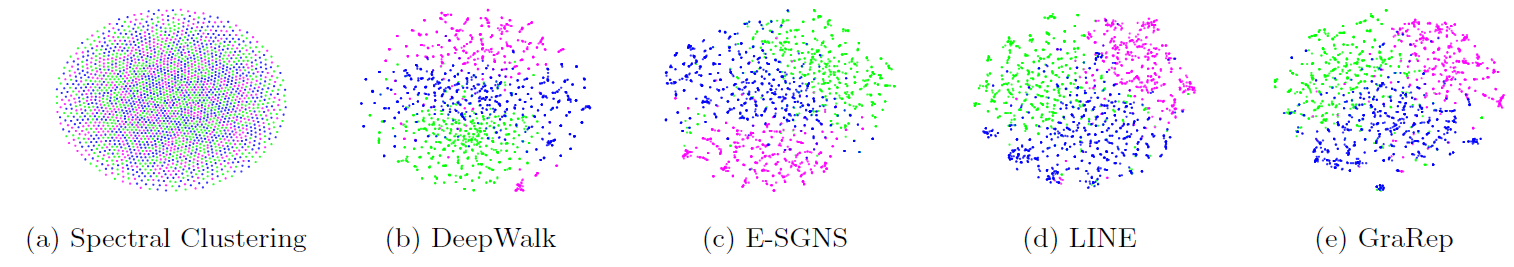

3.3.3 引文网络

在这个实验中,我们专注于通过检查一个真实的引文网络

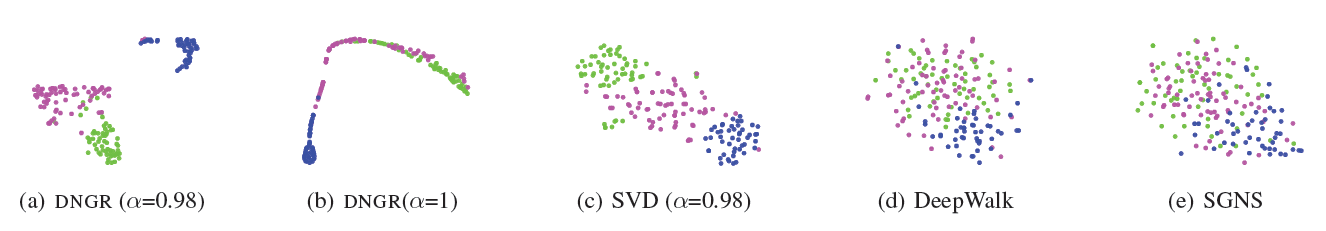

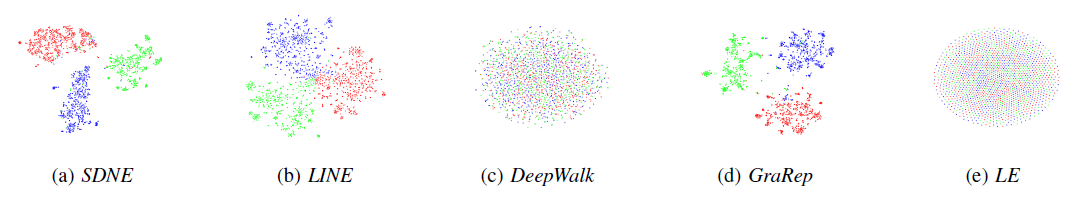

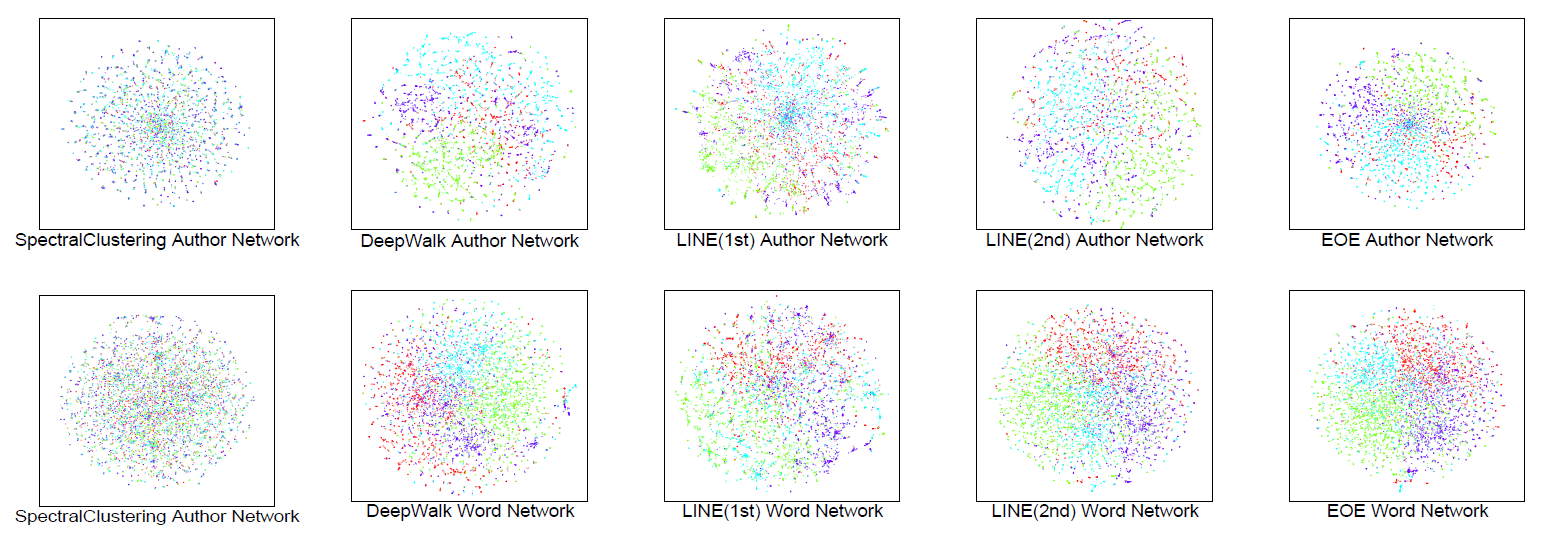

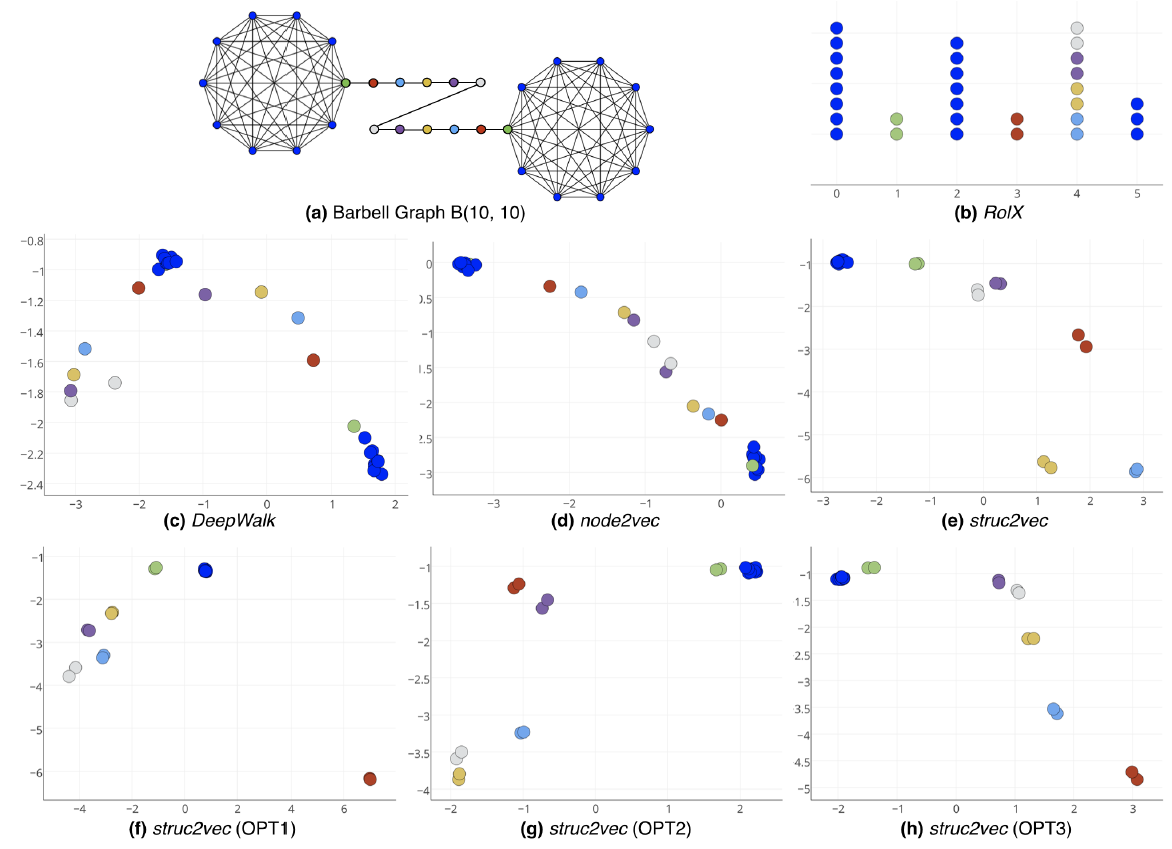

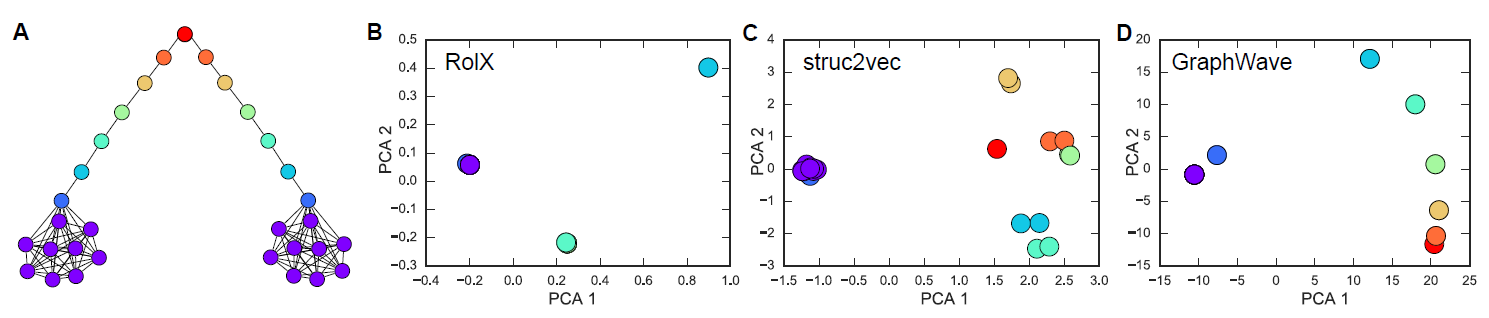

DBLP来可视化学到的representation。我们将学到的graph representation输入到t-SNE工具中来lay out图,其中来自同一个研究领域的作者使用相同的颜色,绿色表示数据挖掘、紫色表示计算机视觉、蓝色表示机器学习。结论:

使用谱聚类的效果一般,因为不同颜色的顶点相互混合。

DeepWalk和E-SGNS结果看起来好得多,因为大多数相同颜色的顶点似乎构成了分组,但是分组的边界似乎不是很明显。LINE和GraRep结果中,每个分组的边界更加清晰,不同颜色的顶点出现在明显可区分的区域中。与

LINE相比GraRep的结果似乎更好,每个区域的边界更清晰。

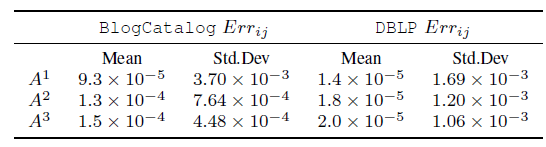

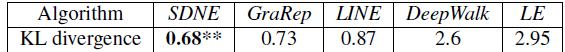

引文网络可视化的

KL散度如下表所示。其中KL散度捕获了 ”成对顶点的相似度” 和 “二维投影距离” 之间的误差。更低的KL散度代表更好的表达能力。可以看到:GraRep模型的顶点representation效果最好。

3.3.4 参数敏感性

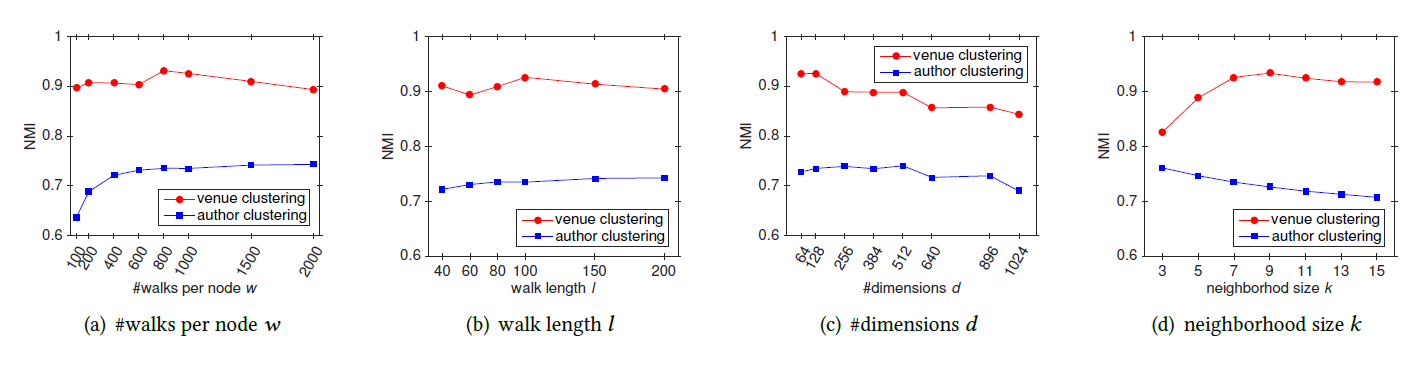

这里我们讨论参数敏感性,具体而言我们评估了最大步长 、维度 对于模型效果的影响。

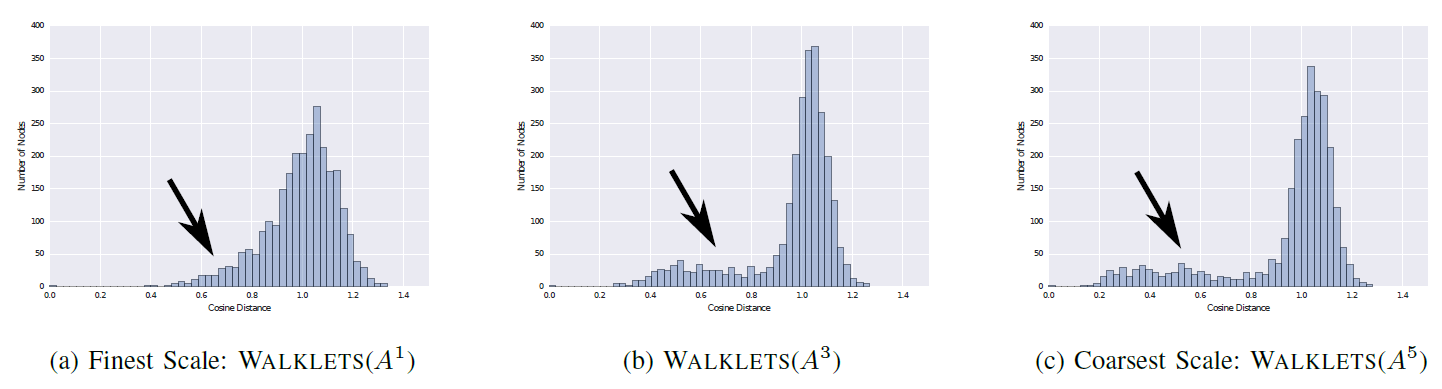

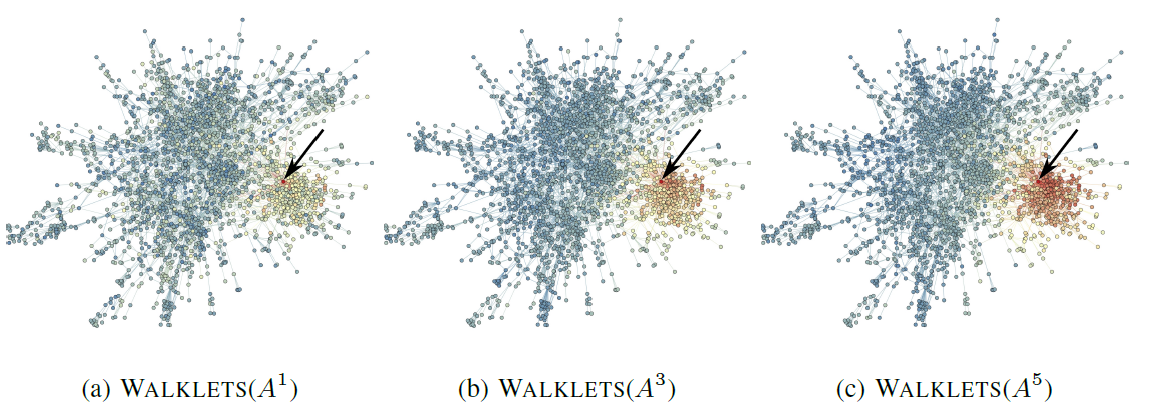

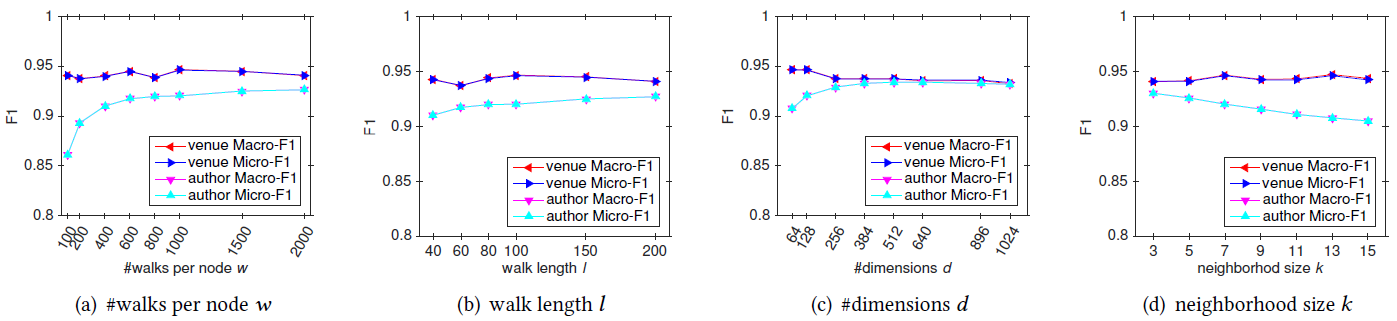

值:下图给出

Blogcatelog数据集上不同 值对应得Micro-F1和macro-F1得分。为阅读方便,这里仅给出 的结果。因为实验发现: 的结果略好于 ,而 的效果与 相当。可以看到:

比 有明显改善,而 的性能进一步优于 。

这表明:不同的 阶信息可以学到互补的局部信息。

的结果并不比 好多少。

这是因为当 足够大时,学到的 阶信息会减弱并趋于一个稳定的分布。

值:下图给出了

3NG和9NG在不同 配置下不同模型的NMI得分。可以看到:GraRep模型结果始终优于其它模型。- 几乎所有算法都在 时取得最佳性能,当 从

64继续增加到更大值时所有算法效果都开始下降。

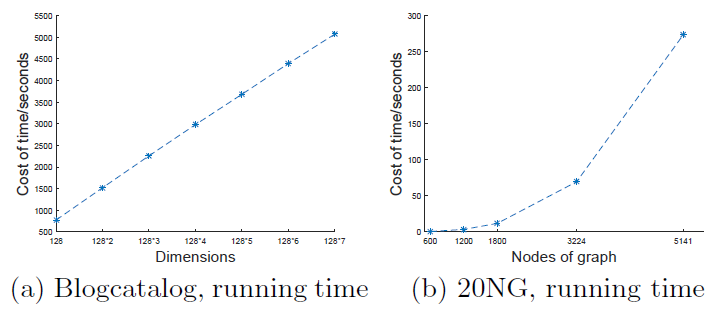

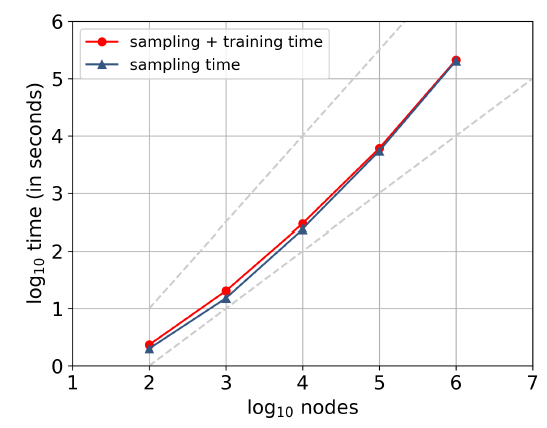

运行时间:下图给出不同总维度和不同图大小时模型的运行时间。总维度等于 ,它代表最终

GraRep拼接得到的representation向量。图

a给出了 且 时,模型在Blogcatalog数据集上的模型训练时间。可以看到:模型训练时间随着总维度的增加而几乎线性增加。

图

b给出了在20-NewsGroup数据集不同规模的网络上训练的时间。可以看到:随着

Graph规模的增长,模型训练时间显著增加。原因是随着Graph增长,矩阵幂运算 和矩阵SVD分解涉及到时间复杂度较高的运算。后续可以考虑采用深度学习来替代

SVD技术来做矩阵分解。

四、TADW[2015]

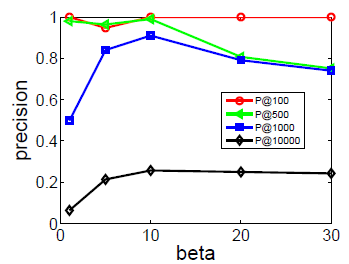

网络在我们的日常生活中无处不在,例如

Facebook用户之间的友谊或学术论文之间的引用。近年来,研究人员广泛研究了网络中许多重要的机器学习应用,例如顶点分类vertex classification、标签推荐tag recommendation、异常检测anomaly detection、链接预测link prediction。数据稀疏data sparsity是这些任务面临的常见问题。为了解决数据稀疏性问题,network representation learning: NRL在统一的低维空间中编码和表达每个顶点。NRL有助于我们更好地理解顶点之间的语义相关性semantic relatedness,并进一步缓解稀疏性带来的不便。NRL中的大多数工作从网络结构中学习representation。例如,social dimensions是计算网络的拉普拉斯Laplacian矩阵或modularity矩阵的特征向量eigenvectors。最近,NLP中的word representation模型SkipGram被引入,用于从社交网络中的随机游走序列中学习顶点的representation,称作DeepWalk。social dimensions和DeepWalk方法都将网络结构作为输入来学习network representation,但是没有考虑任何其它信息。在现实世界中,网络中的顶点通常具有丰富的信息,例如文本内容和其它元数据

meta data。例如,维基百科文章相互连接并形成网络,每篇文章作为一个顶点都包含大量的文本信息,这些文本信息可能对NRL也很重要。因此,论文《Network Representation Learning with Rich Text Information》提出了同时从网络结构和文本信息中学习network representation的想法,即text-associated DeepWalk: TADW。- 一种直接的方法是:分别独立地从文本特征和网络特征中学习

representation,然后将两个独立的representation拼接起来。然而,该方法没有考虑网络结构和文本信息之间复杂的交互interaction,因此通常会导致效果不佳。 - 在现有的

NRL框架中加入文本信息也不容易。例如,DeepWalk在网络中的随机游走过程中,无法轻松地处理附加信息。

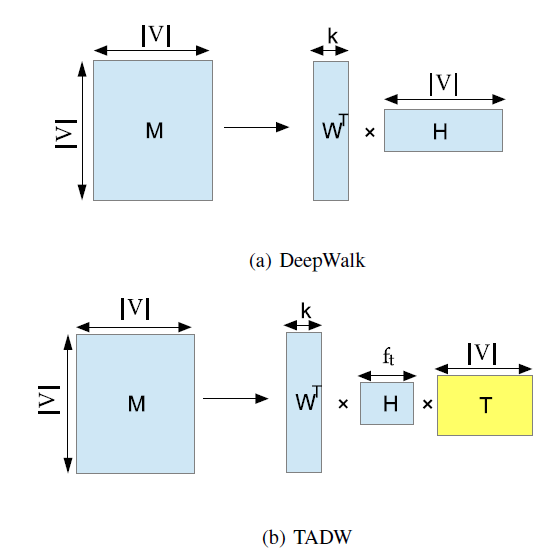

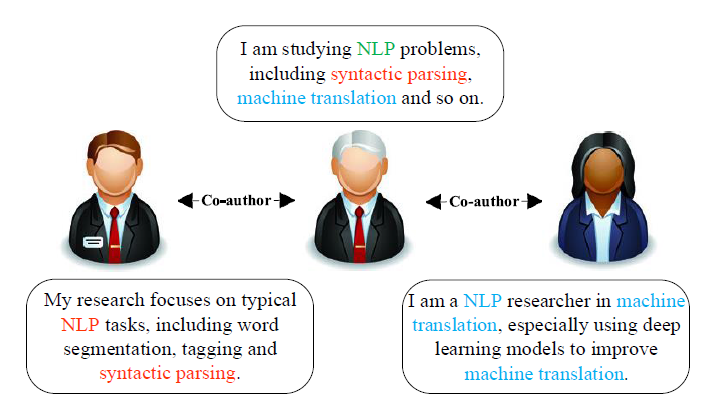

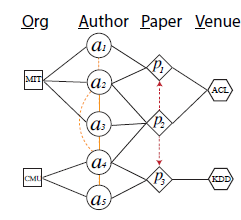

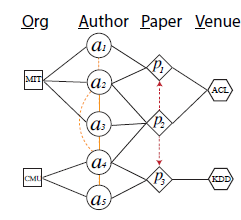

幸运的是,给定网络 ,论文证明

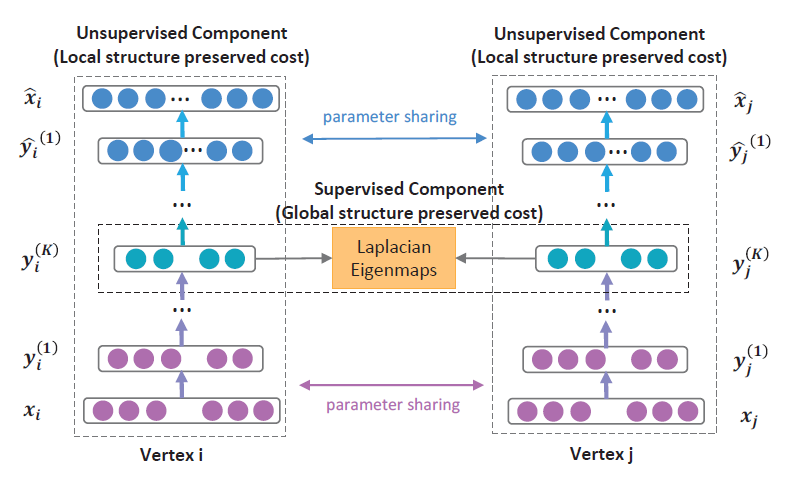

DeepWalk实际上是分解矩阵 ,其中每一项 是顶点 以固定steps随机游走到顶点 的平均概率的对数。下图(a)展示了MF风格的DeepWalk:将矩阵 分解为两个低维矩阵 ,其中 。DeepWalk将矩阵 作为顶点representation。我们将在后面进一步详细介绍。

DeepWalk的矩阵分解视角启发了作者将文本信息引入到NRL的MF中。如上图(b)展示了论文方法的主要思想:将矩阵 分解为三个矩阵的乘积: ,其中 为文本特征矩阵。然后论文拼接 和 作为每个顶点的 维的representation。论文在三个数据集上针对多个

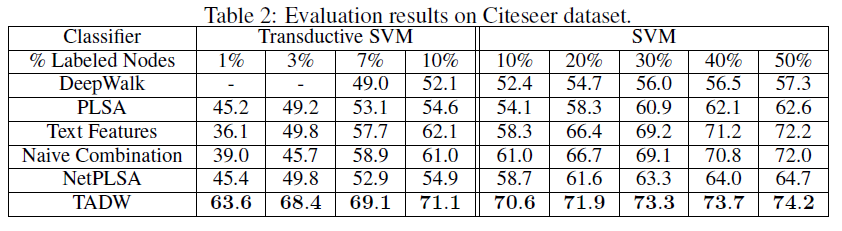

baseline测试了TADW算法。当训练集比率training ratio在10% ~ 50%的范围内时,TADW的representation的分类准确率比其它baseline高达2% ~ 10%。当训练集比率小于10%时,论文还使用半监督分类器Transductive SVM: TSVM测试这些方法。TADW在1%的训练集比率下,相比其它baseline方法提升了5% ~ 20%,尤其是在网络信息包含噪音的情况下。论文主要贡献:

- 论文证明了

DeepWalk算法实际上分解了一个矩阵 ,并找出了 的封闭形式closed form。 - 论文将文本特征引入

NRL,并相比其它baseline获得了5% ~ 20%的优势,尤其是在训练集比率较小的情况下。

- 一种直接的方法是:分别独立地从文本特征和网络特征中学习

相关工作:

representation learning广泛应用于计算机视觉、自然语言处理、knowledge representation learning。一些研究集中在NRL,但它们都无法泛化来处理顶点的其它特征。据作者所知,很少有工作致力于考虑NRL中的文本信息。有一些主题模型

topic model,如NetPLSA,在主题建模时同时考虑了网络和文本信息,然后可以用主题分布topic distribution来表示每个顶点。在本文中,作者以NetPLSA作为baseline方法。

4.1 模型

4.1.1 DeepWalk 作为矩阵分解

公式化

NRL:给定网络 ,我们希望为每个顶点 构建一个低维representation向量 ,其中 。作为一种稠密的real-valued representation, 可以缓解邻接矩阵等network representation的稀疏性。我们可以将 视为顶点 的特征,并将这些特征应用到许多机器学习任务中,如顶点分类。这些特征可以方便地提供给许多分类器,例如逻辑回归、SVM。注意,representation不是特定于任务task-specific的,可以在不同任务之间共享。我们首先介绍

DeepWalk,然后给出DeepWalk和矩阵分解之间的等价证明。

a. DeepWalk

DeepWalk首次将应用广泛的分布式word representation方法SkipGram引入到社交网络的研究中,从而根据网络结构来学习vertex representation。DeepWalk首先生成短的随机游走short random walk(短的随机游走也被用作相似性度量)。给定一条由随机游走生成的顶点序列 ,我们将顶点 视为中心顶点 的上下文,其中 为窗口大小window size。遵循SkipGram的思想,DeepWalk旨在最大化随机游走顶点序列 中所有vertex-context pair的平均对数概率average log probability:其中 以

softmax函数的方式来定义:其中 :

- 为顶点 作为

center vertex时的represetation向量。 - 为顶点 作为

context vertex时的representation向量。

即,每个顶点 有两个

representation向量:当 作为center vertex时的 、当 作为context vertex时的 。之后,

DeepWalk使用SkipGram和Hierarchical Softmax从随机游走生成的序列中学习顶点的representation。注意,Hierarchical Softmax是用于加速的softmax的变体。- 为顶点 作为

b. 等价性证明

假设一个

vertex-context集合 是从随机游走序列中生成,其中每个元素为一个vertex-context pair。定义vertex集合为 ,定义context集合为 ,并且大多数情况下 。DeepWalk将一个vertex嵌入到一个 维向量 。另外,一个context被嵌入到一个 维向量 。令 为所有vertex embedding组成的矩阵,其中第 行表示顶点 的vertex representation。令 为 所有context embedding组成的矩阵,其中第 行表示顶点 的context representation。我们的目标是找出矩阵 的封闭形式closed form,其中 。现在我们考虑一个

vertex-context pair。定义 为 出现在 中的次数, 为vertex出现在 中的次数, 为context出现在 中的次数。《Neural word embedding as implicit matrix factorization》已经证明:当维度 足够大时,带负采样的SkipGram(SkipGram with Negative Sampling: SGNS) 相当于隐式地分解word-context矩阵 。其中 的元素为:其中 为每个

word-context pair的负样本数量。可以解释为

word-context pair的Pointwise Mutual Information: PMI的 偏移。类似地,我们可以证明带

softmax的SkipGram相当于分解矩阵 ,其中:我们现在讨论

DeepWalk中的 代表什么。显然,vertex-context pair的采样方法会影响矩阵 。假设网络是连通connected和无向undirected的,窗口大小为 。我们将基于DeepWalk算法的理想ideal的采样方法来讨论 ,,以及 :- 首先我们生成一条足够长的随机游走序列 。令 表示随机游走序列 上位置 的顶点。

- 然后我们将

vertex-context pair添加到 中,当且仅当 。

就是顶点 在随机游走中出现的频率,也就是 的

PageRank值。 为在 的左侧或右侧 个邻居中观察到 的期望次数。现在我们尝试基于这种理解来计算 。将

PageRank中的转移矩阵表示为 。令 为顶点 的degree,则有:我们使用 来表示一个 维的行向量,其中除了第 项为

1之外其它项均为零。假设我们从顶点 开始随机游走并使用 表示初始状态。那么 是所有顶点的分布,它的第 项是顶点 随机游走到顶点 的概率。因此, 的第 项是顶点 以恰好 步随机游走到顶点 的概率,其中 是矩阵 的 次幂。因此, 的第 项是 出现在 的右侧 个邻居中的期望次数。因此我们有:上述证明也适用于有向图。因此,我们可以看到 为顶点 在 步中随机游走到顶点 的平均概率的对数。

通过证明

DeepWalk等价于矩阵分解,我们提出融合丰富的文本信息到基于DeepWalk派生的矩阵分解中。

4.1.2 TADW

- 这里我们首先简要介绍低秩矩阵分解,然后我们提出从网络和文本信息中学习

representation的方法。

a. 低秩矩阵分解

矩阵是表示关系型数据

relational data的常用方法。矩阵分析的一个有趣主题是通过矩阵的一部分项来找出矩阵的内在结构。一个假设是矩阵 可以用低秩 的另一个矩阵来近似,其中 。然后我们可以在这个假设下用这样一个低秩近似来补全complete矩阵 的缺失值。然而,求解秩约束优化rank constraint optimization始终是NP难的。因此,研究人员求助于寻找矩阵 和 ,从而最小化损失函数 ,并且带有迹范数的约束trace norm constraint(这个约束可以通过在损失函数中添加一个惩罚项从而进一步地移除)。在本文中,我们使用平方损失函数。低秩分解:形式上,令矩阵 的观察集为 。我们希望找到矩阵 和 ,从而最小化损失函数:

其中 表示矩阵的

Frobenius范数, 为正则化系数。归纳矩阵补全:低秩矩阵分解仅基于 的低秩假设来补全矩阵 。如果矩阵 中的

item具有附加特征additional feature,那么我们可以应用归纳矩阵补全inductive matrix completion来利用它们。归纳矩阵补全通过融合两个特征矩阵feature matrix到目标函数中从而利用更多行单元row unit和列单元column unit的信息。假设我们有特征矩阵 和 ,其中 分别为两个矩阵列向量的维度。我们的目标是求解矩阵 和 ,从而最小化:

注意,归纳矩阵补全最初是为了补全具有基因特征和疾病特征的 “基因-疾病”矩阵,其目标与我们的工作有很大不同。受归纳矩阵补全思想的启发,我们将文本信息引入

NRL。

b. TADW

给定一个网络 以及它对应的文本特征矩阵 ,我们提出了文本相关的

DeepWalk(text-associated DeepWalk: TADW)从网络结构 和文本特征 中学习每个顶点 的representaion。回想一下,

DeepWalk分解矩阵 ,其中 。 当 较大时,准确地计算 的计算复杂度为 。实际上,DeepWalk使用基于随机游走的采样方法来避免显式地、精确地计算矩阵 。当DeepWalk采样更多的随机游走序列时,性能会更好,但是计算效率会更低。在

TADW中,我们找到了速度和准确性之间的tradeoff:分解矩阵 。在这里,为了计算效率,我们分解矩阵 而不是 。原因是 比 具有更多的非零项,并且具有平方损失的矩阵分解的复杂度与矩阵 中非零元素的数量成正比。由于大多数现实世界的网络都是稀疏的,即 ,因此计算矩阵 需要 的时间。如果网络是稠密的,我们甚至可以直接分解矩阵 。即使是 的计算复杂度,对于百万甚至亿级顶点的网络而言,这个计算复杂度仍然无法接受。

我们的任务是求解矩阵 和 ,从而最小化:

为了优化 和 ,我们交替最小化 和 ,因为它是 或 的凸函数。虽然

TADW可能收敛到局部最小值而不是全局最小值,但我们的方法在实践中效果很好,如我们的实验所示。也可以直接应用随机梯度下降法来优化。

不同于低秩矩阵分解

low-rank matrix factorization和归纳矩阵补全inductive matrix completion(它们聚焦于补全矩阵 ),TADW的目标是结合文本特征从而获得更好的network representation。此外,归纳矩阵补全直接从原始数据中获得矩阵 ,而我们从MF风格的DeepWalk的推导中人为地构建矩阵 。由于从

TADW获得的 和 都可以视为顶点的低维representation,因此我们可以通过拼接它们为network representation构建一个统一的、 维的矩阵。在实验中,我们将证明统一的representation显著优于将network representation和文本特征(即矩阵 ) 的简单组合。复杂度分析:在

TADW中,计算 的过程需要 的时间。我们使用《Large-scale multi-label learning with missing labels》引入的快速过程来求解TADW的优化问题。最小化 和 的每次迭代的复杂度为 ,其中

nnz(.)为矩阵非零元素的个数。作为比较,传统矩阵分解的复杂度(即低秩矩阵分解的优化问题) 为 。在我们的实验中,优化在10次迭代中收敛。未来工作:针对大规模网络数据场景的

TADW在线学习和分布式学习。另外,还可以研究矩阵分解的其它技术,例如matrix co-factorization,从而包含来自其它来源的丰富信息。

4.2 实验

我们使用顶点分类问题来评估

NRL的质量。正式地,我们得到顶点的低维representation作为顶点特征,然后我们的任务是基于顶点特征用标记顶点集合 来预测未标记顶点集合 的label。机器学习中的许多分类器可以处理这个任务。我们分别选择

SVM和transductive SVM从而进行监督的、半监督的学习和测试。注意,由于representation learning过程忽略了训练集中的顶点label,因此representation learning是无监督的。我们使用三个公开可用的数据集,并使用

representation learning的五种baseline方法来评估TADW。我们从文档之间的链接或引用,以及这些文档的term frequency-inverse document frequency: TF-IDF矩阵(即矩阵 )中学习representation。数据集:

Cora数据集:包含来自七个类别的2708篇机器学习论文。论文之间的链接代表引用关系,共有5429个链接。每篇文档映射为一个1433维的binary向量,每一位为0/1表示对应的单词是否存在。Citeseer数据集:包含来自六个类别的3312篇公开发表出版物。文档之间的链接代表引用关系,共4732个链接。每篇文档映射为一个3703维的binary向量,每一位为0/1表示对应的单词是否存在。Wiki数据集:包含来自十九个类别的2405篇维基百科文章。文章之间的链接代表超链接,共17981个链接。我们移除了没有任何超链接的文档。每篇文章都用内容单词的TFIDF向量来表示,向量维度为4973维。

Cora和Citeseer数据集从标题、摘要中生成短文本作为文档,并经过停用词处理、低频词处理(过滤文档词频低于10个的单词),并将每个单词转化为one-hot向量。Cora、Citeseer数据集平均每篇文档包含18~32个单词,数据集被认为是有向图。Wiki数据集是长文本,平均每篇文档包含640个单词,数据集被认为是无向图。baseline方法及其配置:TADW:通过SVD分解TFIDF矩阵到200维的文本特征矩阵 ,这是为了降低矩阵 的规模。我们也将文本特征矩阵 视为一个content-only的baseline。对于

Cora,Citeseer数据集 ;对于Wiki数据集 。注意:最终每个顶点的

representation向量的维度为 。DeepWalk:DeepWalk是一种network-only representation learning方法。我们选择参数为:窗口尺寸 ,每个顶点的游走序列数量 。对于Cora,Citeseer数据集维度 ,对于Wiki数据集维度 ,这些是在50 ~200之间选择的性能最佳的维度。我们还通过求解“低秩分解”方程并将 和 拼接起来作为顶点

representation从而评估MF-style DeepWalk的性能。结果与DeepWalk相比差不多,因此我们仅报告了原始DeepWalk的性能。pLSA:我们使用PLSA通过将每个顶点视为一个文档来从TF-IDF矩阵训练主题模型。因此,PLSA是content-only baseline方法。PLSA通过EM算法估计文档的主题分布和主题的word分布。我们使用文档的主题分布作为顶点representation。Text Features:使用文本特征矩阵 作为每篇文档的200维representation,这也是一种content-only baseline方法。Naive Combination:直接拼接DeepWalk的embedding向量和文本特征向量。对于Cora,Citeseer数据集这将得到一个300维向量;对于Wiki数据集这将得到一个400维向量。NetPLSA:NetPLSA将文档之间的链接视为网络正则化来学习文档的主题分布,存在链接的文档应该共享相似的主题分布。我们使用网络增强的文档主题分布作为network representation。NetPLSA可以视为一种兼顾网络和文本信息的NRL方法。我们将Cora,Citeseer数据集主题数量设置为160,将Wiki数据集主题数量设置为200。

评估方式:对于监督分类器,我们使用由

Liblinear实现的linear SVM。对于半监督分类器,我们使用SVM-Light实现的transductive SVM。我们对TVSM使用线性核。我们为每个类别训练一个one-vs-rest分类器,并选择linear SVM和transductive SVM中得分最高的类别。我们将顶点的

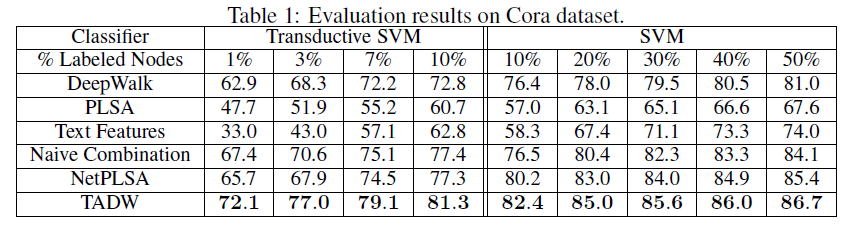

representation作为特征来训练分类器,并以不同的训练比率training ratio来评估分类准确性。训练比率从linear SVM的10% ~ 50%,以及从TSVM的1% ~ 10%不等。对于每个训练比率,我们随机选择文档作为训练集,剩余文档作为测试集。我们重复试验10次并报告平均准确率。实验结果:下表给出了

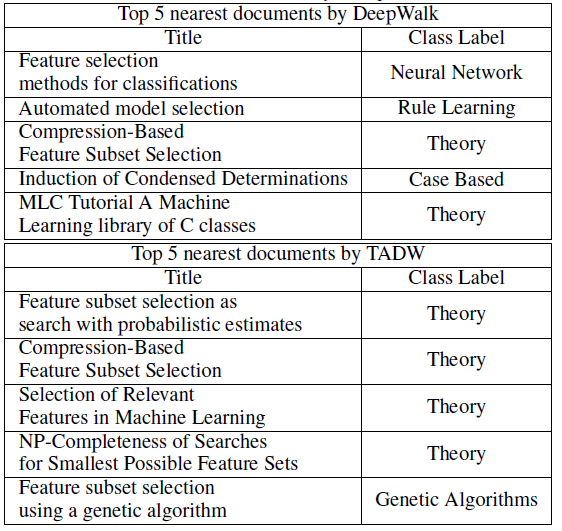

Cora数据集、Citeseer数据集、Wiki数据集的分类准确率。这里-表示TSVM不能在12小时内收敛,因为representation的质量较低(对于TADW,TADM总是可以在5分钟内收敛)。我们没有在Wiki数据集上展示半监督学习的结果,因为监督SVM已经在这个数据集上以较小的训练比率获得了有竞争力的、甚至更好的性能。因此,我们仅报告Wiki数据集的有监督SVM的结果。Wiki数据集的类别要比其它两个数据集多得多,这需要更多的数据来进行足够的训练,因此我们将最小训练比率设为3%。从这些表中我们可以看到:

TADW在所有三个数据集上始终优于所有其它baseline。此外,TADW可以在Cora数据集和Citeseer数据集上减少50%的训练数据从而击败其它baseline。这些实验证明TADW是有效且鲁棒的。TADW对于半监督学习有更显著的提升。TADW的表现优于最佳的baseline(即naive combination),在Cora数据集上提升4%、在Citeseer数据集上提升10% ~ 20%。这是因为在Citeseer上的network representation质量很差,而TADW从噪音的数据中学习比naive combination更鲁棒。TADW在训练比率较小时有更好的表现。大多数baseline的准确率随着训练比率的降低而迅速下降,因为它们的vertex representation对于training和testing而言非常noisy和inconsistent。相反,由于TADW从网络和文本信息中联合学习representation,因此representation具有更少的噪音并且更加一致。

这些观察结果证明了

TADW生成的高质量representation。此外,TADW不是task-specific的,representation可以方便地用于不同的任务,例如链接预测、相似性计算、顶点分类等等。TADW的分类准确性也与最近的几种collective分类算法相媲美,尽管我们在学习representation时没有对任务执行特别的优化。

参数敏感性:

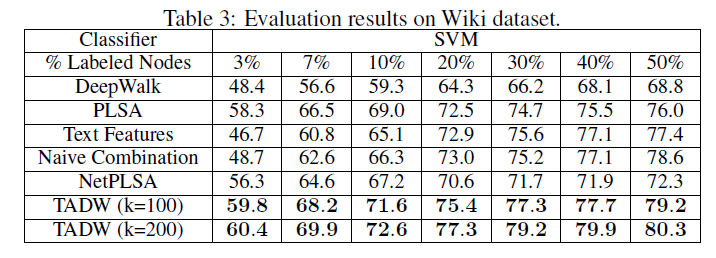

TADW有两个超参数:维度 和正则化系数 。我们将训练比率固定为10%,并使用不同的 和 测试分类准确率。对于Cora数据集和Citeseer数据集,我们让 在40 ~ 120之间变化,而 在0.1 ~ 1之间变化。对于Wiki数据集,我们让 在100 ~ 200之间变化,而 在0.1 ~ 1之间变化。下图显示了不同 和 下分类准确率的变化。可以看到:

- 对于

Cora, Citeseer, Wiki上的固定 ,不同 对应的准确率分别在1.5%, 1%, 2%的波动范围内。 - 当

Cora和Citeseer上的 、Wiki上的 时,准确率具有竞争性competitive。因此,当 和 在合理范围内变化时,TADW可以保持稳定。

- 对于

案例研究:为了更好地理解

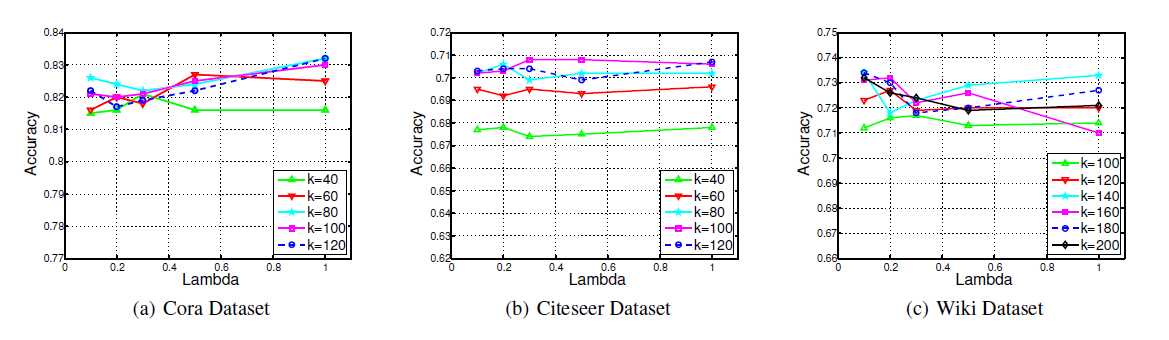

NRL文本信息的有效性,我们在Cora数据集中提供了一个案例。document标题为Irrelevant Features and the Subset Selection Problem(不相关特征和子集选择问题)。我们将这篇论文简称为IFSSP。IFSSP的类别标签为Theory。如下表所示,使用DeepWalk和TADW生成的representation,我们找到了5篇最相似的论文,并基于余弦相似度来排序。我们发现,所有这些论文都被

IFSSP引用。然而,DeepWalk发现的5篇论文中有3篇具有不同的类别标签,而TADW发现的前4篇论文具有相同的类别标签Theory。这表明:与单纯的基于网络的DeepWalk相比,TADW可以借助文本信息学到更好的network representation。DeepWalk发现的第5篇论文也展示了仅考虑网络信息的另一个限制。《MLC Tutorial A Machine Learning library of C classes》(简称MLC)是一个描述通用toolbox的论文,可以被不同主题的许多论文引用。一旦其中一些论文也引用了IFSSP,DeepWalk将倾向于给IFSSP一个与MLC类似的representation,即使它们具有完全不同的主题。

五、DNGR[2016]

图是许多现实世界问题中用于信息管理的常见表达。例如,在

protein-protein interaction网络中挖掘蛋白质复合物在同源蛋白质功能多样性的描述中起着重要作用,并提供有价值的演化洞察,这本质上是一个聚类问题。因此,开发自动化算法以从图中提取有用的深层信息至关重要。组织这类信息(它与潜在的大且复杂的图相关)的有效方法之一是学习graph representation,它为图的每个顶点分配一个低维的稠密的向量representation,从而对图传达的有意义的信息进行编码。最近,人们对学习

word embedding的工作产生了浓厚的兴趣。他们的目标是从大量自然语言文本中,根据上下文为每个自然语言单词学习一个低维的向量representation。这些工作可以被视为线性序列的learning representation,因为语料库由自然语言序列构成的线性结构组成。由此产生的紧凑的、低维的向量representation被认为能够捕获丰富的语义信息,并被证明可用于各种自然语言处理任务。虽然已经确定了学习线性结构的良好representation的有效方法,但是处理具有丰富拓扑的、通用的图结构更为复杂。为此,一种自然的方法是确定一种有效的转化方法:将学习通用图结构的vertex representation的任务转化为学习线性结构的representation的任务。DeepWalk提出了一种思想,它通过称作截断的随机游走truncated random walk的均匀采样方法将无权图转换为线性序列的集合。在他们的方法中,采样的顶点序列刻画了图中顶点之间的连接。这一步可以理解为将通用的图结构转化为线性结构集合的过程。接下来,他们利用了SkipGram模型从这种线性结构中学习顶点的低维representation。学到的顶点representation在一些任务中是有效的,并且优于先前的几种方法,如谱聚类spectral clustering、以及modularity方法。虽然这种学习无权图的顶点

representation的方法是有效的,但是仍然有两个重要问题有待回答:- 首先,对于加权图,如何更准确、更直接地捕获到图结构信息?

- 其次,是否有更好的方法来表达线性结构的顶点?

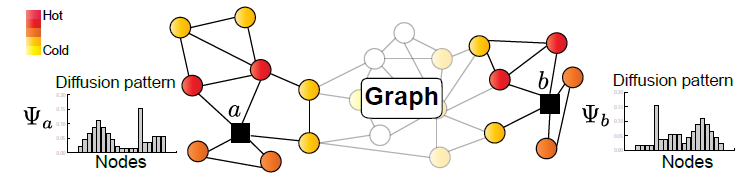

为了回答第一个问题,论文

《Deep Neural Networks for Learning Graph Representations》设计了一个适合加权图的随机冲浪模型random surfing model,它可以直接产生一个概率共现矩阵probabilistic co-occurrence matrix。这样的矩阵类似于通过从图中采样线性序列获得的共现矩阵,但是我们的方法不需要采样过程。使用带重启的

PageRank来计算转移概率,并不具备创新性。为了回答第二个问题,论文

《Deep Neural Networks for Learning Graph Representations》首先回顾了一种用于学习线性结构的顶点representation的现有方法。最近的一项研究《Neural word embedding as implicit matrix factorization》表明:使用负采样的SkipGram的目标函数,与分解由单词和它们上下文组成的一个shifted positive pointwise mutual information: PPMI矩阵有内在关系。具体而言,他们表明可以使用标准的奇异值分解SVD方法对PPMI矩阵进行因式分解,从而从分解的矩阵中导出vertex/word representation。最近的方法GraRep已被证明在学习graph representation的任务上取得了良好的实验结果。然而,该方法采用SVD来执行线性降维,而没有探索更好的非线性降维技术。在论文

《Deep Neural Networks for Learning Graph Representations》中,作者对《Neural word embedding as implicit matrix factorization》的工作给出了一个新的视角。作者认为:原始PPMI矩阵本身是图的显式representation矩阵,而SVD步骤本质上起到了降维toolbox的作用。虽然用于产生最终word representation的SVD步骤被证明是有效的,但是《Improving distributional similarity with lessons learned from word embeddings》也证明了使用PPMI矩阵本身作为word representation的有效性。有趣的是,正如《Improving...》的作者所展示的,从SVD方法学到的representation不能完全胜过PPMI矩阵本身的representation。由于我们的最终目标是学习能够有效捕获图信息的良好顶点representation,因此必须研究从PPMI矩阵中得到顶点representation的更好方法,其中可以捕获不同顶点之间潜在的、复杂的非线性关系。深度学习揭示了非线性的复杂现象建模的路径,它在不同领域有许多成功的应用,例如语音识别和计算机视觉。深度神经网络

DNN,例如堆叠自编码器stacked autoencoder,可以被视为从低级特征学习高级抽象的有效方法。该过程本质上执行降维,将数据从高维空间映射到低维空间。与基于SVD的降维方法不同(它通过线性投影从原始representation空间映射到具有较低秩的新空间),堆叠自编码器等深度神经网络可以学习高度非线性的投影。事实上,

《Learning deep representations for graph clustering》在聚类任务中使用稀疏自编码器sparse autoencoder来代替谱聚类spectral clustering的特征值分解eigenvalue decomposition步骤,并取得了显著的改进。受他们工作的启发,论文《Deep Neural Networks for Learning Graph Representations》还研究了使用基于深度学习的替代方法从原始数据representation中学习低维representation的有效性。与他们的工作不同,这里的目标是学习通用图的顶点representation,而不是专门关注聚类任务。作者将深度学习方法应用于PPMI矩阵,而不是他们模型中使用的拉普拉斯矩阵。DeepWalk已经证明前者有可能比后者产生更好的表现。为了增强模型的鲁棒性,作者还使用了堆叠降噪自编码器来学习多层representation。仅仅用非线性投影代替线性投影,并不具有创新性。

作者称提出的模型为

deep neural networks for graph representation: DNGR。学到的representation可以视为能够输入到其它任务中的输入特征,例如无监督聚类任务和有监督分类任务。为了验证模型的有效性,作者进行了将学到的representation用于一系列不同任务的实验,其中考虑了不同类型和拓扑的现实世界网络。为了在考虑更简单、但是更大规模的实际图结构时证明DNGR模型的有效性,作者将DNGR模型应用于一个非常大的语言数据集,并在word similarity任务上进行了实验。在所有这些任务中,DNGR模型优于其它learning graph representation方法,而且DNGR模型也可以简单地并行化。论文的主要贡献在两个方面:

- 从理论上讲,作者认为深度神经网络的优势在于能够捕获图传递的非线性信息,而许多广泛使用的、传统的线性降维方法无法轻易地捕获此类信息。此外,作者认为论文的随机冲浪模型可用于取代广泛使用的传统采样方法来直接捕获图结构信息。

- 根据实验,作者证明

DNGR模型能够更好地学习加权图的低维顶点representation,其中可以捕获图的有意义的语义信息semantic information、关系信息relational information、以及结构信息structural information。作者表明,得到的representation可以有效地用作不同下游任务的特征。

5.1 背景和相关工作

这里我们首先展示

DeepWalk中提出的无权图的随机采样,从而说明将顶点representation转换为线性representation的可行性。然后我们考虑两种word represenation方法:带负采样的SkigGram、基于PPMI矩阵的矩阵分解。这些方法可以视为从线性结构数据中学习word representation的线性方法。背景:给定加权图 ,其中 为顶点集合, 为边集合,边 由两个顶点组成。在无权图中,二元的边权重表示两个顶点之间是否存在关系。相比之下,加权图中的边权重是个实数,表示两个顶点之间的相关程度。尽管加权图中的边权重可能为负,但是我们在本文中仅考虑非负权重。

为了符号方便,我们在全文中也使用 和 来表示顶点。我们试图通过捕获图 的深层结构信息来获得顶点的

representation矩阵 。DeepWalk:DeepWalk提供了一种有效的方法,称作截断的随机游走truncated random walk,从而将无权的图结构信息转换为表示顶点之间关系的线性序列。所提出的随机游走是一种适用于无权图的均匀采样方法:- 首先从图中随机选择一个顶点 ,并将其标记为当前顶点。

- 然后从当前顶点 的所有邻居中随机选择下一个顶点 。现在,将这个新选择的顶点 标记为当前顶点并重复这样的顶点采样过程。

当一条序列中的顶点数量达到 (称作游走长度

walk length)的预设数时,算法终止。重复上述过程 次(称作游走次数total walk)后,我们得到线性序列的集合。虽然截断的随机游走是一种使用线性序列表达无权图结构信息的有效方法,但是该过程涉及缓慢的采样过程,并且超参数 和 不易确定。我们注意到:

DeepWalk基于采样的线性序列产生了一个共现矩阵co-occurrence matrix。在下文中,我们描述了我们的随机冲浪模型random surfing model,该模型直接从加权图中构建概率共现矩阵,从而避免了昂贵的采样过程。SkipGram with negative sampling: SGNS:自然语言语料库由线性序列的streams of words组成。最近,神经嵌入方法neural embedding method和基于矩阵分解的方法已广泛应用于学习word representation。《Distributed representations of words and phrases and their compositionality》提出的SkipGram模型已被证明是一种有效且高效的学习word representation的方法。改进SkipGram模型的两种值得注意的方法是负采样skip-gram with negative sampling: SGNS、以及hierarchical softmax。在本文中,我们选择使用前一种方法。在

SGNS中,采用噪声对比估计noise contrastive estimation: NCE方法(《A Fast and Simple Algorithm for Training Neural Probabilistic Language Models》)的简化变体来增强SkipGram模型的鲁棒性。SGNS根据经验的unigram word distribution随机创建negative pairs,并尝试使用低维向量表示每个单词 和每个上下文单词 。SGNS的目标函数旨在最大化positive pairs和最小化negative pairs:其中:

- 为

sigmoid函数 。 - 为负样本数量。

- 为当负样本 从分布 中采样时的期望。分布 为均匀分布,

#(c)为上下文顶点 在数据集 中出现的次数, 为数据集规模。 - 为顶点 的

representation向量, 为上下文顶点 的context representation向量。

- 为

PPMI矩阵和SVD:学习graph representation(尤其是word representation)的另一种方法是基于矩阵分解技术。这种方法基于全局共现计数global co-occurrence counts的统计数据来学习representation,并且在某些预测任务中可以优于基于单独的局部上下文窗口local context windows的神经网络方法。矩阵分解方法的一个例子是超空间模拟分析

hyperspace analogue analysis,它分解word-word共现矩阵从而产生word representation。这种方法和相关方法的一个主要缺点是:语义信息相对较小的高频词(例如停用词stop words)对生成的word representation产生不成比例的影响disproportionate effect。《Word association norms, mutual information, and lexicography》提出了pointwise mutual information: PMI矩阵来解决这个问题,并且已经被证明可以提供更好的word representation:其中: 表示数据集 中出现的次数, 为所有

pair的总样本量。进一步提高性能的方法是将每个负值调整为

0(详细信息参考论文《Neural word embedding as implicit matrix factorization》),从而形成PPMI矩阵:其中 为

PPMI矩阵。尽管

PPMI矩阵是一个高维矩阵,但是使用截断的SVD方法truncated SVD method执行降维会产生关于L2损失的最佳秩 的分解。我们假设矩阵 可以分解为三个矩阵: ,其中 为正交矩阵, 为对角矩阵(奇异值从大到小排列)。换言之:其中: 为 的最左侧的 列, 为 的最左侧的 列, 为 最左侧的 个奇异值(也是最大的 个奇异值)。根据

《Improving distributional similarity with lessons learned from word embeddings》,word representation矩阵 可以为:PPMI矩阵 是word representation矩阵和context矩阵的乘积。SVD过程为我们提供了一种从矩阵 中找到矩阵 的方法,其中 的行向量是word/vertex的低维representation,并且 的行向量可以通过 给出的高维representation的线性投影获得。我们认为这种投影不一定是线性投影。在这项工作中,我们研究了使用非线性投影方法通过使用深度神经网络来代替线性SVD的方法。深度神经网络:可用于学习

multiple level的feature representation的深度神经网络在不同领域取得了成功。训练这样的网络被证明是困难的。一种有效的解决方案是使用贪心的逐层无监督预训练greedy layer-wise unsupervised pre-training。该策略旨在一次学习一层的有用的representation。然后将学到的low-level representation作为下一层的输入,用于后续的representation learning。神经网络通常采用非线性激活函数(例如sigmoid或tanh)来捕获从输入到输出的复杂非线性投影。为了训练涉及多层

feature representation的深层架构,自编码器autoencoder已经成为常用的building block之一。自编码器执行两个操作:编码encoding、解码decoding。- 在编码步骤中,函数 应用于输入空间中的向量,并将其转换到新的特征空间。在这个过程中通常会涉及一个激活函数来对两个向量空间之间的非线性进行建模:输入向量空间,以及潜在向量

representation的空间。 - 在解码步骤中,重构函数 用于从潜在

representation空间重构原始输入向量。

让我们假设 ,以及 ,其中: 为非线性激活函数, 为编码器的参数, 为解码器的参数。这里 是转换输入空间的线性映射的权重, 为线性映射的

bias向量。我们的目标是通过找到 和 来最小化以下重构损失函数:其中 为数据集, 为单个样本的损失函数。

堆叠自编码器

stacked autoencoder是由多层的此类自编码器组成的多层深度神经网络。堆叠自编码器使用逐层训练方法来提取基本规律,从数据中逐层捕获不同level的抽象,其中更高层传递来自数据的更高level的抽象。- 在编码步骤中,函数 应用于输入空间中的向量,并将其转换到新的特征空间。在这个过程中通常会涉及一个激活函数来对两个向量空间之间的非线性进行建模:输入向量空间,以及潜在向量

5.2 模型

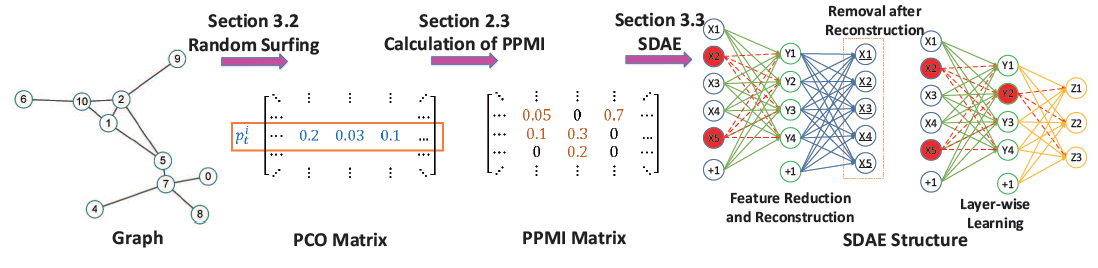

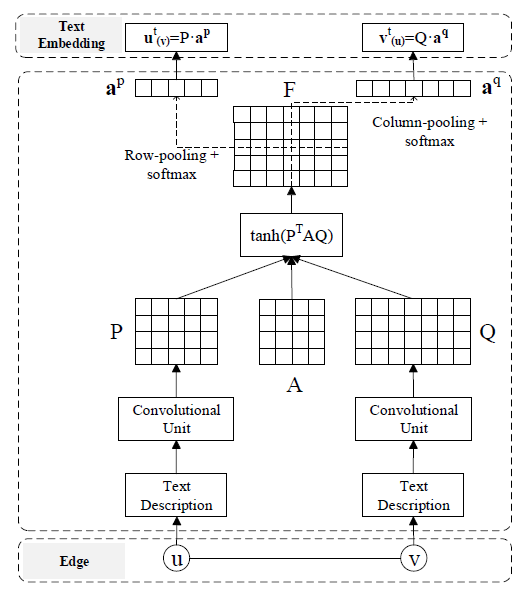

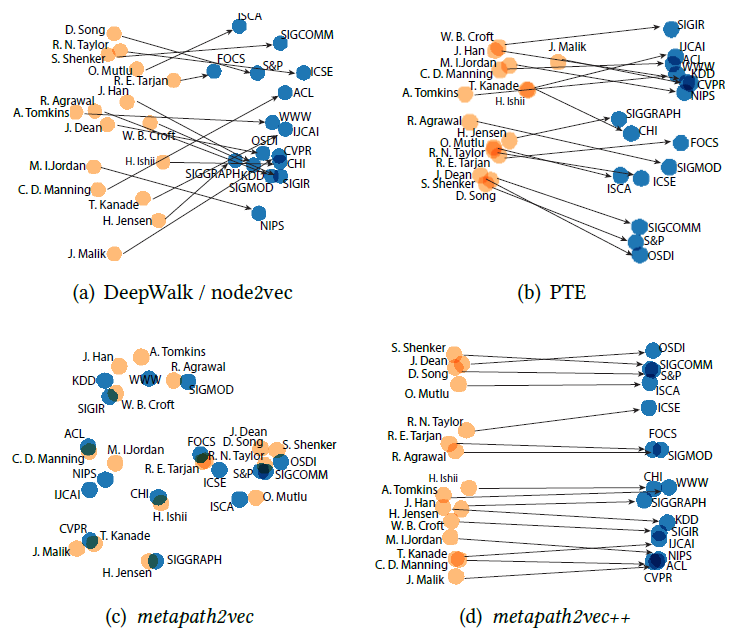

现在我们详细介绍我们的

DNGR模型。如下图所示,该模型由三个主要步骤组成:- 首先,我们引入随机场冲浪模型

random surfing model来捕获图结构信息并生成概率共现矩阵probabilistic co-occurrence matrix。 - 接下来,遵从

《Extracting semantic representations from word co-occurrence statistics: A computational study》,我们根据概率共现矩阵计算PPMI矩阵。 - 最后,我们使用堆叠降噪自编码器

stacked denoising autoencoder来学习低维的vertex representation。

下图的

SDAE结构中, 对应于输入数据、 对应于第一层学到的representation, 对应于第二层学到的representation。临时破坏的节点(例如 ) 以红色突出显示。

- 首先,我们引入随机场冲浪模型

5.2.1 随机冲浪和上下文加权

虽然有效,但是将图结构转换为线性序列的采样方法有一些弱点:

- 首先,采样序列的长度是有限的。这使得很难为出现在采样序列边界处的顶点捕获正确的上下文信息。

- 其次,确定某些超参数(例如游走长度 、游走次数 )难以简单地确定,尤其对于大图。

为了解决这些问题,我们考虑使用由

PangeRank模型启发的随机冲浪模型andom surfing model,其中PageRank模型原本用于ranking任务。我们首先对图中的顶点进行随机排序。我们假设当前的顶点是第 个顶点,并且有一个转移矩阵 来捕获不同顶点之间的转移概率transition probability。我们引入一个行向量 ,它的第 项表示经过 步转移之后达到第 个顶点的概率。 为初始的

1-hot向量,它的第 项为1而其它所有项为0。我们考虑一个带重启的随机冲浪模型random surfing model with restart:在每次,继续随机冲浪过程的概率为 ,返回原始顶点并重新开始的概率为 ,其中 。这将导致以下递推关系:如果我们假设过程中没有随机重启,则在恰好 步转移之后到达不同顶点的概率由以下公式指定:

如果我们考虑所有顶点开始的随机冲浪(而不仅仅是顶点 开始的),则有:

设最大的转移步数为 ,则通过这种方式我们得到

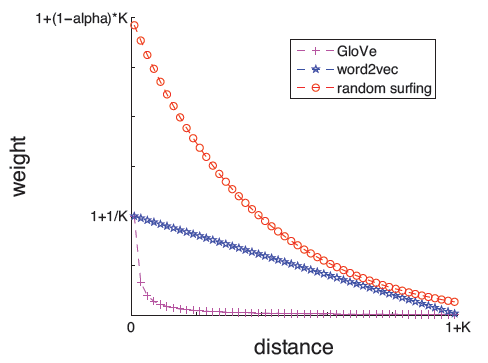

PMI矩阵:直觉上,两个顶点之间的距离越近,它们的关系就应该越紧密。因此,根据上下文节点和当前节点的相对距离来衡量上下文节点的重要性是合理的。在

word2vec和GloVe中都实施了此类加权策略,并且发现对于获得良好的实验结果很重要(《Improving distributional similarity with lessons learned from word embeddings》)。基于这一事实,我们可以看到,理想情况下,第 个顶点的representation应该以如下方式构建:其中 是一个单调递减函数(称作权重函数

weighting function),满足 。注意:

PMI的转移概率向量也可以视为顶点的某种representation。我们认为,基于上述随机冲浪过程构建顶点

representation的以下方式(即 )实际上满足了上述条件。事实上,可以证明:其中 。则 中 的系数为:

当满足 时, 是一个单调递减函数。

另外,

SkipGram中的 函数为:而

GloVe中的 函数为:如下图所示,所有权重函数 都是单调递减的。图中纵轴是分配给上下文节点的权重,横轴是上下文顶点和当前顶点之间的距离。

因此,与

word2vec和GloVe类似,我们的模型还允许根据上下文到target的距离从而对上下文信息进行不同的加权。这在之前被证明对于构建良好的word representation很重要。我们将通过实验评估这方面的重要性。

5.2.2 堆叠降噪自编码器

我们的研究旨在钻研从

PPMI矩阵构建顶点的高质量低维向量representation,其中PPMI矩阵传递了图的基本结构信息。SVD过程虽然有效,但是它本质上只产生从PPMI矩阵所包含的高维向量representation到最终低维向量representation的线性变换。我们相信可以在两个向量空间之间构建潜在的非线性映射。因此,我们使用堆叠降噪自编码器stacked denosing autoencoder(一种用于深度学习的流行模型)从原始高维顶点向量representation生成压缩的低维顶点向量representation。我们首先初始化神经网络的参数,然后我们使用贪心的逐层训练

greedy layer-wise training策略来学习每一层的high-level抽象。为了增强DNN的鲁棒性,我们使用了堆叠降噪自编码器stacked denoising autoencoder: SDAE。与传统的自编码器不同,降噪自编码器会在进行训练之前部分破坏输入数据。具体而言,我们通过将输入向量中的一些位置以一定概率设置为0来随机破坏每个输入样本 (它是一个向量)。这个想法类似于在矩阵补全matrix completion任务中对缺失项进行建模,其目标是利用数据矩阵中的规律性在某些假设下有效地恢复完整矩阵。与标准的自编码器类似,我们从潜在representation中重建数据。换句话讲,我们对以下目标感兴趣:其中 是 的破坏的版本, 为标准的平方误差。

SDAE算法:输入:

PPMI矩阵SDAE层数

输出:顶点的

representation矩阵算法步骤:

初始化第一层的

input贪心逐层训练,步骤为: :

- 基于

input来构建单隐层的SDAE - 学习隐层

representation - 隐层的输出作为

- 基于

最后一层隐层的

representation作为顶点的representation矩阵 。

5.2.3 DNGR 模型的讨论

这里我们分析以下

DNGR的优势,其实验有效性将在实验部分介绍。随机冲浪策略:如前所述,随机冲浪过程克服了以前工作中的采样程序相关的限制,并且为我们提供了某些所需的属性。这些属性是以前的

embedding模型 (例如word2vec和GloVe)所具备的。随机冲浪策略涉及计算

PMI矩阵,其计算复杂度太高()。堆叠策略:堆叠结构提供了一种平滑的降维方式。我们相信在深度架构的不同层上学习的

representation可以为输入数据提供不同level的有意义的抽象。降噪策略:高维输入数据通常包含冗余信息和噪声。我们相信降噪策略可以有效地降低噪声并增强鲁棒性。

效率:根据之前的分析,

DNGR中使用自编码器来推断,在顶点数量方面,比基于SVD的矩阵分解方法具有更低的时间复杂度。SVD的时间复杂度至少是顶点数量的二次方。然而,DNGR的推断时间复杂度与图中的顶点数量呈线性关系。但是在训练效率方面,

DNGR和SVD都需要计算PPMI矩阵,二者都是 计算复杂度。

5.3 实验

为了评估

DNGR模型的性能,我们在真实数据集上进行了实验。除了展示graph representation的结果以外,我们还评估了从自然语言语料库(它由线性序列组成)中学习的word embedding的有效性。数据集:

语言网络数据集

20-Newsgroup:包含2万篇新闻组文档,并按照20个不同的组分类。每篇文档由文档内单词的tf-idf组成的向量表示,并根据余弦相似度计算得到文档的相似度。根据文档的这些相似度构建语言网络,该网络是一个全连接的带权图,用于聚类效果的评估。为验证模型的鲁棒性,我们分别从

3/6/9个不同的新闻组构建了三个更小规模的语言网络(NG代表Newsgroups):3-NG:由comp.graphics, comp.graphics and talk.politics.guns这三个新闻组的文档构成。6-NG:由alt.atheism, comp.sys.mac.hardware, rec.motorcycles, rec.sport.hockey, soc.religion.christian and talk.religion.misc这六个新闻组的文档构成。9-NG:由talk.politics.mideast, talk.politics.misc, comp.os.ms- windows.misc, sci.crypt, sci.med, sci.space, sci.electronics, misc.forsale, and comp.sys.ibm.pc.hardware这九个新闻组的文档构成。

这些小网络分别对每个主题随机抽取

200篇文档。Wine数据集:包含意大利同一地区种植的三种不同品种的葡萄酒化学分析的13种成分的数量(对应13个特征及其对应取值),数据包含178个样本。我们将样本作为顶点、采用不同样本之间的余弦相似度作为边来构建

Graph。维基百科语料库:包含

2010年4月的快照作为训练集,包含2000万条文章和9.9亿个token。由于SVD算法复杂性,我们选择1万个最常见的单词构建词典。为了评估每个算法生成的

word representation的性能,我们在四个数据集上进行了word similarity实验,包括流行的WordSim353、WordSim Similarity、WordSim Relatedness、MC四个数据集。所有这四个数据集都有word pairs以及人工分配的相似性。

注意,这里得到的

graph都是根据节点相似性来构建的,因此并不是天然的图结构。这种数据集作为benchmark可能不太科学,因为稍微不同的图构建方式可能导致完全不同的评测结果。baseline方法:我们考虑以下四个baseline方法:DeepWalk:使用截断的随机游走truncated random walk将图结构转化为线性结构,然后使用hierarchical softmax的SkipGram模型处理序列。SGNS:使用带负采样的SkipGram模型。它已被证明是从理论上和经验上学习word representation的有效模型。PPMI:是信息论中经常使用的度量。该方法直接基于单词的共现来构建PPMI矩阵,并用顶点的PPMI信息构建顶点的稀疏、高维representation。SVD:是一种常用的矩阵分解方法,用于降维或提取特征。我们使用SVD来压缩PPMI矩阵从而获取顶点的低维representation。

参数配置:

随机游走序列长度 ,每个顶点开始的序列数量为 。

对于

DeepWalk, SGNS,负采样个数 ,上下文窗口大小为 。对于

DNGR:使用

dropout缓解过拟合,dropout比例通过调参来择优。所有神经元采用

sigmoid激活函数。堆叠式降噪自编码器的层数针对不同数据集不同。

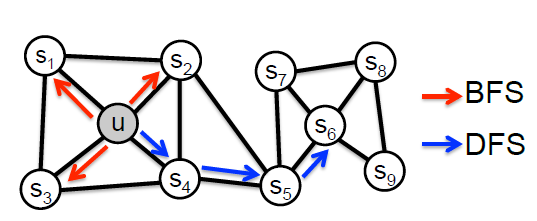

20-NewsGroup数据集上的聚类任务:该任务通过K-means对每个算法生成的顶点representation向量进行聚类,并以归一化互信息normalized mutual information: NMI作为衡量指标。每种算法随机执行10次并报告平均结果。为了验证不同维度的影响,下面还给出了DeepWalk,SGNS在维度为128、512时的结果。结论:

我们的

DNGR模型明显优于其它baseline方法,尤其是当 时。当 时,上下文信息不会根据它们的距离进行加权,我们得到较差的结果。这证明了前面讨论的上下文加权策略的重要性。

在

DeepWalk和SGNS中,增加维度使得效果先提升后下降。比较

DNGR和PPMI,效果的提升证明了对于高维稀疏矩阵降维并提取有效信息的好处。在相同的 设置下,

DNGR始终比SVD效果更好。这为我们之前的讨论提供了实验证据:DNGR是一种比SVD更有效的降维方法。

Wine数据集上的可视化任务:该任务采用t-SNE将DNGR,SVD,DeepWalk,SGNS输出的顶点representation映射到二维空间来可视化。在二维空间中,相同类型的葡萄酒以相同颜色来展示。在相同设置下,不同类型葡萄酒之间具有更清晰边界的聚类意味着更好的representation。结论:

DeepWalk和SGNS的可视化显示不清晰的边界和分散的簇。DNGR()要好得多。虽然SVD优于DNGR(),但是在结果中我们可以看到绿色的点仍然与一些红色的点混合在一起。DNGR()效果最好。我们可以看到不同颜色的点出现在3个独立的区域,并且大多数相同颜色的点聚集在一起。

Word Similarity任务:我们在维基百科语料库上执行单词相似度任务,该任务直接从训练语料库中计算word-context组合因此不需要随机冲浪模型来生产PPMI矩阵。我们采用Spearman’s rank correlation coefficient来评估算法的结果。为了获得最佳结果,我们将SGNS,DNGR,SVD负采样的样本数分别设置为5,1,1。结论:

DNGR的性能优于其它baseline方法。SVD,DNGR都比PPMI效果更好,这表明降维在该任务中的重要性。DNGR超越了SVD和SGNS,这表明学习representation时捕获非线性关系的重要性,并说明了使用我们的深度学习方法学习更好抽象的能力。

深度结构的重要性:为了理解深层结构的必要性,我们进一步度量了

20-NewsGroup数据集的layerwise NMI值。对于3NG和6NG,我们使用3层神经网络,对于9NG我们使用4层神经网络。从结果中我们可以看到:从浅层到深层,这三个网络的性能总体而言都在提升。这证明了深层结构的重要性。

六、Node2Vec[2016]

网络分析中的许多重要任务涉及对节点和边的预测。

- 在典型的节点分类任务中,我们需要预测网络中每个节点最可能的标签。例如,在社交网络中我们预测用户的兴趣标签,在

protein-protein interaction网络中我们预测蛋白质的功能标签。 - 类似地,在链接预测中,我们希望预测网络中的一对节点之间是否应该存在一条边。链接预测在各个领域都很有用。例如,在基因组学

genomics中它可以帮助我们发现基因之间的、新的interaction,在社交网络中它可以识别现实世界中的朋友。

任何有监督的机器学习算法都需要一组信息丰富

informative的、有区分力discriminating的、独立independent的特征。在网络的预测问题中,这意味着必须为节点和边构建特征的向量representation。典型的解决方案涉及基于专家知识的、人工的、领域特定domain-specific的特征。即使不考虑特征工程所需的繁琐工作,这些特征通常也是为特定任务设计的,并且不会在不同的预测任务中泛化。另一种方法是通过解决优化问题来学习feature representation。feature learning的挑战在于定义目标函数,这涉及计算效率和预测准确性的trade-off:- 一方面,人们可以致力于找到一种直接优化下游预测任务性能的

feature representation。虽然这种监督的过程具有良好的准确性,但是由于需要估计的参数数量激增,因此需要以高的训练时间复杂度为代价。 - 另一方面,目标函数可以定义为独立于下游预测任务,并且可以通过纯粹的无监督的方式学习

representation。这使得优化过程的计算效率较高,并且具有精心设计的目标函数。但是该目标函数产生了与任务无关的特征,这些特征无法达到task-specific方法的预测准确性。

然而,当前的技术未能令人满意地定义和优化网络中的合理目标函数,从而支持可扩展的无监督

feature learning。基于线性降维技术和非线性降维技术的经典方法,例如主成分分析

Principal Component Analysis: PCA、多维缩放Multi-Dimensional Scaling: MDS及其扩展方法,它们优化一个目标函数,该目标函数变换transform网络的代表性的数据矩阵representative data matrix从而最大化data representation的方差(原始数据在低维空间representation的方差,即数据尽可能分散)。因此,这些方法总是涉及对应矩阵的特征分解eigen decomposition,而特征分解对于大型现实世界网络而言是代价昂贵的。此外,所得到的潜在representation在网络上的各种预测任务中表现不佳。或者,我们可以设计一个旨在保留节点的局部邻域

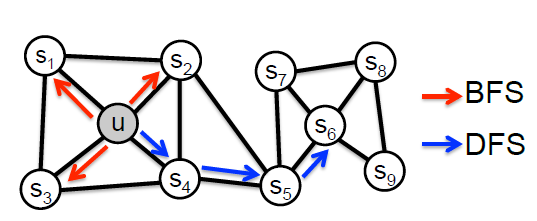

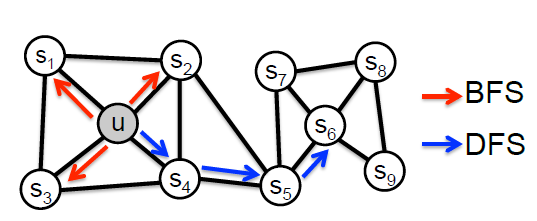

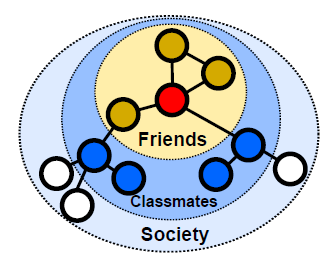

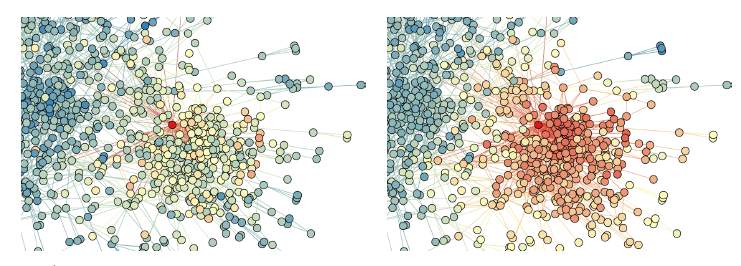

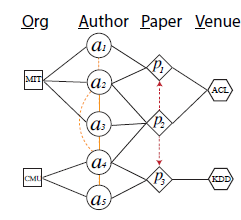

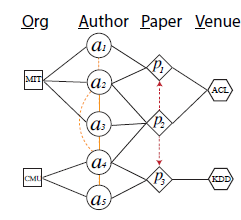

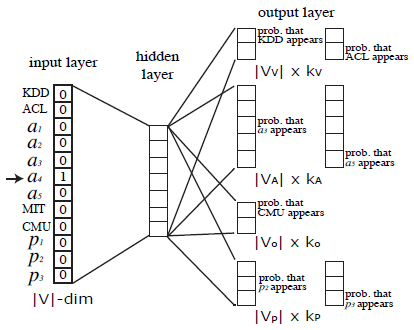

local neighborhood的目标函数(最大化保留节点的网络邻域network neighborhood的可能性)。我们可以使用随机梯度下降stochastic gradient descent: SGD来有效优化目标函数。最近一些工作在这个方向上进行了尝试,但是它们依赖于网络邻域network neighborhood的严格概念,这导致这些方法在很大程度上对网络特有的连接模式connectivity pattern不敏感。具体而言,网络中的节点可以根据它们所属的社区community(即同质性homophily)进行组织,也可以根据它们的结构角色structural role(即结构相等性structural equivalence)来组织。例如,下图中,我们观察到节点 和 都属于同一个紧密结合的节点社区,而两个不同社区中的节点 和 共享相同的结构角色(即中心节点

hub node的角色)。现实世界的网络通常表现出这种相等性的混合体。因此,重要的是允许灵活的算法从而可以学习遵守这两个准则的node representation:能够学习将来自同一个网络社区的节点紧密地嵌入在一起的representation,也能够学习共享相似结构角色的节点具有相似embedding的representation。这将允许feature learning算法在广泛的领域和预测任务中推广。

为此,论文

《node2vec: Scalable Feature Learning for Networks》提出了node2vec,一种用于网络中可扩展的feature learning的半监督算法。论文使用SGD优化graph-based自定义的目标函数,其灵感来自于自然语言处理的先前工作(《Efficient estimation of word representations in vector space》)。直观而言,论文的方法返回的feature representation可以最大化在低维特征空间中保留节点的网络邻域的可能性。论文使用二阶随机游走方法为节点生成(或采样)网络邻域。论文的主要贡献是定义了节点的网络邻域

network neighborhood的灵活概念。通过选择适当的邻域概念,node2vec可以学习根据节点的网络角色、和/或它们所属的社区而组织的representation。论文通过开发一系列有偏biased的随机游走来实现这一点,它可以有效地探索给定节点的多样化diverse的邻域。与先前工作中的严格搜索过程相比,由此产生的算法是灵活的,可以对超参数进行调优。因此,论文的方法推广了先前的工作,并且可以对网络中观察到的所有相等性equivalence进行建模。控制搜索策略的超参数有一个直观的解释,并且使得随机游走偏向于不同的网络探索策略。这些超参数也可以通过半监督的方式使用一小部分标记数据直接学习。论文还展示了如何将单个节点的

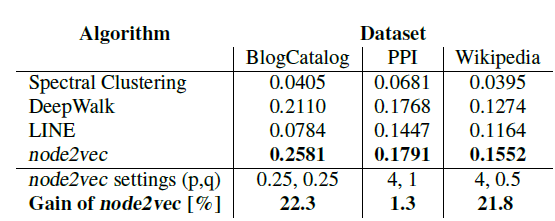

feature representation扩展到节点pair对(即edge)。为了生成边的feature representation,论文使用简单的binary operator组合学习到的各个节点的feature representation。这种组合性compositionality使得node2vec可用于涉及节点预测任务和边预测任务。论文的实验聚焦于网络中的两个常见预测任务上:多标签分类任务,其中每个节点都被分配一个或者多个类别标签;链接预测任务,在给定一对节点的情况下预测边是否存在。作者将

node2vec的性能与state-of-the-art的feature learning算法进行了对比。作者对来自不同领域的几个真实世界的网络进行了实验,例如社交网络social network、信息网络information network、以及来自系统生物学的网络。实验表明:node2vec在多标签分类任务上的性能优于state-of-the-art的方法高达26.7%,在链接预测任务上的性能优于state-of-the-art的方法高达12.6%。node2vec即使在10%的标记数据下也表现出有竞争力的性能,并且对噪声或者链接缺失的扰动也具有鲁棒性。

在计算上,

node2vec的主要阶段是可并行化的,它可以在几个小时内扩展到具有数百万个节点的大型网络。总体而言,论文做出了以下贡献:

- 论文提出了

node2vec,这是一种用于网络中feature learning的高效可扩展算法,可使用SGD有效优化新颖的、网络感知network-aware的、邻域保留neighborhood preserving的目标函数。 - 论文展示了

node2vec如何符合网络科学中的既定准则,为发现符合不同相等性equivalence的representation提供了灵活性。 - 论文扩展了

node2vec和其它基于邻域保留的目标函数的feature learning方法,从节点到节点pair对,从而用于edge-based预测任务。 - 论文根据经验评估了

node2vec在几个真实世界数据集上的多标签分类和链接预测任务。

- 在典型的节点分类任务中,我们需要预测网络中每个节点最可能的标签。例如,在社交网络中我们预测用户的兴趣标签,在

相关工作:机器学习社区在各种领域对特征工程

feature engineering进行了广泛的研究。在网络中,为节点生成特征的传统范式paradigm基于特征提取技术feature extraction technique,该技术通常涉及一些基于网络属性的、手工制作的特征。相比之下,我们的目标是通过将特征提取作为representation learning问题来自动化整个过程。在这种情况下,我们不需要任何手工设计的特征。无监督

feature learning方法通常利用图的各种矩阵representation的谱特性spectral property,尤其是图拉普拉斯矩阵Laplacian matrix和图邻接矩阵adjacency matrix。在这种线性代数的视角下,这些方法可以被视为降维技术。人们已经提出了几种线性降维技术(如PCA)以及非线性降维技术(如IsoMap)。这些方法同时存在计算性能缺陷和统计statistical性能缺陷。- 首先,在计算效率方面,数据矩阵的特征分解

eigen decomposition是代价昂贵的,因此这些方法很难扩展到大型网络。 - 其次,这些方法优化的目标函数对于网络中观察到的多样化模式

diverse pattern(例如同质性homophily和结构相等性structural equivalence)不是鲁棒的,并且对底层网络结构和预测任务之间的关系做出假设。例如,谱聚类spectral clustering做出了一个强烈的同质性假设,即图割graph cut对分类有用。这种假设在许多场景下都是合理的,但是在有效地推广到不同的网络方面并不令人满意。

自然语言处理中

representation learning的最新进展为离散对象(如单词)的feature learning开辟了新途径。具体而言,SkipGram模型旨在通过优化邻域保留neighborhood preserving的似然目标函数likelihood objective来学习单词的continuous feature representation。该算法的过程如下:首先扫描文档的单词,然后embedding每个单词使得该单词的特征能够预测附近的单词(即,该单词某个上下文窗口内的其它单词)。单词的feature representation是通过使用带负采样的SGD来优化似然目标函数likelihood objective来学习的。SkipGram的目标函数基于分布式假设distributional hypothesis,该假设指出:相似上下文中的单词往往具有相似的含义。即,相似的单词往往出现在相似的word neighborhood中。受

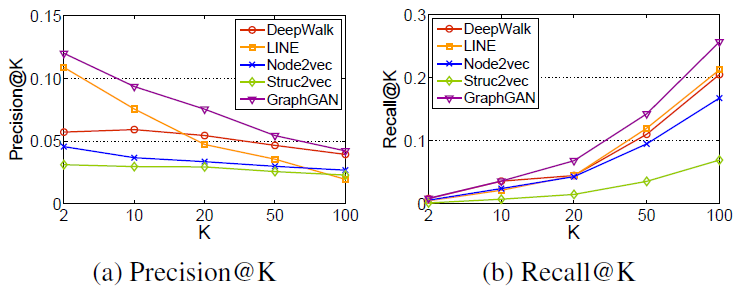

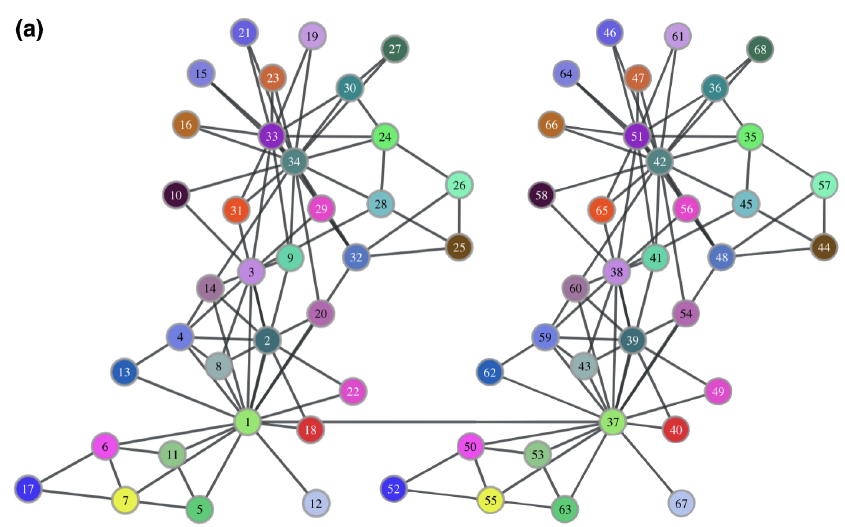

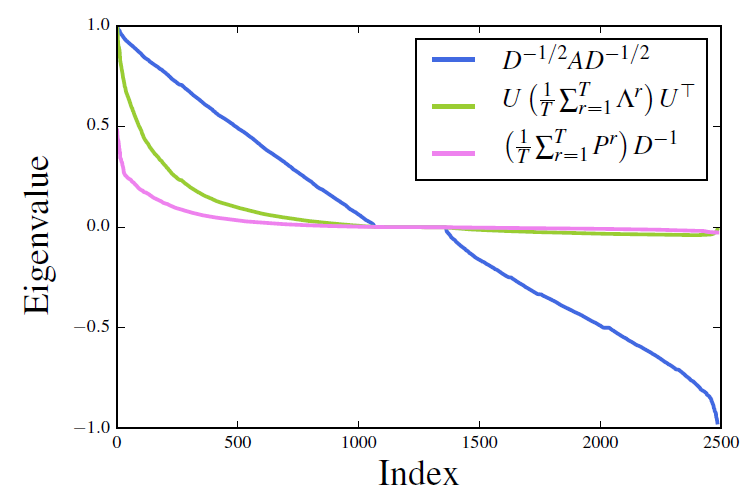

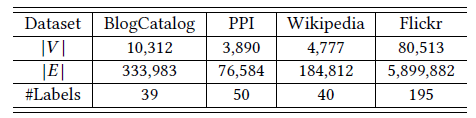

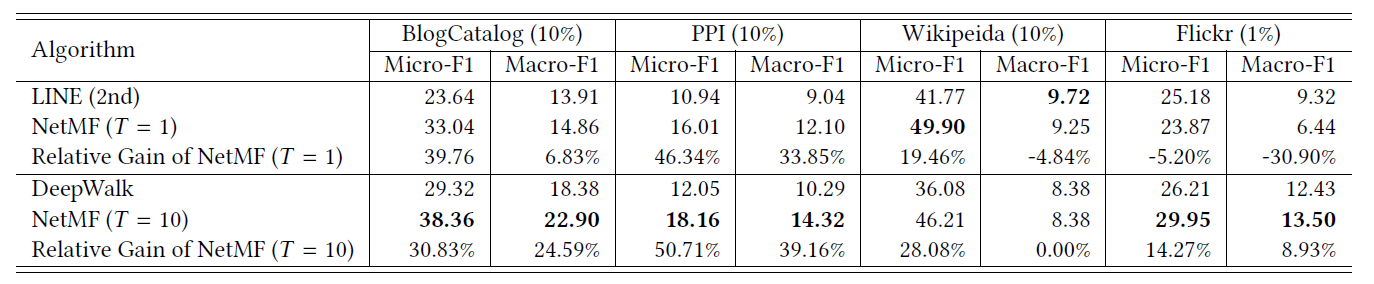

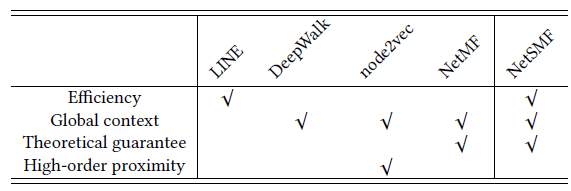

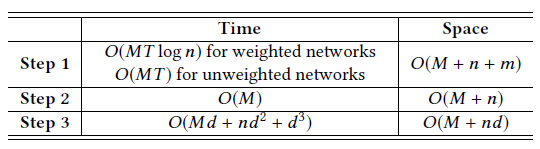

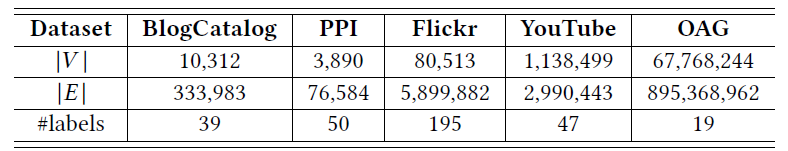

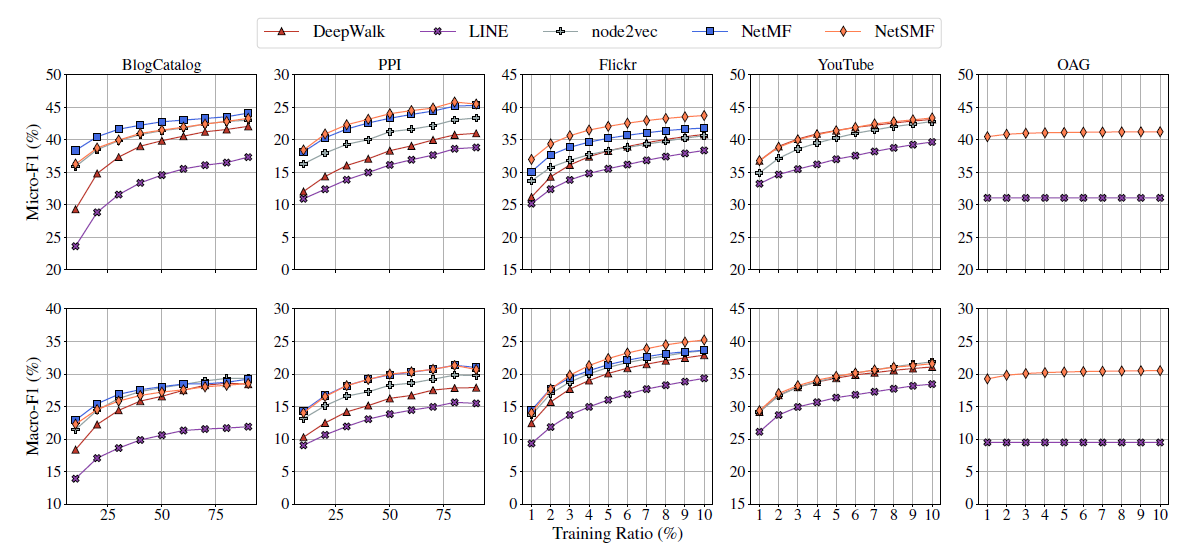

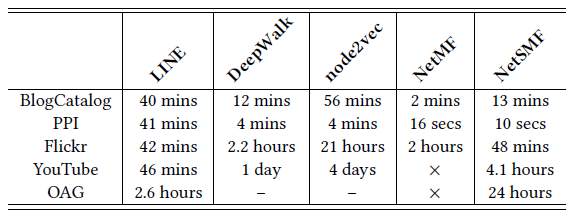

SkipGram模型的启发,最近的研究通过将网络表示为文档document来建立网络的一个类比analogy。就像文档是一个有序的单词序列一样,我们可以从底层网络中采样节点序列,并将网络变成一个有序的节点序列。然而,节点有多种可能的采样策略,导致学到的feature representation不同。事实上,正如我们将要展示的,没有明确的、最好的采样策略从而适用于所有网络和所有预测任务。这是先前工作的一个主要缺点:无法为网络中的节点采样提供任何灵活性。node2vec算法通过设计一个灵活的目标函数来克服这个限制,这个目标函数不依赖于特定的采样策略,并提供超参数来调整探索的搜索空间。最后,对于