GNN(续)

十四、GCMC[2017]

随着电商平台和社交媒体平台的爆炸式增长,推荐算法已经成为很多企业不可或缺的工具。通常而言,推荐算法有两个主流方向:基于内容的推荐系统、基于协同过滤的推荐系统。

- 基于内容的推荐系统使用

user和item的内容信息来进行推荐,如用户的职业、item的类型。 - 基于协同过滤的推荐使用

user-item交互数据(如购买、评分等)来进行推荐。

论文

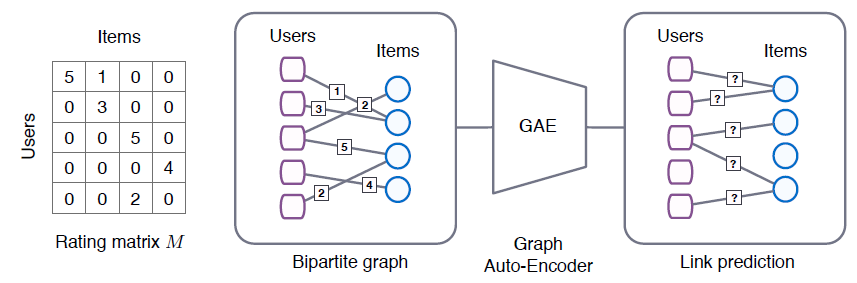

《Graph Convolutional Matrix Completion》将矩阵补全问题视为一个图的链接预测问题:协同过滤中的交互数据可以由用户节点和item节点之间的二部图来表示,观察到的评分/购买由链接来表示。内容信息自然地以节点特征的形式包含在这个框架中。评分预测问题变为预测user-item二部图中的labeled link。论文提出了图卷积矩阵补全

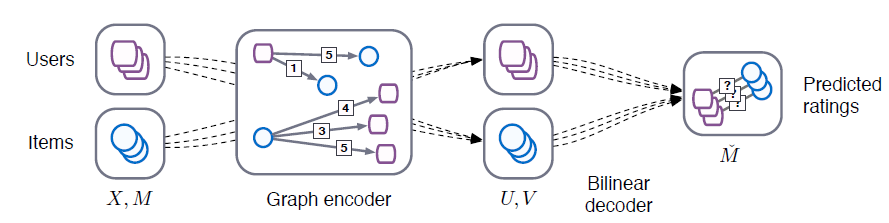

graph convolutional matrix completion: GCMC:一种graph-based的自编码器框架用于矩阵补全,它建立在图上深度学习的最新进展的基础上。自编码器auto-encoder通过在二部图上消息传递的形式来产生user latent feature和item latent feature。这些潜在user representation和item representation用于通过双线性解码器重建评分链接rating link。当有额外的辅助信息

side information可用时,将矩阵补全问题视为二部图上的链接预测问题带来的好处尤为明显。将辅助信息和交互数据结合在一起可以有效缓解冷启动问题。论文证明了所提出的图自编码器模型有效地结合了交互数据和辅助信息。- 基于内容的推荐系统使用

相关工作:

自编码器

auto-encoder:user-based或item-based自编码器是最近一类state-of-the-art协同过滤模型,可以视为我们的图自编码器模型的一个特例,其中仅考虑了user embedding或仅考虑了item embedding。《Autorec: Auto-encoders meet collaborative filtering》是第一个这样的模型,其中user(或item)部分观察到的评分向量rating vector通过编码器层encoder layer投影到潜在空间,并使用具有均方重构误差损失mean squared reconstruction error loss的解码器层decoder layer进行重构。《A neural autoregressive approach to collaborative filtering》提出的CF-NADE算法可以被认为是上述自编码器架构的一个特例。在user-based的设置中,消息仅从item传递给user;而在item-based的设置中,消息仅从user传递给item。我们的图自编码器同时考虑了

item传递给user,以及user传递给item。注意,与我们的模型相比,

CF-NADE给未评分的item在编码器中被分配了默认评分3,从而创建了一个全连接的交互图interaction graph。CF-NADE对节点进行随机排序,并通过随机切割random cut将传入消息划分为两组,并仅保留其中一组。因此,该模型可以看做是一个降噪自编码器,其中在每次迭代中随机丢弃输入空间的一部分。我们的模型仅考虑观测的评分,因此不是全连接的。

分解模型:很多流行的协同过滤算法都是基于矩阵分解

matrix factorization: MF模型,这种方式假设评分矩阵可以很好滴近似为低秩矩阵:其中:

embedding矩阵,每一行代表一个用户的user embedding向量,即user latent feature representation。item embedding矩阵,每一行代表一个item embedding向量,即item latent feature representation。embedding向量的维度,并且满足user集合,item集合。

在这些矩阵分解模型中:

《Probabilistic matrix factorization》提出的概率矩阵分解probabilistic matrix factorization: PMF假设《Matrix factorization techniques for recommender systems》提出的BiasedMF通过融合user-specifc bias, item-specific bias, global-bias来改进PMF。《Neural network matrix factorization》提出的Neural network matrix factorization: NNMF通过将latent user feature和latent item feature传递给前馈神经网络来扩展MF方法。《Local low-rank matrix approximation》提出的局部低秩矩阵近似介绍了使用不同低秩近似的组合来重建评分矩阵的思想。

带辅助信息的矩阵补全

matrix completion with side information:在矩阵补全问题中,目标是使用低秩矩阵来逼近rank的最小化是一个棘手的问题。《Exact matrix completion via convex optimization》使用最小化核范数nuclear norm(矩阵的奇异值之和)来代替秩的最小化,从而将目标函数变成了可处理的凸函数。Inductive matrix completion: IMC将user和item的内容信息融入到特征向量中,并预估useritem其中

itemuser embedding矩阵和item embedding矩阵。《Matrix completion on graphs》提出的geometric matrix completion: GCM模型通过以user graph和item graph的形式添加辅助信息,从而对矩阵补全模型进行正则化。在

《Collaborative filtering with graph information: Consistency and scalable methods》提出的GRALS将一种更有效的交替最小二乘优化方法引入了图正则化矩阵补全问题。最近,

《Geometric matrix completion with recurrent multi-graph neural networks》提出,通过在图上使用卷积神经网络将graph-based辅助信息融合到矩阵补全中,并结合递归神经网络来建模动态评分生成过程。和他们不同,

GCMC直接使用图卷积编码器/解码器对评分的二部图进行建模,通过一个non-iterative步骤即可预测unseen的评分。相比之下,

sRGCNN需要用迭代式的多个step才能预测评分。

14.1 模型

给定用户集合

item集合item我们将矩阵补全问题转化为链接预测问题。考虑二部图

item如下图所示:

- 左图为评分矩阵

user-item之间的评分(评分在1~5分之间),或者未观测(评分记作0)。 - 第二幅图表示

user-item评分的二部图,边对应于评分行为,边上的数字对应于评分数值。 - 最后两幅图表示矩阵补全问题可以转换为二部图上的链接预测问题,并使用端到端的可训练的图自编码器进行建模。

矩阵补全问题转化为链接预测问题的核心是:链接如何对应到评分?

GCMC的做法是:每个等级的评分对应一条边,因此有- 每种类型的边都有一个编码器,所有编码器的结果聚合得到

node embedding。 - 每种类型的边都有一个解码器,所有解码器的结果求期望得到预估的评分。

但是,这里没有考虑评分之间的大小关系:评分为

1要小于评分为

- 左图为评分矩阵

之前的

graph-based推荐算法通常采用multi-stage pipeline,其中包括图的特征抽取模型(如graph embedding模型)以及图的链接预测模型。这些模型都是独立分开训练。但是最近的研究结果表明:通过端到端的技术来建模图结构化数据可以显著提升效果。在这些端到端技术中,应用于无监督学习和链接预测的图自编码

graph auto-encoder技术尤为突出。因此我们提出一种图自编码器的变种来应用于推荐任务。

14.1.1 图自编码器

图自编码器由一个编码器和一个解码器组成,其中:

编码器模型:

embedding矩阵,每一行代表一个节点的embedding向量,node embedding向量维度。

解码器模型:

embedding

对于二部图

其中:

user embedding矩阵,item embedding矩阵。{0,1}内取值,item因此,

这里对每种类型的边定义了一个邻接矩阵,不同的邻接矩阵代表了不同的模型,因此类似于

《Convolutional Networks on Graphs for Learning Molecular Fingerprints》提出的neural graph fingerprint模型。

类似地,我们重新定义解码器为:

解码器输入一对

user-item的embedding向量,并返回useritem我们通过最小化预测评分矩阵

RMSE(将评分预测视为回归问题)或者交叉熵(将评分预测视为分类问题)。最后,我们注意到可以将最近提出的几个矩阵补全

state-of- the-art模型纳入我们的框架中,并将它们视为我们模型的特例。

14.1.2 图卷积编码器

这里我们选择了一种特定的编码器模型,它可以有效地利用图中

location之间的权重共享,并为每种边类型我们选择局部图卷积

local graph covolution作为编码器模型。这类局部图卷积可以视为消息传递的一种方式,其中消息在图的链接之间传递和转换。在我们

case中,我们为每个评分等级分配一个level-specific变换,使得从item其中:

left normalization) 或者根据论文的描述,这里应该是

level-specific权重矩阵。

同理,用户

item这里也可以选择使用不同的

level-specific权重矩阵user -> item和item -> user传递消息时,权重矩阵不同)。在消息传递之后:

- 首先通过求和来聚合类型为

representation向量。 - 然后将所有邻域类型的

representation向量聚合,从而得到节点的单个聚合向量。 - 最后对聚合向量进行变换,最终得到节点的

embedding向量。

以下公式为用户节点

embedding计算公式,item节点embedding也是类似的。其中第一行公式称作卷积层,第二行公式称作

dense层。注意:

当没有辅助信息可用时,

dense层对于user和item都采用相同的参数矩阵当存在辅助信息可用时,

dense层对于user和item都采用单独的参数矩阵这里卷积层只有一层。虽然可以堆叠更多的卷积层来构建更深的模型,但是在最初的实验中我们发现堆叠更多卷积层并不能提高性能。

同理,堆叠更多的

dense层也不能提高性能。因此,最终我们选择单层卷积层 + 单层dense层的组合作为图编码器。这里给出的模型仅仅是一种可能性。虽然编码器的选择相对简单,但是也可以选择不同的变种。例如:

- 可以使用神经网络来计算消息传递(

- 可以使用

attention机制从模型中学习每个消息的权重,从而替代消息的归一化常数

- 可以使用神经网络来计算消息传递(

14.1.3 双线性解码器

我们使用双线性解码器

bilinear decoder来重建二部图的链接。令用户item其中每个评分等级

embedding向量的维度。每个评分登记

模型最终预估的评分为所有评分等级预估结果的期望值:

14.1.4 模型训练

损失函数:模型训练期间我们将

GCMC模型的损失函数定义为:最小化预估评分其中:

mask矩阵:对于观测值对应的项,

因此,上述目标函数仅在所有观测的评分上优化。

GCMC模型的整体框架如下所示。模型由图卷积编码器- 编码器从

user-> item或者item -> user传递并变换消息。 - 解码器根据

user embedding和item embedding的pair对来预估评分。

- 编码器从

node dropout:为使得模型能够很好地泛化到未观测的评分,我们以概率node dropout。注意:和常规dropout一样,在消息丢弃之后需要rescale。这种

node-level的dropout和常规的dropout不同。常规的dropout是在message-level进行dropout,称作message dropout。- 在

message dropout中,每条消息随机独立地丢弃,使得最终embedding对于边的扰动更为鲁棒。 - 而在

node dropout中,每个节点随机独立地丢弃,使得最终embedding对于特定用户和特定item的影响更为鲁棒。这会缓解一些热门用户或热门item的影响。

最后,我们还对卷积自编码器的

dense层的隐单元使用了常规的dropout。- 在

mini-batch训练:为了训练较大的数据集(如MovieLens-10M数据集),我们需要对观测数据进行采样,从而进行mini-batch训练。这是将MovieLens-10M的完整模型加载到GPU内存所必须的。我们从每个等级的观测评分中采样固定比例的评分,然后仅考虑该

mini-batch的损失。这样我们在训练过程中仅需要考虑当前mini-batch中出现的user和item。这既是正则化的有效手段,又可以降低训练模型需要的内存。通过在

Movielens-1M数据集上使用mini-batch训练和full-batch训练的实验对比(对比时针对二者分别调优了各自的正则化参数),我们发现二者产生了可比的结果。最后,对于

MovieLens-10M以外的其它数据集,我们选择full-batch训练,因为full-batch训练相比mini-batch训练的收敛速度更快。

14.1.5 向量化实现

在

GCMC的实现中,我们可以使用高效的稀疏矩阵乘法来实现图自编码器模型,其算法复杂度和边的数量呈线性关系,即假设聚合函数

accum为累加,则图卷积编码器为(采用左归一化):其中:

degree matrix,这里是否要替换为

另外,采用对称归一化的图卷积编码器以及双线性解码器的向量化

vectorization也以类似的方式进行。

14.1.6 辅助信息

理论上可以将包含每个节点的信息(如内容信息)的特征直接作为节点的输入特征(即特征矩阵

item)及其兴趣时,将内容信息直接馈入图卷积层会导致严重的信息流瓶颈bottleneck of information flow。此时,可以通过单独的处理通道

channel,从而将用户特征向量或item特征向量以辅助信息的形式纳入全连接层中。由于内容信息灌入到模型的最后一层,因此上述的信息流瓶颈不会出现,因为瓶颈只会出现在中间层。那么这么做对不对?理论依据是什么?

我们选择输入特征矩阵

one-hot表示。令用户节点embedding为:其中:

bias向量。user节点的参数为item节点的参数为user,item类型的节点使用两套不同的参数。因为

user节点和item节点具有不同的输入特征空间。本文实验中使用的数据集中,用户内容以及

item内容的信息大小有限,因此我们使用这种辅助信息的方式。

注意:辅助信息不一定要以节点特征向量的形式出现,也可以是图结构(如社交网络)、自然语言或者图像数据。此时可以将上式中的

dense层替换为适当的可微模块,如RNN、CNN或者其它图卷积网络。

14.1.7 权重共享

编码器权重共享:在辅助信息的方式中,我们使用节点的

one-hot向量作为输入。此时矩阵user节点(如果节点item节点)或者item节点(如果节点user节点)。但是,并非所有用户拥有评分等级为

item拥有评分等级为遵从

《A neural autoregressive approach to collaborative filtering》我们实现了以下权重共享策略:由于更高的评分等级包含的权重矩阵数量更多,因此我们称这种权重共享为有序权重共享

ordinal weight sharing。为什么更高评分包含的权重矩阵数量更多?完全没有道理。

解码器权重共享:对于成对双线性解码器,我们采用一组基权重矩阵

basis weight matrix其中:

这种解码器的权重共享是一种有效的正则化手段。

14.2 实验

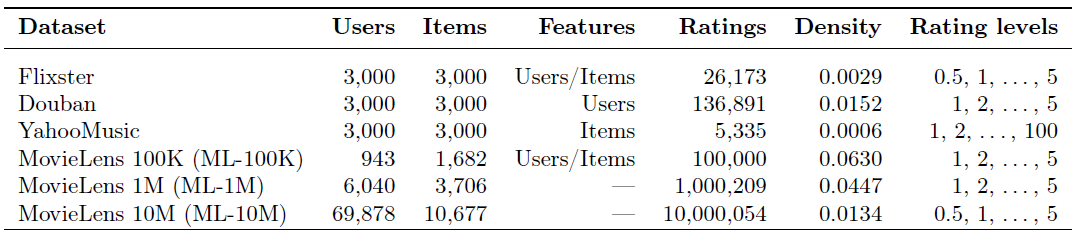

数据集:我们在多个常见的协同过滤

benchmark数据集上评估我们的模型。MovieLens(100K,1M, 10M)数据集:包含多个用户对多部电影的评级数据,也包括电影元数据信息(如电影题材)和用户属性信息(如用户年龄、性别、职业)。该数据集有多个版本,对应于不同的数据量。Flixster数据集:来自于社交电影网站Flixster的电影评分数据集,数据集包含了用户之间的好友关系。Douban数据集:来自豆瓣的电影评分数据集,数据集包含用户之间的好友关系。YahooMusic数据集:来自Yahoo! Music社区的用户对音乐家的评分数据集。

对于

Flixster,Douban, YahooMusic数据集,我们使用《Geometric matrix completion with recurrent multi-graph neural networks》论文提供的预处理的子集。预处理后,每个数据集包含3000个用户节点以及3000个item节点,以及对应的user-user或item-item交互图。下图给出了数据集的统计信息,其中

Features表示是否包含用户特征或者item特征,Ratings表示数据集的评分数量,Density表示评分矩阵中已观测评分的占比,Rating level表示评分等级范围。

baseline模型:- 矩阵补全模型,包括

MC, IMC, GMC, GRALS, sRGCNN。具体细节参考前文所述。 - 矩阵分解模型,包括

PMF, I-RBM, BiasMF, NNMF。 具体细节参考前文所述。 - 协同过滤模型,包括

LLORMA-Local, I-AUTOREC, CF-NADE。 具体细节参考前文所述。

另外我们还对比了我们不带额外信息的

GCMC模型,以及带辅助信息的GCMC+Feat模型。- 矩阵补全模型,包括

参数配置:

所有

baseline方法直接采用原始论文中的实验结论数据(因此也不需要实现和运行这些baseline方法)。对于

GCMC模型,我们通过验证集从以下超参数范围选择最佳的超参数:- 聚合函数

accumulation:stack vs sum。 - 是否在编码器中使用有序权重共享:是

vs否。 - 编码器中

vs对称归一化。 node dropout比例:

另外,除非另有说明,否则我们使用以下超参数配置:

- 使用学习率为

0.01的Adam优化器。 - 解码器基权重矩阵数量

- 编码器采用:维度

500的单层卷积层(使用ReLU激活函数) + 维度50的单层dense层(无激活函数)。

最后,我们使用学习模型参数的指数移动平均(衰减因子

0.995)在保留的测试集上评估模型。- 聚合函数

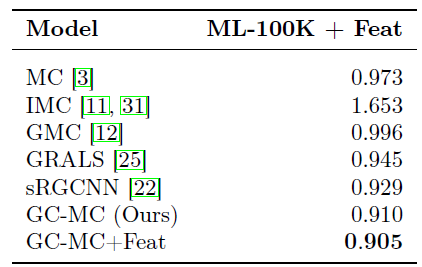

Movielens-100k数据集(特征向量形式的辅助信息实验):我们直接使用数据集原始的u1.base/u1.test的训练集/测试集拆分结果。对于该数据集,我们使用辅助信息来参与所有模型的训练。在该数据集我们对比了矩阵补全baseline方法和我们的GCMC方法,其中:GMC, GRALS, sRGCNN通过user/item特征。- 其它方法直接使用原始特征向量。

对于

GCMC的超参数,我们将原始训练集按照80:20进行训练集/验证集的拆分,然后通过验证集来调优超参数:在图卷积中使用stack作为累积函数,选择对于

GCMC模型,我们不带任何辅助信息。对于GCMC + Feat我们使用辅助信息,并且辅助信息的side information layer使用维度大小为10的dense层(采用ReLU激活函数)。我们使用

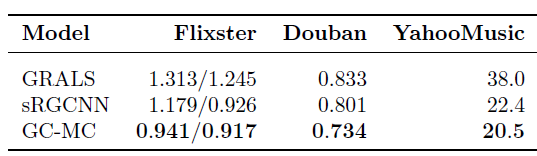

1000个full-batch epoch来训练GCMC和GCMC + Feat。我们随机重复执行5次并报告测试集上的平均RMSE结果。整体评估结果如下(baseline数据直接来自于《Geometric matrix completion with recurrent multi-graph neural networks》)。结论:

我们的

GCMC方法明显优于baseline方法,即使在没有辅助信息的情况下也是如此。和我们方法最接近的是

sRGCNN方法,它在用户和item的近邻图上使用图卷积,并使用RNN以迭代的方式学习表示。实验结果表明,使用简单的解码器(而不是复杂的

RNN)直接从学到的user embedding/ item embedding中直接评估评分矩阵可以更有效,同时计算效率更高。

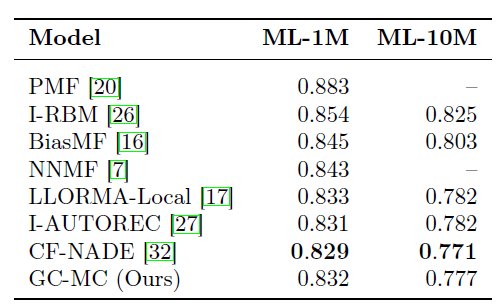

MovieLens-1M, MovieLens-10M数据集(无辅助信息的实验):在该数据集上我们和当前的state-of-the-art协同过滤算法(如AutoRec, LLorma, CF-NADE)进行比较。我们采取和

《A neural autoregressive approach to collaborative filtering》相同的训练集/测试集拆分方式,拆分比例90:10。另外,baseline方法的结果直接使用该论文的数值。该数据集不带任何辅助信息,因此我们没有比较

GCMC + Feat。我们对原始训练集按照95:5随机拆分为训练集/验证集,然后通过验证集来调优超参数:对于

MovieLens-1M数据集,我们使用sum作为累计函数,选择对于

MovieLens-10M,我们使用stack作为累计函数,选择另外考虑到该数据集的评分等级数量翻倍,我们选择解码器的基参数矩阵数量

一旦选择好超参数之后,我们就在整个原始训练集上重新训练模型,并利用训练好的模型来评估测试集。

对于

MovieLens-1M我们训练3500个full-batch epoch,对于MovieLens-10M我们训练18000个mini-batch step(对应于batch size =10000, epoch = 20)。我们按照

90:10随机拆分原始训练集/测试集,并重复执行5轮,报告模型在测试集上的平均RMSE。所有baseline评分来自于论文《A neural autoregressive approach to collaborative filtering》中的数据。对于CF-NADE我们报告了最佳性能的变体。结论:

GCMC方法可以扩展到大规模数据集,其性能可以达到user-based或者item-based协同过滤的state-of-the-art方法。CF-NADE引入的几种技术,如:layer-specific学习率、特殊的ordinal损失函数、评分的自回归建模,这些都和我们的方法正交,因此这些技术也可以和我们的GCMC框架结合使用。

Flixster, Douban, YahooMusic(图形式的辅助信息实验):这些数据集包含了一些图结构的辅助信息。我们通过使用这些图的邻接向量(根据degree进行归一化)作为相应的user/item的特征向量,从而引入辅助信息。注意:辅助信息的图是社交网络等

user-user图,或者item-item图。它们不同于user-item二部图。我们根据论文

《Geometric matrix completion with recurrent multi-graph neural networks》的训练集/测试集拆分。所有baseline方法的结果都取自于该论文的数值。我们从训练集中按照

80:20随机拆分为训练集/验证集,然后通过验证集来调优超参数:在图卷积中使用stack作为累积函数,选择对于

GCMC模型,我们使用辅助信息,并且辅助信息的side information layer使用维度大小为64的dense层(采用ReLU激活函数)。我们使用

full-batch训练200个epoch。最终我们重复执行

5轮,并报告模型在测试集上的平均RMSE。其中Flixster有两组结果:左侧结果表示同时引入了user辅助信息和item辅助信息;右侧结果表示仅考虑item辅助信息。结论:

GCMC在所有baseline中取得了state-of-the-art效果。注意:

GCMC在所有三个数据集上都采用相同的超参数配置,如果针对各自数据集调优,效果会进一步提升。

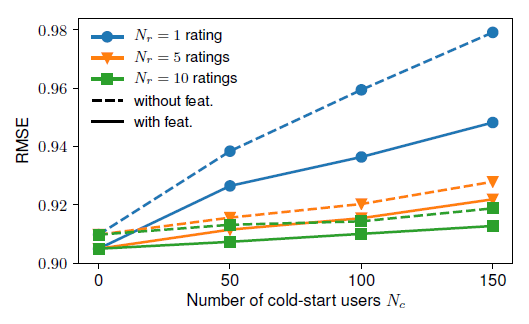

冷启动实验:为深入了解

GCMC模型如何通过辅助信息来提升冷启动性能,我们选择MovieLens-100K数据集,随机选择固定数量的冷启动用户MovieLens=100K原始数据仅包含具有至少20个评分的用户。我们考察当

GCMC的性能(可以看到:对于冷启动用户,使用辅助信息能够带来显著的提升,在只有一个评分的用户上表现尤为突出。

十五、JK-Net[2018]

图是一种普遍存在的结构,广泛出现在数据分析问题中。现实世界的图(如社交网络、金融网络、生物网络和引文网络)代表了重要的丰富的信息,这些信息无法仅仅从单个实体中看到(如一个人所在的社区、一个分子的功能角色、以及企业资产对外部冲击的敏感性)。因此,图中节点的

representation learning旨在从节点及其邻域中抽取高级特征,并已被证明对许多application非常有用,如节点分类、节点聚类、以及链接预测。最近的工作集中在

node representation的深度学习方法上。其中大多数深度学习方法遵循邻域聚合(也称作消息传递message passing)方案。这些模型迭代式地聚合每个节点的hidden feature及其周围邻域节点的hidden feature,从而作为该节点的新的hidden feature。其中每一次迭代都由一层神经网络来表示。理论上讲,执行hidden feature的聚合过程,利用了以节点Weisfeiler-Lehman图同构测试graph isomorphism test的推广,并且能够同时学习图的拓扑结构以及邻域节点特征的分布。但是,这种聚合方式可能会产生出人意料的结果。例如,已经观察到

GCN的深度为2时达到最佳性能;当采用更深网络时,虽然理论上每个节点能够访问更大范围的信息,但是GCN的效果反而更差。在计算机视觉领域中,这种现象称作学习退化degradation,该问题可以通过残差连接来解决,这极大地帮助了深度模型的训练。但是在GCN中,在很多数据集(如,引文网络)上即使采用了残差连接,多层GCN的效果仍然比不过2层GCN。基于上述观察,论文

《Representation Learning on Graphs with Jumping Knowledge Networks》解决了两个问题:- 首先,论文研究了邻域聚合方案的特点及其局限性。

- 其次,基于这种分析,论文提出了

jumping knowledge network: JK-Net框架。该框架和现有的模型不同,JK-Net为每个节点灵活地利用不同的邻域范围,从而实现自适应的结构感知表示structure-aware representation。

通过大量实验,论文证明了

JK-Net达到了state-of-the-art性能。另外,将JK-Net框架和GCN/GraphSage/GAT等模型结合,可以持续改善这些模型的性能。模型分析:为评估不同邻域聚合方案的行为,论文分析了节点

representation依赖的邻域范围。论文通过节点的影响力分布the influence distribution(即不同邻域节点对于representation的贡献的分布)来刻画这个邻域范围。邻域范围隐式的编码了nearest neighbors的先验假设。具体而言,我们将看到这个邻域范围严重受到图结构的影响。因此引发了一个疑问:是否所有的节点

tree-like子图、expander-like子图)。进一步地,论文形式化地分析将

eigenvalue的函数。改变的局部性

changing locality:为了说明图结构的影响和重要性,请回想一下许多现实世界的图具有强烈局部变化的结构locally strongly varying structure。在生物网络和引文网络中,大多数节点几乎没有连接,而一些节点 (hub)连接到许多其它节点。社交网络和web网络通常由expander-like部分组成,它们分别代表well-connected实体和小社区small community。除了节点特征之外,这种子图结构对于邻域聚合结果也有非常大的影响。邻域范围扩张的速度(或者叫影响半径的增长)通过随机游走的

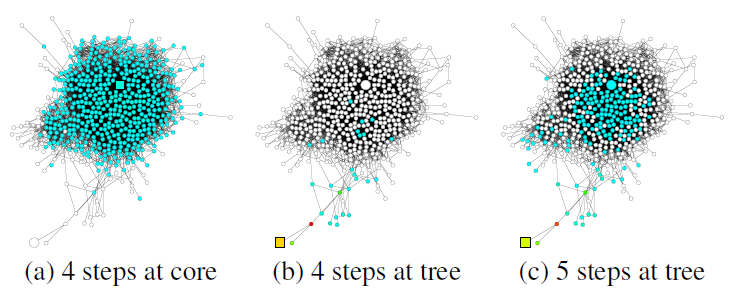

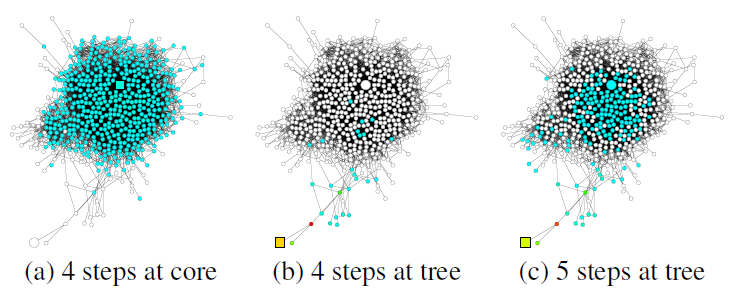

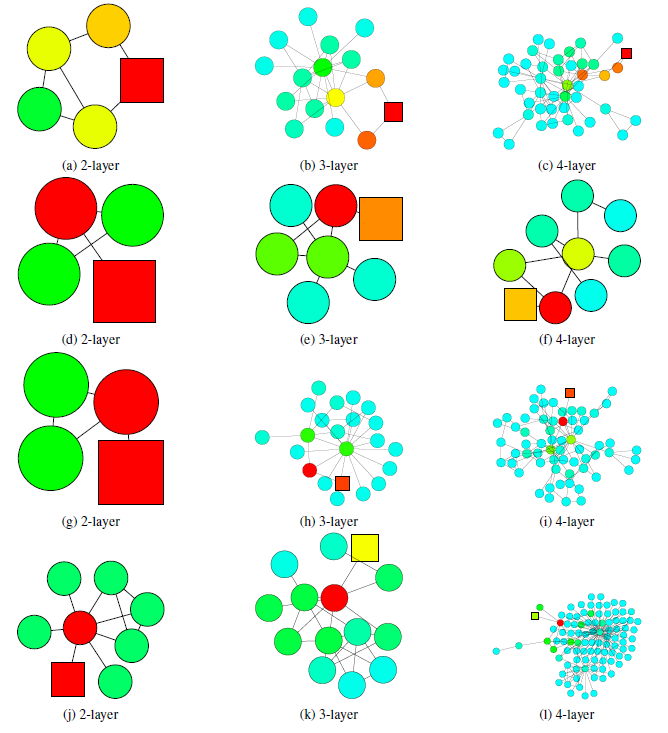

mixing time来刻画(即:从节点例如考虑如下

GooglePlus的社交网络,该图说明了从正方形节点开始的随机游走的扩散(随机游走的扩散也代表了影响力分布的扩散)。可以看到:不同结构的子图带来不同的邻域范围。- 图

a中,来自核心区域内节点的随机游走很快就覆盖了几乎整个图(随机游走覆盖的节点以绿色表示)。 - 图

b中,来自tree形区域节点的随机游走经过相同的step之后,仅覆盖图的一小部分(随机游走覆盖的节点以绿色表示)。 - 图

c中,来自tree形区域节点使用更长的step之后达到了核心区域,并且影响力突然快速扩散。

在

graph representation模型中,这种随机游走的扩散转换为影响力分布。这表明:在同一个图中,相同数量的随机游走step可以导致非常不同的效果。因此我们需要根据具体的图,同时结合较大的邻域范围和较小的邻域范围:- 太大的邻域范围可能会导致过度平滑,从而丢失局部信息。

- 太小的邻域范围可能信息不足,从而不足以支撑准确的预测。

- 图

JK network:上述观察提出一个问题:能否有可能对不同的图和不同的节点自适应地调整邻域范围。为此论文《Representation Learning on Graphs with Jumping Knowledge Networks》提出了JK-Net框架,该框架在网络最后一层选择性地组合不同邻域范围,从而自适应地学习不同邻域的局部性locality。如,将不同邻域范围jump到最后一层,因此这个网络被称作Jumping Knowledge Networks: JK-Nets。相关工作:谱图卷积神经网络

spectral graph convolutional neural network使用图拉普拉斯特征向量作为傅里叶基,从而在图上应用卷积。与诸如邻域聚合之类的空间方法spatial approach相比,谱方法spectral method的一个主要缺点是:需要提前知道图拉普拉斯矩阵(是transductive的)。因此,谱方法无法推广到unseen的图。

15.1 模型

定义图

定义图

假设基于消息传递的模型有

hidden feature为hidden feature的维度。为讨论方便,我们选择所有层的hidden feature维度都相等。另外,我们记定义节点

则典型的消息传递模型可以描述为:对于第

hidden feature更新方程为:其中:

AGG为聚合函数,不同的模型采用不同的聚合函数。

GCN图卷积神经网络(《Semi-supervised classification with graph convolutional networks》)hidden feature更新方程为:其中

degree。《Inductive representation learning on large graphs》推导出一个在inductive learing中的GCN变体(即,GraphSAGE),其hidden feature更新方程为:其中

degree。Neighborhood Aggregation with Skip Connections:最近的一些模型并没有同时聚合节点及其邻域,而是先聚合邻域,然后将得到的neighborhood representation和节点的上一层representation相结合。其hidden feature更新方程为:其中

在这种范式中,

COMBINE函数是关键,可以将其视为跨层的跳跃连接skip connection。 对于COMBINE的选择,GraphSAGE在特征转换之后直接进行拼接,Column Network对二者进行插值,Gated GCN使用GRU单元。但是,该跳跃连接是

input-specific的,而不是output-specific的。考虑某个节点skip。则后续更高层skip。我们无法做出这样的选择:对于第skip、对于第skip。即跳跃连接是由输入决定,而不是由输出决定。因此,跳跃连接无法自适应地独立调整final-layer representation的邻域大小。Neighborhood Aggregation with Directional Biases:最近有些模型没有平等地看到邻域节点,而是对“重要”的邻居给与更大的权重。可以将这类方法视为directional bias的邻域聚合,因为节点受到某些方向的影响要大于其它方向。例如:

GAT和VAIN通过attention机制选择重要的邻居,GraphSAGE的max-pooling隐式地选择重要的邻居。这个研究方向和我们的研究方向正交。因为它调整的是邻域扩张的方向,而我们研究的是调整邻域扩张的范围。我们的方法可以和这些模型相结合,从而增加模型的表达能力。

在下文中,我们证明了

JK-Net框架不仅适用于简单的邻域聚合模型(GCN),还适用于跳跃连接 (GraphSAGE)和directional bias(GAT)。

15.1.1 影响力分布

我们首先利用

《Understanding black-box predictions via influence functions》中的敏感性分析sensitivity analysis以及影响力函数的思想,它们衡量了单个训练样本对于参数的影响。给定节点representation。从这个影响范围,我们可以了解到节点我们通过衡量节点

final representation的影响程度,从而测量节点影响力得分和分布的定义:给定一个图

hidden feature,final representation。定义雅可比矩阵:

定义节点

influence score为:雅可比矩阵其中:

定义节点

influence distribution为:所有节点对于节点对于任何节点

representation的影响。考虑在

其物理意义为:随机游走第

类似的定义适用于具有非均匀转移概率的随机游走。

随机游走分布的一个重要属性是:如果图是非二部图

non-bipartite,则它随着spread,并收敛到极限分布。收敛速度取决于以节点spectral gap(或者conductance) 的限制bounded。

15.1.2 模型分析

不同聚合模型和节点的影响力分布可以深入了解各个

representation所捕获的信息。以下结果表明:常见的聚合方法的影响力分布和随机游走分布密切相关。这些观察暗示了我们接下来要讨论的优缺点。假设

relu在零点的导数也是零(实际上relu函数在零点不可导),则我们得到GCN和随机游走之间的关系:定理:给定一个

GCN变体,假设以相同的成功率证明:令

则有:

这里我们简化了

这里

假设存在

其中

则根据链式法则,我们有:

对于每条路径

现在我们考虑偏导数

其中

relu激活函数在假设

因此有:

另外,我们知道从节点

假设每一层的权重相同:

这里的证明缺少了很多假设条件的说明,因此仅做参考。

很容易修改上述定理的证明,从而得到

GCN版本的近似结果。唯一区别在于,对于随机游走路径其中

degree接近时。类似地,我们也可以证明具有

directional bias的邻域聚合方案类似于有偏的随机游走分布。这可以通过替换掉上述定理中相应的概率得到证明。从经验上看,我们观察到即使假设有所简化,但是我们的理论分析仍然接近于实际情况。

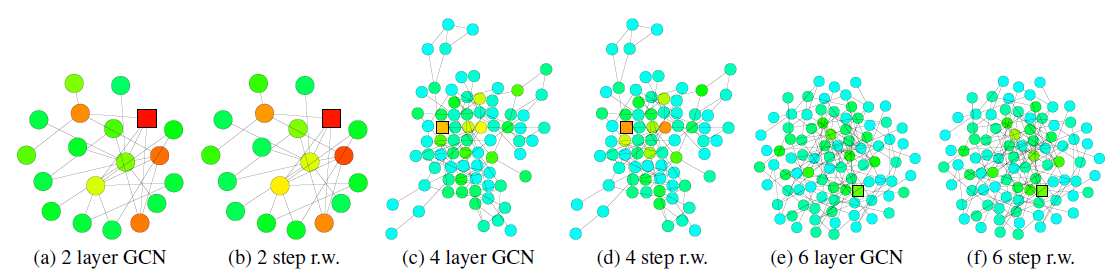

我们可视化了训练好的

GCN的节点(正方形标记)的影响力分布的热力图,并与从同一节点开始的随机游走分布的热力图进行比较。较深的颜色对应于较高的影响力得分(或者较高的随机游走概率)。我们观察到GCN的影响力分布对应于随机游走分布。

为显示跳跃连接的效果,下图可视化了一个带跳跃连接的

GCN的节点的影响力分布热力图。同样地,我们发现带跳跃连接的GCN的节点影响力分布大致对应于lazy随机游走分布(lazy表示每步随机游走都有较高的概率停留在当前节点,这里lazy因子为0.4)。由于每次迭代过程中,所有节点的局部信息都以相似的概率进行保留,因此这无法适应不同高层节点的各种各样的需求。

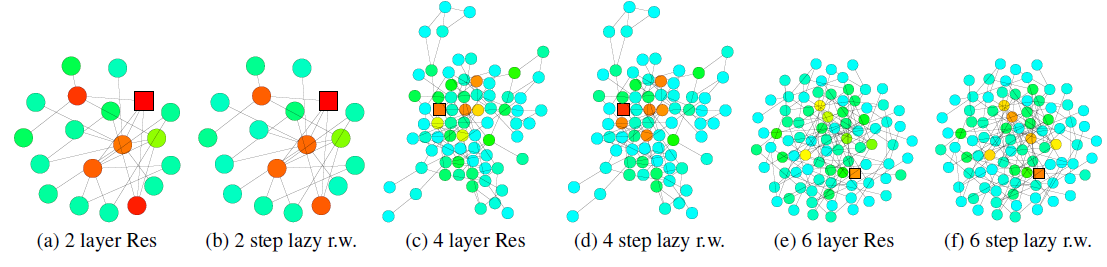

为进一步理解上述定理,以及相应邻域聚合算法的局限性,我们重新审视了下图中社交网络的学习场景。

- 对于

expander(左图)内部开始的随机游走以step快速收敛到几乎均匀分布。根据前述的定理,在经过representation几乎受到expander中所有任何其它节点的影响。因此,每个节点的representation将代表global graph,以至于过度平滑并带有节点自身的非常少的信息。 - 对于

tree-like(右图)开始的随机游走,其收敛速度较慢。这使得经过消息传递模型的聚合之后,每个节点的representation保留了更多的局部信息。

如果消息传递模型的层数

representation。

- 对于

最后我们描述了热力图的相关细节,并提供了更多的可视化结果。

热力图中的节点颜色对应于影响力分布得分或者随机游走分布的概率。颜色越浅则得分越低、颜色越深则得分越高。我们使用相同的颜色来表示得分(或者概率)超过

0.2的情形,因为很少有节点的影响力得分(或概率)超过0.2。对于得分(或概率)低于0.001的节点,我们没有在热力图中展示。首先我们比较

GCN的影响力分布vs随机游走概率分布,以及带跳跃连接的GCN的影响力分布vs惰性随机游走概率分布。目标节点(被影响的节点或者随机游走的起始节点)标记为方块。

数据集为

Cora citation网络,模型分别为2/4/6层训练好的GCN(或者带跳跃连接的GCN Res)。我们使用《Semi-supervised classification with graph convolutional networks》描述的超参数来训练模型。影响力分布、随机游走分布根据前述的公式进行计算。

lazy随机游走使用lazy factor = 0.4的随机游走,即每个节点在每次转移时有0.4的概率留在当前节点。注意:对于

degree特别大的节点,GCN影响力和随机游走概率的颜色有所不同。这是因为我们这里的GCN是基于公式这使得在

GCN影响力模型中,degree更大的节点,其权重越低。

然后我们考察了不同子结构,这些可视化结果进一步支持了前述的定理。

下图中,使用

2层的GCN模型分类错误,但是使用3层或4层GCN模型分类结果正确。当局部子图结构是

tree-like时,如果仅仅使用2层GCN(即查看2-hop邻域),则抽取的信息不足以支撑其预测正确。因此,如果能够从3-hop邻域或4-hop邻域中抽取信息,则可以学到节点的局部邻域的更好表示。

下图中,使用

3或4层的GCN模型分类错误,但是使用2层GCN模型分类结果正确。这意味着从3-hop或4-hop邻域中抽取了太多无关的信息,从而使得节点无法学到正确的、有助于预测的representation。- 在

expander子结构中,随机游走覆盖的节点爆炸增长,3-hop或者4-hop几乎覆盖了所有的节点。因此这种全局信息的representation对于每个节点的预测不是很理想。 - 在

bridge-like子结构中,抽取更远的节点的信息可能意味着从一个完全不同的community中获取信息,这可能意味着噪音并影响最终预测。

- 在

15.1.3 JK-Net

前述观察提出了一个问题,即:在通用聚合方案中使用固定的、但是结构依赖的影响力半径大小是否能够实现所有任务中节点的

best representation。- 如果选择的影响力半径过大,则可能导致过度平滑

oversmoothing。 - 如果选择的影响力半径国小,则可能导致聚合的信息量不足。

为此,我们提出了两个简单有效的体系结构调整:跳跃连接 + 自适应选择的聚合机制。

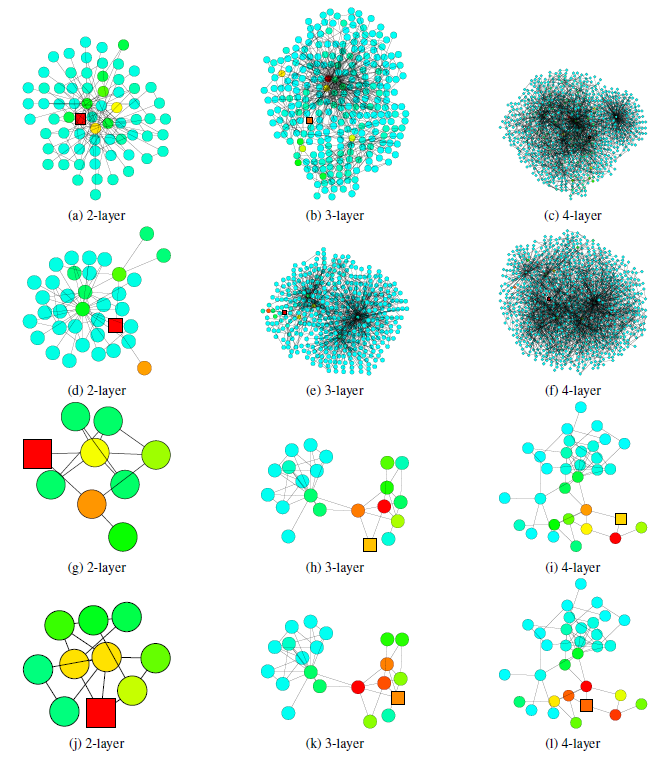

如下图所示为

JK-Net的主要思想。- 和常见的邻域聚合网络一样,每一层都是通过聚合来自上一层的邻域来扩大影响力分布的范围。

- 但是在最后一层,对于每个节点我们都从所有的这些

itermediate representation中仔细挑选(jump到最后一层),从而作为最终的节点representation。

由于这是针对每个节点独立完成的,因此模型可以根据需要为每个节点调整有效邻域范围,从而达到自适应的效果。

可以理解为常规的

GCN模型之上再添加一个聚合层。

- 如果选择的影响力半径过大,则可能导致过度平滑

JK-Net也使用通用的层聚合机制,但是最终的节点representation使用自适应选择的聚合机制。这里我们探索三种主要的聚合方法,其它方法也可以在这里使用。令

representation(每个中间层代表了不同的影响力范围),并将它们jump到最后一层。concatenation聚合:直接拼接- 如果这个线性变换的权重

node-adaptive的。 - 如果这个线性变换的权重

node-adaptive的。

- 如果这个线性变换的权重

max-pooling聚合:对feature coordinate选择信息最丰富的layer。这种方式是自适应的,并且不会引入任何其它额外的学习参数。LSTM-attention聚合:注意力机制通过对每个节点representation对于节点representation为所有中间层的representation的加权平均:对于

LSTM-attention:- 先将

LSTM的输入,并对每层LSTM hidden featureLSTM hidden feature - 然后通过对层

hidden feature - 然后通过一个

softmax layer应用到attention得分。 - 最后,将

attention得分的加权和,作为节点final representation。

LSTM-attention是node-adaptive的,因为不同节点的attention score是不同的。实验表明,这种方法适用于大型复杂的图。由于其相对较高的复杂度,会导致在小型图上过拟合。另外,也可以将

LSTM和最大池化相结合,即LSTM max-pooling。这种

LSTM聚合的方式太复杂,可以简单地基于- 先将

JK-Net的实现比较简单,大量的篇幅都在形容理论。但是,这里的理论仅仅是解释问题,并没有解决问题。这里的layer aggregation方式既没有理论解释,也没有解决问题(针对不同的节点自适应地选择不同的邻域大小):- 为什么如此聚合?论文未给出原因。

- 不同的聚合方式代表了什么样的领域大小?这里也没有对应的物理解释。

层聚合

layer aggregation函数设计的关键思想是:在查看了所有中间层学到的representation之后,确定不同影响力范围内子图representation的重要性,而不是对所有节点设置固定的、相同的影响力范围。假设

relu在零点的导数也是零(实际上relu函数在零点不可导),则layer-wise max-pooling隐式地自适应地学习了不同节点的局部影响力。layer-wise attention也是类似的。推论:假设计算图中相同长度的路径具有相同的激活概率

layer-wise max-pooling的JK-Net中,对于任意证明:假设经过层聚合之后节点

representation为其中

根据前述的定理,我们有:

其中:

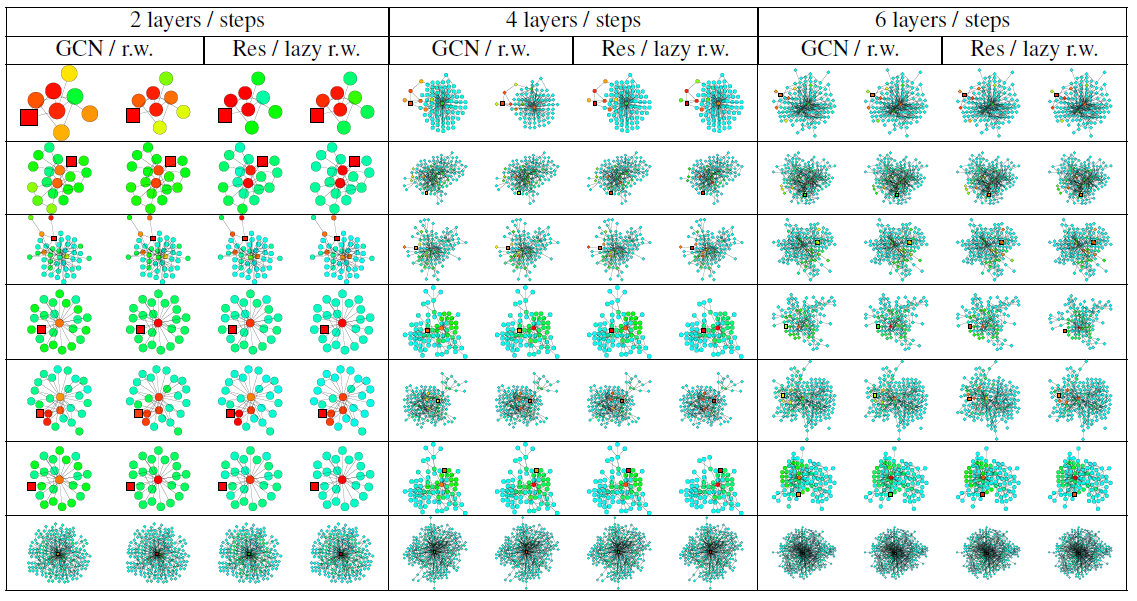

下图给出了采用

max-pooling的6层JK-Net如何学习从而自适应引文网络上不同的子结构。在

tree-like结构中,影响力仍然停留在节点所属的small community中。相反,在

6层GCN模型中,影响力可能会深入到与当前节点不想关的其它community中;而如果使用更浅层的GCN模型,则影响力可能无法覆盖当前节点所在的community。对于

affiliate to hub(即bridge-like)节点,它连接着不同的community,JK-Net学会了对节点自身施加最大的影响,从而防止将其影响力扩散到不想关的community。GCN模型不会捕捉到这种结构中节点自身的重要性,因为在几个随机游走step之后,停留在bridge-like节点自身的概率很低。对于

hub节点(即expander),JK-Net会在一个合理范围内将影响力扩散到相邻节点上。这是可以理解的,因为这些相邻节点和hub节点一样,都具有信息性。

JK-Net的结构有些类似于DenseNet,但是一个疑问是:是否可以像DenseNet一样在所有层之间都使用跳跃连接,而不仅仅是中间层和最后一层之间使用跳跃连接。如果在所有层之间都使用跨层的跳跃连接,并使用layer-wise concatenation聚合,则网络结构非常类似于DenseNet。从

graph theory角度审视DenseNet,图像对应于规则的graph,因此不会面临具有变化的子图结构的挑战。确实,正如我们在实验中看到的,使用concatenation聚合的模型在更规则的图(如图像、结构良好的社区)上表现良好。作为更通用的框架,

JK-Net接受更通用的layer-wise聚合模型,并在具有更复杂结构的图上实现更好的structure-aware representation。

15.2 实验

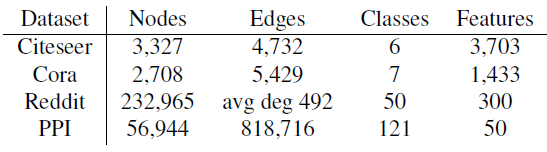

数据集:

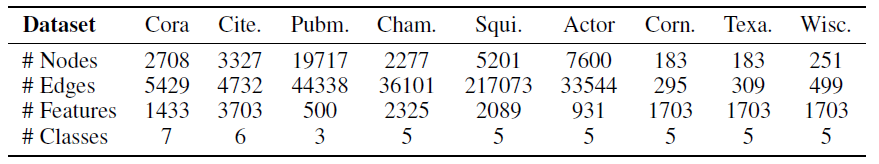

引文网络数据集 (

Citeseer, Cora) :数据集中每个节点代表一篇论文,特征为论文摘要的bag-of-word,边代表论文之间的引用链接。节点类别为论文的主题。Reddit数据集:数据集中每个节点代表一个帖子,特征为帖子所有单词的word vector。如果某个用户同时在两个帖子上发表评论,则这两个帖子之间存在链接。节点类别为帖子所属的community。PPI数据集:数据集包含24个图,每个图对应于一个人体组织的蛋白质结构图。图中每个节点都有positional gene sets, motif gene sets, immunological signatures作为特征,gene ontology sets作为标签。我们使用

20个图进行训练、2个图进行验证、剩余的2个图作为测试。

数据集的统计信息如下表所示:

baseline模型:GCN、GraphSage、GAT。实验配置:

在

transductive实验中,我们只允许访问单个图中的节点子集作为训练数据,剩余节点作为验证集/测试集。在

Citeseer, Cora, Reddit数据集上的实验是transductive的。在

inductive实验中,我们使用多个完整的图作为训练数据,并使用训练时未见过的、剩余的图作为验证集/测试集。在

PPI数据集上的实验是inductive的。

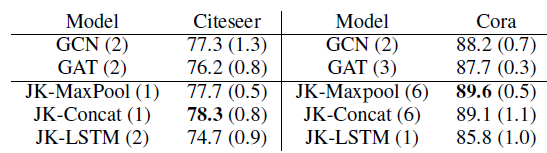

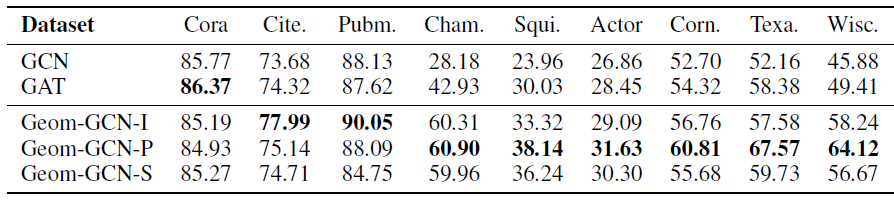

对于

Citeseer和Cora数据集,我们选择GCN作为base模型,因为在我们的数据集实验中它超越了GAT。我们分别选择

MaxPooling(JK-MaxPool)、Concatenation(JK-Concat)、LSTM-attention(JK-LSTM)作为最终聚合层来构建JK-Net。在进行最终聚合时,被聚合的representation除了图卷积中间层的representation之外,我们还考虑了第一个线性变换的representation(可以理解为第零层的representation)。最终预测是通过final聚合层的representation之上的全连接层来完成。我们将每个图的节点根据

60%:20%:20%的比例随机拆分为训练集、验证集、测试集。对于每个模型,我们将层数从1到6,针对验证集选择性能最佳的模型(及其对应的卷积层深度)。JK-Net配置:- 学习率为

0.005的Adam优化器。 - 比例为

0.5的dropout。 - 从

hidden feature维度(Citeseer为16,Cora为32)。 - 在模型参数上添加

0.0005的

每组实验随机执行

3次并报告准确率accuracy的均值和标准差(标准差在括号中给出),实验结果如下表所示。可以看到:就预测准确率而言,

JK-Net优于GAT和GCN这两个baseline。尽管

JK-Net总体表现良好,但是没有始终如一的赢家,并且各个数据集上的性能略有不同。模型名字后面括号中的数字(

1~6之间)表示表现最佳的层数。仔细研究Cora的结果发现:GCN和GAT都在模型为2层或3层时才能达到最佳准确率。这表明局部信息比全局信息更有助于分类。层数越浅,则表明邻域范围越小,则表明是局部信息。

JK-Net在模型为6层上获得最佳性能,这表明全局信息和局部信息事实上都有助于提高性能。这就是JK-Net这类模型发挥价值的所在。

LSTM-attention可能由于复杂性太高,从而不适用于此类小模型。因此JK-LSTM在这两个数据集中表现最差。

- 学习率为

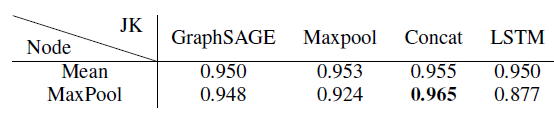

对于

Reddit数据集,由于它太大使得无法由GCN或GAT很好地处理。因此我们使用可扩展性更高的GraphSAGE作为JK-Net的base模型。在

GraphSAGE中存在不同的节点聚合方式,我们分别使用MeanPool和MaxPool来执行节点聚合,然后跟一个线性变换。考虑到JK-Net最后一层的三种聚合模式MaxPooling、Concatenation、LSTM-attention,两两组合得到6种JK-Net变体。我们采用和原始论文完全相同的

GraphSAGE配置,其中模型由两层卷积层组成,hidden layer维度为128维。我们使用学习率维0.01的Adam优化器,无权重衰减。实验结果如下表所示,评估指标维

Micro-F1得分。结论:当采用

MaxPool作为节点聚合器、Concat作为层聚合器时,JK-Net获得了最佳的Micro-F1得分。注意:原始的

GraphSAGE在Reddit数据集上的表现已经足够好(Micro-F1 = 0.950),JK-Net继续将错误率下降了30%。Reddit数据集中的社区是从表现良好的中等规模大小的社区中挑选而来,这是为了避免太大的社区中包含大量噪音、太小的社区是tree-like的。结果,该图比原始Reddit数据集更加规则,因此不会出现子图结构多样性的问题。在这种情况下,

node-specific自适应邻域选择所增加的灵活性可能不是那么重要,而concatenation的稳定特点开始发挥作用。这也是为什么JK-Concat效果较好的原因。

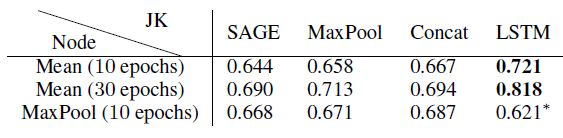

对于

PPI数据集,我们用它来证明自适应JK-Net的强大能力,该数据集的子图结构比Reddit数据集的子图结构更多样和复杂。我们将

GraphSAGE和GAT都作为JK-Net的base model。GraphSAGE和GAT有很大的区别:GraphSAGE基于采样,其中对每个节点的邻域采样固定的邻居数量;GAT基于attention,它考虑每个节点的所有邻居。这种差异在可扩展性和性能方面导致巨大的差距。鉴于GraphSAGE可以扩展到更大的图,因此评估JK-Net在GraphSAGE上的提升显得更有价值。但是我们的实验在二者上都进行。我们的评估指标为Micro-F1得分。对于

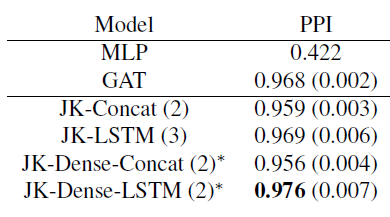

GraphSAGE,我们遵循Reddit实验中的配置,只是在可能的情况下使用3层网络,并训练10到30个epoch。带有*的模型采用2层(由于GPU内存限制),其它模型采用3层。作为对比,采用两层的GraphSAGE性能为0.6(未在表中给出)。实验结果见下表。

对于

GAT及其JK-Net变体,我们使用两层或三层网络,其中有4个attention head,每个head有256维(共1024维)。最后一个预测层有6个attention head,每个head有121维。我们将这6个head执行均值池化,并灌入到sigmoid激活函数。我们在中间attention层之间引入跳跃链接。所有这些模型都使用学习率为

0.005的Adam优化器,并使用batch size = 2的mini-batch训练。我们的

baseline为GAT和MLP模型,网络层数从2,3之间选择。由于GPU内存限制,JK-Dense-Concat和JK-Dense-LSTM的层数为2。实验结果见下表。

结论:

- 带有

LSTM-attention聚合器的JK-Net超越了具有concatenation聚合器的非自适应性JK-Net模型,以及GraphSAGE/GAT/MLP等baseline模型。 - 在训练

30个epoch之后,JK-LSTM在Micro-F1得分上比GraphSAGE高出0.128(绝对提升)。 - 结构感知的节点自适应模型在

PPI这类具有不同结构的复杂图上特别有效。

- 带有

十六、PPNP[2018]

目前有很多流行的图神经网络算法。

graph embedding算法使用随机游走或矩阵分解来直接训练每个节点的embedding,这类算法通常以无监督的方式学习并且不需要节点的特征信息。- 另外一些方法以有监督方式学习,并且同时利用了图结构和节点特征信息,其中包括谱图卷积神经网络

spectral graph convolutional neural network、消息传递message passing方法(或者也称作邻域聚合neighbor aggregation方法)以及基于RNN的邻域聚合方法。

所有这些方法中,消息传递方法由于其灵活性和良好的性能最近引起了特别的关注。已有一些工作通过使用

attention机制、随机游走、edge feature来改善基础的邻域聚合方式,并使得邻域聚合可以扩展到大图。但是,所有这些方法对于每个节点仅支持非常有限的邻域规模。事实上,如果能够使用更大的邻域,则可以为模型提供更多的有效信息。尤其是对于图的外围节点或者标签稀疏的节点。增加这些算法的邻域大小并不简单,因为这些方法中的邻域聚合本质上是拉普拉斯平滑的一种,如果层数太多将导致过度平滑

over-smoothing。在JK-Net的论文中,作者强调了这个挑战,并建立了随机游走和消息传递机制之间的关联。通过这个关联我们发现:随着层数的增加,GCN会收敛到随机游走的极限分布。这个极限分布是整个图的属性,和随机游走的起始节点无关。因此这个分布无法描述随机游走起始节点的邻域(因为过度平滑)。因此GCN的性能必然会随着卷积层数量(具体而言是随着aggregation层的数量)的增加而下降。为解决这个问题,论文

《 PREDICT THEN PROPAGATE: GRAPH NEURAL NETWORKS MEET PERSONALIZED PAGERANK》首先分析了这个极限分布和PageRank之间的内在联系,然后提出了personalized propagation of neural predictions: PPNP算法,该算法利用Personalized PageRank衍生而来的消息传递方案。PPNP算法增加了消息回传根节点的机会,从而确保PageRank Score编码了每个根节点的局部邻域。这个回传概率teleport probability使得我们能够平衡以下两方面的需求:保留节点的局部性(即,避免过度平衡)vs利用来自大型邻域的信息。作者表明,这种消息传递方案允许使用更多的层(理论上无限多),而不会导致过度平滑。另外,

PPNP的训练时间相比以前的模型相同或者更快,参数数量相比以前的模型相同或者更少,计算复杂度和边的数量呈线性关系。此外,PPNP利用一个大的、可调整的邻域来分类,并且可以轻松地和任何神经网络相结合。实验表明,PPNP超越了最近提出的几种GCN-like的半监督分类模型。在传统的消息传递方法中,

propagation和classification固有地耦合在一起,即classification依赖于propagation。但是在PPNP中,作者将propagation和classification解耦,使得二者相互独立。这使得我们能够在不改变神经网络的情况下实现更大的邻域。而在消息传递方法中,如果想多传递一个step就需要多加一个layer。PPNP的基本思想是:首先预测节点的标签(classification步骤),然后利用标签传播算法重新修正得到最终的标签(propagation步骤)。这种方法有效的前提是:相邻节点具有相似的label。PPNP还允许传播算法、以及根据节点特征执行预测的神经网络独立开发。这意味着我们可以将任何state-of-the-art预测方法和PPNP的传播算法相结合。作者甚至发现:在训练期间没有使用到任何图结构信息的模型,仅在inference阶段使用PPNP的传播算法可以显著提升模型预测的准确性。相关工作:

有些工作试图在每个节点添加跳跃连接,从而改善消息传递算法的训练,以及增加每个节点上可用的邻域大小。如,

JK-Net将跳跃连接和邻域聚合方案相结合。但是这些方法的邻域范围仍然有限,当消息传递的layer数量很少的情况下非常明显。虽然可以在我们的

PPNP中使用的神经网络中添加跳跃连接,但是这不会影响我们的传播方案。因此,我们解决邻域范围的方法和这些模型无关。《Deeper Insights Into Graph Convolutional Networks for Semi-Supervised Learning》通过将消息传递和co-training & self-training相结合来促进训练,通过这种组合实现的改善与其它半监督分类模型报告的结果相似。注意,大多数算法,包括我们的算法,都可以用

co-training & self-training进行改进。但是,这些方法使用的每个additional setp都对应一个完整的训练周期,因此会大大增加训练时间。在最近的工作中,人们通过将跳跃连接和

batch normalization相结合,提出了避免过度平滑问题的Deep GNN(《Mean-field theory of graph neural networks in graph partitioning》、《Supervised Community Detection with Line Graph Neural Networks》)。但是,我们的模型通过解耦预测和传播,从而简化了体系结构并解决该问题。并且我们的方法不依赖于任何临时性

ad-hoc技术,这些临时性的技术进一步复杂化模型并引入额外的超参数。此外,我们的

PPNP在不引入额外层的情况下增加了邻域范围,因此和Deep GNN相比,训练速度会更快更容易。

16.1 模型

定义图

假设每个节点

假设每个节点

one-hot向量假设图的邻接矩阵为

self-loops的邻接矩阵。

16.1.1 GCN 及其限制

卷积神经网络

GCN是一种用于半监督分类的简单且应用广泛的消息传递算法。假设有两层消息传递,则预测结果为:其中:

label分布。

对于两层

GCN,它仅考虑2-hop邻域中的邻居节点。基本上有两个原因使得消息传递算法(如GCN)无法自然地扩展到使用更大的邻域:- 首先,如果使用太多的层,则基于均值的聚合会导致过度平滑

over-smoothing。因此,模型失去了局部邻域的信息。 - 其次,最常用的邻域聚合方案在每一层使用可学习的权重矩阵,因此使用更大的邻域必然会增加神经网络的深度和参数数量。虽然参数数量可以通过权重共享来避免,但这不是通用的做法。

理论上,邻域大小和神经网络的深度是不相关的、完全正交的两个因素。它们应该互不影响才对。实际上在

GCN中它们是相互捆绑的(给定神经网络深度就意味着给定了邻域大小),并导致了严重的性能问题。我们首先关注第一个问题。在

JK-Net中已经证明:对于一个GCN,任意节点如果选择极限

irreducible且非周期性的,则这个随机游走概率分布显然,极限分布取决于整个图,并且独立于随机游走的起始节点

16.1.2 PPNP

我们可以考察极限分布和

PageRank之间的联系来解决这个局部邻域失去焦点lost focus问题。极限分布和

PageRank的区别仅在于前者在邻接矩阵中增加了自循环,并对分布进行了归一化。原始的PageRank的分布为:其中

建立这种联系之后,我们现在可以考虑使用结合了根节点的

PageRank变体 --Personalized PageRank。我们定义回传向量

teleport vectorone-hot向量,只有节点1、其它元素为0。对于节点

Personalized PageRank的分布为:其中

teleport probability(也叫做重启概率)。通过求解该等式,我们得到:

可以看到:通过使用回传向量

因为在该模型中,节点

考虑所有节点的回传向量,则我们得到了完整的

Personalized PageRank矩阵其中

注意到由于对称性

事实上这里需要考虑矩阵

证明:要想证明矩阵

由于

通过

Gershgorin circle theorem可以证明1,因此为了将上述影响力得分用于半监督分类,我们首先根据每个节点的自身特征来生成预测

prediction,然后通过我们的Personalized PageRank机制来传播prediction从而生成最终的预测结果。这就是personalized propagation of neural predictions: PPNP的基础。PPNP模型为:其中:

注意:由于

PPNP每个节点预测的label分布。

事实上,还可以用任何传播矩阵来代替

可以看到,

PPNP将神经网络预测和图的传播相互分离。这种分离还解决了上述提到的第二个问题:神经网络的深度现在完全独立于传播算法。正如我们将在GCN和PageRank联系时所看到的,Personalized PageRank能够有效地使用无限多个卷积层,这在传统的消息传递框架中显然是不可能的。此外,分离还使得我们可以灵活地运用任何方法来生成预测。这个就是标签传播

label propagation: LP的思想,将MLP和LP相结合。该方法有效的前提是:相邻节点具有相似的label。PPNP传播的是prediction,而传统GCN传播的是representation。虽然在

inference阶段,生成单个节点的预测和传播这个预测是连续进行的(看起来是多阶段的),实际上模型的训练是端到端的。即,在反向传播期间梯度流经传播框架(相当于隐式地考虑了无限多个邻域聚合层)。因此,采用传播框架之后大大提高了模型的准确性。

16.1.3 APPNP

直接计算完整的

Personalized PageRank矩阵为解决这个问题,重新考虑等式:

除了将

Personalized PageRank矩阵prediction矩阵Topic-sensitive PageRank的变体,其中每个类别对应于一个主题。在这个角度下,teleport set。因此,我们可以通过采用Topic-sensitive PageRank来近似计算PPNP,我们称其为approximate personalized propagation of neural predictions: APPNP。APPNP通过Topic-sensitive PageRank的幂次迭代power iteration来达到线性复杂度。Topic-sensitive PageRank的幂次迭代和带重启的随机游走相关,它的每个幂次迭代步定义为:其中:

prediction矩阵starting vector和teleport set的作用;注意:这个方法保持了图的稀疏性,并且从未构建一个

但是,

可以证明:当

APPNP收敛到PPNP。证明:

APPNP的迭代公式:在经过

当取极限

这就是

PPNP。PPNP/APPNP的传播框架propagation scheme不需要训练任何其它额外的参数。与GCN这样的模型不同,GCN通常需要为每个propagation layer(GCN中的传播层就是聚合层)提供更多的参数。因此,PPNP/APPNP中可以使用很少的参数传播得更远。实验结果表明:这种传播能力确实非常有益。将

PPNP视为不动点fixed-point迭代,这和最原始的图神经网络GNN模型存在关联。图神经网络中也是需要通过迭代来求解不动点,但是PPNP和GNN存在以下几点不同:PPNP的不同点迭代实际上通过Personalized PageRank已经求解到,因此直接使用Personalized PageRank矩阵PPNP在传播之前应用学到的特征变换,而GNN中在传播过程中应用学到的特征变换。

PPNP/APPNP中,影响每个节点的邻域大小可以通过回传概率最后,我们给出

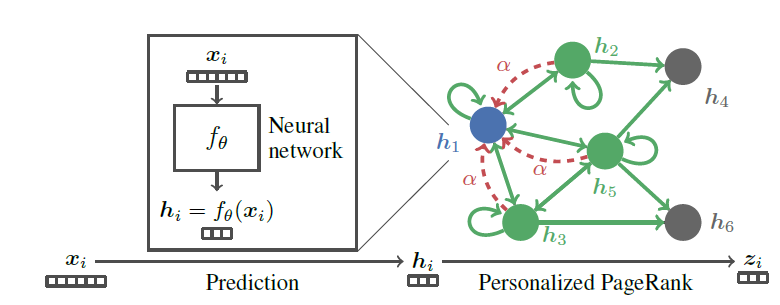

PPNP模型的示意图。- 首先利用神经网络

- 然后使用

Personalized PageRank来传播预测

注意该模型是端到端训练的,而不是

pipeline训练的。

- 首先利用神经网络

16.2 实验

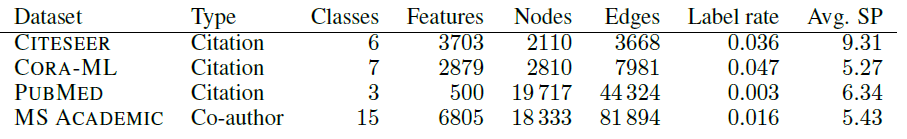

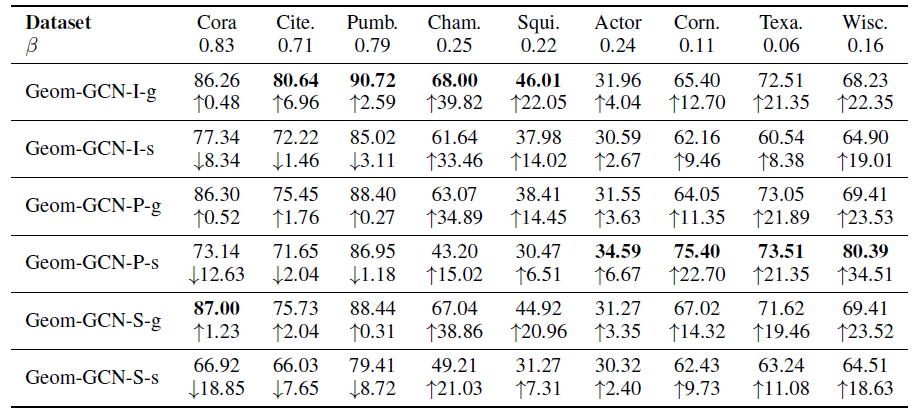

数据集:我们使用四个文本分类数据集。

CITESEER:引文网络,每个节点代表一篇论文,边代表它们之间的引用。CORA-ML:引文网络,每个节点代表一篇论文,边代表它们之间的引用。PUBMED:引文网络,每个节点代表一篇论文,边代表它们之间的引用。MICROSOFT ACADEMIC数据集:引文网络,每个节点代表一篇论文,边代表co-authorship。

对于每个图,我们使用其最大连通分量。所有数据集都使用论文摘要的

bag-of-word作为特征。下图给出了这些数据集的统计信息,其中SP表示平均最短路径长度。注意:更大的图不一定具有较大的直径(以

SP来衡量)。总体而言,这些图的平均直径为5~10,因此常规的两层GCN网络无法覆盖整个图。

因为使用了不同的训练配置和过拟合,很多实验评估都遭受了肤浅的统计评估

superficial statistical evaluation和实验偏差experimental bias。实验偏差的原因是:对于训练集/验证集/测试集的单次拆分没有明显区分验证集和测试集,或者对于每个数据集甚至是数据集的每次拆分都微调超参数。正如我们评估结果中显示的,消息传递算法对于数据集的拆分以及权重初始化非常敏感,因此精心设计的评估方法非常重要。

我们的工作旨在建立一个全面彻底的评估方法:

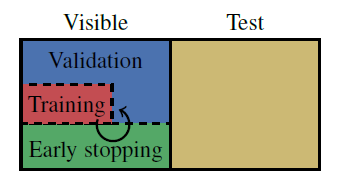

首先,我们对每个实验执行

100次,其中每次都是随机拆分训练集并随机初始化权重。我们采用Glorot权重初始化方法。其次,我们将数据集拆分为可见集和测试集,这种拆分固定不变。其中测试集仅用于报告最终性能,并不会进行训练和超参数择优。

- 对于引文网络,可见集采样了

1500个节点,剩余节点为测试集。 - 对于

MICROSOFT ACADEMIC网络,可见集采样了5000个节点,剩余节点为测试集。

可见集被随机拆分为训练集、验证集、以及早停集。训练集中每种类别包含

20个节点,早停集包含500个节点,剩余节点作为验证集。我们选择

20个不同的随机数种子并固定下来,接下来选择其中的一部分用于随机拆分可见集--测试集、另一部分用于随机拆分训练集--验证集。 另外,每种数据拆分都进行5次随机初始化,因此实验一共进行100次。

- 对于引文网络,可见集采样了

为进一步防止过拟合,考虑到所有实验的数据集都使用

bag-of-word特征,因此我们对所有数据集都采用相同数量的层数、相同的hiddel layer维度、相同的dropout比例、相同的为防止实验偏差,我们使用

CITESEER和CORA-ML上的网格搜索来分别优化所有模型的超参数,并在模型之间使用相同的早停准则:patience = 100的阈值,以及最多epoch(实际上永远无法达到这么多epoch)。只要在早停数据集的准确率提升或者损失函数降低,则重设

patience。我们选择在早停数据集上准确率最高的patience。该准则受到GAT的启发。最后,为了确保我们实验配置的统计鲁棒性,我们通过

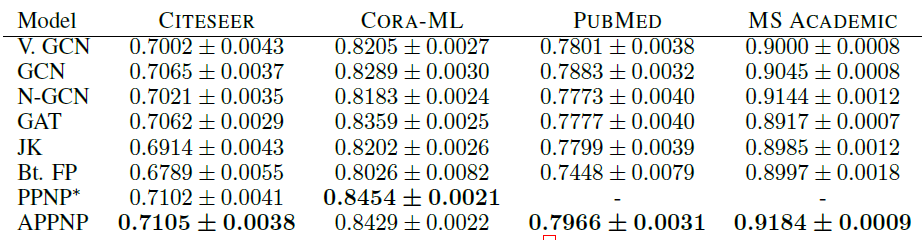

bootstrapping计算出置信区间,并报告主要结论的t-test的p-value。

据我们所知,这是迄今为止对

GCN模型的最严格的研究。Baseline方法:GCN:图卷积神经网络。N-GCN:结合了无监督的随机游走和半监督学习两方面优势的N-GCN模型。GAT:图注意力神经网络。bootstrapped feature propagation: FP:将经典的线性的图扩散结合self-training框架,从而得到的FP网络。jumping knowledge networks with concatenation: JK:JK-Net网络。- 对于

GCN我们还给出了未经过超参数优化的普通版本V.GCN来说明早停和超参数优化的强大影响。

模型配置:

V.GCN:使用原始论文的配置,其中包括两层的卷积层、隐层维度dropout、200个step,以及早停的patience = 10。择优的

GCN:使用两层卷积层、隐层维度dropout rate = 0.5的dropout、N-GCN:每个随机游走长度使用4个head以及隐层维度1 step到4 step。使用attention机制来合并所有head的预测。GAT:使用优化好的原始论文的超参数,除了0.01。和原始论文相反,对于PUBMED数据集我们并未使用不同的超参数。FP:使用10个传播step、10个self-training step,每个step增加我们在预测中添加交叉熵最小的训练节点。每个类别添加的节点数基于预测的类别的比例。注意,该模型在初始化时不包含任何随机性,因此我们在每个

train/early stopping/test集合拆分时仅拆分一次。JK-Net:我们使用concatenation层聚合方案,采用三层卷积神经网络,每层的隐层维度dropout rate = 0.5的dropout。但是正则化和dropout并不作用在邻接矩阵上。PPNP:为确保公平的模型比较,我们为PPNP的预测模型使用了神经网络,该网络在结构上和GCN非常相似,并具有相同的参数数量。我们使用两层网络,每层的隐层维度为我们在第一层的权重矩阵上应用

dropout rate = 0.5的dropout。对于

APPNP,我们在每个幂次迭代步之后,都会对邻接矩阵的dropout重新采样。对于传播过程,我们使用

对于

MICROSOFT ACADEMIC数据集,我们使用

注意:

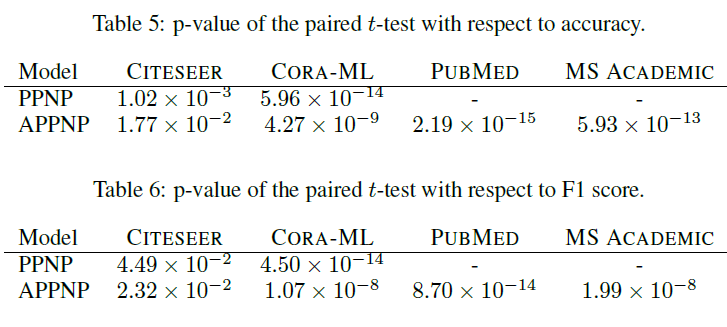

PPNP使用浅层的神经网络和较大的APPNP不同深度的网络对于验证集的准确率。可以看到:更深的预测网络无法提高准确率,这可能是因为简单的Bag-of-word特征以及训练集太小导致的。

另外,我们使用

Adam优化器并且所有模型的学习率都为0.01。我们使用交叉熵损失函数,并且将特征矩阵按行进行不同模型在测试集上的指标如下表所示,其中第一张表为

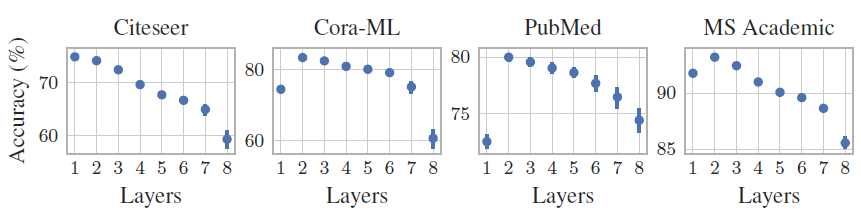

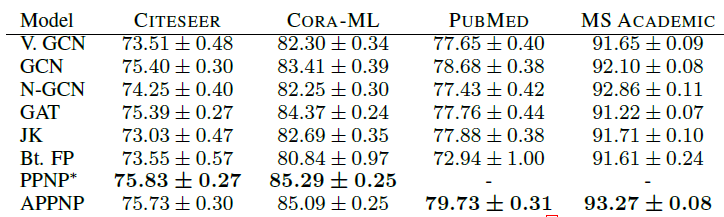

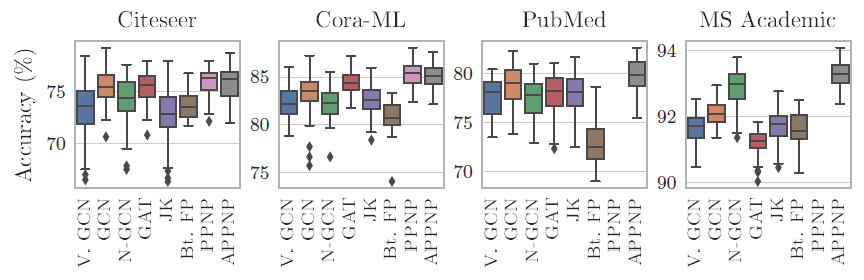

Micro-F1 Score,第二张表为Macro-F1 Score,最后两张表为t检验结果。*表示模型在PUBMED, MS ACADEMIC上Out Of Memory。结论:

我们的

PPNP/APPNP在所有数据集上均明显优于SOA baseline方法。我们的严格的比较方式可能会低估

PPNP/APPNP的优势。通过t检验表明,该比较结果具有统计学意义这种严格的比较方式还表明:当考虑更多的数据集拆分、适当地超参数优化、合理地模型训练时,最近的一些工作(如

N-GCN, GAT, JK-Net, FP等)的优势实际上消失了。在我们的配置中,一个简单的、经过超参数优化的

GCN就超越了最近提出的这几种模型。

我们给出不同模型在不同数据集上,由于不同的随机初始化以及不同的数据集拆分带来的测试准确率的变化。这表明严格的评估方式对于模型比较的结论至关重要。

此外,这还展示了不同方法的鲁棒性。如

PPNP, APPNP, GAT通常具有较低的方差。

我们考虑不同模型的训练时间。这里考虑每个

epoch的平均训练时间(而不是整个训练过程的时间)。我们并未考虑收敛速度(需要多少个epoch收敛),因为不同模型的超参数都各自调优,并且不同模型使用的early stopping准则不同(调优之后各自的patience不一样)。*表示无法实现,因为无法训练;**表示在PUBMED, MS ACADEMIC上Out Of Memory。结论:

PPNP只能应用于中等规模的图,APPNP可以扩展到大图。平均而言,

APPNP比GCN慢25%,因为APPNP的矩阵乘法的数量更多。但是APPNP的可扩展性和GCN相似。APPNP比GCN慢一些但是效果好一点点,所以这是一个速度和效果的trade-off。此外,如果GCN总的训练时间与APPNP相同(即,GCN多25%的epoch),是否二者效果一致?这样的话,APPNP就没有什么优势了。APPNP比其它更复杂的模型(如GAT)快得多。

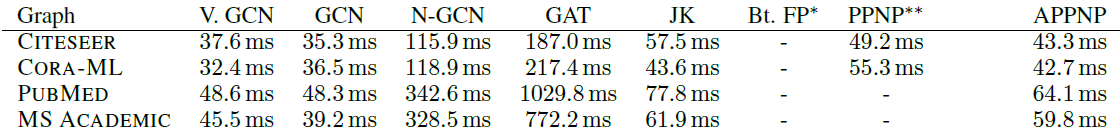

由于现实世界数据集的

label比例通常很小,因此研究小样本模型的性能非常重要。下图依次给出CORA_ML, CITESEER, PUBMED数据集上,每个类别训练节点数量结论:训练的

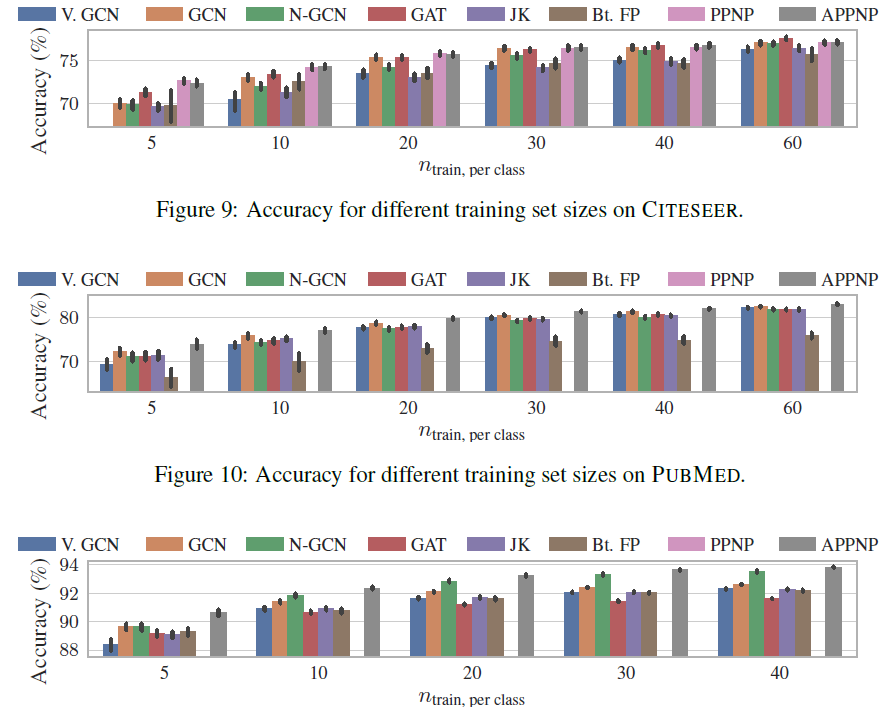

label节点越稀疏,PPNP/APPNP的优势越大。这可以归因于PPNP/APPNP较高的传播范围,从而将label节点传播到更远的地方。为支持这种归因,我们找到了更多的证据:我们比较了

APPNP和GCN的准确率的提升幅度 ,发现准确率提升幅度依赖于测试节点和训练集的距离(以最短路径衡量)。如下面最后一幅图所示,横坐标为最短路径(单位为hop),纵坐标为提升幅度,APPNP相对于GCN的性能提升,随着测试节点到训练集的距离的增加而增加。这表明距训练集较远的节点从APPNP的传播范围的增加中收益更多。

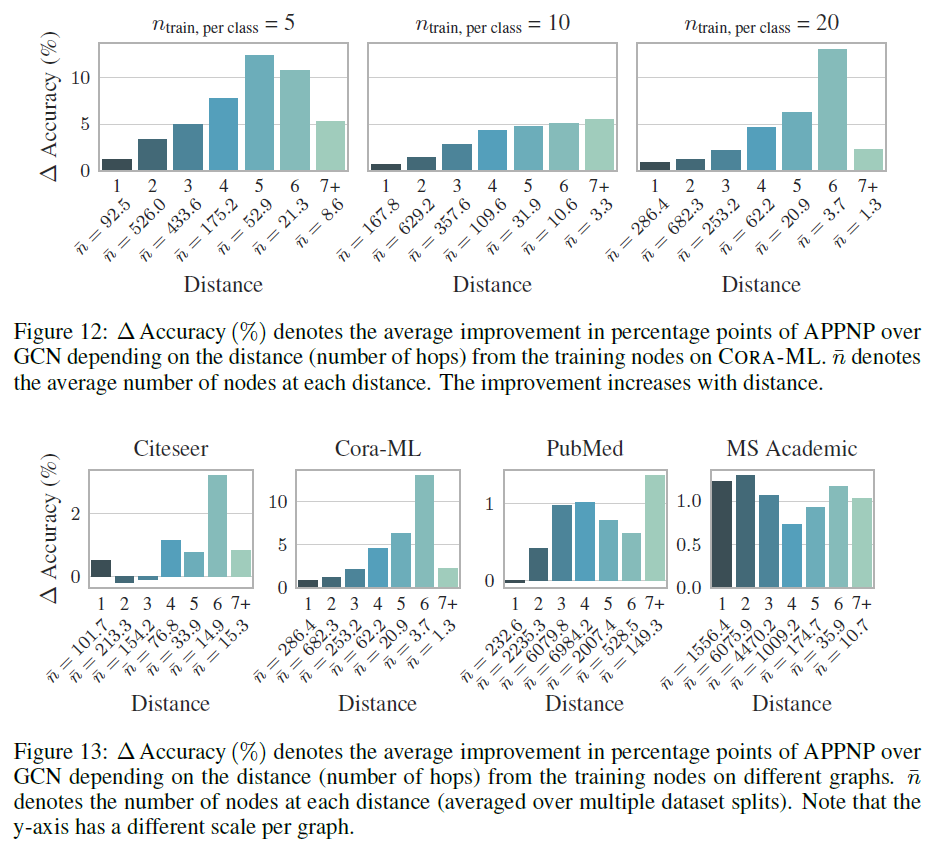

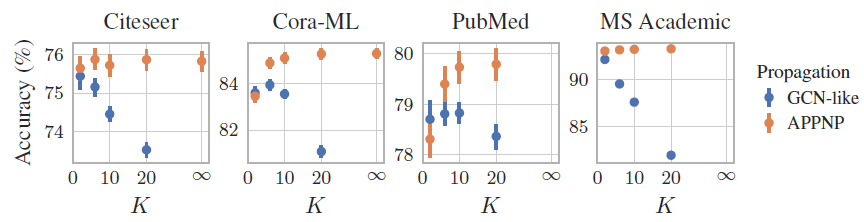

我们评估了幂次迭代

power iteration数量K来表示)对于模型准确性的影响。结论:

对于

GCN-like(对应于PageRank方法),其性能随着对于

APPNP(对应于Personalized PageRank),其性能随着当

APPNP收敛到PPNP。但是我们发现,当APPNP已经足以有效地逼近PPNP。有趣的是,我们发现这个数字和数据集的半径相符。

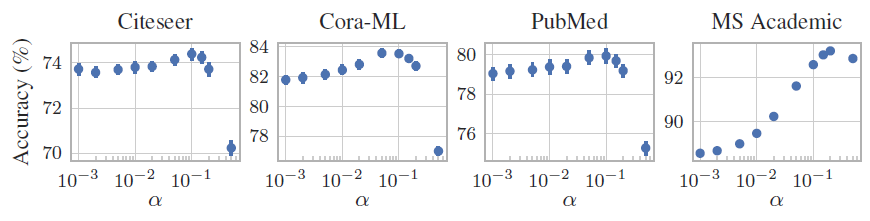

我们评估了超参数

结论:

- 尽管每个数据集的最优

- 应该对不同的数据集采用不同的

注意:较高的

- 尽管每个数据集的最优

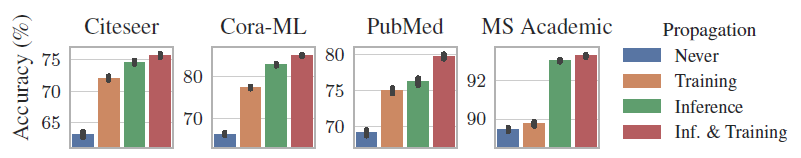

PPNP和APPNP虽然分为预测网络Never:表示从来不使用传播。这表示我们仅使用节点特征来训练和使用一个标准的多层感知机MLPTraining:表示我们使用APPNP来训练模型(采用了传播),但是在inference时仅使用Inference:表示我们仅使用特征来训练多层感知机inference时结合传播来预测。Inf & Training:表示常规的APPNP模型,即在训练和inference时总是使用传播。

结论:

Inf & Training总是可以获得最佳结果,这验证了我们的方法。在大多数数据集上,仅在

inference中使用传播时,准确率下降得很少。训练期间跳过传播可以大大减少大型数据集的训练时间,因为所有节点都可以独立地处理。

这也表明我们的模型可以与不包含任何图结构信息的预训练神经网络相结合,并可以显著提高其准确性。

Training相对于Never也有较大的改善。这表明仅在训练期间进行传播也是有价值的。因此我们的模型也可以应用于online/inductive learning,其中只有特征信息(而不是观察到的邻域信息)可用。

十七、VRGCN[2017]

图卷积网络

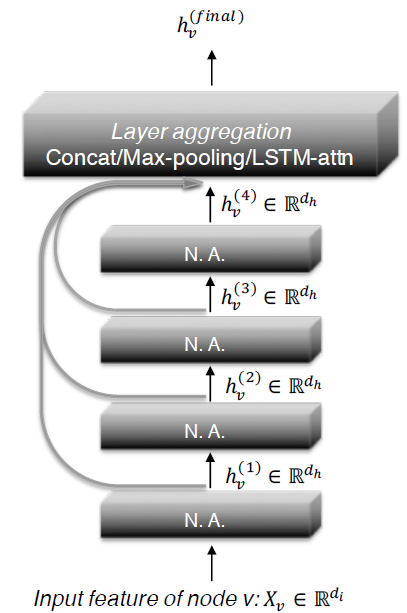

graph convolution network: GCN将卷积神经网络CNN推广到图结构化数据。图卷积graph convolution操作对节点的所有邻居应用相同的线性变换,然后是均值池化和非线性激活函数。通过堆叠多个图卷积层,GCN可以利用来自遥远邻居的信息来学习node representation。GCN及其变体已被应用于半监督节点分类、inductive node embedding、链接预测、 以及知识图谱,超越了不使用图结构的多层感知机MLP以及不使用节点特征的graph embedding方法。然而,图卷积操作使得

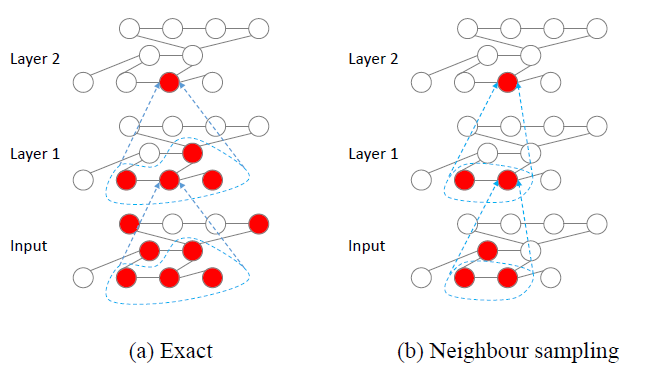

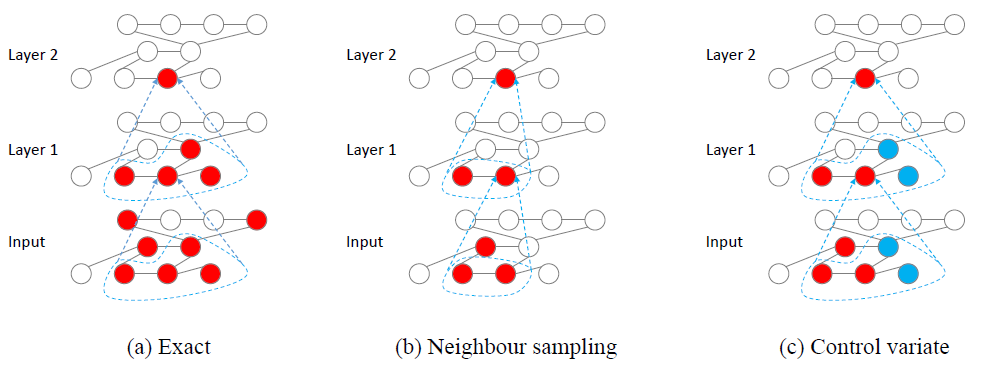

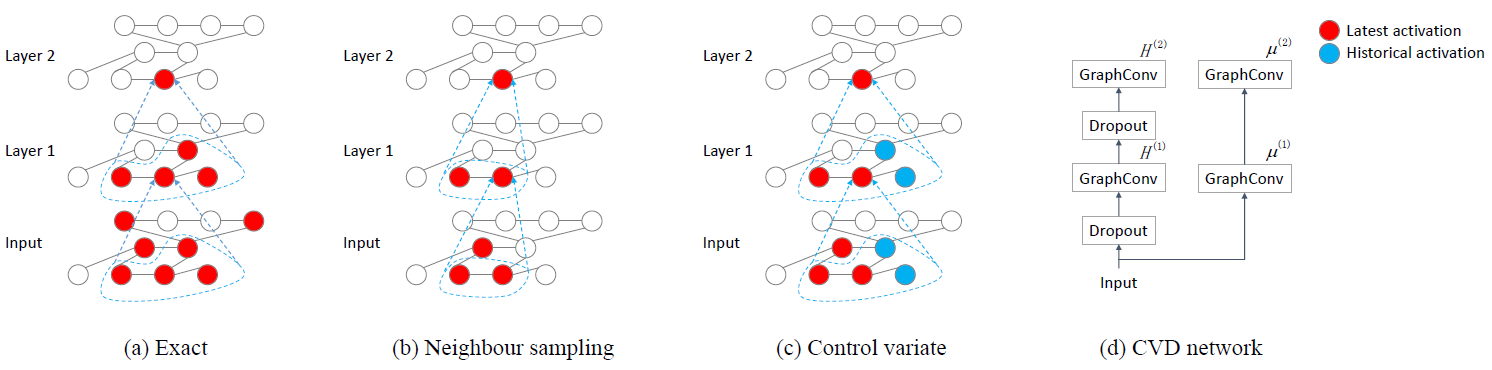

GCN难以高效地训练。考虑一个GCN,节点的第hidden feature需要递归地通过其邻域内所有节点的第hidden feature来计算。因此,如下图(a)所示,单个节点的感受野receptive field的大小随网络层数呈指数型增长。- 为解决感受野太大的问题,

《Semi-supervised classification with graph convolutional networks》提出通过batch算法来训练GCN,该方法同时计算batch内所有节点的representation。但是,由于batch算法收敛速度慢,以及需要将整个数据集放入到GPU中,因此无法处理大规模数据集。 《Inductive representation learning on large graphs》尝试邻域采样neighbor sampling: NS的方法为GCN提出随机训练算法。在NS算法中,他们并未考虑节点的所有邻居,而是为每个节点在第(b)所示。这可以将感受野的大小减小到GCN网络,选择GCN相当的性能。

理论上当

MLP。虽然Hamilton的方法复杂度降低,但是仍然比MLP要大另外,使用基于邻域采样的随机训练算法能否确保模型收敛,尚无理论上的保证。

在论文

《Stochastic Training of Graph Convolutional Networks with Variance Reduction》中,作者为GCN设计了新颖的基于控制变量的control variate-based随机逼近算法,即GCN with Variance Reduction: VRGCN。VRGCN利用节点的历史激活值(即历史hidden feature)作为控制变量control variate。作者表明:通过邻域采样NS策略得到的hidden feature的方差取决于hidden feature的幅度magnitude(因为hidden feature是一个向量),而VRGCN得到的hidden feature的方差取决于hidden feature和它历史均值之间的差异difference。另外,

VRGCN还带来了理论上的收敛性保证。VRGCN可以给出无偏的(相比较于原始的GCN)、零方差的预测。并且训练算法可以收敛到GCN损失函数的局部最优值,而与采样大小VRGCN可以通过仅对节点采样两个邻居节点来显著降低模型的时间复杂度,同时保持模型的质量。作者在六个

graph数据集上对VRGCN进行了实验测试,并表明VRGCN显著降低了具有相同感受野大小的NS的梯度的偏差bias和方差variance。尽管仅采样VRGCN在所有数据集上的可比数量的epoch中实现了与精确算法相同的预测性能,即,VRGCN降低了时间复杂度同时几乎没有损失收敛速度,这是我们可以预期的最好结果。在最大的Reddit数据集上,VRGCN算法的训练时间相比精确算法(《Semi-supervised classification with graph convolutional networks》)、邻域采样算法(《Inductive representation learning on large graphs》)、重要性采样算法(《Fastgcn: Fast learning with graph convolutional networks via importance sampling》)要少7倍。

- 为解决感受野太大的问题,

17.1 模型

17.1.1 GCN

我们以半监督节点分类任务的

GCN作为说明,当然我们的算法不局限于任务类型,也不局限于模型类型。我们的算法适用于任何涉及到计算邻居平均激活值的其它模型,以及其它任务。给定图

每个节点

labellabel,这部分节点的集合记作label。定义邻接矩阵

定义传播矩阵

propagation matrix其中

self-loop的邻接矩阵。因此一个图卷积层可以定义为(假设当前为第

其中:

hidden feature矩阵,也称作激活矩阵activataion matrix。第

hidden feature向量,也称作激活值activation。

假设

GCN模型有GCN模型的训练损失函数为:其中:

final representation。

卷积层通过

hidden feature向量为:它就是

hidden feature的加权和。定义节点

receptive field为:为计算- 对于一个

GCN,节点L-hop邻域集合。 - 当

GCN退化为一个多层感知机MLP,其中不涉及任何图结构信息。对于多层感知机,节点

- 对于一个

GCN训练损失函数的batch梯度为:由于每次迭代都涉及整个标记节点集合

batch梯度代价太大。一个可行的方案是采用随机梯度作为

batch梯度的近似值:其中

mini-batch。但是,由于感受野太大,

mini-batch梯度的计算代价仍然很高。例如,NELL数据集的2-hop邻域平均包含1597个节点,这意味着在一个2层GCN中,为计算单个节点的梯度需要涉及1597/65755 = 2.4%的全部节点。

17.1.2 GraphSAGE

为降低感受野大小,

GraphSAGE提出了邻域采样neighbor sampling: NS策略。 在第NS策略随机采样hidden feature其中

因此

NS策略降低了感受野大小,从L-hop邻域大小降低到采样后的邻域大小我们将

NS估计量,而exact。上述邻域采样策略以矩阵的形式可以重写为:

其中传播矩阵

在

GraphSAGE的随机梯度下降过程中,存在两个随机性来源:- 选择

mini-batch - 选择大小为

尽管

NS策略中节点的final representaion矩阵NS策略中随机梯度下降SGD的收敛性得不到保障,除非采样大小- 选择

在

GraphSAGE中,由于梯度是有偏的,因此NS策略中的采样大小exact策略相近的预测性能。在

GraphSAGE中Hamilton选择MLP的感受野(大小为1),因此训练仍然代价较高。

17.1.3 FastGCN

FastGCN是另一种类似于NS的基于采样的算法。FastGCN并没有为每个节点采样邻域,而是直接采样每一层的、所有节点共享的感受野。对于第

FastGCN首先采样hidden feature其中重要性分布:

我们将这种邻域均值

hidden feature的估计称作重要性采样importance sampling: IS。- 注意,

IS采样策略和NS采样策略的区别在于:前者为第 - 当

IS可以视为NS,因为每个节点NS可以看作是IS的一种。

- 注意,

尽管

IS策略的感受野大小为NS策略的感受野大小IS仍然仅在采样大小从实验来看,我们发现

IS策略的效果要比NS更差,这是因为:在IS策略中我们为所有节点采样了共同的一组节点集合,对于部分节点我们采样到了它们的很多个邻居,对于另一些节点我们没有采样到任何邻居。对于后者,这些节点的邻域均值hidden featurehidden feature

17.1.4 控制变量

我们提出一种新的基于控制变量

control variate: CV的算法,该算法基于历史hidden feature来降低估计量的方差。当计算邻域均值

hidden featureaffordable的近似值。每次计算令

定义:

其中

这里的核心思想是:主要的

因为主要部分是精确值,次要部分是近似值,因此这会大幅度降低近似计算带来的影响。

则有:

hidden featureCV估计量。写作矩阵的形式为:其中

这里我们仅对

由于我们预期

即估计量的偏差和方差都为零。

我们定义控制变量

control variate为:我们将控制变量

NS的现在

采用

CV估计量来训练GCN的方法和NS估计量都相同。具体而言,在GCN的每轮迭代中都执行以下算法。VRGCN迭代算法:随机选择一个

mini-batch的节点构建一个计算图,其中包含当前

mini-batch每个节点的hidden feature计算时需要的其它节点的hidden feature根据下面的前向传播公式进行传播:

这里控制变量

通过反向传播计算梯度,并更新参数。

更新

hidden feature历史均值

其中,第二步的计算图是通过每层的感受野

hidden featuremini-batch。我们自顶向下构建

令

对于第

注意:我们假设

VRGCN的感受野如下图(c)所示,其中红色节点为感受野,其hidden featuremini-batch。蓝色节点的历史hidden feature均值mini-batch。

17.1.5 理论分析

为便于理论分析估计量的方差,这里我们假设所有的特征都是一维的。通过分别处理每个维度,我们的分析结论可以推广到多维。

假设

其中

根据以上结论,对于

NS估计量我们有:即邻域内所有邻居

pair对的加权hidden feature之间的距离之和。如果邻域内所有节点的同样地,对于

CV估计量我们有:相比较于

NS估计量,这里仅需要将CV估计量通常都比NS估计量的方差更小。进一步地,正如我们在下文中分析到的,由于训练期间 间

除了较小的方差,

CV估计量比NS估计量还具有更强的理论收敛性保证。这里我们提出两个定理:- 如果模型参数固定,则在

inference期间,CV会在epoch之后产生exact预测。 - 无论邻域采样大小如何,模型都会朝着局部最优解收敛。

- 如果模型参数固定,则在

假设算法执行多个

epoch,在每个epoch中我们将节点集合mini-batch:mini-batchhidden feature均值。注意:在每个

epoch中我们扫描所有节点,而不仅仅是标记的训练节点,从而确保每个epoch中对每个节点的历史hidden feature均值至少进行了一次更新。记第

SGD随时间更新,在测试期间记第

exact hidden feature为CV估计量的hidden feature为在第

mini-batch对于

exact算法,其损失函数和梯度分别为:对于

exact算法,如果constant序列,则可以忽略下标对于

CV算法,其损失函数和梯度分别为:梯度

- 选择

mini-batch - 选择大小为

因此我们考虑

- 选择

以下定理解释了

CV的近似预测和exact预测之间的关系:对于一个

constant sequenceepoch之后),通过CV估计量计算的hidden feature和exact计算的相等。即:其证明见原始论文附录。

该定理表明:在

inference期间,我们可以使用CV估计量进行前向传播epoch(通常GCN网络中exact预测。这优于NS估计量,因为除非邻域大小无穷大,否则NS估计量无法恢复exact预测。和直接进行

exact预测的batch算法相比,CV估计量可扩展性更强,因为它不需要将整个图加载到内存中。以下定理表明,无论邻域采样大小

SGD训练仍然收敛于局部最优。因此我们可以选择任意小的定理:假设:

激活函数

损失函数的梯度

对于任意的采样

损失函数

其中

则存在

SGD迭代时,有:其中:

[1, N]之间均匀随机分布的变量。每次迭代都使用

CV的近似梯度其中步长

从定理中我们看到:

简而言之,我们证明了近似梯度

SGD收敛到局部最优解。

17.1.6 dropout

这里我们引入第三种随机性来源:对输入特征的随机

dropout。令

dropout算子,其中iid的伯努利随机变量,记

dropout的期望。引入

dropout之后,即使在GCN中采用exact算法,hidden featuredropout。此时节点的邻域均值

hidden feature在

dropout场景下,dropout控制变量control variate for dropout: CVD。我们的方法基于权重缩放

weight scaling技术来近似计算均值dropout模型中,我们可以运行没有dropout的模型的copy,从而获得均值(d)所示。

我们通过

CVD估计量。我们将

其中:

CV估计量中的dropout)和dropout)之间的差距。

因此定义:

则有:

第一项考虑

dropout current value和no-dropout current value之间的gap,使用no-dropout current value和no-dropout avg value之间的gap。第三项就是no-dropout avg value本身。考虑第一项对于

dropout具有零均值,即第一个等式成立是因为当移除

dropout时,CVD估计量就退化为CV估计量。因此,

CVD估计量是无偏的。下面我们即将看到,如果CVD估计量具有良好的方差。假设节点的

hidden feature之间不相关,即假设

则有:

令

这些结论的证明参考原始论文的附录。

通过上述结论,我们有:

我们将第一项视为从

dropout中引入的方差variance from dropout: VD,第二项视为从邻域采样中引入的方差variance from neighbor sampling: VNS。理想情况下,VD应该等于VNS应该等于零。和前述相同的分析,我们可以通过将

VNS。令 :根据这里的第一个结论,

CVD的VD部分为:exact估计量的VD部分。我们总结出所有这些估计量及其方差,推导过程参考原始论文。

exact:VNS部分为零,VD部分为NS估计量:VNS部分为VD部分为CV估计量:VNS部分VD部分CVD估计量:VNS部分VD部分为

CV/CVD的VNS取决于NS的VNS取决于非零的

17.1.7 预处理

有两种可能的

dropout方式:区别在于:第一种方式是在邻域聚合之前应用

dropout、第二种方式在邻域聚合之后应用dropout。《Semi-supervised classification with graph convolutional networks》采用前者,而我们采用后者。实验效果上,我们发现这两种方式的效果都相差无几,因此不同的方式不影响模型的效果。采用第二种方式的优势是提升训练速度:我们可以对输入进行预处理,并定义

由于大多数

GCN仅有两层卷积层,因此这种方式可以显著减少感受野大小,并加快训练速度。我们称该优化为预处理策略preprocessing strategy。

17.2 实验

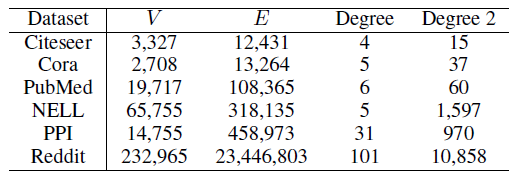

我们在六个数据集上通过实验验证了

VRGCN算法的方差和收敛性,其中包括来自GCN的Citeseer, Cora, PubMed, NeLL四个数据集以及来自GraphSAGE的PPI, Reddit两个数据集。对于这些数据集的统计见下表所示。最后两列给出了节点的

1-hop邻域平均大小、2-hop邻域平均大小。由于是无向图,因此每条边被计算两次,但是self-loop仅被计算一次。- 对于每个数据集,所有模型在该数据集上采用相同的训练集/验证集/测试集拆分 (而不是每个模型单独的一个拆分)。

- 对于

PPI数据集(多标签分类数据集)我们报告测试集的Micro-F1指标,对于其它多分类数据集我们报告准确率accuracy。 - 对于

Citeseer, Cora, PubMed, NELL数据集,baseline模型为GCN;对于PPI, Reddit数据集,baseline模型为GraphSAGE。 - 对于收敛性实验,我们在

Citeseer, Cora, PubMed, NELL数据集上重复执行10次,在Reddit, PPI数据集上重复执行5次。 - 所有实验都在

Titan X GPU上完成。

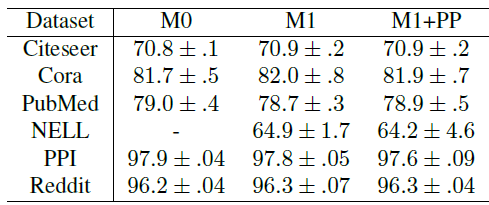

首先我们评估预处理

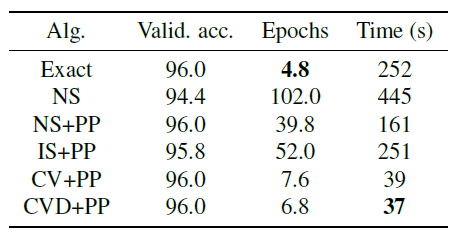

PreProcessing: PP的影响。我们比较了三种配置:M0:dropout在前、计算邻域均值在后,且计算邻域的exact均值(未对邻域进行任何采样)M1:计算邻域均值在前、dropout在后,且计算邻域的exact均值(未对邻域进行任何采样)M1 + PP:计算邻域均值在前、dropout在后,且使用较大的邻域大小exact的。

实验结果如下所示。我们固定了训练的

epoch,然后给出不同配置的GCN在不同数据集上的测试accuracy。我们的实现不支持NELL上的M0配置,因此未报告其结果。可以看到:三种配置都具有相近的性能,即更换

dropout的位置不会影响模型的预处性能。因此后续的收敛性实验中,我们以最快的M1 + PP配置作为exact baseline。

然后我们评估

VRGCN的收敛性。我们将M1 + PP配置作为exact baseline,然后对比MLP。我们对四种近似策略进行比较,其中NS:没有使用预处理的NS估计量(邻域采样)。NS + PP:采用了预处理的NS估计量。IS + PP:采用了预处理的IS估计量(重要性采样)。CV + PP:采用了预处理的CV估计量。CVD + PP:采用了预处理的CVD估计量。

当

epoch都具有很低的、相近的时间复杂度,相比之下baseline M1 + PP的baseline相比,它们的收敛速度。首先我们不考虑

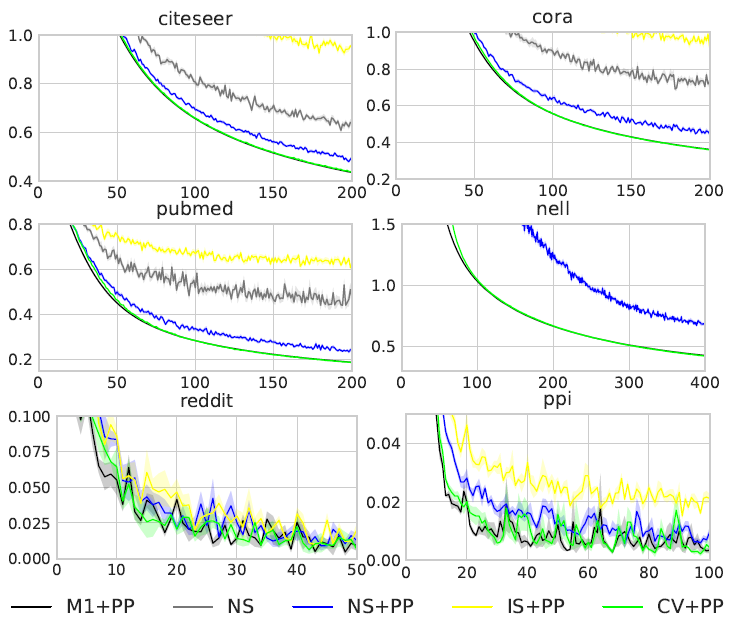

dropout(dropout rate = 0),然后绘制不同方法每个epoch的损失函数值,如下图所示。在前

4个数据集中,CV + PP的损失曲线和exact损失曲线相重叠;部分数据集上未给出NS损失曲线和IS + PP损失曲线,因为损失太大;我们并未绘制CVD + PP,因为当dropout rate = 0时,它等价于CV + PP。结论:

CV + PP总是可以达到和M1 + PP相同的训练损失。NS, NS + PP, IS + PP由于它们的梯度是有偏的,因此其训练损失更高。

这些结果和前述定理相符。定理指数:

CV估计量的训练能够收敛到exact的局部最优,和

然后我们考虑使用

dropout,然后比较每个epoch使用不同方式训练的模型验证accuracy。其中不管训练算法采取何种方式,inference都采用exact算法来预测。结果如下图所示。注意:NS在Reddit数据集上收敛到0.94、在PPI数据集上收敛到0.6,由于太低所以未在图中给出。结论:

当存在

dropout时,CVD + PP是唯一可以在所有数据集上达到和exact算法相近的验证准确率的算法。当存在

dropout时,CVD + PP的收敛速度(以epoch数量衡量)和M1 + PP相当。这意味着尽管CVD + PP的收敛速度几乎没有损失。这已经是我们期待的最佳结果:具有和

MLP可比的计算复杂度,但是具有和GCN相近的模型质量。在

PubMed数据集上,CVD + PP性能比M1 + PP好得多,我们怀疑它找到了更加的局部最优值。对

PPI以外的所有其它数据集,简单的CV + PP的准确率就可以和M1 + PP相媲美。在

Reddit,PPI数据集上,IS + PP性能比NS + PP更差。这可能是部分节点没有采样到任何邻居,正如我们前文所述。我们对

IS + PP的准确率结果和FastGCN的报告结果相符,而他们的GraphSAGE baseline并未实现预处理技术。

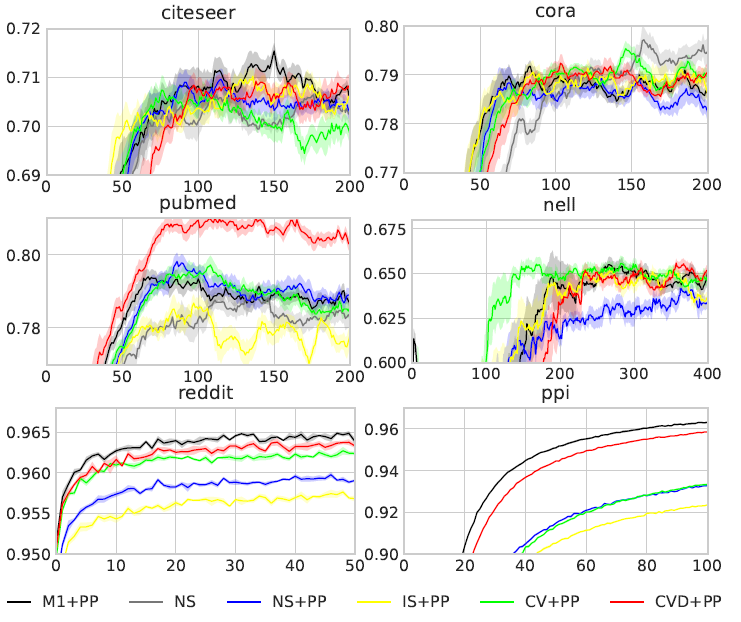

下面给出了在最大的

Reddit数据集上达到给定的96%验证准确率所需要的平均训练epoch和训练时间。可以看到:CVD + PP比exact快7倍左右。这是因为CVD + PP的感受野大小显著降低。另外,

NS, IS + PP无法收敛到给定的准确率(即无法收敛到96%验证准确率)。

我们使用相同的、由

M1 + PP训练的模型,然后采用不同的算法进行预测,并给出预测质量。如前所述,

CV可以达到和exact算法相同的测试准确率,而NS, NS + PP的性能要差得多。

最后,我们比较了训练期间第一层权重每一维梯度的平均

bias和方差(对权重自身进行了归一化)。结论:

- 对于没有

dropout的模型,CV + PP的梯度几乎所无偏的。 - 对于存在

dropout的模型,CV + PPheCVD + PP梯度的bias和方差通常小于NS和NS + PP。

- 对于没有

十八、ClusterGCN[2019]

图卷积网络

graph convolutional network: GCN在解决许多graph-based的应用程序中变得越来越流行,包括半监督节点分类、链接预测、推荐系统。给定一个图,GCN使用图卷积操作逐层获得node embedding:在每一层,节点的embedding是通过收集其邻居的embedding来获得的,然后是一层或几层的线性变换和非线性激活。然后将最后一层的embedding用于一些终端任务。由于

GCN中的图卷积运算需要利用图中节点之间的交互来传播embedding,因此GCN的训练非常困难。和其它神经网络不同,GCN的损失函数中每个节点对应的损失不是相互独立的,而是依赖于大量其它节点,尤其是当GCN的深度很深时。相比之下,其它神经网络的损失函数中,每个样本的损失是相互独立的。由于节点的依赖性,GCN的训练非常缓慢并且需要大量的内存,因为反向传播阶段需要将图中所有的embeding存储到GPU内存中。为了说明研究可扩展的

GCN训练算法的必要性,我们从以下三个因素来讨论现有算法的优缺点:内存需求、epoch训练速度(每个epoch的训练时间)、epoch收敛速度(每个epoch损失函数下降的值)。这三个因素对于评估训练算法至关重要。注意:内存需求直接限制了算法的可扩展性,epoch训练速度和epoch收敛速度一起决定了整个训练时间。令

embedding维度、GCN的深度。full-batch梯度下降:GCN原始论文使用full-batch梯度下降来训练。为计算整个训练集损失的梯度,它需要存储所有中间embedding(intermediate embedding),从而导致另外,尽管每个

epoch训练时间高效(单个epoch训练时间很短),但是单个epoch的收敛速度很慢,因为每个epoch仅更新一次参数。整体而言,

full-batch梯度下降内存需求差、epoch训练速度快、epoch收敛速度慢。mini-batch随机梯度下降:GraphSAGE使用了基于mini-batch的随机梯度下降来训练。由于每次迭代仅基于mini-batch梯度,因此它可以减少内存需求,并在每个epoch进行多次更新从而加快epoch收敛速度。但是,由于邻域扩展问题,

mini-batch随机梯度下降会引入大量的计算开销:为计算第embedding,而这又需要邻域节点的邻域节点在第embedding,并向底层不断递归。这导致计算的时间复杂度和GCN的深度GraphSAGE提出使用固定数量的邻域样本,而FastGCN提出了重要性采样。但是这些方法的开销仍然很大,并且当GCN层数更深时情况更糟。整体而言,

mini-batch随机梯度下降内存需求好、epoch训练速度慢、epoch收敛速度快。VR-GCN:VR-GCN提出方差缩减variance reduction技术来减少邻域采样规模。尽管这种方法成功地降低了邻域采样的数量(在Cluster-GCN的实验中,VR-GCN对每个节点仅采样2个邻居的效果很好),但是它仍然需要将所有节点的中间embedding存储在内存中,从而导致VR-GCN的内存需求可能太高导致无法放入到GPU中。整体而言,

VR-GCN内存需求差、epoch训练速度快、epoch收敛速度快。

论文

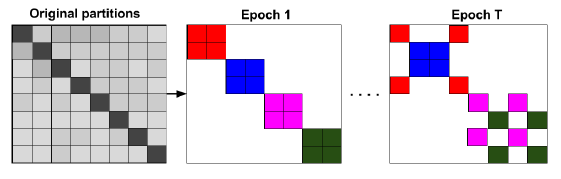

《Cluster-GCN: An Efficient Algorithm for Training Deep and Large Graph Convolutional Networks》提出了一种新的GCN训练算法,该算法利用图聚类结构graph clustering structure来加速GCN的训练。作者发现:

mini-batch算法的效率可以通过embedding利用率embedding utilization的概念来刻画。embedding利用率和单个batch内的边的数量成正比。这一发现促使作者利用图聚类算法来设计batch,目标是构造分区partition使得同一个分区内的边的数量比跨区之间的边的数量更多。基于图聚类

graph clustering的思想,作者提出了Cluster-GCN:一种基于图聚类算法(如METIS)来设计batch的算法。进一步地,作者提出一个随机多聚类框架stochastic multi-clustering framework来改善Cluster-GCN的收敛性。核心思想是:尽可能地将内存和计算控制在

batch内。这要求仔细安排batch内节点。但是,这么做破坏了

mini-batch的随机性要求,因为mini-batch要求随机选取batch-size),而Cluster-GCN中的采样方法不再随机。这使得mini-batch梯度不再是full-batch梯度的无偏估计。作者的解决办法是:随机将多个簇合并为一个大簇,然后将这个大簇作为

mini-batch,使得batch内的节点分布尽可能和full-batch一致。Cluster-GCN带来了巨大的内存优势和计算优势:- 在内存需求方面,

Cluster-GCN仅需要将当前batch中的节点embedding存储在内存中,内存复杂度为batch-size。这比VR-GCN、full-batch梯度下降、以及其它mini-batch随机梯度下降等方法要小得多。 - 在计算复杂度方面,

Cluster-GCN在每个epoch都具有相同的时间代价,并且比邻域搜索方法快得多。 - 在收敛速度方面,

Cluster-GCN相比其它SGD-based方法具有可比的竞争力。 - 最后,

Cluster-GCN算法易于实现,因为它只需要计算矩阵乘法,而无需任何邻域采样策略。

整体而言,

Cluster-GCN内存需求好、epoch训练速度快、epoch收敛速度快。通过对几个大型图数据集进行全面实验,证明了

Cluster-GCN的效果:Cluster-GCN在大型图数据集(尤其是深层GCN)上实现了最佳的内存使用效率。例如在Amazon2M数据集上的3层GCN模型中,Cluster-GCN使用的内存比VR-GCN少5倍。对于浅层网络(例如

2层),Cluster-GCN达到了和VR-GCN相似的训练速度;但是当网络更深(如4层)时,Cluster-GCN可以比VR-GCN更快。这是因为Cluster-GCN的复杂度和层数VR-GCN的复杂度是Cluster-GCN能够训练具有很大embedding size并且非常深的网络。尽管之前的一些工作表明:深层

GCN无法提供更好的性能,但是作者发现通过适当的优化,深层GCN可以帮助提高模型准确性。例如使用5层GCN,Cluster-GCN在PPI数据集上的accuracy为99.36,而之前的最佳效果为98.71。

18.1 模型

给定图

- 节点

- 节点

labellabel的节点集合为

定义一个包含

GCN,其中第其中:

representation矩阵,representation向量的维度。representation向量。为简化讨论,我们假设

其中

self-loop的邻接矩阵。ReLU。

GCN模型的损失函数为:其中:

final representation。

我们首先讨论之前方法的一些不足,从而启发我们提出

Cluster-GCN。原始

GCN:原始GCN中,作者通过full-batch梯度下降来训练GCN,其计算代价和内存需求都很高。- 在内存需求方面,通过反向传播来计算损失函数的梯度需要

embedding矩阵 - 在收敛速度方面,由于模型每个

epoch仅更新一次参数,因此模型需要训练很多个epoch才能收敛。

- 在内存需求方面,通过反向传播来计算损失函数的梯度需要

GraphSAGE:GraphSAGE通过mini-batch SGD来改善GCN的训练速度和内存需求。SGD不需要计算完整的梯度,而是仅在每轮更新中基于一个mini-batch来计算梯度。记

mini-batch节点集合为SGD迭代中,梯度的估计量为:尽管

mini-batch SGD在收敛速度方面更快,但是它在GCN训练过程中引入了另一种计算开销,这使得它与full batch梯度下降相比,每个epoch的训练速度慢得多。原因如下:考虑计算单个节点embeddingrepresentation,而这又依赖于这些邻域节点的邻域节点在第representation,... 。假设

GCN具有degree为hop-k(representation向量需要如果一个

batch中有很多节点,则时间复杂度就不是那么直接,因为不同节点具有重叠的top-k邻域,那么依赖的节点数量可以小于最差的

为反应

mini-batch SGD的计算效率,我们定义embedding利用率embedding utilization的概念,从而刻画计算效率。在算法过程中,如果节点

embedding计算之后,被第embedding计算过程使用了embedding利用率为- 对于具有随机采样的

mini-batch SGD,由于图通常比较大且稀疏,因此hop-k邻域之间几乎没有重叠),则mini-batch SGD在每个batch需要计算embedding,这导致每个mini-batch的训练时间为epoch的训练时间为 - 相反,对于

full-batch梯度下降,每个embedding将在更上一层中重复利用degree),因此具有最大的embedding利用率。结果full-batch SGD在每个epoch需要计算embedding,训练时间为embedding就可以得到一个节点的梯度,相比之下mini-batch SGD需要计算embedding。

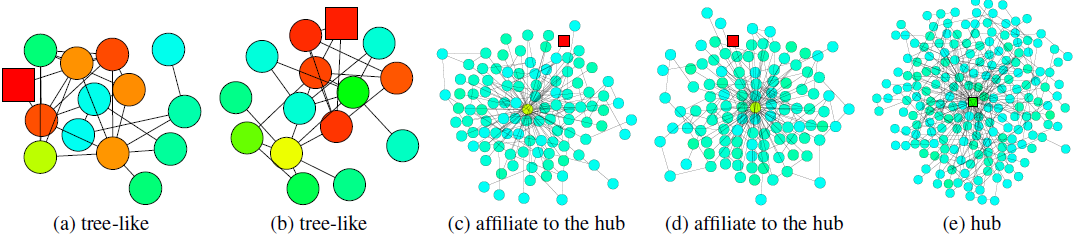

如下图所示给出了传统的

GCN中指数级邻域扩展(左图)。红色节点是扩展的起始节点,不同颜色代表不同的hop。

- 对于具有随机采样的

为了使得

mini-batch SGD顺利工作,已有的一些算法试图限制邻域扩展的大小,但是这无法提升embedding利用率。GraphSAGE均匀采样一个固定大小的邻域,而不是完整的邻域集合。我们将这个固定大小记作embedding,并且也使得梯度估计的准确性降低。FastGCN提出了一种重要性采样策略来改善梯度估计。VR-GCN提出了一种策略,通过存储所有embedding的历史均值,从而应用于未采样邻居节点的embedding计算。尽管存储所有

embedding的内存需求很高,但我们发现该策略非常有效,并且在实践中即使对于非常小的

18.1.1 Cluster-GCN

Cluster-GCN技术受到以下问题的启发:在mini-batch SGD更新过程中,能否设计mini-batch以及对应的计算子图,使得最大程度地提高embedding利用率?解决该问题的关键在于将embedding利用率和聚类相结合。考虑我们计算

batch1层到第embedding。定义embedding利用率是这个batch内链接的数量因此,为了最大化

embedding利用率,我们应该设计一个batchbatch内链接的数量,这使得我们可以将SGD更新的效率和图聚类算法联系起来。现在我们正式地介绍

Cluster-GCN。对于图subgraph:其中

经过节点的重新排列之后,图

其中:

- 每个对角块

同样地,我们可以根据

label为label组成。现在我们用块对角矩阵

cluster(每个cluster对应一个batch)。令

embedding矩阵变为:其中

因此损失函数可以分解为:

在每一步我们随机采样一个簇

SGD更新。在这个更新过程中,仅依赖于当前batch的子图label可以看到,

Cluster-GCN仅需要进行矩阵乘法和前向/反向传播,而之前的SGD-based方法中需要对邻域进行搜索,因此我们的方法更容易实现。- 每个对角块

Cluster-GCN使用图聚类算法对图进行分组。图聚类算法(如Metis和Graclus)旨在对图的节点进行划分,使得簇内的链接比簇间的链接更多,从而更好地捕获图的聚类和社区结构。这正是我们需要的结果,因为:- 如前所述,

embedding利用率等于每个batch的batch内链接数量。 - 由于我们用块对角矩阵

- 如前所述,

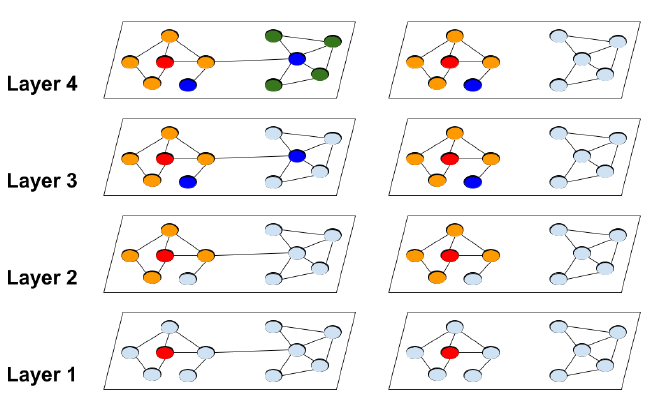

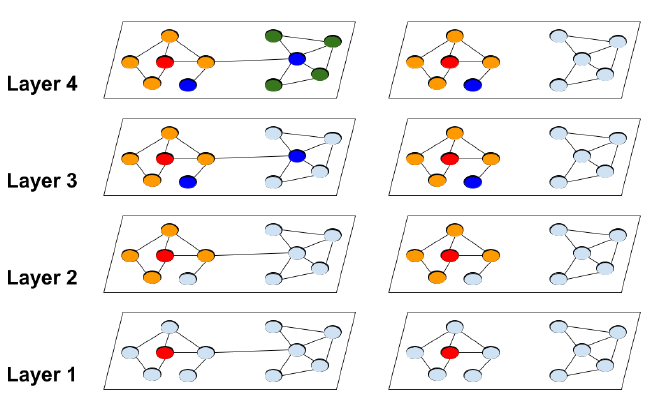

下图给出了在完整图

hop。可以看到:

Cluster-GCN可以避免繁重的邻域搜索,从而将精力集中在每个簇内的邻居上。

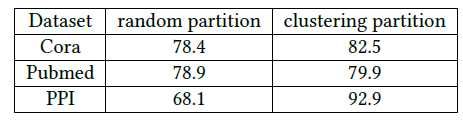

我们比较了两种不同的节点划分策略:随即划分

random partition、聚类划分clustering partition。我们分别通过随即划分、

METIS聚类划分将图划分为10个分组,然后每个分组作为一个batch来执行SGD更新。数据集为三个GCN公共数据集,评估指标为测试集F-1 score。可以看到:在相同epoch下,使用聚类划分可以获得更高的准确性。这表明使用图聚类很重要,并且不应该使用随机划分。

算法复杂度:由于仅考虑

batch的复杂度仅有矩阵乘法batch的时间复杂度为epoch的时间复杂度为平均而言,每个

batch只需要计算embedding,它是线性的而不是batch的空间复杂度为另外,我们的算法仅需要将子图加载到

GPU内存中,无需加载整个图(虽然整个图的存储通常不是瓶颈)。我们在下表中总结了时间复杂度和空间复杂度。显然,所有

SGD-based算法在层数方面都是指数复杂度。对于VR-GCN,即使GPU的内存容量。接下来我们介绍我们的

Cluster-GCN算法,它兼顾了full-batch梯度下降下每个epoch的时间复杂度、以及在普通SGD梯度下降下的空间复杂度。其中:

embedding维度(为方便起见,所有层的embedding以及输入特征的维度都是node degree,mibi-batch size,注意:

由于采用了方差缩减技术,

VR-GCN的GraphSAGE和FastGCN。对于空间复杂度,

embedding。为简单起见,我们忽略了存储

Graph以及子图的需求,因为它们通常都是固定的,且通常不是主要瓶颈。Cluster-GCN具有最好的计算复杂度和最好的空间复杂度。从实验部分得知,

Cluster-GCN的最大优势是内存需求更小从而可以扩展到更大的图。训练速度和训练准确率方面,Cluster-GCN和VR-GCN各有优势(在不同的层数方面)。

18.1.2 随机多重聚类 SMC

尽管前述的

Cluster-GCN实现了良好的计算复杂度和空间复杂度,但是仍然有两个潜在的问题:- 对图进行划分之后,某些链接被删除了(即

- 图聚类算法倾向于将相似的节点聚合在一起,因此每个

batch的节点分布和原始数据集不一致,从而导致在SGD更新时,batch的梯度是完整梯度的一个有偏的估计。

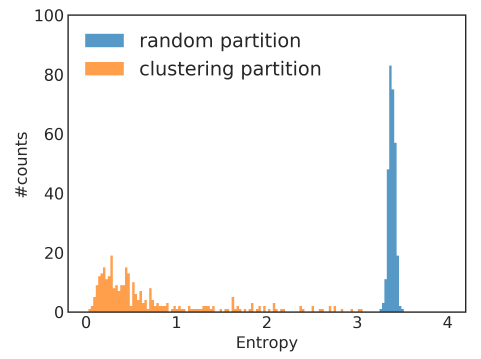

我们以

Reddit数据集为例,考察随机划分来选择mini-batch、通过Metis聚类算法选择mini-batch的数据分布的差异,划分数量为300个分区。数据分布以batch内节点标签分布的熵来衡量。我们给出不同batch的标签熵label entropy的分布直方图如下所示,可以看到:- 大多数聚类

batch具有较低的标签熵,这表明聚类的batch倾向于某些特定的label,从而与整体的数据分布不一致。这可能会影响SGD算法的收敛性。 - 随机

batch具有较高的标签熵,这表明随机batch的数据分布和整体数据分布更为一致。

- 对图进行划分之后,某些链接被删除了(即

为解决这些问题,我们提出了一个随机多重聚类框架

stochastic multiple clustering: SMC,该框架通过随机合并多个簇,从而减少batch之间的数据分布差异。我们首先将节点划分到

batchbatch通过这种方式,所有簇间链接将被重新合并到模型中,并且簇的随机组合可以使得

batch之间的数据分布的差异更小。这种随机多重聚类框架如下图所示,每个

batch包含2个簇,相同的batch的簇具有相同的颜色。不同的epoch中选择不同的簇组合。这种方法只能缓解问题,但是无法解决问题。因为即使是随机组合多个簇,新的

batch内节点分布与整体分布仍然是有差异的。

我们在

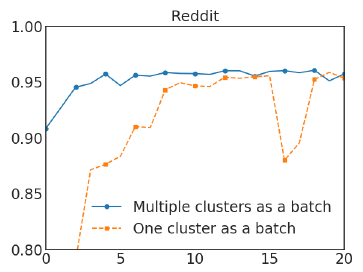

Reddit数据集上进行实验,对比了SMC和普通Cluster-GCN的效果。在Cluster-GCN中我们选择划分为300个分区,在SMC中我们选择划分为1500个分区并随机选择5个簇来构成一个batch。实验结果如下图所示,其中

x轴为epoch,y轴为F1-score。可以看到随机多重聚类可以显著改善Cluster-GCN的收敛性。

Cluster-GCN算法:输入:

- 图

- 输入特征矩阵

- 节点标签矩阵

one-hot或者multi-hot向量) - 最大迭代 步

max-iter - 划分簇的数量

- 每个

batch的簇的数量

- 图

输出:模型的参数

embedding矩阵算法步骤:

通过

METIS聚类算法划分迭代:

- 随机无放回选择

- 以节点集合

- 根据子图的损失函数来计算梯度

- 基于

Adam优化算法使用梯度

- 随机无放回选择

输出模型的参数

embedding矩阵

METIS是Karypis Lab开发的一个功能强大的图切分软件包,支持多种切分方式。优势:METIS具有高质量的划分结果,据称比常规的谱聚类要准确10% ~ 50%。METIS执行效率非常高,比常见的划分算法块1~2个数量级。百万规模节点的图通常几秒钟之内就可以切分为256个簇。METIS具有很低的空间复杂度和时间复杂度,从而降低了存储负载和计算量。

18.1.3 深层 GCN

GCN原始论文表明:对GCN使用更深的层没有任何效果。但是,实验中的这些数据集太小,可能没有说服力。例如,实验中只有数百个节点的图,太深的GCN可能会导致严重过拟合。另外,我们观察到更深的

GCN模型的优化变得更困难,因为更深的模型可能会阻碍前几层的消息传递。在原始GCN中,他们采用类似于残差连接的技术,使得模型能够将信息从前一层传递到后一层。具体而言,第这里我们提出另一种简单的技术来改善深层

GCN的训练。在原始GCN中,每个节点都聚合了来自前一层邻域的representation。但是在深层GCN的背景下,该策略可能不太合适,因为它没有考虑深度。凭直觉,附近的邻居应该比远处的节点贡献更大。因此我们提出了一种更好的解决该问题的技术:放大邻接矩阵

GCN层的聚合把更大的权重放到前一层的representation上。即:这种方式看起来似乎合理,但是这对所有节点都使用相同的权重,无论其邻居数量是多少,这现得有些不合适。此外,当使用更深的层时,某些数值可能出现指数型增长,可能会导致数值不稳定。因此我们提出修改版,从而更好地维护邻域信息和数值范围。

我们首先将一个单位矩阵添加到原始的

然后对消息进行传播:

其中

实验表明这种对角线增强

diagonal enhancement技术可以帮助构建更深的GCN并达到state-of-the-art性能。这就是人工构造的

attention:对self施加相对更大的重要性(这意味着对邻居施加更小的重要性)。可以通过GAT来自适应地学习self和邻居的重要性。根据论文的实验,当层数很深时,模型效果退化并且训练时间大幅上涨,因此没有任何意义。所以这一小节的内容没有价值。

18.2 实验

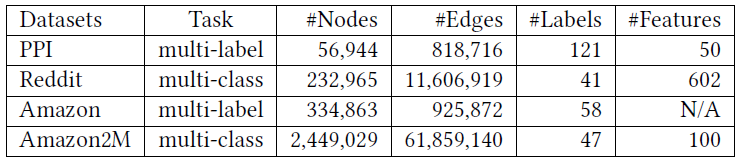

我们在两种任务上评估了

Cluster-GCN的效果:在四个公共数据集上的multi-label分类任务和multi-class分类任务。这些数据集的统计信息如下表所示。注意:

Reddit数据集是迄今为止我们所看到的最大的GCN公共数据集。- 而

Amazon2M数据集是我们自己收集的,比Reddit数据集更大。

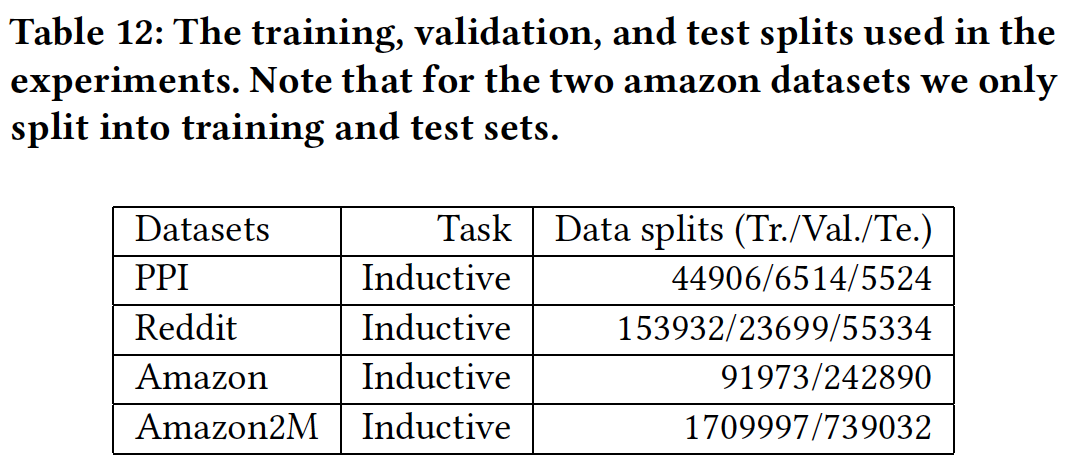

这些数据集的

training/validation/test拆分如下表所示:

baseline方法:我们比较了以下state-of-the-art的GCN训练算法以及Cluster-GCN方法:VRGCN:保留图中所有节点的历史embedding均值,并仅采样少数几个邻居来加快训练速度。我们采用原始论文中的建议,将采用邻居数量设为2。GraphSAGE:对每个节点采样固定数量的邻居。我们使用原始论文中默认的邻居数量 :双层GCN第一层、第二层采样数量分别为

由于原始

GCN很难扩展到大图,因此我们不比较原始GCN。根据VRGCN论文所述,VRGCN比FastGCN更快,因此我们也不比较FastGCN。实验配置:我们使用

PyTorch实现了Cluster-GCN。对于其它baseline,我们使用原始论文提供的代码。所有方法都采用

Adam优化器,学习率为0.01,dropout比例为20%,权重衰减weight decay为零。所有方法都采用均值聚合,并且隐层维度都相同。

所有方法都使用相同的

GCN结构。在比较过程种我们暂时不考虑

diagonal enhancement之类的技术。对于

VRGCN和GraphSAGE,我们遵循原始论文种提供的配置,并将batch-size设为512。对于

Cluster-GCN,下表给出了每个数据集的分区数量,以及每个batch的簇的数量。

所有实验均在

20核的Intel Xeon CPU(2.20 GHz)+192 GB内存 +NVIDIA Tesla V100 GPU(16GB RAM)上执行。

注意:在

Cluster-GCN种,聚类算法被视为预处理步骤,并且未被计入训练时间。聚类只需要执行一次,并且聚类时间很短。此外,我们遵从

FastGCN和VR-GCN的工作,对GCN的第一层执行pre-compute,这使得我们节省了第一层昂贵的邻域搜索过程。为了用于

inductive setting,其中测试节点在训练期间不可见,我们构建了两个邻接矩阵:一个邻接矩阵仅包含训练节点,另一个邻接矩阵包含所有节点。图划分仅作用在第一个邻接矩阵上。为了计算内存用量,对于

TensorFlow我们使用tf.contrib.memory_stats.BytesInUse(),对于PyTorch我们使用torch.cuda.memory_allocated()。

18.2.1 中等规模数据集

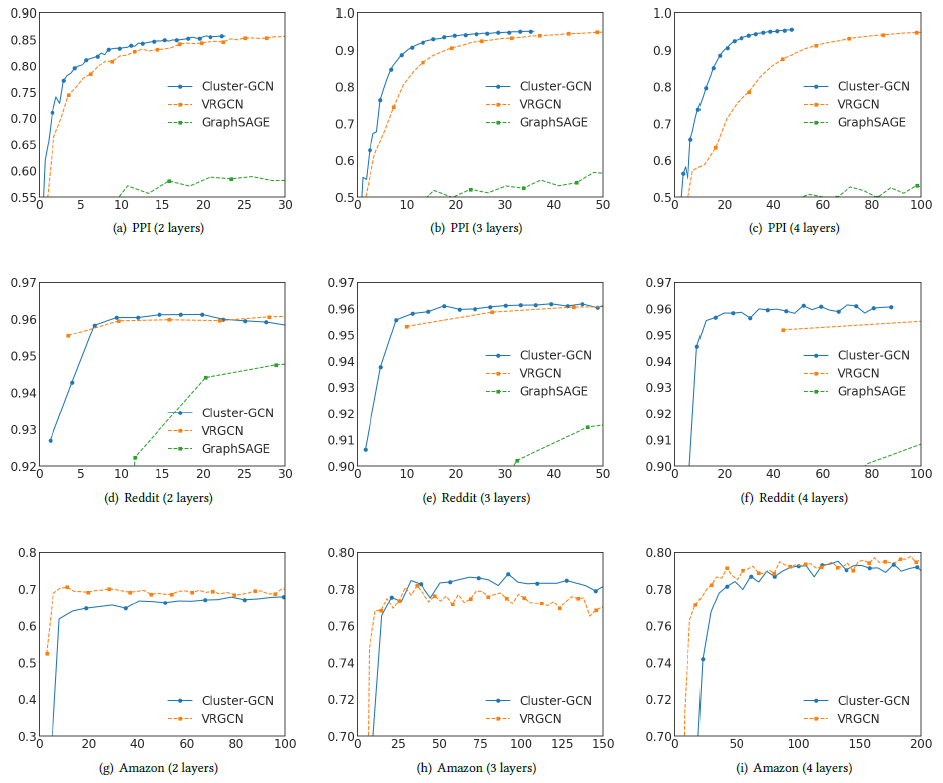

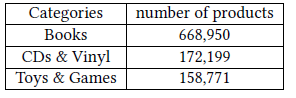

我们首先在训练速度和训练准确性方面评估

Cluster-GCN。我们给出两层GCN、三层GCN、四层GCN在三个中等规模数据集PPI、Reddit、Amazon上的训练时间和预测准确性,如下图所示。其中x轴为训练时间(单位秒),y轴为验证集准确性(单位F1-Score)。由于

GraphSAGE比VRGCN、Cluster-GCN更慢,因此GraphSAGE的曲线仅出现在PPI、Reddit数据集上。对于

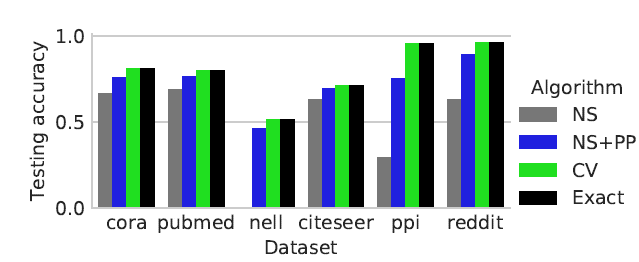

Amazon数据集,由于没有节点特征,因此我们用一个单位矩阵334863 x 128。因此,计算主要由稀疏矩阵运算决定(如结论:

- 在

PPI和Reddit数据集中,Cluster-GCN的训练速度最快,同时预测准确性也最好。 - 在

Amazon数据集中,Cluster-GCN训练速度比VRGCN更慢,预测准确性除了三层GCN最高以外都差于VRGCN。

- 在

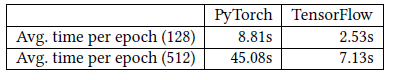

Cluster-GCN比VRGCN更慢的原因可能是:不同框架的稀疏矩阵的运算速度不同。VRGCN在Tensorflow中实现,而Cluster-GCN在PyTorch中实现。PyTorch中的稀疏张量支持目前处于早期阶段。下表中我们显示了

Tensorflow和PyTorch对于Amazon数据集执行前向、反向操作的时间,并使用一个简单的、两层线性网络对这两个框架进行基准测试,括号中的数字表示隐层的维度。我们可以清楚地看到Tensorflow比PyTorch更快。当隐层维度更高时,差异会更大。这解释了为什么Cluster-GCN在Amazon数据集中训练时间比VRGCN更长。

对于

GCN而言,除了训练速度以外,内存需求通常更重要,因为这将直接限制了算法的可扩展性。- 内存需求包括训练多个

epoch所需的内存。为加快训练速度,VRGCN需要在训练过程中保持历史embedding,因此和Cluster-GCN相比VRGCN需要更多的内存。 - 由于指数级邻域扩展的问题,

GraphSAGE也比Cluster-GCN需要更多的内存。

下表中,我们给出了不同方法在不同数据集上训练两层

GCN、三层GCN、四层GCN所需要的内存。括号中的数字表示隐层的维度。可以看到:- 当网络更深时,

Cluster-GCN的内存使用并不会增加很多。因为每当新增一层,引入的额外变量是权重矩阵 - 尽管

VRGCN只需要保持每一层的历史embedding均值,但是这些embedding通常都是稠密向量。因此随着层的加深,它们很快统治了内存需求。 Cluster-GCN比VRGCN有更高的内存利用率。如在Reddit数据集上训练隐层维度为512的四层GCN时,VRGCN需要2064MB内存,而Cluster-GCN仅需要308MB内存。

- 内存需求包括训练多个

18.2.2 大规模数据集

迄今为止评估

GCN的最大的公共数据集是Reddit数据集,其统计数据如前所述。Reddit数据集大约包含200K个节点,可以在几百秒之内训练GCN。为测试

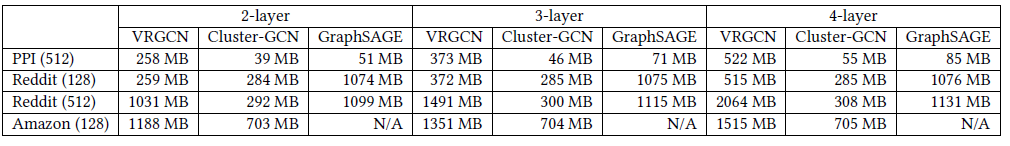

GCN训练算法的可扩展性,我们基于Amazon co-purchasing网络构建了一个更大的图,图中包含200万节点、6100万边。原始的co-purchase数据来自于Amazon-3M。图中每个节点都是一个商品,图中的连接表示是否同时购买了两个商品。每个节点特征都是从商品描述文本中抽取的

bag-of-word,然后通过PCA降维到100维。此外,我们使用top-level的类别作为节点的label。下表给出了数据集中频次最高的类别:

我们在这个大型数据集上比较了

Cluster-GCN和VRGCN的训练时间、内存使用、测试准确性(F1-Score来衡量)。可以看到:

- 训练速度:对于两层

GCN,VRGCN训练速度更快;但是对于更深的GCN,Cluster-GCN训练速度更快。 - 内存使用:

VRGCN比Cluster-GCN需要多得多的内存,对于三层GCN时VRGCN所需内存是Cluster-GCN的五倍。当训练四层GCN时VRGCN因为内存耗尽而无法训练。 - 测试准确性:

Cluster-GCN在四层GCN时可以达到该数据集上的最佳准确性。

- 训练速度:对于两层

18.2.3 深层 GCN

这里我们考虑更深层的

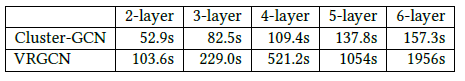

GCN。我们首先给出Cluster-GCN和VRGCN在PPI数据集上不同深度的训练时间的比较,其中每种方法都训练200个epoch。可以看到:

VRGCN的训练时间因为其代价较高的邻域发现而呈现指数型增长,而Cluster-GCN的训练时间仅线性增长。

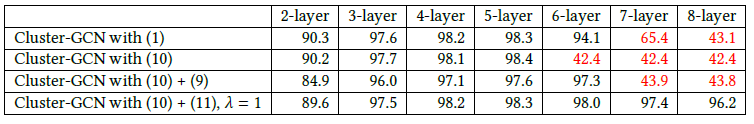

然后我们研究更深的

GCN是否可以得到更好的准确性(衡量指标为验证集的F1-score)。我们在PPI数据集上进行实验并训练200个epoch,并选择dropout rate = 0.1。其中:Cluster-GCN with (1)表示:原始的Cluster-GCN。Cluser-GCN with (10)表示:考虑如下的Cluster-GCN:Cluster-GCN with (10) + (9)表示:考虑如下的Cluster-GCN:Cluster-GCN with (10) + (11)表示:考虑如下的Cluster-GCN:其中

可以看到:

对于

2层到5层,所有方法的准确性都随着层深度的增加而提升,这表明更深的GCN可能是有效的。当使用

7层或8层时,前三种方法无法在200个epoch内收敛,并会大大降低准确性。可能的原因是针对更深GCN的优化变得更加困难。其中红色的数字表示收敛性很差。即使是第四种方法,它在层数很深时虽然收敛,但是模型效果下降、训练时间暴涨(根据前面的实验),因此没有任何意义。

此外,原始

Cluster-GCN在五层时达到最好的效果,所以对角增强技术失去了价值。

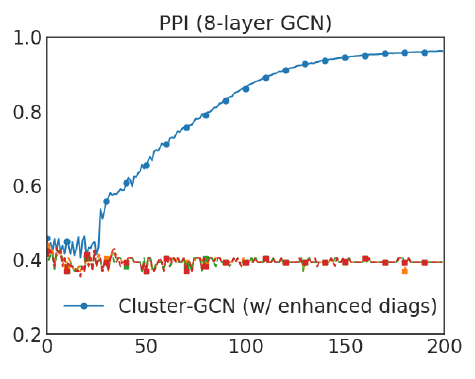

为考察更深层

GCN的详细收敛性,我们给出了采用对角增强技术(即GCN在不同epoch上的验证准确性(F1-Score)。可以看到:我们提出的对角增强技术可以显著改善模型的收敛性,并得到较好的准确性。

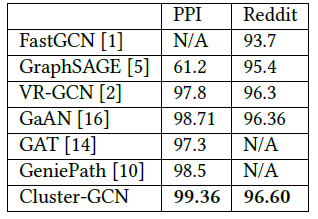

采用了对角增强技术的

Cluster-GCN能够训练更深的GCN从而达到更好的准确性(F1-Score)。我们在下表中给出不同模型在不同数据集上的测试F1-Score。可以看到:

- 在

PPI数据集上,Cluter-GCN通过训练一个具有2048维的隐层的5层GCN来取得state-of-the-art效果。 - 在

Reddit数据集上,Cluster-GCN通过训练一个具有128维隐层的4层GCN取得state-of-the-art效果。

这个优势并不是对角增强技术带来的,而是因为

Cluster-GCN的内存需求更少从而允许训练更深的模型,而更深的模型通常效果更好。

- 在

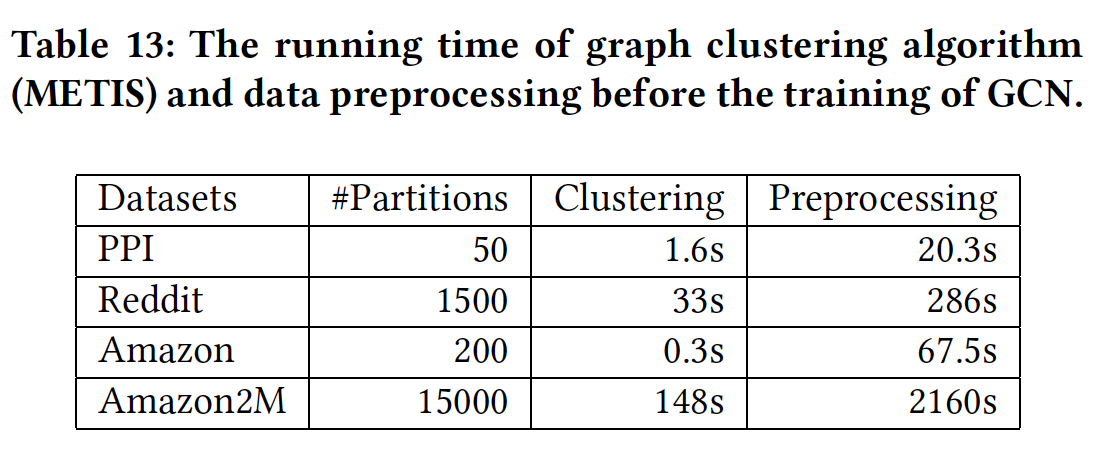

前面的实验都未考虑

ClusterGCN的预处理时间(如,数据集加载,graph clustering等等)。这里我们给出Cluster-GCN在四个数据集上的预处理时间的细节。对于graph clustering,我们使用Metis。结果如下表所示。可以看到:graph clustering算法仅占用预处理时间的很小比例。graph clustering可以扩展到大型的数据集。

此外,

graph clustering仅需要执行一次,并且之后被后续的训练过程重复使用。

十九、LDS-GNN[2019]

关系学习

relational learning同时利用了样本自身的属性以及样本之间的关系。例如:患者诊断不仅需要考虑患者本身的信息,还需要考虑患者亲属的信息。因此,关系学习不会假设数据点之间的独立性,而是显式建模它们之间的依赖关系。图是表示关系信息relational information的自然的方式,并且已经有很多利用图结构的方法,如图神经网络GNN。虽然图结构在某些领域可用(如社交网络),但是在另一些领域中我们必须构造图结构。

一种常用的人工构造图结构的方法是:基于样本之间的某种相似性来构建

kNN图。这种方法被很多算法采用(如LLE,IsoMap),但是它存在不足:模型效果取决于另外在这种方法中,图的构建和

GNN参数的学习是相互独立的,图的构建需要启发式方法并反复实验。另一种方法是简单地使用核矩阵

kernel matrix来隐式建模样本之间的相似性,但是得到了稠密的相似性矩阵(对应于全连接图)维代价。

论文

《Learning Discrete Structures for Graph Neural Networks》提出了不同的方法同时学习了图的构建和GNN参数,即LDS-GNN。简单而言,论文提出了学习图生成概率模型,其中节点来自于训练集和测试集,边被建模为随机变量,其参数视为bilevel学习框架中的超参数。论文在最小化内层目标函数(GCN训练误差)的同时对图结构进行迭代式采样,并通过最小化外层目标函数(GCN验证误差)来优化边的分布参数。两层优化:内层在训练集上优化训练损失,外层在验证集上优化验证损失。该方法仅用于小型图,计算量很大并且不能保证收敛性。

据作者所知,这是针对半监督分类问题中,同时学习图结构和

GNN参数的第一种方法。此外,论文使用基于梯度的超参数优化来处理不连续的超参数(边是否存在)。通过一系列实验,结果证明了论文的方法比现有方法的优势,同时验证了图生成模型具有有意义的边概率(即:边是否存在的概率)。相关工作:

半监督学习

Semi-supervised Learning:基于图的半监督学习的早期工作使用图拉普拉斯正则化graph Laplacian regularization,包括标签传播label propagation: LP、流形正则化manifold regularization: ManiReg、半监督嵌入semi-supervised embedding: SemiEmb。这些方法假设给定一个图,其中边代表节点之间的某种相似性。- 后来,

《Revisiting semi-supervised learning with graph embeddings》提出了一种方法,该方法不使用图进行正则化,而是通过联合classification和graph context prediction这两个任务来学习embedding。 《Semi-supervised classification with graph convolutional networks》提出了第一个用于半监督学习的GCN。

现在有许多

GCN变体,所有这些变体都假设给定了图结构。与所有现有的graph-based半监督学习相反,LDS即使在图不完整或图缺失的情况下也能工作。- 后来,

图合成和生成

graph synthesis and generation:LDS学习图的概率生成模型。- 最早的图概率生成模型是

《On the evolution of random graphs》提出的随机图模型,其中边概率被建模为独立同分布的伯努利随机变量。 - 人们已经提出了几种网络模型来建模特定的图属性,如

degree分布(《Graphs overtime: densification laws, shrinking diameters and possible explanations》)、网络直径(《Collective dynamics of small-world networks》)。 《Kronecker graphs: An approach to modeling networks》提出了一种基于Kronecker乘积的生成模型,该模型将真实图作为输入并生成具有相似属性的图。- 最近,人们已经提出了基于深度学习的图生成方法。

然而,这些方法的目标是学习一个复杂的生成模型

generative model,该模型反映了训练图的属性。另一方面,LDS学习图生成模型,并将其作为分类问题的一种良好的手段,并且LDS的输入不是图的集合。最近的工作提出了一种无监督模型,该模型学习推断实体之间的交互,同时学习物理系统(如弹簧系统)的动力学(

《Neural relational inference for interacting systems》)。与LDS不同,该方法特定于动态交互系统,是无监督的,并且使用变分自编码器。最后,我们注意到

《Learning graphical state transitions》提出了一个完全可微的神经模型,能够在input/representation/output level处理和生成图结构。然而,训练模型需要根据ground truth graph进行监督。- 最早的图概率生成模型是

链接预测:链接预测是一个几十年前的问题。有几篇综述论文涵盖了从社交网络到知识图谱中的链接预测的大量工作。虽然大多数方法都是基于

node pair之间的某种相似性度量,但是也有许多基于神经网络的方法(《Link prediction based on graph neural networks》)。我们在本文中研究的问题与链接预测有关,因为我们也想学习

learn或扩张extend一个图。然而,现有的链接预测方法不会同时学习一个GNN node classifier。统计关系学习statistical relational learning: SRL模型通常通过二元或一元谓词的存在来执行链接预测和节点分类。然而,SRL模型本质上是难以处理的,并且网络结构和模型参数学习步骤是独立的。离散随机变量的梯度估计:由于两个

bilevel objective的难以处理的特性,LDS需要通过随机计算图stochastic computational graph来估计超梯度hypergradient。使用得分函数估计器(也称作REINFORCE)会将外层目标视为黑盒函数,并且不会利用inner optimization dynamics是可微的。相反,路径估计器path-wise estimator并不容易使用,因为随机变量是离散的。LDS借鉴了之前提出的解决方案(《Estimating or propagating gradients through stochastic neurons for conditional computation》),但是代价是估计有偏。

19.1 模型

19.1.1 背景知识

给定图

邻接矩阵

图拉普拉斯矩阵为

每个节点

所有节点的输入特征向量拼接为特征矩阵

每个节点

labelone-hot向量为所有节点的

label向量拼接为label矩阵

定义所有的邻接矩阵的取值空间为

label矩阵的取值空间为则图神经网络的目标是学习函数:

其中

为学习目标函数,我们在训练集上最小化经验损失:

其中:

point-wise损失函数。

在

GCN中,一个典型的其中:

- 网络为两层网络,参数

Bilevel program是一种优化问题,其中目标函数中出现的一组变量被约束为另一个优化问题的最优解。Bilevel program出现在很多常见下,比如超参数调优、多任务学习、meta-learning学习等。给定外层目标函数

outer objectiveinner objectiveouter variableinner variablebilevel program定义为:直接求解上式非常困难,因为内层问题

inner problem通常没有闭式解。一种标准的求解方式是:利用迭代式的动态优化过程令

假设

我们称其为超梯度

hypergradient。其中这种技术允许我们同时调优多个超参数,其调优数量比经典的超参数优化技术大几个量级。

但是这种方法需要执行更多的

19.1.2 LDS

在现实世界中,经常会出现带噪音的图(

noisy graph)、结构残缺的图(incomplete graph)、甚至完全没有图结构(missing graph) 。为解决这些问题,我们必须在训练GCN网络参数的同时,还需要学习图结构。我们将这个问题构造为一个

Bilevel program问题,其中外层变量为图生成概率模型的参数,内层变量为GCN模型的参数。我们的方法同时优化了GCN模型参数以及图生成概率模型的参数。下图给出了我们方法的示意图:

假设真实邻接矩阵

nosisy, incomplete, missing),我们的目标是寻找最小泛化误差的模型。给定验证集其中

因此:

我们将

GCN的最佳参数。我们将

注意,

即使是很小的图,

bilevel问题也难以直接求解。另外,上述模型包含连续变量(GCN参数)和离散变量(网络结构),这使得我们无法直接求解梯度(离散型变量无法求导)。一种可能的解决方案是对离散型变量构造连续性松弛

continuous relaxation;另一种方案是对离散型变量使用概率分布。这里我们采用第二种方案。我们利用二元伯努利随机变量对图的每条边进行建模,并假设每条边是否存在是相互独立的,则我们可以采样一个图

这种边的独立性假设可能并不成立。假设

我们基于图结构的生成模型来重写

bilevel问题为:利用期望,现在内层目标函数和外层目标函数都是伯努利分布的参数的连续函数。

上式给出的

bilevel问题仍然难以有效求解,这是因为内层目标函数对于GCN而言没有闭式解(目标函数非凸)。因此有效的算法仅能找到近似的解。在给出近似解之前,我们先关注于

GCN模型的输出。对于具有GCN的期望输出为:不幸的是,即使对于很小的图,计算这个期望值也非常困难。于是我们可以计算期望输出的经验估计:

其中

注意:

bilevel中学到的GCN- 由于

给定具有伯努利随机变量的图生成模型(边的概率分布

如果将伯努利参数直接作为

GCN的邻接矩阵,则这相当于一个全连接图,图中每条边的权重就是边存在的概率。此时计算GCN输出的计算复杂度为如果采样

GCN的平均输出,由于每个采样的图都是稀疏图,则总的计算复杂度为另外,使用图生成模型的另一个优势是:我们能够在概率上解释它。而学习稠密的邻接矩阵则无法做到。

对于具有百万级别以上的大型图,

现在我们考虑

bilevel问题的近似解。我们基于图结构的生成模型来重写

bilevel问题为:其中图生成模型的参数

GCN模型参数对于内层问题,我们考虑期望

0或1)。因此即使对于很小的图,其计算复杂度也非常高。但是,换个角度来看,我们可以利用迭代式的动态优化过程其中

在合适的假设下,当

SGD收敛到权重向量这种方法就是标准的随机梯度下降,其中邻接矩阵

step发生改变。但是,这种方式是否保证能够收敛到最小值?论文并未证明。直觉上看,难以保证收敛,因为在梯度下降过程中GCN所应用的图在不断变化。对于外层问题,令

根据:

我们有:

我们使用所谓的

straight-through估计,并令

最后,我们对上式采用单个样本的蒙特卡洛估计来更新参数

0到1之间)。在计算外层问题的超梯度时,需要对

这在时间和空间上都代价太大。

此外,我们依赖于梯度的有偏估计,因此并不期望从完整的计算中获得太多收益。因此我们建议截断计算,并在每

short-horizon优化过程,其中带有对warm restart。LDS算法:输入:

- 特征矩阵

- 标签矩阵

- 可能有(也可能没有)邻接矩阵

- 学习率

- 超梯度截断步长

- 可能有(也可能没有)用于计算

kNN的

- 特征矩阵

输出:最佳的权重

算法步骤:

如果没有邻接矩阵

kNN来初始化邻接矩阵通过

外层迭代,当停止条件未满足时(基于验证集):

内层迭代,当内层目标函数还在下降时(基于训练集):

采样一个新的图:

优化内层目标函数:

如果

采样一个新的图:

计算

迭代

- 采样一个结构:

- 计算

- 计算

- 采样一个结构:

优化外层目标函数:

返回最佳的权重

LDS算法包含外层停止条件和内层停止条件。对于内层停止条件,我们发现以内层目标函数的下降作为内层停止条件非常有效。

我们持续优化

patience窗口为对于外层停止条件,我们发现使用早停策略非常有效。

我们选择一部分验证集

但是当需要优化的参数数量太多、验证集规模太小时,可能会存在验证集的过拟合。

每次外层迭代中,对超梯度的估计都存在偏差。偏差即来自于

straig-through估计,也来自于超梯度的截断。尽管如此,我们从实验中发现该算法能够取得良好的效果,并能够在边的分布空间中找到适合于当前任务的参数。LDS借鉴了之前提出的启发式方案,但是代价是超梯度估计是有偏的。给定一个函数

straight-through估计量为:则有:

通常

LDS算法有两个缺陷:- 计算复杂度太高,导致无法扩展到大图。

- 仅限于

transductive learning,无法扩展到未见过的节点。对于新的、未见过的节点,需要从头开始重新训练模型。

19.2 实验

我们针对三个目标进行了一系列实验:

首先,我们在节点分类问题上评估

LDS,其中图结构虽然可用但是缺失了一定比例的边。这里我们将LDS和包括普通GCN在内的基于图的学习算法进行比较。其次,我们想验证我们的假设,即

LDS可以在没有图的半监督分类问题上取得有竞争力的结果。这里我们将LDS和许多现有的半监督分类算法进行比较。此外,我们对比了一些图算法,图是通过在数据集上创建的

kNN近邻图。最后,我们分析了学到的图生成模型,从而了解

LDS如何学到有意义的边的概率分布。

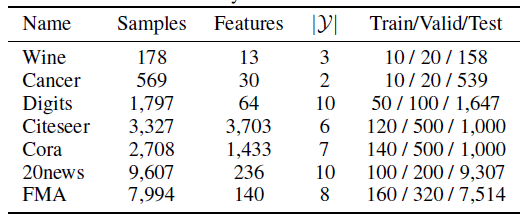

数据集:

图数据集:

Cora, Citeseer是图的两个基准数据集,输入特征是bag of word,任务是节点分类。我们遵循之前的工作,执行相同的数据集拆分和实验配置。为评估残缺图上

LDS的鲁棒性,我们通过随机采样25%, 50%, 75%的边来构造残缺图。非图数据集:我们使用

scikit-learn中的基准数据集,如Wine, Breast Cancer(Cancer), Digits, 20 NewsGroup(20News)等数据集,这些数据集都不是图结构。我们用这些非图数据集来评估LDS。对于

20 NewsGroup数据集,我们从中挑选出10个类别,然后使用词频超过5%的单词的TF-IDF作为特征。FMA数据集:该数据集从7994个音乐曲目中提取了140个音频特征,任务是音乐风格分类。

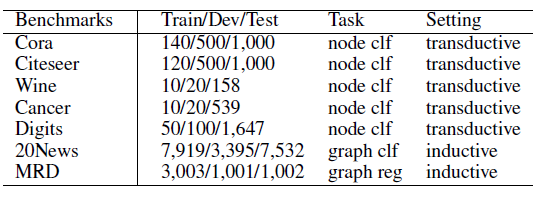

所有这些数据集的统计信息如下:

baseline方法:对于图算法,我们对比了以下方法:普通

GCN、GCN-RND、标签传播算法label propagation: LP、流形正则化算法manifold regularization: ManiReg、半监督embedding算法semi-supervised embedding: SemiEmb。其中ManiReg, SemiEmb将一个kNN图作为拉普拉斯正则化的输入。GCN-RND是在普通GCN的每个优化step中添加随机采样的边。通过这种方法,我们打算证明:仅将随机边添加到GCN中不足以提高模型的泛化能力。对于非图算法,我们对比了以下方法:

GC、 逻辑回归logistic regression: LogReg、支持向量机support vector machines: Linear and RBF SVM、随机森林random forests: RF、前馈神经网络feed-forward neural networks:FFNN。当没有图结构时,

GCN退化为前馈神经网络,此时我们通过下列的手段来构造图结构:- 随机创建一个稀疏的图结构,记作

Sparse-GCN。 - 以相等的边概率构建一个稠密图,记作

Dense-GCN。 - 基于输入特征构建一个

RBF核的稠密图,记作RBF-GCN。 - 基于输入特征构建一个

kNN近邻图的稀疏图,记作kNN-GCN。

对于

LDS,我们使用KNN近邻图作为初始的边概率,即kNN-LDS。另外,我们进一步比较了LDS的稠密版本,此时我们学习一个稠密的相似度矩阵,记作kNN-LDS(dense)。- 随机创建一个稀疏的图结构,记作

当需要用到

kNN时,需要考虑两个超参数:k值的选择、度量函数的选择。我们从cosine距离 ,然后通过验证集的准确性来调优这两个超参数。对于

kNN-LDS,GCN和LDS配置:对于所有用到

GCN的网络,我们使用两层GCN网络,隐层维度为16,采用ReLU激活函数。我们使用

0.5的dropout rate来执行dropout,从而执行额外的正则化。我们使用

Adam优化器,学习率从SemiEmb核FFNN使用相同数量的隐层维度、相同的激活函数。我们使用带正则化的交叉熵损失函数:

其中

one-hot向量,对于

LDS,除了已知的边或者kNN构造的边我们设置为我们将验证集平均划分为验证集

(A)和早停集(B)。对于外层目标,我们使用(A)上的不带正则化的交叉熵损失,并通过随机梯度下降对其进行优化。我们通过超参数调优来优化外层循环的步长

最后我们采样

对于

LDS和GCN,我们以20步的窗口大小来应用早停。

其它方法的实现来自于

skicit-learn或者原始论文。所有方法的超参数都是通过验证集的accuracy来调优。

19.2.1 图数据集

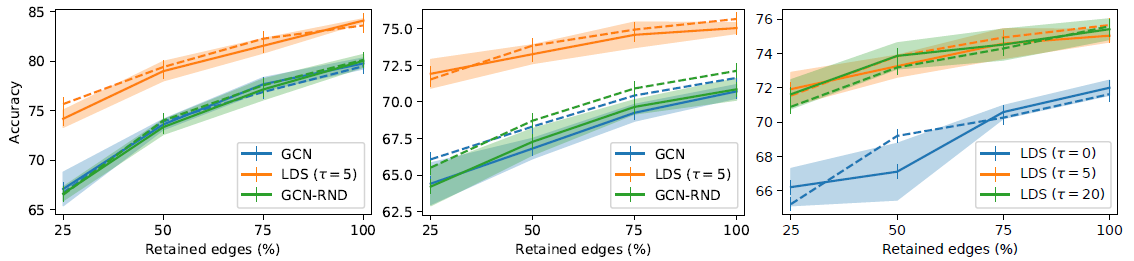

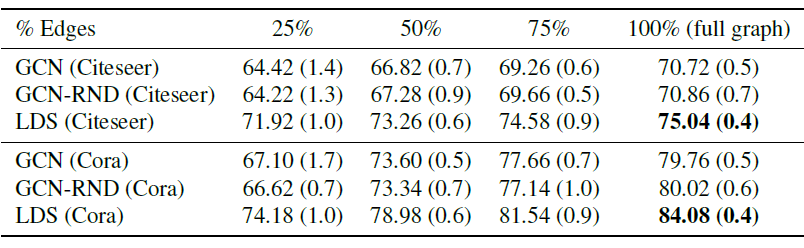

我们比较了在图数据集(

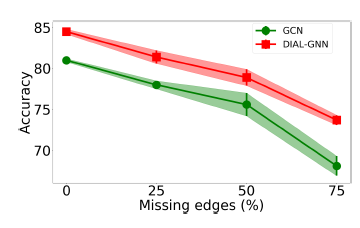

Cora左图、Citeseer中间图)的残缺图上的结果。我们给出边的每个保留比例,以及对应的验证集准确率(虚线,用于早停)和测试集准确率(实线),阴影表示标准差。所有结果都随机执行5次并取均值。可以看到:

LDS在所有情况下都具有竞争性优势,准确率提升了7%。最终Cora和Citeseer的准确率分别为84.1%和75.0%,超越了所有的state-of-the-art模型。- 当保留所有的边(

100%)时,LDS还可以通过学习其它额外的、有用的边来提高GCN模型的泛化准确率。 - 从

GCN和GCN-RND对比中可以看到,随机添加边并不能减少泛化误差,这对于模型没有任何帮助。

右图给出超梯度截断的更新次数

LDS的影响。20并不会带来明显提升,同时会增加计算成本

上述实验更详细的结果如下表所示,其中(

+-表示标准差)。

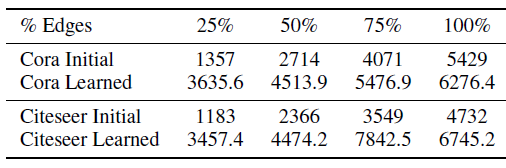

我们考虑

LDS在Cora,Citeseer数据集上期望的边的数量,从而分析学到的图生成器采样的图的属性。LDS期望的边的数量高于原始图的边的数量,这是可以预期的,因为LDS具有比普通GCN更高的准确率。- 尽管如此,

LDS学到的图仍然是非常稀疏的,如,对于Cora而言平均只有不到0.2%的边。这有助于LDS的内层循环中有效学习GCN。

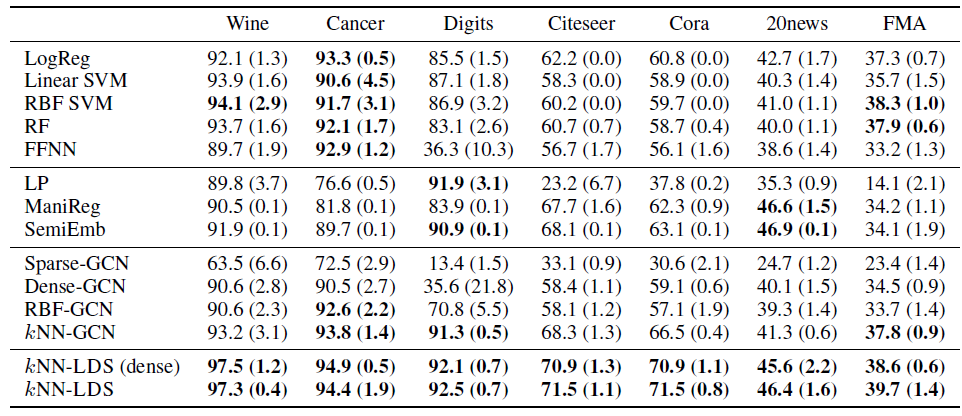

19.2.2 半监督学习

我们考察

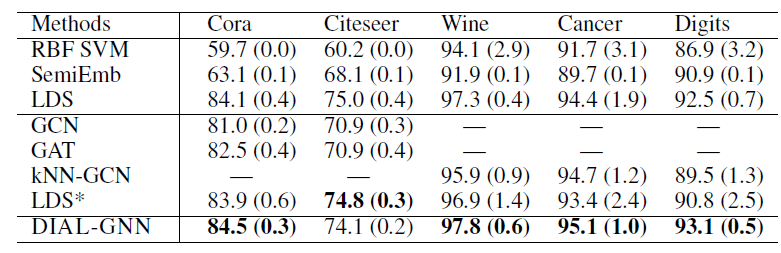

LDS在所有数据集上的半监督学习效果。每个实验随机执行5次并报告平均的测试准确率和标准差(以+-表示)。有竞争力的结果以粗体展示。结论:

- 非图算法在某些数据集上效果很好(如

Wine,Cancer,FMA),但是在Digits,Citeseer,Cora,20news等其它数据集上效果较差。 LP, ManiReg, SemiEmb只能改善Digits,20news数据集的效果。- 和非图算法相比,

kNN-GCN效果很好,并提供了具有竞争力的结果。 kNN-LDS是所有数据集中最具竞争力的方法之一,并且在图数据集上获得最高的收益。kNN-LDS的性能略优于其dense模型,并且其稀疏图可以扩展到更大的数据集。

- 非图算法在某些数据集上效果很好(如

19.2.3 图生成模型

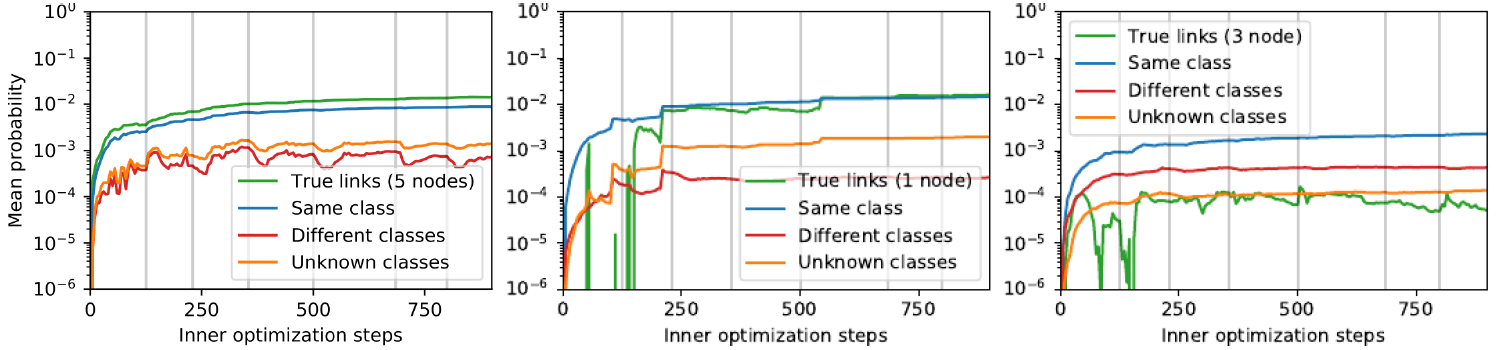

我们给出

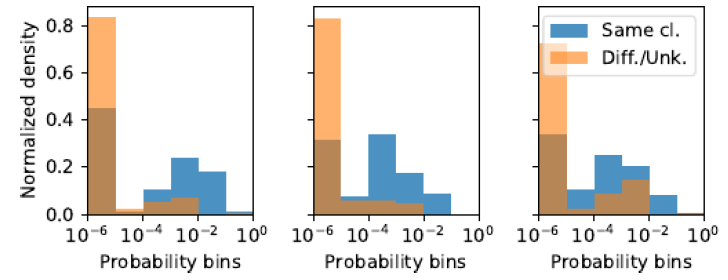

LDS(Cora数据集(保留25%的边)学习过程中,三种类型的节点(训练集、验证集、测试集,对应于下图的从左到右)的平均的边概率的演变,每种类型一个节点。对于每个样本节点,所有其它节点被划分为四个分组:底层真实图中相邻的节点(True link)、相同类别的节点(Same class)、不同类别的节点(Different classes)、未知类别的节点(Unknown classes) 。图中灰色竖线指示内层优化何时重启。纵坐标以log 10来表示。- 平均而言,

LDS将相同类别标签样本之间存在边的概率提高了10到100倍。 LDS能够为真实相邻的边赋予一个较高的概率。

- 平均而言,

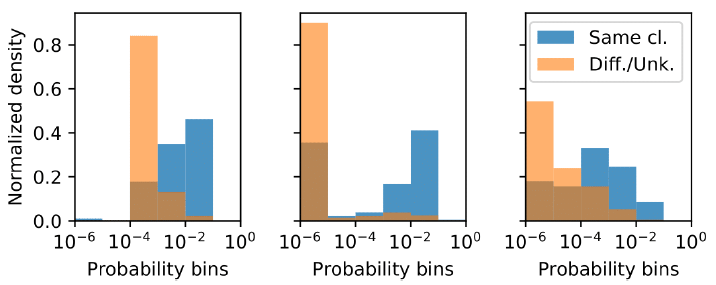

我们给出

LDS(Cora数据集(保留25%的边)学习完成之后,三种类型的节点(训练集、验证集、测试集,对应于下图的从左到右)的边的概率的归一化直方图,每种类型一个节点。对于每个样本节点,所有其它节点被划分为两个分组:相同类别的节点(Same class)、不同类别或未知类别的节点(Different/Unknown classes) 。直方图统计按照log 10分为六个桶。可以看到:

LDS学到边的高度非均匀的概率分布能够反应节点的类别。

我们给出

LDS(Citeseer数据集(保留25%的边)学习完成之后,被kNN-GCN误分类但是被kNN-LDS正确分类的测试集的三个节点的边的概率的归一化直方图。。对于每个样本节点,所有其它节点被划分为两个分组:相同类别的节点(Same class)、不同类别或未知类别的节点(Different/Unknown classes) 。直方图统计按照log 10分为六个桶。可以看到:

LDS学到边的高度非均匀的概率分布能够反应节点的类别,这和前面的结论相同。- 可能更重要的是捕获有效的边的分布(即相同类别之间存在边的概率更高),而不是选择正确的连接。

我们用

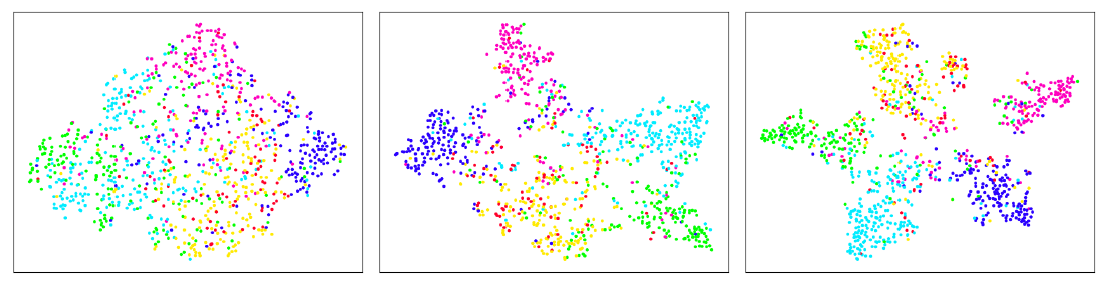

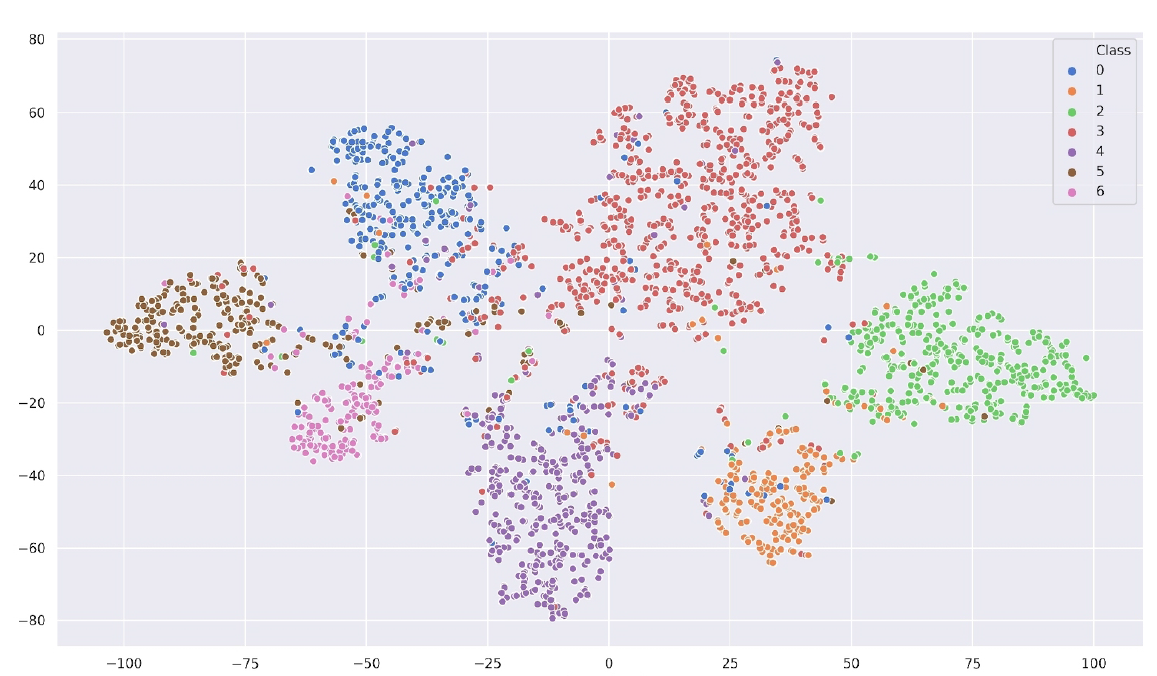

t-SNE进一步可视化了GCN和LDS学到的embedding。下图给出了Citeseer数据集上使用Dense-GCN(左)、kNN-GCN(中)、kNN-LDS(右)学到的embedding的的t-SNE可视化。该embedding是最后一层卷积层的输出。可以看到:

kNN-LDS学到的embedding在所有不同类别之间提供了最佳分隔。

二十、DIAL-GNN[2019]

近年来图神经网络

GNN被广泛使用,不幸的是只有图结构的数据才能使用GNN。很多真实世界中的数据(如社交网络)天然就是图结构数据,但是对于下游任务而言,这些天然的图结构是否对于当前任务是最优的则不一定。更重要的是,很多场景下可能没有图结构数据,因此需要从原始数据中构造图结构数据。- 在图信号处理领域,研究人员探索了从数据中学习图结构的各种方法,但是他们并未考虑下游任务。

- 另外,越来越多的工作研究交互系统的动态建模从而利用隐式的交互模型,但是这些方法无法在很多噪音甚至没有图结构的情况下直接联合学习图结构和

graph representation。 - 最近,研究人员探索了对非图结构数据自动构建图结构并应用

GNN,但是这些方法仅优化了针对下游任务的图结构,并未利用已被证明在图信号处理中非常有用的技术。 - 最近,论文

《Learning Discrete Structures for Graph Neural Networks》提出了一种新的方法(即,LDS-GNN),该方法通过近似求解一个bilevel program从而共同学习图结构和GCN参数。但是,该方法存在严重的可扩展性问题,因为它需要学习transductive learning,这意味着该方法在测试期间无法应用于新的、未见过的节点。

为解决这些限制,论文

《Deep Iterative and Adaptive Learning for Graph Neural Networks》提出了一种用于GNN的深度迭代和自适应学习框架Deep Iterative and Adaptive Learning for Graph Neural Networks: DIAL-GNN,该框架共同学习针对具体任务的最优图结构和GNN网络参数。DIAL-GNN将构建图的图学习graph learning问题转换为数据驱动的相似性度量学习问题similarity metric learning。然后作者利用自适应图正则化来控制生成的图结构的平滑性

smoothness、连接性connectivity以及稀疏性sparsity。更重要的是,作者提出了一种新颖的迭代方法来搜索隐藏的图结构hidden graph structure,该隐藏的图结构将初始图结构优化到监督学习(或半监督学习)任务的最优图结构。另外,论文的方法可以同时处理transductive learning和inductive learning。最后,通过广泛的实验表明,在下游任务性能以及计算时间方面,论文提出的

DIAL-GNN模型可以始终超越或者接近state-of-the-art基准模型。

20.1 模型

给定

图结构学习任务的目标是自动学习图结构

GNN-based模型来应用于下游的预测任务。大多数现有方法通过预处理过程来基于人工规则或特征来构造图,如

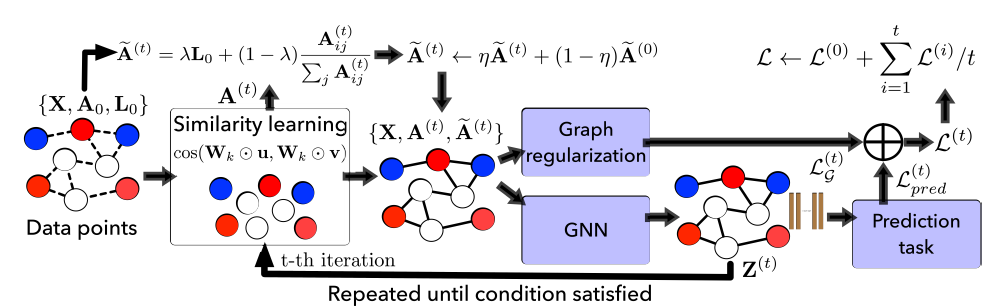

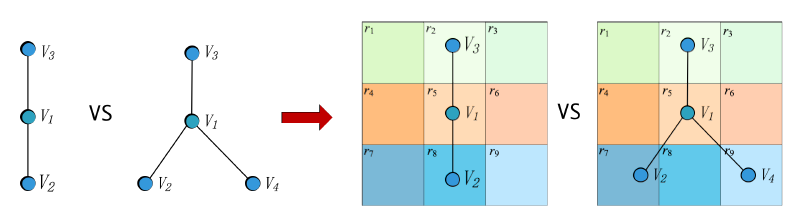

kNN近邻图。和这些方法不同,我们提出的DIAL-GNN框架将问题描述为一个迭代式学习问题,该问题以端到端的方式联合学习图结构和GNN参数。DIAL-GNN整体架构如下图所示,其中最左侧图中的虚线表示原始的图结构kNN近邻图构建的图结构。

20.1.1 相似度量学习

构建图的一个常用策略是:首先基于某种度量来计算节点

pair对之间的相似度,然后在下游任务中使用人工构建的图。和这些方法不同,我们为图结构学习设计了一个可学习的度量函数,它将与下游任务的模型一起训练。Similarity Metric Learning:类似于multi-head attention机制,我们设计了multi-head余弦相似度:其中:

head的数量。head的权重向量,它在所有节点之间共享,并代表一个视图perspective。每个视图捕获了节点之间的部分相似语义。

我们用

这里采用权重向量的逐元素乘积,而不是基于矩阵乘法的投影(即,

vs权重向量这里多个视图的相似性取平均,也可以考虑取最大值或者中位数?

Graph Sparsification:邻接矩阵应该是非负的(度量metric也应该是非负的),而[-1,1]。此外,很多真实的图结构都是稀疏的。进一步地,一个稠密图不仅计算代价较高,而且对于大多数场景意义不大。因此我们仅考虑每个节点的

.

20.1.2 图正则化

在图信号处理

graph signal processing中,对图信号广泛采用的假设是:value在相邻节点之间平滑变化。给定一个加权无向图

smoothness通常由迪利克雷能量Dirichlet energy来衡量:其中:

trace。

可以看到:最小化

上述平滑损失

smoothness loss最小化存在一个平凡解trivial solution:sparsity。考虑《How to learn a graph from smooth signals》的做法,我们对学习的图结构施加了额外的约束:其中:

F范数。第一项通过对数的

barrier来惩罚不连续图的形成,即连通性connectivity。当存在孤立节点

第二项惩罚第一项造成的较大

degree,从而控制稀疏性。在构造邻接矩阵

图的总体正则化损失为上述损失之和,从而控制学习的图结构的平滑性、连通性、稀疏性:

其中

20.1.3 迭代式图学习

a. Joint Graph Structure and Representation Learning

我们期望图结构能起到两个作用:它应该遵循节点之间的语义关系;它应该适合下游预测任务的需求。

因此,我们通过结合任务预测损失和图正则化损失来联合学习图结构和

graph representation,即:注意:我们的图学习框架与各种

GNN无关,也和预测任务无关。为方便讨论,我们采用两层GCN,其中第一层将节点特征映射到embedding空间,第二层将embedding映射到输出空间:其中:

sigmoid或softmax)。label矩阵,

对于节点分类任务,

softmax函数,现在我们讨论如何获得归一化的邻接矩阵

initial graph structure可用,则完全丢失初始图结构是有害的。之前的一些工作通过执行

masked attention从而将初始图结构注入到图结构学习中,但是这会限制图结构学习的能力。因为这种方法无法学到初始图结构中不存在、但是实际上有用的那些边。我们假设最优图结构和初始图结构的差异很小,因此我们认为最优图结构和初始图结构、度量学习学到的图结构满足以下关系:其中:

- 超参数

上式等价于:

如果初始图结构 kNN 近邻图从而作为初始图结构。

“最优图结构和初始图结构的差异很小” 这是一个非常强的假设。当

时模型就回退到使用初始图结构的版本。

b. Iterative Method for Graph Learning:

以前的一些工作仅依靠原始节点特征并基于某些注意力机制来学习图结构。我们认为这有一些局限性,因为原始节点特征可能不包含足够的信息来学习号的图结构。我们的初步实验表明:简单地在这些原始节点特征上应用一些注意力函数无助于学习有意义的图。

为解决上述限制,我们提出了一种用于图神经网络的深度迭代和自适应学习框架,即

Deep Iterative and Adaptive Learning framework for Graph Neural Network: DIAL-GNN。具体而言,除了基于原始特征计算节点相似度之外,我们还引入了另一个可学习的、基于节点embedding计算到的相似度度量函数。这么做的目的是在node embedding空间上定义的度量函数能够学习拓扑信息,从而补充仅基于原始节点特征学到的拓扑信息。为了结合原始节点特征和节点embedding双方的优势,我们将最终学到的图结构作为它们的线性组合:其中:

DIAL-GNN算法:输入:

- 特征矩阵

label矩阵 - 初始的邻接矩阵(如果有的话)

- 超参数

- 特征矩阵

输出:最优图结构

label矩阵算法步骤:

随机初始化

GCN模型参数如果初始邻接矩阵

kNN来给出初始邻接矩阵:根据

其中,

计算节点

embedding:计算预测损失:

计算图正则化损失:

计算联合损失:

迭代,停止条件为:

基于

基于

multi-head余弦相似度来计算。根据度量学习矩阵

计算

计算节点

embedding:计算预测损失:

计算图正则化损失:

计算联合损失:

总的损失为:

如果为训练截断,则反向传播

从上述算法可以看到:

算法使用更新后的节点

embeddingembedding这个迭代过程动态停止,直到学到的邻接矩阵以指定的阈值收敛,或者最大迭代步

采用动态的阈值收敛相比固定的迭代步,在

mini-batch训练时优势更为明显:我们可以使得mini-batch中每个样本图exaple graph动态停止(每个样本表示一个图)。在所有迭代之后,总的损失将通过所有之前的迭代进行反向传播,从而更新模型参数。

20.1.4 理论分析

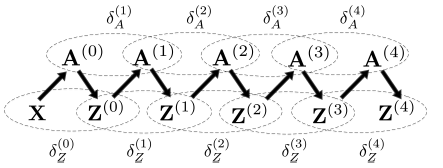

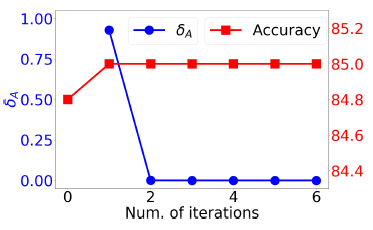

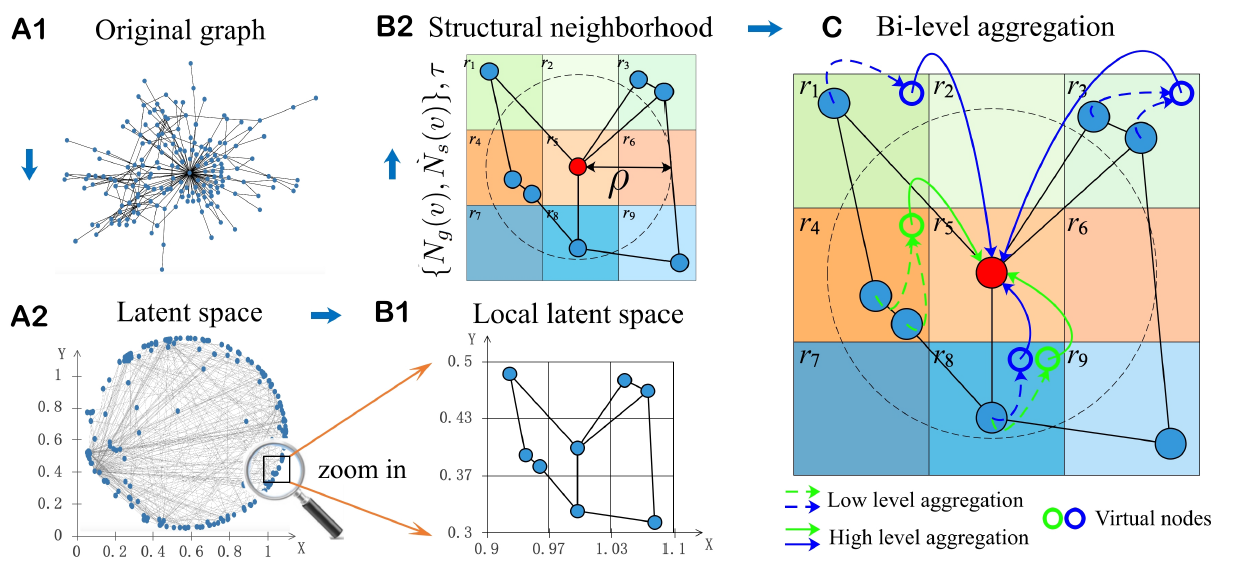

收敛性分析:理论上证明迭代式学习过程的收敛性是一个挑战,因为所涉及的学习模的任意复杂性,这里我们从概念上理解它为何在实践中有效。下图给出了迭代式学习过程中,学到的邻接矩阵

embedding可以看到:在第

进一步地,我们用

- 如果我们假设有

node embedding矩阵(即更小的 - 同样地,如果我们假设有

根据这一推理链条,我们可以轻松地扩展到后续的迭代。

现在讨论为什么在实践过程中

我们将在实验部分经验性地检验迭代式学习过程的收敛性。

- 如果我们假设有

模型复杂度:

- 学习一个邻接矩阵的算法复杂度为

embedding维度。 - 计算节点

embedding矩阵的算法复杂度为 - 计算输出的算法复杂度为

- 计算总的损失函数的代价为

假设迭代式图学习的迭代次数为

- 学习一个邻接矩阵的算法复杂度为

20.2 实验

这里我们进行一系列实验,从而验证

DIAL-GNN框架的有效性,并评估不同部分的影响。数据集:

- 图数据集:

Cora和Citeseer是评估图学习算法的两个常用的基准数据集,输入的特征是bag-of-word,任务是节点分类。在这两个数据集中,图结构可用。 - 非图数据集:

Wine, Breast Cancel, Digits是三个非图数据集,任务是节点分类。在这些数据集中没有图结构。 inductive learning数据集:为了证明IDAL-GNN在inductive learning任务上的有效性,我们分别对20Newsgroups数据集(20News)、movie review数据集(MRD)进行文档分类和回归任务。我们将每个文档视为一个图,其中文档中的每个单词作为图的节点。

对于

Cora,Citeseer,我们遵循之前工作的实验配置(GCN, GAT, LDS-GNN)。对于Wine, Cancer, Digits,我们遵循LDS-GNN的实验配置;对于20News,我们从训练数据中随机选择30%样本作为验证集;对于MRD,我们使用60%:20%:20%的比例将数据集拆分为训练集、验证集、测试集。所有实验都是采用不同的随机数种子执行

5次的均值。

- 图数据集:

baseline方法:在

transductive learning中的baseline为LDS-GNN。与我们的工作类似,LDS-GNN也是共同学习图结构和GNN参数,但是LDS-GNN无法应用于inductive-learning。因为它旨在直接优化底层图的边上的离散概率分布,这使得它无法在测试阶段处理unseen的节点或图。LDS-GNN论文给出了几种半监督baseline的实验结果,这里我们直接复制结果到这里,而并没有花时间重跑这些baseline。对于

Cora,Cteseer数据集,我们还将GCN, GAT作为baseline。为评估

DIAL-GNN在带噪音的图上的鲁棒性,我们还将DIAL-GNN, GCN在添加额外噪声的边、或删除已有的边的图上进行比较。对于非图数据集,我们给出了一个

kNN-GCN作为baseline,其中先在数据集上构建kNN近邻图,然后对这个图应用GCN。对于

inductive learning,我们将DIAL-GNN和BiLSTM, kNN-GCN进行比较。

实验配置:

在我们所有实验中(拷贝的实验除外),除了输出层之外,我们在

GCN最后一层卷积层之后、输出层之前应用dropout rate = 0.5的dropout。在迭代式学习过程中,除了

Citeseer(无dropout)、Digits(dropout rate = 0.3),我们也在GCN中间的卷积层应用dropout rate = 0.5的dropout。对于文本数据集,我们选择数据集中词频超过

10次的单词,并训练了一个300维的GloVe向量。对于长文本,为提高效率我们将文本长度限制为最大

1000个单词。在

word embedding层和BiLSTM层之后,我们使用dropout rate = 0.5的dropout。我们使用

Adam优化器,batch size = 16。对于

20News,隐层维度为128;对于MRD,隐层维度为64。对于其它benchmark,隐层维度为16。对于

text benchmark,我们将学习率设为0.001;所有其它benchmark,学习率为0.01,并应用0.0005的权重衰减。

下图给出了

benchmark上DIAL-GNN相关的超参数。所有超参数都在验证集上进行了优化:

在

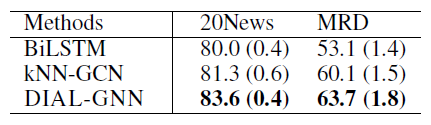

transductive learning和inductive learning上的实验结果如下所示。其中上图为transductive learning,评估指标为测试准确率accuracy(+-标准差);下图为inductive learning,评估指标分别为测试准确率(分类问题)和测试R2 score(回归问题) ,括号内为+-标准差。结论:

DIAL-GNN在7个benchmark中有6个优于所有的baseline方法,这证明了DIAL-GNN的有效性。- 即使图结构可用,

DIAL-GNN也可以极大地帮助完成节点分类任务。 - 当图结构不可用时,和

kNN-GCN相比,DIAL-GNN在所有数据集上始终获得更好的结果。这表明联合学习图结构和GNN的强大能力。 - 和

LDS相比,DIAL-GNN在5个benchmark上的4个获得了更好的性能。 20News和MRD上的良好表现证明了DIAL-GNN在inductive learning中的能力。

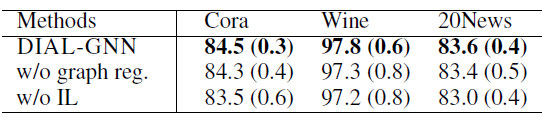

我们进行消融实验从而评估

DIAL-GNN框架不同部分的影响,评估指标为测试集accuracy(+-标准差)。其中w/o表示without。结论:

- 关闭迭代式学习(

w/o IL),所有数据集的性能持续下降。这证明了迭代式学习对于图结构学习问题的有效性。 - 关闭图正则化(

w/o graph reg.),所有数据集的性能也在持续下降。这证明了结合图正则化损失共同训练模型的好处。

- 关闭迭代式学习(

为评估

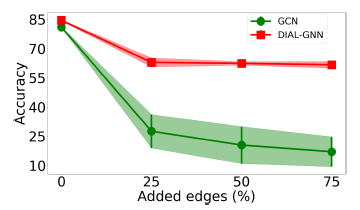

DIAL-GNN在噪音图上的鲁棒性,我们对于Cora数据集构建了随机添加边、随机删除边的图。具体而言,我们随机删除原始图中25%, 50%, 75%的边(上图),或者随机添加原始图中25%, 50%, 75%的边(下图)。评估指标为测试集accuracy(+-标准差)。结论:

- 在所有的情况下,

DIAL-GNN都比GCN获得更好的结果,并且对带噪音的图更鲁棒。 GCN在添加噪音边的场景下完全失败,但是DIAL-GNN仍然能够合理地执行。我们猜测是因为等式

- 在所有的情况下,

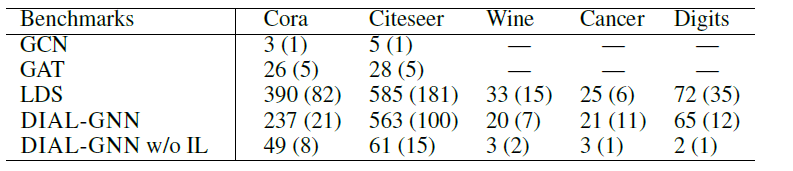

我们通过测试阶段的迭代式学习过程中的迭代,展示了迭代式学习学到的邻接矩阵的演变,以及模型测试

accuracy的演变。我们将迭代式学习过程中相邻矩阵之间的差定义为:

其典型取值范围是

0~1。结论:邻接矩阵和

accuracy都通过迭代快速收敛,这从经验上验证了我们对迭代式学习过程的收敛性做出的分析。

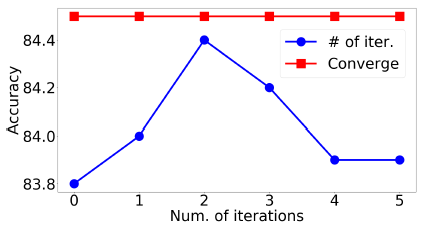

DIAL-GNN迭代式学习方法的停止策略有两种:迭代固定数量的迭代步之后停止、应用某些停止条件从而动态停止。下图我们比较了两种策略的有效性,其中蓝线表示使用固定数量的迭代次数,红线表示使用动态停止条件。评估指标为Cora数据集的测试集上的平均accuracy。结论:使用停止条件从而动态停止的效果更好。

最后,我们在各种

benchmark中比较了DIAL-GNN, LDS以及其它经典GNN(如GCN, GAT)的训练效率。所有实验均在

Intel i7-2700K CPU, NVIDIA Titan XP GPU和16GB RAM的同一台机器上运行,并使用不同随机数种子重复执行5次。结果见下表(单位秒)。结论:

DIAL-GNN和LDS都要比GCN,GAT更慢。这是可以预期的,因为GCN和GAT不需要同时学习图结构。DIAL-GNN始终比LDS更快,但总体而言它们是差不多的水平。- 通过移除迭代式学习(

DIAL-GNN w/o IL) 可以发现,迭代式学习的部分是DIAL-GNN中最耗时的。

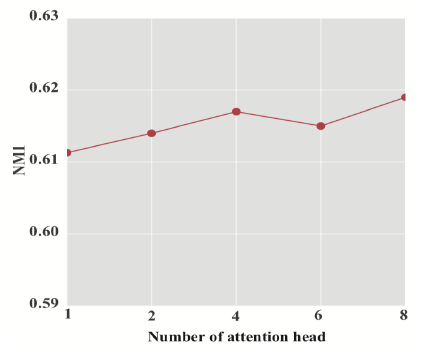

二十一、HAN[2019]

现实世界中的数据很多包含图结构,如社交网络、引文网络、万维网。图神经网络

GNN作为一种强大的图结构数据的深度representation learning方法,在图数据分析中表现出卓越的性能,并引起广泛的研究。例如,一些工作(《A new model for learning in graph domains》、《Gated graph sequence neural networks》、《The graph neural network model》)利用神经网络来学习基于节点特征和图结构的node representation。一些工作(《Convolutional neural networks on graphs with fast localized spectral filtering》、GraphSAGE、GCN)通过将卷积推广到图来提出图卷积网络。深度学习的最新研究趋势是注意力机制,该机制可以处理可变大小的数据,并鼓励模型更关注于数据中最重要的部分。注意力机制已被证明在深度神经网络框架中的有效性,并广泛应用于各个领域,如文本分析、知识图谱、图像处理。

Graph Attention Network: GAT是一种新颖的卷积式图神经网络,它利用注意力机制来处理仅包含一种类型的节点或边的同质图。尽管注意力机制在深度学习中取得成功,但是目前的异质图神经网络架构尚未考虑注意力机制。事实上,现实世界中的图通常带有多种类型的节点和边,这通常被称作异质信息网络

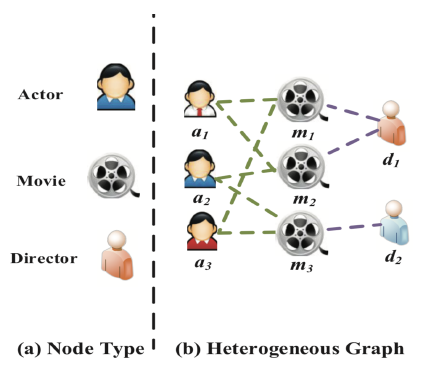

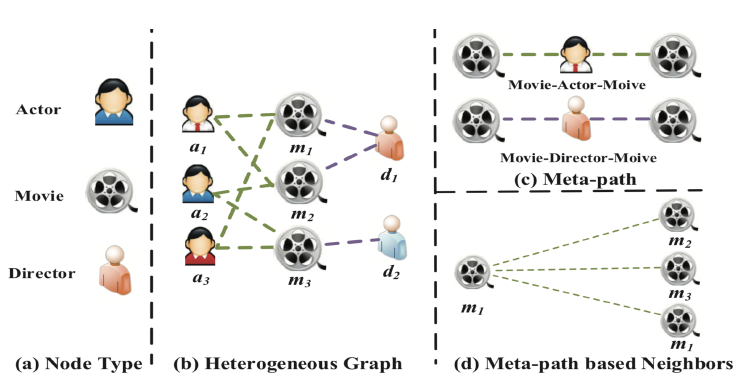

heterogeneous information network: HIN或异质图heterogeneous graph。异质图包含更全面的信息和更丰富的语义,因此被广泛应用于许多数据挖掘任务中。由于异质图的复杂性,传统的GNN模型无法直接应用于异质图。metapath表示了不同类型对象之间的关系,它是一种广泛用于捕获语义的结构。以电影数据集IMDB为例,它包含三种类型的节点:电影Movie、演员Actor、导演Director。metapath“电影-演员-电影”MAM表示两部电影之间的共同演员关系。metapath“电影-导演-电影”MDM表示两部电影之间的共同导演关系。

可以看到:采用不同的

metapath,异质图中节点之间的关系可以具有不同的语义。由于异质图的复杂性,传统的图神经网络无法直接应用于异质图。

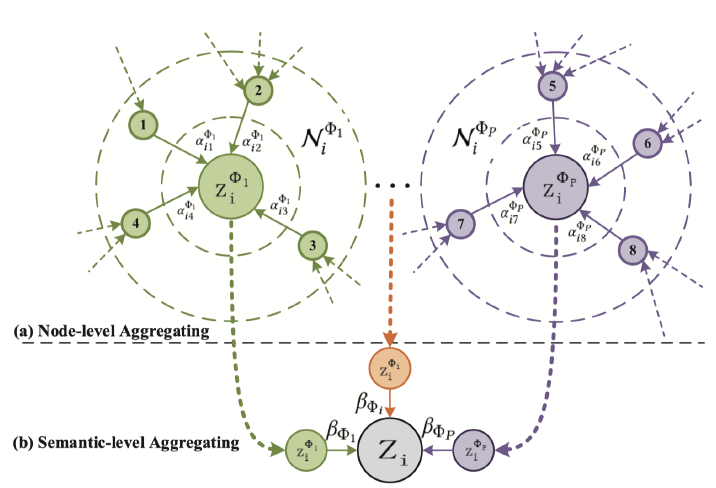

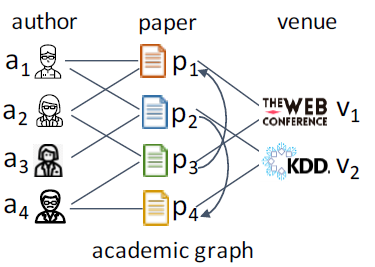

基于以上分析,在为异质图设计具有注意力机制的神经网络体系结构时,需要满足以下需求:

图的异质性:异质性

heterogeneity是异质图的固有属性,即图中包含各种类型的节点和边。例如,不同类型的节点具有不同的特征,它们的特征可能位于不同的特征空间。如何同时处理如此复杂的异质图结构信息,同时保持多样化的特征信息是需要解决的问题。semantic-level注意力:异质图涉及不同的有意义和复杂的语义信息,这些语义信息通常以metapath来刻画。因此,异质图中不同的metapath可以抽取不同的语义信息。如何选择最有意义的metapath,并为task-specific融合语义信息是需要解决的问题。semantic-level注意力旨在了解每个metapath的重要性,并为其分配适当的权重。如,电影 “《终结者》” 可以通过Movie-Actor-Movie连接到 “《终结者2》” (都是由施瓦辛格主演),也可以通过Movie-Year-Movie连接到 “《Birdy》” (都是在1984年拍摄)。但是在影片分类任务中,MAM通常要比MYM更重要。因此,均匀对待所有

metapath是不切实际的,这会削弱某些有用的metapath提供的语义信息。node-level注意力:在异质图中,节点可以通过各种类型的关系来连接。给定一个metapath,每个节点多有很多基于该metapath的邻居。我们需要知道如何区分邻居之间的重要性,并选择一些信息丰富的邻居。对于每个节点,node-level注意力旨在了解metapath-based邻居的重要性,并为他们分配不同的注意力值。

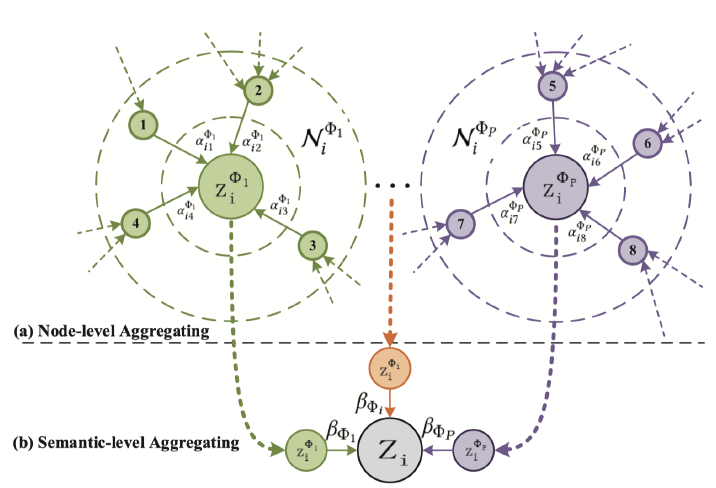

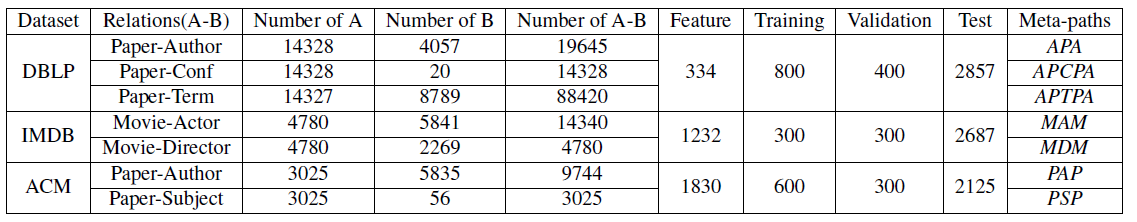

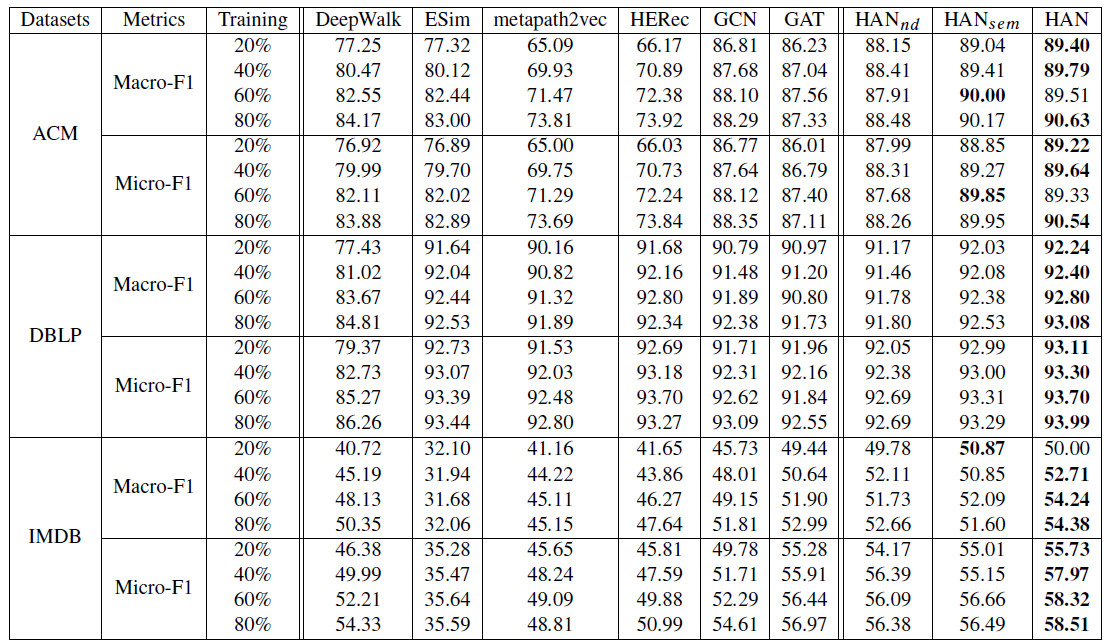

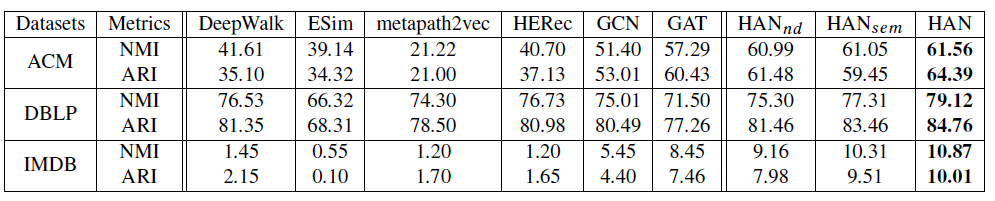

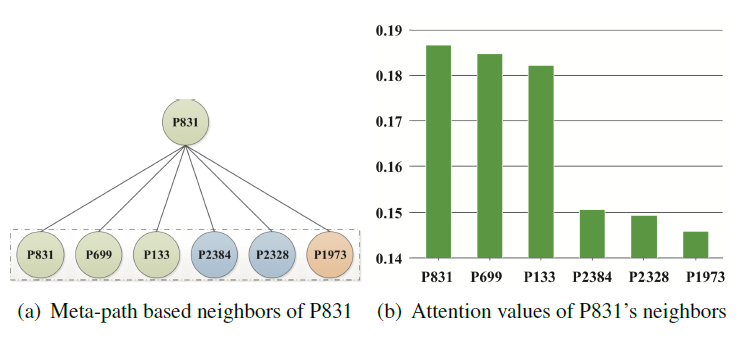

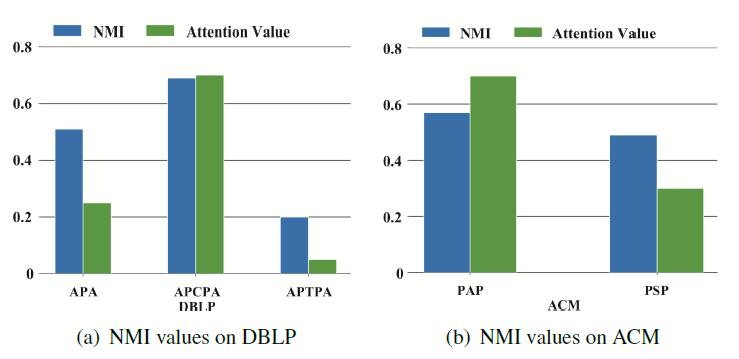

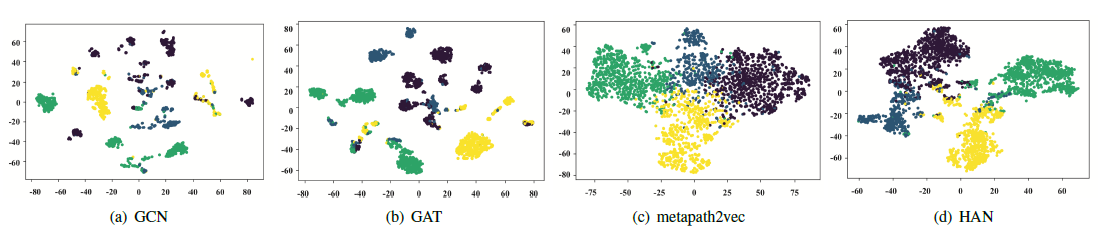

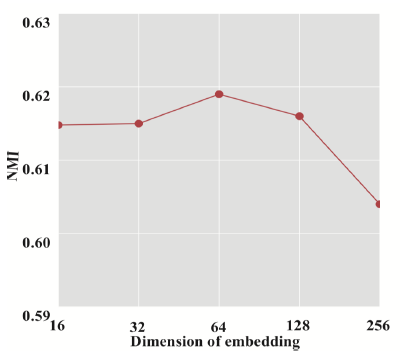

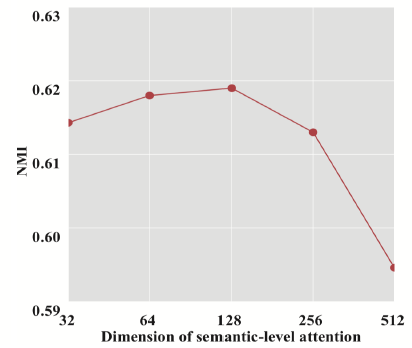

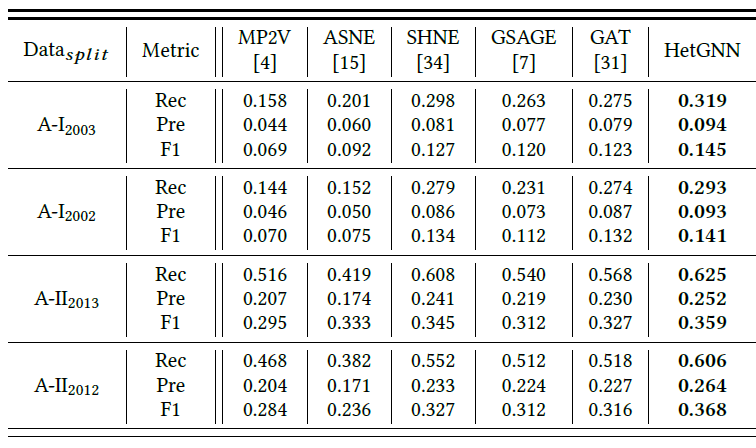

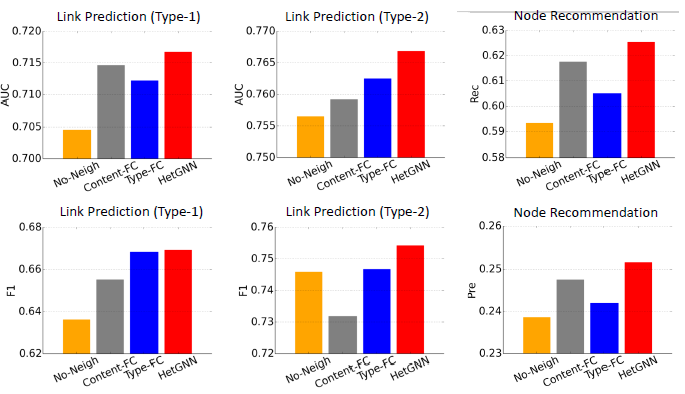

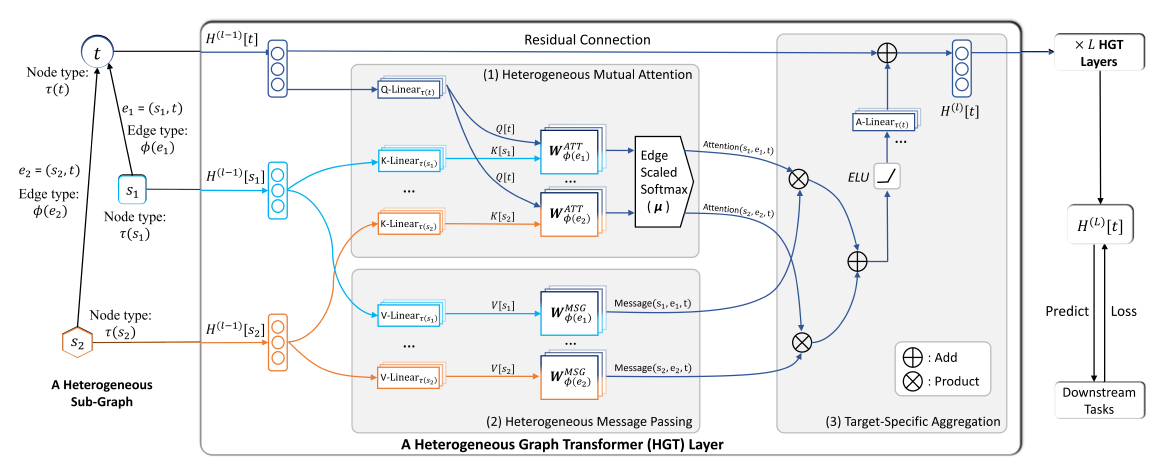

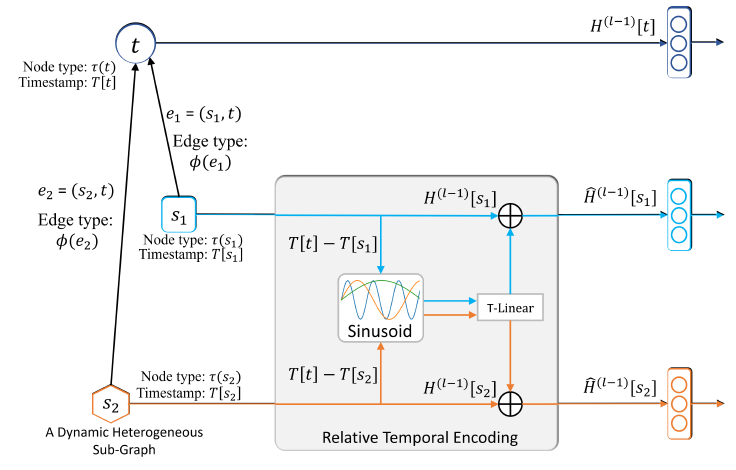

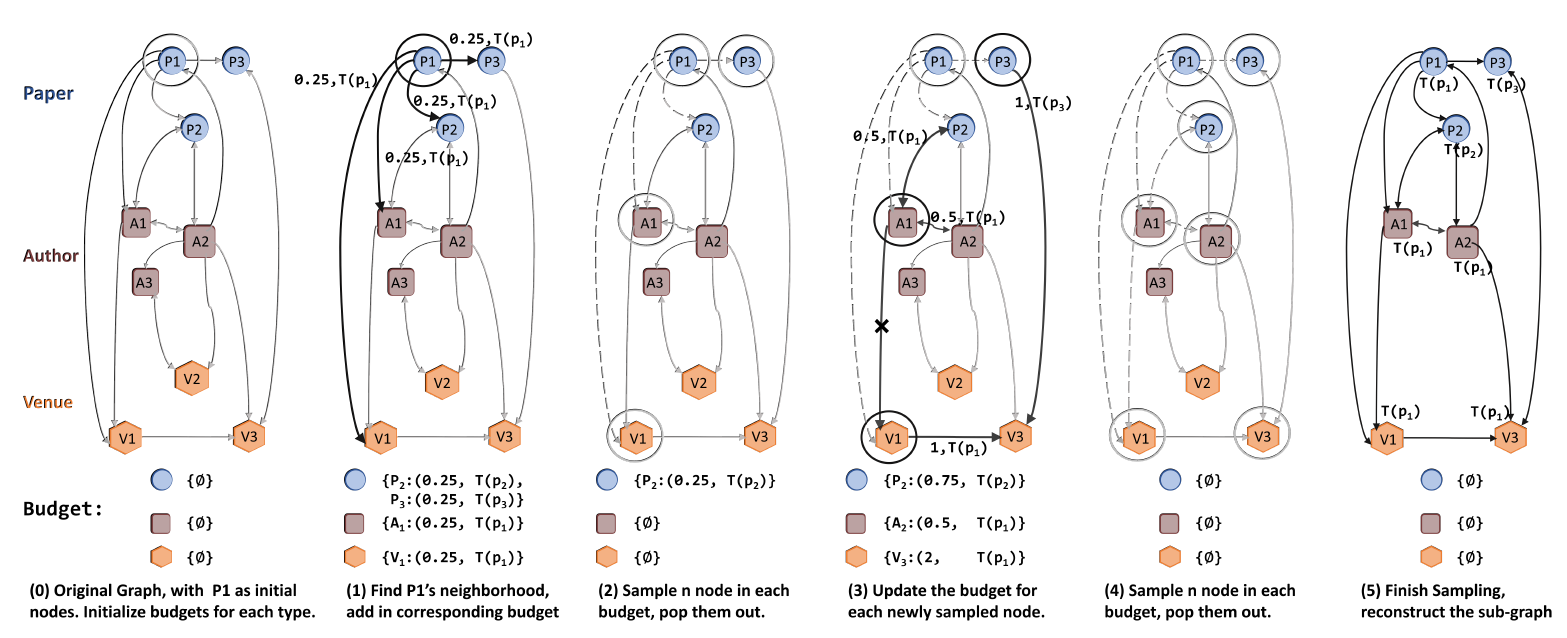

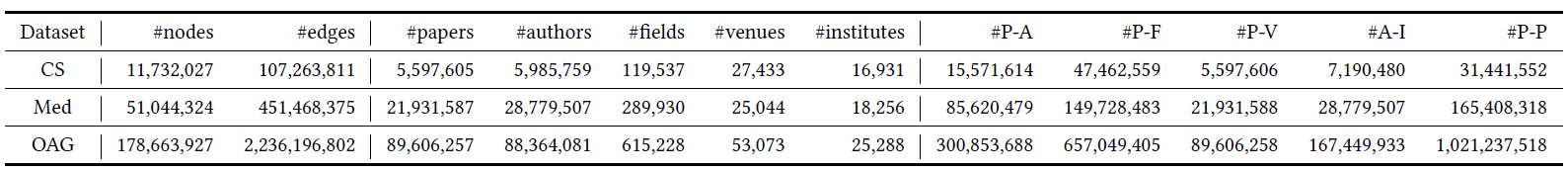

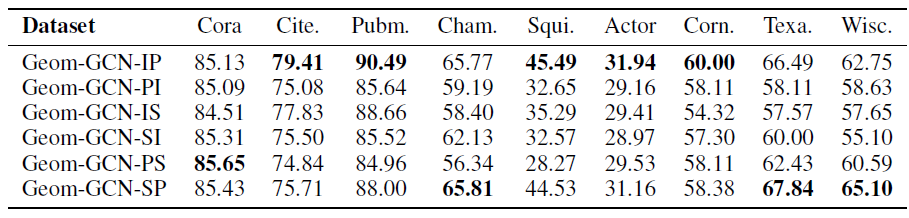

为解决这些问题,论文