一、MIND[2019](用于召回)

天猫是中国最大的

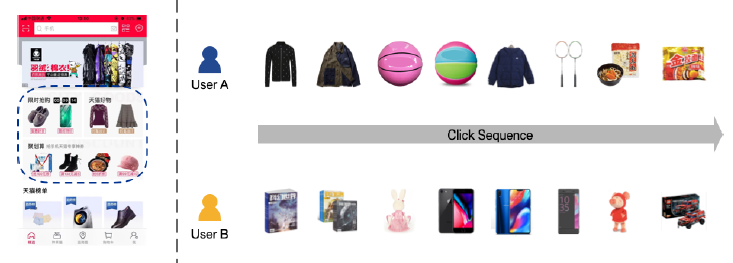

Business-To-Customer: B2C电商平台,它在线提供十亿规模的商品,服务于十亿规模的用户。2018年11月11日,著名的天猫全球购物节,商品交易总额Gross Merchandise Volume: GMV大约为2130亿元,较2017年同期增长26.9%。随着用户和商品的不断增长,帮助每个用户找到他 / 她可能感兴趣的商品变得越来越重要。近年来,天猫在开发个性化推荐系统方面付出了巨大的努力,极大地促进了用户体验的优化以及商业价值的提升。例如,占天猫总流量一半左右的移动天猫App首页(如下图左图所示),就部署了推荐系统来展示个性化商品,从而满足客户的个性化需求。由于拥有十亿规模的用户和

item,天猫的推荐流程分为matching阶段和ranking阶段两个阶段。matching阶段负责检索与用户兴趣相关的数千个候选item,然后ranking阶段负责预测用户与这些候选item交互的精确概率。对于这两个阶段,为了支持对满足用户兴趣的item的高效检索,建模用户兴趣并得到捕获用户兴趣的用户representation至关重要。然而,由于用户兴趣的多样性diversity,在天猫上建模用户兴趣并非易事。平均而言,十亿级用户访问天猫,每个用户每天与数百种商品进行交互。交互的商品往往隶属不同的类目,暗示了用户兴趣的多样性。例如,如下图右图所示,不同用户的兴趣是不同的,同一用户也可能对不同的item感兴趣。因此,捕获用户多样化兴趣diverse interests的能力对天猫的推荐系统而言至关重要。注:下图中,左图的虚线矩形区域是天猫的十亿规模用户的个性化区域;右图是两个用户和不同类目商品的交互。

现有的推荐算法以不同的方式建模和表示用户兴趣:

基于协同过滤的方法通过历史交互

item或潜在因子来表示用户兴趣,这些方法存在数据稀疏问题、或者计算复杂度太高的问题。基于深度学习的方法通常用低维

embedding向量表示用户兴趣。例如,为YouTube视频推荐提出的深度神经网络(YouTubeDNN)通过一个固定长度的向量来表示每个用户,该向量是由用户历史行为转换而来。这可能是建模多样化兴趣的瓶颈,因为它的维度必须很高,从而表达天猫上的、大量的兴趣画像。深度兴趣网络

Deep Interest Network: DIN通过注意力机制来捕获用户兴趣的多样性,使得用户在不同目标item上的用户representation不同。然而,注意力机制的采纳也使得具有十亿级item的大规模应用在计算上受到限制,因为它需要重新计算每个目标item的用户representation,使得DIN仅适用于ranking阶段。

论文

《Multi-Interest Network with Dynamic Routing for Recommendation at Tmall》关注于在matching阶段对用户的多样化兴趣进行建模的问题。为了克服现有方法的局限性,论文提出了具有动态路由的多兴趣网络Multi-Interest Network with Dynamic routing: MIND。MIND用于工业级推荐系统在matching阶段学习反映用户的多样化兴趣的representation。为了推断用户

representation向量,论文设计了一个称为多兴趣提取器层multi-interest extractor layer,它利用动态路由将用户的历史行为自适应地聚合到用户representation中。动态路由的过程可以视为软聚类soft-clustering,它将用户的历史行为分为几个簇。每个历史行为簇进一步用于推断对应于一个特定兴趣的用户representation向量。这样,对于特定的用户,MIND输出多个represenation向量,它们共同代表了用户的多样化兴趣。用户representation向量只需要计算一次,就可以用于matching阶段从而在十亿级item中检索相关item。总而言之,这项工作的主要贡献:- 为了从用户行为中捕获用户的不同兴趣,论文设计了多兴趣提取器层,该层利用动态路由自适应地将用户的历史行为聚合为用户

representation向量。

通过使用多兴趣提取器层、以及新提出的标签感知注意力层

label-aware attention layer所产出的用户representation向量,论文为个性化推荐任务构建了一个深度神经网络。与现有的方法相比,MIND在多个公共数据集和一个来自天猫的工业数据集上表现出优越的性能。- 为了在天猫部署

MIND从而服务于十亿级用户,论文构建了一个系统来实现数据集采集、模型训练、以及在线serving的整个pipeline。部署的系统显著提高了移动天猫App首页的点击率click-through rate: CTR。目前MIND已经在Mobile Tmall App首页上部署从而处理主要的在线流量。

- 为了在天猫部署

相关工作:

深度学习推荐:受深度学习在计算机视觉和自然语言处理中成功应用的启发,人们投入了大量努力来开发基于深度学习的推荐算法。除了

《Deep neural networks for youtube recommendations》和《Deep interest network for click-through rate prediction》之外,各种类型的深度模型也得到了极大的关注。- 神经协同过滤

Neural Collaborative Filtering: NCF、DeepFM、和深度矩阵分解Deep Matrix Factorization Model: DMF构建了一个由若干MLP组成的神经网络,从而对用户和item之间的交互进行建模。 《Personalized top-n sequential recommendation via convolutional sequence embedding》通过提供一个统一且灵活的网络来捕获更多特征,为top-N序列推荐提供了一个新颖的解决方案。

- 神经协同过滤

用户

Representation:将用户表示为向量是推荐系统中常见的做法。传统方法将用户感兴趣的

item、用户感兴趣的关键词、用户感兴趣的主题拼接起来,从而构成用户偏好向量。随着distributed representation learning的出现,通过神经网络获取user embedding得到了广泛的应用。《Learning user and product distributed representations using a sequence model for sentiment analysis》使用RNN-GRU从时间有序的review documents中学习user embedding。《User embedding for scholarly microblog recommendation》从word embedding向量中学习user embedding向量,并将其应用于推荐学术微博scholarly microblog。《Modelling Context with User Embeddings for Sarcasm Detection in Social Media》提出了一种新的、基于卷积神经网络的模型,该模型显式地学习和利用user embedding以及从话语utterances中获得的特征。

胶囊网络

Capsule Network:”胶囊” 的概念表示一组神经元组装而成的向量,它由Hinton在2011年首次提出。动态路由dynamic routing用于学习胶囊之间连接的权重,该学习方法不是基于反向传播,而是基于Expectation-Maximization: EM算法,从而克服几个缺陷并获得更好的准确性。与传统神经网络的这两个主要区别(由一组神经元组成、通过EM算法学习)使得胶囊网络能够对部分和整体之间的关系进行编码,这在计算机视觉和自然语言处理方面是先进的。SegCaps证明,胶囊可以比传统的CNN更好地建模对象的空间关系。《Investigating Capsule Networks with Dynamic Routing for Text Classification》研究了用于文本分类的胶囊网络,并提出了三种提高性能的策略。

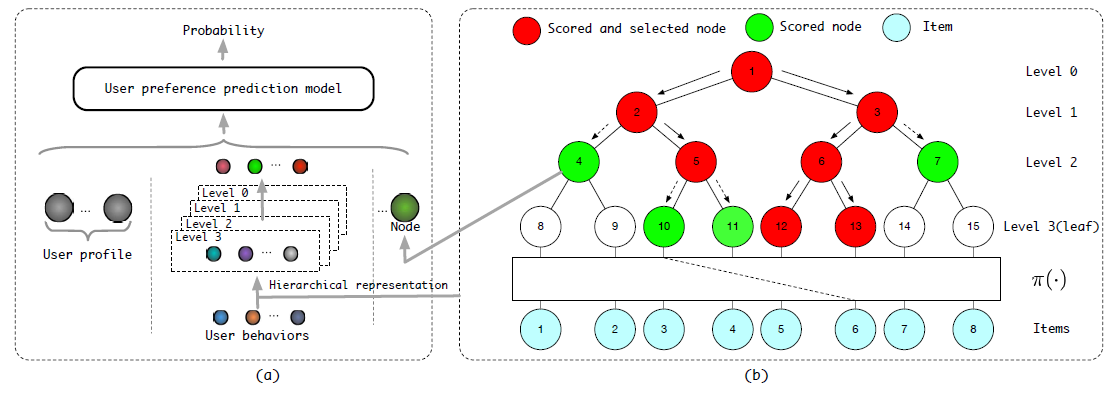

1.1 模型

工业推荐系统

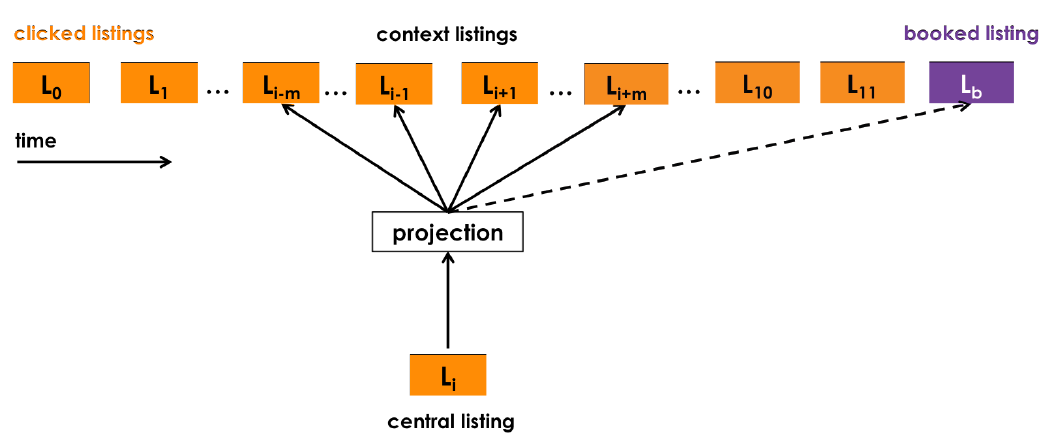

matching阶段的目标是为每个用户 从十亿规模的item库 中检索仅包含数千个item的item子集,其中该子集中每个item都和用户的兴趣相关。为了实现该目标,我们收集用户历史行为数据从而构建

matching模型。具体而言,每个样本都可以用一个元组 ,其中:表示用户 交互的

item集合,也称作用户行为。为用户 的基础画像,如性别、年龄。

为

target item的特征,如item id、category id。注意:

target item不一定隶属于 ,即用户 不一定在target item上有过互动行为。

MIND的核心任务是学习将原始特征映射到用户representation的函数,即:其中 为用户 的 个

representation向量,向量维度为 。当 时,每个用户仅使用单个representation向量,就像YouTube DNN一样。此外,通过

embedding函数获得target item的representation向量为:其中 表示

item的representation向量。 的详细信息在后文说明。当学习了用户

representation向量、item representation向量之后,在线serving时根据评分函数检索top N候选item:其中 时在

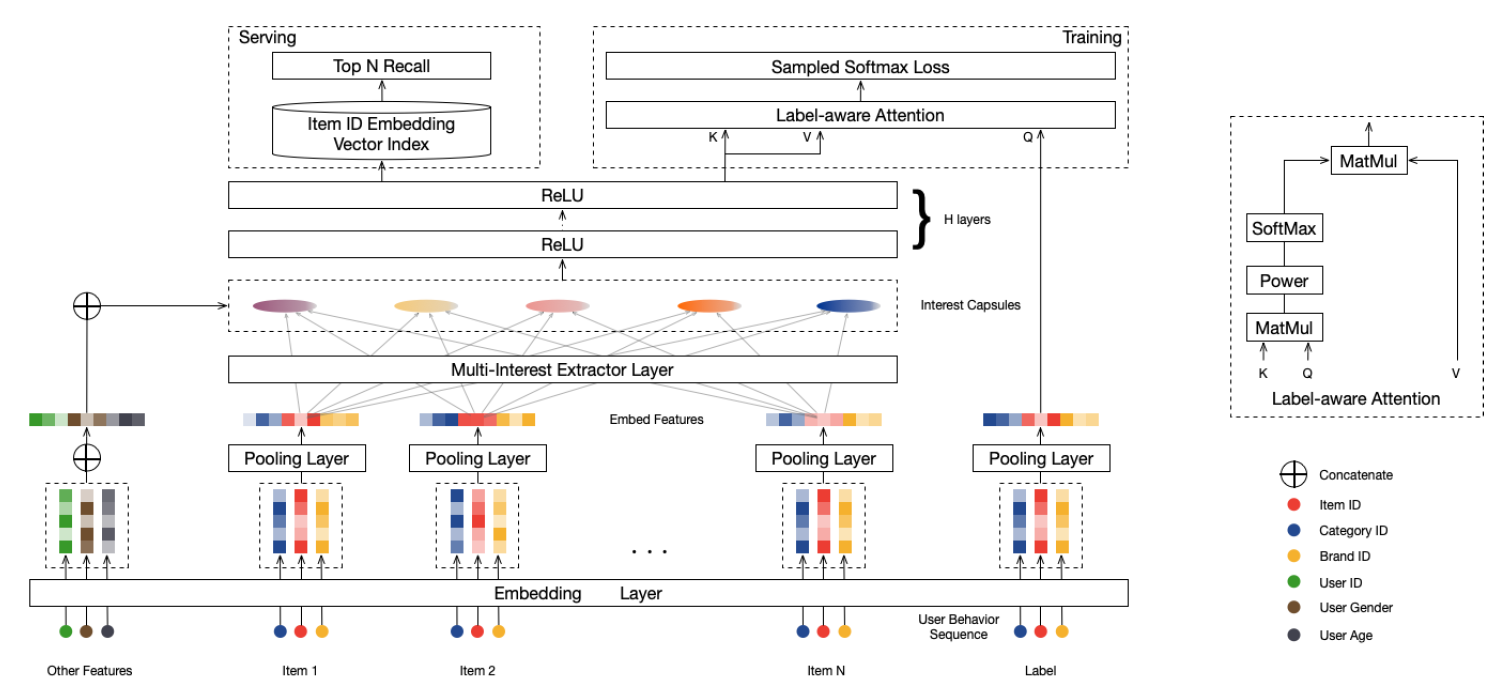

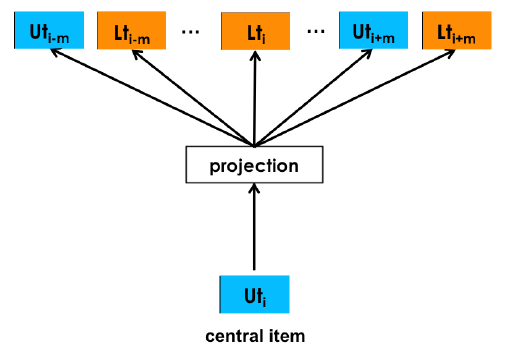

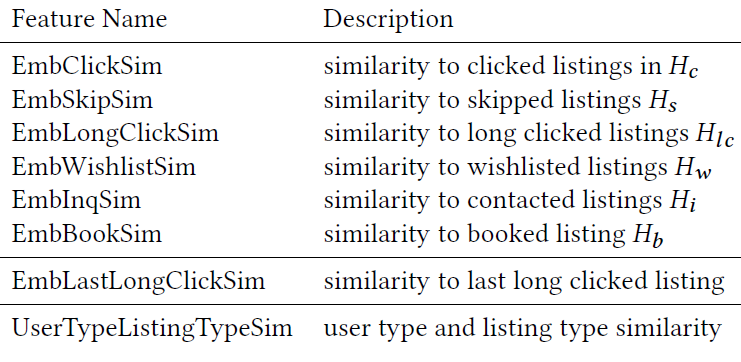

matching阶段要检索的、预定义的item数。注意: 仅用于serving阶段,而不用于训练阶段。如下图所示,

MIND将用户行为序列、用户画像、label item等特征作为输入,然后输出用户representation从而用于推荐系统的matching阶段来检索item。MIND主要由以下部分组成:Embedding&Pooling Layer:来自输入层的id特征通过embedding层转换为embedding,然后每个item的各种id embedding由池化层进一步取平均。Multi-Interest Extractor Layer:用户行为embedding被馈入多兴趣提取器层从而产生兴趣胶囊。通过将兴趣胶囊和用户画像embedding拼接,然后经过几个ReLU的全连接层进行转换,可以得到用户representation向量。Label-aware Attention Layer:在训练过程中引入一个额外的标签感知注意力层,从而指导训练过程。

最后在

serving过程中,用户的多个representation向量用于通过最近邻检索来检索item。

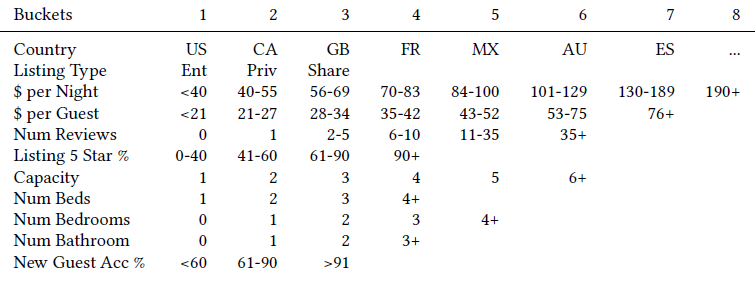

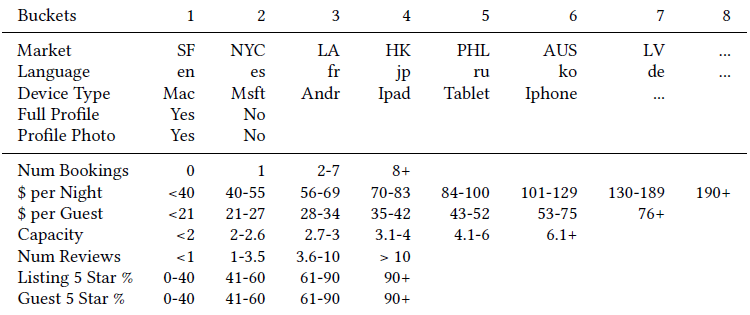

Embedding&Pooling Layer:MIND的输入包含三组:用户画像 、用户行为 、label item,每组输入包含几个具有极高维数的categorical id特征。例如,item id的数量约为数十亿个,因此我们采用了广泛使用的embedding技术将这些ID特征嵌入到低维稠密向量(也称作embedding向量)中,从而显著减少了参数数量并简化了学习过程。- 对于来自用户画像 的

id特征(性别、年龄等),对相应的embedding进行拼接从而构成用户画像embedding。 - 对于

item的item id以及其它categorical id(如品牌id、店铺id等),这些id被证明有助于label item的冷启动,相应的embedding会进一步通过均值池化层从而形成label item embedding,即 函数。 - 对于来自用户行为 的

item,收集相应的item embedding从而形成用户行为embedding,这些embedding构成了用户行为embedding矩阵 。

- 对于来自用户画像 的

1.1.1 Multi-Interest Extractor Layer

我们认为,用一个

representation向量表示用户兴趣可能是捕获用户的多样化兴趣的瓶颈,因为我们必须将与用户的多样化兴趣相关的所有信息压缩到一个representation向量中。因此,关于用户的不同兴趣的所有信息都被混合在一起,从而导致在matching阶段的item检索不准确。相反,我们采用多个

representation向量分别表达用户的不同兴趣。通过这种方式,我们可以在matching阶段分别考虑用户的多样化兴趣,从而可以更准确地检索各个方面的兴趣。为了学习多个

representation向量,我们利用聚类过程将用户的历史行为分组为几个簇cluster。我们预期来自同一个簇的item将密切相关,并且共同代表了用户在某个特定方面的兴趣。这里,我们设计了多兴趣提取器层multi-interest extractor layer,从而用于聚类历史行为,并得到结果聚类的representation向量。由于多兴趣提取器层的设计受到最近提出的、用于胶囊网络

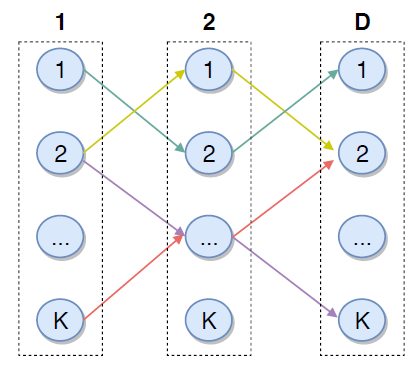

capsule network中表示学习representation learning的动态路由dynamic routing的启发,因此我们首先回顾基础知识。动态路由

Dynamic Routing:我们简单介绍用于胶囊网络表示学习的动态路由,这是一种以向量表示的、新型的神经元。假设我们有两层胶囊,分别将第一层胶囊和第二层胶囊称作低层胶囊

low-level capsule、高层胶囊high-level capsule。动态路由的目标是以迭代的方式在给定低层胶囊值的情况下计算高层胶囊值。在每次迭代中,给定低层胶囊 对应的值 、以及高层胶囊 对应的值 ,其中 , 分别为低层

value vector和高层value vector的维度。则低层胶囊 和高层胶囊 之间的

routing logit为:其中 为待学习的双线性映射矩阵。

当计算好

routing logit之后,高层胶囊 的value vector更新为:其中:

- 为所有低层胶囊值向量的加权和。加权和的权重 表示低层胶囊 和高层胶囊 的权重,是通过对

routing logit进行softmax来计算的。 - 非线性的

squash函数用于获得高层胶囊的值向量。

另外, 的值将被初始化为零。

整个路由过程通常需要

3轮迭代才会收敛。路由结束后,高层胶囊的值向量 通常会固定不变,并且可以用于下一层layer的输入。- 为所有低层胶囊值向量的加权和。加权和的权重 表示低层胶囊 和高层胶囊 的权重,是通过对

B2I动态路由:简而言之胶囊是一种由向量表示的神经元,而不是普通神经网络中标量表示的神经元。我们期待基于向量的胶囊能够代表实体的不同属性,其中向量的方向代表一种属性、向量的长度代表该属性存在的概率。相应地,多兴趣提取器层的目标是学习用于表达用户兴趣、以及是否存在相应兴趣的

representation。胶囊和兴趣representation之间的语义联系促使我们将行为/兴趣representation视为行为/兴趣胶囊,并采用动态路由从行为胶囊behavior capsule中学习兴趣胶囊interest capsule。然而,针对图像数据提出的原始路由算法并不能用于直接处理用户行为数据。因此,我们提出了

Behavior-to-Interest:B2I动态路由,用于将用户的行为自适应地聚合到兴趣representation向量中,这和原始路由算法在三个方面有所不同:共享双线性映射矩阵:基于两方面的考虑,我们将每对低层胶囊和高层胶囊

pair对之间使用固定的双线性映射矩阵 ,而不是在原始动态路由中独立的双线性映射矩阵:- 一方面,用户行为序列的长度是可变的,天猫用户的行为序列长度从几十到几百,因此使用共享的双线性映射矩阵更为泛化

generalizable。 - 另一方面,我们希望兴趣胶囊位于相同的向量空间中,而不同的双线性映射矩阵会将兴趣胶囊映射到不同的向量空间中。

因此,

routing logit计算为:其中:

- 为

behavior item的embedding。 - 为

interest capsule的向量,一共有 个兴趣。 - 双线性映射矩阵 在每对行为胶囊和兴趣胶囊

pair对之间共享。

- 一方面,用户行为序列的长度是可变的,天猫用户的行为序列长度从几十到几百,因此使用共享的双线性映射矩阵更为泛化

随机初始化

routing logit:由于使用了共享的双线性映射矩阵 ,将routing logit初始化为零导致所有用户具有相同的初始兴趣胶囊。然后在随后的每一轮迭代中,不同用户之间在当前轮次具有相同的兴趣胶囊。(注:不同迭代步之间的取值不同,但是同一迭代步之内的取值都相同)。为了缓解这种现象,我们从高斯分布 中抽样一个随机矩阵作为初始

routing logit,使得初始兴趣胶囊彼此不同。这和著名的K-Means聚类算法的随机初始化类似。动态兴趣数量:由于不同用户的兴趣数量可能不同,因此我们引入了一种启发式规则,用于针对不同用户自适应地调整 的值。

具体而言,用户 的 值通过以下公式计算:

这种调整兴趣数量的策略可以为那些兴趣较少的用户节省一些资源,包括计算资源、内存资源。

B2I Dynamic Routing算法:输入:

- 用户 的行为

embedding集合 - 迭代轮次

- 兴趣胶囊数量

- 用户 的行为

输出:用户 的兴趣胶囊集合

算法步骤:

计算自适应的兴趣胶囊数量:

对于所有的行为胶囊 和兴趣胶囊 ,随机初始化

迭代 ,迭代步骤为:

- 对于所有行为胶囊 :

- 对于所有兴趣胶囊 :

- 对于所有兴趣胶囊 :

- 对于所有的行为胶囊 和兴趣胶囊 :

返回

注:本质上它是在给定 行为胶囊的前提下找到 个兴趣胶囊,使得:

a. 兴趣胶囊 是所有行为胶囊的加权和。

b. 行为胶囊 对所有兴趣胶囊的权重是由兴趣胶囊进行

softmax得到。这类似于二部图上的消息传递机制,因此迭代若干轮之后就会收敛。

这里 的选择是个难点:太小则不足以捕获用户多样化兴趣,太大则计算复杂度太高并引入噪音的兴趣胶囊。

注二:这里使用胶囊网络来进行聚类,本质是一个聚类过程。

1.1.2 Label-aware Attention Layer

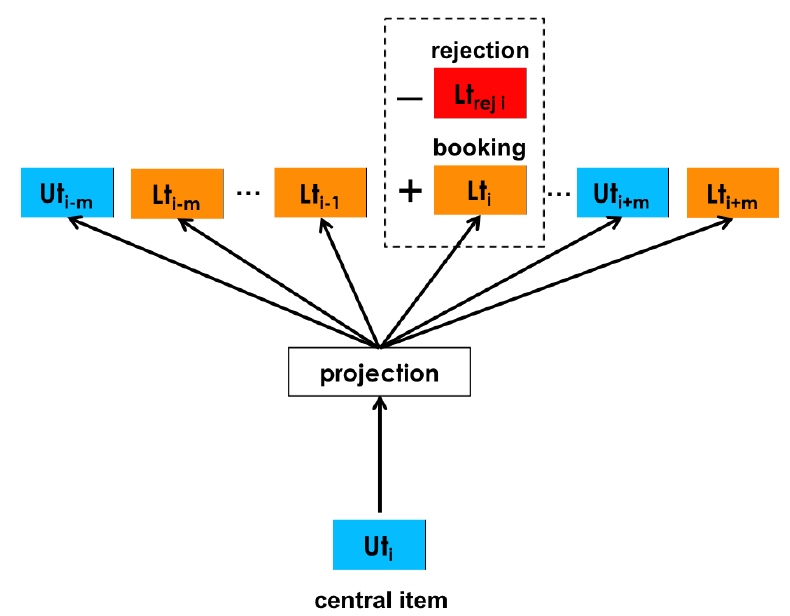

通过多兴趣抽取层,我们从用户的行为

embedding中生成了多个兴趣胶囊。不同的兴趣胶囊代表了用户兴趣的不同方面,而且相关的兴趣胶囊用于评估用户对特定item的偏好。因此,在训练过程中我们基于scaled dot-product attention设计了标签感知注意力层label-aware attention layer。具体而言,对于一个目标

item:- 首先,我们计算每个兴趣胶囊和目标

item embedding之间的相似性。 - 然后,我们计算兴趣胶囊的加权和作为针对目标

item的用户representation向量,其中每个兴趣胶囊的权重由相应的相似性来确定。

- 首先,我们计算每个兴趣胶囊和目标

在标签感知注意力层中,

label item是query,兴趣胶囊同时作为key和value。用户 关于item的representation为:其中:

pow()函数表示逐元素的指数函数。p是一个超参数作为指数函数的指数项,它用于调整注意力分布:当 接近于零时,每个兴趣胶囊倾向于收到均匀分布的注意力。

当 大于

1时,随着 的增加,具有较大dot-product的兴趣胶囊将获得越来越大的权重。考虑极端情况下当 为正无穷时,注意力机制将成为一种硬注意力

hard attention:选择注意力最大的兴趣胶囊并忽略其它兴趣胶囊。这意味着挑选和目标

item最相似的兴趣来作为标签感知的兴趣representation。此时无需进行复杂的attention计算,直接利用最近邻检索来获取。

在我们的实验中,我们发现

hard attention可以加快收敛速度。

1.1.3 其它

Training:得到用户representation向量 以及label item embedding之后,我们计算用户 和label item交互的概率为:训练

MIND的目标函数为:其中 是包含所有

user-item交互的训练数据的集合。注意,这里通过

softmax函数变为一个多分类问题,因此没有负样本的概率。在多分类问题中,不存在负样本,只有二分类问题存在负样本。由于

item规模在数十亿级,因此 的分母计算量太大导致无法实现,因此我们采用采样的softmax技术sampled softmax technique。我们使用

Adam优化器来训练MIND。Serving:除了标签感知注意力层之外的MIND网络即为用户representation映射函数 。在serving期间:- 用户的行为序列和用户画像馈入 函数,从而为每个用户生成多个

representation向量。 - 然后,我们使用这些

representation向量通过最近邻方法检索top N个item,从而构成推荐系统matching阶段的最终候选item集。

注意:

- 当用户有新的行为时,这将改变用户的行为序列以及相应的用户

representation向量,因此MIND对于mathcing阶段拥有实时个性化的能力。 - 每个用户有 个兴趣胶囊, ,这里会针对每个兴趣胶囊进行检索然后合并。

- 用户的行为序列和用户画像馈入 函数,从而为每个用户生成多个

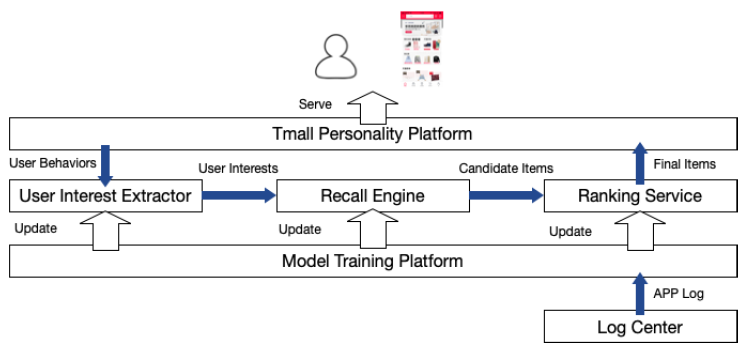

部署:天猫上

MIND的实现和部署如下所示:当用户启动天猫

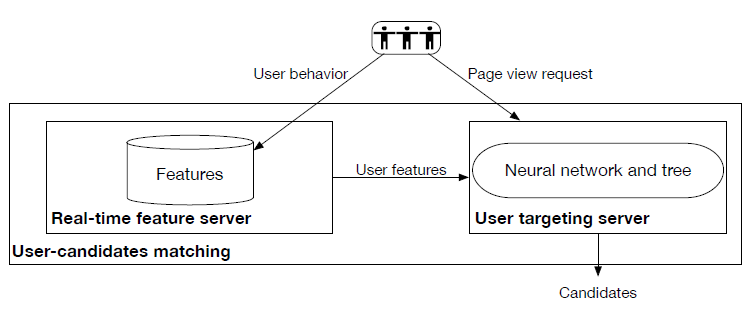

APP时,推荐请求发送到天猫个性化平台Tmall Personality Platform,该服务器集群集成了很多插件模块并提供天猫在线推荐服务。天猫个性化平台检索用户的近期行为,并将其发送到用户兴趣提取器

User Interest Extractor,后者是实现MIND的主要模块,用于将用户行为转换为多用户兴趣multiple user interest。随后,召回引擎

Recall Engine将搜索和用户兴趣的embedding向量最邻近的item。由不同兴趣触发的item将融合为候选item,并根据它们与用户兴趣的相似性进行排序。由于基于

MIND服务的有效性,通过用户兴趣提取器和召回引擎从数十亿个item库中选择数千个候选item的整个过程可以在不到15ms的时间内完成。Ranking Service对这些候选item中的top 1000个item进行打分(在item数量和延迟时间之间进行权衡),该服务通过一系列特征来预测CTR。最后天猫个性化平台完成推荐列表,并向用户展示推荐结果。

用户兴趣提取器和

Ranking Service都是在Model Training Platform上使用100个GPU进行训练,训练可以在8个小时内完成。得益于Model Training Platform的出色性能,深度模型天级更新。

这里我们对

MIND和两种现有方法之间的关系做一些说明,说明它们的相似之处和不同之处。YouTube DNN:MIND和YouTube DNN都利用深度神经网络对行为数据进行建模从而生成用户representation。这些representation用于工业推荐系统matching阶段的大规模item检索。但是,

YouTube DNN使用一个向量来代表用户,而MIND使用多个向量。当用户兴趣数量K=1时,MIND会退化为YouTube DNN,因此MIND可以视为YouTube DNN的推广。DIN:在捕获用户的多样化兴趣方面,MIND和DIN具有相同的目标。但是,这两种方法在实现目标的方式和适用性方面有所不同。- 为了处理多样化兴趣,

DIN在item-level应用了注意力机制;而MIND使用动态路由生成兴趣胶囊,并在interest-level考虑了多样性。(interest比item更高一个level)。 - 此外,

DIN重点聚焦于ranking阶段,因为它处理上千个item;而MIND作用于matching阶段,处理数十亿个item。

- 为了处理多样化兴趣,

未来方向:

- 第一个方向是融合有关用户行为序列的更多信息,如行为时间等。

- 第二个方向是优化动态路由的初始化方案,参考

K-means++初始化方案,从而实现更好的用户representation。

1.2 实验

1.2.1 离线评估

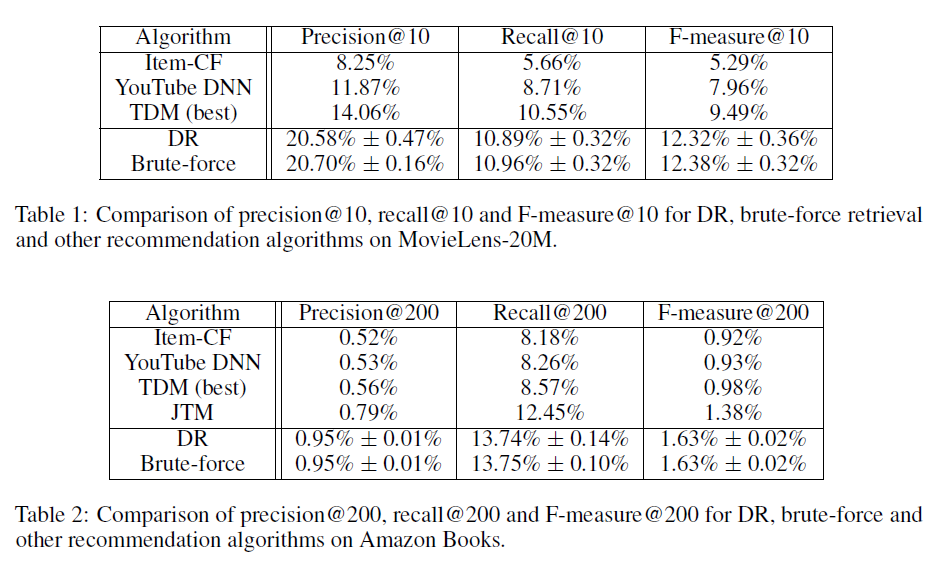

这里我们在多个数据集上离线评估了

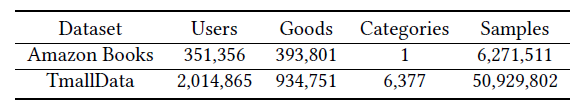

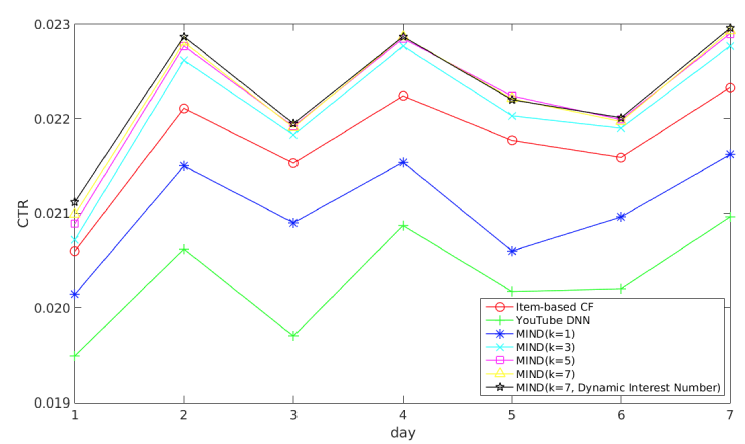

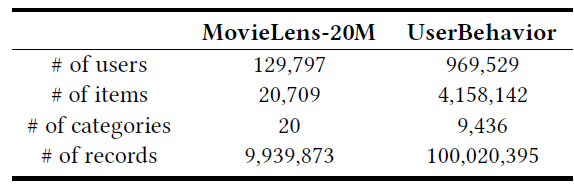

MIND和现有方法的推荐准确率。数据集:

Amazon Books数据集:它是电商推荐领域中使用最广的公共数据集之一。我们仅保留至少评论10次的item、以及至少评论10个item的用户。Tmall Data数据集:它是从Mobile Tmall App中随机采样的200万天猫用户,并获得这些用户在10天内的历史行为。我们保留至少600个用户点击的item。

这些数据集的统计信息如下表所示:

评估指标:我们选择

next item prediction问题(即预测用户的下一个交互)来评估方法的性能,因为这是推荐系统mathcing阶段的核心任务。我们将每个数据集的

user-item交互数据按照19:1的比例随机划分为训练集、测试集。然后对于每个用户,我们将用户交互的、测试集中的item作为目标item,该item之前所有交互的item作为用户历史行为。我们根据用户历史行为来预测目标item。我们采用命中率

hit rate作为衡量推荐效果的主要指标,定义为:其中:

- 表示由用户和

target item组成的测试集。 - 为示性函数, 。

target item occurs in top N表示目标item是否在预估多分类概率中的top N。由于模型采用softmax输出层,因此可以考虑目标item的输出概率在所有item输出概率中的位置。

我们在每个数据集上对

embedding向量维度 、用户兴趣数 进行超参数调优,并使用最佳超参数对每种方法进行测试以便进行公平的比较。- 表示由用户和

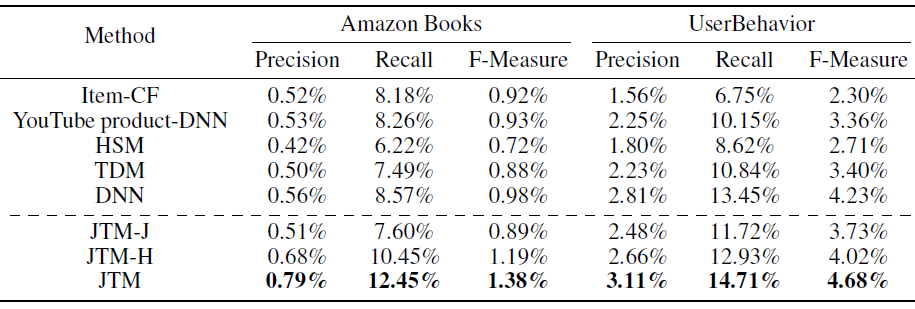

baseline方法:WALS:即加权最小二乘法Weighted Alternating Least Square。它是一种经典的矩阵分解算法,用于将user-item交互矩阵分解为用户的隐藏因子hidden factor和item的隐藏因子 。然后基于用户的隐藏因子和target item的隐藏因子之间的相似性进行推荐。YouTube DNN:它是用于工业推荐系统的最成功的深度学习方法之一。MaxMF:它引入了一种高度可扩展的方法来学习非线性潜在因子分解,从而对用户的多个兴趣进行建模。

实验结果如下表所示,我们给出了不同方法在两个数据集上

N=10,50,100的命中率结果。其中:黑体表示最佳性能;HP表示性能最佳的超参数,K表示兴趣数量,d表示embedding维度;括号中的百分比表示相对于YouTube DNN的相对提升。可以看到:

矩阵分解方法

WALS被其它方法击败,这表明深度学习方法对于改进推荐系统mathcing阶段的强大作用。但是,即使没有使用深度学习方法,

MaxMF的性能也要比WALS好得多。这可以用以下事实来解释:MaxMF将标准MF泛化为非线性模型,并对于每个用户采用了多个representation向量。可以观察到:采用用户的多个

representation向量的方法(MaxMF-K-interest、MIND-K-interest) 通常要比其它方法(WALS、YouTube DNN、MIND-1-interest)表现更好。因此,事实证明:使用用户的多个

representation向量是一种对用户的不同兴趣进行建模、并提高推荐准确性的有效方法。此外,我们可以观察到,由于天猫的用户倾向于表现出更多的兴趣,因此由于用户的多个

representation向量引入的改善对于TmallData更为显著。多样性的增加也可以通过每个数据集的最佳

K值来反映,其中TmallData的最佳K大于Amazon Books的最佳K值。

和

YouTube DNN相比,MIND-1-interest的提高表明:动态路由是一种比均值池化更好的池化策略。对比

MaxMF和MIND-K-interest的结果,这验证了通过动态路由从用户行为中提取多个兴趣优于在MaxMF中使用非线性建模策略。这可以归结于两点:- 多兴趣提取器层利用聚类过程生成兴趣的

representation,从而实现用户的更精确的representation。 - 标签感知注意力层使

target item在用户的多个representation向量上分配注意力,从而使得用户兴趣和target item之间的匹配更加准确。

- 多兴趣提取器层利用聚类过程生成兴趣的

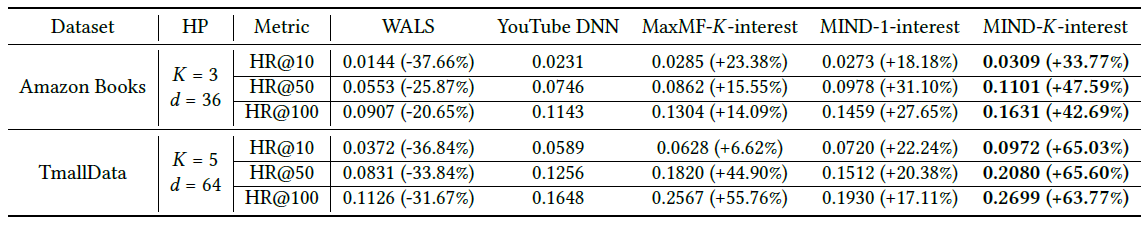

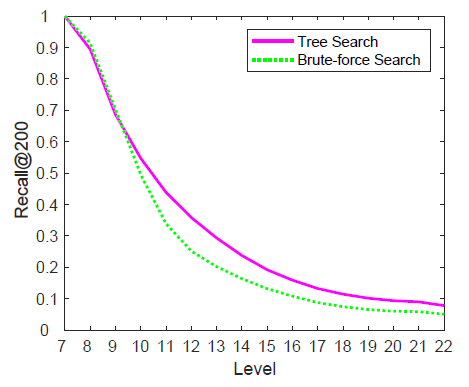

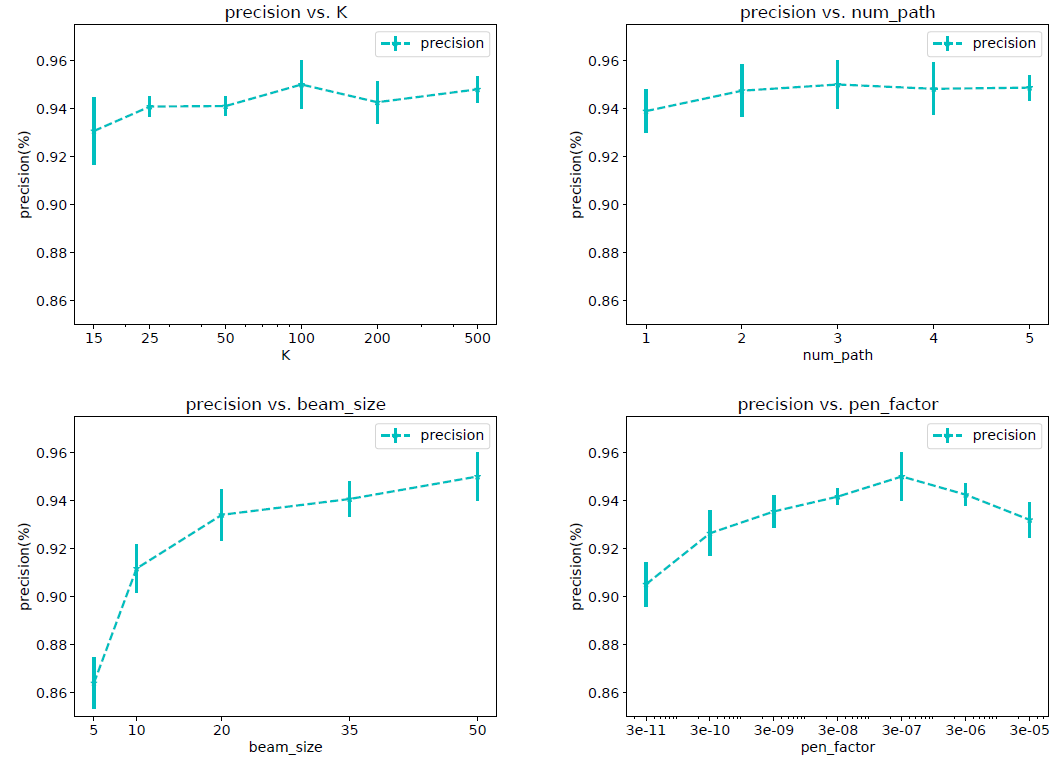

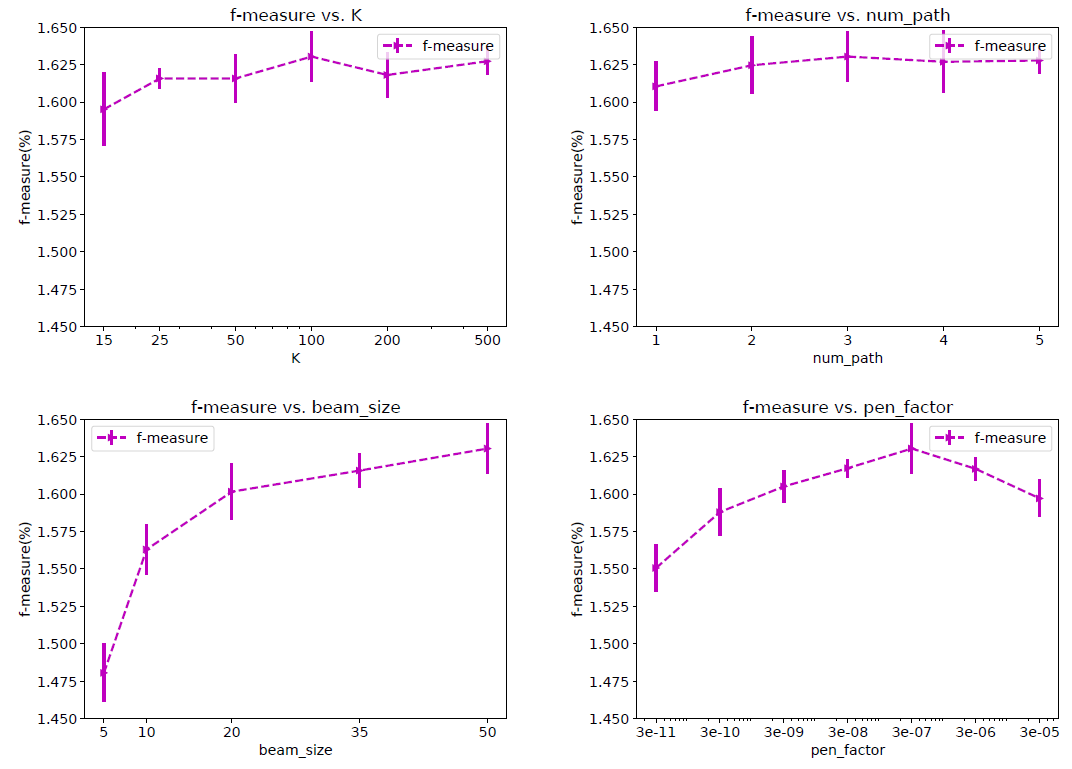

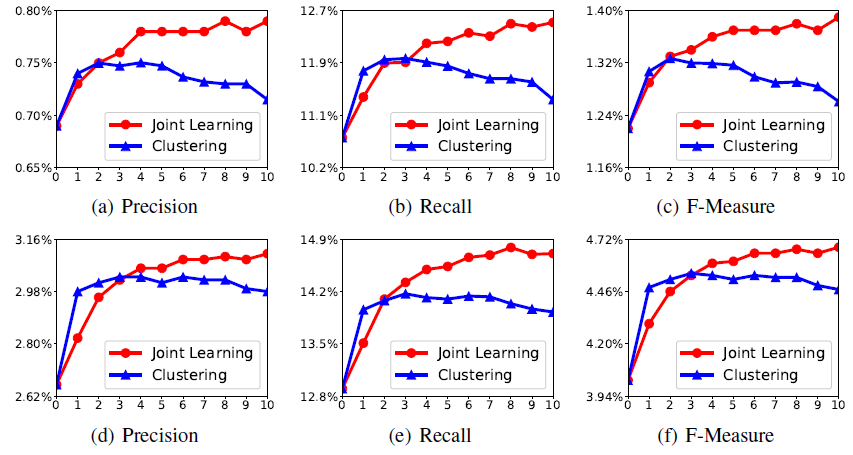

这里我们在

Amazon Books上进行两个实验,从而研究多兴趣提取器层和标签感知注意力层中超参数的影响。routing logit的初始化:多兴趣提取器层采用的routing logit的随机初始化和K-means质心的初始化相似,其中初始聚类中心的分布对于最终聚类结果的影响很大。由于routing logit是根据高斯分布 初始化的,因此我们担心 的不同取值可能导致不同的收敛性从而影响性能。为了研究 的影响,我们使用了三个不同的 (0.1, 1, 5)来初始化routing logit。实验结果如下图所示。可以看到:不同 的每条曲线几乎都重叠。该结果表明:

MIND对于 的取值具有鲁棒性。因此我们在实际应用中选择 是合理的。

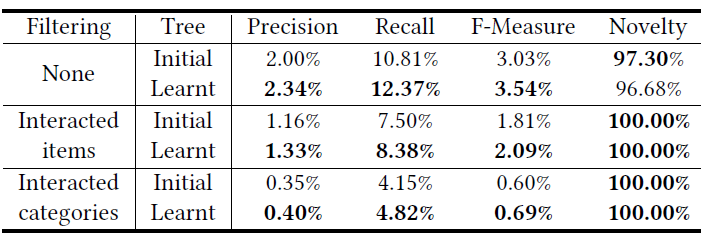

标签感知注意力层的幂次:如前所示,标签感知注意力中的幂次 控制每个兴趣在组合的标签感知兴趣表示

label-aware interest representation中所占的比例。为了研究 的影响,我们比较了 当 从 时MIND的性能变化。实验结果如下图所示。可以看到:

p=0时的性能相对而言要差很多。原因是当 时每个兴趣都具有相同的注意力,因此组合的兴趣表示combined interest representation等于没有参考label时的兴趣representation均值。- 当 时,注意力得分与兴趣

representation向量和目标item的embedding之间相似度成比例,这使得组合的兴趣representation为所有兴趣representation的加权和。 - 另外,随着 的增加性能会变得更好,因为和目标

item相似度更高的兴趣representation获得了更大的注意力。 - 最后,当 时变成了

hard attention scheme。此时和目标item最相似的兴趣representation将主导组合的兴趣representation,从而使得MIND收敛得更快并且表现最好。

1.2.2 在线评估

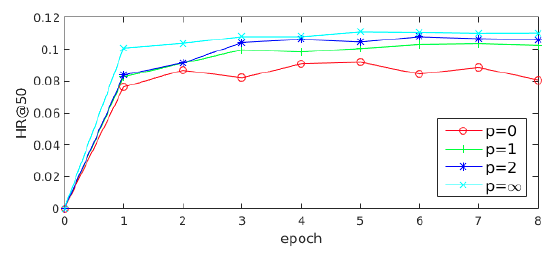

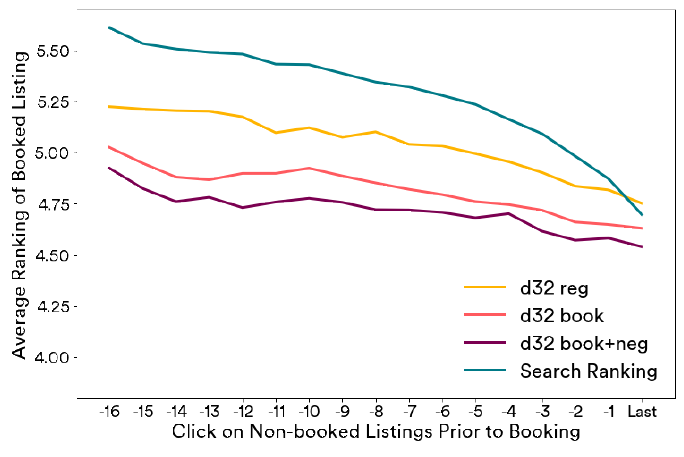

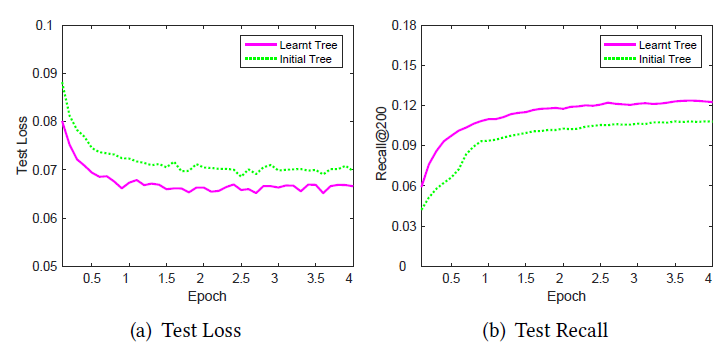

我们在线部署

MIND来处理天猫首页上的实际流量从而进行在线实验,为期一周。为了公平地进行比较,在matching阶段部署的所有方法后续都使用相同的ranking过程。我们评估指标是最终的CTR效果指标。baseline方法:item-based CF:它是服务于在线主流量的基本matching方法。YouTube DNN:它是著名的基于深度学习的matching方法。

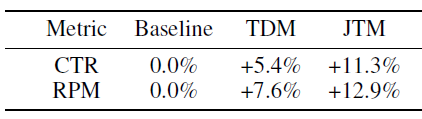

我们将所有对比方法部署在

A/B test框架中,每种方法检索一千个候选item,然后将候选item送入ranking阶段以进行最终推荐。实验结果如下图所示,我们得出以下结论:

MIND优于item-based CF和YouTube DNN,这表明MIND产生了更好的用户representation。通过长期的实践优化,

item-based CF的效果要比YouTube DNN更好,而MIND-1-interest也超越了YouTube DNN。一个非常明显的趋势是:随着兴趣数量从

1增加到5,MIND的性能会变好。当兴趣数量达到5时,MIND性能达到峰值,随后继续增加K值则CTR保持不变。例如,K=7相对于K=5带来的提升几乎可以忽略。因此对于天猫用户来讲,最佳的用户兴趣数量是

5~7,这表明了用户兴趣的平均多样化程度。具有动态兴趣数的

MIND与K=7的MIND性能相当。因此动态兴趣数机制不会带来CTR收益,但是在实验过程中我们发现该方案可以降低serving的成本,这有利于大规模的service(如天猫),并且在实践中更易于采用。

总而言之,在线实验证明了

MIND可以实现更好的解决方案,从而为具有不同兴趣的用户建模,并且可以显著提高整个推荐系统的效果。

1.2.3 Case Study

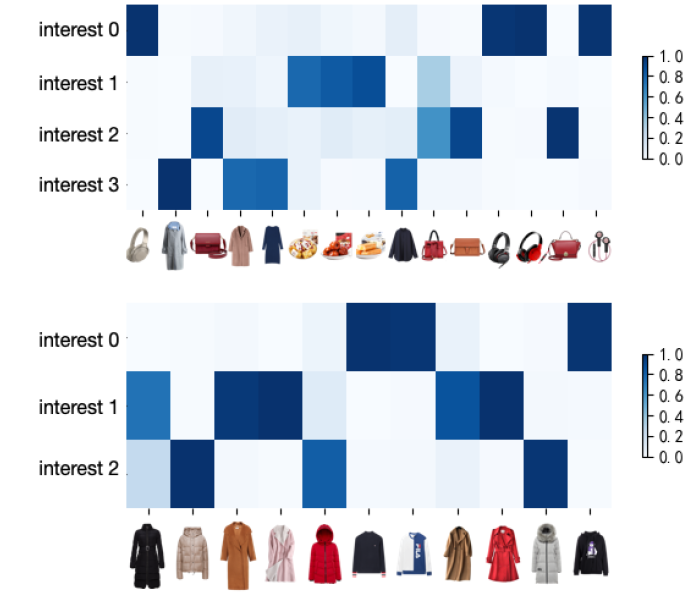

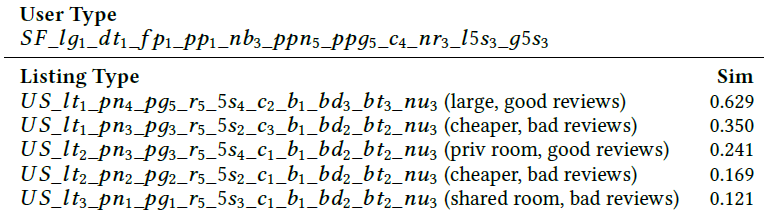

耦合系数

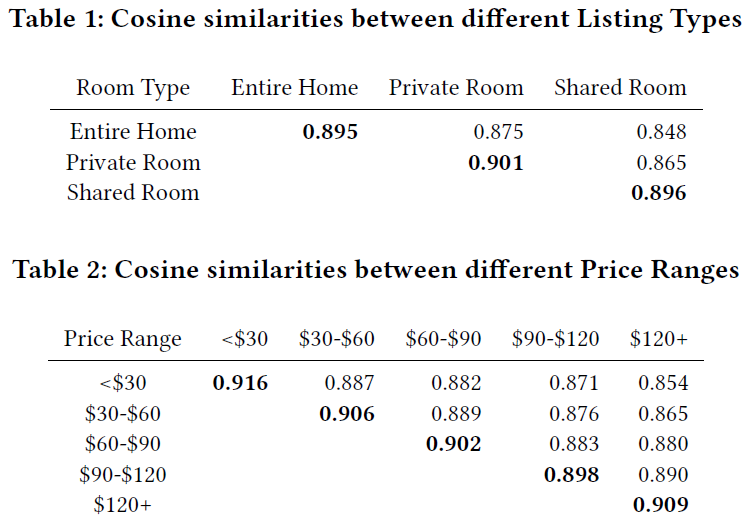

coupling coefficient:行为胶囊和兴趣胶囊之间的耦合系数可以衡量行为对于兴趣的隶属程度。这里我们将这些耦合系数可视化,从而表明兴趣提取过程是可解释的。下图给出了从天猫每日活跃用户中随机选择的两个用户相关的耦合系数,每一行对应一个兴趣胶囊、每一列对应一个行为。每一类行为在相应的兴趣上具有最大的耦合系数。注意:这两个用户具有不同粒度的兴趣。

可以看到:

- 用户

C(上部)已经和4类商品(耳机、小吃、手提包、衣服)进行了交互,每类商品在一个兴趣胶囊上具有最大的耦合系数,并形成了相应的兴趣。 - 用户

D(下部)仅对衣服感兴趣,但是可以从行为中解析到3个细粒度的兴趣(毛衣、大衣、羽绒服)。

从这些结果中我们可以看到:用户行为的每个类别被聚类在一起,并形成了相应的兴趣

representation向量。

- 用户

item分布:在serving阶段,和用户兴趣相似的item将通过最近邻搜索来被检索到。我们根据兴趣检索的item和对应兴趣的相似度,从而可视化相似度的分布。下图给出了用户

C检索的item的结果。其中:上面的四个轴显示了基于MIND的四个兴趣召回的item;最下面的轴显示了基于YouTube DNN召回的item。item根据它们和兴趣的相似性在轴的相应位置上。我们已经通过min-max归一化将相似性缩放到0.0 ~1.0之间,并四舍五入到最近的0.05。图中每个点都是由该区域内

item组成,因此每个点的大小表示具有相应相似度的item数。 我们还给出了从所有候选item中随机选择的一些item。不出所料:

MIND召回的item和相应的兴趣密切相关;而YouTube DNN召回的item类别相差很大,并且与用户行为的相似性较低。

二、DNN For YouTube[2016]

YouTube是全球最大的创建creating、分享sharing和发现discovering视频内容平台。YouTube的推荐可以帮助超过十亿用户从不断增长的视频库video corpus中发现个性化内容,是现有规模最大、最复杂的工业推荐系统之一。推荐

YouTube视频在三个方面具有极大挑战:规模

scale:实践证明,现有的很多推荐算法在小规模问题上都能很好地发挥作用,但是在YouTube规模的问题上无法应用。高度专业化的分布式学习算法

highly specialized distributed learning algorithms和高效的服务系统efficient serving system对于处理YouTube庞大的用户基数和视频库至关重要。新鲜性

freshness:YouTube视频库非常活跃dynamic,每秒钟都会上传大量的视频。推荐系统应该具有足够的响应能力responsive,从而建模新上传的内容、以及建模用户的最新行为action。新内容和学习成熟的

well-established视频之间的平衡从某种角度可以视为探索和利用exploration/exploitation。噪音

noise:由于稀疏性sparsity和各种不可观察的外部因素,YouTube上的用户历史行为固有地inherently难以预测。我们几乎无法获取用户满意度的

ground truth,事实上我们是对带噪音的隐式反馈信号noisy implicit feedback signal进行建模。此外,内容关联的元数据metadata结构化较差,没有定义良好的本体ontology。因此,我们的算法需要对训练数据的这些特点具有鲁棒性

robust。

与谷歌的其它产品领域

product areas相结合,YouTube经历了根本性的范式paradigm转变,转向使用深度学习作为几乎所有学习问题的通用解决方案。YouTube的推荐系统建立在Google Bran(其开源版本即著名的TensorFlow)上。YouTube推荐的深度学习模型大约包含10亿级参数,并且使用千亿级的训练样本。与被大量研究的矩阵分解方法相比,使用深度神经网络进行推荐系统的工作相对较少。

- 神经网络在

《Personalized news recommendation using classi ed keywords to capture user preference》中用于推荐新闻、在《A neural probabilistic model for context based citation recommendation》中用于推荐ciatations、在《User modeling with neural network for review rating prediction》中用于推荐评论的评分。 - 协同过滤在

《Collaborative deep learning for recommender systems》中被表述为深度神经网络,在《Autoencoders meet collaborative fi ltering》中被表述为自编码器。 《A multi-view deep learning approach for cross domain user modeling in recommendation systems》使用深度学习进行跨域的用户建模。- 在

content-based推荐中,《Deep content-based music recommendation》使用深度神经网络进行音乐推荐。

在论文

《Deep Neural Networks for YouTube Recommendations》中,作者从从较高的视角high level描述了该系统,并聚焦于深度学习带来的显著性能提升。论文根据经典的两阶段信息检索二分法retrieval dichotomy分为两部分:首先论文详细介绍了一个深度候选生成Candidate Generation模型(即召回模型),然后论文详细介绍了一个独立的深度排序Ranking模型。论文还提供了有关设计、迭代、维护一个庞大推荐系统的实践经验教训和洞察。

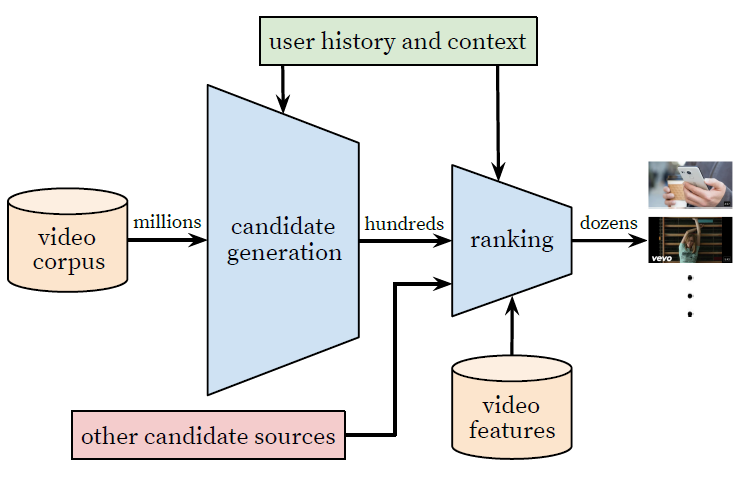

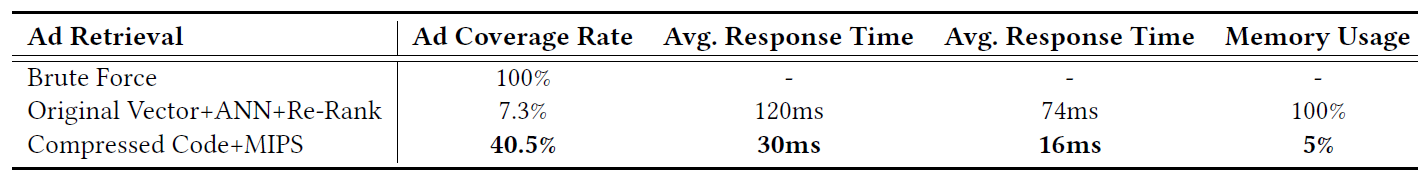

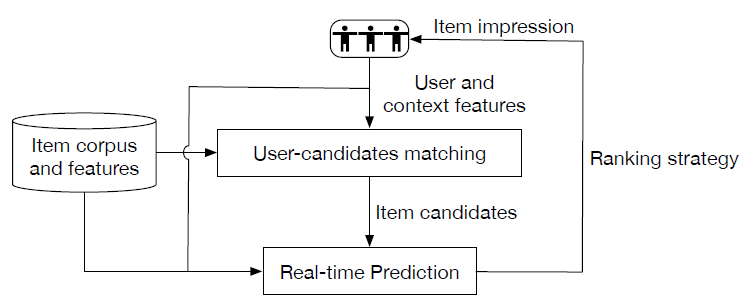

2.1 Overview

我们的推荐系统由两个神经网络组成:一个用于候选生成

candidate generation、一个用于排序ranking。总体架构如下图所示。候选生成网络:从用户的

YouTube历史行为记录中获取事件event作为输入,并从大型视频库中检索一小部分(数百个)视频。这些候选视频倾向于和用户高度相关。候选生成网络仅通过协同过滤提供广泛

broad的个性化。用户之间的相似性是通过粗粒度coarse-level的特征来表示的,如观看视频video watch的ID、搜索query的token、人口统计学特征demographic。排序网络:根据一个细粒度

fine-level的representation来区分召回的候选视频之间的相对重要性,从而提供一些 “最佳” 推荐最终构成推荐列表。排序网络通过使用描述视频和用户的一组丰富的特征,并根据期望的目标函数

desired objective function,从而为每个视频分配一个score来完成该任务。候选视频根据它们的score进行排序,得分最高的候选视频被呈现给用户。

这种两阶段方法允许我们从非常大的视频库(数百万)中进行推荐,同时仍然可以确保呈现给用户的少量视频对于用户来说是个性化的

personalized和吸引人的engaging。此外,这种设计能够融合其它来源生成的候选(

other candidate sources,即其它召回通路)。

在开发过程中,我们广泛使用离线指标(精度

precision、召回率recall、ranking loss等)来指导系统的迭代改进。然后,为了最终确定算法或模型的有效性,我们依靠在线实验live experiment进行A/B test。在在线实验中,我们可以衡量

click-through rate: CTR、观看时长watch time、以及其它衡量用户互动user engagement指标的细微变化。这一点很重要,因为在线A/B test结果并不总是和离线实验正相关。

2.2 Candidate Generation

在候选生成

candidate generation过程中,我们从庞大的YouTube视频库中筛选可能与用户有关的数百个视频。这里描述的推荐器

recommender的前身predecessor是在rank loss下训练的矩阵分解matrix factorization方法。我们神经网络模型的早期迭代通过浅层网络模仿了这种分解行为,该浅层网络仅嵌入了用户历史观看的视频。从这个角度来看,我们的方法可以视为矩阵分解技术的非线性推广。作为分类任务的推荐

Recommendation as Classification:我们提出将推荐视作极端的多分类任务,其中预测问题变为:基于用户 和上下文 在时刻 从视频库 的数百万个视频(类别)中准确地分类特定的视频观看video watch为类别 (即视频库 中的第 个视频)的概率。 即:其中: 为

(user,context) pair对的embedding向量; 为每个候选视频的embedding向量; 为embedding维度。在这种

setting下,embedding只是将稀疏实体(单个视频、用户等)映射到 中的稠密向量。深度神经网络的任务是学习用户embedding作为用户历史行为和上下文的函数,这对于使用softmax分类器在视频之间进行区分discriminating是很有用的。尽管

YouTube存在明确的反馈机制(加赞thumbs up、减赞thumbs down、产品内调查等),但是我们使用视频观看video watch的隐式反馈implicit feedback来训练模型,其中用户完成视频观看就是一个正样本。这种选择是基于大规模可用的隐式用户行为历史记录,从而允许我们可以在显式反馈explicit feedback极其稀疏的长尾提供推荐。为了有效地训练具有数百万个类别的模型,我们依靠负采样技术从背景分布

background distribution中采样负样本(候选采样candidate sampling),然后通过重要性加权对这些负样本进行校正。对于每个正样本,我们最小化true label和采样的负类之间的交叉熵。- 在实践中,我们对每个正样本随机采样几千个负样本,这相当于传统

softmax的100多倍的加速。 - 一种流行的替代方法是分层

softmax(hierarchical softmax),但是它无法达到相当的准确性。在分层softmax中涉及把原本可能不相关的样本归结到同一个中间节点,这使得分类问题更加困难并降低了性能。

在

serving阶段,我们需要计算最有可能的N个类别(视频),以便选择要呈现给用户的top-N个类别。在数十毫秒的严格serving延迟时间下对数百万个item进行打分,需要一种近似的、与类别数量亚线性的评分方案。YouTube以前的系统依赖于哈希,而这里的分类器使用类似的方法。由于在serving时不需要来自softmax输出层的、经过校准的likelihood,因此评分问题简化为内积空间中的最近邻检索nearest neighbor search问题,而这可以通过通用的library来解决。我们发现A/B test结果对于最近邻检索算法的选择不是特别敏感。- 在实践中,我们对每个正样本随机采样几千个负样本,这相当于传统

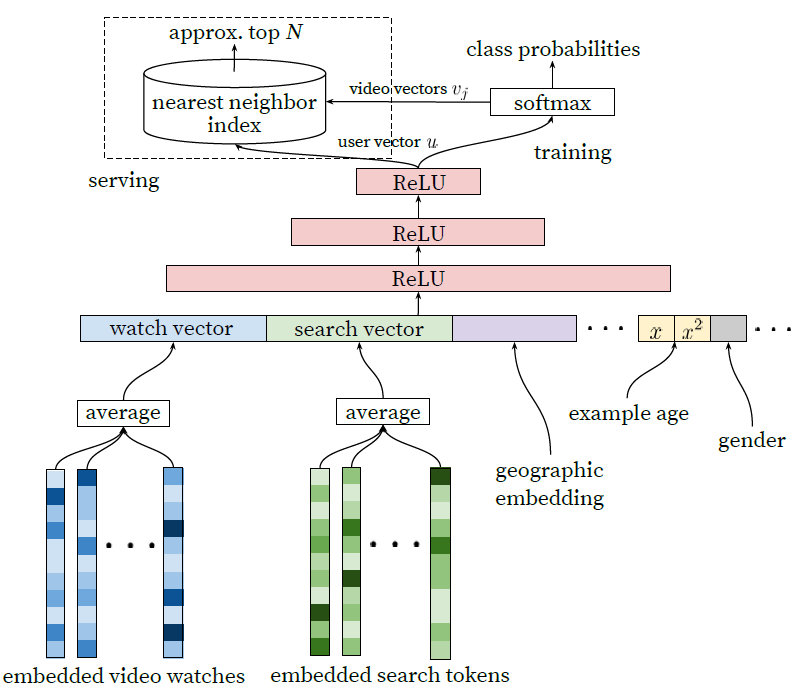

模型架构:受连续的

bag-of-word语言模型的启发,我们在固定的词典vocabulary中学习每个视频的embedding,并将这些embedding馈入前馈神经网络。用户的观看历史由可变长度的视频

ID序列来表示,该序列通过embedding映射为稠密的向量representation。由于前馈神经网络需要固定尺寸的稠密输入,因此我们对embedding序列进行均值池化从而聚合为固定尺寸的向量。在所有聚合策略中(sum池化、最大池化、均值池化),均值池化效果最好。重要的是,

embedding与所有其它模型参数是通过常规的梯度下降来联合学习的。下图给出了

candidate generation网络的架构:特征被拼接称宽wide的第一层,接着是几层带ReLU激活函数的全连接层FC layer。其中:- 嵌入的稀疏特征和稠密特征进行拼接。 特征拼接之前先对

embedding序列进行均值池化,从而将可变大小的稀疏ID序列转换为适合输入到隐层hidden layer的固定尺寸的向量。 - 所有隐层都使用全连接。

- 训练过程中,通过对

softmax输出进行负采样来进行梯度下降,从而最小化交叉熵损失。 serving过程中,执行近似的最近邻检索从而生成数百个候选视频。

- 嵌入的稀疏特征和稠密特征进行拼接。 特征拼接之前先对

特征体系:深度神经网络作为矩阵分解的推广的一个关键优势是,可以轻松地将任意连续特征和离散特征添加到模型中。

搜索历史记录

search history和观看历史记录watch history的处理方式相似:每个query被tokenize为unigram和bigram,并且每个token都被嵌入。然后我们将所有的token的embedding均值池化。池化后的稠密向量就代表了用户的搜索历史记录。人口统计特征

demographic feature对于提供先验知识prior很重要,这样对新用户的推荐就能合理地进行。用户的地理区域

geographic region和设备分别被嵌入,然后进行拼接。简单的二元特征和连续特征(如用户性别、登录状态、用户年龄)将被直接输入到网络,其中实数值将被标准化为

[0.0, 1.0]之间。example age特征:每秒都有大量的视频上传到YouTube。因此对于YouTube产品而言,推荐最新上传(fresh) 的内容非常重要。我们始终观察到:在不牺牲相关性的前提下,用户更喜欢新鲜的内容

fresh content。除了简单地推荐用户想看的新视频这个一阶效应first-order effect之外,还有一个关键的次级现象:自举和传播病毒内容bootstrapping and propagating viral content。机器学习系统经常表现出对过去

past的隐性bias,因为它们被训练为通过历史样本来预测未来的行为。视频热度popularity的分布非常不稳定,但是我们推荐器recommender产生的视频库上的多项式分布将反映几周训练窗口中的平均观看可能性likelihood。即:我们模型学到的是过去一段时间平均的热度,而不是当前时刻的热度。而平均热度和当前热度差异很大。

为解决这个问题,我们在训练过程中以训练样本的

age作为特征,它是训练时刻减去创建日志的时刻。在serving阶段,这个特征被设为零(或者略微为负),从而表示采用最近的热度。一种朴素的方法是,将训练样本根据发生时刻进行加权:距离训练时刻越近则权重越大、距离训练时刻越久则权重越小。这种方式使得近期发生的模式更重要。这种方式的缺点是:难以确定合适的时间衰减加权方式。而

YouTube DNN中的方法是:将样本age作为特征,由模型自动根据该特征来学习模式随时间变化的规律。下图给出了这种方法在任意挑选的一个视频上的效果。可以看到:

- 添加了样本

age特征之后,模型能够准确地表示数据中观察到的上传时间和依赖于时间的热度。 - 如果没有该特征,则模型将预估为:近似于训练窗口内的平均观看可能性

likelihood。

- 添加了样本

需要强调的是,推荐通常涉及解决一个代理问题

surrogate problem,然后将结果迁移到特定的上下文context。一个经典的例子是,我们假设准确地预估收视率会带来有效的电影推荐。我们已经发现,这个代理学习问题的选择对A/B test的性能有着极其重要的影响,但是很难用离线实现来衡量。例如,离线优化的是点击率,但是在线需要优化的是

GMV,二者之间存在一定的gap。训练样本是从所有

YouTube观看记录(甚至是从其它网站内嵌的观看记录)生成的,而不仅仅是我们产生的推荐结果的观看记录。否则,新内容将很难出现,推荐器将过度倾向于利用exploitation。如果用户通过我们推荐以外的方式发现视频,我们希望能够通过协同过滤将这一发现快速传播给其他人。提升实时

metric的另一个关键洞察是:为每个用户生成固定数量的训练样本,这等效于在损失函数中认为所有用户同等重要。这防止了一小批高度活跃的用户来统治了损失函数。这里值得商榷:a. 是否活跃的用户更重要?这个问题不同的场景有不同的答案。 b. 每个用户生成固定数量的训练样本,必然会丢弃活跃用户的大量样本,这降低了训练数据量,降低模型效果。

虽然有点违背直觉,但是针对分类器的保留信息

withhold information(如hold out验证集或测试集)必须非常小心,从而防止模型利用网站的结构structure从而对代理问题过拟合。考虑这样的一个例子,用户刚刚提交了对

taylor swift的搜索query。由于我们的问题是预测下一个观看的视频,给定该搜索信息的分类器将预测最可能观看的视频是那些出现在taylor swift搜索结果页面上的视频。毫不意外的是,将用户上一次搜索页重新作为主页推荐列表,效果很差。通过丢弃序列信息,并用无序的

bag of token来表示搜索query,分类器将不再直接感知label的来源。视频的自然消费模式通常会导致非常不对称的

co-watch概率。例如:- 情景剧系列

episodic series通常是按顺序观看的。用户先看第一集、再看第二集的概率,远大于先看第二集、再看第一集。 - 用户通常会发现最流行流派

genre的艺术家,然后再关注较小的领域,而不是相反。

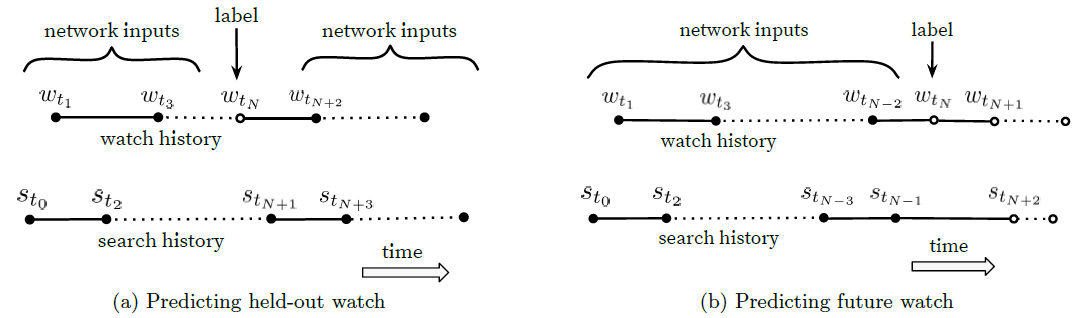

因此,我们发现预测用户的下一个观看

next watch要比预测一个随机hold-out(即,留一法)观看hold-out watch表现好得多。而很多协同过滤系统通过hold out一个随机item,然后从用户剩余的历史行为的其它item来预测这个item,从而隐式地选择label和上下文,如下图(a)所示。这会泄露未来的信息,并且会忽略任何非对称的消费模式asymmetric consumption pattern。相比值下,我们通过随机选择一个观看

watch,并且仅选择用户在这个hold out label之前的用户行为作为输入,从而rollback用户的历史行为记录。如下图(b)所示。如下图所示,选择模型的

label和input context对于离线评估具有挑战性,并且对于在线性能有很大影响。这里,实心事件event是网络的输入特征,而空心事件 不是网络的输入特征。我们发现:预测未来的观看(b) 在A/B test中表现更好。b中的example age表示为 ,其中 为训练数据中观察到的最大时刻。

- 情景剧系列

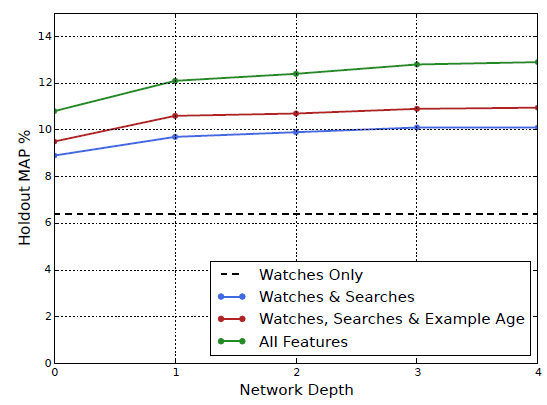

实验结果:添加更多特征、加深模型深度显著提升了

hold out预估的精度precision,如下图所示。所谓

hold out预估指的是:label为hold out数据,特征为label之前的历史数据(如上图的b图所示)。实验中,包含

100万视频和100万搜索token的词典vocabulary被嵌入为256维的embedding向量。每个用户样本最多50个最近的观看,以及最多50个最近的搜索。softmax层输出在相同的100万个视频类别上的多项式分布,output向量的维度为256维(这可以被认为是一个独立的output video embedding)。这些模型在所有

YouTube用户上训练若干个epoch,直到收敛。网络结构遵循常见的

tower模式,其中网络的底部最宽、然后每个连续的隐层将神经元数量减半。我们进行了四组实验,深度不断增加,直到增加的收益减少并且收敛变得困难。depth 0:一个线性层,它仅仅转换这个concatenation layer来匹配softmax的维度256维。零深度的网络实际上是一种线性分解方案,它和先前

predecessor的系统非常相似。depth 1:256 ReLU。depth 2:512 ReLU --> 256 ReLU。depth 3:1024 ReLU --> 512 ReLU --> 256 ReLU。depth 4:2048 ReLU --> 1024 ReLU --> 512 ReLU --> 256 ReLU。

可以看到:特征越多,

holdout预估的Mean Average Precision: MAP越高;层的深度越深,MAP越高。因为更深的模型提升了表达能力,使得模型能够有效建模特征之间的交互。precision-k为top-k列表的推荐精准度,MAP@k为所有用户AP@k的平均。由于这里是留一法评估,因此k=1。

2.3 Ranking

Ranking的主要作用是使用曝光数据impression data来专门化specialize和校准calibrate特定用户界面particular user interface的候选预测。例如,用户通常可能以高概率观看给定的视频,但是由于缩略图thumbnail image的选择 ,因此不太可能点击给定的首页曝光homepage impression。在

ranking期间,我们可以访问更多的特征来描述视频、以及用户和视频之间的关系。因为只有数百个视频被评分,而不是对数百万个视频进行评分(在candidate generation中才需要对数百万个视频进行评分)。此外,

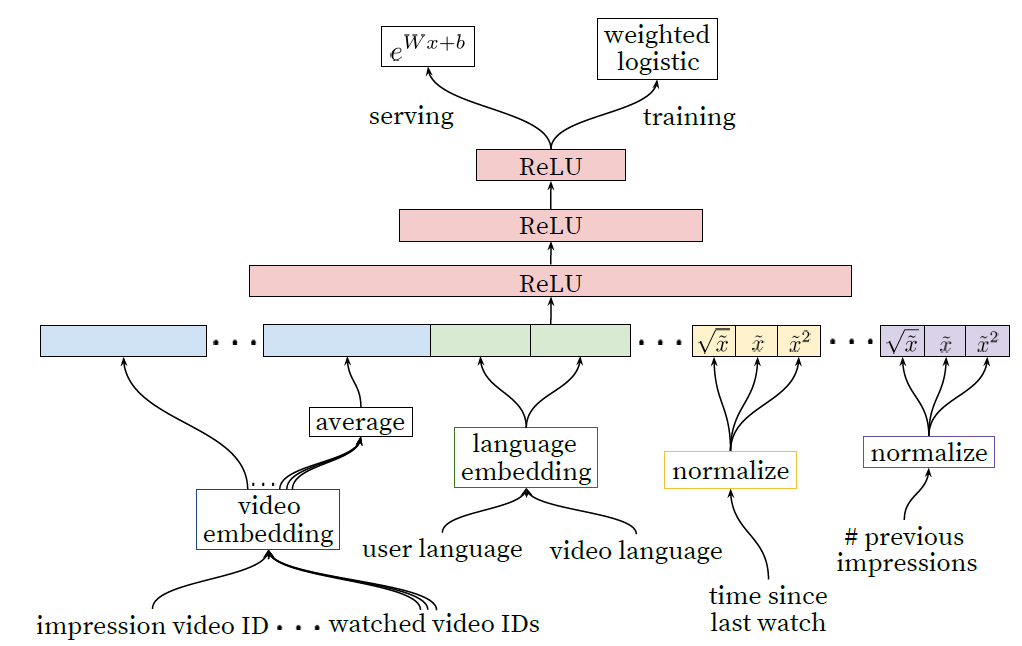

ranking对于集成ensembling来自不同候选源(每个候选源代表了一路召回通路)也至关重要,这些候选源之间的score不能直接比较(跨召回通路之间的召回score不是直接可比较的,但是召回通路内部的score是可以直接比较的)。我们使用和

candidate generation模型类似的深层神经网络,使用逻辑回归为每个视频曝光分配一个独立的score,如下图所示。然后视频列表根据这个分数排序并返回top-n视频给到用户。我们最终的

ranking目标是根据在线A/B test结果不断调整的, 但是通常是每个曝光的期望观看时长的简单函数。按点击率排名通常会鼓励用户观看一些未完成的欺骗性deceptive视频(点击诱饵clickbait),而观看时长可以更好地捕获用户的互动engagement。下图为

Ranking的深度网络体系架构,它描述了具有共享embedding的离散特征(单值univalent和多值multivalent),以及幂次power的归一化连续特征。所有的layer都是全连接的。实际上,数以百计的特征被馈入到网络中。

我们的特征与传统的离散特征、连续/常规特征这种分类体系不同。我们使用的离散特征的基数

cardinality差异很大:有些离散特征是二元的(如用户是否已登录),而另一些离散特征则具有数百万个可能的值(如用户上一次的搜索query)。我们将特征根据是仅贡献单个值(单值

univalent特征)、还是贡献一组值(多值multivalent特征)来进一步细分。单值离散特征的典型例子是被评分的曝光

impression的video ID。而相应的一个多值特征是用户最近观看的N个视频的video ID列表。我们还根据特征是描述

item(曝光impression)的属性,还是描述用户/上下文(query)的属性,来对特征进行分类。query特征针对每次请求request执行计算(即请求粒度),而曝光impression特征对每个被评分的item进行计算(即item粒度)。

特征工程:我们通常在

ranking模型中使用数百个特征,其中离散特征和连续特征大体上各占一半。尽管深度学习有望缓解手工特征工程的负担,但是原始数据的特性

nature不容易直接输入到前馈神经网络。我们仍然花费大量的工程资源将用户和视频数据转换为有用的特征。主要挑战在于如何表达用户行为的时间序列a temporal sequence of user action,以及这些行为如何与被评分的视频曝光video impression相关联。我们观察到,最重要的信号是那些描述用户之前与

item本身、以及其它类似item之间的交互interaction。这借鉴了其它工作在广告ranking上的经验。例如,考虑用户和需要评分的视频的频道

channel的历史记录:用户在这个频道观看了多少视频?用户最近一次看这个频道的视频是什么时候?这些描述用户过去在相关

item上的行为的连续特征是特别强大的,因为它们可以很好地在不同的item之间进行泛化。我们还发现:以特征的形式将

candidate generation中的信息传播到ranking过程中,这至关重要。例如,这个候选视频从哪个通路召回?这个候选视频的召回分是多少?

描述过去视频曝光

impression频率的特征对于在推荐中引入 “变动”churn也是至关重要的(连续的请求不会返回相同的推荐列表)。如果一个用户最近被推荐了一个视频,但是没有看,那么模型自然会在下一次页面加载

page load时剔除这个曝光impression。即剔除已经曝光过的

item(新鲜度过滤)。serving最新的曝光impression和观看历史是一个工程问题,这超出了本文的范围,但是对于产生响应性responsive推荐至关重要。

离散特征

embedding:和candidate generation模型类似,我们使用emebdding将稀疏离散特征映射到适用于神经网络的稠密representation。每个

unique的ID空间(vocabulary)都有一个独立的、待学习的embedding,其维度大约是和unique值数量的对数成正比。这些词典是简单的look-up table,通过在训练之前将数据传输一次来建立。非常大

cardinality的ID空间(如视频ID、搜索query的term)根据点击频次对top N进行截断。out-of-vocabulary取值简单地映射到全零的embedding。截断的原因是低频

ID出现次数太少,导致embedding学不好。实际上有更好的做法:进行hash映射。一方面hash映射不会对结果产生太大影响,另一方面它能自适应低频ID出现增量更新的情况。和

candidate generation一样,在多值离散特征embedding馈入网络之前,先对它们均值池化。重要的是,相同

ID空间中的离散特征共享底层的embedding。例如,我们有一个全局的视频

ID的embedding,所有用到视频ID的特征都将使用它(如曝光impression的视频ID、用户最近观看视频的视频ID等等)。尽管是共享的

embedding,但是每个特征都被独立地馈入到网络中,因此后续的layer可以学到每个特征的专门的representation。embedding共享对于提高泛化能力、加快训练速度、降低内存需求非常重要。

绝大多数模型参数都位于这些高基数

high-cardinality的embedding空间中。例如,一百万个ID映射到32维空间中,这比2048个神经元的全连接层的参数多7倍。归一化连续特征:众所周知,神经网络对于输入的缩放

scaling和分布distribution非常敏感,而诸如决策树集成ensemble模型之类的替代方法则对于特征的scaling是不变的。我们发现连续特征的适当归一化对于模型收敛至关重要。假设连续特征 的分布为 ,我们使用累积分布

cumulative distribution,通过缩放取值从而将该特征转换为 ,其中 在[0~1]之间均匀分布。在训练开始之前,通过对数据进行单次遍历来对特征取值的分位数进行线性插值,可以近似得到该积分。这种归一化实际上是

ranking归一化:即某个特征X的取值 在所有样本中X的所有取值的排名。实际上还有更简单的做法:在input层之后紧跟着一个BatchNormalization层。除了原始归一化特征 之外,我们还输入了幂次特征 ,使得网络能够轻松地构成特征的超线性函数、亚线性函数,从而赋予网络更强的表达能力。实验发现,向模型馈入幂次特征可以提高离线准确率。

建模期望观看时长

Expected Watch Time:我们的优化目标是在给定的训练样本(要么是点击样本、要么是未被点击)的情况下,预估期望观看时长expected watch time。其中,正样本带有用户观看视频所花费的时长。为了预估期望观看时长,我们使用了专门为该目标而开发的加权逻辑回归

weighted logistic regression。该模型以交叉熵损失为目标函数来训练逻辑回归,但是正样本(点击样本)会根据视频上的观看时长来加权,而所有的负样本(未点击样本)都采用单位权重。假设样本 的点击率为 ,则逻辑回归学到的几率为:

由于这里对正样本进行加权,则加权逻辑回归学到的几率为:

其中 为正样本的观看时长。考虑到 通常是一个很小的值,使得 ,因此有:

注:样本加权的方式有两种:

- 采样加权:对一条样本重复 次,其中 为加权的权重。

- 梯度加权:对样本的梯度乘以 。

从效率上看,第二种方式的计算量更小、计算效率更高。

从效果上看,如果没有随机混洗则二者效果相同(都是基于当前梯度之上的 个梯度的累加),否则二者效果不同(第一种方式中,每个样本的当前梯度都不同)。

在推断期间,我们有:

因此推断期我们使用指数函数 作为最终的激活函数,从而产生接近于预估的期望观看时长的几率。然后我们根据预估期望观看时长来进行排序。

注:由于 为单调递增函数,因此根据 排序等价于根据 排序。

表面上看,推断时没有进行样本加权,但是观看时长更长的视频预估的 更大。

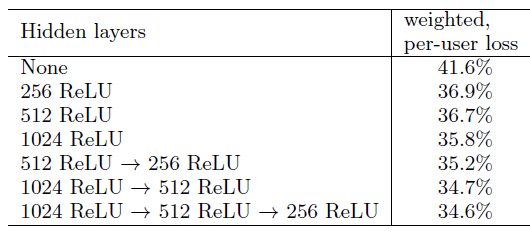

实验结果:下表展示了我们在具有不同隐层配置下的、

next-day holdout数据上的实验结果。每个配置的取值(weighted, per-user loss)通过考虑为单个用户在单个页面上同时考虑正样本(点击的)、负样本(未点击的)的曝光impression来获取的。首先通过我们的模型来为这两种曝光

impression打分。如果负样本得分高于正样本,则我们认为正样本的观看时长是错误预测的观看时长。weighted per-user loss是在heldout数据上,所有错误预测的观看时长占总观看时长上的比例。可以看到:

增加隐层的宽度和深度都可以改善结果,但是代价就是推断期间所需的服务器

CPU时间。1024ReLU-512ReLU-256ReLU的配置获得了最佳的效果,同时使得我们能够保持在serving的CPU预算之内。- 对于

1024ReLU-512ReLU-256ReLU模型,我们尝试仅提供归一化的连续特征,而没有幂次特征,这会使得loss增加0.2%。 - 对于

1024ReLU-512ReLU-256ReLU模型,我们也尝试将正样本和负样本都是相等权重(相当于无加权)。毫无意外地,这使得观看时长的weighted loss显著增加了4.1%。

- 对于

2.4 总结

我们描述了推荐

YouTube视频的深度神经网络架构,分为两个不同的问题:candidate generation、ranking。candidate generation:我们的深度协同过滤deep collaborative filtering模型能够有效地吸收很多信号,并用深度网络对它们的交互进行建模,这优于以前在YouTube上使用的矩阵分解方法。- 在选择推荐的代理问题

surrogate problem方面,艺术多于科学。我们发现通过捕获不对称的co-watch行为和防止未来信息泄露,对未来观看future watch进行分类可以在在线指标上表现良好。 - 分类器中的

withholding discrimative signal(即label)对于获得好的结果也至关重要--否则模型会过拟合代理问题,并且不能很好地迁移到主页上。 - 我们证明了使用训练样本的

age作为输入特征消除了对过去past的固有偏见,并允许模型表示流行视频的时间依赖行为。这提高了离线holdout precision结果,并在A/B test中显著增加了最近上传的视频的观看时长。

- 在选择推荐的代理问题

ranking:ranking是一个更经典的机器学习问题,但是我们的深度学习方法优于以前的、用于观看时长预测的线性模型和基于树的模型。- 推荐系统尤其受益于历史用户行为(用户在

item上的行为)的专门特征。深度神经网络需要离散和连续特征的特殊表示,其中我们分别用embedding和分位数归一化来转换它们。深度的layer被证明能够有效地建模数百个特征之间的非线性相互作用。 - 逻辑回归被修改为通过正样本的观看时长来加权,而负样本的加权系数固定为单位权重。这允许我们学习与期望观看时长接近的几率

odds模型 。和直接预估点击率CTR相比,这种方法在观看时长加权的ranking评估指标上表现更好。

- 推荐系统尤其受益于历史用户行为(用户在

三、Recommending What Video to Watch Next[2019]

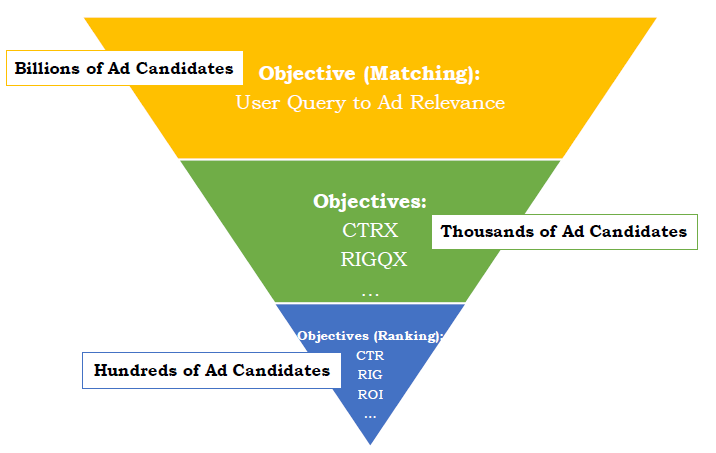

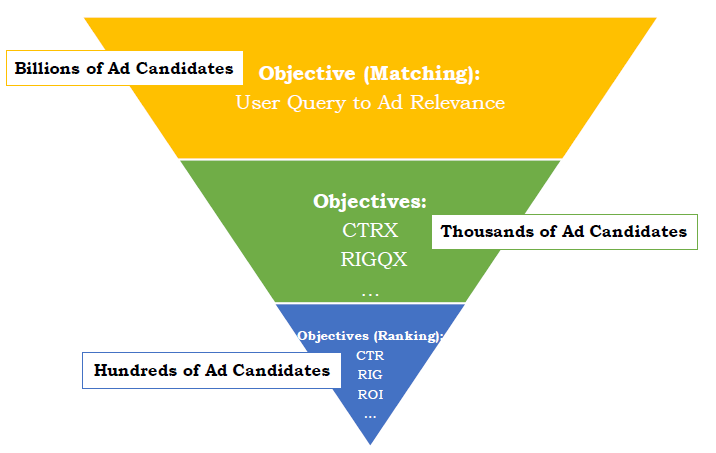

论文

《Recommending What Video to Watch Next: A Multitask Ranking System》描述了一个大规模的视频推荐排序系统ranking system。也就是说,给定用户当前正在观看的视频,推荐用户可能观看和喜欢的下一个视频。典型的推荐系统遵循两阶段设计,包括候选生成

candidate generation和排序ranking。本文重点研究排序阶段。在这个阶段,推荐器recommender从候选生成(如矩阵分解、或神经网络模型)中检索出几百个候选者,并应用复杂的、大容量的模型来对最有希望的item进行排序。我们展示了在大型工业视频发布和共享平台上构建这样一个排序系统的实验和经验教训。设计和开发一个真实世界的大规模视频推荐系统充满了挑战,其中包括:

我们想优化的目标

objective通常有所不同,有时甚至是相互竞争competing的。例如,我们可能想推荐用户评价高、并且分享(除了自己观看之外)给他们好友的视频。系统中经常存在隐性偏差

implicit bias。例如,用户点击并观看一个视频,可能仅仅是因为它排名最靠前,而不是因为用户最喜欢它。因此,使用当前系统生成的数据来训练的模型会有偏差

bias,导致反馈回路效应feedback loop effect。如何有效地学习降低这种bias是一个悬而未决的问题。

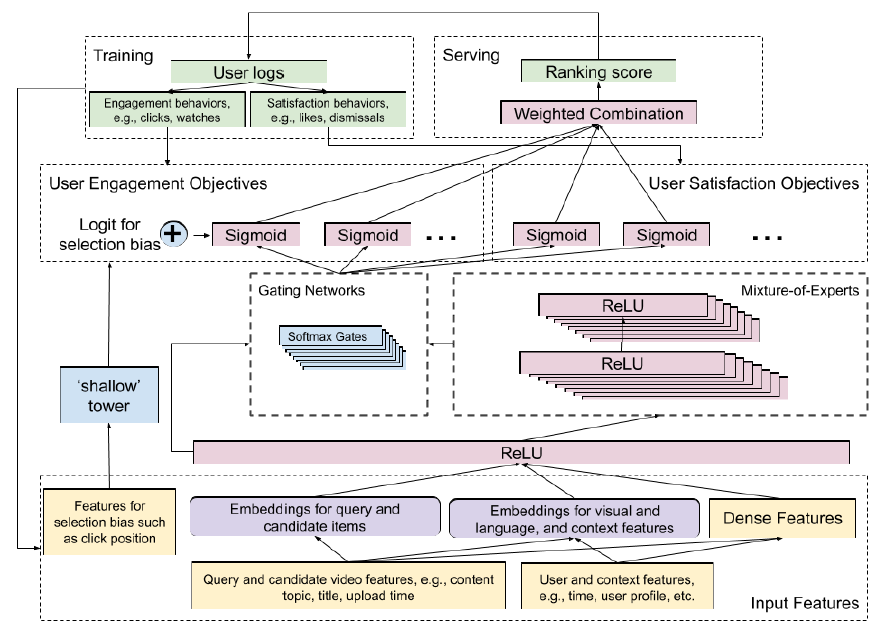

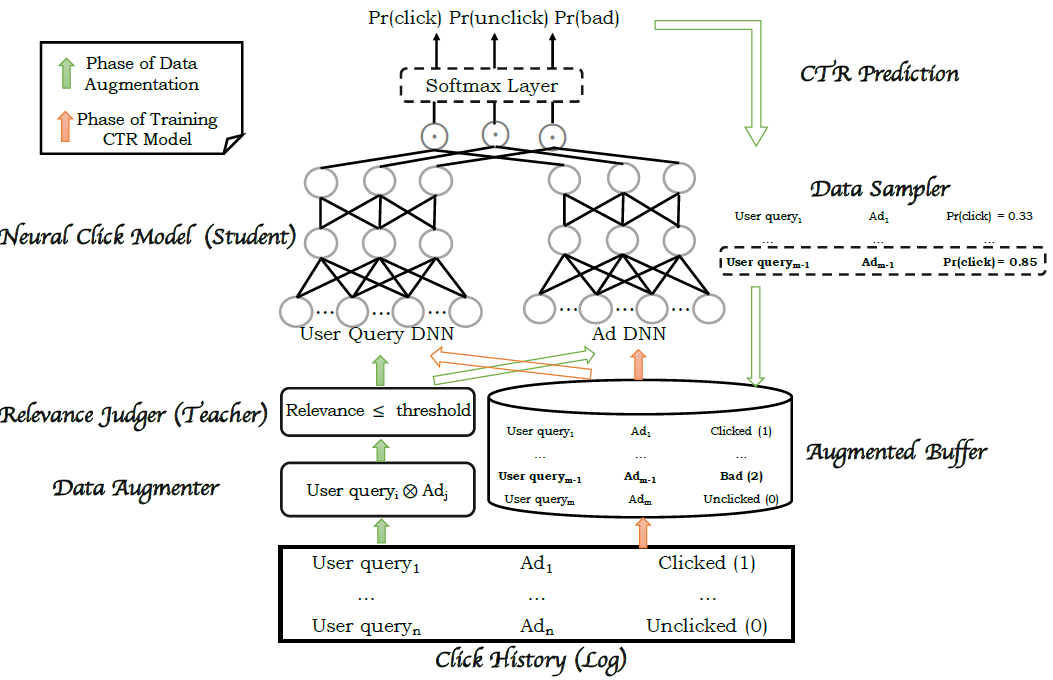

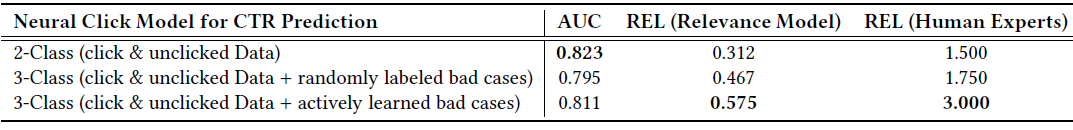

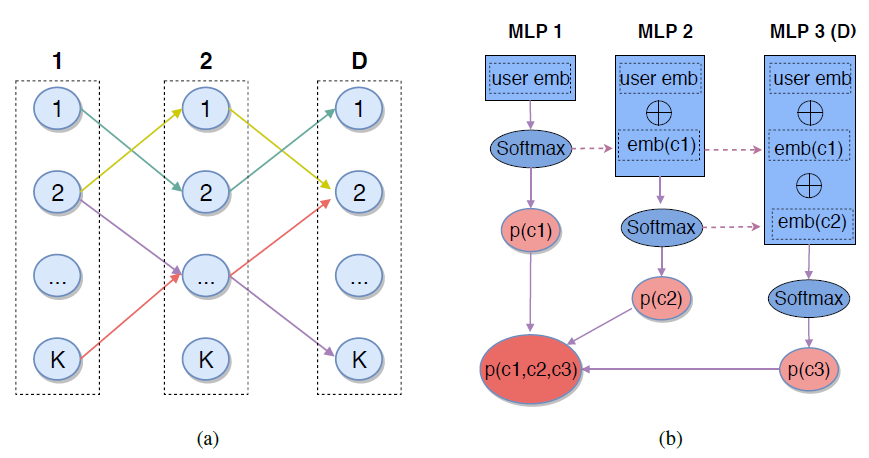

为应对这些挑战,我们为排序系统提出了一个高效的多任务神经网络架构,如下图所示。它通过采用

Multi-gate Mixture-of-Experts:MMoE来扩展了Wide&Deep框架,从而进行多任务学习。此外,它还引入了一个shallow tower来建模和消除选择偏差selection bias。我们将该架构应用于视频推荐来作为案例研究case study:给定用户当前正在观看的内容,推荐下一个要观看的视频recommend the next video to watch。我们在一个工业大型视频发布和共享平台上对我们提出的排序系统进行了实验。实验结果表明:我们提出的系统带来显著的提升。排序框架使用用户日志作为训练数据,并构建

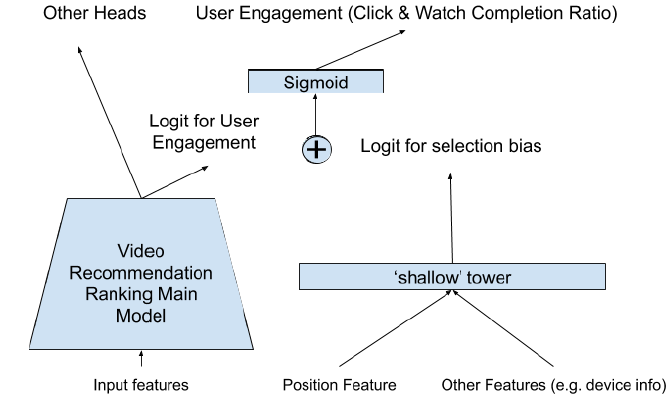

Mixture-of-Experts layer来预估两类用户行为:互动engagement(如点赞、评论、分享、@好友等)、满意度satisfaction。它用侧塔side-tower修正了排序的选择偏差selection bias。最重要的是,多个预测结果被组合成一个最终的排序分ranking score。

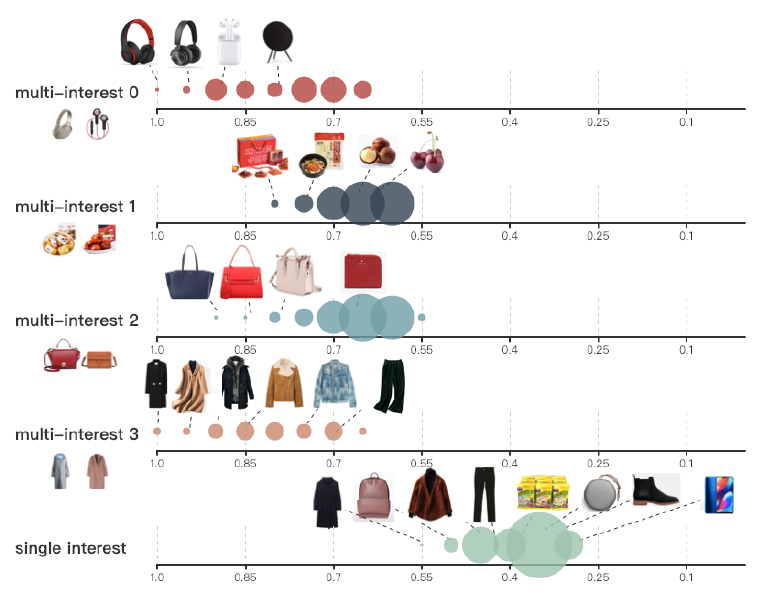

我们首先将我们的多个目标分为两类:

- 互动目标

engagement objective,如用户点击click、推荐视频的互动程度degree of engagement。 - 满意度目标

satisfaction objective,如用户喜欢YouTube上推荐的某个视频从而对推荐进行评分。

为了学习和评估多种类型的用户行为,我们使用

MMoE来自动学习参数,以便在潜在冲突的conficting目标之间共享。Mixture-of-Experts架构将输入层模块化为专家experts,每个专家聚焦于输入的不同方面aspect。这改善了来自多模态生成的复杂特征空间中学到的表示representation。然后,通过利用多个门控网络gating networks,每个目标可以选择和其它目标共享、或不共享专家。- 互动目标

为了从有偏差的训练数据中建模并减少选择偏差(如位置偏差

position bias),我们提出在主模型中添加一个shallow tower,如上图左侧所示。shallow tower接受与选择偏差相关的输入,例如当前系统决定的排序顺序ranking order,并输出标量作为主模型的最终预测的偏差项bias term。排序架构将训练数据中的

label分解为两部分:从主模型中学习的无偏用户效用unbiased user utility,以及从shallow tower中学习的估计倾向分estimated propensity score。我们提出的模型架构可以视为

Wide&Deep模型的扩展extension,其中shallow tower代表wide部分。通过与主模型一起直接学习shallow tower,我们受益于选择偏差的学习,而无需借助随机实验来获得倾向分propensity score。为评估我们提出的排序系统,我们设计并进行了一系列的在离线和在线实验,从而验证以下方法的有效性:多任务学习

multitask learning、消除一种常见的选择偏差(即,位置偏差)。和

state-of-the-art的baseline方法相比,我们提出的框架有显著的提升。我们使用最大的视频共享平台之一YouTube来进行我们的实验。总之,我们的主要贡献:

- 我们为视频推荐引入了端到端的排序系统。

- 我们将排序问题形式化为一个多目标学习问题,并扩展了

MMOE架构,从而提高所有目标的性能。 - 我们在真实世界的大规模视频推荐系统上评估了我们的方法,结果展示了显著的提升。

3.1 模型

3.1.1 相关工作

工业推荐系统:为设计和研发一个由机器学习模型支持的、成功的排序系统,我们需要的大量的训练数据。最近的大多数工业推荐系统在很大程度上依赖于大量的用户日志来构建它们的模型。

一种选择是直接询问用户对于

item效用utility的显式反馈explicit feedback。然而,由于成本太高,显式反馈的数量难以扩大scale up。因此,排序系统通常利用隐式反馈implicit feedback,例如对被推荐的item的点击和互动engagement。大多数推荐系统包含两个阶段:

候选生成

candidate generation:在candidate generation阶段,通常会使用多种信号源signal source和模型。例如,使用item之间的共现co-occurrence、使用协同过滤collaborative fltering、使用图上的随机游走random walk(它也代表了一种共现)、使用内容的representation来过滤等等。排序

ranking:在ranking阶段,广泛使用learning-to-rank框架的机器学习算法。例如,- 有的方法使用线性模型以及

tree-based模型探索了point-wise和pair-wise的learning to rank框架 。 - 有的方法使用

Gradient Boosted Decision Tree: GBDT用于point-wise排序目标ranking objective。 - 还有的方法使用以

point-wise ranking objective的神经网络来预估加权点击weighted click。

- 有的方法使用线性模型以及

这些工业推荐系统的一个主要挑战是可扩展性。因此,它们通常采用基础设施改进

infrastructure improvement和高效机器学习算法的结合。为了在模型质量和效率之间的权衡,一种流行的选择是使用基于深度神经网络的point-wise ranking模型。本文中,我们首先确定了工业排序系统中的一个关键问题:在被推荐的

item上,用户隐式反馈和真实用户效用true user utility之间的不一致性misalignment。随后,我们引入了基于深度神经网络的

ranking模型,该模型使用多任务学习技术multi-task learning technique来支持多个排序目标ranking objective,每个目标对应于一种类型的用户反馈。推荐系统的多目标学习:从训练数据中学习和预测用户行为具有挑战性。有不同类型的用户行为,如点击、评分

rating、评论commenting等。然而,每种类型的用户行为都不能独立地反映真实的用户效用。例如,用户可以点击一个item,但最终不喜欢它;用户可能仅仅为点击的item和互动的item提供评分。我们的排序系统需要能够有效地学习和评估多种类型的用户行为和效用

utility,并随后结合这些评估来计算ranking的最终效用分utility score。关于行为感知

behavior aware和多目标推荐的现有工作,要么只能在候选生成candidate generation阶段应用,要么不适合大规模在线ranking。例如,一些推荐系统扩展了协同过滤或者content-based系统,以从多个用户信号中学习user-item相似性。这些系统有效地用于候选生成,但是与基于深度神经网络的ranking模型相比,它们在提供最终推荐效果方面并不那么有效。另一方面,很多现有的多目标排序系统是为特定类型的特征和应用而设计的,例如文本

text和视觉vision。扩展这些系统以支持来自多模态的特征空间feature space(例如来自视频的标题文本、来自缩略图的视觉特征)将是具有挑战性的。同时,其他多目标排序系统(这些系统考虑了输入特征的多模态)无法扩展scale up,因为它们在有效共享多目标模型参数方面存在局限性。在推荐系统的研究领域之外,基于深度神经网络的多任务学习已经在许多传统的机器学习应用中进行了广泛的研究和探索,例如自然语言处理

nlp、计算机视觉computer vision。虽然很多为representation learning提出的多任务学习multi-task learning技术对于构建排序系统并不实用,但它们的一些构件building block启发了我们的设计。在本文中,我们描述了一个基于DNN的排序系统,该系统是为真实世界的推荐而设计的,并应用了Mixture-of-Experts layer来支持多任务学习。训练数据中

bias的理解和建模:用户日志用作我们的训练数据,它捕获当前生产系统production system中用户对于推荐的行为behavior和反映response。用户和当前系统之间的交互

interaction会在反馈feedback中产生选择偏差selection bias。例如,用户可能已经点击了一个item,仅仅是因为该item是当前系统选出来展现给用户的,而不是因为该item是整个语料库corpus中用户最喜欢的那个。因此,根据当前系统生成的数据之上而训练的新模型将偏向于当前系统,导致反馈回路效应feedback loop effect。如何有效和高效地学习减少系统的这种bias是一个悬而未决的问题。《Evaluating the accuracy of implicit feedback from clicks and query reformulations in web search》首先分析了隐式反馈数据中的位置偏差position bias和表示偏差presentation bias,从而训练learning to rank模型。通过比较点击数据和显式反馈之间的相关性,他们发现在点击数据中存在位置偏差,并可以显著地影响用于估计query和document之间相关性的learning to rank模型。根据这一发现,已经提出了很多方法来消除这种选择偏差,尤其是位置偏差。一种常用的做法是在模型训练中注入位置作为输入特征,然后在

serving阶段通过消融ablation来消除偏差 。在概率点击模型中,位置用于学习 。一种消除位置偏差的方法受到

《A dynamic bayesian network click model for web search ranking》的启发,他们使用 来推断CTR模型,并假设position = 1的推断没有没有位置偏差效应。随后,为了消除位置偏差,我们可以使用位置作为输入特征来训练模型,并通过将位置特征设为1(或者其他固定值,如缺失值)来做线上serving。其他方法试图从位置中学习一个偏差项

bias term,并将其作为一个归一化器normalizer或者正则化器regularizer。通常,要学习一个bias term,需要一些不考虑相关性的随机数据来推断这个bias项(也称作全局bias、或者倾向性propensity)。

在现实世界中的推荐系统中,尤其是像

Twitter, YouTube这样的社交媒体平台,用户行为和item流行度popularity每天都会发生显著变化。因此,当我们在训练ranking模型时需要一种有效的方法来适应训练数据分布的变化从而建模选择偏差。

3.1.2 系统概览

除了上述针对建立具有隐式反馈训练的排序系统的挑战之外,现实世界中的大规模视频推荐问题还需要考虑以下其他因素:

多模态特征空间

multimodal feature space:在上下文感知context-aware的个性化推荐系统中,我们需要学习候选视频的用户效用user utility,其中候选视频的特征空间是从多个模态生成的,例如视频内容、缩略图、音频、标题和描述description、用户人口统计特征user demographics。和其它机器学习应用相比,从多模态特征空间学习

representation以进行推荐具有独特的挑战性。它具有两个难点:- 从低级

low-level的内容中学习语义,以进行内容过滤content fltering。 - 从

item的稀疏分布中学习相似性,以进行协同过滤collaborative fltering。

- 从低级

可扩展性

scalability:可扩展性非常重要,因为我们正在为数十亿用户和视频构建一个推荐系统。模型必须能够有效地训练并高效地serving。尽管排序系统在每个

query仅对数百个候选视频评分,但现实中通常要求实时评分,因为一些query和上下文信息只能在线获取。因此,ranking sytem不仅需要学习数十亿个item和用户的representation,还需要在serving过程中保持高效。

回想一下,我们推荐系统的目标是在给定当前观看的视频和上下文的情况下,提供视频的排序列表

ranked list。为了处理多模态的特征空间,对于每个视频我们抽取诸如视频元数据meta-data、以及视频内容信号video content signal之类的特征作为视频的representation。对于上下文,我们使用诸如用户人口统计demographics、设备、时间、地理位置等特征。为了处理可扩展性,我们的推荐系统有两个阶段,即候选生成和排序。在候选生成阶段,我们从一个巨大的视频库中检索出几百个候选

item。我们的排序系统为每个候选视频提供一个分数,并生成最终排序列表。候选生成

candidate generation:我们的视频推荐算法使用多种候选生成算法,每种算法都捕获query video和候选视频之间相似性的一个方面。例如,一种算法通过召回

query video的主题来生成候选视频,另一种算法基于视频和query video共同观看的频率来检索候选视频。我们构建了一个类似于

《Deep neural networks for YouTube Recommendations》的序列模型,用于在给定用户历史记录的情况下生成个性化候选视频。最后,所有候选视频被聚集成一个

set,然后由排序系统来评分。排序

ranking:我们的排序系统会从数百名候选视频中生成排序列表ranked list。候选生成阶段试图过滤大多数

item,并只保留相关的item。和候选生成不同的是,排序系统旨在提供一个排序列表,以便对用户具有最高效用utility的item将显示在列表的头部。因此,我们在排序系统中应用最先进的机器学习技术(即一个神经网络架构),以便模型具有足够的表达能力来学习特征的关联、以及特征和效用的关系。我们的排序系统从两种类型的用户反馈中学习:互动行为

engagement behavior,如点击、观看;满意度行为satisfaction behavior,如喜欢like、拒绝dismissal。给定每个候选视频,排序系统使用候选视频的特征、

query和上下文作为输入,然后学习预测多种用户行为。对于问题的形式化,我们采用了

learning-to-rank框架。我们将排序问题建模为多目标分类问题和多目标回归问题的组合。给定query、候选视频、以及上下文,排序模型预测用户采取行为(如点击、观看、喜欢、拒绝)的概率。这种对每个候选视频进行预测的方法是一种

point-wise方法。相反,pair-wise或者list-wise方法对两个或者多个候选视频的排序进行预测。pair-wise或者list-wise方法可以用于潜在地提高推荐的多样性。然而,我们选择使用point-wise排序主要是基于serving的考虑。在serving阶段,point-wise排序简单有效,且可以扩展scale到大量候选视频。相比之下,pair-wise或者list-wise方法需要对pair对或者列表进行多次评分,从而在给定一组候选视频的情况下找到最有排序列表ranked list,这限制了它们的可扩展性。

3.1.3 排序目标

我们使用用户行为作为训练

label。由于用户可以对推荐的item具有不同类型的行为,我们设计了排序系统来支持多个目标。每个目标是预测一种与用户效用相关的用户行为。为了便于说明,在下文中我们将我们的目标分为两类:

- 互动目标

engagement objective:互动目标捕获用户的点击、观看等行为。我们将这些行为的预测形式化为两种类型的任务:针对诸如点击等行为的二元分类任务、以及针对观看时长等相关行为的回归任务。 - 满意度目标

satisfaction objective:满意度目标捕获用户点赞、点不喜欢等行为。我们将这些行为的预测形式化为二元分类任务或回归任务。例如,对视频点击 “喜欢” 这种行为被形式化为二元分类任务,而像评分行为被形式化为回归任务。

对于二元分类任务,我们计算交叉熵损失。对于回归任务,我们计算平方损失。

- 互动目标

一旦确定了多个排序目标

ranking objective及其问题类型,我们就会为这些预测任务训练一个多任务排序模型multitask ranking model。对于每个候选视频,我们采用这些多个预测的输入,并使用加权乘法形式的组合函数输出组合分数。加权的权重是手动调优的,从而在用户互动和用户满意度上同时达到最佳性能。

3.1.4 MMoE

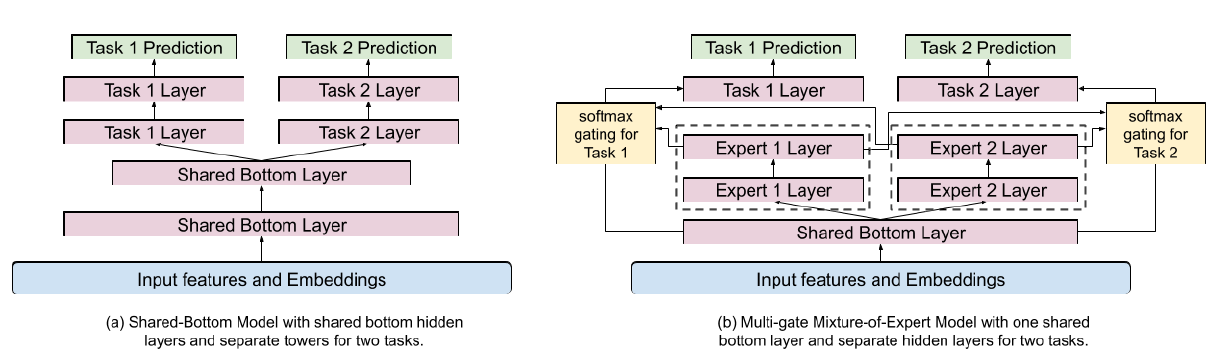

多目标排序系统通常使用共享底部

shared-bottom的模型架构(如下图(a)所示)。然而,当任务之间的相关性较低时,这种硬参数共享hard-parameter sharing技术有时会损害多个目标的学习。为了缓解多目标的冲突conflict,我们采用并扩展了最近发布的Multi-gate Mixture-of-Experts: MMoE模型架构。MMoE是一种软参数共享soft-parameter sharing的模型架构,旨在对任务冲突和任务联系进行建模。它采用Mixture-of-Experts: MoE的结构,通过让专家experts在所有任务之间共享来进行多任务学习,同时还为每个任务训练了一个门控网络gating network。MMoE layer旨在捕获任务差异,而不需要比shared-bottom模型多得多的模型参数。它的关键思想是用MoE layer代替共享的ReLU layer,并为每个任务添加一个独立的门控网络。对于我们的排序系统,我们提出在共享的

hidden layer之上添加专家,如下图(b)所示。这是因为MoE layer能够帮助从它的输入中学习模块化信息modularized information。当直接在输入层或更低层的hidden layer之上使用时,它可以更好地建模多模态特征空间。然而,直接在输入层应用MoE layer将显著增加模型训练和serving成本。这是因为通常输入层的维度要比hidden layer的维度高得多。

我们的专家网络

expert network的实现和采用ReLU激活函数的多层感知机相同。对于任务 ,假设最后一层的

hidden layer(即上图(b)中的Task k Layer)的函数为 ,则带 个专家的MMoE layer对于任务 的输出为:其中:

- 为低层的共享

hidden embedding。 - 为任务 的门控网络,而 为 的第 项,对应于任务 中第 个专家的权重。

- 为第 个专家,一共有 个专家。

- 为所有 个专家在任务 上的加权和,它是

Task k Layer的输入。

- 为低层的共享

门控网络只是对输入线性变换然后通过一个

softmax层:其中 是任务 门控网络的、线性变换的参数。

在论文

《Outrageously large neural networks: The sparsely-gated mixture-of-experts layer》的稀疏门控网络中,专家的数量很大,并且每个训练样本进使用表现最好的专家。与之相反,我们使用相对较少的专家。这是为了鼓励通过多个门控网络共享专家并提高训练效率。

3.1.5 选择偏差

隐式反馈已被广泛用于训练

learning-to-rank模型。可以通过从用户日志中提取大量的隐式反馈来训练复杂的深度神经网络模型。然而,由于隐式反馈是从现有的排序系统生成的,因此存在偏差

bias。位置偏差position bias以及很多其他类型的选择偏差被证明存在于不同的排序问题ranking problem中。在我们的排序系统中,

query是当前正在观看的视频,候选是相关的视频。通常,用户倾向于点击并观看更靠近列表头部展示的视频,而不管它们的的实际用户效用--无论是与观看视频的相关性还是用户的偏好。我们的目标是从排序模型中消除这种位置偏差。在我们训练数据中或者在模型训练期间建模和减少选择偏差可以导致模型质量的提高,并打破由选择偏差导致的反馈环路

feedback loop。我们提出的模型架构类似于

Wide&Deep模型架构。我们将模型预测分解为两个部分:主tower的用户效用部分user-utility component、和shallow tower的的偏差部分bias component。具体而言,我们训练一个

shallow tower,它采用有助于选择偏差的特征,如针对位置偏差的位置特征position feature。然后将shallow tower添加到主模型的最终logit中去,如下图所示。- 在训练阶段我们使用所有曝光的位置,并使用

10%的位置特征drop-out rate从而防止我们的模型过度依赖位置特征。 - 在

serving阶段,位置特征被视为缺失。

注意:我们将位置特征和设备特征交叉的原因是:在不同类型的设备上会观察到不同的位置偏差。因为不同设备的屏幕大小不同,导致呈现的

item列表有所差异。

- 在训练阶段我们使用所有曝光的位置,并使用

3.1.6 讨论

这里我们讨论一些洞察和局限性,这些都是我们从开发和实验我们的排序系统的过程中学到的。

推荐和排序任务的神经网络模型架构:很多推荐系统领域的研究论文扩展了最初为传统机器学习应用程序设计的模型架构,如用于

natural language processing: NLP的multi-headed attention、用于计算机视觉的CNN。然而,我们发现这些模型体系架构中的很多仅适用于特定领域的representation learning,并不直接适用于我们的需求。这是因为:- 多模态

Multimodal特征空间:我们的排序系统依赖于多个特征源source,例如来自于query和item的内容特征、上下文特征。这些特征从稀疏的离散空间sparse categorical space、到自然语言、到图像等等。从混合特征空间中学习是一项挑战。 - 可扩展性

scalability和多个排序目标:许多模型架构被设计为捕获一种类型的信息,如特征交叉feature cros或序列信息sequential information。它们通常会提升一种排序目标,但是可能会损害其他排序目标。此外,在推荐系统中应用复杂模型架构的组合几乎无法扩展。 - 带噪音

noisy的和局部稀疏locally sparse的训练数据:我们的系统需要为item和query训练embedding向量。然而,我们的大多数稀疏特征遵循幂律分布power-law distribution,并且对于用户反馈有很大的分布差异。例如,在上下文稍有不同的情况下,即使给定相同的query,用户可能点击也可能不点击推荐的item。而这在我们的系统中是无法捕获的。这给优化长尾的尾部item的embedding空间带来了很大的困难。 mini-batch随机梯度下降的分布式训练:我们依靠一个具有强大表达能力的大型神经网络模型来找出特征关联feature association。由于我们的模型消耗了大量的训练数据,我们不得不使用分布式训练,这本身就带来了固有intrinsic的挑战。

- 多模态

效果

efectiveness和效率eficiency之间的平衡tradeoff:对于现实世界的排序系统,效率不仅影响serving成本,还影响用户体验。过于复杂的模型会显著增加生成推荐item的延时latency,从而降低用户满意度和在线指标。因此,我们通常更喜欢更简单、更直接straight-forward的模型架构。训练数据中的

biases:除了位置偏差之外,还有许多其他类型的偏差。其中一些偏差可能是未知和不可预测的。例如,由于我们的系统在获取训练数据方面的局限性(对于未曝光的item,我们压根不知道用户对它们是否会发生行为)。如何自动学习和捕获训练数据中已知和未知的偏差是一个长期的挑战,需要做更多的研究。

评估方法

evaluation的挑战:由于我们的排序系统主要使用了用户的隐式反馈,离线评估得到的效果提升结论并不一定会转化为在线性能提升。事实上,我们经常观察到离线和在线指标之间的不一致misalignment。因此,最好选择一个总体上更简单的模型,以便可以更好地泛化到在线性能。未来方向:除了

MMoE和消除位置偏差之外,我们正在沿着以下方向改进我们的排序系统:探索用于多目标排序的、新的模型架构,该架构平衡了稳定性

stability、可训练性trainability和表达能力expressiveness。我们注意到,

MMoE通过灵活地选择共享哪些专家从而提高多任务排序性能。最近的一些工作在不损害预测性能的情况下进一步提高了模型的稳定性。理解并学习分解

factorize。为了对已知和未知的偏差进行建模,我们希望探索模型架构和目标,这些架构和目标能够从训练数据中自动识别潜在偏差、并学会减少这些偏差。模型压缩

compression:出于降低serving成本的需要,我们正在探索用于排序和推荐模型的、不同类型的模型压缩技术。

3.2 实验

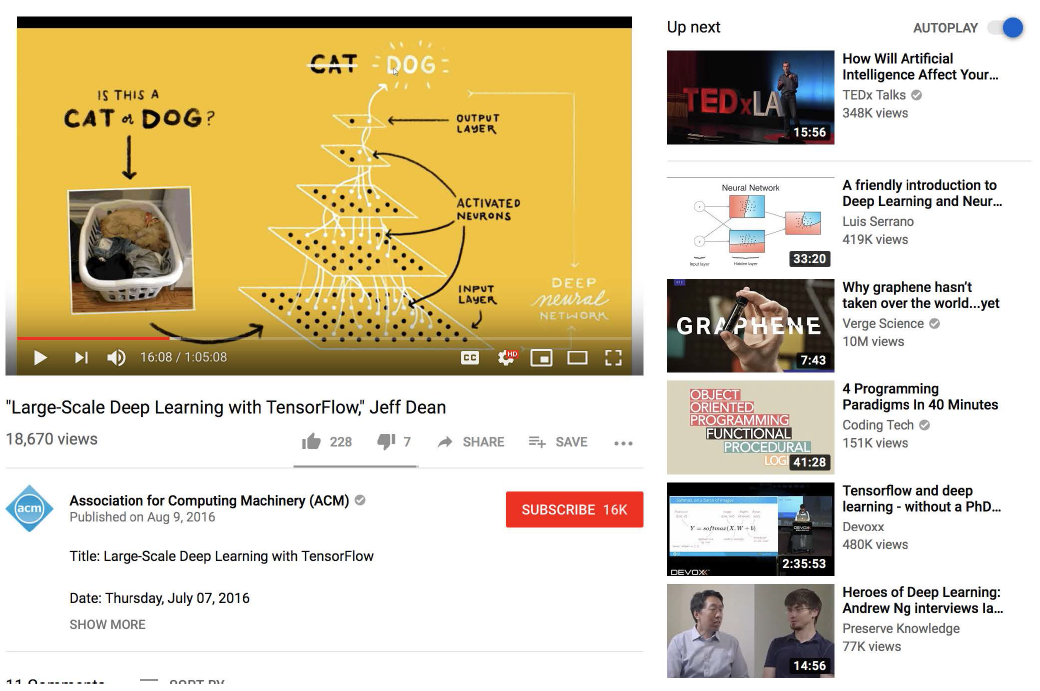

利用

YouTube提供的用户隐式反馈,我们训练了我们的排序模型,并进行了离线和在线的实验。YouTube的规模和复杂性使其成为我们排序系统的完美测试平台。YouTube的最大的视频分享平台,月活用户19亿。该网站每天创建了千亿级的用户日志,其中记录了用户和推荐结果之间的互动。YouTube的一个关键产品提供了在给定观看视频的情况下推荐下一个观看视频的功能(what video to watch next),如下图所示。它的用户界面为用户提供了多种与推荐视频交互的方式,如点击、观看、喜欢、拒绝dismissal。

实验配置:如前所述,我们的排序系统从多个候选生成算法中召回了几百个候选视频。我们使用

TensorFlow构建模型并训练和serving。具体而言,我们使用Tensor Processing Unit: TPU来训练我们的模型,并使用TFX Servo来serve。我们对提出的模型和

baseline模型都是串行sequentially地训练。这意味着我们根据时间顺序来组织训练数据从而训练我们的模型,并持续训练模型以消耗新到达的训练数据。通过这种方式,我们的模型适应了最新的数据。这对于很多现实世界的推荐应用程序application而言是至关重要的,在这些应用程序中,数据分布和用户模式会随着时间动态变化。对于离线实验,我们评估分类任务的

AUC和回归任务的平方误差。对于在线实验,我们进行了与生产系统production system相比较的A/B test实验。我们使用离线和在线指标来调整超参数,如学习率。我们检查了多个互动指标

engagement metric(诸如在YouTube上花费的时长等),以及满意度指标(如拒绝率dismissal rate、用户调查回访user survey response等)。除了在线指标之外,我们还关注模型在

serving时的计算成本,因为YouTube每秒都需要响应大量的query。

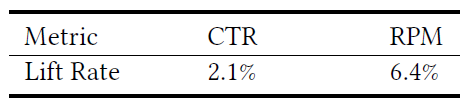

3.2.1 MMoE

为了评估采用

MMoE进行多任务排序的性能,我们与baseline方法进行了比较,并在YouTube上进行了在线实验。baseline方法:我们的baseline方法采用共享底部模型架构shared-bottom model architecture。我们以每个模型体系架构内的乘法数量来衡量模型的复杂度,因为这是模型

serving的主要计算成本。当比较

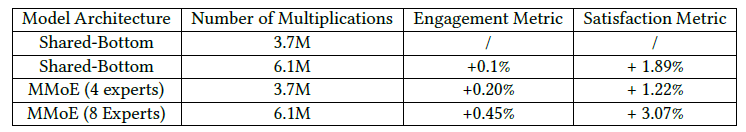

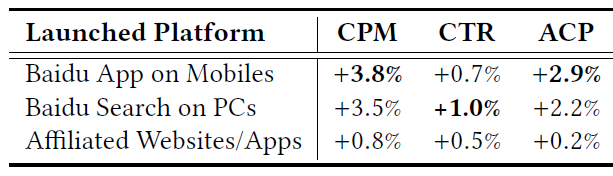

MMoE模型和baseline模型时,我们使用相同的模型复杂度。出于效率的考虑,我们的MMoE layer只有一层底部共享hidden layer,它使用比输入层更低的维度。YouTube上的在线实验结果如下表所示,其中MMoE模型使用4个专家或8个专家。我们报告了互动指标和满意度指标的结果。互动指标给出用户在观看推荐视频上所花的时长,满意度指标给出用户在调查回访中的评分。

可以看到:在相同模型复杂度的情况下,

MMoE显著提升了互动和满意度指标。

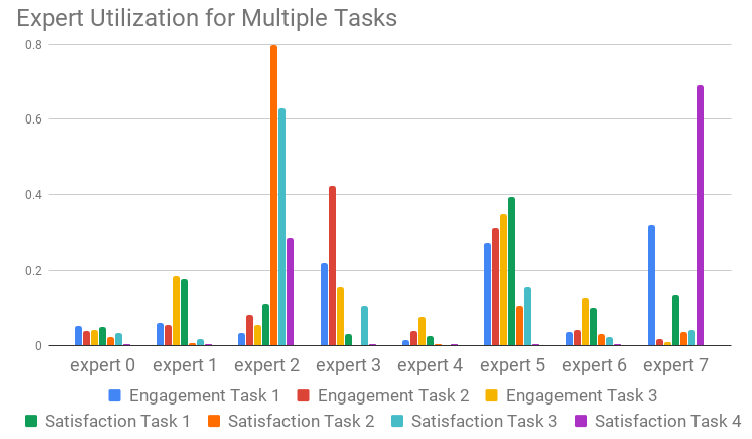

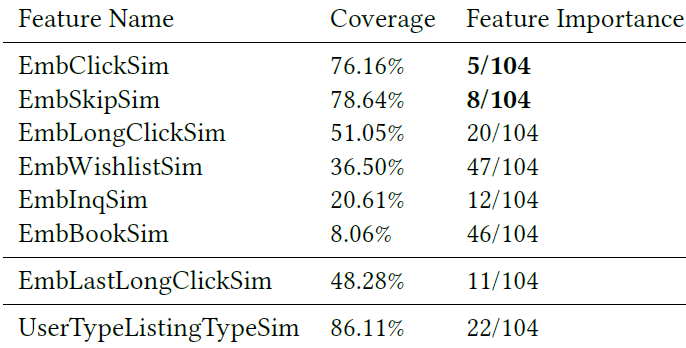

门控网络的分布

Gating Network Distribution:为进一步了解MMoE如何帮助多目标优化multi-objective optimization,我们绘制了softmax门控网络中每个专家上每个任务的累计概率accumulated probability,如下图所示。可以看到:一些互动任务

engagement task和其它互动任务共享多位专家,而满意度任务satisfaction task倾向于共享一小部分高效用high utilization的专家 ,这是通过使用这些专家的累计概率来衡量的。

如前所述,我们的

MMoE layer共享一个bottom hidden layer,它的门控网络从共享的隐层获取输入。与直接从输入层构造MMoE layer相比,这可能使MMoE layer更难于模块化modularize输入信息。或者,我们让门控网络直接从输入层而不是共享隐层获取输入,以便让输入特征可以直接用于选择专家。然而,在线实验结果显示这种变体没有显著差异。因此,门控网络从共享隐层获取输入可以有效地将输入信息模块化到专家中,从而建模任务关系和任务冲突

conflict。门控网络稳定性

Gating Network Stability:当使用多台机器训练神经网络模型时,分布式训练策略会导致模型经常发散diverge(即不收敛)。发散的一个例子是ReLU死亡。在

MMoE中,据报道softmax门控网络具有不平衡的专家分布问题imbalanced expert distribution problem,其中门控网络收敛到绝大多数专家的效用为零zero-utilization。通过分布式训练,我们观察到在我们的模型中有20%的机会出现这种门控网络的极化问题polarization issue。门控网络的极化会损害使用该门控网络的模型的性能。为解决这个问题,我们在门控网络上应用了

drop-out。通过采用dropout rate = 10%,以及re-normalizing重新标准化softmax输出,我们消除了所有门控网络的极化。

3.2.2 Position Bias

使用用户隐式反馈作为训练数据的一个主要挑战是难以建模隐式反馈和真实用户效用之间的差距

gap。使用多种类型的隐式反馈信号和多个排序目标,我们可以在

serving阶段进行更多手段的调优tune,从而在item推荐中捕获模型预估到用户效用之间的转换。但是,我们仍然需要建模和减少隐式反馈中普遍存在的偏差,例如,由用户和当前推荐系统之间的交互引起的选择偏差。在这里,我们评估如何使用我们提出的轻量级模型架构

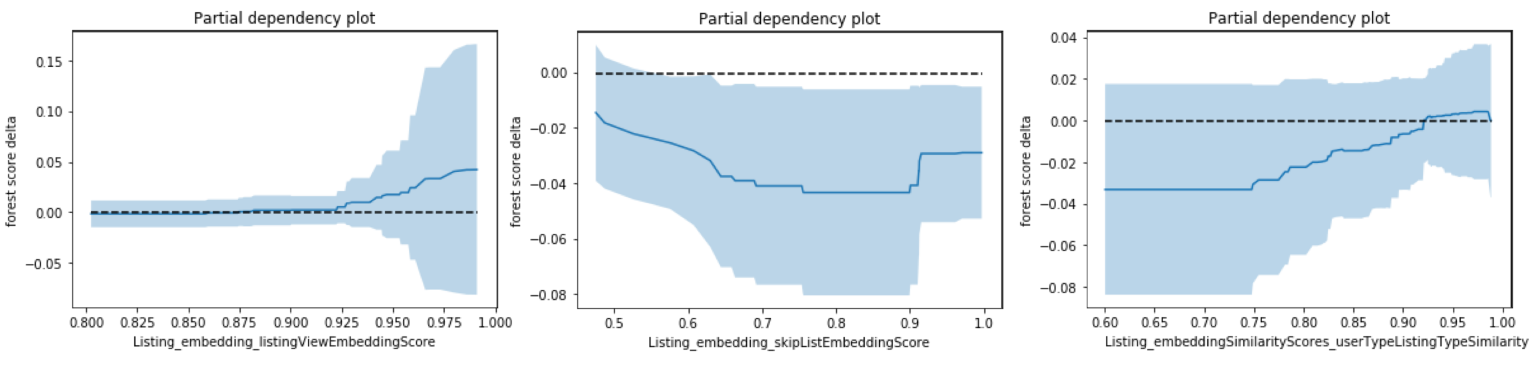

light-weight model architecture来建模和减少位置偏差position bias(一种类型的选择偏差)。我们的解决方案避免了随机实验或者复杂计算的代价。用户隐式反馈的分析:为了验证我们的训练数据中是否存在位置偏差,我们对不同位置的点击率

click through rate: CTR进行了分析。下图给出了位置1 ~ 9的相对CTR( 进行了同比例缩放)。正如预期所示,随着位置越来越低,点击率将显著降低。较高位置的点击率较高,这是由于推荐了更相关的

item、以及位置偏差的综合效果。使用我们提出的

shallow tower方法,我们在下面证明了该方法可以将用户效用的学习和位置偏差的学习分开。

baseline方法:为了评估我们提出的模型架构,我们将它与下面的baseline方法进行比较。直接使用位置特征作为输入特征:这种简单的方法已经在工业推荐系统中广泛使用,从而消除位置偏差。该方法用于线性的

learning-to-rank模型。对抗学习:受到领域适配

domain adaptation和机器学习公平性machine learning fairness中广泛采用的对抗学习的启发,我们使用类似的技术来引入辅助任务,该辅助任务可以预测训练数据中的位置position。随后,在反向传播阶段,我们将传递给主模型的梯度取反,确保主模型的预测不依赖于位置特征。

下表给出了我们提出的方法和

baseline方法的在线实验结果。可以看到:我们提出的方法通过建模和减少位置偏差,显著提升了互动指标。

下图显示了每个位置学到的位置偏差。可以看到:对于较低的位置,学到的偏差较小。

学到的偏差是通过有偏差的隐式反馈来得到的倾向分

propensity score的估计。使用足够的训练数据进行模型训练,我们可以有效地减少位置偏差。

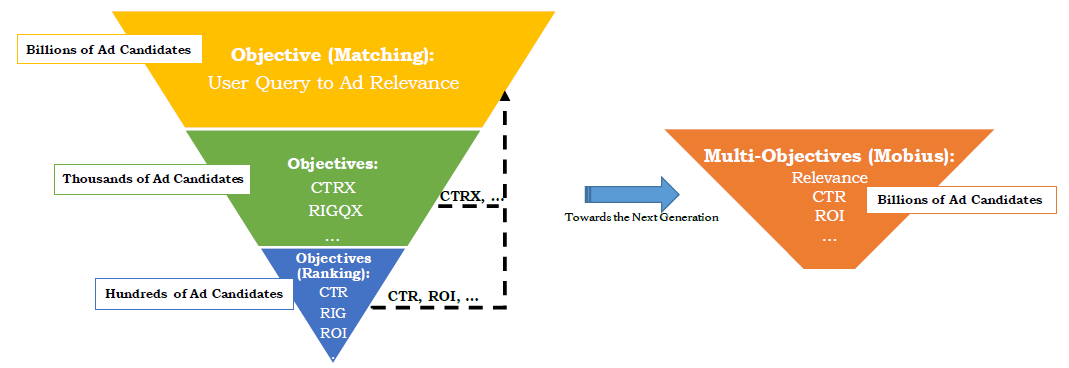

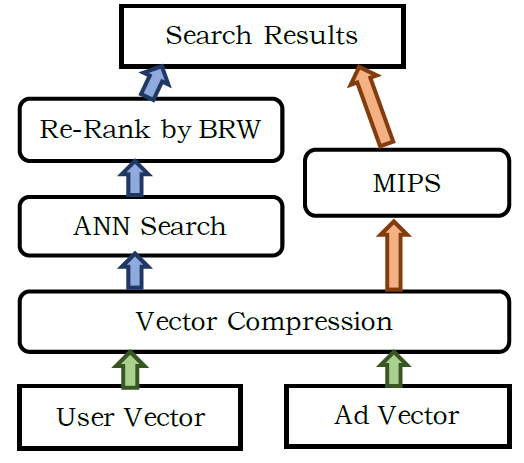

四、ESAM[2020]

排序模型

ranking model的典型公式formulation是:在给定query的情况下提供item的一个排序列表rank list。它具有广泛的应用,包括推荐系统、搜索系统等。排序模型可以形式化为: ,其中:- 是

query,例如推荐系统中的用户画像和用户行为历史、个性化搜索系统中的用户画像和关键词keyword,这取决于特定的排序应用。 - 代表基于 检索的相关

item,例如文本文档、item、问题答案answer。 - 由 和整个

item空间中每个item之间的相关性得分 组成, 为item的总数。

简而言之,排序模型旨在选择与

query相关性最高的top K个item作为最终的排序结果。目前,基于深度学习的方法广泛应用于排序模型,这些方法显示出比传统算法更好的排序性能。然而,这些模型主要是使用曝光

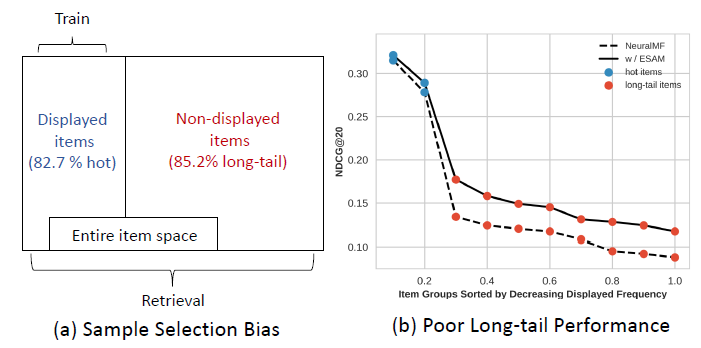

item的隐式反馈(如点击click、购买purchase)来训练,但是在提供serving服务时被用来在包含曝光item和未曝光item的整个item空间中检索item。我们根据曝光频率将整个

item空间分为热门item和long-tail长尾item。通过分析两个公共数据集(MovieLens和CIKM Cup 2016),我们发现:82%的曝光item是热门item,而85%的非曝光item是长尾item。因此,如下图所示,样本选择偏差sample selection bias: SSB的存在会导致模型对曝光item(大部分是热门item)过拟合,并且无法准确预测长尾item。图(b)给出了CIKM Cup 2016数据集上的SSB问题:由于SSB问题导致长尾性能很差。

更糟糕的是:这种训练策略将使得模型偏向于热门

item。这意味着这些模型通常会检索热门item,而忽略那些更合适的长尾item,尤其是那些新上架的item。这种现象被称作 “马太效应”Matthew Effect。我们认为造成这种现象的原因是

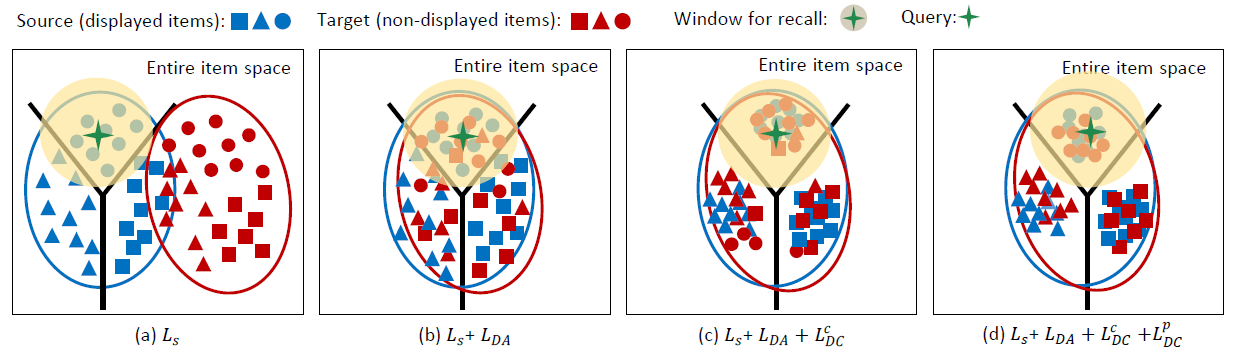

SSB导致长尾item缺乏记录(即反馈)来获得良好的特征representation,即数据稀疏data sparsity和冷启动cold start问题。因此和拥有足够记录的热门item相比,长尾item的特征具有不一致inconsistent的分布。如下图所示,领域漂移domain shift的存在意味着这些排序模型很难检索长尾item,因为它们总是过拟合热门item。下图中,蓝色为曝光item、红色为未曝光item,不同形状(三角形、圆形、方形)表示不同反馈类型,十字星表示query,黄色阴影表示query覆盖的item。

为了提高排序模型的长尾性能并增加检索结果的多样性,现有方法利用了不容易获取的辅助信息

auxiliary information或者辅助域auxiliary domain。遵循一些过去的工作,论文《ESAM: Discriminative Domain Adaptation with Non-Displayed Items to Improve Long-Tail Performance》强调了学习未曝光item的良好特征representation的重要性。为了实现这一点,考虑到曝光item和未曝光item之间的领域漂移导致的长尾性能不佳、以及未曝光item是未标记样本,我们采用了无监督unsupervised领域自适应domain adaptation: DA技术,将曝光item视为源域source domain、将未曝光item视为目标域target domain。领域自适应方法允许将带标签的源域训练的模型应用到带很少标签或者缺失标签的目标域。以前的

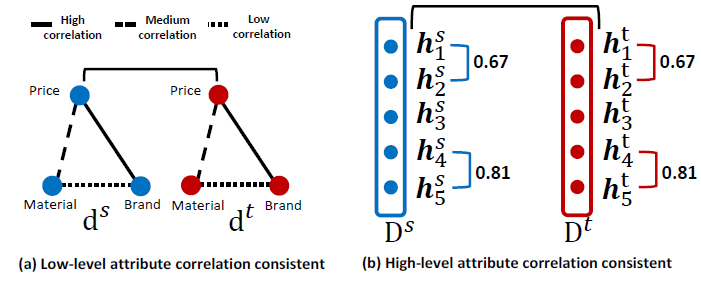

DA-based工作通过最小化一些分布度量来减少领域漂移,如最大平均差异maximum mean discrepancy: MMD,或者对抗训练。对于排序任务,我们提出了一种新的DA方法,称作属性相关性对齐attribute correlation alignment: ACA。无论一个item是否曝光,其属性之间的相关性都遵循相同的规则(即知识knowledge)。例如在电商中,一个item的品牌越豪华luxurious,其售价就越高(品牌brand和价格都是item的属性)。该规则对于曝光item和未曝光item都相同。在一个排序模型中,每个item都会通过特征提取器feature extractor表示为一个特征representation,特征的每个维度都可以看做是item的一个高级属性high-level attribute。因此,我们认为高级属性之间的相关性在曝光空间和未曝光空间中都应该遵循相同的规则。然而由于缺乏

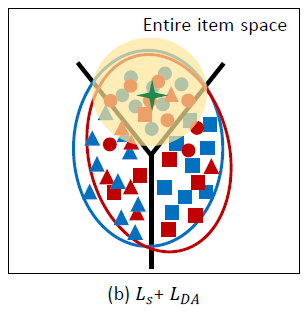

label信息,模型不能很好地获得未曝光item的特征。这导致曝光item和未曝光item的特征分布之间的不一致inconsistency,使得上述范式paradigm难以成立。因此,我们设计了属性相关一致性attribute correlation congruence: A2C来利用高级属性之间的成对相关性pair-wise correlation作为分布(从而增加分布一致性的约束)。虽然前面提到的

ACA算法可以解决分布不一致的问题,但是有两个关键的限制:使用

point-wise交叉熵的学习会忽略空间结构信息,从而导致特征空间中的邻域关系较差。如下图所示:尽管领域偏移得到缓解,但是较差的邻域关系使得模型很容易检索到异常值outlier。

未曝光

item的target label不可用,这可能在盲目地对齐分布aligning distribution时容易导致负向迁移negative transfer。负向迁移指的是迁移模型transfer model比非自适应模型non-adaptation model更差的窘境。如下图所示:类别无关的

ACA可能导致负向迁移,如一些target域(红色)的圆形和source域(蓝色)的三角形对齐。

为了克服这两个困难,我们提出了两个新的正则化策略:中心聚类

center-wise clustering和自训练self-training,从而增强DA过程。- 中心聚类:我们观察到:对于同一个

query,具有相同反馈的item是相似的、具有不同反馈的item是不相似的。例如,在电商中,当向用户曝光各种手机时,用户可能点击所有的iPhone而忽略其它手机。因此,对于每个query,我们可以根据反馈类型对曝光的item进行分类categorize。我们提出的中心聚类是为了使相似的item紧密地结合在一起,而不相似的item相互分离。这种约束可以为DA提供进一步的指导,导致更好的排序性能。 - 自训练:对于

target label的缺失,我们给target item分配高置信度的伪标签pseudo-label,并通过自训练self-training使模型拟合这些item。此外,当在执行对齐alignment时考虑这些伪标签时,模型可以逐渐正确地预测更复杂的item。

综上所述,本文的主要贡献:

提出了一种通用的全空间自适应模型

entire space adaptation model: ESAM,该模型利用属性相关对齐attribute correlation alignment: ACA的领域自适应domain adaptation: DA来提高长尾性能。ESAM可以很容易地融入大多数现有的排序框架。引入两种新颖而有效的正则化策略来优化邻域关系和处理

target label缺失,从而实现有区分性discriminative的领域自适应。在

item推荐系统和个性化搜索系统这两个典型的排序应用中实现了ESAM,并在两个公开数据集、一个淘宝工业数据集上的实验结果证明了ESAM的有效性。另外,我们将

ESAM部署到淘宝搜索引擎上,通过在线A/B test测试,结果表明ESAM产生更好的性能。

- 是

在不需要任何辅助信息

auxiliary information和辅助领域auxiliary domain的情况下,ESAM将知识从曝光item迁移到未曝光item,从而缓解曝光item和未曝光item的分布不一致性distribution inconsistency。下图为

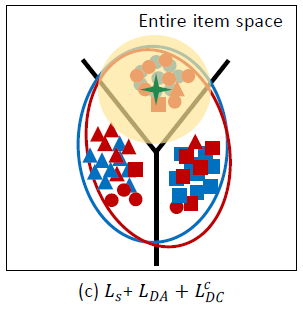

ESAM的基本思想,其中:三种形状代表三种反馈,蓝色代表源域(曝光item空间),红色代表目标域(未曝光item空间),星星代表query,带阴影的星星代表一个query及其检索范围。- 图

(a):曝光item特征和未曝光item特征之间的领域漂移。 - 图

(b):我们提出的属性相关性对齐的领域自适应可以有效缓解领域漂移。虽然领域漂移得到缓解,但是较差的邻域关系使得模型很容易检索到异常点outlier(簇内有不相似的item)。 - 图

(c):我们提出的中心聚类鼓励更好的流形结构manifold structure。但是,类别无关class-agnostic的ACA可能会导致负向迁移,如某些目标域的圆形和源域的三角形对齐。 - 图

(d):ESAM抽取了最佳的item特征representation。

- 图

相关工作:

基于神经网络的排序模型:最近,很多工作使用神经网络来完成排序任务。排序模型的一个重要发展是深度的

learning to rank: LTR。为了解决这个问题,一些方法利用领域自适应技术,如最大均值差异

maximum mean discrepancy: MMD(《Domain Adaptation for Enterprise Email Search》)、对抗训练(《An Adversarial Approach to Improve Long-Tail Performance in Neural Collaborative Filtering》),从而缓解源域和目标域的不一致分布。此外,一些方法(

《Causal embeddings for recommendation》,《Improving Ad Click Prediction by Considering Non-displayed Events》)引入了无偏系统(即,为一个query从整个item池中随机选择item)获得的无偏数据集来训练无偏模型。此外,还有一些方法引入辅助信息(

《Improving Ad Click Prediction by Considering Non-displayed Events》,《DARec: Deep Domain Adaptation for Cross-Domain Recommendation via Transferring Rating Patterns》)或辅助域(《Cross-domain Recommendation Without Sharing User-relevant Data》,《Cross-Domain Recommendation: An Embedding and Mapping Approach》)从而获得更多的长尾信息。与之前的方法不同,

ESAM结合领域自适应和未曝光item来提高长尾性能,无需任何辅助信息和辅助域。此外,我们设计了一种新颖的领域自适应技术,称作属性相关性对齐,将item高级属性之间的相关性视为要传递的知识。区分性的领域自适应

Discriminative Domain Adaption:领域自适应将知识从大量标记的源样本迁移到具有缺失或有限标签的目标样本,从而提高目标样本性能。领域自适应最近得到了广泛研究。这些领域自适应方法通过嵌入用于矩匹配

moment matching的自适应层adaptation layer来学习领域不变性domain-invariant feature,例如:- 最大平均差异

maximum mean discrepancy: MMD(《Deep joint two-stream Wasserstein auto-encoder and selective attention alignment for unsupervised domain adaptation》)。 - 相关性对齐

correlation alignment: CORAL。 - 中心矩差异

center moment discrepancy: CMD(《Central moment discrepancy (cmd) for domaininvariant representation learning》)。

也有一些领域自适应方法集成领域判别器

domain discriminator进进行对抗训练,如领域对抗神经网络domain adversarial neural network: DANN(《Domain-adversarial training of neural networks》)和对抗判别领域适应adversarial discriminative domain adaptation: ADDA(《Adversarial discriminative domain adaptation》)。还有一些方法努力学习更多的判别特征从而提高性能,例如对比损失

contrastive loss(《Dimensionality reduction by learning an invariant mapping》) 和中心损失(《Large-margin softmax loss for convolutional neural networks》)。这些方法已经在很多应用中被采纳,例如人脸识别和person re-identification。受到上述方法的启发,我们提出对整个空间具有更好判别力的

item特征进行领域自适应。- 最大平均差异

4.1 模型

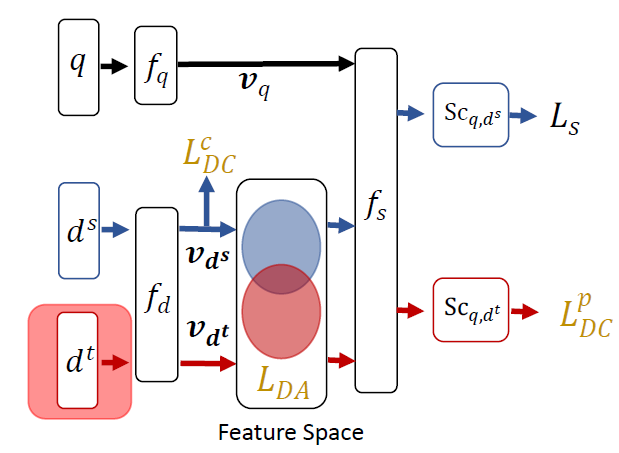

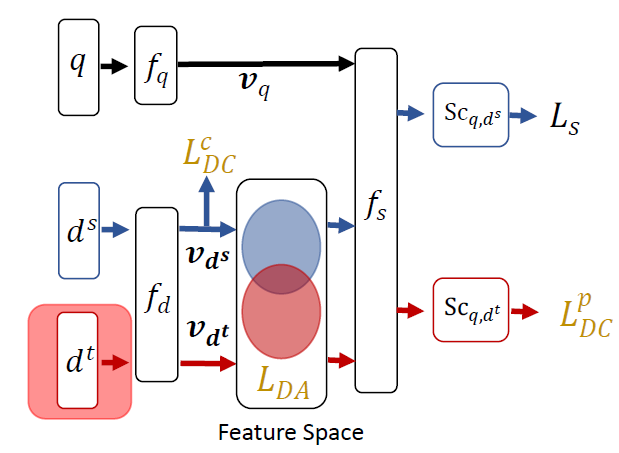

我们首先介绍了名为

BaseModel的基本排序框架,然后包括A2C和两个正则化策略的ESAM被集成到BaseModel中,以便在整个空间中更好地学习item特征representation。下图给出了ESAM的总体框架。我们将剔除未曝光

item(未曝光的item同时也是无标签的) 输入流input stream的ESAM视为BaseModel。下图中红色箭头为未标记的未曝光item,BaseModel即为剔除红色的部分。

本文中,源域

source domain(曝光item)记作 ,目标域target domain(未曝光item)记作 ,整体item空间记作 。源域和目标域共享相同的query集合 。从一个query到一个item的反馈集合记作 ,其中:- 为特定的

query,如关键词keyword、用户画像user profile、问题question等等。 - 为一个

item,如文本文档、item、问题答案answer等等。 - 为一个隐式反馈,如是否点击、是否收藏等等。

对于每个

query:- 我们分配一个标记的

source item集合 ,它们的反馈是可用的。其中 为对query有反馈的item的数量, 为对应的反馈类型、 为对应的反馈item。 - 我们也分配一个未标记的

target item集合 ,它们是从未曝光item中随机选择的。其中 为随机采样的item的数量, 为采样到的item。

对于每个

query,排序模型的目标是从 中检索一个排序的item集合 ,从而最大化query的满意度satisfaction。- 为特定的

4.1.1 BaseModel

从下图可以看到:排序模型主要由

query side和item side来组成。排序模型的核心任务是:将一个query和一个item分别通过 和 映射成一个query特征 和一个item特征 。这可以公式化为:当获得

query和item的特征之后,我们利用评分函数 来计算query和item的相关性得分relevance score:然后:

在训练阶段,可以通过使用隐式反馈来训练排序模型,其中模型的损失函数为 (例如,

point-wise目标函数、pair-wise目标函数、list-wise目标函数)。注意,隐式反馈在大多数现实应用中可用,因此

point-wise目标损失被广泛用于模型训练。在

serving阶段,相关性得分最高的top-K个item组成的排序列表rank list可以作为检索结果。

最近,很多工作设计了新的 和 来抽取更好的特征。例如:

- 神经矩阵分解

neural matrix factorization: NeuralMF:采用MLP作为 和 来分别抽取query特征和item特征。 - 深度兴趣演化网络

deep interest evolution network: DIN:在 和 之间引入注意力机制。 - 行为序列

transformerbehavior sequence transformer: BST:在 中引入transformer模块来捕获query的短期兴趣。

然而,大多数方法都忽略了对未曝光

item的处理,因此这些体系架构解决方案可能无法很好地泛化generalize(到长尾item)。- 神经矩阵分解

4.1.2 ESAM

ESAM的思想是:通过抑制曝光item和未曝光item之间的分布不一致inconsistent distribution从而提高长尾性能。实现该思想的方法是:利用未曝光

item的有区分性的领域自适应discriminative domain adaptation从而在整个item空间中抽取更好的item特征。ESAM主要聚焦于item侧 的改进。具体而言,如上图所示,ESAM另外引入了一个未曝光item(未曝光的同时也是无label的)输入流input flow,它对BaseModel的 有三个约束:属性相关性对齐的领域自适应Domain Adaptation with Attribute Correlation Alignment、面向源聚类的中心聚类Center-Wise Clustering for Source Clustering、面向目标聚类的自训练Self-Training for Target Clustering。注:如何选择未曝光

item也是一个问题。由于真实世界中,item集合非常庞大,因此选择所有的未曝光item是不现实的。实验中,作者选择曝光item相似的item作为目标集合。“相似” 包括:相似的类型、相似的价格等等。属性相关性对齐的领域自适应:由于曝光

item和未曝光item之间存在领域漂移,因此我们利用领域自适应技术来提高整个item空间的检索质量。假设 表示针对

source item集合 的source item特征矩阵, 表示针对target item集合 的target item特征矩阵。其中:其中:

- 为了便于讨论,我们假设

source item集合和target item集合的规模相同,即: 。 - 分别表示

source item特征和target item特征,并且由item侧 生成。 表示item特征的维度。

从另一个角度来看,这两个矩阵也可以看做是一个

source高级属性high-level attribute矩阵 以及一个target高级属性矩阵 。其中: 分别表示源item矩阵和目标item矩阵中的第 个高级属性。我们认为:曝光

item的低级属性low-level attribute(如价格、品牌)之间的相关性,与非曝光item一致consistent。如下图所示,在电商中,品牌属性和价格属性具有高度相关性,而品牌属性和材料属性之间的相关性较低。这些知识在源域和目标域中是一致的。因此,我们认为:高级属性也应该具有和低级属性相同的相关一致性correlation consistency。基于这样的约束,我们认为:当源域中item高级属性向量之间的相关性和目标域一致时,源域和目标域的分布distribution是对齐的aligned。

因此,我们将

item高级属性向量之间的相关性矩阵correlation matrix定义为分布distribution。具体而言,我们提出属性相关一致性attribute correlation congruence:A2C作为分布的度量。我们减少分布之间的距离,从而确保高级属性之间的相关性在源域和目标域是一致的。A2C的数学描述为:其中:

- 为矩阵的

Frobenius范数的平方。 - 为源域高级属性的协方差矩阵

covariance matrice, 为目标域高级属性的协方差矩阵。协方差矩阵中第 项表示 和 之间的相关系数 。

我们从源域抽取两个

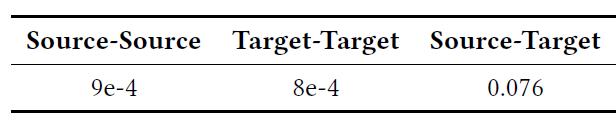

batch的样本、从目标域抽取两个batch的样本,并计算由BaseModel抽取的高级属性中每两个协方差矩阵的 。如下表所示(工业数据集),源域和目标域之间的 远大于相同域内的 ,这表明确实存在分布漂移distribution shift。下表中:

Source-Source表示 ,Target-Target表示 ,Srouce-Target表示 。其中下标1表示第一个batch、2表示第二个batch、1,2表示融合两个batch。注: 本质上是刻画两组样本之间特征相关性的距离。这两组样本可以来自于不同的

domain,也可以来自于相同的domain。注二:这是建模了特征之间的关系:即曝光数据集上的特征关系、未曝光数据集上的特征关系是相同的。这本质上是一种半监督学习:损失函数 = 监督损失 + 无监督的分布损失。

- 为了便于讨论,我们假设

面向源聚类的中心聚类:大多数

BaseModel只优化 ,而 对特征空间中的空间结构不敏感,并使得模型无法学习可区分性的特征discriminative feature。在我们的初步研究中,我们注意到:对于同一个query,具有相同反馈的item是相似的、具有不同反馈的item是不相似的。为此,我们提出一个中心聚类center-wise clustering来鼓励具有相同反馈的item的特征彼此靠近,而具有不同反馈的item的特征彼此远离。每个

query的hinge-based中心聚类可以形式化为:其中:

- 假设有 种不同的反馈类型 ,如非点击

non-click、点击、购买等等。 表示第 种反馈类型。 - 表示在 上的反馈类型。

- 表示由

query得到类型为 反馈的所有item的特征的簇中心。它就是类型 反馈的item特征归一化之后的均值向量。 - 和 是两个距离约束

margin。 - 表示如果条件满足则返回

1。

的物理意义为:

- 第一项要求每个

item的特征向量尽可能靠近它所在的簇中心,因此强制簇内(具有相同反馈的item)的紧凑性compactness。 - 第二项要求不同簇中心之间尽可能远离,因此强制簇间(具有不同反馈的

item)的可分离性separability。

由于 的存在,源域和目标域高度相关。因此,使源

item特征空间更有可区分性discriminative是合理的(通过 使得源特征空间更有区分性),这使得目标item特征空间通过优化 而变得有可区分性。从这个意义上讲,排序模型可以提取更好的item特征来提高领域自适应性,从而获得更好的长尾性能。- 假设有 种不同的反馈类型 ,如非点击

面向目标聚类的自训练:对于一个

query,我们可以为每个未曝光的item分配一个target伪标签pseudo-label(正样本或负样本)。目前为止,

ESAM可以被视为类别无关class-agnostic的领域自适应方法,该方法在对齐aligning时会忽略目标标签target label信息,并且可能将目标item映射到错误的位置(如,将目标正样本target positive sample匹配match到源负样本source negative sample)。带有伪标签的目标样本在对齐时将为模型提供目标区分性

target-discriminative的信息。因此,我们使用带有伪标签的样本进行自训练self-training,来缓解负向迁移。具体而言,最小化熵正则化 有利于类别之间的低密度分离low-density separation,并增加目标的区分度target discrimination。我们根据 来计算

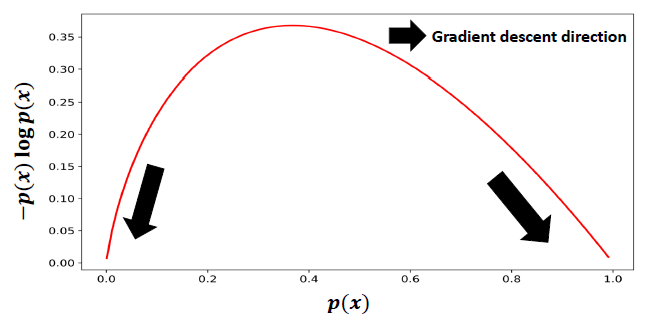

query和未曝光item之间的相关性得分,然后归一化为[0.0 ~ 1.0]之间(例如通过sigmoid函数)。这个归一化的得分可以作为目标item是该query的正样本的概率。例如,对于点击反馈,这个得分表示query点击这个未曝光item的概率。如下图所示,通过梯度下降优化熵正则化会强制使得归一化得分数小于

0.4并逐渐接近0(负样本)、归一化得分数大于0.4并逐渐接近1(正样本)。因此,这种正则化可以被视为一种自训练的方式,它增强了未曝光item之间的区分能力discriminative power。

但是,当直接使用正则化时,由于在早期训练中曝光

item和未曝光item之间存在较大的领域漂移,因此排序模型无法正确预测未曝光item,尤其是对于归一化得分在[0.4,0.6]之间的item。 因此,目标样本target sample很容易被分配错误的标签,并陷入错误的反馈中。为此,我们采用带约束的熵正则化来选择可靠的目标样本进行自训练:其中:

- 为两个置信度阈值,用于选择带有置信度伪标签的可靠样本。

- 是 和 之间的相关性得分,并归一化为

[0.0,1.0]之间。 - ,如果条件

a或者条件b满足。

通过优化 ,模型可以使用 小于 的负

target item、或者 大于 的正target item进行自训练。这种带有约束的熵正则化保证了target label的正确性,从而避免了负向迁移。此外,基于课程学习curriculum learning,该模型可以从可靠样本reliable sample中学习目标有区分性target-discriminative的信息,从而将更多样本转化为可靠样本。个人认为这里的自训练的目的是提高未曝光

item预估概率的可区分性。对于未曝光item,模型预估结果倾向于集中在概率均值附近(熵值较大),使得正负样本之间区分性不大。而对于曝光item,由于有真实反馈信息,模型预估结果趋向于两端(熵值较小),使得正负样本之间区分性较大。因此,如果对未曝光

item预估概率为0.55,则它可能是一个正样本;如果对曝光item预估概率为0.55,则它可能是一个负样本。本质原因是因为未曝光item预估概率分布和曝光item预估概率分布的不一致性,后者的熵更小、更具区分性。为此,这里的自训练通过最小化未曝光

item预估结果的熵值,使得未曝光item预估概率分布尽可能有区分度。最终

ESAM总的损失函数为:其中 为超参数,分别控制对应项的重要性。

4.2 应用

这里我们将

ESAM应用于两个特定的排序场景:item推荐、个性化搜索。Item推荐:Item推荐是一个典型的排序问题。推荐系统最重要的方法之一是协同过滤,它探索了潜在的user-item相似性。推荐系统主要包括四个组成部分:特征组成

Feature Composition、特征抽取Feature Extract、评分函数Scoring Function、损失函数Loss Function。特征组成:我们在

item推荐中主要采用三组特征:用户画像特征、用户行为特征、item画像特征。每组特征由一系列的稀疏特征组成:- 用户画像

user profile特征:包括用户ID、年龄、性别等等。 - 用户行为

user behavior特征:包括用户最近交互的item id。 item画像item profile特征:包括item id、品牌、类目等等。

模型使用哪些特征组

feature group、以及使用特征组内哪些稀疏特征取决于特征提取器extractor的设计。- 用户画像

特征提取器

Feature Extractor:基于神经网络的推荐系统的基础basic特征提取器是MLP。目前设计了各种新颖的模块来增强特征抽取,如注意力机制attention mechanism、transformer模块。在我们的实验中,我们将

ESAM集成到多种提取器中,以证明它是一个提高长尾性能的通用框架。评分函数:我们定义评分函数为:

其中:

- 为针对

item的bias项。 - 为从 抽取的、用户 的特征。

- 为从 抽取的、

item的特征。

- 为针对

损失函数:我们将点击视为反馈,因此对于一个

query,一个item是否会被点击可以认为是一个二分类问题。我们应用point-wise交叉熵目标函数:其中:

- 为一个二元标签,它指示

query是否在item上产生点击。 - 是

query所有曝光的item的数量。

- 为一个二元标签,它指示

上述模型仅使用 进行训练,而 仅考虑曝光的

item。为了缓解领域偏移以提高模型的性能,我们在每个训练epoch随机地将未曝光item分配给每个query,并且通过在item侧 的三个约束来引入额外的未曝光item输入流input stream,从而将ESAM集成到模型中。在推荐场景中,面向源聚类的中心聚类是个难点。论文假设对于给定的

query,相同反馈的item是相似的。但是在这里,用户相同反馈(如点击或购买)的item不一定相似,因为用户的兴趣是多样化的。个性化搜索:这里的个性化搜索系统是根据用户发出的关键字

keyword来识别用户可能感兴趣的所有可能item。因此,ESAM的集成、特征提取器、损失函数和item推荐场景相同,只是特征组成、评分函数有所不同。特征组成:个性化搜索系统引入了额外的关键词特征组

feature group。通过对关键词的word vector求平均,将关键词转换为向量。评分函数:我们定义评分函数为余弦相似度:

为什么推荐任务中使用

sigmoid而搜索任务中使用余弦相似度?这里没有讲清楚。

4.3 实验

我们对

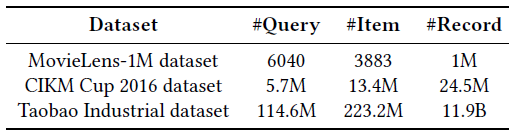

ESAM进行了item推荐实验和个性化搜索实验。数据集:

Item推荐:MovieLens-1M:该数据集由超过数千部电影和用户的一百万条电影评分记录组成。我们首先将评分二值化binarize来模拟CTR预估任务:评分大于3分的为正样本、评分小于等于3分的为负样本。这是常见的解决该问题的方法。我们使用的特征是

query侧的用户ID、年龄、性别、用户职业,以及item侧的电影ID、发行年份、电影流派genres。在每个训练

epoch,我们随机添加10部与曝光item相似的未曝光电影(即 ) 。相似的电影是那些流派与曝光电影相同的未曝光电影。如何定义相似?这是一个问题。

我们按照

8:1:1的比例将数据随机划分为训练集、验证集、测试集。

个性化搜索:

CIKM Cup 2016 Personalized E-Commerce Search:个性化电商搜索挑战赛发布了DIGINETICA提供的数据集。每个

item包含了item ID、类目ID、标题、描述文本。每个query由用户id、年龄、历史行为、提交的关键词ID(由单词列表转换而来)组成。每条记录都包含一个query,以及该query相关的10个曝光item、以及该query点击的item。我们采用

MovieLens-1M相同的策略为每条记录分配未曝光的item。我们按照8:1:1的比例将数据随机划分为训练集、验证集、测试集。Industrial Dataset of Taobao:我们收集了2019年6月淘宝一周的日志。在这个数据集中,所有使用的特征、获取未曝光item的方式,以及记录的组织方式都与CIKM Cup 2016数据集相同。我们将第一天到第五天的记录作为训练集、第六天的数据作为验证集、第七天的数据作为测试集。

这些数据集的统计信息如下表所示。

baseline方法:为了验证ESAM是一个通用框架,我们将其集成到基于神经网络的一些单域single-domain排序方法中。注意:特征提取器 ( 和 )在个性化搜索和推荐应用程序中是一致的,只有特征组成( 和 )、以及评分函数 ()取决于具体应用。

我们还比较了一些

DA-based排序方法,以及一些missing not random方法(仅考虑曝光item而不考虑未曝光item),从而显示我们提出的ESAM的优势。具体而言,

baseline方法包括:单域方法:

NeuralMF、RALM、YoutubeNet、BST。DA-based方法:DARec、DA learning to rank framework: DALRF。注意:对于

DA-based方法,我们仅将原始DA约束替换为ESAM,并保持其他模块不变以进行比较。missing not random方法:unbiased imputation model: UIM。注意:

missing not random方法需要无偏数据集unbiased dataset。这里无偏数据集是通过对一小部分在线流量部署一个统一策略uniform policy而收集的。为了公平地比较,我们仅将使用无偏数据集的约束替换为ESAM。

评估指标:我们使用三个标准评估指标来比较性能:

Normalized Discounted Cumulative Gain: NDCG、Recall、Mean Average Precision: MAP。所有方法进行了五次训练,并报告平均结果。

配置:

所有方法均由

TensorFlow实现,并使用Adam优化器进行训练。超参数:

- 对于超参数 ,我们从

{0.01, 0.1,0.3,0.5,0.7,1,10}中搜索最佳的值,并设置 。 - 对于其它超参数,我们设置学习率为 、

batch size = 256、特征维度 、距离约束 、置信阈值 。 - 对于

baseline方法的超参数,我们使用基于验证集性能的网格搜索。

- 对于超参数 ,我们从

我们为每个

query分配了10个源item、10个目标item,即 。根据曝光频率,我们将整个

item空间划分为热门item和长尾item:我们将top 20%的item定义为热门item、剩余item定义为长尾item。

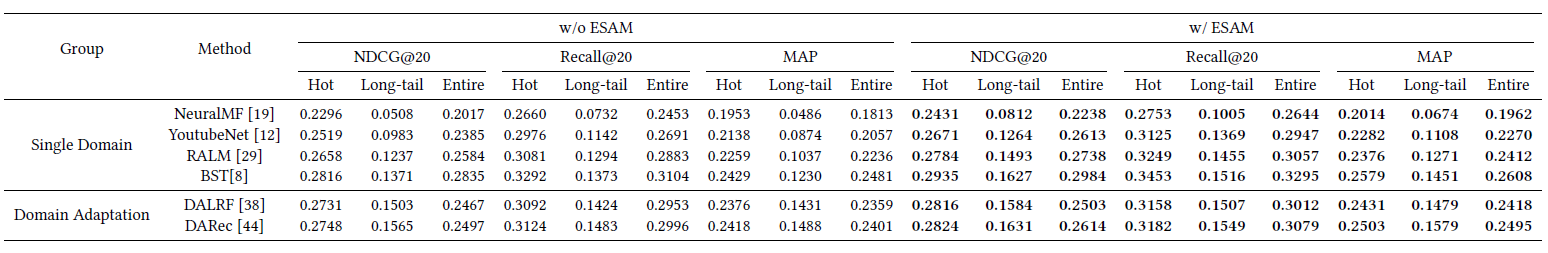

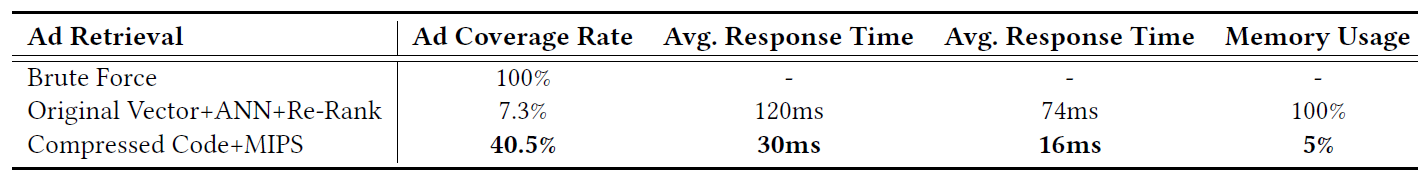

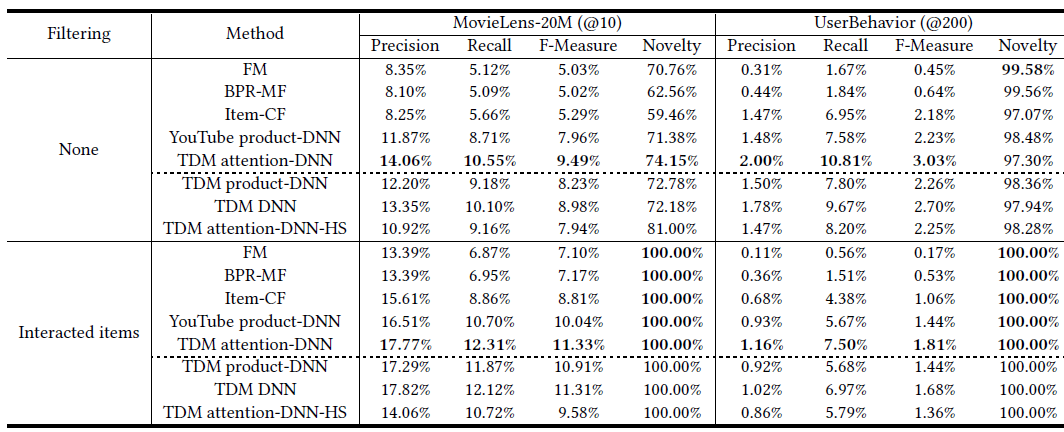

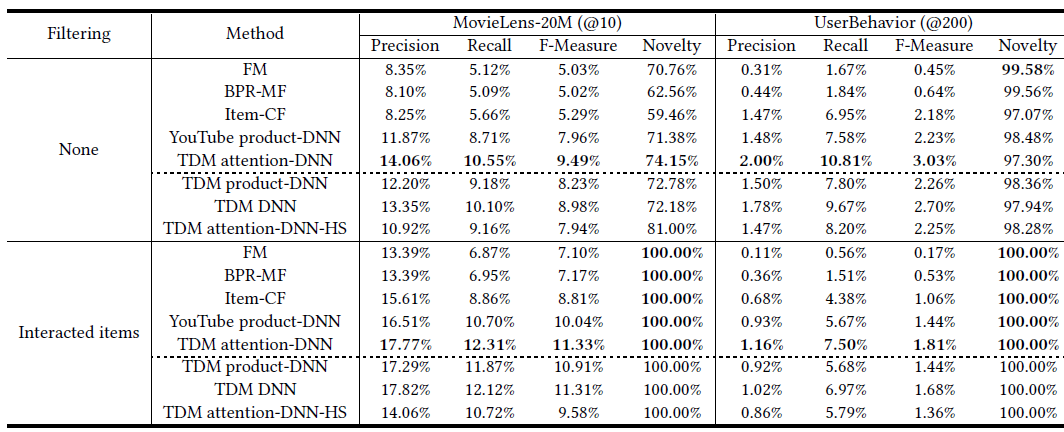

公共数据集:下表分别给出了

Movielens-1M数据集和CIKM Cup 2016数据集上不带ESAM和带ESAM的性能。Hot代表测试集中的热门item、Long-tail代表测试集中的长尾item、Entire代表测试集中的所有item。上图为Movielens-1M数据集的结果,下图为CIKM Cup 2016数据集的结果。w/o ESAM表示不带ESAM,w/ESAM表示集成了ESAM。最佳结果用黑体突出显示。可以看到:

各模型对于热门

item的性能总是远远高于长尾item,这表明热门item和长尾item的分布是不一致的。带

ESAM的单域baseline优于不带ESAM的单域baseline。- 对于个性化搜索,在

NDCG@20/Recall@20/MAP指标上,带ESAM的baseline相比不带ESAM的baseline:在热门item空间中分别绝对提升1.4%/2.1%/1.5%,在长尾item空间中分别绝对提升3.3%/3.4%/2.5%,在整个item空间中分别绝对提升2.3%/2.8%/2.3%。 - 对于

item推荐,在NDCG@20/Recall@20/MAP指标上,带ESAM的baseline相比不带ESAM的baseline:在热门item空间中分别绝对提升1.3%/1.4%/1.2%,在长尾item空间中分别绝对提升2.7%/2.0%/2.2%,在整个item空间中分别绝对提升1.8%/1.9%/1.7%。

长尾空间中的显著改善证明了

ESAM能够有效缓解长尾item的领域漂移问题,使得模型为不同的数据集和application在整个item空间中学到更好的特征。- 对于个性化搜索,在

我们发现

ESAM优于其它DA-based方法(如DALRF, DARec)。结果表明,我们设计的有区分性的领域自适应考虑了高级属性之间的相关性,并采用中心聚类和自训练来改善源区分性source discrimination和目标区分性target discrimination,从而可以有效地迁移更多的有区分性的知识discriminative knowledge。

冷启动性能

Cold-Start Performance:我们随机选择测试集中20%的记录,并从训练集中删除曝光item包含所选测试记录的所有训练记录。我们使用BST作为BaseModel,因为它在公共数据集上具有最佳性能。实验结果如下所示,可以看到:

- 由于曝光

item空间中缺少这些item,BST很难解决冷启动问题。 ESAM可以显著提升冷启动性能,因为它引入了包含冷启动item的非曝光item,从而增强特征学习。

- 由于曝光

淘宝工业数据集

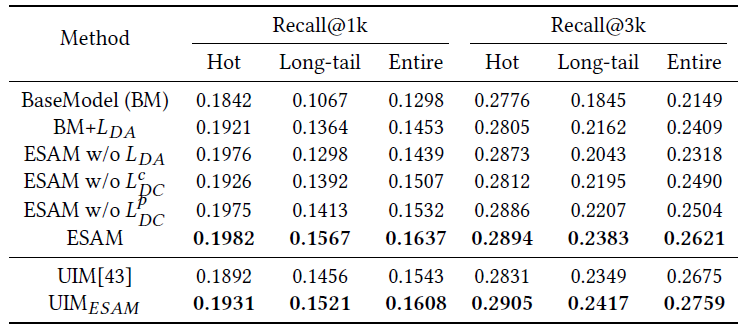

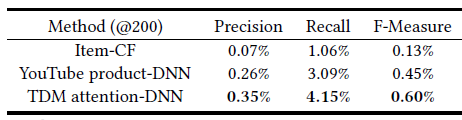

Industrial Dataset of Taobao:由于淘宝工业数据集非常大,我们采用Recall@1k和Recall@3k作为度量指标,并使用公共数据集上表现最好的BST作为消融研究的BaseModel。实验结果如下表所示,可以看到:

比较不带 和带 的方法(如

BM和 ,或者不带 的ESAM和ESAM),我们发现:A2C可以大幅度提高模型在长尾空间的性能(如平均绝对增益为+2.73%或+3.05%),这表明通过对齐aligning源域和目标域的分布可以解决长尾性能差的问题。和不带 的模型(如不带 的

ESAM)相比,采用 的模型(如ESAM)通过采用 优化源空间结构,从而在热门空间的性能尤为突出(如平均绝对增益为+0.6%或+0.7%)。此外, 使目标空间结构具有更好的簇内紧凑性

intra-class compactness和簇间可分性inter-class separability,从而提高了长尾性能(例如,平均绝对增益为+0.5%或+1.8%)。这三个约束条件的组合(即

ESAM)产生了最佳性能,这表明我们设计的三个正则项的必要性。ESAM的性能优于UIM,这表明ESAM可以抑制 ”马太效应“ 来提高长尾性能。

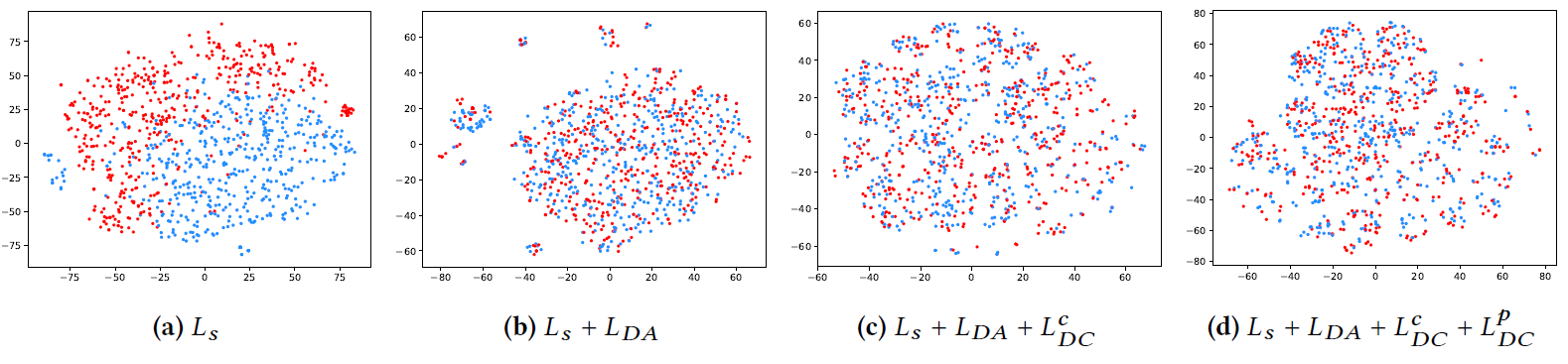

特征分布可视化

Feature Distribution Visualization:为了说明领域漂移的存在、以及我们提出的ESAM的有效性,我们随机选择了淘宝工业数据集上的2000个item,并使用t-SNE可视化了从 输出的特征。结果如下图所示,红色点代表target item、蓝色点代表source item。可以看到:- 如图

(a)所示,在源特征分布和目标特征分布之间存在domain gap。这种gap使得基于源item训练的模型无法应用于具有大量未曝光item的整个空间。 - 如图

(b)所示,我们发现 的集成可以显著降低分布之间的gap,这证明item高级属性之间的相关性可以很好地反映领域domain的分布。 - 如图

(c)所示,采用区分性的聚类discriminative clustering,特征空间将具有更好的流形结构manifold structure。 通过更好的簇内紧凑性intra-class compactness和簇间可分性inter-class separability来增强共享特征空间。 - 如图

(d)所示, 鼓励进一步的有区分性的对齐discriminative alignment。和图(c)相比,图(d)横坐标扩展为[-60,80]、纵坐标扩展为[-80, 80]。

总之,

ESAM通过区分性的领域自适应来提取领域不变的domain-invariant和有区分性的特征,使得该模型对长尾item具有鲁棒性,并且能够为用户检索更加个性化和多样化的item。

- 如图

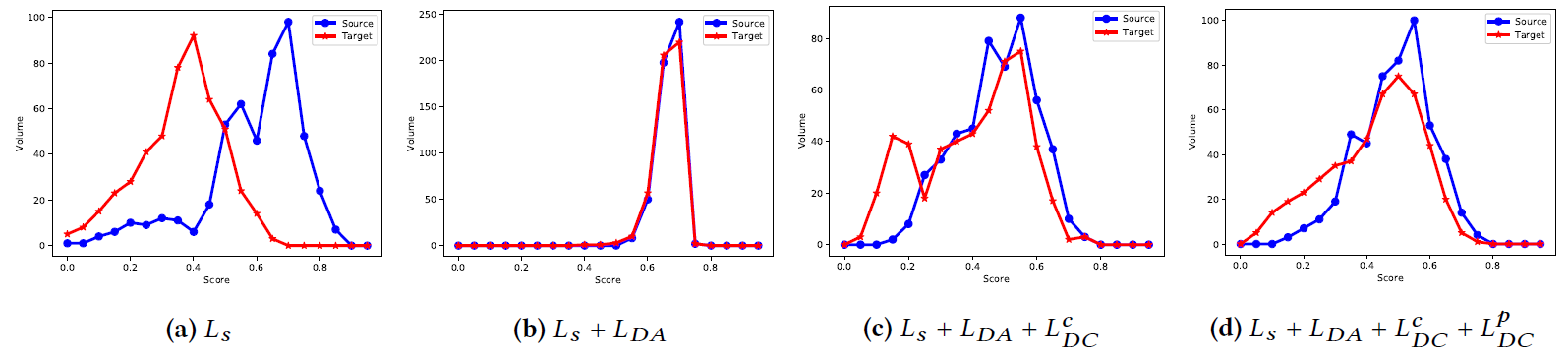

评分的分布

Score Distribution:为进一步说明ESAM可以有效优化长尾性能,我们分别从淘宝工业数据集的源域和目标域中随机各选择500个 的组合,从而可视化评分的分布。如下图所示,横坐标分数,纵坐标为评分在区间内的样本数。可以看到:根据图

(a),模型倾向于对未曝光的item给出更低的分数,使得这些item难以被检索。根据图

(b),引入 之后模型鼓励源域和目标域具有相同的分数分布,这增加了长尾item的曝光概率。但是,对齐后的分数分布过于集中,这可能导致检索不相关的

item。为了解决这个问题,我们提出的区分性的聚类鼓励分数分布具有更好的区分性对齐(图(c)和图(d))。- 如图

(c)所示,target曲线具有一个异常尖峰(在score = 0.15附近),我们认为这是由于在对齐过程中忽略了目标label从而导致了负向迁移。 - 如图

(d)所示,使用目标可靠target reliable的伪标签进行自训练可以一定程度上解决这个负向迁移问题。

- 如图

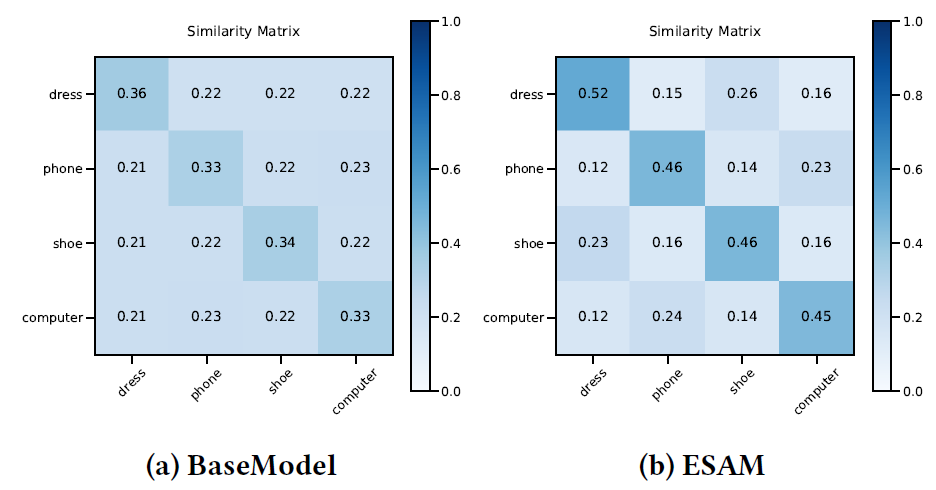

相似度矩阵

Similarity Matrix:为了证明ESAM可以学到更好的item特征representation,我们在淘宝工业数据集的整个item空间中,从每个类目(服装、电话、鞋子、计算机)中随机选择了1000个item。我们将每个类目的item平均分为两组,每组500个item。对于每一组,我们将类目中心计算为item representation的均值。然后,我们可以通过每一对中心的余弦相似度来获得相似度矩阵。结果如下图所示。可以看到:- 和

BaseModel相比,ESAM具有更大的簇内相似度和更小的簇间相似度,这表明ESAM具有更具可区分 的邻域关系。 - 此外,

ESAM抽取的相似度矩阵能够更好地反映实际情况,即服装dress和鞋子shoe的相似度高于服装dress和手机phone的相似度,而这在BaseModel中是无法体现出来的。

- 和

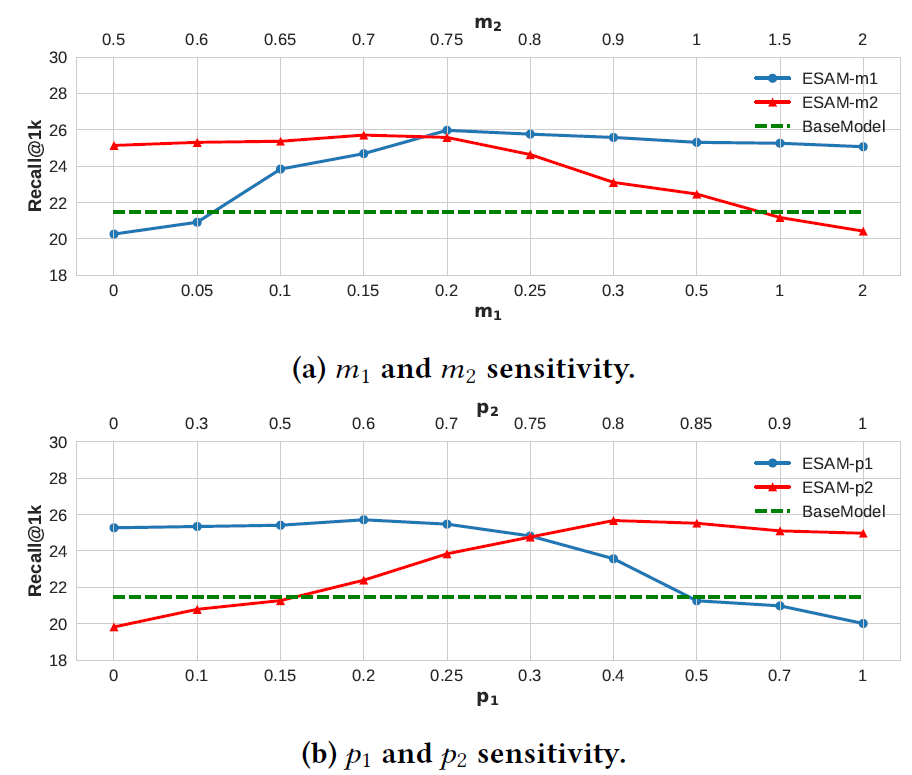

参数敏感性

Parameter Sensitivity:为了研究 的距离约束 的影响,我们考虑 以及 时,模型效果的影响。结果如下图

(a)所示。可以看到:适当的簇内和簇间距离约束可以有效地优化邻域关系,从而提高检索性能。

对于 的置信阈值 和 ,如图

(b)所示,我们发现:为低置信度样本(如 太大或 太小)分配伪标签用于自训练将会导致模型崩溃,因为大量的标签是假的。而增加置信度阈值可以提高模型的性能。这表明:带有适当约束的熵正则化可以有效地选择可靠的目标样本,从而获得更好的领域自适应性和最终性能。

在线实验

Online Experiment:我们将ESAM用于淘宝搜索引擎进行个性化搜索,并进行了在线A/B test实验。为了公平地进行比较,除了模型是否与ESAM集成以外,其他所有变量都是一致的。和

BaseModel相比,在7天内ESAM获得了0.85%的CTR增益、0.63%的collection rate(collection表示加购物车的行为)增益、0.24%的CVR增益、0.4%的GMV增益。注意,由于淘宝中的搜索引擎服务于数十亿用户,每天产生超过一千万的GMV,因此这里的性能提升对于我们的业务来说已经足够显著了。我们将其归因于通过引入未标记的未曝光输入流

input stream来减少曝光item和未曝光item之间的分布差异,从而提高了对长尾item的检索能力。总之,在线实验验证了

ESAM可以显著提升整个搜索引擎的效率。

五、Facebook Embedding Based Retrieval[2020](用于检索)

搜索引擎已经成为帮助人们在线获取海量信息的重要工具。在过去的几十年里,已经开发了各种技术来提高搜索质量,特别是在包括

Bing和Google在内的互联网搜索引擎中。由于很难从query文本中准确地计算搜索意图search intent,也很难表达文档document的语义semantic meaning,因此搜索技术大多数基于各种term匹配技术,这对于关键词keyword匹配可以解决的情况表现良好。语义匹配仍然是一个具有挑战性的问题:需要解决与

query文本不完全匹配、但是能够满足用户搜索意图的预期结果desired result。在过去几年中,深度学习在语音识别、计算机视觉、自然语言理解方面取得了重大进展。其中

embedding(也被称作representation learning)已被证明是有助于成功的技术。本质上,embedding是将id的稀疏向量表示为稠密特征向量的一种方式,这种方式也被称作语义embedding(semantic embedding),因为它通常可以学习语义semantics。一旦学到了embedding,就可以将其用作query和文档的representation,从而应用于搜索引擎的各个阶段stages。由于该技术在包括计算机视觉和推荐系统在内的其它领域获得巨大成功,因此作为下一代搜索技术,它已经成为信息检索information retrieval社区和搜索引擎行业search engine industry的一个活跃研究课题。一般而言,搜索引擎包括:

- 召回层

recall layer:旨在以低延迟low latency和低计算量low computational cost来检索一组相关relevant的文档。这也被称作检索retrieval。 - 精确层

precision layer:旨在以更复杂的算法或模型将最想要的文档排在最前面。这也被称作排序ranking。

尽管可以将

embedding应用于检索和排序,但是通常更多地利用检索层中的emebdding,因为检索层位于系统的底部,并且通常是系统的瓶颈。embedding在检索中的应用称作基于embedding的检索embedding-based retrieval: EBR。简而言之,EBR是一种使用embedding来表示query和文档,然后将检索问题转换为embedding空间中的最近邻nearest neighbor: NN搜索问题的技术。- 由于要考虑的数据规模巨大,因此

EBR在搜索引擎中是一个具有挑战性的问题。不同于通常每个session仅考虑数百个文档的排序层,检索层需要在搜索引擎的索引中处理数十亿或者数万亿个文档。巨大的规模对于embedding的训练以及embedding的serving提出了挑战。 - 其次,与计算机视觉任务中基于

embedding的检索不同,搜索引擎通常需要将基于embedding的检索和基于term匹配的检索term matching based retrieval结合起来,从而在检索层中对文档进行评分。

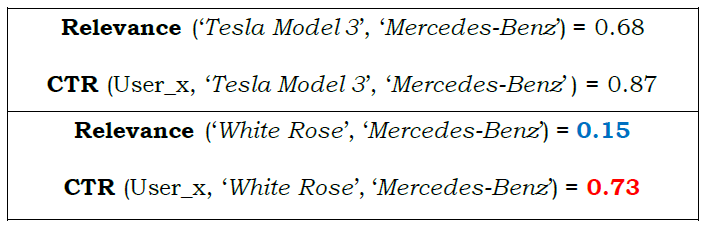

Facebook搜索作为一个社交搜索引擎,它与传统搜索引擎相比有着独特的挑战。在Facebook搜索中,搜索意图不仅取决于query文本,而且还受到发出query的用户、以及该用户所处上下文的严重影响。例如,searcher的社交图social graph就是上下文的组成部分,并且是Facebook搜索的一个特有方面unique aspect。因此,正如信息检索社区IR community中积极研究的那样,在Facebook搜索中基于embedding的检索不是文本embedding问题。相反,它是一个更复杂的问题,需要完全理解文本、用户、以及上下文。为了在

Facebook搜索中部署EBR,论文《Embedding-based Retrieval in Facebook Search》开发了一些方法来解决建模modeling、serving、和全栈full-stack优化方面的挑战。在建模中,我们提出了统一嵌入

unified embedding的方法。该模型是一种two side模型,其中一个side是包含query文本、搜索用户searcher、上下文的搜索请求search request,另一个side是文档。为了有效地训练模型,我们开发了从搜索日志中挖掘训练数据,并从搜索用户、

query、上下文和文档中抽取特征的方法。为了快速进行模型迭代,我们在离线评估集合中采用召回recall指标来比较模型。为搜索引擎构建检索模型有着独特的挑战,例如如何为模型构建具有代表性

representative的训练任务,以使其有效effectively和高效efficiently地学习。我们研究了两个不同的方向:hard mining以解决有效地effectively表示representing和学习learning检索任务。ensemble embedding以将模型划分为多个阶段stage,其中每个阶段都有不同的召回率recall和精确率precision的tradeoff。

在模型开发完成之后,我们需要开发一些方法来高效

efficiently、有效effectively地serve检索stack中的模型。虽然构建一个结合现有检索(即基于term匹配的检索)和embedding KNN的系统很简单,但是由于以下几个原因,我们发现这是次优suboptimal的:- 从我们最初的实验来看,它具有巨大的性能代价

performance cost(延迟方面)。 - 双套索引(即一套为基于

term matching、一套基于embedding)导致维护成本较高。 - 现有检索的候选

item和embedding kNN的候选item可能有很大的重叠,这使得整体效率较低。

因此,我们开发了一种混合检索框架

hybrid retrieval framework,将embedding KNN和布尔匹配Boolean Matching集成integrate在一起,从而对文档打分以进行检索。为此,我们使用Faiss库来用于embedding向量的量化quantization,并将其与基于倒排索引inverted index based的检索相集成,从而构建一个混合检索系统hybrid retrieval system。除了解决上述挑战之外,该系统还具有两个主要优点:- 它可以实现

embedding和term matching的联合优化,从而解决搜索的检索问题。 - 它支持受

term matching约束的embedding KNN,这不仅有助于解决系统性能代价system performance cost问题,而且还提升了embedding KNN结果的precision。

- 从我们最初的实验来看,它具有巨大的性能代价

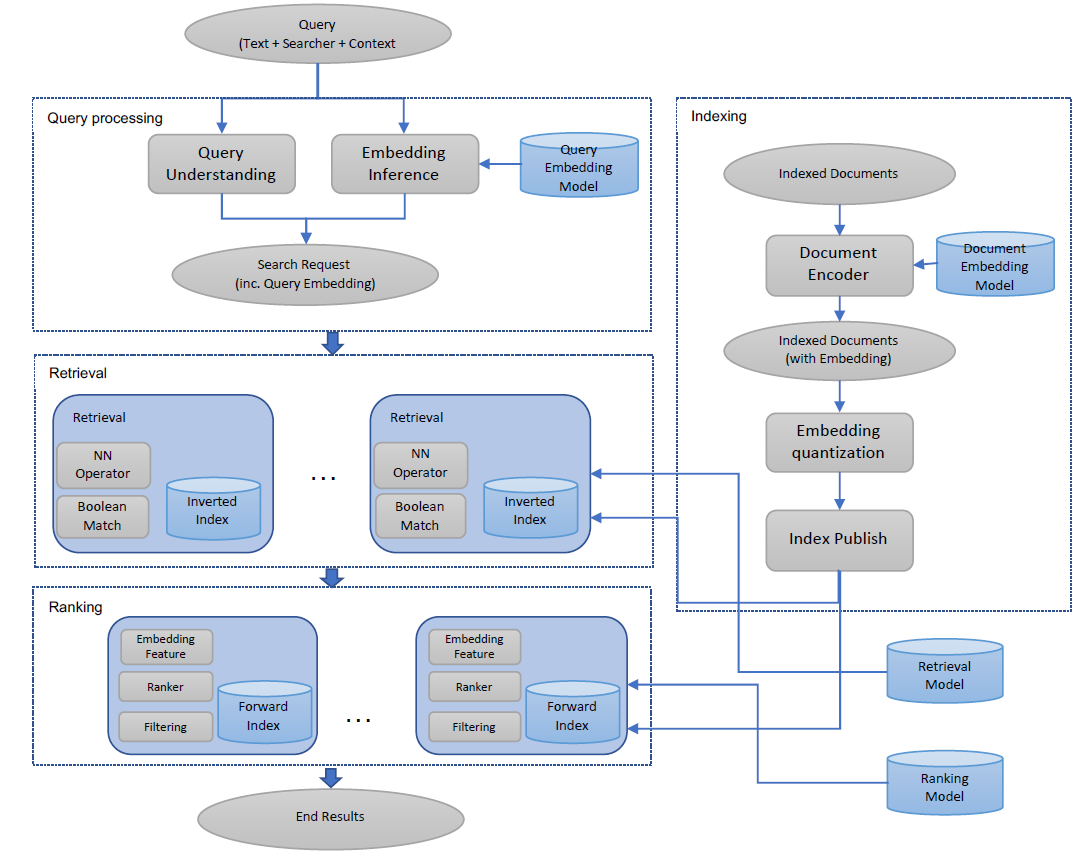

搜索是一个多阶段的排序系统

multi-stage ranking system,其中检索是第一阶段,然后是排序模型ranking models和过滤模型filtering models等各阶段。为了全局优化系统以最终返回那些新的好结果new good results并抑制新的坏结果new bad results,我们执行了后期优化later-stage optimization。具体而言,我们将embedding融合到排序层中,并建立了训练数据的反馈循环feedback loop,从而主动学习识别EBR中好的结果和坏的结果。下图中给出了EBR系统的说明。

我们使用在线

A/B test对Facebook Search的垂直领域verticals评估了EBR,并观察到显著的指标增长。我们相信本文将提供有用的洞察和经验,从而帮助人们开发搜索引擎中基于embedding的检索系统。注:搜索的垂直领域

verticals指的是哪种类型的搜索,比如搜索某个人people、某个页面page、某个群组group等。- 召回层

5.1 模型

我们将搜索的检索任务形式化为召回优化

recall optimization问题。具体而言,给定一个搜索query以及target结果集合 ,我们的目标是模型返回的top-K结果 的recall召回率最大化:其中:

target结果是基于某些准则criteria下的、与给定query相关的文档(即label)。例如,它可能是用户点击的结果,或者是基于人类评分得到的相关的文档。 为target结果集合的规模。我们将召回优化问题形式化为:基于

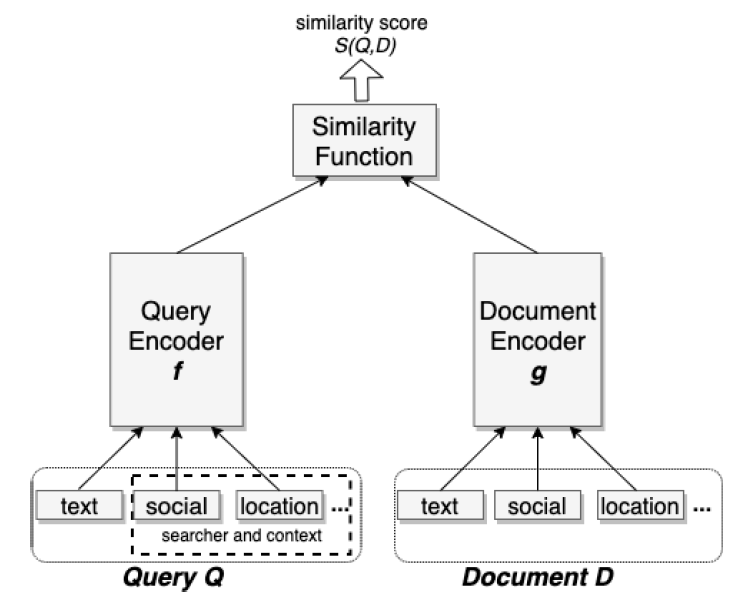

query和文档之间计算的距离的排序问题ranking problem。query和文档被神经网络模型编码为稠密向量dense vector,在此基础上我们使用余弦相似度作为距离度量。我们提出使用

triplet loss来逼近召回目标函数recall objective,从而学习神经网络编码器(也被称作embedding模型)。尽管

semantic embedding语义embedding通常被表述为信息检索中的文本embedding问题,但是对于Facebook搜索而言这是不够的。Facebook搜索是一种个性化的搜索引擎,它不仅考虑文本query,而且还考虑searcher的信息以及搜索任务中的上下文,从而满足用户的个性化信息需求。以人物搜索people search为例,虽然Facebook可能有成千上万个名为John Smith的用户资料,但是用户通过query "John Smith"搜索的实际目标人物可能是他们的朋友或熟人。为了对这个问题进行建模,我们提出了

unified embedding,该embedding不仅考虑了文本、还考虑用户和上下文信息。

5.1.1 评估指标

虽然我们的最终目标是通过在线

A/B test实现端到端的质量提升,但重要的是开发离线指标,以便在在线实验之前快速评估模型质量,并从复杂的在线实验配置中隔离isolate问题。我们提出在整个索引中运行

KNN搜索,然后使用 作为模型评估指标。具体而言,我们采样了10000个搜索session从而收集评估集合的query和target result的pair对。然后我们报告这10000个搜索session的平均recall@K指标。

5.1.2 损失函数

给定一个三元组 ,其中 是一个

query的representation, 为对应的positive文档的representation、 为对应的negative文档的representation。triplet loss定义为:其中:

- 为两个向量 和 之间的距离。

- 为

margin超参数,它是正pair对和负pair对之间的边距margin。 - 为训练集中所有的

triplet数量。

这个损失函数的直觉是:将正

pair对和负pair对分开一段距离(由 超参数指定)。我们发现调整

margin值 非常重要:最佳 值在不同训练任务中变化很大,不同的 值会导致5 ~ 10%的KNN recall方差。我们认为,使用随机样本形成负

pair对的triplet loss可以逼近召回优化任务。 理由如下:如果我们为训练数据中每个

postive样本随机采样 个negative样本,那么当候选池candidate pool大小为 时,模型将优化最头部位置的top-1召回。候选池为

n,假设池子中每个样本都是随机选择的,则候选池中有1个positive样本。假设实际

serving的候选池大小为 ,我们将优化最前面的 位置的top-K召回。候选池为

N,假设池子中每个样本都是随机选择的,则候选池中有 个postive样本。

在后续我们将验证该假设,并提供不同正、负标签定义的比较。

5.1.3 Unified Embedding Model

为了从优化

triples loss中学习embedding,我们的模型包括三个主要组件:- 一个

query encoder, 它用于根据query产生query embedding。 - 一个

document encoder,它用于根据文档D产生 文档embedding。 - 一个相似度函数

similarity function,它用于产生query和文档 之间的得分score。

下图给出了我们的

unified embedding模型架构,其中有关特征工程将在后续讨论。

- 一个

编码器

encoder是一种神经网络,可以将输入转换为低维稠密向量,也称作embedding。在我们的模型中,这两个编码器 默认是两个独立的网络,但是可以选择共享部分参数。对于相似度函数,我们选择余弦相似度,因为它是

embedding学习中常用的方法之一:因此在

triplet loss函数中定义的距离函数为:因此如果 和 相似,则它们的相似性得分较高(由余弦相似度刻画)、距离较近。可以看到 为一个

0~2之间的正数。编码器的输入是

unified embedding模型区别于传统文本embedding模型的地方。unified embedding模型编码文本特征、社交特征、以及其他有意义的上下文特征来分别表征query和文档 。例如:- 在

query side,我们可以包括searcher location以及他们的社交关系。 - 在文档侧

document side,以group搜索为例,我们可以包含有关Facebook group的聚合location以及社交群social cluster。

大多数特征都是高基数

high cardinality的离散特征,可以是one-hot或者multi-hot向量。- 对于每个离散特征,在输入编码器之前插入一个

embedding look-up layer从而学习和输出其稠密向量的representation。 - 对于

multi-hot向量,将多个embedding的加权组合从而得到最终的feature-level embedding。

- 在

5.1.4 Training Data Mining

在搜索排序系统

search ranking system中为检索任务定义positive label和negative label是一个非常重要的问题。这里我们根据模型召回率指标比较了几种选择。对于负样本,我们在初始研究中尝试了以下两种负样本选择,同时将click作为正样本:- 随机选择:对于每个

query,我们从文档库中随机采样文档作为负样本。 non-click曝光:对于每个query,我们随机采样那些在同一个session中曝光、但是未被点击的文档作为负样本。

和使用随机负样本相比,使用

non-click曝光的负样本训练的模型具有更差的模型召回率:对于people搜索的embedding模型,召回率下降了55%(绝对值,而不是相对比例)。我们认为这是因为

non-click曝光负样本倾向于hard case(可能在一个或者多个因子factor上匹配了query),而倒排索引中的大多数文档都是easy case(根本不可能匹配上query)。将所有负样本都设为hard case会改变训练数据对于真实检索任务的表示性representativeness,这可能会对学到的embedding施加不小的bias。所谓的

easy case指的是文档和query压根无关,模型很容易学到是负样本;hard case指的是文档和query有一定相关性,模型需要努力学习才知道是不是负样本。- 随机选择:对于每个

我们还尝试了多种挖掘正样本的不同方法,并有如下有趣的发现:

click:将点击的结果作为正样本是很直观的,因为点击表明用户对结果的反馈:可能与用户的搜索意图相匹配。impression曝光:我们的想法是将检索视为ranker的近似函数,但可以更快地执行。然后,我们希望设计检索模型来学习ranker相同的结果集合以及结果排列顺序。从这个意义上讲,所有用户的曝光结果对于检索模型都是正样本。即用

matching模型去逼近ranking模型:认为曝光的item都是相关的item。

我们的实验结果表明:两种定义均有效。在给定相同数据量的情况下,使用点击的模型和使用曝光的模型产生了相似的召回率。

此外,我们还尝试了使用

impression-based的数据来扩充click-based的训练数据,但是我们并未观察到相比于click-based模型的更多增益。结果表明:增加曝光数据不能提供额外的价值,模型也不能从增加的训练数据中获益。我们的上述研究表明:使用点击作为正样本、以及使用随机采样的负样本可以提供合理的模型性能。此外,我们还进一步探索了

hard mining策略,从而提高模型区分相似结果的能力。

5.2 特征工程

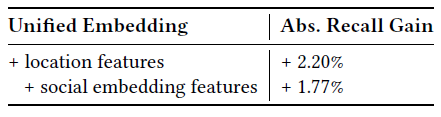

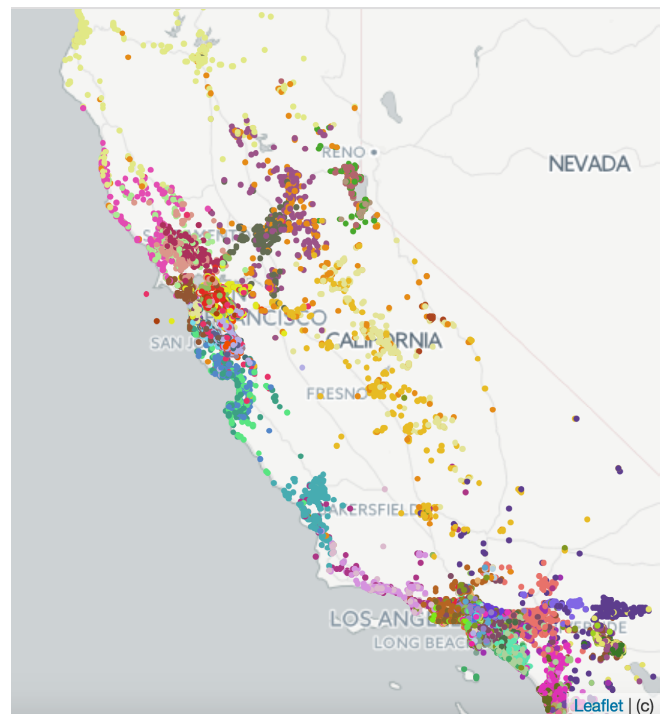

unified embedding模型的优点之一是它可以融合文本之外的各种特征,从而提高模型性能。我们在不同的垂直领域vertical观察到,unified embedding比文本embedding更有效。例如,将文本embedding切换为unified embedding之后,事件搜索events search的召回率提高了18%、群组搜索group search的召回率提高了16%。unified embedding的有效性很大程度上取决于识别和构建有信息量informative的特征的成功。下表展示了通过将每个新特征添加到group embedding模型(以文本特征为baseline)而实现的增量提升。其中Abs.Recall Gain表示绝对的召回率增益。

接下来,我们将讨论有助于提升模型效果的几个重要特征。

文本特征:字符的

n-gram是用于文本embedding的表示文本的常用方法。和单词n-gram相比,它有两个优势:- 首先,由于字符

n-gram的词典规模vocabulary size有限,因此embedding lookup table规模较小,在训练过程中可以更有效地学习。 - 其次,

subword representation对于我们在query侧(例如拼写变化或错误)和文档侧(由于Facebook中的大量内容库存content inventory)遇到的out-of-vocabulary问题是鲁棒robust的。

我们比较了使用字符

n-gram训练的模型以及使用单词n-gram训练的模型,发现前者可以产生更好的模型。但是,在字符3-gram模型的基础上,包含单词n-gram representation额外提供了较小、但是一致的模型提升(+1.5%的召回率提升)。注意,由于单词

n-gram的基数cardinality通常非常高(例如,352M的query 3-gram),因此需要哈希hashing来减少embedding lookup table的规模。但是,即使有哈希冲突的缺点,添加单词n-gram仍然提供了额外的增益。对于

Facebook实体entity,抽取文本特征的主要字段是人物实体people entity的名字、非人物实体non-people entity的标题。和布尔term匹配技术相比,我们发现使用纯文本特征训练(即没有位置特征、社交特征等非文本特征)的embedding特别擅长处理以下两种情况:- 模糊文本匹配

fuzzy text match:例如,该模型能够学习在query "kacis creations"和"Kasie’s creations"网页之间进行匹配,而基于term的匹配则无法实现。 - 可选

optionalization:在query "mini cooper nw"的情况下,模型可以通过删除"nw"以获得可选的term匹配,从而学习检索预期的、Mini cooper owner/drivers club的group。

- 首先,由于字符

位置特征

location feature:位置匹配在很多搜索场景中是有利的,例如本地商业local business、本地群组local groups、本地事件local events。为了使得embedding模型在生成输出embedding时考虑位置信息,我们在query侧和文档侧的特征中都添加了位置特征。- 在

query侧,我们抽取了searcher的城市city、地区region、国家country、以及语言language。 - 在文档侧,我们添加了公开可用的信息,例如由管理员

admin打标tag的、显示的群组位置group location。

结合文本特征,该模型能够成功学习

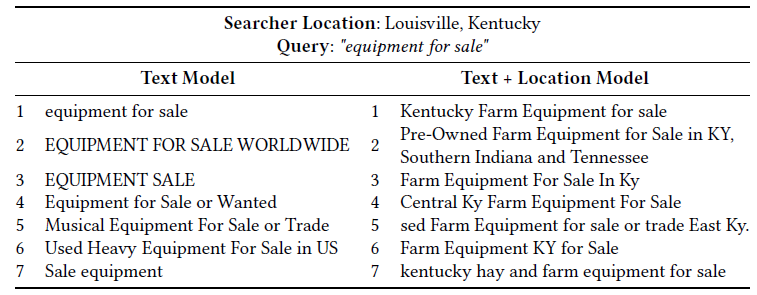

query和结果之间的隐式位置匹配location match。下表比较了文本

embedding模型和文本+位置embedding模型返回的、用于group搜索的最相似的文档。可以看到:具有位置特征的模型可以学习将位置信号融合到embedding中,将与来自Louisville、Kentucky的searcher位置相同的文档排序到更高的position。

- 在

社交

embedding特征:为了利用丰富的Facebook社交图来改善unified embedding模型,我们基于社交图训练了一个单独的embedding模型来嵌入用户和实体。这有助于将综合社交图comprehensive social graph融合到unified embedding模型,否则该模型可能没有完整的社交图信息。

5.3 Serving

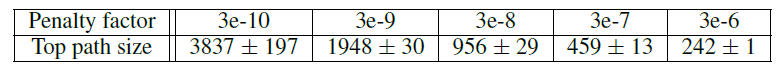

5.3.1 ANN

我们在系统中部署了基于倒排索引的

ANN(近似近邻approximate near neighbor)搜索算法,因为它具有以下优点:- 首先,由于

embedding向量的量化quantization,它具有较小的存储成本。 - 其次,更容易集成

integrate到现有的、基于倒排索引inverted index的检索系统中。

- 首先,由于

我们使用

Faiss library来量化向量,然后在我们现有的倒排表inverted table扫描系统scanning system中实现高效的最近邻搜索。embedding量化有两个主要组成部分:- 一个是粗量化

coarse quantization,它通常使用K-means算法将embedding向量量化为粗粒度的簇cluster。 - 一个是乘积量化

product quantization,它执行细粒度量化以实现embedding距离的有效计算。

- 一个是粗量化

我们需要调优几个重要参数:

粗量化

coarse quantization:粗量化有不同的算法,例如IMI和IVF算法。而且重要的是调整簇的数量num_cluster,这会影响性能和召回率。乘积量化

product quantization:乘积量化算法有多重变体,包括原始PQ、QPQ、带PCA变换的PQ。PQ的字节数pq_bytes是要调优的重要参数。乘积量化的思想是将向量空间(假设为 维)划分为 个(即

pq_bytes参数)子空间,每个子空间的维度为 。然后我们在每个子空间上聚类。假设每个子空间聚类的类别数都是 ,则每个原始向量将由 个整数来表示(称作codebook),每个整数代表某个子空间中的聚类类别。nprobe:该参数用于确定每个query embedding需要召回多少个簇,它进一步决定将扫描多少个粗簇。该参数会影响性能和召回率。

我们构建了一个离线

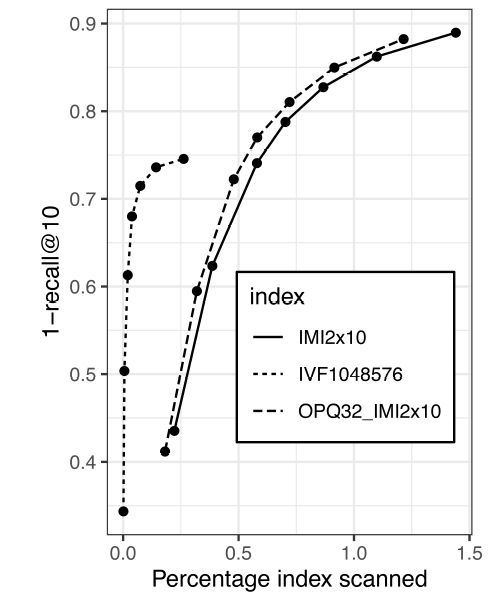

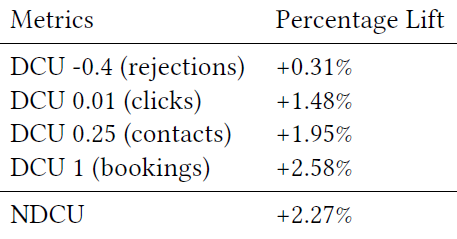

pipeline来有效地调优这些超参数。此外,我们需要进行在线实验,根据离线调优结果从选定的候选配置中确定最终配置。下面我们将分享从ANN调优中获得的经验和技巧:基于扫描的文档数量调优召回率。最初,我们比较了相同

num_cluster和相同nprobe下,不同粗量化算法的召回率。但是,通过更多的数据分析我们发现:簇

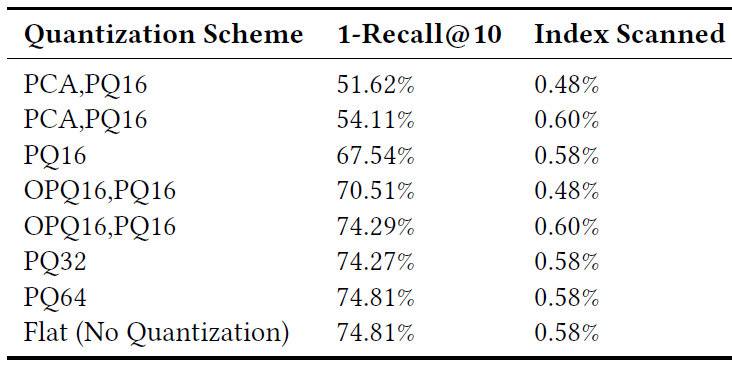

cluster是不平衡的imbalanced,特别是对于IMI算法而言大约一半的簇仅有几个样本。对于相同num_cluster和相同nprobe的配置下,这将导致扫描文档的数量不同。因此,我们将扫文档数量(而不是簇的数量)作为更好的指标来近似approximateANN调优中的性能影响,如下图所示。我们使用

1-recall@10来度量ANN的准确率accuracy,这是根据准确的KNN搜索的top结果在ANN搜索top-10结果中的召回率。即:

KNN搜索得到top-1结果,然后看这个top-1结果是否在ANN搜索的top-10列表中。

当模型发生重大变化时,调优

ANN的超参数。我们观察到,ANN的性能和模型特性characteristics有关。例如,当我们将集成技术ensemble technique用于non-click曝光训练的模型时,我们发现:虽然模型显示出比baseline更好的召回率,但是在对两者应用量化之后,模型召回率比baseline更差。当模型训练任务发生重大变化时,例如增加更多的

hard负样本,应该始终考虑调优ANN超参数。始终尝试

OPQ。在应用量化之前对数据进行转换通常很有用。我们用PCA和OPQ对数据进行了转换,发现OPQ通常更有效,如下表和下图所示,其中采用128维的embedding。OPQ的一个警告是:由于OPQ应用了embedding的旋转,我们可能还需要重新调优num_cluster和nprobe才能有类似的文档扫描。

选择

pq_bytes为d/4。乘积量化器product quantizer将向量压缩为 个字节码。对于 的选择,它与embedding向量的维度 有关: 越大,搜索准确率search accuracy越高,但代价是内存和延迟的增加。从经验结果来看,我们发现 之后,准确率提升有限。在线调优

nprobe, num_clusters, py_bytes以了解实际的性能影响。虽然离线调优ANN算法和参数以合理了解性能和召回率之间的tradeoff很重要,但是我们发现同样很重要的一点是:在线部署ANN算法和参数的若干个配置,从而更好地了解从embedding-based检索、到实际系统的性能影响。这对于确定容量预算capacity budget,并减少离线调优中的参数搜索范围非常重要。

5.3.2 系统实现

为了将

EBR集成integrate到我们的serving stack中,我们在Unicorn中实现了对最近邻搜索的first-class支持。Unicorn是为Facebook上大多数搜索产品提供支持的检索引擎retrieval engine。Unicorn将每个文档表示为bag of terms,这些term是表示文档二元属性binary property的任意字符串,通常使用属性的语义来命名。例如:居住在西雅图的用户John的term为:text:john和location:seattle。term可以附加有效载荷payload。query可以是term的任何布尔表达式。例如,以下query将返回名字中有john和smithe、并且居住在Seattle(西雅图)或者Menlo Park(门罗公园)的人:1(and (or (term location:seattle)2(term location:menlo_park))3(and (term text:john)4(term text:smithe))5)为了支持最近邻,我们扩展了

document representation从而包括文档embedding。每个文档embedding都有一个预先固定的字符串关键字,并在query侧添加了一个nn<key>: radius <radius>的query operator。这个query operator匹配<key> embedding在query embedding指定半径内的所有文档。其中<key>就是预先固定的字符串关键字,如model-141795009(模型版本号)。在索引时,每个文档

embedding被量化并转换成一个term(针对粗聚类)和一个有效载荷(针对量化的残差)。在查询时,

(nn)在内部被重写为term之间的(or)的规则。这些term关联那些与query embedding最接近的coarse clusters(即(probes))。然后对于匹配的文档, 检索term的playload以验证半径约束。probes的数量可以用一个额外的属性来指定:: nprobe。

通过根据已经存在的原语

primitives实现最近邻支持,而不是编写一个单独的系统,我们继承了现有系统的所有功能,例如实时更新、高效的查询计划query planning和执行、以及对multi-hop query的支持。multi-hop query使我们能够支持基于top-K的最近邻query,其中我们只选择最接近query的K个文档,而不是通过半径进行匹配。然后评估query的剩余部分。然而,从我们的实验研究中我们发现:半径模式可以更好地权衡

tradeoff系统性能和结果质量。一个可能的原因是:半径模式支持受约束的最近邻搜索(受匹配表达式的其它部分约束),但是top K模式提供了更宽松的操作more relaxed operation,该操作需要扫描整个索引来获得top K的结果。因此,我们在当前产品中使用基于半径的匹配。混合检索

Hybrid Retrieval:通过将(nn) operator作为布尔查询语言的一部分,我们现在可以支持混合检索表达式,将embedding和term任意组合。这可用于基于模型的模糊匹配fuzzy matching,该模型可以改善拼写变体spelling variation、可选化optionalization等情况,并且重用和受益于检索表达式的其它部分。例如,假设一个拼写错误的

query "john smithe"意图寻找一个位于Seattle或者Menlo Park的、名叫john smith的用户,那么检索表达式类似于上面的表达式。该表达式将无法检索目标用户,因为termtext:smithe和该文档不匹配。我们可以通过(nn) operator为该表达式添加模糊匹配:xxxxxxxxxx61(and (or (term location:seattle)2(term location:menlo_park))3(or (and (term text:john)4(term text:smithe)))5(nn model-141795009 :radius 0.24 :nprobe 16))6)其中,

model-141795009是embedding的键。在这种情况下,如果

query "john smithe"的embedding与文档"john smith"的embedding之间余弦距离小于0.24,则目标用户将被检索。Model Serving:我们通过以下方式来serve embedding模型。在训练好two-sidedembedding模型之后,我们将该模型分解为query embedding模型和document embedding模型,然后分别独立地serve这两个模型。- 对于

query embedding,我们将模型部署在online embedding inference service从而进行实时推断。 - 对于

document embedding,我们使用Spark在离线状态下batch地进行模型推断,然后将生成的embedding内容与其它元数据metadata一起发布到正排索引forward index中。

我们还进行了额外的

embedding量化,包括粗量化和PQ,并将其发布到倒排索引inverted index中。- 对于

5.3.3 Query and Index Selection

为了提高

EBR的效率和质量,我们执行了query和索引选择query and index selection。在

query选择方面:我们应用query选择技术来克服诸如过度触发over-triggering、巨大的容量成本capacity cost、以及垃圾增加junkiness increase等问题。我们并未针对某些

query触发EBR,因为EBR在这些query上的优势很弱,并且无法提供任何额外的价值。例如考虑以下两类场景:searcher正在搜索之前已经被搜索过的、或者点击过的特定目标。query意图和embedding模型训练的意图明显不同的情况。

在索引选择方面:我们进行了索引选择,从而加快索引速度。例如,我们仅选择每月活跃用户、最近事件

event、热门页面page、热门的group。

5.4 后期优化

Facebook的搜索排序是一个复杂的多阶段排序系统multi-stage ranking system,其中每个阶段逐步精细化refine前一阶段的结果。该stack的最底部是检索层retrieval layer,这里应用了EBR。检索层的结果随后被一组ranking layer进行排序和过滤。每个阶段的模型都应该针对前一层返回的结果的分布进行优化。然而,由于当前的排序阶段是为现有检索场景设计的,这可能导致从