一、BST [2019]

《Behavior Sequence Transformer for E-commerce Recommendation in Alibaba》

在过去的十年中,推荐系统已经成为业界最流行的

application。并且在过去的五年中,基于深度学习的方法已经广泛应用于工业推荐系统中。在中国最大的电商平台阿里巴巴上,推荐系统一直是Gross Merchandise Volume: GMV和收入的主要引擎,并且在丰富的电商场景中已经部署了各种基于深度学习的推荐方法。阿里巴巴的推荐系统分为两个阶段:

match和rank。在

match阶段,根据和用户交互的item选择一组相似的item。然后在

rank阶段,我们学习一个经过微调(fine-tuned)的预测模型,从而预测用户点击给定候选item集合的可能性。

在论文

《Behavior Sequence Transformer for E-commerce Recommendation in Alibaba》中,我们重点关注阿里巴巴旗下淘宝(中国最大的Consumer-to-Consumer: C2C平台)的rank阶段。在这个阶段,我们有数百万的候选item,并且需要在给定用户历史行为的情况下预测用户点击候选item的概率。在深度学习时代,

embedding和MLP已经成为工业推荐系统的标准范式:大量原始特征作为向量被嵌入到低维空间中,然后馈入称作多层感知机(multi layer perceptron: MLP)的全连接层中,从而预测用户是否会点击某个item。代表作是谷歌的wide and deep learning: WDL,以及阿里巴巴的Deep Interest networks: DIN。在淘宝,我们在

WDL的基础上构建了rank模型,在Embedding&MLP范式中使用了各种特征。例如,item类目(category)、品牌(brand),item的统计数字,用户画像特征等等。尽管该框架取得了成功,但是它本身远远不能令人满意,因为它实际上忽略了一种非常重要的信号:用户行为序列(即用户按顺序点击的item)背后的序列信号(sequential signal)。例如,用户在淘宝上购买了

iphone之后倾向于点击手机保护套,或者在购买一条裤子之后试图找到合适的鞋子。从这个意义上讲,在淘宝的rank阶段部署预测模型时,不考虑这一因素是有问题的。在

WDL中,模型只是简单地拼接所有特征,而没有捕获用户行为序列中的顺序信息(order information)。在

DIN中,模型使用注意力机制来捕获候选item和用户历史点击item之间的相似性,也没有考虑用户行为序列背后的序列性质(sequential nature)。

因此,在这项工作中,为解决

WDL和DIN面临的上述问题,我们尝试将用户行为序列的序列信号融合到淘宝的推荐系统中。受到

natural language processing: NLP中机器翻译任务的Transformer的巨大成功的启发,我们采用self-attention机制,通过考虑embedding阶段的序列信息来学习用户行为序列中每个item的更好的representation。然后将这些item representation馈入到MLP中来预测用户对候选item的响应。Transformer的主要优势在于,它可以通过self-attention机制更好地捕获句子中单词之间的依赖关系。从直觉上讲,用户行为序列中item之间的'dependency'也可以通过Transformer来提取。因此,我们在淘宝上提出了用于电商推荐的user behavior sequence transformer: BST。离线实验和在线

A/B test显示了BST与现有方法相比的优越性。BST已经部署在淘宝推荐的rank阶段,每天为数亿消费者提供推荐服务。相关工作:自从

WDL提出以来,人们已经提出了一系列基于深度学习的方法来提高CTR预估的工作,如DeepFM、XDeepFM、Deep and Cross等。然而,所有这些先前的工作都集中在神经网络的特征组合或不同架构上,而忽略了现实世界推荐场景中用户行为序列的顺序特性(sequential nature)。最近,

DIN通过注意力机制来处理用户的行为序列。我们的模型和DIN之间的主要区别在于,我们提出使用Transformer来学习用户行为序列中每个item的更deeper的representation,而DIN试图捕获历史点击item和目标item的相似性。换句话讲,我们的transformer模型更适合捕获序列信号。在

《Self-attentive sequential recommendation》和《BERT4Rec: Sequential Recommendation with Bidirectional Encoder Representations from Transformer》中,他们使用Transformer模型来以sequence-to-sequence的方式解决序列推荐问题,而我们的CTR预估模型与他们的架构不同。

1.1 模型

在

rank阶段,我们将推荐任务建模为点击率(Click-Through Rate: CTR)预估问题,其定义如下:给定用户item构成的用户行为序列itemitem) 的概率。我们在

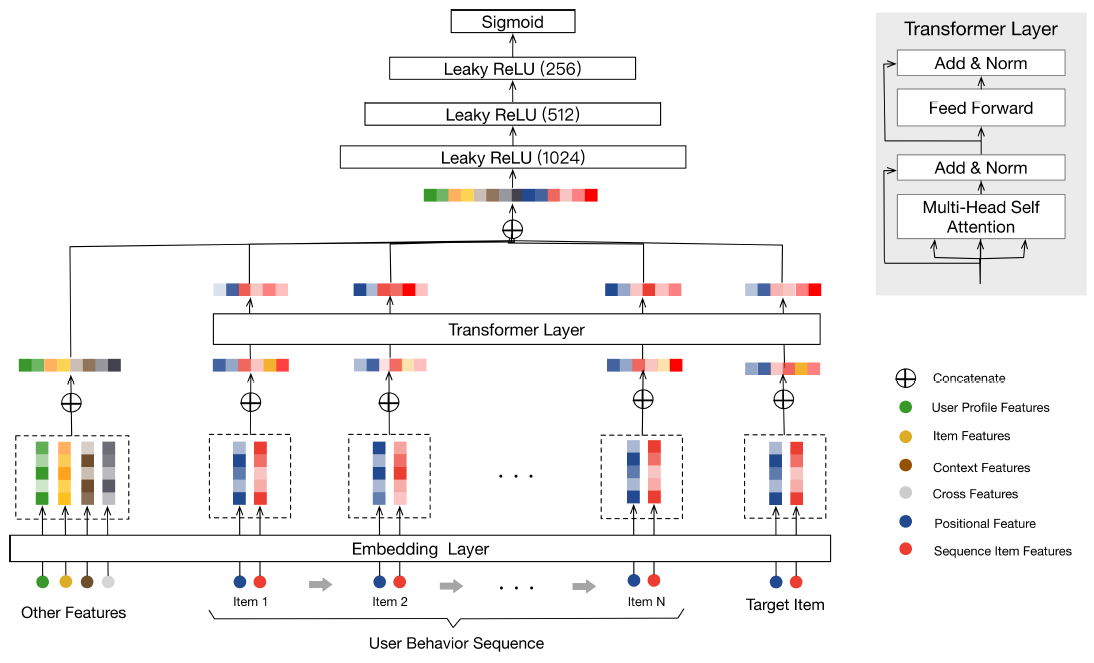

WDL的基础上构建了BST,整体架构如下图所示。从图中可以看到BST遵循流行的Embedding&MLP范式,其中历史点击item和相关的特征首先被嵌入到低维向量中,然后被馈送到MLP。具体而言,

BST将用户行为序列(包括target item和其它特征Other Features)作为输入。其中Other Features包括:用户画像特征、上下文特征、item特征、以及交叉特征。首先,这些输入特征被嵌入为低维向量。为了更好地捕获行为序列中

item之间的关系,可以使用transformer layer来学习序列中每个item的更深层representation。然后,通过将

Other Features的embedding和transformer layer的输出进行拼接,并使用三层MLP来学习hidden features的交互作用。最后,使用

sigmoid函数生成最终输出。

注意:

Positional Features被合并到Sequence Item Features中。BST和WDL之间的主要区别在于:BST添加了transformer layer,从而通过捕获底层的序列信号来学到用户点击item的更好的representation。接下来的内容我们将以自下而上的方式介绍

BST的关键组件:embedding layer、transformer layer、MLP。

1.1.1 Embedding Layer

第一个组件是

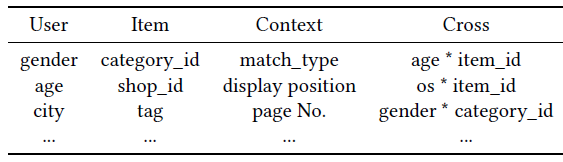

embedding layer,它将所有输入特征嵌入到一个固定大小的低维向量中。在我们的场景中有各种特征,如用户画像特征、

item特征、上下文特征、以及不同特征的组合(即交叉特征)。由于我们的工作聚焦于使用transformer对用户行为序列进行建模,因此为简单起见我们将所有这些特征都表示为Other Features,并在下表中给出了一些示例。我们将

Other Features拼接起来,将它们嵌入到低维向量中。对于这些特征,我们创建一个embedding矩阵embedding向量的维度,uniqe特征数量。

此外,我们还获得了用户行为序列中每个

item(包括目标item)的embedding。我们使用两种类型的特征来表示一个item:Sequence Item Features(红色)、Positional Features(深蓝色)。Sequence Item Features包括item id和category id。注意,一个

item往往具有数百个特征,而在用户行为序列中选择item的所有这些特征代价太大。正如我们先前的工作《Billion-scale commodity embedding for e-commerce recommendation in alibaba》所述,item id和category id足以满足性能要求。因此我们选择这两个稀疏特征来表示嵌入用户行为序列中的每个item。Positional Features对应于下面的positional embedding。

对于每个

item,我们将Sequence Item Features和Positional Features拼接起来,并创建一个embedding矩阵embedding向量的维度,item数量。我们使用item的embedding。

positional embedding:在《Attention is all you need》中,作者提出了一种positional embedding来捕获句子中的顺序信息(order information)。同样地,顺序(order)也存在于用户行为序列中。因此,我们添加position作为bottom layer每个item的输入特征,然后将其投影为低维向量。注意,

itemposition value计算为:其中:

target item,item。recommending time),而item

我们采用这种方法,因为在我们的场景中,它的性能优于

《Attention is all you need》中的sin和cos函数。

1.1.2 Transformer Layer

这一部分,我们介绍了

Transformer layer,它通过捕获行为序列中每个item与其它item的关系来学习item的更深deeper的representation。self-attention layer:缩放的内积注意力(scaled dot-product attention)定义为:其中:

query,key,value。在我们的场景中,

self-attention操作将item的embedding作为输入,通过线性映射将其转换为三个矩阵,并将其馈入attention layer。遵从

《Attention is all you need》,我们使用multi-head attention:其中:

item的embedding矩阵。head数量。

Point-wise Feed-Forward Network:遵从《Attention is all you need》,我们添加一个point-wise Feed-Forward Network:FFN来进一步提升模型的非线性,它定义为:为避免过拟合并且学习层次的有意义的特征,我们同时在

self-attention和FFN中使用dropout和LeakyReLU。然后self-attention layer和FFN layer的总输出为:其中:

normalization layer。

Stacking the self-attention blocks:在第一个self-attention block之后,它会聚合所有历史item的embedding。为了进一步建模底层item序列的复杂关系。我们堆叠了self-attention building block,其中第block定义为:实践中我们观察到

1.1.3 MLP Layer & Loss Function

我们将

Other Features的embedding和应用于target item的Transformer layer的输出进行拼接,然后使用三个全连接层来进一步学习这些dense features之间的交互。这是工业推荐系统的标准做法。为了预测用户是否点击

target itemsigmoid函数作为输出单元。为了训练模型,我们使用交叉熵损失函数:

其中:

label。sigmoid单元之后的输出,代表样本

1.2 实验

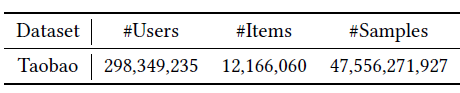

数据集:数据集是根据

Taobao App的日志来构建的。我们根据用户在八天内的行为来构建离线数据集,其中前七天用于训练集、第八天用于测试集。数据集的统计信息如下表所示,可以看到该数据集非常大并且非常稀疏。

baseline:为了显示BST的有效性,我们将它和其它两个模型进行比较:WDL和DIN。此外,我们通过将序列信息合并到

WDL(称作WDL(+Seq))中来创建baseline方法,该方法将历史点击item的embedding进行均值聚合。我们的框架是在

WDL的基础上通过使用Transformer添加序列建模而构建的,而DIN是通过注意力机制来捕获目标item和历史点击item之间的相似性。评估指标:

对于离线结果,我们使用

AUC得分来评估不同模型的性能。对于在线

A/B test,我们使用CTR和平均RT来评估所有模型。RT是响应时间(response time: RT)的缩写,它是给定query(即淘宝上来自用户的一个请求)生成推荐结果的时间成本。我们使用平均RT来衡量在线生产环境中各种效率的指标。

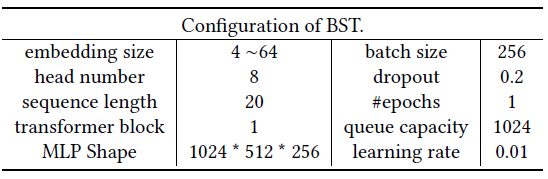

配置:我们的模型是使用

Python2.7和Tensorflow 1.4实现的,并且选择了Adagrad作为优化器。此外,我们在下表中给出了模型参数的详细信息。

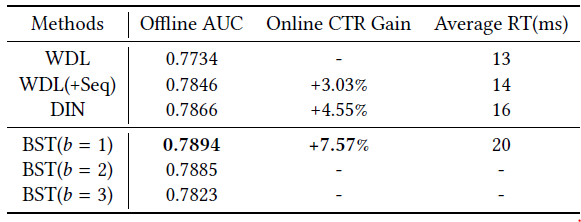

实验结果如下表所示,其中

Online CTR Grain是相对于控制组(control group)(即WDL)。从结果中我们可以看到BST相比于baseline的优越性。具体而言:离线

AUC从0.7734(WDL)和0.7866(DIN) 提高到0.7894(BST)。比较

WDL和WDL(+Seq)时,我们可以看到以简单的平均方式结合序列信息的有效性。这意味着BST在self-attention的帮助下,具有强大的能力来捕获底层用户行为序列的序列信号。注意:根据我们的实际经验,即使离线

AUC的收益很小,也可以带来在线CTR的巨大收益。Google的研究人员在WDL中报道了类似的现象。此外,就效率而言,

BST的平均RT接近WDL和DIN的平均RT,这保证了在现实世界的大型推荐系统中部署诸如Transformer之类的复杂模型的可行性。最后,我们还展示了堆叠

self-attention layer的影响。可以看到AUC。这可能是由于以下事实:用户行为序列中的序列依赖性并不像机器翻译任务中的句子那样复杂。因此,较少的

block数量就足以获得良好的性能。在《Self-attentive sequential recommendation》中报道了类似的观察结果。因此,我们选择BST,并且仅在下表中报告CTR增益。