一、Fi-GNN [2019]

《Fi-GNN: Modeling Feature Interactions via Graph Neural Networks for CTR Prediction》

建模复杂的特征交互,对

CTR预测的成功起到了核心作用。FM是一个著名的模型,它通过向量内积来建模二阶特征交互。FFM进一步考虑了field信息并引入了field-aware embedding。然而,这些FM-based模型只能建模二阶交互。最近,许多基于深度学习的模型被提出来从而学习高阶特征交互,这些模型遵循一个通用的范式:简单地拼接

field embedding向量,并将其馈入DNN或其他专门设计的模型,从而学习交互。例如FNN, NFM, Wide&Deep, DeepFM等。然而,这些基于DNN的模型都是以bit-wise的、隐式的方式来学习高阶特征交互,这缺乏良好的模型解释。一些模型试图通过引入专门设计的网络来显式地学习高阶交互。例如,

Deep&Cross引入了Cross Network: CrossNet,xDeepFM引入了压缩交互网络(Compressed Interaction Network: CIN)。尽管如此,它们仍然不够有效和显式,因为它们仍然遵循将feature field组合在一起的通用范式来建模交互。简单的unstructured combination将不可避免地限制了灵活地、显式地建模不同feature field之间复杂交互的能力。在论文

《Fi-GNN: Modeling Feature Interactions via Graph Neural Networks for CTR Prediction》中,作者考虑了multi-field feature的结构。具体来说,作者用一个名为feature graph的图结构来表示multi-field feature。直观而言,图中的每个节点对应于一个feature field,不同field可以通过边进行交互。因此,建模feature field之间复杂交互的任务可以转化为建模feature graph上的节点交互的任务。为此,作者在Graph Neural Network: GNN的基础上设计了一个新的Feature interaction Graph Neural Network: Fi-GNN,它能够以灵活的、显式的方式建模复杂的节点交互(即,特征交互)。在Fi-GNN中,节点将通过与邻居节点交流node state来进行交互,并以recurrent的方式更新自己。AutoInt用Transformer Encoder Block建模multi-field feature,而这里用GNN来建模multi-field feature。Transformer Encoder Block可以视为一个简单的GNN。在每一个

time step中,模型与邻居节点进行one-hop的交互。因此,interaction step的数量等同于特征交互的阶次。此外,在feature graph中,边的权重反映了不同feature interaction对于CTR预测的重要性,而节点的权重反映了每个feature field对于CTR预测的重要性。这可以提供很好的解释。总的来说,论文提出的模型能够以显式的、灵活的方式建模复杂的特征交互,并提供良好的可解释性。论文贡献如下:

论文指出了现有工作的局限性,即把

multi-field feature视为feature field的unstructured combination。为此,作者首次提出用图结构来表示multi-field feature。论文设计了一个新的模型

Feature interaction Graph Neural Network: Fi-GNN,从而以更灵活的、显式的方式建模graph-structured feature上feature field之间的复杂交互。论文在两个真实世界的数据集上进行的广泛实验表明:所提出的方法不仅可以超越

SOTA的方法,而且可以提供良好的模型解释。

相关工作:

Feature Interaction in CTR Predict:建模特征交互是CTR预测成功的关键,因此在文献中得到了广泛的研究。LR是一种线性方法,它只能对原始单个特征的线性组合建模一阶交互。FM通过向量内积来建模二阶特征交互。之后,FM的不同变体也被提出:Field-aware factorization machine: FFM考虑了field信息并引入了field-aware embedding。AFM考虑了不同二阶特征交互的权重。

然而,这些方法只能建模二阶交互,这是不够的。

随着

DNN在各个领域的成功,研究人员开始用它来学习高阶特征交互,因为它有更深的结构和非线性激活函数。一般的范式是将field embedding向量拼接在一起,并将其馈入DNN来学习高阶特征交互。《A convolutional click prediction model》利用卷积网络建模特征交互。FNN在应用DNN之前,在field embedding上使用预训练的FM。PNN通过在field embedding layer和DNN layer之间引入一个product layer来建模二阶交互和高阶交互。类似地,

NFM通过在field embedding layer和DNN layer之间引入一个Bi-Interaction Pooling layer来建模二阶交互,但是随后的操作是sum操作,而不是像PNN中的拼接操作。

另一个方向上的一些工作试图通过混合架构来联合建模二阶交互和高阶交互:

Wide&Deep和DeepFM包含一个wide组件来建模低阶交互、一个deep组件来建模高阶交互。然而,所有这些利用

DNN的方法都是以隐式的、bit-wise的方式学习高阶特征交互,因此缺乏良好的模型解释能力。 最近,一些工作试图通过专门设计的网络以显式的方式学习特征交互:Deep&Cross引入了一个在bit-level上对特征进行外积的CrossNet。相反,

xDeepFM引入了一个在vector-level对特征进行外积的CIN。

然而,他们仍然没有解决最根本的问题,即把

field embedding向量拼接起来。对

feature field进行简单的unstructured combination将不可避免地限制了以灵活的、显式的方式建模不同field之间复杂交互的能力。为此,我们提出用图结构表示multi-field feature,每个节点代表一个field,不同的feature field可以通过边进行交互。因此,我们可以在图上建模不同feature field之间的灵活交互。Graph Neural Network:图是一种数据结构,它对一组对象(节点)和它们的关系(边)进行建模。早期的工作通常将图结构的数据转换成序列结构的数据来处理。无监督的

DeepWalk算法受word2vec的启发,用于学习基于random walk的node embedding。之后,

LINE算法保留了图的一阶结构信息和二阶结构信息。node2vec引入了一个有偏的随机行走。

然而,这些方法的计算成本很高,而且对于大型图而言也不是最优的。图形神经网络(

graph neural network: GNN)就是为了解决这些问题而设计的,它是基于深度学习的方法,在graph domain上运行。现在已经有很多GNN的变种,这里我们只介绍一些有代表性的经典方法:Gated Graph Neural Network: GGNN使用GRU作为更新器。Graph Convolutional Network: GCN考虑了图的spectral structure并利用卷积聚合器。GraphSAGE考虑了空间信息,并引入了三种聚合器:mean aggregator, LSTM aggregator, Pooling aggregator。graph attention network: GAT将注意力机制纳入消息传播步骤。

由于

GNN具有令人信服的性能和较高的可解释性,GNN已经成为一种广泛应用的图分析方法。在这项工作中,我们提出了一个基于GGNN的模型Fi-GNN来为CTR预测建模特征交互。

1.1 模型

假设训练数据集由

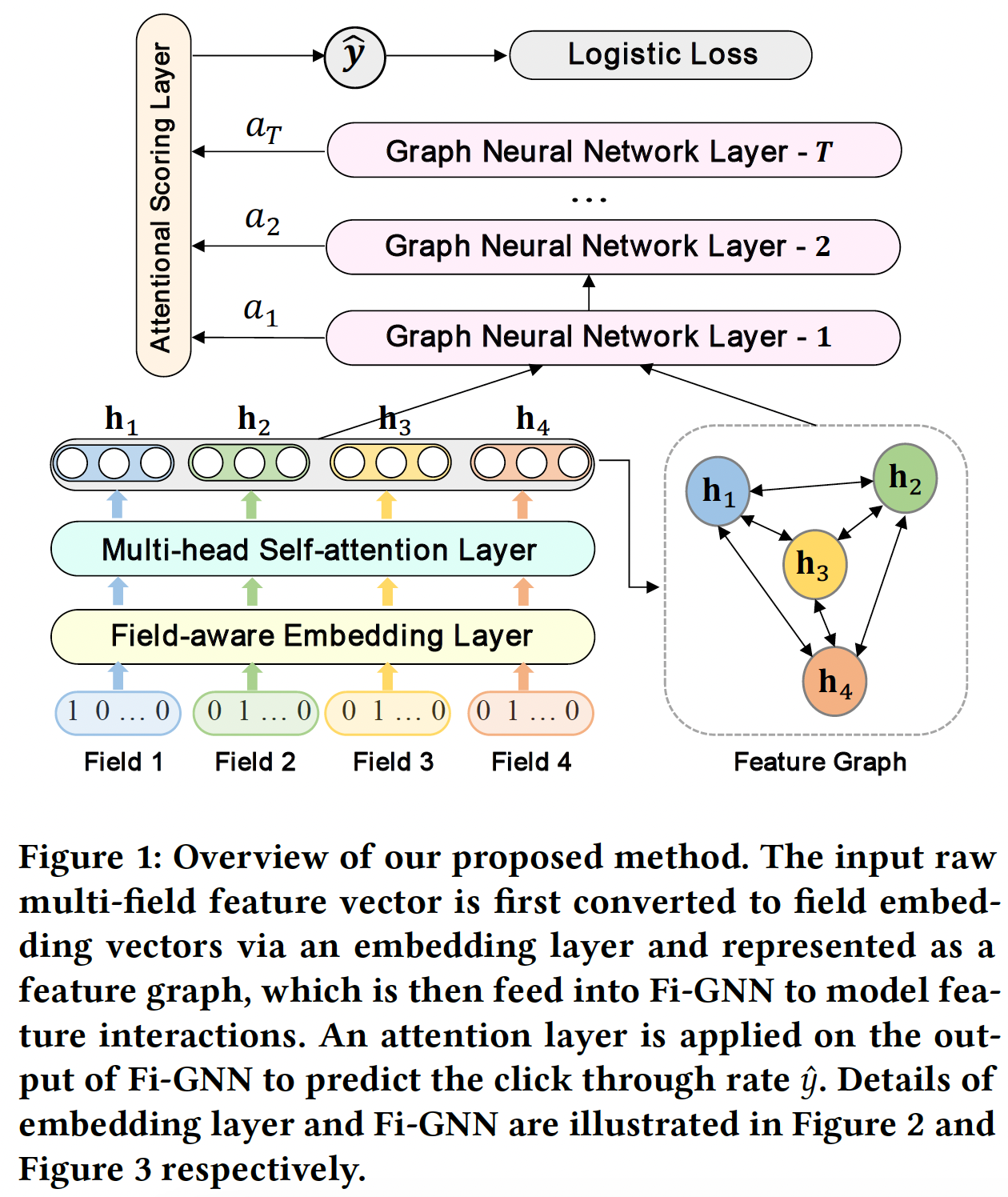

field的categorical feature、以及表示用户点击行为的labelCTR预测任务是对输入特征(包含field)来预测用户点击的概率下图是我们所提出方法的概览(

输入的

sparse m-field feature vector首先被映射成稀疏的one-hot向量,然后通过embedding layer和multi-head self-attention layer嵌入到稠密的field embedding向量中。然后,

field embedding向量被表示为一个feature graph,其中每个节点对应于一个feature field,不同的feature field可以通过边进行交互。因此,建模交互的任务可以转换为建模feature graph上的节点交互。因此,feature graph被馈入Fi-GNN从而建模节点交互。最后,在

Fi-GNN的输出上应用一个Attentional Scoring Layer来估计点击率

这里的

Multi-head Self-Attention Layer就是单层的AutoInt,因此,Fi-GNN相当于是AutoInt和GNN的堆叠。实验并没有表明AutoInt在这里的贡献,而且即使是AutoInt + Fi-GNN,模型在所有数据集上的整体效果提升也不明显,因此论文价值不大。

Embedding Layer:我们将每个field表示为一个ont-hot encoding向量,然后将其嵌入到一个稠密向量中,记做field embedding向量 。field的field embedding向量被拼接为(沿着feature field维度拼接):其中:

fieldembedding向量,field embedding向量的维度,feature field维度拼接。Multi-head Self-attention Layer:我们利用多头自注意力机制来捕获不同语义子空间中的pairwise特征交互。遵从

《AutoInt: Automatic Feature Interaction Learning via Self-Attentive Neural Networks》,给定feature embedding矩阵feature representation,它覆盖了attention headpairwise interaction:其中:

attention headhead然后,我们将学到的每个

head的feature representation结合起来,以保留每个语义子空间中的pairwise feature interaction:其中:

embedding维度),attention head数量,embedding维度。Feature Graph:与以往简单地将field embedding向量拼接在一起并将其馈入模型中从而学习特征交互所不同的是,我们用图结构来表示feature field。具体而言,我们将每个输入的multi-field feature表示为一个feature graphfeature fieldfield可以通过边进行交互,所以每个样本对应一张图,因此这是一个

graph-level分类任务(二分类)。Feature Interaction Graph Neural Network:Fi-GNN旨在以一种灵活的、显式的方式建模feature graph上的节点交互。在Fi-GNN中,每个节点hidden state其中

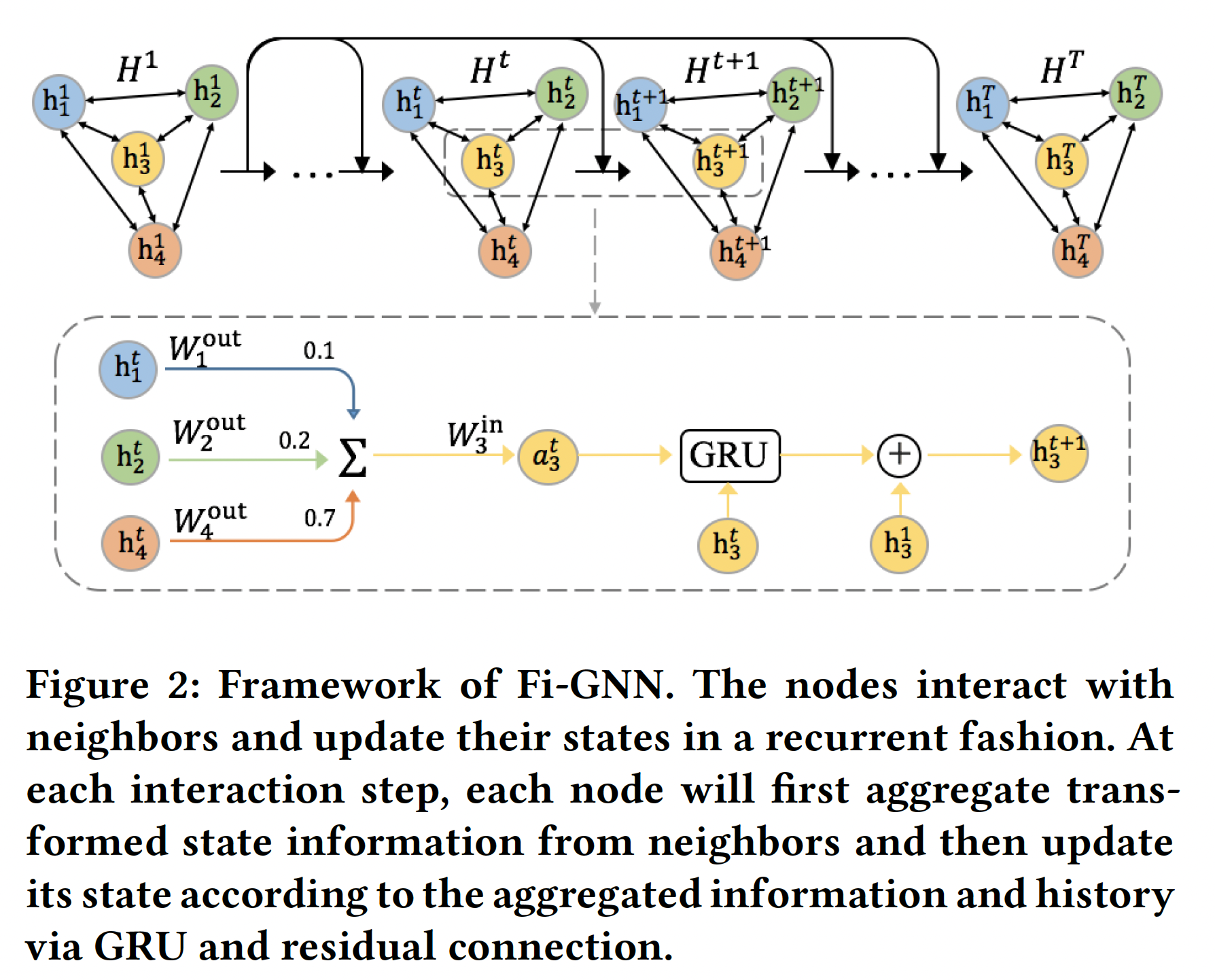

interaction step。由多头自注意力层学到的feature representation作为图的初始状态如下图所示,节点以循环方式进行交互并更新其状态。在每一个

interaction step中,节点聚合邻居节点的状态信息(经过变换之后),然后根据聚合信息、以及节点历史状态通过GRU和残差连接来更新节点状态。State Aggregation:在interaction step其中:

显然,投影矩阵和邻接矩阵决定了节点之间的交互。由于每条边上的交互应该是不同的,我们的目标是建模边上的交互,这需要对每条边有一个

unique的权重和投影矩阵。基于注意力的边权重:为了推断不同节点之间交互的重要性,我们建议通过注意力机制来学习边权重。具体而言,从节点

field embedding向量)来计算:其中:

embedding维度)。利用softmax函数进行归一化,使不同节点的权重容易比较。最终邻接矩阵为:

由于边的权重反映了不同交互的重要性,

Fi-GNN可以很好地解释输入样本的不同feature field之间的关系,这一点将在实验部分进一步讨论。edge-wise变换:如前所述,所有边上的固定的投影矩阵无法建模灵活的交互,对每个边进行unique的变换是必要的。然而,我们的图是完全图(complete graph)(即,任意两个节点之间都存在边),因此包含大量的边。简单地给每条边分配一个unique的投影矩阵将消耗太多的参数空间和运行时间。为了减少时间和空间的复杂性,同时实现edge-wise transformation,我们为每个节点因此聚合信息

这样一来,参数的数量与节点的数量成正比,而不是与边的数量成正比,这就大大降低了空间复杂性和时间复杂性,同时也实现了

edge-wise interaction。

State Update:聚合状态信息之后,节点将通过GRU和残差连接来更新状态向量。通过

GRU进行状态更新:根据传统的GGNN,节点step的状态通过GRU更新的:通过残差连接进行状态更新:我们引入了额外的残差连接(来自初始状态),与

GRU一起更新节点状态,这可以促进低阶特征重用和梯度反向传播:注意,这里是

Attentional Scoring Layer:经过propagation step之后,我们得到了final node state:由于节点已经与它们的

Fi-GNN建模了graph-level output来预测CTR。我们分别对每个

field的final state预测一个得分,并通过注意力机制将它们相加,这个注意力机制衡量它们对整体预测的影响。正式地,每个节点attentional node weight可以通过两个MLP分别得到:整体预测是所有节点的预测的加权和:

训练:损失函数为

logloss,即:其中:

label;CTR。我们采用

RMSProp优化器。此外,为了平衡正负样本比例,在训练过程中,对于每个batch我们随机选择相同数量的正样本和负样本。

1.2 实验

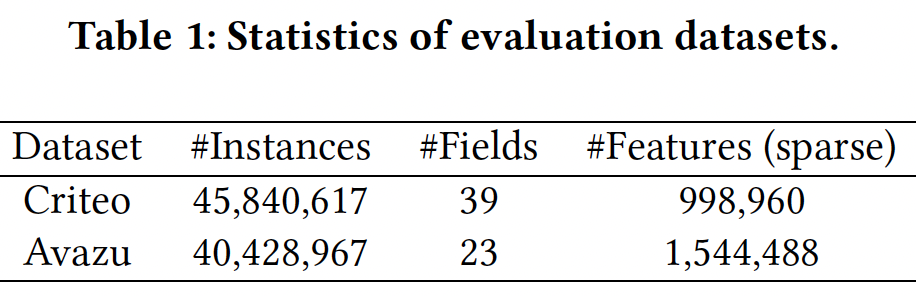

数据集:

Criteo, Avazu。对于这两个数据集:我们移除了低频特征,并将低频特征替换为

"<unknown>"。频次阈值分别为:Criteo数据集为10、Avazu数据集为5。即出现频次低于该阈值则移除。由于数值特征可能具有较大的方差,因此我们进行对数变换:

这是由

Criteo竞赛的获胜者提出的。数据集以

8:1:1的比例随机拆分为训练集、验证集、测试集。

数据集的统计信息如下表所示。

评估指标:

AUC, LogLoss, Relative Improvement (RI)。应该注意的是,对于真实世界的

CTR任务来说,AUC方面的微小改进被认为是显著的。为了估计我们的模型相对于baseline模型的相对改进,我们在此测量RI-AUC和RI-Logloss:其中

X为AUC或LogLoss。baseline方法:LR:通过原始特征的线性组合来建模一阶特征交互。FM:通过field embedding向量的内积来建模二阶特征交互。AFM:是FM的一个扩展,利用注意力机制考虑不同二阶特征交互的权重。DeepCrossing:利用具有残差连接的DNN以隐式的方式学习高阶特征交互。NFM:利用Bi-Interaction Pooling layer来建模二阶特征交互,然后将拼接的二阶组合特征馈入DNN来建模高阶特征交互。CrossNet(Deep&Cross):是Deep&Cross模型的核心,它通过采用拼接的feature vector的外积,从而显式地在bit-wise level上建模特征交互。CIN(xDeepFM):是xDeepFM模型的核心,它通过采用堆叠的feature matrix的外积,从而显式地在vector-wise level上建模特征交互。

实现细节:我们使用

Tensorflow实现我们的方法。最优超参数由网格搜索策略确定。baseline的实现遵循《AutoInt: Automatic Feature Interaction Learning via Self-Attentive Neural Networks》。对于所有方法,

field embedding向量的维度是16,batch size = 1024。DeepCrossing有四个前馈层,每层有100个隐单元。NFM在Bi-Interaction layer之上有一个大小为200的隐层,如原始论文中所推荐的。CrossNet和CIN都有三个交互层。所有实验都是在配备了

8个NVIDIA Titan X GPU的服务器上进行的。

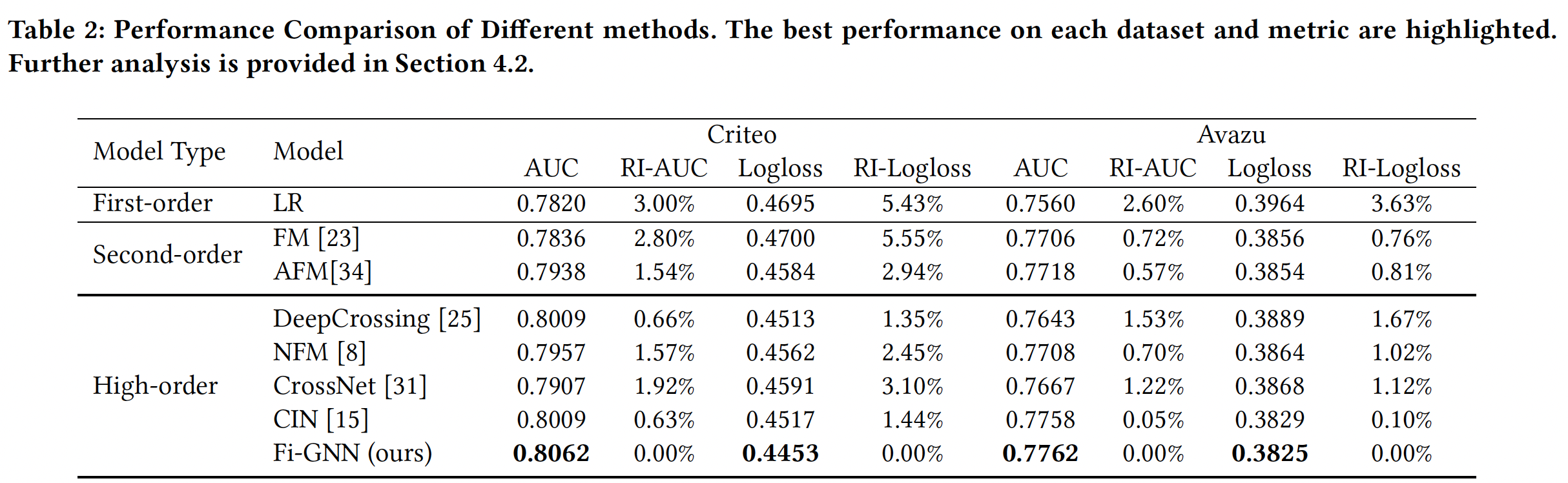

不同模型的性能比较,如下表所示。可以看到:

LR在这些baseline中效果最差,这证明了单个特征在CTR预测中是不够的。在所有数据集上,建模二阶特征交互的

FM和AFM优于LR,这表明建模feature field之间的pairwise交互是有效的。此外,AFM比FM具有更好的表现,证明了在不同交互上的注意力的有效性。建模高阶特征交互的方法大多优于建模二阶特征交互的方法。这表明二阶特征交互是不够的。

DeepCrossing优于NFM,证明了残差连接在CTR预测中的有效性。在两个数据集上,

Fi-GNN在所有这些方法中取得了最好的性能,尤其是在Criteo数据集上。Fi-GNN在Criteo数据集上取得的相对改进,高于在Avazu数据集上取得的相对改进。这可能是因为Criteo数据集中有更多的feature field,可以更好地利用图结构的表达能力。

消融研究:我们提出的

Fi-GNN模型是基于GGNN的,在此基础上我们主要做了两个改进:通过

attentional edge weight和edge-wise transformation实现edge-wise node interaction。引入残差连接从而与

GRU一起更新节点状态。

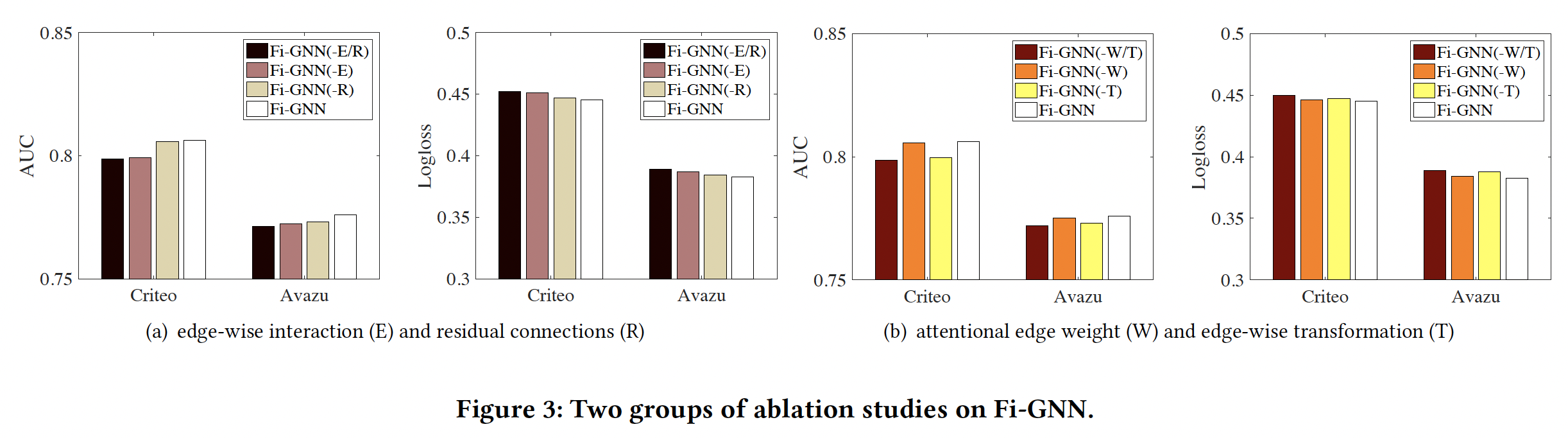

为了评估两种改进的有效性,我们对比了三个变体:

Fi-GNN(-E/R):同时没有上述两个改进的变体。Fi-GNN(-E):没有edge-wise interaction: E的变体。即,用二元邻接矩阵、以及所有边上共享的投影矩阵。Fi-GNN(-R):没有residual connection: R的变体。

对比结果如下图

(a)所示。可以看到:Fi-GNN(-E)的性能相比完整的Fi-GNN大幅下降,这表明建模edge-wise interaction是至关重要的。Fi-GNN(-E)取得了比Fi-GNN(-E/R)更好的性能,证明了残差连接确实可以提供有用的信息。完整的

Fi-GNN优于三种变体,表明我们所做的两种改进,即残差连接和edge-wise interaction,可以联合提高性能。

在

Fi-GNN中,我们采用两种方法来实现edge-wise node interaction:attentional edge weight: W、edge-wise transformation: T。为了进一步研究巨大的改进来自哪,我们比较了另外三个变体:Fi-GNN(-W/T):即Fi-GNN-(E)。Fi-GNN(-W):没有attentional edge weight。Fi-GNN(-T):没有edge-wise transformation,即所有边上共享投影矩阵。

对比结果如下图

(b)所示。可以看到:Fi-GNN(-T)和Fi-GNN(-W)都优于Fi-GNN(-W/T),这证明了它们的有效性。Fi-GNN(-W)比Fi-GNN(-T)实现了更大的改进,这表明在建模edge-wise interaction方面,edge-wise transformation比attentional edge weight更有效。这是非常合理的,因为投影矩阵应该比标量的attentional edge weight对edge-wise interaction有更强的影响。

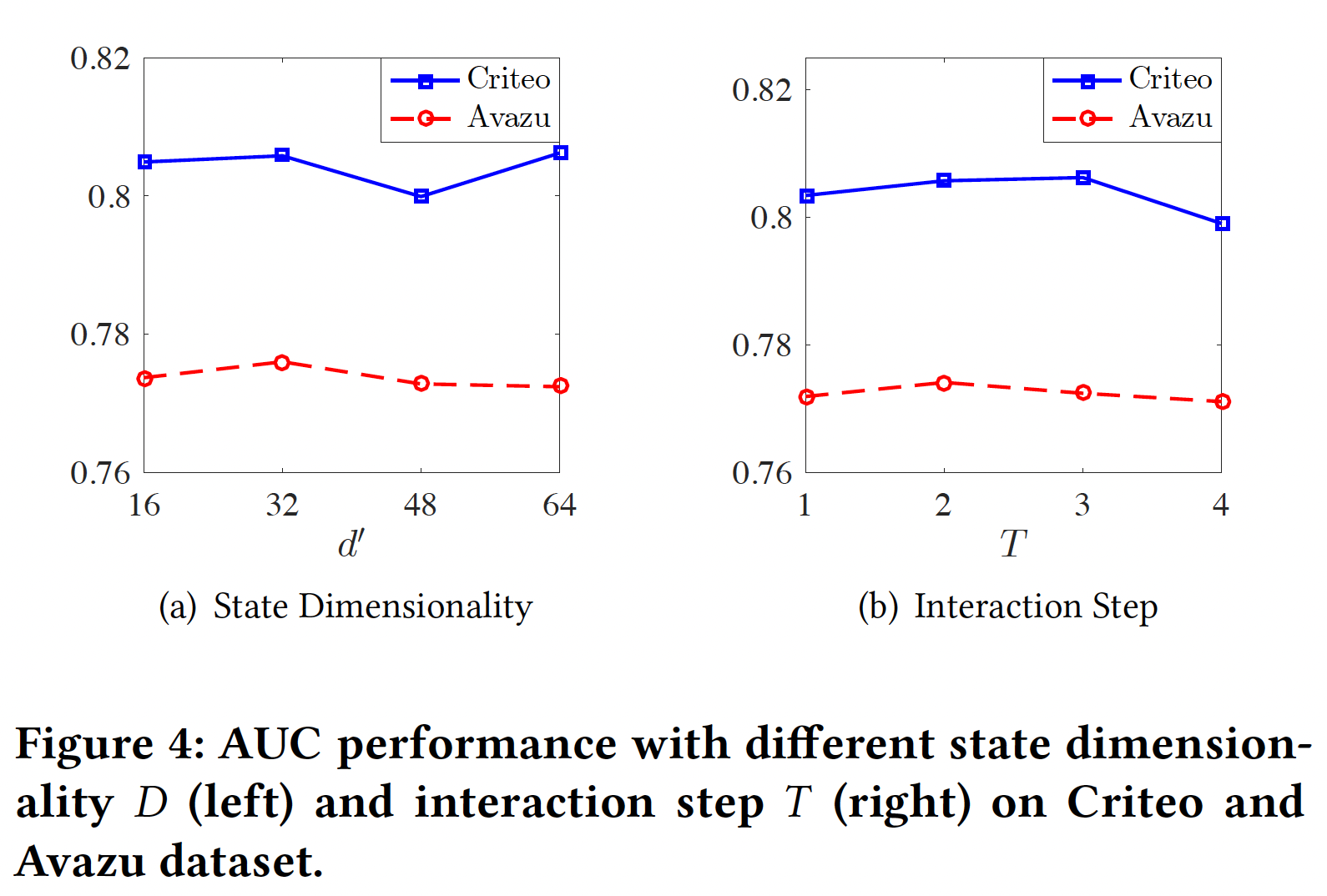

超参数研究:

state维度32(Avazu数据集)、64(Criteo数据集)时性能最佳。这是合理的,因为Criteo数据集更复杂,需要更大的维度来保持足够的信息。没有考虑

attention head的影响?interaction stepinteraction step等于特征交互的最高阶次。模型性能随着2(Avazu数据集)、3(Criteo数据集)时性能最佳。这是合理的,因为Avazu数据集有23个feature field、Criteo数据集有39个feature field。因此,Criteo数据集需要更多的interaction step来使field node与feature graph中的其他节点完全交互。

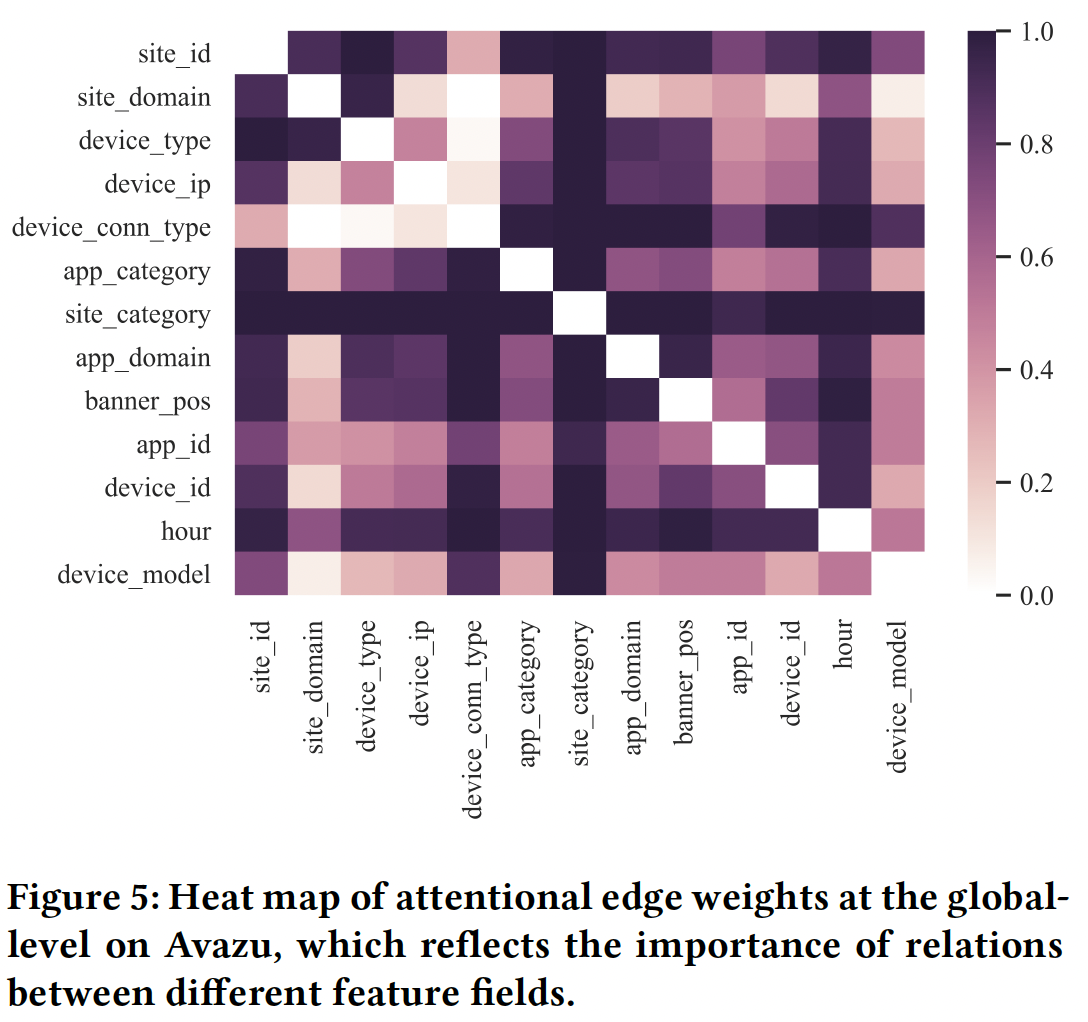

模型可解释性:我们在

feature graph的边上和节点上都应用了注意力机制,分别得到了attentional edge weight和attentional node weight,可以从不同的角度给出解释。Multi-head Self-attention Layer捕获的pair-wise交互是否也是可解释的?论文并没有说明这一点。attentional edge weight:attentional edge weight反映了两个相连的field node之间交互的重要性,也反映了两个feature field之间的关系。下图展示了Avazu数据集中所有样本的全局平均邻接矩阵的热力图,它可以在全局水平上反映不同field之间的关系。 由于有一些field是匿名的,我们只显示剩余的13个具有真实含义的feature field。可以看到:

一些

feature field倾向于与其他field有很强的关系,例如site_category和site_id。这是有意义的,因为两个feature field都对应于投放广告的网站。hour是另一个与其他field有密切关系的特征。这是合理的,因为Avazu专注于移动场景,用户可以在一天的任何时间在线冲浪。上网时间对其他的广告特征有很大的影响。另一方面,

device_ip和device_id似乎与其他feature field的关系较弱。这可能是因为它们几乎等同于user id,相对固定,不易受其他特征的影响。

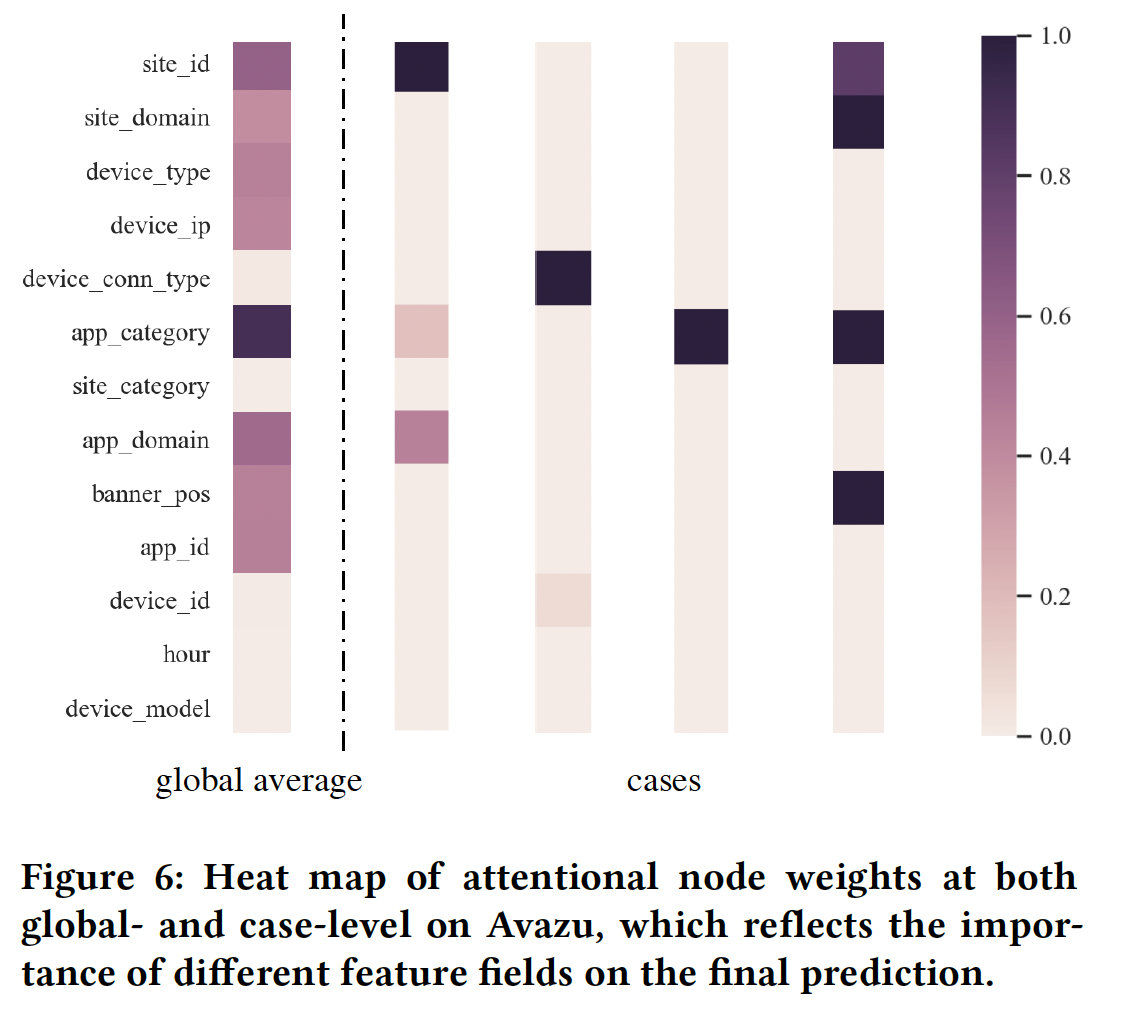

attentional node weight:attentional node weight反映了feature field对整体预测分数的影响的重要性。下图显示了global-level和case-level的attentional node weight的热力图。左边的是Avazu数据集中所有样本的全局平均值,右边的是Avazu数据集中随机选择的四个样本(预测分数分别为[0.97, 0.12, 0.91, 0.99],标签分别为[1, 0, 1, 1])。在

global level,我们可以看到featuer field app_category对点击行为的影响最大。这是合理的,因为Avazu专注于移动场景,而app是最重要的因素。在

case level,我们观察到,在大多数情况下,最终的点击行为主要取决于一个关键的feature field。