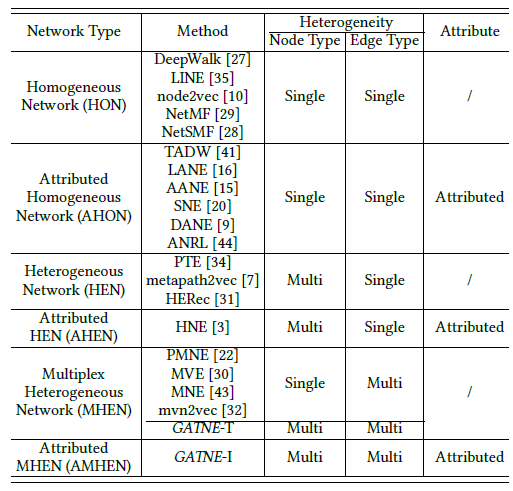

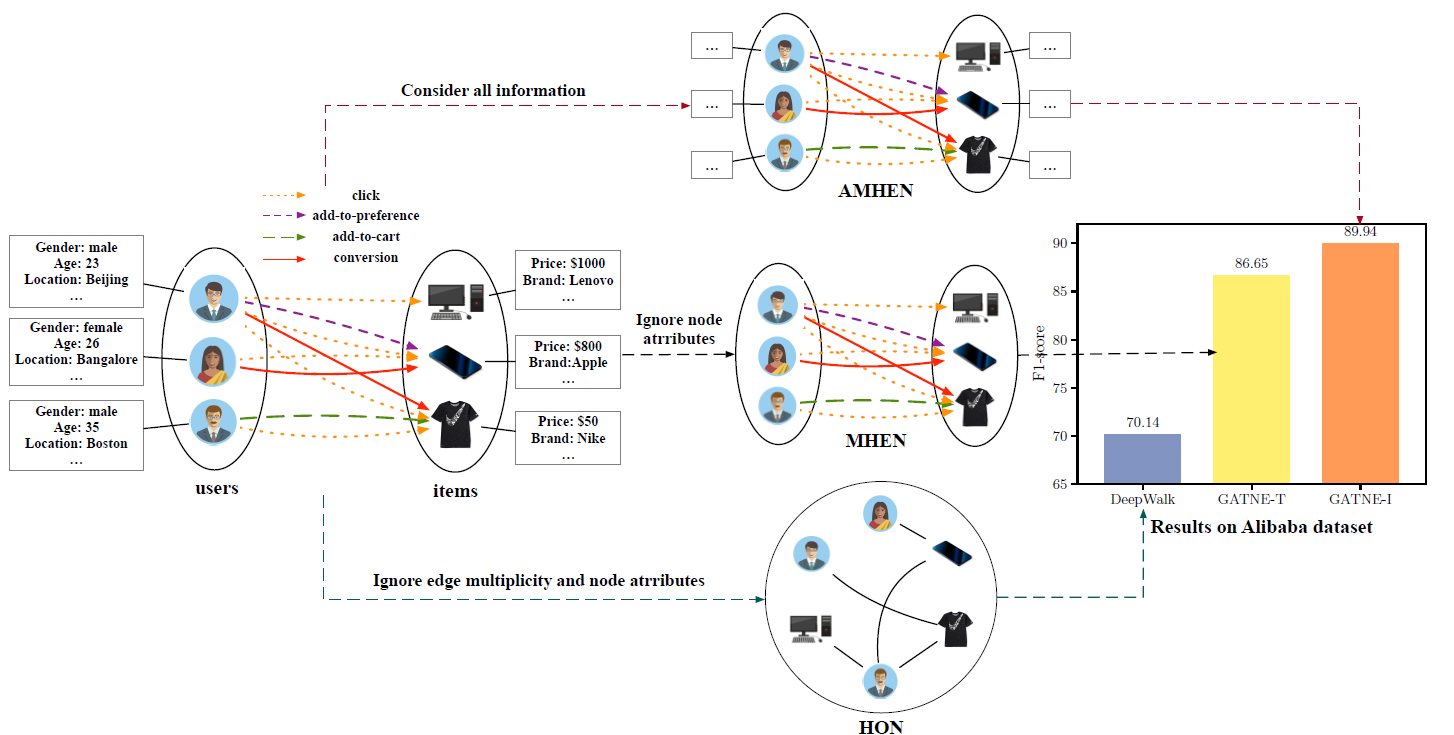

图的表达2

十七、PTE[2015]

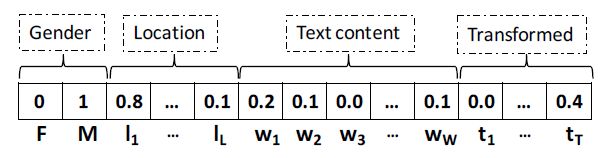

学习有意义且有效的文本(例如

word、document)的representation,是许多机器学习任务(例如文本分类、文本聚类、文本检索)的关键前提条件。传统上,每个word都相互独立地表示,并且每个document都表示为bag-of-words。然而,这两种representation都存在数据稀疏、多义性polysemy、同义性synonymy等问题,因为在这两种representation中不同word之间的语义相关性semantic relatedness通常被忽略。word和document的分布式representation通过在低维空间中表达word和document,从而有效地解决了这个问题。在这个低维空间中,相似的word/document彼此紧密地嵌入。这些方法的基本思想来自于分布式假设distributional hypothesis:一个单词的意义是由它的使用环境所形成的 (you shall know a word by the company it keeps)。《Distributed representations of words and phrases and their compositionality》提出了一种简单而优雅的word embedding模型,称作SkipGram。SkipGram使用target word的embedding来预测局部窗口local window中每个单独的context word的embedding。《Distributed representations of sentences and documents》进一步扩展了这一思想,并提出了Paragraph Vector从而嵌入任意的文本片段,例如sentence和document。其基本思想是:使用sentence/document的embedding来预测sentence/document中word的embedding。和也利用word context的分布式相似性distributional similarity的其它经典方法(如布朗聚类Brown clustering、最近邻法)相比,这些text embedding方法已被证明是非常有效的,可以在单台机器上扩展到数百万个document。由于采用无监督学习,通过这些

text embedding模型学到的representation足够通用,可以应用于分类classification、聚类clustering、以及排序ranking等各种任务。然而,和端到端的复杂的深度学习方法(如卷积神经网络)相比时,text embedding的性能通常在特定任务上达不到要求。这毫不奇怪,因为深度神经网络在学习数据representation时充分利用了可用于任务的label信息。大多数text embedding方法在学习representation时都无法考虑label信息。只有在使用训练好的representation作为特征来训练分类器时,label才会被使用。换句话讲,无监督的text embedding对于不同的任务是可泛化generalizable的,但是对于特定任务的预测能力较弱。尽管存在这一缺陷,但是和深度神经网络相比,

text embedding方法仍有相当大的优势。- 首先,深度神经网络(尤其是卷积神经网络)的训练是计算密集型的,在处理大量数据的时候通常需要多个

GPU或CPU集群。 - 其次,卷积神经网络通常假设大量的标记样本可用,这在许多任务中是不现实的。对于容易获取的未标记数据,卷积神经网络通常使用预训练的方式来间接利用。

- 第三,卷积神经网络的训练需要多许多超参数进行详尽的调优,即使对于专家而言也是非常耗时的,而对于非专家而言是不可行的。

另一方面,像

SkipGram这样的text embedding方法效率更高、更容易调优、并且天然地适应于未标记数据。在论文

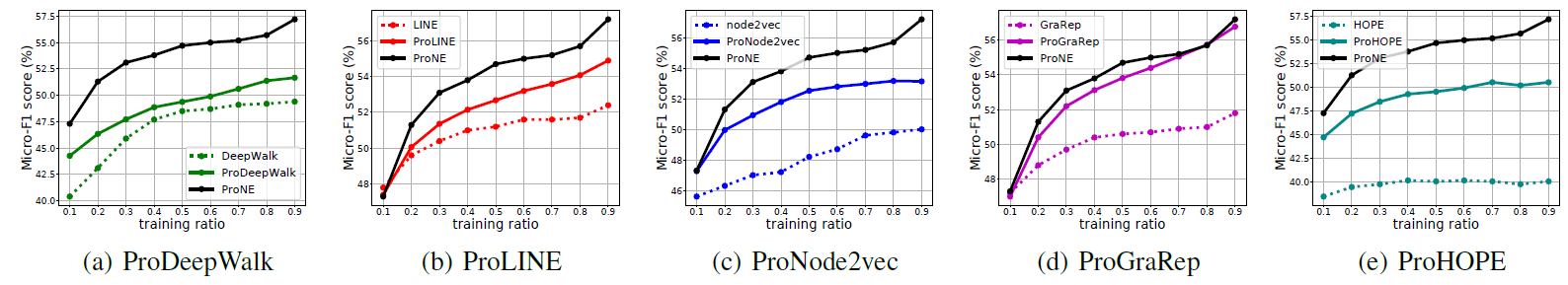

《PTE:Predictive Text Embedding through Large-scale Heterogeneous Text Networks》中,作者通过提出predictive text embedding: PTE来填补这一空白。PTE具有无监督text embedding的优点,但是在representation learning过程中自然地利用了标记信息。通过PTE,我们可以从有限的标记样本和大量的未标记样本中联合学习有效的低维representation。与无监督embedding相比,这种representation针对特定任务进行了优化,就像卷积神经网络所作的那样。即,PTE学到的representation对特定的分类任务具有很强的预测能力。PTE自然地扩展了作者之前的无监督信息网络embedding工作(《Line: Large-scale information network embedding》),并首先提出通过异质文本网络heterogeneous text networt学习word的低维embedding。该网络对word-word、word-document、word-label之间不同level的共现信息co-occurrence information进行编码。该网络被嵌入到一个低维向量空间中,该空间保留了网络中顶点之间的二阶邻近性second-order proximity。任意一段文本(例如sentence或document)的representation可以简单地推断为word representation的均值,结果证明这是非常有效的。整个优化过程仍然非常高效,在单台机器上可以扩展到数百万个document和数十亿个token。论文对现实世界的文本语料库进行了广泛的实验,包括

long document和short document。实验结果表明:PTE在各种文本分类任务中显著优于state-of-the-art的无监督embedding。与用于文本分类的端到端卷积神经网络相比,PTE在long document上表现更好、在short document上表现相当。与卷积神经网络相比,PTE具有各种优势,因为它更高效、有效地利用大规模未标记数据,并且对模型超参数不太敏感。作者相信PTE的探索指向了一个学习text embedding的方向,该方向可以在特定任务中与深度神经网络进行正面竞争。总而言之,论文的贡献如下:

- 论文提出以半监督的方式学习

predictive text embedding。未标记数据和标记信息被集成到一个异质文本网络中,该网络包含不同level的文本共现信息。 - 论文提出了一种高效的算法

PTE,它通过将异质文本网络嵌入到低维空间中来学习文本的分布式representation。该算法非常有效,几乎没有需要调优的超参数。 - 论文使用各种真实世界的数据集进行了广泛的实验,并将

PTE与无监督text embedding、卷积神经网络进行了比较。

- 首先,深度神经网络(尤其是卷积神经网络)的训练是计算密集型的,在处理大量数据的时候通常需要多个

相关工作:我们的工作主要涉及分布式文本

representation learning和信息网络embedding。Distributed Text Embedding:文本的分布式representation已被证明在许多自然语言处理任务中非常有效,例如单词类比word analogy、词性标注POS tagging、parsing、语言建模language modeling、以及情感分析sentiment analysis。现有的方法通常可以分为两类:无监督方法、监督方法。- 最近提出的无监督方法通常通过在局部上下文

local context(例如SkipGram)或者document级别(例如Paragraph Vector),利用word co-occurrence来学习word/document的embedding。这些方法非常有效,可以扩展到数百万个document。 - 监督方法通常基于深度神经网络架构,例如

recursive neural tensor network: RNTN、convolutional neural network: CNN。在RNTN中,每个word都嵌入到一个低维向量中,并且通过在parse tree中的子短语sub-phrase或者word上应用相同的、基于张量tensor-based的组合函数composition function来递归学习短语phrase的embedding。在CNN中,每个word也用一个向量来表示,并且在sentence的不同位置的上下文窗口上应用相同的卷积核,然后是一个最大池化层和一个全连接层。

这两类方法之间的主要区别在于它们如何在

representation learning阶段利用标记信息和未标记信息。无监督方法在representation learning时不包含标记信息,仅在将数据转换为学到的representation之后,才使用label来训练分类器。RNTN和CNN将label直接结合到representation learning中,因此学到的representation特别针对分类任务进行了调优。然而,为了融合未标记的样本,这些神经网络通常必须使用间接方法,例如使用无监督方法预训练word embedding。和这两类方法相比,PTE以半监督方式学习text embedding,representation learning算法直接利用标记信息和大量的未标记数据。与

predictive word embedding类似的另一项工作是《Learning word vectors for sentiment analysis》,该工作学习特别针对情感分析调优的word embedding。然而,他们的方法无法扩展到数百万个document,也无法推广到其它分类任务。- 最近提出的无监督方法通常通过在局部上下文

Information Network Embedding:我们的工作还与network/graph embedding问题有关,因为PTE的word representation是通过异质文本网络heterogeneous text network学到的。将

network/graph嵌入到低维空间,这在各种应用中非常有用,例如节点分类、链接预测。MDS、IsoMap、Laplacian eigenmap等经典graph embedding算法不适用于嵌入包含数百万个顶点、数十亿条边的大型网络。最近有一些工作试图嵌入非常大的现实世界网络。

《Deepwalk: Online learning of social representations》提出了一种叫做DeepWalk的network embedding模型,该模型在网络上使用截断的随机游走,并且仅适用于具有二元边的网络。我们先前的工作提出了一种新的大规模网络嵌入模型,称作LINE。LINE适用于任意类型的信息网络,无向或有向、二元边或者带权边。LINE模型优化了一个目标函数,该目标函数旨在保持局部网络结构local network structure和全局网络结构global network structure。DeepWalk和LINE都是无监督的,只能处理同质网络homogeneous network。PTE使用的network embedding算法扩展了LINE从而处理异质网络(网络中存在多种类型的顶点和边)。

17.1 模型

17.1.1 基本概念

让我们从正式定义

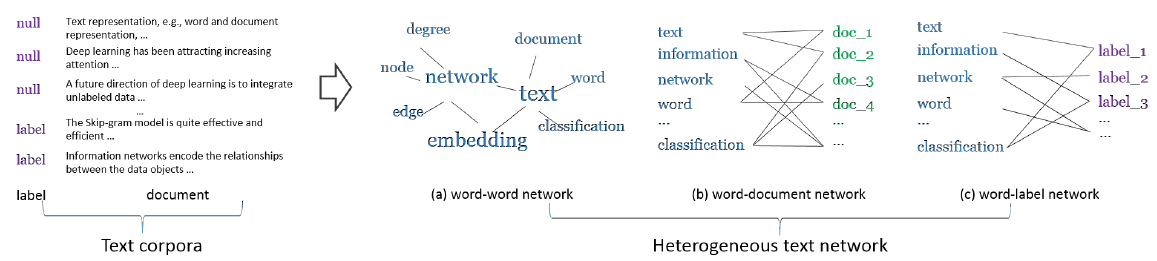

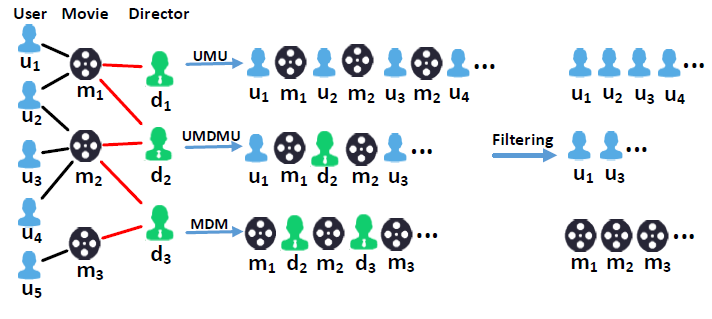

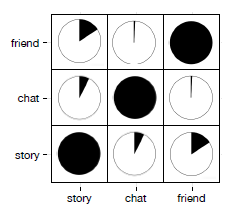

predictive text embedding问题(通过异质文本网络)来开始。与学习文本的通用语义representation的无监督text embedding方法(包括SkipGram和Paragraph Vector)相比,我们的目标是学习针对给定文本分类任务优化的文本representation。换句话讲,我们期待text embedding对给定任务的性能具有很强的预测能力。基本思想是:在学习text embedding时结合标记信息和未标记信息。为了实现这一点,首先需要有一个统一的representation对这两类信息(标记的和未标记的)进行编码。在本文中,我们提出了不同类型的网络来实现这一点,包括word-word co-occurrence network、word-document network、word-label network。word-word co-occurrence network:word-word共现网络表示为local context中的word共现信息。word的词表vocabulary,word之间的边的集合(共现关系)。wordword在给定窗口大小的上下文窗口中同时出现的次数。word-word网络捕获局部上下文中的word共现,这是现有word embedding方法(如SkipGram)使用的基本信息。除了局部上下文之外,document level的word共现也在经典的文本representation中被广泛探索,例如统计主题模型statistical topic model(如latent Dirichlet allocation: LDA)。为了捕获document level的word共现,我们引入了另一个网络,即word-document网络。word-document network:word-document网络表示为二部图document的集合,word的集合,word到document的链接构成的边集合。worddocumentworddocumentword-word网络和word-document网络对大规模语料库中的未标记信息进行编码,在局部上下文level和document level捕获word共现。为了对标记信息进行编码,我们引入了word-label网络,该网络在category-level捕获word共现。word-label network:word-label网络表示为二部图class的集合,word的集合,word到class的链接构成边的集合。category-level的word共现。wordclassdocumentworddocumentclass label。上述三种网络可以进一步融合为一个异质文本网络

heterogeneous text network(如下图所示)。Heterogeneous Text Network:异质文本网络是由标记文本数据和未标记文本数据共同构建的word-word网络、word-document网络、word-label网络的组合。它捕获不同level的word共现,并同时包含标记信息和未标记信息。注意,异质文本网络的定义可以推广到融合其它类型的网络,例如

word-sentence网络、word-paragraph网络、document-label网络等等。在这项工作中,我们使用三种类型的网络(word-word、word-document、word-label)作为说明性示例。我们特别关注word网络,以便首先将word表示为低维空间。然后可以通过聚合word representation来计算其它文本单元(如stentence或paragraph)的representation。子网的构建需要结合具体任务,并且对任务性能产生重大影响。但是论文并未给出子网构建的原则。可以借鉴的是:这里的

word-word捕获局部共现、word-document捕获全局共现。

最后,我们正式定义

predictive text embedding问题如下:Predictive Text Embedding:给定具有标记信息和未标记信息的大量文本数据,predictive text embedding问题旨在通过将由文本数据构建的异质文本网络嵌入到低维向量空间中从而学习word的低维representation。接下来我们将介绍通过异质文本网络学习

predictive text embedding的方法。我们的方法首先将异质文本网络嵌入到低维空间来学习word的向量representation,然后根据学到的word embedding推断text embedding。由于异质文本网络由三个二部图组成,我们首先介绍一种嵌入单个二部图的方法。

17.1.2 二部图 Embedding

在我们之前的工作中,我们引入了

LINE模型来学习大规模信息网络的embedding。LINE主要是为同质网络而设计的,即具有相同类型节点的网络。LINE无法直接应用于异质网络,因为不同类型边的权重不具有可比性。在这里,我们首先将LINE模型用于嵌入二部图。基本思想是:利用顶点之间的二阶邻近性,假设具有相似邻域的顶点彼此相似,因此应该在低维空间中紧密地表示。对于二部图,假设顶点

给定一个二部图

其中:

embedding向量,embedding向量。对于

second-order proximity可以由它们的条件分布其中:

KL-divergence函数。degree:- 经验分布

忽略常数项,则上述目标函数重写为:

我们可以采用带边采样

edge sampling和负采样nagative sampling的随机梯度下降法来求解该最优化问题。在梯度下降的每一步:- 首先以正比于权重

binary edgeedge sampling。 - 然后通过

noise distributionnagative sampling。

采样过程解决了学习

network embedding中随机梯度下降的重大缺陷。详细的优化过程可以参考LINE的原始论文。word-word网络、word-document网络、word-label网络的embedding都可以通过上述模型来学习。注意,word-word网络本质上是一个二部图,可以将每条无向边视为两条有向边,并且将embedding。

17.1.2 异质文本网络 Embedding

异质文本网络由三个二部图组成:

word-word网络、word-document网络、word-label网络,其中word顶点在三个网络之间共享。为了学习异质文本网络的embedding,一种直观的方法是共同嵌入三个二部图,这可以通过最小化以下目标函数来实现:上述目标函数可以通过不同的方式进行优化,具体取决于如何使用标记信息(即

word-label网络)。- 一种解决方案是同时使用未标记数据(

word-word网络和word-document网络)和标记数据训练模型。我们称这种方法为联合训练joint training。 - 另一种解决方案是首先使用未标记数据来学习

embedding,然后使用word-label网络来微调embedding。这是受到深度学习文献中预训练和微调pre-training and fine-tuning思想的启发。

- 一种解决方案是同时使用未标记数据(

在联合训练中,所有三种类型的网络一起使用。优化目标

edge sampling(在每个step中对边进行采样从而进行模型更新,采样概率与边的权重成正比)。然而,当网络是异质的时候,不同类型顶点之间的边的权重是不可比的。更合理的解决方案是从三组边中交替采样。PTE联合训练算法:输入:

- 异质文本网络的三个子网

- 采样数量

- 负采样比例

- 异质文本网络的三个子网

输出:所有单词的

embedding算法步骤:

循环迭代,直到迭代了

step。迭代过程为:- 从

word embedding。 - 从

word embedding和document embedding。 - 从

word embedding和label embedding。

- 从

PTE预训练和微调算法:输入:

- 异质文本网络的三个子网

- 采样数量

- 负采样比例

- 异质文本网络的三个子网

输出:所有单词的

embedding算法步骤:

预训练阶段:循环迭代,直到迭代了

step。迭代过程为:- 从

word embedding。 - 从

word embedding和document embedding。

微调阶段:循环迭代,直到迭代了

step。迭代过程为:- 从

word embedding和label embedding。

- 从

Text Embedding:异质文本网络对不同level的word co-occurrence进行编码,这些编码是从未标记数据和特定分类任务的标记信息中提取的。因此,通过嵌入异质文本网络学习的word representation不仅更加鲁棒,而且针对该特定任务进行了优化。一旦学到了word vector,就可以通过简单地对这段文本中word的向量求均值来获得任意一段文本的representation。即,一段文本representation可以计算为:其中

wordembedding向量。事实上,

word embedding的均值是最小化以下目标函数的最优解:其中

word embedding和text embedding之间的、欧式距离的损失函数。与之相关的是

paragraph vector的推断过程,它的目标函数相同但是具有不同的损失函数:然而这个损失函数对应的目标函数没有闭式解

close form solution,因此必须通过梯度下降算法来优化。

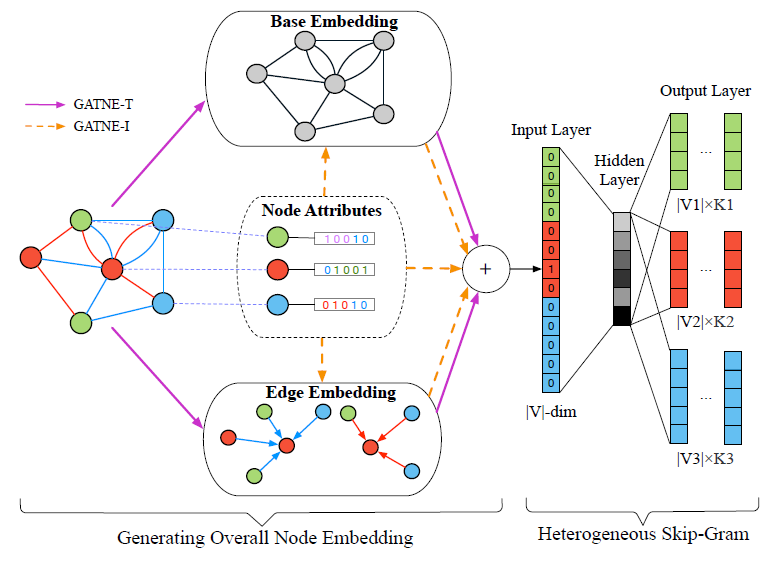

17.2 实验

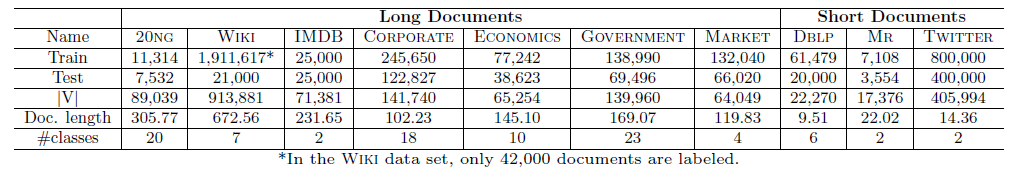

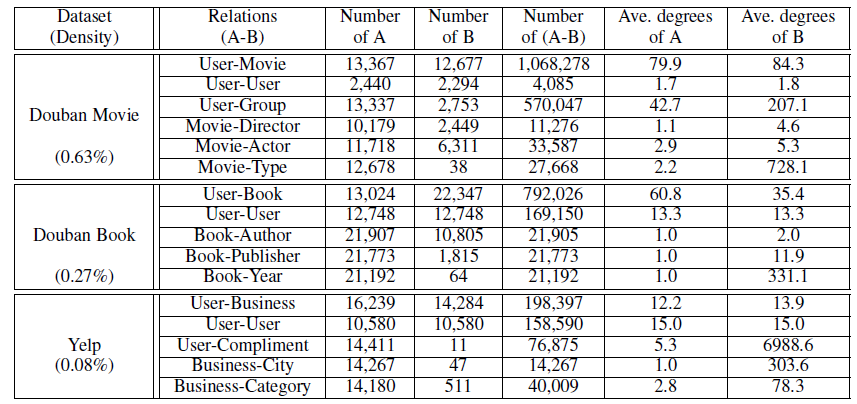

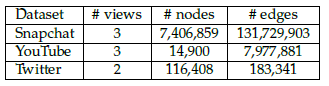

数据集:我们选择了长文

document、短document两种类型的数据集:长

document数据集:20newsgroup数据集:广泛使用的文本分类数据集,包含20个类别。wiki数据集:2010年4月的维基百科数据集,包含大约200万篇英文文章。我们仅保留2010年维基百科中出现的常见词汇。我们选择了七种不同类别,包括Art, History, Human, Mathematics, Nature, Technology, Sports。每种类别我们随机选择9000篇文章作为标记的document来训练。Imdb数据集:一个情感分类数据集。为避免训练数据和测试数据之间的分布偏差,我们随机混洗了训练数据和测试数据。RCV1数据集:一个大型文本分类基准语料库。我们从数据集中抽取了四个子集,包括Corporate, Economics, Government, Market。在RCV1数据集中,文档已经被处理为bag-of-word: BOW的格式,因此word的顺序已经被丢失。

短

document数据集:DBLP数据集:包含来自计算机科学领域论文的标题。我们选择了六个领域的论文,包括database, arti cial intelligence, hardware, system, programming languages, theory等。对于每个领域,我们选择该领域具有代表性的会议并收集该会议中发表的论文作为标记的document。

MR数据集:一个电影评论数据集,每条评论仅包含一个sentence。Twitter数据集:用于情感分类的Tweet语料库。我们从中随机抽取了120万Tweets然后拆分为训练集和测试集。

我们并没有在原始数据上执行进一步的文本归一化text normalization ,如删除停用词或者词干化。下表给出了数据集的详细统计信息。

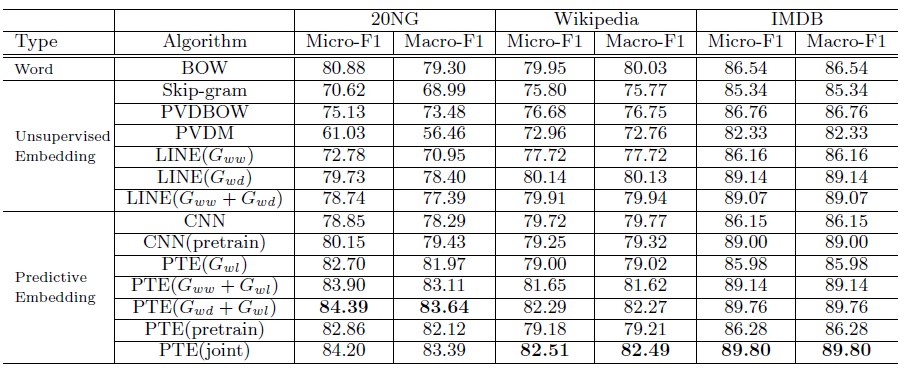

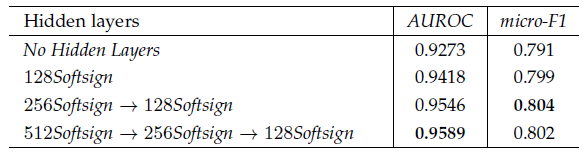

baseline方法:我们将PTE算法和其它的文本数据representation learning算法进行比较,包括经典的BOW算法、state-of-the-art的无监督text embedding、以及state-of-the-art的监督text embedding方法。BOW:经典的BOW方法。每篇文档使用一个wordTFIDF值。SkipGram:根据SkipGram训练得到word embedding,然后我们使用word embedding的均值来作为document embedding。PVDBOW:一种paragraph embedding模型,其中document内word的顺序被忽略。PVDM:另一种paragraph embedding模型,其中document内word的顺序被考虑。LINE:我们之前的工作提出的大规模信息网络embedding模型。我们使用LINE模型分别学习word-word网络和word-dococument网络,分别记作word-word网络和word-document网络,记作CNN:基于卷积神经网络CNN模型来监督学习text embedding。尽管原始论文用于建模sentence,我们这里将其改编为适用于长文本在内的一般word序列。尽管CNN通常适用于完全标记的documnet,但是它也可以通过无监督的word embedding从而对模型进行预训练来利用未标记数据,这被记作CNN(pretrain)。PTE:我们提出的、学习predictive text embedding的方法。PTE有多种变体,它们使用word-word、word-document、word-label的不同组合。word-label的版本。word-word和word-label的版本。word-document和word-label的版本。word-word、word-document进行无监督训练,然后使用word-label来微调的版本。PTE(joint)为联合训练异质文本网络的版本。

实验配置:

SkipGram, PVDBOW, PVDM, PTE, PTE模型:- 随机梯度下降的

mini-batch size设为1。 - 学习率设为

T为总的迭代步数, - 负采样次数为

K=5。

- 随机梯度下降的

SkipGram, PVDBOW, PVDM, PTE模型:word-word网络共现窗口大小为5。CNN模型:我们使用《Convolutional neural networks for sentence classi cation》中的CNN结构。该结构使用一个卷积层,然后是最大池化层和全连接层。卷积层的窗口大小设为3,feature map数量设为100,随机选择训练集的1%作为验证集来执行早停。所有

embedding模型的词向量维度为100。

注意:对于

PTE模型,默认情况下在不同数据集上,超参数均按照上述设置。唯一需要调整的超参数的边采样中的样本数评估方式:一旦构建或学习了

document的向量representation,我们就会使用相同的训练数据集应用相同的分类过程。具体而言,训练集中的所有文档都用于representation learning阶段和classifier learning阶段。- 如果使用无监督

embedding方法,则在representation learning阶段不使用document的类别标签,仅在classifier learning阶段使用类别标签。 - 如果使用

predictive embedding方法,则同时在这两个阶段都使用类别标签。

对于测试数据集,我们在这两个阶段都留出

hold-out标签数据和document文本。注意:在

representation learning阶段保留所有测试数据,即这一阶段模型看不到测试数据的标签、也看不到测试数据的文本。在分类阶段,我们使用

LibLinear package中的one-vs-rest逻辑回归模型,并评估micro-F和macro-F1指标。每一种配置我们都执行十次,并报告指标的均值和方差。- 如果使用无监督

17.2.1 实验结果

我们在

20NG,Wiki,IMDB数据集上的长文本效果对比如下。首先我们比较无监督

text embedding方法,可以看到:- 具有

document-level的word共现的embedding中表现最好。 PVDM性能不如PVDBOW,这和原始论文中的结论不同。不幸的是我们始终无法得出他们的结论。

然后我们比较

predictive embedding方法,可以看到:PTE(joint)效果最好。- 所有带

word-label网络PTE方法都超越了对应的无监督方法(即LINE模型),这表明了在监督学习下predictive text embedding的强大能力。 PTE(joint)超越了PTE(joint)也超越了PTE(pretrain),这表明联合训练未标记数据和标记数据,要比将它们分别独立训练并微调更有效。- 另外我们通过

embedding来对CNN进行预训练,然后使用label信息对其进行微调。出乎意料的是:预训练CNN在20NG和IMDB数据集上显著提高,并且在Wiki上几乎保持不变。这意味着训练良好的无监督embedding对CNN进行预训练非常有用。 - 但是,即使是预训练的

CNN,其性能仍然不如PTE(joint)。这可能的因为PTE模型可以联合训练标记数据和未标记数据,而CNN只能通过预训练和微调两阶段来各自独立的使用标记数据和未标记数据。 PTE(joint)也始终优于经典的BOW模型,尽管PTE(joint)的embedding向量维度远小于BOW的向量维度。

- 具有

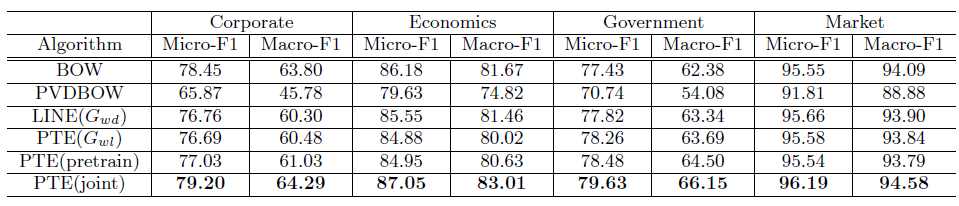

我们在

RCV1数据集上的长文本效果对比如下。由于word之间的顺序丢失,因此要求保留word顺序信息的embedding方法不适用。这里我们观察到了类似的结论:predictive embedding方法超越了无监督embedding。PTE(joint)方法比PTE(pretrain)方法更有效。

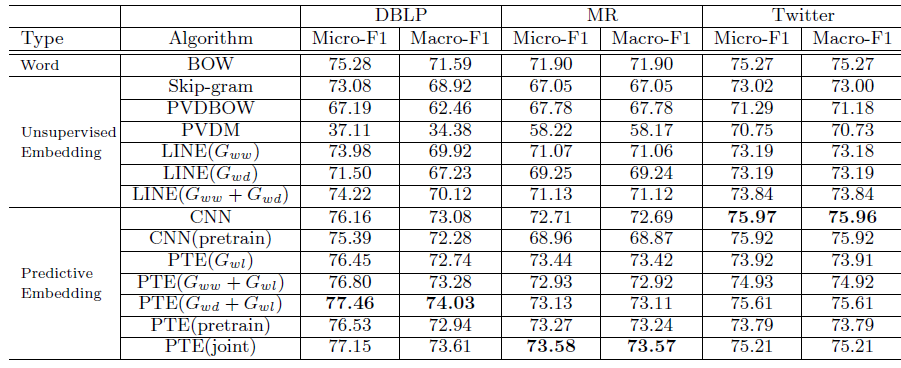

我们比较了

CNN和PTE(joint)在IMDB数据集上的训练实践。我们采用异步随机梯度下降算法,在1T内存、2.0G HZ的40核CPU上执行。平均而言PTE(joint)要比CNN快10倍以上。当使用pretrain时,CNN虽然训练速度加快,但是仍然比PTE(joint)慢 5倍以上。我们在短文本上比较了模型性能如下。

首先我们比较无监督

text embedding方法,可以看到:- 结合了

document-level和local-context level的word共现的 - 使用局部上下文级别

word共现的document级别word共现的document级别的word共现非常稀疏。我们在主题模型中也观察到了类似的结果。 PVDM性能仍然不如PVDBOW性能,这和长文本中结论一致。

然后我们比较

predictive embedding方法,可以看到:PTE在DBLP,MR数据集上性能最佳,CNN在Twitter数据集上性能最好。融合了

word-label网络的PTE方法超越了对应的无监督embedding方法(即LINE模型),这和长文本中结论一致。PTE(joint)超越了PTE(joint)超越了PTE(pretrain),这证明了对标记数据和未标记数据联合训练的优势。我们观察到

PTE(joint)并不能始终超越CNN。原因可能是单词歧义ambiguity问题,这类问题在短文本中更为严重。CNN通过在卷积核中使用局部上下文的word顺序来减少单词歧义问题,而PTE抛弃了word顺序。我们相信:如果利用了word顺序,则PTE还有很大提升空间。

- 结合了

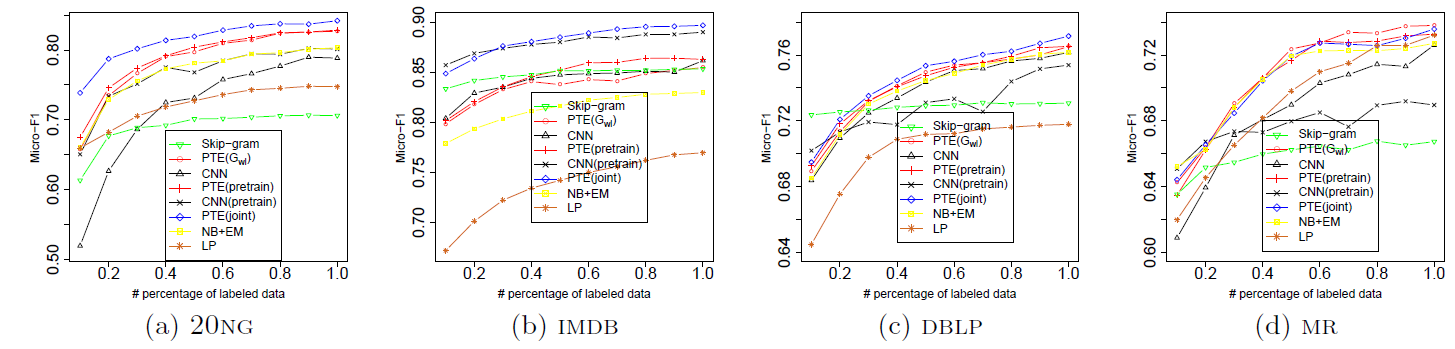

17.2.2 标记数据 & 未标记数据

我们考察标记样本规模的变化对

CNN和PTE的影响。我们考虑两种模式:- 监督学习:不包含未标记数据。如

CNN。 - 半监督学习:包含未标记数据。如

PTE(joint)、CNN等。

在半监督学习中,我们还比较了经典的半监督方法:带

EM的朴素贝叶斯NB+EM、标签传播算法label propagation:LP。可以看到:

CNN和PTE随着标记数据规模的增加,性能持续改善。- 在监督学习的

CNN和CNN或可与CNN媲美。 - 在半监督学习的

CNN(pretrain)和PTE(joint)之间,PTE(joint)始终优于CNN(pretrain)。 PTE(joint)还始终优于经典的NB+EM和LP方法。

另外我们还注意到:

- 当标记数据规模不足时,使用无监督

embedding的预训练CNN非常有效,尤其是在短文本上。当训练样本太少时,它甚至优于所有的PTE。 - 当标记数据规模增加时,预训练

CNN并不总是能够改善其性能,如DBLP和MR数据集。 - 对于

SkipGram模型,增加标记数据规模几乎不会进一步改善其性能。 - 在

DBLP数据集上,当标记样本太少时PTE性能甚至不如SkipGram。原因是当标记数据太少时,word-label网络的噪音太多。PTE将word-label网络与噪音较少的word-word, word-document网络同等对待。一种解决办法是:在标签数据不足时,调整word-label, word-word, word-document网络的采样概率。

- 监督学习:不包含未标记数据。如

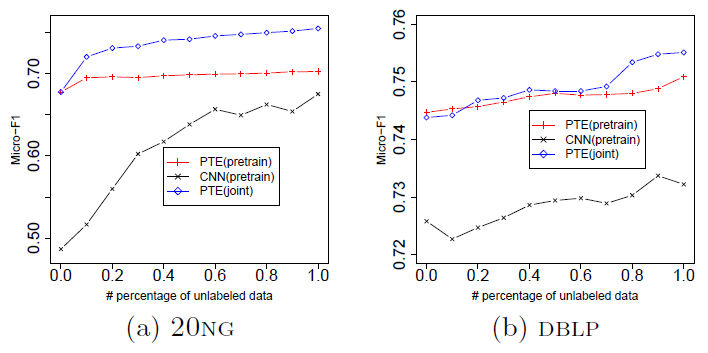

我们考察未标记数据规模的变化对

CNN(pretrain)和PTE的影响。由于篇幅有限,这里我们仅给出20NG和DBLP数据集的效果。对于CNN,未标记数据可用于预训练。对于PTE,未标记数据可用于预训练或联合训练。在

20NG数据集上,我们使用10%文档作为标记数据,剩余文档作为未标记数据;在DBLP数据集上,我们随机抽取其它会议发表的20万篇论文的标题作为未标记数据。我们使用

CNN的预训练模型。可以看到:- 当未标记数据规模增加时,

CNN和PTE性能都有改善。 - 对于

PTE模型,未标记数据和标记数据联合训练的效果要优于“预训练和微调”的方式。

- 当未标记数据规模增加时,

17.2.3 参数敏感性与可视化

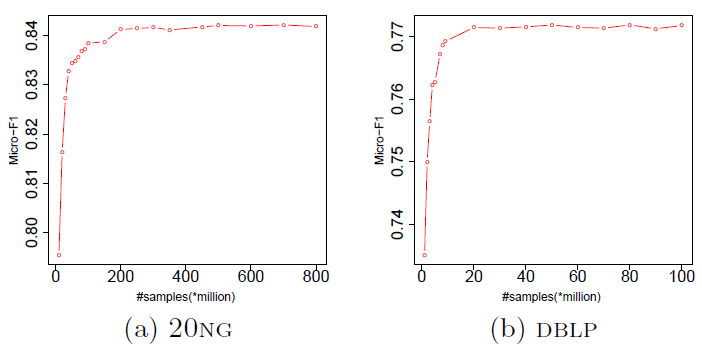

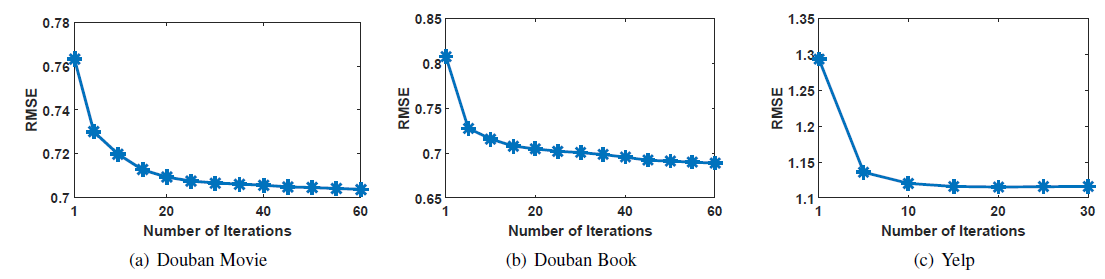

PTE模型除了训练步数T之外,大多数超参数对于不同训练集都是不敏感的(如学习率、batch size),所以可以使用默认配置。我们在

20NG和DBLP数据集上考察了PTE(joint)对于参数T的敏感性。可以看到:当T足够大时,PTE(joint)性能会收敛。实际应用中,我们可以将

T的数量设置称足够大。经验表明:T的合理范围是异质文本网络中所有边的数量的几倍。

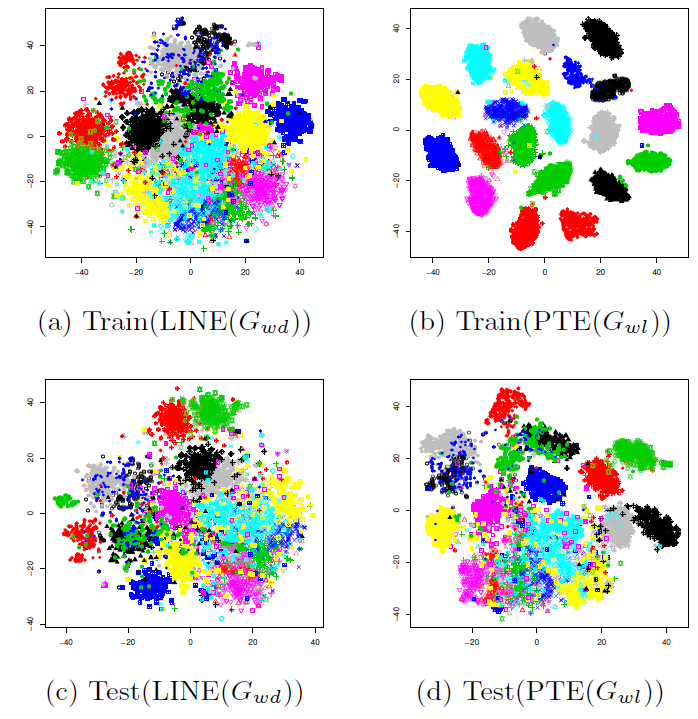

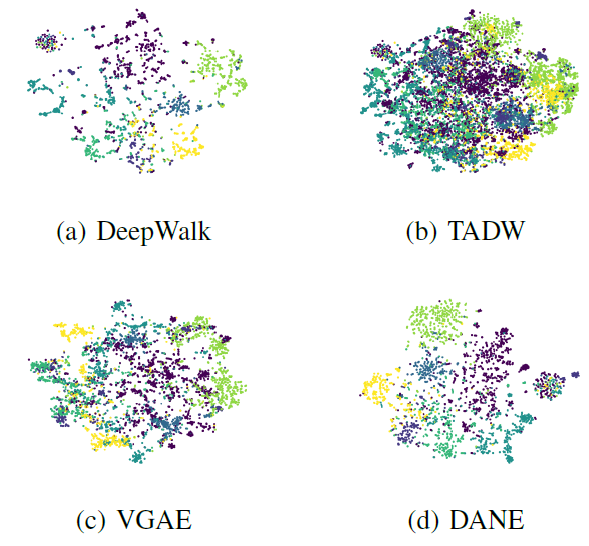

我们给出了无监督

embedding(以predictive embedding(以20NG数据集上采用tSNE可视化的结果。我们对训练集和测试集的文档均进行了可视化,其中

document embedding为document内所有word embedding的均值。可以看到:在训练集和测试集上,predictive embedding均比无监督embedding更好地区分了不同的类别。这直观表明了predictive embedding在文本分类任务中的强大能力。

17.2.4 讨论

无监督

embedding使用的基本信息是局部上下文级别或者document级别的word共现。- 在长文本中,我们可以看到

document级别的word共现比局部上下文级别的word共现效果更好,并且二者的结合并不能进一步改善效果。 - 在短文本中,局部上下文级别的

word共现比document级别的word共现效果更好,并且二者的结合可以进一步改善效果。这是因为document级别的word共现受到文本长度太短的困扰,即文本太稀疏。

- 在长文本中,我们可以看到

predictive embedding中:与

PTE相比,CNN模型可以更有效地处理标记信息,尤其是在短文本上。这是因为CNN的模型结构比PTE复杂得多,尤其时CNN可以在局部上下文中利用词序从而解决word的歧义问题。因此,在标记数据非常稀疏的情况下,CNN可以超越PTE,尤其是在短文本上。但是这个优势是以大量的计算、详尽的超参数调优为代价的。与

CNN相比,PTE训练速度更快、超参数调整更容易(几乎没有需要调整的超参数)。当标记数据更为丰富时,PTE的性能至少和CNN一样好并且通常更好。PTE模型的一个明显优势是它可以联合训练标记数据和未标记数据。相比之下CNN只能通过预训练来间接利用未标记数据。当标记数据非常丰富时,这种预训练并不总是有帮助的。

实践指南:基于上述讨论,我们提供以下实践指南。

当没有标记数据时:

- 在长文本上使用

text embedding。 - 在短文本上使用

text embedding。

- 在长文本上使用

当只有少量标记数据时:

- 在长文本上使用

PTE来学习text embedding。 - 在短文本上使用

CNN(pretrain),其中预训练采用

- 在长文本上使用

当有大量标记数据时:

- 在长文本上使用

PTE(joint)来学习text embedding。 - 在短文本上从

PTE(joint)、CNN或者CNN(pretrain)三者之间选择,其中主要考虑训练效率和模型效果之间的平衡。

- 在长文本上使用

未来方向:

PTE中考虑word的词序。

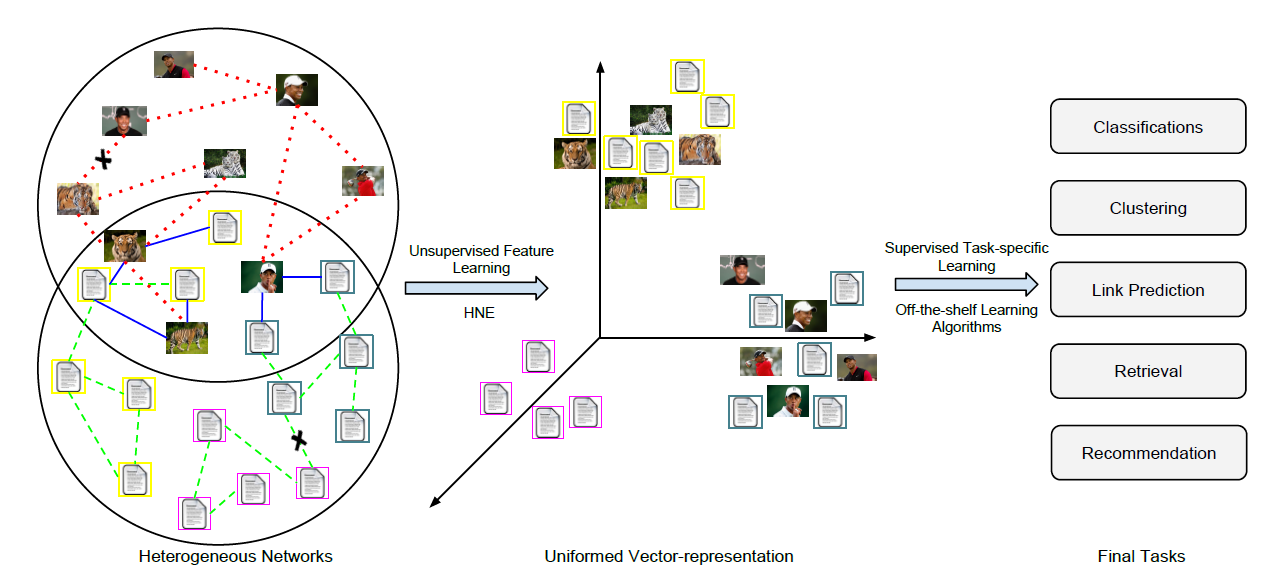

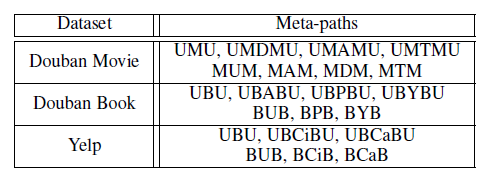

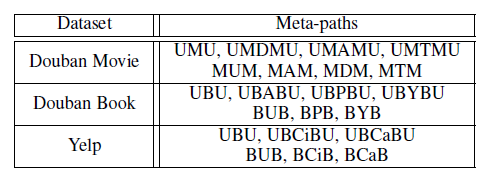

十八、HNE[2015]

向量化的

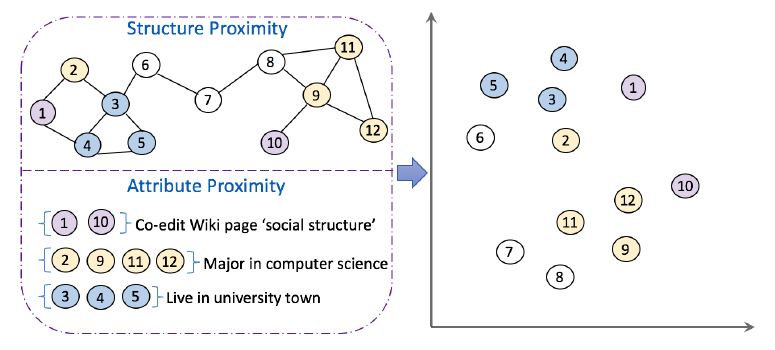

data representation经常出现在许多数据挖掘application中。向量化的data representation更容易处理,因为每个数据都可以被视为驻留在欧式空间中的一个point。因此,可以通过一个合适的指标来直接衡量不同data point之间的相似性,从而解决分类、聚类、检索等传统任务。如《Data Classification: Algorithms and Applications》所示,学习良好的representation是数据挖掘和web搜索中的基本问题之一。与设计更复杂的模型相比,学习良好的representation对任务效果的影响通常更大。不幸的是,许多

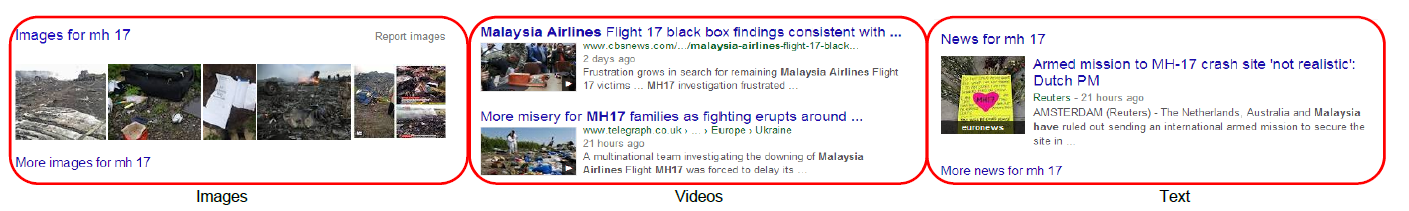

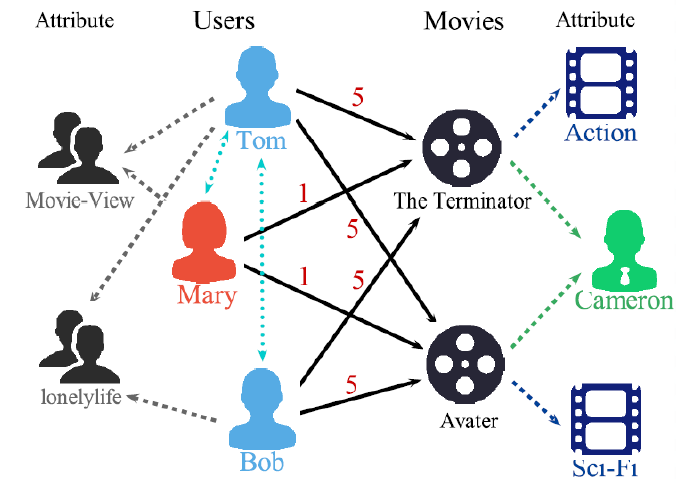

network数据源(如Facebook, YouTube, Flickr, Twitter)无法自然地表示为向量化的输入。这些社交网络和社交媒体数据通常以图数据graph data和关系数据relational data二者组合的形式来表示。当前的研究集中在预定义pre-defined的特征向量、或者复杂的graph-based的算法来解决底层任务。人们在各种主题上完成了大量的研究,例如协同分类collective classification、社区检测community detection、链接预测link prediction、社交推荐social recommendation、定向广告targeted advertising等等。对于内容和链接而言,网络数据network data以embedding形式开发的unified representation非常重要。unified representation的基本假设是:一旦获得向量化的representation,网络挖掘任务就可以很容易地通过现有的机器学习算法来解决。然而,网络数据的

feature learning并不是一项简单的任务,因为网络数据具有许多特有的特性,例如网络的规模、动态性、噪声、以及异质性heterogeneity。首先,社交网站上的多媒体数据量呈指数级增长。到2011年年中,Facebook上的照片估计数量已达1000亿张,并且每天上传的新照片数量高达3.5亿张。其次,鉴于用户的不同背景background,社交媒体往往噪音很大。而且研究人员注意到,垃圾邮件发送者产生的数据比合法用户更多,这使得网络挖掘更加困难。最后,社交媒体数据包含多样diverse的、异质的信息。例如,当事件发生时,不同类型的媒体数据都会进行报道。如下图所示,当在谷歌中搜索 “马航MH17” 时,相关结果中不仅包含文本文档,还包含图像和视频。

此外,社交媒体数据不是孤立存在的,而是由各种类型的数据组合而成的。这些交互可以通过它们之间的链接显式或隐式地形成。例如,在同一网页中同时出现的图像和文本提供了它们之间的显式链接,而文本到文本的链接是通过不同

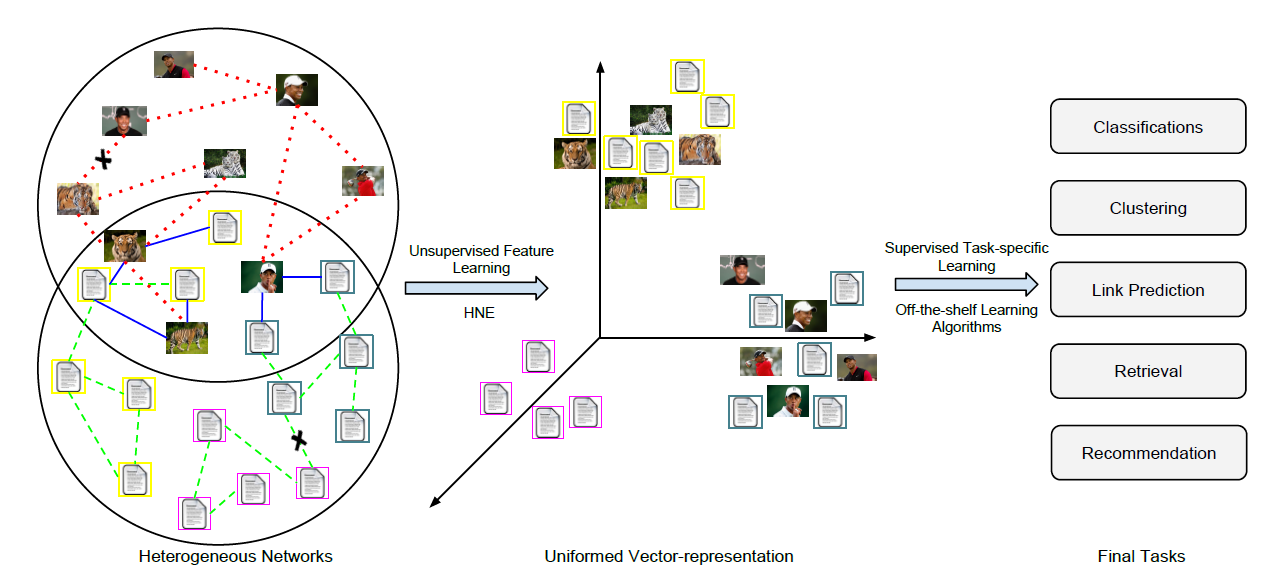

web document之间的超链接显式形成的。另一方面,用户的交互活动可以被视为隐式反馈,它链接了不同的社交媒体部分social media component。如果用户以相似的标签tag描述多张图像,那么一个合理的假设是:这些图像之间存在语义关系。很明显,如此庞大的数据量导致了复杂的异质网络,这给学习uniform representation带来了巨大的挑战。为了应对上述挑战,论文

《Heterogeneous Network Embedding via Deep Architectures》提出了一种关于network representation learning的新思想,称作Heterogeneous Network Embedding: HNE。HNE同时考虑了内容信息content information和关系信息relational information。HNE将不同的异质对象映射到一个统一unified的潜在空间中,以便可以直接比较来自不同空间的对象。与传统的线性

embedding模型不同,HNE将feature learning过程分解为深层的多个非线性层。HNE通过迭代求解关于feature learning和objective minimization的问题,从而协调并相互加强这两个部分。HNE同时建模了底层网络的全局链接结构global linkage structure和局部链接结构local linkage structure,这使得它在捕获网络链接方面比浅层embedding方案更强大,特别是当链接信息在揭示不同对象之间的语义相关性方面起关键作用时。沿着这个研究方向,论文利用网络链接来设计一个损失函数,从而迫使网络中存在链接的不同对象在embedding空间是相似的。network-preserved embedding的思想如下图所示。事实上根据

HNE的模型公式,HNE仅建模了局部链接结构(即,保留一阶邻域),并未建模全局链接结构。

HNE框架的主要优点如下:- 鲁棒性:

HNE探索不同异质对象之间的全局一致性global consistency,从而学习由网络结构指导guide的unified feature representation。 - 无监督:

HNE是无监督并且独立于任务的,这使其适用于许多面向网络的数据挖掘application。 out-of-sample:HNE能够处理out-of-sample问题(即unseen顶点)。这解决了动态网络相关的挑战,其中随着时间的推移可能会在网络中添加新顶点。

- 鲁棒性:

相关工作:

Network Embedding:feature embedding的一个分支是由网络中的协同过滤和链接预测等application所推动的。这些application根据潜在属性对实体之间的关系进行建模。这些模型通常将问题迁移transfer为学习实体的embedding,这在数学上对应于对观察到的关系矩阵的矩阵分解问题。《Combining content and link for classification using matrix factorization》提出了一种在链接邻接矩阵linkage adjacency matrix和document-term frequency矩阵上联合分解的方法,从而用于网页分类。- 此外,

《Structure preserving embedding》提出了一种structure preserving的embedding框架,该框架将图嵌入到低维欧式空间中,并保持了全局拓扑属性。 - 此外,

DeepWalk从截断的随机游走中学习网络中顶点的潜在representation。

然而,这些模型仅关注单一关系

single relation,这无法应用于异质网络。而且这些模型中的大多数很难泛化到unseen sample(即训练期间未见过的顶点)。这些方法对异质网络的自然扩展是将多个关系矩阵堆叠在一起,然后应用传统的张量分解。这种

multi-relational embedding的缺点是不同term之间共享参数,这无法扩展到大型网络。《Latent feature learning in social media network》提出的非线性embedding模型使用Restricted Boltzmann Machine: RBM进行跨模型链接分析crossmodel link analysis。但是,它没有利用原始数据中的所有社交信息,这导致了次优的解决方案。此外,计算机视觉和语音方面的工作表明,与DNN和CNN相比,layer-wise的RBM训练对于大规模数据而言效率低下。深度学习:近年来,机器学习研究已经从基于人工制作的特征显著转向为基于原始数据学到的特征,这主要归功于深度学习的成功。深度学习模型在语音识别、图像识别/检测、以及最近的自然语言处理中变得越来越重要。深度学习技术是通用函数的逼近器

approximator。然而,从历史上来看,训练具有两层以上隐层的深度神经网络很难成功。困难在于高维的参数空间、以及高度非凸的目标函数,这使得基于梯度的方法受到局部极小值的困扰。深度学习的最新进展得益于多种因素的推动,例如大规模数据集的使用、算力的增长、以及无监督和监督训练算法的进步。

- 无监督深度学习(通常被称为预训练

pre-training),借助大量可用的未标记数据来提供鲁棒的初始化和正则化。例如,《Reducing the dimensionality of data with neural networks》首次使用RBM对深度神经网络进行layer-wise初始化。《Greedy layer-wise training of deep network》也提出了类似的方法,采用自编码器来进行权重初始化。 - 最近,多层神经网络的监督学习已经成为可能。

dropout的方法已经展示出特别的前景。《Imagenet classification with deep convolutional neural networks》提出的七层卷积神经网络在ImageNet大规模视觉识别挑战赛上取得了state-of-the-art的性能。该挑战赛是计算机视觉中最具挑战性的任务之一。来自这个七层卷积神经网络的中间层的特征,后来被证明是其它计算机视觉任务(如对象检测object detection)的良好的feature representation。

在深度学习架构的背景下,人们对利用来自多模态

multiple modalities的数据越来越感兴趣。自编码器和RBM等无监督深度学习方法被部署并联合重建(部分共享的网络partially shared network)音频和视频来执行feature learning,从而成功应用于多模态任务multimodal task。另一种方案,也有人努力学习具有多个任务的联合representation。对于图像和文本,一种特别有用的场景是通过将语义上有意义的embedding空间与图像label相结合,从而实现对unseen的label进行图像分类的zero-shot learning。据我们所知,之前很少有人尝试利用网络中的链接结构进行

representation learning。在《A deep learning approach to link prediction in dynamic network》中,它使用条件conditional的动态temporary的RBM对网络链接的动态性进行建模,主要任务是使用历史数据预测未来的链接。与我们最相似的工作是《Latent feature learning in social media network》,其中它在多媒体链接数据上训练一个content RBM。我们在几个方面与他们的工作不同:我们在无监督环境中使用监督学习的方案,我们的方法可以扩展到大规模数据集,我们执行多任务学习从而融合来自不同模态的形式。- 无监督深度学习(通常被称为预训练

18.1 模型

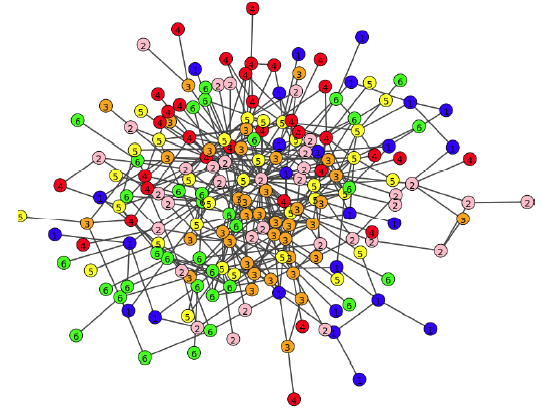

异质网络

heterogeneous network指的是具有不同类型对象、和/或具有不同类型链接的网络。从数学上讲,我们定义一个无向图此外,图

网络的异质性分别由集合

heterogeneous的。否则网络是异质heterogeneous的。下图说明了一个异质网络的示例,其中包含两种对象类型和三种链接类型。为了进一步便于理解,我们将假设对象类型为image: I、text: T。链接关系image-to-image(红色点虚线)、text-to-text(绿色短虚线)、image-to-text(蓝色实线),分别用RII, RTT, RIT表示。因此,在这种情况下,我们有因此,任何顶点

unique的内容信息。具体而言:- 对于每个图像顶点

- 对于每个文本顶点

例如,图像的内容是

RGB颜色空间中的原始像素格式,文本的内容是文档的Term Frequency - Inverse Document Frequency: TF-IDF得分。我们将链接关系表示为一个对称的邻接矩阵注意,这里的邻接矩阵元素取值为

{+1, -1},这和经典的{+1, 0}不同。这是为了后面的损失函数服务,给 “负边”(即,未链接的顶点对)一个非零值可以在损失函数中引入 “负边” 的信息。虽然这种邻接矩阵是完全稠密的矩阵,但是我们可以仅存储“正边”,从而仍然存储一个稀疏版本的邻接矩阵。

- 对于每个图像顶点

接下来,我们首先引入一种新的损失函数来衡量跨网络的相关性,并以数学方式展示我们的

HNE框架。本质上,embedding过程为每个对象同时将异质内容和异质链接编码到一个representation中。然后我们提出了一种

linkage-guided的深度学习框架,从而同时对潜在空间embedding和feature learning进行联合建模。这可以通过使用反向传播技术有效地求解。最后,我们讨论了将

HNE算法直接扩展到多于两种对象类型的一般情况。

18.1.1 线性 HNE

异质

embedding任务的主要目标是学习映射函数,从而将不同模态的数据映射到公共空间,以便直接衡量对象之间的相似性。假设与图像顶点相关联的原始内容representationfeature machine。值得一提的是,我们使用两个线性变换矩阵

represetnation分别为尽管图像和文本可能在不同维度的空间中表示,但是变换矩阵

data point之间的相似性可以表示为投影空间中的内积,即:注意,由于嵌入到公共空间,不同类型对象(如文本和图像)之间也可以进行相似度计算,即:

这里

潜在

embedding与文献《Learning locally-adaptive decision functions for person verification》中已被广泛研究的相似性学习similarity learning和度量学习metric learning密切相关。即,两个顶点之间的相关性correlation可以通过投影矩阵application-specific的方式来建模异质关系的灵活性。对象之间的交互被表示为网络中的异质链接。我们假设:如果两个对象是连接的,则它们之间的相似性应该比孤立对象之间的相似性更大,从而反映这一事实(即,对象是连接的)。

注意,这里仅考虑一阶邻近性,即直接连接关系。

考虑两个图像

pairwise决策函数注意,要推断

in-sample。这意味着该方法具有泛化能力从而嵌入unseen顶点。这句话的意思是,

unseen的顶点,我们也可以计算对于所有顶点

bias值。则损失函数可以定义为:这可以视为由网络链接引导

guided的二元逻辑回归。text-text损失函数和image-text损失函数也是类似的,只需要将bias值。该损失函数仅捕获一阶邻近性(即局部网络结构),没有捕获高阶邻近性(既全局网络结构)。

该损失函数迫使相连的顶点之间的

embedding是相似的、不相连的顶点之间的embedding是不相似的。这就是为什么最终我们的目标函数如下:

其中:

image-image链接的数量,即text-text链接的数量,即image-text链接的数量,即F范数。bias值既可以从数据中学习得到,也可以设为固定值。为简单考虑,我们都设置为固定值。

该最优化问题可以通过坐标下降法

coordinate descent得到有效解决,每次固定一个变量从而求解另一个变量:首先固定参数

18.1.2 深度 HNE

目前为止,我们已经证明了我们的损失函数融合了网络结构,从而将不同异质成分

heterogeneous component映射到统一的潜在空间。然而,这种embedding函数仍然是线性的,可能缺乏建模复杂网络链接的能力。接下来我们引入深度学习框架。前面部分我们的解决方案可以分为两个步骤:

- 手动构造顶点的

feature representation:对于文本顶点使用其TF-IDF向量,对于图像顶点使用其原始RGB像素点拼接而成的向量。 - 将不同的

feature representation嵌入到公共的低维空间中。

这里我们通过深度学习将

feature representation的learning和embedding合并在一起。- 手动构造顶点的

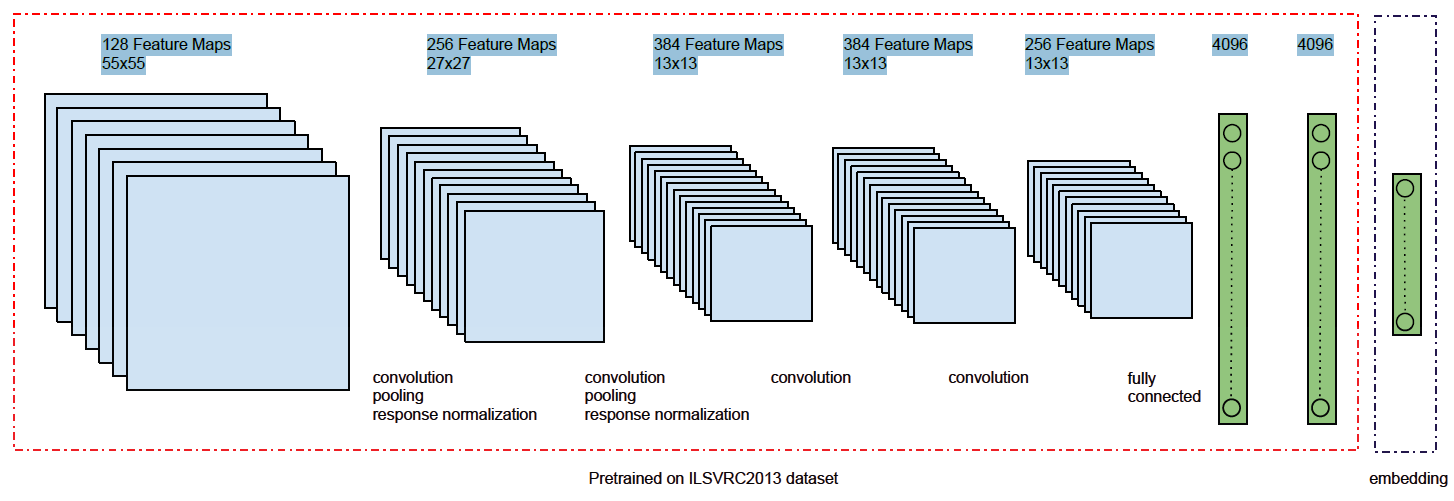

feature representation learning:定义图像特征抽取的非线性函数为

CNN来抽取图像特征。下图为一个图像特征抽取模型,它由五个卷积层、两个全连接层组成。所有层都采用ReLU非线性激活函数。该模块称作deep image模块。

定义文本特征抽取的非线性函数为

FC对文本的TF-IDF输入来抽取特征。该模块称作deep text模块。

则我们的损失函数变为:

feature representation embedding:我们可以通过一个额外的线性embedding layer来级联deep image模块和deep text模块。定义

其中:

我们使用

dropout代替了我们使用新的损失函数:

与前面的

bias项。

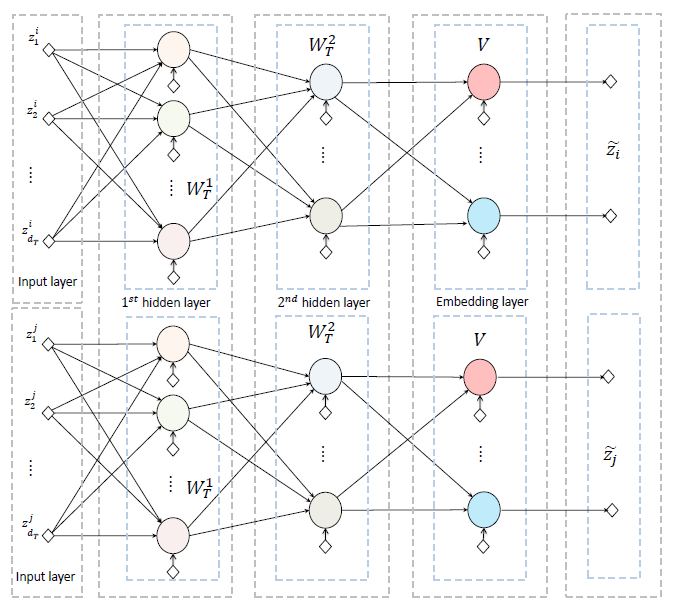

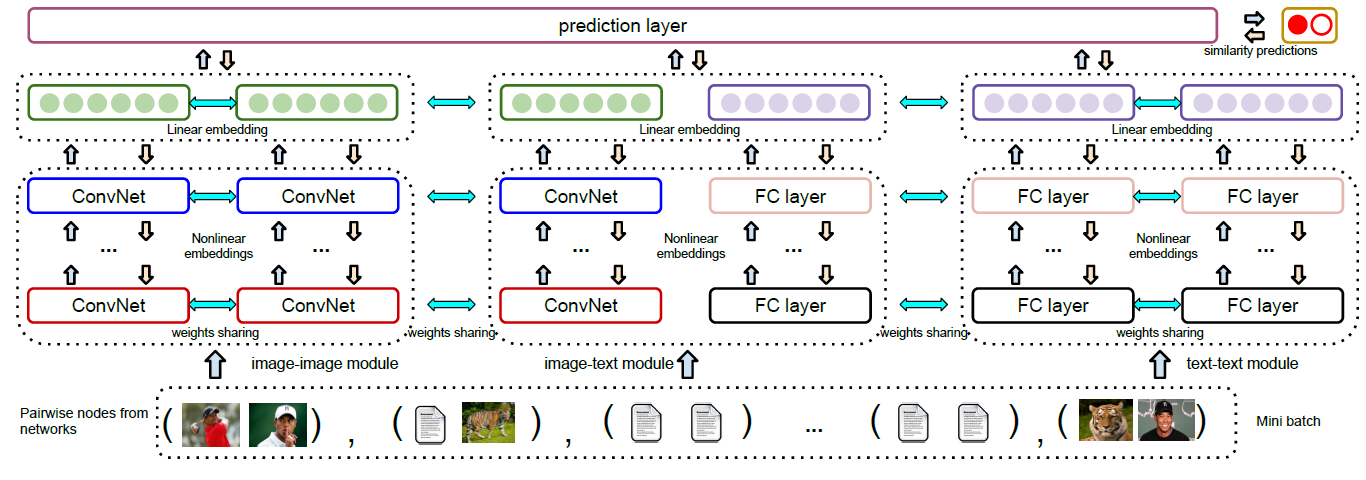

该目标函数可以通过随机梯度下降

SGD来求解。为进行端到端的

HNE学习,我们将deep image模块和deep image模块连接起来。我们以text-text链接为例,另外两种类型的链接也是类似的。下图包含两个deep text模块,它们构成了pairwise的text-text模块。deep text模块包含两个FC全连接层,然后是一个线性embedding层。这里有些违反直觉。主流的

DNN模型都是先通过一个embedding层,然后再通过FC层。线性

embedding层的输出是公共潜在空间中的低维向量,该低维向量进一步送到预测层prediction layer来计算损失函数。text-text模块是对称的,下图中相同颜色的神经元共享相同的权重和偏差,箭头表示前向传播的方向。

HNE的整体架构如下图所示,图中展示了三个模块,从左到右依次为image-image模块、image-text模块、text-text模块。这些模块分别连接到prediction layer来计算损失函数。下图中,相同的颜色代表共享权重。箭头表示前向传播和反向传播的方向。

讨论:

- 目前为止我们仅展示了两种类型顶点的异质网络

embedding方法。事实上,我们的框架也支持多种类型顶点的异质网络embedding。 - 由于深度学习是高度非线性和非凸的,因为无法保证全局最优解。参数的初始化对模型性能至关重要。文献表明,即使最终任务与

pre-training任务不同,精心设计的pre-training也可以显著提高最终任务的表现。 - 值得一提的是,我们提出的方法是无监督学习方法,因此可以作为下游

fine-tuning微调阶段的预训练pretraining步骤来使用。换句话讲,如果我们想对网络顶点进行分类,那么我们可以从embedding layer获得最终特征并应用相应的机器学习算法。或者我们也可以将prediction layer替换为softmax层,然后进行微调为task-specific的端到端监督学习深度神经网络。

- 目前为止我们仅展示了两种类型顶点的异质网络

18.2 实验

数据集:我们使用来自现实世界社交网络的两个公开数据集。所有实验结果均在五次不同的运行中取均值。

BlogCatalog:一个社交博客网络,博主可以在预定义的类别下对其博客进行分类。这样的分类用于定义类标签,而following(即,关注)行为用于构建博主之间的链接。我们使用每个博主的所有博客内容的TF-IDF向量作为博主的内容特征。最终我们得到一个无向、同质图,每个顶点代表一个博主,顶点的特征为TF-IDF向量。最终该图包含5196个顶点、171743条边、类别数量6、内容向量维度8189,并且该数据集各类别是平衡的。NUS-WIDE:Flickr上的图像和文本数据,包含269648张关联有tag的图像,其中tag集合大小为5018。每一组image-tag标记有一个label,一共81个类别。由于原始数据中包含很多不属于任何类别的噪音样本,因此这些样本被删除。另外,我们将频次最高的

1000个tag作为文本并抽取其TF-IDF向量作为特征。我们进一步删除了不包含任何这1000个tag中单词的样本。最终我们分别随机抽样了53844和36352个样本进行训练和测试。我们将图像和文本分别视为独立的顶点来构建异质网络,训练网络包含

107688个顶点、测试网络包含72704个顶点。如果两个顶点共享至少一个概念concept,则构建它们之间的语义链接。我们对每个顶点最多随机采样30个链接,从而构建稀疏的邻接矩阵值得一提的是,我们以

out-of-sample方式来评估不同的算法。即,训练样本绝对不会出现在测试数据集中。

网络重建

Network Reconstruction:在分类、聚类或检索任务之前,我们首先对网络链接重建的质量进行基本的、直观的评估,从而验证我们的假设。我们从BlogCatalog数据集中随机选择500个顶点,然后可视化其链接,其中每个顶点的颜色代表其类别。可以看到:相对而言,社交“关注” 关系倾向于将具有相似属性的用户聚合在一起。

绝对而言,这种聚合之中存在大量噪音,其中

59.89%的链接连接到了不同类别的顶点。这是可以理解的,因为即使

HNE百分之百地重建了网络,但是原始网络本身就存在大量的、不同类别的顶点链接在一起的情况。

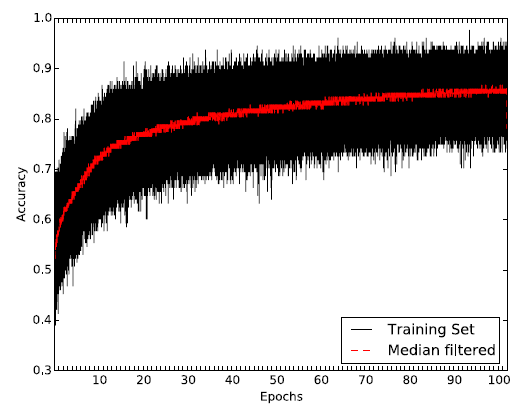

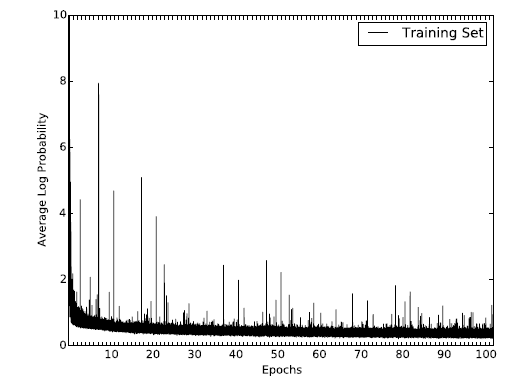

我们评估了算法学习

embedding过程中,训练集每个mini-batch的链接重建准确率 :预估正确的pair对的数量, 除以所有的pair对的数量。其中mini-batch = 128。结果如下图所示,其中横轴表示epoch,每个epoch包含500个step。红线表示每个epoch重建准确率的均值。可以看到:随着学习的推进,算法能够正确地重建80%以上的链接,而一开始的准确率只有55%。注意,这里是训练集的重建准确率,而不是测试集的。

18.2.1 BlogCatalog 数据集

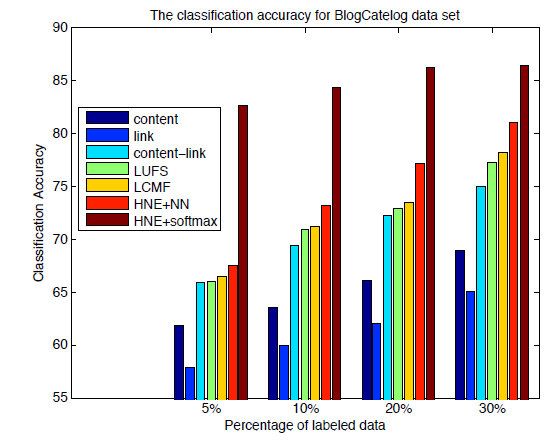

分类任务:在

BlogCatalog数据集上,我们将我们的feature learning方法和以下feature learning方法进行比较:Content:基于原始空间的内容特征,即用户所有博主的TF-IDF特征向量。Links:基于原始空间的链接特征,即用户的邻接关系作为特征。Link-Content:将内容和邻接关系都视为特征。LUFS:针对内容和链接的无监督特征抽取框架。LCMF:基于链接和内容的矩阵分解方法。HNE:我们提出的异质网络特征抽取方法。

对于这些抽取出来的特征,我们使用标准的

kNN分类器来评估特征的分类效果。为确保公平比较,所有方法的embedding维度固定为100。对于Content/Links/Link-Content方法抽取的特征,我们使用PCA算法投影到100维的空间。这些模型的分类准确率如下所示。可以看到:

- 在不同规模的训练集中,

HNE始终优于其它的baseline方法。这是因为网络链接可以编码很多有用的信息。 - 如果将

embedding视为预训练步骤,并通过将多类softmax替换掉predict layer来微调整个模型,则我们的效果会进一步提升。这表明了无监督的embedding学习对于有监督分类任务提供了很好的初始化,并能进一步提升性能。

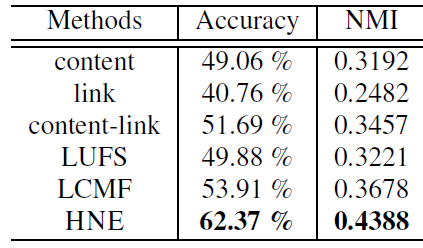

聚类任务:我们还比较了

BlogCatalog数据集上不同方法得到的embedding的聚类表现。与分类任务相比,聚类任务是完全无监督的,并很大程度上依赖于相似性度量函数。这里我们采用最常见的余弦相似度。我们根据聚类后的结果以及label信息,同时给出了准确率和互信息normalized mutual information :NMI作为评估指标。结果表明:

- 类似分类任务,仅使用链接会带来最差的结果。这可能是因为:在没有全局内容信息指导的条件下,相似性往往是局部的,并且对噪音非常敏感。

- 仅内容相似性不足以捕获关系信息。

- 通过链接和内容的简单组合,这可以提供与其它

baseline相当的性能。 - 我们的

HNE模型优于所有其它baseline模型并达到state-of-the-art的水平。

18.2.2 NUS-WIDE 数据集

与

BlogCatalog相比,NUS-WIDE数据集构成了一个包含图像、文本的异质网络。我们将在分类任务、跨模态检索cross-modal retrieval任务中评估HNE的性能。注意,跨模态检索任务在前一个数据集的同质场景中是不可行的。分类任务:鉴于

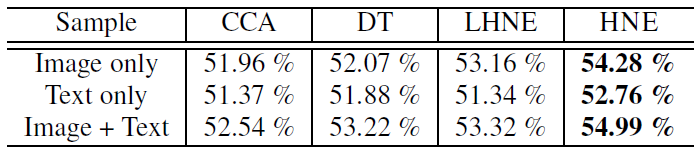

BlogCatalog的异质场景,我们将我们的方法和以下无监督的、能够处理多模态输入的baseline进行比较:Canonical Correlation Analysis: CCA:根据输入的多个数据源的关系将它们嵌入到共同的潜在空间。DT:一种迁移学习方法,通过潜在embedding来减少图像和文本之间的语义距离。LHNE:HNE的线性版本。

我们为所有其它

baseline方法抽取了4096维的特征,但是由于我们的HNE方法是端到端的,因此不需要为图像手动抽取特征。由于NUS-WIDE数据集是类别不平衡的,因此我们用平均精度average precsision:AP来评估每种可能的标签结果的分类性能。AP就是P-R曲线下的面积,mAP就是所有类别的AP的均值。事实上,AP就是把recall的取值根据11个水平(也可以划分更小的单位),然后取对应的Precision的平均值。在P-R曲线上这等价于曲线的线下面积。为了方便比较,所有方法的公共嵌入空间的维度为

400维,并且使用线性支持向量机SVM来作为所有方法产出的embedding的通用分类器。之所以用SVM是因为计算AP需要预估一个概率值,而这不方便从深度神经网络分类器中取得。我们比较了三种配置:

image only:仅在图像顶点上学习embedding,然后训练SVM、执行分类测试。text only:仅在文本顶点上学习embedding,然后训练SVM、执行分类测试。image + text:同时使用图像顶点和文本顶点学习embedding,然后后训练SVM、执行分类测试。

可以看到:

- 对于所有方法,仅使用文本数据进行分类效果最差。这可能是由于:和图像输入相比,文本输入非常稀疏。

- 仅使用线性的

HNE,我们就可以获得与DT相当的结果,并且优于CCA。 - 非线性

HNE在所有三种配置中进一步提高性能,这表明使用非线性函数同时优化feature learning和潜在embedding的优势。

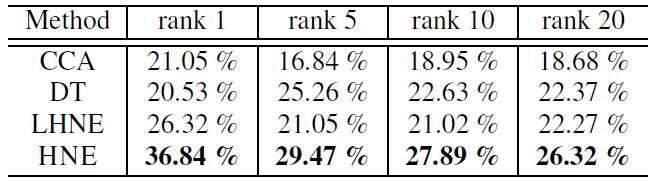

跨模态检索:为进一步验证

HNE的能力,我们在跨模态检索任务中将我们的方法和baseline进行比较。我们的目标是希望通过文本query来召回对应的图片。在所有81个label中,有75个出现在TF-IDF文本向量中。因此我们基于这75个label word来构建query向量:其中

query向量长度为1000, 除了第label对应的位置为1,其它所有位置为零。query向量一共有75个。根据学到的

embedding函数,我们将这些query向量都映射到公共潜在空间中,并通过欧式距离来检索测试集中的所有图像。我们报告了average precision at rank k: p@k(top k结果中的平均precision值) 的结果。 可以看到:HNE明显优于其它baseline。

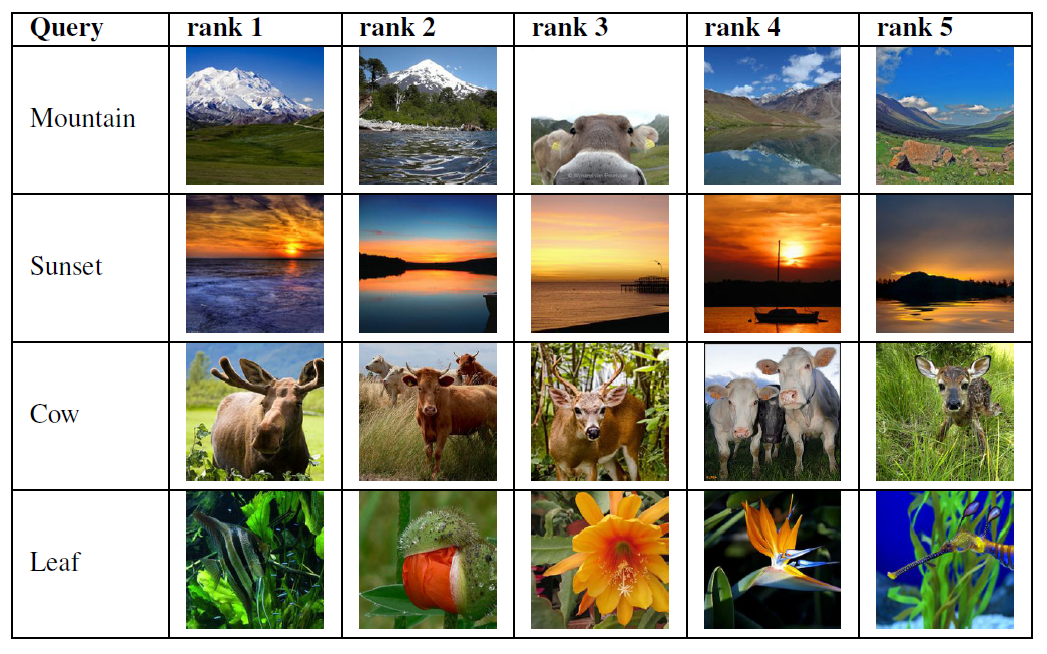

然后我们给出一些检索的案例。可以看到:

Mountain的第三个检索结果不正确,这可能是由于其它Mountain图像和带有牛的Mountain图像之间存在极大的视觉相似性。Cow的检索结果中包含三只鹿,这是因为这些图像具有多个tag,并通过“动物” 概念进行链接。由于我们的方法以及

ranking函数完全是无监督的,因此cow和deer等对象之间的联系会混淆我们的embedding学习。我们预期使用监督ranking可以提升性能。

18.2.3 其它

训练收敛性:我们展示了

HNE在BlogCatalog数据集上目标函数的变化,从而验证模型的收敛性。其中x轴代表epoch。可以看到:目标函数经过60个epoch的持续性降低之后趋向于平稳,这表明算法可以收敛到稳定结果。

十九、AANE[2017]

网络分析已经成为许多实际应用中的有效工具,例如精准营销

targeted marketing和基因分析。识别有效特征对于这些任务至关重要,但是这涉及大量的人力和大规模的工程实验。作为替代方案,network embedding将每个节点的拓扑结构topological structure映射为低维的向量represetnation,从而可以很好地保留原始网络邻近性proximity。已有工作表明,network embedding可以使各种任务收益,例如节点分类、链接预测、网络聚类。虽然现有的

network embedding算法专注于纯网络pure network,但是现实世界网络中的节点通常关联一组丰富的特征或属性,这称作属性网络attributed network。像同质性homophily和社交影响social influence等社会科学理论表明:节点属性与网络结构高度相关,即一方的形成取决于并影响了另一方。例如,微博中用户帖子和“关注” 关系之间的强关联,论文主题和引用关系的高度相关性。在各种应用中,已有工作表明联合利用这两个信息源(即节点拓扑结构和节点属性)可以提高学习性能。受到这些的启发,论文《Accelerated Attributed Network Embedding》提出研究节点特征是否可能有助于学到更好的embedding representation。此外,现实世界的网络通常是大规模的,具有大量节点和高维特征。例如,截至

2016年,美国每月有超过6500万活跃的Twitter用户,每个用户可以发布数千条推文。这对embedding算法的可扩展性提出了更高的要求。属性网络embedding在以下三个方面具有挑战性:- 高的时间复杂度可能是限制算法在实践中应用的瓶颈。一些工作致力于利用网络结构和属性信息来寻找低秩

low-rank的潜在representation。它们要么在每次迭代中需要具有eigen-decomposition(其中 - 由于异质信息

heterogeneous information的各种组合,在网络和属性的联合空间中评估节点邻近性node proximity具有挑战性。另外,随着网络规模的扩大,节点属性邻近性node attribute proximity矩阵往往太大,无法存储在单机上,更不用说对它的操作了。因此,如果embedding算法也是可扩展的,那么将很有吸引力。 - 两个信息源都可能不完整

incomplete的且充满噪音noisy的,这进一步加剧了embedding representation learning问题。

因此,鉴于数据的独有特性,现有方法不能直接应用于可扩展的、属性网络的

embedding。为了应对上述挑战,论文研究了在属性网络上有效地学习embedding representation的问题。论文旨在回答以下问题:- 如何在网络结构和节点属性组成的联合空间中有效地建模节点邻近性?

- 如何使

vector representations learning过程具有可扩展性scalable和高效efficient?

通过调研这些问题,论文提出了一个称作

Accelerated Attributed Network Embedding: AANE的新框架。总之,本文贡献如下:- 正式定义属性网络

embeding问题。 - 提出一个可扩展的、高效的框架

AANE。AANE通过将节点属性邻近性纳入network embedding,从而学到有效的、统一的embedding representation。 - 提出一种分布式优化算法。该算法将复杂的建模和优化问题分解为许多低复杂度的子问题,使得

AANE能够高效地处理每个节点。 - 在三个真实数据集上验证了

AANE的效率和效果。

- 高的时间复杂度可能是限制算法在实践中应用的瓶颈。一些工作致力于利用网络结构和属性信息来寻找低秩

相关工作:

network embedding已经成为处理大规模网络的有效工具。人们已经从各个方面进行了努力。《Scalable learning of collective behavior based on sparse social dimensions》提出了一种edge-centric的聚类方案,从而提高学习效率并减轻内存需求。《Distributed large-scale natural graph factorization》提出了一种基于随机梯度下降的分布式矩阵分解算法来分解大规模图。《LINE: Large scale Information Network Embedding》通过将weighted edge展开unfolding为多个binary edge来提高随机梯度下降的效率。《Asymmetric transitivity preserving graph embedding》设计了一种Jacobi-Davidson类型的算法来近似和加速high-order proximity embedding中的奇异值分解。《Structural deep network embedding》涉及深度架构从而有效地嵌入节点的一阶邻近性和二阶邻近性。

人们已经研究并分析了各个领域中的属性网络,并表明:通过联合利用几何结构和节点属性来提高学习性能变得越来越有希望。

《What's in a hashtag? content based prediction of the spread of ideas in microblogging communities》通过利用内容和拓扑特征改善了对思想ideas传播的预测。《Exploring context and content links in social media: A latent space method》基于pairwise相似性对内容信息进行建模,并通过学习语义概念semantic concept之间的结构相关性structural correlation,从而将内容信息与上下文链接一起映射到语义潜在空间中。《Probabilistic latent document network embedding》通过为网络链接和文本内容找到一个联合的低维representation,从而为文档网络提出了一个基于概率的框架。《Heterogeneous network embedding via deep architectures》设计了一种深度学习方法,将丰富的链接信息和内容信息映射到潜在空间,同时捕获跨模态数据之间的相关性。

属性网络分析不同于多视图学习。属性网络的网络结构不止一个视图,其底层属性很复杂,包括连通性

connectivity、传递性transitivity、一阶和更高阶的邻近性等等。

19.1 模型

19.1.1 基本概念

设

每条边

定义节点

定义

attributed network embedding为:给定网络embedding向量embedding向量能够同时保留节点的结构邻近关系、节点的属性邻近关系。所有节点的embedding向量构成embedding矩阵

19.1.2 AANE

现实世界属性网络的理想

embedding方法需要满足以下三个要求:- 首先,它需要能够处理任意类型的边(如,无向/有向边、无权/带权边)。

- 其次,它需要同时在网络空间和属性空间中都很好地保持节点邻近性。

- 最后,可扩展性很重要,因为节点的数量

为此,我们开发了一个满足所有要求的、有效的、高效的框架

AANE。这里我们将描述AANE如何以有效的方式联合建模网络结构邻近性和属性邻近性。网络结构建模:为了保持

AANE提出两个假设:- 首先,假设基于图的映射

graph-based mapping在边上是平滑的,特别是对于节点密集的区域。这符合 “聚类假设”cluster hypothesis。 - 其次,具有更相似拓扑结构或由更高权重连接的一对节点更有可能具有相似的

embedding。

为了实现这些目标,我们提出以下损失函数来最小化相连节点之间的

embedding差异:其中

embedding representation,- 首先,假设基于图的映射

属性邻近性建模:节点的属性信息与网络拓扑结构紧密相关。网络空间中的节点邻近性应该与节点属性空间中的节点邻近性一致。为此,我们研究如何使得

embedding representation受对称矩阵分解

symmetric matrix factorization的启发,我们提出使用attribute affinity matrixembedding representation其中亲和矩阵可以通过节点属性相似性来计算,具体而言这里我们采用余弦相似度。假设节点

计算亲和矩阵的时间复杂度为

top k个节点,从而将时间复杂度和空间复杂度降低到Joint Embedding Representation Learning:现在我们有两个损失函数其中

- 当

embedding,。因此每个节点都可以是一个孤立的cluster。 - 当

embedding相同(即embedding空间中形成单个cluster。

因此我们可以通过调节

embedding空间中cluster的数量。AANE可以视为带正则化项的矩阵分解,其中将embedding空间中彼此靠近。AANE仅考虑网络结构的一阶邻近性,无法捕获网络结构的高阶邻近性。AANE仅捕获线性关系,未能捕获非线性关系。AANE分别独立地建模网络结构邻近性和节点属性邻近性,并未建模二者之间的交互。- 当

19.1.3 加速算法

AANE的目标函数不仅联合建模网络结构邻近性和节点属性亲和性,而且它还具有特殊的设计, 从而能够更有效地和分布式地优化:separable的,因此可以重新表述为双凸优化问题bi-convex optimization。如果我们添加一个副本

则目标函数重写为:

这表明

separable的。考虑到上式的每一项都是凸函数,因此这是一个双凸优化问题。因此我们可以将原始问题划分为但是, 对于这

Alternating Direction Method of Multipliers: ADMM的做法来加速优化过程:将学习过程转换为updating step和一个矩阵updating step。也可以用随机梯度下降法来求解。这里介绍的优化算法需要

现在我们介绍优化过程的细节。我们首先引入增强的拉格朗日函数:

其中

我们可以交替优化

step的更新为:根据偏导数为零,我们解得

这里我们使用

《Efficient and robust feature selection via joint-norms minimization》证明了这种更新规则的单调递减特性。由于每个子问题都是凸的,因此当由于原始问题是一个

bi-convex问题, 因此可以证明我们方法的收敛性,确保算法收敛到一个局部极小值点。这里有几点需要注意:在计算

计算

如果机器内存有限,则也可以不必存储亲和矩阵

其中

为了进行适当的初始化,我们在第一次迭代中将

AANE将优化过程分为updating step分配给worker。当原始残差整体而言,

AANE优化算法有几个不错的特性:- 首先,它使得

updating step彼此独立。因此,在每次迭代中,global coordination可以将任务并行分配给worker并从这些worker中收集结果,而无需考虑任务顺序。 - 其次,所有

updating step都具有低复杂度。 - 最后,该方法快速收敛到一个合适的解。

- 首先,它使得

AANE优化算法:输入:

- 图

- 节点属性矩阵

embedding维度- 收敛阈值

- 图

输出:所有节点的

embedding矩阵步骤:

从属性矩阵

初始化:

计算属性亲和矩阵

迭代,直到残差

- 计算

- 分配

worker, 然后更新:对于 - 计算

- 分配

worker, 然后更新:对于 - 计算

- 更新

- 计算

返回

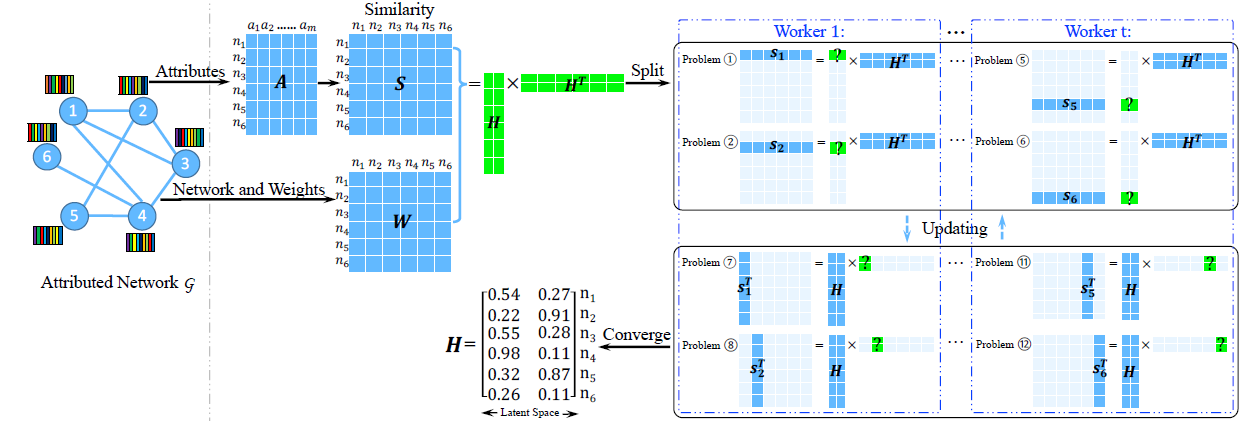

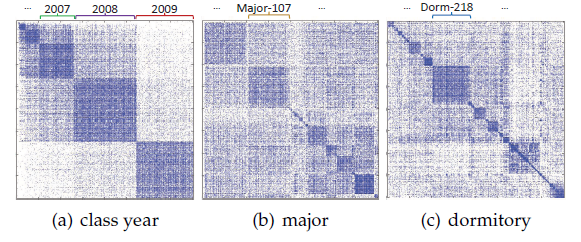

下图说明了

AANE的基本思想:给定一个为了加速优化算法,我们提出了一种分布式优化算法,将原始问题分解为

worker。在最终输出中,节点1和节点3分别分配了相似的向量[0.54, 0.27]和[0.55, 0.28],这表明这两个节点在原始网络和属性的联合空间joint space中彼此相似。

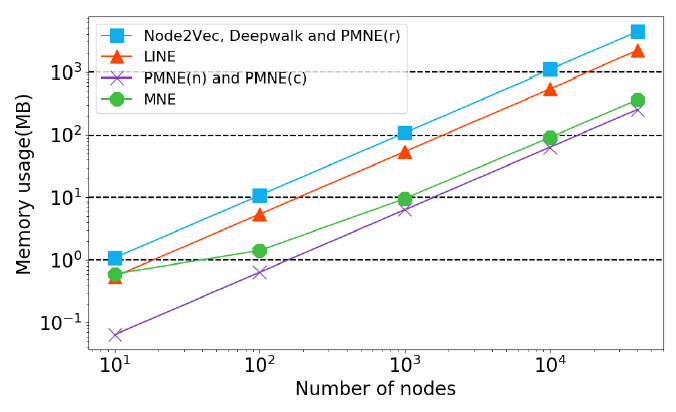

算法复杂度:由于

AANE的优化算法是一个典型的ADMM算法,因此训练算法在迭代很少的几个step之后就能收敛到很高的精度。在初始化步骤,由于需要计算奇异值向量,因此计算复杂度为

在每个子任务过程中,更新

另外,可以验证每个子任务的空间复杂度为

因此

AANE总的时间复杂度为worker数量。AANE的算法复杂度总体而言在

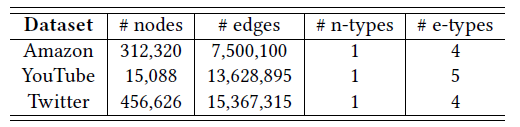

19.2 实验

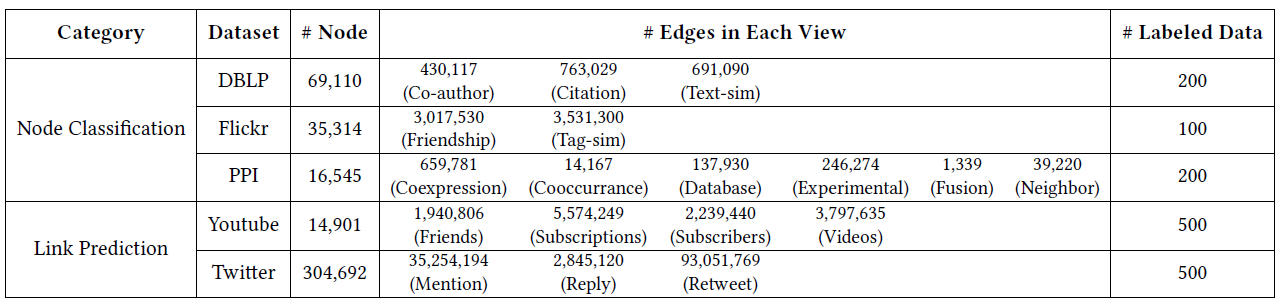

数据集:

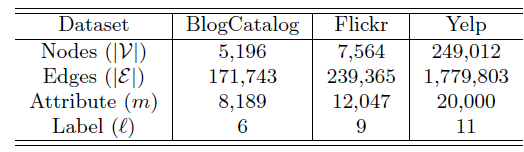

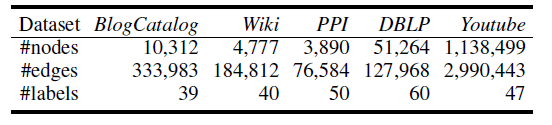

BlogCatalog数据集:一个博客社区,用户彼此关注从而构成一个网络。用户可以生成关键词来作为其博客的简短描述,我们将这些关键词作为节点(用户)的属性。用户也可以将其博客注册为指定的类别,我们将这些类别作为用户的label。没有关注或者没有指定类别的用户从网络中剔除。Flickr数据集:一个在线图片共享社区,用户彼此关注从而构成一个网络。用户可以为图片指定tag,我们将这些tag作为节点(用户)的属性。用于可以加入不同的组,我们将这些组作为用户的label。Yelp数据集:一个类似大众点评的本地生活评论网站。我们基于用户的社交关系来构成一个网络。我们从用户的评论中利用bag-of-word抽取文本信息来作为用户的属性信息。所有本地商家分为11个主要类别,如Active Life, Fast Food, Services...,我们将用户所点评的商家的类别作为用户的label。

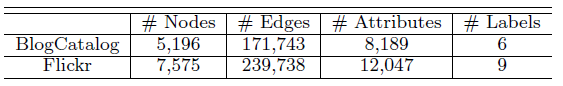

这些数据集的统计信息如下所示。

baseline模型:为评估节点属性的贡献,我们对比了DeepWalk,LINE,PCA等模型,这些baseline模型仅能处理网络结构或者节点属性,无法处理二者的融合;为了对比AANE的效率和效果,我们对比了其它的两种ANE模型LCMF, MultiSpec。DeepWalk:使用SkipGram学习基于图上的、截断的随机游走序列从而得到图的embedding。LINE:建模图的一阶邻近度和二阶邻近度从而得到图的embedding。PCA:经典的降维技术,它将属性矩阵top d个主成分作为图的embedding。LCMF:它通过对网络结构信息和顶点属性信息进行联合矩阵分解来学习图的embedding。MultiSpec:它将网络结构和顶点属性视为两个视图view,然后在两个视图之间执行co-regularizing spectral clustering来学习图的embedding。

实验配置:在所有实验中,我们首先在图上学习顶点的

embedding,然后根据学到的embedding向量作为特征,来训练一个SVM分类模型。分类模型在训练集上训练,然后在测试集上评估Macro-F1和Micro-F1指标。在训练

SVM时,我们使用五折交叉验证。所有的顶点被随机拆分为训练集、测试集,其中训练集和测试集之间的所有边都被移除。考虑到每个顶点可能属于多个类别,因此对每个类别我们训练一个二类SVM分类器。所有模型的

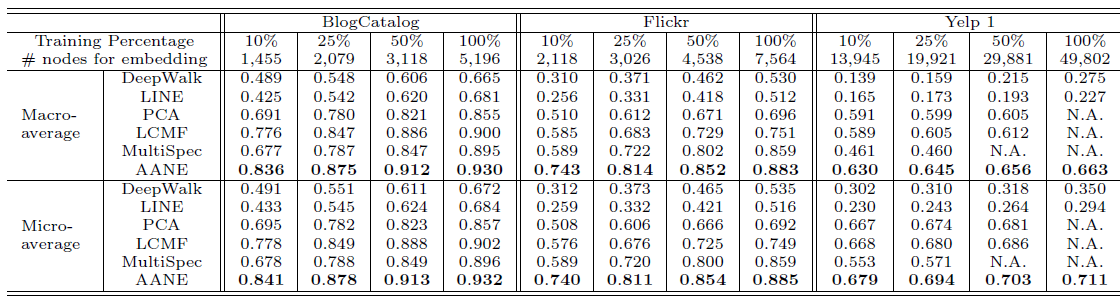

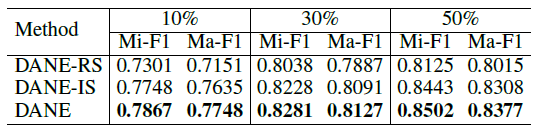

embedding维度设置为10并报告评估指标的均值。属性信息的影响:我们分别将分类训练集的规模设置为

10%,25%,50%,100%。其中,由于Yelp数据集的规模太大,大多数ANE方法的复杂度太高而无法训练,因此我们随机抽取其20%的数据并设置为新的数据集,即Yelp1。所有模型的分类效果如下所示:

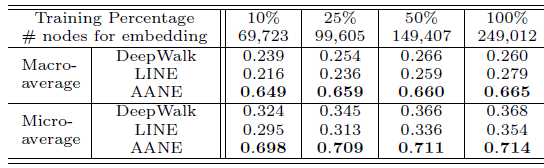

所有模型在完整的

Yelp数据集上的分类效果如下所示,其中PCA,LCMF,MultiSpec因为无法扩展到如此大的数据集,因此不参与比较:

结论:

- 由于利用了顶点的属性信息,因此

LCMF,MultiSpec,AANE等属性网络embedding方法比DeepWalk,LINE等网络结构embedding方法效果更好。例如,在BlogCatalog数据集上,结合属性信息的AANE在Micro-average得分上比DeepWalk相对提升38.7%、比LINE提升36.3%。 - 我们提出的

AANE始终优于LCMF, MultiSpec方法。例如,在Flickr数据集上,AANE比LCMF相对提升18.2%。这可以解释为通过分解网络矩阵network matrix和属性矩阵attribute matrix学到的潜在特征是异质的,并且很难将它们直接结合起来。 LCMF,MultiSpec方法无法应用于大型数据集。

- 由于利用了顶点的属性信息,因此

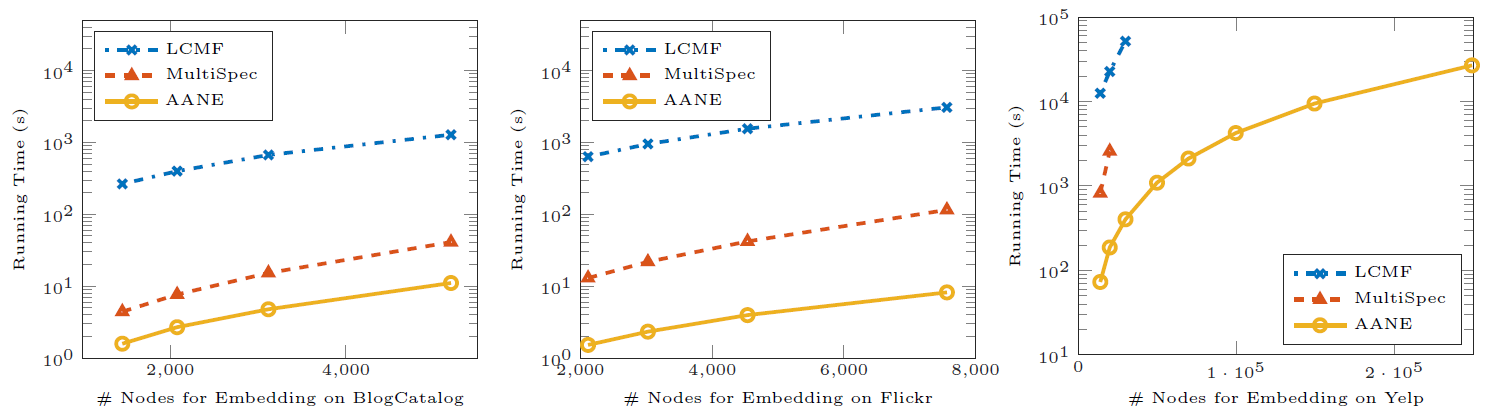

效率评估:然后我们评估这些方法的训练效率。我们将

AANE和LCMF,MultiSpec这些属性网络embedding方法进行比较。下图给出了这些模型在不同数据集上、不同顶点规模的训练时间。结论:

AANE的训练时间始终比LCMF和MultiSpec更少。- 随着顶点规模的增加,训练效率之间的

gap也越来越大。 AANE可以在多线程环境下进一步提升训练效率。

这种比较意义不大,本质上

AANE是AANE的时间曲线是平行的,也就是相差常数时间。在算法中,相差

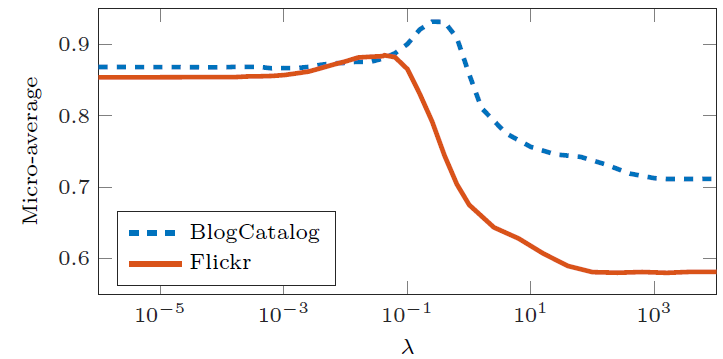

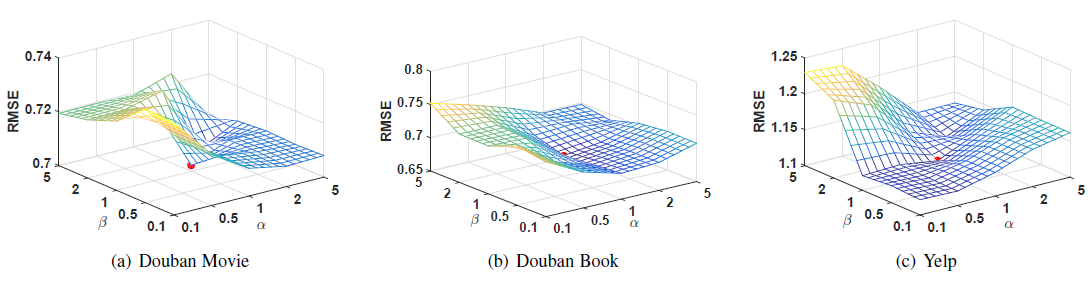

参数敏感性:这里我们研究参数

参数

Micro-F1效果如下所示。- 当

0时,模型未考虑网络结构信息,就好像所有节点都是孤立的。随着AANE开始根据拓扑结构对节点进行聚类,因此性能不断提升。 - 当

0.1时,模型在BlogCatalog和Flickr上的效果达到最佳。随着embedding。

- 当

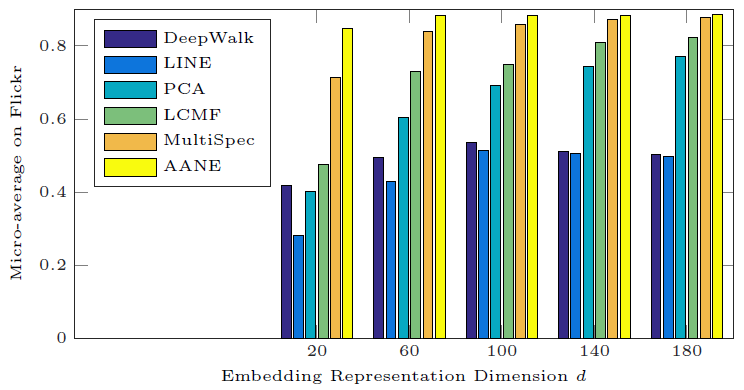

为研究

embedding维度20变化到180,对应的分类Micro-F1效果如下所示。我们仅给出Flickr数据集的结果,BlogCatalog和Yelp的结果也是类似的。可以看到:

- 无论

DeepWalk和LINE都不如属性网络embedding方法(AANE,LCMF,MultiSpec) - 无论

AANE的效果始终最佳。 - 当

embedding已经能够捕获大多数有意义的信息。

- 无论

二十、LANE[2017]

属性网络

attributed network在各种现实世界的信息系统中无处不在,例如学术网络、医疗保健系统。与仅观测节点之间交互和依赖关系的常规网络不同,属性网络中的每个节点通常关联一组丰富的特征。例如,随着社交网络服务的普及,人们不仅可以结识朋友从而形成在线社区,还可以积极分享意见、发表评论。在社会科学中,人们已经研究了社交影响理论social influence theory,即:个体的属性既可以反映、也可以影响他们的社区结构。此外,许多数据挖掘应用程序(如情感分析、信任预测)都可以受益于几何结构和节点属性之间的相关性。network embedding作为一种高效的图挖掘计算工具,旨在将网络中所有节点的拓扑邻近性topological proximity映射为连续的低维向量representation。学到的embedding representation有助于节点分类、链接预测、网络可视化等众多应用。虽然network embedding已被广泛研究,但是对Attributed Network Embedding: ANE的研究仍处于早期阶段。与从纯网络pure network学习的network embedding相比,ANE的目标是利用网络邻近性proximity和节点属性亲和性affinity。由于两种信息源的异质性,现有的network embedding算法很难直接应用于ANE。人们在各种现实世界的网络中收集了丰富的

label,如group或者社区类别。例如,在Facebook和Flickr等许多社交网络中,用户被允许加入一些预定义的分组。同组的用户倾向于分享类似主题的帖子或照片,并且组内用户之间也经常互动。引文网络是另一个例子。在同一个研究社区中发表的论文通常具有共同的主题,它们还大量引用来自同一社区的其它论文。这些事实可以用同质性假设homophily hypothesis来解释,即,具有相同label的个体通常具有相似的社交关系和相似的节点属性。label受到网络结构和属性信息的强烈影响,并与它们固有地相关。受到这一事实(即,label可能有助于学习更好的联合embedding representation)的启发,而现有方法关注于以无监督的方式学习embedding,论文《Label Informed Attributed Network Embedding》建议研究如何利用label信息并将其整合到ANE中。然而,在属性网络中建模和利用

label是一项困难的任务。有两个主要挑战:- 首先,属性网络和

label信息可能是稀疏sparse的、不完整incomplete的、噪音noisy的。例如,在社交网络中,单个用户的好友数量相比总用户量而言总是极少的,特定label的活跃用户的占比也可能很小。 - 其次,鉴于属性网络及其

label的异质性,学习统一的representation具有挑战性。与评论和帖子等属性不同,label将实例划分为不同的分组或社区。很难显式地建模所有这些多模态信息源之间的相关性correlation,并将它们共同嵌入到信息量丰富的embedding representation中。

因此,利用异质的、噪音的信息来相互补充从而获得有效的、鲁棒的

embedding representation是一项具有挑战性的任务。在论文

《Label Informed Attributed Network Embedding》中,作者研究了label informed attributed network embedding的问题,并提出了一个有效的框架LANE。具体而言,论文旨在回答以下问题:- 如何将

label建模且融合到ANE框架中? label对embedding representation learning的潜在影响是什么?LANE通过利用label对其它学习任务(如节点分类)做出多大贡献?

总之,论文的主要贡献如下:

- 正式定义

label informed attributed network embedding问题。 - 提出一个新的框架

LANE。LANE可以将label与属性网络关联,并通过建模它们的结构邻近性和相关性,将它们平滑地嵌入到低维representation中。 - 提出一种有效的交替算法来解决

LANE的优化问题。 - 实验评估和验证了

LANE在真实世界属性网络上的有效性。

- 首先,属性网络和

相关工作:

近年来,

network embedding越来越受欢迎。network embedding的开创性工作可以追溯到graph embedding问题,该问题由《On determining the genus of a graph in O(v^{O(g)}) steps》在1979年作为graph genus determining问题所引入。一系列更通用的

graph embedding方法是在2000年代左右开发的。他们的目标是生成可以对数据的非线性几何进行建模的低维流形low-dimensional manifold,包括Isomap、Laplacian Eigenmap、谱技术。到目前为止,由于网络数据的普遍性,人们已经实现了各种

network embedding算法。《Probabilistic latent semantic visualization: topic model for visualizing documents》将概率潜在语义分析probabilistic latent semantic analysis: pLSA应用于嵌入文档网络。《Community evolution in dynamic multi-mode networks》研究了利用时间信息分析动态多模式网络的优势。《Structure preserving embedding》利用半定程序semidefinite program来学习低维representation,从而很好地保留了全局拓扑结构。《Topic modeling with network regularization》设计了一种基于harmonic regularization的embedding框架来解决具有网络结构的主题建模问题。《Distributed large-scale natural graph factorization》提出了一种用于大规模图的异步分布式矩阵分解算法。《Learning social network embeddings for predicting information diffusion》将观察到的时间动态投影到潜在空间中,从而更好地建模网络中的信息扩散。《node2vec: Scalable feature learning for networks》通过增加邻域的灵活性,进一步推进了基于随机游走的embedding算法。- 为了嵌入异质网络,

《Learning latent representations of nodes for classifying in heterogeneous social networks》将transductive模型和深度学习技术扩展到该问题中。 《Revisiting semi-supervised learning with graph embeddings》利用概率模型以半监督方式进行network embedding。

最近,人们提出了几种基于深度学习的

embedding算法,从而进一步提高学习representation的性能。

在众多现实世界网络中,节点往往关联丰富的节点属性信息,因此人们提出了属性网络分析。在这些网络中,人们普遍认为几何结构和节点属性之间存在相关性。因此,同时利用这两者的算法可以提高整体的学习性能。例如,

《What's in a hashtag? content based prediction of the spread of ideas in microblogging communities》通过分析社交图的拓扑和内容,从而推进对思想ideas传播的预测。为了解决复杂的数据结构,人们致力于将两个信息源联合嵌入到一个统一的空间中。《Exploring context and content links in social media: A latent space method》探索了一种有效的算法,通过构建语义概念semantic concept的潜在空间,从而联合嵌入社交媒体中的链接和内容。《Probabilistic latent document network embedding》提出一个整体框架来同时处理文档链接和文本信息,并找到一个统一的低维representation。他们通过联合概率模型来实现这一目标。《Unsupervised streaming feature selection in social media》利用流式特征选择框架联合学习高维内容数据和链接信息中的潜在因子的概率。《Heterogeneous network embedding via deep architectures》将内容转换为另一个网络,并利用非线性多层embedding模型来学习构建的内容网络与原始网络之间的复杂交互。

在许多应用中,数据表现出多个方面

multiple facets,这些数据被称作多视图数据。多视图学习multi-view learning旨在从多个信息源中学习统计模型。人们已经提出了许多算法。《A reconstruction error based framework for multi-label and multi-view learning》研究了一种基于重构误差的框架,用于处理multi-label和multi-view学习。该框架可以显式量化多个label或视图的合并的性能。《Pre-trained multi-view word embedding using two-side neural network》应用了一个two-side多模态神经网络来嵌入基于多个数据源的word。

《A survey of multi-view machine learning》对多视图学习给出了更详细的回顾。我们的工作与多视图学习之间的主要区别在于:属性网络可以被视为一个特殊构建的数据源,而且ANE本身就是一个具有挑战性的问题。label也是具有特定形式的特殊数据源。

20.1 模型

20.1.1 基本概念

定义

除了网络结构和节点属性之外,每个节点还关联一组

label。节点的label矩阵为label种类。label向量,label,每个节点可以属于其中某一类label或者某几类label。我们定义

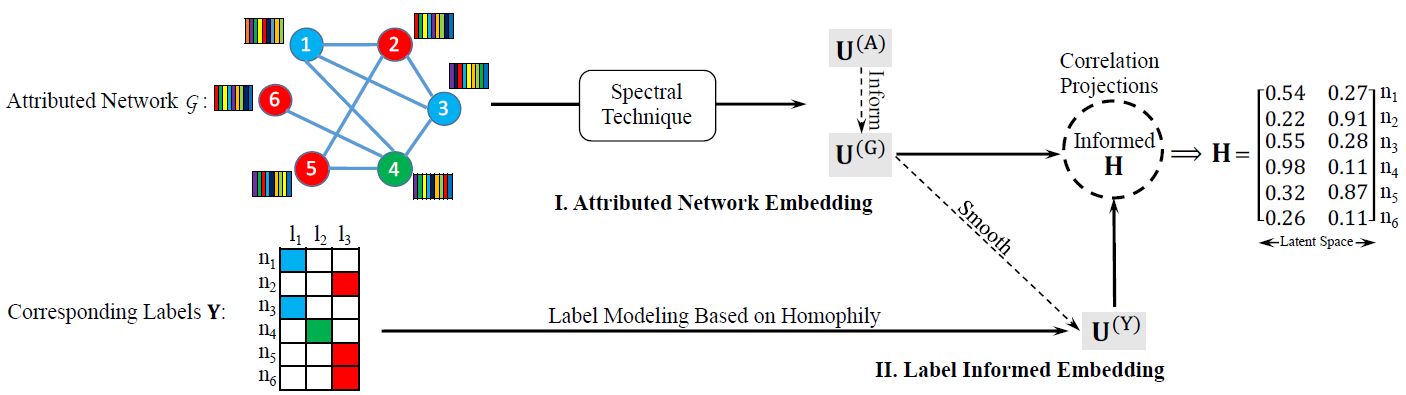

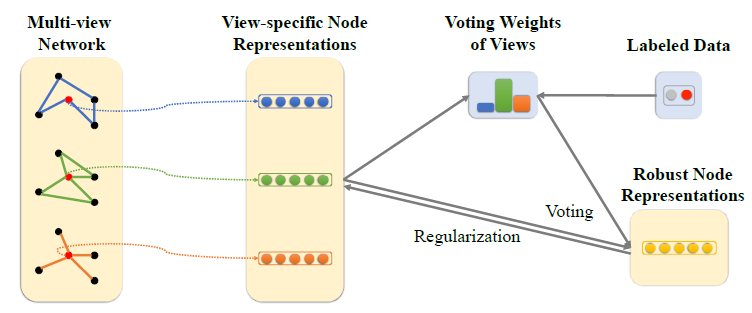

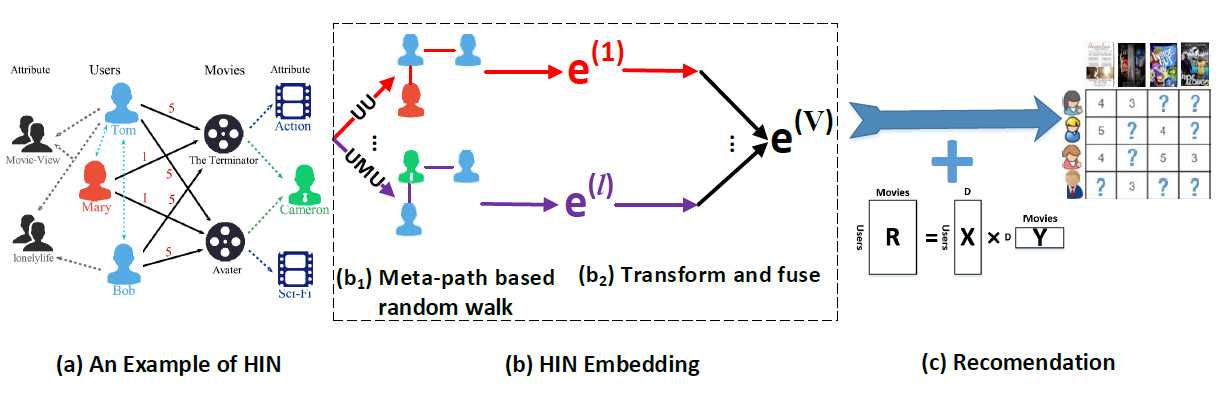

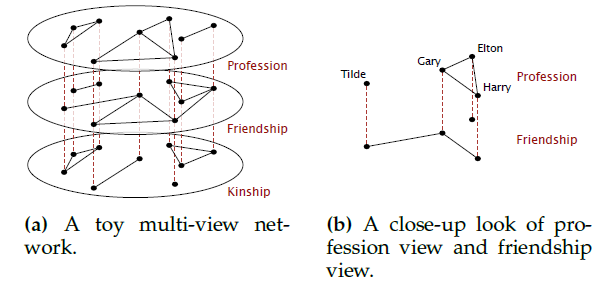

label informed attributed network embedding为:给定属性网络label信息representationlabel信息。我们提出了一种新颖的

informed attributed network embedding: LANE方法。LANE可以建模属性网络空间和label信息空间中的节点邻近性,并将它们联合嵌入到统一的低维representation中。下图说明了LANE的主要思想,图中有一个含有六个节点的属性网络,每个节点都有各自的label。LANE通过两个模块来学习节点的embedding:属性网络嵌入Attributed Network Embedding、标签信息嵌入Label Informed Embedding。- 首先,我们将网络结构邻近性和网络节点属性邻近性映射到两个潜在

representation - 其次,我们利用融合的

label信息,从而统一嵌入到另一个潜在空间 - 最后,我们将所有学到的潜在

representation映射到一个统一的representation

如下图所示,节点

1和节点3的embedding向量分别为[0.54, 0.27]和[0.55, 0.28],这意味着它们在原始空间中具有相似的属性。为了有效地学习节点embedding,我们设计了一种高效的交替优化算法。

- 首先,我们将网络结构邻近性和网络节点属性邻近性映射到两个潜在

20.1.2 Attributed Network Embedding: ANE

Attributed Network Embedding模块的目标是寻找两个representation。首先考虑对网络结构进行建模。网络结构建模的核心思想是:如果节点

representation向量representation向量的相似性,其中AANE中采用边权重我们通过

- 当节点

- 当

该损失函数无法解决结构不相似但是

embedding都相等。因此论文增加了约束条件考虑所有节点,则我们得到总的不一致程度为:

定义图结构的

pair-wise结构相似性矩阵为这里采用这种归一化形式是为了得到拉普拉斯矩阵的矩阵形式。

则我们的目标函数为:

其中

representation矩阵,其第其中:

我们添加约束

- 当节点

与网络结构建模类似,我们对节点属性邻近性建模过程也是类似的。定义节点属性

pair-wise邻近性矩阵为representation矩阵为定义归一化拉普拉斯矩阵

为了将

这里是通过正则化的方式,迫使结构邻近性和节点属性邻近性产生高度的相关。

为了使得网络结构信息和节点属性信息互补,我们在模型中共同最大化

其中

ANE模块内部网络结构和节点属性的贡献。论文

《Accelerated Attributed Network Embedding》提出的AANE中,我们在

ANE模块基于pair-wise相似性来执行属性网络embedding。这种方法和谱聚类相一致,它有几个优点:- 对于输入没有很强的假设,即普适性较好,可以推广到很多实际问题。

- 目标函数可以使用很多图论来解释,如

ratio-cut partitioning、随机游走。 - 可以通过

eigen-decomposition特征值分解很容易求解问题。

20.1.3 Label Informed Embedding: LIE

label信息在确定每个节点内部结构方面起着至关重要的作用,它和网络结构、节点属性有着强烈的、固有的相关性。除了这些强相关性之外,label还可能被纳入前面提到的ANE模块中。然而,label通常是噪音noisy的、且不完整incomplete的。直接探索label可能会对最终的embedding产生负面影响。我们提出了一种对label进行建模的方法,并且使用两个步骤来强化embedding representation learning:label information modeling、correlation projection。Label Information Modeling:在这一步中,我们将label邻近性映射到潜在representationembedding来平滑label邻近性,使得当节点具有相同的label时,它们的网络结构、节点属性、以及最终的representation都趋近于相似。具体而言,我们根据

label将节点划分到对应的团clique中,对应的表示形式为label向量的内积。假设每个节点仅属于一个label类别:- 当节点

clique。 - 当节点

clique。

如果节点可以有多个

label类别,则我们根据

label邻近性来建模。令我们可以参考网络结构邻近性和节点属性邻近性建模,通过矩阵的特征值分解来求解

label信息的特殊结构:为解决该问题,我们利用学到的网络结构邻近性

smooth模型。我们定义以下目标函数使得相同label的节点具有相似的representation:这里假设结构相似的节点可能具有相同的

label。这里没有考虑属性邻近性,主要是为了将label融合到网络结构中。这里是否可以考虑引入一个平衡因子

label信息和属性网络embedding信息,即:embedding也是用网络结构邻近性smooth模型。这种方式有几个优点:

首先,矩阵

其次,联合的邻近性融合了更多的信息,这使得

label信息与网络结构、节点属性等信息相一致。另外第二项

label邻近性学习,因为label和节点结构、节点属性是高度相关的。最后,学到的潜在

representationlabel空间中大部分信息可被恢复。

因此,尽管

label信息可能是不完整的、且噪音的,但我们仍然能够捕获label空间中的节点邻近性。- 当节点

Correlation Projection:现在我们已经得到了属性网络embeddinglabel信息embeddingembedding我们将这些

embedding都投影到新的embedding空间则投影的目标函数定义为:

其中

embedding。这里通过相关性最大,从而从三个潜在

embedding中得到统一的embedding

20.1.4 联合学习

现在我们考虑所有的

embedding,以及所有的相关性。我们定义两个参数来平衡不同度量的重要性从而得到LANE的目标函数:其中:

ANE模块内部网络结构和节点属性的贡献,ANE模块和LIE模块的贡献。通过求解

embedding representation learning和correlation projection高度相关。通过这种方式,label邻近性,以及它们之间的相关性。优化算法:目标函数有四个矩阵变量需要优化,因此无法得到闭式解。这里我们采用一种交替优化算法来逼近最优解。基本思想是:每轮迭代时固定其中三个变量而求解另外一个变量的局部最优解。当固定其中三个变量时,目标函数就是剩下变量的凸函数。

考虑

其中

当

则

top类似地,最大化

top由于每个

updating step都是求解凸优化问题,因此可以保证收敛到局部最优解。我们从主要的信息源的

representationLANE训练算法:输入:

- 异质网络

label信息矩阵embedding维度- 收敛阈值

- 异质网络

输出:节点的

embedding矩阵步骤:

构建结构邻近度矩阵

label邻近度矩阵计算拉普拉斯矩阵

初始化:

迭代,直到

通过求解下式来更新

通过求解下式来更新

通过求解下式来更新

通过求解下式来更新

算法复杂度:

LANE框架在收敛之前只需要进行少量的迭代,在每轮迭代过程中都需要进行四个特征值分解。为计算top d个特征向量,类似于Lanczos方法的特征值分解方法最坏情况需要令

LANE的总的时间复杂度为spectral embedding的计算复杂度相同。由于LANE总的时间复杂度为另外,可以很容易得到

LANE的空间复杂度为这种复杂度对于大型网络而言是不可行的。

在某些网络中节点属性或者节点

label可能不可用。如,当移动通信公司希望分析客户网络以便提供更好的服务时,他们只能收集到通讯网络及其部分label信息,通讯内容、用户偏好之类的属性不可用。LANE也能够处理这类场景,其中节点属性或节点label之一发生缺失,或者二者全部缺失。我们以

label信息缺失为例,此时label信息建模)、label邻近性和其中

LANE的这种变体我们称作LANE_w/o_LABEL,其求解方法也类似于上述交替优化算法。

20.2 实验

数据集:

BlogCatalog数据集:一个博客社区,用户彼此关注从而构成一个网络。用户可以生成关键词来作为其博客的简短描述,我们将这些关键词作为节点(用户)的属性。用户也可以将其博客注册为指定的类别,我们将这些类别作为用户的label。Flickr数据集:一个在线图片共享社区,用户彼此关注从而构成一个网络。用户可以为图片指定tag,我们将这些tag作为节点(用户)的属性。用于可以加入不同的组,我们将这些组作为用户的label。

Baseline模型可以分为四类:- 首先,为评估

embedding的效果,我们使用原始特征作为baseline。 - 然后,为评估节点属性的贡献,我们考虑三种仅嵌入网络结构的方法,包括

DeepWalk,LINE, LANE_on_Net。 - 接着,为评估

label信息的贡献,我们考虑两种ANE方法,包括LCMF和LANE_w/o_Label。 - 最后,为评估

LANE的效果,我们考虑SpecComb和MultiView方法。

具体描述如下:

Original Features原始特征:将原始网络结构特征、原始节点属性特征直接拼接,从而作为节点特征。DeepWalk:使用SkipGram学习基于图上的、截断的随机游走序列从而得到图的embedding。LINE:建模图的一阶邻近度和二阶邻近度从而得到图的embedding。LCMF:它通过对网络结构信息和节点属性信息进行联合矩阵分解来学习图的embedding。SpecComb:将属性网络labelnormalized spectral embedding。最后选择top d的特征向量作为embedding。MultiView:将网络结构、节点属性、节点label视为三个视图,并在它们上共同应用正则化的谱聚类spectral clustering。LANE_on_NET和LANE_W/o_LABEL:是LANE的两个变种。LANE_on_NET仅对单纯的网络结构建模,LANE_W/o_LABEL对网络结构和节点属性建模(没有节点label信息)。

- 首先,为评估

实验配置:我们验证不同算法学到的

embedding对节点分类任务的有效性。我们使用五折交叉验证,并随机将数据集划分为训练集和测试集。其中,训练集不包含任何测试集的信息(训练期间测试节点是unseen的),但是测试集包含测试节点到任何其它节点的链接信息。我们首先在训练集上学到节点的

embedding,然后在训练集上训练一个SVM分类器,分类器的输入为节点的embedding、输出为节点的label类别。然后,为了得到测试集的embedding,我们首先构造两个线性映射函数embedding空间这相当于是根据

unseen节点的为简单起见这里我们使用线性映射,也可以使用其它非线性映射函数。我们并没有根据测试集来训练

embedding,因为这会泄露测试集的label信息embedding向量为:其中:

最后我们基于测试集的

embedding和训练集学到的SVM分类器来对测试集进行分类,并报告分类的F1指标。每种配置都随机执行10次并报告指标的均值。对于所有方法,

embedding维度为Baseline方法的其它超参数都使用原始论文中的超参数,LANE方法的超参数通过grid search搜索到合适的值。为证明

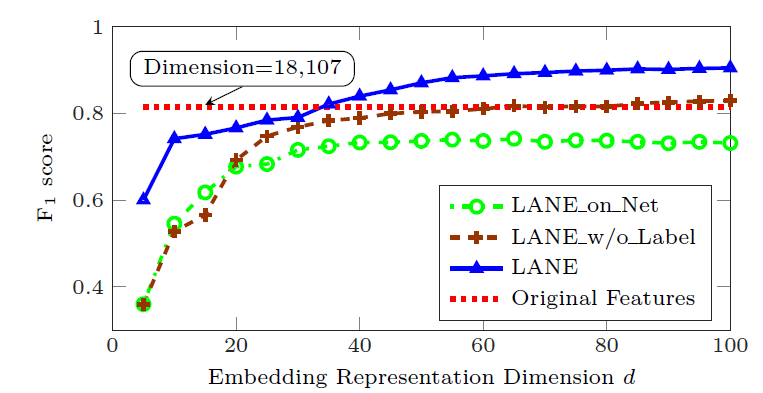

embedding的有效性,我们将LANE及其变体与原始特征进行比较。其中BlogCatalog数据集的原始特征为12346维、Flickr数据集的原始特征为18107维。实验中,我们将embedding维度从5增加到100。我们给出了Flickr数据集上不同BlogCatalog数据集,因为结果也类似。结论:

- 当

18107时,LANE_w/o_Label可以达到和原始特征相近的分类能力。 - 当

18107时,LANE可以达到和原始特征相近的分类能力。 LANE_on_Net比原始特征效果更差,这是因为它仅包含网络结构信息。

因此,通过利用

embedding representation learning,LANE实现了比原始特征更好的性能。

- 当

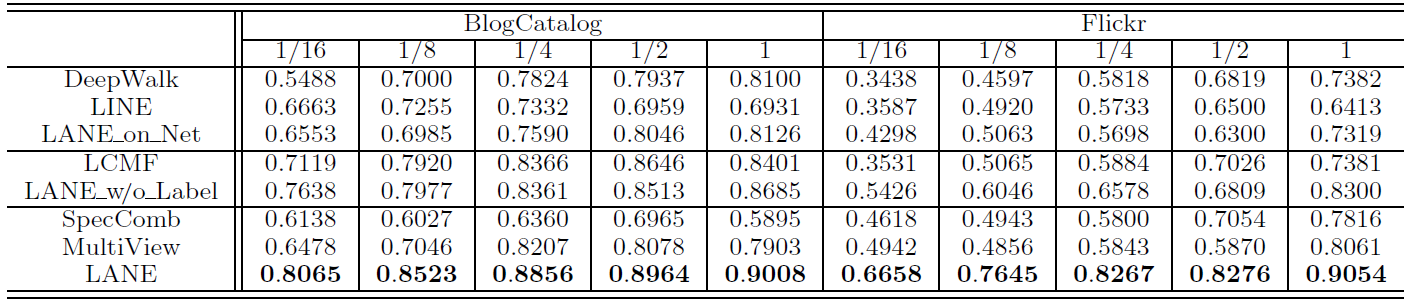

为研究

LANE的有效性,我们对比了所有的Baseline模型。我们固定结论:

- 所有情况下,

LANE总是优于Baseline模型。 - 当训练数据规模从

100%时,LANE的性能持续改善,但增长的幅度变小。

- 所有情况下,

为评估

label信息对于embedding的影响,我们分析上表中的数据。与单纯的网络结构

embedding方法(DeepWalk, LINE, LANE_on_Net) 相比,使用了节点属性信息的LANE_w/o_Label的效果更好。但是利用了label信息之后,LANE进一步超越了LANE_w/o_Label。这证明了将label信息融合到embedding中的优势。另外

LANE也超过了属性网络embedding方法LCMF,这进一步证明了label信息的优势。通过

LANE和SpecComb/MultiView的比较发现,SpecComb/MultiView的效果始终不如LANE,甚至比单纯的网络结构embedding方法(如DeepWalk)更差。这是因为:SpecComb没有明确考虑固有的相关性,并且直接拼接异质信息并不是组合异质信息的合适方法。MultiView会平等对待网络结构、节点属性、label信息,这也不是融合这些异质信息的好方法。

所有这些观察结果表明:

- 属性网络和

label之间确实存在很强的相关性。 label信息确实可以帮助我们获得更好的embedding representation。- 如何融合

label信息需要一种合适的方法。

LINE通过执行label informed embedding成功地实现了这一提升,并始终优于所有baseline方法。我们要强调的是:在节点分类任务中,所有方法都可以访问训练集中的label,并以不同的方式利用label信息。只有LANE, SpecComb, MultiView可以将这些label合并到embedding representation learning中。因此,LANE的优势不是拥有额外的信息源,而是执行label informed embedding的结果。超参数

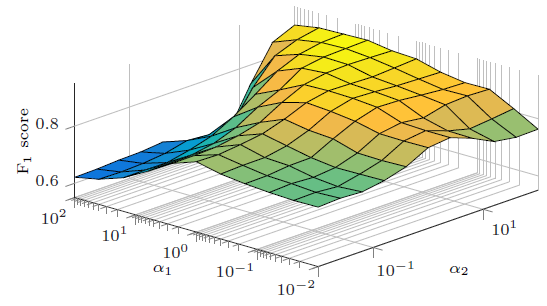

label信息的贡献。我们同时将它们从0.01增加到100。Flickr数据集上的指标如下,BlogCatalog也有类似结果因此省略。结论:

当属性网络和

label信息都具有足够的贡献时,即LANE会实现相对较高的性能。当

当固定

0.01变化到100时,模型性能提升了42.7%;当固定0.01变化到100时,模型性能提升了16.07%。这表明label信息对于LANE的影响大于属性网络。因为在相同范围内取值时,模型性能随

label信息的影响更大。

总之,通过配置合理的参数,

LANE可以实现相对较高的性能。同时,label信息在embedding过程中非常重要。

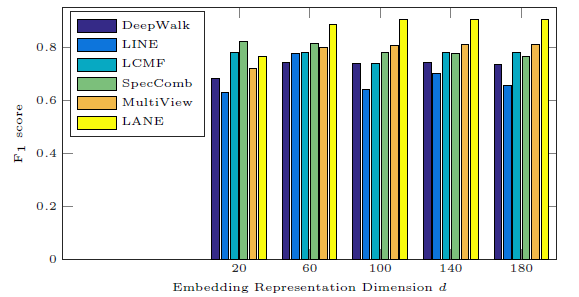

我们将

20变化到180来研究分类性能的影响。。在Flickr数据集上不同方法的效果和d的关系如下图,BlogCatalog也有类似结果因此省略。结论:

- 当

LANE始终比所有基准方法效果更好。 - 增加

LANE的分类性能首先提高,然后保持稳定。这在实际应用中很有吸引力,因为人们可以在大范围内安全地调整超参数

- 当

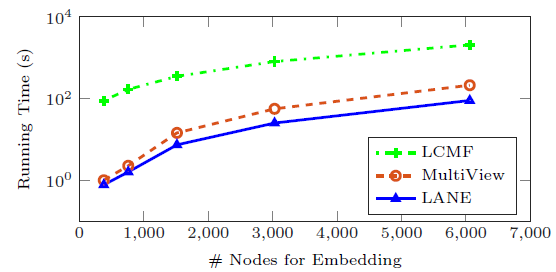

最后我们比较

LANE和两种属性网络ANE方法(LCMF和MultiView)的运行时间。我们在Flickr数据集上观察输入节点数量和训练时间(对数表示)的关系,BlogCatalog也有类似结果因此省略。结论:

LANE的运行时间最少。原因是:LCMF基于随机梯度下降来优化,这通常收敛速度很慢。MultiView具有和LANE相同的时间复杂度,但经验表明LANE可以在这两个数据集上仅使用几个迭代就能收敛。因此这证明了LANE的计算效率。

二十一、MVE[2017]

由于在现实世界中的广泛应用,挖掘和分析大规模信息网络(如社交网络、引文网络、航空网络)最近引起了很多关注。为了有效地、高效地挖掘此类网络,首要条件是找到有意义的

network representation。传统上,网络被表示为节点的邻接矩阵,这个矩阵既是高维的、又是稀疏的。最近,人们越来越关注将网络表示为低维空间(也称作network embedding),其中每个节点都用一个低维向量来表示。这样的向量能够保持节点之间的邻近性proximity,因此可被视为节点特征并有助于各种下游应用(如节点分类、链接预测、节点可视化)。尽管这些工作在许多网络中经验性地有效和高效,但是它们都假设网络中的节点之间仅存在一种类型的邻近性,而实际上网络中存在多种类型的邻近性。以科技文献中作者之间的网络为例,可以通过

co-authorship关系来得到邻近性,即两位作者是否曾经共同撰写过同一篇论文;也可以通过引用关系来得到邻近性,即一位作者是否引用另一位作者的论文。另一个例子是社交网站中用户之间的网络,其中存在多种类型的邻近性,例如由关注(following-followee)、回复、转发、引用等关系所产生的邻近性。每种邻近性定义了一个网络视图,多个邻近性产生了一个具有多视图multiple views的网络。每个单独的视图通常是稀疏sparse的、有偏biased的,因此现有方法学到的node representation可能不是那么全面。为了学到更鲁棒的node representation,一个自然的解决方案可能是利用来自多个视图的信息。这促使我们研究一个新的问题:学习多视图网络的

node representation,旨在通过考虑网络的多个视图来学习节点的robust representation。在文献中,人们已经提出了各种方法来从多个视图中学习数据representation,例如多视图聚类multi-view clustering方法、多视图矩阵分解multi-view matrix factorization方法。这些方法在许多application上表现良好,例如聚类任务、推荐任务。但是,当应用于我们的问题时,它们具有以下局限性:- 视图协同

collaboration不足。由于网络的每个单独的视图通常都是有偏biased的,因此学习节点的robust representation需要多个视图的协同。然而,大多数现有的多视图学习方法旨在找到跨不同视图的compatible representation,而不是促进不同视图的协同从而找到节点的robust representation。 - 缺乏权重学习

weight learning。为了学习节点的robust representation,需要整合来自多个视图的信息。在集成过程中,由于不同视图的重要性可能存在差异,因此需要仔细确定它们的权重。现有方法通常为所有视图分配相同的权重。换句话讲,不同的视图被同等对待,这对于大多数多视图网络而言是不合理的。

为了克服这些限制,我们正在寻求一种能够促进不同视图协同,并在集成过程中自动推断视图权重的方法。

在论文

《An Attention-based Collaboration Framework for Multi-View Network Representation Learning》中,作者提出了这种方法。作者首先引入一组view-specific的node representation,从而保持不同视图中节点的邻近性。然后作者组合view-specific的node representation从而用于投票出节点的robust representation。由于不同视图的信息量可能不同,因此理想的情况下,在投票过程中需要以不同的方式对待每个视图。换句话讲,每个视图的权重应该不同。受到最近神经机器翻译neural machine translation中注意力机制attention mechanism进展的启发,在论文中作者提出了一种基于注意力的方法来推断不同节点的各个视图权重。该方法利用一些标记数据。整个模型可以通过反向传播算法进行有效地训练,在优化view-specific node representation、以及投票出节点的robust representation(通过学习不同视图的权重)之间交替进行。作者对各种现实世界的多视图网络进行了广泛的实验。多标签节点分类任务、链接预测任务的实验结果表明:论文提出的方法优于用于学习单视图

node representation的最新方法、以及多视图的其它竞争性方法。总之,论文贡献如下:

- 论文建议研究

multi-view network representation learning,旨在通过利用来自多个视图的信息来学习node representation。 - 论文提出了一个新颖的协同框架,该框架促进了不同视图的协同

collaboration,以投票的方式得到节点的robust representation。论文引入了一种注意力机制,用于在投票期间学习不同视图的权重。 - 论文在几个多视图网络上进行了实验。两项任务的实验结果证明了所提出的方法在许多竞争性的

baseline上的效率和效果。

- 视图协同

相关工作:我们的工作与现有的、用于学习

network representation的scalable方法有关,包括DeepWalk, LINE, node2vec。这些方法使用不同的搜索策略来探索网络结构:深度优先搜索depth-first search: DFS、广度优先搜索breadth-first search: BFS、以及这两种搜索策略的组合。然而,所有这些方法都侧重于学习单视图网络single-view network的node representation,而我们研究多视图网络multiple-view network。另一类相关工作是多视图学习

multi-view learning,旨在利用来自多个视图的信息,并在分类、聚类、ranking、主题模型topic modeling等任务中显示出有效性。与我们最相似的工作是多视图聚类、以及多视图矩阵分解方法。例如:《Co-regularized multi-view spectral clustering》提出了一个谱聚类spectral clustering框架来正则化regularize不同视图的聚类假设clustering hypotheses。《Multiview spectral embedding》提出了一种多视图非负矩阵分解模型,旨在最小化每个视图的相关系数矩阵coefficient matrix和共性矩阵consensus matrix之间的距离。

我们的多视图

network representation方法与这些工作具有相似的直觉,旨在找到跨多个视图的、鲁棒的data representation。然而,主要区别在于现有方法为所有视图分配相同的权重,而我们的方法采用基于注意力的方法,从而为不同节点学习不同的视图投票权重。此外,我们的工作还与基于注意力的模型

attention based model有关。基于注意力的模型旨在推断训练数据不同部分的重要性,并让learning算法专注于信息量最大的部分。基于注意力的模型已经应用于各种任务,包括图像分类、机器翻译、语音识别。据我们所知,这是在multi-view network representation learning问题中首次尝试使用基于注意力的方法。

21.1 模型

21.1.1 基本概念

信息网络

Information Network定义:信息网络一个网络视图来自于节点之间的、单一类型的关系或邻近性

proximity,可以用一个边集合传统上,网络被表示为稀疏的、高维的邻接矩阵。最近,人们越来越关注学习网络的低维向量

representation(也称作network embedding)。Network Embedding定义:给定一个信息网络network embedding问题旨在为每个节点representationrepresentation保留节点之间的邻近性。最近人们已经提出了各种

network embedding方法。尽管它们已被证明在各种场景中有效果、高效率,但是它们都专注于具有单一类型关系的网络。然而,在现实中,我们经常观察到节点之间多种类型的关系。例如,对于社交网站(如Twitter)的用户,除了following(关注)关系之外,还存在其它关系,如转发retweet、引用mention等关系。每种类型的关系定义了节点之间的一个网络视图,而多种类型的关系产生了具有多个视图的网络。网络的不同视图之间通常互补,因此考虑多个视图可能有助于学习节点的robust representation。这促使我们研究学习多视图网络的node representation问题。Multi-view Network Embedding定义:给定带network embedding旨在为每个节点robust representationrepresentation在不同的视图中是一致consistent的。为了学习跨不同视图的、节点的

robust representation,我们需要设计一种方法来促进不同视图的协同、并投票来产生节点的robust representation。由于视图的质量不同,该方法还应该能够在投票期间对不同的视图进行不同的加权。这里我们介绍我们提出的、用于嵌入多视图网络的方法。大多数现有的多视图

network embedding方法,例如多视图聚类和多视图矩阵分解算法,都未能取得令人满意的结果。这是因为它们在训练过程中不能有效地促进不同视图的协同。此外,在组合多视图信息时,这些方法也无法为不同的视图分配合适的权重。为了解决这些挑战:

- 我们的方法首先挖掘了编码单个视图的邻近性的

node representation。在编码期间,我们提出了一个协同框架collaboration framework来促进不同视图的协同。 - 然后,我们通过投票

vote来进一步集成不同的视图,从而得到节点的robust representation。在投票过程中,我们通过基于注意力的机制来自动学习每个视图的投票权重。

我们的目标函数总结为:

其中:

robust representation。

注意:这里并没有引入超参数来平衡这两个目标函数。理论上可以引入超参数,比如

我们的方法如下所示,其中:黄色部分为协同框架,蓝色部分为基于注意力的权重学习,不同颜色的边代表不同的视图(共有三个视图),红色的节点为待分类的节点。

- 我们的方法首先挖掘了编码单个视图的邻近性的

12.1.2 协同框架

collaboration framework协同框架的目标是学习编码了单个视图节点邻近性的node representation,同时将它们集成起来通过投票产生节点的robust representation。对于每个节点view-specific representationrobust representation考虑视图

这意味着

其中

context representation。在我们的方法中,节点context representation在所有视图之间共享,这使得不同的view-specific representation将位于相同的语义空间中。我们还尝试了对不同视图采用不同的context representation,这作为我们方法的一个变种,并在试验中进行比较。context representation在所有视图之间共享,这使得节点的view-specific representation位于相同的语义空间中,这就是 “协同” 的含义。根据定义,概率分布

neighbor distribution。定义视图view-specific representation的目标是最小化邻居分布KL散度作为概率分布之间的距离的度量。我们将经验邻居分布定义为

out degree,即经过简化之后,视图

view-specific representation的目标函数为:该目标函数优化一阶邻近性(即直接邻域)。

直接优化视图

negative sampling技术,从而简化了条件概率的计算:其中

sigmoid函数,- 第一项用于最大化“正边”,即观察到的边

observed edge。 - 第二项用于最小化“负边”,即不存在的噪音边

noisy edge。其中

- 第一项用于最大化“正边”,即观察到的边

通过最小化

view-specific representation的目标函数,robust representation。在投票过程中由于各个视图的重要性可能不同,因此我们需要为每个视图分配不同的权重。考虑所有这些因素,我们引入正则化项:

其中:

该正则化使得最终的

robust representation与各view-specific representation保持一致。其物理意义为:一方面,要求节点的

robust representatioinview-specific representation的一致性consistency。另一方面,如果节点的

robust representation无法保留所有视图中的结构信息,则它保留较重要的那些视图的结构信息。即尽可能逼近如果采用相等的权重,那么

view-specific representation的均值。

直观而言,通过为每个节点

最终,不同的

view-specific representation基于以下方式投票从而产生robust representation:视图的权重作用在两个地方:投票产生

robust representation、不同视图的正则化系数。根据

很自然地,

robust representation被计算为view-specific representation的加权组合,加权系数为视图的投票权重,这非常直观。通过整合

view-specific representation学习阶段的目标、投票阶段的目标(即正则化项),则协同框架的最终目标为:其中

当

view-specific representation之间的一致性。

12.1.3 attention 机制

上述框架提出了一种灵活的方式让不同的视图相互协同。这里我们介绍一种基于

attention机制,用于在投票期间学习不同视图的权重。我们提出的方法非常通用,只需要提供少量标记数据就可以为specific-task学习不同节点的视图权重。基于

attention机制,我们使用softmax单元来定义节点其中:

view-specific representation的拼接向量feature vector,用于描述哪些特征的节点认为视图informative)。这里

这里使用拼接后的向量作为

query,而没有使用每个视图的representation向量作为query。后者使用局部的、单个视图的representation,前者使用全局的、所有视图的representation。

当

另外,每个节点的视图权重将由其

view-specific representation的拼接向量view-specific representation,因此视图权重也相似。这种性质是合理的,这使得我们能够利用view-specific representation中保留的邻近性更好地推断不同节点的注意力,即相似的representation有相似的attention。一旦学到视图的权重,则可以通过

robust representation。然后我们可以将该representation应用于不同的预测任务,并基于部分标记数据来使用反向传播算法来自动学习投票权重。以节点分类任务为例,我们基于视图的特征向量

其中:

robust representation;task-specific损失函数。我们根据梯度下降法来求解该最优化问题,其梯度为:

一旦求解出参数

总的目标函数为:

在本文中,我们研究两类预测任务:节点分类、链接预测。

在节点分类任务中,目标函数定义为:

其中:

one-hot向量;在链接预测任务中,目标函数定义为:

其中:

pair对;cos相似度。

12.1.4 优化

我们使用梯度下降法和反向传播算法来优化模型。具体地说,在每轮迭代中:

- 我们首先从网络中采样一组边,并优化节点的

view-specific representation - 然后我们使用标记数据来训练视图的参数向量

- 最后,基于学到的视图投票权重,我们集成节点的

view-specific representation来得到节点的robust representation。

算法本质上是一个半监督学习,以多任务的形式进行学习:无监督地优化节点邻近性损失、监督地优化节点分类损失。训练是以交替优化无监督损失、监督损失的方式进行。

- 我们首先从网络中采样一组边,并优化节点的

MVE算法:输入:

- 多视图网络

- 标记数据

- 更新

view-specific representation中采样的样本数 - 负采样比例

- 多视图网络

输出:节点的

robust representation算法步骤:

迭代直到算法收敛,迭代步骤为:

更新节点的

view-specific representation。 更新方式为:迭代直到本轮采样的“正边”数量大于- 随机选择一个视图,记作视图

- 从

- 求解

view-specific representation - 求解

context representation

- 随机选择一个视图,记作视图

更新顶点的投票权重。更新方式为:

- 求解

- 求解

通过

- 更新节点的

robust representation

- 更新节点的

MVE算法由三个过程组成:view-specific representation学习过程:该过程根据未标记数据、标记数据分别来学习节点的view-specific representation。根据之前的研究,这部分的计算复杂度为representation的维度,robust representation学习过程:该过程根据每个节点的view-specific representation投票得到最终的robust representation。这部分的计算复杂度为- 投票权重学习过程:这部分通过注意力机制来学习每个视图的投票权重。这部分的计算复杂度为

考虑到大多数网络有

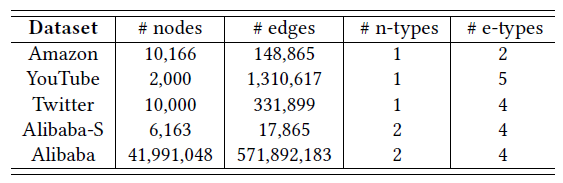

21.2 实验

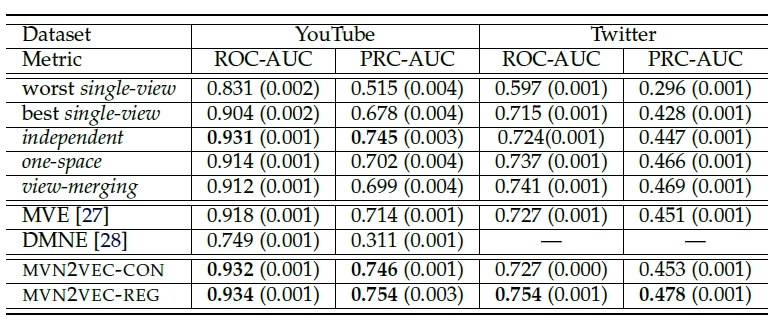

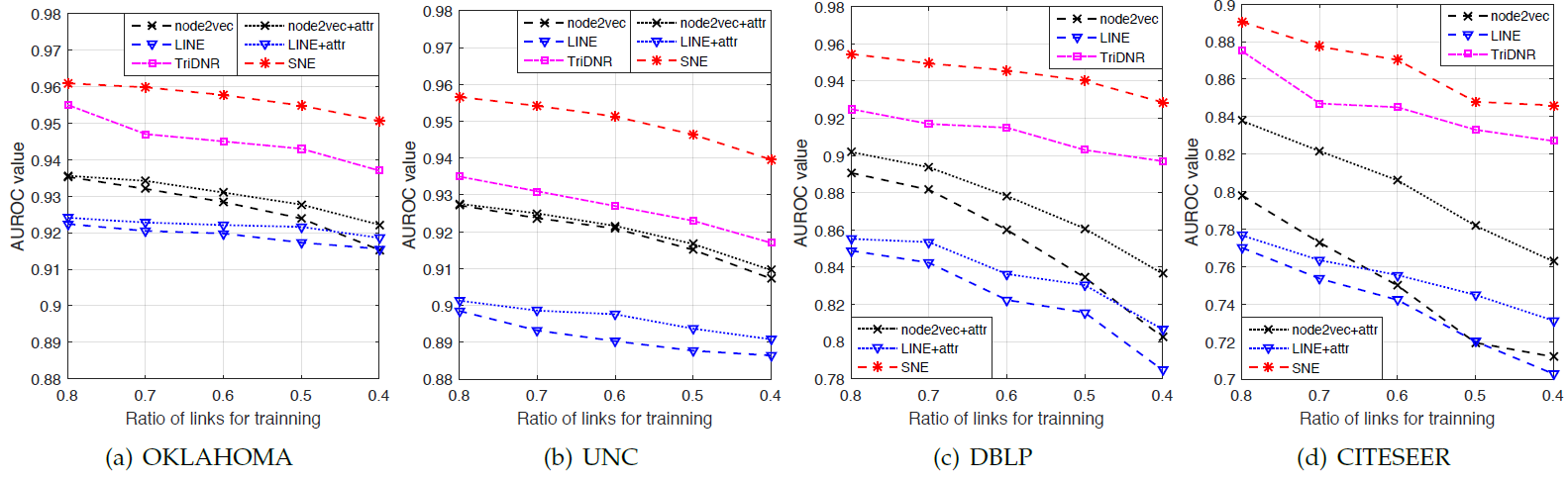

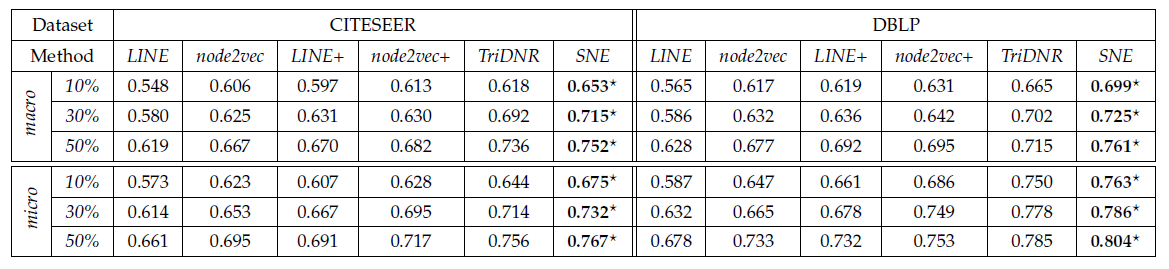

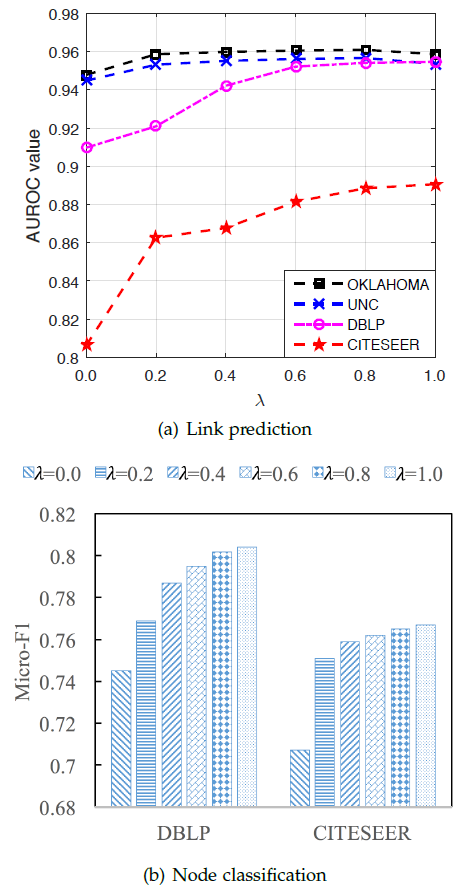

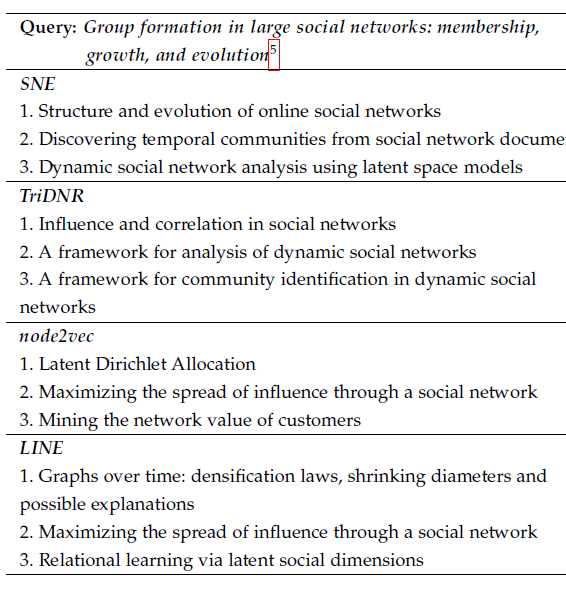

数据集:一共包含

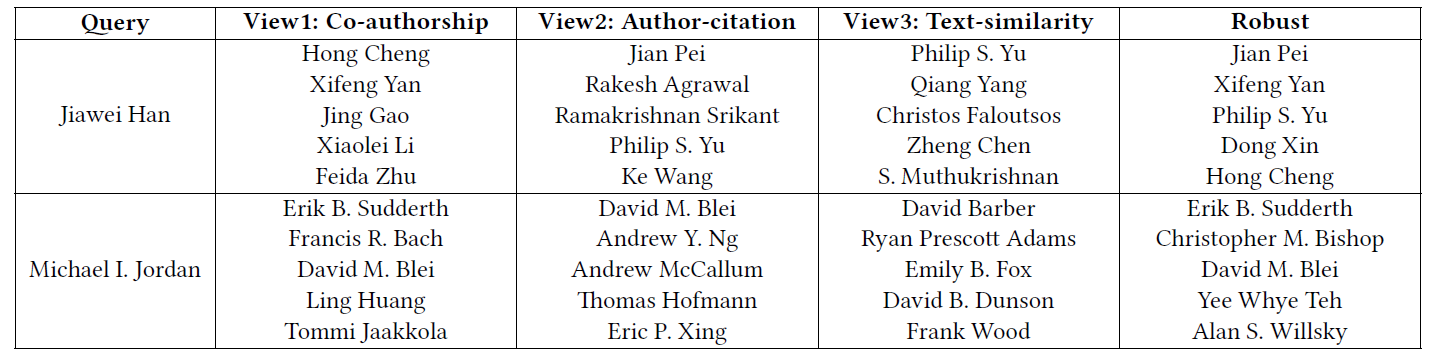

5个数据集,其中前三个数据集用于节点分类任务,后两个数据集用于链接预测任务。DBLP:包含来自计算机科学领域论文的作者author。网络包含三种类型的视图:co-authorship视图:边的类型定义为作者之间共同发表论文的关系,边的权重为共同发表文章的数量。author-citation视图:边的类型定义为作者之间的论文引用关系,边的权重为作者text-similariry视图:边的类型定义为作者论文之间的相似度,边的权重为每个作者发表论文的标题、摘要计算得到的TF-IDF的cos相似度,每个顶点仅保留最相似的5个邻居顶点的链接及其权重。

我们选择

8个不同的研究领域作为label,包括machine learning, computational linguistics, programming language, data mining, database, system technology, hardware, theory。对于每个label我们选择该领域若干个具有代表性的会议,并且只有在这些会议中发表的论文才用于构建这三个视图。Flickr数据集:一个在线图片共享社区,用户彼此关注从而构成一个网络。用户可以为图片指定tag,我们将这些tag作为节点(用户)的属性。用于可以加入不同的组,我们将这些组作为用户的label。该网络包含两个视图:

friendship视图:边的类型定义为用户之间的关注,边的权重为0(没有关注)或1关注。tag-similarity视图:边的类型定义为用户所有图片tag之间的相似性,边的权重就是tag之间的相似度。每个节点仅保留最相似的100个邻居节点的链接及其权重。

PPI数据集:一个protein-protein interaction network,只考虑人类基因作为节点。我们根据coexpression, cooccurrance, database, experiments, fusion, neighborhood information构建了六个视图。Hallmark基因组提供的基因分组视为节点的类别。考虑到原始的网络非常稀疏,因此我们对每个视图通过添加邻居的邻居来扩展

degree小于1000的节点的邻居集合,直到扩展的邻居集合的规模达到1000。Youtube数据集:根据Youtube网络的用户社交数据构建的用户社交网络。我们构建了五个视图:common friends视图:边的类型定义为用户之间的共同好友,边的权重共同好友数量。common subscription视图:边的类型定义为共同订阅用户(站在subscriber的角度) ,边的权重为共同订阅用户数量。common subscriber视图:边的类型定义为共同订阅者(站在订阅用户的角度),边的权重为共同订阅者的数量。common favorite video视图:边的类型定义为共同喜爱的视频,边的权重为共同喜爱视频的数量。friendship视图:边的类型定义为是否好友关系,边的权重为0或1。

我们认为

friendship视图可以更好地反映用户之间的邻近性,因此我们使用前四个视图来训练,并预测第五个视图中的链接。Twitter数据集:根据Twitter网络的用户社交数据构建的用户社交网络。由于原始网络的稀疏性,我们将其视为无向图。我们根据回复reply、转发retweet、提及mention、好友friendship等关系定义了四个视图,其中前三个视图用于训练(以PPI数据集相同的形式重建),预测第四个视图中的链接。

Baseline模型:我们比较了两类方法:基于单视图single-view的方法、基于多视图multi-view的方法。LINE:一种用于单视图、可扩展的embedding方法。我们给出了它在所有单个视图的结果中,效果最好的那一个。node2vec:另一种用于单视图、可扩展的embedding方法。我们给出了它在所有单个视图的结果中,效果最好的那一个。node2vec-merge:node2vec的一个变种。为了融合多视图,我们合并了所有视图的边从而得到一个大的视图,然后通过node2vec来学习该视图的embedding。node2vec-concat:node2vec的另一个变种。为了融合多视图,我们首先从每个视图学到node embedding,然后将节点在每个视图的embedding拼接起来。CMSC:一个co-regularized多视图谱聚类模型。它可以应用于我们的任务,但是无法扩展到大规模的图。我们使用基于质心的变体,因为其效率更高并且质心的特征向量

eigen-vector可以视作节点的representation。MultiNMF:一个多视图的非负矩阵分解模型。它可以应用于我们的任务,但是无法扩展到大规模的图。MultiSPPMI:一个词向量模型,它通过分解单词的共现矩阵从而得到单词的embedding。这里我们通过联合分解不同视图的邻接矩阵,并在不同视图之间共享node representation,从而利用该模型来学习node representation。MVE:我们提出的方法,其中使用了协同框架和注意力机制。MVE-NoCollab:MVE的一个变体。我们针对不同的视图引入了不同的context node representation,因此节点的view-specific representation将位于不同的语义空间中。因此在训练期间,节点的view-specific representation无法协同。MVE-NoAttn:MVE的另一个变体。我们在投票期间为每个视图赋予相同的权重,因此没有采用注意力机制。

注意,我们并没有比较

DeepWalk模型,因为DeepWalk可以视为参数node2vec模型的特例。实验配置:

- 对于除了

node2vec-concat以外的其它所有方法,node representation维度设置为node2vec-concat方法,每个视图的representation维度为100,最终的维度为 - 对于

LINE和MVE,负采样系数为0.025。 - 对于

node2vec,窗口大小设为10、随机游走序列长度为40,超参数 - 对于

MVE,每轮迭代中的“正边”数量1000万,参数0.05。

- 对于除了

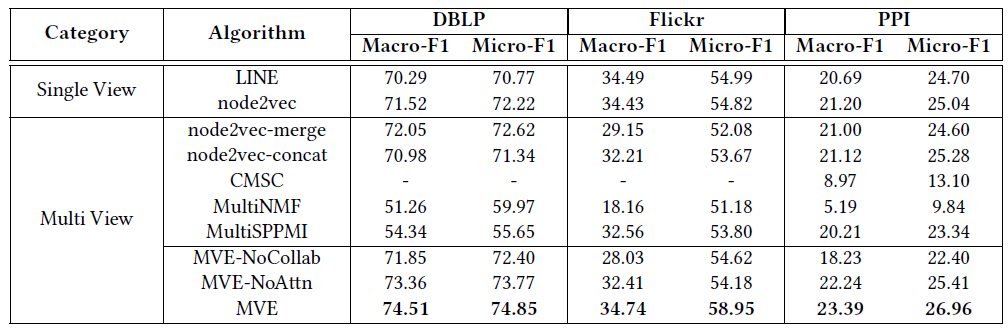

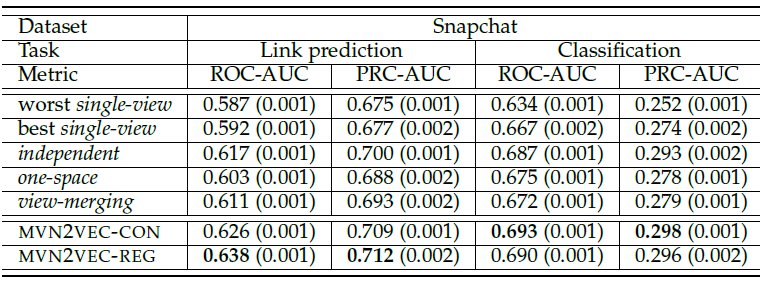

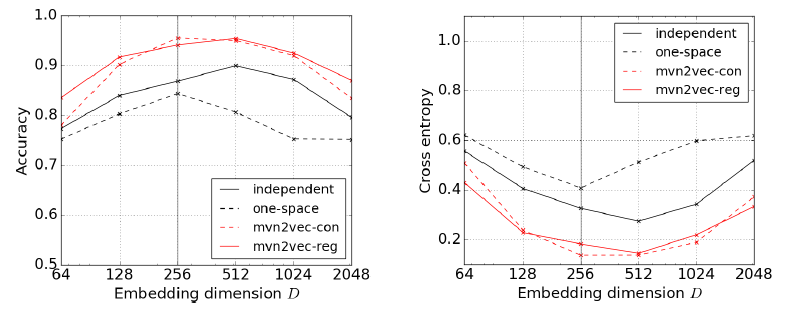

节点分类任务:我们将不同算法学到的

node reprsentation作为特征,并使用Lib-Linear软件包来训练one-vs-rest线性分类器。在分类器的训练过程中:- 对于

DBLP和PPI数据集,我们随机抽取10%的节点作为训练集,剩余90%作为测试集。 - 对于

Flickr数据集,我们随机选择100个节点作为训练集,以及10000个节点作为测试集。

为了学习视图权重,我们随机选择少量的标记样本来训练

MVE模型,这些标记样本不包含在测试集中,标记节点的数量参考数据集部分提供的图表。我们给出在测试集上的分类

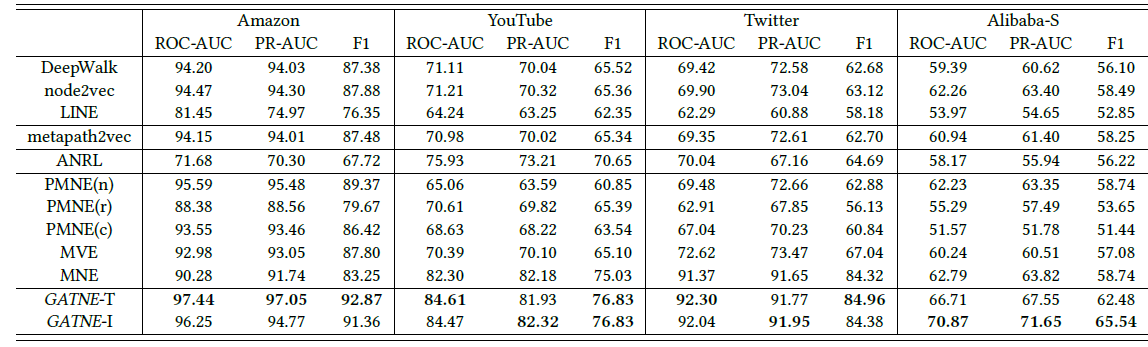

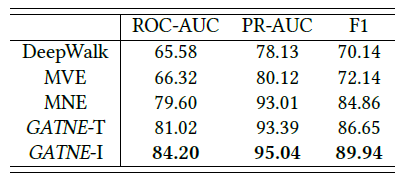

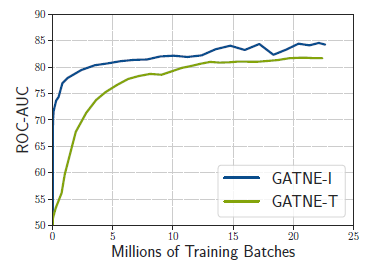

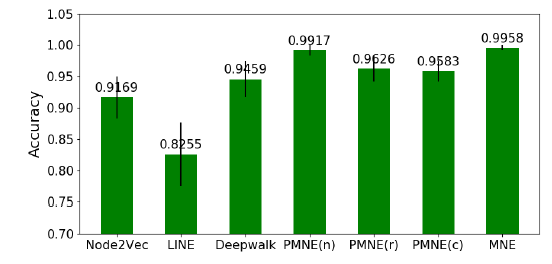

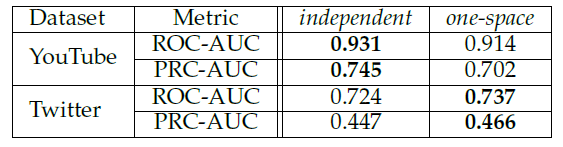

Micro-F1/Macro-F1值,每种配置随机执行10次并报告平均结果。由于CMSC无法扩展到非常大的网络,因此仅报告它在PPI网络上的结果。结论:

- 基于单视图的方法(

LINE和node2vec)分类效果都比较一般。 node2vec-merge通过合并不同视图的边来利用多视图信息。但是,不同视图的邻近性是无法直接比较的,简单地将它们融合在一起会破坏每个视图的网络结构。在Flickr数据集上,node2vec-merge方法的效果甚至还不如基于单视图的方法。node2vec-concat通过将学到的多个视图的view-specific representatioin进行拼接来利用多视图信息。但是,来自某些稀疏视图的representation可能会有严重有偏biased,这可能会破坏最终的representation。因此,即使该方法使用了更高的维度,node2vec-concat也不会显著优于其它的、基于单视图的方法。- 多视图聚类

CMSC和多视图矩阵分解(MultiNMF和MultiSPPMI) 的效果都较差,因为它们无法有效地实现不同视图的协同,也无法学习不同视图的权重。 - 我们提出的

MVE在不使用标签信息来学习视图权重的情况下,MVE-NoAttn超越了所有baseline方法。当使用注意力机制之后,MVE可以进一步提升效果。 - 如果

MVE去掉了不同视图的协同(即MVE-NoCollab),则会观察到较差的结果。这表明我们的协同框架确实可以通过促进视图的协同来提升性能。

- 对于

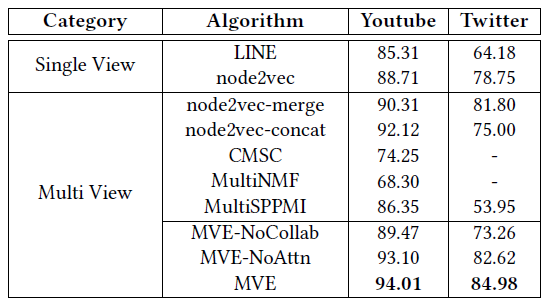

链接预测任务:链接预测任务旨在预测网络中最有可能形成的链接。由于节点规模巨大,因此预测全网的所有可能的链接是不现实的。因此我们为每个数据集构造一个核心节点集合,并且仅预测核心节点集合中的节点链接。

- 对于

Youtube数据集,核心节点集包含同时出现在所有四个视图中的所有节点,一共7654个节点。 - 对于

Twitter数据集,由于节点数量太多,我们随机采样了出现在所有三个视图中的5000个节点。

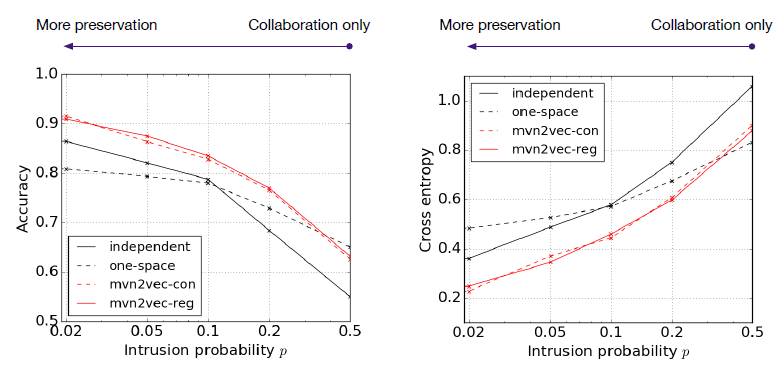

对核心节点集中的每对节点,我们用它们

robust representation向量的余弦相似度来作为形成链接的概率。另外,为了获得MVE模型中视图的投票权重,我们从每个数据集中随机抽取500条边作为标记数据,这些标记数据不包含在评估数据集中。我们通过核心数据集的

AUC来评估不同模型的链接预测能力。由于CMSC/MultiNMF无法扩展到非常大的网络,因此我们仅报告Youtube数据集上的结果。结论:

- 基于单视图的方法(

node2vec/LINE)效果都比较一般。 node2vec-merge通过合并不同视图的边来利用多视图信息。由于这两个数据集的不同视图具有可比性和互补性,因此node2vec-merge的效果得到改善。node2vec-concat通过将学到的多个视图的view-specific representatioin进行拼接来利用多视图信息。但是某些稀疏的视图(如Twitter数据集上的reply视图)可能会有严重的bias,这可能会破坏最终的representation。- 多视图聚类

CMSC和多视图矩阵分解(MultiNMF和MultiSPPMI) 的效果仍然都较差,因为它们无法有效地实现不同视图的协同,也无法学习不同视图的权重。 - 我们提出的

MVE方法让然优于所有的baseline方法。如果移除视图协同(MVE-NoCollab)或者移除注意力机制(MVE-NoAttn),则效果将下降。这表明我们协同框架的有效性和注意力机制的重要性。

- 对于

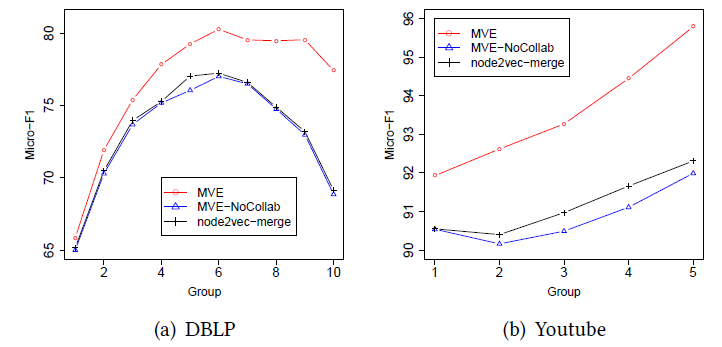

数据稀疏性:这里我们检查

MVE是否对稀疏数据也是鲁棒的。具体而言,我们研究MVE在不同degree节点上的性能,这对应于不同级别的数据稀疏性。每个节点的degree是所有视图的degree的总和。根据节点的degree,我们将DBLP数据集的所有节点划分为10个不同的分组、将Youtube数据集中所有节点划分为5个不同的分组。我们比较了

MVE, node2vec-merge和MVE-NoCollab在不同分组上的性能,效果如下图所示。图中组id越小则节点degree越大,组id越大则节点degree越小。因此越靠近右侧,数据越稀疏。结论如下:

对于

BDLP数据集,这三个模型在左侧的分组上效果均不理想。这是因为很多degree非常高的节点属于多个研究领域,因此难以正确分类。在右侧的分组中,

node2vec-merge和MVE-NoCollab的性能仍然很差,但是MVE明显优于它们。对于

Youtube数据集,也观察到类似的结果。这三个模型在左侧的分组上效果均不理想,但是在右侧的分组中MVE的效果优于node2vec-merge和MVE-NoCollab。

总之,

MVE在更稀疏的节点上取得了更好的效果,并且始终优于MVE-NoCollab和node2vec-merge。这表明我们的方法可以有效解决数据稀疏性问题,并帮助学到更鲁棒的node representation。

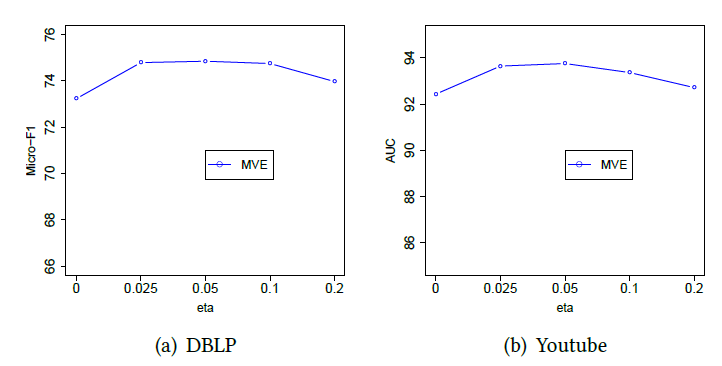

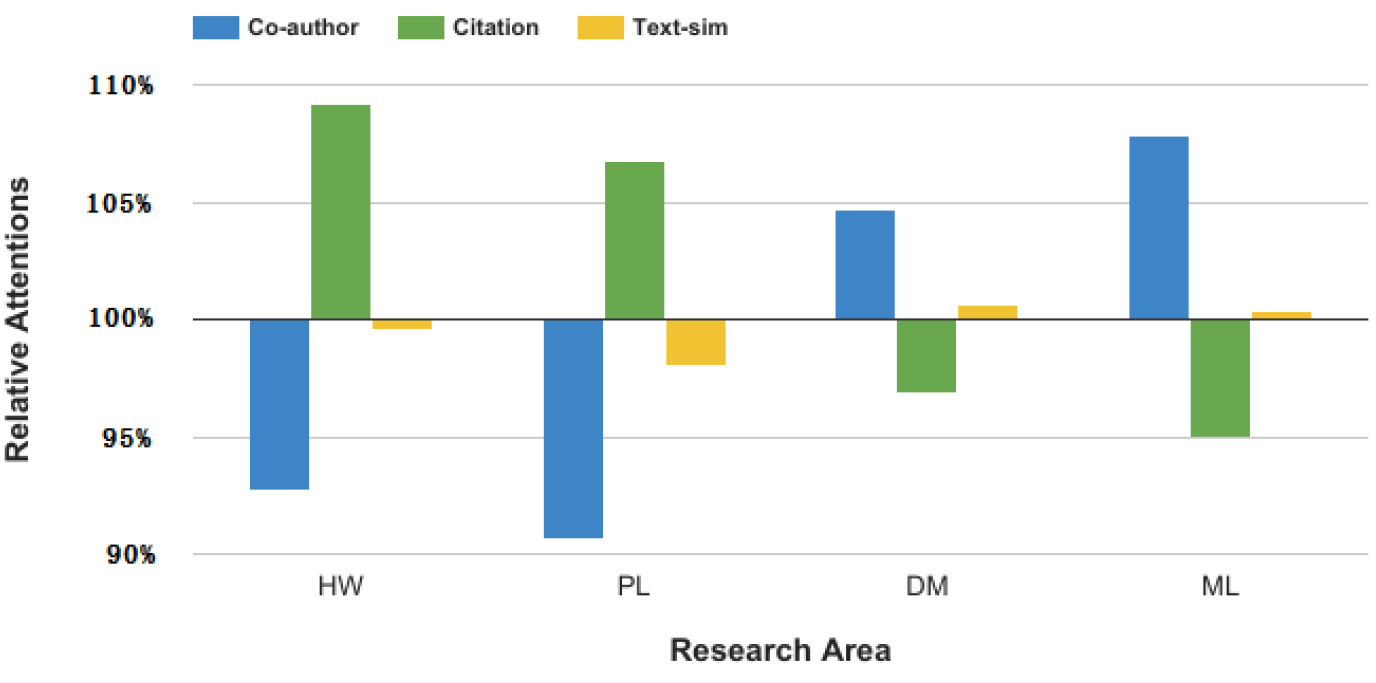

参数

view-specific representation保留的邻近性与view-specific representation的一致性。我们在节点分类任务和链接预测任务上比较了MVE随着不同结论:

- 当

MVE效果较差,因为不同视图无法通过正则化来彼此交流信息。 - 当

MVE效果持续改善。 - 当

MVE的效果比较稳定。 - 当

MVE效果持续下降。这是因为更大的view-specific representation趋同,从而忽略了视图之间的差异。

- 当

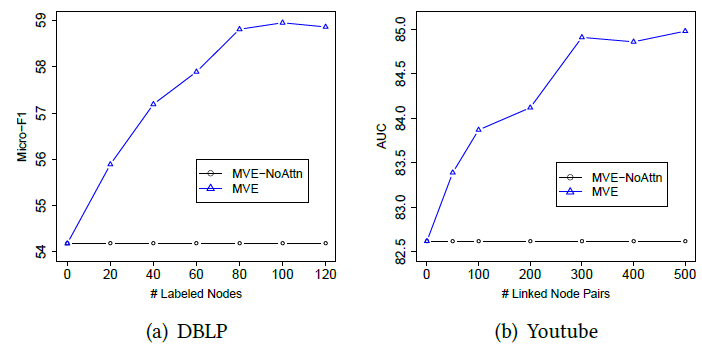

标记数据规模的敏感性:为了学习不同节点的视图投票权重,我们的框架需要一些标记数据。这里我们考察不同规模的标记数据对于效果的影响。我们观察随着标记数据规模的变化,

MVE和MVE-NoAttn的性能。结论:

- 通过利用标记数据来学习视图的投票权重,

MVE始终超越了其变体MVE-NoAttn - 在这两个数据集上,

MVE只需要很少的标记数据就可以使得预测性能收敛,这证明了我们基于注意力机制来学习投票权重的有效性。

- 通过利用标记数据来学习视图的投票权重,

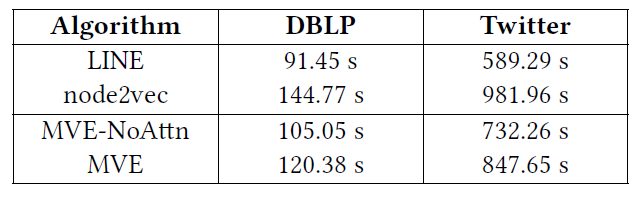

效率:我们在

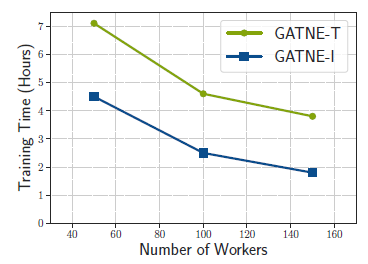

DBLP和Twitter数据集上对比MVE和node2vec/LINE/MVE-NoAttn的训练时间。结论:

MVE和LINE/node2vec的运行时间都很接近。- 在拥有超过

30万顶点、1亿边的Twitter数据集上,MVE训练过程不超过15分钟,非常高效。 - 对比

MVE和MVE-NoAttn的训练时间,我们观察到MVE的权重学习过程在这两个数据集上花费的时间不到总训练时间的15%。这证明了我们基于注意力的权重学习方法具有很高的效率。

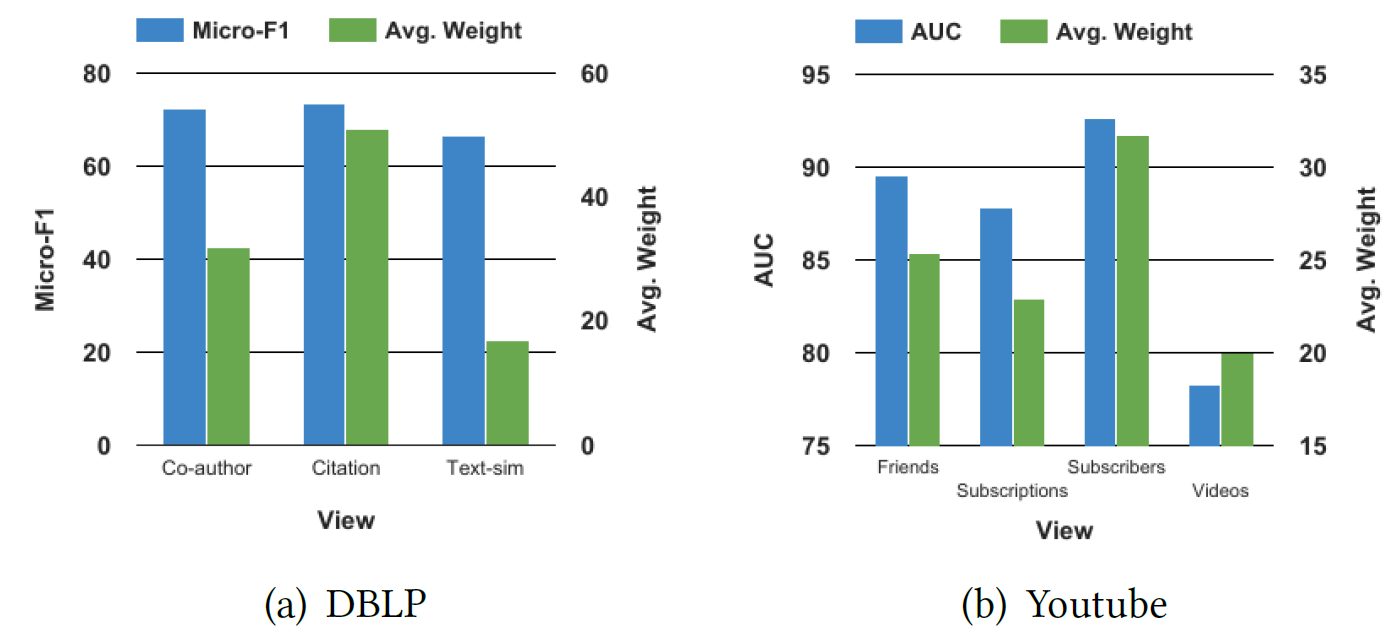

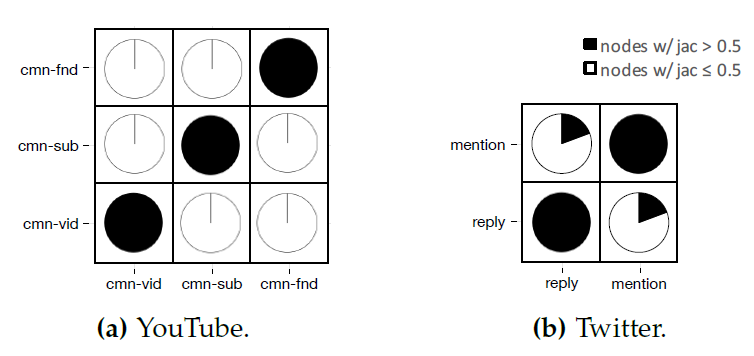

注意力权重分析:我们考察

MVE学到的注意力,以及这些注意力为什么能够改善性能。首先我们研究哪些视图会得到更高的注意力。我们以

DBLP和Youtube数据集为例。对每个视图,我们报告单独使用view-specific representation进行分类/链接预测的结果,以及每个视图所有节点的平均注意力得分。结论:单个视图的性能和它们分配的平均注意力正相关。即:我们的方法使每个节点关注于效果最好的视图。

然后,我们比较不同

label中节点的注意力,从而在更细粒度进一步研究学到的注意力。我们以DBLP数据集为例,并研究四种label中的节点,包括hardware (HW), programming language (PL), data mining (DM) and machine learning (ML)。对每种label,我们计算属于该label的节点各视图平均分配的权重,并报告与其它label的节点各视图平均分配的权重的比值,以便了解哪些视图对于各label而言效果最好。结论:

- 对

HW/PL领域的节点而言,它们对citation视图的关注相对更多。 - 对

DM/ML邻域的节点而言,它们对co-author视图的关注相对更多。

这是因为我们的节点分类任务旨在预测不同作者的研究领域。为了提高预测的准确性,我们的注意力机制需要让节点关注于最能够与其它领域作者区分开的视图。

- 对于

HW和PL领域作者而言,与其它领域节点(每个节点就是一位作者)相比,这两个领域的作者可能会引用非常不同的论文,因此论文引用视图对它们的区分度最大。因此,HW/PL领域的节点对citation视图的注意力更大。 - 对于

DM/ML领域作者而言,他们更可能使用相似的术语并引用相似的论文,因此文本相似度视图、引文视图都无法将这些领域区分开来。因此,这些领域的节点很少关注文本相似性视图和引文视图,而更多地关注co-author视图。

总之,通过注意力机制学到的视图权重非常直观:迫使每个节点专注于信息量最高的视图。

- 对

case研究:最后我们提供一些case来展示view-specific representation和robust representation之间的差异。我们以DBLP数据集为例。 给定一个作者作为query,我们根据不同的embedding找出最相似的作者,相似度通过embedding向量的余弦相似度来衡量。结论:

view-specific representation可以很好地保留各个视图的结构邻近性,而robust representation则利用了来自所有不同视图的信息。

二十二、PMNE[2017]

随着大数据的兴起(尤其是社交网络),图挖掘已经成为分析对象之间的多样化关系、理解底层图的复杂结构的必要条件。分析如此复杂的系统对于了解社交网络的形成方式、或者预测未来的网络行为至关重要。

然而,图挖掘对网络的拓扑结构

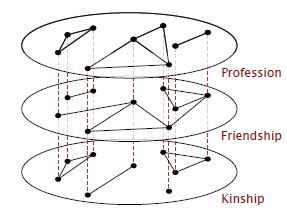

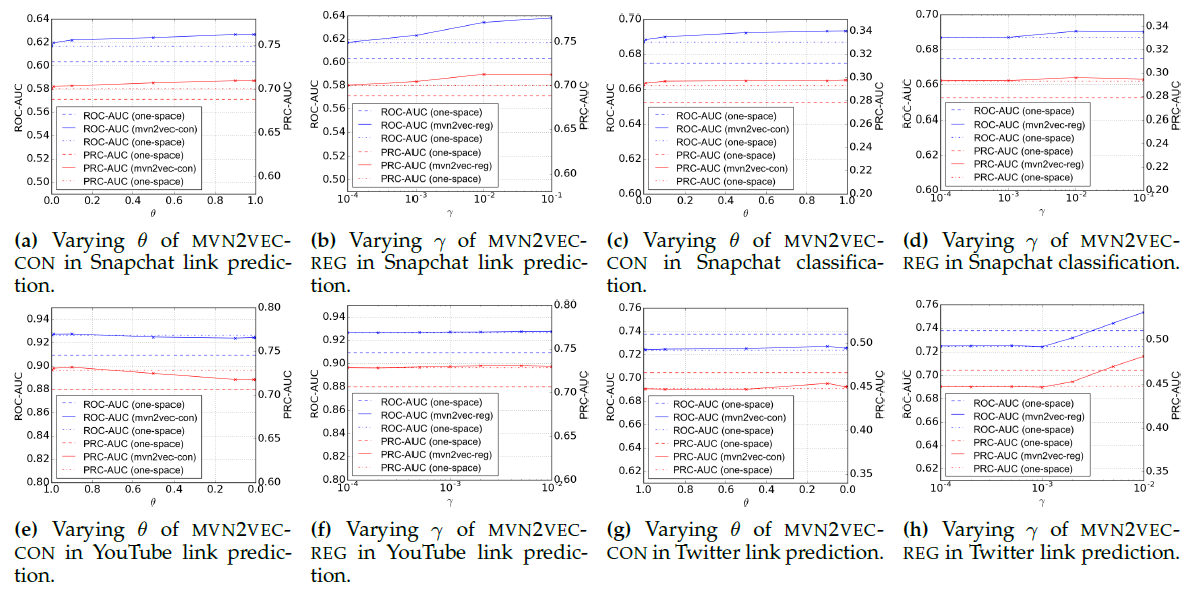

topological structure非常敏感。例如,在社交网络分析中,图挖掘可以利用拓扑信息来识别网络中的社区,但是无法确定拓扑是否包含噪声(或其它错误)。避免这种情况的一种方法是使用多层网络multilayer network。多层网络是描述节点之间多种关系的一组网络,其中每个网络(一个网络代表一层 )代表一种特定类型的关系。多层网络也就是多视图网络。

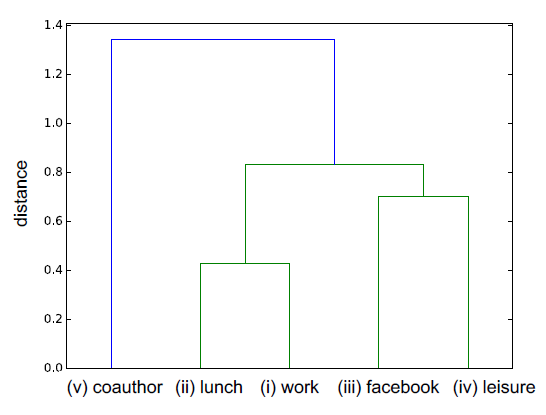

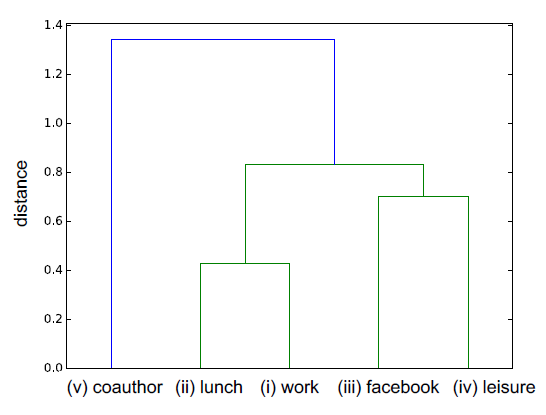

以

AUCS数据集为例。多个层代表大学院系61名员工之间的五种不同关系类型:共同工作、共进午餐、facebook好友、共度闲暇时光、共著学术论文。下图显示了这些不同层之间的距离(根据论文《Structural reducibility of multilayer networks》的方法),其中层之间的距离是包含双方的最小子树的根节点的distance value。从下图中,我们观察到一些关键的交互:例如,我们观察到 “共同工作”、“共进午餐” 密切相关,因为它们具有较小的layer distance;而 “共度闲暇时光” 和 “facebook好友” 也是密切相关的。一般而言,我们认为,多层网络通过考虑多种关系类型从而固有地反映了节点之间的基本交互essential interaction,并且对任何单个关系类型中的噪音都具有鲁棒性。

如今,多层网络上的图挖掘方法通常集中在不同的网络粒度,具体取决于任务。例如:

在节点粒度/边粒度上,

《Multiplex networks and interest group influence reputation: An exponential random graph model》和《Conditions for viral influence spreading through multiplex correlated social networks》专注于开发合适的中心性centrality指标,例如多层网络的cross-layer degree中心性。《Individual neighbourhood exploration in complex multi-layered social network》和《A method for group extraction in complex social networks》提出了多层局部聚类系数multilayered local clustering coefficient: MLCC和跨层聚类系数cross-layer clustering coefficient: CLCC来描述多层网络中节点的聚类系数。相比之下,

cluster级别通常用于社区检测,而layer级别通常用于分析不同层类型之间的交互。

在论文

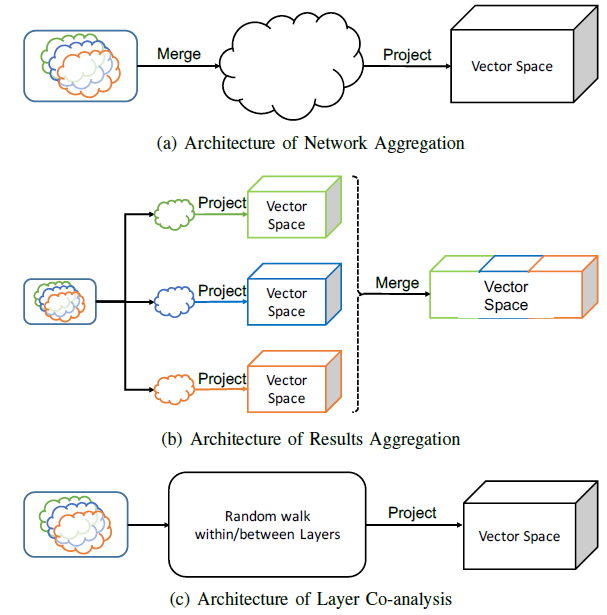

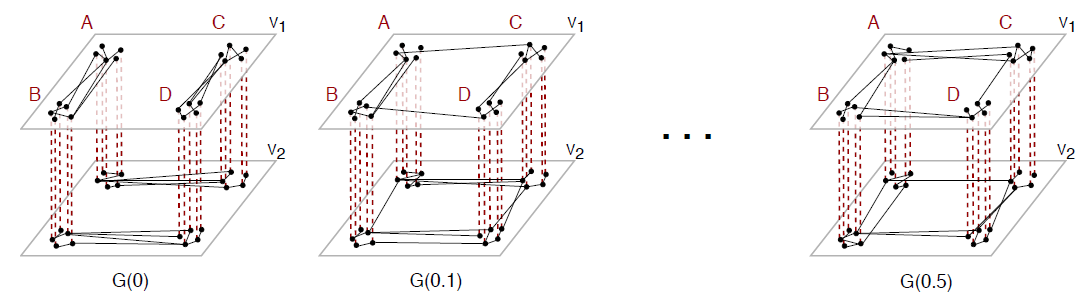

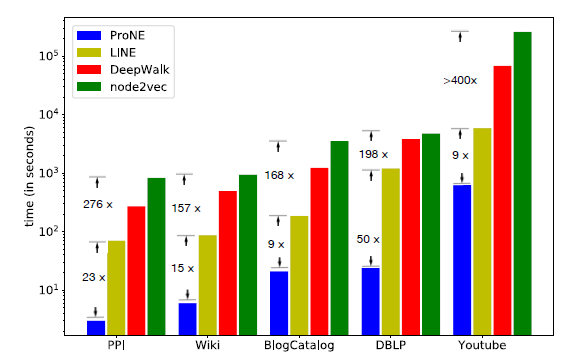

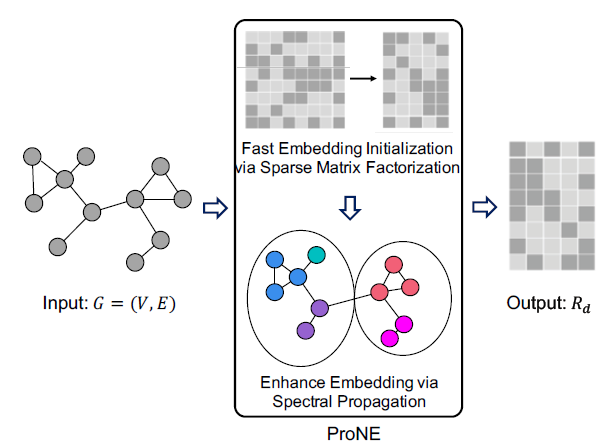

《Principled Multilayer Network Embedding》中,作者尝试通过结合所有粒度级别的分析,提出三种新颖的、多层网络的图挖掘方法。作者通过将多层网络的节点嵌入到向量空间来实现这一点。这个向量空间可以被解释为多层网络的隐式度量空间metric space,它自然地定义了节点之间的相似性概念,并捕获了原始多层网络的多个方面,最终促进了基于向量的representation来解决一系列任务。在标准的网络分析中,人们已经开发了许多这样的

network embedding方法,如DeepWalk, LINE, node2vec。这些方法都基于在输入图上生成随机游走的样本,随机游走的方式因方法而异。然而,这些方法是建立在单个图之上的,据作者所知,多层网络的graph embedding方法尚未得到严格的探索。因此,作者提出了一个通用的多层网络embedding框架,该框架适用于为单层网络开发的任何graph embedding方法。具体而言,作者介绍了将graph embedding扩展到多层网络的三种方法,即:网络聚合Network Aggregation、结果聚合Results Aggregation、网络协同Network Co-analysis。- 网络聚合:该方法的假设是来自不同层的所有边都是等价的。基于该假设,该方法将所有网络聚合为单个网络(如果不允许节点之间存在多条边,则聚合后为加权网络),然后应用现有的

graph embedding算法来分析合并的图。注意,这个合并的图不再区分关系类型。 - 结果聚合:该方法的假设是不同的层有完全不同的边,这意味着即使两个节点在不同的层中都有边,那么这些边是完全不同的、无法合并的。基于这个假设,该方法将

graph embedding方法分别应用于每一层,然后将向量空间合并在一起从而定义多层网络的向量空间。 - 网络协同:与前两种方法仅考虑

inter-layer边(network aggregation)或intra-layer边(results aggregation)不同,该方法利用不同层之间的交互来允许层之间的遍历,并保留每个层的结构。具体而言,论文引入了一种能够跨层遍历的、新的随机游走方法,从而编码节点和层之间的重要交互。

多层网络中的随机游走方法是单层

embedding方法的通用扩展。例如,node2vec和DeepWalk都是state-of-the-art的单层graph embedding方法。就像node2vec为DeepWalk添加了控制随机游走的同质性homophily和结构等价性structural equivalence的能力,论文使得随机游走能够遍历多个层。具体而言,论文添加论文没多大价值,典型的 ”水“ 文。

相关工作:这里我们回顾了标准的

network embedding的相关工作,即为单层网络提出的embedding方法。随着无监督

feature learning技术的发展,深度学习方法通过神经语言模型在自然语言处理任务中被证明是成功的。这些模型通过将word嵌入为向量来捕获人类语言的语义结构semantic structure和语法结构syntactic structure,甚至是捕获逻辑类比logical analogy。由于图可以被解释为一种语言(通过将随机游走视为等价的sentence),DeepWalk将此类方法引入网络分析,从而允许将网络节点投影到向量空间中。为了解决这类方法在应用于现实世界信息网络(通常包含数百万个节点)时的可扩展性问题,人们开发了LINE。LINE将DeepWalk的均匀随机游走扩展为一阶加权随机游走或二阶加权随机游走,从而可以在几个小时内将具有数百万节点、数十亿条边的网络投影到向量空间中。但是,这两种方法都有局限性。由于

DeepWalk使用均匀随机游走进行搜索,因此它无法控制所探索的邻域。相比之下,LINE提出了一种广度优先策略来采样节点,并在一阶邻域和二阶邻域上独立地优化似然性likelihood,但是它无法灵活地探索更深的节点。为了解决这两个限制,node2vec提供了一种灵活的、可控的策略,通过参数node2vec具有可扩展性,并且对扰动具有鲁棒性。当然,这些方法都无法处理多层网络的

layer之间的随机游走。因此,我们的网络协同方法是已有工作在随机游走能力方面的自然扩展。

22.1 模型

给定多层网络

layer集合,其中

layer多层网络嵌入任务是学习一个映射函数

我们提出了多层网络嵌入的三种架构如下图所示:

这篇论文是典型的 ”水”文,每什么价值。

22.1.1 网络聚合

网络聚合

network aggregation方法将多层网络的多个layer合并成单层网络,然后将常规的node2vec应用于合并后的单层网络。该方法的关键在于网络聚合函数:注意:这种方式将所有的层组合在一起,从而失去了每一层的细节信息,并且在学习映射

多层网络嵌入之网络聚合算法:

输入:

- 多层网络

node2vec的超参数

- 多层网络

输出:顶点的

embedding算法步骤:

初始化

网络聚合:

遍历每一对节点

遍历每一层

在

node2vec并返回每个节点的embedding

22.1.2 结果聚合

结果聚合

results aggregation方法将多层网络中的每一层视为一个独立的网络我们独立地学习每个网络

embedding,然后将节点在所有层的embedding拼接起来作为该节点的最终embedding。这种方法可以保持每一层的网络结构,但是无法利用层之间的交互信息。多层网络嵌入之结果聚合算法:

输入:

- 多层网络

node2vec的超参数

- 多层网络

输出:节点的

embedding算法步骤:

遍历每一层

- 初始化

- 遍历

- 在

node2vec得到顶点在第embedding

- 初始化

拼接节点在所有层的

embedding,得到节点的最终embedding

22.1.3 网络协同

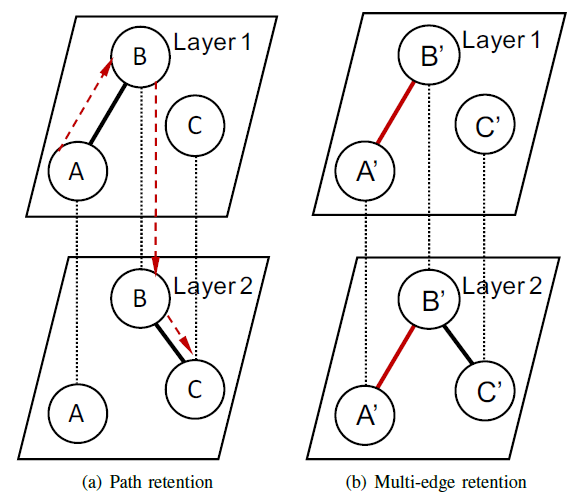

为了克服网络聚合、结果聚合都无法利用层间交互的缺陷,我们采用网络协同

layer co-analysis来构建顶点embedding,该方法可以识别各层之间的交互,并保留各层的结构。考虑下图所示的多层网络随机游走,其中黑色点线代表每层顶点之间的对应关系,黑色粗线代表网络中的边。

- 如果在图

(a)中使用结果聚合,则节点A到节点C没有路径,因为结果聚合无法在层之间遍历。因此该方法无法学到节点A和C的关联。 - 如果在图

(b)中使用网络聚合,则会忽略节点

这使得我们我们寻求一种方法,该方法可以遍历从

A到C的跨层路径(图(a)的红色虚线表示),并可以保留多条边隐含的信息。

- 如果在图

node2vec在DeepWalk基础上引入了参数bias和全局bias,我们在node2vec基础上再引入参数令

其中

我们引入参数为

如果当前节点

node2vec在层其中

node2vec针对多层网络的修改:其中

如果当前节点

本文仅考虑二元边,也可以通过将遍历边的概率乘以归一化的边权重从而推广到加权的多层网络。

另外,我们将在未来探索如何通过分析多层网络的层距离来自动学习

多层网络嵌入之网络协同算法:

输入:

- 多层网络

- 随机游走序列数量

- 每条游走序列长度

- 超参数

- 多层网络

输出:节点的

embedding算法步骤:

初始化游走路径集合

迭代直到生成

随机选择一条边作为序列的起始边:

迭代直到第

- 以概率

next_layer - 以概率

next_layer中的下一个节点

- 以概率

对随机游走路径集合

node2vecSGD(基于node2vec对数似然目标函数的随机梯度下降)。

超参数

- 当

- 当

- 当

22.2 实验

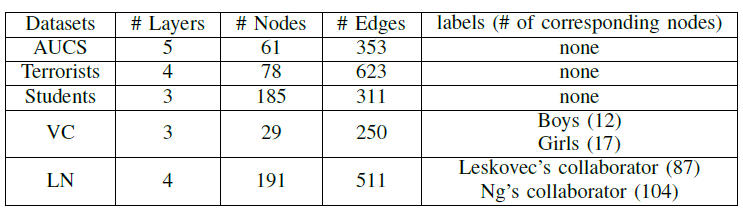

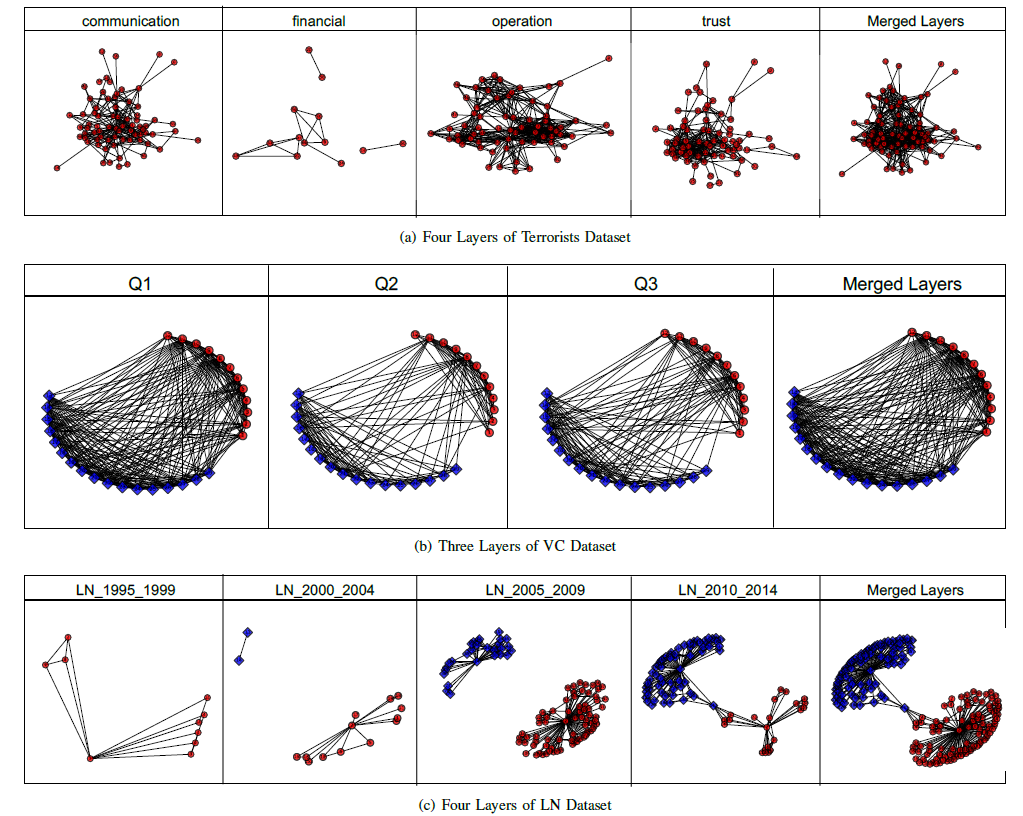

数据集:

AUCS数据集:数据集为一个多层网络,代表大学部门的61位员工之间的五种不同关系:coworking, having lunch together, facebook friendship, onine friendship(having fun together), coauthorship。Terrorist数据集:数据集为一个多层网络,代表恐怖分子之间的不同关系:communication, financial, operation, trust。Student数据集:数据集为一个多层网络,代表Ben-Gurion University中185名学生之间的不同关系:Computer Network(学生在同一台机器上完成论文)、Partner’s Networt(学生共同完成论文)、Time Network(学生在同一时间提交论文)。Vickers Chan数据集VC:数据集为一个多层网络,代表七年级学生社交的不同互动关系:你在班上和谁打交道、谁是你班上最好的朋友、你最想和谁一起玩。Leskovec-Ng collaboration数据集LN:数据集为一个多层网络,代表从1995到2014不同年代Jure Leskovec和Andrew Ng的共同著作网络。我们将coauthorship网络按照5年一个layer,最终得到四层网络。在每层网络中,如果和这两个作者任意一个至少由一篇共同著作,则存在一条边。根据协作的频次,每位学者被标记为

Leskovec的协作者、或者Ng的协作者。

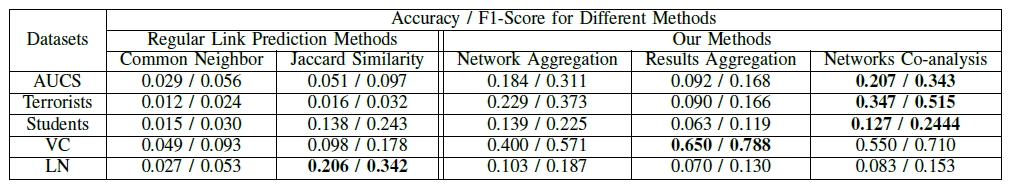

我们在这些多层网络数据集上执行链接预测任务,从而比较不同方法在链接预测任务上的性能。

我们将边

10%的边作为测试集。我们使用我们的

embedding方法在训练集embedding,然后计算10%预测为存在边,并将预测结果和准确率

acc为这个指标其实是召回率指标,而不是准确率。

F1得分为precision和recall的调和均值。这个指标预估每个层的边。

我们的方法中,超参数设置为:

10、每条随机游走序列的长度为80。baseline模型:我们在融合的网络中引入两个著名的链接预测算法:Common Neighbor Similarity:Jaccard Similarity:

这两种方法也是选择相似度最大的

top 10%来预测存在边。baseline没有graph embedding方法,垃圾。数据集太拉胯。不同方法在不同数据集上的评估结果如下表所示。可以看到,除了

LN数据集以外,我们的方法可以实现更高的准确率和F1得分。

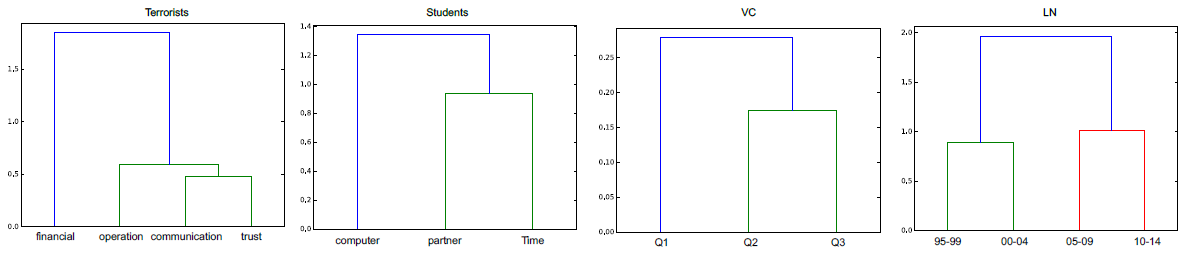

不同数据集中各层之间的距离如下所示:

我们使用下图来给出三个多层网络每一层和相应的融合层的结构。由于

VC数据集和LN数据集带有标签信息,因此我们使用不同的形状和颜色来展示不同标签的顶点。在

Terrorists数据集中,多层网络显式了恐怖分子如何协作。显然,不同层之间的作用影响很大。这意味着如果我们需要预测两个顶点之间的链接,则需要考虑这两个顶点在不同层之间的交互。以图(a)为例,尽管financial层的顶点很少,但是四层之间的交互作用很强,而网络协同可以通过不同层的随机游走来恢复必要的信息。对于

AUCS/Students数据集,也是类似的结果。在

VC数据集中,不同question代表不同的关系,因此不同层之间的作用影响较弱。比如,“你在班上和谁打交道” (Q1)并不意味着你和她/他就是好朋友关系 (Q2)。由于第一个问题过于笼统,导致产生大量的噪音,因此无法指示这些顶点之间的真实关系。如果我们将这些层合并,或者更多地关注层交互上,那么网络聚合和网络协同都无法揭示真实的信息,反而会引入更多噪音。

在

LN数据集中,不同时间区间的layer没有任何交互。如,第一层没有蓝色顶点、第二层和第三层中两个簇自行扩展。这表明以下事实:层之间的交互作用并不是对应层中形成拓扑结构的关键。而且,各层之间的间隔为5年,因此层内的噪音使得我们的方法效果较差。相反,原始

Jaccard方法最好,因为它仅关心两个顶点的平均共享邻居数量,这种方法受噪音影响最小。

二十三、ANRL[2018]

网络是对现实世界中复杂系统进行探索和建模的通用数据结构,包括社交网络、学术网络、万维网等等。在大数据时代,网络已经成为一个重要媒介,用于有效地存储、访问交互实体的关系知识

relational knowledge。在网络中挖掘知识已经引起了学术界和工业界的持续关注,例如在线广告targeting、推荐系统。大多数的这些任务都需要精心设计的模型,并且需要大量专家努力进行特征工程,而representation learning是自动化的feature representation方案。采用representation learning之后,可以通过在低维向量空间中学习从而极大地提升网络中的知识挖掘任务,如聚类、链接预测、分类等任务。network representation learning中的相关工作可以追溯到基于图的降维方法,例如局部线性嵌入Locally Linear Embedding: LLE、Laplacian Eigenmap: LE。LLE和LE都通过构建最近邻图nearest neighbor graph来维护数据空间中的局部结构local structure。为了使相互连接的节点在representation空间中彼此更接近,人们计算亲和图affinity graph的相应eigenvector作为节点的representation。这些方法的一个主要问题是:由于计算eigenvector的计算复杂度太高,它们很难扩展到大型网络。受到

word2vec模型最近成功的启发,人们已经提出了许多基于网络结构的representation learning方法,并在各种application中显示出良好的性能。然而,节点属性信息没有受到太多关注,实际上这些节点属性信息可能在许多application中发挥重要作用。我们经常在现实世界的网络中观察到带各种属性的节点,这种网络被称作属性信息网络attributed information network。例如,在Facebook社交网络中,用户节点通常关联了个性化的用户画像,包括年龄、性别、教育、以及发帖内容。最近的一些努力通过整合网络拓扑信息和节点属性信息来探索属性信息网络,从而学到更好的representation。属性信息网络中的

representation learning仍然处于早期阶段,能力相当有限,原因是:- 网络拓扑和节点属性是两个异质的信息源,因此很难在公共向量空间中保存它们的属性。

- 观察到的网络数据往往是不完整

attributed information network的,甚至是噪音noisy的,这使得更加难以获取有信息量的representation。

为了解决上述挑战,论文

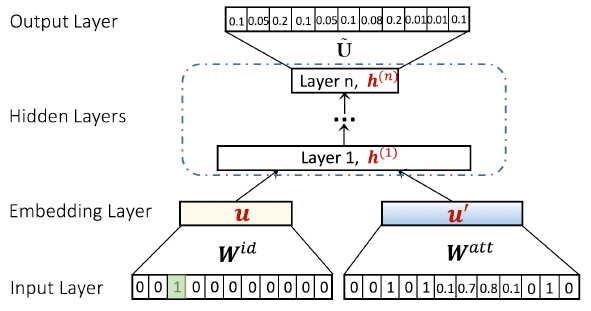

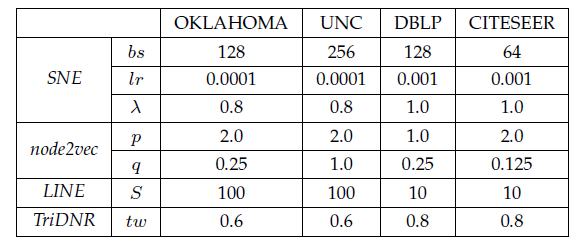

《ANRL: Attributed Network Representation Learning via Deep Neural Networks》提出了一个统一的框架,称作ANRL。该框架通过联合地集成网络结构信息和节点属性信息来学习属性信息网络中的、鲁棒的representation。更具体而言,论文利用深度神经网络的强大表达能力来捕获两个信息源的、复杂的相关性,这两个信息源由邻域增强自编码器neighbor enhancement autoencoder、以及属性感知attribute-aware的SkipGram模型组成。总而言之,论文的主要贡献如下:- 论文提出了一个统一的框架

ANRL,它将网络结构邻近性proximity和节点属性亲和性affinity无缝集成到低维representation空间中。更具体而言,论文设计了一个邻域增强自编码器,它可以在representation空间中更好地保持数据样本之间的相似性。论文还提出了一个属性感知的SkipGram模型来捕获结构相关性。这两个组件与一个共享的编码器相连,其中这个共享编码器捕获了节点属性信息以及网络结构信息。 - 论文通过两个任务(链接预测任务、节点分类任务)对六个数据集进行了广泛的实验,并通过实验证明了所提出模型的有效性。

相关工作:一些早期的工作和其它谱方法

spectral method旨在保留数据的局部几何结构,并在低维空间表达数据。这些方法是降维技术的一部分,可以被视为graph embedding的先驱。最近,

network representation learning在网络分析中越来越受欢迎。network representation learning专注于嵌入当前的网络而不是构建亲和图affinity graph。其中:DeepWalk执行截断的随机游走从而生成节点序列,并将节点序列视为sentence并输入到SkipGram模型从而学习representation。Node2vec通过采用广度优先breadth-first: BFS和深度优先depth-first: DFS的图搜索策略来探索不同的邻域,从而扩展了DeepWalk。LINE不是执行随机游走,而是优化一阶邻近性和二阶邻近性。GraRep提出为graph representation捕获k阶关系信息relational information。SDNE将图结构整合到深度自编码器deep autoencoder中,从而保持高度非线性的一阶邻近性和二阶邻近性。

属性信息网络在许多领域中无处不在。通过同时使用网络结构信息和节点属性信息来实现更好的

representation,这是很有前景的。一些现有的算法已经研究了将这两个信息源联合地嵌入到一个统一空间中的可能性。例如:TADW将DeepWalk和相关的文本特征整合到矩阵分解框架中。PTE利用label信息和不同level的单词共现信息来生成predictive text representation。TriDNR使用来自三方的信息(包括节点结构、节点内容、节点label)来联合学习node representation。

尽管上述方法确实将节点属性信息融合到

representation中,但它们是专门为文本数据设计的,不适用于许多其他类型的特征(如连续数值特征)。最近,人们已经提出了几种特征类型无关的

representation learning算法,以通过无监督或半监督的方式进一步提高性能。这些算法可以处理各种特征类型,并捕获结构邻近性structural proximity以及属性亲和性attribute affinity。AANE是一种分布式embedding方法,它通过分解属性亲和矩阵,并使用network lasso正则化来惩罚互相连接的节点之间的embedding difference,从而联合地学习node representation。Planetoid同时开发了transductive方法和inductive方法来联合预测图中的class label和邻域上下文。SNE通过利用端到端神经网络模型来捕获网络结构信息和节点属性信息之间复杂的相互关系,从而生成embedding。- 另一个半监督学习框架

SEANO采用输入样本属性、以及它平均邻域属性聚合的方式,从而缓解异常值在representation leraning过程中的负面影响。

也有一些工作在探索异质信息网络中的

representation learning。metapath2vec利用基于metapath的随机游走来生成异质节点序列,并采用异质SkipGram模型来学习node representation。《Attributed network embedding for learning in a dynamic environment》提出了一种模型,该模型可以在动态环境而不是静态网络中处理representation learning。《Attributed signed network embedding》研究了有符号信息网络中的representation learning问题。

我们将这些可能的扩展保留为未来的工作。

23.1 模型

令

属性信息网络的

representation learning任务的目标是:学习一个映射函数network structure proximity、节点属性邻近关系node attribute proximity。

23.1.1 邻域增强自编码器

为了编码节点的属性信息,我们设计了一个邻域增强自编码器模型。该自编码器由编码器和解码器组成,旨在重建目标节点的邻域而不是目标节点本身。值得注意的是,当我们的目标邻域是输入节点本身时,该自编码器退化为传统的自编码器。

具体而言,对于节点

target neighbor的聚合函数为定义每一层的隐向量为:

其中:

ReLU),我们的目标是最小化自编码器的损失:

其中:

函数

邻域加权平均

Weighted Average Neighbor:其中:

邻域的逐元素中位数

Elementwise Median Neighbor:其中

中位数指的是排序之后位于正中间的那个数。

与传统的自编码器相比,我们的邻域增强自编码器在保持节点之间的邻近性方面效果更好。因为邻域增强自编码器迫使节点重建相似的目标邻域,从而使得位置相近的节点具有相似的

representation。因此,它捕获了节点属性信息和局部网络结构信息。另外,重建的目标综合了多个邻域节点的信息,这比传统的重建单个节点(目标节点自身)更为鲁棒。因为单个节点的波动更大。

最后,我们提出的邻域增强自编码器是一个通用框架,可用于各种自编码器的变体,如降噪自编码器、变分自编码器。

23.1.2 属性感知 SkipGram 模型

属性感知

SkipGram模型将属性信息融合到SkipGram模型。具体而言,在SkipGram的目标函数中为随机游走上下文提供当前节点的属性信息:其中:

其中:

CNN编码器、针对序列数据的RNN编码器。这里我们使用邻域增强自编码器(见小面的小节)。representation。

因此,

直接优化

其中:

sigmoid函数。degree。

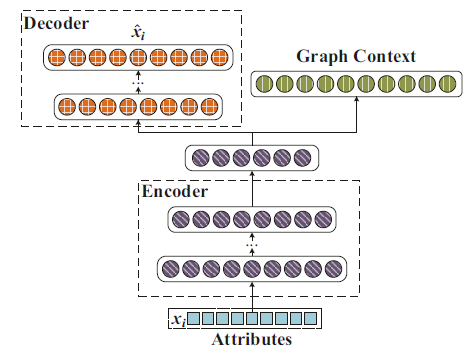

23.1.3 ANRL 模型

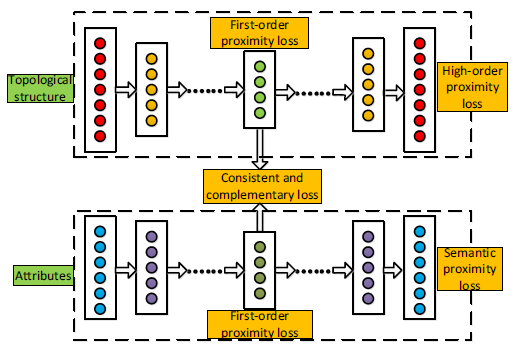

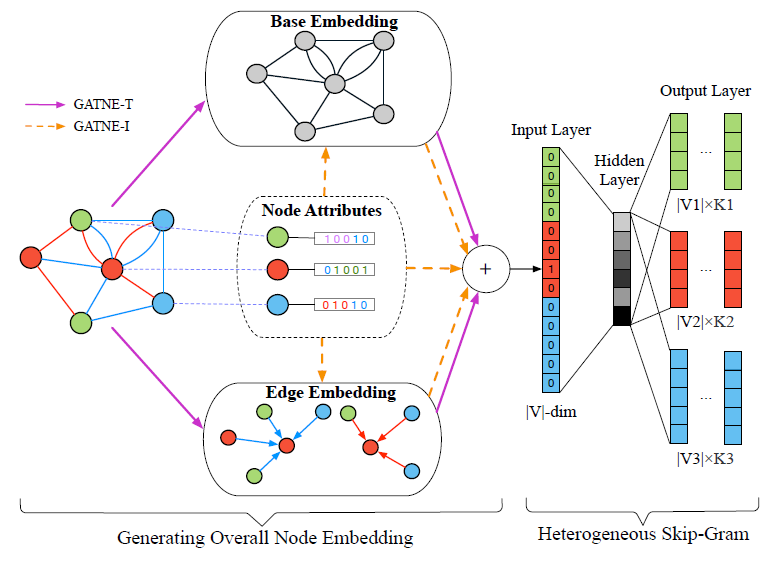

ARNL模型同时利用了网络结构和节点属性信息。如下图所示,ANRL模型由两个耦合的模块组成:邻域增强自编码器模块、属性感知SkipGram模块。编码器将输入的属性信息映射到低维向量空间,并扩展出两路输出:

- 左路输出为邻域增强自编码器的解码器部分。

- 右路输出用于预测属性感知

SkipGram的节点上下文。

邻域增强自编码器、属性感知

SkipGram共享网络的前几层(编码器部分),因此这两个模块相互耦合。通过这种方式,ARNL学到的节点representationANRL可以视为多任务模型,包括:基于邻域增强自编码器的邻域属性重建任务、基于属性感知SkipGram的上下文预测任务。二者共享节点的representation。

ANRL模型通过联合学习邻域增强自编码器模块、属性感知SkipGram模块两个模块,其目标函数为:其中:

representation。

通过这种方式,

ANRL将节点属性、局部网络结构、全局网络结构保留在一个统一的框架中。通过邻域增强自编码器模块捕获网络局部结构信息,通过属性感知的

SkipGram模块捕获网络全局结构信息,通过这两个模块同时捕获节点属性信息。值得注意的是:属性感知的

SkipGram模块的函数representation此外,为简单起见,我们使用单个非线性层来捕获图的上下文信息,并可以轻松地扩展到多个非线性层。

我们使用随机梯度算法来优化

ANRL训练算法:输入:

- 属性信息网络

- 每个节点开始的随机游走序列数量

- 随机游走序列长度

- 上下文窗口大小

embedding维度- 损失函数平衡系数

- 属性信息网络

输出:节点的

representation矩阵算法步骤:

对每个节点执行

从随机游走序列中构建每个节点的上下文集合

根据函数

随机初始化所有的参数

迭代直到模型收敛,迭代步骤为:

- 随机采样一个

mini-batch的节点及其上下文。 - 计算梯度

- 计算梯度

SkipGram模块的参数。

- 随机采样一个

返回

embedding矩阵。

23.2 实验

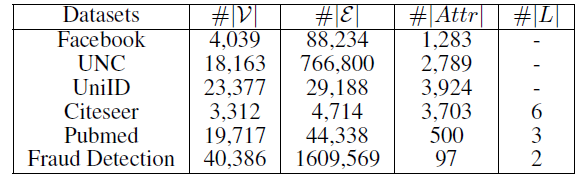

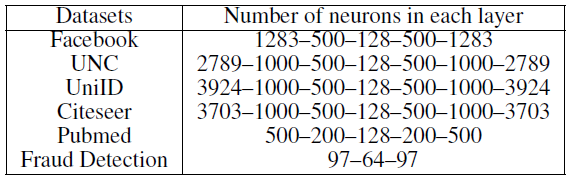

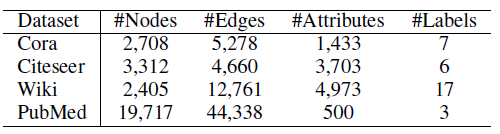

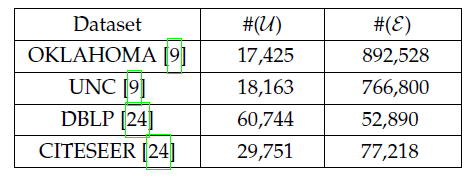

数据集:

社交网络数据集:

Facebook和UNC数据集是两个典型的社交网络数据集,节点代表用户,边代表用户的好友关系。引文网络数据集:

Citeseer和Pubmed是典型的引文网络数据集,节点代表论文或出版物,边代表它们之间的引用关系。Citeseer中的论文分为六种类别:Agents,AI,DB,IR,ML,HCI。Pubmed中的论文分别三种类别:Diabetes Mellitus Experimental、Diabetes Mellitus Type 1(I型糖尿病)、Diabetes Mellitus Type 2(II型糖尿病)。

用户行为网络数据集:

UniID和Fraud Detection是阿里巴巴提供的两个真实的用户行为数据集。UniID网络中的节点表示物理设备的ID,边表示在同一个用户的行为记录中观察到两个ID同时出现。Fraud Detection网络中存在两种类型的节点:cookie节点(代表买家)、seller节点(代表卖家)。cookie节点包含了带属性的cookie信息。为了获得同质

cookie网络,我们采用如下方法将二部图映射为仅包含cookie节点的图:当且仅当两个cookie之间存在至少五个共同的seller节点时,连接这两个cookie节点。我们的目标是鉴别哪些cookie是可疑的。

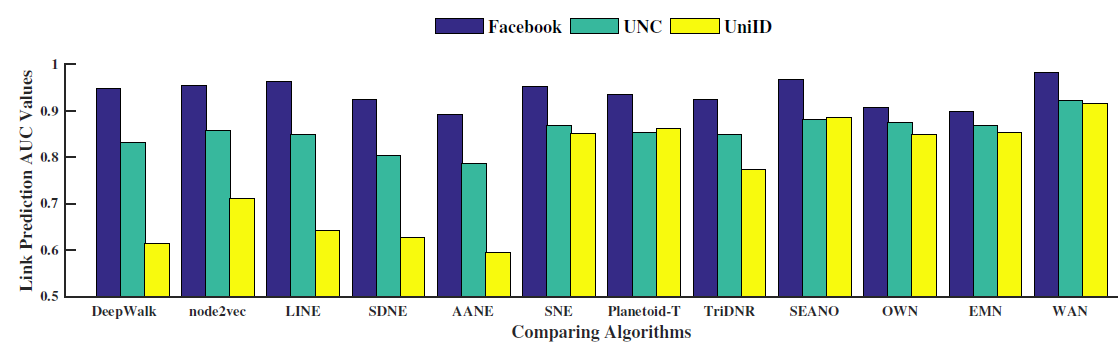

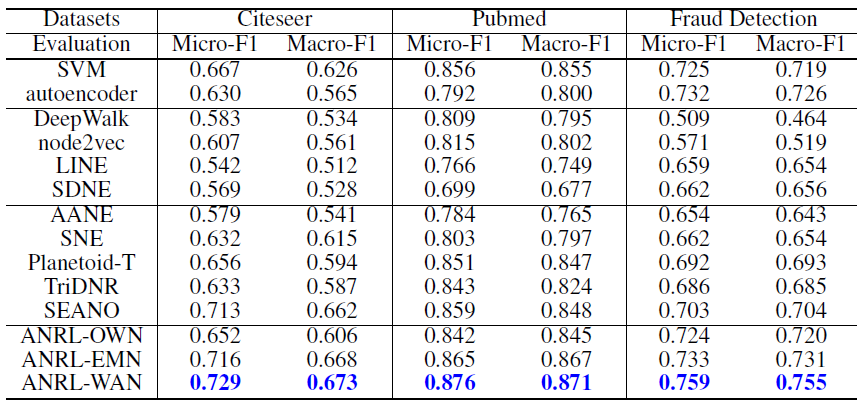

Baseline模型:我们将当前state-of-the-art的network representation learning方法划分为以下几组:- 仅属性的方法

Attribute-only:仅考虑节点属性信息。这里我们选择SVM和自编码器作为baseline模型。 - 仅结构的方法