GNN(续)

二十六、Graph Network[2018]

摘要:人工智能

Artificial intelligence: AI最近经历了一场复兴,并在视觉、语言、控制、决策等关键领域取得了重大进展。取得这些进展的部分原因是由于廉价的数据、廉价的计算资源,这符合深度学习的天然优势。然而,在不同压力下发展起来的人类智力,其许多决定性特点对于目前的人工智能方法而言仍然是触不可及的。具体而言,超越经验的泛化能力--人类智力从幼年开始发展的标志--仍然是现代人工智能面临的巨大挑战。论文

《Relational inductive biases, deep learning, and graph networks》认为:组合泛化combinatorial generalization是AI实现人类相似能力的首要任务,而结构化表示和计算structured representations and computations是实现该目标的关键。正如生物学把先天nature和后天nurture相结合,论文摒弃手动设计特征hand-engineering、端到端学习end-to-end learning之间进行二选一选择的错误做法,而是提倡一种利用它们进行优势互补的做法。论文探索深度学习框架中使用关系归纳偏置

relational inductive biases如何促进对实体entity、关系relation、以及构成它们的规则rule的了解。论文为AI toolkit提供了一个新的、具有强大关系归纳偏置的构建块building block:Graph Network。Graph Network概括和扩展了图上运行的各种神经网络方法,并为操作结构化知识manipulating structured knowledge和产生结构化行为producing structured behaviors提供了直接接口。论文讨论

Graph Network如何支持关系推理relational reasoning、组合泛化combinatorial generalization。这为更复杂、更可解释、更可扩展的推理模式reasoning pattern奠定了基础。作为论文的补充,作者还发布了一个用于构建

Graph Network的开源软件库,并演示了如何在实际工作中应用它们。引言:人类智能的一个重要标志是 “无限使用有限方法” (

infinite use of finite means) 的能力,其中一小部分的、有限的原始(如单词word)可以无限地组合(如构成无限多的句子sentence)。这反映了组合泛化combinatorial generalization的原理,即从已知的构建块building block来创建新的推论inference、预测prediction、行为behavior。这里我们探索如何通过将偏置学习biasing learning用于结构化的表示和计算structured representations and computations从而提高现代AI的组合泛化能力,尤其是对图graph进行操作的系统。人类的组合泛化能力很大程度上取决于我们表达结构

representing structure和推理关系reasoning about relations的认知机制。- 我们将复杂系统表示为实体

entity及其相互作用interaction的组合。 - 我们使用层次结构来抽象细粒度

fine-grained的差异,并捕获representations和behaviors之间的更一般的共性,比如:同一个物体的一部分、同一个场景的物体、同一个城镇的社区。 - 我们通过组合熟悉的技能

skills和惯例routines来解决新的问题。 - 我们通过将两个领域之间的关系结构对齐,并根据其中一个领域的相应知识得出另一个领域的推论来进行类比。

Kenneth Craik的The Nature of Explanation将世界的组成结构compositional structure of the world和我们内在的心理模型internal mental model的组织方式联系起来,即:世界是组合的compositional,或者至少我们是从组合的角度来理解它的。当我们学习的时候,我们要么将新知识放入现有的结构化表示structured representations中、要么调整结构本身从而更好地适应(和使用)新旧知识。自

AI诞生以来,如何构建具有组合泛化的人工智能系统一直就是AI的核心问题,它是很多结构化方法structured approach的核心,包括:逻辑logic、语法grammar、经典规划classic planning、图模型graphical model、因果推理causal reasoning、贝叶斯非参数化Bayesian nonparametric以及概率规划probabilistic programming。所有子领域都集中于显式的以实体

entity和关系relation为中心的学习上,例如关系强化学习relational reinforcement learning、统计关系学习statistical relational learning。结构化方法对于之前的机器学习如此重要的一个关键原因,部分是因为数据和计算资源的昂贵,而结构化方法强大的归纳偏置inductive biases所带来的样本复杂度sample complexity的改善是非常有价值的。与过去的人工智能方法相比,现代深度学习经常遵循 “端到端”(

end-to-end) 的设计理念,强调最小限度的先验表征的、计算的假设minimal a priori representational and computational assumptions,并力求避免使用显式的结构explicit structure和特征工程hand-engineering。这种强调emphasis和当前的大量廉价数据和廉价计算资源非常契合,也得到了充分的验证。这使得牺牲样本效率sample efficiency从而更灵活地学习成为一种理性的选择。从图像分类到自然语言处理,深度学习在很多具有挑战性的领域中取得了令人瞩目的快速发展,这证明了这种极简主义原则minimalist principle的成功。一个突出的例子是语言翻译,事实证明sequence-to-sequence方法非常有效,无需使用显式的解析树parse tree或者语言实体linguistic entity之间的复杂关系。尽管深度学习取得了巨大成功,但是也有一些严厉的批评:深度学习在复杂的语言和场景理解

complex language and scene understanding、结构化数据的推理reasoning about structured data、训练条件之外的迁移学习transferring learning beyond the training condition以及少量经验中学习learning from small amounts of experience时面临重大挑战。这些挑战需要组合泛化,因此摒弃组合性compositionality以及显式结构explicit structure的方法难以满足这些挑战,这并不奇怪。当深度学习的前辈连接主义

connectionist面临诸如结构性的structured、符号性的symbolic立场position等类似批评时,有些工作直接地、细致地做出了建设性的努力来解决这些挑战。在诸如模拟制造analogy-making、语言分析linguistic analysis、符号操作symbol manipulation以及其它形式的关系推理之类的领域中,符号主义开发了用于表示和推理结构化对象的各种创新的亚符号sub-symbolic方法,以及有关大脑如何工作的更多综合理论integrative theory。这些工作还有助于培养更多的深度学习进展advances,这些进展使用分布式向量表示来捕获文本text、图graph、代数表达式algebraic expression、逻辑表达式logical expression、以及程序programs中的丰富语义内容。我们认为,现代

AI的关键途径是致力于将组合泛化作为首要任务,并且我们主张采用综合方法integrative approache来实现这一目标。正如生物学没有在先天nature和后天nurture之间进行选择一样(生物学同时利用先天和后天,这种整体效果强于每个部分之和),我们也拒绝这样的观念(即,结构struture和灵活性flexibility在某种程度上是矛盾的或不相容的),并且我们同时拥抱结构和灵活性从而获得它们的互补优势。根据大量最新的一些混合了structure-based方法、deep learning方法的案例,我们发现:将当今最好的方法(即deeplearning方法)和早期算力昂贵时必不可少的方法(即结构化方法)相结合的综合技术具有广阔的前景。近年来,在深度学习和结构化方法的交集中出现了一类模型,这些模型聚焦于推理有关显式结构化数据(特别是图

graph)的方法。这些方法的共同点是可以对离散实体entity以及实体之间的关系relation进行计算。这些方法和经典方法不同之处在于:如何学习实体和关系的representation以及structure,以及相应的计算,从而缓解了事先需要指定它们的负担。即,这些知识是通过学习而来,而不是预先指定的。至关重要的是,这些方法以特定的体系架构假设的形式引入强烈的关系归纳偏置relational inductive biases,这些偏置指导这些方法学习实体和关系。我们和很多其他人一起认为,这是类似人类智力的基本组成部分。在文章的剩余部分,我们通过关系归纳偏置的角度考察了各种深度学习方法,表明现有方法通常带有关系假设

relational assumptions,这些假设并不总是很明显或者显而易见。然后我们提出了一个基于实体和关系推理的通用框架,我们称之为Graph Network:GN。GN统一和扩展了图上运行的现有方法,并描述了使用Graph Network作为构建块building block来构建强大架构的关键设计原理。我们还发布了一个用于构建Graph Network的开源库。- 我们将复杂系统表示为实体

26.1 关系归纳偏置

26.1.1 Relational Reasoning

定义结构

structure为通过一组已知构建块building block组成的产品product。结构化表示Structured representations捕获了这种组成composition,如元素element的排列arrangement。结构化计算structured computations以一个整体的方式对所有这些元素及其组合进行操作。关系推理Relational Reasoning涉及利用实体entity和关系relation的组成规则composed rule,从而操作实体和关系的结构化表示。我们用以下数据来描述认知科学、理论计算机科学、人工智能的相关概念:实体

entity:具有属性的元素,如具有大小、质量的物理对象。关系

relation:实体之间的属性。如两个对象之间的关系可能包括:相同大小same size as、比.. 更重heavier than、距离distance from。- 关系也可以具有属性。比如

more than X times heavier than带有一个属性X,它决定了这个关系取值为true/false的阈值。 - 关系也可能对全局上下文敏感。比如对于石头和羽毛,关系

falls with greater accelaration than取决于环境是在空气中还是真空中。

这里我们关注实体之间的成对关系

pairwise relations。- 关系也可以具有属性。比如

规则

rule:将实体和关系映射到其它实体和关系的函数,就像一个非二元的逻辑谓词non-binary logical predicate。例如is entity X large?、is entity X heavier than entity y?这样的尺度比较scale comparison。这里我们仅考虑带有一个参数或两个参数、并返回一个属性的规则。

我们以图模型

graphical model来作为机器学习中关系推理的示例性说明。图模型可以通过在随机变量之间指定显式的条件独立性来建模复杂的联合分布。这样的模型非常成功,因为它捕获了稀疏结构

sparse structure,而稀疏结构是很多现实世界生成过程generative processes的基础,并且它们支持有效的学习和推理算法。例如,隐马尔可夫模型可以显式指定条件独立性:

- 当前状态仅依赖于前一个状态,与其它历史状态无关。

- 当前观测值仅依赖于当前状态,和其它历史状态、其它观测值无关。

这和很多现实世界因果过程

causal process的关系结构非常契合。明确表达变量之间的稀疏依赖关系提供了各种高效的推断

inference和推理reasoning算法。例如,消息传递算法在图模型内的各个位置之间采用通用的消息传播过程,从而导致一个可组合的composable、部分并行化的partially parallelizable推理过程reasoning procedure,这适用于不同大小和形状的图模型。

26.1.2 Inductive Biases

学习是通过观察世界并与世界互动来理解有用知识的过程,它涉及搜索解空间

space of solutions以期找到可以更好地解释数据、或获得更高回报的解决方案solution。但是在很多情况下,有多种解决方案同样出色。归纳偏置inductive bias允许学习算法独立于观测到的数据,从而将一种解决方案(或者解释)优先于另一种解决方案(或解释)。在贝叶斯模型中,归纳偏置通常以先验分布的选择

choice、参数化parameterization来表示。而在其它模型中,归纳偏置可能是为避免过拟合而添加的正则化项,也可能被编码到算法本身的体系结构中。归纳偏置通常以灵活性

flexibility为代价从而换取改善的样本复杂性sample complexity,并且可以从偏差-方差平衡bias-variance tradeoff的角度来理解。理想情况下,归纳偏置既可以在不显著降低性能的情况下改善对于解空间的搜索,又可以帮助找到理想泛化的解决方案。但是,不匹配mismatched的归纳偏置也会引入过强的约束从而导致欠拟合。归纳偏置可以表达关于数据生成过程

data-generating process或解空间的假设。例如,当使用一维函数拟合数据时,线性最小二乘法遵循近似函数为线性模型的约束,并且在additive Gaussian noise破坏的线性过程line process。类似地,

ill-posed problem可以得到唯一的解决方案和全局结果。这可以解释为关于学习过程的一种假设:当解决方案之间的分歧较少时,寻找好的解决方案更加容易。注意,这些假设不需要明确地解释模型或算法如何与世界交互。

26.1.3 Relational Inductive Biases

机器学习和

AI中很多具有关系推理能力的方法使用关系归纳偏置relational inductive bias。虽然不是精确的正式定义,但是我们通常使用该术语来指归纳偏置inductive bias,它对于学习过程中实体之间的关系和交互施加了约束。近年来新型的机器学习体系架构迅速增加,从业人员经常遵循通过组合基本构建块

elementary building block来形成更复杂、更深计算的层次hierarchies和计算图。例如:

- 全连接层

full connected layer被堆叠到多层感知机multilayer perceptrons: MLPs中。 - 卷积层

convolutional layers被堆叠到卷积神经网络convolutional neural networks: CNNs中。 - 图像处理网络的标准配置是由各种

CNN变体 +MLP的组合。

这种

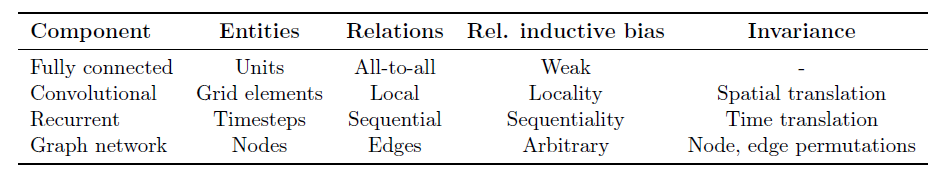

layer的组合提供了一种特殊类型的关系归纳偏置:层次处理hierarchical processing的关系归纳偏置。其中计算分阶段in stages进行,这会导致输入信号中的信息之间产生越来越长距离的交互long range interaction。正如我们在下面探讨的那样,构建块本身也带有各种关系归纳偏置(如下表所述)。尽管超出了本文的范围,但是在深度学习中也使用各种非关系归纳偏置

non-relational inductive biases,例如:激活值的非线性non-linearity、权重衰减、dropout、batch normalization/layer normalization、data augmentation、训练方式、优化算法都对学习的轨迹和结果施加了约束。

- 全连接层

要探索各种深度学习方法中表达的关系归纳偏置,我们必须确定几个关键因素:实体是什么、关系是什么、组成实体和关系的规则是什么、计算实体和关系的规则是什么。在深度学习中,实体和关系通常表示为分布式表示

distributed representation,规则通常表示为神经网络函数逼近器approximator。然后,实体、关系、规则的精确形式在不同体系架构之间有所不同。为了理解架构之间的这些差异,我们通过以下探索进一步理解每种架构如何支持关系推理:- 规则函数

rule function的自变量argument,例如:哪些实体和关系作为输入。 - 规则函数如何在计算图上重用或共享,例如:跨不同实体和关系、跨不同时间或

step。 - 架构如何定义

representation之间的交互interaction与隔离isolation。例如:通过在相关的实体上应用规则来得出结论,而不是对每个实体独立处理。

- 规则函数

26.1.4 标准 deep learning 构建块

Fully Connected Layers全连接层:也许最常见的构建块是全连接层。通常全连接层被实现为输入向量的非线性函数:

其中

因此实体是网络中的单元,关系是

all-to-all:- 所有输入单元都连接到所有输出单元,规则由权重矩阵和偏置向量指定。

- 规则的自变量是完整的输入信号,没有参数共享,也没有信息隔离。

因此,在全连接层中的隐式关系归纳偏置非常弱

week:所有输入单元之间可以交互从而决定任何输出单元的值,并且所有输出单元之间相互独立。Convolutional Layers卷积层:另一个常见的构建块是卷积层。卷积层通常被实现为输入向量或张量的卷积:

其中

这里的实体仍然是单个单元(或者网格元素,如像素),但是实体之间的关系更为稀疏。全连接层和卷积层之间的差异在于卷积层增加了一些重要的关系归纳偏置:局部性

locality和平移不变性translation invariance。- 局部性反映了关系规则

relational rule的自变量是那些在输入信号的坐标空间中紧密相邻的实体、并且和远处实体隔离。 - 平移不变性反映了在输入中跨区域重复使用相同的规则。

这些偏置对于处理天然的图像数据非常有效,因为图像数据局部邻域内存在较高的协方差,且随着距离增加,协方差会减小。并且统计量在整个图上大多是平稳的

stationary。- 局部性反映了关系规则

Recurrent Layers递归层:第三种常用的构建块是递归层,它是通过一系列step来实现的。这里我们将每个step的输入和hidden state视为实体,将马尔可夫过程视为关系:当前hidden state依赖于前一个hidden state和当前input。实体组合的规则将当前step的输入、前一个hidden state作为规则的自变量,然后更新当前hidden state。这个规则在每个

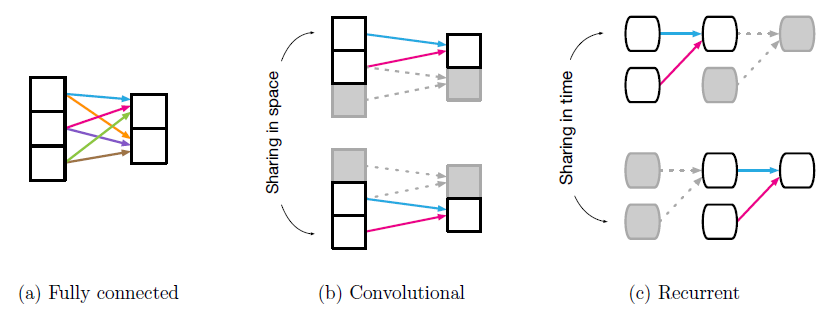

step被复用,这反映了时间不变性(类似于CNN在空间上的平移不变性)的关系归纳偏置。例如,某些物理事件序列的结果不应该取决于一天中的某个时刻。RNN也通过其马尔可夫结构对序列带来局部性locality的bias。下图给出了常见的深度学习构建块中的复用和共享,共享的权重由具有相同颜色的箭头表示。

(a):全连接层,其中所有权重都是独立的,并且没有共享。(b):卷积层,其中局部核函数在输入中多次重复使用。(c):循环层,其中相同的函数可以在不同的step中复用(水平方向代表了时间线)。

26.1.5 sets 和 graphs 上的计算

虽然标准的深度学习工具包所包含的方法具有各种形式的关系归纳偏置,但是没有默认的深度学习组件可以在任意关系结构上运行。我们需要模型具有显式的实体表示和关系表示,并需要学习算法,该算法用于找到计算实体和关系交互的规则、以及将规则置于数据中的方式。

重要的是,世界上的实体(如对象、

agent)没有自然顺序。相反,可以通过关系的性质来定义顺序。如:可以根据对象之间的大小、质量、年龄、毒性、价格之间的关系来对它们进行排序。顺序不变性invariance to ordering(除了处理关系时)是一种理想的属性,这种不变性应该由用于关系推理的深度学习组件来反映。集合

sets是描述包含一组无序实体的系统的自然表达形式。具体而言,集合的关系归纳偏置并不是来自于something的存在,而是来自于something的缺失。为了说明,考虑由

但是,如果要使用

MLP来预测该任务,即使已经知道了特定顺序输入MLP可能会认为每种顺序从根本上看是不同的,因此需要指数级的输入/输出训练样本来学习近似函数。处理类似组合爆炸的自然方法是允许预测依赖于输入的对称函数。这可能意味着首先计算

per-object参数共享的特征Deep Sets以及相关模型的本质。我们在后文进一步讨论。当然,在很多问题中排列不变性

permutation invariance并不是底层结构的唯一重要形式。例如,一个集合中的每个对象都可能受到集合中其它对象的pairwise interaction的影响。在我们的行星case中,考虑在时间间隔取而代之的是,我们可以将每个对象的状态计算为

我们在各处都使用相同的

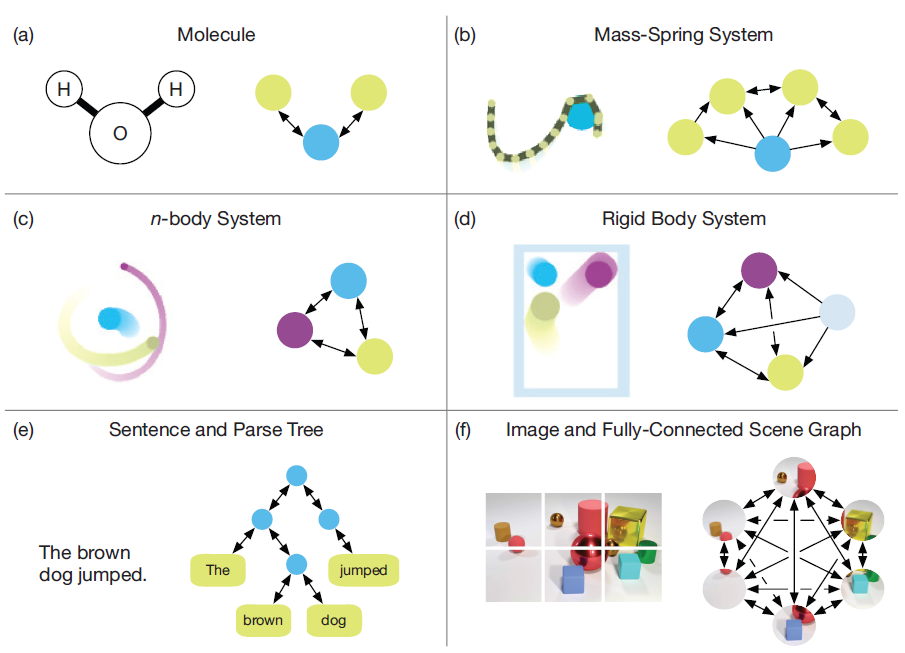

global permutation invariance。但是,它也支持不同的关系结构,因为上述太阳系的例子说明了两种关系结构

relation structure:一种完全没有关系,一种包含所有的pairwise关系。很多现实世界的系统(如下图所示)的关系结构在这两种极端case之间:某些实体pair对之间存在关系、另一些实体pair对之间缺乏关系。在我们的太阳系例子中,如果该系统改为由行星及其卫星组成,则可能会试图通过忽略不同行星的卫星之间的相互作用来近似。实际上,这意味着仅计算某些对象之间的交互,即:

其中

graph,因为第注意:节点

下图为现实世界的不同系统,以及对应的

graph的表达:(a):一个分子图,其中每个原子表示为一个节点,边对应于化学键。(b):一个质点弹簧系统,其中绳索由一个质点序列定义,这些质点在图中表示为节点。(c):一个n body系统,其中每个body为节点,节点之间全连接。(d):一个刚体系统,其中球和墙壁都为节点,底层的graph定义了球之间、球和墙壁之间的相互作用。(e):一个句子,其中单词对应于解析树上的叶结点,其它节点和边可以由解析器提供。或者也可以使用一个全连接的图。(f):一张图片,可以将其分解为图像块patch,每个块代表一个节点,并且节点之间全连接。

通常,图

graph是支持任意pairwise关系结构的表示形式,并且图上的计算提供了超越卷积层、递归层的强大的关系归纳偏置。

26.2 Graph Network

图神经网络已经在监督学习、半监督学习、无监督学习、强化学习领域被应用。

- 图神经网络被认为在具有丰富的关系结构的任务上很有效,例如视觉场景理解

visual scene understanding任务、few-shot learning任务等。 - 图神经网络也被用于物理系统

physical system和多智体系统multi-agent system,从而推理知识图谱、预测分子化学性质、预测道路交通流量、分类和分割图像/视频/3D网格/点云、分类图像中的区域、执行半监督文本分类及机器翻译。 - 图神经网络已经在

model-free和model-based连续控制中都被使用,用于model-free的强化学习,以及更经典的规划问题。 - 图神经网络还探索了很多涉及离散实体和结构推理的传统计算机科学问题,例如组合优化、布尔满足性

satisfiability、程序表示和验证、元胞自动机及图灵机建模,以及图模型上的inference。最近的工作还关注于图的生成模型、graph embedding的无监督学习。

- 图神经网络被认为在具有丰富的关系结构的任务上很有效,例如视觉场景理解

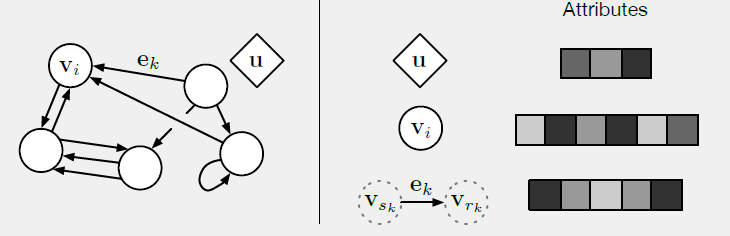

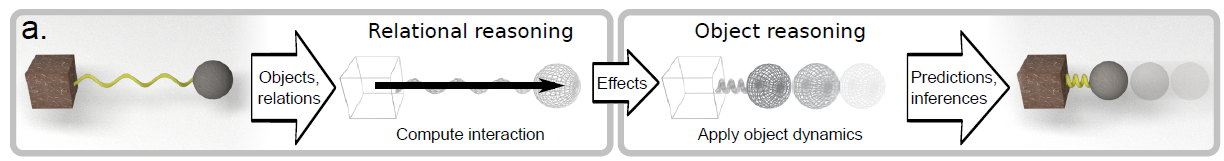

这里介绍我们的图网络框架

Graph Networks:GN,该框架定义了一族函数用于图结构表示graph-structured representations的关系推理relational reasoning。我们的GN框架概括并扩展了各种图神经网络、MPNN、以及NLNN方法,并支持从简单的构建块构建复杂的体系架构。注意,我们避免在

Graph Network中使用术语neural来反映GN可以使用除神经网络以外的函数来实现,尽管这里我们的重点是神经网络的实现。GN框架中的主要计算单元是GN块GN block。GN块是一个graph-to-graph的模块,它将图作为输入,对结构进行计算,然后将图作为输出返回。图的节点表示实体,图的边表示关系,图的全局属性表示system-level属性。GN框架的block组织强调可定制性customizability,以及综合了新的架构,这个新架构能够表达预期的关系归纳偏置。GN框架的主要设计原则是:灵活的表示形式flexible representations、可配置的块内结构configurable within-block structure、可组合的多块体系架构composable multi-block architectures。

我们引入一个例子来更具体的说明

GN。可以在任意重力场中预测一组橡胶球的运动,这些橡胶球不会彼此弹跳,而是每个橡胶球都有一个或多个弹簧,这些弹簧将它们和其它橡胶球相连。我们将在下文中参考这个例子,从而启发motivate图的表示以及图上进行的计算。

26.2.1 图的定义

这里我们使用图来表示带全局属性的、有向的、带属性的多图

multi-graph。- 带全局属性:每个图具有一个

graph-level属性 - 有向的:每条边

sender节点receiver节点 - 带属性的:每个节点

- 属性:节点、边、图的属性可以编码为向量、集合、甚至另一个图。

- 多图

multi-graph:节点之间可能存在多条边,包括自连接self-edge。

- 带全局属性:每个图具有一个

在我们的

GN框架内,图被定义为三元组receiver节点,sender节点。例如:

26.2.2 GN block

一个

GN块包含三个更新函数其中:

其物理意义为:

sender节点属性receiver节点属性receiver为当前节点的所有边的属性(更新后的边属性)聚合后的- 每个

permutation invariant,并且应该采用可变数量的自变量。一些典型的例子包括:逐元素求和、均值池化、最大值池化等。

GN块的计算步骤:通过执行

- 更新后,边的集合为

- 更新后,节点

receiver。

- 更新后,边的集合为

执行

通过执行

更新后,所有节点的属性集合为

通过执行

通过执行

通过执行

尽管这里我们给出了计算步骤的顺序,但是并不是严格地根据这个顺序来执行。例如,可以先更新全局属性、再更新节点属性、最后更新边属性。

GN block更新函数GraphNETWORK():输入:图

输出:更新后的图

计算步骤:

迭代更新边的属性:

迭代更新节点的属性:

- 令

receiver为当前节点 - 聚合

- 更新节点属性

- 令

令

令

根据全局属性、聚合后的节点属性、聚合后的边属性来更新全局属性

返回更新后的图

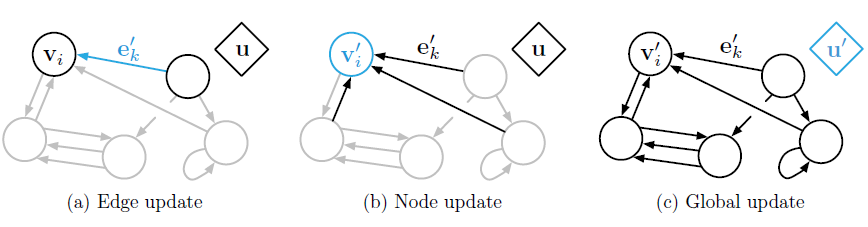

给定一个图

GN块的输入时,计算过程从边、节点、global-level。下图给出了这些计算中,每一个计算都涉及哪些图元素。蓝色表示待更新的元素,黑色表示更新中涉及的其它元素(注意,蓝色元素更新之前的值也用于它的本次更新)。

下图给出了具有更新函数、聚合函数的完整

GN块。它根据输入的节点属性、边属性、全局属性来预测输出的节点属性、边属性、全局属性。

26.2.3 关系归纳偏置

当用于

learning process的组成部分时,我们的GN框架会强制添加几个很强的关系归纳偏置:首先,图可以表达实体之间的任意关系。这意味着

GN的输入决定了representation是如何交互interact和隔离isolated的,而不是由固定fixed的体系架构来决定的。即实体的交互和隔离是由数据决定,而不是由模型决定。

例如:

- 如果两个实体对应的节点之间存在边,则认为这两个实体之间有关联,即有交互。

- 如果两个实体对应的节点之间不存在边,则认为这两个实体之间没有关联,即隔离的。

其次,图将实体及其关系表示为集合,这是排列不变的

permutation invariant。这意味着GN对于这些元素的顺序是不敏感的,这通常是我们所需要的。最后,

GN的per-edge函数、per-node函数分别在所有边、所有节点之间重用。这意味着GN自动支持某种形式的组合泛化:由于图由边、节点、以及全局属性组成,因此单个GN可以在不同大小(以边和节点数量刻画)、不同形状(不同的连通性)的图上进行操作。

26.3 GN 设计原则

根据前述列出的设计原则,

GN框架可用于实现各种各样的体系架构。通常,GN框架和特定的属性表示attribute representation和函数形式functional form无关。但是这里我们重点关注深度学习架构,该架构允许GN充当可学习的graph-to-graph的函数逼近器function approximator。这里再回顾一下

GN设计原则:灵活的表示flexible representations、可配置的块内结构con gurable within-block structure、可组合的多块体系架构composable multi-block architectures。这三个设计原则再我们的

GN框架中结合在一起,非常灵活,适用于从感知、语言、到符号推理的广泛领域。并且,如前所述,GN具有的强大的关系归纳偏置支持组合泛化,因此使得GN在实际和理论上都成为强大的工具。

26.3.1 Flexible Representations

灵活的表示有两层含义:

- 属性形式:

GN块的全局属性、节点属性、边属性可以为任意表示形式arbitrary representational formats。 - 图结构形式:输入数据可以包含关系结构,或者不包含关系结构,即输入数据的图结构形式可以任意。

- 属性形式:

属性形式:

GN块的全局属性、节点属性、边属性可以使用任意表示形式。在深度学习实现中,通常使用实值向量或张量。但是,也可以使用其它数据结构,如序列sequence、集合set、甚至是图graph。通常我们需要决定:对某个问题采用何种表示形式来描述属性。例如:

- 当输入数据是图像时,节点属性可以为图像

patches的张量。 - 当输入数据为文档时,节点属性可以为句子对应的单词序列。

- 当输入数据是图像时,节点属性可以为图像

对于更广泛的体系架构中的每个

GN块,每个边/节点的输出通常对应于一个张量/向量,而全局输出对应于单个张量/向量。这使得GN块的输出可以传递到其它深度学习构建块building block中,如MLP,CNN,RNN。GN块的输出也可以根据任务需求进行定制化。具体而言:edge-focused GN可以仅仅将边作为输出。例如,做出有关实体之间相互作用的决策。node-focused GN可以仅仅将节点作为输出。例如,用于推理物理系统。graph-focused GN可以仅仅将全局属性作为输出。例如,预测物理系统的势能、分子性质、关于某个视觉场景问题的答案。

节点属性、边属性、全局属性的输出也可以根据任务混合使用。

图结构形式:在定义如何将输入数据表示为图结构时,有两种情形:

首先,输入数据明确指定了关系结构。例如:知识图谱、社交网络、化学分子图、交通网络、以及具有已知交互作用的物理系统。

其次,需要从输入数据中推断或假设关系结构,即关系结构没有明确指定。例如视觉场景、文本文档等。

这里可以将数据表示为一组没有关系的实体,甚至仅表示为向量或张量(如:图像)。

如果未明确指定实体,则可以通过将诸如句子中的每个单词、或者

CNN输出feature map中的feature vector视为节点来指定实体。或者,也可以使用单独的学习机制从非结构化信号中推断实体,如通过解析树算法从文本中得到解析树。

如果关系不可用,则最简单的方法是在实体之间添加所有可能的有向边。如在图像的

patches之间两两添加有向边。但是,这对于拥有大量实体的图而言是不可行的,因为边的数量会随着节点数量的增加而平方规模的增加。因此,研发更复杂的方法来从非结构化数据中推断稀疏的图结构是未来的重要方向。

26.3.2 Configurable Within-block Structure

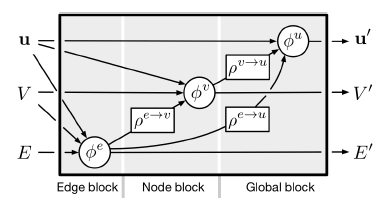

GN块中的结构和函数可以通过不同的方式进行配置,从而可以灵活地确定哪些信息可以用作函数的输入,以及如何更新边属性、节点属性、全局属性。具体而言,GN块中的每个argument signature决定了它需要哪些信息作为输入。通过选择不同的函数

GN框架可以表达其它各种架构,如下图所示。接下来讨论如何使用不同的方式配置GN的块内结构。下图中,每个

incoming箭头表示是否将(a):full GN(即完整的、原始的GN块)根据传入的节点属性、边属性、全局属性来输出节点属性、边属性、全局属性。(b):独立的循环块使用input和hidden state来进行更新,其中RNN。(c):MPNN根据传入的节点属性、边属性来输出节点属性、边属性、全局属性。注意,全局预测中不包含聚合的边,输入中不包含全局属性。(d):NLNN仅输出节点属性。(e):Relation Network仅使用预测的边属性来输出全局属性。(f):Deep Set没有采用边更新从而输出全局属性。

Full GN block:《Relational inductive bias for physical construction in humans and machines》和《Graph networks as learnable physics engines for inference and control》使用完整的GN块,如上图的(a)所示。- 他们使用神经网络来实现

- 他们的

更新方程为:

其中:

- 对于向量属性,通常采用

MLP作为feature map),通常采用CNN作为

- 他们使用神经网络来实现

RNN,这需要额外的hidden state作为输入和输出。上图(b)展示了一个非常简单的GN块,其中RNN作为block可用于对某些dynamic graph state进行递归平滑recurrent smoothing。当然,

RNN作为full GN block中使用。Message-passing neural network: MPNN概括了很多之前的体系架构,并且可以很自然地转换为GN的格式:- 消息函数

GN中的 GN的- 更新函数

GN中的 readout函数GN中的GN的GN中的GN的

上图

(c)展示了如何根据GN块来构建MPNN。- 消息函数

Non-local Neural Networks:NLNN统一了各种intra/self/vertex/graph attention方法,它也可以转换为GN的格式。attention指的是节点的更新方式:每个节点更新均基于其邻域节点属性(或者它的某些函数)的加权和,其中一个节点和它某个邻居之间的权重由属性之间的scale pairwise函数(然后整个邻域归一化)给出。已发表的

NLNN公式并未显式包含边,而是计算所有节点之间的pairwise注意力权重。但是,各种NLNN-compliant模型,例如节点注意力交互网络vertex attention interaction network、图注意力网络graph attention network都可以通过有效地将没有边的节点之间的权重设为零来显式处理边。在

NLNN中,pairwise-interaction函数,该函数返回:- 未归一化的

attention系数,记作 - 一个

non-pairwise的向量值,记作

在

receiver的所有边上归一化,然后在

NLNN论文中,set(而不是图graph)、并且这个图是根据集合中所有实体之间添加所有可能的边来构建的。Transformer体系架构中的single-headed self-attention,即SA, 实现为公式为:其中

《Attention is all you need》的multi-head self-attention机制增加了一个有趣的特性:Gated Graph Sequence Neural Networks。具体而言,

multi-head self-attention计算Vertex Attention Interaction Networks和SA很相似,但是它将欧几里得距离用于attention相似性度量,并在attention输入的embedding中共享参数,且在节点更新函数中使用节点的输入特征:Graph Attention Networks和multi-head self-attention相似,但是它使用神经网络作为attention相似性度量,并在attention输入的embedding中共享参数:《Self-attention with relative position representations》提出相对位置编码relative position encodings来扩展multi-head self-attention。relative是指对序列中节点之间的空间距离进行编码、或度量空间中其它信号进行编码。这可以在GN中表示为边的属性multi-head self-attention中的

下图展示了如何在

GN框架下通过NLNN。 通常NLNN假设图像(或句子中的单词)对应于全连接图中的节点,并假设注意力机制在聚合步骤中定义节点上的加权和。

- 未归一化的

完整的

GN block公式可以预测完整的图同样的思路可以适用于其它

GN变体,这些变体不使用完整的mappingreductionInteraction Networks和Neural Physics Engine使用full GN,但是没有使用全局属性来更新边属性。该工作还包括对上述公式的扩展:输出全局的、而不是

per-node的预测:这里没有使用全局属性来更新边属性,也没有用边属性来更新全局属性。

Relation Networks完全绕开了节点更新,并直接从池化的边信息中预测全局属性输出:Deep Sets完全绕开了边更新,并直接根据池化的节点信息中预测全局属性输出:PointNet使用类似的更新规则,但是对于Gated Graph Sequence Neural Networks: GGS-NN使用稍微泛化的公式,其中每条边关联一个类别这里

GRU,上述更新递归进行,然后接一个全局解码器,该解码器计算所有节点的最终

embedding的加权和。CommNet的更新公式为:structure2vec也可以适配我们的算法,只需要进行少量的修改:其中

边的属性现在在

receiver和sender之间具有message的含义。注意,对于边和节点更新,现在只有一组参数需要学习。

注意:对于

CommNet、structure2vec、Graph Sequence Neural Networks使用一种非对称的pairwise interaction,而是忽略receiver node而仅考虑sender节点,并且某种程度上是在边属性上进行。这种做法可以通过具有以下签名signature的.

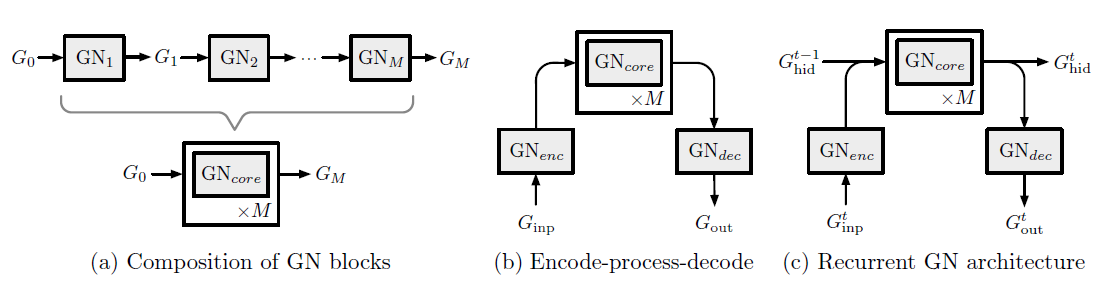

26.3.3 Composable Multi-block Architectures

GN的主要设计原理是通过组合GN block来构建复杂的体系架构。我们将GN block定义为包含边属性、节点属性、全局属性的图作为输入,并返回新的边属性、节点属性、全局属性的图作为输出。如果某些元素不需要更新,则只需要直接对应的输入传递到输出即可。这种

graph-to-graph的input/output接口可以确保GN block的输出可以传递给另一个GN block作为输入。这两个GN block内部可以使用完全不同的配置,这类似于深度学习toolkit的tensor-to-tensor接口。这种接口最基本的形式是:给定两个

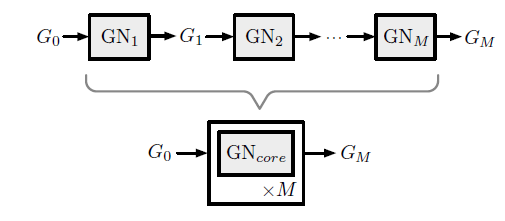

GN blockGN1和GN2,可以通过将GN1的输出作为GN2的输入,从而将它们组合在一起:可以组合任意数量的

GN block,如下图所示。图中M个重复的内部处理子步骤repeated internal processing sub-steps,可能包含共享或者不共享的GN block。- 这些

block可以不共享(采用不同的函数或参数,类似于CNN的不同的layer),即 - 这些

block也可以共享(采用相同的函数或参数,类似于展开的RNN),即

- 这些

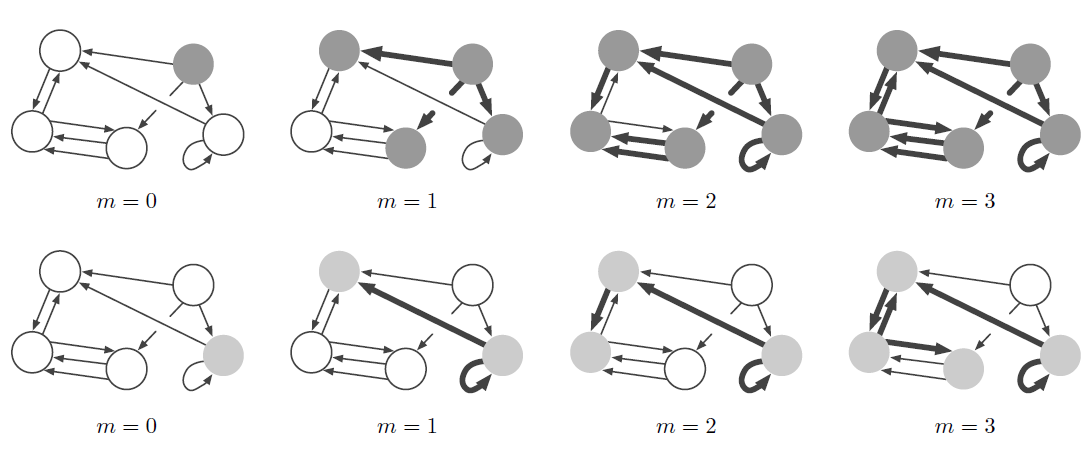

配置共享(采用相同的函数或参数)类似于消息传递,其中反复应用相同的局部更新过程从而在整个结构中传播消息,如下图所示。如果不考虑全局属性

step之后,可访问的信息由最多m-hop的节点和边的集合确定。这可以解释为将复杂的计算分解为较小的基础步

elementary step。这些step也可以用于捕获时间上的顺序。在我们的橡胶球示例中,如果每个

step预测持续时间为step的总的模拟时间为下图中,每一行突出显式了从特定节点开始、然后扩展到整个图的信息。

- 第一行中,初始节点在右上方;第二行中,初始节点在右下方。

- 阴影节点表示距初始节点经过

step能够传播的范围。 - 粗边表示消息传播的边。

注意:在完整的消息传递过程中,这种消息传播同时发生在图中所有节点和所有边上,而不仅仅是这里的两个初始节点。

可以通过

GN block构建两种常见的体系架构:一种体系架构我们称之为

encode-process-decode配置,如下图(b)所示。其中:- 一个输入图

- 一个共享的

core block - 通过解码器

例如在我们的橡胶球例子种,编码器可能会计算球之间的初始力和相互作用势能,

core可能会应用基本动力学更新,解码器可能从更新后的图状态读取最终位置。- 一个输入图

类似

encode-process-decode设计,另一种体系架构我们称之为recurrent GN-based配置,如下图(c)所示。其中在step每个

step维护一个hidden graph一个输入图

其中

(c)的箭头合并),然后传递给一个共享的

core blockunrolled(一共展开GRU或者LSTM。(c)的箭头拆分),其中一路输出由通过解码器

这种设计以两种方式重用

GN block:step- 在每个

step内,sub-step内共享。

这种类型的体系架构常用于预测

graph序列,例如预测一段时间内动力系统的轨迹。

其它一些技术对于设计

GN体系架构可能也有用。例如:Graph Skip Connection可以将GN block的输入Recurrent GN架构中合并输入图和hidden图的信息可以使用LSTM或GRU风格的gating scheme,而不是简单地拼接。或者在其它

GN block之前和/或之间组合不同的递归GN块,从而提高多个传播step中representation的稳定性。

26.3.4 实现

类似于可天然并行的

CNN(在GPU上),GN具有天然并行结构:- 由于

- 通过将多个图视为较大图的非连通分量

disjoint component,可以自然地将几张图打包一起。因此可以将几个独立图上进行的计算打包在一起。

- 由于

重用

GN的样本效率。类似于卷积核,GN中用于优化我们已经发布了用于构建

GN的开源软件库,在github.com/deepmind/graph_nets。我们也给出了一些demo包括:在最短路径搜索任务、排序任务、物理系统预测等任务上,如何创建、操作、训练GN来推理图结构数据。每个demo使用相同的GN体系架构,这凸显了该方法的灵活性。

26.4 讨论

GN的结构天然支持组合泛化,因为它们并不严格地在系统级别执行计算,而且还跨实体、跨关系执行共享计算。这样可以推理未曾见过的系统,因为它们都是由熟悉的组件构成的,从而体现了infinite use of finite means的方式。GN和MPNN的消息传递学习方式的局限性之一是无法解决某些类型的问题,如区分某些非同构图non-isomorphic graph。更一般而言,尽管图是表示结构信息的有效方式,但是它们也有局限性。诸如递归、控制流、条件迭代之类的概念并不容易用图来表示。就这些概念而言,

program和更多的computer-like处理过程可以提供更好的表示性。关于使用

Graph Network还存在很多悬而未决的问题:一个紧迫的问题是:运行

GN的图如何构建?深度学习的标志之一是它能够对原始的感官数据

sensory data(如图像、文本)执行复杂的计算,但是尚不清楚如何将感官数据转换为更结构化的表示形式(如graph)。一种方法(我们已经讨论过)假设空间或语言实体之间是全连接的图结构,例如在

self-attention的文献采用这种方法。但是,这样的representation可能不完全对应于真实的实体,如卷积feature map并不直接对应于真实场景中的对象。此外,很多底层图结构比全连接的图稀疏的多,如何引入这种稀疏性也是一个悬而未决的问题。

有一些研究正在探索这些问题,但是目前为止并没有一种方法能够可靠地从感官数据中提取离散实体。开发这种方法是一个令人兴奋的挑战,一旦解决就可以推开更强大、更灵活的推理算法的大门。

一个相关的问题是如何在计算过程中自适应地修改图结构。例如,如果一个对象分解为多个片段,则代表该对象的节点也应该拆分为多个节点。同样,仅保留交互对象之间的边可能很有用,因此需要根据上下文添加、删除边的能力。

人类的认知提出了一个强有力的假设,即世界是由对象和关系组成的。并且,由于

GN做出了类似的假设,因此它的行为往往更具有解释性。GN所处理的实体和关系通常对应于人类理解的实物(如物理对象),因此支持更可解释的分析和可视化。未来一个有趣的方向是进一步探索网络行为的可解释性。

尽管我们的重点是图,但是本文的重点不是图本身,而更多是将强大的深度学习方法和结构化表示相结合的方法。

二十七、GIN[2019]

对图结构数据的学习需要有效地对图结构进行表示。最近,对图表示学习

graph representation learning的图神经网络Graph Neural Network: GNN引起了人们的广泛兴趣。GNN遵循递归邻域聚合方案,其中每个节点聚合其邻居的representation向量从而计算节点的新的representation。已经有很多

GNN的变体,它们采用不同的邻域聚合方法、graph-level池化方法。从实验上看,这些GNN变体在很多任务(如节点分类、链接预测、图分类)中都达到了state-of-the-art性能。但是,新的GNN的设计主要基于经验直觉empirical intuition、启发式heuristics、以及实验性experimental的反复试验。人们对

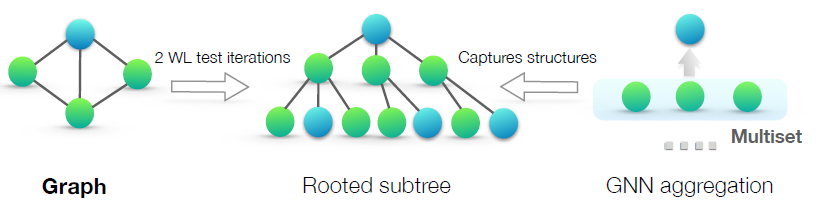

GNN的性质和局限性的理论了解很少,对GNN的表达容量representational capacity的理论分析也很有限。论文《How powerful are graph neural networks?》提出了一个用于分析GNN表达能力representational power的理论框架。作者正式刻画了不同GNN变体在学习表达represent和区分distinguish不同图结构上的表达能力expressive。论文的灵感主要来自于

GNN和Weisfeiler-Lehman:WL图同构检验graph isomorphism test之间的紧密联系。WL-test是一种强大的、用于区分同构图的检验。类似于GNN,WL-test通过聚合其网络邻域的特征向量来迭代更新给定节点的特征向量。WL-test如此强大的原因在于它的单射聚合更新injective aggregation update,这可以将不同的节点邻域映射到不同的特征向量。单射函数:假设

论文的主要洞察是:如果

GNN的聚合方案具有很高的表达能力expressive并且建模单射函数injective function,那么GNN可以具有与WL-test一样强大的判别力discriminative power。为了从数学上形式化该洞察,论文的框架首先将给定节点的邻居的特征向量集合表示为

multiset,即可能包含重复元素的集合。可以将GNN中的邻域聚合视为multiset上的聚合函数aggregation function over the multiset。因此,为了具有强大的表征能力 ,GNN必须能够将不同的multiset聚合为不同的representation。论文严格研究了multiset函数的几种变体,并从理论上刻画了它们的判别能力,即不同的聚合函数如何区分不同的multiset。multiset函数的判别力越强,则底层GNN的表征能力就越强。然后论文设计出一种简单的架构Graph Isomorphism Network:GIN,该架构被证明是GNN中最具表达能力的,并且和WL-test一样强大。论文在图分类数据集上进行实验来验证该理论,其中

GNN的表达能力对于捕获图结构至关重要。具体而言,作者比较了使用各种聚合函数的GNN的性能。实验结果证明了最强大的GNN(即作者提出的GIN)在实验中也具有很高的表征能力,因为它几乎完美拟合训练数据。而能力更弱的GNN变体通常对于训练数据严重欠拟合underfit。此外,GIN在测试集上的准确率也超过了其它GNN变体,并在图分类benchmark上达到了state-of-the-art性能。论文的主要贡献:

- 证明

GNN在区分图结构方面最多和WL-test一样强大。 - 给出邻域聚合函数和图

readout函数在什么条件下所得的GNN和WL-test一样强大。 - 识别那些无法被主流的

GNN变体(如GCN,GraphSAGE)判别的图结构,然后刻画这些GNN-based模型能够捕获的图结构。 - 设计了一个简单的神经网络架构,即

Graph Isomorphism Network: GIN,并证明了其判别能力/表征能力等于WL-test。

- 证明

相关工作:尽管

GNN在经验上取得成功,但是在数学上研究GNN特性的工作很少。《Computational capabilities of graph neural networks》表明:早期的GNN模型在概率上逼近测度函数。《Deriving neural architectures fromsequence and graph kernels》表明:该论文提出的架构位于graph kernel的PKHS中,但没有明确研究该架构可以区分哪些图。

这些工作中的每一个都专注于特定的体系结构,并且不容易推广到多种体系结构。相反,我们的研究为分析和刻画一系列

GNN模型的表征能力提供了一个通用框架。另外,近期提出了一些基于

GNN的体系结构大多数没有理论推导。与此相比,我们的GIN是有理论推导的,而且简单、强大。

27.1 GNN 模型

我们首先总结一些常见的

GNN模型。令图

- 每个节点

通常我们关心图上的两类任务:

- 节点分类任务:每个节点

representation向量 - 图分类任务:给定一组图

representation向量

GNN利用图结构和节点特征representation向量representation向量现代

GNN使用邻域聚合策略,在该策略中我们通过聚合邻域的representation来迭代更新节点的representation。在经过representation将捕获其k-hop邻域内的结构信息。以数学公式来讲,

GNN的第其中:

representation。另外

在

GraphSAGE的最大池化变体中,聚合函数为:其中:

relu非线性激活函数。

而

GraphSAGE中的拼接函数为简单的向量拼接:其中

[,]表示向量拼接,在

Graph Convolutional Networks: GCN中,聚合函数采用逐元素的均值池化。此时聚合函数、拼接函数整合在一起:其中

MEAN(.)为逐元素的均值池化,

对于节点分类任务,节点

representationrepresentation。对于图分类任务,

READOUT函数聚合所有节点最后一层的representation从而得到整个图的representationREADOUT函数可以是简单的排列不变函数permutation invariant function,例如求和函数;也可以是更复杂的graph-level池化函数。

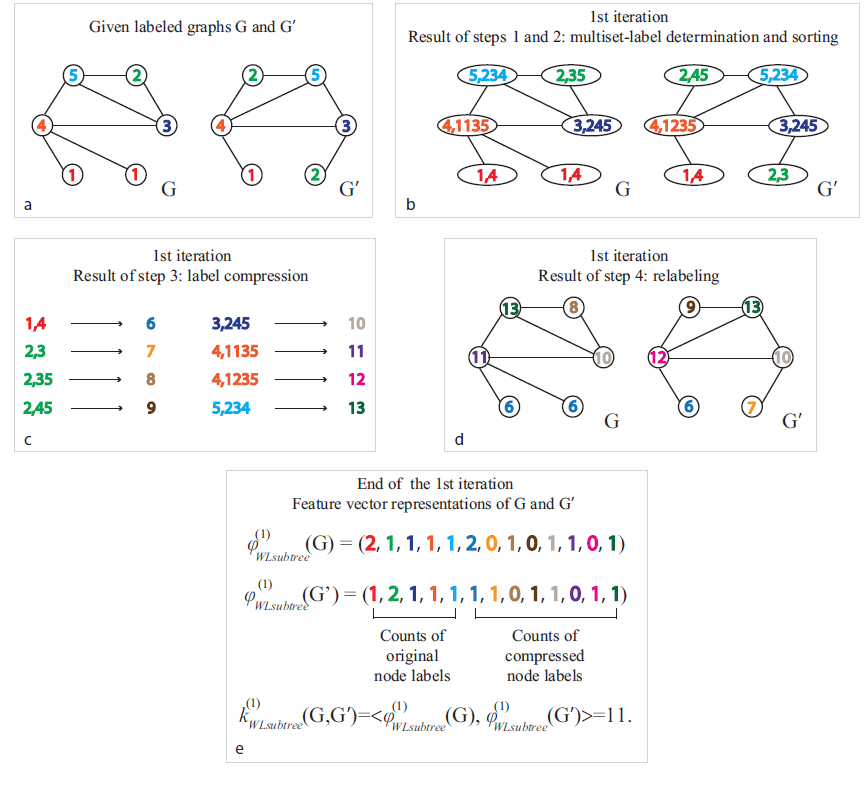

27.2 WL-test

图同构问题

graph isomorphism problem是判断两个图在拓扑结构上是否相同。这是一个具有挑战性的问题,尚不知道多项式时间polynomial-time的算法。除了某些极端情况之外,图同构的

Weisfeiler-Lehman(WL) test是一种有效且计算效率高的算法,可用于各种类型的图。它的一维形式是naïve vertex refinement,它类似于GNN中的邻域聚合。在

WL-test过程中,每个节点都分配一个label。注意:这里的label和分类任务中的label不同,这里的label更多的表示“属性”, 而不是“监督信息”。WL-test对节点邻域进行反复迭代,最终根据两个图之间的节点label是否完全相同,从而判断两个图是否同构的。WL-test迭代过程如下:- 聚合节点及其邻域的

label。 - 将聚合后的

label经过哈希函数得到不同的、新的label,即relabel。

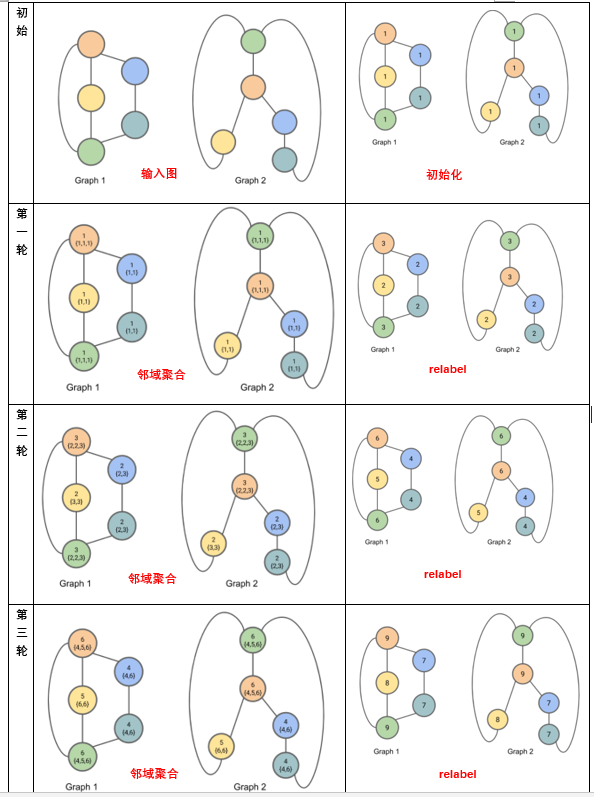

如下图所示:

首先将图中每个节点初始化为

label = 1。然后经过三轮迭代,最终:

- 图

1具有1个label = 8、2个label = 7、2个label = 9。 - 图

2具有1个label = 8、2个label = 7、2个label = 9。

因此我们不排除图

1和图2同构的可能性。- 图

下图的哈希函数为:

{1,1} --> 2{1,1,1} --> 3{2,3} --> 4{3,3} --> 5{2,2,3} --> 6{4,6} --> 7{6,6} --> 8{4,5,6} --> 9注意:这里的

label集合需要根据label大小排序,并且每次哈希之后都需要分配一个新的label。

- 聚合节点及其邻域的

《Weisfeiler-lehman graph kernels》根据WL-test提出了WL subtree kernel来衡量两个图的相似性。核函数利用WL tet的不同迭代中使用的节点label数作为图的特征向量。直观地讲,

WL test第label代表了以该节点为根的、高度为WL subtree kernel考虑的图特征本质上是不同根子树的计数。如下图所示为一棵高度

WL subtree。 这里label = 8的节点代表一棵高度为1的subtree模式,其中subtree根节点的label为2、包含label=3和label=5的邻居节点。

27.3 模型

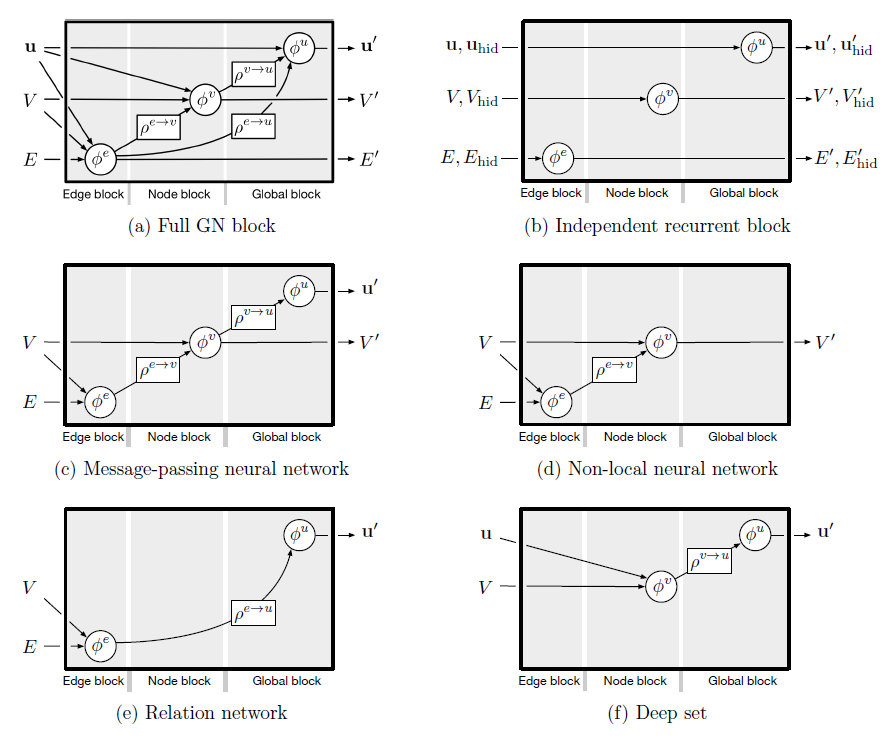

我们首先概述我们的框架,下图说明了我们的思想:

GNN递归更新每个节点的representation向量,从而捕获网络结构和邻域节点的representation,即它的rooted subtree结构。在整篇论文中,我们假设:

- 节点输入特征来自于可数的范围

countable universe。 - 模型的任何

layer的representation也是来自可数的范围。

通常浮点数是不可数的,而整数是可数的。我们可以将浮点数离散化为整数,从而使得数值可数。

为便于说明,我们为每个

representation vector(输入特征向量是第0层的representation vector)分配唯一的label,label范围在label然后节点的邻域节点

representation vector就构成一个multiset:由于不同的节点可以具有相同的representation向量,因此同一个label可以在multiset中出现多次。下图中:

- 左图:一个图结构的数据。

- 中图:

rooted subtree结构,用于在WL test中区分不同的图。 - 右图:如果

GNN聚合函数捕获节点邻域的full multiset,则GNN能够以递归的方式捕获rooted subtree结构,从而和WL test一样强大。

- 节点输入特征来自于可数的范围

multiset定义:multiset是set概念的推广,它允许包含相同的多个元素。正式地讲,,multiset是一个2-tupleset,它包含唯一distinct的元素。multiplicity。

为研究

GNN的表征能力,我们分析GNN何时将两个节点映射到embedding空间中的相同位置。直观地看,能力强大的

GNN仅在两个节点具有相同subtree结构、且subtree上相应节点具有相同特征的情况下才将两个节点映射到相同的位置。由于

subtree结构是通过节点邻域递归定义的,因此我们可以将分析简化为:GNN是否将两个邻域(即两个multiset)映射到相同的embedding或representation。能力强大的

GNN绝对不会将两个不同的邻域(即representation向量的multiset)映射到相同的representation。这意味着聚合函数必须是单射函数。因此我们将GNN的聚合函数抽象为神经网络可以表示的、multiset上的函数,并分析它们能否表示multiset上的单射函数。接下来我们使用这种思路来设计能力最强的

GIN。最后我们研究了主流的GNN变体,发现它们的聚合函数本质上不是单射的因此能力较弱,但是它们能够捕获图的其它有趣的特性。

27.3.1 定理

我们首先刻画

GNN-based通用模型的最大表征能力。理想情况下,能力最强大的

GNN可以通过将不同的图结构映射到embedding空间中不同的representation来区分它们。这种将任意两个不同的图映射到不同embedding的能力意味着解决具有挑战性的图同构问题。即,我们希望将同构图映射到相同的representation,将非同构图映射到不同的representation。在我们的分析中,我们通过一个稍弱的准则来刻画

GNN的表征能力:一种强大powerful的、启发式heuristic的、称作Weisfeiler-Lehman(WL)的图同构测试graph isomorphism test。WL-test通常工作良好,但是也有一些例外,如正规图regular graph。正规图是图中每个节点的degree都相同。如:立方体包含四个节点,每个节点的degree为3,记作4k3。

引理

2:令non-isomorphic graph。如果一个图神经网络embedding,则WL-test也会判定证明:这里采用反证法。

假设经过

WL-test无法区分WL-test中从迭代0到迭代label collection都相同。具体而言,

label multisetlabel集合WL-test第label。否则WL-test在第label collection从而区分出现在我们证明:如果

当

WL-test和GNN都使用节点的特征向量来初始化。如前所述,对于任意label假设对于第

考虑第

根据第

由于两个图

AGGREGATE函数和COMBINE函数。因此相同的输入(如邻域特征)产生相同的输出。因此有:因此第

因此如果

WL-test节点label满足representation集合graph-level readout函数对于节点representation集合是排列不变的permutation invariant,因此有根据引理

2,任何基于聚合的GNN在区分不同图结构方面最多和WL-test一样强大。一个自然的问题是:是否存在和

WL-test一样强大的GNN?在定理3中,我们将证明:如果邻域聚合函数和graph-level readout函数是单射的,则得到的GNN和WL-test一样强大。定理

3:令GNN。在具有足够数量GNN层的条件下,如果满足以下条件,则WL-test判定为非同构的两个图embedding:representation:其中

multiset上。graph-level readout函数是单射函数。其中readout函数作用在节点embedding multiset

证明:令

WL-test在我们假设

representation为:其中

假设

WL-test应用一个预定义的单射函数label:其中

接下来我们通过数学归纳法证明:对于任意迭代轮次

当

WL-test和GNN都使用节点的特征向量来初始化。如前所述,对于任意label假设对于

现在考虑第

由于单射函数的复合函数也是单射函数,因此存在某个单射函数

则有:

因此复合函数

因此对于任意迭代轮次

经过

WL-test判定label multisetinjectivity,embedding集合对于可数集,单射性

injectiveness很好地描述了一个函数是否保持输入的唯一性distinctness。节点输入特征是连续的不可数集则需要进一步考虑。此外,刻画学到的

representation在embedding空间中的邻近程度(如果两个embedding不相等的话)也很有意义。我们将这些问题留待以后的工作,本文重点放在输入节点特征来自可数集的情况,并仅考虑输出representation相等/不等的情况。引理

4:假设输入特征空间GNN第size有界的multisetrepresentation证明:证明之前我们先给出一个众所周知的结论,然后将其简化:对于任意

现在回到我们的的引理证明。如果我们可以证明在可数集上的、

size有限的multiset上定义的任何函数range也是可数的,则对于任意现在我们的目标是证明

首先,因为

layer定义良好well-defined的函数,因此很明显multiset由于两个可数集的并集也是可数的,因此

dummy元素且不在正如

multiset的集合映射到由于

我们对于

由于

multisetsize有界,则存在其中最后

dummy element

显然

size有界的multiset这里还值得讨论

GNN在图结构判别能力上的一个重要优点,即:捕获图结构的相似性。WL-test中的节点特征向量本质上是one-hot编码,因此无法捕获subtree之间的相似性。相反,满足定理

3条件的GNN将subtree嵌入到低维空间来推广WL-test。这使得GNN不仅可以区分不同的结构,还可以学习将相似的图结构映射到相似的embedding从而捕获不同图结构之间的依赖关系。捕获

node label的结构相似性有助于泛化generalization,尤其是当subtree的共现co-occurrence很稀疏时、或者存在边噪音和/或节点特征噪音时。

27.3.2 GIN

在研究出能力最强的

GNN的条件之后,我们接下来将设计一种简单的架构,即图同构网络Graph Isomorphism Network:GIN。可以证明GIN满足定理3中的条件。GIN将WL-test推广从而实现了GNN的最大判别力。为建模用于邻居聚合的

multiset单射函数,我们研究了一种deep multiset理论,即:使用神经网络对multiset函数进行参数化。我们的下一个引理指出:

sum聚合实际上可以表示为multiset上的通用单射函数。引理

5:假设输入特征空间size的multisetunique。进一步地,任何multiset函数证明:我们首先证明存在一个映射

size的multiset由于

multisetcardinality是有界的,则存在自然数one-hot向量或N-digit数字的压缩表示。因此multiset的单射函数。permutation invariant,因此它是定义良好的well-defined的multiset函数。对于任意multiset函数引理

5将《Deep sets》中的结论从set扩展到multiset。deep multiset和deep set之间的重要区别是:某些流行的set单射函数 (如均值聚合)不再是multiset单射函数。通过将引理

5中的通用multiset函数建模机制作为构建块building block,我们可以设想一个聚合方案,该方案可以表示单个节点及其邻域的multiset上的通用函数,因此满足定理3中的第一个条件。我们的下一个推论是在所有这些聚合方案中选择一个简单而具体的形式。

推论

6:假设pair对unique,其中size的multisetpair上的函数证明:接着推论

5的证明过程,我们考虑5。令

我们用反证法证明。

对于任意

此时

根据推论

5该等式不成立,因为我们重写

因为

对于定义在

注意:这样的

well-defined,因为由于通用逼近定理

universal approximation theorem,我们可以使用多层感知机multi-layer perceptrons:MLPs来建模和学习推论6中的函数实际上我们使用一个

MLP来建模MLPs可以表示组合函数。在第一轮迭代中,如果输入特征是

one-hot编码,则在求和之前不需要MLP,因为它们的求和本身就是单射的。即:

我们将

GIN的节点representation更新方程为:

通常而言,可能存在很多其它强大的

GNN。GIN是这些能力强大的GNN中的一个简单的例子。GIN学到的节点embedding可以直接用于诸如节点分类、链接预测之类的任务。对于图分类任务,我们提出以下readout函数,该函数可以在给定每个节点embedding的情况下生成整个图的embedding。关于

graph-level readout函数的一个重要方面是:对应于subtree结构的node embedding随着迭代次数的增加而越来越精细化refine和全局化global。足够数量的迭代是获得良好判别力的关键,但是早期迭代的representation可能会泛化能力更好。为了考虑所有结构信息,我们使用来自模型所有深度的信息。我们通过类似于

Jumping Knowledge Networks的架构来实现这一点。在该架构体系中,我们将GIN所有层的representation拼接在一起:通过定理

3和推论6,如果GIN使用求和函数(求和针对相同迭代轮次中所有节点的representation进行)替代了上式中的READOUT(因为求和本身就是单射函数,因此在求和之前不必添加额外的MLP),它就可证明地provably推广了WL-test和WL subtree kernel。

27.4 Less Powerfull GNN

现在我们研究不满足定理

3中条件的GNN,包括GCN、GraphSAGE。另外,我们对GIN的聚合器的两个方面进行消融研究:- 单层感知机代替多层感知机

MLP。 - 均值池化或最大池化代替求和。

我们将看到:这些

GNN变体无法区分很简单的图,并且比WL-test能力更差。尽管如此,具有均值聚合的模型(如GCN)在节点分类任务中仍然表现良好。为了更好地理解这一点,我们精确地刻画了哪些GNN变体可以捕获或无法捕获图结构,并讨论了图学习的意义。- 单层感知机代替多层感知机

27.4.1 单层感知机

引理

5中的函数multiset映射到唯一的embedding。MLP可以通过通用逼近定理对GNN改为使用单层感知机relu)。这种单层映射是广义线性模型Generalized Linear Models的示例。因此,我们有兴趣了解单层感知机是否足以进行图学习。引理

7表明:确实存在使用单层感知机的图模型永远无法区分的网络邻域(multiset)。引理

7:存在有限size的multiset证明:考虑示例

multiset,但是它们的sum结果相同。我们将使用ReLU的同质性homogeneity。令

- 如果

- 如果

- 如果

因此得到:

- 如果

引理

7的证明的主要思想是:单层感知机的行为和线性映射非常相似。因此GNN层退化为简单地对邻域特征进行求和。我们的证明基于以下事实:线性映射中缺少偏置项。使用偏置项和足够大的输出维度,单层感知机可能区分不同的multiset。尽管如此,和使用

MLP的模型不同,单层感知机(即使带有偏置项)也不是multiset函数的通用逼近器。因此,即使具有单层感知机的GNN可以在不同程度上将不同的图嵌入到不同的位置,此类embedding也可能无法充分捕获结构相似性,并且可能难以拟合简单的分类器(如线性分类器)。在实验中,我们观察到带单层感知机的

GNN应用于图分类时,有时对于训练数据严重欠拟合underfit。并且在测试集准确率方面要比带MLP的GNN更差。

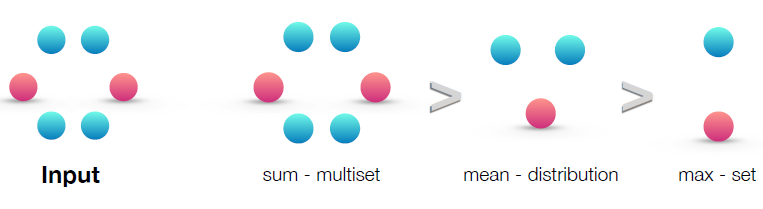

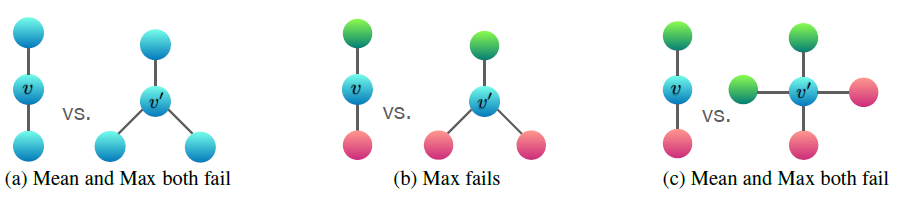

27.4.2 均值池化和最大池化

如果我们把

GCN、GraphSAGE中的那样,结果会如何?均值池化和最大池化仍然是

multiset上定义良好的函数,因为它们是排列不变的permutation invariant。但是,它们不是单射函数。下图按照表征能力对这三种聚合器(

sum/mean/max聚合器)进行排名rank。左图给出了输入的multiset,即待聚合的网络邻域。后面的三幅图说明了给定的聚合器能够捕获multiset的哪个方面:sum捕获了完整的multiset。mean捕获了给定类型的元素的比例/分布。max忽略了多重性multiplicity,将multiset简化为简单的set。

下图说明了

mean池化和max池化无法区分的一对图结构。这里节点颜色表示不同的节点特征,我们假设GNN首先将邻域聚合在一起,然后再将它们与标记为combine在一起。在两个图之间,节点

embedding,即使它们的图结构是不同的。如前所述:sum捕获了完整的multiset;mean捕获了给定类型的元素的比例/分布;max忽略了多重性multiplicity,将multiset简化为简单的set。图

(a)给出均值池化和最大池化都无法区分的图。这表明:均值池化和最大池化无法区分所有节点特征都相同的图。图

(b)给出最大池化无法区分的图。令r表示红色、g表示绿色) 为max池化:collapse到相同的representation(即使对应的图结构不同)。因此最大池化也无法区分它们。相反,均值池化是有效的,因为

图

(c)给出均值池化和最大池化都无法区分的图。这表明:均值池化和最大池化无法区分节点特征分布相同的图。因为:

a. 均值池化

为了刻画均值聚合器能够区分的

multiset类型,考虑两个multiset:distinct元素,但是embedding,因为均值聚合器只是对各元素特征取均值。因此,均值聚合器捕获的是

multiset中元素的分布(比例),而不是捕获确切的multiset本身。推论

8:假设1的整数。证明:假设

multiset1的正整数。即set,并且multiplicity为因此有:

现在我们证明存在一个函数

distributionally equivalent的unique的。由于multisetcardinality是有界的,因此存在一个数如果某个任务中,图的统计信息和分布信息比确切结构更重要,则对于该任务使用均值聚合器可能会表现良好。

此外,当节点特征多种多样

diverse,且很少重复时,均值聚合器的能力几乎和sum聚合器一样强大。这可以解释为什么尽管存在限制(只能捕获multiset中元素的分布、而不是捕获确切的multiset本身),但是具有均值聚合器的GNN对于节点特征丰富的节点分类任务(如文章主题分类和社区检测)有效,因为邻域特征分布足以为任务提供强有力的信号。

b. 最大池化

最大池化将多个具有相同特征的节点视为仅一个节点(即,将

multiset视为一个简单的set)。最大池化无法捕获确切的结构或分布。但是,它可能适合于需要识别代表性元素或者骨架

skeleton,而不适合需要区分确切结构或分布的任务。实验表明:最大池化聚合器学会了识别

3D点云的骨架,并对噪声和离群点具有鲁棒性。为了完整起见,下一个推论表明最大池化聚合器捕获了multiset底层的set。推论

9:假设set有证明:假设

multisetset现在我们证明存在一个映射

set的unique的。由于其中

multiset映射到它的one-hot embedding。

27.4.3 其它聚合器

- 我们还没有覆盖到其它非标准的邻域聚合方案,如通过

attention加权平均的聚合器、LSTM池化聚合器。我们强调,我们的理论框架足以通用从而刻画任何基于聚合的GNN的表征能力。未来我们会研究应用我们的框架来分析和理解其它聚合方案。

27.5 实验

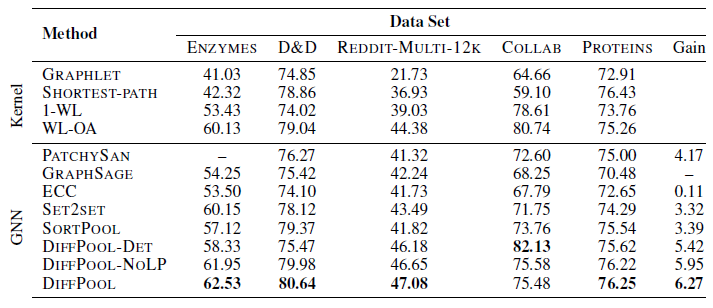

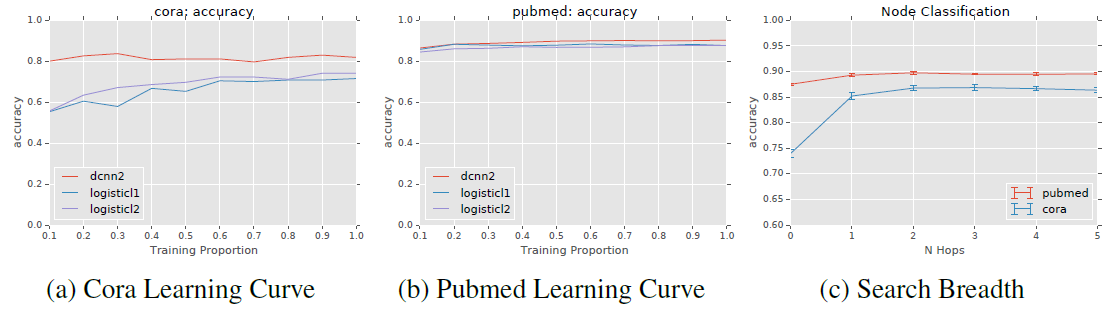

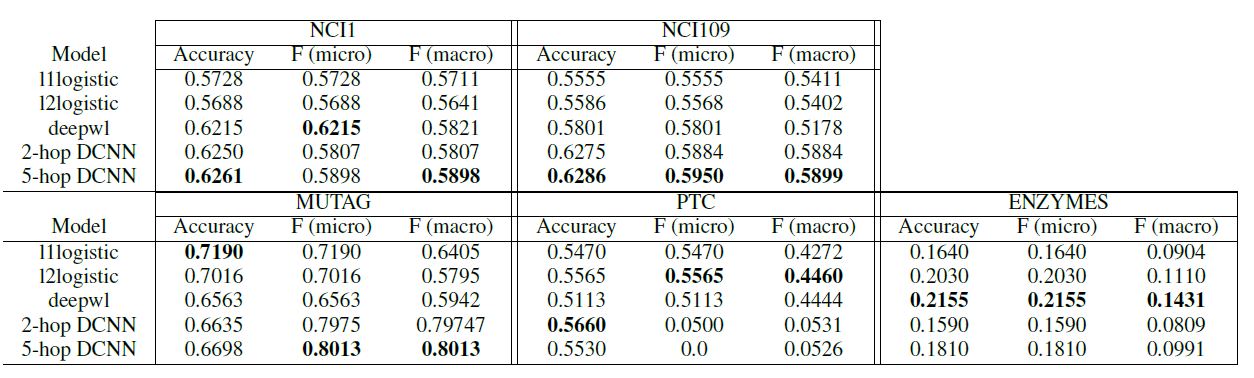

我们评估和对比了

GIN以及能力较弱的GNN变体的训练和测试性能。- 训练集上的性能比较让我们能够对比不同

GNN模型的表征能力。 - 测试集上的性能比较让我们能够对比不同

GNN模型的泛化能力。

- 训练集上的性能比较让我们能够对比不同

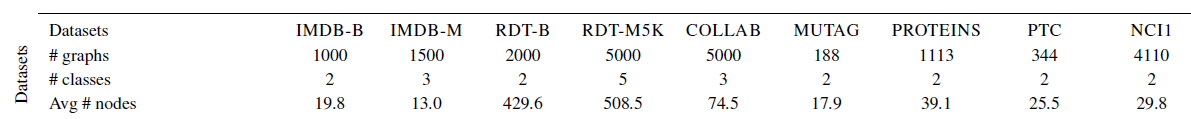

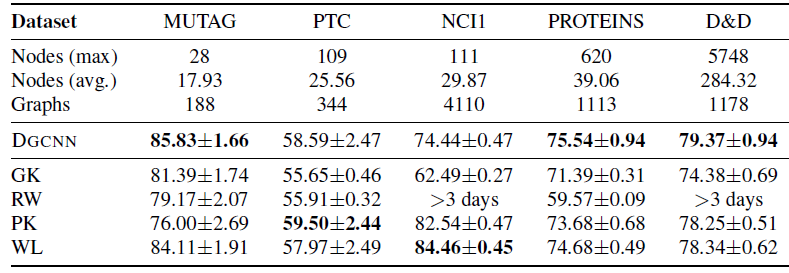

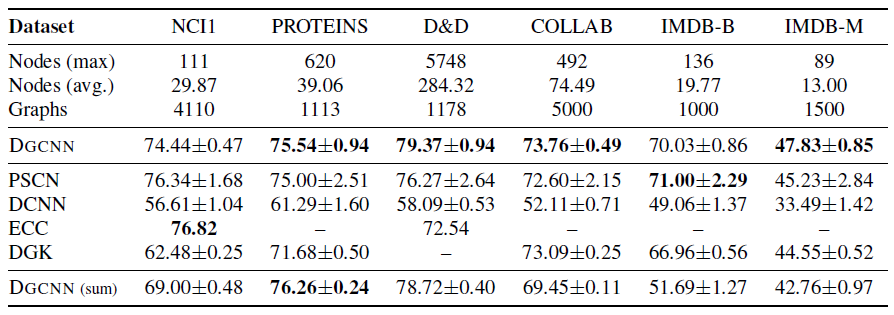

数据集:我们使用

9种图分类benchmark数据集,包括4个生物信息学数据集(MUTAG, PTC, NCI1, PROTEINS)、5个社交网络数据集(COLLAB, IMDB-BINARY, IMDB-MULTI, REDDITBINARY and REDDIT-MULTI5K) 。社交网络数据集:

IMDB-BINARY和IMDB-MULTI是电影协作collaboration数据集。每个图对应于演员的协作图,节点代表演员。如果两个演员出现在同一部电影中,则节点之间存在边。

每个图都来自于预先指定的电影流派

genre,任务的目标是对图的流派进行分类。REDDIT-BINARY和REDDIT-MULTI5K是平衡的数据集。每个图对应于一个在线讨论话题

thread,节点对应于用户。如果一个用户评论了另一个用户的帖子,则两个节点之间存在一条边。任务的目标是将每个图分类到对应的社区。

COLLAB是一个科学协作collaboration数据集,它来自3个公共协作数据集,即High Energy Physics, Condensed Matter Physics, Astro Physics。每个图对应于来自每个领域的不同研究人员的协作网络。任务的目标是将每个图分类到所属的领域。

生物学数据集:

MUTAG是包含188个诱变mutagenic的芳香族aromatic和异芳香族heteroaromatic硝基化合物nitro compound的数据集,具有7个类别。PROTEINS数据集中,节点是二级结构元素secondary structure elements:SSEs,如果两个节点在氨基酸序列或3D空间中是邻居,则两个节点之间存在边。它具有3个类别,分别代表螺旋helix、片sheet、弯turn。PTC是包含344种化合物的数据集,给出了针对雄性和雌性老鼠的致癌性,具有19个类别。NCL1是美国国家癌症研究所公开的数据集,是化学化合物平衡数据集的子集balanced datasets of chemical compounds。这些化合物经过筛选具有抑制一组人类癌细胞系生长的能力,具有37个类别。

重要的是,我们的目标不是让模型依赖于节点的特征,而是主要从网络结构中学习。因此:在生物信息图中,节点具有离散

categorical的输入特征;而在社交网络中,节点没有特征。对于社交网络,我们按照如下方式创建节点特征:- 对于

REDDIT数据集,我们将所有节点特征向量设置为相同。因此这里特征向量不带任何有效信息。 - 对于其它社交网络,我们使用节点

degree的one-hot编码作为节点特征向量。因此这里的特征向量仅包含结构信息。

下表给出了数据集的统计信息。

baseline方法:WL sbuntree kernel,其中使用C-SVM来作为分类器。SVM的超参数C以及WL迭代次数通过超参数调优得到,其中迭代次数从{1,2,3,4,5,6}之中选择。state-of-the-art深度学习架构,如Diffusionconvolutional neural networks: DCNN、PATCHY-SAN、Deep Graph CNN: DGCNN。Anonymous Walk Embeddings:AWL。

对于深度学习方法和

AWL,我们报告其原始论文中的准确率。实验配置:我们评估

GIN和能力较弱的GNN变体。在

GIN框架下,我们考虑两种变体:一种是通过梯度下降来学习

另一种是固定

GIN-0。GIN的邻域聚合就是sum池化(不包含当前节点自身)。

正如我们将看到的,

GIN-0将表现出强大的实验性能:GIN-0不仅与对于能力较弱的

GNN变体,我们考虑使用均值池化或最大池化替代GIN-0中的sum聚合,或者使用单层感知机来代替GIN-0中的多层感知机。这些变体根据使用的聚合器、感知器来命名。如

mean-1-layer对应于GCN、max-1-layer对应于GraphSAGE,尽管有一些小的体系架构修改。

对于

GIN和所有的GNN变体,我们使用相同的graph-level readout函数。具体而言,由于更好的测试性能,生物信息学数据集的readout采用sum函数,而社交网络数据集的readout采用mean函数。我们使用

LIB-SVM执行10-fold交叉验证,并报告10-fold交叉验证中验证集准确率的均值和标准差。对于所有配置

configurations:- 我们使用

5层GNN layer(包含输入层),并且MLP都有2层(它不算在5层GNN内)。 - 我们对于每个

hidden layer应用batch normalization。 - 我们使用初始学习率为

0.01的Adam学习器,并且每50个epoch进行学习率衰减0.5。

超参数是针对每个数据集进行调优的:

- 对于生物学数据集,隐层维度为

16或32;对于社交网络数据集,隐层维度为64。 batch size为32或128。dropout在dense层后,dropout比例为0或0.5。epoch数量通过10-fold交叉验证来确定。

注意:由于数据集规模较小,因此使用验证集进行超参数选择极其不稳定。例如对于

MUTAG,验证集仅包含18个数据点。因此上述有很多超参数是我们人工调优的。我们也报告了不同

GNN的训练准确率。其中所有的超参数在所有数据集上都是固定的(调优之后):5层GNN layer(包括输入层)、hidden维度为64、batch size = 128、dropout比例为0.5。为进行比较,我们也报告了

WL subtree kernel的准确率,其中迭代数量为4。这和5 GNN layer相当。

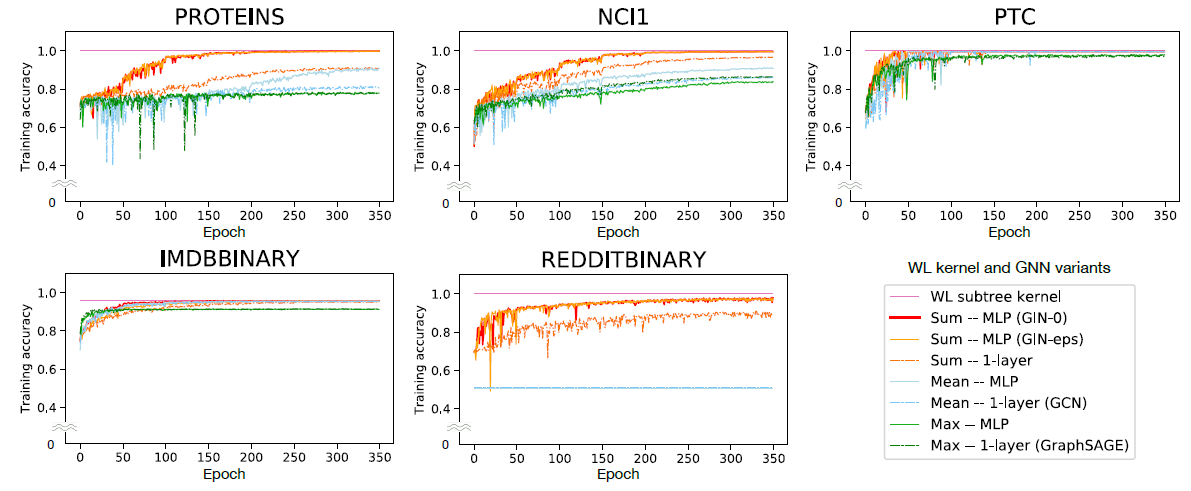

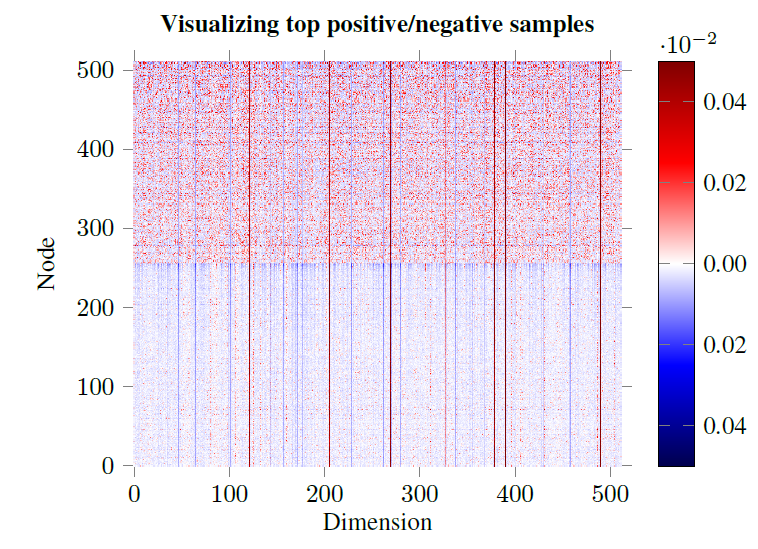

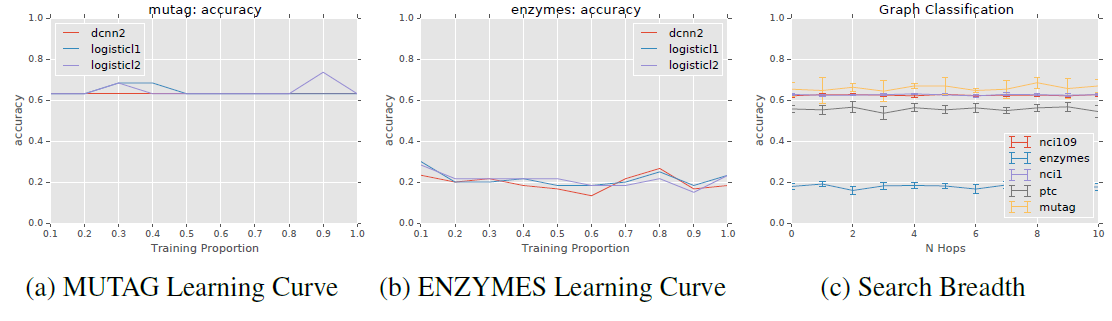

27.5.1 训练准确率

通过比较

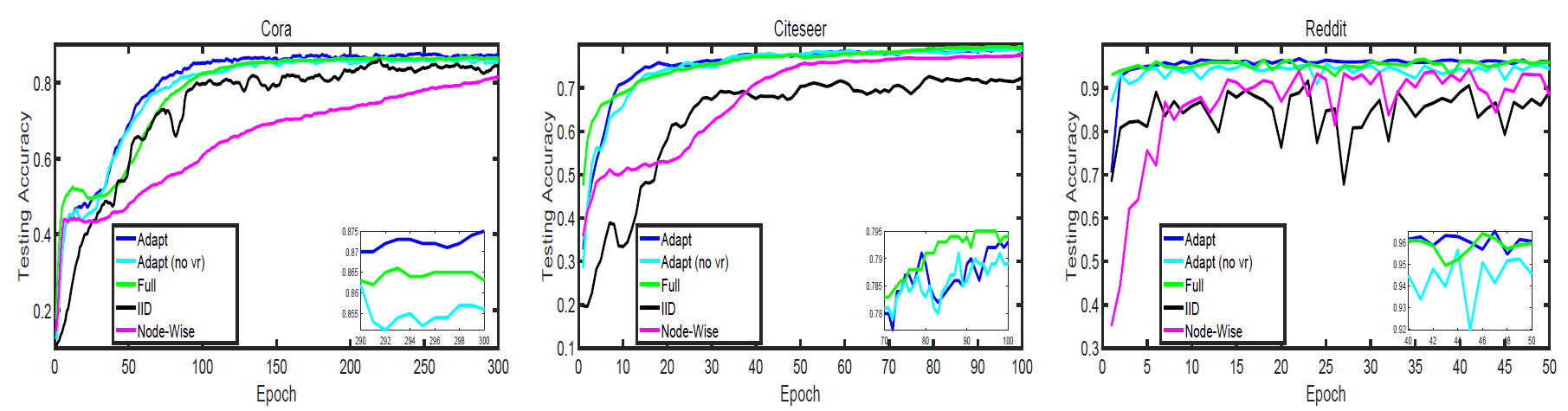

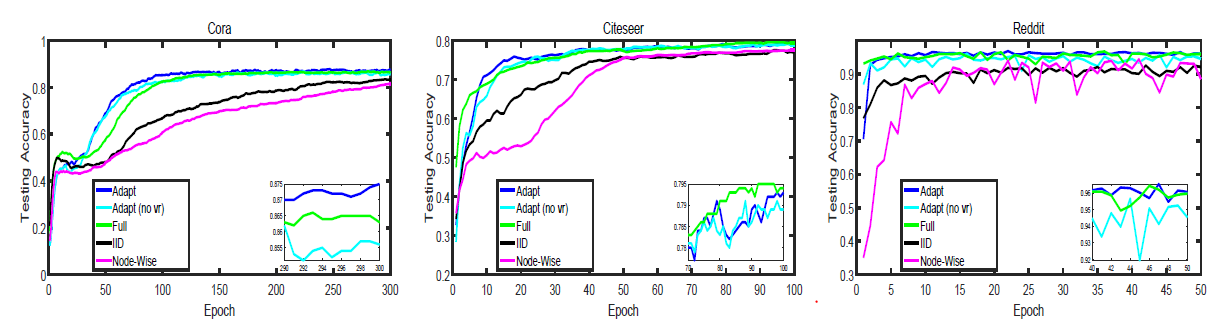

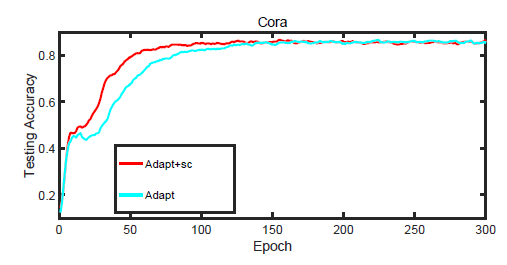

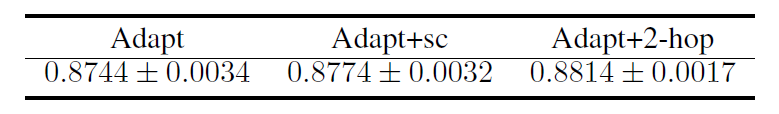

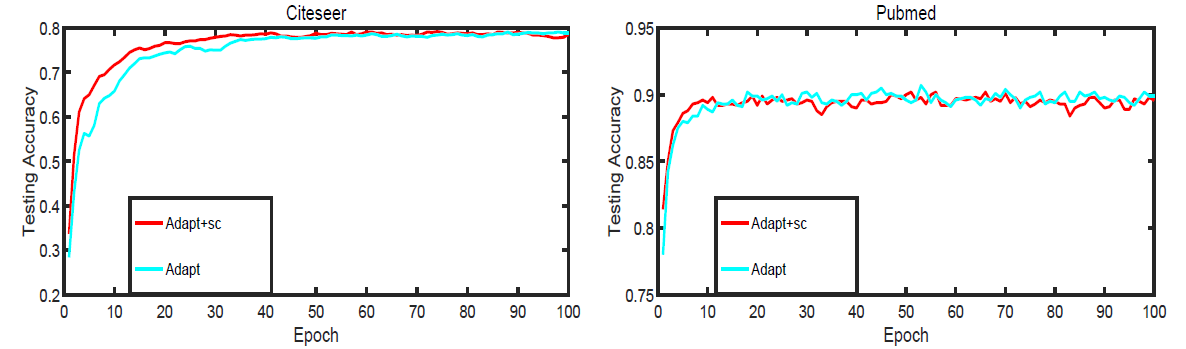

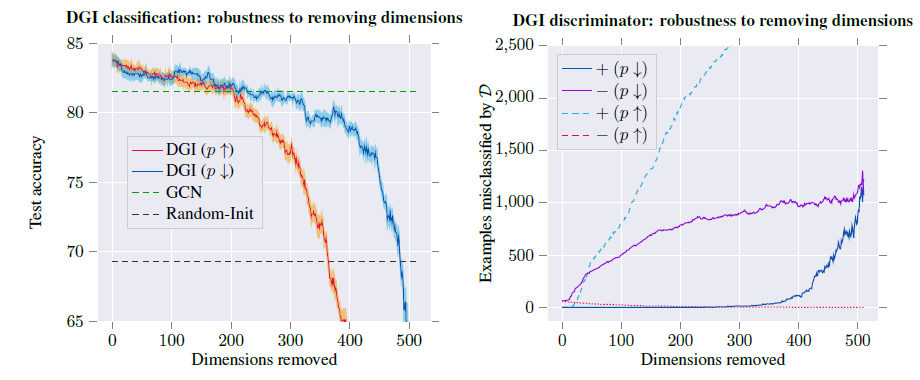

GNN的训练准确率,我们验证了我们关于表征能力的理论分析。具有较高表达能力的模型应该具有较高的训练准确率。下图给出了具有相同超参数设置的GIN和能力较弱的GNN变体的训练曲线。首先,

GNN,它们都可以几乎完美地拟合训练集。在我们的实验中,在拟合训练数据集这个方面 ,显式学习

0的相比之下,使用均值/最大值池化聚合、或者单层感知机的

GNN变体在很多数据集中严重欠拟合。具体而言,训练准确率模式和我们通过模型表征能力的排名相符:

- 采用

MLP的GNN变体要比采用单层感知机的GNN变体拟合训练集效果更好。 - 采用

sum聚合器的GNN变体要比采用均值/最大值池化聚合的GNN变体拟合训练集效果更好。

- 采用

在我们的数据集上,

GNN训练准确率永远不会超过WL subtree kernel。这是可以预期的,因为

GNN的判别力通常比WL-test更低。例如在IMDB-BINARY数据集上,没有一个模型能够完美拟合训练集,而GNN最多可达到与WL kernel相同的训练准确率。这种模式和我们的结果一致,即

WL-test为基于聚合的GNN的表征能力提供了上限。但是,WL kernel无法学习如何组合节点特征,这对于给定的预测任务非常有用。我们接下来会看到。

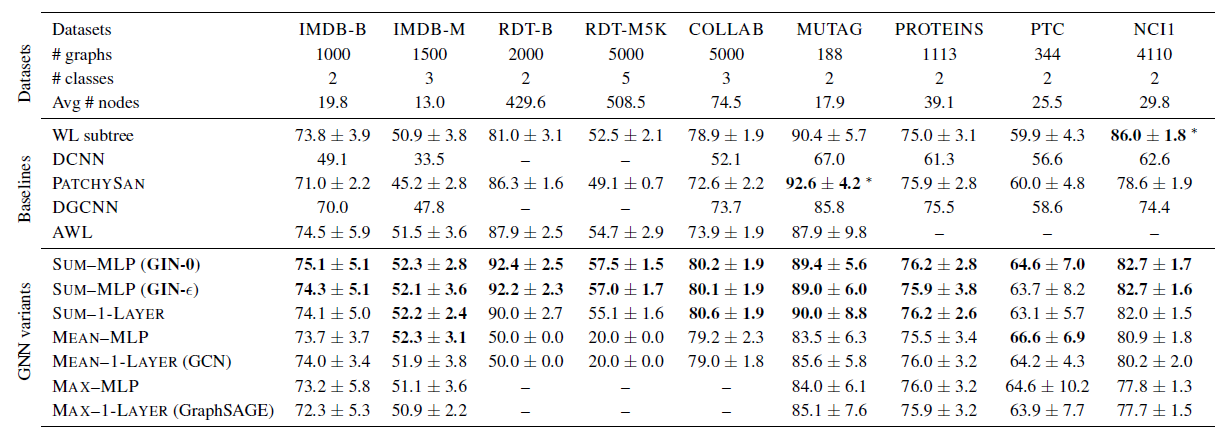

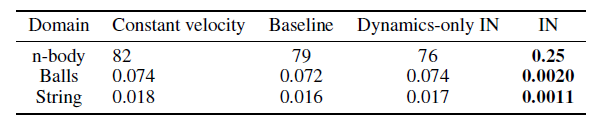

27.5.2 测试准确率

接下来我们比较测试准确率。尽管我们的理论分析并未直接提及

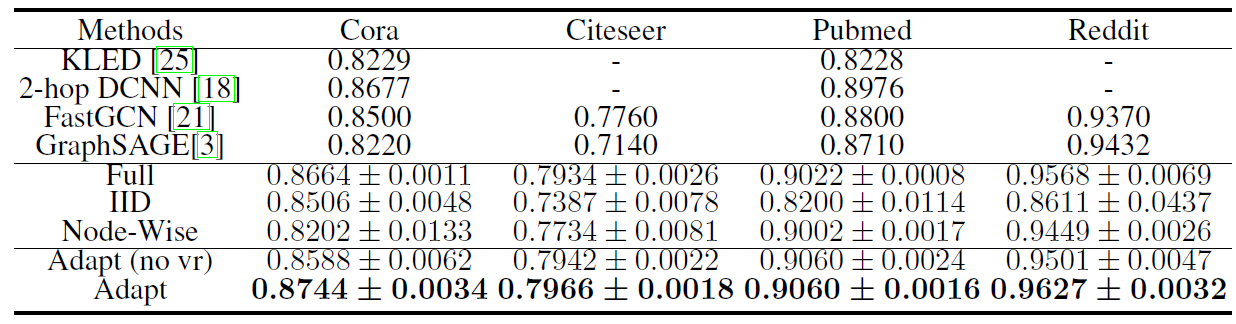

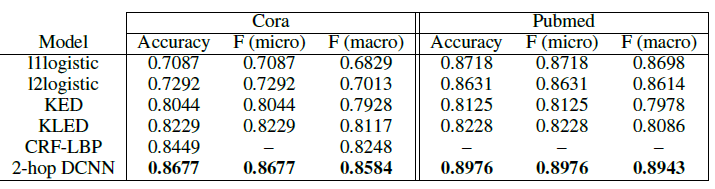

GIN的泛化能力,但是可以合理地预期具有强大表达能力的GNN可以准确地捕获感兴趣的图结构,从而更好地泛化。下表给出了

GIN(Sum-MLP) 、其它GNN变体、以及state-of-the-art baseline的测试准确率。表现最好的GNN以黑色突出显示。在有些数据集上GIN的准确率在所有GNN变体之间并非最高,但是和最佳GNN相比GIN仍然具有可比的性能,因此GIN也已黑色突出显示。如果baseline的性能明显高于所有GNN,则我们用黑体和星号同时突出显示。结论:

首先,

GIN,尤其是GIN-0,在所有9个数据集上均超越了(或者达到可比的)能力较弱的GNN变体,达到了state-of-the-art性能。其次,在包含大量训练数据的社交网络数据集中,

GIN效果非常好。对于

Reddit数据集,所有节点都使用相同的特征,因此模型仅能捕获图结构信息。GIN以及sum聚合的GNN准确地捕获到图结构,并且显著优于其它模型。- 均值聚合

GNN无法捕获图的任何结构,并且其测试准确率和随机猜测差不多。

对于其它社交网络数据集,虽然提供了节点

degree作为输入特征,但是基于均值聚合的GNN也要比基于sum聚合的GNN差得多。对于

GIN-0和GIN-0稍微、但是一致地超越了GIN-0相比

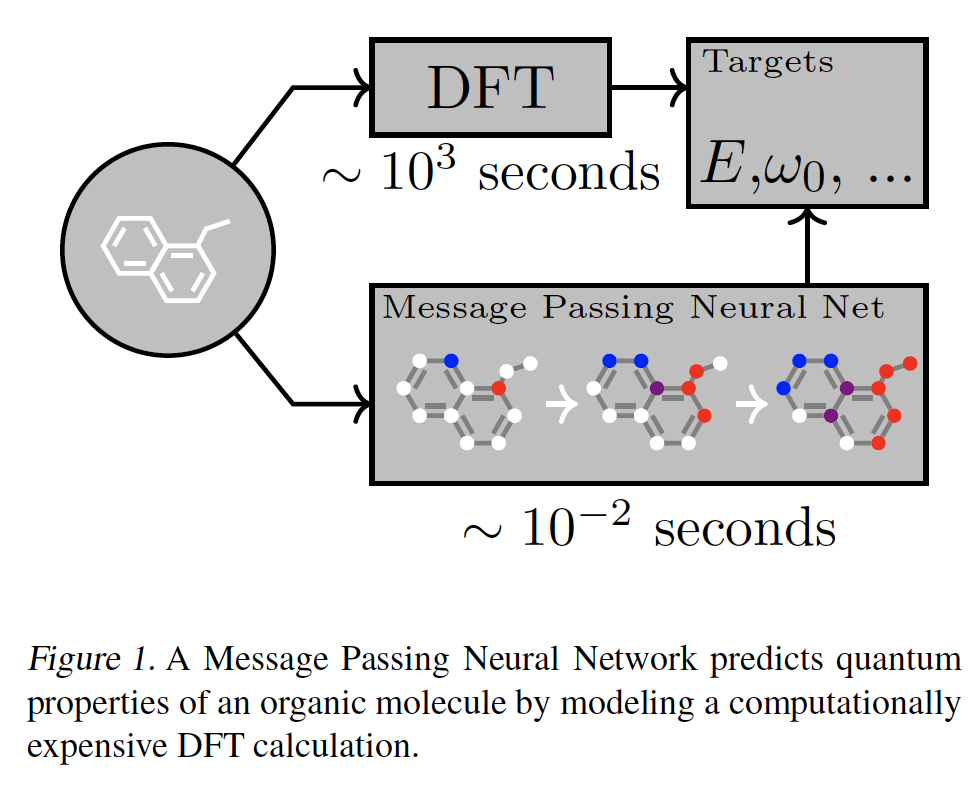

二十八、MPNN[2017]

机器学习预测分子和材料的性质仍处于起步阶段。迄今为止,将机器学习应用于化学任务的大多数研究都围绕着特征工程展开,神经网络在化学领域并未广泛采用。这使人联想到卷积神经网络被广泛采用之前的图像模型

image model的状态,部分原因是缺乏经验证据表明:具有适当归纳偏置inductive bias的神经网络体系结构可以在该领域获得成功。最近,大规模的量子化学计算

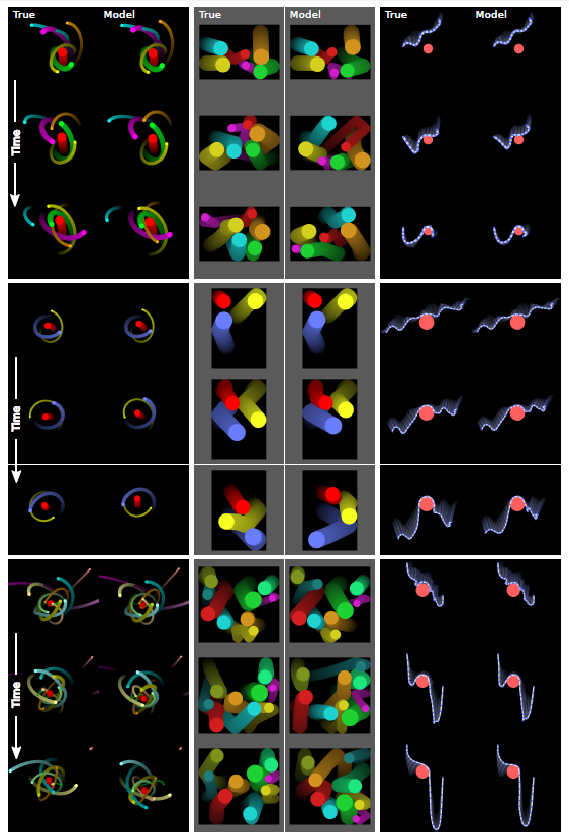

quantum chemistry calculation和分子动力学模拟molecular dynamics simulation,加上高通量high throughput实验的进展,开始以前所未有的速度产生数据。大多数经典的技术不能有效地利用现在的大量数据。假设我们能找到具有适当归纳偏置的模型,将更强大和更灵活的机器学习方法应用于这些问题的时机已经成熟。原子系统的对称性表明,在图结构数据上操作并对图同构graph isomorphism不变的神经网络可能也适合于分子。足够成功的模型有朝一日可以帮助实现药物发现或材料科学中具有挑战性的化学搜索问题的自动化。在论文

《Neural Message Passing for Quantum Chemistry》中,作者的目标是为化学预测问题展示有效的机器学习模型,这些模型能够直接从分子图molecular graph中学习特征,并且对图同构不变invariant。为此,论文描述了一个在图上进行监督学习的一般框架,称为信息传递神经网络(Message Passing Neural Network: MPNN)。MPNN简单地抽象了现有的几个最有前景的图神经模型之间的共性,以便更容易理解它们之间的关系,并提出新的变体。鉴于许多研究人员已经发表了适合MPNN框架的模型,作者认为社区应该在重要的图问题上尽可能地推动这种通用方法,并且只提出由application所启发的新变体,例如论文中考虑的应用:预测小有机分子的量子力学特性(如下图所示)。

最后,

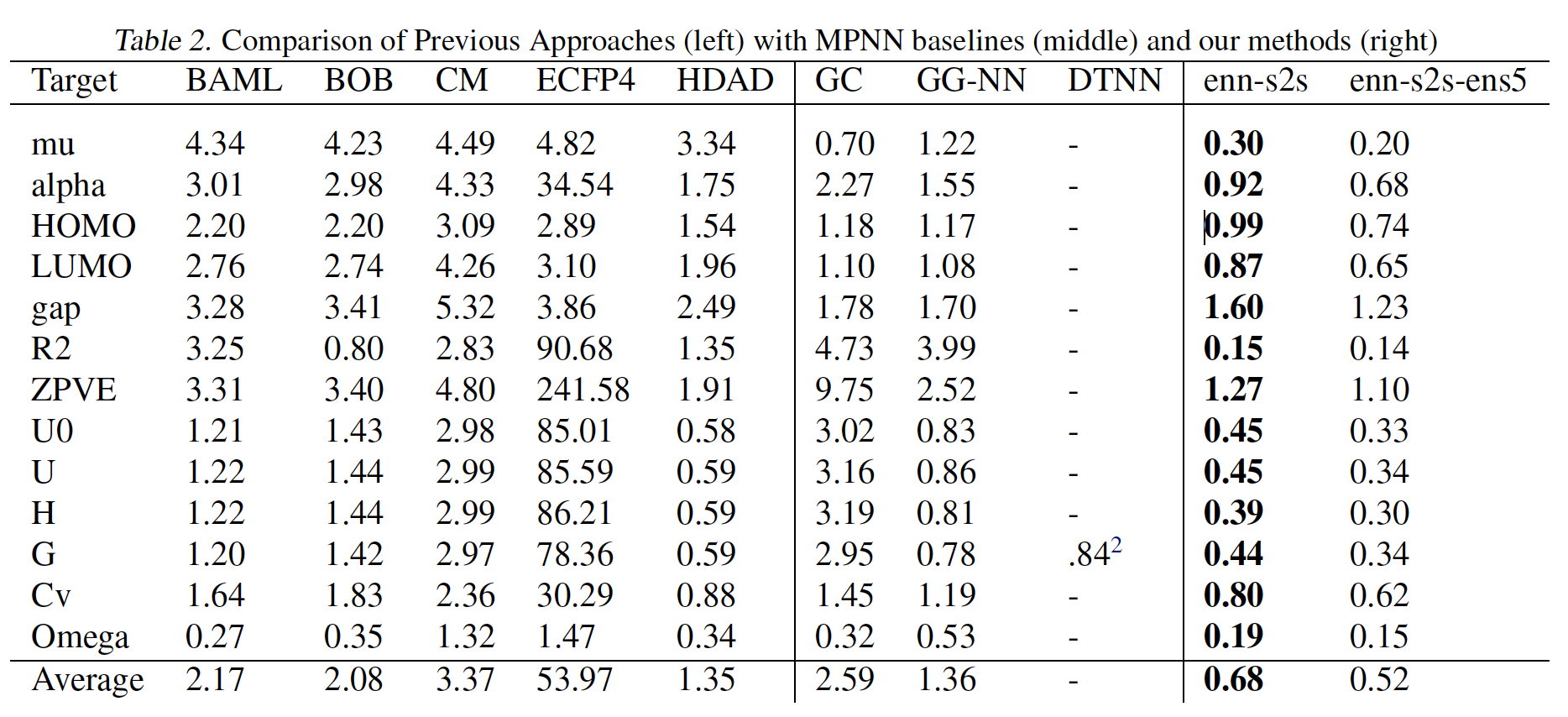

MPNN在分子属性预测benchmark上取得了state-of-the-art的结果。论文贡献:

- 论文开发了一个

MPNN框架 ,它在所有13个目标target上都取得了SOTA的结果,并在13个目标中的11个目标上预测到DFT的化学准确性。 - 论文开发了几种不同的

MPNN,在13个目标中的5个目标上预测到DFT的化学准确性,同时仅对分子的拓扑结构进行操作(没有空间信息作为输入)。 - 论文开发了一种通用的方法来训练具有更大

node representation的MPNN,而不需要相应地增加计算时间或内存,与以前的MPNN相比,在高维node representation方面产生了巨大的节省。

作者相信论文的工作是朝着使设计良好的

MPNN成为中等大小分子上的监督学习的默认方法迈出的重要一步。为了实现这一点,研究人员需要进行仔细的实证研究,以找到使用这些类型的模型的正确方法,并对其进行必要的改进。- 论文开发了一个

相关工作:尽管原则上量子力学可以让我们计算分子的特性,但物理定律导致的方程太难精确解决。因此,科学家们开发了一系列的量子力学近似方法,对速度和准确率进行了不同的权衡,如带有各种函数的密度功能理论(

Density Functional Theory: DFT)以及量子蒙特卡洛Quantum Monte-Carlo。尽管被广泛使用,DFT仍然太慢,无法应用于大型系统(时间复杂度为DFT表现出系统误差和随机误差。《Combined first-principles calculation and neural-network correction approach for heat of formation 》使用神经网络来近似DFT中一个特别麻烦的项,即交换相关势能exchange correlation potential,以提高DFT的准确性。然而,他们的方法未能提高DFT的效率,而是依赖于一大套临时的原子描述符atomic descriptor。另一个方向试图直接对量子力学的解进行近似,而不求助于DFT。这两个方向都使用了有固有局限性的手工设计的特征。

28.1 MPNN

为简单起见我们考虑无向图。给定无向图

- 每个节点

- 每条边

将无向图推广到有向的多图

multigraph(即多条边)也很容易。- 每个节点

GNN的前向传播具有两个阶段:消息传递阶段、readout阶段:消息传递阶段执行

step,它通过消息函数message functionupdate function在消息传递阶段,节点

其中

readout阶段根据所有节点在embedding向量其中

readout函数readout function。permutation invariant从而使得MPNN对图的同构不变性graph isomorphism invariant。

注意:你也可以在

MPNN中通过引入边的状态向量消息函数

readout函数《Convolutional Networks for Learning Molecular Fingerprints》:消息函数

节点更新函数

degree,并且不同的degree使用不同的映射矩阵。sigmoid函数。

Readout函数skip connection连接所有节点的所有历史状态其中

这种消息传递方案可能是有问题的,因为得到的消息向量

Gated Graph Neural Networks:GG-NN:消息函数

edge labellabel是离散的。节点更新函数

GRU为Gated Recurrent Unit。该工作使用了权重绑定

weight tying,因此在每个时间步都使用相同的更新函数。即,它将每个节点的

Readout函数sigmoid函数。

Interaction Networks:该工作既考虑了node-level目标,也考虑了graph-level目标。也考虑了在节点上施加的外部效应。- 消息函数

- 节点更新函数

- 当进行

graph-level输出时,Readout函数1。

- 消息函数

Molecular Graph Convolutions:该工作和MPNN稍有不同,因为它在消息传递阶段更新了边的表示消息函数

节点更新函数

relu为ReLU非线性激活函数,边更新函数:

其中

Deep Tensor Neural Networks:- 消息函数

bias向量。 - 节点更新函数

Readout函数

- 消息函数

Laplacian Based Methods,例如GCN:消息函数

其中

deg(v)为节点degree。节点更新函数

将这些方法抽象为通用的

MPNN的好处是:我们可以确定关键的实现细节,并可能达到这些模型的极限,从而指导我们进行未来的模型改进。所有这些方法的缺点之一是计算时间。最近的工作通过在每个

time step仅在图的子集上传递消息,已经将GG-NN架构应用到更大的图。这里我们也提出了一种可以改善计算成本的MPNN修改。

28.2 MPNN 变体

我们基于

GG-NN模型探索MPNN,我们认为GG-NN是一个很强的baseline。我们聚焦于探索不同的消息函数、输出函数,从而找到适当的输入representation以及正确调优的超参数。消息函数探索:

矩阵乘法作为消息函数:首先考察

GG-NN中使用的消息函数,它定义为其中

edge labellabel是离散的。Edge Network:为了支持向量值的edge特征,我们使用以下消息函数:其中

edge特征Pair Message:前面两种消息函数仅依赖于隐状态其中

当我们将上述消息函数应用于有向图时,将使用两个独立的函数

虚拟节点 & 虚拟边:我们探索了两种方式来在图中添加虚拟元素,从而修改了消息传递的方式(使得消息传播得更广):

虚拟边:在未连接节点

pair对之间添加虚拟边,这个边的类型是特殊类型。这可以实现为数据预处理步骤,并允许消息在传播阶段传播很长一段距离。虚拟节点:虚拟一个

master节点,该节点以特殊的边类型来连接到图中的每个输入节点。此时

master节点充当全局暂存空间,每个节点都在消息传递的每个step中从master读取信息、向master写入信息。这允许信息在传播阶段传播很长的距离。我们允许

master节点具有单独的节点维度master节点在内部状态更新函数中使用单独的权重矩阵。由于加入了

master节点,理论上模型复杂度有所增加,并提升了模型型容量。

Readout函数:我们尝试了两种Readout函数。一种是在

GG-NN中使用的Readout函数:另一种是

Set2Set模型,该模型专门为Set输入而设计的,并且比简单地累加final node state具有更强的表达能力。该模型首先将线性投影应用于每个元组

set的元组投影作为输入。然后,在经过step之后,Set2Set模型将产生graph-level embeddingembedding对于set的顺序具有不变性。我们将这个embedding

Multiple Towers:MPNN的一个问题是可扩展性,特别是对于稠密图。消息传递阶段的每个step需要我们将

embeddingembeddingembedding。然后我们在每个隐空间

embedding最后这

embedding结果通过以下方式混合:其中:

这种混合方式保留了节点的排列不变性

permutation invariant,同时允许图的不同embedding在传播阶段相互交流。这种方法是有利的,因为对于相同数量的参数数量,它能产生更大的假设空间,表达能力更强。并且时间复杂度更低。当消息函数是矩阵乘法时,某种

embedding的传播step花费embedding,因此总的时间复杂度为Multiple Towers就是multi-head的思想。

28.3 实验

数据集:

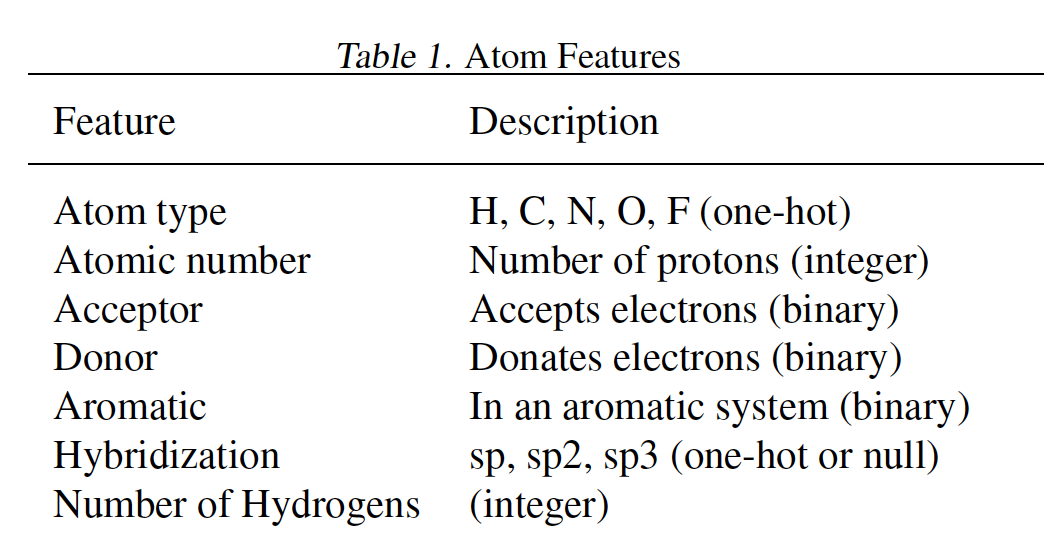

QM-9分子数据集,包含130462个分子。我们随机选择10000个样本作为验证集、10000个样本用于测试集、其它作为训练集。特征(如下表所示)和label的含义参考原始论文。

我们使用验证集进行早停和模型选择,并在测试集上报告

mean absolute error:MAE。结论:

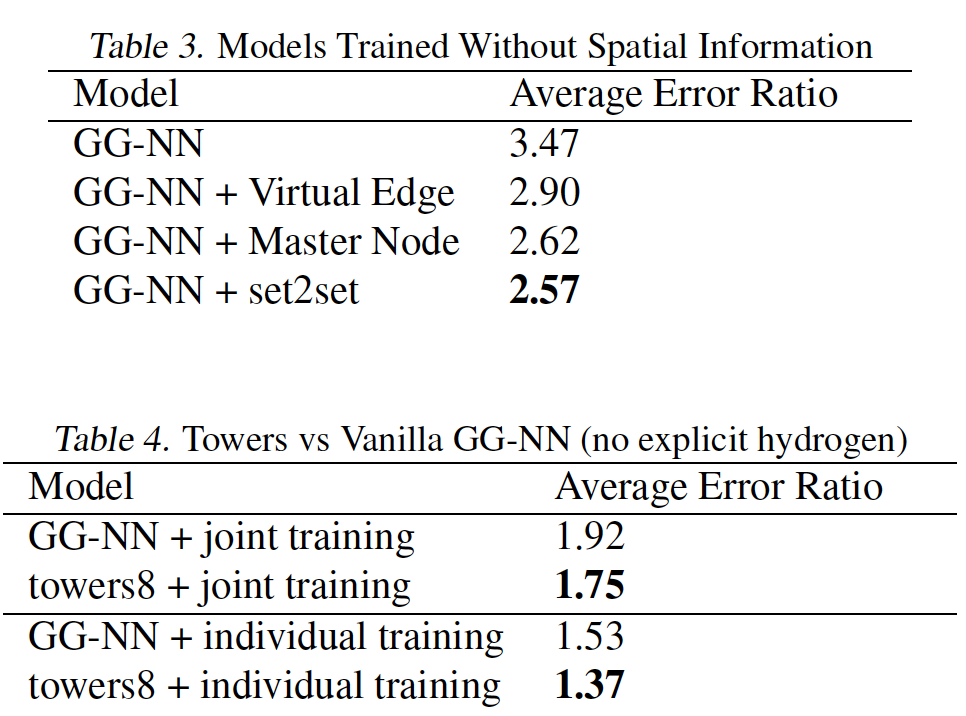

- 针对每个目标训练一个模型始终优于对所有

13个目标进行联合训练。 - 最优的

MPNN变体使用edge network消息函数。 - 添加虚拟边、添加

master节点、将graph-level输出修改为Set2Set输出对于13个目标都有帮助。 Multiple Towers不仅可以缩短训练时间,还可以提高泛化性能。

具体实验细节参考原始论文。

下图中,

enn-s2s表示最好的MPNN变体(使用edge network消息函数、set2set输出、以及在具有显式氢原子的图上操作),enn-s2s-ens5表示对应的ensemble。

- 针对每个目标训练一个模型始终优于对所有

二十九、UniMP[2020]

在半监督节点分类任务中,我们需要学习带标签的样本,然后对未标记样本进行预测。为更好地对节点进行分类,基于拉普拉斯平滑性假设

Laplacian smoothing assumption,人们提出了消息传递模型来聚合节点邻域的信息从而获得足够的事实fact来对未标记节点产生更可靠的预测。通常有两种实现消息传递模型的实用方法:

- 图神经网络

Graph Neural Network:GNN:通过神经网络执行特征传播feature propagation以进行预测。 - 标签传播算法

Label Propagation Algorithm:LPA:跨graph adjacency matrix的标签传播label propagation来进行预测。

由于

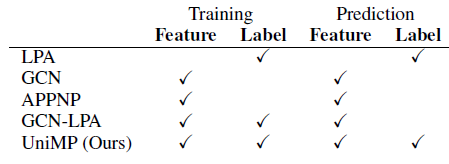

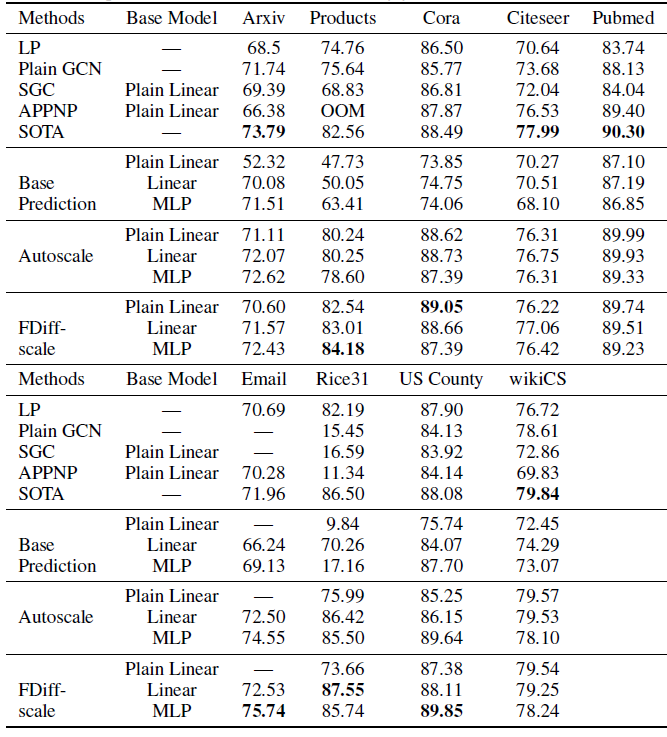

GNN和LPA基于相同的假设:通过消息传播进行半监督分类。因此有一种直觉认为:将它们一起使用可以提高半监督分类的性能。已有一些优秀的研究提出了基于该想法的图模型。例如,APPNP和TPN通过将GNN和LPA拼接在一起,GCN-LPA使用LPA来正则化GCN模型。但是,如下表所示,上述方法仍然无法将GNN和LPA共同融入消息传递模型,从而在训练和预测过程中同时传播特征和标签。

为了统一特征传播和标签传播,主要有两个问题需要解决:

聚合特征信息和标签信息:由于节点特征是由

embedding表达的,而节点标签是一个one-hot向量。它们不在同一个向量空间中。此外,它们的信息传递方式也不同:

GNN可以通过不同的神经网络架构来传播信息,如GraphSAGE、GCN和GAT;但是LPA只能通过图邻接矩阵来传递标签信息。监督训练:用特征传播和标签传播进行监督训练的模型不可避免地会在

self-loop标签信息中出现过拟合,这使得在训练时出现标签泄漏label leakage,导致预测的性能不佳。

受

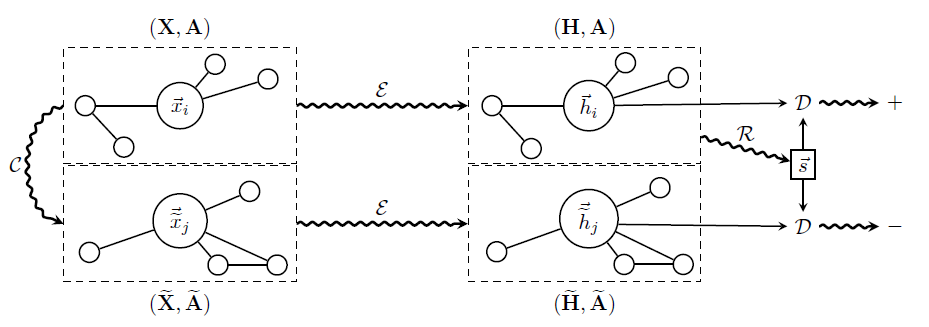

NLP发展的启发,论文《Masked label prediction: unified message passing model for semi-supervised classification》提出了一个新的统一消息传递模型Unified Message Passing:UniMP,并且使用带masked label prediction的UniMP来解决上述问题。UniMP模型可以通过一个共享的消息传递网络将特征传播和标签传播xx,从而在半监督分类中提供更好的性能。UniMP是一个多层的Graph Transformer,它使用label embedding来将节点标签转换为和节点特征相同的向量空间。一方面,

UniMP像之前的attention-based GNN一样传播节点特征;另一方面,UniMP将multi-head attention视为转移矩阵从而用于传播label vector。因此,每个节点都可以聚合邻域的特征信息和标签信息。即,

label vector的转移矩阵来自于attention,而不是来自于图的邻接矩阵。为了监督训练

UniMP模型而又不过拟合于self-loop标签信息,论文从BERT中的masked word prediction中吸取经验,并提出了一种masked label prediction策略。该策略随机mask某些训练样本的标签信息,然后对其进行预测。这种训练方法完美地模拟了图中标签信息从有标签的样本到无标签的样本的转移过程。

论文在

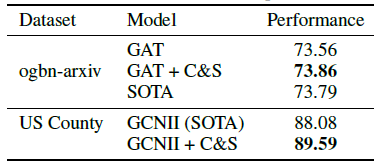

Open Graph Benchmark:OGB数据集上对三个半监督分类数据集进行实验,从而证明了UniMP获得了state-of-the-art半监督分类结果。论文还对具有不同输入的模型进行了消融研究,以证明UniMP方法的有效性。此外,论文还对标签传播如何提高UniMP模型的性能进行了最彻底的分析。- 图神经网络

29.1 模型

定义图

每个节点

每条边

每个节点

one-hot表示为one-hot构成标签矩阵实际上在半监督节点分类任务中,大部分节点的标签是未知的。因此我们定义初始标签矩阵

one-hot标签向量或者全零向量组成:对于标记节点,它就是标签的one-hot向量;对于未标记节点,它就是全零的向量。图的邻接矩阵定义为

degree。归一化的邻接矩阵定义为

特征传播

Feature Propagation模型:在半监督节点分类中,基于拉普拉斯平滑假设,GNN将节点特征GNN的特征传播范式为:在第其中:

representation矩阵,final embedding矩阵

标签传播

Label Propagation模型:LPA假定相连节点之间的标签是平滑的,并在整个图上迭代传播标签。LPA的特征传播范式为:在第其中

在

LPA中,标签信息通过归一化的邻接矩阵

29.1.1 UniMP 模型

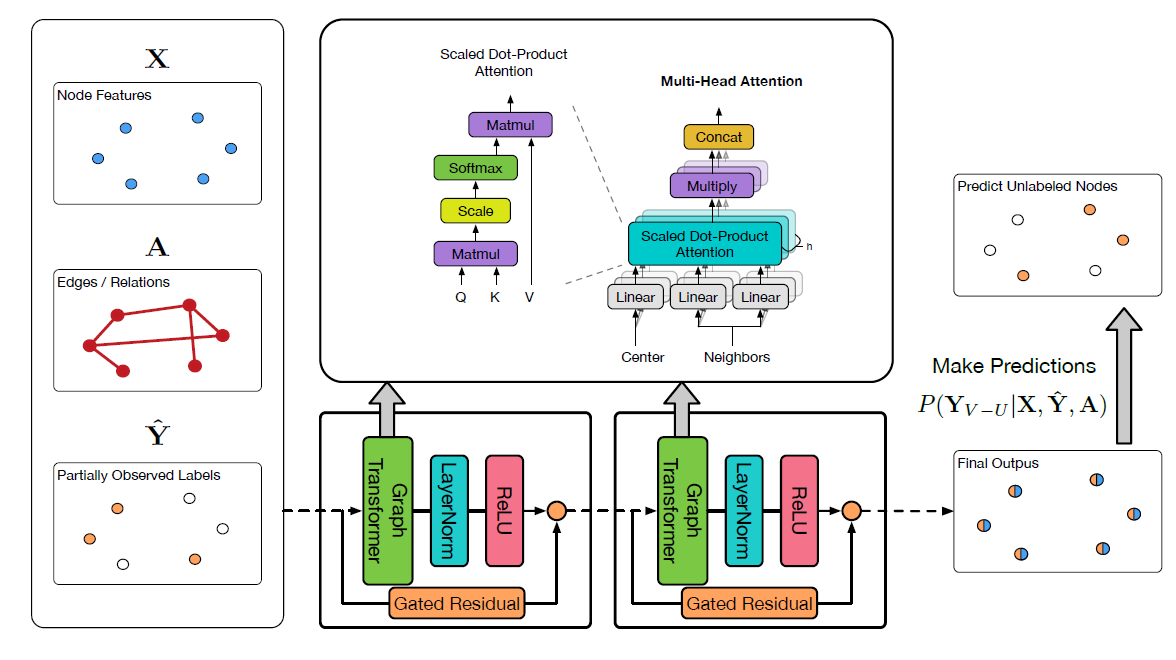

UniMP整体架构如下图所示。我们采用了Graph Transformer并结合使用label embedding来构建UniMP模型,从而将上述特征传播和标签传播结合在一起。

Graph Transformer:由于Transformer已经在NLP中被证明功能强大,因此我们将常规的multi-head attention应用到graph learning中。给定节点

representation集合multi-head attention:其中:

head的隐层大小。head attention。

我们首先将

source featurequery向量distant featurekey向量edge featurekey向量作为额外的信息。编码过程中使用了可训练的参数edge feature跨层共享。在计算注意力系数时,edge feature作为key的附加信息。当得到

graph multi-head attention,我们聚合节点注:这里的公式和上面的架构图不匹配。根据公式中的描述,残差应该连接在

Graph Transformer层之后。即:残差连接 ->LayerNorm->ReLU。其中:

节点

embeddingvalue向量考虑了

和特征传播相比,

multi-head attention矩阵代替了原始的归一化邻接矩阵作为消息传递的转移矩阵(类似于GAT)。另外,我们提出一个层间的门控残差连接gated residual connection来防止过度平滑oversmoothing。门控机制由

类似于

GAT,如果我们在输出层应用Graph Transformer,则我们对multi-head output应用均值池化(并且没有LayerNorm和relu):Label Embedding and Propagation:我们提出将部分观测到的标签信息embed到节点特征相同的空间中:label embedding向量和未标记节点的零向量。然后,我们通过简单地将节点特征和标签特征相加得到传播特征

propagation feature:我们可以证明,通过将部分标记的

证明:令

Graph Transformer中的attention矩阵(即edge feature,并且bias向量。那么我们有:其中

APPNP中预定义的超参数。为简单起见,我们取

其中

因此我们发现

UniMP模型可以近似分解为特征传播

29.1.2 Masked Label Prediction

已有的

GNN相关工作很少考虑在训练和推断阶段都使用部分观测的标签。大多数工作仅将这些标签信息作为ground truth target,从而监督训练模型参数其中

但是,我们的

UniMP模型会传播节点特征和标签信息从而进行预测:inference性能很差。我们向

BERT学习,它可以mask输入的word并预测被masked的word从而预训练BERT模型。有鉴于此,我们提出了一种masked label prediction策略来训练我们的模型。训练过程中,在每个iteration,我们随机屏蔽部分节点标签为零并保留剩余节点标签,从而将label_rate所控制(label_rate表示保留的标签比例)。假设被

masked之后的标签矩阵为其中:

masked标签的节点数量,masked标签。每个

batch内的target节点的label都是被屏蔽掉的。否则的话,对target节点预测标签会发生标签泄漏。通过这种方式,我们可以训练我们的模型从而不会泄露

self-loop标签信息。这篇论文就是一篇水文,其思想就是把

node label作为一个节点特征拼接到原始节点特征上去(当然,目标节点拼接全零信息而不是node label从而防止信息泄露),然后在所有输入的特征上执行随机mask。在推断过程中,我们可以将所有

29.2 实验

数据集:和实际工程应用的图相比,大多数论文常用的图数据集规模很小。

GNN在这些论文数据集上的性能通常不稳定,因为数据集太小、不可忽略的重复率或泄露率、不切实际的数据切分等。最近发布的

OGB数据集克服了常用数据集的主要缺点,它规模更大、更有挑战性。OGB数据集涵盖了各种现实应用,并覆盖了多个重要领域,从社交网络、信息网络到生物网络、分子图、知识图谱。它还覆盖了各种预测任务,包括node-level预测、graph-level预测、edge-level预测。因此我们在该数据集上进行实验,并将

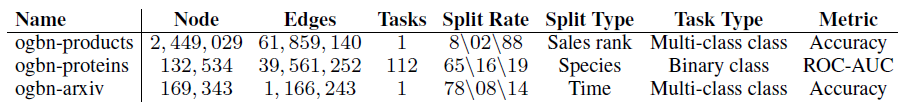

UniMP和SOTA模型进行比较。如下表所示,我们对三个OGBN数据集进行实验,它们是具有不同大小的不同任务。其中包括:ogbn-products:关于47种产品类别的分类(多分类问题),其中每个产品给出了100维的节点特征。ogbn-proteins:关于112种蛋白质功能的分类(多标签二分类问题),其中每条边并给出了8维的边特征。ogbn-arxiv:关于40种文章主题的分类(多分类问题),其中每篇文章给出了128维的节点特征。

实现细节:

这些数据集大小或任务各不相同,因此我们使用不同的抽样方法对模型进行评估。

- 在

ogbn-products数据集中,我们在训练期间每一层使用size=10的NeighborSampling来采样子图,并在推断期间使用full-batch。 - 在

ogbn-proteins数据集中,我们使用随机分区Random Partition将稠密图拆分为子图,从而训练和测试我们的模型。训练数据的分区数为9、测试数据的分区数为5。 - 在小型的

ogbn-arxiv数据集中,我们对训练数据和测试数据进行full batch处理。

- 在

我们为每个数据集设置了模型的超参数,如下表所示。

label rate表示我们在应用masked label prediction策略期间保留的标签比例。我们使用

lr=0.001的Adam优化器来训练模型。此外,我们在小型ogbn-arxiv数据集中将模型的权重衰减设置为0.0005来缓解过拟合。所有的模型都通过

PGL以及PaddlePaddle来实现,并且所有实验均在单个NVIDIA V100 32 GB上实现。

实验结果:

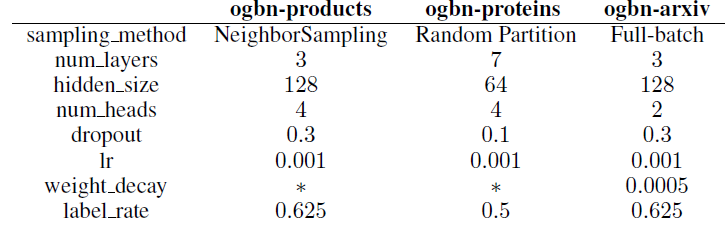

baseline方法和其它SOTA方法均由OGB排行榜给出。其中一些结果是原始作者根据原始论文官方提供,其它结果由社区重新实现的。并且所有这些结果都保证可以用开源代码复现。按照

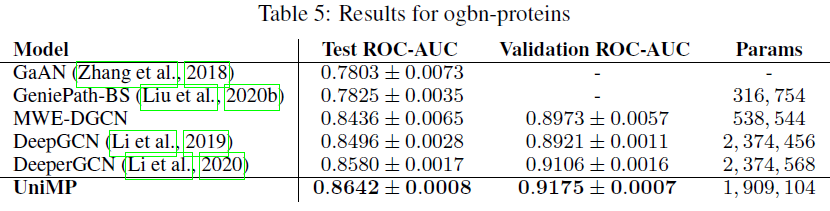

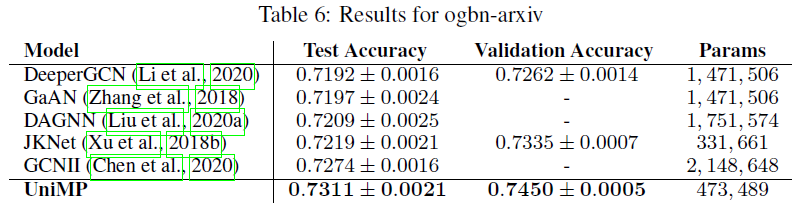

OGB的要求,我们对每个数据集运行10次实验结果,并报告均值和标准差。如下表所示,我们的UniMP模型在三个OGBN数据集上都超过所有其它模型。由于大多数模型仅考虑基于特征传播来优化模型,因此结果表明:将标签传播纳入GNN模型可以带来重大改进。具体而言:

UniMP在gbn-products中获得了82.56%的测试准确率,相比SOTA取得了1.6%的绝对提升。UniMP在gbn-proteins中获得了86.42%的测试ROC-AUC,相比SOTA取得了0.6%的绝对提升。UniMP在gbn-arxiv中获得了73.11%的测试准确率,相比SOTA实现了0.37%的绝对提升。

作者没有消融研究:

- 不同

label_rate对于模型性能的变化(当label_rate = 0时表示移除标签传播)。 - 除了

Graph Transformer之外,UniMap采用其它base model的效果是否也很好。

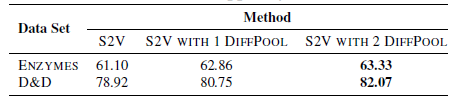

三十、Correct and Smooth [2020]

摘要:

GNN是在图上学习的主要技术。然而,人们对GNN在实践中取得成功的原因、以及它们是否是良好性能所必需的了解相对较少。在这里,论文表明:对于许多标准的transductive node classification benchmark,可以结合忽略图结构的浅层模型、以及利用标签结构中相关性的两个简单后处理步骤,从而超过或匹配SOTA的GNN的性能。这些后处理步骤利用了标签结构label structure中的相关性:- 误差相关性

error correlation:它将训练数据中的残差residual error扩散,从而纠正测试数据中的误差。 - 预测相关性

prediction correlation:平滑了测试数据上的预测结果。

论文的这个

pipeline称作 “矫正和平滑”Correct and Smooth:C&S。论文的方法在各种transductive节点分类benchmark上都超过或接近了SOTA GNN的性能,而参数规模小得多,运行速度也快了几个量级,并可以轻松scale到大型图。例如在OGB-Products数据集上,论文的方法相比于著名的GNN模型减少了137倍参数、提高了100倍的训练时间,并且效果还更好。还可以将论文的技术整合到大型GNN模型中,从而获得适度的收益。- 误差相关性

引言:

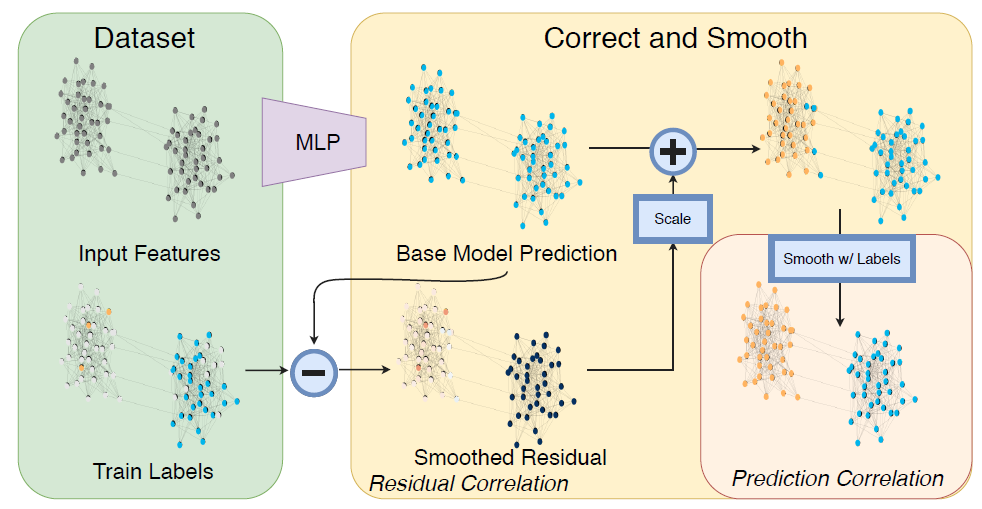

Graph Neural Network: GNN目前在图数据领域取得巨大成功,并且经常排在Open Graph Benchmark等排行榜的榜首。通常GNN的方法论都围绕着创建比基本变体(如GCN,GraphSAGE)更具有表达力的体系架构,如GAT、GIN以及其它各种深度模型。然而,随着这些模型变得越来越复杂,理解它们的性能为什么提升是一个重大挑战,而且将它们扩展到大型数据集也很困难。相反,论文

《Combining label propagation and simple models out-performs graph neural networks》研究了结合更简单的模型来获得收益。为此,论文提出了一个简单的pipeline,它包含三个主要部分(如下图所示):base prediction:使用忽略图结构(如MLP或线性模型)的节点特征进行基础预测base prediction。correction step:将训练数据中的误差传播到整个图,从而校正基础预测。smoothing:最后,对图上的预测进行平滑。

这里第二步和第三步只是后处理

post-processing,并且使用经典的标签传播label propagation: LP技术进行基于图的半监督学习。在该框架中,图结构不是用来学习参数的,而是作为一种后处理机制。这种简单性导致模型的参数数量减少,训练时间也减少了几个数量级,并且可以很容易地扩展到大型图。还可以将论文的思想与SOTA的GNN结合起来,从而得到适度的性能提升。论文性能提升的一个主要来源是:直接使用标签进行预测。这个思想并不新鲜,早期的

diffusion-based的图半监督学习算法(如spectral graph transducer、Gaussian random field model和label spreading)都使用了这个思想。然而,这些方法的动机是对点云数据进行半监督学习,所以特征被用来构建图。然后,这些技术被用于仅从标签(即没有特征)来在关系数据上学习,而这种学习方式在GNN中基本上被忽略了。即,作者发现:即使是简单的标签传播(忽略了特征)在一些benchmark上也有令人惊讶的表现。这启发了作者结合结合两个正交的预测能力:一个预测能力来自节点特征(忽略图形结构),一个预测能力来自在预测中直接使用已知标签。最近的研究将

GNN与标签传播label propagation以及马尔科夫随机场Markov Random field联系起来,一些技术在特征中使用标签信息的临时融合 (如UniMP)。然而,这些方法的训练成本仍然很高,而论文以两种可以理解的低成本方式使用标签传播:论文从一个无视图结构的模型开始进行廉价的 "基础预测";之后,论文使用标签传播进行纠错,然后对最终预测进行平滑处理。这些后处理步骤是基于

error和label在相连节点上是正相关的这一事实。假设相连节点之间的相似性是许多网络分析的中心,并对应于同质性homophily或同源混合assortative mixing。在半监督学习文献中,类似的假设是平滑性smoothness或聚类假设cluster assumption。论文在各种数据集上看到的标签传播的良好表现表明:这些相关性在普通benchmark上是成立的。总的来说,论文的方法表明:结合几个简单的思想,可以在模型大小(即参数数量)和训练时间方面,以很小的成本产生出色的

transductive节点分类性能。例如,在OGB-Product benchmark上,论文的表现超过了目前最著名的GNN,参数数量少了两个数量级,训练时间少了两个数量级。然而,论文的目标并不是说目前的graph learning方法很差或不合适。相反,论文的目标是强调提高graph learning预测性能的更容易的方法,并更好地理解性能提高的来源。论文的主要发现是:将标签更直接地纳入学习算法中是关键。而通过将论文的思想与现有的GNN相结合,也可以看到改进,尽管这些改进是微小的。作者希望论文的方法能够激发新的思想,帮助其他的graph learning任务,如inductive节点分类、链接预测和图预测。下图为

C&S方法的概览。左图表示数据集中有两个类别:橙色和蓝色。- 首先使用

MLP进行基础预测,从而忽略了图结构。这里假设所有节点都给出了相同的预测。 - 然后从训练数据中传播误差来校正基础预测。

- 最后校正后的预测通过标签传播得以平滑。

相关工作:

Approximate Personalized Propagation of Neural Predictions:APPNP框架是和我们工作最相关的,因为它们也是平滑了基础预测。但是,他们专注于将这个平滑处理集成到训练过程中,以便可以端到端地训练他们的模型。这种方式不仅显著增加计算成本,而且还使APPNP无法在推断时纳入标签信息。和

APPNP相比,我们的框架可以产生更准确的预测、训练速度更快,并且更容易scale到大规模图数据。我们的框架还补充了

Simplified Graph Convolution,以及旨在提高可扩展性的算法。然而,我们的方法的主要重点是直接使用标签,而可扩展性是一个副产品。之前也有将

GCN和标签传播联系起来的工作:《Unifying graph convolutional neural networks and label propagation》将标签传播作为预处理步骤从而用于GNN的edge加权,而我们将标签传播作为后处理步骤并避免使用GNN。《Residual correlation in graph neural network regression》将具备标签传播的GNN用于回归任务,我们的error correction步骤将他们的一些思想适配为分类的情况。

最后,最近有几种方法将非线性纳入标签传播从而与

GNN竞争并实现可扩展性,但这些方法专注于low label rate setting,并且没有纳入feature learning。

30.1 模型

给定无向图

每个节点

令

degree度矩阵,节点集合

one-hot向量one-hot向量记作全零

所有节点标签的

one-hot向量组成标签矩阵进一步地,我们将标记节点集合

我们任务的目标是:给定

C&S方法从基于节点特征的、简单的base predictor开始,这个predictor不依赖于对图的任何学习。然后执行两种类型的标签传播:- 一种是通过对误差相关性进行建模来校正

base prediction,即误差平滑性。 - 另一种是平滑最终预测,即标签平滑性。

标签传播只是后处理步骤

post-processing step,因此我们的pipeline没有端到端的训练。- 一种是通过对误差相关性进行建模来校正

在

C&S方法中,图数据仅在这些后处理步骤和预处理步骤pre-processing step中使用(比如构建节点特征),和标准的GNN模型相比,这使得训练更快且可扩展性更好。图数据在预处理步骤中用于生成节点

embedding,从而增强特征此外,

C&S方法同时使用了标签传播和节点特征,这些互补的信号会产生更出色的预测结果。标签传播本身往往在没有特征的情况下也表现得很出色。

30.1.1 Base Predictor

首先我们使用不依赖于图结构的、简单的

base predictor。具体而言,我们首先训练模型其中:

one-hot向量。

所有损失在标记的训练集

本文选择

multilayer perceptron: MLP后接一个softmax输出层。这种base predictor忽略图结构,因此可以避免GNN的可扩展问题。不过我们可以使用任何base predictor,甚至包括GNN的base predictor。但是,为了使得我们的

pipeline简单且可扩展,我们仅使用线性模型或者MLP作为base predictor。

30.1.2 误差校正

接下来我们通过融合标签信息来提高

base prediction的准确率。核心思想是:我们预期基础预测的误差在图上正相关。换句话讲:节点我们在图上传播

spread这种误差相似性。我们的方法在某种程度上受到残差传播的启发。在残差传播中,类似的概念用于节点回归任务。为此,我们定义一个误差矩阵

其中:

base predictor做出完美预测时,误差矩阵才为零。

现在我们已知误差矩阵

应该是在训练集上和误差矩阵

因此我们使用标签扩散技术来平滑误差,优化目标:

其中:

第一项鼓励误差估计在图上的平滑性。这等价于:

第二项使得最终的解接近已知的真实误差

这个目标函数可以通过迭代来求解:

其中:

该迭代方程快速收敛到

一旦得到平滑误差

我们强调这是一种后处理技术,没有和

base predictor相结合的训练过程。在回归问题中,基于高斯假设,这种方式的误差传播被证明是正确的方法。但是对于分类问题,平滑误差

考虑到:

其中

因此,传播没有足够多的总质量

total mass,所以传播无法完全纠正图中所有节点上的误差。并且,实验发现调整残差的比例实际上可以提供帮助。有鉴于此,我们提出了两种缩放残差的方法:

autoscale:直观地,我们希望将由于我们仅知道训练节点上的真实误差,所以我们用训练节点上的平均误差来计算这个缩放比例。

形式上,令

其中

然后我们将未标记节点

其中

FDiff-scale:另一种方法,我们可以选择一种扩散方法,该方法在标记节点上(包括训练集和验证集)保持真实误差具体而言,我们在未标记节点上迭代平滑误差为:

迭代过程中固定

直观地看,这将在标记节点

另外,我们仍然发现学习缩放的超参数

30.1.3 平滑预测

现在我们得到每个节点

score vectorbase predictor为了做出最终预测,我们进一步对校正后的预测进行平滑处理。这样做的动机是:图中相邻的节点可能具有相似的标签,这在网络同质性

homophily或者分类混合assortative mixing的属性下是可以预期的。因此,我们通过另一个标签传播来鼓励图上标签分布的平滑性。

首先我们定义标签矩阵的最优猜测

我们也可以在验证节点上使用真实标签,这将在后面的实验中讨论。

然后我们使用迭代公式:

其中

我们迭代上式直到收敛,从而得到最终预测

最终测试节点

和误差校正一样,这里的预测平滑是一个后处理步骤。这里的预测平滑在本质上类似于

APPNP,我们稍后将其进行比较。但是,APPNP是端到端训练的,在最后一层representation上进行传播而不是softmax,不使用标签,并且动机不同。

30.1.4 总结

回顾我们的

pipeline:首先,我们从低成本的基础预测

然后,我们通过在训练数据上传播已知真实误差来估计平滑误差

将训练节点的真实误差传播到所有节点。注意,我们仅关心测试节点的误差,因为测试误差需要用于纠正测试节点的预测标签。而训练节点的标签是已知的,直接使用

ground-truth。最后,我们通过另外一个标记传播步骤将校正预测与已知标签相结合,从而生成平滑的最终预测。

标签传播时,训练节点传播的是真实标签,测试节点传播的是预测标签。

我们将这个通用的

pipeline称作Correct and Smooth:C&S。其核心就是两个平滑:误差平滑、输出平滑。

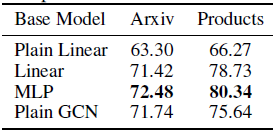

在显示该

pipeline在transductive节点分类上实现SOTA性能之前,我们简要介绍了另一种提高性能的简单方法:特征增强。深度学习的标志是:我们可以自动学习特征而不是手动的特征工程,但是

GNN仍然依靠输入的特征来执行预测。有很多方法可以从图拓扑中获取有用的特征来扩展原始节点的特征。在我们的

pipeline中,我们使用来自矩阵eigenvector作为规范化的谱域嵌入regularized spectral embedding,从而增强特征。这里:degree。degree。

虽然底层的矩阵是稠密的,但是我们可以应用矩阵向量乘法,并使用迭代的特征向量求解器

eigensolver来在embedding。在论文的实验部分,作者在进行训练速度的比较时没有考虑计算

spectral embedding的预处理时间,因此是不公平的比较。此外,计算spectral embedding对于大图而言是不可行的。

30.2 实验

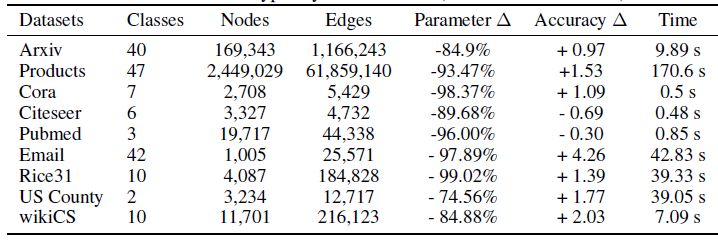

数据集:为证明我们方法的效果,我们使用了九个数据集,其中包括:

Open Graph Benchmark:OGB中的Arxiv数据集和Products数据集:标签为论文类别或商品类别,特征从文本内容派生而来。- 三个经典引文网络

benchmark数据集Cora,Citeseer,Pubmed:标签为论文类别,特征从文本内容派生而来。 - 一个

web graph数据集wikiCS::标签为网页类别,特征从文本内容派生而来。 Rice University的Facebook社交网络数据集:类别为宿舍dorm residence,特征为画像诸如性别、专业、班级等属性。US County数据:类别为2016年选举结果,特征为人口统计特征。- 欧洲研究所的

email数据集:类别为成员的部门,没有特征。

数据集的统计信息如下所示。另外我们还给出了我们方法相比较于

SOTA GNN:参数数量降低的比例、准确率的提升(绝对值)、以及我们方法的训练时间(秒)。结果表明:通过避免使用昂贵的GNN,我们的方法需要较少的参数、更快的训练速度,并且通常得到更准确的结果。

数据集拆分:

- 在

Arxiv数据集和Products数据集中,训练集、验证集、测试集的拆分由benchmark本身来提供。 - 对于

wikiCS数据集的拆分,我们和《A wikipedia-based benchmark for graph neural networks》的拆分一致。 - 对于

Rice, US County, Email数据集,我们随机拆分为40%/10%/50%。 - 对于更小的引文网络数据集,我们使用

60%/20%/20%的随机拆分。

我们并没有采用很低的

label rate,这是为了改善数据集对于超参数的敏感性。在我们的所有实验中,不同拆分的预估准确率标准差在

1%以内,并且通常不会改变我们的定性比较。- 在

base predictor和baseline:base predictor:- 我们使用线性模型

Linear和MLP模型作为简单的base predictor,其中输入特征是原始节点特征和spectral embedding。 - 我们还使用了仅使用原始特征的普通线性模型

Plain Linear作为base predictor进行比较。

- 我们使用线性模型

变种:我们对比了仅使用

base predictor的方法、使用autoscale和FDiff-scale的方法。baseline:我们对标签传播

Label Propagation模型进行比较。我们选择

GCN, SGC, APPNP作为对比的GNN模型。对于GCN模型,我们将输入到每一层、以及从每一层到输出层都添加了额外的残差链接residual connection,从而产生了更好的效果。GCN的层数、隐层维度和MLP相同。注意:这里的

GCN一种GCN风格的模型,而不是原始的、Kipf&Welling提出的模型。

最后,我们还包含了几个

state-of-the-art的baseline:- 对于

Arxiv和Product数据集,我们使用UniMP模型。该模型在2020-10-01位于OGB排行榜的榜首。 - 对于

Cora,Citeseer,Pubmed数据集,我们复用《 Simple and deep graph convolutional networks》论文给出的最好的结果。 - 对于

Email和US County数据集,我们使用GCNII模型。 - 对于

Rice31,我们使用带spectral embedding的GCN、以及带node2vec embedding的GCN。这是我们发现的、效果最好的GNN-based模型。 - 对于

WikiCS,我们使用APPNP。

- 对于

对于所有模型,我们通过验证集来选择一组固定的超参数。

30.2.1 仅训练标签

在平滑预测阶段,我们仅在训练节点上使用真实标签,即:

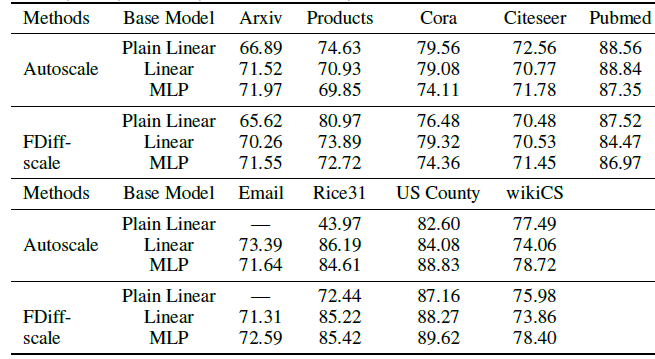

下表给出了实验结果,其中

Base Prediction表示仅使用基础预测而没有任何后处理;Autoscale和FDiff-scale表示使用不同的平滑预测缩放方式。我们重点介绍一些重要发现:

首先,在我们模型中

C&S后处理带来可观的收益。例如在Product数据集上,应用了后处理之后MLP base prediction的测试准确率从63%提升到84%。其次,在很多

case中:- 具有

C&S的Plain Linear模型也足以战胜常规的GCN模型。 - 标签传播

LP(一种没有可训练参数的方法)通常与GCN具有相当的竞争力。

鉴于

GCN的主要动机是解决连接的节点可能没有相似的标签的事实,这一点令人惊讶。我们的结果表明:通过简单地使用特征从而将相关性融合到图中,这通常是一个更好的主意。- 具有

第三,我们模型的变体在

Product,Cora,Email,Rice31, US County上的表现优于SOTA。在其它数据集上,我们表现最好的模型和SOTA之间没有太大差异。

为了了解直接使用

ground truth标签有多大帮助,我们还尝试了没有标签的C&S版本,其中不执行C&S步骤,而是使用《Learning with local and global consistency》中的方法来平滑base predictor的输出,我们称这个版本为Basic Model。即:- 标签信息仅用于

base predictor的训练。 - 图结构信息仅用于

base predictor预测结果的平滑。

这里面缺少了误差的平滑,仅保留预测结果的平滑。

结果如下表所示。我们看到:

Linear和MLP的base predictor通常可以超过GCN的性能。这些结果再次表明输出平滑非常重要,而GCN的原始动机具有误导性。相反,我们假设GCN可以通过平滑图上的输出来获得性能提升。这与《Simplifying graph convolutional networks》的观察类似。- 另外,我们也看到下图中这个

Basic Model和上图中使用C&S的方法之间仍然存在性能差异。

Plain Linear缺少了节点的spectral embedding特征。

- 标签信息仅用于

下表给出了仅使用误差校正,但是未使用平滑预测的实验结果。

实验结果表明:误差校正、平滑预测这两个标签传播步骤对于最终效果提升都是至关重要的。

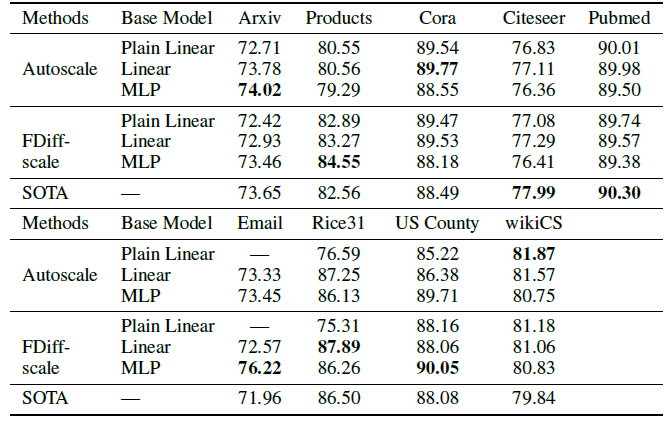

30.2.2 更多标签

可以使用验证标签是我们方法的优势,这甚至可以进一步提升我们框架的性能。

在平滑预测阶段,我们在训练节点和验证节点上使用真实标签,即:

注意:我们不使用验证标签来训练

base predictor模型,而是用于选择base predictor的超参数。通过引入验证集标签,更多的节点被指定了

ground-truth,因此网络中传播的信息量更大。下表给出了实验结果(另外,数据集统计信息表给出了相对于

SOTA的收益)。应用了验证标签之后,我们的最佳模型在9个数据集中的7个中超越了SOTA,并且具有可观的收益。可以看到:

- 融合验证标签的能力是我们方法的优势。而

GNN并没有这种优势,因为它们通常依靠早停来防止过拟合,可能并不总是从更多数据中受益(比如,在标签分布偏移shift的情况下),并且不直接使用标签。 - 对于很多数据集上的

transductive节点分类,要获得良好的性能,实际上并不需要大型的而且昂贵的GNN模型。 - 将经典的标签传播思想和简单的

base predictor相结合,在这些任务上的性能超越了GNN模型。

- 融合验证标签的能力是我们方法的优势。而

30.2.3 改善 GNN

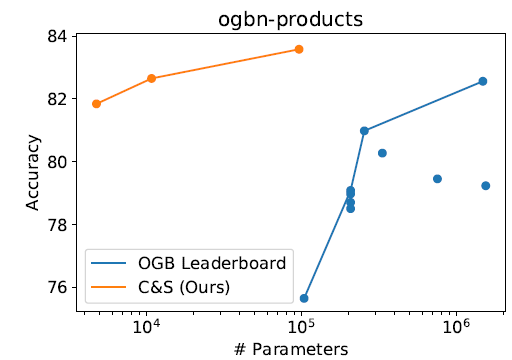

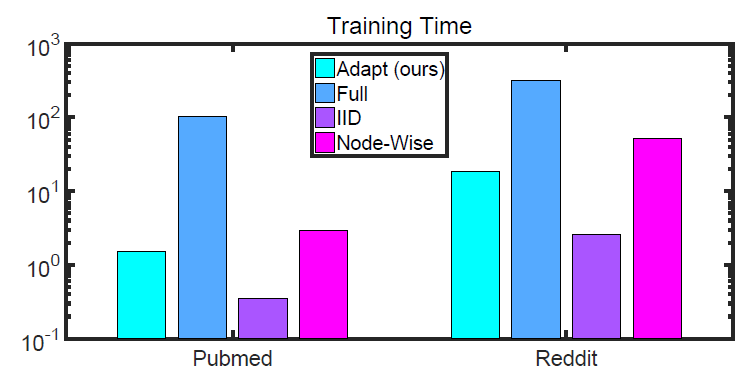

和

GNN以及其它SOTA解决方案相比,我们的C&S框架通常需要更少的参数。例如我们在下图绘制了Product数据中,不同模型的参数和性能的关系。

我们的方法不仅使用更少的参数,但真正的收益在于训练时间更快。和具有可比准确率的模型相比,我们的模型的训练时间要快几个量级。因为我们的

base prediction不需要使用图结构。例如:- 在

Arxiv数据集上,我们的MLP+C&S模型和GCN + label的模型具有相似的参数数量。但是我们的模型训练中,每个epoch的训练速度要快7倍,并且收敛速度更快。 - 在

Products数据集上,和SOTA相比,我们的linear base predictor +C&S模型具有更高的准确率,训练速度提高了100倍、参数数量减少了137倍。 - 我们还在更大的数据集

papers 100M上评估了我们的方法。这里我们以Linear + C&S模型,可以达到65.33%的准确率,比SOTA的63.29%更高。

这种比较是不公平的比较,因此

C&S方法需要节点的spectral embedding作为输入,这通常是非常昂贵的且通常无法扩展到大型图。一种解决办法是用DeepWalk来得到node emebdding,但是这种预处理也非常耗时。如果没有

spectral embedding(即,Plain Linear),则C&S的效果出现巨大的下降。而且这种依赖于人工特征工程(虽然是通过graph embedding自动计算得到)的方式不太鼓励,因为强烈依赖于经验。- 在

一般而言,我们的

pipeline还可以用于改善GNN的性能。我们将误差校正、平滑预测应用到了更复杂的base predictor上,诸如GCNII和GAT。实验结果如下表所示。这提升了我们在某些数据集上的结果,包括在

Arxiv上击败了SOTA。但是,有时性能提升只是很小的,这表明大型模型可能正在捕获与我们简单的C&S框架相同的信号。

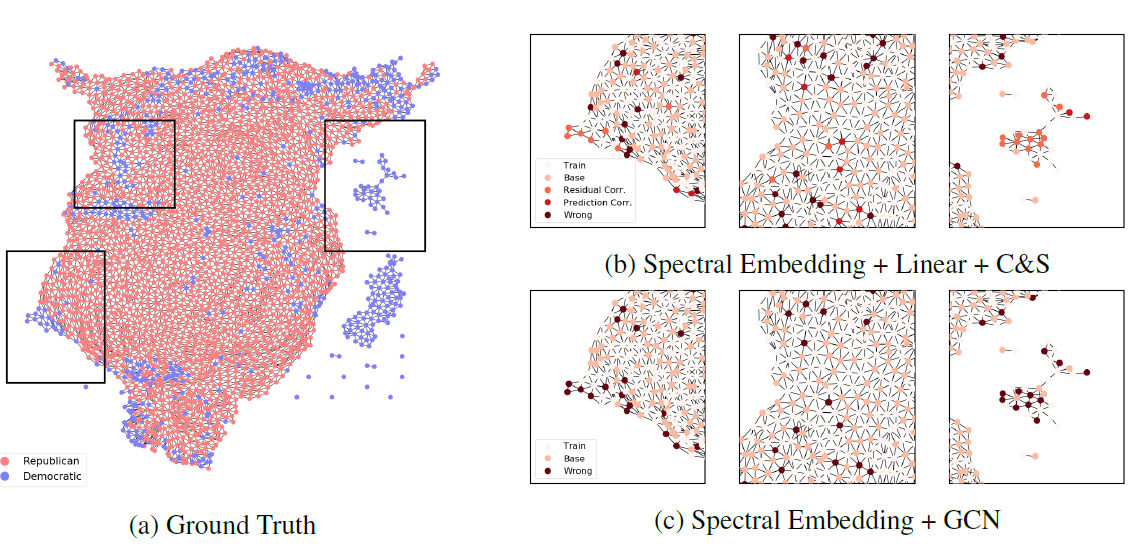

30.2.4 可视化

为了帮助理解

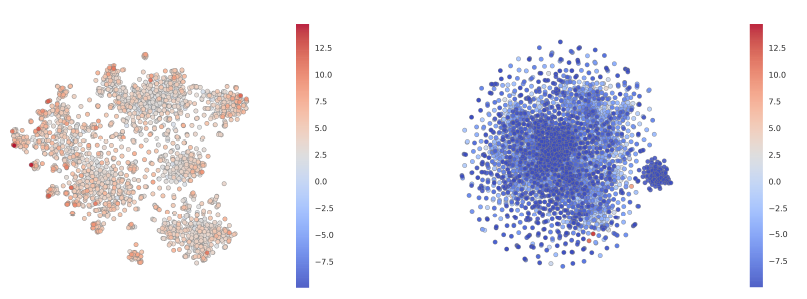

C&S框架的性能,我们在US County数据集上的预测可视化。(a):US County可视化,其中embedding由GraphViz提供,颜色对应于类别标签。总体而言是经纬度坐标的压缩旋转版本。(b):和(a)部分对应的pannel,显示C&S在哪个阶段做出了正确的预测。(c):显示了相同pannel上GNN做出的预测。

如预期的那样,残差相关性倾向于校正节点,其中临县为这些节点提供了相关信息。例如:

- 我们看到

base prediction中的很多误差已被残差相关性校正(图3b的左图和右图)。在这些情况下,对应于德克萨斯州和夏威夷州的部分地区,县的人口统计特征和全国其它地区相比是异常的,这误导了Linear模型和GCN模型。而来自相邻县的残差相关性能够校正预测。 - 我们还看到最终的预测相关性使得预测变得平滑,如图

3b的中间部分所示,这使得可以基于邻居的正确分类来校正误差。

三十一、LGCN[2018]

CNN在很多领域已经获得巨大成功,如图像领域、NLP领域。这些领域背后的一个共同点是数据可以由网格结构表示,这使得可以在输入的每个位置上应用卷积算子。但是在很多实际应用中数据是图结构,如社交网络、引文网络、生物网络。网格结构是图结构的特殊情况,因此将图像领域的深度学习模型(尤其是CNN)推广到图结构数据很有吸引力。但是,在图结构数据上应用常规卷积算子面临两个主要挑战。这些挑战来自于这样一个事实:常规卷积算子要求每个节点的邻域节点数量不变,并且这些邻域节点是有序的。论文

《Large-Scale Learnable Graph Convolutional Networks》为解决这些挑战提出了优雅的解决方案。两个挑战:图数据中,不同节点的邻域节点数量不同,并且邻域节点没有排序信息。

最近的一些研究试图将卷积算子推广到通用图结构:

GCN提出使用类似卷积的运算来聚合每个节点的所有邻域节点的特征,然后进行线性变换来生成给定节点的新的representation。可以将其视为类似于卷积的运算,但是它在两个方面和常规的卷积算子有本质的不同:首先,它不使用相同的局部滤波器来扫描每个节点。即,邻域数量不同的节点具有不同尺寸

size和权重的滤波器。其次,对于感受野

receptive field中所有的邻域节点,滤波器中的权重均相同,权重为相比之下,

CNN滤波器的权重是可训练的。

GAT采用注意力机制,通过衡量邻域节点的特征向量和中心节点的特征向量之间的相关性,从而获得邻域节点的不同、且可训练的权重。但是,

graph attention操作仍然不同于常规卷积,后者直接学习局部滤波器的权重。此外,注意力机制需要根据成对的特征向量进行额外的计算,从而在实践中导致过多的内存和计算资源需求。

和这些方法不同,论文

《Large-Scale Learnable Graph Convolutional Networks》为在通用图结构数据上应用CNN做出了两个主要贡献:首先,论文提出可学习的图卷积层

learnable graph convolutional layer: LGCL,以便能够在图上使用常规的卷积运算。注意:之前的研究修改了原始卷积运算来适配图数据。相比之下,

LGCL修改了图数据来适配卷积运算。LGCL为每个特征维度根据取值的排名自动选择固定数量的邻域节点,以便将graph数据转换为1-D格式的网格结构,从而可以在通用的graph上应用卷积运算。实验结果表明,基于

LGCL的模型在transductive learning和inductive learning的节点分类任务上均表现出更好的性能。其次,论文观察到现有方法的另一个局限性,即:现有的训练过程将整个图的邻接矩阵作为输入。当图包含大量节点时,这需要过多的内存和计算资源。

为克服这一局限性,论文提出了一种子图训练方法

sub-graph training method。该方法是一种简单而有效的方法,可以对大规模图数据进行训练。子图训练方法可以显著减少所需的内存和计算资源,而在模型性能方面的损失可以忽略不计。

31.1 模型

31.1.1 背景和相关工作

给定图

- 每个节点

- 令

degree度矩阵。degree矩阵。

- 每个节点

GCN模型中,每一层的操作可以表示为:其中:

embedding矩阵,ReLU函数。

可以看到该操作类似于卷积运算:每个节点的感受野由其本身和邻域节点组成,然后在感受野上应用一个局部滤波器。但是这种运算和

CNN中的常规卷积运算有两点区别:- 通常图数据中不同节点具有不同数量的邻域节点,这使得不同节点的感受野大小有所不同,从而导致不同的局部滤波器。这是和常规卷积运算的主要区别,在常规卷积运算中,网格数据的每个输入位置都使用相同的滤波器。

- 此外,即使对图数据使用大小不同的局部滤波器似乎是合理的,但是值得注意的是

因此,

GCN中这种不可训练的聚合操作限制了CNN在通用图数据上的能力。两点区别:

GCN中每个节点采用不同的滤波器(滤波器不会跨节点共享,且滤波器的尺寸不固定),且滤波器是不可训练的。GAT试图通过注意力机制来聚合邻域特征向量,从而使得学习聚合权重成为可能。像

GCN一样,GAT中每个节点仍然具有局部滤波器,其感受野包含节点本身及其邻域。当执行特征向量的加权和时,每个邻居节点都通过衡量它与中心节点之间的相关性来接收不同的权重。正式地,在第

其中:

attention向量。attention权重。

尽管通过这种方式

GAT向不同的邻域节点提供了不同、且可训练的权重,但学习权重的过程和常规CNN的学习过程不同。在常规CNN中,直接学习局部滤波器的权重。另外,注意力机制需要在中心节点和所有邻域节点之间进行额外的计算,这在实践中会引起内存和计算资源的问题。

和现有的这些修改常规卷积运算使得其适合通用的图数据不同,我们提出将图转换为类似网格的数据来直接应用

CNN。这个想法以前在《Learning convolutional neural networks for graphs》中有所探讨,但是该论文中的变换是在预处理过程中实现的。而我们的方法在模型中包含转换。此外,我们的工作还提出了一种子图训练方法,这是一种允许大规模图的训练的简单而有效的方法。

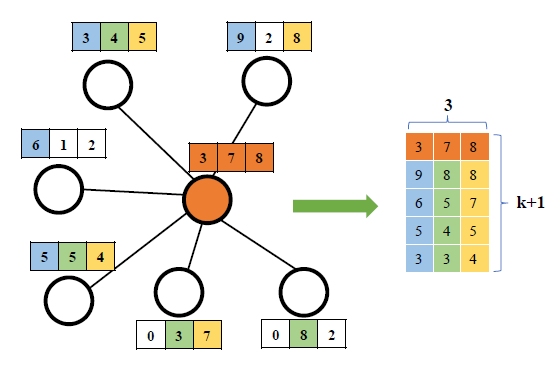

31.1.2 LGCL

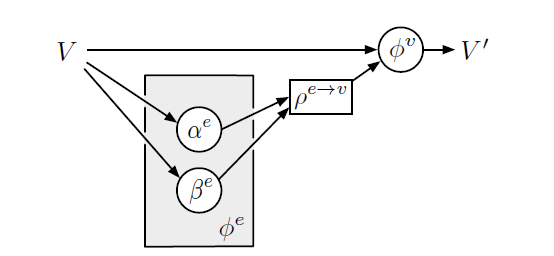

这里我们介绍通用图数据的可学习图卷积层

learnable graph convolutional layer:LGCL。LGCL的传播规则为:其中:

embedding矩阵,k-largest节点并将通用图结构转换为网格数据的操作。1-D CNN来聚合邻域信息并为每个节点输出新的representation向量。

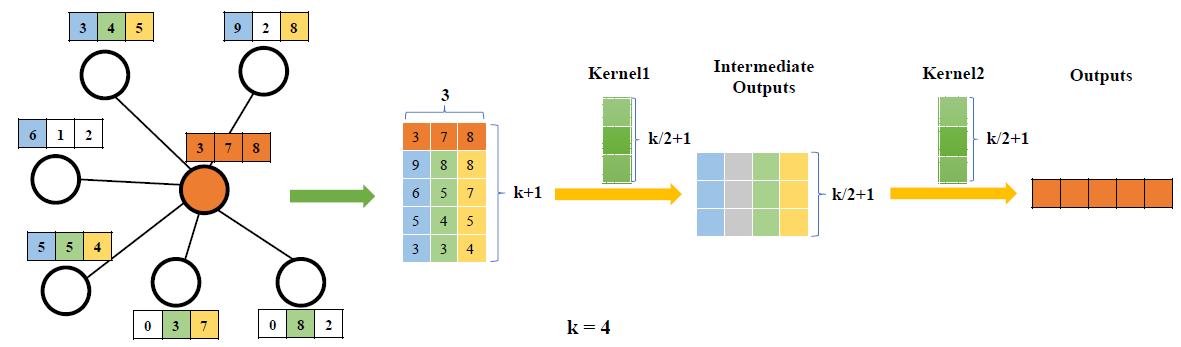

下面我们分别讨论

k-largest node selectionk-largest node selection的新颖方法,从而实现从图数据到网格数据的转换,其中LGCL的超参数。执行该操作后,每个节点将聚合来自邻域的信息,并表示为具有

1D-CNN来更新representation向量。假设

representation。representation的维度。给定邻接矩阵

representation向量拼接为矩阵:不失一般性假设

k-largest节点选择是在k-largest个节点。注意,这里是对每一列单独进行排序,而不是根据维度取值来对节点进行排序。此外,这里不仅仅是选择了最大的

CNN卷积的要求。这里的核心的两个操作是:如何

select、如何sort。除了论文里提到的这种维度独立的选择和排序,还可以选择样本独立的选择和排序:从第一个维度到最后一个维度,依次选择最后,我们将

k-largest node selection过程:中心节点具有6个邻居;对于每个特征,根据特征取值从邻域中选择四个最大的值;最后将中心节点自己的特征拼接起来得到通过在每个节点上应用这一过程,

1D网格数据,其中batch size、k-largest node selection函数k-largest node selection操作利用了实数之间的自然排名信息,并强制每个节点具有固定数量的有序邻居。

1D-CNN1D网格数据,因此我们采用1-D CNN模型LGCL的基本功能是聚合邻域信息并更新每个节点的representation,因此1-D CNN1。batch size,它和考虑节点

k-largest node selection转换的输出为由于任何常规卷积算子(滤波器尺寸大于

1并且没有填充)都会减小空间尺寸,因此最简单的同时,也可以使用任何多层

CNN,只要其最终输出的尺寸为同样地,对所有

总之,我们的

LGCL使用k-largest node selection方法将通用的图数据转换为网格数据,并应用标准的1-D CNN进行特征聚合从而为每个节点更新representation。下图为

LGCL的一个例子。考虑具有6个邻域节点的中心节点(橙色表示),每个节点具有3维特征(特征由三个分量的特征向量来表示)。LGCL选择邻近的1-D CNN来更新中心节点的representation。- 左侧描述了从邻域中为每个特征选择

k-largest节点的过程。 - 右侧给出了通过

1-D CNN作用于生成的网格数据并得到中心节点的representation。输出为5维特征(输出通道数为5)。

这里

1-D CNN的输入通道数和输出通道数都不相同,并且1-D CNN可以为任何CNN模型。这里采用了两层的

1-D卷积:第一层输入通道数为3、输出通道数为4;第二层输入通道数为4、输出通道数为5。

- 左侧描述了从邻域中为每个特征选择

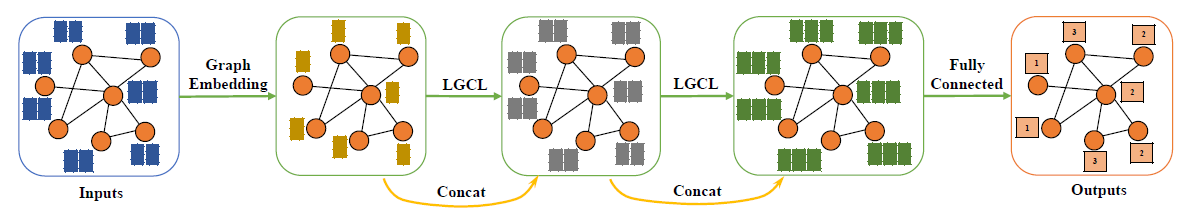

31.1.3 LGCN

众所周知更深的网络通常会产生更好的性能,但是之前

GCN之类的图模型通常只有两层,因为它们层数加深时会受到性能损失。但是在我们的LGCL中可以采用更深的层,从而为图节点分类提供可学习的图卷积网络learnable graph convolutional networks: LGCNs。我们基于

densely connected convolutional networks:DCNNs体系架构来构建LGCN,因为DCNNs在ImageNet分类挑战中获得了state-of-the-art性能。在

LGCN中,我们首先应用一个graph embedding layer来生成节点的低维representation。因为某些图数据集中,原始输入通常是很高维度的特征向量。第一层中的

graph embedding layer实际上是一个线性变换,即:其中:

也可以使用一个

GCN layer作为graph embedding layer。在

graph embedding layer之后,根据图数据的复杂性,我们堆叠了多个LGCL。由于每个LGCL仅聚合来自于一阶邻域的信息,因此多个LGCL可以收集到更大感受野中的信息。为了提高模型性能并简化训练过程,我们应用了

skip-connection来连接LGCL的输入和输出。最后,我们在

softmax输出层之前采用一个全连接层。

遵循

LGCNs的设计原理,LGCL堆叠层数是最重要的超参数。- 图中节点的平均

degree可以作为选择 LGCL层的数量取决于任务的复杂性,如类别数量、图中节点数量等。通常更复杂的任务需要更深度的模型。

- 图中节点的平均

LGCN的一个例子如下图所示。在这个例子中,输入的节点具有两维特征。首先,我们使用

graph embedding layer将输入特征向量转换为低维representation。然后,我们使用两个

LGCL层,每个LGCL层和skip-connection堆叠在一起。注意:

LGCL层和skip-connection输出是拼接起来,而不是相加。最后,使用一个全连接层和

softmax输出层用于节点分类。这里有三个不同的类别。

31.1.4 子图训练

通常而言,在训练期间,图模型的输入是所有节点的特征向量及整个图的邻接矩阵。这些模型可以在小规模图上正常工作。但是对于大规模图,这些方法通常会导致过多的内存和计算资源需求,从而限制了这些模型的实际应用。

对于其它类型的数据(如网格数据)的深度神经网络,也会遇到类似的问题。如,在处理大尺寸图像时,模型通常使用随机裁剪的

patch。受到该策略的启发,我们打算随机 “裁剪”graph从而获得较小的graph来进行训练。但是,图像的矩形

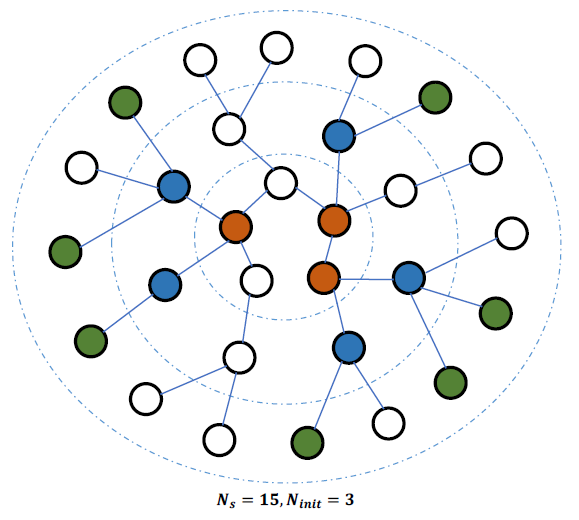

patch自然地保持了像素之间的相邻信息,而如何处理图中的节点之间的不规则连接仍然具有挑战性。这里我们提出了一种子图选择算法来解决大规模图数据上的内存和计算资源问题。具体而言,给定一个图:

- 我们首先对一些初始节点进行采样。

- 从这些节点开始,我们使用广度优先搜索

BFS算法将相邻节点迭代地扩展到子图中。 - 通过多次迭代,我们得到了初始节点和它们的高阶邻域节点。

Sub-Graph Selection Algorithm:输入:

- 邻接矩阵

- 所有节点数量

- 子图大小

- 初始的节点数量

- 每轮迭代扩展的最大节点数量

- 邻接矩阵

输出:子图的节点集合

算法步骤:

初始化

从

更新

记

当

候选节点集合为

更新

- 如果

- 如果

- 如果

更新

注:为简单期间这里我们使用单个参数

下图是一个子图选择过程的示例。我们从

- 在第一次迭代中,我们使用

BFS查找3个初始节点(橙色)中的所有一阶相邻节点(不包括它们自己)。在这些节点中,我们随机选择 - 在下一次迭代中,我们从蓝色节点的邻居中选择

经过两次迭代,我们选择了

3+5+7=15个节点并获得了所需的子图。这些节点以及相应的邻接矩阵将在训练迭代期间作为LGCN的输入。

- 在第一次迭代中,我们使用

有了这样的随机 “裁剪” 子图,我们就能够在大规模图上训练深度模型。

此外,我们可以利用

mini-batch训练策略来加速学习过程。在每次训练迭代中,我们可以使用提出的子图选择算法来采样若干个子图,然后将这些子图放到mini-batch中。相应的特征向量和邻接矩阵构成了网络的输入。子图采样也可以作为

GNN的通用策略从而帮助GNN的mini-batch训练。

31.1.5 未来方向

我们的方法主要解决节点分类问题,实践中有些任务需要对图进行分类,即图分类问题。

但是目前的图卷积方法(包括我们的方法)无法对图进行降采样(类似于图像数据的池化操作),我们需要一个

layer来有效地减少节点数,这是图分类所必须的。另外,我们的方法主要应用于通用图数据,如引文网络。对于其它数据,如文本,我们的方法也可能会有所帮助,因为我们可以将文本数据视为图。

31.2 实验

我们评估在

transductive learning和inductive learning环境下LGCN在大规模图的节点分类任务上的表现。另外,除了和

state-of-the-art模型进行比较之外,我们还进行了一些性能研究,从而研究如何选择超参数。最终实验结果表明,

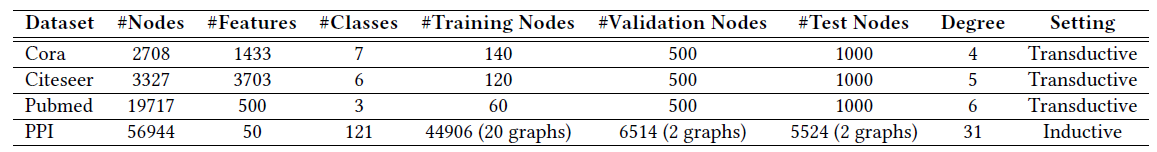

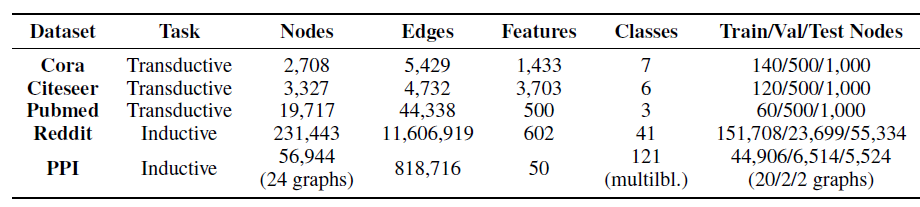

LGCN可以提高性能,并且子图训练比全图训练更有效。数据集:

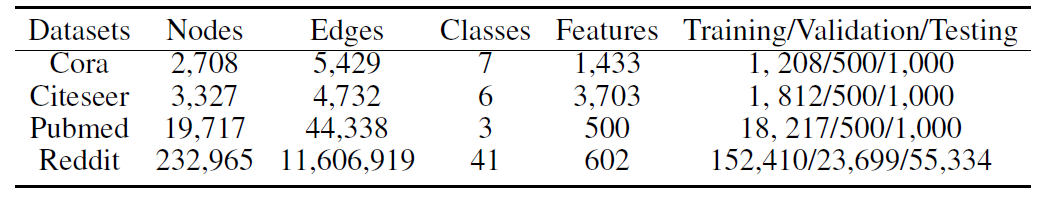

transduction Learning:在transductive learning环境下,未标记的测试节点可以在训练期间访问到,包括测试节点的特征和连接。这意味着训练期间知道包含测试节点的图结构。我们使用三个标准的

benchmark数据集:Cora, Citeseer, Pubmed。这三个数据集是引文网络数据集,节点代表文档、边代表引用关系。每个节点的特征向量是文档的bag-of-word表示。对于这三个数据集,我们采用和GCN中相同的实验设置:对于每个类别,我们选择20个节点进行训练、500个节点进行验证、1000个节点用于测试。inductive Learning:在inductive learning环境下,未标记的测试节点可以在训练期间不可用。这意味着训练期间不知道测试图的结构。在

inductive learning环境下,我们通常具有不同的训练图、验证图、测试图。在训练期间模型仅使用训练图、而无法访问验证图和测试图。我们使用

protein-protein interaction: PPI数据集,其中包含20个训练图、2个验证图、2个测试图。由于验证图和测试图是独立的,因此训练过程中不会使用它们。平均每个图包含2372个节点,每个节点包含50个特征。每个节点都有来自121个类别的多个标签。

下表给出这些数据集的统计量。

degree属性是每个数据集的平均节点degree,这有助于选择LGCL中的超参数

实验配置:

transduction Learning:由于

transductive learning数据集使用高维的bag-of-word作为特征向量,因此输入经过graph embedding layer来减小维度。这里我们使用

GCN layer来作为graph embedding layer,embedding的输出维度为32。然后我们使用

LGCL,每个LGCL使用8的特征向量。对于Cora/Citesser/Pubmed,我们分别堆叠了2/1/1个LGCL。另外,我们在

skip-connection中使用拼接操作。最后,将全连接层用作分类器以进行预测。在全连接层之前,我们执行一个简单的

sum操作来聚合邻域节点的特征向量。在每一层的输入特征向量和邻接矩阵上都应用

dropout,dropout比例分别为0.16和0.999。所有

LGCN模型都使用子图训练策略,子图大小设置为2000。

inductive Learning:除了某些超参数之外,使用和transductive learning相同的配置。- 对于

graph embedding layer,输出特征向量维度为128。 - 我们堆叠两层

LGCL, - 我们还使用子图训练策略,子图初始节点大小等于

500和200。 - 在每一层应用

dropout,dropout比例为0.9。

- 对于

对于

transductive learning和inductive learning,LGCN模型共享以下配置:- 对于所有层仅使用线性激活函数,这意味着网络中不涉及非线性。

- 为了避免过拟合,使用

L2正则化。 - 训练期间,使用学习率为

0.1的Adam优化器。 LGCN中的权重使用Glorot方法初始化。- 我们根据验证集准确率来执行早停策略,最多训练

1000个epoch。

实验结果:

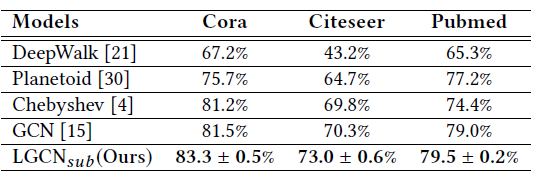

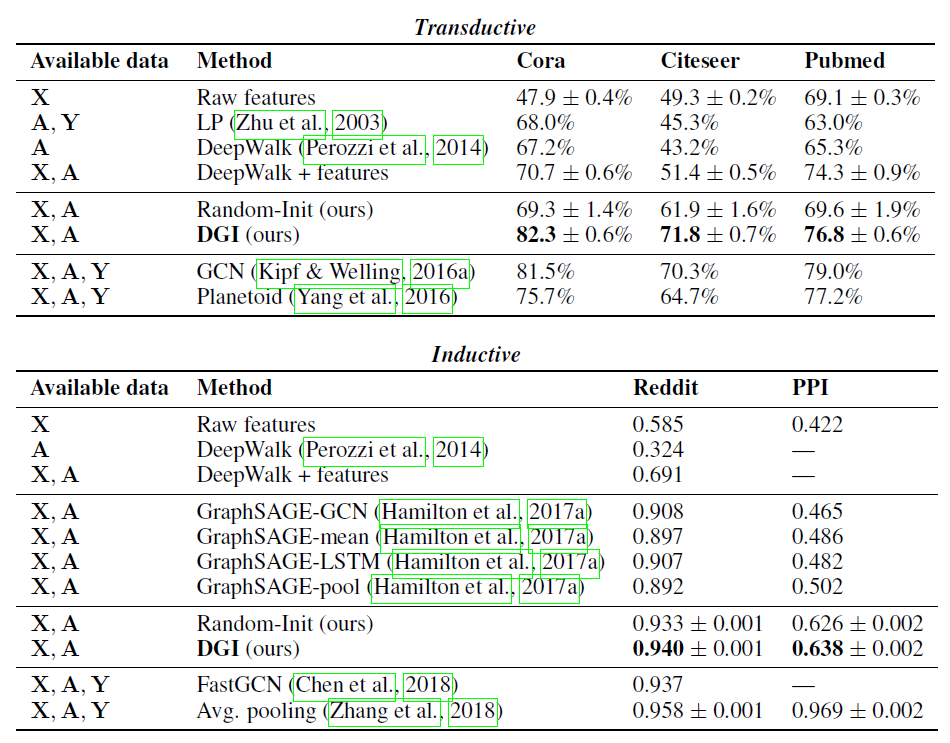

Transduction Learning实验结果:我们报告了不同模型在节点分类任务上的准确率。根据结果,LGCN模型在Cora, Citeseer, Pubmed数据集上的性能比state-of-the-art的GCN分别提高了1.8%, 2.7%, 0.5%(绝对提升)。其中LGCN模型。

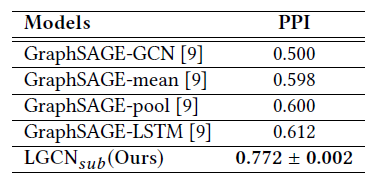

Inductive Learning实验结果:我们报告了不同模型的micro-averaged F1得分。根据结果,LGCN模型的性能比GraphSAGE-LSTM提高了16%。这表明在训练期间看不到测试图的情况下,LGCN模型仍然取得很好的泛化能力。

上述实验结果表明:

- 在通用的图数据上提出的

LGCN模型在不同节点分类数据集上一致性地达到state-of-the-art性能。 - 这些结果证明了在变换后的图数据上应用常规卷积运算的有效性。

- 另外,通过

k-largest node selection实现的转换方法被证明是有效的。

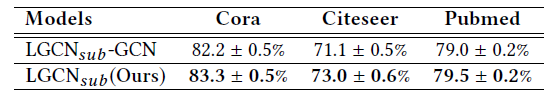

LGCL vs GCL Layer:有人认为LGCN性能的提高仅仅是因为LGCN模型采用的网络体系结构比GCN更深。但是,已有论文提出:通过堆叠更多的层来加深GCN会导致性能更差。因此,这里我们进行另一项实验:将

LGCN模型中所有LGCL替换为GCN Layer,称之为下表给出了

LGCL比GCN Layer更为有效。

子图训练

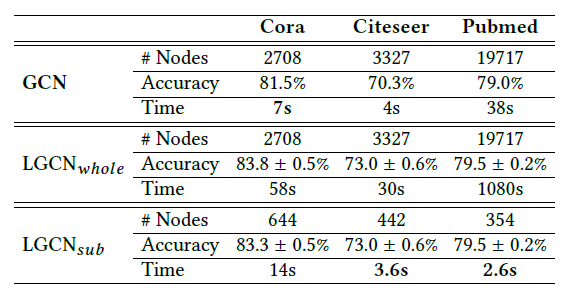

vs全图训练:上述实验中我们使用子图训练策略来训练LGCN模型,旨在节省内存和训练时间。但是,由于子图选择算法从整个图中抽取一些节点作为子图,这意味着以这种方式训练的模型在训练过程中不了解整个图的结构。同时,在transductive learning环境下,测试节点的信息可能会被忽略,从而增加了性能下降的风险。为解决这个问题,我们在

transductive learning环境下进行实验,从而比较子图训练策略subgraph training strategy和全图训练策略whole-graph training strategy。通过实验,我们证明了子图训练策略的优势,同时在模型性能方面的损失可以忽略不计。对于子图选择过程,在

transductive learning环境下我们仅从带有训练标签的节点中采样初始节点,以确保训练可以进行。具体而言,对于Cora/Citeseer/Pubmed数据集,我们分别随机采样140/120/60个初始节点。在迭代过程中,我们并没有设置2000。对于我们的GPU而言这是可行的大小。为进行比较,我们使用相同的

LGCN模型进行实验,但使用和GCN相同的全图训练策略来训练它们。这意味着输入是整个图的表示。和使用子图训练策略的下表给出了这两种模型和

GCN的比较结果:报告的节点数表示一次迭代训练使用了多少个节点;报告的时间是使用单个TITAN Xp GPU运行100个epoch的训练时间;报告的准确率是测试准确率。可以看到:

Cora/Citeseer/Pubmed数据集的子图训练中,子图的实际节点数量分别为644/442/354,远小于最大的子图大小2000。这表明这三个数据集中的节点是稀疏连接的。具体而言,从带有训练标记的几个初始节点开始,通过扩展相邻节点以形成连接的子图,只会选择一小部分节点。尽管通常将这些数据集视为一个大图,但是整个图实际上只是由彼此独立的几个单独的子图组成。子图训练策略利用了这一事实,并有效利用了带训练标签的节点。

由于只有初始节点具有训练标签,并且所有这些初始节点的连接性信息都包含在所选子图中,因此子图训练中的信息丢失量降到最低,从而导致性能损失几乎可以忽略不计。

通过对比

Cora数据集上有0.5%的微小性能损失,而在Citeseer和Pubmed数据集上却具有相同的性能。在调查了性能损失的风险之后,我们看到子图训练策略在训练速度方面的巨大优势。通过使用子图训练策略,和全图训练策略相比,

从结果可以看到,这种训练效率的提升是显著的。尽管

GCN的计算更简单,它在Pubmed之类的大规模图数据集上的运行时间比LGCN模型要长的多。通常在大规模图数据上应用强大的深度学习模型,这使得子图训练策略在实践中很有用。子图训练策略可以使用更复杂的层,如

LGCL,而无需担心训练时间。结果,带有子图训练策略的大型LGCN不仅效果好而且效率高。

超参数

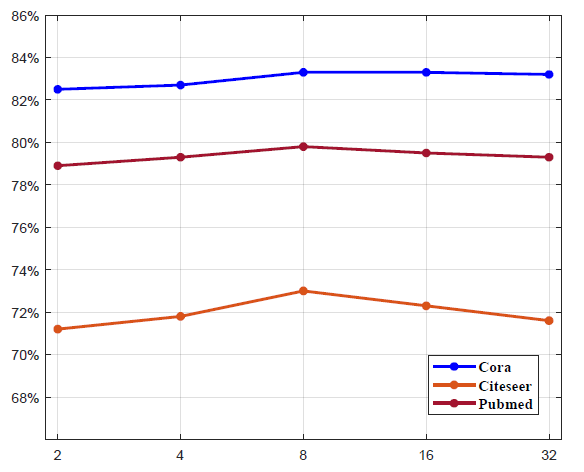

LGCN中选择超参数degree会有所帮助。这里我们进行实验来展示不同的LGCN模型的性能。我们在

Cora,Citeseer,Pubmed数据集上调整[2,4,8,16,32],这覆盖了合理范围内的整数值。下图给出了不同

LGCN模型的性能变化。可以看到:LGCN模型上的所有三个数据集在Cora, Citeseer, Pubmed数据集中,平均节点degree分别为4/5/6。这表明最佳的degree稍大一点。- 当

LGCN模型的性能会降低。可能的解释是:如果degree大得多,那么在k-largest node selection过程中使用了太多的零填充,这会不利于接下来的1-D CNN模型的性能。 - 对于

PPI数据集上的inductive learning任务,我们也探索了不同的degree为31。这和我们上面讨论的结果一致。

三十二、DGCNN[2018]

摘要:直接读取

graph并对graph进行分类,有两个挑战:- 如何编码

graph中丰富的信息从而用于分类。为此论文《An End-to-End Deep Learning Architecture for Graph Classification》设计了一个局部图卷积模型localized graph convolution model,并展示了它与两个graph kernel的联系。 - 如何以一个有意义

meaningful且一致的consistent顺序来读取一个graph。为此论文《An End-to-End Deep Learning Architecture for Graph Classification》设计了一个新颖的SortPooling层,该层以一致的顺序对图的节点进行排序,以便可以在图上训练传统的神经网络。

在

benchmark图分类数据集上的实验表明,所提出的架构与最先进的graph kernel和其他图神经网络方法相比,取得了极具竞争力的性能。此外,该架构允许使用原始图进行端到端的梯度训练,而不需要首先将图转化为向量。整个架构称之为Deep Graph Convolutional Neural Network:DGCNN。- 如何编码

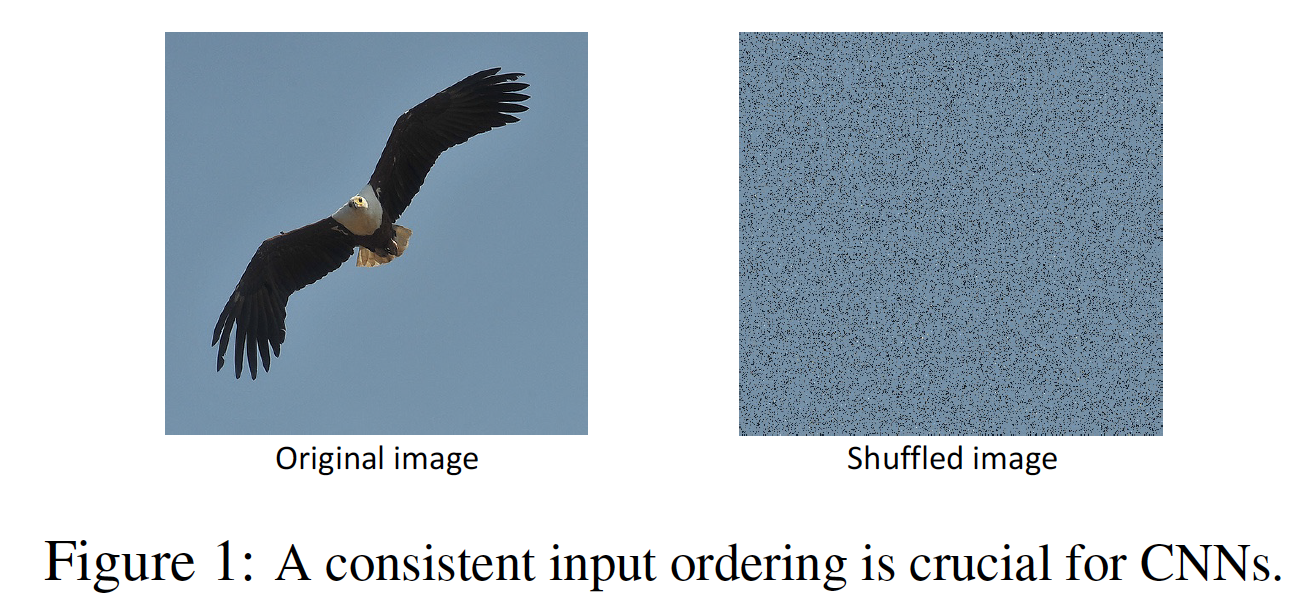

引言:过去几年中,神经网络在图像分类、自然语言处理、强化学习、以及时间序列分析等应用领域日益盛行。层与层之间的连接结构使神经网络适合处理张量形式的信号,其中张量元素以有意义的顺序排列。这种固定的输入顺序是神经网络提取高层次特征的基石。例如,如果我们随机混洗下图所示图像的像素,那么

SOTA的卷积神经网络就无法将其识别为一只鹰。

虽然图像和许多其他类型的数据都是有自然的顺序,但还有另一大类结构化数据,即

graph,它们通常缺乏具有固定顺序的张量表示tensor representation。graph的例子包括分子结构、知识图谱、生物网络、社会网络、以及有依赖关系的文本文档。有序张量表示的缺乏,限制了神经网络在图上的适用性。最近,人们对将神经网络推广到图上的兴趣越来越大:

《Spectral networks and locally connected networks on graphs》将卷积网络推广到谱域中的graph,其中滤波器应用于图的频率模式frequency mode。这个频率模式由图傅里叶变换计算得到。- 图傅里叶变换涉及到与图拉普拉斯矩阵的特征向量的昂贵乘法。为了减少计算负担,

《Convolutional neural networks on graphs with fast localized spectral filtering》将谱域滤波器参数化为特征值的Chebyshev多项式,并实现了高效的和局部化的滤波器。

上述谱域公式的一个局限性是:它们依赖于图拉普拉斯矩阵的固定频谱,因此只适合于具有固定单一结构的图。相反,空域公式不限于固定的图结构。为了提取局部特征,有几项工作独立提出在相邻节点之间传播特征。

《Convolutional networks on graphs for learning molecular fingerprints》提出了可微分的神经图指纹Neural Graph Fingerprint,它在1-hop邻居之间传播特征,以模拟传统的圆形指纹circular fingerprint。《Diffusion-convolutional neural networks》提出了Diffusion-CNN,它使用不同的权重将不同hop的邻居传播到中心节点。- 后来,

《Semi-supervised classification with graph convolutional networks》开发了针对《Convolutional neural networks on graphs with fast localized spectral filtering》提出的谱域卷积的一阶近似,这也导致了相邻节点之间的传播。 《Learning convolutional neural networks for graphs》提出了另一种空域图卷积的方式,从节点的邻域中提取固定大小的local patch,并用graph labeling方法和graph canonization工具对这些patch进行线性化处理。由此产生的算法被称为PATCHY-SAN。

由于空域方法不需要单一的图结构,它们可以被应用于节点分类和图分类任务。虽然取得了

SOTA的节点分类结果,但以前的大多数工作在图分类任务上的表现相对较差。其中一个原因是,在提取局部节点特征后,这些特征被直接sum从而用于图分类的图graph-level特征。在论文《An End-to-End Deep Learning Architecture for Graph Classification》中,作者提出了一个新的架构,可以保留更多的节点信息并从全局图的拓扑结构中进行学习。一个关键的创新是一个新的SortPooling层,它从空域图卷积中获取图的无序节点特征作为输入。SortPooling不是将这些节点特征相加,而是将它们按照一致的顺序排列,并输出一个固定大小的sorted graph representation,这样传统的卷积神经网络就可以按照一致的顺序读取节点并在这个representation上进行训练。作为图卷积层和传统神经网络层之间的桥梁,SortPooling层可以通过它来反向传播损失的梯度,将graph representation和graph learning融合为一个端到端的架构。论文贡献如下:

- 论文提出了一个新颖的端到端深度学习架构,用于图分类。它直接接受图作为输入,不需要任何预处理。

- 论文提出了一个新颖的空域图卷积层来提取多尺度

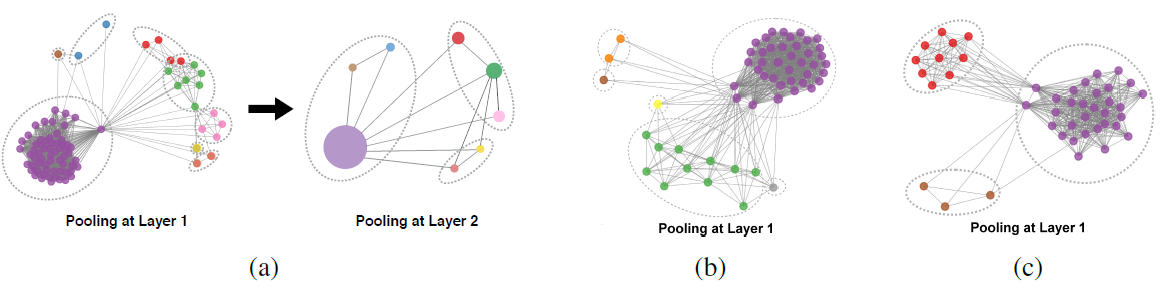

multi-scale的节点特征,并与流行的graph kernel进行类比,从而解释为什么它能发挥作用。 - 论文开发了一个新颖的

SortPooling层来对节点特征进行排序,而不是将它们相加,这样可以保留更多的信息,并允许我们从全局范围内学习。

相关工作:

Graph Kernel:Graph Kernel通过计算一些半正定的graph similarity度量,使SVM等kernel machine在图分类中变得可行,在许多图数据集上取得了SOTA的分类结果。- 一个开创性的工作是在

《Convolution kernels on discrete structures》中引入了convolution kernel,它将图分解成小的子结构substructure,并通过增加这些子结构之间的成对相似度来计算核函数kernel function。常见的子结构类型包括walk、subgraph、path、以及subtree。 《Graph invariant kernels》以一种通用的方式重新表述了许多著名的基于子结构的核,称为图不变核graph invariant kernel。《Deep graph kernels》提出了deep graph kernel,它学习子结构的潜在representation从而利用其依赖信息。

convolution kernel根据两个图的所有子结构对进行比较。另一方面,assignment kernel倾向于找到两个图的子结构之间的对应关系。《An aligned subtree kernel for weighted graphs》提出了包含显式子树对应关系的aligned subtree kernel。《On valid optimal assignment kernels and applications to graph classification》为一种类型的hierarchy-induced kernel提出了最佳分配。

大多数现有的

graph kernel侧重于对比小的局部模式。最近的研究表明,对比图的全局模式可以提高性能。《Discriminative embeddings of latent variable models for structured data》使用latent variable model表示每个图,然后以类似于graphical model inference的方式显式地将它们嵌入到特征空间。结果在准确性和效率方面与标准graph kernel相比都很好。DGCNN与一类基于structure propagation的graph kernel密切相关,具体而言是Weisfeiler-Lehman(WL) subtree kernel和propagation kernel (PK)。为了编码图的结构信息,WL和PK基于中心节点的邻居的特征迭代更新中心节点的特征。WL对hard节点标签进行操作,而PK对soft标签分布进行操作。由于这种操作可以有效地实现为随机行走,这些graph kernel在大型图上是有效的。与WL和PK相比,DGCNN有额外的参数graph kernel的两阶段框架。- 一个开创性的工作是在

用于图的神经网络:

将神经网络推广到图的研究有两条线:给定一个单一的图结构,推断单个节点的标签或者单个图的标签;给定一组具有不同结构和大小的图,预测未见过的图的类标签(图分类问题)。

在本文中,我们专注于第二个问题,这个问题更加困难,因为:图的结构不是固定的,每个图内的节点数量也不是固定的。此外,在第一个问题中来自不同图的节点具有固定的索引或对应的索引,但是在第二个问题中节点排序往往是不可用的。

我们的工作与一项使用

CNN进行图分类的开创性工作有关,称为PATCHY-SAN。为了模仿CNN在图像上的行为,PATCHY-SAN首先从节点的邻域中提取固定大小的局部patch作为卷积滤波器的感受野。然后,为了在这些patch上应用CNN,PATCHY-SAN使用外部软件(如图规范化工具NAUTY)在预处理步骤中为整个图定义一个全局节点顺序,以及为每个patch定义一个局部顺序。之后,graph被转换为有序的tensor representation,并在这些张量上训练CNN。虽然取得了与

graph kernel有竞争力的结果,但这种方法的缺点包括繁重的数据预处理、以及对外部软件的依赖。我们的DGCNN继承了其为图节点施加顺序的思想,但将这一步骤集成到网络结构中,即SortPooling层。在如何提取节点特征方面,

DGCNN也与GNN、Diffusion-CNN、以及Neural Graph Fingerprint相关。然而,为了进行graph-level分类,GNN监督单个节点(是一个虚拟的超级节点,它节点与所有其它真实节点相连),而Diffusion-CNN和Neural Graph Fingerprint使用sum的节点特征。相比之下,DGCNN以某种顺序对节点进行排序,并将传统的CNN应用于有序的representation上,这样可以保留更多的信息,并能从全局图拓扑结构中学习。

32.1 模型

给定图

0/1矩阵。并且图中没有自环self-loop。- 每个节点

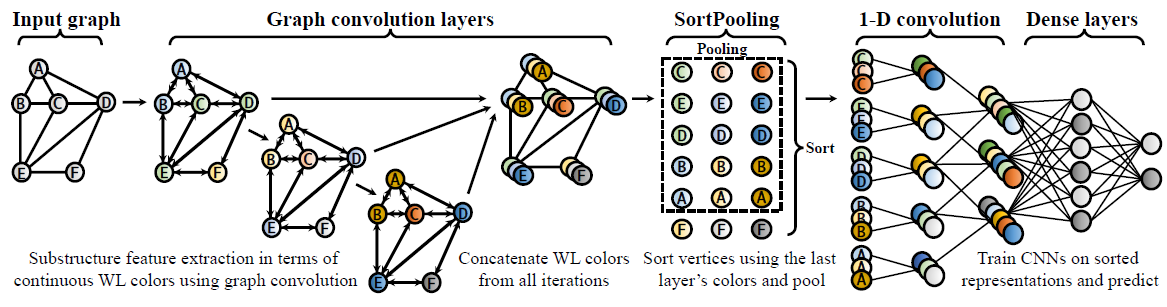

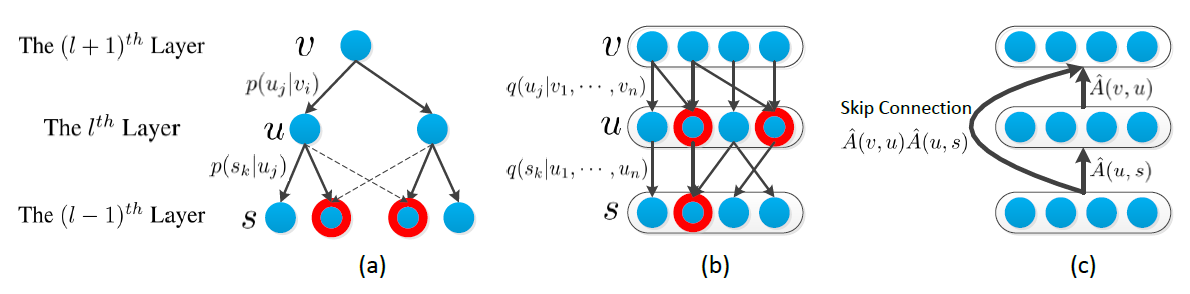

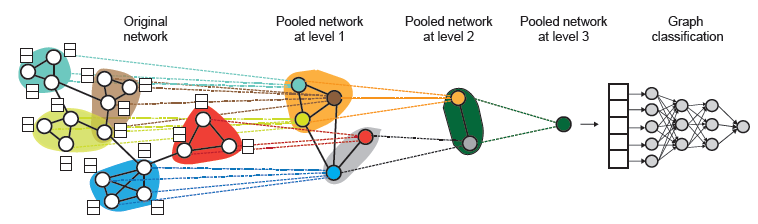

DGCNN包含三个连续的阶段:- 图卷积层

graph convolution layer抽取节点的局部子结构特征,并定义一致的节点顺序。 SortPooling层按照前面定义的顺序对节点特征进行排序,并统一输入尺寸size。- 传统的卷积层和

dense层读取排序的graph representation并进行预测。

DGCNN整体架构如下图所示:图数据首先通过多个图卷积层,其中节点信息在邻域之间传播;然后对节点特征排序并通过SortPooling层池化;然后传递给传统的CNN结构以学习模型。节点特征以颜色来可视化。

- 图卷积层

32.1.1 图卷积层

我们的图卷积层的形式为:

其中:

self-loop的邻接矩阵。

图卷积层聚合局部邻域的节点信息从而抽取局部子结构。为了抽取多尺度

multi-scale的子结构特征,我们堆叠多个图卷积层。第其中:

representation,representation。

假设一共有

拼接的结果

feature descriptor,它编码了节点的多尺度局部子结构信息multi-scale local substructure information。我们的图卷积层和

GCN层很相似,区别在于它们使用不同的传播矩阵。GCN layer采用可以证明,我们的图卷积层有效地模仿了两个流行的

graph kernel(Weisfeiler-Lehman subtree kernel、propagation kernel)的行为,这有助于解释其graph-level分类行为。WL-test对节点邻域进行反复迭代,最终根据两个图之间的节点label是否完全相同,从而判断两个图是否同构的。注:这里的label更多地是节点的离散特征,而不是节点的监督信息。WL-test迭代过程如下:聚合节点及其邻域的label;将聚合后的label经过哈希函数得到不同的、新的label,即relabel。《Weisfeiler-lehman graph kernels》根据WL-test提出了WL subtree kernel来衡量两个图的相似性。核函数利用WL tet的不同迭代中使用的节点label数作为图的特征向量。直观地讲,WL test第label代表了以该节点为根的、高度为WL subtree kernel考虑的图特征本质上是不同根子树的计数。如果我们记

我们可以视

continuous color。因此我们的图卷积公式可以视为WL-test算法的一个soft版本。soft版本有两个好处:- 首先,卷积参数

WL subtree kernel具有更好的表达能力。 - 其次,使用稀疏矩阵乘法更容易实现

soft WL-test,避免了读取和排序可能非常长的WL signature字符串。

- 首先,卷积参数

propagation kernel:PK比较了两个图的label分布,它基于扩散更新的方案diffusion update scheme:其中:

label distribution向量。其初始值就是每个节点label的one-hot。

最终将所有迭代过程中的

label distribution向量通过locality-sensitive hashing:LSH映射到离散的分桶,从而计算label distribution向量之间的相似性。PK具有和WL kernel类似的graph分类性能,甚至具有更高的效率。而我们的图卷积公式和PK非常相似。

WL kernel在hard vertex label上进行,而PK在soft label distribution上进行。这些操作都可以有效地实现为随机游走,因此这些核函数在大规模图上非常有效。和WL kernel和PK相比,DGCNN在传播之间具有其它参数,这些参数是通过端到端优化进行训练的。这允许从标签信息中进行有监督的特征学习,使其不同于graph kernel的两阶段框架。WL kernel的基本思想是将节点的颜色和其1-hop邻域的颜色拼接起来作为节点的WL-signature,然后按照字典顺序对signature字符串进行排序从而分配新的颜色。具有相同signature的节点将分配相同的新颜色。这种 “聚合--分配” 动作和我们的图卷积层是类似的,因此我们称

WL color。

32.1.2 SortPooling 层

SortPooling层的主要功能是将特征描述符输入传统的1-D卷积层和dense层之前,以一致的顺序对特征描述符进行排序,其中每个特征描述符对应于一个节点。问题是:以什么样的顺序对节点进行排序?在图像分类中,像素天然地以某种空间顺序排序。在

NLP任务中,可以使用字典顺序对单词进行排序。在图中,我们可以根据节点在图中的结构角色structural role对节点进行排序。一些工作使用

graph labeling方法(如WL kernel)来在预处理阶段对节点进行排序,因为最终的WL color定义了基于图拓扑的排序。WL施加的这种节点顺序在各个图之间是一致的,这意味着如果两个不同图中的节点在各自图中具有相似的结构角色,那么它们会被分配以相似的相对位置。结果,神经网络可以按顺序读取图节点并学习有意义的模型。在

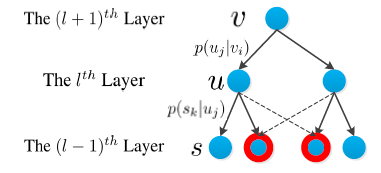

DGCNN中,我们也使用WL color来对节点进行排序。幸运的是,我们已经看到图卷积层的输出正好是连续的WL colorSortPooling层。对于SortPooling层:- 输入是一个

feature channel。 - 输出是一个

在

SortPooling层中,首先根据WL color,并根据这个final color对所有节点进行排序。通过这种方式,我们对图节点施加了一致的排序,从而可以在排序的

graph representation上训练传统的神经网络。理想情况下,我们需要图卷积层足够深(意味着- 输入是一个

基于

node representation的最后一维)。- 如果两个节点在

- 如果两个节点在

- 如果两个节点在

除了一致性的顺序对节点特征进行排序外,

SortPooling还有一个能力是统一输出张量的尺寸size。排序后,我们将输出张量的尺寸从

graph size,使得不同数量节点的图将其大小同一为- 如果

- 如果

这和

LGCN的k-largest节点选择方法很类似。只是LGCN独立地选择并排序最大的k个特征,而SortPooling根据final color选择最大的k个节点。除此之外,LGCN和DGCNN还有一个最大的区别:LGCN中,卷积层用于根据邻域节点的k-largest representation来更新中心节点的representation,因此最终用于节点分类。DGCNN中,卷积层根据所有节点的GCN representation来获得graph representation,因此最终用于图分类。

- 如果

作为图卷积层和传统层之间的桥梁,

SortPooling还有另一个好处,就是通过它可以记住输入的排序顺序从而将损失梯度传递给前一层,从而可以训练前一层的参数。相比之下,一些工作在预处理阶段对节点进行排序,因此无法在排序之前进行参数训练。

32.1.3 其它层

在

SortPooling层之后,我们得到一个大小为- 为了在

CNN,我们添加若干个1-D卷积层和最大池化层,从而学习节点序列上的局部模式。 - 最后我们添加一个全连接层和一个

softmax输出层。

- 为了在

32.1.4 讨论