基于会话的推荐

注:会话 session 通常意味着短期的用户行为序列。

一、FPMC[2010]

在

next basket recommendation任务中,我们已知用户在各个时刻购买的basket的item,目标是向用户推荐该用户下一次访问时可能想要购买的item。基于马尔科夫链

Markov Chain: MC模型的推荐系统通过上一个动作来预测下一个动作,从而利用这种序列数据。MC估计了一个概率转移矩阵transition matrix,它给出了已知上一个动作的情况下,发生下一个动作的条件概率。预测时,模型对每个用户的最近一次行为应用概率转移矩阵从而进行推荐。然而,

MC模型的概率转移矩阵对所有用户都是相同的,即非个性化的。另一方面,协同过滤方法(如矩阵分解

matrix factorization: MF)学习了个性化的、用户的一般兴趣general taste,而忽略了序列信息。

MC和MF各有优势:MC可以通过非个性化的概率转移矩阵来及时地捕获序列效果(即,概率转移矩阵是在所有用户的所有数据上学习的),而MF可以通过所有数据来学习个性化的、每个用户的一般兴趣。在论文

《Factorizing Personalized Markov Chains for Next-Basket Recommendation》中,论文提出了一个基于个性化MC的模型,其中概率转移矩阵是user-specific的。具体而言,论文建模了一个概率转移立方体transition cube,这个立方体的每个切面都是user-specific概率转移矩阵。通过这种个性化,论文将MC和MF的优点结合在一起:序列数据由概率转移矩阵捕获;由于所有概率转移矩阵都是user-specific的,因此模型捕获了个性化的用户兴趣。除了引入个性化

MC之外,这项工作的核心贡献是估计概率转移张量transition tensor(即概率转移立方体)。由于数据的稀疏性,不可能通过在完全参数化complete parametrization上使用标准计数方法(即,最大似然估计的估计Maximum Likelihood Estimator: MLE)来获得个性化概率转移矩阵的良好估计。相反,论文通过一个分解模型factorization model来建模概率转移张量。这允许在相似的用户、相似的item、以及相似的转移之间传播信息。通过使用基于pairwise interaction的MF,模型能够处理高度稀疏性。论文表明,该模型包含了个性化的MF模型、以及非个性化的MC模型。为了学习模型参数,论文将Bayesian Personalized Ranking: BPR框架扩展到next basket recommendation。最后,论文将所提出的方法应用到真实的电商数据集,实验结果表明所提出的方法优于

MF和MC模型。总而言之,论文的贡献如下:

- 论文引入了依赖于个性化的概率转移矩阵的个性化

MC,这允许我们同时捕获序列效应和长期用户兴趣。论文证明这是标准MC和MF的推广。 - 为了处理转移概率估计的稀疏性,论文引入了一个可以应用于个性化概率转移矩阵的分解模型。这种分解方法导致参数更少,并且由于泛化能力导致它比完全参数化的模型更好的质量。

- 论文的实验表明,所提出的模型在序列数据上优于其它

state-of-the-art方法。

相关工作:

- 一些研究人员已经研究了马尔科夫链或推荐系统。我们没有使用启发式方法来改善最大似然估计,而是使用为优化

ranking(而不是优化MLE)而学习的分解模型。总体而言,我们的工作与之前所有方法的主要区别在于使用个性化的概率转移矩阵,这结合了序列的好处(如时间感知、具有时不变用户兴趣的马尔科夫链)。此外,转移概率的分解和用于ranking的参数优化准则是新提出的。 - 另一方面,大多数推荐系统未考虑序列模式,而是基于整个用户历史进行推荐。最近,来自隐式反馈的

item推荐已经开始成为热点。item推荐是相比评分预测更难的问题,因为只有正反馈而没有负反馈,因此无法直接应用标准的回归方法或分类方法。最近人们提出了一些基于矩阵分解的模型,这些模型分解了user-item相关性矩阵correlation matrix。在这项工作中,我们将这些MF模型的优点与MC模型结合起来。

- 一些研究人员已经研究了马尔科夫链或推荐系统。我们没有使用启发式方法来改善最大似然估计,而是使用为优化

1.1 模型

生成推荐的最常见方法是丢弃任何序列信息并学习用户的一般兴趣。另一方面,序列方法(主要依赖于马尔科夫链)的推荐仅基于最近的用户事件来学习相邻购买行为的关联。这两种方法都各有优缺点。

令

item集合,item数量。假设用户

busket为busket集合为busket为next basket recommendation任务是:在用户下次访问商店的时候向用户推荐item。注意,我们处理的不是绝对时间,而是关于用户的相对时间,如用户busket、第二个busket等等。因此该方法未考虑时间信息(绝对时间、相对时间间隔),仅考虑相对次序。

next basket recommendation推荐任务可以公式化为:为用户busket中的所有item创建个性化的ranking函数ranking函数,我们可以向用户推荐top n item。首先,我们为顺序的集合

sequential set引入MC,并将其扩展到个性化MC。然后,我们讨论概率转移立方体transition cube的最大似然估计的弱点。然后,为解决这个问题 ,我们引入了分解的概率转移立方体 ,其中转移之间的信息被传播。最后,我们结合了所有的思想从而得到FPMC模型。

1.1.1 用于集合的个性化马尔科夫链

a. 用于集合 Set 的马尔科夫链

通常,阶次为

其中:

在非集合的推荐应用

application中,随机变量是在itembasket上的,因此其状态空间大小是basket,它包含不同item的组合有为了处理这个巨大的状态空间,我们做了两个简化:

我们使用长度为

对于

basket场景,在非集合的推荐场景中,通常可以选择更长的马尔科夫链(如

item。在我们的case中,即使长度为basket包含很多item。例如,在我们评估的application中,平均每个basket大约有10个item。我们简化了转移概率

transition probability。长度为

basket上建模转移,而是在描述了basket状态的item是否包含在当前basket中)上建模转移:itembasket的情况下,下一个basket中出现item这种建模方式意味着:

状态空间现在是

状态空间的元素是二元变量,因此

因为下一个

basket可能包含很多item,使得

对于

item推荐,我们感兴趣的是:在给定用户最近一个basket的情况下购买某个item的概率。这可以定义为从最近一个basket到该item的所有转移概率的均值:这里假设最近一个

basket中所有item对于next itemattention的DNN模型,从而得到交互的、非线性的、自适应权重的模型。basket上完全的马尔科夫链可以表示为:注意,我们的目标是寻求

item ranking list,因此对完全的马尔科夫链item概率

b. 转移概率的估计

给定所有用户的所有历史

busket其中:

- 分子为所有历史

busketbasket、basket的basket pair数量。 - 分母为所有历史

busketbasket的basket pair数量。

这里基于统计的方法来估计

item的存在对于概率的影响。即,认为basket中所有item对于next item- 分子为所有历史

c. 用于集合的个性化马尔科夫链

上述的马尔科夫链是非个性化的,即与用户无关。现在我们将其扩展到个性化马尔科夫链

item的转移概率来表示每个马尔科夫链,但是现在是user-specific的:同样地,预测结果也是

user-specific的:同样地,这里假设最近一个

basket中所有item对于next item这意味着对于每个用户

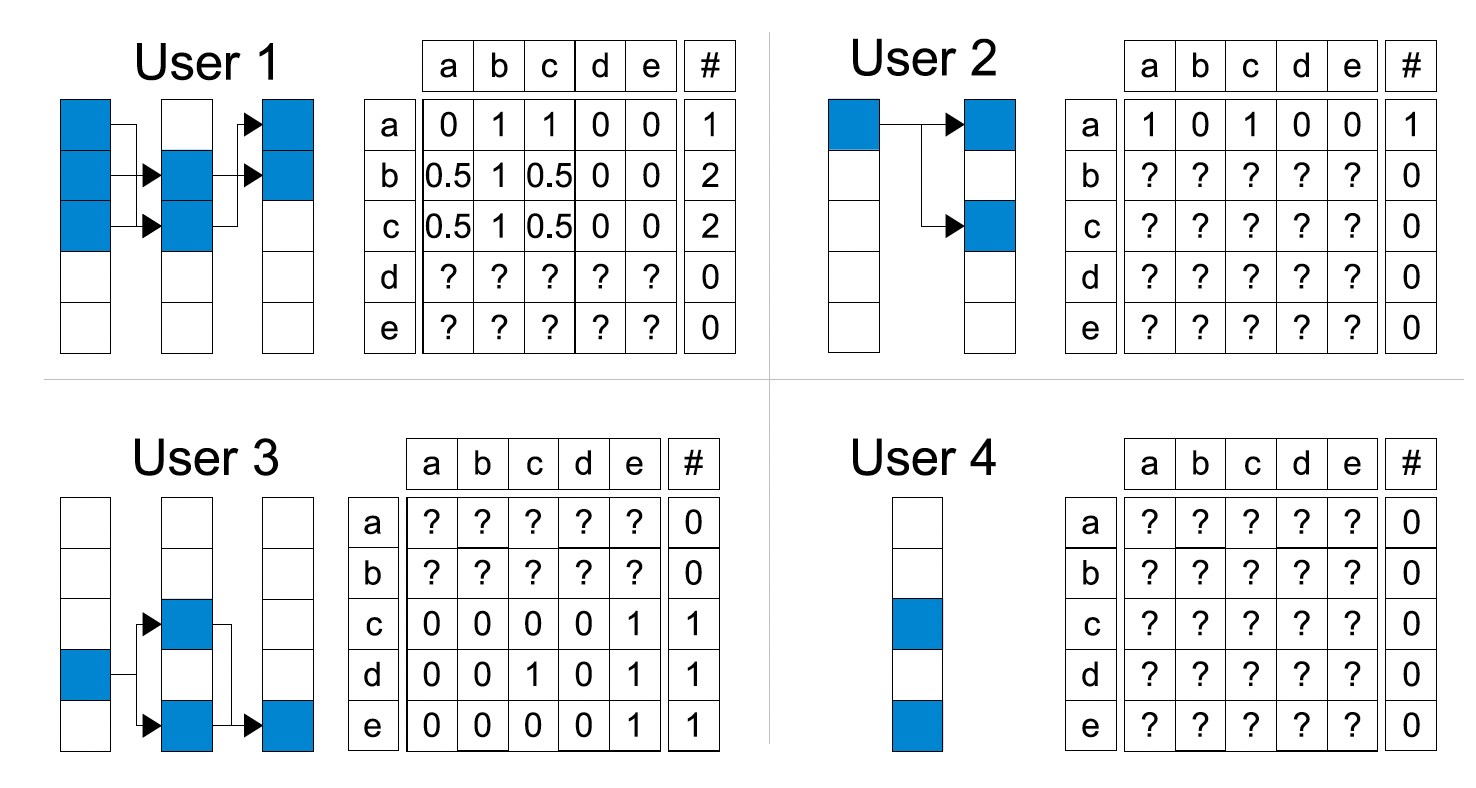

下图展示了个性化概率转移矩阵的一个例子。许多参数无法估计(图中以

?标记 ),因为没有对应的观察数据。此外,估计的转移概率仅基于少量观察数据,这意味着这些估计是不可靠的。乍一看,使用个性化马尔科夫链似乎是不合理的,接下来我们将讨论导致错误估计的原因是什么,并展示如何解决它。

d. 最大似然估计和完全参数化的局限性

非个性化马尔科夫链和个性化马尔科夫链的不可靠转移概率的问题在于:它们使用完全参数化

full parametrization的转移图transition graph(即转移矩阵、转移立方体)、以及参数估计的方式。完全参数化意味着我们分别有

此外,最大似然估计独立地估计每个转移概率参数

此外,最大似然估计的重要性质(如高斯分布、无偏估计、无偏估计的最小方差)仅存在于渐进理论中。当数据较少的情况下,最大似然估计会遭受欠拟合。由于我们的场景中数据非常稀疏,因此最大似然估计很容易失败。

即模型的容量空间太大,数据量太少,导致模型欠拟合。

为了得到更可靠的转移概率估计,我们分解了概率转移立方体。这种方式打破了参数的独立性、以及估计的独立性。这样,每个转移概率都受到相似用户、相似

item、以及相似转移的影响,这是因为信息通过该分解模型进行传播。

1.1.2 分解转移图

我们对概率转移立方体

概率转移立方体的分解:用于估计概率转移立方体

Tucker Decomposition: TD:其中:

core tensor,item的特征矩阵(outgoing节点)。item的特征矩阵(ingoing节点)。

Tucker Decomposition包含其它分解模型,如Canonical Decomposition: CD(也称作并行因子分析parallel factor analysis: PARAFAC)。CD假设core tensor是对角矩阵,即:并且因子分解的维度相等,即

由于观察到

CD的一种特殊情况来建模pairwise交互:这里类似于

FFM的思想,每个field都有两个embedding从而与不同的其它field进行交互。此外,这里的

core tensor对角线为1,意味着不同的field交互的重要性都是相同的。能否自动学习不同field交互的重要性?该模型直接建模张量的所有三种模式之间的

pairwise交互,即user和next item之间、user和last item之间、以及last item和next item之间的交互。对于每种模式,我们有两个分解矩阵:- 对于

user和next item之间的交互:next item特征。 - 对于

user和last item之间的交互:last item特征。 - 对于

last item和next item之间的交互:next item特征,last item特征。

该模型优于

TD的一个优点是:预测和学习复杂度远远低于TD。此外,即使TD和CD包含了上述pairwise交互模型,但是它们无法识别到pairwise交互模型。我们提出的分解概率转移立方体的模型也可以用于非个性化的概率转移矩阵

总结:将个性化的、集合的马尔科夫链与分解的概率转移立方体相结合,则得到分解的个性化马尔科夫链

factorized personalized Markov chain: FPMC:其中我们通过被分解的立方体

因为

user和next item之间的交互可以看到

FPMC的预测结果可以分为几个部分:user和next item之间的交互,建模next item与用户长期偏好的关系,因为这部分与时间last item和next item之间的交互,建模next item与用户短期偏好的关系。user和last item之间的交互,这一部分可以建模了用户长期偏好和用户短期偏好的关系。随后的章节中,论文证明这个部分可以被移除。

所有的这些部分都可以用更复杂的模型(如

DNN)、引入更多的辅助信息(如用户画像、item画像)来刻画。在接下来的章节中,我们将

FPMC模型应用于item推荐任务。我们将证明,在这种情况下模型可以进一步简化,此时user和last item之间的交互可以移除。与完全参数化的概率转移立方体相比,分解模型的泛化性能更好、且参数更少。

- 完全参数化的模型需要

- 分解模型只需要

对于具有大量

item的application而言,使用

1.1.3 Item 推荐

前面已经介绍了个性化马尔科夫链的分解模型,接下来我们将该模型应用于

item推荐任务中。这意味着模型参数应该针对ranking进行优化。首先,我们从

sequential set数据中导出S-BPR,它是item推荐的通用优化准则。该优化准则不仅可用于我们的FPMC模型,还可用于其他模型,如kNN或标准MF模型。其次,我们将

S-BPR应用于FPMC,并展示了在使用S-BPR进行item推荐的情况下如何简化模型。最后,我们提出了一种基于

bootstrap采样的随机梯度下降学习算法,用于使用S-BPR优化模型参数。这个

bootstrap采样的随机梯度下降学习算法就是mini-batch随机梯度下降学习算法。

a. S-BPR 优化准则

如前所述,从

sequential basket数据中推荐item的目标是推导出item的ranking函数ranking,我们假设有一个估计量ranking:其中

由于

total order,所以item集合接下来我们导出类似于通用

BPR方法 的sequential BPR: S-BPR优化准则。用户raking其中

假设

basket和用户独立,这导致模型参数的最大后验maximum a posterior: MAP估计:对所有

item pairbasket内的next item之间是相互独立的(来自于BPR原始论文的假设),则然后我们用模型定义

这里我们忽略参数

sigmoid函数,则有:进一步地,我们假设模型参数

S-BPR的MAP估计:其中

S-BPR和BPR的核心区别在于:BPR的(positive, negative) pair中,negative是用户item之外选取,即全局负样本。S-BPR的(positive, negative) pair中,negative是用户basket item(即positive所在的basket)之外选取,即局部负样本。

b. 采用 FPMC 的 Item 推荐

首先,我们用

FPMC模型来表示S-BPR:引理一(

user和last item之间分解的不变性):对于使用S-BPR的item排序和优化,FPMC模型对于user和last item之间的分解是不变的,即证明过程见原文。主要思路:令

则可以证明:

- 两个模型

- 两个采用

S-BPR的模型最优化得到相同的参数解

因此对于采用

FPMC的item推荐,我们使用新的- 两个模型

然后,我们将展示简化的

FPMC模型与标准的矩阵分解matrix factorization: MF和分解马尔科夫链factorized Markov chain: FMC的关联。用于

item推荐的标准MF模型为:其中

非个性化的分解马尔科夫链

FMC模型为:

因此,

FPMC是MF模型和FMC模型的线性组合:这意味着

FPMC可以包含这两种模型:- 通过将

user和next item之间分解的维度设为0,即FMC。 - 通过将

last item和next item之间分解的维度设为0,即MF模型。

需要注意的是:

item推荐中,即使FPMC的模型方程可以通过MF和FMC模型的线性组合来表示,但是FPMC不同于单个MF模型和单个FMC模型的线性组合。因为FPMC模型的参数是联合学习的,而不是每个子模型(如MF模型和FMC模型)单独学习的。这在FPMC的通用情况下更为明显,其中FPMC的模型方程 无法由MC和FMC的线性组合来表示,如:- 当

FPMC优化另一个准则(如最小平方误差)而不是S-BPR准则时,其中user和last item之间的分解不能被丢弃,因为这个准则下的不变性(即引理一)不成立。此时FPMC的模型方程无法由MC和FMC的线性组合来表示。 - 当

FPMC中为张量TD或CD)而不是pairwise交互时,此时即使采用S-BPR优化准则,则FPMC的模型方程也无法由MC和FMC的线性组合来表示。

- 当

c. 最优化

FPMC包含MF和FMC,而这两个模型也可以使用它们各自所提供的的算法针对S-BPR准则进行优化。尝试直接优化

S-BPR非常耗时,因为basket-wise随机梯度下降方法的收敛速度非常慢。相反,我们通过bootstrapp独立地随机抽取四元组,并对这些样本进行随机梯度下降。在每次迭代中,我们随机抽取一个四元组basketitembasket中的itemS-BPR执行梯度下降。算法的复杂度为basket大小。感觉这就是常规的

mini-batch随机梯度下降。

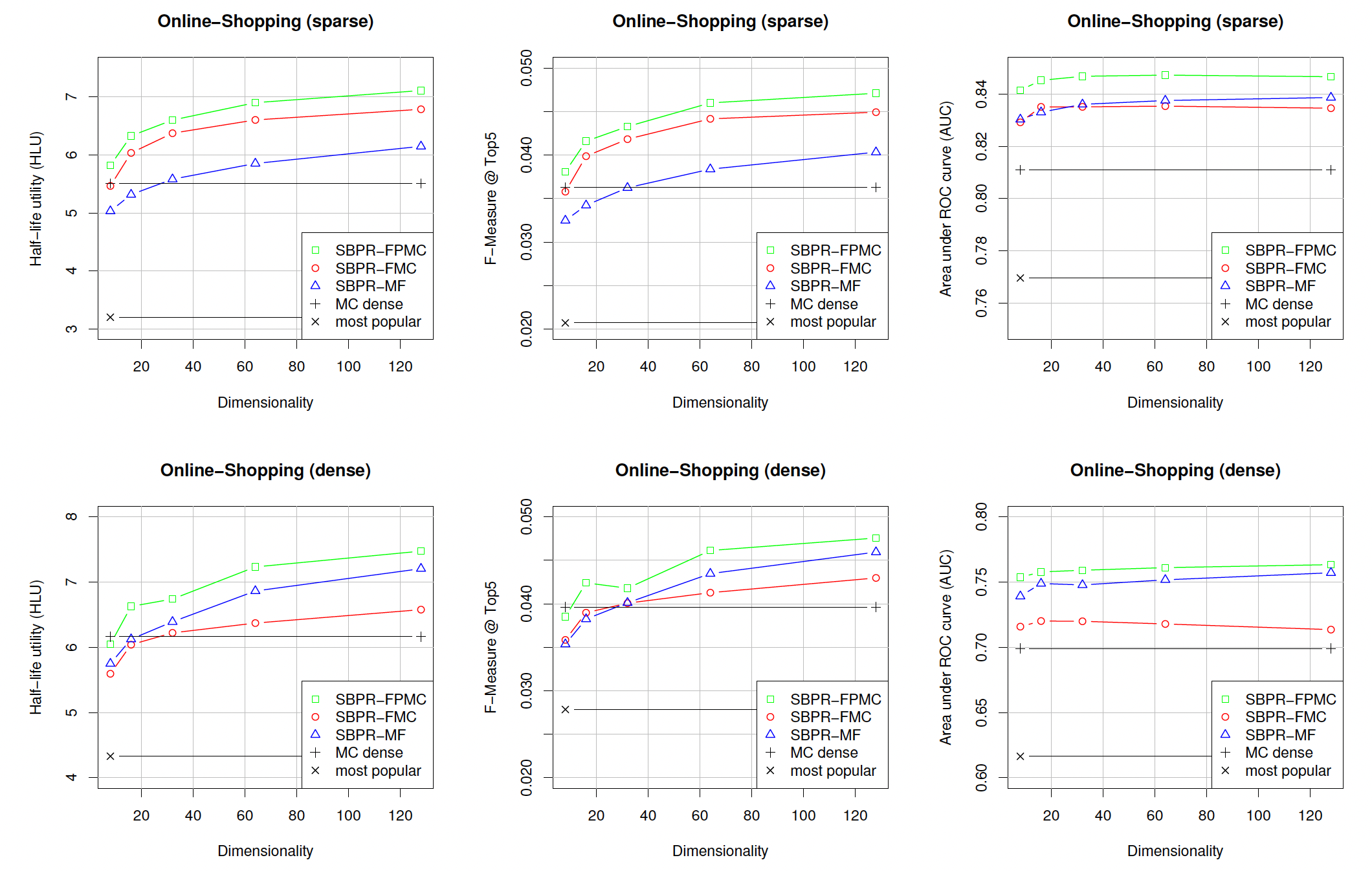

1.2 实验

baseline方法:factorized Markov chain: FMC、non-factorized Markov chain: MC dense、matrix factorization: MF、最流行most-popular: MP。注意,这里包含很强的

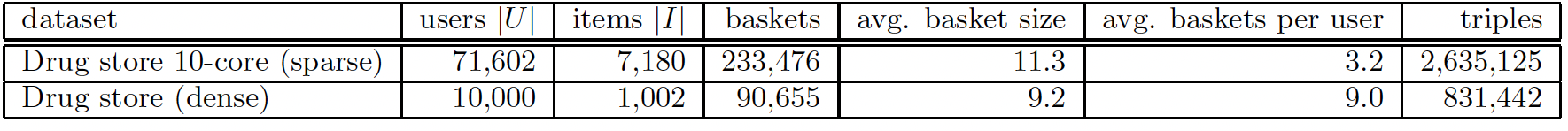

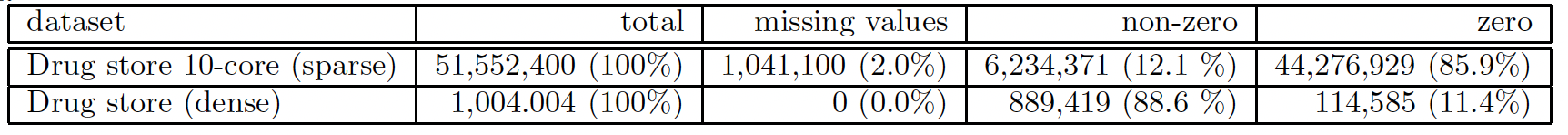

baseline方法BPR-MF。由于MF和FMC都是FPMC的特例,因此对于这三种方法我们都是用FPMC的学习算法。数据集:我们使用在线药店的匿名购买数据集。我们使用的数据集是一个

10 core子集,其中每个用户总共至少购买了10个item,每个item至少被10个用户购买。我们还创建了它的一个子集,其中包含10000个最多购买的用户、以及1000个最多购买的item,从而评估稀疏性对方法的影响。

评估方式:我们将每个用户的最后一个

basket作为测试集,并将剩余的basket作为训练集。我们从测试集中删除了过去购买少于10种不同item的用户。对于每个用户,我们从测试集中删除该用户已经购买过的所有

item,这是因为我们希望向用户推荐其不知道的新品。这使得预测任务变得更加困难。否则,对于牙刷、清洁剂等药店中的非耐用品,仅重复推荐已购买商品将是一个简单的、但是非常成功的策略。然而,这不是推荐系统的任务,因为推荐系统应该帮助用户发现新事物。我们针对每个用户

basket来测试不同模型的质量。评估指标:Half-life-utility: HLU:测试basket中每个next item的归一化衰减因子之和。其中,归一化衰减因子为:next item在所有我们报告所有测试

basket的HLU均值。Precision:top K预估结果中,命中next item的item数量除以Recall:top K预估结果中,命中next item的item数量除以测试basket的大小。这里我们选择此外,我们还报告

F-measure指标,它是Precision和Recall的调和均值。AUC:Area under the ROC curve。

实验结果如下图所示。对于分解方法,我们使用

- 正如预期的那样,所有其它方法都优于

most-popular方法。 - 其次,在合理的分解维度(如

32)下,所有其它分解方法都优于标准MC方法(即MC dense)。 - 总体而言,

FPMC优于所有其它方法。

我们比较

FMC和MC。结果表明:学习分解的概率转移矩阵相比通常的计数方案counting scheme产生更好的估计。分解方法有两个优点:它的参数规模更小,并且通过使用低秩近似来防止过拟合。我们比较

FMC和MF。可以看到:在稠密场景下MF似乎优于FMC,而在稀疏场景下FMC似乎更胜一筹。原因可能是:- 在稠密场景中,每个用户的信息要多得多,因此使用所有全部用户购买信息的

MF方法,要优于仅使用最后一次购买的FMC方法。 - 反之,

FMC在稀疏数据集上具有优势。而结合了这两种方法优点的FPMC在两个数据集上都优于它们。

- 正如预期的那样,所有其它方法都优于

二、GRU4Rec[2015]

有些电商推荐系统、新闻网站、媒体网站不会跟踪用户

ID。虽然cookie和浏览器指纹技术可以提供一些程度上的用户识别,但是这些技术通常不可靠并且容易引发隐私问题。即使可以跟踪用户ID,但是用户在一些小型电商网站上可能只有一两个会话session,并且在某些领域(如分类网站classified site)中,用户的行为通常表现出session-based的特征。因此,同一个用户的每个会话应该独立地处理。在中国的互联网早期,存在大量的、可以匿名访问的网站或

APP,因此不会跟踪用户ID。随着移动互联网浪潮的兴起,中国互联网大多数网站或APP需要登录才能访问,典型的例子是淘宝,因此可以跟踪到用户ID。即使能够跟踪到用户ID,我们也无法保证操作手机的是同一个用户。目前大多数电商的

session-based的推荐系统都使用相对简单的方法,如item-to-item相似性、item共现、转移概率等等。虽然有效,但是这些方法仅考虑用户的最后一次行为,而忽略了用户的历史行为。此外,推荐系统中最常用的是因子模型

factor model和邻域方法neighborhood method。- 因子模型将稀疏的

user-item交互矩阵分解为一组user潜在因子向量和item潜在因子向量来完成矩阵补全问题(例如用潜在因子向量的内积)。由于无法跟踪用户ID(导致无法获取用户历史交互的item),所以因子模型很难应用于session-based的推荐。 - 邻域方法依赖于会话内的

item共现,因此被广泛应用于session-based推荐中。

RNN在翻译、对话建模、图像标注image captioning等领域取得了显著成功,但是很少有人将其用于推荐领域。在论文《Session-Based Recommendations With Recurrent Neural Networks》中,作者认为RNN可以应用于session-based推荐并取得了显著效果。作者处理了在建模这类稀疏序列数据进行时出现的问题,并通过引入适当的、新的ranking loss function来使得RNN模型适应推荐setting。session-based推荐问题在建模方面与一些NLP-related问题相似,比如它们都处理序列数据。在session-based推荐中,我们可以将用户在会话中的第一个交互item作为RNN的初始输入,然后我们根据这个初始输入来query模型从而获得推荐。然后,用户的每次后续交互都会产生一个推荐,这个推荐取决于所有先前的、同一个会话内的交互。item集合可能是数万甚至数十万,另外交互行为可能非常频繁,因此训练时间和可扩展性非常重要。和大多数信息检索和推荐

setting一样,论文主要关注于建模用户最感兴趣的top item,为此论文使用ranking loss function来训练RNN。- 因子模型将稀疏的

相关工作:

session-based推荐:推荐系统领域的大部分工作都集中在当user ID可用并且可以获取用户画像时的模型上。这种情况下,矩阵分解模型、邻域模型在文献中占据主导地位。session-based推荐中采用的主要方法之一是item-to-item推荐,此时item-to-item相似度矩阵是从可用的会话数据中预计算而来,也就是说,在同一个会话中共现的item被认为是相似的。这种方法虽然简单但是已被证明有效,并被广泛采用。但是,该方法仅考虑用户的最近一次行为,忽略了用户历史行为信息。session-based推荐的另一个稍微不同的方法是马尔科夫决策过程Markov Decision Processes: MDP。MDP是序列随机决策问题的模型,最简单的MDP本质上是一阶马尔科夫链,其中next推荐可以简单地根据item之间的转移概率来计算。 在session-based推荐中应用马尔科夫链的主要问题是:当试图包含所有可能的用户行为序列时,状态空间很快变得无法管理。通用分解框架

General Factorization Framework: GFM的扩展版本能够使用会话数据来推荐。该方法通过事件event的sum来建模会话,并对item使用两种潜在representation:一种代表item本身、另一种代表item是会话的一部分。然后将会话中所有item的第二种representation取平均从而作为会话的representation。但是,该方法不考虑会话中的行为顺序。推荐系统中的深度学习:在推荐系统中最早应用深度学习的相关方法之一是

《Restricted boltzmann machines for collaborative filtering》,它使用RBM来对user-item交互进行建模并执行推荐。此外,深度模型也用于从音乐或图像等非结构化内容中提取特征,然后与更传统的协同过滤模型一起使用,如《Deep content-based music recommendation》。最近,《Collaborative deep learning for recommender systems》引入了一种更通用的方法,该方法使用深度网络从任何类型的item中抽取通用的内容特征,然后将这些特征集成到标准的协同过滤中从而提高推荐性能。这些方法在缺乏足够user-item交互的setting中特别有用 。

2.1 模型

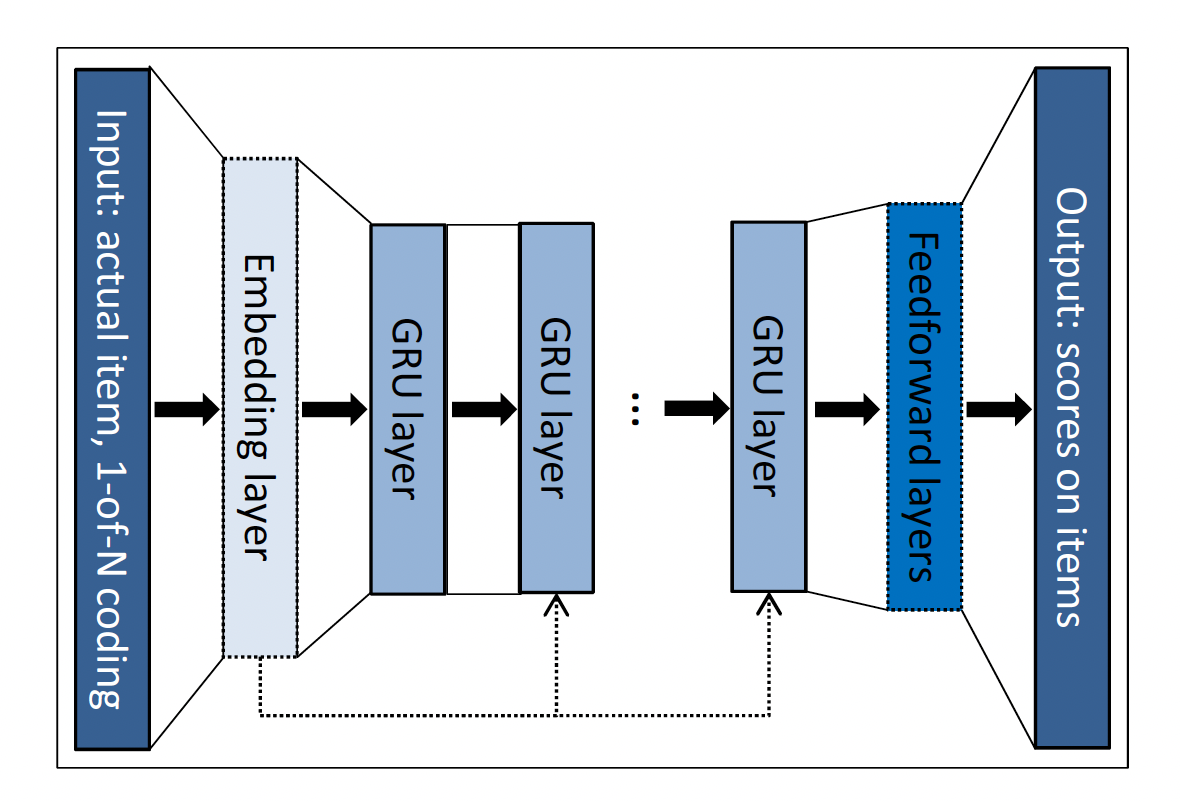

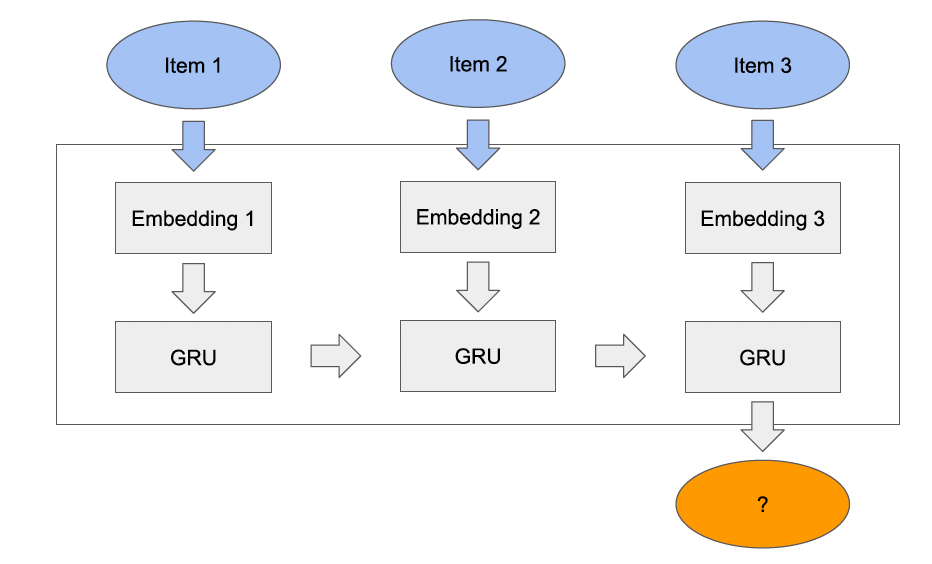

2.1.1 模型

标准的

RNN:其中:

hidden state,sigmoid函数)。Gated Recurrent Unit: GRU是一个更精细的RNN模型,旨在处理梯度消失问题。GRU gates本质上是学习何时更新单元的隐状态、以及更新多少:其中:

update gate,reset gate,sigmoid激活函数,candidate activation。我们在模型中使用

GRU-based RNN来进行session-based推荐。网络的输入是每个时刻会话的实际状态actual state,输出是会话中下一个事件的item。会话的状态可以是最新的事件(即当前事件)。此时使用

OneHot编码,即输入向量的长度为item为1而其它位置为0,其中item集合大小。会话的状态也可以是截止到当前的所有事件(即累计事件)。此时对每个事件的

OneHot编码进行加权和,权重根据事件发生时刻距离当前时间间隔进行衰减。为了稳定性,我们对输入向量进行归一化。我们希望这种累计事件的方式会有所帮助,因为它增强了记忆效应

memory effect。但是实验发现,这种方式并不会带来额外的准确率增益。这毫不奇怪,因为GRU像LSTM一样,同时具有长期记忆和短期记忆。

我们尝试添加一个额外的

embedding layer,但是发现OneHot编码总是表现得更好。如果没有

embedding layer,则embedding矩阵; 如果添加额外的embedding layer,则embedding矩阵之上的投影矩阵。网络的核心是

GRU layer。可以使用多层GRU layer,其中前一层的hidden state是下一层 的输入。最后一个GRU layer和输出层之间添加了额外的前馈层Feedforward layer(但是实验发现增加这个额外的前馈层对于效果提升没有帮助)。输出是每个item在当前会话中成为next的可能性。input层也可以选择连接到网络中更深的GRU layer,因为我们发现这可以提高性能。完整的架构如下图所示,该架构描述了事件时间序列中单个事件的

representation。图中包含了

embedding layer和feedforward layer,但是根据实验描述,这两个layer是无益的,需要移除。

2.1.2 调整

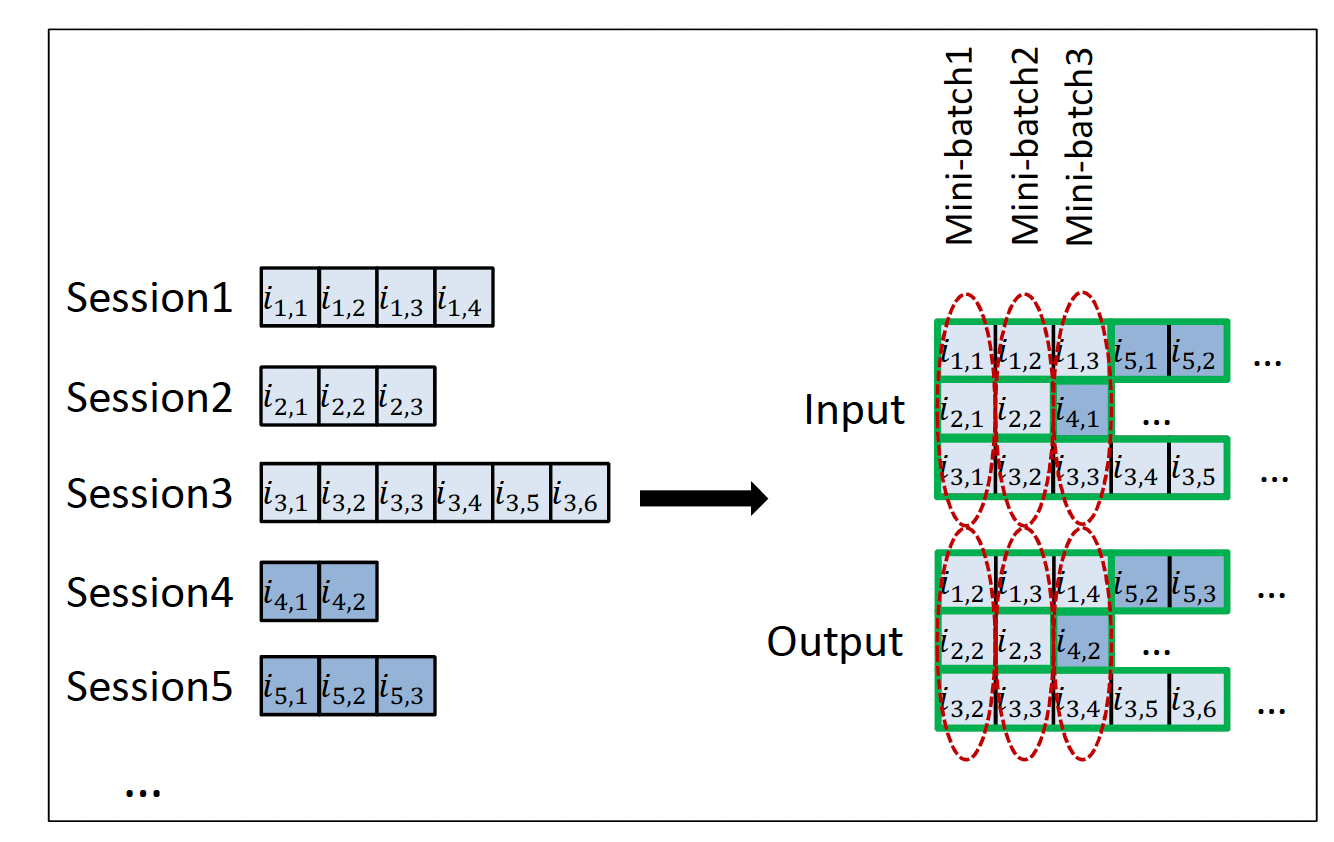

由于推荐系统不是

RNN的主要应用领域,我们修改了基础网络从而更好地适应任务。我们还考虑了实际场景,以便我们的解决方案可以应用于现场环境。session-parallel mini-batch:用于NLP任务的RNN通常使用in-sequence mini-batch。例如,通常在句子的单词上使用滑动窗口,并将这些窗口片段彼此相邻从而形成mini-batch。这不适合于我们的任务,因为:- 首先,会话之间长度的差异非常大(远远大于

NLP中的句子)。一些会话仅包含一到两个事件,而另一些会话可能包含超过数百个事件。 - 其次,我们的目标是捕获会话如何随时间的演变,因此将会话分解为片段是没有意义的。

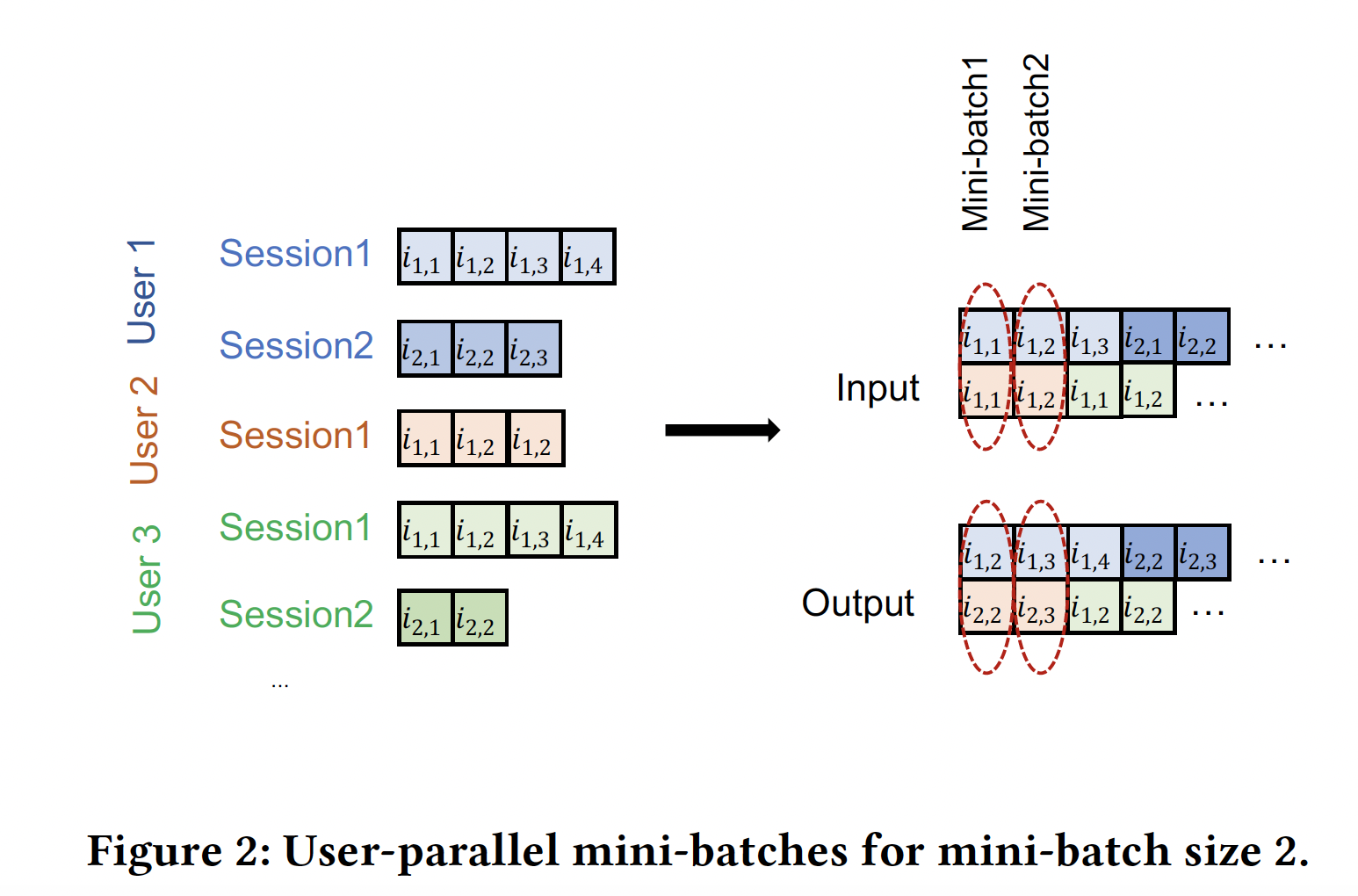

因此,我们使用

session-parallel mini-batch,如下图所示。具体而言:首先,我们将所有会话进行排序。

注意,这里是以会话为基本单元进行排序,而不是对会话内的事件进行排序。

然后,我们使用前

X个会话的第一个事件来构成第一个mini-batch的输入(所需的输出是这些会话的第二个事件)。第二个mini-batch是由这些会话的第二个事件形成的,依次类推。如果任何一个会话结束了,则下一个可用的会话将填补该结束会话的位置。假设会话之间是相互独立的,因此我们在发生这种会话切换的时候重置对应的

hidden state。这种训练方式可以支持任意长度的

session,而无需将session进行长度限制(比如截断为固定长度)。

- 首先,会话之间长度的差异非常大(远远大于

sampling on the output:当item集合规模太大时,在每个step计算每个item在当前会话中成为next的可能性是不现实的。因此我们需要负采样技术。我们根据

item的流行程度进行负采样:item越流行,那么用户就越可能知道它,那么用户未对该item交互则意味着用户更有可能不喜欢该流行item。我们没有为每个训练样本生成单独的负采样,而是使用来自

mini-batch的其它训练样本的item作为负采样。这种方法的好处是我们可以减少计算时间、降低代码复杂性、并且也易于实现。同时,该方法也是一种基于流行程度的采样,因为一个item出现在mini-batch中的可能性与其流行程度成正比。ranking loss:推荐系统的核心是item的relevance-based ranking。尽管该任务也可以解释为分类任务,但是learning-to-rank方法通常优于其它方法。ranking可以是point-wise、pair-wise、或者list-wise的。point-wise ranking彼此独立地估计item的score或者ranking,并且损失函数的定义方式使得相关的item的排名应该靠前。pair-wise ranking比较一个positive item和一个negative item组成的ranking pair对,损失函数强制positive item的排名应该比negative item的排名更靠前。list-wise ranking使用所有item的score或ranking,并将它们与完美排序进行比较。它通常在计算上代价太大,因此不经常使用。

此外,如果仅有一个相关的

item(例如我们这里的例子),list-wise ranking可以通过pair-wise ranking来解决。我们在我们的解决方案中包含了几个point-wise ranking loss和pair-wise ranking loss。我们发现模型的point-wise ranking loss不太稳定,而pair-wise ranking loss表现良好,最终我们使用以下两个pair-wise ranking loss:BPR:贝叶斯个性化排名Bayesian Personalized Ranking: BPR是一种矩阵分解方法,它使用pair-wise ranking loss。它比较一个positive item和一个负采样的negative item的score。这里,我们将positive item的score和几个负采样的negative item的score进行比较,并将它们的均值作为损失。具体而言,pair-wise ranking loss为:其中:

sigmoid函数,s中itemscore,positive item,negative item。TOP1:这个ranking loss是我们为这项任务而设计的,它是relevant item的相对排名relative rank的正则化近似。relevant item其中

sigmoid函数来代替示性函数,优化这个相对排名将会修改parameter从而使得itemscore会很高。然而,这个目标函数不稳定,因为某些

positive item也会扮演负样本角色,因此score往往会变得越来越高。为避免这种情况,我们希望强制

negative item的score在零左右,这是negative item的score的自然预期。为此,我们在损失函数中添加了一个正则化项。重要的是,这一项与相对排名在同一取值区间并且作用与其相似。最终的损失函数为:.

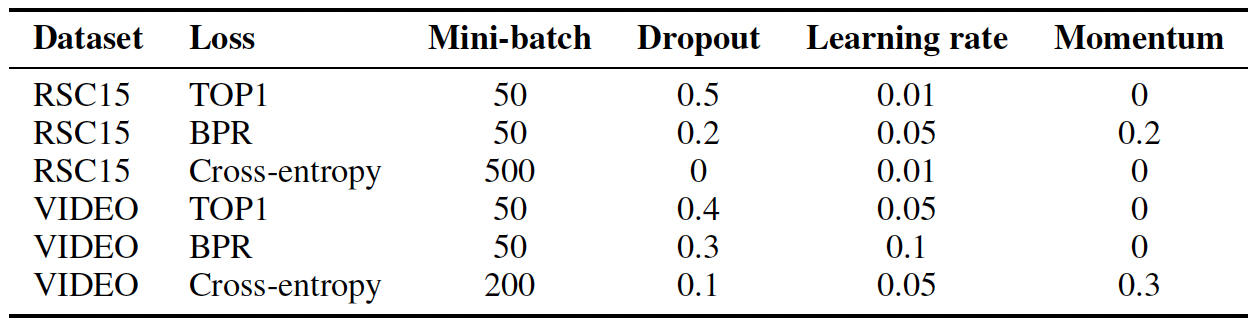

2.2 实验

数据集:

RecSys Challenge 2015数据集(RSC15):该数据集包含电商网站上的click-streams,其中某些stream以购买事件而结束。我们仅保留点击事件,并且过滤掉长度为1的会话。我们使用前6个月的数据进行训练,使用第二天的会话进行测试。每个会话要么是训练集要么是测试集,我们不会在会话中拆分数据。由于协同过滤方法的性质,我们从测试集中过滤掉训练期间

unseen的item,并且删除测试集中长度为1的会话。VIDEO数据集:包含某个视频服务平台收集的视频观看事件。预处理步骤如前所述,但是也过滤掉了很长的会话,因为这些会话可能是由机器人生成的。训练数据集包含最后一天除外的所有数据,测试数据集包含最后一天的数据。

评估方式:通过

one-by-one提供会话的事件并检查下一个事件的item排名来完成评估。GRU的隐状态在会话结束之后重置为零。item按照score降序排名。对于

RSC15数据集,我们对训练集中出现的37483个item进行排名。对于VIDEO数据集,因为item集合太大因此我们将next item和最流行的30000个item进行排名。这种评估的影响可以忽略不计,因为冷门的item通常score很低。此外,基于流行度的预过滤在实际推荐系统中很常见。recall@20:在top 20排名的item中,召回的next item占所有next item的比例。召回不考虑

item的实际排名,只要它位于top N的位置。这很好地建模了某些实际场景,其中绝对顺序无关紧要。此外,召回率通常还与重要的在线指标密切相关,如点击率CTR。MRR@20:Mean Reciprocal Rank: MRR是next item的排名的倒数的均值。如果排名在20之后则排名的倒数置为零。MRR考虑item的排名,这在推荐顺序很重要的场景下很重要(如排名靠后的item仅在滚动屏幕之后才可见)。

baseline方法:POP:流行度的predictor,它总是推荐训练集中的流行item。尽管简单,但是它通常是某些领域的强大baseline。S-POP:推荐当前会话中最流行的item(而不是全局最流行的item)。该baseline在具有高重复性的领域中很强。Item-KNN:基于item相似性来推荐和当前item最相似的item。相似度定义为此外,我们还使用正则化从而避免冷门

item的偶然发生导致的高度相似性。该

baseline是实际系统中最常见的item-to-item解决方案之一。尽管简单,它通常也是一个强大的baseline。BPR-MF:它通过SGD优化pair-wise ranking目标函数,是最常用的矩阵分解方法之一。矩阵分解无法直接应用于session-based推荐,因为新会话没有预先计算的特征向量。然而,我们可以通过使用会话中出现的item的特征向量的均值作为user特征向量来克服这个问题。换句话讲,我们对next item的特征向量、迄今为止会话中item特征向量的相似性进行平均。

这些

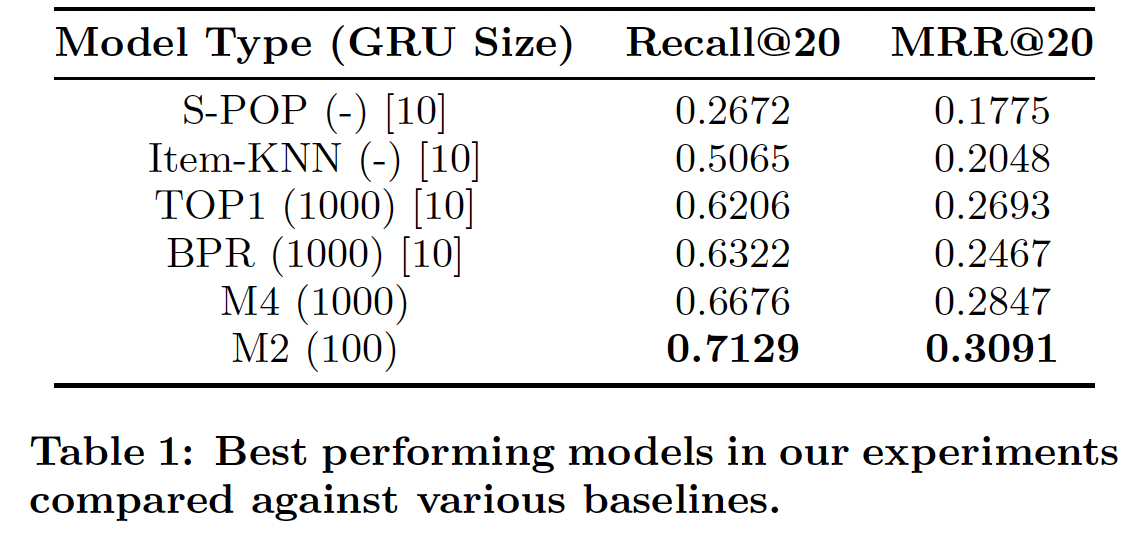

baseline的效果如下表所示,其中item-KNN方法显著优于其它baseline方法。

参数配置:我们通过单独优化每个超参数来进行超参数调优,其中调优是在单独的验证集上进行的。然后我们在训练集和验证集上对网络进行重新训练,并最终在测试集上进行评估。下表给出了最佳的超参数。

此外还有一些探索如下:

权重矩阵从

我们评估了

rmsprop和adagrad优化器,发现adagrad效果更好。我们对

GRU以外的其它RNN单元进行了简单的实验,发现常规的RNN单元和LSTM单元的效果都更差。我们尝试了几种损失函数。

point-wise ranking loss(如交叉熵和MRR)优化通常是不稳定的,即使添加正则化也是如此。我们认为:这是由于这种方法试图为positive item获得高分,而负样本的negative push太小。- 另一方面,

pair-wise ranking loss表现良好。

我们检查了几种架构,发现:

- 单层

GRU表现最好。我们假设这是由于会话的生命周期通常都很短,不需要表达不同分辨率的多个时间尺度。然而,确切原因尚不明确,需要进一步研究。 - 使用

item embedding得到的效果稍差,因此我们仅使用OneHot编码。 - 此外,将会话的所有历史事件(而不是最新的事件)作为输入并不能带来额外的准确率增益。这毫不奇怪,因为

GRU像LSTM一样,同时具有长期记忆和短期记忆。 - 在

GRU layer之后添加额外的前馈层也没有帮助。 - 然而,增加

GRU layer的大小提高了性能。 - 我们还发现使用

tanh作为输出层的激活函数是有益的。

- 单层

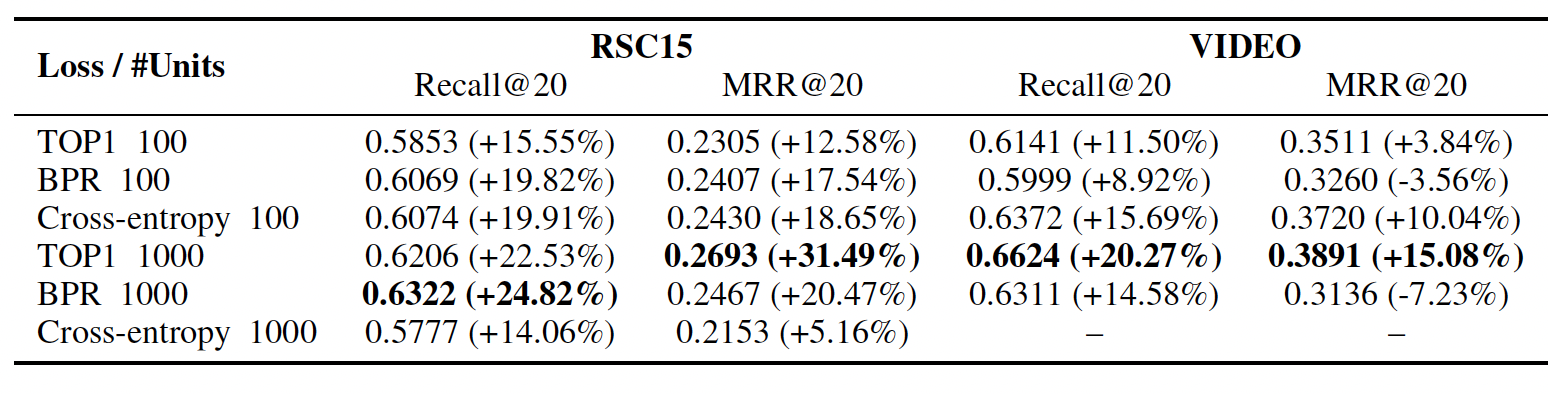

实验结果:下表给出了性能最佳的网络的结果(括号表示相对于

item-KNN中的提升。)。具有1000个隐单元的VIDEO数据集的交叉熵在数值上不稳定,因此我们没有提供结果。结论:- 即使隐单元数量为

100,GRU-based的方法在两个数据集上都显著优于item-KNN。增加隐单元数量进一步改善pair-wise loss的结果,但是降低了交叉熵损失(即point-wise loss)的准确率。 - 在隐单元数量为

100时,尽管交叉熵损失给出了更好的结果,但是随着隐单元数量的增加,pair-wise loss超过了该结果。 - 尽管增加隐单元数量会增加训练时间,但是我们发现

GPU上从隐单元100提升到1000的代价不太昂贵。 - 交叉熵损失在数值上不稳定,因为网络独立地尝试增加

positive item的score,而其它item的negative push相对较小。因此,我们建议使用上述两个pair-wise loss中的任何一个。

- 即使隐单元数量为

三、HRM[2015]

购物篮分析

market basket analysis可以帮助零售商更好地了解用户的购买行为,从而作出更好的决策。购物篮分析最重要的任务之一是next basket recommendation:根据每个用户的序列交易数据来推荐用户下一次访问时可能想要购买的item。其中,交易transaction是在某个时刻购买的一组item(如鞋子、包包)。该问题有两种建模范式:- 序列推荐器

sequential recommender:主要依赖于马尔科夫链。它根据最近的动作预测next purchase来探索序列交易数据。该模型的一个主要优点是它能够捕获序列行为从而用于良好的推荐。例如,对于最近购买手机的用户,它可能会推荐该用户购买手机配件,其中这些手机配件是其它用户购买手机后也来购买的。 - 通用推荐器

general recommender:丢弃任何序列信息并学习用户感兴趣的item。这类方法中最成功的方法之一是基于模型的协同过滤 (如矩阵分解模型)。显然,通用推荐器擅长通过学习用户的整个购买历史来捕获用户的通用兴趣general taste。

next basket recommendation的更好的解决方案是同时考虑序列行为和用户的通用兴趣。个性化的马尔科夫链personalized Markov chain: FPMC朝着这个方向迈出了一步,它能够同时建模序列行为(通过前一个交易中的item与后一个交易中的item之间的交互)、以及用户的通用兴趣(通过用户与next basket中的item之间的交互),因此比单独的序列推荐器或者单独的通用推荐器表现更好。然而,FPMC的一个主要问题在于它的所有组件都是线性组合的,表明它在多个因子之间做出了强独立性假设(即,每个组件都是独立地影响用户的next purchase)。不幸的是,根据论文《Learning Hierarchical Representation Model for Next Basket Recommendation》的分析,作者表明独立性假设不足以提供良好的推荐。为解决上述问题,论文

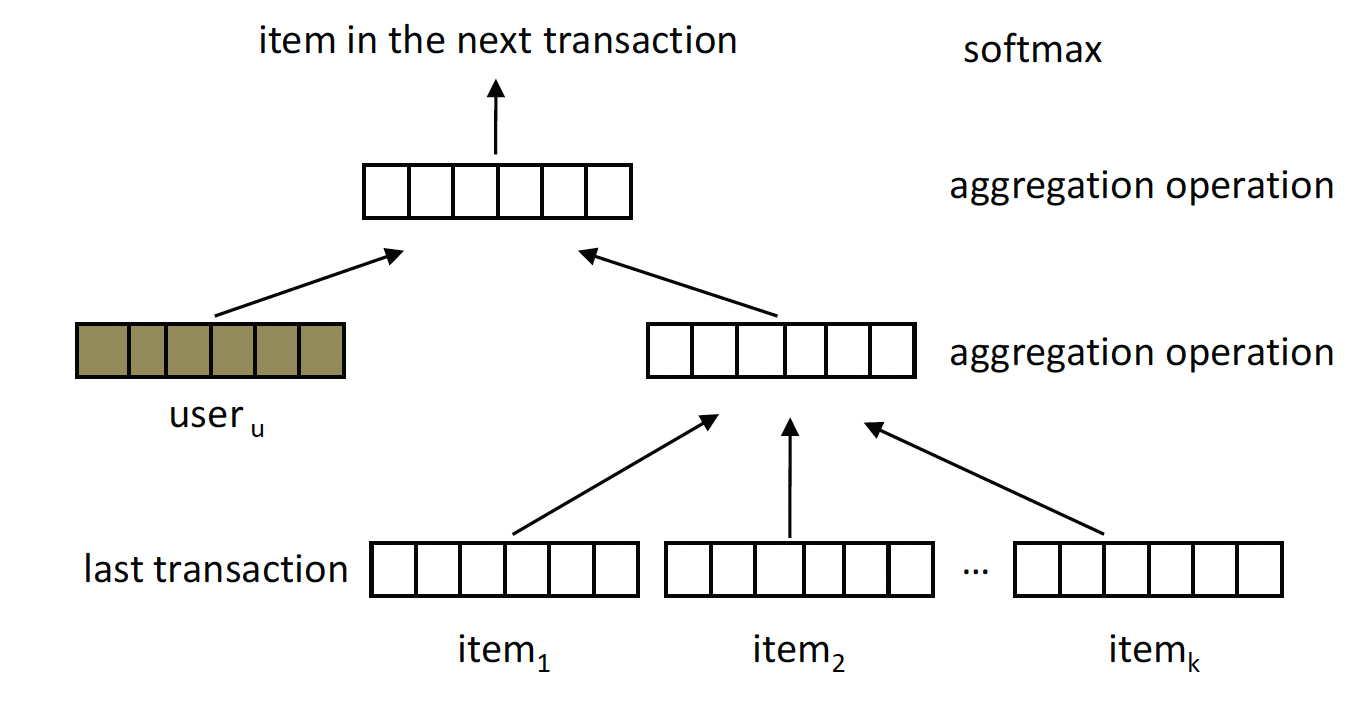

《Learning Hierarchical Representation Model for Next Basket Recommendation》为next basket recommendation引入了一种新颖的hierarchical representation model: HRM。具体而言,HRM将每个用户和每个item表达为连续空间中的一个向量,并使用two-layer结构来构建用户、以及上一次交易的item的hybrid representation`:- 第一层通过聚合上一次交易的

item向量,从而形成transaction representation。 - 第二层通过聚合用户向量和

transaction representation从而构建hybrid representation。

然后,论文使用得到的

hybrid representation来预测next basket中的item。注意,transaction representation对序列行为进行建模,而user representation捕获了用户的通用兴趣。HRM允许我们在不同的层灵活地使用不同类型的聚合函数。具体而言,通过采用非线性运算(而不是线性运算),我们可以建模不同因子之间更复杂的交互,而不是独立性假设。例如,通过使用最大池化操作,我们可以比较来自不同因子的特征,并且仅选择那些最重要的特征来形成更高level的representation从而用于未来的预测。论文还表明,通过选择适当的聚合函数,

HRM包含了几种现有的方法,包括马尔科夫链模型、矩阵分解模型、FPMC模型的变体。为了学习模型参数,论文使用负采样程序作为优化方法。论文对三个真实世界的交易数据集进行了实验,结果证明了HRM与state-of-the-art baseline方法相比的有效性。主要贡献:

- 为

next basket recommendation引入了一个通用模型,该模型可以捕获序列行为和用户的通用兴趣,并灵活地结合多个因子之间的不同交互。 - 在

hierarchical model中引入了两种类型的聚合函数,即均值池化和最大池化,并研究了这些函数的不同组合的效果。 - 理论上表明

HRM模型在选择适当聚合函数的情况下,包含了几种现有的推荐方法。 - 实验表明,

HRM模型在next basket recommendation的不同评估指标下始终优于state-of-the-art baseline。

- 序列推荐器

相关工作:

next basket recommendation是基于隐式反馈的推荐系统的典型应用,其中用户没有显式的偏好(如评分),而只有正向的观察positive observation(如购买或点击)。序列推荐器:主要基于马尔科夫链模型,通过在给定最近一个动作的情况下预测用户的下一步动作来利用序列数据。我们的工作与之前方法的主要区别在于:除了序列行为之外,我们还包含了用户的通用兴趣。以外,以前的序列推荐器很少解决因子中

item之间的交互。通用推荐器:根据用户的整个购买历史进行推荐 ,而不考虑序列行为。通用推荐器的关键思想是协同过滤

collaborative filtering: CF,它进一步可以分为基于内存的CF(通过某些相似性度量找到k近邻的用户或item来进行推荐)、以及基于模型的CF(通过分解user-item相关性矩阵来进行推荐)。通用推荐器擅长捕获用户的通用兴趣,但是如果没有建模序列行为,那么很难将其用于用户最近的购买行为。混合模型

hybrid model:结合了序列行为建模和用户通用兴趣建模。一个

state-of-the-art模型是FPMC,它构建了一个概率转移立方体transition cube,其中立方体的每一项给出了用户itemitemlast item、next item之间的三个pairwise交互来解释这个概率。以这种方式,FPMC通过last item与next item之间的交互来建模序列行为,通过用户与next item之间的交互来建模用户的通用兴趣。实验表明,这种混合模型可以比单独的序列推荐器、或者单独的通用推荐器实现更好的性能。

3.1 模型

动机:

next basket recommendation的一个简单的解决方案是:线性组合序列因子sequential factor(来自序列行为模型)和通用因子general factor(来自用户通用兴趣模型)。然而,这种线性组合假设多个因子之间是独立的。真实世界的结果表明,不同因子之间的独立性假设可能不足以提供良好的推荐。我们需要一个能够更复杂地集成多个因子之间交互的模型。这成为我们工作的主要动机。令

item集合,item数量。对于每个用户

item集合,next basket recommendation任务是推荐用户item。next basket recommendation任务可以公式化为对用户rankingranking我们可以向每个用户推荐top n items。为解决上述推荐问题,我们提出了

HRM模型。HRM的思想是学习一个可以同时包含序列行为和用户通用兴趣的推荐模型,同时建模这些因子之间的复杂交互。具体而言,

HRM将每个用户和每个item表达为连续空间中的一个向量,并采用两层结构来构建用户和最近一次交易的item的hybrid representation:- 第一层通过聚合最近一次交易的

item向量从而形成transaction representation。 - 第二层通过聚合用户向量和

transaction representation来构建hybrid representation。

然后使用得到的

hybrid representation来预测next basket中的item。HRM的整体结构如下图所示。正如我们所见,HRM通过对连续购买进行建模从而捕获序列行为,通过在序列推荐中集成个性化的user representation从而建模了用户的通用兴趣。该模型有两个不足:

- 首先,模型无法捕获用户的所有历史,只能“看到 “最近” 一次发生的交易,所以无法捕获用户的长期兴趣。

- 其次,模型没有捕获用户兴趣的动态演变。

- 第一层通过聚合最近一次交易的

更正式而言,令

representation矩阵,第representation向量,item representation矩阵,第itemrepresentation向量。给定用户

HRM通过一个softmax函数定义用户next item其中

hybrid representation,它被定义为:其中

HRM的一个优点是我们可以引入各种聚合函数来从lower level形成higher level的representation。通过这种方式,我们可以对不同层的多个因子之间的不同交互进行建模,即在第一层对构成了transaction representation的item之间的交互进行建模,在第二层对user represetnation和transaction representation之间的交互进行建模。在这项工作中,我们研究了均值池化

average pooling和最大池化max pooling这两种典型的聚合函数。显然,均值池化是一种线性运算,它假设输入的representation之间相互独立。相反,最大池化是一种非线性操作,它对输入的representation之间的交互进行建模,只有那些最重要的特征才会被保留下来。注意,还可以定义其它类型的聚合函数,如

top-k均值池化或者Hadamard product。我们可能会在将来的工作中研究这些聚合函数。此外,还可以考虑在深度神经网络中引入非线性层,然而我们求助于简单的模型,因为这样的计算复杂度较低从而可以用于非常大的数据集。由于

HRM中有两个聚合,因此我们根据不同的操作组合得到四个版本的HRM,即:HRM版本实际上假设多个因子之间的交互程度不同。- 通过仅使用均值池化,

FPMC的某种变体。 item之间、要么在user represetnation和transaction representation之间。

- 通过仅使用均值池化,

HRM的损失函数是负的对数似然:其中:

然而直接优化上述目标函数是不现实的,因为计算完整的

softmax的代价与item数量其中:

sigmoid函数,noise distribution。正如我们所看到的的,带负采样的

HRM的目标旨在最大化观察到的itemitem我们使用随机梯度下降算法来最小化

Dropout技术来避免过拟合。在我们的工作中,我们为每个单元设置了一个固定的dropout rate(即,0.5)。一旦学到

user representation和item representation,则HRM的next basket recommendation过程如下:- 给定用户

item - 然后根据

item的未归一化概率对item进行排序,并选择top n个结果来推荐给用户。

注意,由于排序只需要考虑相对大小,因此没有必要计算完整的

softmax值。- 给定用户

3.2 和之前模型的关系

HRM和马尔科夫链的关系:HRM可以简化为某种类型的马尔科夫链模型。我们选择特殊的聚合函数:

- 对于第一层聚合,我们随机选择一个

item向量作为transaction representation。 - 对于第二层聚合,我们选择

transaction representation作为hybrid representation。

我们将这种模型称作

其中

item的representation。类似于

《distributed representations of sentences and documents》中的推导,我们得到上式的最优解:这意味着

factorized Markov chain model: FMC,它通过分解item(这些item来自于两个连续的交易)之间的转移矩阵transition matrix,这个转移矩阵与shifted PMI矩阵相关联。当PMI矩阵。事实上,如果我们采用噪声对比估计进行优化,则最优解为:

这意味着

shifted的对数条件概率矩阵。- 对于第一层聚合,我们随机选择一个

HRM和矩阵分解模型:HRM可以简化为矩阵分解模型。HRM vs Matrix Factorization Model:我们选择特殊的聚合函数:对于第二层聚合,我们选择

user representation作为hybrid representation(此时第一层完全被移除掉)。我们将这种模型称作其最优解为:

通过这种方式,

shifted PMI矩阵。这个

shifted PMI矩阵和shifted PMI矩阵在公式上不相同。HRM和FPMC的关系:HRM可以简化为FPMC模型的某种变体。基于

S-BPR优化准则和最大后验估计的FPMC,其损失函数为:其中

prediction model:对于

HRM模型,如果我们选择负样本数量考虑到每一层都是均值池化,则有:

因此有:

可以看到:

FPMC共享相同的预测模型(即,pairwise优化准则optimization criteria:FPMC使用pairwise ranking损失函数,即itemranking高于未观察到的itempairwise ranking损失函数,即itemranking、最小化未观察到的itemranking。

实际上,我们也可以采用

S-BPR准则来定义FPMC相同的模型。基于上述分析,我们可以看到

HRM实际上是一个非常通用的模型。通过引入不同的聚合函数,我们可以包含已有方法。此外,我们还可以探索其它预测函数以及优化准则,从而展现HRM的灵活性和潜力。

3.3 实验

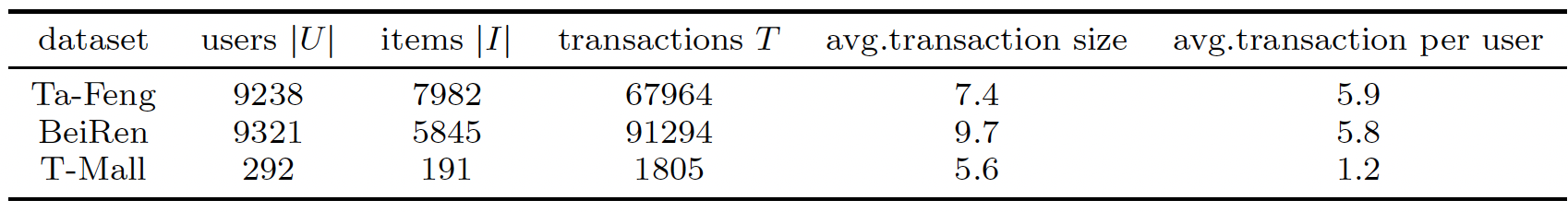

数据集:我们使用三个真实交易数据集来评估不同的推荐方法。

Ta-Feng数据集:RecSys会议发布的公开数据集,涵盖了从食品、办公用品到家具产品。BeiRen数据集:来自中国的大型零售企业BeiGuoRenBai,记录了2013年1月到2013年9月期间的超市购买记录。T-Mall数据集:淘宝发布的一个公共的在线电商数据集,以品牌(而不是商品)的方式记录了在线交易。

我们首先对数据集进行预处理。对于

Ta-Feng和BeiRen数据集,我们删除了用户量少于10个的商品、以及商品量少于10个的用户。对于较小的T-Mall数据集,我们删除了用户量少于3个的商品、以及商品量少于3个的用户。处理后的数据集如下表所示。最后,我们将所有数据集拆分为训练集和测试集,其中测试集仅包含每个用户的最后一笔交易,而剩余所有交易都放入训练集中。

baseline方法:TOP:将训练集中最流行的item作为每个用户的推荐。MC:马尔科夫链模型(即序列推荐器),它根据用户的最后一笔交易来预测next purchase。预测模型为:其中转移概率

Nonnegative Matrix Factorization: NMF:是一种state-of-the-art的协同过滤方法。它是基于user-item矩阵的非负矩阵分解,该矩阵是通过丢弃序列信息从交易数据集构造而来。FPMC:next basket recommendation的state-of-the-art混合模型,预测时同时考虑了序列行为和用户的通用兴趣。

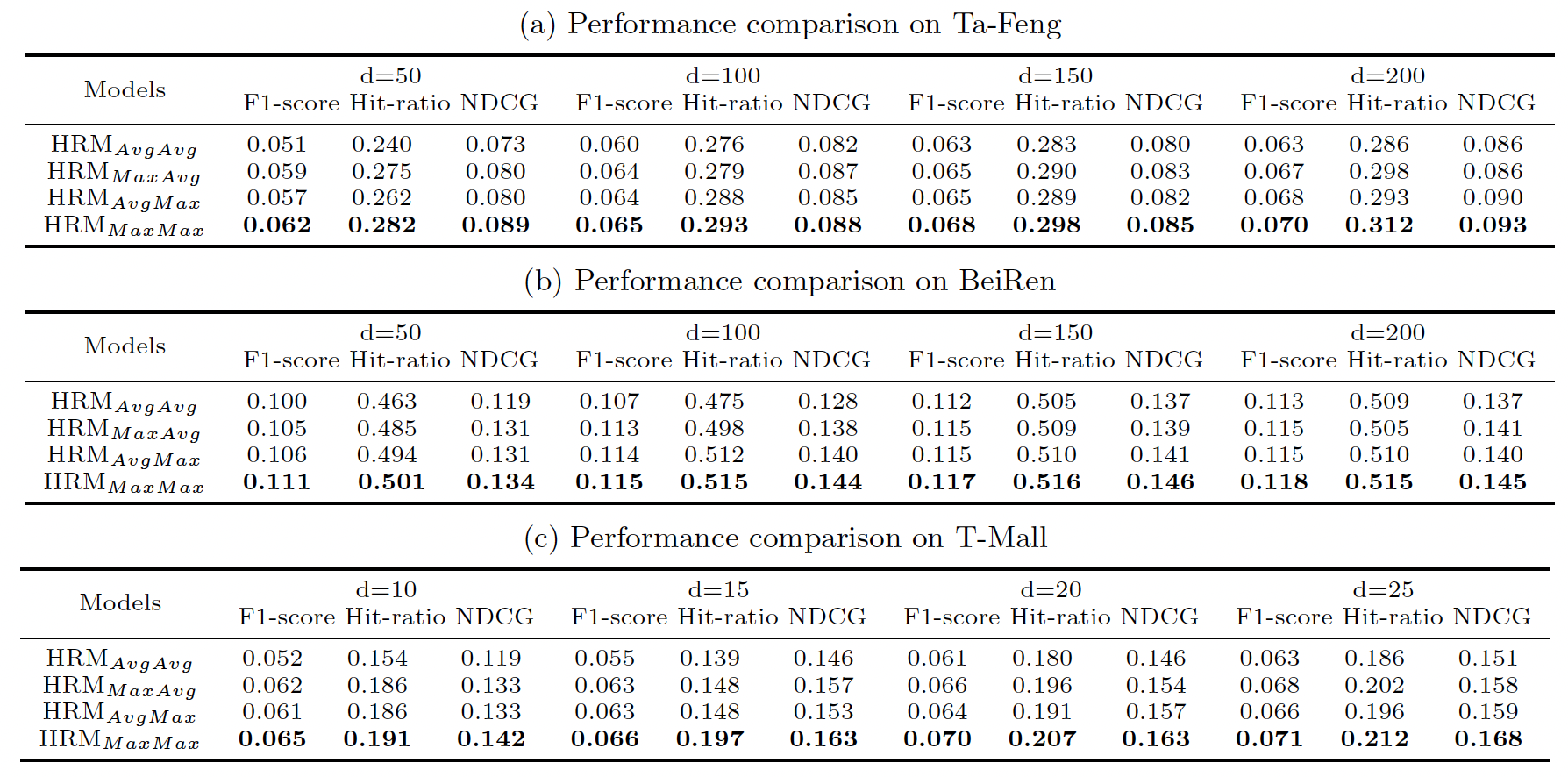

对于

NMF, FPMC, HRM方法,我们在Ta-Feng数据集和BeiRen数据集上设置维度T-Mall数据集上设置评估指标:我们在测试集中对每个用户

item(item列表item。我们使用以下指标来评估推荐列表与实际购买的item:F1-Score:它是precision和recall的调和平均值,是广泛应用的指标。Hit-Ratio:如果实际购买的item至少有一项也出现在推荐列表中,则称之为命中。命中的推荐列表占所有推荐列表的比例称之为命中率。命中率关注推荐系统的召回率,即所有用户中有多少比率的人获得至少一个正确的推荐。NDCG@k:Normalized Discounted Cumulative Gain: NDCG是一种基于排名的指标,它考虑了列表推荐中的item顺序。

不同

HRM变体的比较:- 在聚合中仅使用均值池化操作的

- 仅使用一次最大池化操作的

- 在聚合中全部使用最大池化操作的

next basket recommendation中对多个因子之间的交互进行建模的优势。

- 在聚合中仅使用均值池化操作的

不同方法之间的比较:我们选择

HRM版本与baseline方法进行比较。- 总体而言,

TOP方法效果最差。然而我们发现Top方法在T-Mall数据集上优于MC。这可能是由于T-Mall数据集中的商品实际上是品牌。因此流行品牌在训练集和测试集上的分布非常接近,这符合Top方法的假设并导致更好的性能。 NMF方法在大多数情况下优于MC方法。一个主要原因是MC方法中估计的转移矩阵相当稀疏,直接应用它进行推荐可能导致效果不佳。提高MC方法性能的一种方法是分解转移矩阵从而缓解稀疏性问题。- 通过结合序列行为和用户的通用兴趣,

FPMC可以获得比MC和NMF更好的结果。 - 通过进一步引入多个因子之间的交互,

baseline方法。

为进一步研究不同方法的性能,我们根据用户的活跃度将用户分为三组(即,不活跃、中等活跃、活跃)并对不同用户组进行比较。以

Ta-Feng数据集为例,如果用户购买历史少于5次则为不活跃、超过20次则为活跃、否则为中等活跃。这样,不活跃、中等活跃、活跃用户的占比分别为40.8%, 54.5%, 4.7%。由于篇幅所限我们仅报告Ta-Feng数据集的结果,其它数据集的结果也是类似的。Top方法仍然是所有用户组中表现最差的。MC在非活跃用户和中等活跃用户上的效果都优于NMF,而在活跃用户上比NMF更差。这表明,NMF很难通过很少的交易来学习良好的user representation从而进行推荐。- 通过将序列行为和用户的通用兴趣来线性组合,

FPMC在非活跃用户和活跃用户上的性能优于MC、在非活跃用户和中等活跃用户上的性能优于NMF。但是,我们可以看到不同用户组的改进并不是很一致。

- 总体而言,

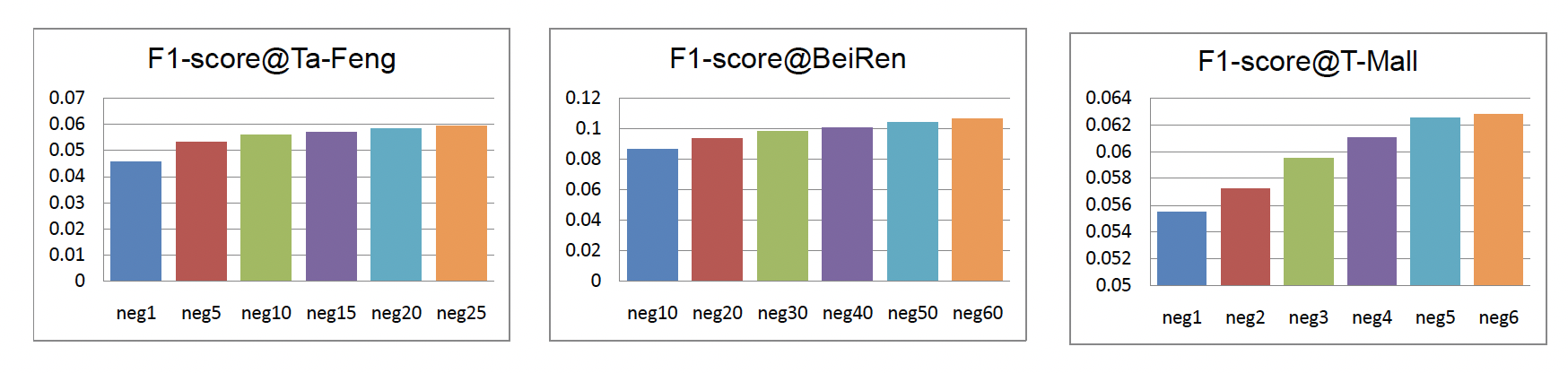

负采样的影响:这里我们研究负采样数量

Ta-Feng数据集和BeiRen数据集上T-Mall数据集上- 随着

F1-Score也随之提升,并且三个数据集的趋势非常一致。 - 随着

baseline比较实验中,我们在Ta-Feng, BeiRen, T-Mall数据集中,分别将25, 60, 6。

- 随着

四、DREAM[2016]

通常而言,

next basket recommendation有两种不同的方法:- 协同过滤

collaborative filtering: CF模型:它捕获用户的通用兴趣general interest,但是难以考虑历史交易的序列特征。矩阵分解matrix factorization: MF模型是一个成功的CF模型,它对整个历史交易数据构建的user-item矩阵进行因子分解,并用潜在向量来表达用户的通用兴趣。 - 基于马尔科夫链的序列推荐模型:它从历史交易中提取序列特征,然后根据这些序列行为预测

next purchase。

因此,

next basket recommendation的一种更合适的方法是在混合模型hybrid model中同时捕获上述序列行为和用户通用兴趣。- 因子分解个性化马尔科夫链

Factorizing Personalized Markov Chain: FPMC可以对每两个相邻basket之间的序列行为进行建模,并且用户的通用兴趣由basket中的item来塑造shaped。但是,FPMC只是对多个因子进行线性运算,并不能描述多个因子之间的交互。 Hierarchical Representation Model: HRM似乎部分地解决了如何通过非线性最大池化操作来聚合多个交互因子的问题。然而,所有基于马尔科夫链的方法(包括上述FPMC和HRM)都具有相同的缺陷,即这些推荐器只能对每两个相邻basket之间的局部序列行为进行建模,而这这两个相邻basket有时可能不相关。例如,用户ultrabook、在ultrabook的配件,此时每两个相邻basket之间不存在任何相关性。因此,我们需要对全局序列行为进行建模,从而充分利用sequential basket之间的所有相关性,如basket。出于这个原因,论文《A Dynamic Recurrent Model for Next Basket Recommendation》计划在用户的所有sequential basket中对全局序列特征进行建模。

如前所述,

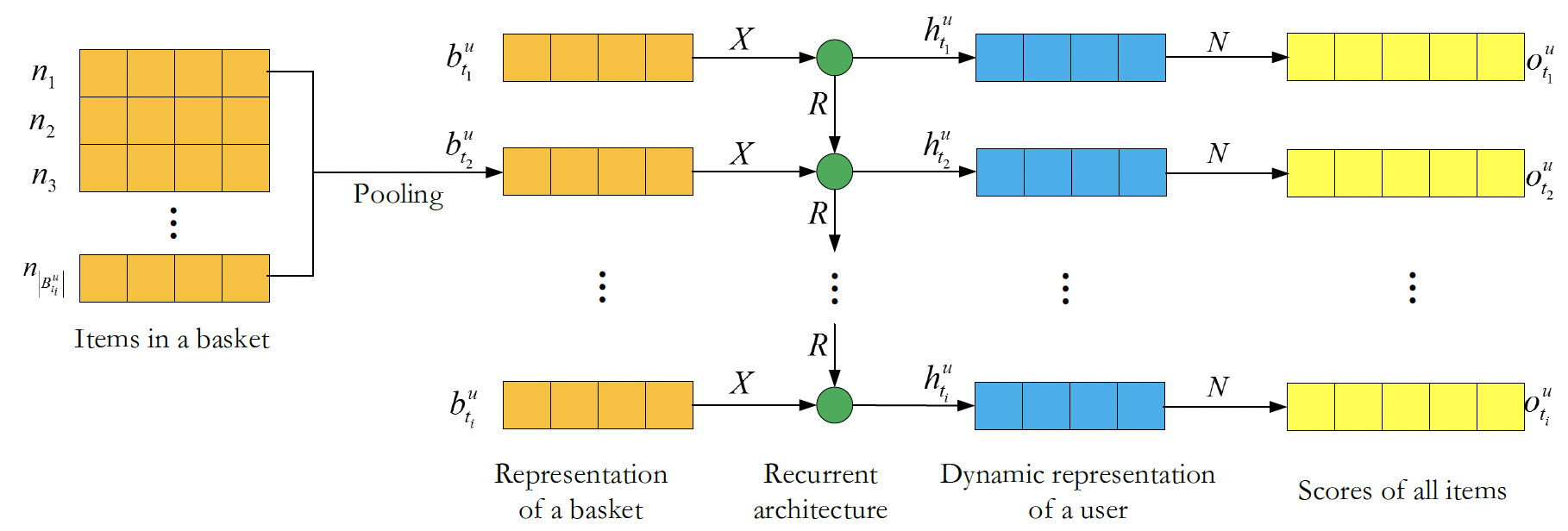

HRM提取的局部序列特征不足以对不同basket之间的关系进行建模,而深度RNN架构的循环操作可以从用户的所有basket中捕获全局序列特征。因此,论文《A Dynamic Recurrent Model for Next Basket Recommendation》提出了一个动态循环模型DREAM用于next basket recommendation。DREAM模型的输入由一系列basket的item组成,这些item构成了特定用户的、顺序的交易。随着时间的推移,池化操作和矩阵运算为每个用户提供dynamic representation。此外,循环结构可以从整体历史交易数据中获得每个用户的一些全局序列特征。论文在两个真实世界数据集上的实验结果表明,和FPMC、HRM等state-of-the-art模型相比,DREAM模型在next basket recommendation方面取得了很大的进步。这项工作的主要贡献:

- 论文调研了每个用户的

dynamic representation,以及item购买历史的全局序列行为。 - 论文在两个真实世界数据集上进行实验从而验证了

DREAM模型的有效性。

据作者所知,

DREAM是首个尝试结合dynamic representation和全局序列行为从而提高next basket recommendation性能的方法。- 协同过滤

4.1 模型

令

item的representation矩阵,其第itemrepresentation向量,representation维度。所有item的集合为对于用户

basket集合basket of items。对于具有历史交易数据的

next basket recommendation,我们将问题公式化为:预测每个用户在给定时刻item的ranking list。DREAM的整体框架如下图所示。模型的输入是

basket的序列。对于用户basketbasket内item的潜在representationbasketitem的潜在representation,basketitem数量。现在,我们可以通过聚合这些item representation来生成basketbasket representationbasket representationRNN的输入层。隐层的

vector representationdynamic representation。RNN矩阵basket representation和用户兴趣之间的转移矩阵。最后,隐层的vector representation可以计算为:其中:

basket representation,dynamic representation,sigmoid函数)。最后,模型在时刻

item的得分它是每个

item representation和user dynamic representation的内积。itemitem。

目标函数:我们选择

Bayesian Personalized Ranking: BPR作为目标函数。我们的基本假设是:用户在特定时间更喜欢basket中的item,而不是负样本(即basket之外的item)。负样本可以是basket之外的任何其它item。因此我们最大化以下概率:其中:

sigmoid函数。考虑所有的对数似然以及正则化项,则我们的目标函数为:

其中:

我们使用随机梯度下降来更新求解上述最优化问题。

DREAM仅仅建模序列信息,并未建模用户的全局兴趣。可以看到这里并没有user embedding矩阵。注意,

DREAM模型迭代式地学习用户的representation。即,我们可以迭代式地根据新的交易来更新已有的用户representation(由于RNN的性质),这种更新的代价相比分解完整的user-item矩阵而言要小得多。

4.2 实验

数据集:

Ta-Feng数据集:RecSys会议发布的公开数据集,涵盖了从食品、办公用品到家具产品。T-mall数据集:淘宝发布的一个公共的在线电商数据集,以品牌(而不是商品)的方式记录了在线交易。

我们对上述数据集进行预处理,每个用户至少购买

item才会被保留。对于Ta-Feng数据集我们设置T-Mall数据集我们设置baseline方法:TOP:将训练集中最流行的item作为每个用户的推荐。MC:马尔科夫链模型(即序列推荐器),它根据用户的最后一笔交易来预测next purchase。预测模型为:其中转移概率

Nonnegative Matrix Factorization: NMF:是一种state-of-the-art的协同过滤方法。它是基于user-item矩阵的非负矩阵分解,该矩阵是通过丢弃序列信息从交易数据集构造而来。FPMC:next basket recommendation的state-of-the-art混合模型,预测时同时考虑了序列行为和用户的通用兴趣。HRM:是一种state-of-the-art的hierarchical repre- sentation模型,可以捕获通用的用户兴趣以及序列效应。此外,通过各种非线性操作,HRM可以比先前的模型更准确地捕获所有这些因子。

评估指标:我们为每个用户

item的ranking list。我们使用F1-score和Normalized Discounted Cumulative Gain: NDCG指标。我们使用每个用户的最后一笔交易作为测试数据集,其它所有交易作为训练数据集。

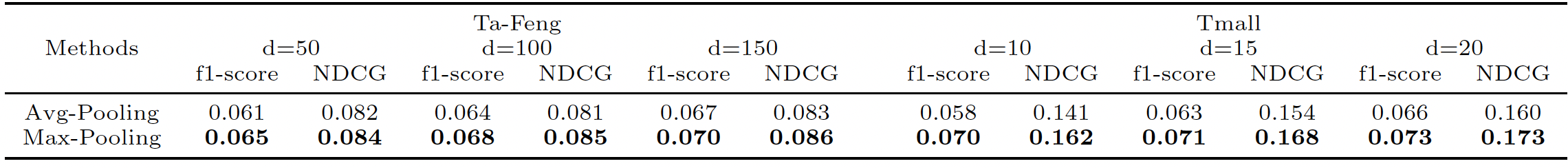

item representation是随机初始化的。此外我们给出不同

representation维度Ta-Feng数据集,T-Mall数据集,首先我们将

DREAM模型与baseline方法比较,如下图所示。整体而言,next basket recommendation的性能排名如下:DREAM, HRM, FPMC, NMF, MC, TOP。- 由于

TOP仅推荐流行item,并且没有利用每个basket的特征,因此该方法效果最差。 - 尽管

NMF和MC仅利用了一种特征(或者是序列行为、或者是用户的通用兴趣),我们观察到NMF比MC效果更好,尤其是在稀疏的T-Mall数据集上。可能是因为MC无法揭露用户之间的协同信息。在T-Mall的稀疏的user-item矩阵上,协同信息相比较于稀疏的序列行为,对于生成用户的准确兴趣更重要。 - 在这两个数据集上,

HRM模型都优于FPMC模型。虽然FPMC和HRM都利用了序列行为,但是HRM的多个因子之间的非线性运算为其带来了更好的性能。而FPMC对basket中item交互的线性独立假设使其不适用于复杂的商业场景。 DREAM在两个数据集上的所有指标方面都优于所有baseline。这表明,具有循环架构的user dynamic representation在捕获用户的序列特征和动态兴趣方面是有效的。此外,池化操作、激活函数等丰富的非线性操作有助于更好地表达basket。

- 由于

然后我们比较最大池化和均值池化对

DREAM模型的性能影响。可以看到,最大池化的效果要优于均值池化。显然,均值池化是一种线性操作,这表明

basket中的每个item都以独立的方式影响basket representation。然而在现实世界的场景中,我们购买的许多item都是交互的,即,一个item会影响我们是否购买另一个item,而购买item的整体可以shape我们的兴趣。 因此,更好的解决方案是通过非线性运算来学习basket内item的复杂交互关系。最大池化是一种非线性操作,能够比线性操作更好地学习复杂的交互。

五、Improved GRU4Rec[2016]

传统的个性化推荐方法通常需要用户画像,至关重要的是,这些方法要求在推荐时识别用户。然而这可能是不可行的,例如:网站的新用户没有任何画像信息,或者用户没有登录,或者用户删除了他们的

tracking信息。这导致了基于用户历史的推荐方法的冷启动问题。另一种替代方法依赖于历史数据,并提供

session-based推荐。在这个setting中,推荐系统仅根据用户在当前session中的行为进行推荐。这避免了上述冷启动问题,但我们必须确保系统保持准确率和及时响应(即,预测不会耗费太长时间)。最近,《Session-based recommendations with recurrent neural networks》提出了RNN用于session-based推荐。作者展示了RNN相对于传统模型在session-based推荐上的显著改进。在论文

《Improved Recurrent Neural Networks for Session-based Recommendations》中,论文进一步研究了RNN在session-based推荐中的应用。具体而言,作者检查和采纳了文献中的各种技术来完成这项任务,包括:- 通过序列预处理

sequence preprocessing和embedding dropout来增强数据,从而提升训练并减少过拟合。 - 通过模型预训练,从而考虑数据分布的时间偏移

temporal shift。 - 使用

privileged information的蒸馏,从而从小数据集中学习。

此外,论文提出了一种新颖的替代模型,该模型通过直接预测

item embedding来减少预测的时间成本和空间成本。这使得RNN更容易在real-time setting中部署 。论文在

RecSys Challenge 2015数据集上进行了评估,并证明了作者所提出方法的有效性。- 通过序列预处理

相关工作:

矩阵分解和基于邻域的方法在文献中被广泛应用于推荐系统。

矩阵分解方法基于稀疏的

user-item交互矩阵,其中推荐问题被公式化为矩阵补全任务matrix completion task。在分解矩阵之后,每个用户都由一个潜在因子向量来表示,每个item也都由一个潜在因子向量来表示。然后可以通过对应的user latent vector和item latent vector内积来补全user-item矩阵的缺失值。由于这需要我们同时识别用户向量和

item向量,因此矩阵分解方法无法直接适用于用户未知的session-based推荐。解决这个冷启动问题的一种方法是使用成对偏好回归pairwise preference regression。基于邻域的方法利用

target item和用户购买历史item之间的相似性。通过比较session similarity,基于邻域的方法可以应用于session-based推荐。

深度学习最近在图像识别、语音识别、自然语言处理等领域取得了非常成功的应用。在

《Session-based recommendations with recurrent neural networks》中,作者提出RNN来用于session-based推荐。作者将RNN(带有自定义的ranking loss)与现有的session-based预测方法进行比较,发现RNN-based方法的性能相比baseline要提升20% ~ 30%。我们的工作与之密切相关,我们研究该RNN模型的扩展。在

《Sequential click prediction for sponsored search with recurrent neural networks》中,作者还使用RNN进行点击序列预测。他们考虑了历史用户行为,也考虑了每个用户和每个item的、手工设计的特征。在这项工作中,我们完全依赖于自动学习的feature representation。也有许多工作提出了方法来提高

DNN的预测性能。流行的方法包括:数据增强、dropout、batch normalization、残差连接。我们寻求应用其中一些方法来提升我们模型的训练。人们提出

learning using privileged information: LUPI框架来利用一些额外的feature representation,这些feature representation仅在训练期间可用但是在测试期间不可用。当训练数据量有限时,人们发现使用此类信息是有益的。在广义蒸馏方法中,

student模型从teacher模型提供的soft label中学习。如果我们在privileged dataset上训练teacher模型,那么这种方法可以应用于LUPI。在这项工作中,我们提出使用LUPI框架来用于点击序列的预测,其中我们使用每个点击序列的未来部分作为privileged information。

5.1 模型

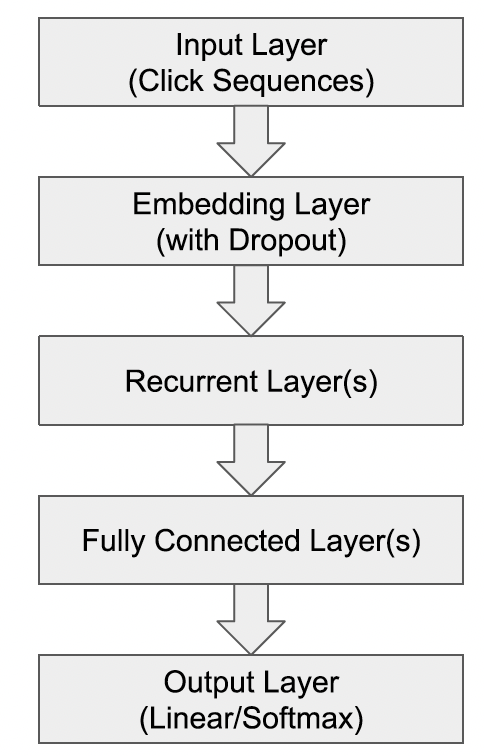

session-based推荐的RNN:session-based推荐问题可以公式化为基于序列的预测问题:令所有item集合的大小为click session,其中item的索引并且click session中的任何前导点击序列itemitem的概率。我们将

item成为session中next click的排序分。由于我们通常需要为用户选择一个以上的推荐,因此这里推荐top-k item(根据next click,则我们用一个one-hot编码pairwise ranking loss。我们遵循下图所示

RNN模型的通用结构。对于recurrent layer,我们使用Gated Recurrent Unit: GRU,因为《Session-based recommendations with recurrent neural networks》中发现它优于LSTM单元。但是,我们没有使用stateful RNN训练过程,在stateful RNN训练过程中模型以session-parallel、sequence-to-sequence的方式进行训练。相反,我们的网络处理每个序列next click

我们还使用可训练的

embedding来表示所有input。我们的网络可以通过Back-Propagation-Through-Time: BPTT算法在固定数量的time step上,使用交叉熵损失来执行标准的mini-batch随机梯度下降从而进行训练。如下图所示为一条序列的训练示意图,梯度沿着灰色箭头的反向传播,蓝色为input序列,橙色为target output。

数据增强

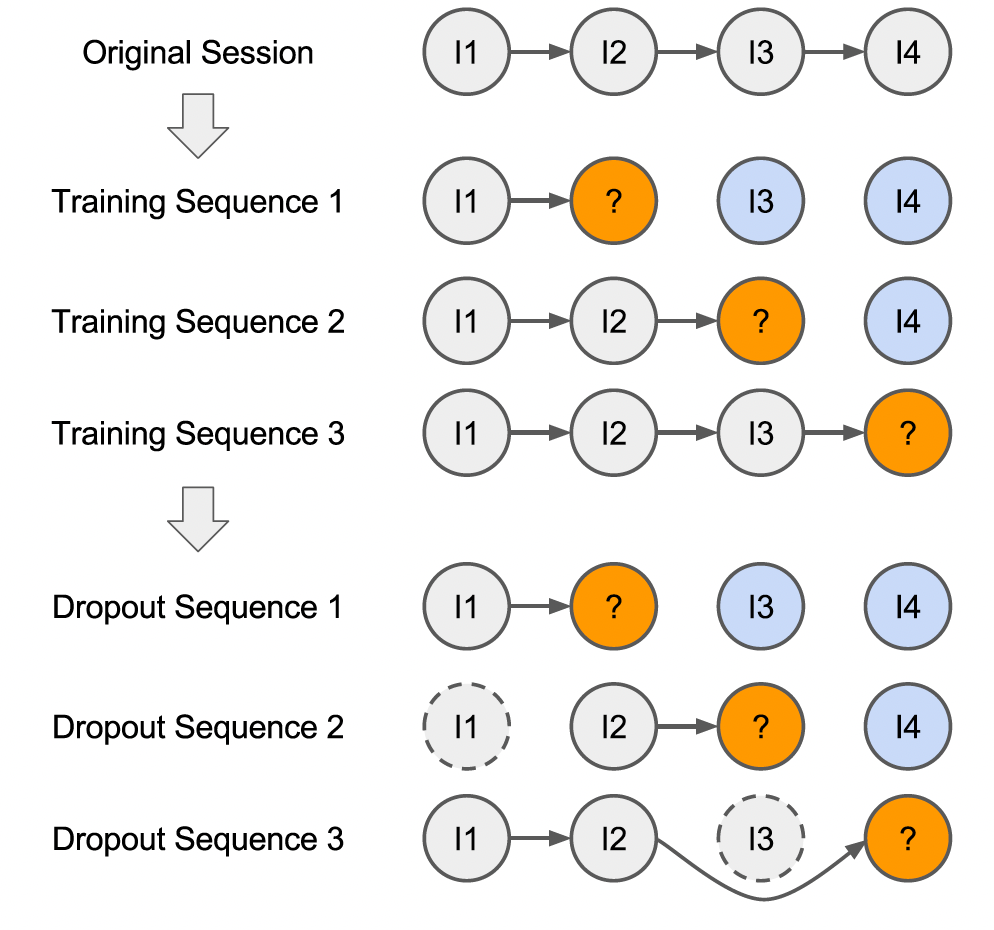

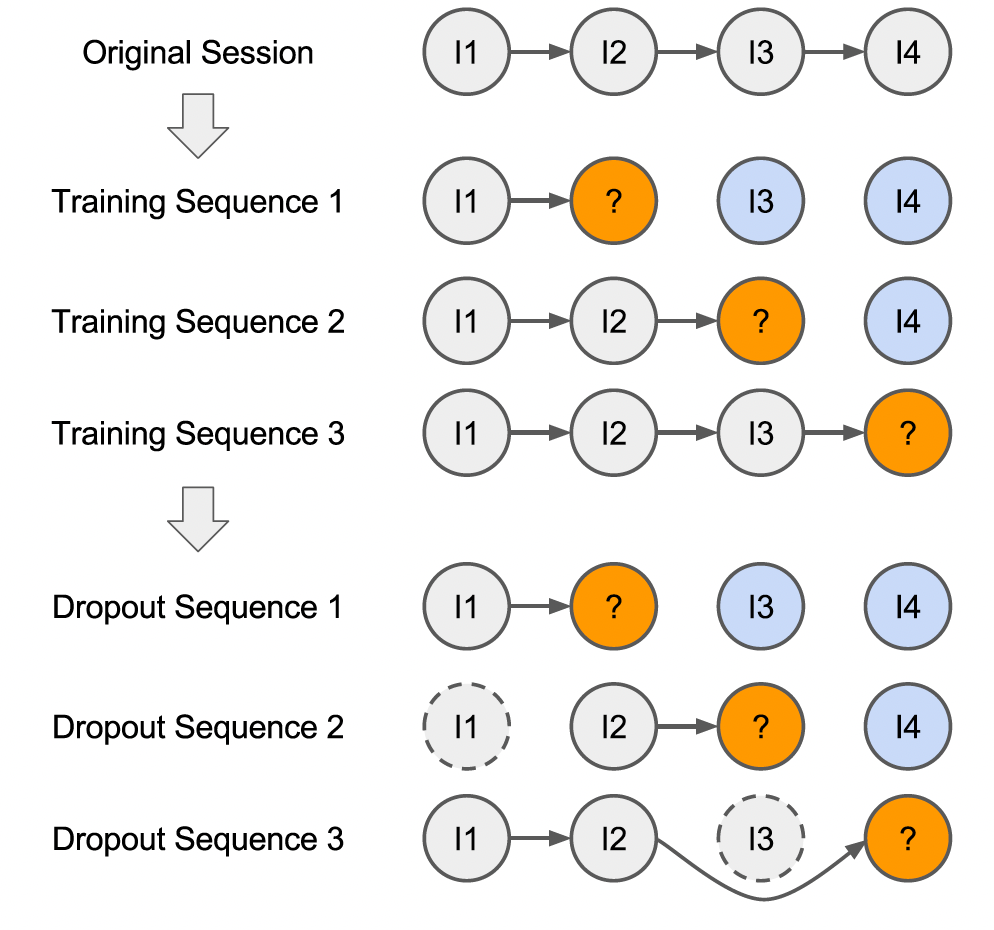

data augmentation:数据增强技术已被广泛应用于图像领域,这里我们提出两种方法来增强点击序列:第一个方法是

《Artificial neural networks applied to taxi destination prediction》中提出的序列预处理方法的应用。原始input session的所有前导prefix都被视为新的训练序列。给定一个训练sessionlabel来用于训练:第二个方法是

dropout,它是应用于input sequence的正则化形式。对点击序列应用dropout相当于随机删除部分click的预处理步骤。直观而言,这使得我们的模型对noisy click不太敏感,例如用户可能不小心点击了不感兴趣的item。因此,dropout使模型不太可能过拟合特定的noisy序列。dropout也可以被视为一种数据增强形式,它生成更短的、被裁剪的序列来用于模型训练。这里是

dropout输入序列中原始的item id,而不是dropout对应的item embedding。在本论文里二者是相同的,但是需要实验来验证?

我们将这两种方法应用于我们的所有模型。下图展示了一个示例:图中是一个包含了四个点击的

session,虚线轮廓表示训练期间被dropout的点击,灰色表示训练序列,橙色表示output label,蓝色表示privileged information(它们不用于标准的训练过程)。注意,相同序列在不同的训练

epoch会丢弃不同的点击item。

适应时序变化

adapting to temporal changes:许多机器学习模型的一个关键假设是:输入是独立且同分布的。这在item recommendation setting中并非严格如此,因为新的商品只会出现在该商品发布之后的session中,并且用户行为/偏好也可能随着时间而改变。此外,推荐系统的目标是对新序列进行预测,即那些来自用户最近行为的序列。因此,在整个数据集上学习推荐模型可能会导致性能下降,因为模型最终会关注一些与最近序列无关的过时属性。解决这个问题的一种方法是定义一个时间阈值,并在构建模型时丢弃早于该阈值的点击序列。但是,这种方法减少了可供模型学习的训练数据量。

我们提出了一个简单的解决方案:通过预训练获得两全其美的效果。我们首先在整个数据集上训练一个模型,然后使用训练好的模型来初始化一个新模型。这个新模型仅使用近期数据(整个数据集的子集)进行训练,例如从一年点击数据中使用最近一个月的数据来训练。这使得模型能够使用大量数据进行良好的初始化,并聚焦于近期的点击序列。通过这种方式,这类似于在图像领域中使用的

fine-tuning过程。使用长期数据训练意味着学习用户的长期兴趣,使用短期数据训练意味着学习用户的短期兴趣。这里的方法通过初始化使得用户长期兴趣作为先验知识:当短期数据丰富时,学到的用户短期兴趣占主导;当短期数据匮乏时,初始的用户长期兴趣占主导。

使用

privileged information:用户在某个item之后点击的item序列也可能包含有关该item的信息,如下图所示的蓝色item。这些信息不能用于执行预测,因为我们在进行推荐时无法查看到未来的序列。然而,我们可以利用这些未来的序列用作privileged information,以便为我们模型的正则化和训练来提供soft label。为此,我们使用广义蒸馏框架。

形式上,给定一个序列

session的labelprivileged information定义为:session的长度。privileged sequence仅仅是发生在第item之后的、逆序的未来序列。我们现在可以在privileged sequenceteacher模型,它也具有相同的label接下来我们通过最小化以下形式的损失函数来调优我们的

student模型其中:

label之间的重要性。注意:这里的

teacher序列为未来序列的逆序,它提供soft label。这使得

label中学习,也可以从teacherlabel(即soft label)中进行学习。当可用的训练数据很小的时候,这种学习过程很有用。论文并未说明

teacher模型用于快速预测的

output embedding:我们输出层需要输出所有item的排序分,这不仅消耗内存,也使得预测很慢。在NLP中也研究了类似的问题,典型的方法包括 使用hierarchical softmax layer、以及采样最高频的item。hierarchical softmax并不适用于我们的场景,因为我们需要进行top-k预测,而不仅仅是top-1预测。相反,我们将item embedding视为将item从one-hot编码空间到低维空间的投影。基于这个观点,我们建议训练模型直接预测next click的embedding。使用真实输出的embedding和预测的embedding之间的余弦损失来调优模型。该方法的灵感来自于word2vec,其中相似的单词具有更接近的embedding(以余弦距离来衡量)。同样地,我们预期用户在给定序列之后可能点击的item应该在item embedding空间中接近。使用这种类型的输出将

final layer中的参数数量从embedding的维度。这种方法的一个缺点是:它需要为每个

item提供高质量的embedding。获得这种embedding的一种方法是从上述模型中抽取和重用经过训练的item embedding。这种方式的

label是一个embedding向量,而不再是一个类别。还有一种解决方案:利用负采样技术,从而将

softmax layer转换为一个双塔架构。

5.2 实验

数据集:

RecSys Challenge 2015数据集,其中最后一天的session为测试集(包含15234个session),其它天的session作为训练集(包含7966257个session)。预测的候选item数量为37483。在预处理session之后,我们有23670981个训练序列。为了更好地评估我们的模型(如

privileged information和预训练),我们按时间对训练序列进行排序,然后报告我们在训练序列的最近部分上(评估方式:每个

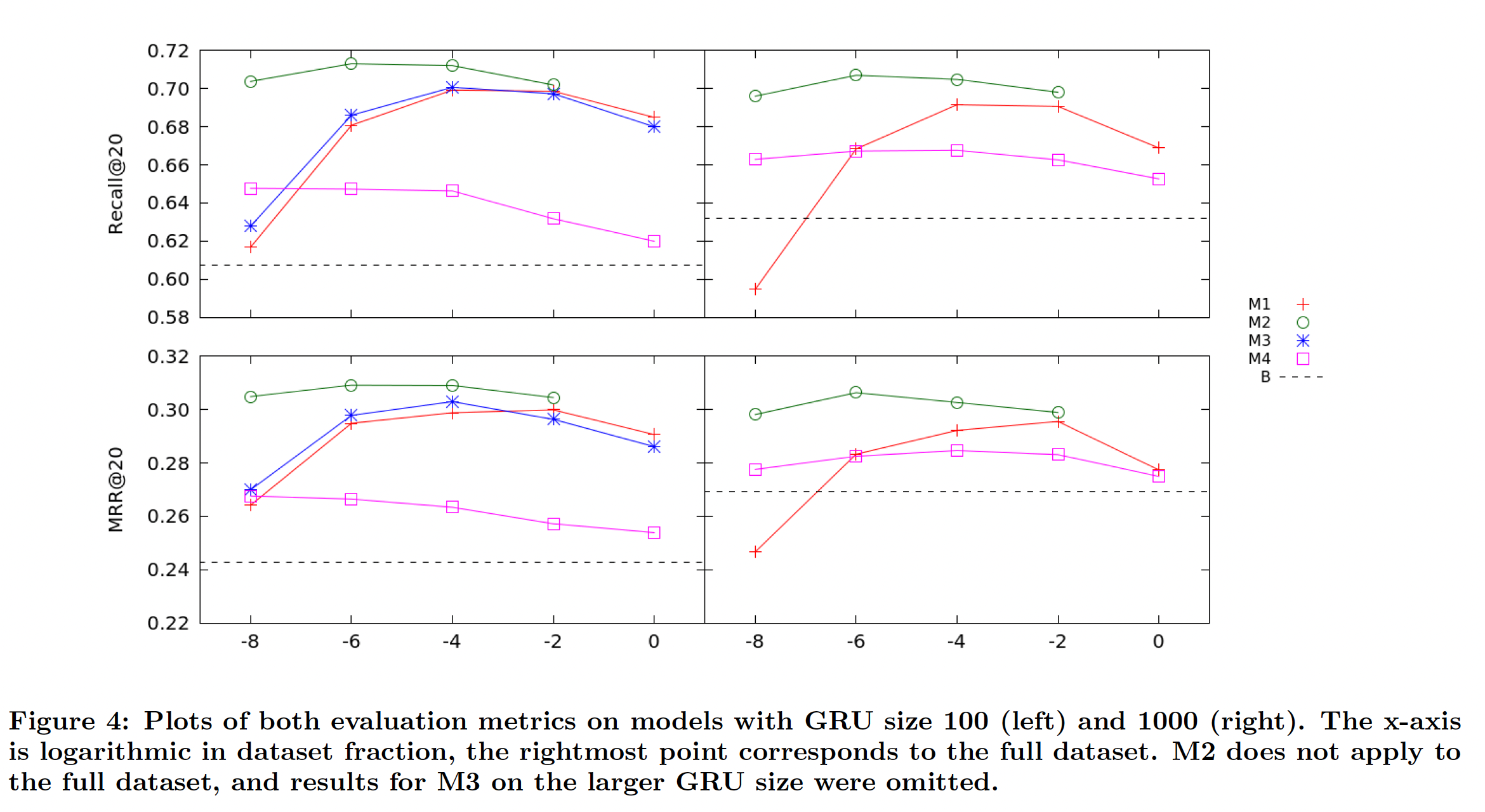

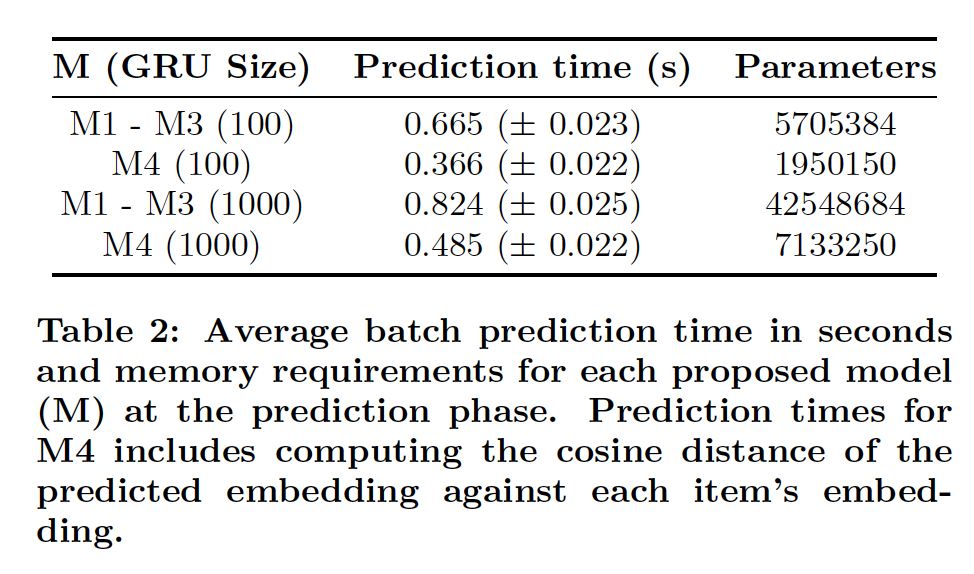

session被item-by-item地输入到模型,计算模型在session的next click的排名。评估指标是Recall@20和Mean Reciprocal Rank (MRR)@20。对于

M1 ~ M3,我们直接从softmax输出中选取top 20个最可能的item。对于M4,我们计算模型输出与item embedding的余弦距离,然后选取top 20个最接近的item。最后,我们还报告了每个模型的模型大小和

batch预测时间。如果模型要部署在真实的推荐系统中,那么这些都是重要的考虑因素。配置:

- 所有模型对

item使用50维的embedding,embedding的dropout rate为25%。 - 我们使用

Adam优化器,batch size = 512。 - 我们将

item序列的长度截断为19,因为99%的原始训练session的长度小于等于19。为简单起见,短于19个item的序列用零填充,RNN将忽略这些零。 - 我们使用

10%的训练数据作为每个模型的验证集来早停,从而设置每个模型的epoch数量。 - 我们在所有模型中都使用单层

recurrent layer,因为我们发现更多的层并未提高性能。每个模型的GRU设置为100个隐单元或1000个隐单元。

模型是在

GeForce GTX Titan Black GPU上,在keras和theano中定义和训练的。每个模型的详细信息(以及它们的label)如下:M1:具有softmax输出、序列预处理、embedding dropout的RNN模型。recurrent layer全连接到输出层。M2:与M1相同,但是针对数据集的最近时间段的部分重新训练了模型。预训练是在整个数据集上进行的,重新训练是在最近部分上进行的(下图的

x轴)。M3:在每个数据中可用的privileged information(未来序列)上训练的M1模型。这用于为参数softmax的温度超参数) 和M1模型提供soft label。我们并没有广泛调优这两个超参数。M4:模型的输出直接预测item embedding。我们在recurrent layer和输出层之间添加了一个全连接的隐层,因为我们发现这提高了模型的稳定性。我们为这些模型使用了embedding,这些embedding是由M1在整个训练数据集上训练得到的。

- 所有模型对

下图总结了每个模型在评估指标上的性能。

M1和M2比报告的baseline RNN模型产生了显著的性能提升。从

M1的结果中,我们看到使用整个数据集进行训练的结果,要比使用使用数据集最近部分重新训练的结果稍差。这表明我们的推荐模型确实需要考虑随时间变化的用户行为。下表还报告了我们表现最好的模型,我们还列出了

《Session-based recommendations with recurrent neural networks》中报告的baseline结果,包括他们最好的、基于RNN的模型(即TOP1和BPR)以及两种传统算法(即S-POP和Item-KNN)。令人惊讶的是,从GRU 100到GRU 1000,我们模型的性能(M1 ~ M3)并未显著提升。

我们发现

privileged information模型(M3)的训练时间非常长。我们省略了GRU size 1000的结果,因为它无法在合理的时间内进行训练。我们认为训练时间急剧增加的主要原因是:需要计算soft label、以及为每个mini-batch计算针对这些soft label的相应交叉熵损失。当可能的soft label数量很大时,这种扩展性很差,就像这里的情况一样。尽管如此,在最小的数据集上(即仅使用最近1/8的训练数据),M3相比M1产生了适度的性能提升。这与《Unifying distillation and privileged information》中privileged information的使用是一致的,并且表明它在可用数据很少的环境中可能很有用。最后,与我们的其它模型相比,

M4在预测准确性方面表现不佳(尽管它仍然比baseline有所提高)。如果可以使用质量更好的embedding作为目标,我们或许能够进一步提升M4的准确性。例如我们没有使用item的任何辅助信息,如类别、品牌。另一方面,

batch prediction时间和模型大小如下表所示。对于M4模型,仅使用基于分类的模型(M1 ~ M3)的大约60%的预测时间就可以在M4中进行预测。M4的参数也少得多,因此需要的内存更少。总之,这些都是使RNN能够部署在真实推荐系统中的步骤。

六、NARM[2017]

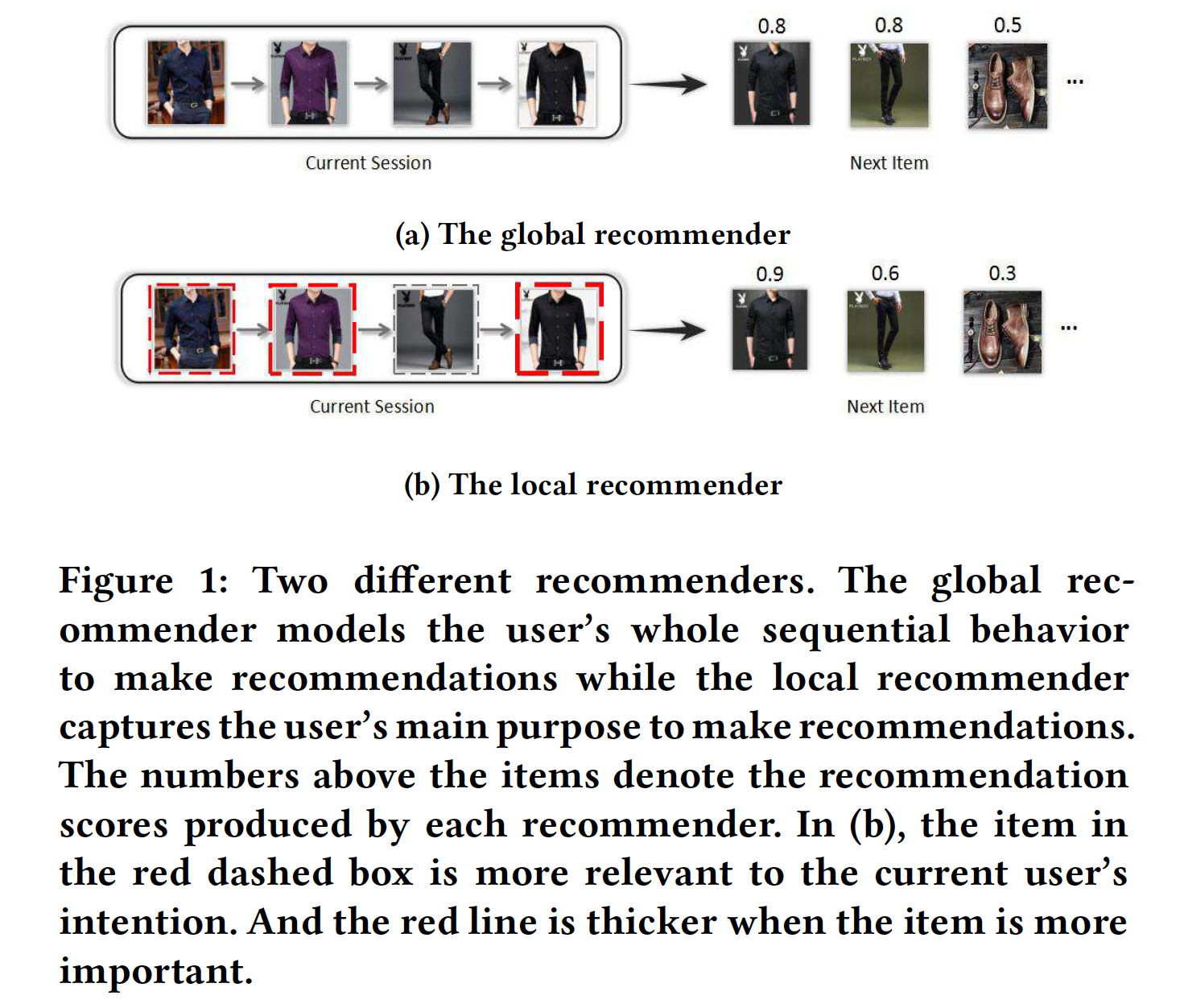

《Session-based recommendations with recurrent neural networks》使用GRU来进行session-based推荐。该模型将用户点击的第一个item作为RNN的初始输入,并据此生成推荐。然后用户可能会点击其中的一个推荐,然后将其输入RNN,并根据之前的全部点击生成后续推荐。《Improved recurrent neural networks for sessionbased recommendations》通过利用两种关键技术,即数据增强、以及一种考虑输入数据分布变化的方法。尽管上述所有RNN-based方法都显示出对传统推荐方法的有效改进,但是它们仅考虑了用户在当前session中的序列行为sequential behavior,而没有强调用户在当前session中的主要意图main purpose。当用户不小心点击了错误的item、或者用户由于好奇而被一些不相关的item所吸引时,仅依赖于用户的序列行为是危险的。因此,论文《Neural Attentive Session-based Recommendation》认为在session-based推荐中应该考虑用户在当前session中的序列行为和主要意图。假设用户想在网上购买一件衬衫。如下图所示,在浏览过程中,该用户倾向于点击一些款式相似的衬衫进行比较,同时该用户可能会偶然或出于好奇而点击一条西裤。之后,该用户一直在寻找合适的衬衫。

- 在这种情况下,如果我们仅考虑用户的序列行为,那么可能会向该用户推荐另一件衬衫、西裤、甚至一双鞋,因为许多用户在点击一些衬衫或西裤之后点击了鞋子,如下图

(a)所示。 - 假设推荐器是一位经验丰富的人工购物向导,那么该向导可以推测该用户此时很可能购买一件短袖衬衫,因为用户的大部分点击

item都与短袖衬衫相关。因此,该向导会更加关注用户点击过的短袖衬衫,并向该用户推荐其它类似的衬衫,如下图(b)所示。

理想情况下,一个优秀的推荐器除了考虑用户的整个序列行为之外,还应该考虑用户的主要意图,这反映在当前

session中一些相对重要的item上。注意,一个session中的序列行为和主要意图是互补的,因为我们并不能总是从session中推测出用户的主要意图,例如当session太短、或者当用户仅仅是漫无目的地点击item时。为了解决上述问题,论文

《Neural Attentive Session-based Recommendation》提出了一种新颖的神经网络框架,即神经注意力推荐机Neural Attentive Recommendation Machine: NARM。具体而言,论文探索了一种具有注意力机制的混合编码器,从而对用户的序列行为进行建模并捕获用户在当前session的主要意图,稍后将它们组合为统一的session representation。通过这种item-level的注意力机制,NARM学会了以不同的方式关注越来越重要的item。然后,论文使用基于统一的session representation的bi-linear matching scheme来计算每个候选item的推荐分。NARM通过联合学习item representation、session representation、以及它们之间的matching来训练。论文主要贡献:

- 提出了一种新颖的

NARM模型,该模型同时考虑用户在当前session中的序列行为和主要意图,并使用bi-linear matching scheme来计算推荐分。 - 应用注意力机制提取用户在当前

session中的主要意图。 - 对两个

benchmark数据集进行了广泛的实验,结果表明:NARM在这两个数据集上的召回率和MRR均优于state-of-the-art的baseline。此外,NARM在long session上取得了更好的性能,这证明了NARM在同时建模用户序列行为和主要意图方面的优势。

- 在这种情况下,如果我们仅考虑用户的序列行为,那么可能会向该用户推荐另一件衬衫、西裤、甚至一双鞋,因为许多用户在点击一些衬衫或西裤之后点击了鞋子,如下图

相关工作:

session-based推荐是基于隐式反馈的推荐系统的典型application,其中没有显式的偏好(如,评分),而只有positive观察(如,点击)可用。我们跟踪用户在一段时间内的positive观察从而获得序列形式的数据。传统方法:通常有两种典型的建模范式,即通用推荐器

general recommender、序列推荐器sequential recommender。- 通用推荐器:通用推荐器主要是基于

item-to-item的推荐方法。在这个setting中,item-to-item的相似性矩阵是根据可用的session数据预先计算的。在session中经常一起点击(即共现)的item之间被认为是相似的。尽管这些方法已被证明是有效的并且被广泛采用,但是它们仅考虑了session的最近一次点击,而忽略了整个点击序列的信息。 - 序列推荐器:序列推荐器基于马尔科夫链,它通过在给定最近一个动作的情况下预测用户的

next action从而利用序列数据。在基于session的推荐任务中应用马尔科夫链的一个主要问题是:当试图在所有item上包含所有可能的、潜在的用户行为序列时,状态空间很快变得难以管理。

- 通用推荐器:通用推荐器主要是基于

基于深度学习的方法:神经网络推荐器

neural network recommender主要关注经典的协同过滤user-item的setting。《Restricted boltzmann machines for collaborative filtering》首先提出使用Restricted BoltzmannMachines: RBM进行协同过滤。《Learning hierarchical representation model for nextbasket recommendation》介绍了基于encoder-decoder机制的、next basket recommendation的hierarchical representation模型。- 最近,

《Session-based recommendations with recurrent neural networks》将RNN应用于session-based推荐,并实现了对传统方法的显著提升。 《Improved recurrent neural networks for session-based recommendations》进一步研究了RNN在session-based推荐中的应用,他们提出了两种技术来提高模型的性能,即数据增强、以及一种考虑输入数据分布变化的方法。《Sequential click prediction for sponsored search with recurrent neural networks》也使用RNN来用于点击序列预测,他们考虑了历史的用户行为、以及每个用户和item上的人工特征。

尽管越来越多关于

session-based推荐的工作关注于RNN-based方法,但是与他们不同,我们提出了一种新颖的神经注意力推荐模型,该模型结合了用户在当前session中的序列行为和主要意图。据我们所知,目前还没有研究考虑到这一点(即,结合了当前session中用户的序列行为和主要意图)。并且,我们首次将注意力机制应用于session-based推荐。

6.1 模型

session-based推荐:session-based推荐任务是在给定用户的序列点击数据时,预测该用户下一步想点击什么。具体而言,令

click session,其中item的编号。我们构建了一个模型session中任何给定的前导点击序列ranking list,item集合的大小,item为next item的概率(即,推荐分)。由于推荐器通常需要为用户提供多个推荐,因此我们为用户推荐ranking listtop-k个item,在本文中,我们提出了一种改进的

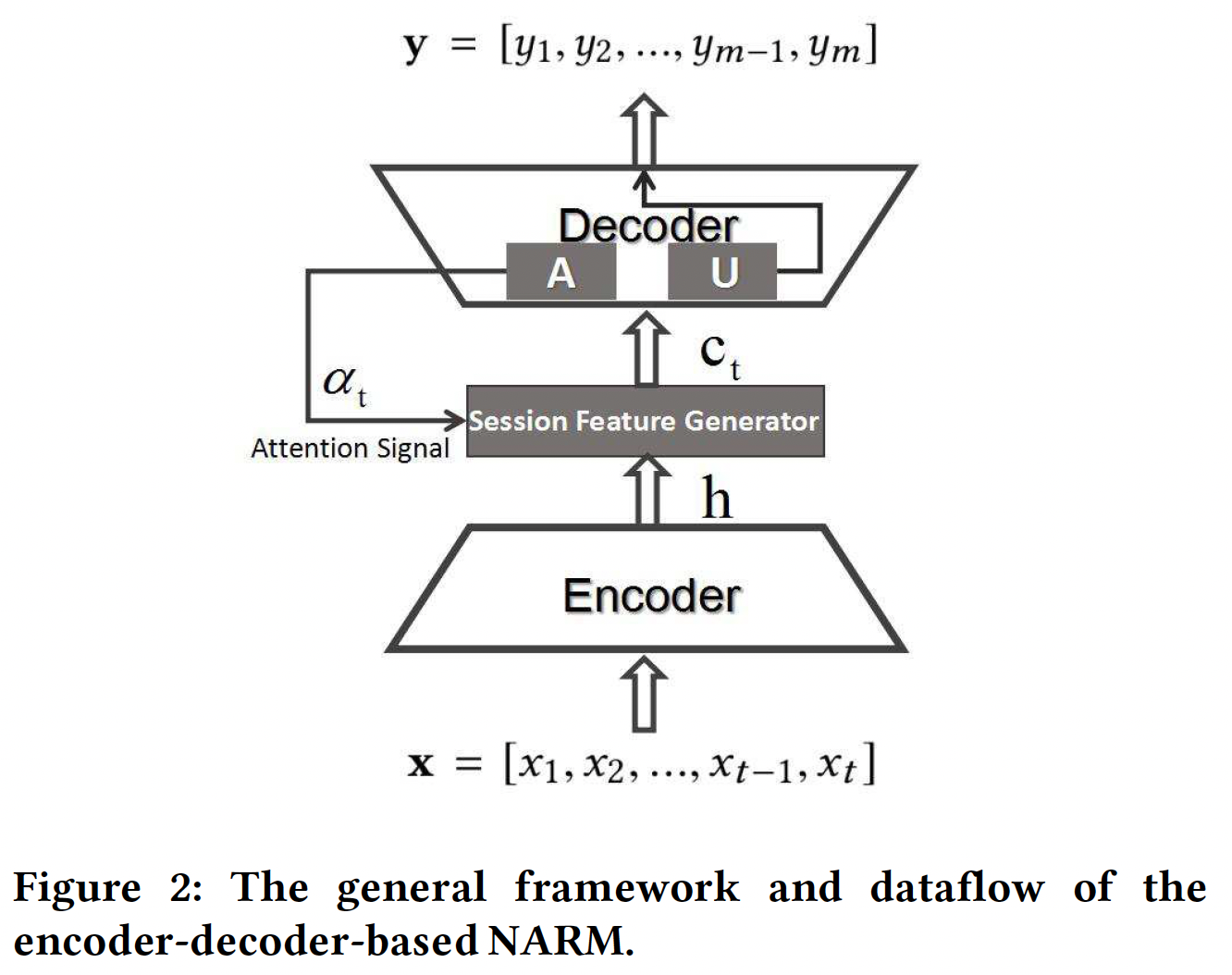

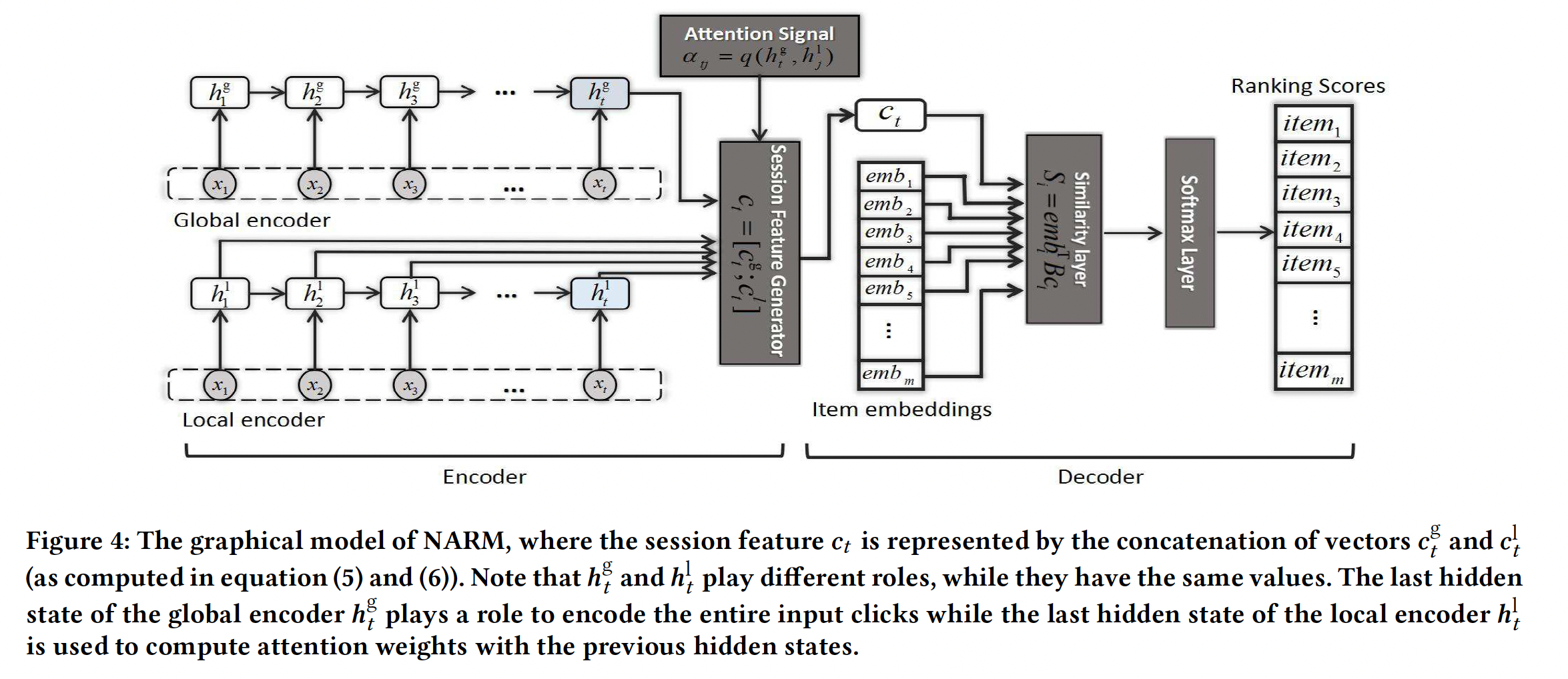

neural encoder-decoder架构来解决session-based推荐问题,该架构被称作Neural Attentive Recommendation Machine: NARM。NARM的基本思想是:构建当前session的hidden representation,然后基于该representation生成预测。如下图所示:编码器将输入的点击序列

hidden representationitem的注意力信号。hidden representation的哪一部分。应该注意的是,setting中,hidden representation或input item embedding的函数。我们在模型中采用动态的setting。然后这组高维的

hidden representation被馈入session feature generator从而构建当前session在时刻representation,记做时刻

session representationsoftmax激活函数)之后生成ranking list

我们工作的基本思想是:学习一个同时考虑用户在当前

session中的序列行为和主要意图的推荐模型。接下来:- 我们首先描述

NARM中的全局编码器,它用于建模用户的序列行为。 - 然后我们介绍了局部编码器,它用于捕获用户在当前

session中的主要意图。 - 最后我们展示了

NARM,它结合了全局编码器和局部编码器,并使用bilinear matching scheme来计算每个候选item的推荐分。

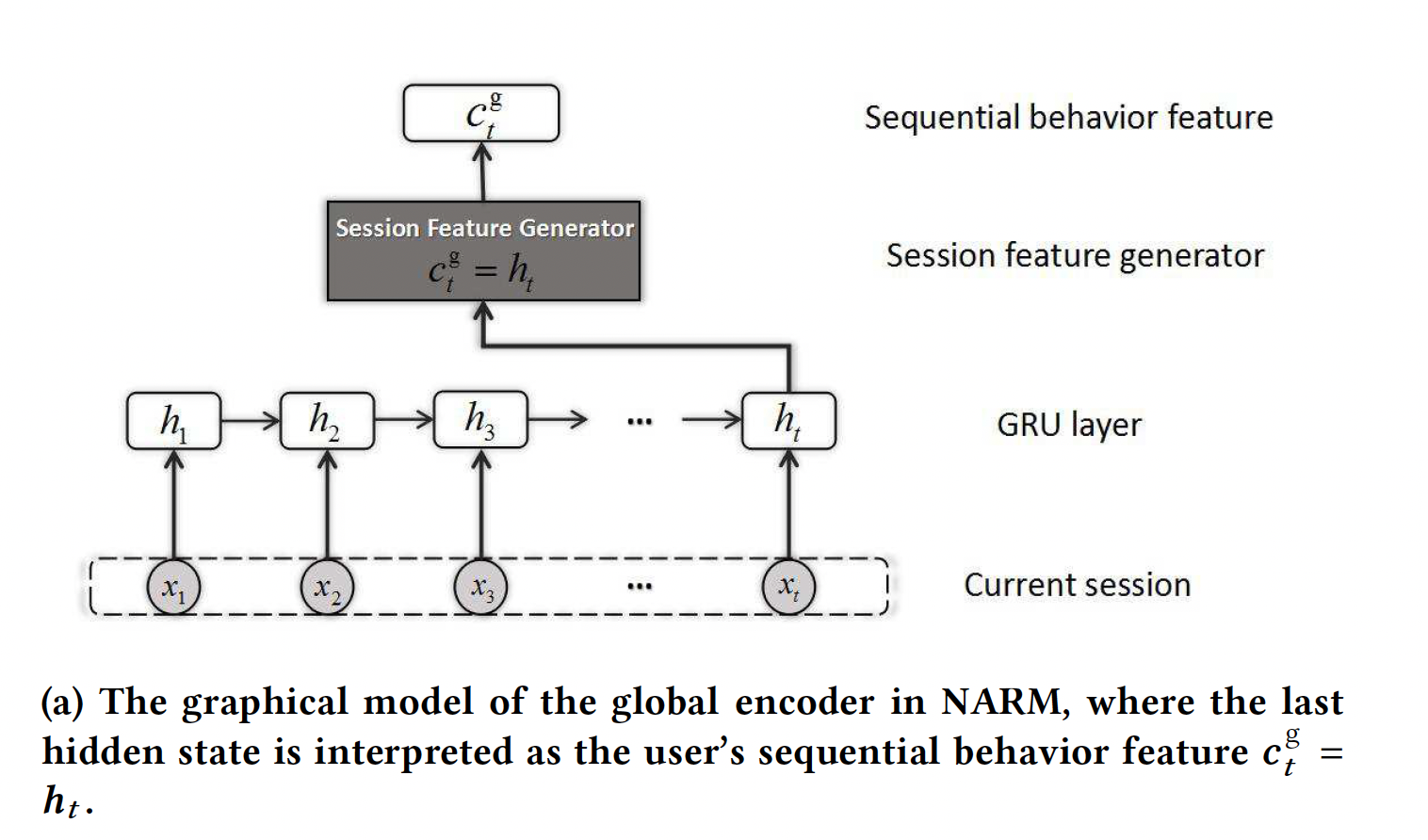

全局编码器

Global Encoder:在全局编码器中,输入是整个先前previous的点击,输出是用户在当前session中的序列行为的feature。输入和输出都是高维的representation向量。下图

(a)展示了NARM中全局编码器的示意图。我们使用GRU单元的RNN而不是标准的RNN,因为《Session-based recommendations with recurrent neural networks》证明了GRU单元在session-based推荐任务中可以胜过LSTM单元。GRU的公式为:其中:

one-hot向量作为input,hidden state,hidden state。update gate,reset gate,

作为一个简单的

session feature generator,我们使用final hidden staterepresentation:然而,这种全局编码器存在缺陷,例如,对整个序列行为的向量化的

summarization通常很难捕获到当前用户的更精确的意图。简单地讲,序列行为中存在噪音,而

RNN架构无法自动化地屏蔽噪音。

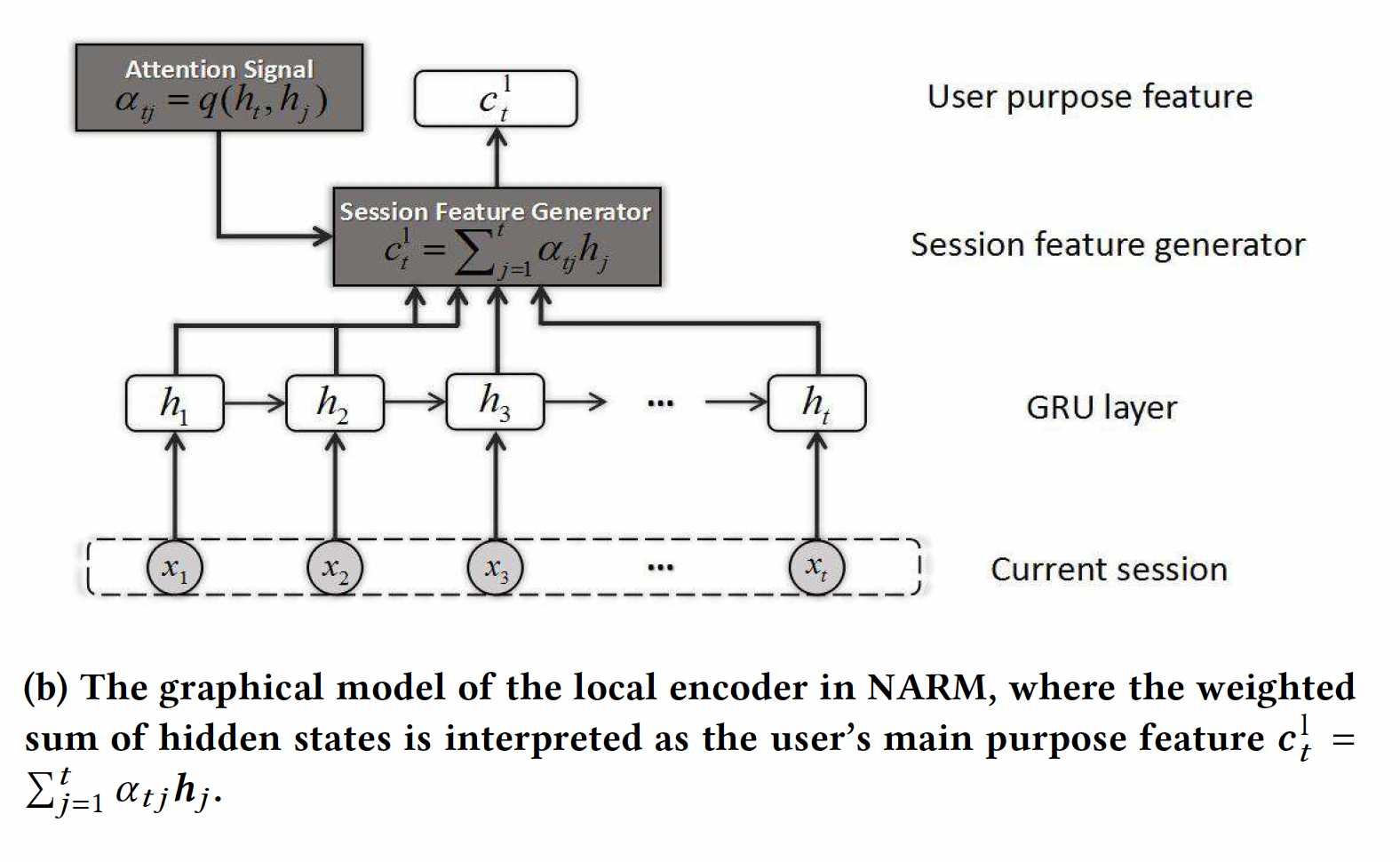

局部编码器

Local Encoder:局部编码器的架构类似于全局编码器,如下图(b)所示。在局部编码器中,我们也采用GRU单元的RNN。为了捕获用户在当前session的主要意图,我们引入了一个item-level注意力机制,它允许解码器动态选择和线性组合输入序列的不同部分:其中加权因子

hidden state的函数:注意,在时刻

next click。基本上,加权因子

input和时刻input之间的alignment进行建模,因此可以将其视为特定的matching model。在局部编码器中,函数final hidden statehidden state其中:

sigmoid激活函数),待学习的参数矩阵attention向量。这种局部编码器能够自适应地关注更重要的

item从而捕获用户在当前session中主要意图。

NARM模型:对于session-based推荐任务,全局编码器summarize了整个序列行为,而局部编码器自适应地选择当前session中的重要item来捕获用户的主要意图。我们推测,在当前session中,序列行为representationrepresentationprevious hidden stateitem的注意力权重。然后在每个时刻,将序列行为的feature和用户意图feature拼接起来作为extended representation。如下图所示,我们可以看到

summarizationNARM提供序列行为represetnation。需要注意的是:NARM中的session feature generator在全局编码器和局部编码器中调用不同的编码机制。具体而言:全局编码器的final hidden statefinal hidden stateprevious hidden state的注意力权重。通过这种混合编码方案,用户在当前

session中的序列行为和主要意图都可以建模为一个统一的representation其中

注意,这里注意力权重

final hidden statefinal hidden state下图给出

NARM中采用的解码机制的示意图。通常,标准的RNN使用全连接层进行解码,但是使用全连接层意味着该层待学习的参数个数是session representionitem的数量。因此我们必须预留很大的空间来存储这些参数。尽管有一些方法可以减少参数,例如hierarchical softmax layer、随机负采样negative sampling,但是它们并不是我们模型的最佳选择。我们提出一种替代的

bi-linear解码方案,它不仅减少了参数的数量,而且提高了NARM的性能。具体而言,我们使用一个bi-linear相似度函数来计算当前session的representation和每个候选item的embedding的相似度得分其中:

item embedding的 维度,item的embedding。然后将每个

item的相似度得分输入到一个softmax layer,从而获得该item接下来会出现的概率。通过使用这种bi-linear decoder,我们将参数数量从bi-linear decoder可以提高NARM的性能。该方法在训练时仍然需要计算

softmax,因此计算复杂度并未降低。但是,该方法降低了参数规模,并且在推断时只需要根据item即可。

为了学习模型的参数,我们没有使用

《Session-based recommendations with recurrent neural networks》中提出的训练过程,其中模型以session-parallel、sequence-to-sequence的方式进行训练。相反,为了适应局部编码器中的注意力机制,NARM分别处理每个序列mini-batch随机梯度下降进行训练:其中:

最后,我们采用固定数量的时间步的

Back-Propagation Through Time: BPTT方法来训练NARM。未来工作:

- 考虑

item的属性,如价格、类目。 - 考虑

nearest neighbor session,以及考虑不同neighbor session的重要性。 - 用注意力机制探索当前

session中,不同属性的重要性。

- 考虑

6.2 实验

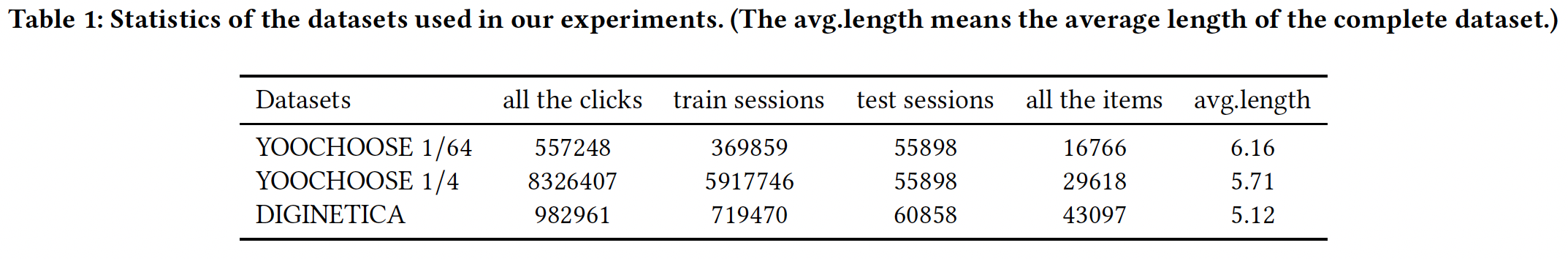

数据集:

YOOCHOOSE数据集:RecSys Challenge 2015发布的公开数据集,它包含电商网站上的click-stream。过滤掉长度为1的session、出现频次低于5次的item之后,数据集剩下7981580个session、37483个item。DIGINETICA数据集:来自CIKM Cup 2016。我们仅使用发布的交易数据,过滤掉长度为1的session、出现频次低于5次的item之后,数据集剩下204771个session、43097个item。

我们首先对两个数据集进行了一些预处理:

- 对于

YOOCHOOSE数据集,我们使用下一天的session进行测试,并从测试集中过滤掉未出现在训练集中的clicked item。 - 对于

DIGINETICA数据集,我们使用下一周的session进行测试,并从测试集中过滤掉未出现在训练集中的clicked item。

由于我们没有以

session-parallel的方式训练NARM,所以序列拆分预处理是必要的。在YOOCHOOSE和DIGINETICA这两个数据集上,对于输入sessionlabel如果以

session-parallel方式训练,那么就不需要拆分预处理。考虑到以下原因:

YOOCHOOSE相当大。《Improved recurrent neural networks for sessionbased recommendations》验证了推荐模型需要考虑随时间变化的用户行为。《Improved recurrent neural networks for sessionbased recommendations》的实验结果表明,对整个数据集进行训练产生的结果相比对数据集的近期部分进行训练产生的结果稍差。

因此,我们按时间对

YOOCHOOSE的训练序列进行了排序,并报告了我们的模型在最近1/64和1/4部分的训练序列上的效果。注意,测试集中的一些item不会出现在训练集中,因为我们仅在近期的部分数据上训练了模型。三个数据集(即YOOCHOOSE 1/64、YOOCHOOSE 1/4、DIGINETICA)的统计数据如下表所示。

baseline方法:我们对比了五种传统方法(POP, S-POP, Item-KNN, BPR-MF, FPMC)以及两种RNN-based模型(GRU-Rec, Improved GRU-Rec)。POP:流行度的predictor,它总是推荐训练集中的流行item。尽管简单,但是它通常是某些领域的强大baseline。S-POP:推荐当前session中最流行的item(而不是全局最流行的item)。该baseline在具有高重复度的领域中很强。Item-KNN:基于item相似性来推荐和当前item最相似的item。相似度定义为此外,我们还使用正则化从而避免冷门

item的偶然发生导致的高度相似性。该

baseline是实际系统中最常见的item-to-item解决方案之一。尽管简单,它通常也是一个强大的baseline。BPR-MF:它通过SGD优化pair-wise ranking目标函数,是最常用的矩阵分解方法之一。矩阵分解无法直接应用于session-based推荐,因为新session没有预先计算的特征向量。然而,我们可以通过使用session中出现的item的特征向量的均值作为user特征向量来克服这个问题。换句话讲,我们对next item的特征向量与迄今为止session中item特征向量的相似性进行平均。FPMC:它是next-basket recommendation的state-of-the-art的混合模型。为了使其适用于session-based推荐,我们在计算推荐分时不考虑user latent representation。GRU-Rec:《Session-based recommendations with recurrent neural networks》提出的模型,它利用session-parallel的mini-batch训练过程,并且还采用ranking-based损失函数来学习模型。Improved GRU-Rec:《Improved recurrent neural networks for sessionbased recommendations》提出的模型,它采用两种技术(包括数据增强、以及一种考虑输入数据分布变化的方法)来提高GRU-Rec的性能。

评估指标:

Recall@20:目标item位于推荐列表(top 20推荐的item)的数量占所有目标item数量的比例。Recall@N不考虑item的实际排名(只需要目标item位于top N推荐分的推荐列表中),并且通常与点击率CTR等其它指标有很好的相关性。MRR@20:Mean Reciprocal Rank: MRR是目标item排名倒数reciprocal rank的均值,如果排名大于20则倒数排名为零。MRR会考虑目标item的排名,这在需要考虑推荐顺序的场景很有用。

实验配置:

NARM的item embedding为50维,使用Adam优化器,初始学习率为0.001,mini-batch的batch size = 512。NARM使用两个dropout layer:- 第一个

dropout layer位于item embedding layer和GRU layer之间,dropout rate = 25%。 - 第二个

dropout layer位于GRU layer和bi-linear similarity layer之间,dropout rate = 50%。

- 第一个

NARM使用time step截断为19的BPTT,训练epoch为30,训练集的10%数据作为验证集。NARM使用单层GRU,GRU隐层维度为100。模型是在

GeForce GTX TitanX GPU上的Theano中定义和训练的。

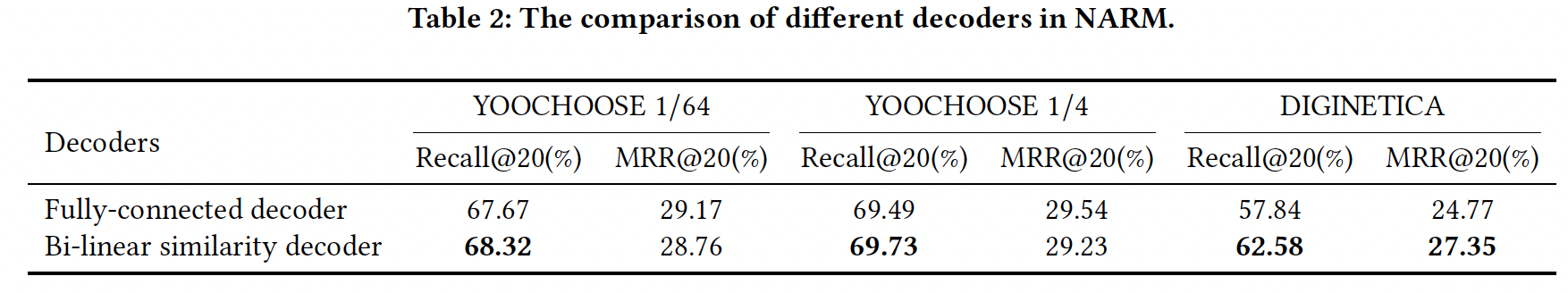

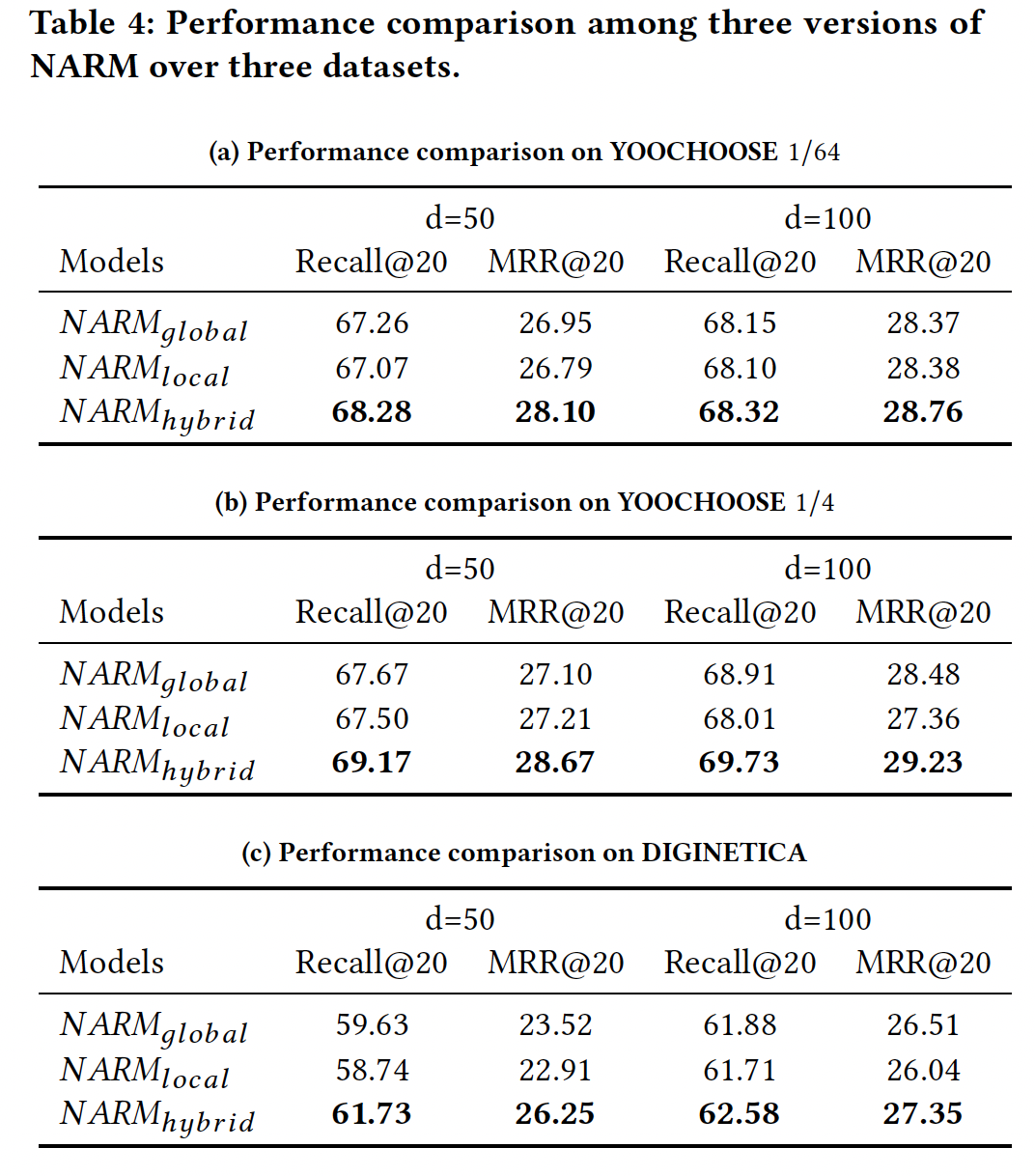

不同解码器的比较:我们在

NARM上比较了全连接解码器和bi-linear解码器,如下表所示。这里我们仅给出隐层维度为100的结果,因为其它维度的结论相同。结论:- 在

Recall@20指标上,使用bi-linear解码器的性能有所提高,三个数据集的提升分别约为0.65%, 0.24%, 4.74%(绝对值) 。 - 在

MRR@20指标上,bi-linear解码器在YOOCHOOSE 1/64和YOOCHOOSE 1/4数据集上稍差,但是在DIGINETICA数据集上仍然显著优于全连接解码器。

对于

session-based推荐任务,由于我们的setting是一次性推荐top 20的item,因此我们认为recall指标要比MRR指标更重要。在接下来的实验中,NARM采用bi-linear解码器。

- 在

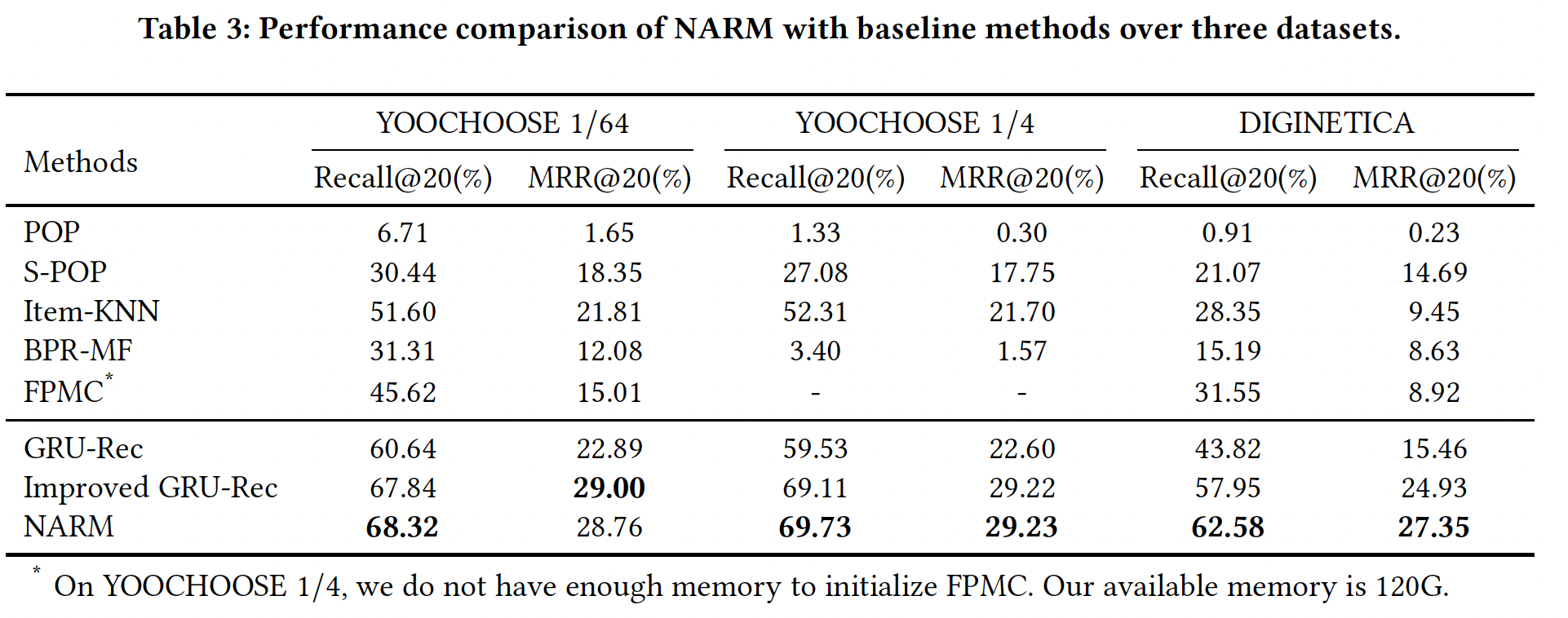

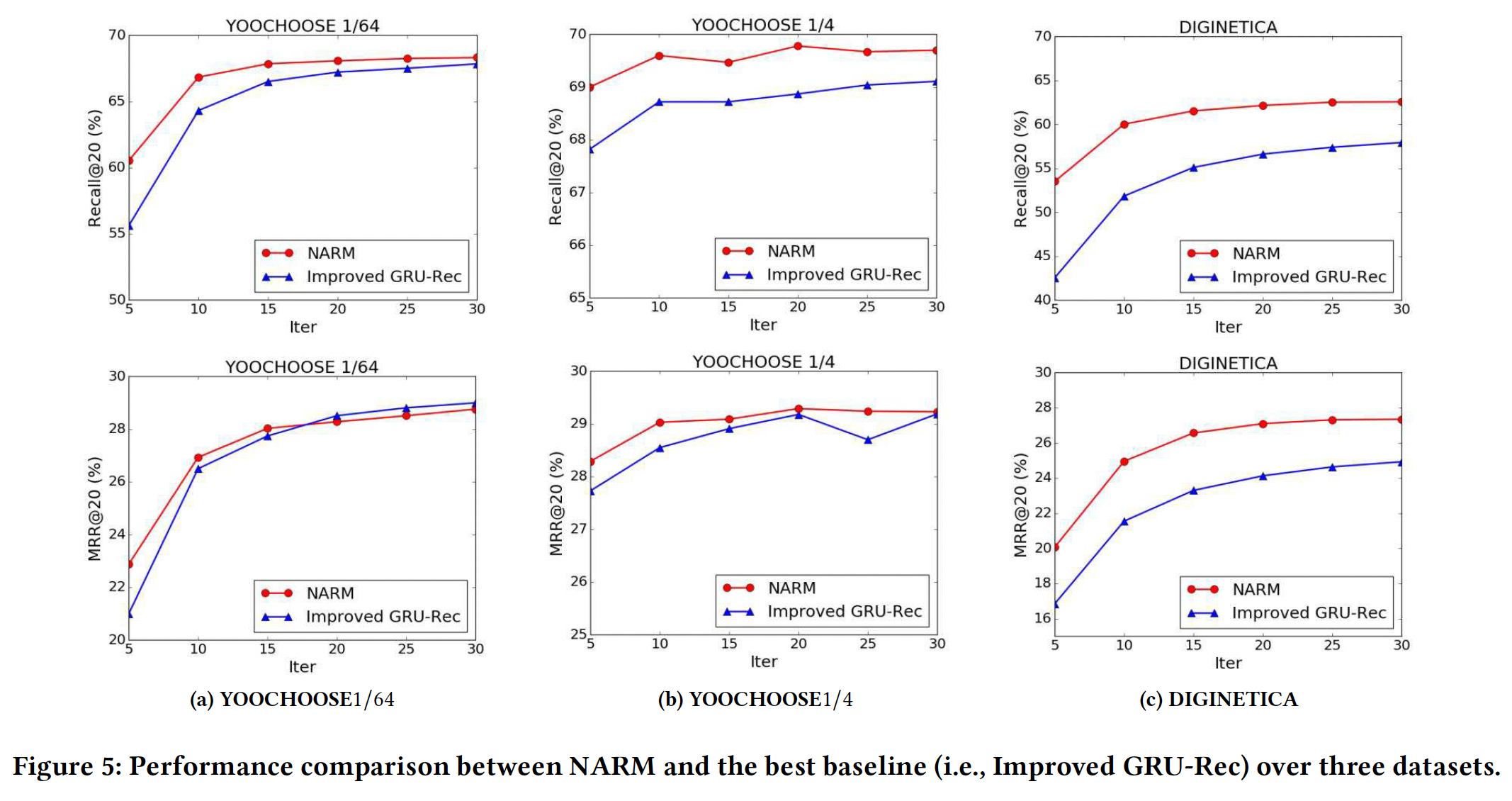

和

baseline的比较:所有方法的结果如下表所示。NARM与best baseline(即Improved GRU-Rec)之间的更具体的比较如下图所示。结论:对于

YOOCHOOSE 1/4数据集,由于我们使用session中出现的item factor的均值来代替user factor,因此BPR-MF不起作用。此外,由于我们在FPMC中将每个session视为一个用户,因此我们没有足够的内存来初始化它。这些问题表明传统的user-based方法不再适用于session-based推荐。总体而言,三种

RNN-based方法始终优于传统的baseline,这表明RNN-based模型擅长处理session中的序列信息。通过同时考虑用户的序列行为和主要意图,

NARM在三个数据集上的Recall@20指标上优于所有baseline,并且在MRR@20指标上可以优于大多数baseline。以

DIGINETICA数据集为例,与best baseline(即Improved GRU-Rec) 相比,NARM在Recall@20和MRR@20指标上的相对提升分别约为7.98%和9.70%。可以看到,

NARM和best baseline相比,YOOCHOOSE 1/64和YOOCHOOSE 1/4数据集上的Recall@20指标提升不如DIGINETICA数据集的显著。此外,YOOCHOOSE 1/64和YOOCHOOSE 1/4数据集上这两个方法的MRR@20指标非常接近。我们认为其中一个重要原因是:我们将

YOOCHOOSE数据集拆分为1/64和1/4时,为了与Improved GRU-Rec中的一致,我们没有从测试集中过滤掉不在新训练集(即,拆分后的训练集)中的clicked item(因为这些clicked item可能位于未拆分的训练集中)。相比之下,在DIGINETICA数据集中,我们从测试集中过滤掉了这些不在训练集中的clicked item,因此NARM在Recall@20和MRR@20指标上都显著优于baseline。

使用不同特征的影响:我们考察仅使用序列行为特征的

NARM(NARM(NARM(session的序列行为、或用户意图,可能无法学到好的推荐模型。session-based推荐中同时考虑当前用户的序列行为和主要意图的优势。

GRU-Rec主要区别在于前者使用双线性解码器,以及前者采用交叉熵损失而后者采用pairwise ranking loss,因此其效果应该和GRU-Rec相差无几。但是结果发现GRU-Rec高很多。论文并未解释其原因。

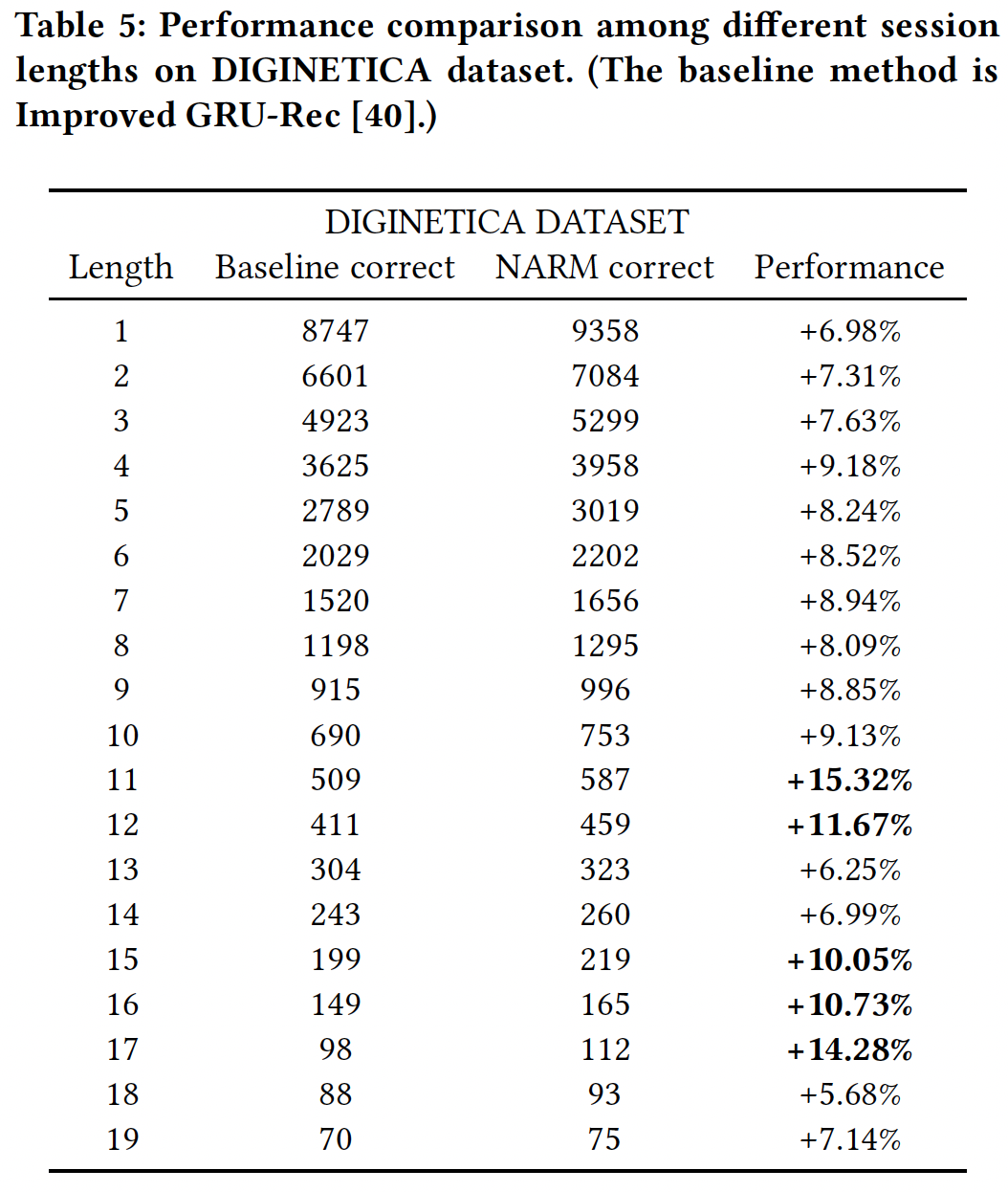

不同

session长度的影响:NARM模型基于这样的假设:当用户在线浏览时,用户的点击行为频繁地围绕用户在当前session中的主要意图。然而,当用户仅仅是点击少数几个item时,我们很难捕获到用户的主要意图。因此,我们的NARM模型应该只是擅长对长的session进行建模。为了验证这一点,我们在

DIGINETICA数据集上对不同长度的测试session进行了比较,结果如下表所示。结论:NARM通常在session长度为4 ~ 17之间时表现更好。这表明NARM在长的session中确实更准确地捕获了用户的主要意图。- 当

session过长时,NARM的性能提升有所下降。我们认为原因是,当session过长时用户很可能漫无目的地点击某些item,导致NARM中的局部编码器无法捕获用户在当前session中的主要意图。

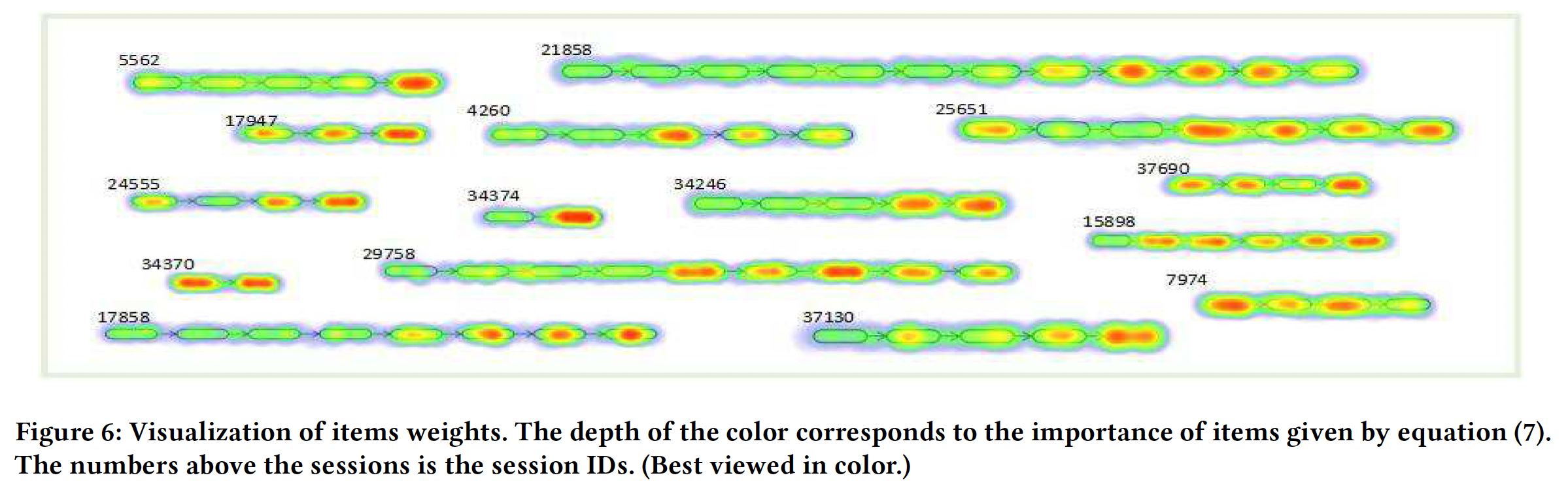

可视化注意力权重:为了直观地说明注意力机制的作用,我们在下图中展示了一个例子。

session实例是从DIGINETICA数据集中随机选择的。颜色的深浅对应于item的重要性大小。结论:- 总体而言,很明显并不是所有的

item都与next click相关,而且当前session中几乎所有的重要item都是连续的。这意味着用户在session中的意图确实是局部性的,这也是NARM能够优于常规RNN-based模型的原因之一。 - 最重要的

item通常在session结束附近的位置。这符合人们的浏览行为:用户很可能会点击该用户刚刚点击item相关的其它item。回想一下,常规RNN-based模型能够对这一事实进行建模,因此它们可以在session-based推荐中取得相当好的性能。 - 在某些情况下,最重要的

item出现在session的开始或中间(例如在session 7974或session 4260)。在这种情况下,我们相信NARM可以比常规RNN-based模型表现更好,因为注意力机制可以学到去更多地关注于更重要的item,而不管这个item位于session中的什么位置。

- 总体而言,很明显并不是所有的

七、HRNN[2017]

session是在给定时间范围time frame内发生的一组交互。同一个用户的不同session可以发生在同一天,也可以发生在数天内、数周内、甚至数月内。一个session通常有一个目的goal,例如找到一家好餐馆、或者听到某种风格的音乐。在这些领域提供推荐带来了独有的挑战

unique challenge,直到最近,这些挑战主要通过在最近一次交互、或者最近一个session上应用传统的推荐算法来解决。在session-based推荐中,仅基于当前的user session来提供推荐,因为假定用户是匿名的。但是在许多此类系统中,用户可能已经登录、或者存在某种形式的user id(如cookie)。在这些情况下,可以合理地假设:同一个用户的历史session行为可能会为next session中的推荐提供有价值的信息。在

session-based算法中,结合历史的user session信息的一种简单方法是:简单地拼接历史的user session和当前的user session。虽然这似乎是一种合理的方法,但论文《Personalizing Session-based Recommendations with Hierarchical Recurrent Neural Networks》将在实验部分看到这不会产生最佳效果。在论文

《Personalizing Session-based Recommendations with Hierarchical Recurrent Neural Networks》中,作者描述了一种基于RNN的新算法,该算法可以同时处理如下两种case:session-aware推荐:当存在user id时,将信息从前一个user session传播到下一个user session从而提高推荐准确率。session-based推荐:当没有历史的user session时(例如没有user id)。

该算法基于

Hierarchical RNN,其中当一个user session结束时,lower-level RNN的hidden state作为输入而传递给higher-level RNN。而这个higher-level RNN旨在为用户下一个user session的lower-level RNN的hidden state提供良好初始化。论文在来自行业内的两个数据集上评估了

Hierarchical RNN,结果表明论文的方法优于普通的session-based RNN、以及item-based协同过滤。相关工作:

session-based推荐:当没有用户画像时(因此也没有user id,从而无法获取该用户的所有历史行为),那么经典的CF方法(如矩阵分解)在session-based setting中失效。这个问题的一个自然解决方案是item-to-item推荐方法。在这个setting中,从可用的session数据中预先计算出一个item-to-item相似度矩阵,并且在session中经常一起被点击的item被认为是相似的。然后使用这些相似性来执行推荐。这种方法虽然简单,但是已被证明是有效的,并且被广泛采用。但是,这些方法仅考虑用户的最近一次点击,而忽略了用户之前的点击信息。递归神经网络模型:

RNN是处理序列数据的首选深度模型。LSTM网络已被证明是工作良好的RNN模型,其略微简化的版本是GRU。我们在这项工作中使用GRU。- 在

《Session-based recommendations with recurrent neural networks》中,RNN被首次用于对session数据进行建模。RNN在session中item ID的one-hot representation上使用ranking loss进行训练。然后,RNN用于在新的session中每次点击之后提供推荐。该方法仅关注当前session,而我们的目标不仅考虑当前session也考虑跨session的用户行为建模。 - 在

《Parallel recurrent neural network architectures for feature-rich session-based recommendations》中,RNN还被用于联合建模item的内容以及点击序列。通过包含诸如缩略图或文本描述等item特征,该论文提出的所谓的parallel- NN提供了优于普通RNN的推荐质量。 - 在

《Improved recurrent neural networks for session-based recommendations》中,作者提出了数据增强技术来提高session-based推荐的RNN性能。因为单个session被分为几个sub-session进行训练,因此该方法具有增加训练时间的副作用。 RNN也被用于标准的user-item协同过滤setting,其目的是对user factor和item factor的演变进行建模。结果虽然不那么突出,该方法几乎没有优于标准的矩阵分解方法。- 在

《A hierarchical recurrent encoder-decoder for generative context-aware query suggestion》中,Hierarchical Recurrent Neural Network的seq-to-seq模型被用于生成上下文感知的query suggestion。

- 在

7.1 模型

7.1.1 Session-based RNN

我们的模型基于

《Session-based recommendations with recurrent neural networks》中提出的session-based RNN模型,其中RNN基于单层GRU layer来建模用户在session内的交互。RNN将session中的当前item ID作为输入,并为每个item输出一个得分表示成为session中next item的可能性。形式上,对于第

sessionsession的item数量,session中的第item,RNN将计算如下所示的session-level representation:其中:

session-level GRU,GRU在step t的hidden state并且null vector),step t item IDone-hot向量。RNN的输出是item集合中每个item的得分item成为session中next item(即第item集合。其中

softmax或tanh),具体取决于损失函数。在训练期间,将得分

next item IDonehot向量进行比较来计算损失函数。网络可以使用多种ranking loss function进行训练,如交叉熵、BPR、TOP1。在这项工作中,TOP1损失总是优于其它ranking loss,因此我们在本文的剩余部分仅考虑该损失函数。TOP1损失是relevant item(即next item)的相对排名的正则化近似。relevant item的相对排名定义为:其中:

relevant item的得分。irrelevant item的得分,sigmoid来近似。

为了迫使

negative item(即irrelevant item)的分数趋于零,在损失函数中添加了一个正则化项。最终的损失函数为:RNN通过session-parallel的mini-batch来进行有效地训练。在每个训练step,batch的current item ID of sessions(以one-hot向量来表示)。session-parallel机制在mini-batch中保留指向每个session的当前item的指针,并会在session结束时重置RNN的hidden state。为了进一步降低计算复杂度,损失函数是在

current item ID和负采样的item ID上计算而来。具体而言,在计算损失函数时,将每个session的current item ID作为postive item、将mini-batch中其它session的所有item ID作为negative item。这使得无需执行显式的negative item采样,并执行了基于流行度popularity-based的采样。然而,由于user id在纯的session-based场景中是未知的,因此negative item很有可能被同一个用户在其它session中交互的postive item所“污染”。这种方式称作

in-batch负采样。另外,既可以将其它session的current item ID作为negative item(实现更简单),也可以将其它session的所有item ID作为negative item(效果更好)。

7.1.2 个性化的 Session-based Hierarchical RNN

我们的

HRNN模型在RNN之上通过以下方式构建:- 添加一个额外的

GRU layer来建模跨user session的信息。 - 使用强大的

user-parallel mini-batch机制进行高效地训练。

- 添加一个额外的

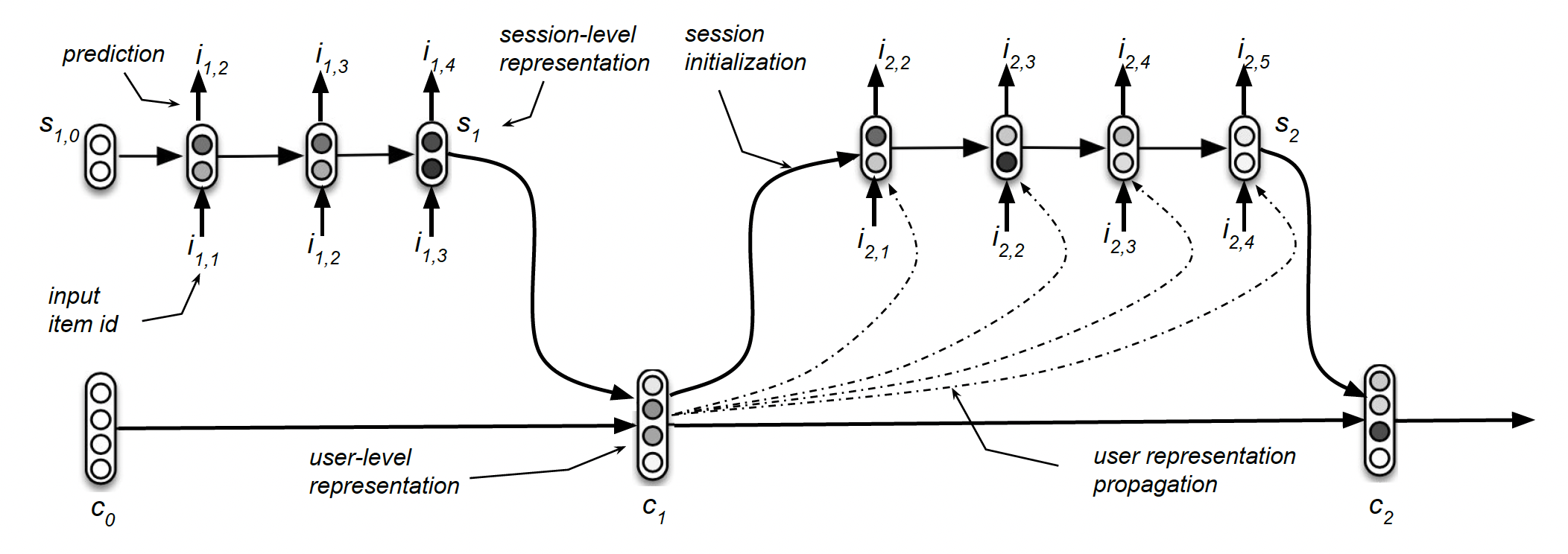

架构:除了

session-level GRU之外,我们的HRNN模型还添加了一个user-level GRU(session的用户活动。下图展示了HRNN的结构示意图。- 在每个

time step,由RNN中的一样。 - 但是,当

session结束时,user-level representation通过 - 当一个新的

session开始时,hidden state(即user-level representation)用于初始化

形式上,对于每个用户

session集合user-level GRU将session-level representationuser-level representationsession数量,user sessionlast hidden state。接下来为了便于表述,我们移除了

user上标user-level representation其中

null vector)。session-level GRU的last hidden state作为user-level GRU的输入。通过这种方式,user-level GRU可以跨session跟踪用户的演变,从而无缝地建模动态的用户兴趣。注意,user-level representation在整个session期间保持固定,并且仅在session结束时更新。然后使用

user-level rerepsentation来初始化session-level GRU的hidden state。给定session的session-level GRU的初始hidden state其中:

initialization权重矩阵,initialization偏置向量。通过这种方式,用户在先前session中表达的偏好相关的信息在session-level被传递。session-level representation更新为:其中方括号表示

session-level GRU的输入。如果仅仅是为了跨

session来传递用户的偏好,那么可以简单地将上一个session的last hidden state传递给下一个session。那么user-level GRU的价值在哪里?论文的解释是:user-level GRU建模了user-session如何随着时间的演变,即 “计算并演变了用户画像” 。此外论文还在实验部分评估了这种做法的效果(即

RNN Concat这个baseline),实验发现RNN Concat和HRNN在小型数据集上的效果相差无几,但是在大型数据集上HRNN效果显著优于RNN Concat。所以HRNN需要更大规模的数据才能体现其优势,因为HRNN的模型容量更大。- 在每个

模型使用反向传播进行端到端训练。

- 如果

user-level rerepsentationsession之间更新,即session结束时以及接下来的session开始时。 - 如果

user-level rerepsentationsession内保持不变),session内更新。 - 我们也尝试将

user-level representation传播到final prediction layer,即RNN而言,新模型的性能严重下降。因此,我们在本次讨论中放弃了这种setting。

注意,

user session的hidden state传递给下一个user session,而且还学习(在训练期间)user session如何随时间的演变。我们将在实验部分看到,这对于提高性能至关重要。实际上,user session),因此实际上个性化了RNN中,具有相同点击item序列的user session,模型将为这些用户提供相同的推荐。在HRNN中,情况不再如此,推荐结果也会受到用户历史session的影响。总之,我们考虑了以下两种不同的

HRNN setting,具体取决于公式user representationHRNN Init:其中next session的representation。HRNN All:其中next session的representation,也用作next session的输入。HRNN All相比于HRNN Init的模型复杂度稍高。

正如我们将在实验部分看到的,根据推荐场景,这两种

setting可能会导致截然不同的结果。- 如果

学习:为了提高训练效率,我们调整了

《Parallel recurrent neural network architectures for feature-rich session-based recommendations》中描述的session-parallel mini-batch机制,从而考虑训练期间的user id,如下图所示。我们首先根据用户对

session进行分组,然后按照时间戳对每个分组内的session事件进行排序。然后我们对用户进行随机排序。在第一次迭代中,前面session的第一个item构成了HRNN的输入,对应session的第二个item构成了HRNN的输出。然后我们将HRNN的输出作为下一次迭代的输入,依此类推。当

mini-batch中的session结束时,更新hidden state、并为下一个session来初始化hidden state。当一个用户被完全处理之后,hidden state都被重置,mini-batch中下一个用户将被放到这个被处理完的用户的位置进行处理。使用

user-parallel mini-batch,我们可以有效地训练HRNN从而满足不同session数量、以及session内不同长度的用户。此外,这种机制允许以独立于用户的方式对负样本进行采样,从而减少负样本被实际正样本“污染” 的机会。采样过程仍然是基于流行度

popularity的,因为一个item出现在mini-batch中的可能性与其流行度成正比。众所周知,这两个特点都有利于基于隐式用户反馈的pairwise learning。因为负样本是从其它用户那里采样到的,因此可以减少污染机会。

未来工作:

- 使用注意力模型、

item特征、用户特征,从而进一步改善user representation并进一步提升session-based推荐方法。 - 在其它领域研究

session-based个性化模型,例如音乐推荐领域、电商领域、在线广告领域。

- 使用注意力模型、

7.2 实验

数据集:

XING数据集:XING Recsys Challenge 2016数据集,包含80天内77万用户的job posting交互信息。用户交互带有时间戳和交互类型(点击、添加书签、回复、删除)。VIDEO数据集:来自类似于Youtube的视频点播网站的专属数据集,包含13k用户在2个月内观看的视频。观看时长小于指定阈值的事件被丢弃。

我们使用

30分钟空闲阈值来手动地将交互数据拆分为session。对于XING数据集,我们丢弃了 “删除” 类型的交互。我们还丢弃了session中相同类型的重复交互从而减少噪音(例如在session中重复点击同一个job posting)。然后我们对两个数据集进行如下预处理:

- 我们删除了

XING数据集中出现频次低于20的item,删除了VIDEO数据集中出现频次低于10的item,因为低频item不是建模的最佳选择。 - 我们删除了交互次数少于

3次的session从而过滤太短且信息量不足的session。 - 我们删除了

session总数低于5个的用户,从而使得用户具有足够多的cross-session信息,以便对用户进行正确的建模。

我们使用每个用户的最后一个

session构建测试集,剩余的session构成训练集。我们还过滤了测试集中不属于训练集的item。这种划分允许针对具有不同历史session数量的用户进行评估,从而衡量模型对不同活跃程度的用户的推荐质量。我们使用相同的程序进一步划分验证集从而调优算法的超参数。数据集的统计信息如下表所示。

baseline方法:Personal Pop: PPOP:推荐用户交互次数最多(而不是全局交互次数最多的item)。Item-KNN:根据session内item的共现来计算item-to-item的余弦相似度。RNN:采用《Session-based recommendations with recurrent neural networks》中提出的模型,该模型使用TOP1损失函数以及session-parallel mini-batch(来自同一个用户的session彼此独立地馈入RNN)。RNN Concat:与RNN相同,但是来自同一个用户的所有session被拼接为单个session。这相当于

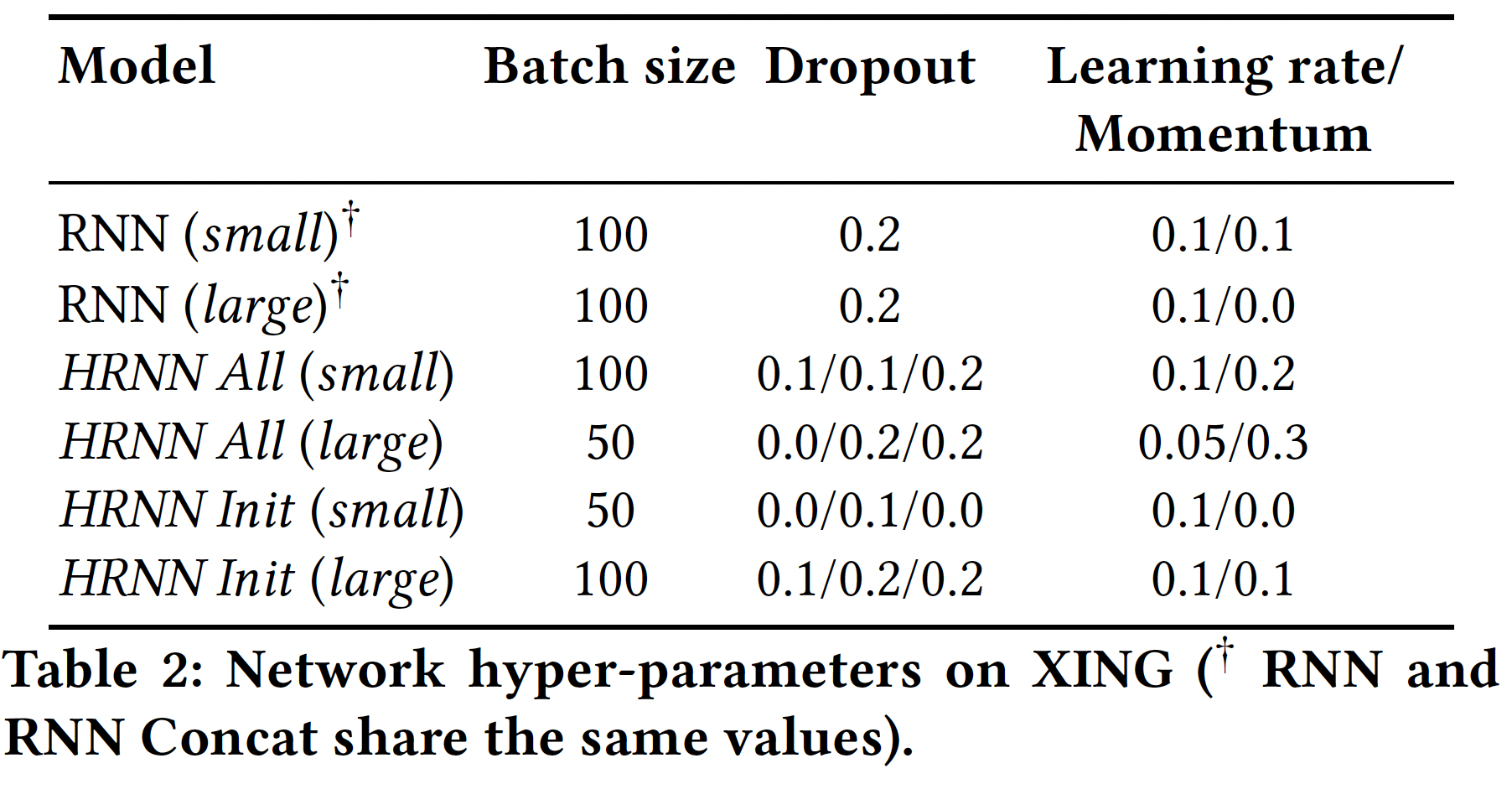

配置:

我们使用

AdaGrad来优化TOP1损失函数的神经网络模型,训练10个epoch。在所有模型中,增加epoch数量并未显著改善损失。我们对

RNN和HRNN的hidden state使用了dropout正则化。我们还将dropout应用于HRNN的我们在

hierarchy的两个level中都采用了单层GRU,因为使用多层GRU layer并没有提高性能。为了评估网络容量如何影响推荐质量,我们考虑了每个

GRU layer具有100个隐单元的小型网络、以及具有500个隐单元的大型网络。我们使用随机搜索

random search在验证集上调优了每个模型(包括baseline模型)的超参数。为了帮助我们实验的可复现性,我们在下表中报告了我们在XING数据集上的、在实验中使用的超参数。HRNN中的user-level GRU、session-level GRU、以及初始化都使用了dropout,因此下表中给出的dropout概率按照这个顺序提供。对于所有的数据集,Item-KMM的最佳邻域大小都是300。

神经网络模型在

12GB GPU内存的Nvidia K80 GPU上进行训练。训练时间从XING上的小型RNN模型的5分钟,到VIDEO上的大型HRNN All的30分钟不等。所有实验的评估时间不超过2分钟。我们要强调的是,

RNN和HRNN之间的训练时间没有显著差异,其中HRNN All是计算成本最高的模型,因为其架构的复杂性更高。

评估方式:我们评估序列的

next-item prediction task,即给定user session的事件,我们评估算法预测后续事件的效果。所有RNN-based模型都一个接一个地在session中输入事件,我们检查next item的预测排名。此外,

HRNN模型和RNN Concat使用测试session之前的所有历史session,这会降低评估速度,但是有必要在评估开始之前正确地设置个性化模型的internal representation(如HRNN的user-level representation)。注意,评估指标仍然仅针对测试集中的事件进行计算,因此评估仍然是公平的。此外,我们在每个测试

session中丢弃了由RNN Concat baseline计算的第一个预测,因为它是唯一的、能够推荐user session中首个事件的方法。其它方法都只能最早预测

user session中第二个事件。由于推荐系统一次只能推荐几个

item,因此relevant item应该在推荐列表中排名靠前。因此我们选择Recall@5、Precision@5、Mean Reciprocal Rank (MRR@5)等指标来评估推荐质量。Recall@5:相当于命中率指标,它衡量所有测试case中,relevant item在top-5的case的占比。对于推荐顺序无关紧要的场景,这是一个良好的指标,并且该指标与CTR等重要KPI密切相关。Precision@5:衡量所有推荐列表的top-5位置中正确推荐的比例。MRR@5:relevant item的排名的倒数reciprocal rank,如果排名大于5则排名的倒数被手动置为零。MRR会考虑item的排名,这在推荐顺序要紧的情况下很重要。

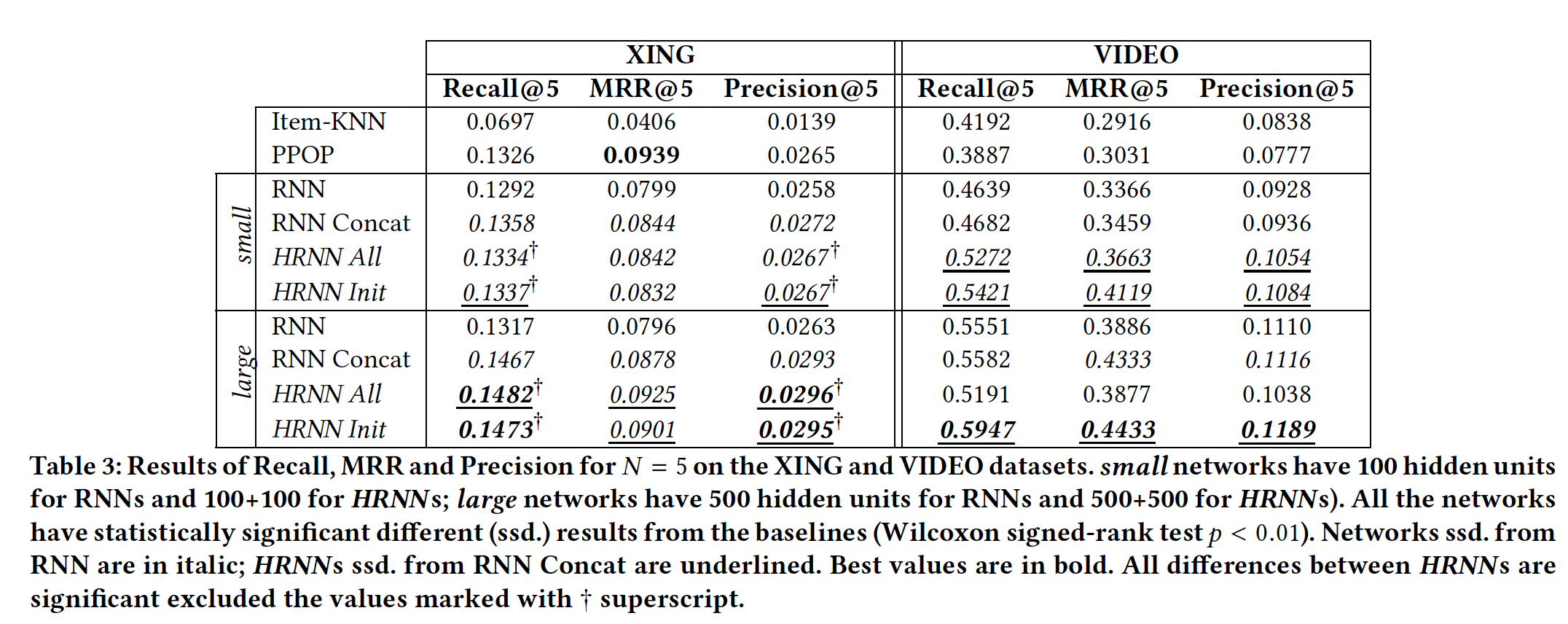

实验结果:下表给出了

XING和VIDEO数据集的结果。我们使用不同的随机数种子对每个神经网络模型进行了10次训练,并报告了平均结果。我们使用Wilcoxon signed-rank test来评估HRNN模型与baseline方法之间差异的显著性。XING数据集的结果:简单的

PPOP baseline就是一种非常有竞争力的方法,能够大大超越更复杂的Item-KNN baseline。正如前人工作对数据集的研究已经表明,用户在sessoin内和跨session之间的活动具有高度的重复性。这使得在这种情况下生成non-trivial的个性化推荐非常具有挑战性。session-based RNN较差的性能进一步突出了这一点,无论网络容量如何,它总是比PPOP差得多。尽管如此,

session-based个性化推荐可以克服其局限性,并在小型网络和大型网络的Recall和Precision指标上实现卓越的性能。HRNN在Recall和Precision指标上显著优于RNN Concat,并且在大型网络上提供显著更好的MRR。此外,

HRNN在Recall和Precision指标上显著优于强大的PPOP baseline大约11%,同时获得了可比的MRR。两个

HRNN变体之间并没有显著的差异,除了在MRR指标上HRNN All比HRNN Init略有优势。Recall和Precision指标上的差异并没有统计显著性。RNN Concat与HRNN All, HRNN Init相差无几,但是在文章末尾的大型数据集上,HRNN效果要好得多。这是符合预期的,因为HRNN的模型复杂度更高,所以需要更大量的数据才能体现其能力。

VIDEO数据集的结果:该数据集上显示出与XING数据集截然不同的结果。Item-KNN baseline显著优于PPOP,而session-based RNN可以大大优于这两个baseline。这与过去一些工作在类似数据集上的实验结果一致。RNN Concat相比较于session-based RNN具有可比的Recall和Precision。有趣的是,RNN Concat大型网络的MRR指标明显更好。这表明直接拼接session不会增强RNN推荐器的检索能力,但是会增强其正确排序item的能力。HRNN Init的性能显著优于所有baseline。换句话讲,在相同的情况下,由HRNN建模的更复杂的cross-session dynamic在整体推荐质量方面提供了显著的优势。我们将在后面研究这些结果的可能原因。值得注意的是,

HRNN All在这种情况下表现不佳。我们将推荐质量的严重下降归因于该setting中使用的context-enforcing policy。一种可能的解释是:多媒体内容(在我们的例子中是视频)的消费是一个session-based场景,比XING中代表的求职场景强得多。用户可能会遵循通用群体趋势general community trend并且具有长期兴趣(该长期兴趣由user-level GRU来捕获)。但是,session中的用户活动可能与该用户最近的session完全断开,甚至与用户的一般兴趣general interest无关(如,对极限运动视频有强烈兴趣的用户可能偶尔也会观看卡通电影预告片)。HRNN Init让session-level GRU根据session中用户兴趣的实际演变来自由地利用这些用户兴趣动态。其更大的灵活性带来了卓越的推荐质量。即该场景中的兴趣更多的是

session内的,而求职场景中的兴趣更多的是跨session的。对于session内的兴趣建模,用HRNN Init效果更好;对于跨session的兴趣建模,用HRNN All效果更好。

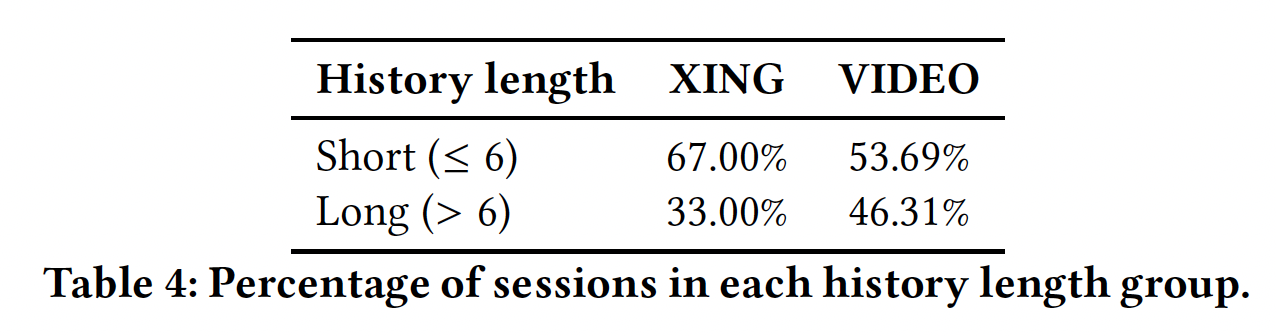

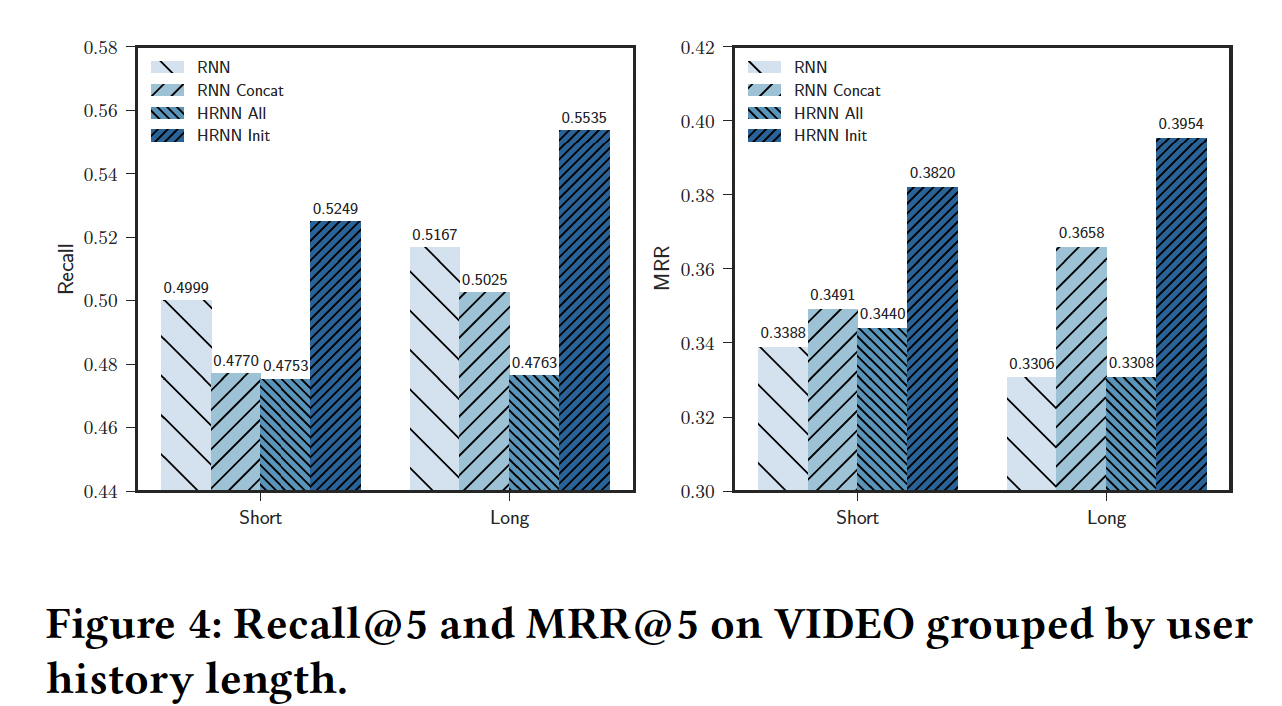

用户历史长度分析:我们预计用户历史长度会对推荐质量产生影响,因此我们按照用户历史中的

session数量对evaluation进行细分。为此,我们将用户历史分为两组:具有<= 6个session的short用户历史、具有> 6个session的long用户历史。下表中报告了这些数据集中不同分组占比的统计数据。

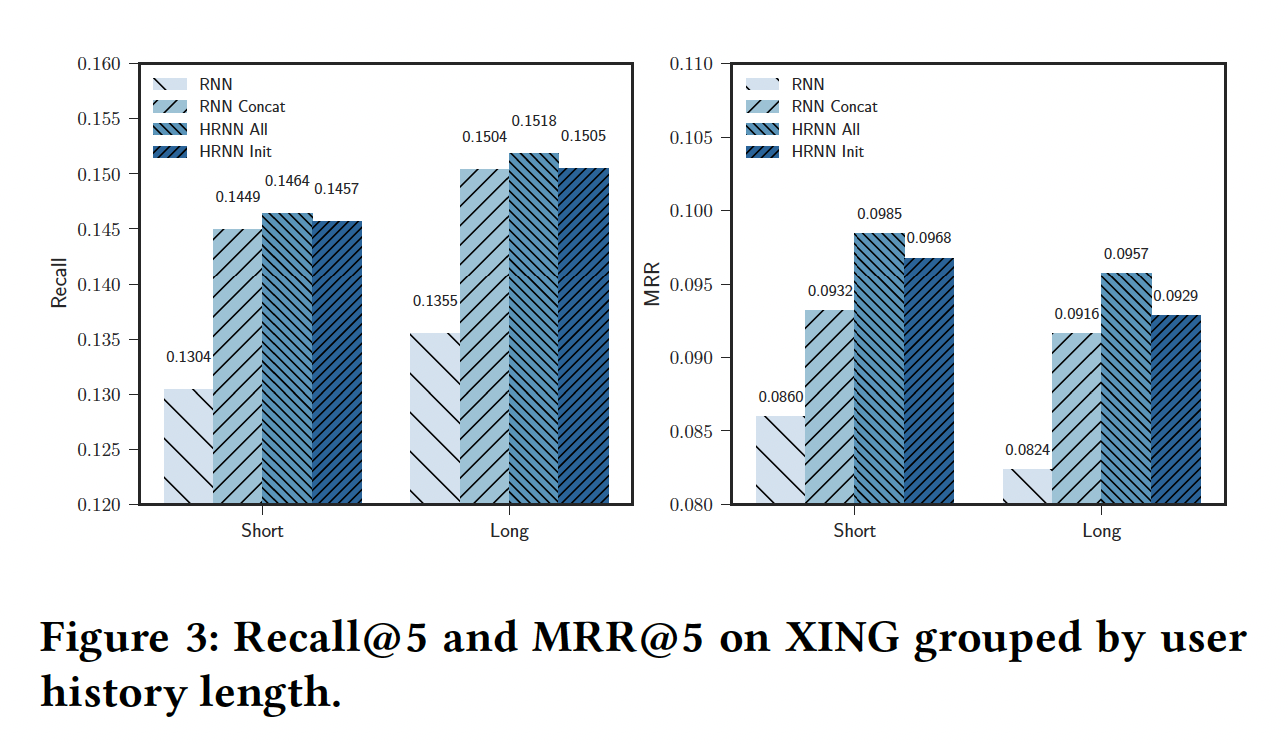

由于我们的目标是衡量

HRNN中使用的复杂的cross-session dynamic对于传统RNN的影响,因此我们将这些分析限制在大型配置中RNN-based推荐器上。对于每种算法,我们计算测试集中不同分组中test session的平均Recall@5和MRR@5。由于Precision@5的分析结论与Recall@5相似,因此由于篇幅有限我们在此省略。为了增强实验结果的鲁棒性,我们使用不同的随机数种子运行10次评估,并报告每个算法的median value(而不是均值)。XING数据集的结果如下所示。可以看到:- 随着用户历史长度的增加,我们注意到所有方法(包括

session-based RNN)的Recall略微增加、MRR略微下降。 - 不同方法的

short用户历史和long用户历史的效果之间并没有显著变化。 HRNN All是性能最好的模型,与session-based RNN相比,其Recall@5提高了12%、MRR@5提高了14~16%。- 根据我们之前的发现,

HRNN Init的性能与RNN Concat、HRNN All相当。

VIDEO数据集的结果如下所示。可以看到:- 所有方法(包括

session-based RNN)的Recall都随着用户历史长度的增加而提升。MRR仅在RNN Concat、HRNN Init方法上随着用户历史长度的增加而提升。这凸显了需要有效的个性化策略从而在session-level获得卓越的推荐质量。 - 此外,

HRNN Init相对于session-based RNN在Recall@5/MRR@5指标上分别提升5%/12% (short)到7%/19% (long),这进一步凸显了我们个性化策略的推荐质量。 - 与我们之前的发现一致,

HRNN All在这种情况下表现不佳。

综上所述,正如预期的那样,用户历史的长度对推荐质量有很大的影响。在像

XING这样松散的session-bounded领域,其中用户活动高度重复并且跨session的多样性较少,那么将user representation强制提供给session-level输入,将得到比initialization-only方法更好的性能。然而,在更强的session-based场景中,跨session的用户活动具有更高程度的变化性,并且可能很大程度上偏离了用户的历史兴趣和偏好,那么更简单有效的HRNN Init变体将具有更好的推荐质量。- 随着用户历史长度的增加,我们注意到所有方法(包括

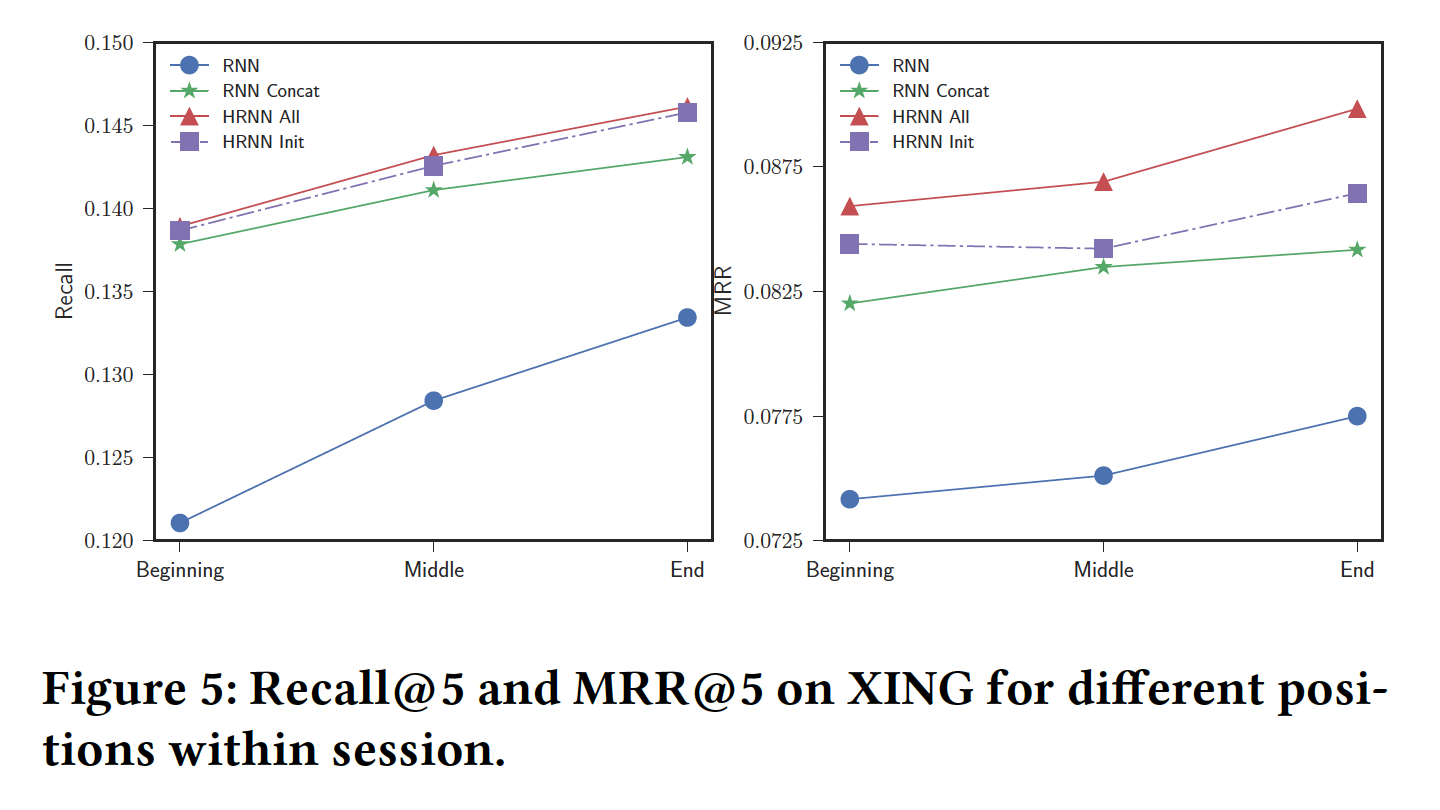

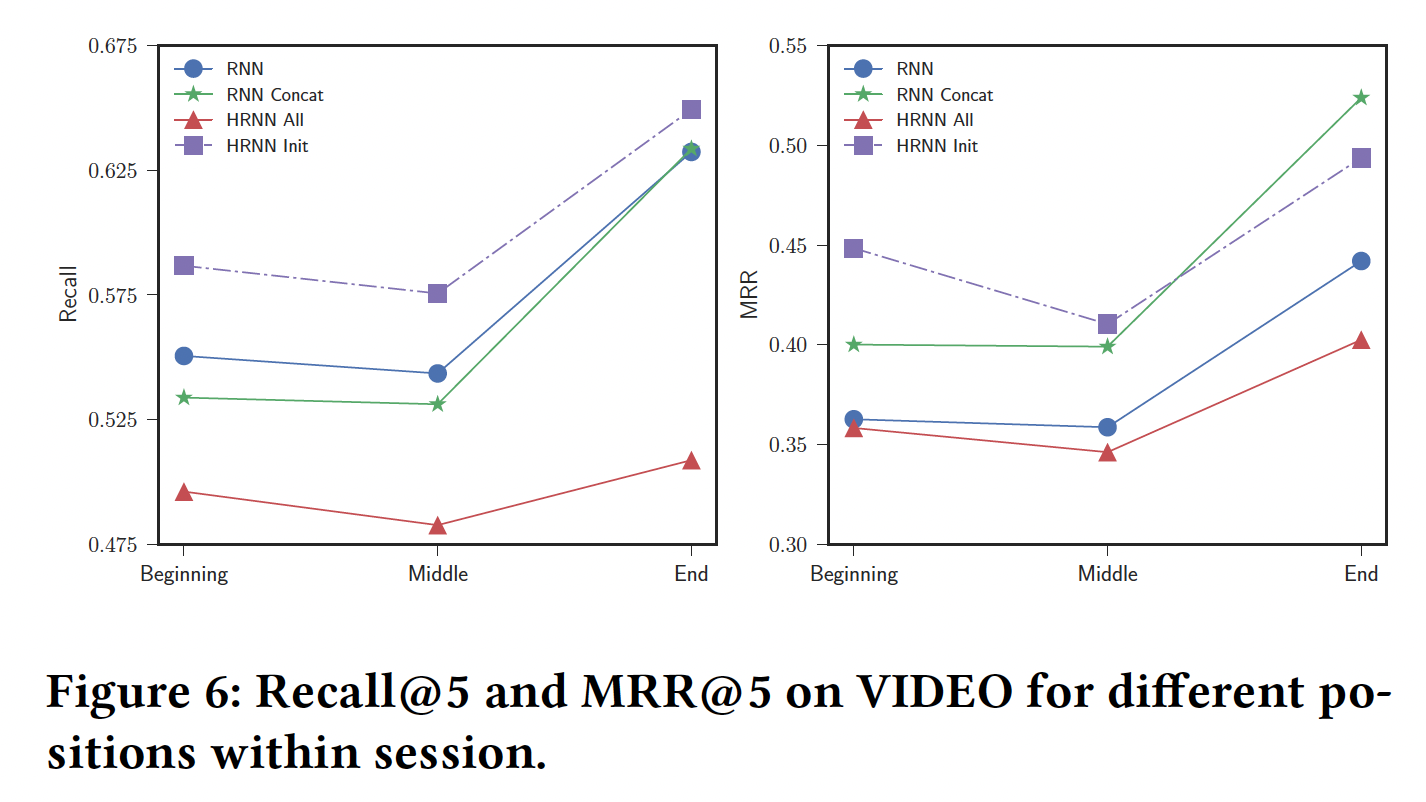

session分析:这里我们按session中事件数量进行细分,从而衡量个性化在user session中的影响。我们仅分析长度>= 5的session(XING数据集中仅为6736个session、VIDEO数据集中仅为8254个session)。我们根据session中的位置(开始Beginning、中间Middle、结束End)计算每个指标的均值。开始指的是session的前2个事件,中间指的是session的第3和第4个事件,结束指的是session第5个及其之后的任何事件。与之前的分析一样,我们关注

large配置中RNN-based模型,并报告使用不同随机数种子在10次运行中均值的median。Recall@5和MRR@5的结果如下图所示。在

XING数据集上:- 所有方法的性能随着

session中previous item的数量增加而增加,这表明session-level的user context被所有RNN-based方法所正确利用。 - 但是,个性化的

session-based模型和pure session-based模型之间存在很大差距。两个HRNN都具有相似的Recall@5,并且与RNN Concat相当。有趣的是,HRNN All的MRR@5相对于RNN和RNN Concat的增益随着处理的item数量增加而增加,这意味着在这种情况下,随着user session的继续,历史用户信息变得更加有用。 HRNN Init的MRR一直都比RNN Concat更好,在Begining和End具有更高的增益。

在

VIDEO数据集上:在

session开始和结束之间,Recall和MRR都如预期的增加。HRNN Init在session开始时比RNN和RNN Concat有很大的提升。这符合直觉,即过去的用户活动也可以有效地用于更准确地预测用户在接下来session中的首个行为。在最初的几个事件之后,个性化的

session-based模型相对于pure session-based模型的Recall增益在减少,而MRR的增益保持稳定。换句话讲,在经历一些事件之后,session-level dynamic开始压制longer-term user interest dynamic,从而降低了个性化策略的有效性。然而,个性化仍然在整个

session中提供了卓越的排序质量,正如HRNN Init和RNN Concat都比RNN有更高的MRR所证明的那样。更重要的是,在session开始时更好的推荐,要比session后期更好的推荐更具有影响力,因为前者更有可能增加留住用户的机会。最后,

HRNN All总是更差的方法,这进一步巩固了HRNN Init变体的优越性。

- 所有方法的性能随着

大型数据集上的实验:我们在更大版本的

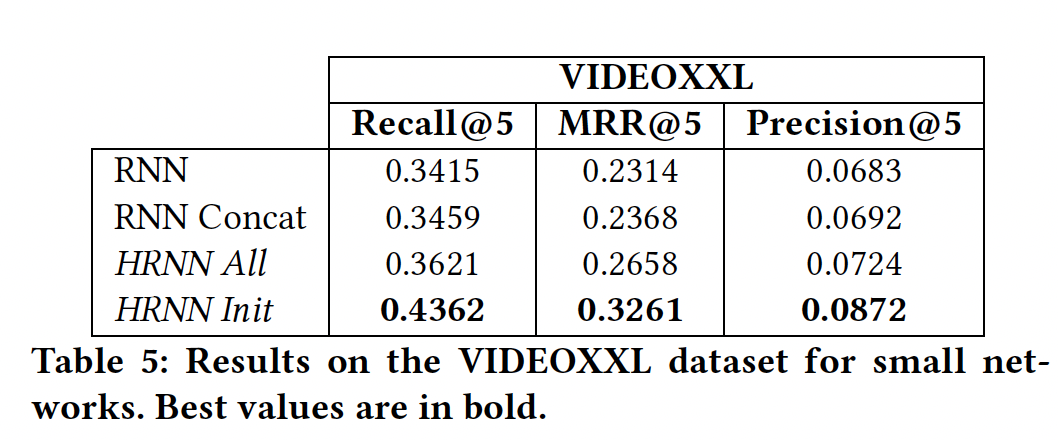

VIDEO数据集(由先前的论文所使用)上验证了HRNN。该数据集由81万用户在2个月期间对38万个视频的交互组成,总共包括3300万个事件、850万个session。然后我们应用了与VIDEO数据集相同的预处理步骤。我们将这个数据集命名为VIDEOXXL。由于我们的计算资源有限,因此我们只能在这个大型数据集上测试

small网络(对于RNN和HRNN采用100维的隐层)。我们使用在小型VIDEO数据集上学到的相同超参数运行一次所有的RNN和HRNN。虽然这不是最优的,但是这种方法在更一般的setting下提供了我们解决方案的初步近似。出于同样的原因,我们没有像对小型数据集所做的那样对实验结果进行详尽的分析。为了加快评估速度,我们计算了相关item与5万个最热门item相比的排名,如《Parallel recurrent neural network architectures for feature-rich session-based recommendations》中所做的那样。结果在下表中所述,这证实了我们之前在小型

VIDEO数据集上的发现:RNN Concat无效,其性能类似于session-based RNN。另一方面,

HRNN的性能优于session-based RNN。具体而言,HRNN Init相比session-based RNN,其Recall@5高了28%、MRR@5高了41%。这些结果进一步证实了本文提出的HRNN模型的有效性。在更大的数据集上,

HRNN体现了其优势。