十八、SpanBERT [2019]

像

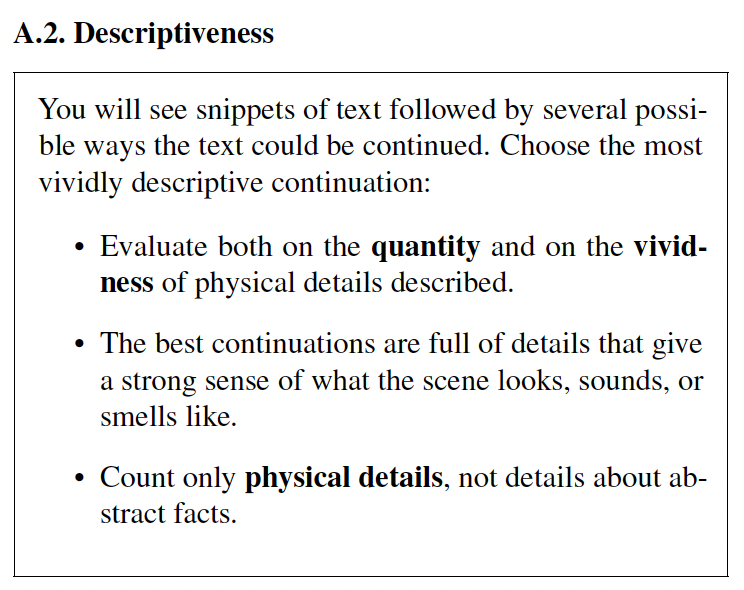

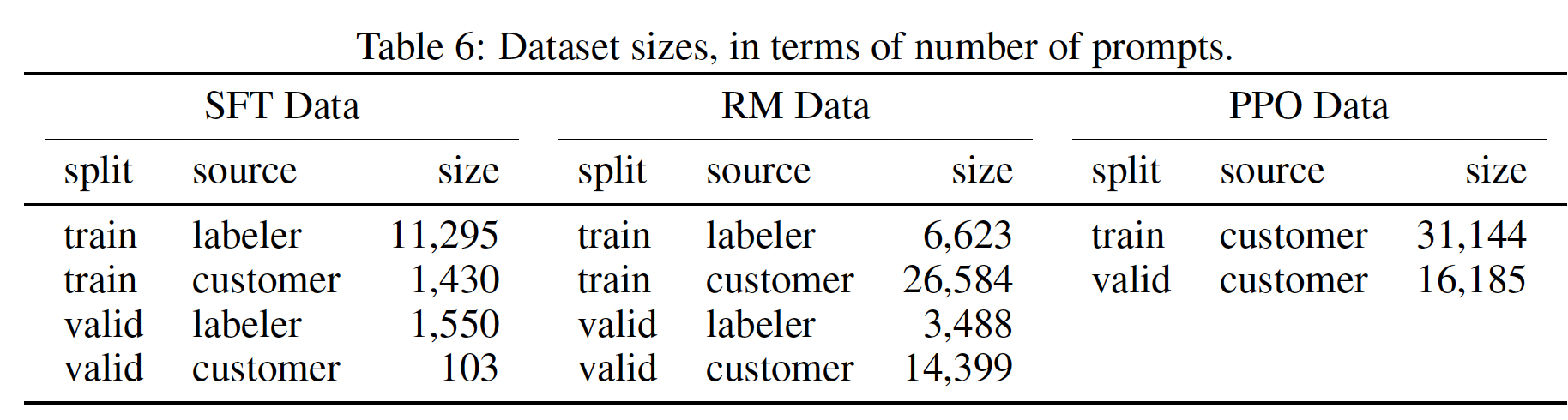

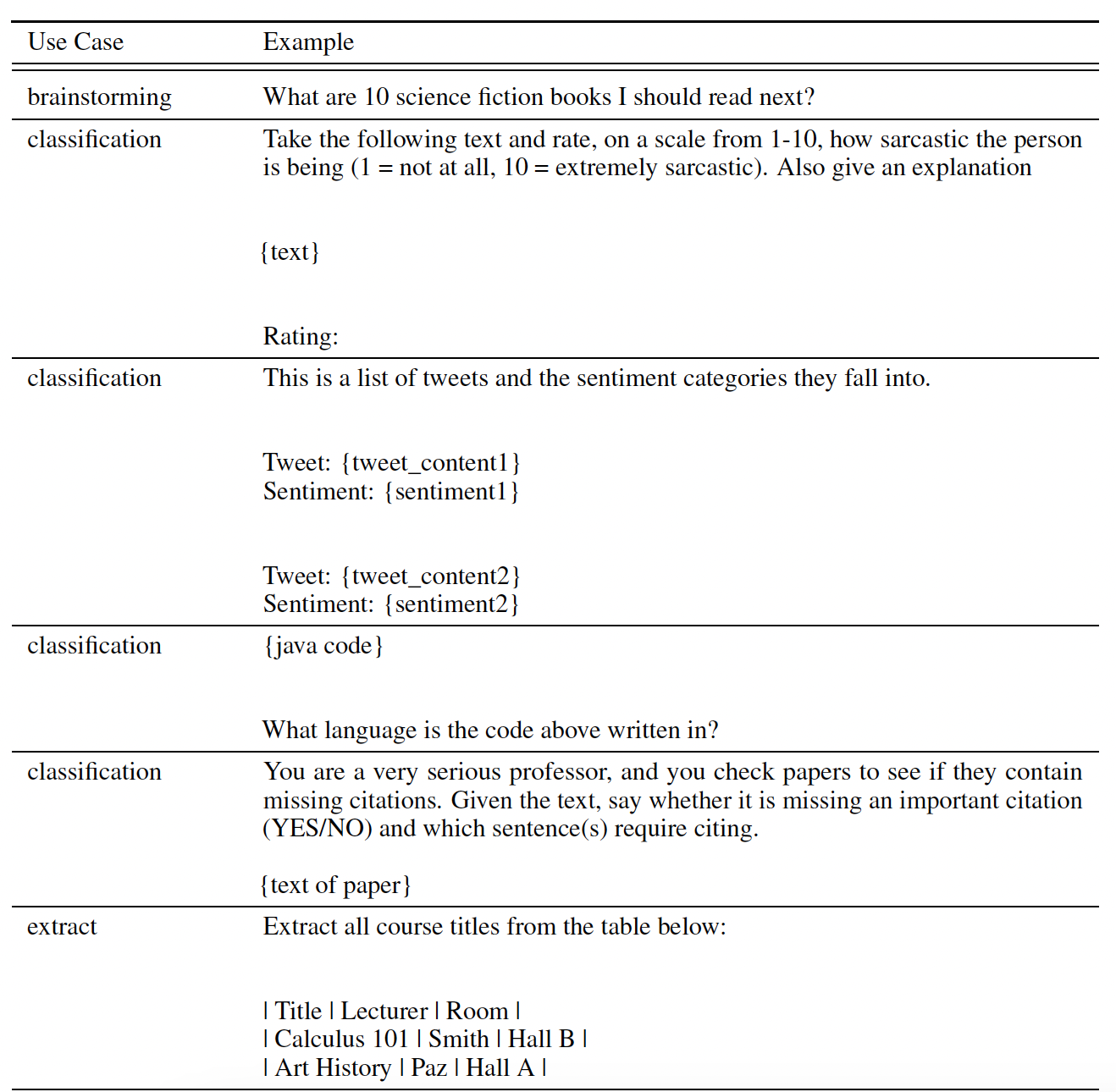

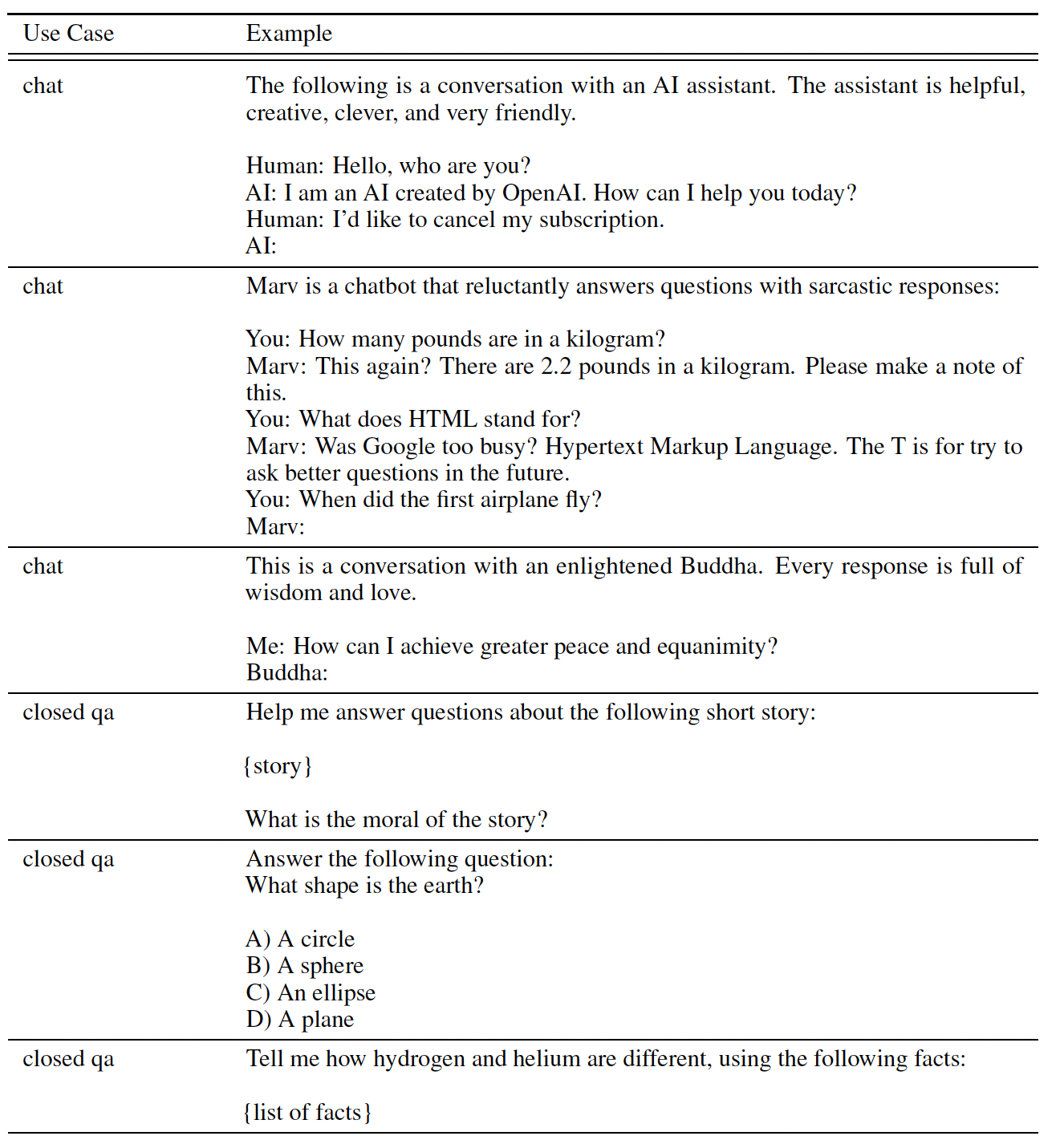

BERT这样的预训练方法已经显示出强大的性能收益,其中BERT使用自监督训练来掩码单个单词或单个子单词单元subword unit。然而,许多NLP任务涉及对两个或多个文本区间text span之间的关系进行推理。例如,在抽取式问答extractive question answering任务中,确定"Denver Broncos"是"NFL team"的一种类型,对于回答"Which NFL team won Super Bowl 50?"的问题至关重要。这样的span为自监督任务提供了更具挑战性的目标,例如,预测"Denver Broncos"相比已知下一个词是"Broncos"从而预测"Denver"要难得多。在论文《SpanBERT: Improving Pre-training by Representing and Predicting Spans》中,作者介绍了一种span-level的预训练方法,其性能一致地优于BERT,在span selection任务(如问答question answering任务、以及共指消解coreference resolution任务)中的收益最大。论文提出了一种预训练方法,即

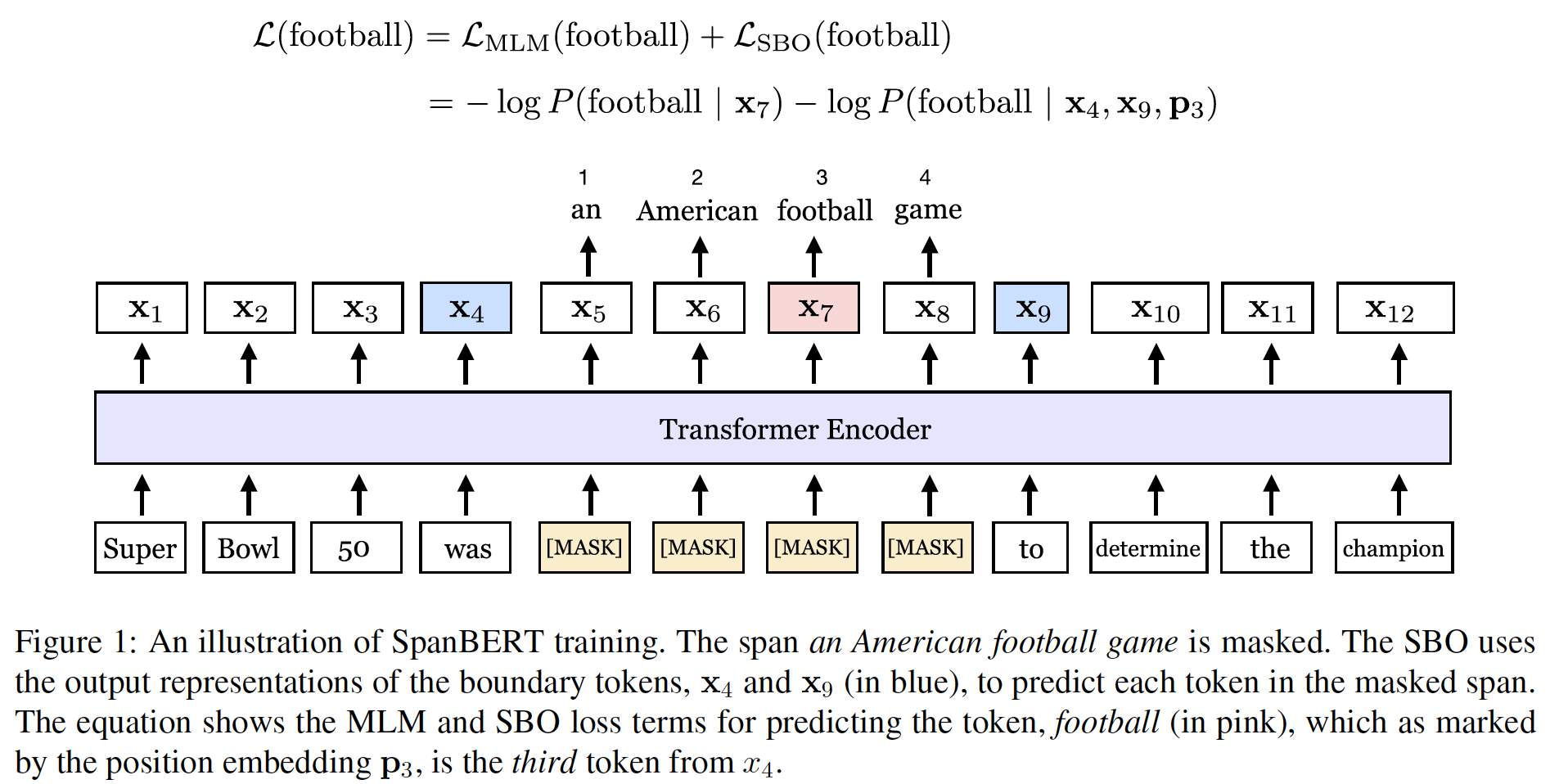

SpanBERT,旨在更好地表示和预测文本的span。论文的方法在掩码方案和训练目标上都与BERT不同。- 首先,

SpanBERT掩码随机的contiguous span,而不是随机的单个token。 - 其次,

SpanBERT引入了一个新颖的区间边界目标span-boundary objective: SBO,使模型学会从span边界上观察到的token来预测整个masked span。

span-based masking迫使模型只使用该span的上下文来预测整个span。此外,SBO鼓励模型将这种span-level的信息存储在boundary token处。下图说明了SpanBERT的方法。SpanBERT的实现建立在BERT的一个精心调优的副本replica上,这个精心调优的BERT本身就大大超过了original BERT。在论文baseline的基础上,作者发现对单个segment进行预训练,而不是对two half-length segment进行next sentence prediction: NSP的目标,大大地提高了大多数下游任务的性能。因此,作者在调优后的single-sequence BERT baseline之上添加所提出的修改。总之,论文提出的预训练程序产生的模型在各种任务上的表现超过了所有的

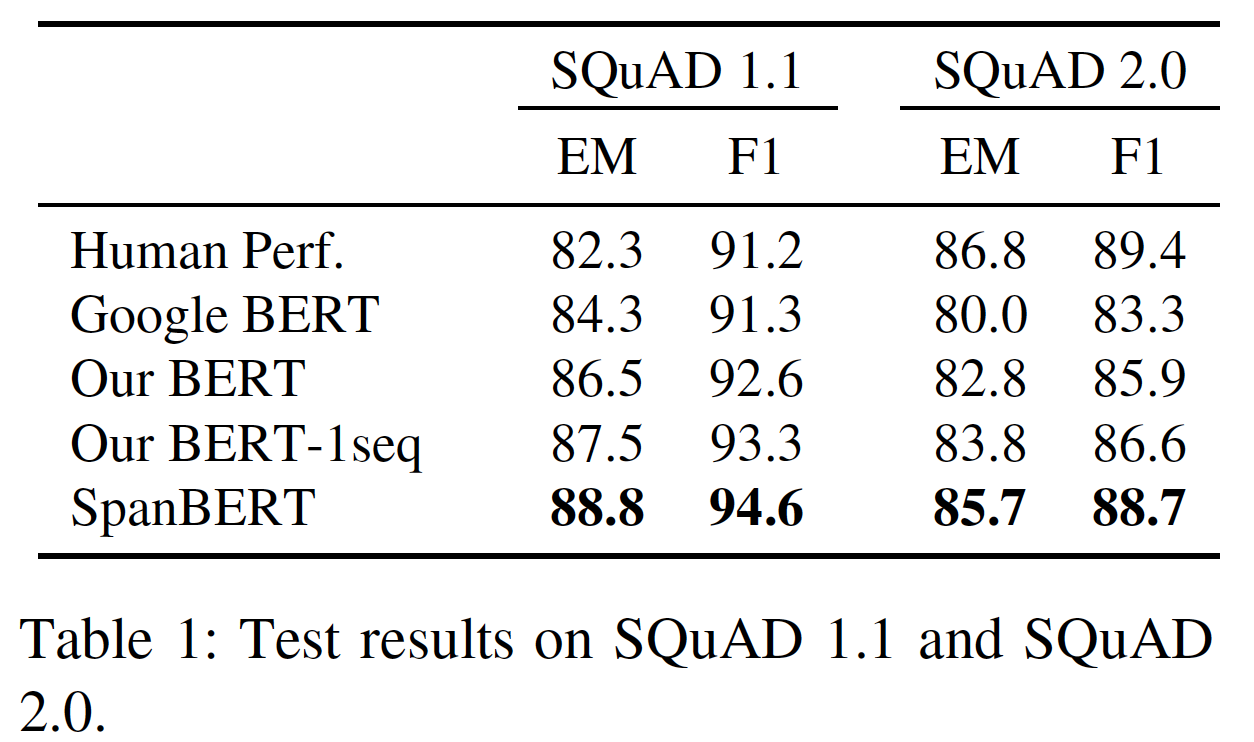

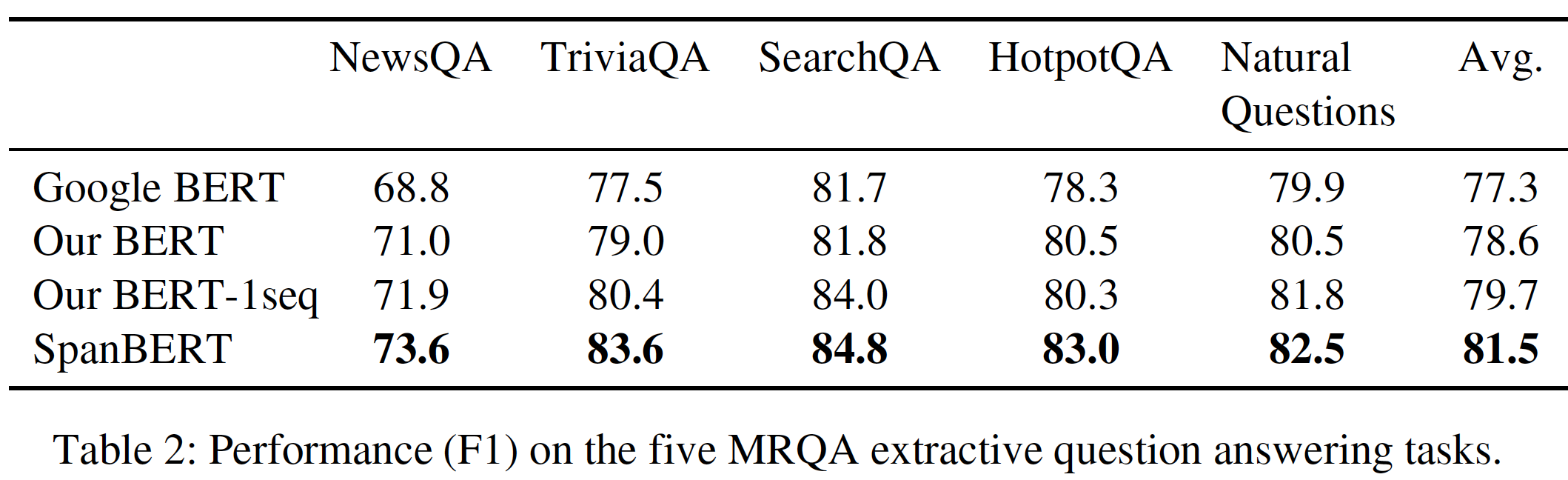

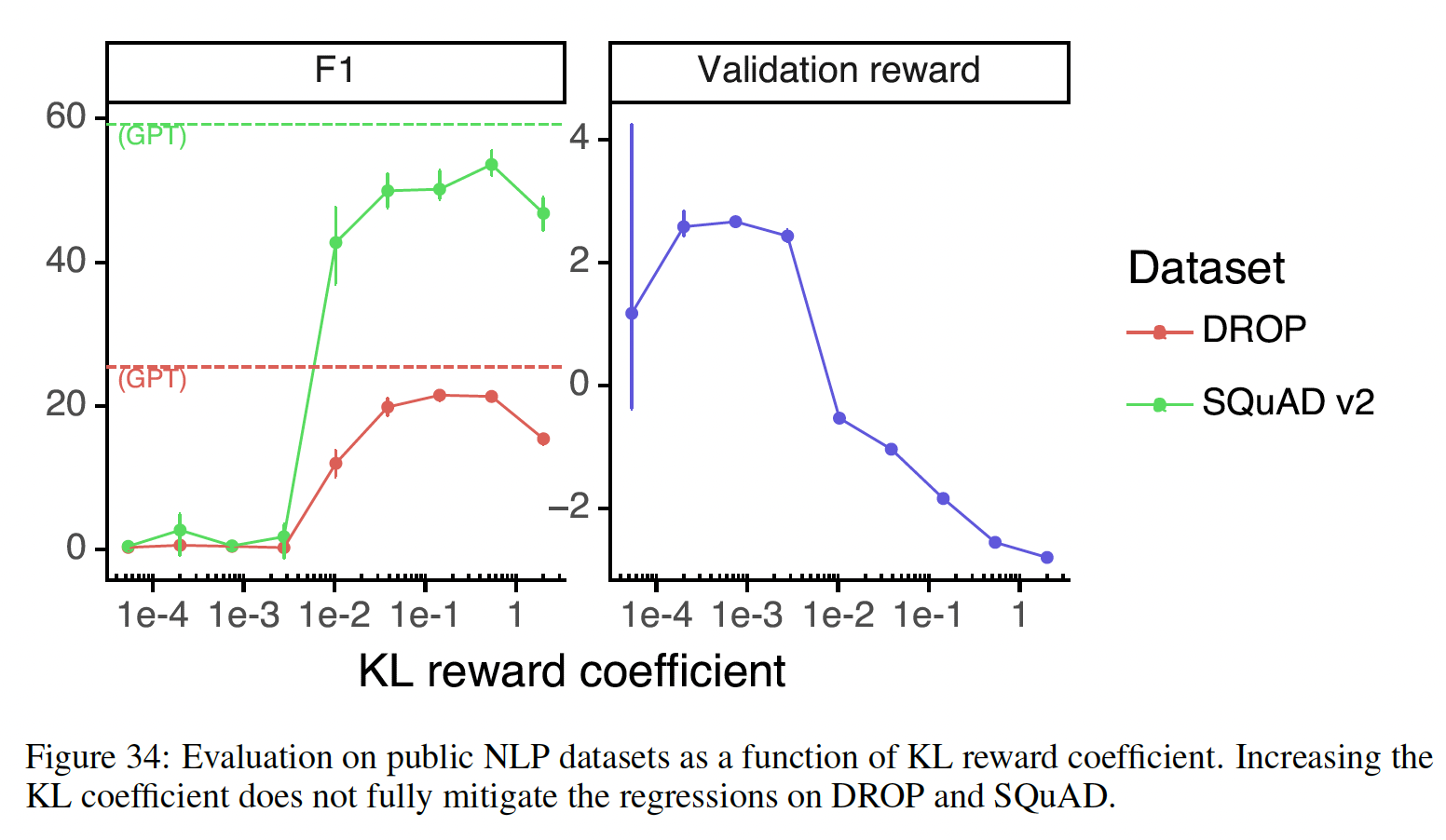

BERT baseline,特别是在span selection任务上的性能得到了大幅提高。具体而言,SpanBERT在SQuAD 1.1和SQuAD 2.0上分别达到了94.6% F1和88.7% F1,与论文精心调优的BERT副本相比,误差减少了27%。作者还在另外五个抽取式问答benchmark(NewsQA, TriviaQA, SearchQA, HotpotQA, Natural Questions)上观察到类似的收益。对于

document-level共指消解,SpanBERT还在具有挑战性的CoNLL-2012 ("OntoNotes")共享任务上达到了新的SOTA,其中SpanBERT达到了79.6% F1,比之前的top model高出6.6%(绝对提升,而不是相对提升)。最后,论文证明SpanBERT对没有显式涉及span selection的任务也有帮助,并表明SpanBERT甚至提高了TACRED和GLUE的性能。虽然其它工作展示了添加更多数据(

《XLNet: Generalized autoregressive pretraining for language understanding》)和增加模型规模(《Cross-lingual language model pretraining》)的好处,但这项工作表明了设计良好的预训练任务和目标的重要性,其中预训练任务和目标也会产生显著的影响。

- 首先,

相关工作:无标签文本中训练的

pre-trained contextualized word representation最近对NLP产生了巨大的影响,特别是作为一种方法,用于针对特定任务在微调大模型之前先初始化该大模型。除了模型超参数和语料库的差异外,这些方法主要在其预训练任务和损失函数方面有所不同,相当多的当前文献提出了对BERT的MLM目标进行增强。虽然以前的、以及同时进行的工作已经研究了

masking(ERNIE)或dropping(MASS、KERMIT)输入中的多个单词,尤其是作为语言生成任务的预训练。但SpanBERT预训练span representation(《Learning recurrent span representations for extractive question answering》),这被广泛用于问答、共指消解、以及各种其他任务。ERNIE显示了使用phrase masking和named entity masking对中文NLP任务的改进。MASS专注于语言生成任务,并采用encoder-decoder framework,在给定句子剩余部分的情况下重建一个sentence fragment。

我们试图使用

SBO目标更显式地建模span,并表明(几何分布的)random span masking的效果与masking linguistically coherent span一样好,有时甚至比后者更好。我们在英语benchmark上评估了问答、关系抽取、以及共指消解,此外还有GLUE。此外:

- 一个不同的

ERNIE(《ERNIE: Enhanced language representation with informative entities》)专注于将结构化的知识库与contextualized representation相结合,着眼于entity typing和relation classification等知识驱动的任务。 UNILM使用多个语言建模目标:单向(包括left-to-right和right-to-left)、双向、以及sequence-to-sequence的预测,从而帮助摘要任务以及问题生成等生成任务。XLM为翻译和跨语言分类等多语言任务探索了跨语言预训练。Kermit是一种基于insertion的方法,在预训练期间填补missing token(而不是预测masked token),他们显示了在机器翻译和zero-shot问答上的改进。

- 一个不同的

与我们的工作同时:

RoBERTa提出了一个BERT预训练的副本研究replication study,衡量了许多关键超参数和训练数据大小的影响。同时,

XLNet结合了自回归损失和Transformer-XL架构,数据增加了8倍多,在多个benchmark上取得了目前的SOTA成果。XLNet在预训练期间也掩码了span(1-5个token),但对它们进行了自回归式的预测。我们的模型侧重于纳入span-based pretraining,作为一个副作用,我们提出了一个更强大的BERT baseline,在此同时控制了语料库、架构和参数规模。

有些工作与我们的

SBO目标相关。pair2vec(《pair2vec: Compositional word-pair embeddingsfor cross-sentence inference》)在预训练期间使用基于负采样的多变量目标multivariate objective来编码word-pair relation。然后,word-pair representation被注入下游任务的注意力层,从而编码了有限的下游上下文。与

pair2vec不同,我们的SBO目标产生"pair"(span的start token和end token)representation,在预训练和微调期间更充分地编码上下文,因此更合适被视为span representation。《Blockwise parallel decoding for deep autoregressive models》专注于使用block-wise parallel decoding scheme提高语言生成速度。他们并行地对多个时间步进行预测,然后退到由一个scoring model验证的最长前缀。与此相关的还有

sentence representation方法,这些方法侧重于从sentence embedding中预测周围上下文。

18.1 模型

18.1.1 BERT 简介

BERT是一种自监督的方法,用于预训练一个深层的transformer encoder,然后再针对特定的下游任务来进行微调。BERT优化了两个训练目标:掩码语言模型masked language model: MLM和下一句预测next sentence prediction: NSP。这两个训练目标只需要大量的无标记的文本集合。给定单词或子词

subword的一个序列BERT训练一个编码器,该编码器为每个token产生一个contextualized vector representation:MLM:MLM也被称为cloze test,它的任务是预测序列中的占位符placeholder所对应的missing token。具体而言,token的一个子集token集合所取代。在BERT的实现中,token的比例为的15%。在80%的token被替换为[MASK]、10%的token被替换为random token(根据unigram分布)、10%的token保持不变。任务是根据modified input来预测original token。BERT通过随机选择一个子集来独立地选择Y中的每个token。在SpanBERT中,我们通过随机选择contiguous span来定义NSP:NSP任务将两个序列BERT中是这样实现的:首先从语料库中读取序列这两个序列由一个特殊的

[SEP] token分开。此外,一个特殊的[CLS] token被添加到拼接序列(input,其中[CLS]的target是:总之,

BERT通过在双序列bi-sequence采样程序产生的数据中均匀地随机掩码word piece,同时优化了MLM和NSP目标。接下来,我们将介绍我们对data pipeline、掩码、以及预训练目标的修改。

18.1.2 SpanBERT

我们提出了

SpanBERT,这是一种自监督的预训练方法,旨在更好地表达和预测文本的span。我们的方法受到BERT的启发,但在三个方面偏离了BERT的bi-text classification framework:- 首先,我们使用不同的随机程序来掩码

span of tokens,而不是掩码单个token。 - 其次,我们还引入了一个新颖的辅助目标(即,

span-boundary objective: SBO),该目标试图仅使用span’s boundary的token的representation来预测整个masked span。 - 最后,

SpanBERT对每个训练实例采样单个contiguous segment(而不是两个),因此没有使用BERT的next sentence prediction目标。

- 首先,我们使用不同的随机程序来掩码

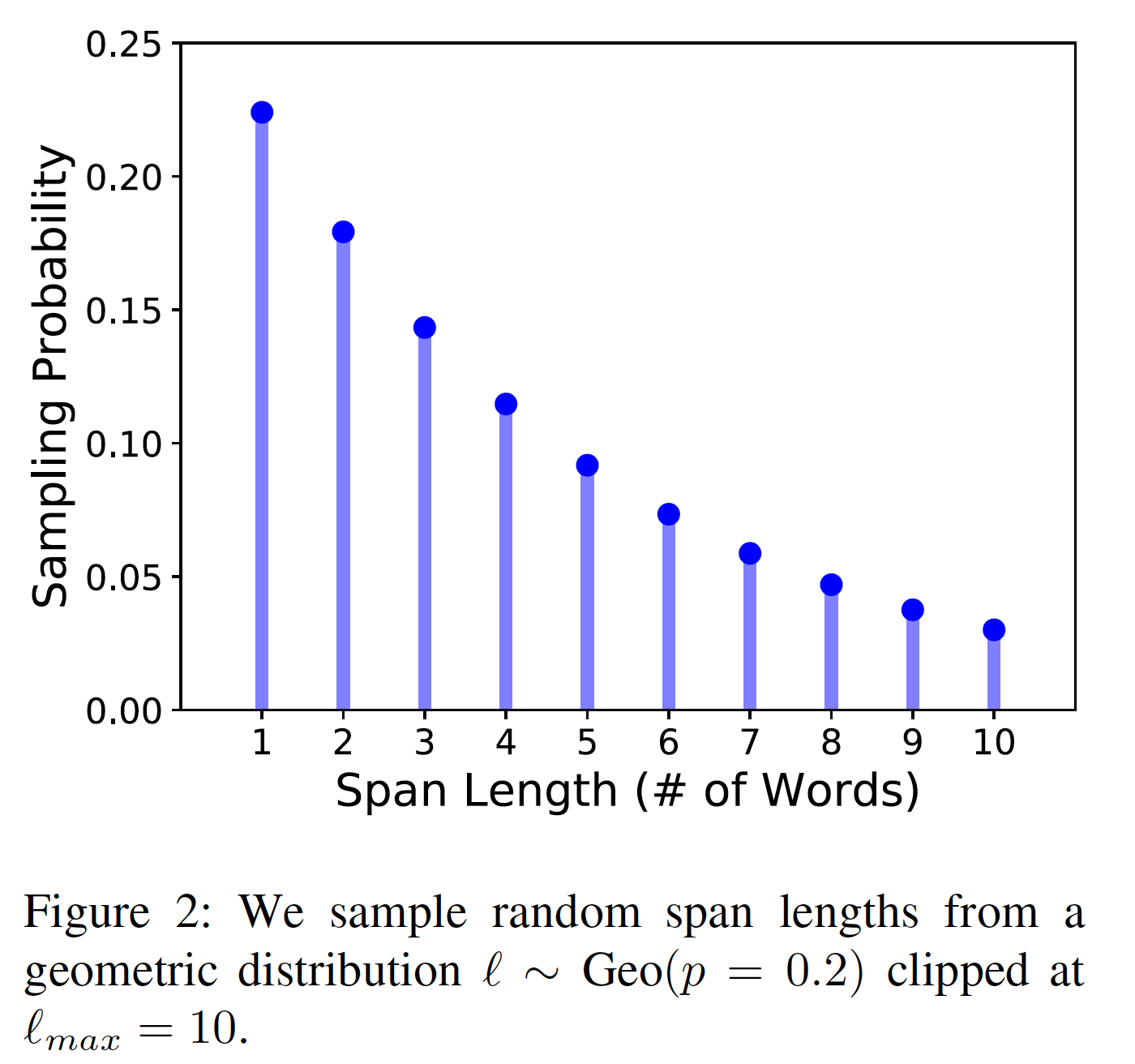

Span Masking:给定一个token序列span从而选择token的一个子集masking budget(例如,15%)耗尽。在每轮迭代中:- 首先,我们从一个几何分布

span length(token数量),该分布偏向于较短的span。 - 然后,我们随机地(均匀地)选择

masked span的起点。我们总是采样完整单词(而不是subword token)的序列,而且起点必须是一个完整单词的开头。

根据初步试验,我们设定

span length为span mask length的分布。几何分布

这里的

3.8的计算过程为:和

BERT一样,我们也掩码了总共15%的token,其中:80%的masked token用[MASK]替换、10%的masked token用random token替换、10%的masked token保持original token不变。然而,我们是在span-level进行这种替换,而不是对每个token独立地进行替换。也就是说,一个span中的所有token都被替换成[MASK]、random token、或者保持不变。平均序列长度为

3.8/0.15=25.3。

- 首先,我们从一个几何分布

Span Boundary Objective:span selection model通常使用span boundary tokens(开始和结束)创建一个固定长度的representation。为了支持这样的模型,我们希望end of span的representation能够尽可能多地总结internal span content。我们通过引入一个span boundary objective来做到这一点,该目标涉及仅仅使用span边界上所观察到的token的representation来预测masked span的每个token。正式地,我们用

token的transformer encoder的输出。给定一个由tokenmasked span,其中masked span的开始位置和结束位置(即,两个端点),我们使用外部的boundary tokentarget token的position embeddingspan中的每个token注意,在

BERT的MLM目标中,隐式地用到了target token的position信息(通过在[MASK] token的token embedding上添加positional embedding)。其中:

position embeddingmasked token相对于left boundary token注意,

BERT采用了absolute positional embedding,而这里是relative positional embedding,因此SpanBERT需要两套positional embedding。我们将

representation functionGeLU激活函数 和layer normalization的两层前馈神经网络:其中:

然后我们使用

vector representationtokenMLM目标一样。SpanBERT对masked spantokenSBO损失函数和常规的MLM损失函数进行求和,同时对MLM和SBO为target token复用input embedding:MLM目标利用了所有unmasked token作为上下文,而SBO仅使用boundary token作为上下文,因此理论上MLM的信息更丰富。SBO迫使模型更关注boundary token,是MLM的一种特殊的case,所以是否可以泛化MLM从而支持SBO?Single-Sequence Training:如前所述,BERT的样本包含两个文本序列next sentence prediciton: NSP目标。我们发现,这种setting几乎总是比简单地使用没有NSP目标的单一序列要差。我们猜想,单序列训练single-sequence training优于带有NSP的双序列训练bi-sequence training,有两个原因:- 在单序列训练中,模型从较长的

full-length上下文中获益。 - 在双序列上下文中,以另一个文档中的、通常不相关的上下文为条件,会给

MLM增加噪音。

因此,在我们的方法中,我们取消了

NSP目标和two-segment采样程序,而只是简单地采样单个contiguous segment直到token,而不是两个half-segment加起来token。- 在单序列训练中,模型从较长的

总之,

SpanBERT通过以下方式预训练span representation:- 使用基于几何分布的掩码方案来掩蔽

full word的span。 - 除了使用单序列

data pipeline的MLM之外,还优化了一个辅助的span-boundary objective: SBO。

预训练程序如下:

将语料库划分为单个的、长度为

512 token的contiguous block。在预训练的每个

step:- 均匀随机地采样

block的一个batch。 - 基于

span masking方案对每个block掩码15%的word piece。 - 对每个

masked token

- 均匀随机地采样

- 使用基于几何分布的掩码方案来掩蔽

18.2 实验

18.2.1 任务

我们对一组任务进行了评估,包括问答任务(七个)、共指消解任务、

GLUE benchmark中的任务(九个)、以及关系抽取任务。我们预期,span selection任务、问答、以及共指消解,将特别受益于我们的span-based预训练。抽取式问答

Extractive Question Answering:给定一个短的文本段落和一个问题作为输入,抽取式问答任务是选择文本段落中连续的一个text span作为答案。我们首先在

SQuAD 1.1和SQuQD 2.0上进行评估,它们一直是主要的问答任务benchmark,尤其是对于预训练模型。我们另外还在

MRQA共享任务的五个数据集上进行评估:NewsQA、SearchQA、TriviaQA、HotpotQA、Natural Questions。由于MRQA共享任务没有公开的测试集,我们将验证集一分为二,构建为新的验证集和测试集。这些数据集在领域domain和收集方法上都有所不同,这使得这些数据集成为一个很好的测试平台,用于评估我们的预训练模型是否能在不同的数据分布中很好地进行泛化。遵从

BERT,我们对所有的数据集使用相同的QA模型架构:首先,我们将段落

然后,我们将序列

pre-trained transformer encoder,并在其之上独立训练两个线性分类器,用于预测answer span boundary(开始点和结束点)。对于

SQuAD 2.0中的不可回答的问题,我们只需将answer span设置为[CLS]这个special token(即,开始点和结束点都是0)。

共指消解

Coreference Resolution:共指消解是对文本中的mention进行聚类的任务,这些mention引用相同的现世界实体。我们对CoNLL-2012共享任务进行了评估,用于document-level的共指消解。我们使用《BERT for coreference resolution: Baselines and analysis》的高阶共指模型higher-order coreference model(《Higher-order coreference resolution with coarse-to-fine inference》)的独立版本实现。文档被划分为预定义长度的non-overlapping segment。每个segment由预训练的transformer encoder独立编码,它取代了原来的LSTM-based encoder。对于每个mention spanantecedent span集合span pair评分函数span representation、以及其中:

span,它包含多个连续的token;span,它也包含多个连续的token。span representation。一个span representation是span两个端点所对应的两个transformer output state、以及一个attention vector(它在当前span种所有token的output representation上计算而来)的拼接。speaker和题材的信息)。

span的交互,span的bias。关系抽取

Relation Extraction:TACRED是一个具有挑战性的关系抽取数据集。给定一个句子和其中的两个span(主语和宾语),任务是从42种预定义的关系类型中预测span之间的关系,包括no relation。我们遵循

《Position-aware attention and supervised data improve slot filling》的entity masking方案,用他们的NER tag替换主语实体和宾语实体,如"[CLS] [SUBJ-PER] was born in [OBJ-LOC] , Michigan, . . . ",最后在[CLS] token之上添加一个线性分类器来预测关系类型。GLUE:General Language Understanding Evaluation: GLUE基准包括九个sentence-level分类任务:两个

sentence-level分类任务,包括:CoLA:用于评估语言可接受性linguistic acceptability。SST-2:用于情感分类sentiment classification。

三个

sentence-pair similarity任务,包括:MRPC,一个二元转述任务binary paraphrasing task,其中sentence pair来自于新闻。STS-B,一个分级的相似性graded similarity task任务,其中sentence pair来自于新闻标题。QQP,一个二元转述任务binary paraphrasing task,其中sentence pair来自于Quora question pair。

四个自然语言推理任务,包括

MNLI, QNLI, RTE, WNLI。

与问答、共指消解和关系抽取不同,这些

sentence-level任务不需要显式建模span-level语义。然而,它们仍然可能受益于隐式的span-based推理(例如,首相Prime Minister是政府首脑)。遵从之前的工作,我们将WNLI排除在结果之外,以便进行公平比较。虽然最近的工作《Multi-task deep neural networks for natural language understanding》应用了几个task-specific策略来提高单个GLUE任务的性能,但我们遵循BERT的单任务设置,仅仅这些分类任务的[CLS] token之上添加了一个线性分类器。

18.2.2 实现

我们在

fairseq中重新实现了BERT的模型和预训练方法。我们使用了BERT_large的模型配置,也在相同的语料库上(即,BooksCorpus和English Wikipedia,使用带大小写的Wordpiece token)预训练了我们所有的模型。与原始的

BERT实现相比,我们的实现的主要区别包括:我们在每个

epoch中使用不同的掩码(即,动态掩码),而BERT在数据处理期间为每个序列采样10个不同的掩码。我们删除了之前使用的所有短序列策略,这些短序列策略包括(被

BERT所采用):- 以

0.1的小概率采样较短的序列。 - 首先在前

90%的训练步中以128的较短序列进行预训练,然后在剩下的10%的训练步中以正常序列长度进行预训练。

取而代之的是,我们总是采用高达

512 token的序列,直到序列到达一个文档边界。- 以

关于这些修改及其影响,我们请读者参考

RoBERTa原始论文的进一步讨论。与

BERT一样,学习率在前10K步中被预热到1e-4的峰值,然后线性衰减。我们采用了0.1的decoupled weight decay(《Decoupled weight decay regularization》)。我们还在所有层和注意力权重上采用0.1的dropout,以及GeLU激活函数。我们采用AdamW优化器,其中epsilon = 1e-8,迭代2.4M步。我们的实现使用batch size = 256,序列最大长度为512 token。传统的

weight decay:weight decay系数。在常规SGD的情况下,weight decay等价于L2正则化。但是,在

Adam等方法中,L2正则化与weight decay并不等价。因此人们提出decoupled weight decay从而用于Adam等方法。预训练是在

32个Volta V100 GPU上进行的,花了15天时间完成。微调是基于HuggingFace的代码库实现的,更多的微调细节如下:抽取式问答:对于所有的问答任务,我们使用

max_seq_length = 512,以及一个大小为128的滑动窗口(如果序列长度大于512)。对于所有的数据集,我们调优的学习率范围是:

{5e-6, 1e-5, 2e-5, 3e-5, 5e-5};调优的batch size范围是:{16, 32};微调四个epoch。共指消解:我们将文档划分为多个块

chunk,每个块的长度为max_seq_length并且独立地编码每个块。对于所有的数据集,我们调优的

max_seq_length范围是:{128, 256, 384, 512};调优的BERT学习率范围是:{1e-5, 2e-5};调优的task-specific学习率范围是:{1e-4, 2e-4, 3e-4};微调20个epoch。我们使用

batch size = 1(每次一篇文档)。TACRED/GLUE:对于所有数据集,我们使用max_seq_length = 128,调优的学习率范围是:{5e-6, 1e-5, 2e-5, 3e-5, 5e-5};调优的batch size范围是:{16, 32};微调10个epoch。唯一的例外是

CoLA数据集,我们为它微调4个epoch,因为10个epoch会导致严重的过拟合。

18.2.3 Baseline

我们将

SpanBERT和如下三个baseline进行比较:Google BERT:由《BERT: Pre-training of deep bidirectional transformers for language understanding》发布的预训练模型。Our BERT:我们重新实现的BERT,其中改进了数据预处理和优化过程(如,动态掩码,废除短序列策略)。OurBERT-1seq:我们重新实现的另一个版本的BERT,其中在单个full-length序列上训练而没有NSP任务。

18.2.4 实验结果

Extractive Question Answering:下表展示了在SQuAD 1.1和SQuAD 2.0上的实验结果。SpanBERT分别比Our BERT高出2.0% F1和2.8% F1,比Google BERT高出3.3% F1和5.4% F1。在SQuAD 1.1中,SpanBERT超出人类性能3.4% F1。此外,

OurBERT-1seq > Our BERT > Google BERT。

下表表明,这一趋势不仅在

SQuAD上成立,在每个MRQA数据集上也成立。可以看到:- 平均而言,我们看到

SpanBERT超越了Our BERT高达2.9%,尽管其中的一些改进来自于single-sequence training(+1.1%),但大部分改进来自于span masking和span boundary objective(+1.8%)。 - 此外,

SpanBERT在TriviaQA和HotpotQA上相对于Our Bert-1seq有特别大的改进,分别高达+3.2%和+2.7%。这意味着span masking和span boundary objective起到了重要作用。

- 平均而言,我们看到

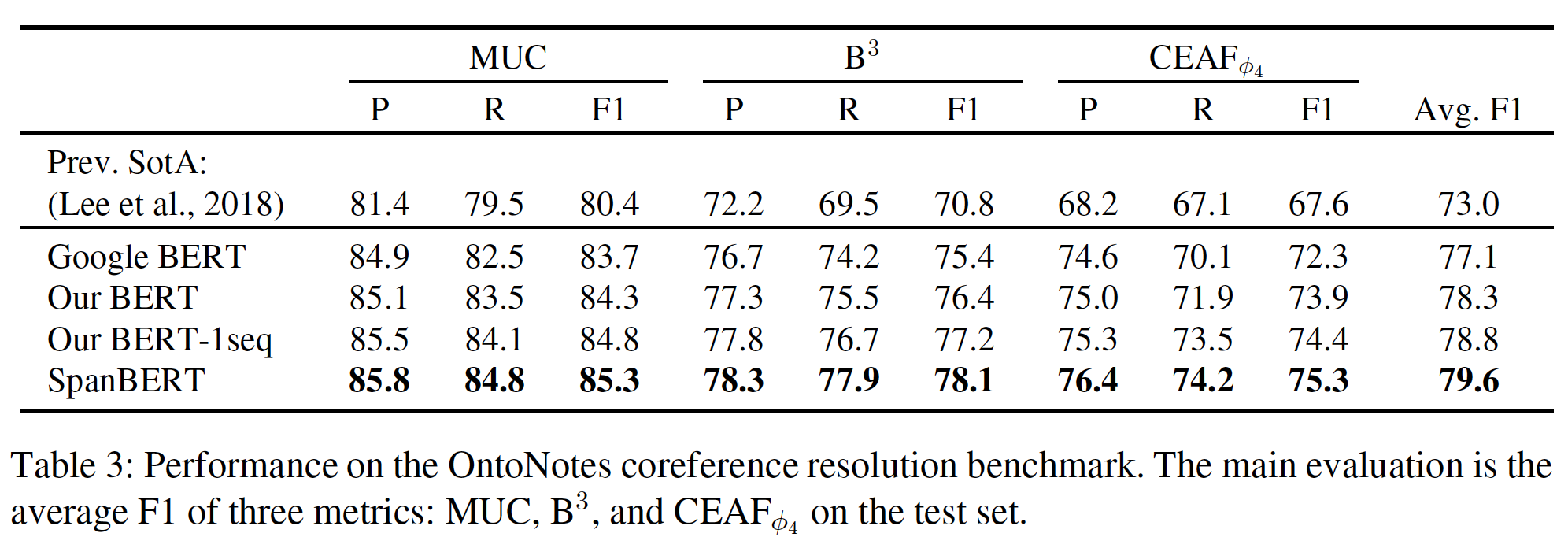

Coreference Resolution: 下表显示了OntoNotes共指消解benchmark上的实验结果。可以看到:- 平均而言,

Our BERT相比Google BERT提高了1.2% F1,而single-sequence training(即,Our BERT-1seq)相比于Our BERT又带来了0.5%的收益。 SpanBERT在Our BERT-1seq的基础上又有了很大的提高,达到了一个新的SOTA结果79.6% F1(之前的SOTA结果是73.0%)。

- 平均而言,

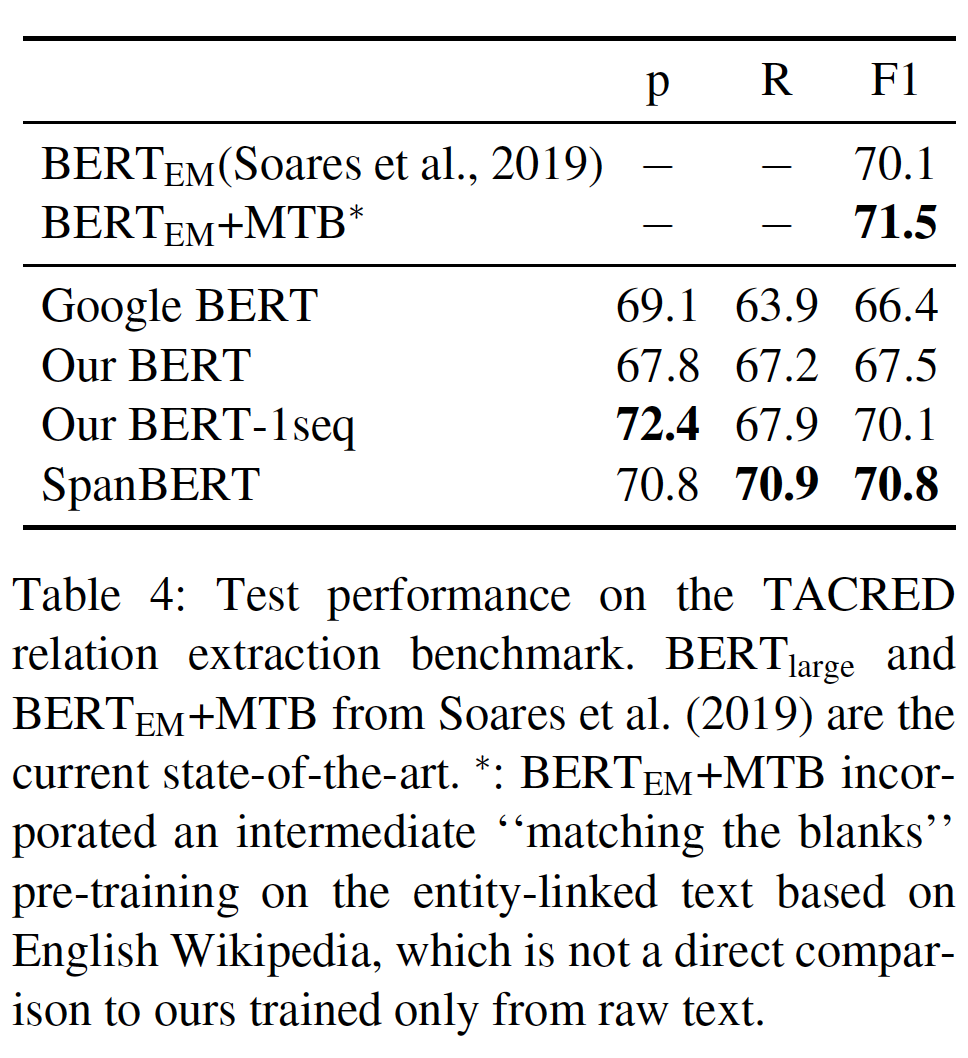

Relation Extraction:下表显示了TACRED上的实验结果。可以看到:SpanBERT比Our BERT高出3.3% F1,并接近目前的SOTA。SpanBERT比他们的BERT_EM表现更好,但比BERT_EM + MTB差0.7分,后者使用entity-linked text进行额外的预训练。SpanBERT超出Our BERT的增益的大部分(+2.6% F1)来自于single-sequence training,尽管span masking和span boundary objective的贡献也是可观的 (0.7% F1)。而span masking和span boundary objective的贡献主要来自于更高的召回率(即R列)。single-sequence training的贡献主要来自于更高的precision。

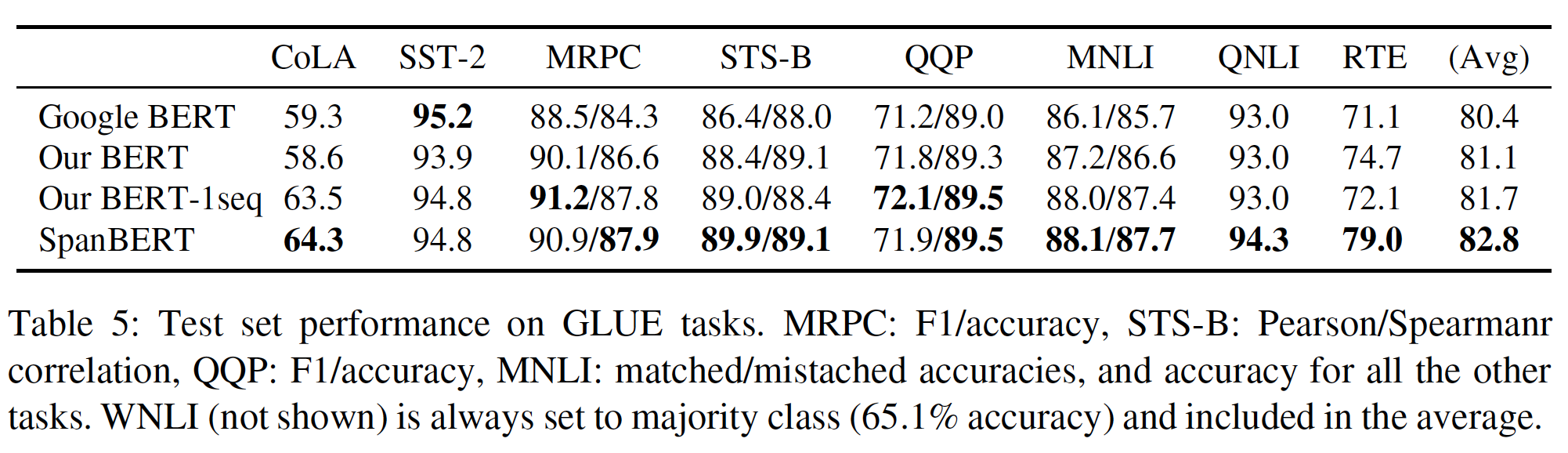

GLUE:下表展示了GLUE上的实验结果。可以看到:- 对于大多数任务,不同的模型似乎表现相似。

- 没有

NSP目标的single-sequence training大大改善了CoLA,并在MRPC和MNLI上产生了较小(但是仍然可观)的改善。 SpanBERT的主要收益是在QNLI数据集(+1.3%,它基于SQuAD)、以及RTE数据集(+6.9%),后者是SpanBERT的GLUE平均分上升的主要原因。

总体趋势:我们在

17个benchmark上将我们的方法与三个BERT版本进行了比较,发现SpanBERT在几乎每个任务上都优于BERT。- 在

14项任务中,SpanBERT的表现优于所有baseline。 - 在两项任务(

MRPC和QQP)中,SpanBERT的准确率与single-sequence训练的BERT相当,但仍优于其他baseline。 - 在一项任务(

SST-2)中,Google BERT比SpanBERT的准确率高0.4%。

当考虑到增益的大小时,似乎

SpanBERT在抽取式问答方面特别好。例如:- 在

SQuAD 1.1中,我们观察到2.0% F1的增益,尽管baseline已经远远高于人类的表现。 - 在

MRQA中,SpanBERT在Our BERT的基础上提高了从2.0% F1(Natural Questions)到4.6% F1(TriviaQA)。

最后,我们观察到,在各种任务中,

single-sequence training比带有NSP的bi-sequence training,在效果上要好得多。这是令人惊讶的,因为BERT的消融研究显示了来自NSP目标的收益。然而,消融研究仍然涉及bi-sequence的数据处理(即,预训练阶段只控制NSP目标,同时仍然采样两个half-length的序列)。我们猜测:bi-sequence training,正如它在BERT中实现的那样,阻碍了模型学习较长距离的特征,并因此损害了许多下游任务的性能。- 在

18.2.5 消融研究

我们将我们的

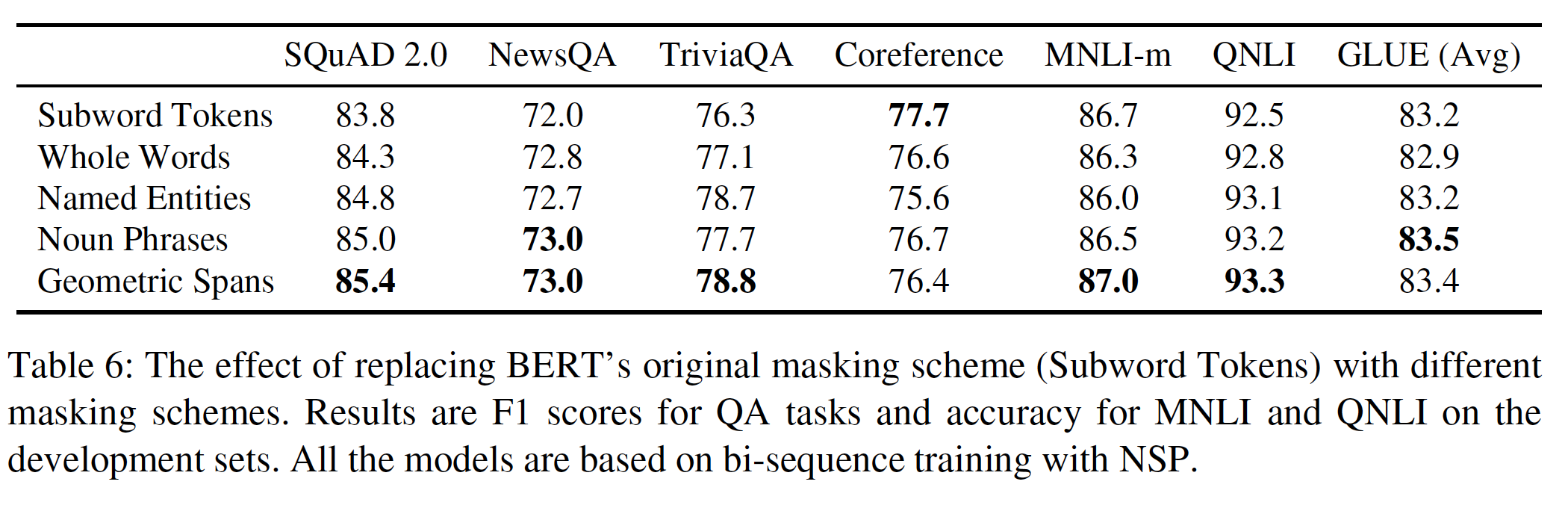

random span masking方案与linguistically-informed masking方案进行比较,发现masking random span是一种有竞争力的、并且通常是更好的方法。然后,我们研究了SBO的影响,并将其与BERT的NSP目标进行对比。掩码方案:以前的工作

ERNIE表明,在中文数据的预训练中,通过掩码linguistically informed span,改善了下游任务的表现。我们将我们的random span masking方案与linguistically informed span掩码进行比较。具体而言,我们训练了以下五种baseline模型,它们的区别仅仅在于token的掩码方式:Subword Tokens:我们采样随机的Wordpiece token,就像在original BERT中一样。Whole Words:我们采样随机的单词,然后掩码这些单词中的所有subword token。masked subword token总共占所有token的15%。Named Entities:在50%的时间里,我们从文本中采样命名实体,而在剩下50%的时间里随机采样全词whole word。masked subword token总共占所有token的15%。具体而言,我们在语料库上运行

spaCy的named entity recognizer,并选择所有非数值型的命名实体作为候选。Noun Phrases:与Named Entities类似,我们在50%的时间内采样名词短语。名词短语是通过spaCy’s constituency parser抽取的。Geometric Spans:我们从几何分布中随机采样span,如我们的SpanBERT所示。

Whole Words, Named Entities, Noun Phrases, Geometric Spans都是span-based掩码策略。下表显示了不同的预训练掩码方案在不同任务验证集上的效果。所有的模型都是在验证集上评估的,并且是基于默认的

BERT设置(即带NSP的bi-sequence training),其结果不能直接与main evaluation相比较。可以看到:除了共指消解之外,

masking random span比其他策略更好。尽管

linguistic masking方案(命名实体和名词短语)通常与random span的竞争力相当,但它们的性能并不是一致consistent的。例如,在NewsQA上,masking noun phrase实现了与random span相同的效果,但在TriviaQA上表现不佳(-1.1% F1)。在共指消解方面,

masking random subword token比任何形式的span masking都要好。然而,我们将在下面的实验中看到,将random span masking与span boundary objective相结合可以大大改善这一结果。

总体而言,这些掩码方案的差距不大。

辅助目标:如前所述,与

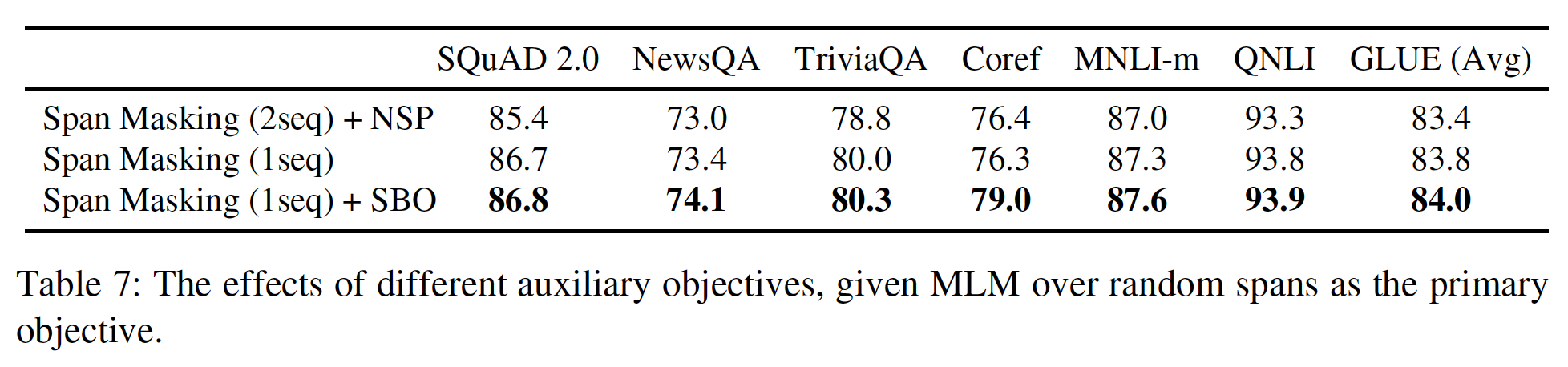

single-sequence training相比,带NSP目标的bi-sequence training会损害下游任务的性能。 我们测试了这一点对于用span masking预训练的模型是否成立,同时也评估了用SBO目标替代NSP目标的效果。下表证实了

single-sequence training通常会提高性能。加入SBO可以进一步提高性能,与span masking alone相比,共指消解有很大的提高(+2.7% F1)。不像NSP目标,SBO似乎没有任何不利影响。SBO对模型性能提升的幅度不大,同时Geometric Spans对模型性能提升的幅度也不大,但是SpanBERT整体相对于Google BERT的性能提升较大。这意味着数据预处理和优化过程(如,动态掩码,废除短序列策略)的影响也较大。

十九、ALBERT [2019]

全网络预训练

full network pre-training已经导致了language representation learning的一系列突破。许多困难的NLP任务,包括那些训练数据有限的任务,都大大受益于这些预训练的模型。这些突破之中最引人注目的标志之一是机器在RACE test上(为中国初中和高中英语考试设计的阅读理解任务)的性能演进:- 最初描述该任务并提出

modeling challenge的论文报告了当时SOTA的机器准确率为44.1%。 - 最新发表的结果(即

RoBERTa)报告了他们的模型性能为83.2%。 - 论文

《A Lite BERT for Self-supervised Learning of Language Representations》提出的ALBERT将其推高到89.4%,达到一个惊人的45.3%的改进,这主要归功于我们目前建立高性能预训练的language representation的能力。

这些改进的证据显示,大型网络对于实现

SOTA的性能至关重要。预训练大型模型并将其蒸馏成较小的模型,这种做法已成为实际应用的普遍做法。鉴于模型规模的重要性,我们问:拥有更好的NLP模型和拥有更大的模型一样容易吗?回答这个问题的一个障碍是现有硬件的内存限制。鉴于目前

SOTA的模型往往有数亿甚至数十亿的参数,当我们试图扩大我们的模型规模时,很容易就会遇到这些限制。在分布式训练中,训练速度也会受到很大影响,因为通信开销与模型中的参数规模成正比。上述问题的现有解决方案包括模型并行

model parallelization、以及巧妙的内存管理。这些解决方案解决了内存限制问题,但没有解决通信开销问题。在论文《A Lite BERT for Self-supervised Learning of Language Representations》中,作者通过设计A Lite BERT: ALBERT架构来解决上述所有问题,该架构的参数明显少于传统的BERT架构。ALBERT采用了两种参数缩减parameter reduction技术,解除了scale预训练模型的主要障碍:- 第一个技术是因子分解的

embedding parameterization。通过将大型词表的embedding matrix分解成两个小矩阵,论文将隐层的维度与vocabulary embedding的维度分离。这种分离使得在不显著增加vocabulary embedding的参数规模的情况下,更容易增长隐层的维度。 - 第二种技术是跨层参数共享

cross-layer parameter sharing。这种技术可以防止参数随着网络的深度而增长。

这两种技术都大大减少了

BERT的参数数量而不严重损害性能,从而提高了参数效率。配置类似于BERT-large的ALBERT的参数数量减少了18倍,训练速度可以提高约1.7倍。参数缩减技术也作为一种正则化的形式,稳定了训练并有助于泛化。为了进一步提高

ALBERT的性能,作者引入了一个自监督的损失用于sentence-order prediction: SOP。SOP主要关注句子间的连贯性,旨在解决original BERT中提出的next sentence prediction: NSP损失的无效性。由于这些设计决策,论文能够扩展到更大的

ALBERT配置,这些配置的参数仍然比BERT-large更少,但是性能更好。论文在著名的GLUE、SQuAD和RACE等自然语言理解benchmark上建立了新的SOTA结果。具体而言,ALBERT将RACE的准确率提高到89.4%、将GLUE benchmark提高到89.4%、将SQuAD 2.0的F1得分提高到92.2。虽然准确率更高,但是训练时间要长三倍。

- 最初描述该任务并提出

相关工作:

为自然语言

scale up representation learning:学习自然语言的representation已被证明对广泛的NLP任务有用,并被广泛采纳。过去两年中最重要的变化之一是,从预训练word embedding(无论是标准的、还是上下文contextualized的),都转变为全网络预训练full-network pre-training,然后再紧跟着进行task-specific的微调。在这个工作方向,通常显示较大的模型规模可以提高性能。例如,BERT原始论文表明:在三个自然语言理解任务中,使用更大的隐层维度、更多的隐层和更多的注意力头总是能带来更好的性能。然而,他们止步于1024的隐层维度,可能是因为模型规模和计算成本的问题。即,

BERT_LARGE的性能比BERT_BASE的性能更好。由于计算上的限制,特别是

GPU/TPU内存的限制,很难对大型模型进行实验。鉴于目前SOTA的模型往往有数亿甚至数十亿的参数,我们很容易遇到内存限制。为了解决这个问题:《Training deep nets with sublinear memory cost》提出了一种叫做gradient checkpointing的方法,以额外的前向传播为代价,将内存需求降低到亚线性sublinear。《The reversible residual network: Backpropagation without storing activations》提出了一种从next layer重构每一层的activation的方法,这样就不需要存储intermediate activation。- 这两种方法都以速度为代价降低了内存消耗。

《Exploring the limits of transfer learning with a unified text-to-text transformer》提出使用模型并行来训练一个巨型模型。

相比之下,我们的参数缩减技术减少了内存消耗,提高了训练速度。

跨层参数共享:跨层共享参数的思想之前已经用

Transformer架构进行了探索,但这之前的工作主要是针对标准的encoder-decoder任务的训练,而不是pretraining/finetuning setting。与我们的观察不同,

《Universal transformers》表明,具有跨层参数共享的网络(Universal Transformer: UT)在语言建模任务和主谓一致subject-verb agreement任务上得到了比标准transformer更好的性能。ALBERT的论文实验表明:跨层参数共享会损害模型性能。此外,

UT是encoder-decoder架构,它分别在encoder和decoder上进行参数共享。而ALBERT只有encoder,因此只有encoder的参数共享。最近,

《Deep equilibrium models》针对transformer网络提出了Deep Equilibrium Model: DQE,并表明DQE可以达到一个平衡点,即某一层的input embedding和output embedding保持一致(即,到达不动点)。我们的观察表明,我们的

embedding是振荡的,而不是收敛的。《Modeling recurrence for transformer》将参数共享的transformer与标准的transformer相结合,这进一步增加了标准transformer的参数数量。

Sentence Ordering Objectives:ALBERT使用了一个预训练损失,该损失基于预测两个连续的文本片段text segment的顺序。一些研究者已经尝试了与篇章连贯性discourse coherence类似的预训练目标。篇章中的连贯性coherence和凝聚力cohesion已被广泛研究,许多现象已被确定为连接相邻的文本片段。在实践中发现的大多数有效目标都很简单。Skipthought和FastSent的sentence embedding是通过使用一个句子的编码来预测相邻句子中的单词来学习的。sentence embedding learning的其他目标包括:预测未来的句子(而不是仅仅预测邻居),以及预测显式的篇章标记discourse marker。我们的损失与

《Discourse-based objectives for fast unsupervised sentence representation learning》的sentence ordering objective最为相似。该方法学习sentence embedding从而确定两个连续句子的顺序。然而,与上述大多数工作不同的是,我们的损失是在文本片段上而不是句子上定义的。BERT使用的损失是基于next sentence prediction。我们在实验中与这种损失进行了比较,发现sentence ordering是一项更具挑战性的预训练任务,对某些下游任务更有用。与我们的工作同时,

《StructBERT: Incorporating language structures into pre-training for deep language understanding》也试图预测两个连续的文本片段的顺序,但他们把它与原来的next sentence prediction结合起来从而得到一个三分类任务,而不是二分类任务(比较两个连续的文本片段的顺序)。

19.1 模型

19.1.1 模型架构选择

ALBERT架构的backbone与BERT类似,它使用了一个具有GELU非线性激活函数的transformer encoder。我们遵从BERT的惯例,将vocabulary embedding size记做encoder layer数量记做hidden size记做feed-forward/filter size设定为与

BERT的设计选择相比,ALBERT有三个主要贡献:因子分解的embedding参数化factorized embedding parameterization、跨层参数共享cross-layer parameter sharing、句子间的一致性损失Inter-sentence coherence loss。Factorized embedding parameterization:在BERT,以及XLNet和RoBERTa等后续建模改进中,WordPiece embedding size- 从建模的角度来看,

WordPiece embedding是为了学习context-independent representation,而hidden-layer embedding则是为了学习context-dependent representation。正如关于上下文长度的实验所示(见RoBERTa原始论文),BERT-like representation的力量来自于上下文的使用,从而提供用于学习这种context-dependent representation的信号。因此,将WordPiece embedding sizehidden layer size - 从实践的角度来看,自然语言处理通常需要很大的词表大小

embedding matrix的大小,其中embedding matrix的大小为

因此,对于

ALBERT,我们使用embedding参数的因子分解,将它们分解成两个较小的矩阵。我们不是直接将one-hot向量投影到维度为embedding空间,然后再投影到隐空间。通过使用这种分解,我们将embedding参数的规模从我们选择对所有的

word piece使用相同的whole-word相比,word piece在文档中的分布更加均匀。在whole-word embedding中,对不同的词有不同的embedding size是很重要的。- 从建模的角度来看,

Cross-layer parameter sharing:跨层参数共享是提高参数效率的另一种方式。有多种共享参数的方式,例如,仅共享跨层的feed-forward network: FFN参数、或者仅共享注意力参数。ALBERT的默认决定是跨层共享所有参数。除非另有说明,我们所有的实验都使用这个默认决定。我们在实验中把这个设计决定与其他共享参数策略进行了比较。虽然参数共享降低了参数规模,但是并没有降低计算量。

Universal Transformer: UT和Deep Equilibrium Models: DQE对Transformer网络也进行了类似的探索。- 与我们的观察不同,

《Universal Transformer》表明:UT优于普通的Transformer。 《Deep equilibrium models》表明,他们的DQE达到了一个平衡点,对于这个平衡点,某一层的input embedding和output embedding保持不变。我们对L2距离和余弦相似度的测量表明,我们的embedding是振荡的而不是收敛的。

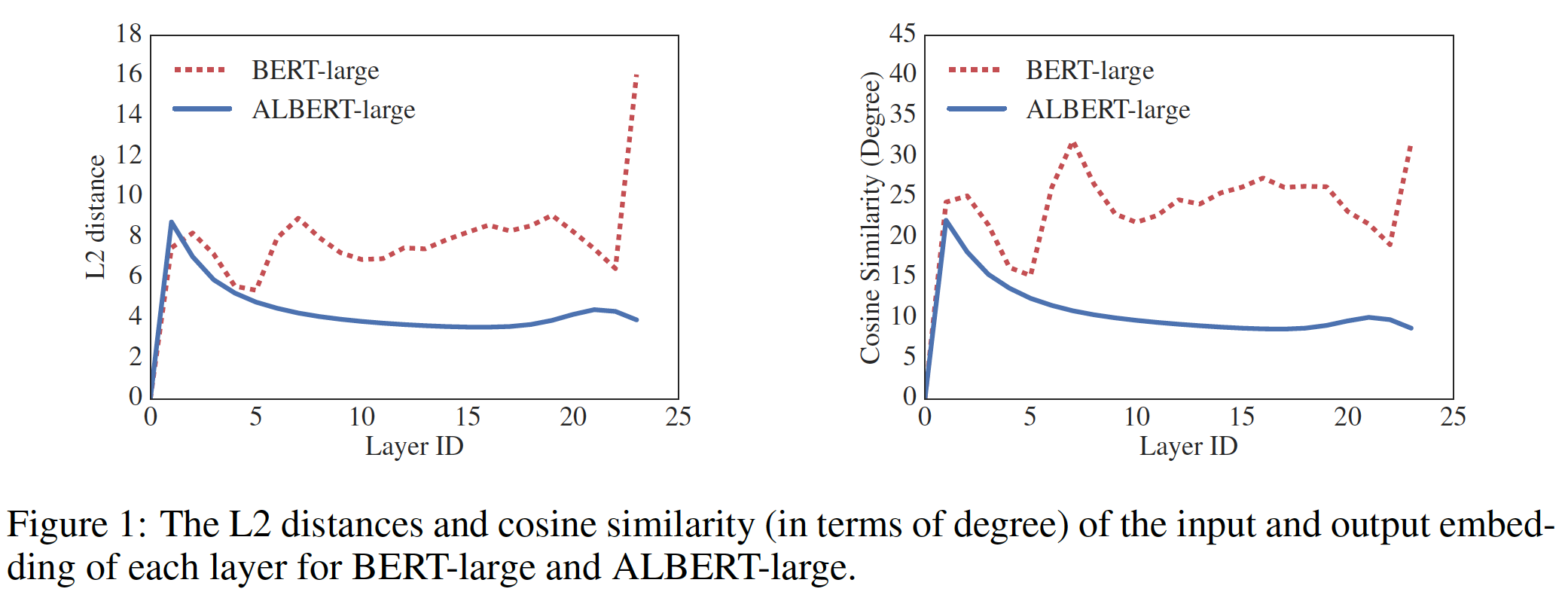

下图显示了每一层的

input embedding和output embedding的L2距离和余弦相似度,使用BERT-large和ALBERT-large配置(如下表所示)。我们观察到:ALBERT的层与层之间的转移transition比BERT的平滑得多。这些结果表明,权重共享对稳定网络参数有一定的影响。尽管与

BERT相比,两个指标(即,L2距离和余弦相似度)都有下降,但即使在24层之后,它们也没有收敛到0。这表明:ALBERT参数的解空间与DQE所发现的解空间非常不同。

- 与我们的观察不同,

Inter-sentence coherence loss:除了masked language modeling: MLM损失,BERT还使用了一个额外的损失,称为next-sentence prediction: NSP。NSP是一种二元分类损失,用于预测两个segment是否在原始文本中连续出现,具体如下:通过从训练语料库中抽取连续的segment来创建正样本,通过将不同文档中的segment配对来创建负样本,正样本和负样本是以相同的概率进行采样。NSP的目的是为了提高下游任务(如自然语言推理)的性能,这些任务需要推理sentence pair之间的关系。然而,随后的研究(XLNet、RoBERTa)发现NSP的影响不可靠,并决定取消NSP。我们猜想,

NSP的无效性背后的主要原因是:与MLM相比,NSP任务缺乏难度。正如该任务的表述,NSP将话题预测topic prediction和连贯性预测coherence prediction混合在一个任务中。 然而,与连贯性预测相比,话题预测更容易学习,而且也与MLM损失所学到的内容有很多重叠。SpanBERT认为NSP的无效性背后的主要原因是:- 在双序列上下文中,模型无法从较长的

full-length上下文中获益。 - 在双序列上下文中,以另一个文档中的、通常不相关的上下文为条件,会给

MLM增加噪音。

我们坚持认为句子间建模

inter-sentence modeling是语言理解的一个重要方面,但我们提出了一个主要基于连贯性的损失。也就是说,对于ALBERT,我们使用了一个sentence-order prediction: SOP损失,它避免了主题预测,而是专注于建模句子间的连贯性。SOP损失使用与BERT相同的技术(来自同一文件的两个连续segment)作为样本,并使用相同的两个连续segment但是调换顺序之后作为负样本。这就迫使模型学习关于篇章级discourse-level连贯性的更精细的区分。正如我们在实验部分所显示的,事实证明:

NSP根本不能解决SOP的任务(也就是说,它最终学习了更容易的话题预测信号,并在SOP任务中表现为随机水平)。- 而

SOP可以在一定程度上解决NSP的任务,大概是基于分析misaligned coherence cue。

因此,

ALBERT模型为multi-sentence encoding任务一致性地改善了的下游任务表现。- 在双序列上下文中,模型无法从较长的

19.1.2 模型配置

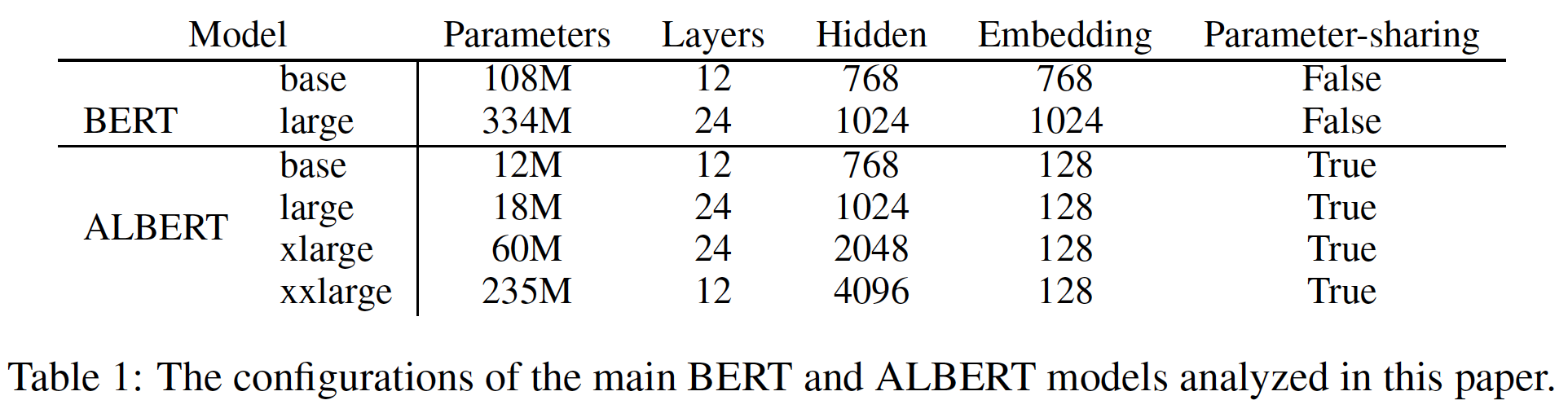

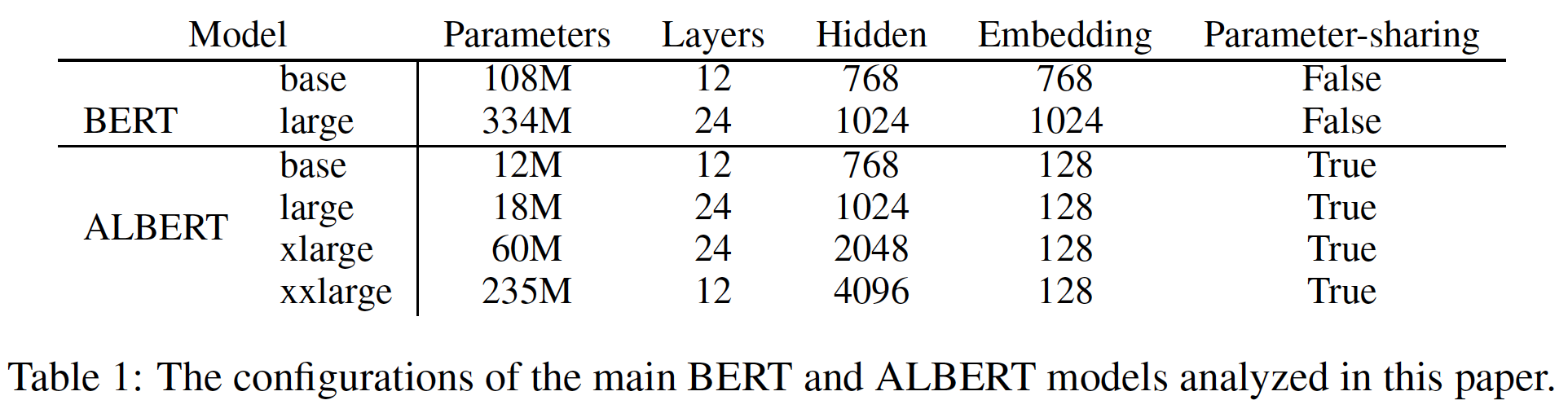

我们在下表中列出了

BERT模型和ALBERT模型在可比的超参数设置下的差异。由于上面讨论的设计选择,ALBERT模型与相应的BERT模型相比,其参数规模要小得多。例如:

与

BERT-large相比,ALBERT-large的参数少了大约18倍,即18M对334M。参数少了

18倍,但是模型的效果也有所降低。H=2048的ALBERT-xlarge只有60M的参数,H=4096的ALBERT-xxlarge只有235M的参数(约为BERT-large参数规模的70%)。

请注意,对于

ALBERT-xxlarge,我们主要报告12层网络的结果,因为24层网络(具有相同的配置)获得了类似的结果,但计算成本更高。这种参数效率的提高是

ALBERT的设计选择的最重要的优势。

19.2 实验

为了使对比尽可能的有意义,我们遵从

BERT的设置,使用BOOKCORPUS和English Wikipedia用于预训练baseline模型。这两个语料库包括大约16GB的未压缩文本。我们将输入格式化为

segment。我们总是将最大输入长度(即,拼接之后的序列的最大长度)限制为512个token,并以10%的概率随机生成短于512的输入序列。与

BERT一样,我们使用大小为30K的词表vocabulary,使用SentencePiece进行tokenization(如同XLNet)。我们使用

n-gram masking为MLM目标生成masked input(如同SpanBERT),每个n-gram masking的长度n-gram masking的最大长度):这个概率倾向于更短的

n-gram masking。例如,当0.341, 0.171, 0.114, 0.085, 0.068, 0.057, 0.049, 0.043, 0.038, 0.034。我们设定

n-gram masking的最大长度为3,即MLM目标可以由最多3个完整的单词组成,如"White House correspondents"。所有的模型更新都使用了

batch size = 4096、以及学习率为0.00176的LAMB优化器。除非另有说明,我们对所有模型进行了125K个step的训练。训练是在Cloud TPU V3上进行的。用于训练的TPU数量从64到512不等,取决于模型大小。LAMB优化器是针对大batch size的训练。首先我们看下Adam优化器:其中:

AdamW是为了适配weight decay(权重衰减相当于参数的L2正则化),在Adam的基础上进行修改:其中:

0.005/0.01。LAMB在AdamW的基础上继续修改:其中:

除非另有说明,本节中描述的实验设置用于我们自己的所有版本的

BERT以及ALBERT模型。评估

benchmark:固有评估

Intrinsic Evaluation:为了监控训练进度,我们使用前面相同的程序和配置,在SQuAD和RACE的验证集基础上创建了一个验证集。我们同时报告了MLM和句子分类任务的准确率。注意,我们只用这个创建的验证集来检查模型是如何收敛的,它的使用方式不会影响任何下游评估的性能(例如,该验证集不是用于模型选择)。

下游评估

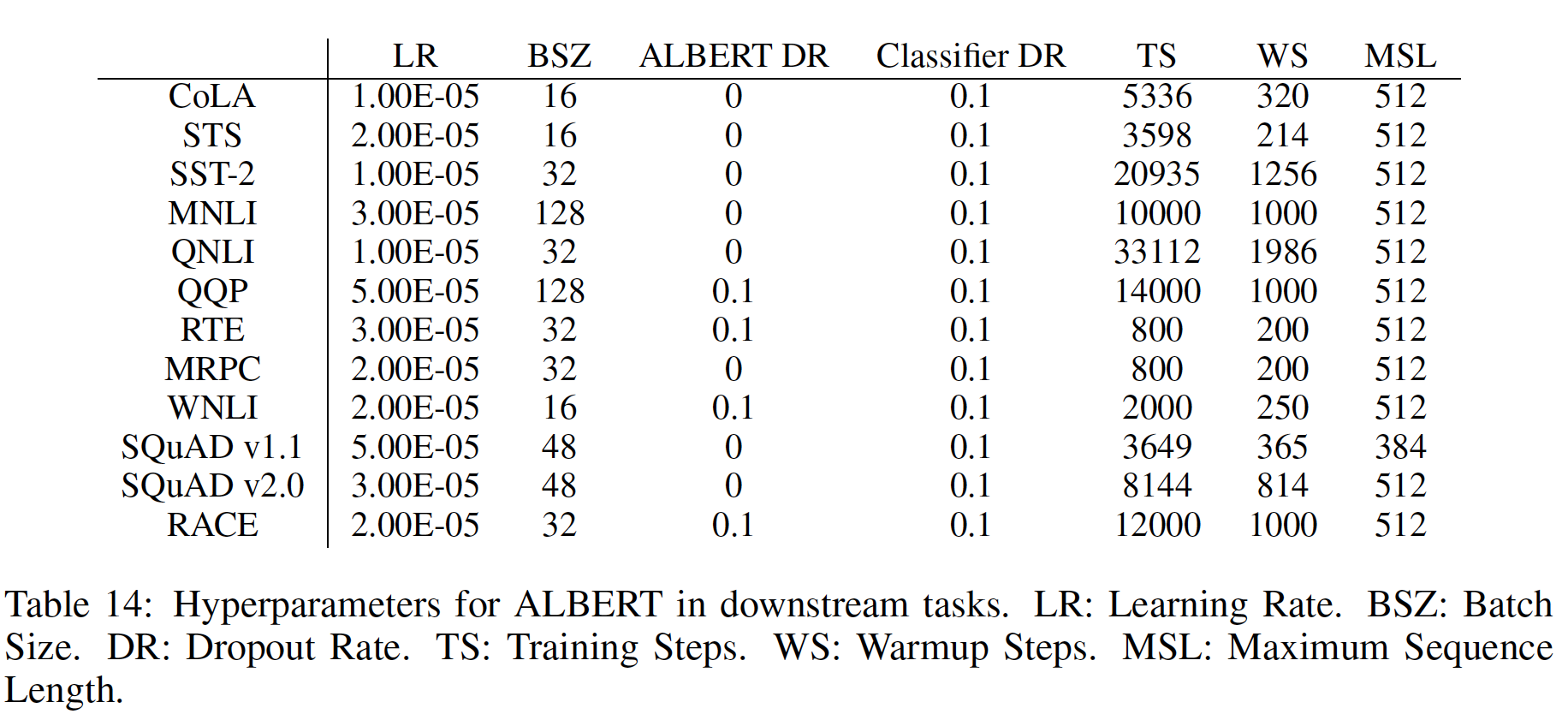

Downstream Evaluation:遵从XLNet和RoBERTa,我们在三个流行的benchmark上评估我们的模型:General Language Understanding Evaluation: GLUE基准、两个版本的Stanford Question Answering Dataset: SQuAD、以及ReAding Comprehension from Examinations: RACE数据集。与RoBERTa一样,我们对验证集进行了早停early stopping,在此基础上我们报告了所有的比较,除了基于任务排行榜的最终比较(在最终比较,我们也报告了测试集的结果)。对于在验证集上有较大方差的GLUE数据集,我们报告了5次运行的中位数。GLUE:GLUE由9个任务组成,即 :xxxxxxxxxxCorpus of Linguistic Acceptability: CoLAStanford Sentiment Treebank: SSTMicrosoft Research Paraphrase Corpus: MRPCSemantic Textual Similarity Benchmark: STSQuora Question Pairs: QQPMulti-Genre NLI: MNLIQuestion NLI: QNLIRecognizing Textual Entailment: RTEWinograd NLI: WNLIGLUE聚焦于评估模型的自然语言理解能力。当报告MNLI结果时,我们只报告"match"条件(即,MNLI-m)。我们遵循先前工作中的微调程序(BERT、RoBERTa、XLNet),并报告GLUE sbumission的held-out test set性能。对于测试集的submission,我们遵从RoBERTa和XLNet的描述,对WNLI和QLNLI进行了task-specific修改。SQuAD:SQuAD是一个从Wikipedia建立的提取式问答数据集extractive question answering dataset。答案是来自上下文段落的segment,任务是预测answer span。我们在两个版本的SQuAD上评估我们的模型:v1.1和v2.0。SQuAD v1.1有100K个人类标注的question/answer pair,SQuAD v2.0还额外引入 了50K个无法回答的问题。对于

SQuAD v1.1,我们使用与BERT相同的训练程序;而对于SQuAD v2.0,模型是用span extraction loss和额外的predicting answerability分类器联合训练的(RoBERTa、XLNet)。我们同时报告了验证集和测试集的性能。RACE:RACE是一个大规模的多选阅读理解数据集,收集自中国的英语考试,有近100K个问题。RACE中的每个实例有4个候选答案。遵从之前的工作(RoBERTa、XLNet),我们使用段落、问题、以及每个候选答案的拼接作为模型的输入。然后,我们使用来自"[CLS]" token的representation来预测每个答案的概率。该数据集包括两个

domain:初中和高中。我们同时在这两个domain上训练我们的模型,并同时报告验证集和测试集的准确率。

下游任务的超参数配置如下表所示。

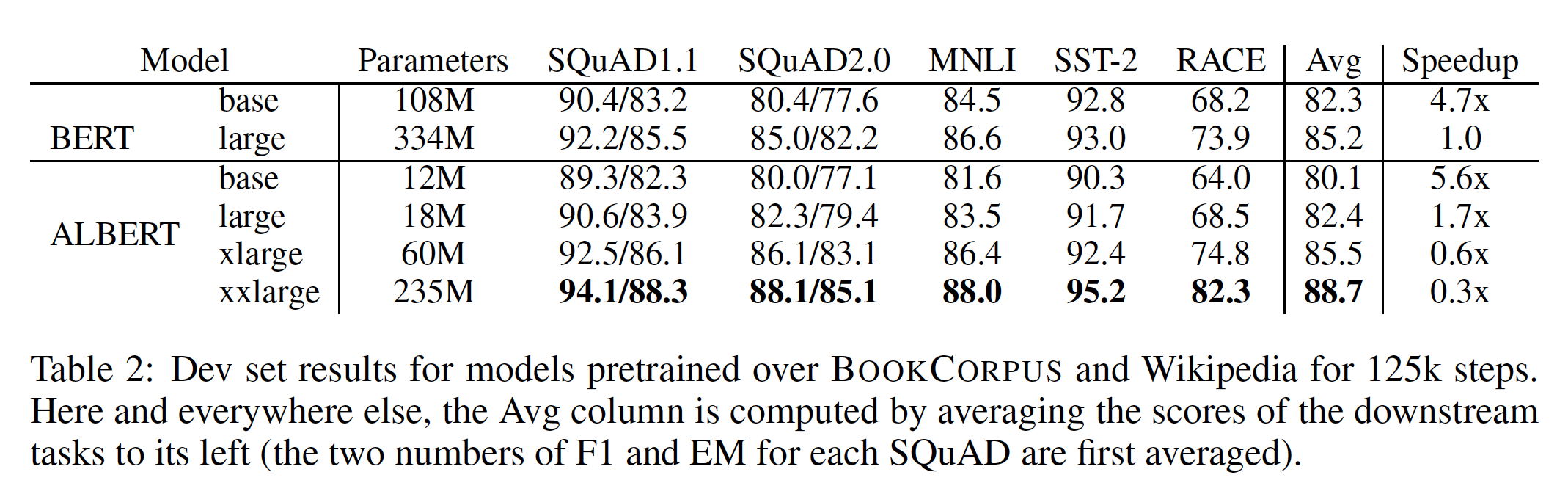

19.2.1 BERT 和 ALBERT 的整体比较

我们现在准备量化

ALBERT模型架构设计选择的影响,特别是围绕参数效率parameter efficiency的选择。如下表所示,参数效率的提高展示了ALBERT设计选择的最重要的优势:ALBERT-xxlarge只用了BERT-large的70%左右的参数,就比BERT-large取得了显著的改进,这可以通过几个有代表性的下游任务的验证集分数的差异来衡量:SQuAD v1.1(+1.9%)、SQuAD v2.0(+3.1%)、MNLI(+1.4%)、SST-2(+2.2%)、以及RACE(+8.4%) 。另一个有趣的观察是在相同的训练配置(相同数量的

TPU)下,训练期间的数据吞吐速度。由于较少的通信和较少的计算,ALBERT模型与它们相应的BERT模型相比,具有更高的数据吞吐量。如果我们使用BERT-large作为baseline,我们观察到ALBERT-large在训练期间大约快1.7倍,而ALBERT-xxlarge由于结构较大,大约慢3倍。这种比较的意义不大:

- 虽然

ALBERT-xxlarge的平均准确率更高(+3.5%),但是它要慢3倍。 - 虽然

ALBERT-large更快(快1.7倍),但是它的平均准确率更低(-2.8%)。 ALBERT-xlarge的效果与BERT几乎差不多(略高+0.3%),但是要慢1.5倍。

这表明

ALBERT虽然降低了参数数量,但是没有降低总的计算量。但是,接下来作者比较了在相同训练时间情况下,ALBERT-xxlarge仍然要超过BERT-large,这才证明了ALBERT的价值。接下来,我们进行消融实验,从而量化

ALBERT的每个设计选择的单独贡献。

- 虽然

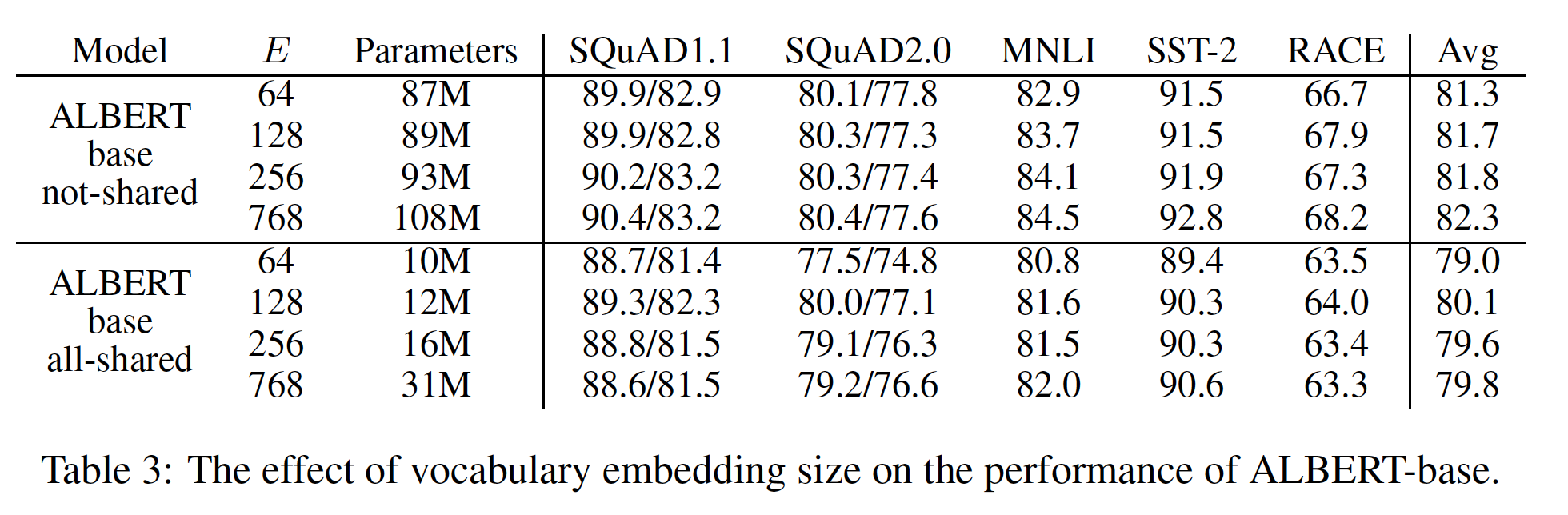

19.2.2 因子分解的 Embedding Parameterization

下表显示了使用

ALBERT-base配置(见Table 1)时改变vocabulary embedding维度- 在

not-shared条件下(BERT-style),较大的embedding维度会带来更好的性能,但幅度不大。 - 在

all-shared条件下(ALBERT-style,即ALBERT base对应的结果),128维的embedding似乎是最好的。

这样看起来,

embedding size超过了64之后,似乎模型性能差距不大?这是否说明此时模型容量已经足够强大,而瓶颈在于训练数据?可以通过在embedding size小于64上进行验证,如embedding size为{1, 4, 8, 16, 32}。基于这些结果,我们在未来的所有设置中使用

embedding维度scaling的必要步骤。下表还说明:相同

embedding size下,ALBERT比BERT的效果更差。

- 在

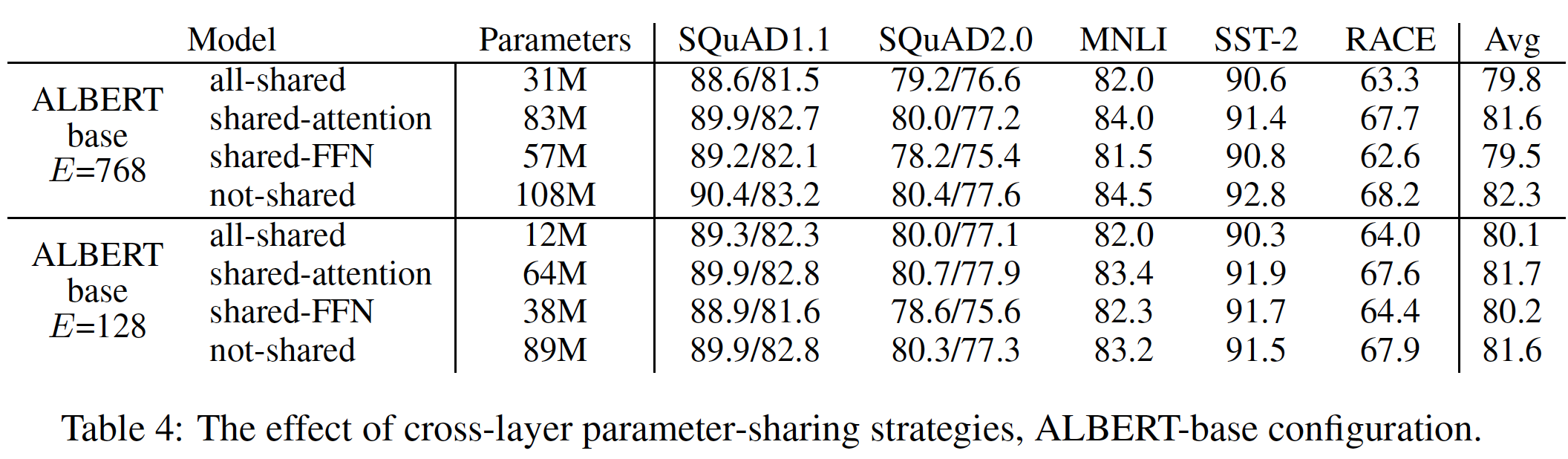

19.2.3 跨层参数共享

下表 列出了各种跨层参数共享策略的实验,其中使用

ALBERT-base配置(见Table 1)和两种embedding维度(all-shared策略(ALBERT-style)、not-shared策略(BERT-style)、以及中间策略(只有注意力参数被共享、或只有FFN参数被共享)。可以看到:相比较于

not-shared,all-shared在两种embedding维度下都会损害性能,但与-2.5%)相比,-1.5%)的情况稍微好一点。这和

《Universal Transformer》的实验结论相反。此外,相比较于

not-shared,大部分的性能下降似乎来自于共享FFN参数,而共享注意力参数在+0.1%)、在-0.7%)。还有其他跨层共享参数的策略。例如,我们可以把

all-shared作为我们的默认选择。

19.2.4 Sentence Order Prediction

我们使用

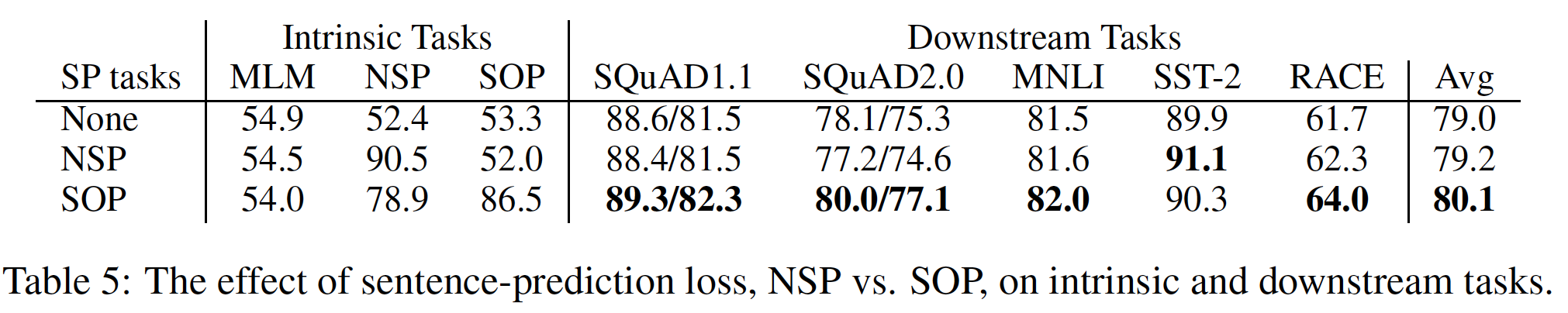

ALBERT-base配置,对额外的句间损失inter-sentence loss进行了三个实验:none(XLNet-style和RoBERTa-style)、NSP(BERT-style)、以及SOP(ALBERT-style)。结果如下表所示,包括固有任务(MLM、NSP、以及SOP任务的准确率)和下游任务。可以看到:固有任务的结果显示:

NSP loss没有给SOP任务带来判别能力(52.0%的准确率,类似于None条件下的随机猜测性能)。这使我们可以得出结论:NSP最终仅建模话题漂移topic shift。- 相比之下,

SOP loss确实能比较好地解决NSP任务(准确率78.9%),解决SOP任务甚至更好(准确率86.5%)。

这三种方式对

MLM任务都没有帮助。更重要的是,相比

None,SOP loss似乎一致地改善下游multi-sentence encoding任务的表现(SQuAD1.1约提升+1%、SQuAD 2.0约提升+2%、RACE约提升+1.7%),平均得分提高了约+1%。

19.2.5 相同训练时间

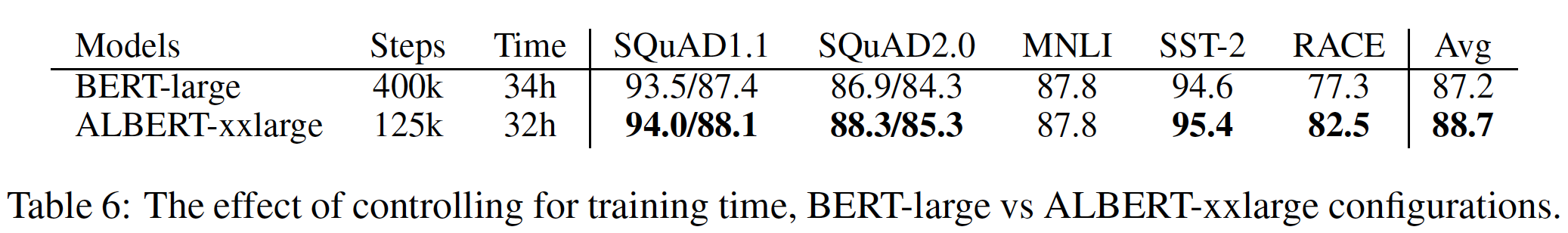

Table 2中的加速结果表明,与ALBERT-xxlarge相比,BERT-large的数据吞吐量高出约3.17倍。由于更长的训练时间通常会导致更好的性能,我们进行了一个比较,其中,我们不控制数据吞吐量(即,训练步数),而是控制实际训练时间(即,让不同的模型训练相同的小时数)。在下表中,我们比较了一个BERT-large模型在400K个训练step(经过34小时的训练)后的性能,大致相当于训练一个ALBERT-xxlarge模型所需的125K个训练step(32小时的训练)的时间。在训练了大致相同的时间后,

ALBERT-xxlarge显著优于BERT-large:平均值提高了+1.5%,在RACE上的性能提升高达+5.2%。

19.2.6 额外的训练数据和 Dropout 效果

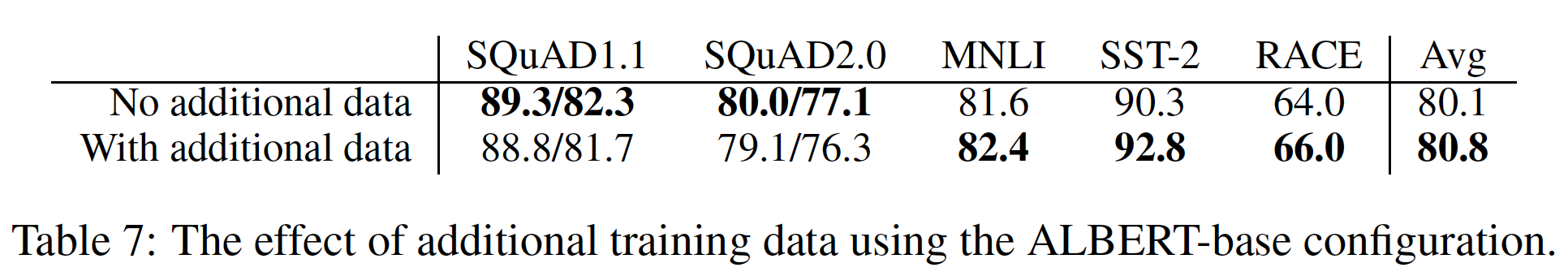

到目前为止所做的实验只使用了

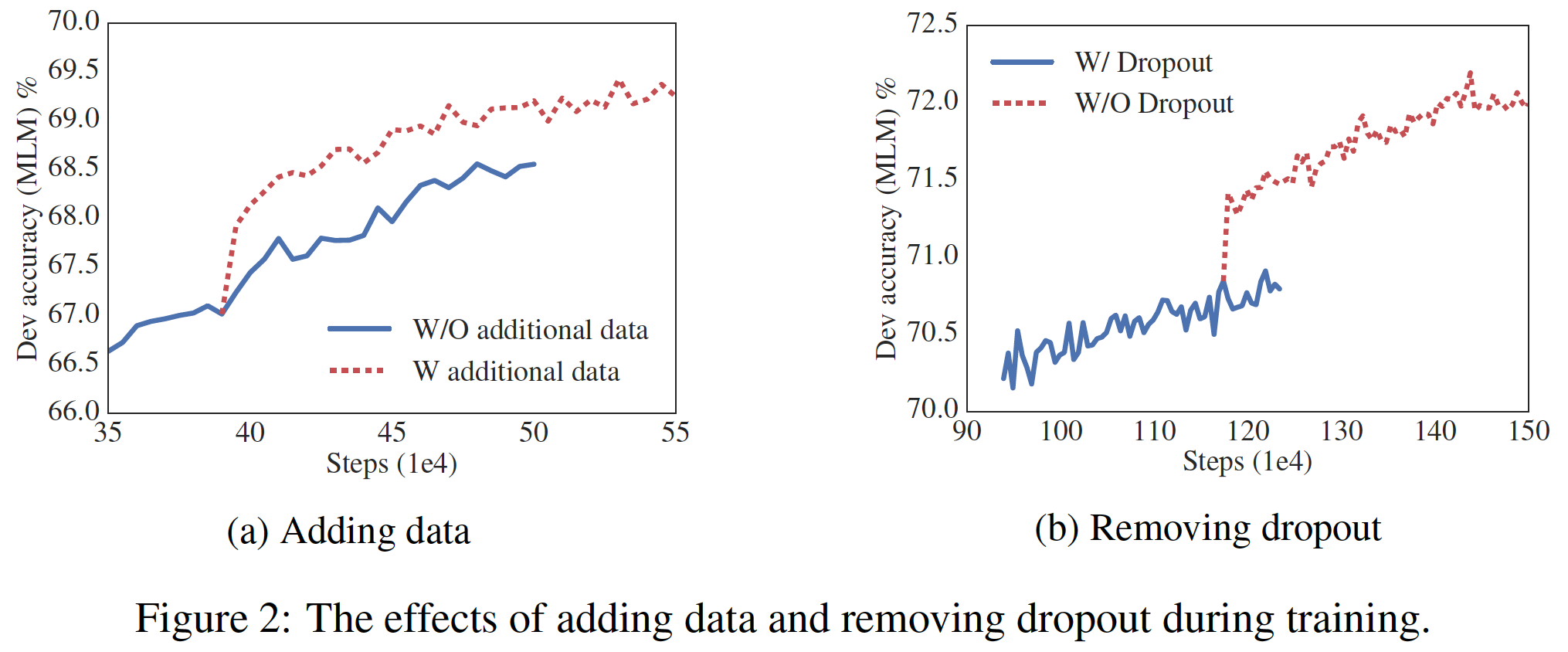

Wikipedia和BOOKCORPUS数据集,就如BERT所使用的。在本节中,我们报告了XLNet和RoBERTa所使用的额外数据的影响。下图(a)显示了在没有额外数据、以及有额外数据两种条件下的验证集MLM准确率,可以看到有额外数据条件下有显著的提升。从下表中我们还观察到,除了SQuAD benchmark(Wikipedia-based,因此受到out-of-domain训练数据的负面影响)之外,下游任务的性能也有所提高。BERT-large模型训练了400K步,因此ALBERT-base也用Wikipedia + BOOKCORPUS训练了400K步。然后在此之后使用了额外的数据。因此下图(a)中,前面400K步,二者的曲线是重合的。

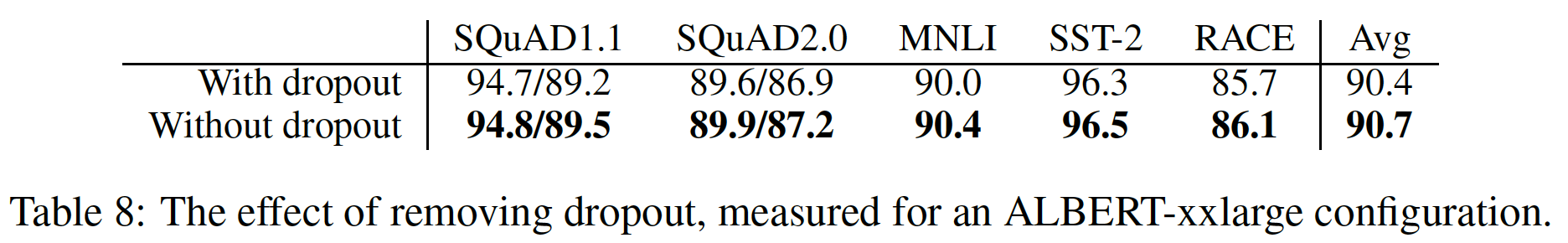

我们还注意到,即使在训练了

1M步之后,我们最大的模型仍然没有过拟合训练数据。因此,我们决定移除dropout从而进一步提高我们的模型容量。如下图(b)所示,移除dropout显著提高了MLM的准确率。对ALBERT-xxlarge在大约1M步训练的中间评估(如下表所示)也证实:移除dropout有助于下游任务。有经验(《Inception-v4, inception-resnet and the impact of residual connections on learning》)和理论(《Understanding the disharmony between dropout and batch normalization by variance shift》)证据表明:卷积神经网络中的batch normalization和dropout组合可能会产生有害的结果。据我们所知,我们是第一个表明dropout会损害大型Transformer-based模型的性能。然而,ALBERT的底层网络结构是transformer的一个特例,需要进一步的实验来观察这种现象是否出现在其他transformer-based的架构中。注意,下图

(b)是从1M步之后再移除dropout的,而不是一开始就移除dropout。所以前面1M步,二者的曲线是重合的。另外,论文的结论有点问题。这里仅仅说明,前

2/3的时间使用dropout然后剩余时间移除dropout,要比全部时间使用dropout的效果更好。而无法说明移除dropout比带dropout更好。另外,论文的

Table 8仅仅说是在大约1M步时的评估结果,但是没有说具体在什么时候。是110万步?还是120万步?

19.2.7 NLU 任务上的当前 SOTA

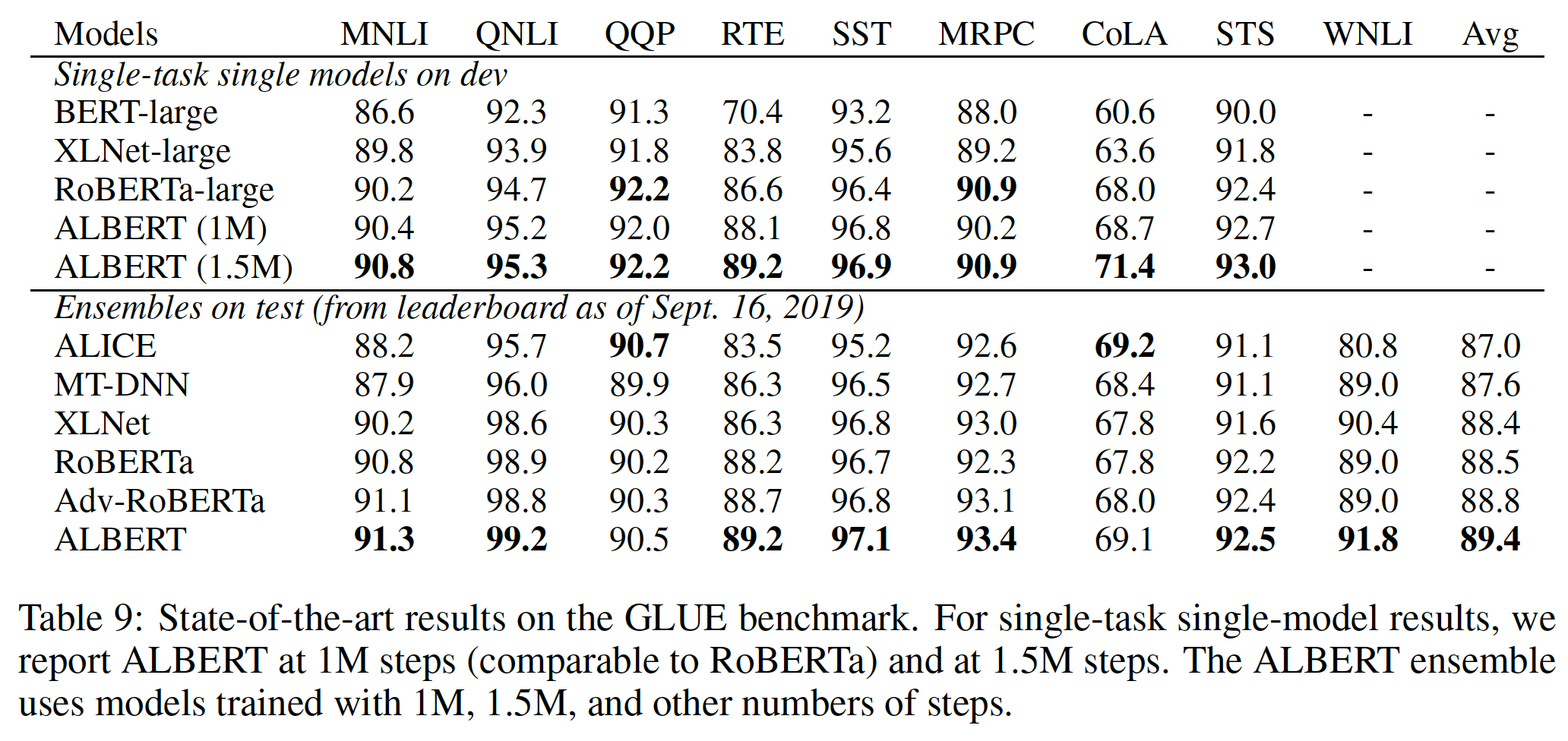

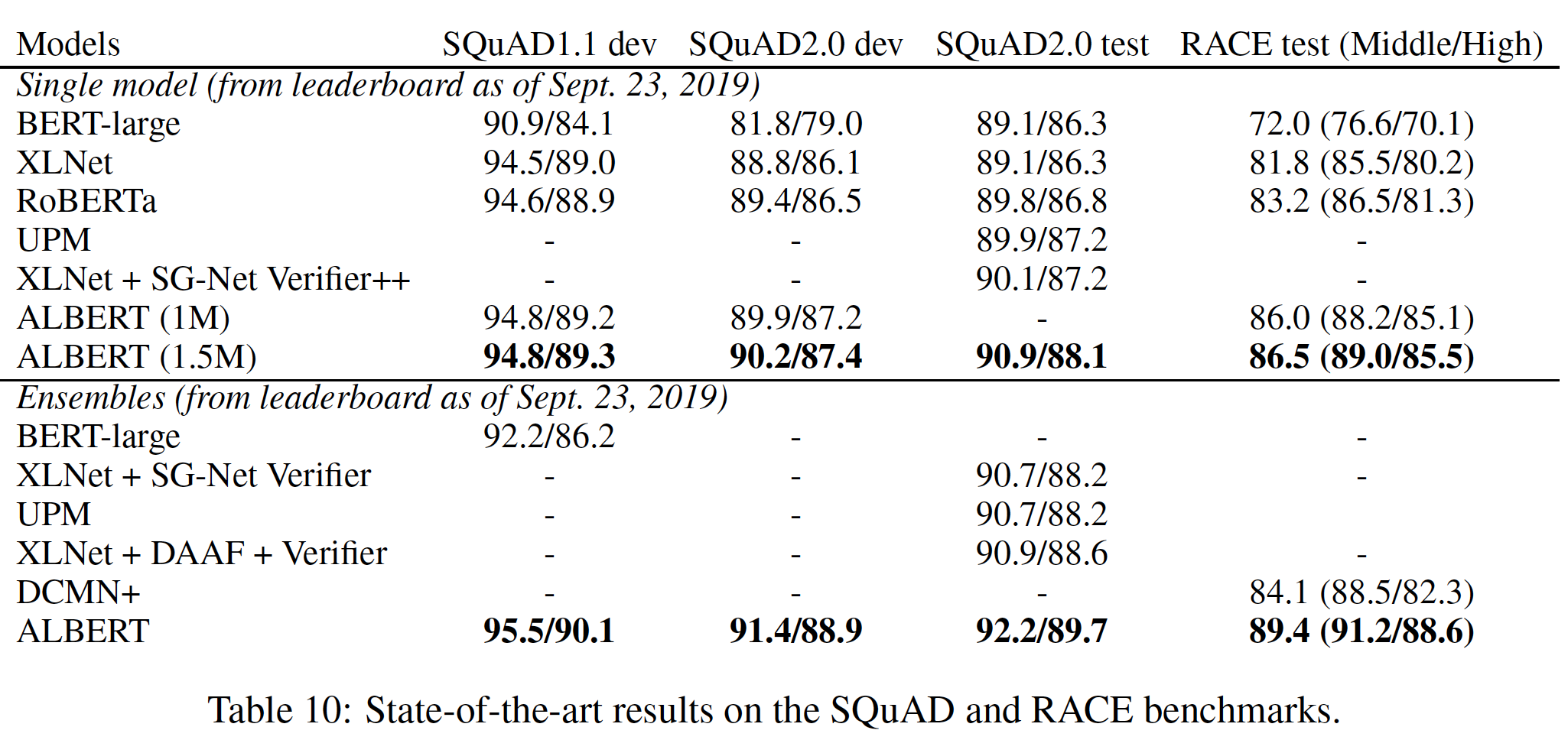

我们在本节报告的结果利用了

BERT使用的训练数据,以及RoBERTa和XLNet使用的额外数据。我们报告了两种setting下的微调的SOTA结果:单模型single-model和集成ensemble。在这两种setting中,我们只做单任务微调。遵从RoBERTa的做法,在验证集上,我们报告了五次运行的中位数。单模型的

ALBERT配置包含了所讨论的最佳性能的setting:ALBERT-xxlarge配置(参考Table 1),组合MLM loss和SOP loss,以及no dropout。ensemble的ALBERT是从多个checkpoint来获取的,这些checkpoint根据验证集的性能来选择,被选中的checkpoint的数量从6到19不等。对于

GLUE(Table 9)和RACE(Table 10),我们对集成模型ensemble models的预测值取平均,其中候选模型是微调了不同的预训练模型(这些预训练模型使用12架构层和24层架构,并预训练了不同的步数)。对于

SQuAD(Table 10),我们对那些有多个概率的span的预测分数进行了平均。我们还对"unanswerable"的决定的分数进行了平均。

单模型结果和集成模型结果都表明:

ALBERT在所有三个benchmark上都大大改善了SOTA的水平,实现了89.4的GLUE得分、92.2的SQuAD 2.0测试F1得分、以及89.4的RACE测试准确率。这些都是集成模型的效果。

RACE上似乎是一个特别强大的改进:我们的集成模型比

BERT的绝对分值跃升+17.4%、比XLNet提升+7.6%、比RoBERTa提升+6.2%、比DCMI+提升5.3%。这里只有

DCMI+是集成模型的效果,其它的BERT/XLNET/RoBERTa都是单模型的效果(不公平的比较)。我们的单模型达到了

86.5%的测试准确率,比SOTA的集成模型仍好2.4%。

19.2.8 附录:网络的深度和宽度

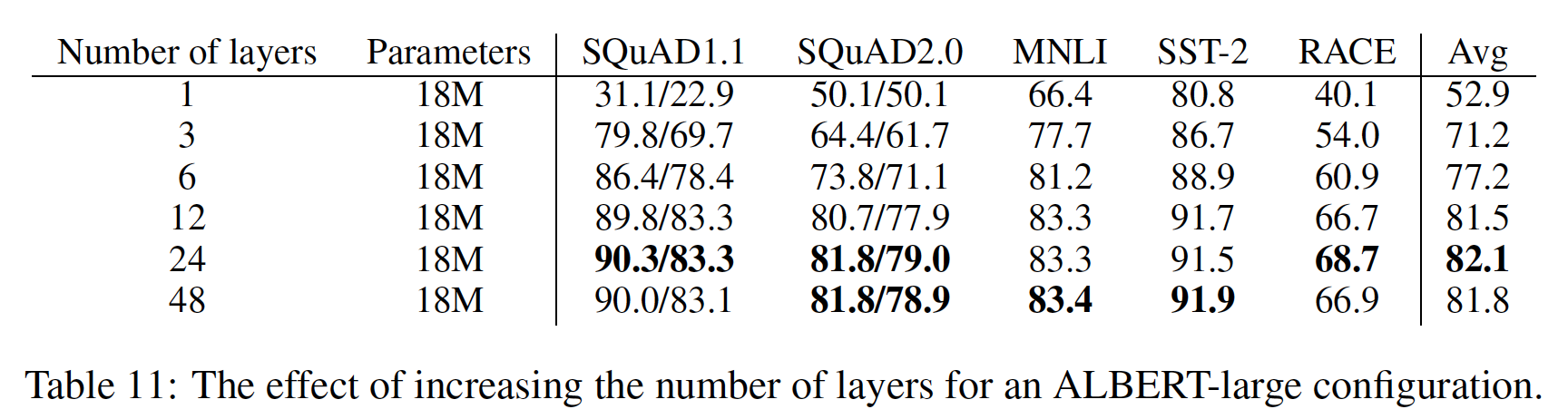

在本节中,我们检查了网络深度(层数)和宽度(隐层维度)对

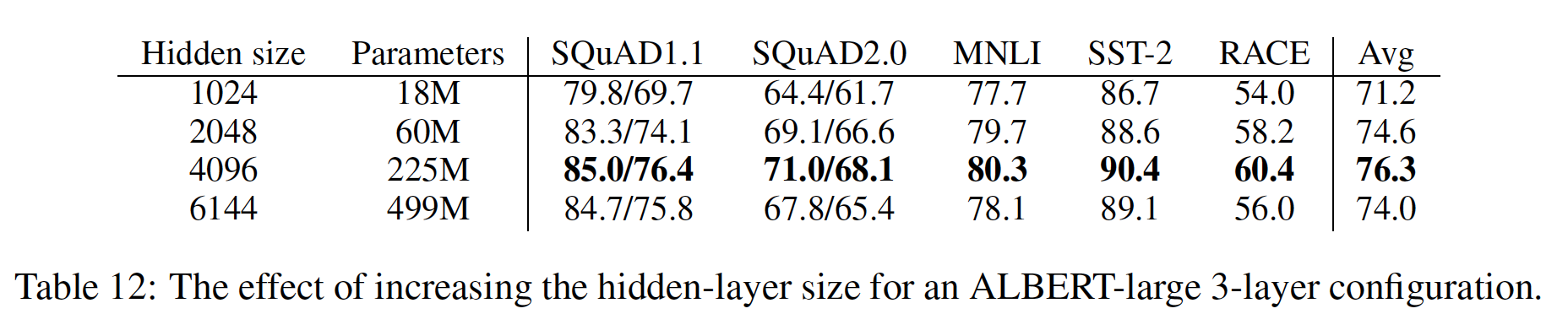

ALBERT的性能的影响。下表显示了使用不同层数的

ALBERT-large配置(见Table 1)的性能。具有3层或更多层的网络是通过使用之前深度的网络参数进行微调来训练的(例如,12层的网络参数是从6层网络参数的checkpoint进行微调的)。《Efficient training of bert by progressively stacking》也使用了类似的技术。>=3层的网络都不是从头开始训练的,而是利用更浅网络的参数来微调的。对于

ALBERT-large,可以看到:对比

3网络与1层网络,虽然它们的参数数量相同,但性能显著提高。所有不同层的网络,它们的参数数量都相同,因为是参数共享。

然而,当继续增加层数时,会出现收益递减:

12层网络的结果与24层网络的结果相对接近,而48层网络的性能似乎有所下降。

网络宽度也出现了类似的现象,如下表所示(针对不同宽度的

ALBERT-large配置)。可以看到:- 当增加隐层维度时,模型性能增加,但会出现收益递减。

- 在隐层维度为

6144时,模型性能似乎明显下降。

我们注意到,这些模型似乎都没有过拟合训练数据,而且与表现最好的

ALBERT配置相比,它们的训练损失和验证损失都比较高。

是否更宽的模型需要更深?在前面我们表明:对于隐层维度

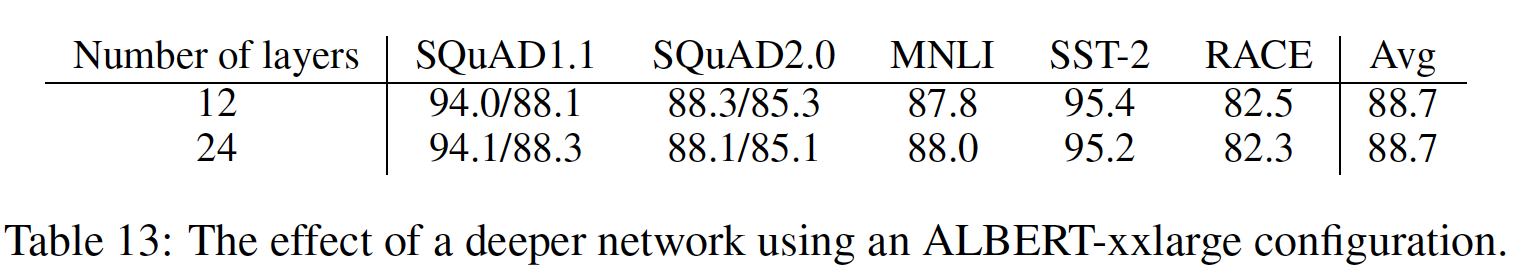

ALBERT-large,12层和24层模型 之间的差异很小。对于更宽的ALBERT,如ALBERT-xxlarge(答案如下表所示。

12层和24层的ALBERT-xxlarge配置在下游任务准确率方面的差异可以忽略不计,Avg得分相同。我们的结论是:当共享所有跨层参数(ALBERT-style)时,没有必要建立比12层更深的模型。

二十、UniLM [2019]

语言模型的预训练在各种自然语言处理任务中大大推进了

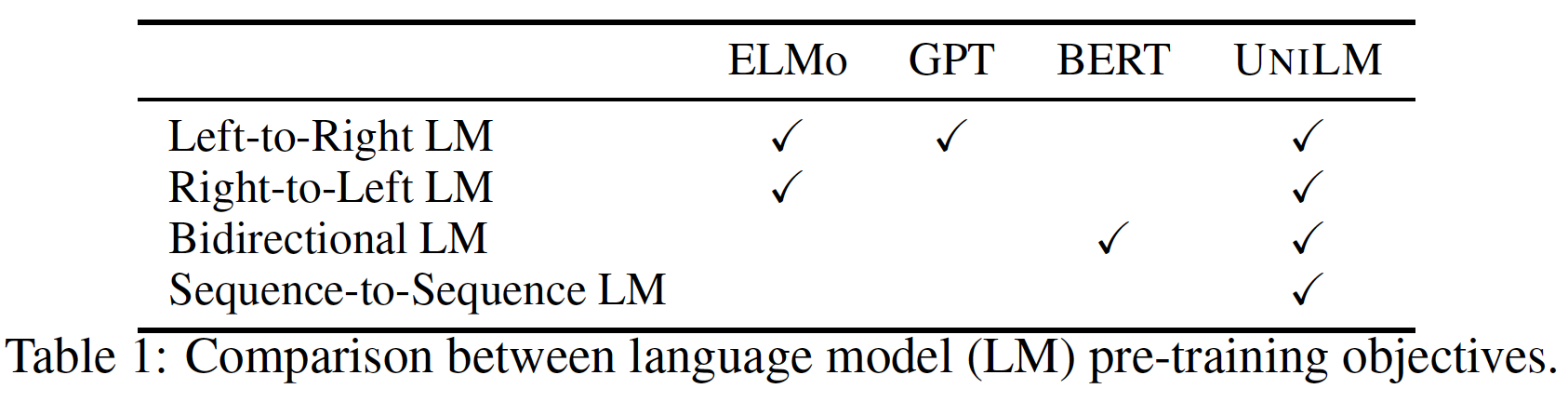

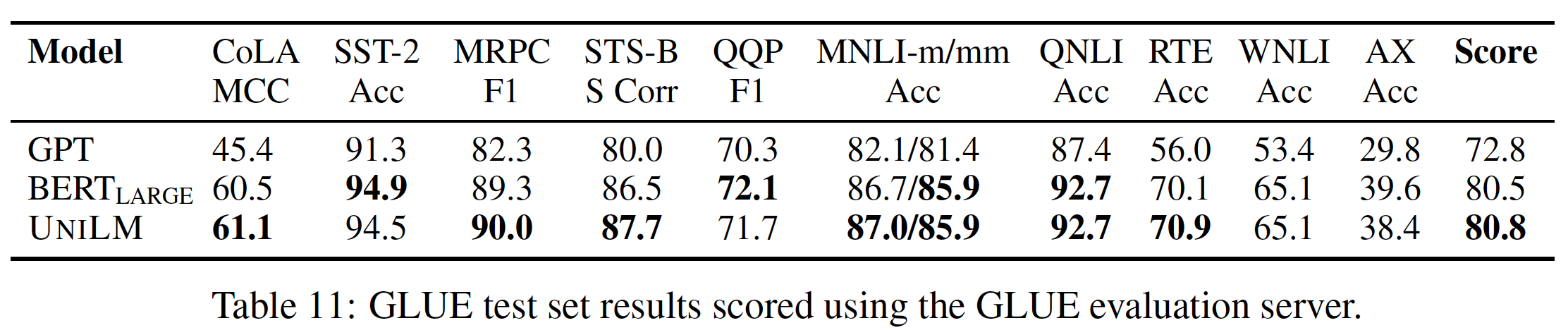

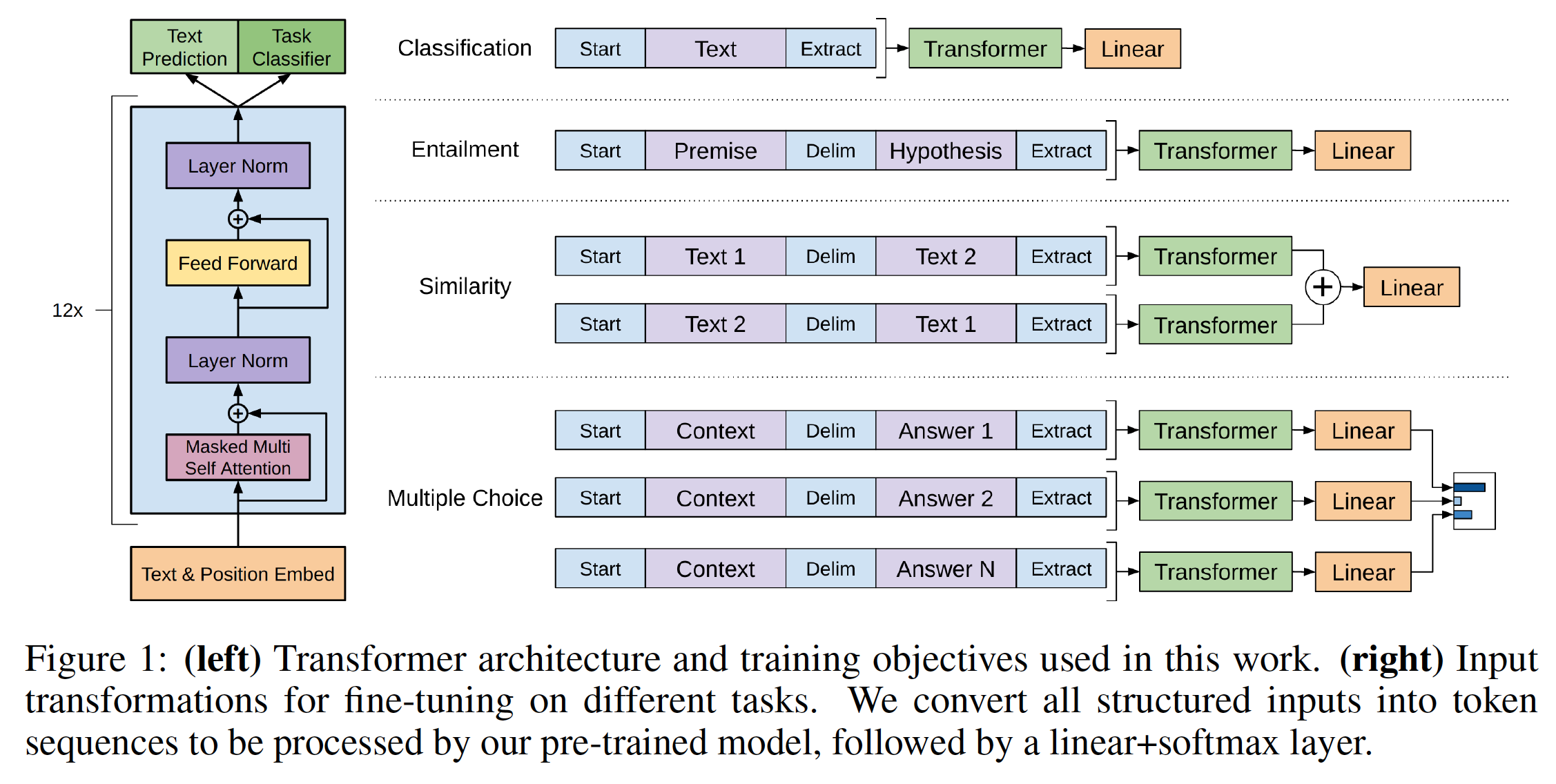

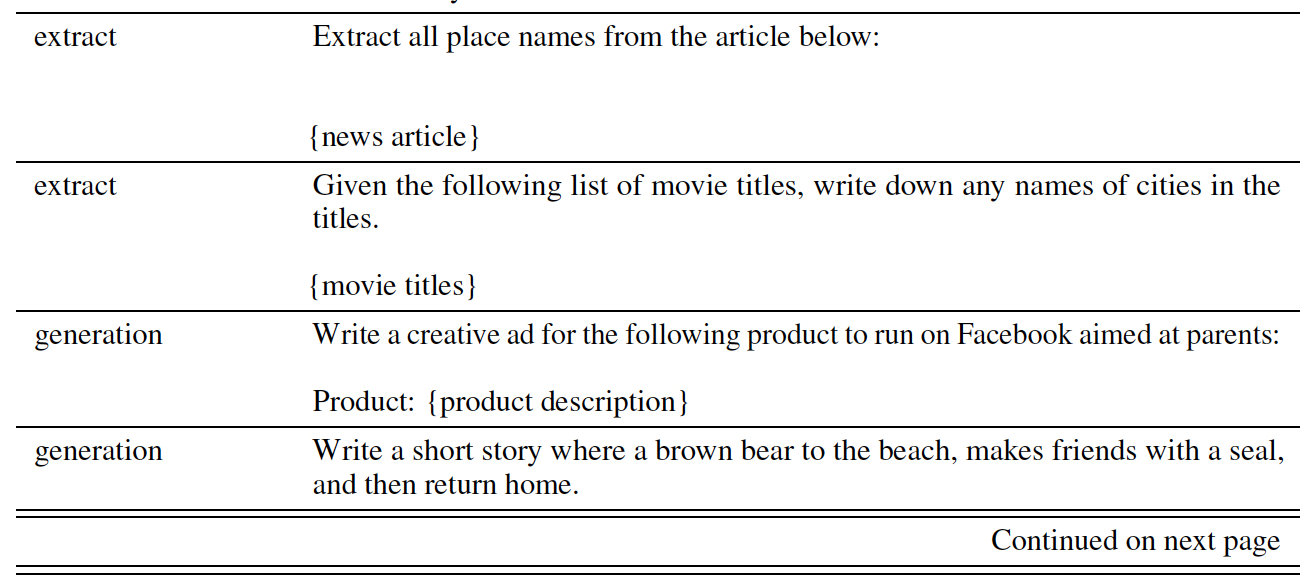

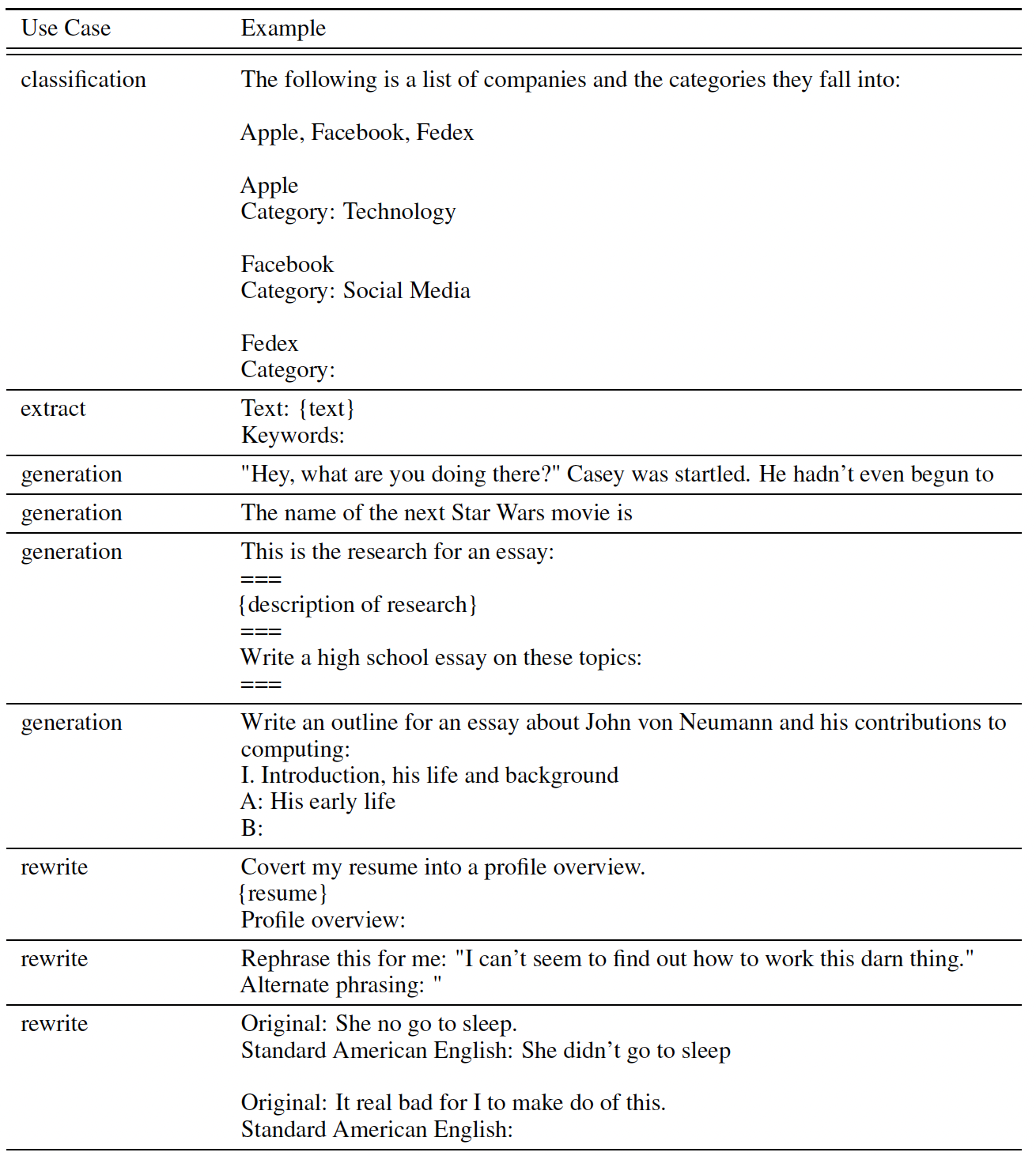

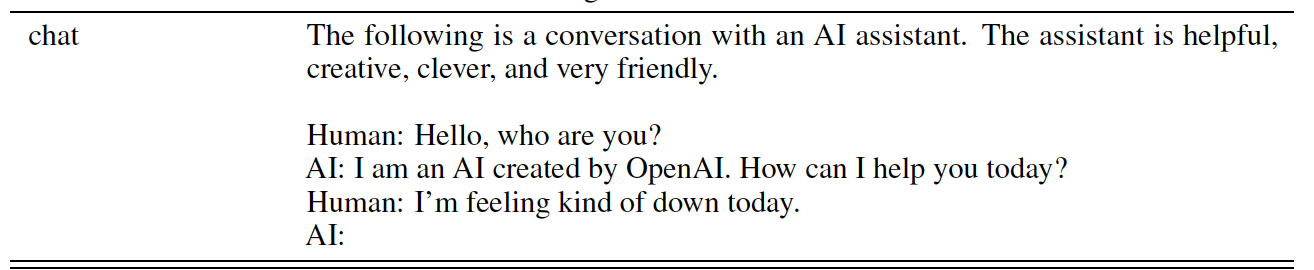

SOTA。预训练的语言模型通过使用大量的文本数据根据单词的上下文来预测该单词来学习contextualized text representation,并且可以进行微调从而适应下游的任务。不同的预测任务和训练目标已经被用于预训练不同类型的语言模型,如下表所示:

ELMo学习两个单向的语言模型:一个正向语言模型从左到右编码文本,一个反向的语言模型从右到左编码文本。GPT使用一个从左到右的transformer来word-by-word地预测文本序列。- 相比之下,

BERT采用了一个双向Transformer encoder来融合左右两侧的上下文从而预测masked word。虽然BERT极大地提高了各种自然语言理解natural language understanding: NLU任务的性能,但其双向性bidirectionality的特点使其难以应用于自然语言生成natural language generation: NLG任务。

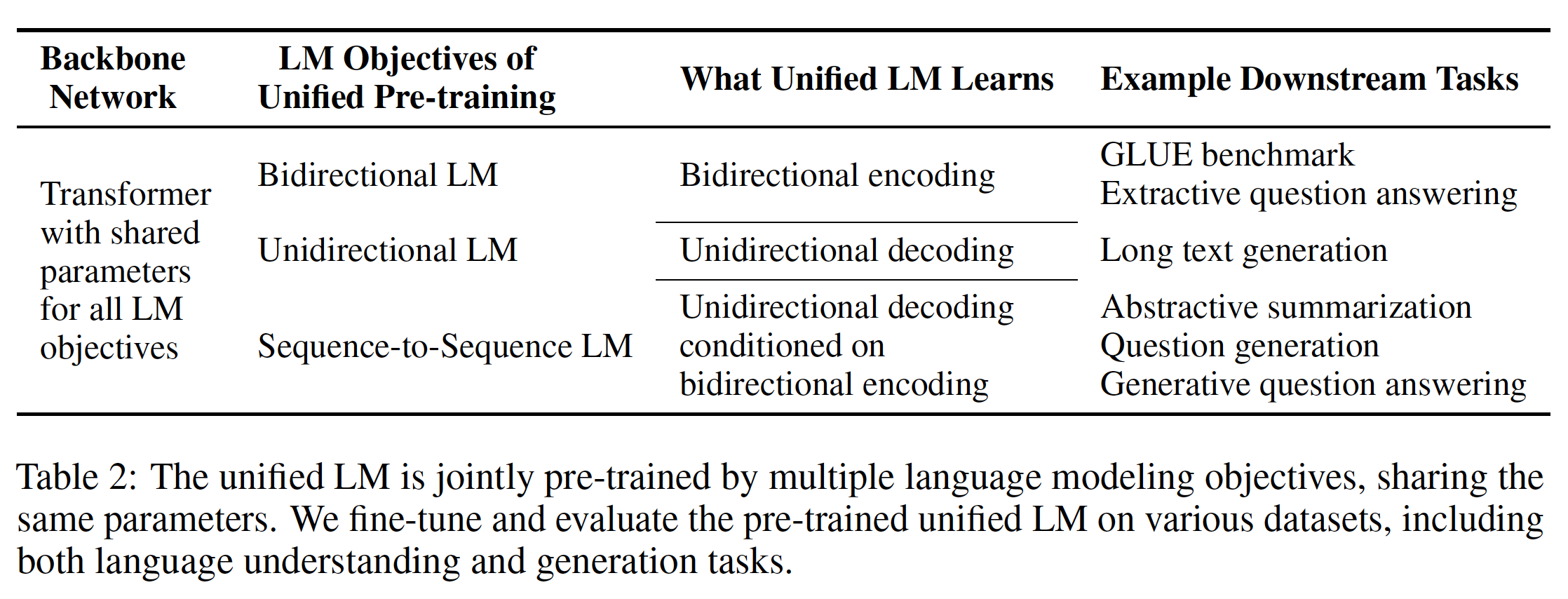

在论文

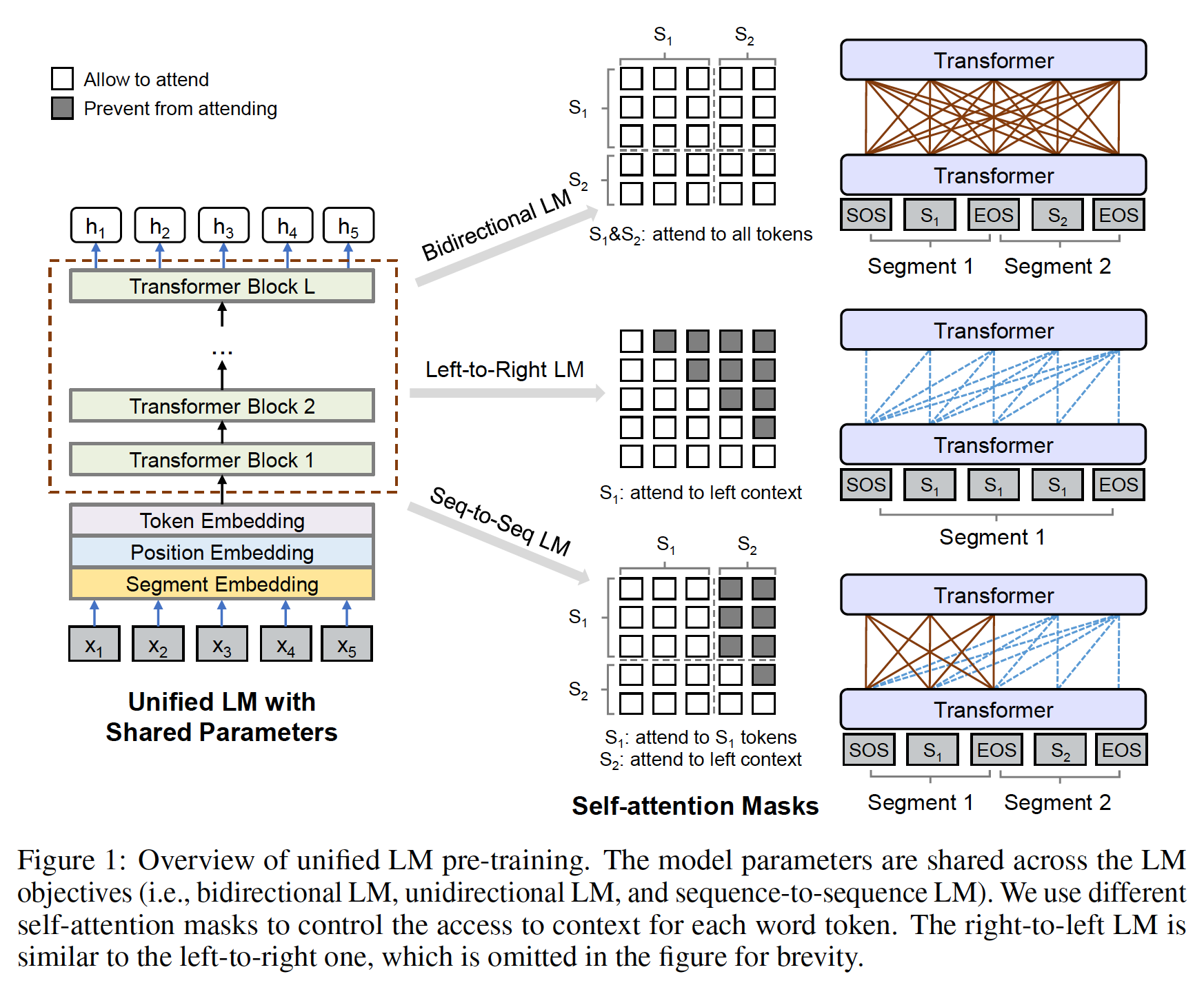

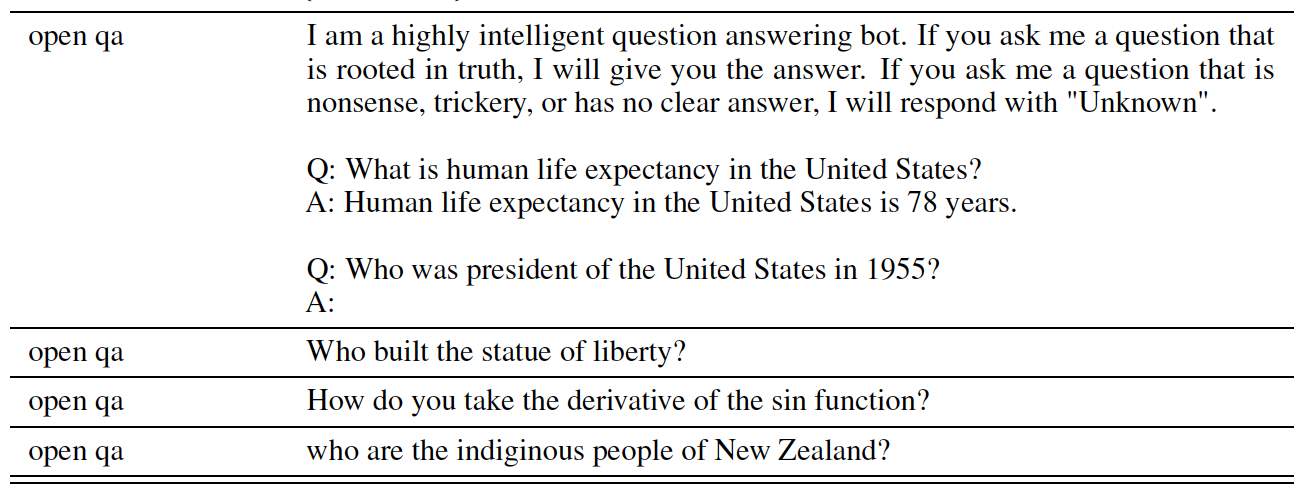

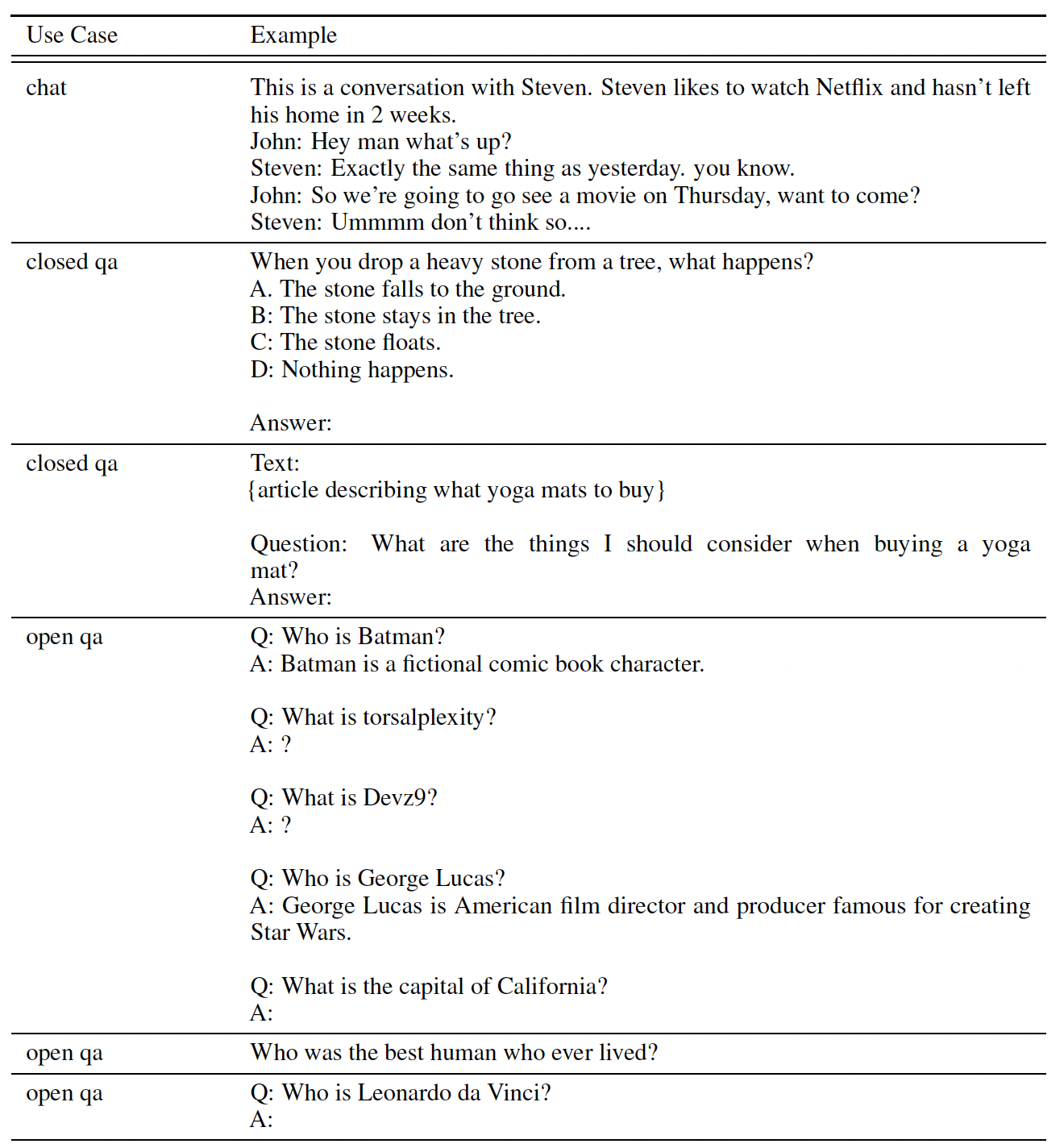

《Unified Language Model Pre-training for Natural Language Understanding and Generation》中,作者提出了一个新的UNIfied pre-trained Language Model: UNILM,可以应用于自然语言理解任务和自然语言生成任务。UNILM是一个多层的Transformer网络,在大量的文本上联合预训练,为三种类型的无监督语言建模目标进行了优化,如下表所示。具体而言,论文设计了一组完形填空任务cloze task,其中根据上下文预测一个masked word。这些完形填空任务的不同之处在于如何定义上下文:- 对于

left-to-right的单向语言模型,要预测的masked word的上下文包括其左边的所有单词。 - 对于

right-to-left的单向语言模型,要预测的masked word的上下文包括其右边的所有单词。 - 对于双向语言模型,要预测的

masked word的上下文由左右两侧的所有单词组成。 - 对于序列到序列的语言模型,第二个序列(即,

target序列)中要预测的单词的上下文由第一个序列(即,source序列)中的所有单词、以及target序列中被预测单词左边的所有单词组成。

这些不同的语言模型是通过

self-attention mask来实现的。

与

BERT类似,预训练的UNILM可以进行微调(必要时增加task-specific layer)以适配各种下游任务。但与主要用于自然语言理解任务的BERT不同,UNILM可以通过使用不同的自注意力掩码self-attention mask进行配置,为不同类型的语言模型聚合上下文,因此可以同时用于自然语言理解任务和自然语言生成任务。UNILM有三个主要优势:- 首先,统一的预训练程序导致了一个单一的

Transformer语言模型,它对不同类型语言模型采用共享的参数和架构,缓解了单独训练和host多个语言模型的需要。 - 第二,参数共享使学到的

text representation更加通用,因为它们是针对不同的语言建模目标共同优化的,其中上下文的利用方式不同从而缓解了对任何单个语言模型任务的过拟合。 - 第三,除了应用于自然语言理解任务外,

UNILM可以作为sequence-to-sequence的语言模型来使用,使其成为自然语言生成任务的自然选择,如抽象式摘要abstractive summarization和问题生成question generation。

实验结果表明,

UNILM作为一个双向编码器来使用,在GLUE benchmark和两个抽取式问答extractive question answering任务(即SQuAD 2.0和CoQA)上与BERT相比更有优势。此外,论文还证明了UNILM在五个自然语言生成数据集上的有效性,其中UNILM作为一个sequence-to-sequence的语言模型来使用, 在CNN/DailyMail和Gigaword的抽象式摘要、SQuAD问题生成、CoQA生成式问答enerative question answering、以及DSTC7对话式响应生成dialog response generation上创造了新的SOTA。

20.1 模型

给定一个输入序列

UNILM为每个token获得了一个contextualized vector representation。如下图所示, 预训练通过几个无监督的语言建模目标来优化共享的Transformer网络,即单向语言模型、双向语言模型、以及sequence-to-sequence语言模型。为了控制对将要预测的word token的上下文的访问,我们采用了不同的自注意力掩码。换句话说,我们使用掩码来控制token在计算其contextualized representation时应该注意多少上下文。一旦UNILM得到预训练,我们就可以利用下游任务的task-specific数据对其进行微调。

Input Representation:输入- 对于单向语言模型而言,

text segment。 - 对于双向语言模型和

sequence-to-sequence语言模型而言,segment pair。

我们总是在输入的开头添加一个特殊的

start-of-sequence token([SOS]),并在每个segment的结尾添加一个特殊的end-of-sequence token([EOS])。[EOS]不仅标志着自然语言理解任务中的句子边界,而且在自然语言生成任务中还用于模型学习何时终止解码过程。注意,这里的

[SOS]类似于BERT中的[CLS]。input representation遵从BERT:- 通过

WordPiece将文本tokenize为子词单元subword unit。 - 对于每个

input token,它的vector representation是由相应的token embedding、position embedding、以及segment embedding相加而计算出来的。

由于

UNILM是使用多个语言模型任务进行训练的,segment embedding也起到了语言模型id的作用,因为我们为不同的语言模型目标使用不同的segment embedding。对于单向语言模型,只有一个

segment,因此segment id都是1;对于双向语言模型和sequence-to-sequence语言模型,有两个segment,因此segment id是1和2。因此,根据segment id是几个,可以粗略地(而无法精确地)区分不同的语言模型。- 对于单向语言模型而言,

Backbone Network: Multi-Layer Transformer:input向量token embedding维度(也是position embedding、segment embedding的维度)。然后Transformer被编码到不同level的contextual representation:其中

Transformer的输出。在每个

Transformer Block中,多个self-attention head被用于聚合前一层的输出向量。对于第Transformer层,单个self-attention head其中:

query空间、key空间、value空间。self-attention head的维度。mask matrix(也叫做self-attention mask matrix),用于决定一对token之间是否可以相互关注attend。

我们使用不同的

mask matrixtoken可以关注的上下文从而计算该token的contextualized representation,如Figure 1所示。以双向的语言模型为例:mask matrix的元素都是0,表明所有的token都可以相互访问。预训练目标:我们使用四个完形填空任务来预训练

UNILM,这些完形填空任务为了不同语言建模目标而设计的。在完形填空任务中,我们在输入中随机选择一些WordPiece token,并用special token(即,[MASK])替换它们。然后,我们将Transformer网络计算出的、这些special token对应的输出向量馈入一个softmax分类器,以预测masked token。UNILM的参数被学习为:使predicted token和original token计算的交叉熵损失最小。值得注意的是,使用完形填空任务使得所有的语言模型都可以使用相同的训练程序,单向和双向的都一样。单向语言模型:我们同时使用

left-to-right语言模型目标、以及right-to-left语言模型目标。以

left-to-right语言模型为例。每个token的representation只编码左侧的context token和它自身。例如,为了预测 "masked token,只能使用token[MASK])。这是通过使用三角矩阵的self-attention maskself-attention mask的上三角部分被设置为Figure 1所示。类似地,

right-to-left语言模型以token的右侧上下文为条件来预测该token。双向语言模型:遵从

BERT,双向语言模型允许所有token在预测中相互关注。双向语言模型对来自两个方向的上下文信息进行编码,并能产生比单向语言模型更好的contextual representation。在双向语言模型中,self-attention masktoken。Sequence-to-Sequence语言模型: 如图Figure 1所示,对于预测来说:- 第一个

segment(即,source segment)的token可以从source segment内的两个方向相互关注。 - 而第二个

segment(即,target segment)的token只能关注target segment内的左侧上下文及其自身,以及source segment内的所有token。

例如,给定

source segmenttarget segmentinput"token(即,"token(即,"Figure 1显示了用于Sequence-to-Sequence语言模型目标的self-attention masktoken都能访问到第一个segment。source segment关注到target segment。- 此外,对于

target segment中的token关注到它们未来的位置(即,右侧)。

在训练过程中,我们同时在两个

segment中随机选择token,并用special token(即,[MASK])来替换它们。该模型被学习从而恢复masked token。由于source text和target text的pair对在训练中被打包成一个连续的输入文本序列,我们隐式地鼓励模型学习这两个segment之间的关系。为了更好地预测target segment中的token,UNILM学习有效地编码source segment。因此,针对Sequence-to-Sequence语言模型设计的完形填空任务(也被称为encoder-decoder模型),同时预训练了一个双向编码器和一个单向解码器。预训练的模型作为encoder-decoder模型,可以很容易地适用于广泛的条件文本生成conditional text generation任务,如抽象式摘要abstractive summarization。这里的 “

Sequence-to-Sequence语言模型”其实同时混合了双向语言模型(当[MASK]位于source segment)和Sequence-to-Sequence模型(当[MASK]位于target segment)。此外,这里的

decoder仅解码[MASK]对应的token,因此是一个incomplete的解码过程。此外,这里的

encoder-decoder架构与传统的架构不同,这里decoder可以直接访问encoder的所有位置。而传统的架构中,decoder仅能访问单个encoder representation,这个encoder representation聚合了所有encoder input信息。- 第一个

Next Sentence Prediction:遵从BERT,对于双向语言模型,在预训练中我们也包括next sentence prediction任务。

预训练配置:整体预训练目标是上述不同类型的语言模型的目标之和。具体而言,在一个

training batch中,包含:1/3的双向语言模型目标、1/3的Sequence-to-Sequence语言模型目标、1/6的left-to-right语言模型目标、1/6的right-to-left语言模型目标。UNILM的模型结构遵循BERT_LARGE的结构,以便进行公平的比较。遵从GPT,UNILM采用gelu激活函数。具体而言,我们使用一个24层的Transformer,隐层维度1024、注意力头16个,共包含大约340M的参数。softmax分类器的权重矩阵与token embedding绑定(即,二者共享相同的参数矩阵)。UNILM由BERT_LARGE初始化,然后使用English Wikipedia和BookCorpus进行预训练,这两个数据集的处理方式与BERT相同。词表vocabulary规模为28996。输入序列的最大长度为512。token masking的概率为15%。在masked position中,80%的时间我们用[MASK]来替代被选中的token,10%的时间用random token来替代,其余的10%时间保持original token。此外,80%的时间我们每次随机掩码一个token,20%的时间我们随机掩码一个bigram或一个trigram。我们使用

Adam优化器。学习率为3e-5,其中在最初的40K步中进行线性预热然后进行线性衰减。dropout-rate = 0.1,weight-decay = 0.01,batch-size = 330。预训练程序运行了大约770K步。使用8块Nvidia Telsa V100 32GB GPU card进行混合精度训练,每10K步需要约7小时。用

BERT_LARGE初始化之后还预训练了770K步,那初始化的意义和影响是什么?通常,用预训练好的模型作为初始化之后,只需要训练少量的step就能达到比较好的效果。从工程落地上来讲,用

BERT_LARGE来初始化有利于更快地收敛从而降低训练成本;从实验上来讲,最好是从头开始训练从而进行公平地比较。下游自然语言理解任务和自然语言生成任务的微调:

对于自然语言理解任务,我们将

UNILM作为一个双向Transformer encoder来微调,就像BERT。以文本分类任务为例。我们使用

[SOS]的encoding vector作为input representation,记做softmax分类器(即task-specific输出层),其中类别概率计算为:softmax分类器的参数,从而最大化labeled training data的似然likelihood。对于自然语言生成任务,我们以

sequence-to-sequence任务为例。微调过程类似于使用self-attention mask的预训练。令source sequence和target sequence。我们通过special token将它们打包在一起,形成输入 "target序列中一定比例的token来进行微调,并学习恢复masked word。训练目标是在给定上下文的情况下,最大化masked token的似然likelihood。值得注意的是,标识着

target序列结束的[EOS] token在微调过程中也可能被掩码,因此当这种情况发生时,模型会学习何时发出[EOS] token从而终止target序列的生成过程。UNILM在自然语言生成任务上的微调与常规的sequence-to-sequence模型不同。常规的sequence-to-sequence模型会依次生成target sequence(包括[EOS] token)。而这里的UNILM采用它预训练时的方式,仅掩码target sequence并且仅仅预测masked token(而不是序列生成)。常规的

sequence-to-sequence更符合实际,因为在实际应用中,我们通常只有source sequence而没有target sequence。而UNILM不仅需要知道source sequence、还需要知道部分的target sequence信息(从而预测被masked的部分)。

20.2 实验

- 我们对自然语言理解任务(即

GLUE benchmark,以及抽取式问答extractive question answering)和自然语言生成任务(即抽象式摘要abstractive summarization、问题生成、生成式问答、以及对话响应生成dialog response generation)都进行了实验。

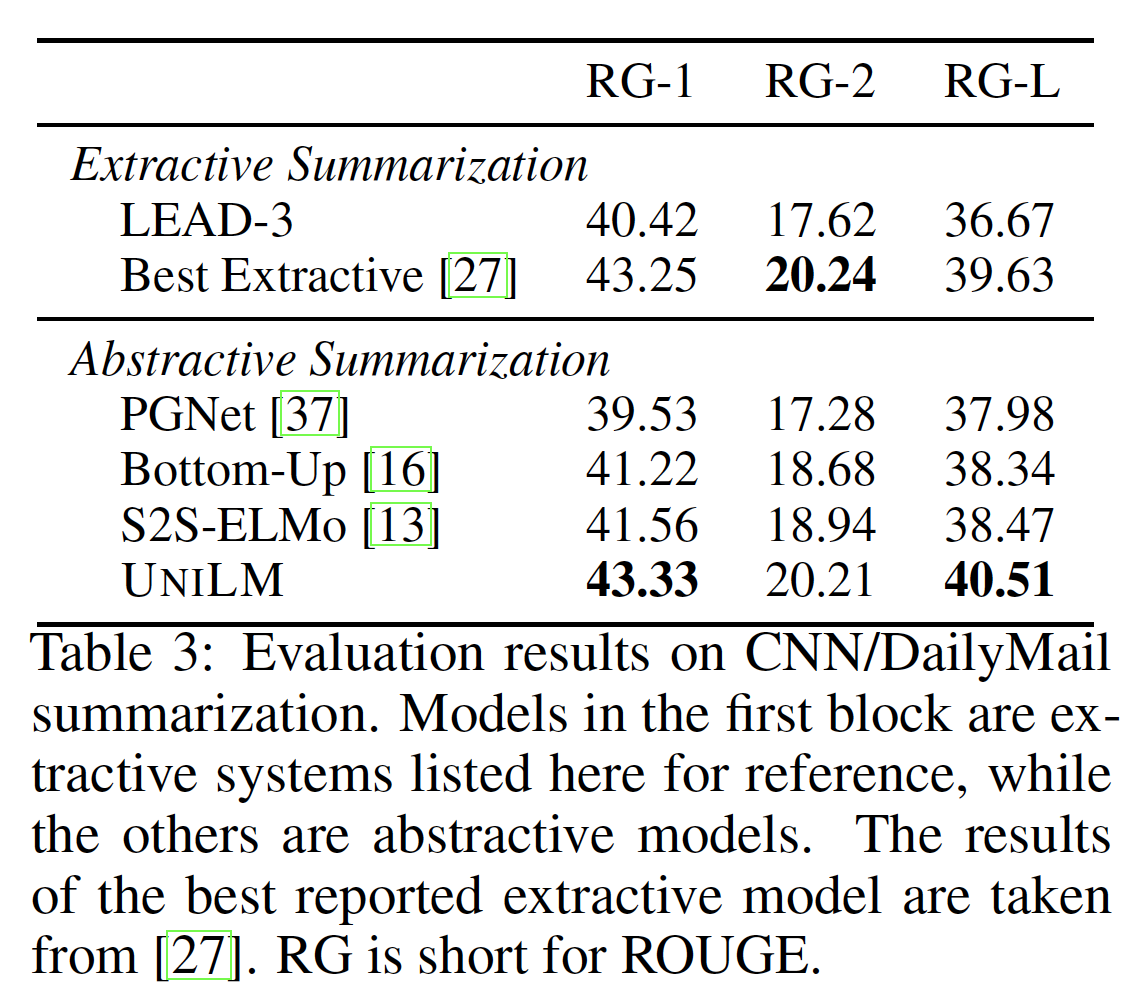

20.2.1 抽象式摘要

自动文本摘要

automatic text summarization能产生一个简明流畅的summary,传达input(如,一篇新闻文章)的关键信息。我们聚焦于抽象式摘要,这是一项生成任务,其中summary不必使用输入文本中的短语或句子。我们使用CNN/DailyMail数据集的非匿名版本、以及Gigaword来用于模型微调和评估。我们按照前面描述的程序将UNILM作为一个sequence-to-sequence模型进行微调,将文档(第一个segment)和summary(第二个segment)拼接起来作为输入,并根据预定义的最大序列长度进行截断。我们在训练集上对我们的模型微调了

30个epoch。我们复用预训练中的大多数超参数。掩码概率为0.7。我们还使用平滑率为0.1的标签平滑label smoothing。- 对于

CNN/DailyMail,我们设置batch size = 32,最大序列长度为768。 - 对于

Gigaword,我们设置batch size = 64,最大序列长度为256。

在解码过程中,我们使用

beam size = 5的beam search。对于CNN/DailyMail和Gigaword来说,input document被截断为前640个token和后192个token。我们在beam search中删除了重复的trigram,并在验证集上调整了maximum summary length。- 对于

我们使用

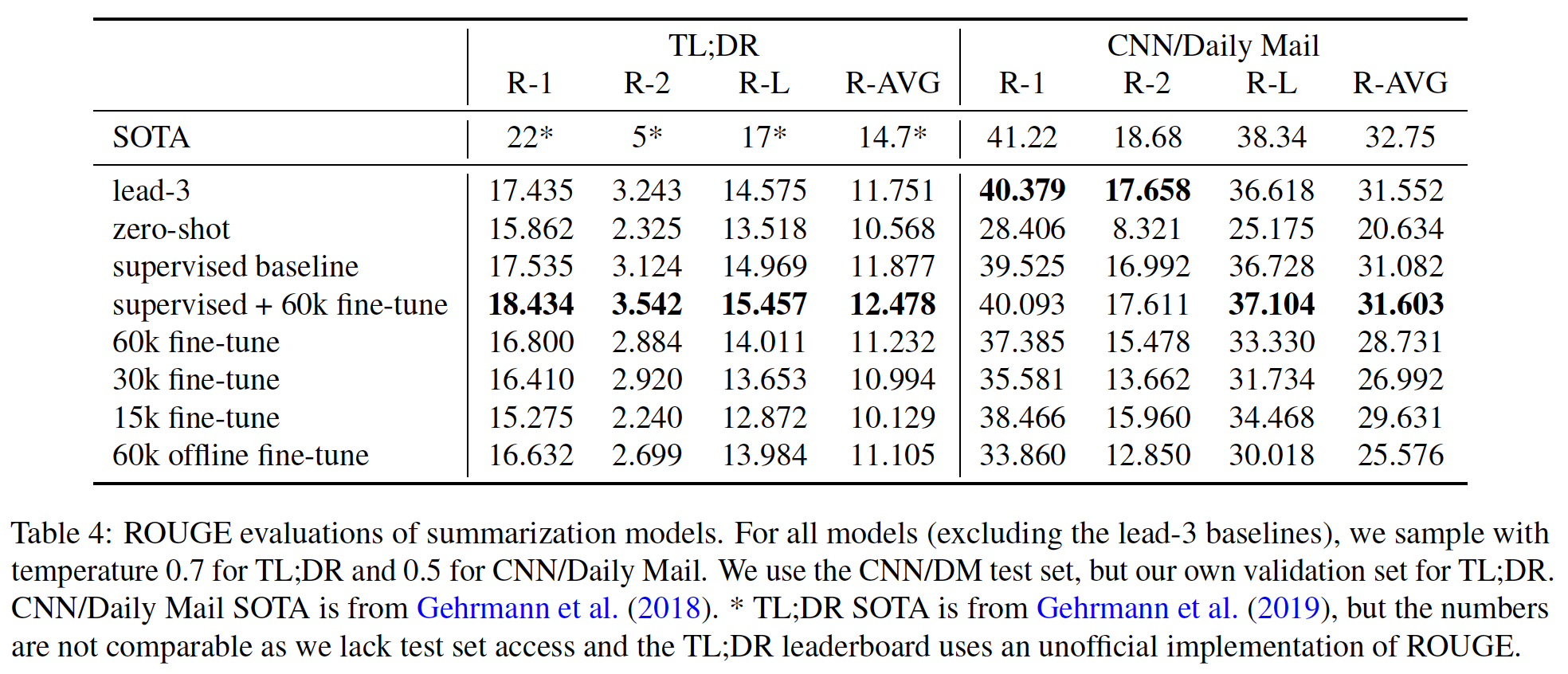

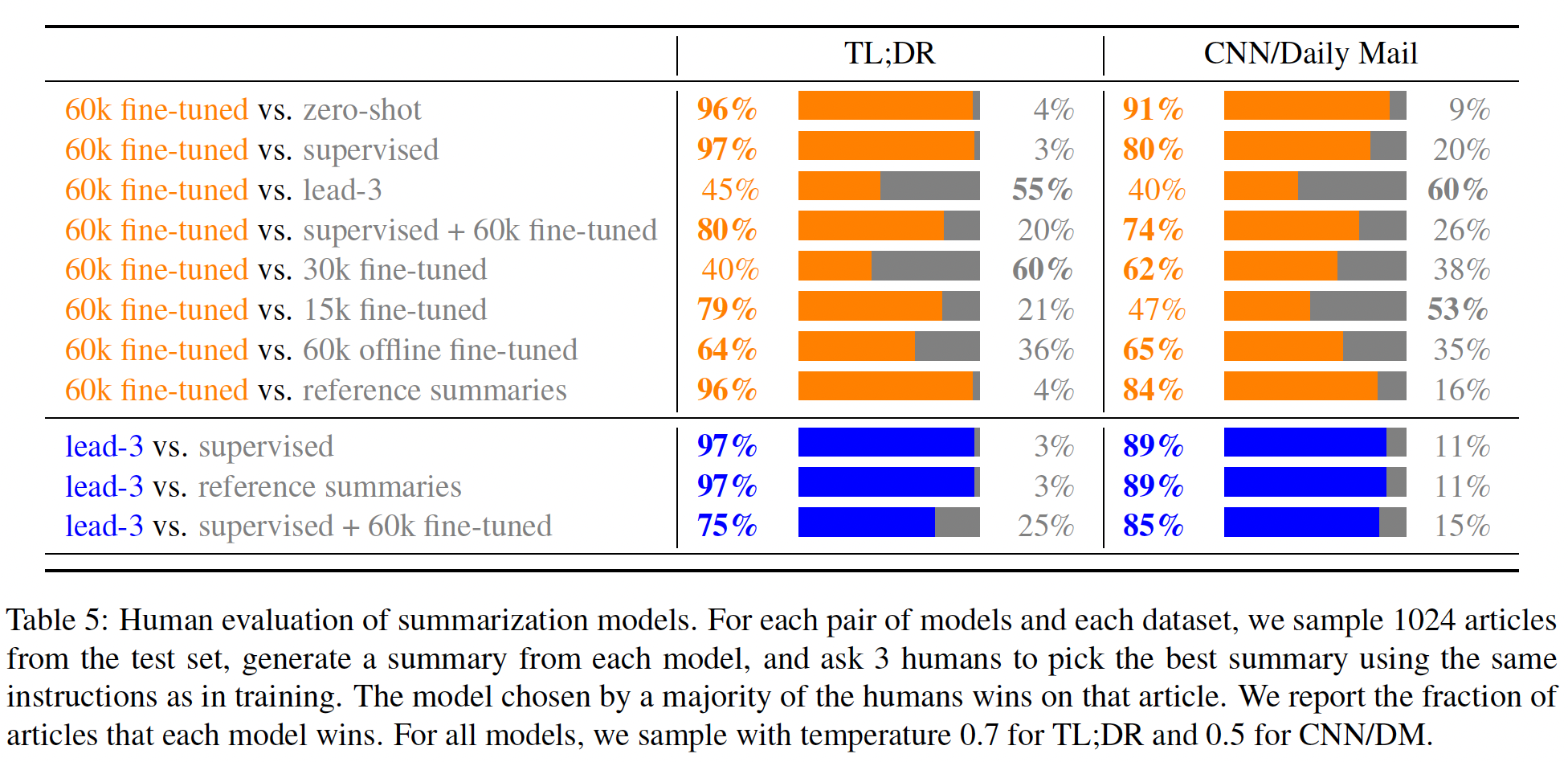

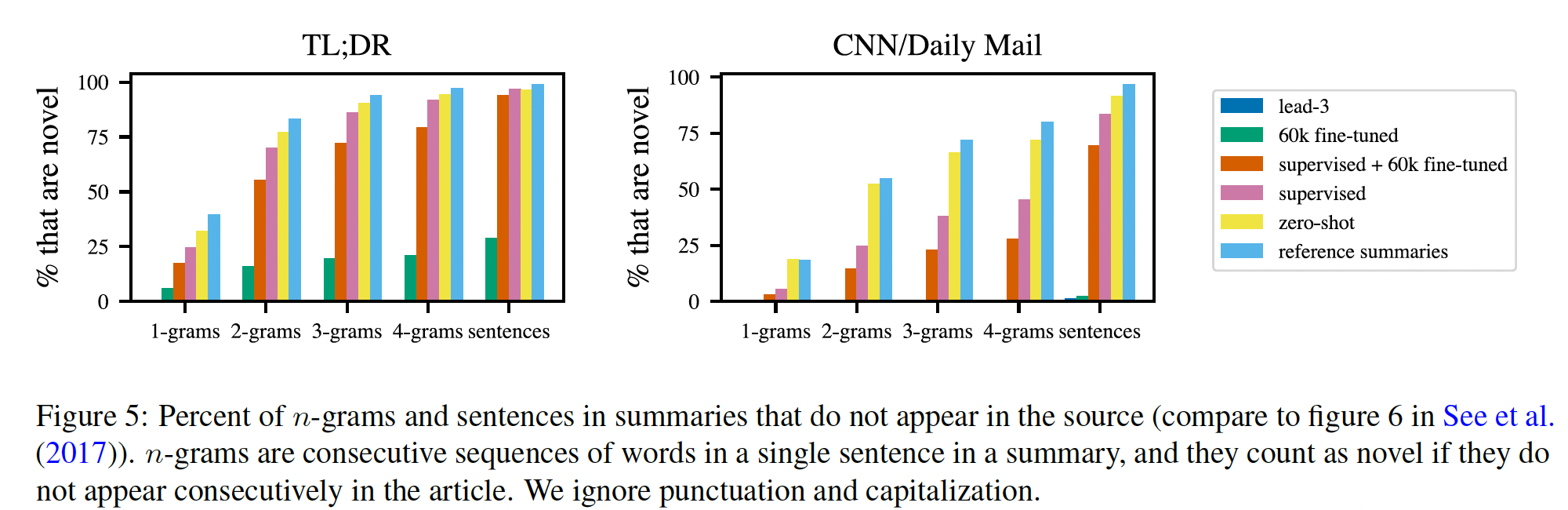

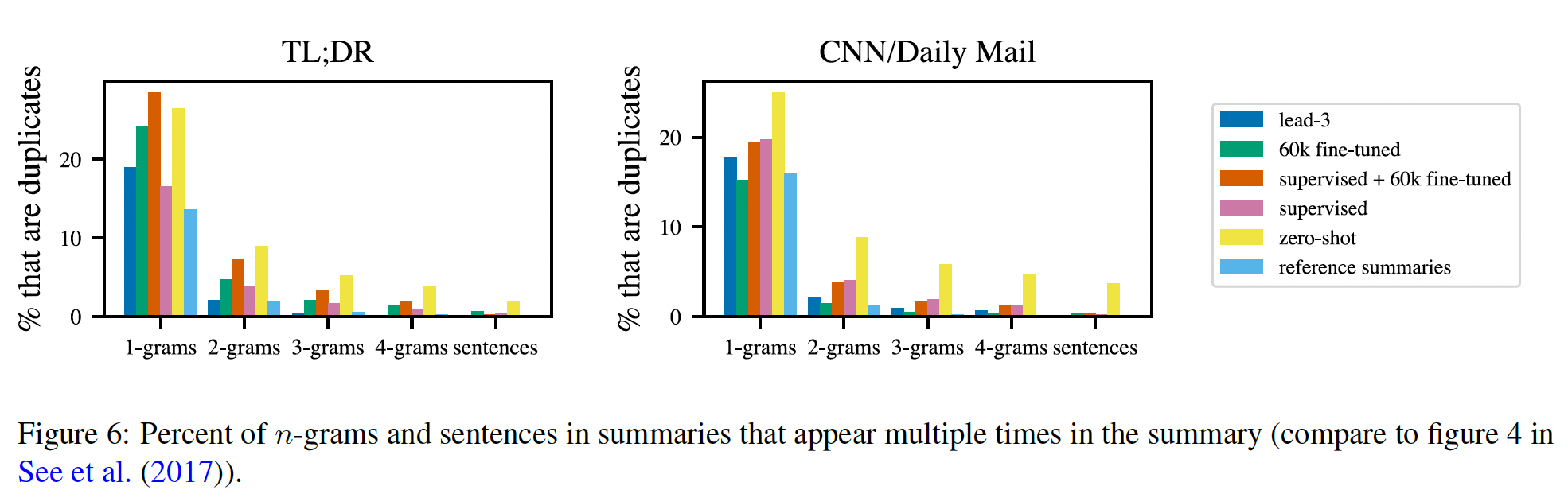

F1版本的ROUGE作为两个数据集的评估指标。在下表中,在CNN/DailyMail数据集上,我们将UNILM与baseline以及几个SOTA模型进行比较:LEAD-3是一个baseline模型,它抽取文档中的前三句话作为其摘要。PGNet是一个基于pointer-generator network的sequence-to-sequence模型。S2S-ELMo使用一个sequence-to-sequence模型,用预训练好的ELMo representation进行增强,被称为SRC-ELMO+SHDEMB。Bottom-Up是一个sequence-to-sequence模型,用一个bottom-up content selector来选择突出的短语。

我们还在下表中列出了数据集上最好的抽取式摘要结果。如下表所示,我们的模型优于以前所有的抽象式系统

abstractive system,在数据集上创造了一个新的SOTA的抽象式结果。在ROUGE-L中,我们的模型也比最好的抽取式模型高出0.88分。

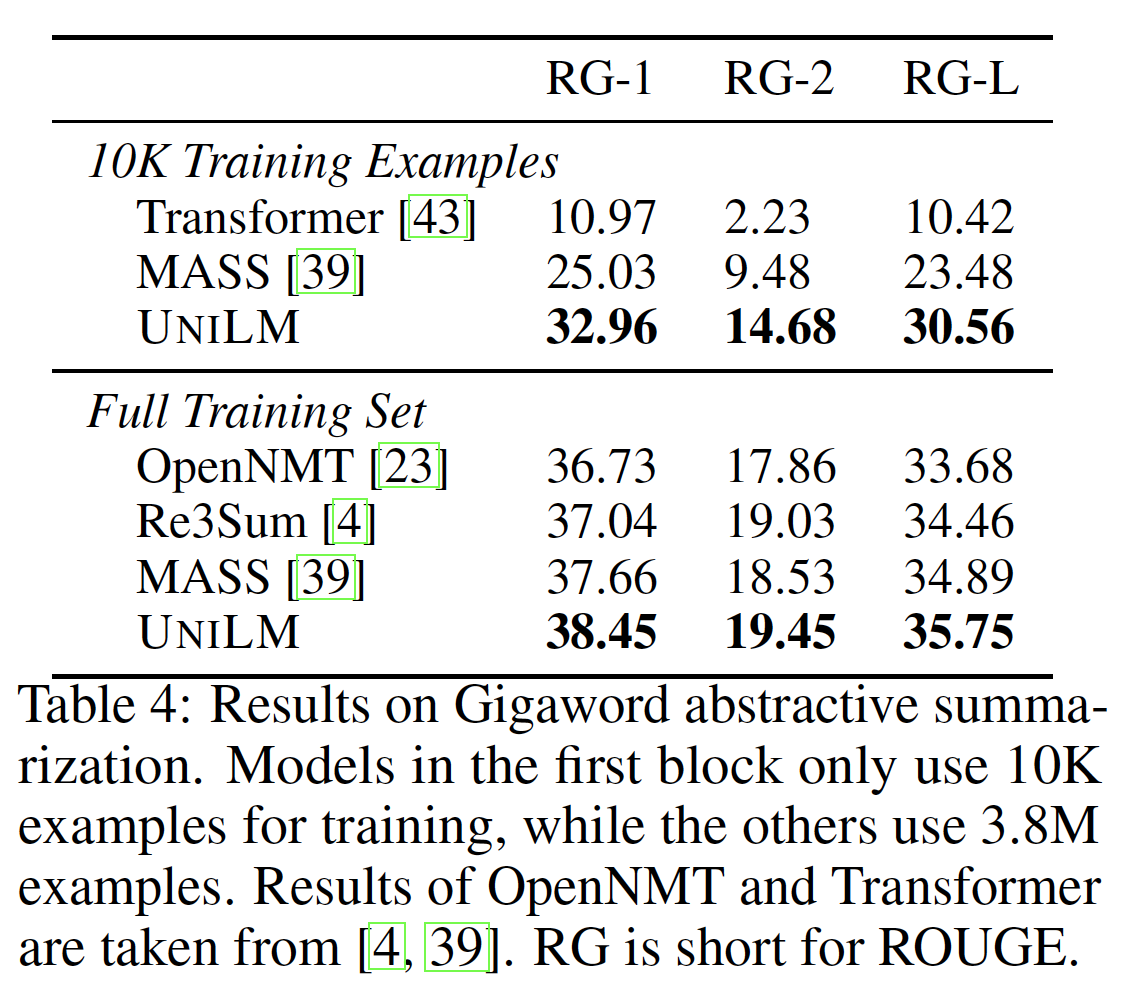

在下表中,我们对模型在不同规模(

10K和3.8M)的Gigaword上进行了评估。Transforme和OpenNMT都实现了标准的attentional sequence-to-sequence模型。Re3Sum检索摘要作为候选模板,然后使用一个扩展的sequence-to-sequence模型来生成摘要。MASS是一个基于Transformer网络的预训练的sequence-to-sequence模型。

实验结果表明:

UNILM取得了比以往工作更好的性能。此外,在低资源环境下(即只使用10K个样本作为训练数据),我们的模型在ROUGE-L中比MASS高出7.08分。

20.2.2 问答

Question Answering: QA任务是在给定一个段落的条件下回答一个问题。有两种setting:- 第一种被称为抽取式问答

extractive QA,答案被假定为段落中的一个text span。 - 另一种被称为生成式问答

generative QA,答案需要即时生成。

- 第一种被称为抽取式问答

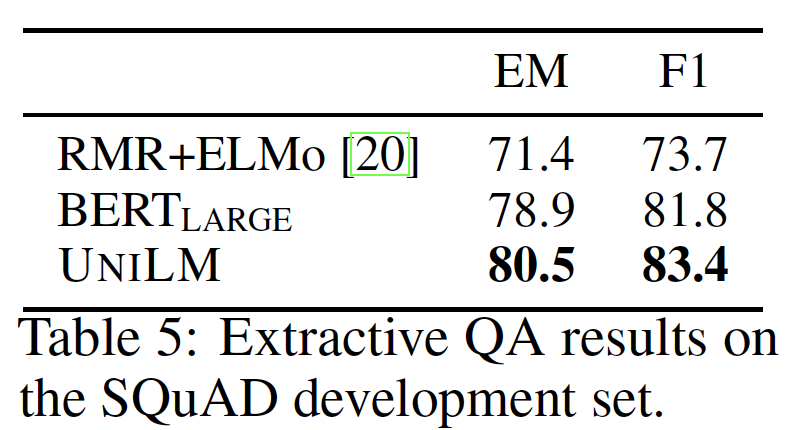

抽取式问答:这项任务可以被表述为自然语言理解任务,我们需要预测答案在段落中的开始位置和结束位置。我们对预训练的

UNILM进行微调,将UNILM作为双向编码器从而用于抽取式问答。我们在Stanford Question Answering Dataset: SQuAD的2.0版本、以及Conversational Question Answering: CoQA数据集上进行了实验。在

SQuAD 2.0上的结果如下表所示,我们比较了两个模型的精确匹配Exact Match: EM分和F1分。RMR+ELMo是一个基于LSTM的问答模型,用预训练好的language representation来增强。BERT_LARGE是一个cased模型(即,字母保持大小写),在SQuAD训练数据上微调了3个epoch,batch size = 24,最大序列长度为384。UNILM以与BERT_LARGE相同的方式进行微调。

我们看到

UNILM的表现优于BERT_LARGE。

CoQA是一个对话式问答conversational question answering数据集。与SQuAD相比,CoQA有几个独有的特点:- 首先,

CoQA中的样本是对话式的,所以我们需要根据对话历史来回答input question。 - 其次,

CoQA中的答案可以是自由格式的文本,包括很大一部分是"yes/no"的答案。

我们对用于

SQuAD的模型做了如下修改:首先,除了被问的问题,我们将

question-answer的历史拼接到第一个segment,这样模型就可以捕获到对话信息。其次,对于

"yes/no"问题,我们使用[SOS] token的final hidden vector来预测input question是否是一个"yes/no"问题,以及答案为"yes/no"。对于非

"yes/no"问题 ,我们选择一个F1分数最高的passage subspan用于训练。

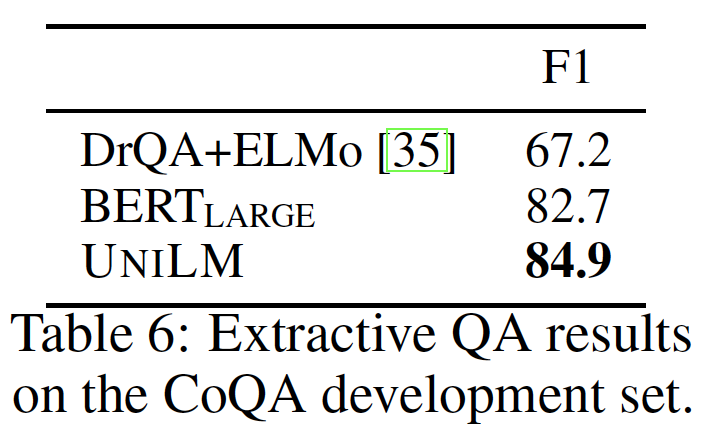

CoQA的实验结果如下表所示。我们比较了两个模型的F1分:DrQA+ELMo是一个基于LSTM的问答模型,用预训练好的ELMo representation来增强。BERT_LARGE是一个cased模型(即,字母保持大小写),在CoQA训练数据上微调了2个epoch,batch size = 16,最大序列长度为512。UNILM以与BERT_LARGE相同的方式进行微调。

我们看到

UNILM的表现优于BERT_LARGE。

- 首先,

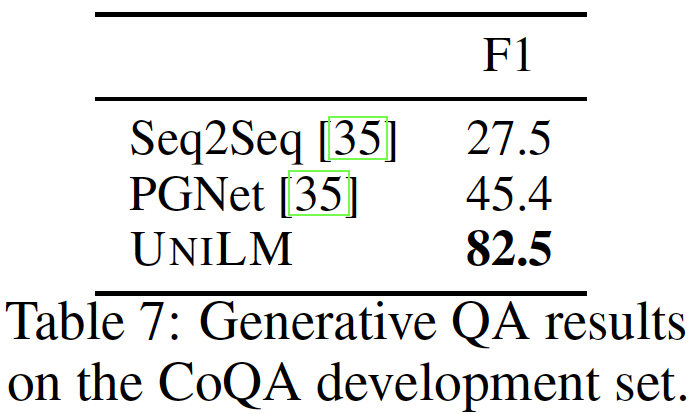

生成式问答:生成式问答为

input question和段落生成自由形式的答案,这是一个自然语言生成任务。相比之下,抽取式问答只能预测input passage的subspan作为答案。在CoQA数据集上(如前所述),《CoQA: A conversational question answering challenge》表明:普通的sequence-to-sequence模型的性能仍然远远低于抽取式方法。我们为生成式问答来适配

UNILM,从而将UNILM作为一个sequence-to-sequence模型。第一个segment(即input sequence)是对话历史、input question、以及段落的拼接。第二个segment(即,output sequence)是答案。我们在CoQA训练集上对预训练的UNILM微调了10个epoch。我们设置batch size = 32,掩码率为0.5,最大序列长度为512。我们还使用平滑率为0.1的标签平滑。其他超参数与预训练保持一致。在解码过程中,我们使用

beam size = 3的beam search,input question和段落的最大长度为470。对于超过最大长度的段落,我们用滑动窗口的方法将段落分成若干块,并选择一个与question具有最高word overlap的块。我们将我们的方法与生成式问答模型

Seq2Seq和PGNet进行了比较:Seq2Seq baseline是一个带有注意力机制的sequence-to-sequence模型。PGNet模型用一个copy机制增强了Seq2Seq。

如下表所示,我们的生成式问答模型在大大超过了以前的生成式方法,这极大地缩小了生成式方法和抽取式方法之间的差距。

20.2.3 问题生成

我们对

answer-aware的问题生成question generation任务进行了实验。给定一个input passage和一个answer span,我们的目标是生成一个针对答案的问题。SQuAD 1.1数据集被用于评估。遵从《Learning to ask: Neural question generation for reading comprehension》,我们将原始训练集拆分为训练集和测试集,并保留原始验证集。我们还遵从《Paragraph-level neural question generation with maxout pointer and gated self-attention networks》中的数据拆分方式进行实验,即,使用反向的dev-test拆分。问题生成任务被表述为一个

sequence-to-sequence问题。第一个segment是input passage和答案的拼接,而第二个segment是被生成的问题。我们在训练集上对

UNILM微调了10个epoch。我们设置batch size = 32,掩码率为0.7,学习率为2e-5。我们采用平滑率为0.1的标签平滑。其他超参数与预训练相同。在解码过程中,我们将输入截断为

464个token并选择包含答案的passage块。评估指标BLEU-4, METEOR, ROUGE-L的计算方法与《Learning to ask: Neural question generation for reading comprehension》中的脚本相同。结果如下表所示。

CorefNQG是基于一个带有注意力的sequence-to-sequence模型、以及一个特征丰富的编码器。MP-GSN使用了一个带门控自注意力编码器的attention-based sequence-to-sequence model。SemQG使用两个语义增强的奖励semantics-enhanced reward来正则化generation。

UNILM的性能优于以前的模型,并针对问题生成任务达到了新的SOTA。

生成的问题来改善

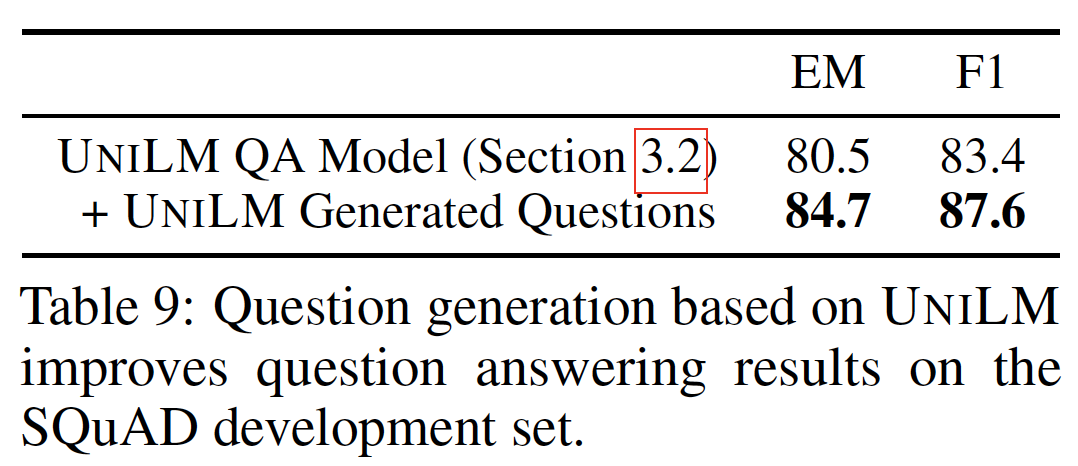

QA:问题生成模型可以从文本语料库中自动收集大量的question-passage-answer的样本。我们表明,由问题生成模型产生的augmented data可以改善问答模型。我们生成了

5M个可回答的样本,并通过修改可回答的样本生成了4M万个不可回答的样本。我们在生成的数据上对我们的问题回答模型微调一个epoch。然后在SQuAD 2.0的数据上再微调两个epoch。生成的

augmented data并不是和下游任务的数据混合,而是进行stack-style的微调。因此,augmented data微调的模型仅用于初始化。下游任务的目标数据才是作为最终的微调,使得与测试集的数据分布保持一致。如下表所示,由

UNILM生成的augmented data改善了问答模型。请注意,在微调过程中,我们对生成的数据集和

SQuAD 2.0数据集都使用了双向masked language modeling: MLM作为辅助任务(MLM原本用于预训练阶段)。与直接使用自动生成的样本相比,双向MLM带来了2.3个点的绝对改进。一个可能的原因是,当在augmented data上进行微调时,辅助任务缓解了灾难遗忘catastrophic forgetting。这个

2.3的绝对改进并没有在下表中展示。

20.2.4 响应生成

我们在以文档为基础的

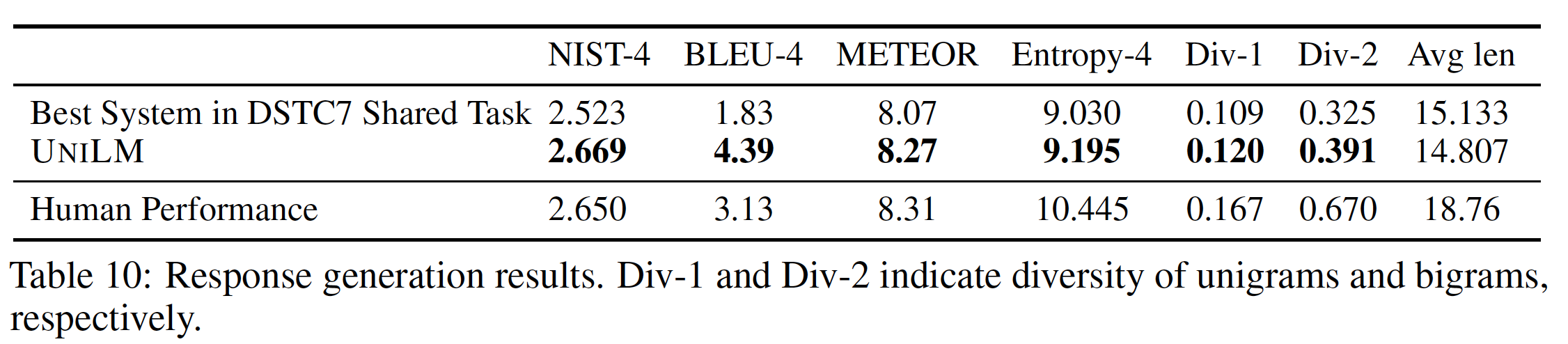

dialog response generation任务上评估UNILM。给定一个多轮对话历史、以及一个网络文档web document作为知识源,系统需要生成一个既适合对话、又反映网络文档内容的自然语言响应。我们微调UNILM来完成这个任务,其中UNILM作为一个sequence-to-sequence模型。第一个segment(input sequence)是web document和对话历史的拼接。第二个segment(output sequence)是响应。我们在

DSTC7的训练数据上对UNILM微调了20个epoch,batch size = 64。掩码率为0.5。最大序列长度为512。在解码过程中,我们使用beam size = 10的beam search。产生的响应的最大序列长度被设置为40。如下表所示,在

DSTC7共享任务中,UNILM在所有评估指标上都超过了最好的系统。

20.2.5 GLUE Benchmark

我们在

GLUE benchmark上评估UNILM。GLUE是九个语言理解任务的集合,包括问答、语言可接受性linguistic acceptability、情感分析、文本相似性、转述检测paraphrase detection、以及自然语言推理natural language inference : NLI。我们的模型作为一个双向语言模型被微调。我们使用

Adamax优化器,学习率为5e-5,batch size = 32。最大epoch数被设为5。使用一个带预热(预热比例0.1)的线性学习率衰减的学习率调度。每个任务的last linear projection的dropout-rate = 0.1,除了MNLI的0.3、CoLA/SST-2的0.05。为了避免梯度爆炸问题,梯度范数被剪裁在1.0以内。我们截断token使得输入序列长度不超过512。下表列出了从

benchmark evaluation server获得的GLUE测试结果。结果显示,在GLUE任务中,UNILM与BERT_LARGE相比获得了相差无几的性能。

20.2.6 未来工作

UNILM可以从以下几个方面继续改善:- 我们将通过在

web-scale的文本语料库上训练更多的epoch和更大的模型来推动当前方法的极限。同时,我们还将在下游应用上进行更多的实验以及消融实验,从而研究模型能力以及采用相同网络来预训练多种语言建模任务的好处。 - 在我们目前的实验中,我们聚焦于单语

NLP任务。我们还对扩展UNILM从而支持跨语言的任务感兴趣。 - 我们将对自然语言理解和自然语言生成任务进行多任务微调,这是

Multi-Task Deep Neural Network: MT-DNN的自然延伸。

- 我们将通过在

二十一、MASS [2019]

预训练和微调被广泛使用,当目标任务的训练数据资源较少或为零而预训练有大量的数据时。例如,在计算机视觉中,模型通常在大规模的

ImageNet数据集上进行预训练,然后在下游任务(如目标检测任务、图像分割任务)上进行微调。最近,ELMo、OpenAI GPT、以及BERT等预训练方法在自然语言处理中引起了很多关注,并在多种语言理解任务中取得了SOTA的准确性,如情感分类、自然语言推理、命名实体识别、以及SQuAD问答,这些任务通常只有有限的监督数据。在上述预训练方法中,BERT是最卓越的一种,它通过masked language modeling和next sentence prediction,在大型单语语料库上预训练bidirectional encoder representation。与语言理解不同,语言生成的目的是在某些输入的条件下生成自然语言句子,包括神经机器翻译

neural machine translation : NMT、文本摘要text summarization、以及对话式响应生成conversational response generation等任务。语言生成任务通常对数据要求很高,许多任务在训练数据方面是低资源low-resource甚至是零资源zero-source的。在这些自然语言生成任务上直接应用BERT-like的预训练方法是不可行的,因为BERT是为语言理解设计的,其中这些任务通常只由一个encoder或decoder处理。因此,如何为语言生成任务(通常采用基于encoder-decoder的序列学习框架)设计预训练方法,具有很大的潜力和重要性。在论文

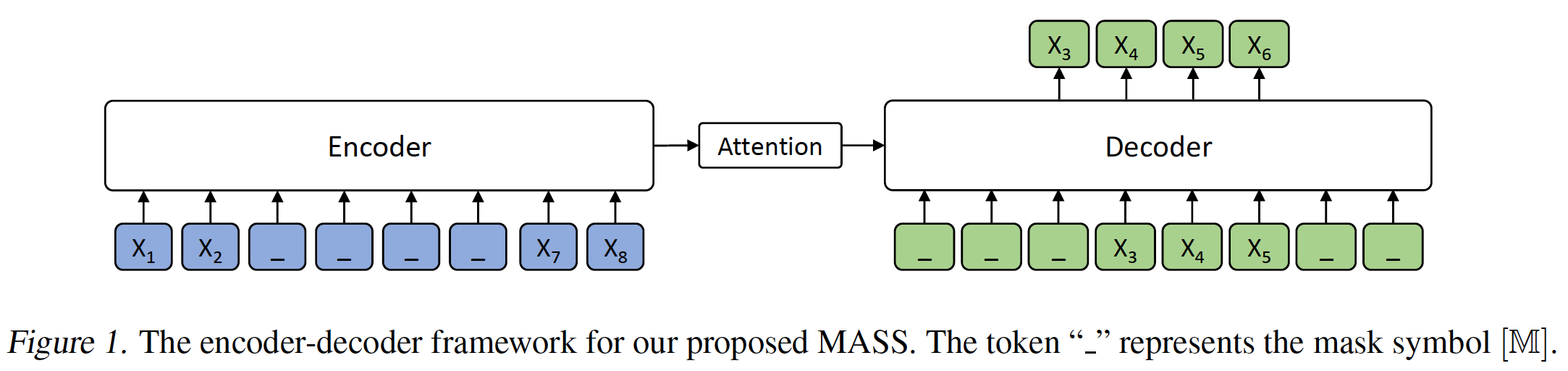

《MASS: Masked Sequence to Sequence Pre-training for Language Generation》中,受BERT的启发,作者提出了一个新颖的预训练目标:MAsked Sequence to Sequence learning : MASS用于语言生成。MASS是基于sequence to sequence的学习框架:它的encoder将带有一个masked fragment(几个连续的token)的一个句子作为输入,而它的decoder则根据encoder representation来预测这个masked fragment。与BERT或仅对encoder/decoder进行预训练的语言模型不同,MASS经过精心设计,分两步对encoder和decoder进行联合预训练:- 通过预测

encoder side的masked fragment,MASS可以迫使encoder理解unmasked token的含义,从而在decoder side预测masked token。 - 通过掩码

decoder的input tokens,其中这些masked input tokens在encoder side没有被掩码,MASS可以迫使decoder更多地依赖于source representation(即,encoder representation)而不是decoder side的previous tokens,从而用于next token prediction。这可以更好地促进encoder和decoder的联合训练。

MASS只需要预训练一个模型,然后在各种下游任务中进行微调。论文使用transformer作为基础的sequence to sequence模型,并且在WMT单语语料库上进行预训练,然后在三种不同的语言生成任务上进行微调,包括神经机器翻译、文本摘要、以及对话式响应生成。考虑到下游任务涵盖了像神经机器翻译这样的跨语言任务,论文在多种语言上预训练一个模型。论文为所有三个任务探索了low-resource setting,也考虑了无监督的神经机器翻译(这是一个纯粹的zero-resource setting)。- 对于神经机器翻译,论文在

WMT14 English-French、WMT16 English-German、以及WMT16 English-Romanian数据集上进行了实验。 - 对于无监督的神经机器翻译,论文直接在单语数据上用

back-translation loss微调预训练的模型,而不是像《Phrase-based & neural unsupervised machine translation》那样使用额外的降噪自编码器损失。 - 对于低资源的神经机器翻译,论文在有限的双语数据上微调预训练的模型。

- 对于其他两项任务,论文的实验如下:

Gigaword语料库用于抽象式文本摘要,Cornell Movie Dialog语料库用于对话式响应生成。

论文的方法在所有这些任务以及

zero-resource setting和low-resource setting中都取得了改进,表明论文的方法是有效的,适用于广泛的序列生成任务。论文的贡献如下:

论文提出了

MASS,一种用于语言生成的masked sequence to sequence预训练方法。MASS主要用于自然语言生成任务,而无法用于自然语言理解任务。论文将

MASS应用于各种语言生成任务,包括神经机器翻译、文本摘要、以及对话式响应生成,并取得了显著的改进,证明了MASS的有效性。具体而言,

MASS在两种language pair(即,English-French, English-German)的无监督神经机器翻译上取得了SOTA的BLEU分,并且在English-French和French-English上分别超过了之前的无监督神经机器翻译方法4分以上和1分以上,甚至超过了早期的attention-based的监督模型。

- 通过预测

相关工作:在自然语言处理领域,在

sequence to sequence learning和预训练方面有很多工作。Sequence to Sequence Learning:sequence to sequence learning是人工智能领域的一项挑战性任务,涵盖了各种语言生成应用,如神经机器翻译、文本摘要、问答、以及对话式响应生成。近年来,由于深度学习的进步,

sequence to sequence learning引起了很多关注。然而,许多语言生成任务,如神经机器翻译,缺乏paired data(即,监督数据),但有大量的unpaired data(即,无监督数据)。因此,在unpaired data上进行预训练,并用小规模的paired data进行微调,将有助于这些任务,这正是本工作的重点。Pre-training for NLP task:预训练已被广泛用于NLP任务中,从而学习更好的language representation。以前的工作大多集中在自然语言理解任务上,可以分为feature-based方法和fine-tuning方法。feature-based方法主要是利用预训练为下游任务提供language representation和feature,其中包括word-level representation、sentence-level representation、以及来自神经机器翻译模型和ELMo的context sensitive feature。fine-tuning方法主要是在语言建模目标上预训练模型,然后在具有监督数据的下游任务上微调模型。具体来说,《Bert: Pre-training of deep bidirectional transformers for language understanding》提出了基于masked language modeling和next sentence prediction的BERT,并在GLUE benchmark和SQuAD中的多个语言理解任务中取得了SOTA准确性。

也有一些工作采用针对语言生成的

encoder-decoder模型进行预训练。《Semi-supervised sequence learning》、《Unsupervised pretraining for sequence to sequence learning》利用语言模型或自编码器来预训练编码器和解码器。他们的方法虽然获得了improvement,但很有限,不像语言理解的预训练方法(如BERT)那样通用和显著。《Exploiting source-side monolingual data in neural machine translation》设计了一个用于预训练的句子重排任务sentence reordering task,但只针对encoder-decoder模型的编码器部分。《Transfer learning for low-resource neural machine translation》和《Zero-resource translation with multi-lingualneural machine translation》在similar rich-resource language pair上预训练模型,在target language pair上对预训练模型进行微调,这依赖于other language pair的监督数据。- 最近,

XLM对编码器和解码器都预训练了BERT-like模型,并在无监督机器翻译上取得了previous SOTA的结果。然而,XLM中的编码器和解码器是单独预训练的,而且encoder-decoder的注意力机制无法被预训练,这对于基于sequence to sequence的语言生成任务来说是次优的。

与以往的工作不同,我们提出的

MASS是经过精心设计的,只使用未标记的数据并同时对编码器和解码器进行联合预训练,可以应用于大多数语言生成任务。

21.1 模型

- 这里,我们首先介绍了

sequence to sequence learning的基本框架,然后提出MASS(MAsked Sequence to Sequence预训练)。然后,我们讨论了MASS与以前的预训练方法的区别,包括masked language modeling(参考BERT)、以及standard language modeling。

21.1.1 Sequence to Sequence Learning

定义

sentence pair,其中:token的source sentence。token的target sentence。source domain,target domain。

一个

sequence to sequence模型学习参数log likelihood作为目标函数:这个条件概率

其中

target sentencesequence to sequence learning的一个主要方法是encoder-decoder框架。编码器读取source sequence并生成一组representation;解码器在给定一组source representation和前面已经处理的target tokens的条件下,估计每个target token的条件概率。注意力机制被进一步引入编码器和解码器之间,从而在预测当前token时寻找应该聚焦于哪个source representation。

21.1.2 Masked Sequence to Sequence Pre-training

我们在本节中介绍了一个新的无监督预测任务。给定一个

unpaired source sentence我们记

fragment都被掩码。token数量。每个masked token替换为一个special symbolmasked sentence的长度保持不变。我们记

token的数量。我们记

fragment。

MASS通过预测sentence fragmentsequence to sequence模型,其中模型将masked sentence我们也使用对数似然作为目标函数:

其中:

token,它在sentence fragmentsentence fragmenttoken子序列(不包括位置

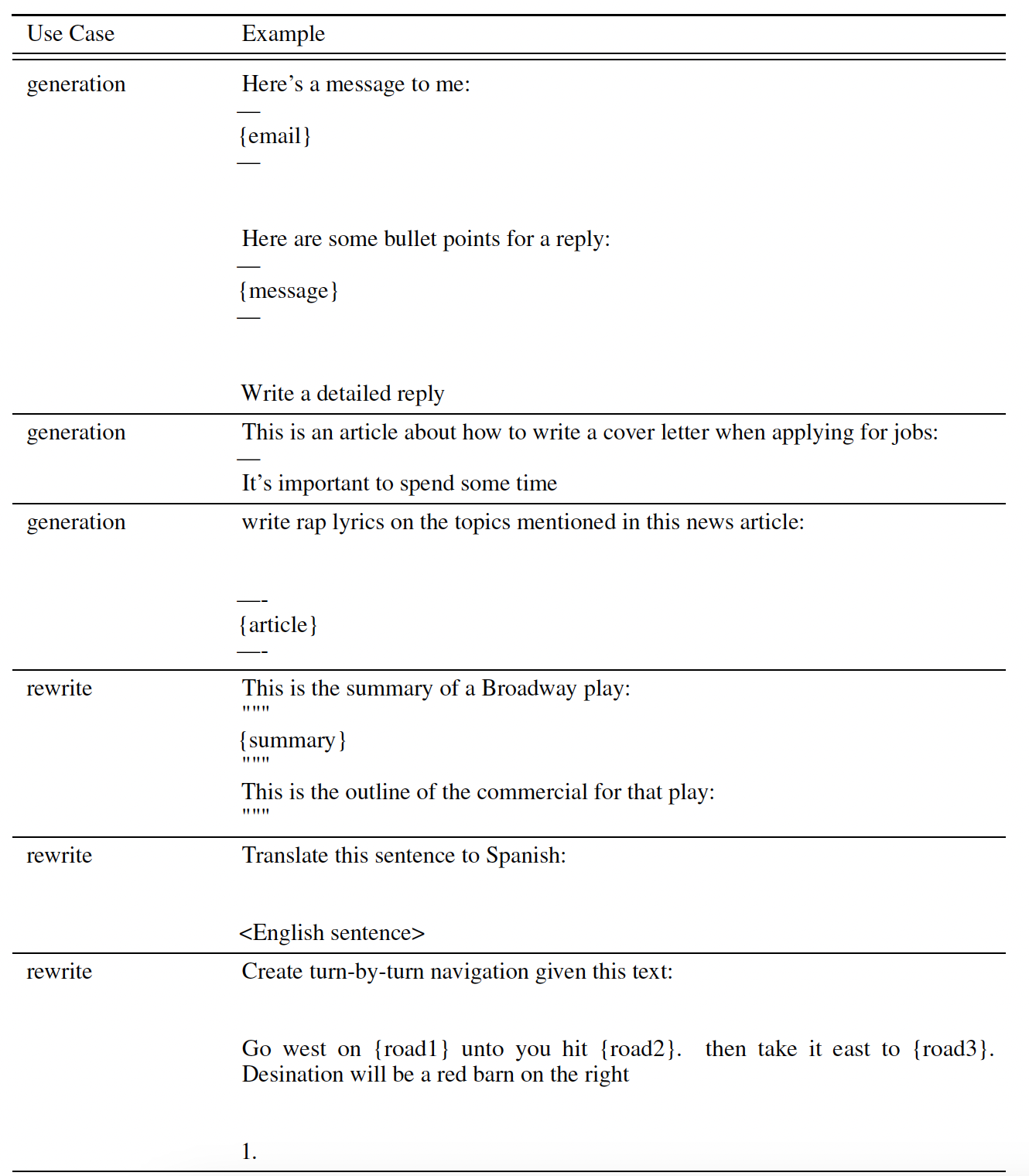

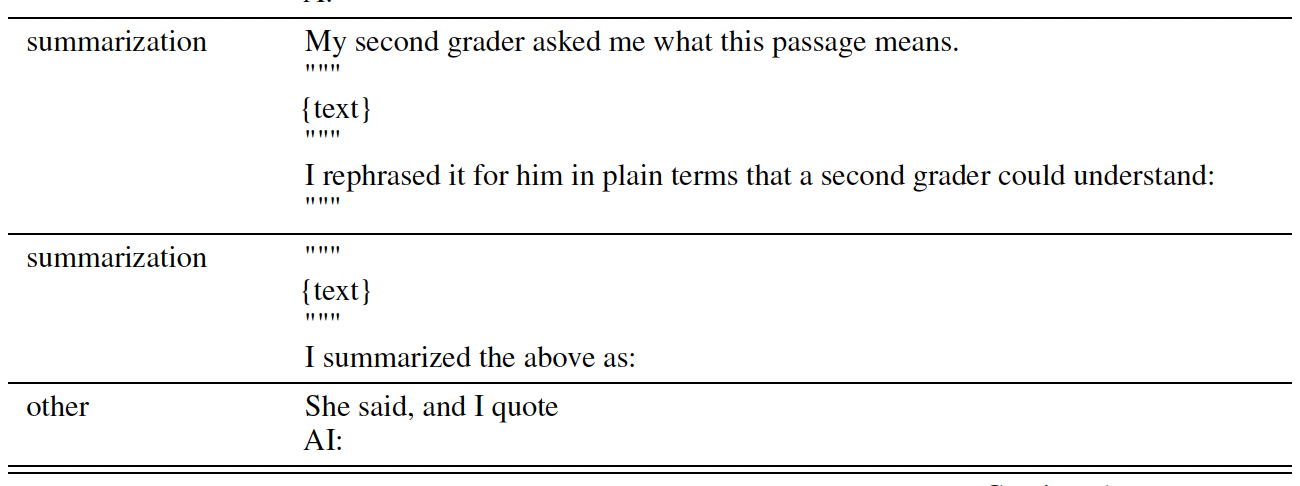

我们在下图中展示了一个例子,其中输入序列有

8个token,fragmentfragmentdecoder input为:位置0 ~ 2和位置6 ~ 7的输入都是special token3 ~ 5的输入为0开始 。虽然我们的方法适用于任何基于神经网络的

encoder-decoder框架,但我们在实验中选择了Transformer,因为它在多个sequence to sequence learning任务中取得了SOTA的性能。在论文的实现中,作者将

decoder input中的masked token移除,但是对所有的token保留它们的原始位置信息。即,下图中保留{2, 3, 4, 5}(位置编号从零开始计算)。

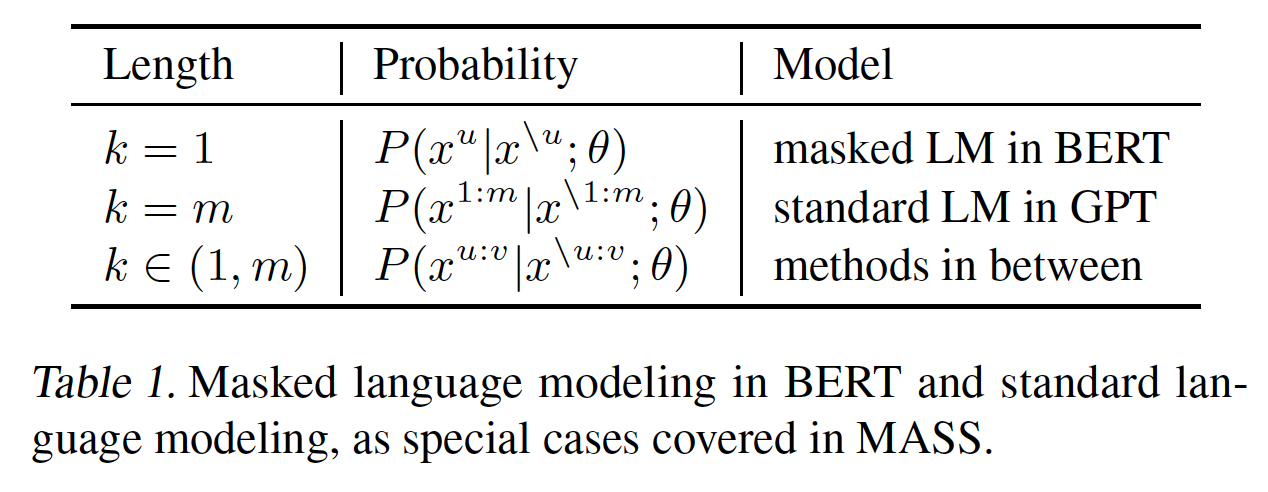

实际上,

BERT中的掩码语言建模masked language modeling、以及GPT中的标准语言建模standard language modeling可以被视为MASS的特殊情况。我们有一个重要的超参数masked fragment的长度。具有不同MASS可以覆盖一些特殊的case,这些特殊的case与先前的预训练方法相关,如下表所示。

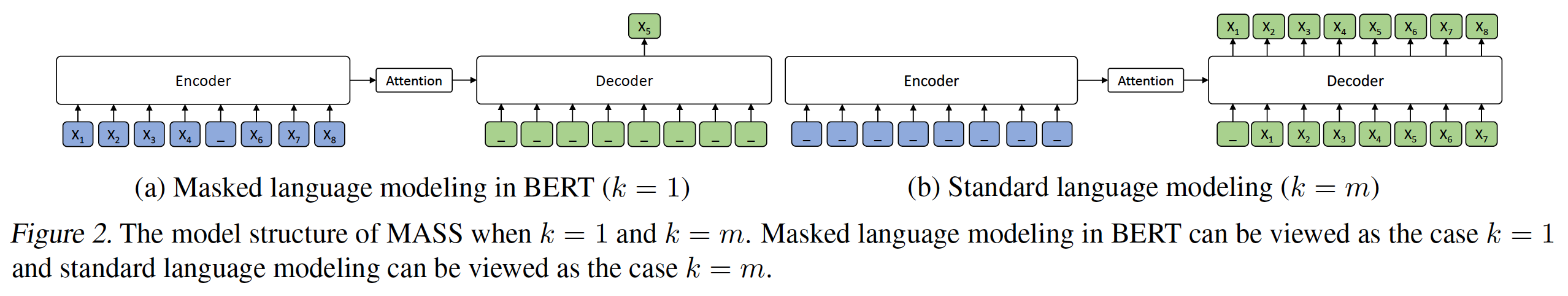

当

source sentence中的masked fragment只包含一个token,解码器预测这个token时没有任何其它token作为输入,而是以unmasked source token为条件,如下图(a)所示。这就成了BERT中使用的masked language modeling。有人可能会说,该模型结构与

masked language modeling有一点不同。然而,由于解码器的所有输入token都被掩码了,解码器本身就像一个非线性分类器,类似于BERT中使用的softmax矩阵。在这种情况下,条件概率是masked token的位置,这正是BERT中使用的masked language modeling的公式。当

token数量,encoder side的所有token都被掩码,解码器需要在给定previous tokens的条件下预测所有token,如下图(b)所示。条件概率为GPT中的standard language modeling,以来自编码器的null信息为条件,因为encoder side的所有token都被掩码了。

21.1.3 讨论

MASS是一种用于language generation的预训练方法。虽然它的特殊case与先前的方法有关,包括GPT中的standard language modeling和BERT中的masked language modeling,但它与这些方法总体上是不同的:standard language modeling长期以来一直被用于预训练,最突出的是最近提出的ELMo和OpenAI GPT。BERT为自然语言理解引入了两个预训练任务(masked language modeling和next sentence prediction),并使用一个编码器来为单句single sentence和句子对sentence pair抽取representation。standard language modeling和BERT都可以只对编码器或解码器分别进行预训练。虽然在语言理解任务上取得了可喜的成果,但它们并不适合语言生成任务,其中语言生成任务通常利用encoder-decoder框架从而用于条件序列生成conditional sequence generation。MASS被设计为联合预训练编码器和解码器从而用于语言生成任务。- 首先,通过

sequence to sequence框架来仅仅预测masked token,MASS迫使编码器理解unmasked token的含义,同时也鼓励解码器从encoder side抽取有用的信息。 - 第二,通过预测

decoder side的连续token,解码器可以建立更好的语言建模能力,而不仅仅是预测离散的token。 - 第三,通过进一步掩码解码器的

input token(这些token在encoder side没有被掩码),鼓励解码器从encoder side抽取更多有用的信息,而不是利用decoder side的previous token的丰富信息。

- 首先,通过

21.2 实验

21.2.1 MASS 预训练

模型配置:我们选择

Transformer作为基本模型结构,它由6层编码器和6层解码器组成,emebdding/hidden维度为1024,feed-forward filter维度为4096。对于神经机器翻译任务,我们在

source language和target language的单语数据上对我们的模型进行预训练。我们分别对三种language pair进行了实验:English-French, English-German, English-Romanian。对于其他语言生成任务,包括文本摘要和对话式响应生成,我们分别只用英语单语数据对模型进行预训练。

为了区分神经机器翻译任务中的

source language和target language,我们为编码器和解码器的input sentence的每个token添加了一个language embedding,其中language embedding也是端到端学习的。mBART是在input sentence的开头添加一个<LID>的special token,如<EN>用于英语 。我们基于

XLM的代码库来实现我们的方法。数据集:我们使用了

WMT News Crawl数据集的所有单语数据,其中涵盖了2007年至2017年的190M英语句子、62M法语句子、270M德语句子。我们还在预训练阶段加入了一种

low-resource language,即罗马尼亚语Romanian,以验证用低资源单语数据预训练的MASS的有效性。我们使用News Crawl数据集中所有可用的罗马尼亚语句子,并使用WMT16数据对其进行增强,从而得到2.9M罗马尼亚语句子。我们删除了长度超过

175的句子。对于每个任务,我们在source language和target language之间用BPE联合学习了60K个子词单元sub-word unit。这里是跨语言的

BPE,而不是针对每个语言单独学习一个BPE。预训练细节:我们通过

special symboltoken来掩码segment,其中随机选择masked segment的起始位置BERT,编码器中的masked token为:80%的概率是token,10%的概率是random token,10%的概率是original token。我们将fragment lengthtoken总数的大约50%,同时研究不同的为了减少内存和计算成本,我们删除了解码器中的

padding(即,masked token),但保持unmasked token的positional embedding不变(例如,如果前两个token被掩码和删除,第三个token的位置仍然是2而不是0)。通过这种方式,我们可以获得类似的准确性,并减少解码器中50%的计算量。我们使用

Adam优化器进行预训练,学习率为8个NVIDIA V100 GPU card上进行训练,每个mini-batch包含3000个token从而用于预训练。为了验证

MASS的有效性,我们在三个语言生成任务上对预训练的模型进行了微调:神经机器翻译、文本摘要、对话式响应生成。我们在这些任务中探索了low-resource setting,其中我们只是利用少数训练数据用于微调从而模拟low-resource的场景。对于神经机器翻译,我们主要研究zero-resource setting(无监督),因为近年来无监督的神经机器翻译已经成为一项具有挑战性的任务。

21.2.2 Fine-Tuning on NMT

这里,我们首先描述无监督神经机器翻译的实验,然后介绍低资源神经机器翻译的实验。

实验配置:对于无监督神经机器翻译,没有双语数据

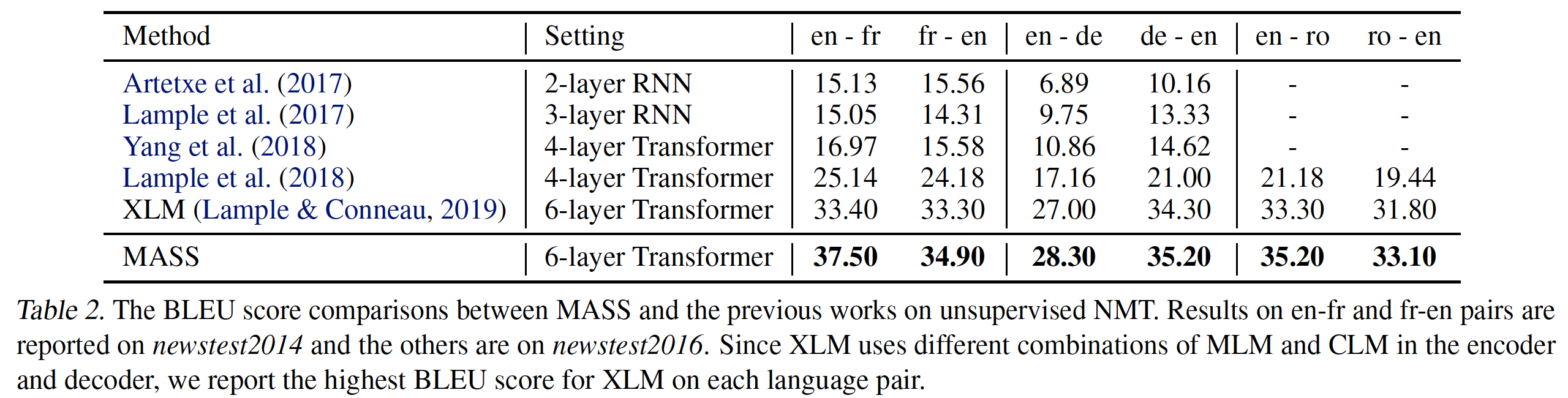

bilingual data来微调预训练的模型。因此,我们利用了预训练阶段的单语数据。与《Unsupervised neural machine translation》、《Unsupervised machine translation using monolingual corpora only》、《Phrase-based & neural unsupervised machine translation》、《Unsupervised pivot translation for distant languages》不同的是,我们只是利用back-translation来生成pseudo bilingual data从而用于训练,而不使用降噪自编码器。在微调过程中,我们使用Adam优化器,初始学习率为GPU的batch size被设置为2000个token。在评估过程中,我们用multi-bleu.pl(来自https://github.com/moses-smt/mosesdecoder/blob/master/scripts/generic/multi-bleu.perl)在newstest2014上评估English-French的BLEU分、在newstest2016上评估English-German和English-Romanian的BLEU分。无监督神经机器翻译的结果:我们的结果如下表所示。可以看到:

在所有

6个翻译方向上,我们的方法优于之前的所有结果,包括没有预训练的方法(Lample et al., 2018)和有预训练的方法(XLM)。XLM是之前的SOTA方法,它在编码器和解码器中利用了BERT-like的预训练,该预训练涵盖了几种预训练方法:masked language model: MLM、causal language model: CLM。我们的方法在en-fr上仍然比XLM高出4.1 BLEU point。

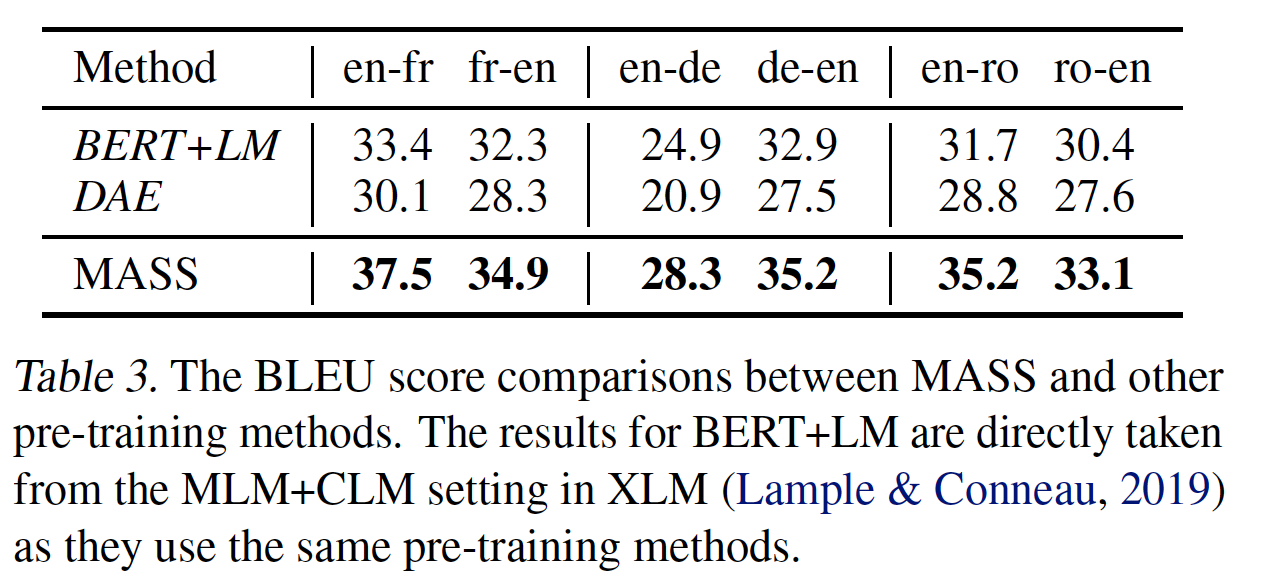

与其他预训练方法相比:我们还将

MASS与之前的语言生成任务的预训练方法进行比较。- 第一个

baseline是BERT+LM,在BERT中使用masked language modeling对编码器进行预训练,并使用standard language modeling对解码器进行预训练。 - 第二个

baseline是DAE,它简单地使用去降噪自编码器denoising auto-encoder来预训练编码器和解码器。

我们用

BERT+LM和DAE来预训练模型,并用XLM相同的微调策略对无监督翻译pair对进行微调(即DAE loss + back-translation)。这些方法也采用6层的Transformer。如下表所示:

BERT+LM取得了比DAE更高的BLEU分,而MASS在所有无监督翻译pair对的表现都超过了BERT+LM和DAE。虽然

DAE通常利用一些降噪方法,如随机masking token或互换相邻token,但解码器仍然可以通过encoder-decoder attention轻松地学会拷贝unmasked token。另一方面,

DAE中的解码器将完整的句子作为输入,这足以像语言模型一样预测下next token,而不会被迫从编码器中提取额外的useful representation。

- 第一个

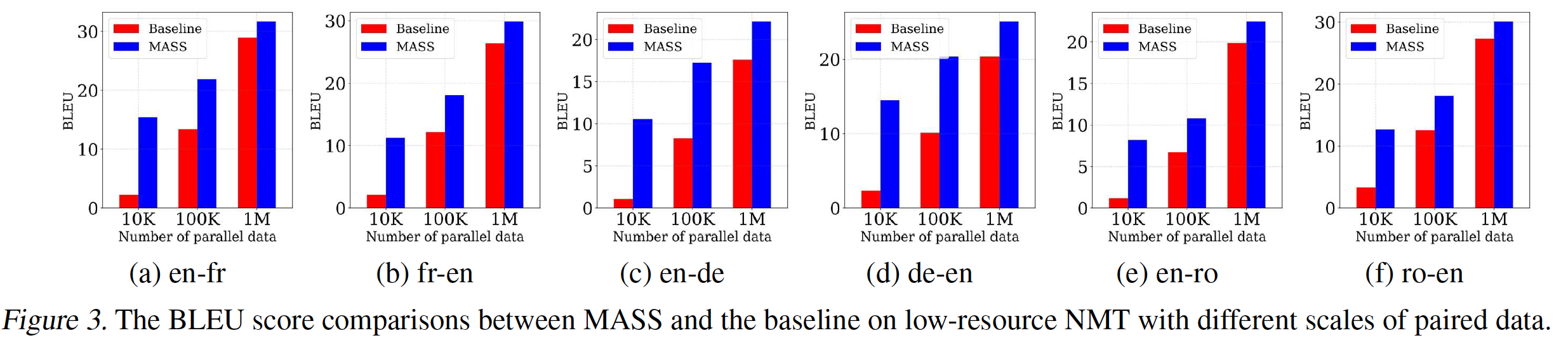

Low-Resource NMT实验:在低资源神经机器翻译的setting中,我们分别WMT14 English-French, WMT16 English-German, WMT16 English-Romanian的双语训练数据中抽取10K, 100K, 1M个paired sentence,从而探索我们的方法在不同low-resource场景中的表现。我们使用在预训练阶段学到的相同的

BPE代码来tokenize这些training sentence pair。我们用Adam优化器在paired data上对预训练模型进行了20K步的微调,学习率为setting中使用的相同测试集上的BLEU分。如下图所示,

MASS优于baseline模型,其中baseline模型仅在双语数据上训练而没有在所有六个翻译方向进行任何预训练。这表明我们的方法在低资源场景下的有效性。即,

baseline模型是传统的监督学习,而MASS是pretraining + finetuning。此外还可以看到:双语训练数据越少(即,资源越少),那么

MASS相比baseline的提升就越大。

21.2.3 Fine-Tuning on Text Summarization

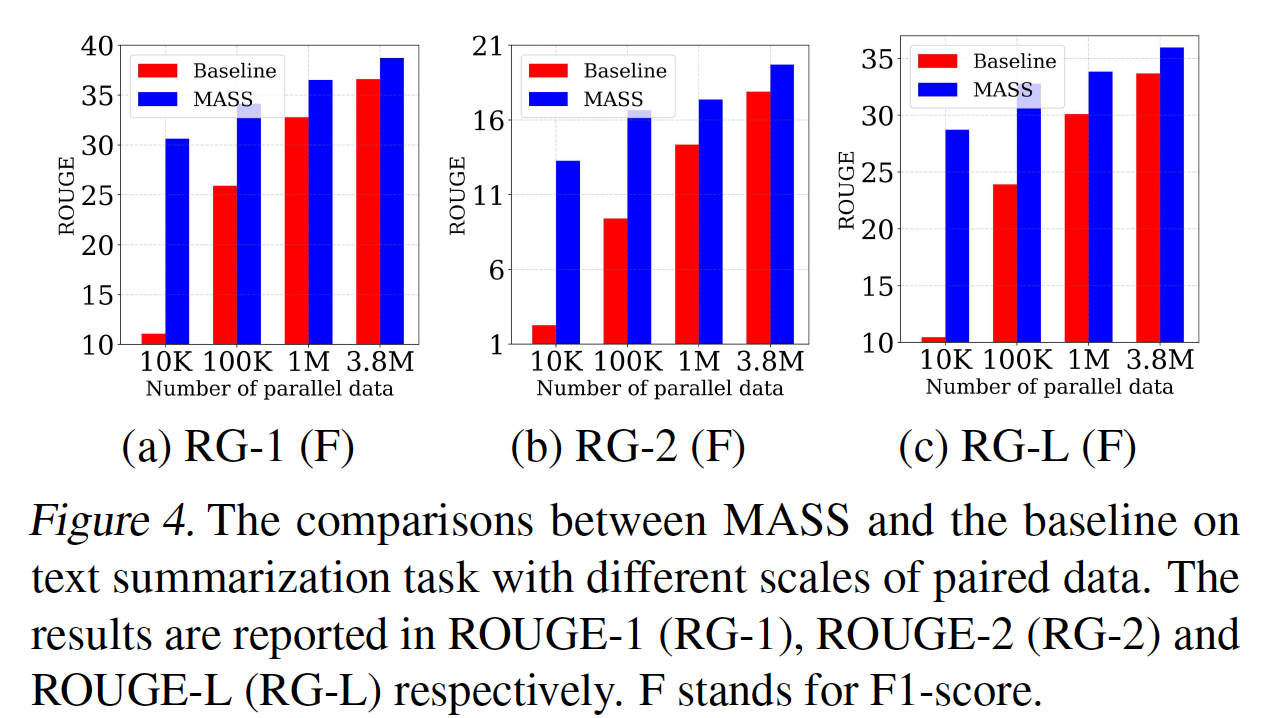

实验配置:文本摘要是对长篇文本文档创建简短而流畅的

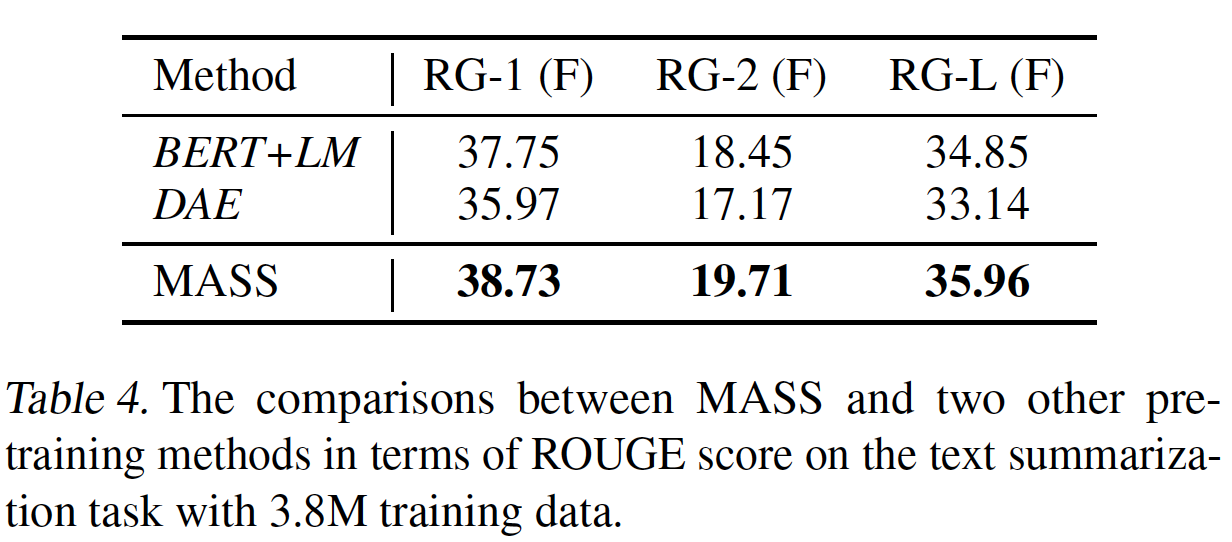

summary,这是一项典型的序列生成任务。我们用来自Gigaword语料库的不同规模(10K、100K、1M、以及3.8M)的训练数据在文本摘要任务上对预训练模型进行微调,其中Gigaword语料库由总共3.8M篇英文的article-title pair组成。我们把article作为编码器的输入、把title作为解码器的输入从而用于微调。在评估过程中,我们报告了在Gigaword测试集上的ROUGE-1、ROUGE-2、以及ROUGE-L的F1得分。我们使用beam size = 5的beam search从而用于推理。结果:我们的结果如下图所示。我们将

MASS与仅在paired data上训练而没有任何预训练的模型(即,baseline)进行比较。在不同规模的微调数据上,MASS始终优于baseline(在10K数据上获得超过10 ROUGE point的增益,在100K数据上获得超过5 ROUGE point的增益),这表明MASS在这个任务上在具有不同规模训练数据的低资源场景中是有效的。

与其他预训练方法相比较:我们进一步将

MASS与前面描述的BERT+LM和DAE的预训练方法进行比较,其中在文本摘要任务上使用了3.8M的数据。如下表所示,MASS在三个ROUGE分数上一致地优于这两种预训练方法。

21.2.4 Fine-Tuning on Conversational Response Generation

实验配置:对话式响应生成为对话生成一个灵活的响应。我们在

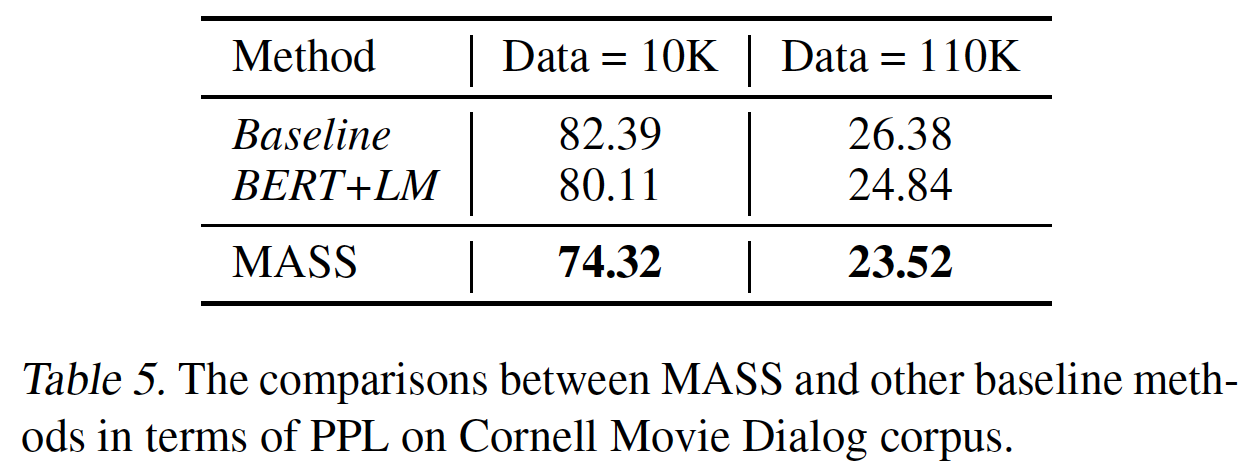

Cornell Movie Dialog语料库上进行了实验,该语料库包含140K个conversation pair。我们随机抽取10K/20K个pair作为验证集/测试集,剩余的数据用于训练。我们采用预训练阶段的相同优化超参数进行微调。我们遵从《A neural conversational model》的方法,报告困惑度perplexity: PPL的结果。结果:我们将

MASS与baseline进行比较,其中baseline在现有可用的data pair上训练得到。我们对两组训练数据规模进行实验:随机选择10K个训练data pair、所有的110K个训练data pair,并在下表中展示实验结果。在10K和110K的训练数据上,MASS的PPL都比baseline更低。

与其他预训练方法相比较:我们还将

MASS与BERT+LM和DAE的预训练方法在对话式响应生成任务上进行了比较。如Table 5所示,在10K和110K的训练数据上,MASS的PPL都比这两种预训练方法更低。

21.2.5 MASS 的分析

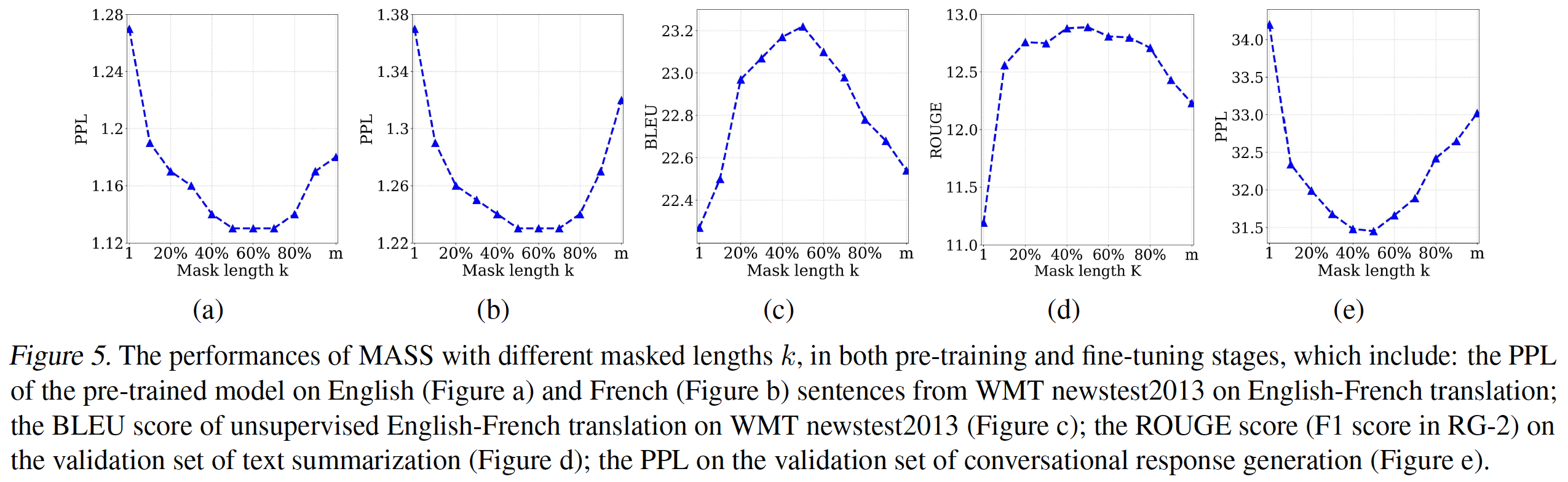

不同

masked fragment的长度MASS的一个重要的超参数。如前所述,通过改变masked language modeling(参考BERT)、以及standard language modeling的特殊case。在这一节中,我们研究了不同MASS的性能,我们选择10% ~ 90%,步长为10%,再加上我们观察了

MASS在预训练的表现,以及在几个语言生成任务中微调的表现,包括无监督的English-French翻译、文本摘要、以及对话式响应生成。我们首先展示了在不同的

perplexity: PPL。我们选择WMT En-Fr的newstest2013中的英语句子和法语句子作为验证集,并绘制PPL如下图所示(图(a)为英语、图(b)为法语)。可以看到:当

50%到70%之间时,预训练的模型达到了最佳的validation PPL。然后我们观察微调任务的表现。我们在

(c)中显示了无监督En-Fr翻译的validation BLEU分数的曲线,在图(d)中显示了文本摘要的validation ROUGE分数,在图(e)中显示了对话式响应生成的validation PPL。可以看到,当

50%时,MASS在这些下游任务上取得了最佳性能。

因此,我们在实验中为

MASS设定了50%。实际上,

50%是编码器和解码器之间的一个良好平衡。encoder side或decoder side的有效token太少,会使模型偏向于更多地关注另一侧,这不适合语言生成任务。因为语言生成任务通常利用encoder-decoder框架在编码器中抽取sentence representation,以及在解码器中建模和生成句子。极端情况是BERT中的masked language modeling)和standard language modeling)。如下图所示,

MASS的消融研究:在我们的masked sequence to sequence预训练中,我们有两个精心的设计:- 我们在

encoder side掩码连续的token,从而在decoder side预测连续的token,这比仅仅预测离散的token可以建立更好的语言建模能力。 - 我们掩码解码器的

input token,其中这些token在encoder side没有被掩码,从而鼓励解码器从encoder side抽取更多有用的信息,而不是利用decoder side的previous tokens的丰富信息。

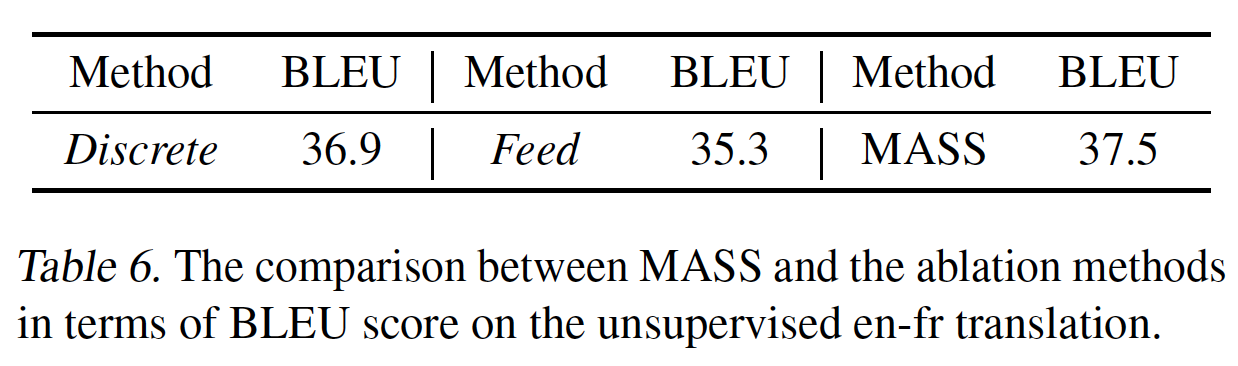

在本节中,我们进行了两项消融研究,以验证

MASS中两种设计的有效性:- 第一项研究是在

MASS中随机掩码离散的token而不是连续的token,记做Discrete。 - 第二项研究是将所有的

token馈入解码器,而不是掩码解码器的input token(其中这些token在encoder side没有被掩码)记做Feed。

我们将

MASS与这两种消融方法在无监督的English-French上进行比较,如下表所示。可以看到,Discrete和Feed的表现都比MASS更差,证明了MASS的这两种设计的有效性。这里就一个例子,是不是说服力不强?可以在更多的数据集上进行评估。

- 我们在

二十二、MacBERT [2019]

BERT受到广泛的欢迎,并在最近的自然语言处理研究中被证明是有效的。BERT利用大规模的无标记训练数据并生成丰富的contextual representation。在几个流行的机器阅读理解benchmark上,如SQuAD,CoQA,QuAC,NaturalQuestions,RACE,我们可以看到大多数表现最好的模型是基于BERT及其变体,表明预训练的语言模型已经成为自然语言处理领域的新的基础部分。从

BERT开始,社区成员在优化预训练语言模型pre-trained language model方面取得了巨大而迅速的进展,如ERNIE, XLNet, RoBERTa, SpanBERT, ALBERT, ELECTRA等等。然而,针对learning representation,训练Transformer-based的预训练语言模型并不像我们用来训练word-embedding或其他传统神经网络那样容易:- 通常情况下,训练一个强大的

BERT-large模型(具有24层Transformer和3.3亿个参数)到收敛,需要高内存的计算设备(如TPU或TPU Pod),这些设备非常昂贵。 - 另一方面,虽然已经发布了各种预训练的语言模型,但大多数都是基于英语的,在其他语言中建立强大的预训练语言模型的努力很少。

为了尽量减少重复性工作,并为未来的研究建立

baseline,在论文《Pre-Training with Whole Word Masking for Chinese BERT》中,作者旨在建立中文预训练语言模型系列model series,并向公众发布,以促进科研社区,因为中文和英文是世界上最常用的语言之一。论文重新审视了现有的流行的预训练语言模型,并将其调整为中文,从而了解这些模型是否能在英语以外的语言中得到推广并表现良好。此外,论文还提出了一个新的预训练语言模型,称为MacBERT,它将原来的MLM任务替换为MLM as correction: Mac任务。MacBERT主要是为了缓解原始BERT中预训练阶段和微调阶段的差异。论文在十个流行的中文NLP数据集上进行了广泛的实验,范围从sentence-level任务到document-level任务,如机器阅读理解、文本分类等。实验结果表明,与其他预训练的语言模型相比,所提出的MacBERT可以在大多数任务中获得显著的收益。论文还给出了详细的消融实验,以更好地检查哪些因素带来改进。论文的贡献如下:- 为了进一步加快中文

NLP的未来研究,论文创建了中文预训练语言模型系列并向社区发布。作者进行了广泛的实证研究,通过仔细分析来重新审视这些预训练语言模型在各种任务上的表现。 - 论文提出了一个新的预训练语言模型,叫做

MacBERT,通过用相似的单词来掩码一个单词,从而缓解了预训练阶段和微调阶段的gap,这在各种下游任务中被证明是有效的。 - 论文还创建了一系列小型模型,称为

RBT,从而展示小型模型与常规预训练语言模型相比的表现,这有助于在现实世界中利用这些小模型。

本文创新力不足,更像是一篇工程实现的报告。

- 通常情况下,训练一个强大的

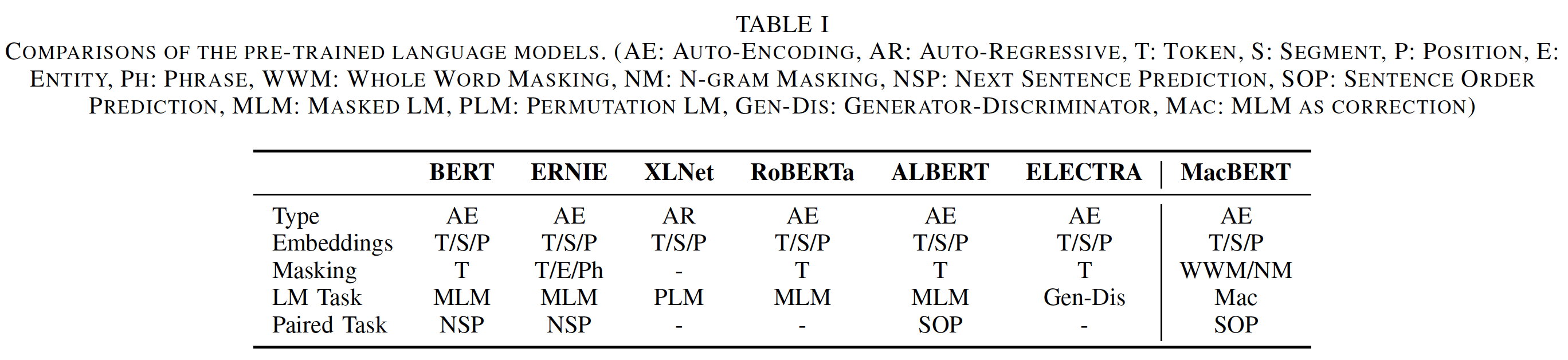

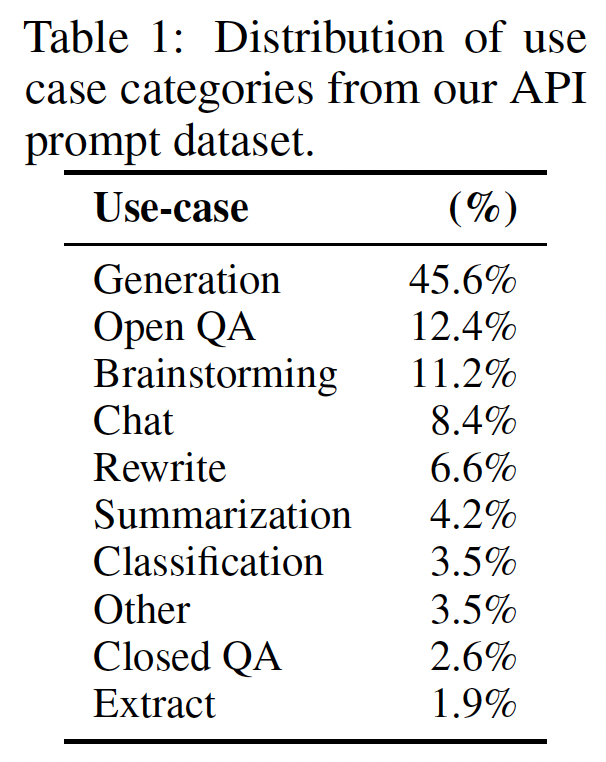

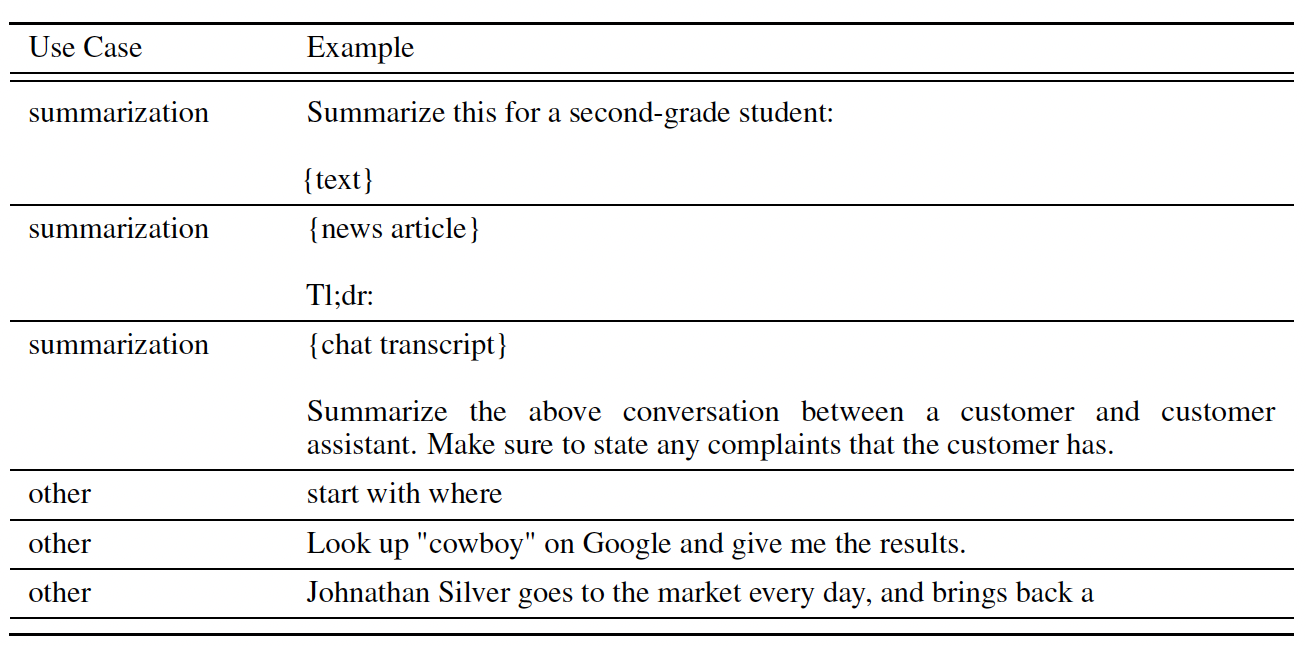

相关工作:这里我们重新审视了最近自然语言处理领域中具有代表性的预训练语言模型的技术。这些模型以及所提出的

MacBERT的整体比较在下表中描述。BERT:Bidirectional Encoder Representations from Transformers: BERT已经在广泛的自然语言处理任务中证明了其有效性。BERT通过在所有Transformer层中,同时以左侧上下文和右侧上下文为条件来预训练深度双向representation。BERT主要由两个预训练任务组成:Masked Language Model: MLM、Next Sentence Prediction: NSP。MLM:随机掩码输入中的一些token,目标是仅根据其上下文来预测原始token。NSP:预测sentence B是否是sentence A的下一句。

后来,他们进一步提出了一种叫做全词掩码(

whole word masking: wwm)的技术,用于优化MLM任务中的原始掩码。在这个setting中,我们不是随机选择WordPiece token来掩码,而是总是一次性掩码对应于整个单词的所有token。这明确地迫使模型在MLM预训练任务中恢复整个单词,而不是仅仅恢复WordPiece token,而恢复整个单词的挑战性更大。由于全词掩码只影响预训练过程的掩码策略,因此它不会给下游任务带来额外的负担。此外,由于训练预训练语言模型的计算成本很高,他们还公布了所有的预训练模型以及源代码,这大大刺激了社区对预训练语言模型进行研究的极大兴趣。

ERNIE:Enhanced Representation through kNowledge IntEgration: ERNIE旨在优化BERT的掩码过程,其中包括entity-level masking和phrase-level masking。与选择输入中的随机单词不同:entity-level masking是对命名实体的掩蔽,这些实体通常由几个单词组成。phrase-level masking是掩码连续的词,这与N-gram掩码策略相似。

XLNet:《Xlnet: Generalized autoregressive pretraining for language understanding》认为,现有的基于自编码的预训练语言模型(如BERT)存在预训练阶段和微调阶段的gap,因为masking token(即[MASK])从未在微调阶段出现。为了缓解这个问题,他们提出了基于Transformer-XL的XLNet。XLNet主要有两处修改:- 首先是在输入的分解顺序的所有排列上最大化期望的似然

expected likelihood,在这里他们称之为排列语言模型Permutation Language Model。为了实现这一目标,他们提出了一种新颖的双流自注意力机制two-stream self-attention mechanism。 - 其次是将自编码语言模型改为自回归语言模型,这与传统的统计语言模型类似。

- 首先是在输入的分解顺序的所有排列上最大化期望的似然

RoBERTa:Robustly Optimized BERT Pretraining Approach: RoBERTa旨在采用原始的BERT架构,但做了更精细的修改,以充分释放BERT的力量。他们对BERT中的各种组件进行了仔细的比较,包括掩码策略、输入格式、训练步数等。经过全面的评估,他们得出了几个有用的结论从而使得BERT更加强大,主要包括:- 用更大的

batch size和更长的序列在更多的数据上进行更长时间的训练。 - 取消

next sentence prediction任务,以及在MLM任务中使用动态掩码dynamic masking。

- 用更大的

ALBERT:A Lite BERT: ALBERT主要解决了BERT的内存消耗较大和训练速度慢的问题。ALBERT介绍了两种减少参数的技术。- 第一个是

factorized embedding parameterization,它将embedding矩阵分解为两个小矩阵。 - 第二个是跨层参数共享,即在

ALBERT的每一层共享Transformer权重,这大大减少了整体参数。

此外,他们还提出了

sentence order prediction: SOP任务,取代传统的NSP预训练任务,从而产生更好的性能。- 第一个是

ELECTRA:Efficiently Learning an Encoder that Classifiers Token Replacements Accurately: ELECTRA采用了一个新的generator-discriminator framework,类似于生成对抗网generative adversarial net: GAN。- 生成器通常是一个小型的

MLM,学习预测masked token的原始token。 - 判别器被训练来判别

input token是否被生成器所替换,这被称作Replaced Token Detection: RTD。

注意,为了实现有效的训练,判别器只需要预测一个二元标签来表示

"replacement",而不像MLM预测准确的masked word。在预训练阶段之后,我们抛弃了生成器,只用判别器来微调下游的任务。- 生成器通常是一个小型的

22.1 模型

22.1.1 中文预训练模型

虽然

BERT及其变体在各种英语任务中取得了显著的改进,但我们想知道这些模型和技术是否能在其他语言中得到很好的泛化。在本节中,我们将说明现有的预训练语言模型是如何适用于中文的。我们采用BERT、RoBERTa和ELECTRA以及它们的变体来创建中文预训练模型系列model series,其有效性在实验部分展示。需要注意的是,由于这些模型都是源于BERT或ELECTRA,没有改变输入的性质,在微调阶段无需修改从而适配这些模型,相互替换非常灵活。BERT-wwm & RoBERTa-wwm:原始的BERT使用WordPiece tokenizer将文本拆分成WordPiece tokens,其中一些单词被拆分成几个小的片段small fragment。全词掩码whole word masking: wwm缓解了仅掩码整个单词的一部分的缺点,因为仅掩码整个单词的一部分对模型来说更容易预测。根据单词的一部分

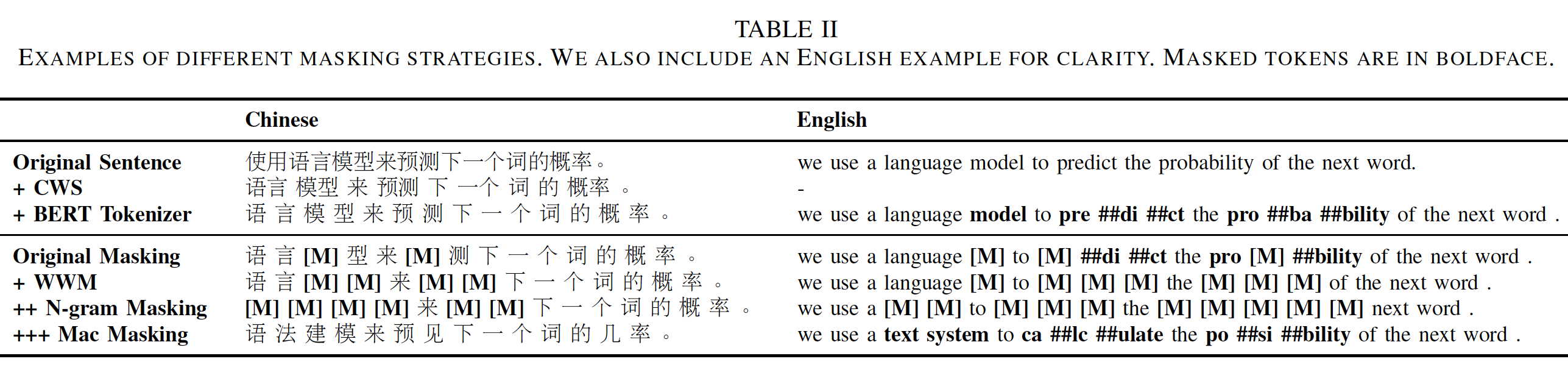

token来预测另一部分token相对比较容易,如player被拆分为play和##er两个token。如果被掩码的token为##er,那么已知play来预测##er要相对容易。在中文条件下,

WordPiece tokenizer不再将单词分割成小的片段,因为汉字不是由类似字母的符号组成。我们使用中文分词Chinese Word Segmentation: CWS工具,将文本分割成若干个词语。通过这种方式,我们可以采用中文的全词掩码,而不是单个汉字的掩码。在实施过程中,我们严格遵循原有的全词掩码代码,不改变其他的组成部分,如word masking的百分比等。我们使用LTP进行中文分词来识别单词的边界。需要注意的是,全词掩码只影响到预训练阶段的masking token的选择。我们仍然使用WordPiece tokenizer来拆分文本,这与原始的BERT是相同的。同样地,全词掩码也可以应用于

RoBERTa,其中没有采用NSP任务。然而,我们仍然使用paired input进行预训练,这可能有利于sentence pair的分类任务和阅读理解任务。SpanBERT表明,single-sequence training的效果要好于bi-sequence training,因为单个句子的训练可以获得更长的上下文。下表中描述了一个全词掩码的例子。

ELECTRA:除了BERT和RoBERTa系列,我们还探索了ELECTRA模型,它采用了一个新的预训练框架,由生成器和判别器组成。我们严格遵循ELECTRA原始论文中的原始实现。RBT Series:尽管上述的预训练语言模型很强大,但它们不是计算高效的,而且很难在实际应用中采用。为了使社区研究人员更容易获得预训练的模型,除了常规的预训练语言模型,我们还预训练了几个小模型,我们称之为RBT。具体而言,我们使用与训练

RoBERTa完全相同的训练策略,但我们使用较少的Transformer层。我们训练3层、4层、6层的RoBERTa-base,分别表示为RBT3、RBT4和RBT6。我们还训练了一个3层的RoBERTa-large,表示为RBTL3,它的参数规模与RBT6相似。这样做的目的是在参数规模相当的情况下,比较一个更宽更浅的模型(RBTL3)和一个更窄更深的模型(RBT6),这有助于未来预训练语言模型的设计。

22.1.2 MACBERT

在上一节中,我们提出了一系列的中文预训练语言模型。在这一节中,我们充分利用这些模型,并提出了一个叫做

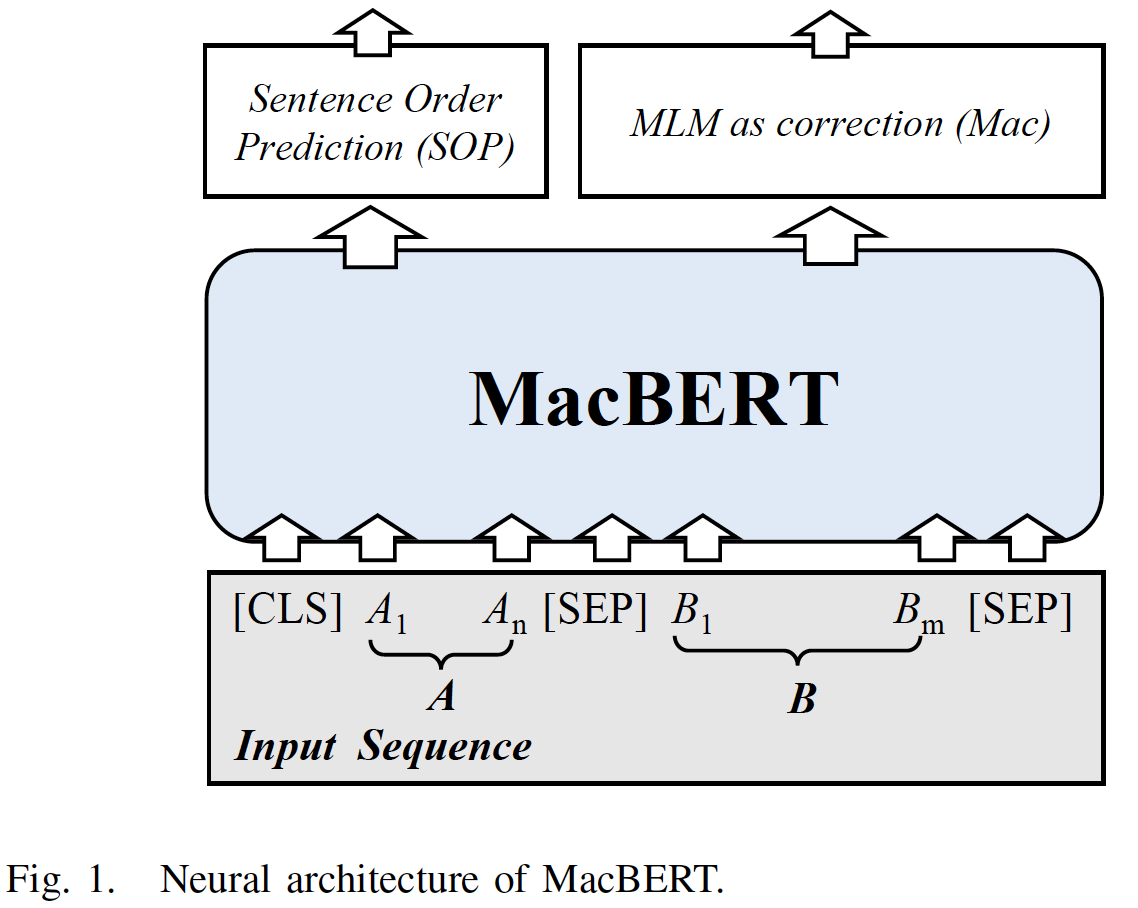

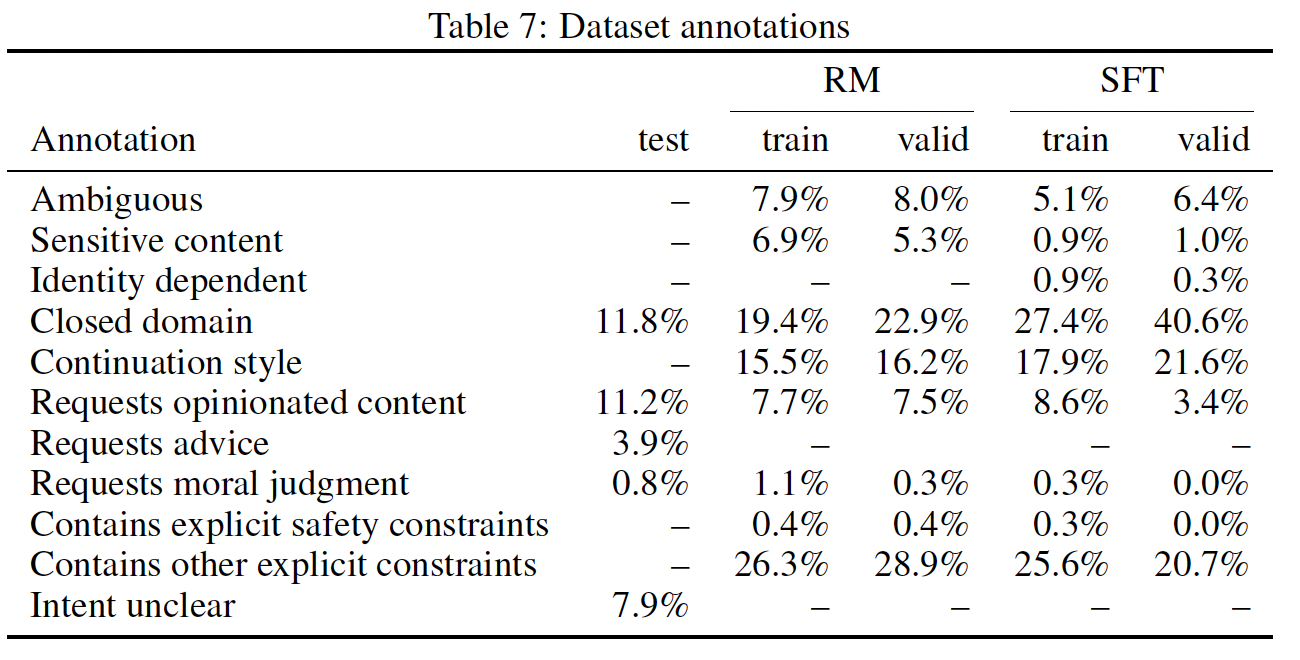

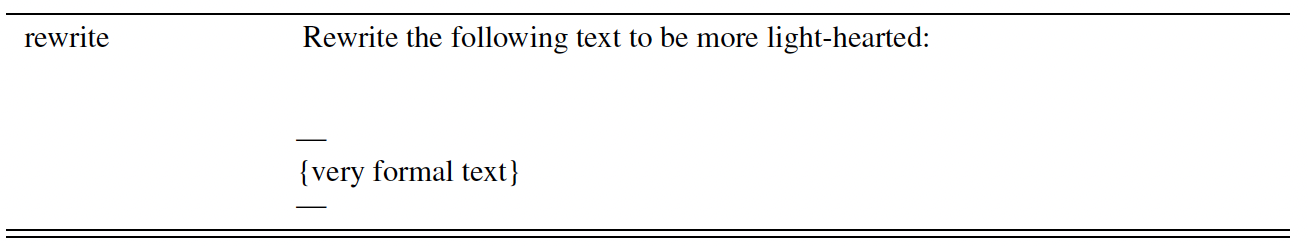

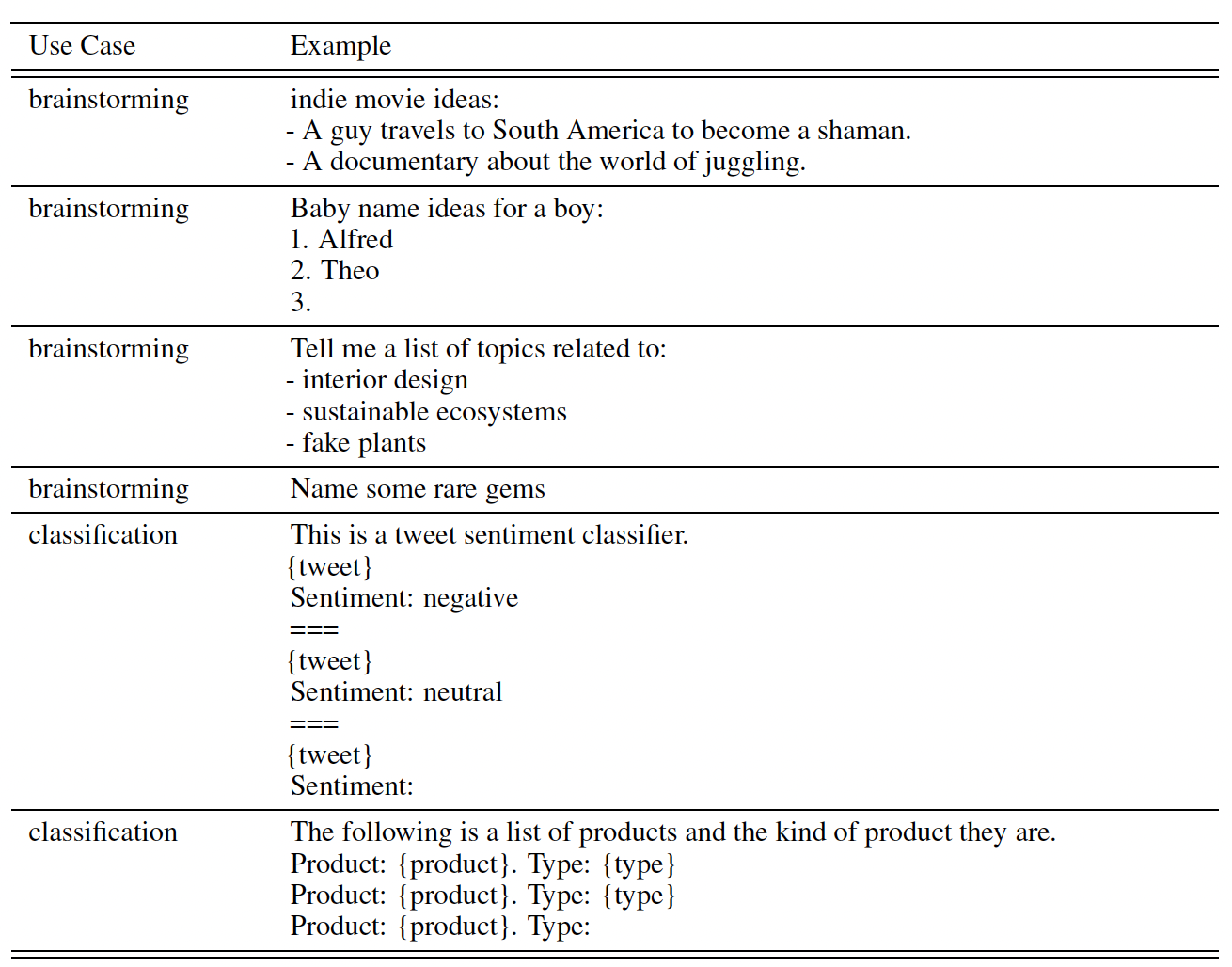

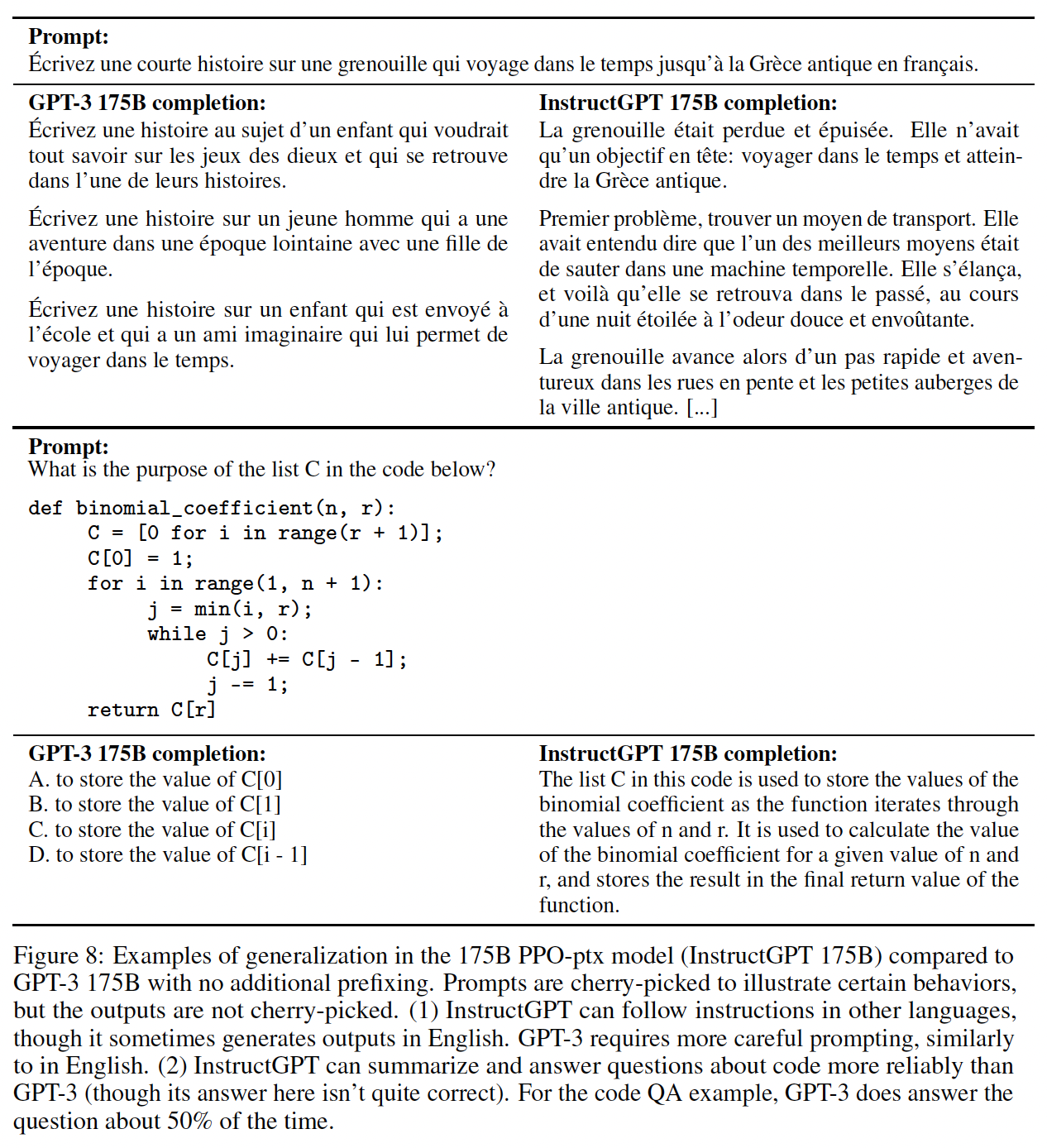

MLM as correction BERT: MacBERT的新型模型。MacBERT与BERT共享相似的预训练任务类型,并做了一些修改。MacBERT由两个预训练任务组成:MLM as correction、sentence order prediction。下图描述了

MacBERT的整体架构。

MLM as correction:MLM是BERT及其变体中最重要的预训练任务,它建模了双向上下文推断bidirectional contextual inference的能力。然而,如前所述,MLM存在预训练阶段和微调阶段的不一致性,即预训练阶段的人工标记(如[MASK])从未出现在真正的下游微调任务中。为了解决这个问题,我们提出了一个新的预训练任务,称为

MLM as correction: Mac。在这个预训练任务中,我们不采用任何预定义的token来进行掩码。相反,我们将原始的MLM转化为一个文本纠正text correction任务:模型应该将错误的单词纠正为正确的单词,这比MLM更自然。具体而言,在Mac任务中,我们对原始MLM进行了以下修改:文本纠正任务要比

MLM任务更简单。文本纠正任务是:给定original word的similar word,因此需要预测的original word一定跟similar word非常相似。这大大缩小了候选单词的范围。例如:原始句子为

I like play football.,我们用basketball代替了football,变成I like play basketball.。我们需要根据这个句子来预测最后一个单词为football。事实上,我们知道这个目标单词和basketball非常相似,这大大缩小了候选单词的范围。我们使用全词掩码策略以及

N-gram掩码策略来选择候选token进行掩码,对于word-level的unigram, 2-gram, 3-gram, 4-gram,其掩码比例分别为40%, 30%, 20%, 10%。我们还注意到,最近的一项工作提出了PMI-masking(《{PMI}-masking: Principled maskingof correlated spans》),它优化了掩码策略。在本文中,我们采用的是普通的N-gram掩码,并将在未来尝试PMI掩码。在微调阶段,

[MASK] token从未出现过,我们建议使用similar word来进行掩码,而不是用[MASK] token进行掩码。similar word是通过使用同义词工具包Synonyms toolkit(https://github.com/huyingxi/Synonyms)来获得的,它是基于word2vec的相似性来计算。如果选择了一个N-gram进行掩码,我们会对每个被掩码的单词寻找similar word。在极少数情况下,当没有

similar word时,我们会退化到使用random word来替换。这种random word替换被限制在不超过所有待掩码的token的10%。similar word的token数量与原始单词的token数量不一致,怎么解决?例如,原始单词为player,它的token为[play, #er];similar word为participant,它的token为['participant']。这种纠错的方式可以视为对输入加噪音的一种,可以用于

BART的预训练任务。遵从以前的工作,我们使用

15%的输入词进行掩码,其中80%的token被替换成similar word,10%的token被替换成random word,其余10%的token保持原词。此外,所有这

15%的输入词中,对于word-level的unigram, 2-gram, 3-gram, 4-gram的掩码比例分别为40%, 30%, 20%, 10%。

Sentence Order Prediction:BERT中最初的next sentence prediction: NSP任务被认为对模型来说太容易了,人们已经证明它不是那么有效(Roberta原始论文、ALBERT原始论文)。在本文中,我们采用了由ALBERT引入的sentence order prediction: SOP任务,该任务被证明比NSP更有效。正样本是通过使用两个连续的文本创建的,而负样本是通过交换它们的原始顺序创建的。我们在实验部分中消融这些修改,以更好地展示每个组成部分的贡献。神经架构

Neural Architecture:正式地,给定两个序列我们首先通过拼接两个序列来构建输入序列

然后,

MacBERT通过一个embedding layer(由word embedding, positional embedding, token type embedding组成)和transformer将contextualized representationtoken type embedding就是segment embedding。我们只需要预测被

Mac任务替代的position,在得到contextual representationreplaced position有关的子集,形成replaced representationreplaced token的数量。根据Mac任务的定义,然后我们将

vocabulary space中,从而预测在整个词表BERT实现,我们也使用word embedding矩阵embedding维度和隐层维度是相同的:其中:

replaced representation;然后我们使用标准的交叉熵损失来优化预训练任务:

其中:

1,否则为0。replaced token的ground truth。replaced token为

对于

SOP任务,我们直接使用[CLS] token的contextual representation,也就是label prediction layer:其中:

我们也使用交叉熵损失来优化

SOP预训练任务。最后,整体训练损失是

Mac损失和SOP损失的组合:这里是否需要用超参数

22.2 实验

22.2.1 实验配置

数据处理:我们使用

Wikipedia dump(截至2019年3月25日),并按照BERT原始论文的建议用WikiExtractor.py进行预处理,结果有1307个extracted files。我们在这个dump中同时使用了简体中文和繁体中文,并没有将繁体中文部分转换成简体中文。我们在实验部分展示了在繁体中文任务中的有效性。在清理原始文本(例如去除html tag)以及分离文件之后,我们得到了大约0.4B单词。由于

Chinese Wikipedia的数据相对较少,除了Chinese Wikipedia,我们还使用扩展的训练数据来训练这些预训练语言模型(模型名称中标有ext)。内部收集的扩展数据包含百科全书encyclopedia、新闻、以及问答网络question answering web,有5.4B单词,比Chinese Wikipedia大十倍以上。请注意,对于MacBERT我们总是使用扩展数据,并省略ext标记。为了识别全词掩码的中文单词的边界,我们使用

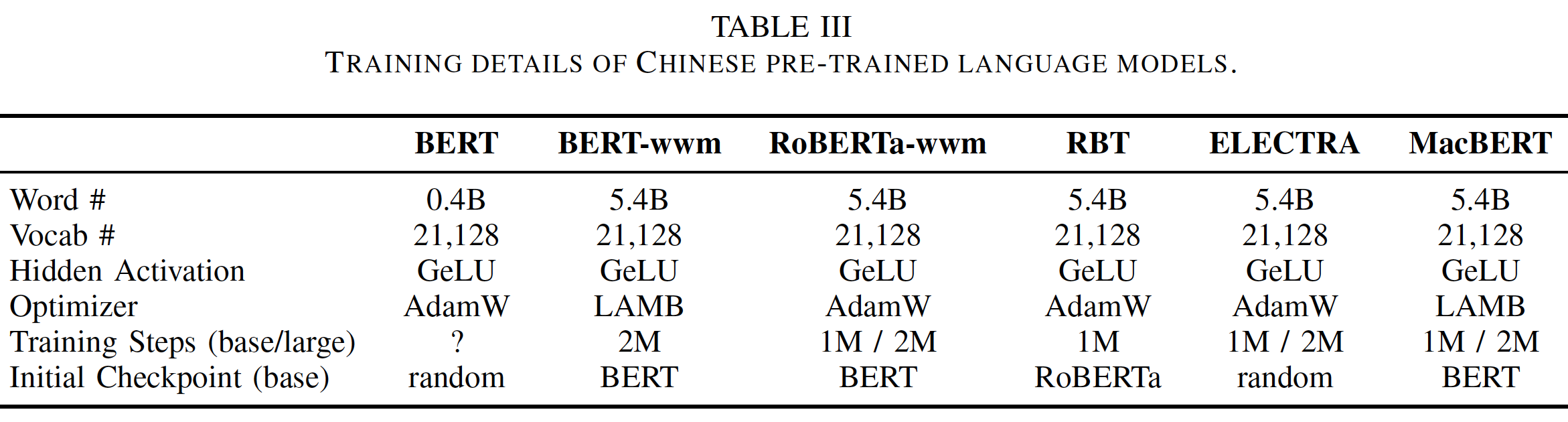

LTP进行中文分词。我们使用BERT原始论文提供的create_pretraining_data.py将原始输入文本转换为预训练样本。预训练语言模型的配置:为了更好地从现有的预训练好的语言模型中获取知识,我们没有从头开始训练我们的

base-level model,而是从官方的Chinese BERT-base开始,继承其词表vocabulary和模型权重。然而,对于large-level model,我们必须从头开始训练,但仍然使用base-level model提供的相同词表。base-level model是一个12层的transformer,隐层维度为768。- 而

large-level model是一个24层的transformer,隐层维度为1024。

对于训练

BERT series,我们采用了BERT所建议的方案:预训练开始时选择最大序列长度为128个token,然后选择最大序列长度为512个token。然而,我们根据实验发现,这导致对长序列任务(如阅读理解任务)的适应性adaptation不足。在这种情况下,对于BERT以外的模型,我们直接在整个预训练过程中使用512的最大长度,这在Roberta中被采用。对于较小的

batch size,我们采用BERT中原始的、带权重衰减的ADAM优化器进行优化。对于较大的batch size,我们采用LAMB优化器以获得更好的scalability。预训练是在单个Google Cloud TPU v3-8(相当于单个TPU)或TPU Pod v3-32(相当于4个TPU)上进行的,这取决于模型的规模。具体而言,对于MacBERT-large,我们训练了2M步,batch size = 512,初始学习率为1e-4。训练细节如下表所示。为了简洁,我们没有列出

'ext'模型,其中'ext'模型的超参数与没有在扩展数据上训练的模型相同。

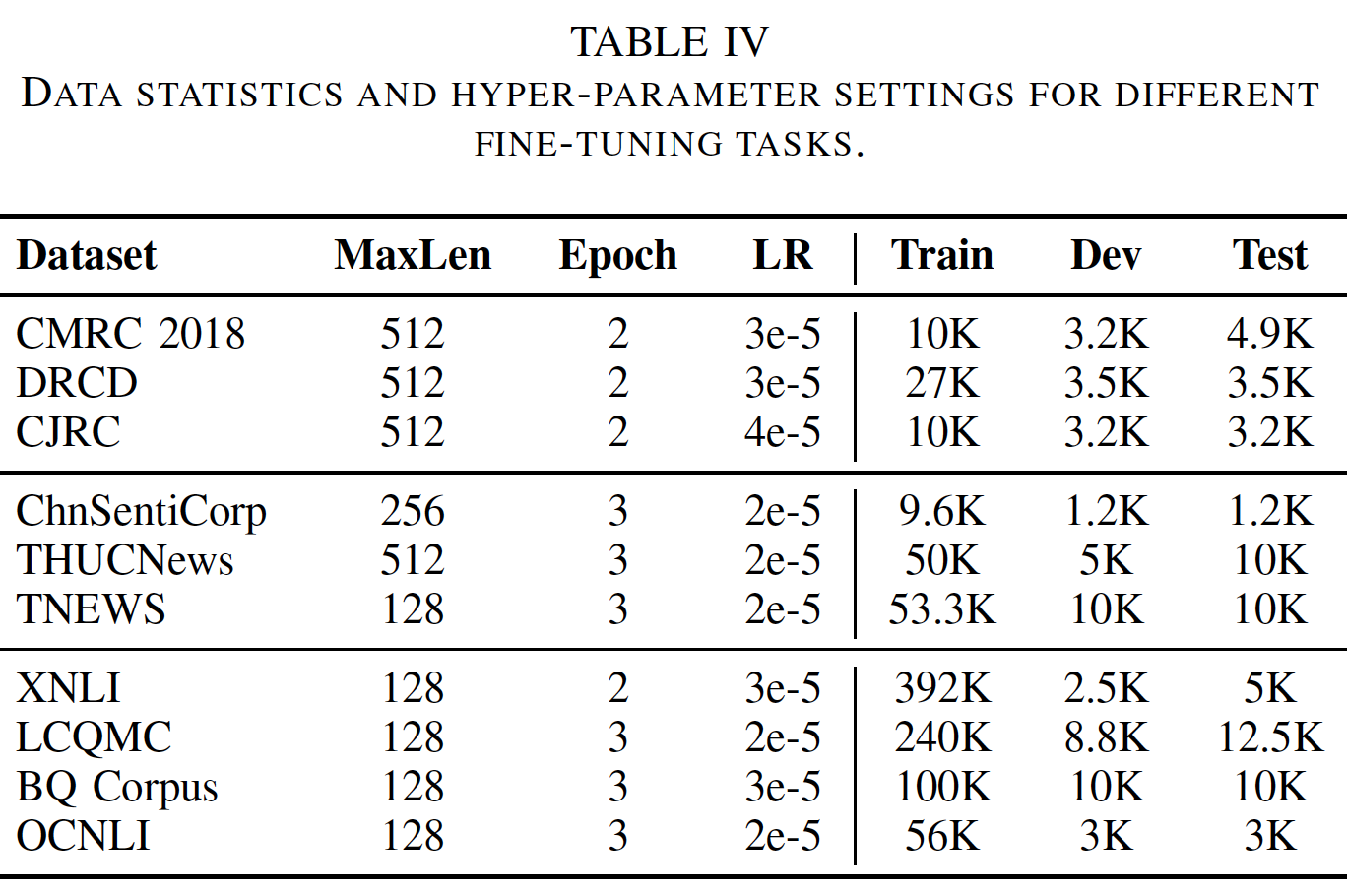

微调任务的配置:为了彻底测试这些预训练语言模型,我们对各种自然语言处理任务进行了广泛的实验,涵盖了广泛的文本长度,即从

sentence-level到document-level。任务细节如下表所示。具体而言,我们选择了如下十个流行的中文数据集:- 机器阅读理解

Machine Reading Comprehension: MRC:CMRC 2018, DRCD, CJRC。 - 单句分类

Single Sentence Classification: SSC:ChnSentiCorp, THUCNews, TNEWS。 - 句子对分类

Sentence Pair Classification: SPC:XNLI, LCQMC, BQ Corpus, OCNLI。

为了进行公平的比较,对于每个数据集,我们保持相同的超参数(如最大序列长度、

warm-up步数等),只对每个任务的初始学习率调优 (从1e-5到5e-5)。请注意,初始学习率是在原始的Chinese BERT上调优的,通过对每个任务独立地调优学习率,有可能实现另一种增益。我们将相同的实验运行十次,以确保结果的可靠性。最佳的初始学习率是通过选择最佳的平均验证集性能来确定的。我们报告最高分和平均分,从而同时评估峰值性能和平均性能。除了TNEWS和OCNLI的测试集没有公开,我们同时报告验证集和测试集的结果。注意,这里是用于微调任务的超参数,与预训练任务的超参数有所差异。

对于除

ELECTRA以外的所有模型,我们对每个任务使用相同的初始学习率设置,如下表所示。对于ELECTRA模型,我们按照ELECTRA原始论文的建议,对base-level model使用1e-4的通用初始学习率,对large-level model使用5e-5的通用初始学习率。由于现有的各种中文预训练语言模型,如

ERNIE, ERNIE 2.0, NEZHA的预训练数据有很大的不同,我们只对BERT, BERT-wwm, BERT-wwm-ext, RoBERTa-wwm-ext, RoBERTa-wwm-ext-large, ELECTRA以及我们的MacBERT进行比较,从而保证不同模型之间相对公平的比较。其中,除了原始的Chinese BERT,所有模型都由我们自己训练。我们在TensorFlow框架下进行了实验,并对BERT原始论文提供的微调脚本进行了轻微改动,以更好地适配中文任务。

- 机器阅读理解

22.2.2 实验结果

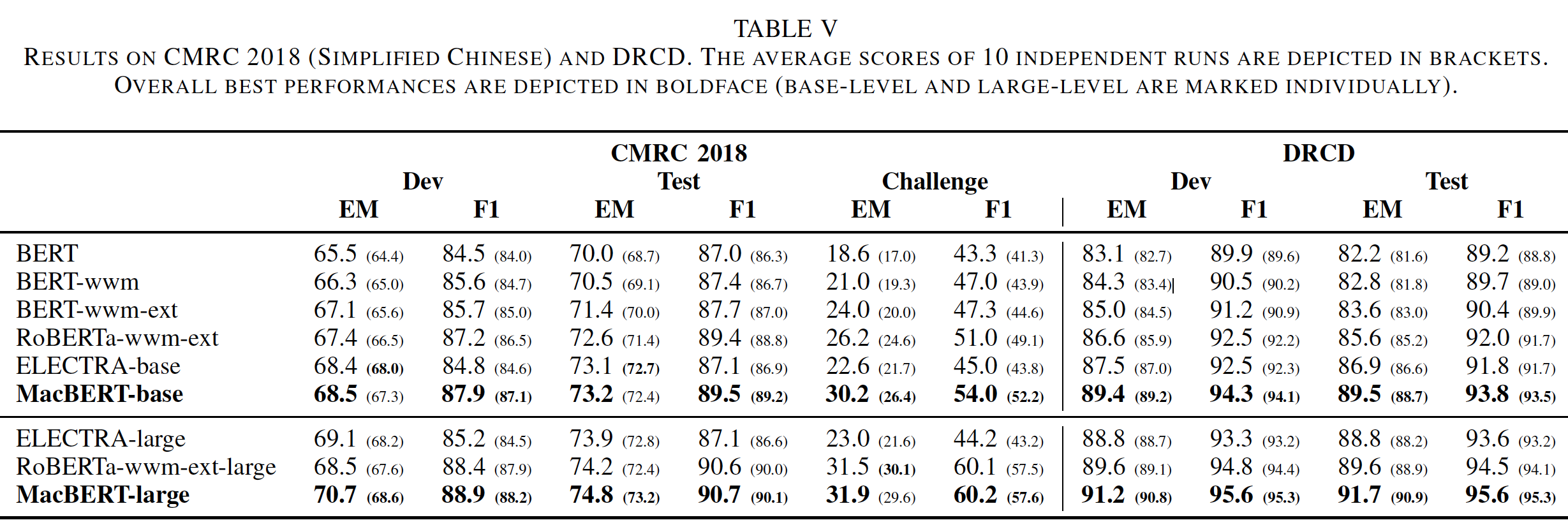

机器阅读理解:机器阅读理解是一项有代表性的

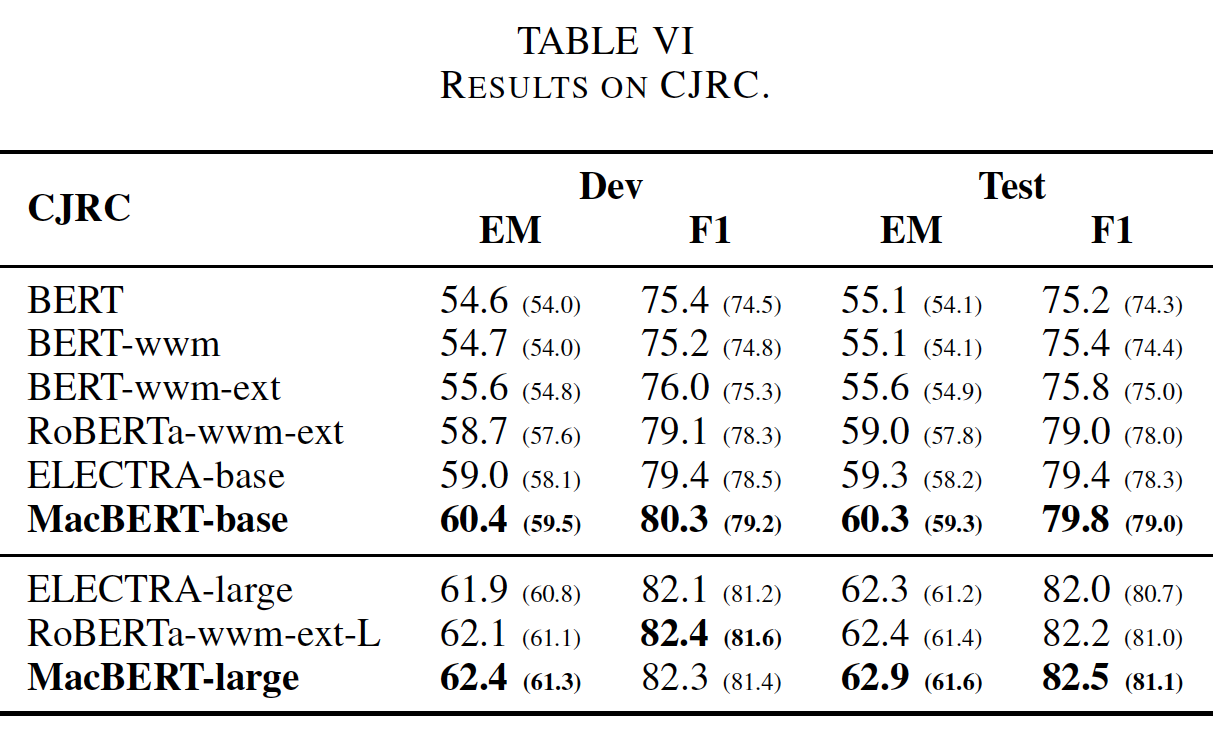

document-level建模任务,要求根据给定的段落回答问题。我们主要在三个数据集上测试这些模型:CMRC 2018, DRCD, CJRC。CMRC 2018:一个span-extraction的机器阅读理解数据集,与SQuAD类似,为给定的问题抽取一个passage span。DRCD:这也是一个span-extraction的机器阅读理解数据集,但是是繁体中文。CJRC:类似于CoQA,它有yes/no question、没有答案的问题、以及span-extraction question。该数据收集自中国的法律判决文件。注意,我们只使用small-train-data.json进行训练。

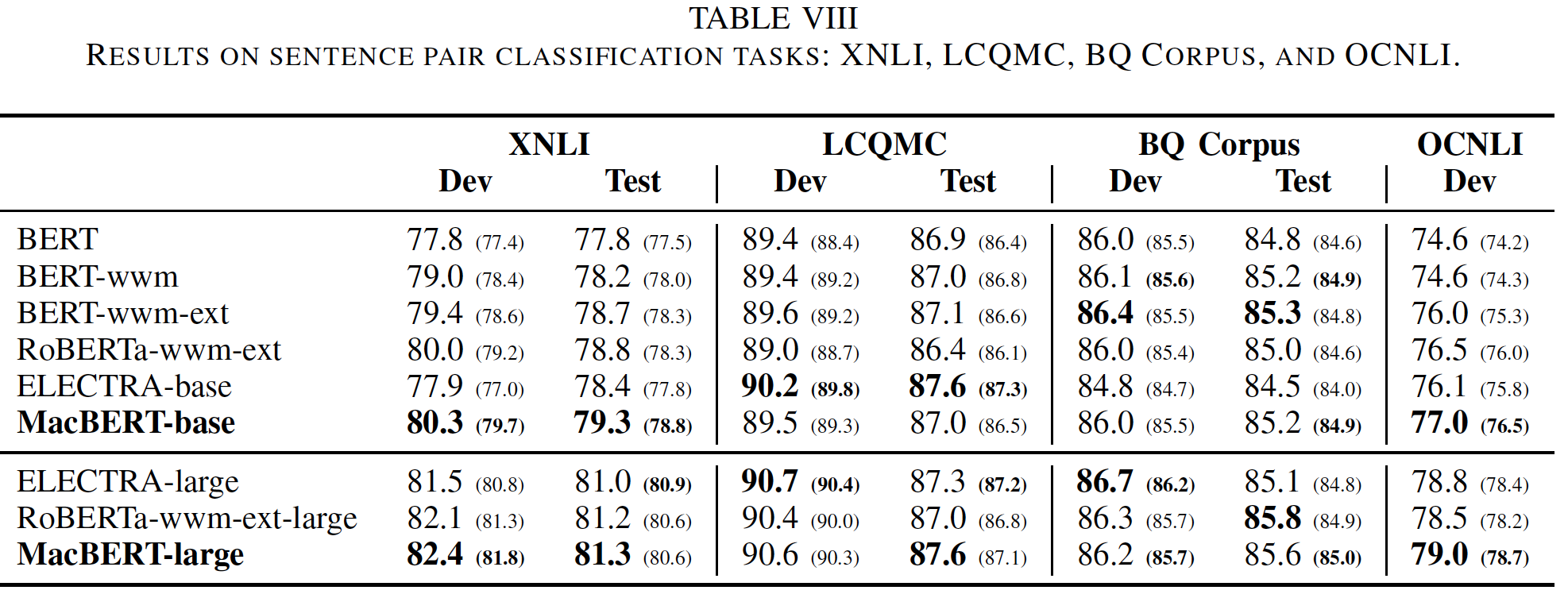

结果如下表所示。可以看到:

使用额外的预训练数据会带来进一步的改进,如

BERT-wwm和BERT-wwm-ext之间的比较所示。这就是为什么我们对RoBERTa、ELECTRA和MacBERT使用扩展数据。注意,

MacBERT默认就使用了扩展数据。此外,所提出的

MacBERT在所有阅读理解数据集上都产生了显著的改进。值得一提的是,我们的MacBERT-large可以在CMRC 2018的Challenge集合上实现SOTA的F1,即60%,这需要更深入的文本理解。此外,应该注意的是,虽然

DRCD是一个繁体中文数据集,但用额外的大规模简体中文进行训练也会有很大的积极作用。由于简体中文和繁体中文有许多相同的字符,使用带有少量繁体中文数据的一个强大的预训练语言模型也可以带来改进,而不需要将繁体中文字符转换为简体字符。关于

CJRC,其中文本是以关于中国法律的专业方式写成的,BERT-wwm比BERT显示出适度的改进,但不是那么突出,表明在非通用领域的微调任务中需要进一步的领域适应domain adaptation。然而,增加通用的预训练数据会导致改善,这表明当没有足够的领域数据domain data时,我们也可以使用大规模的通用数据作为补救措施。

这里没有

BERT-large的数据,因为BERT官方未提供。根据论文的说明,MacBERT-base是用预训练好的BERT-base来初始化的,这相当于MacBERT-base比BERT-base训练更长的时间,因此它的效果更好,也就不足为奇。

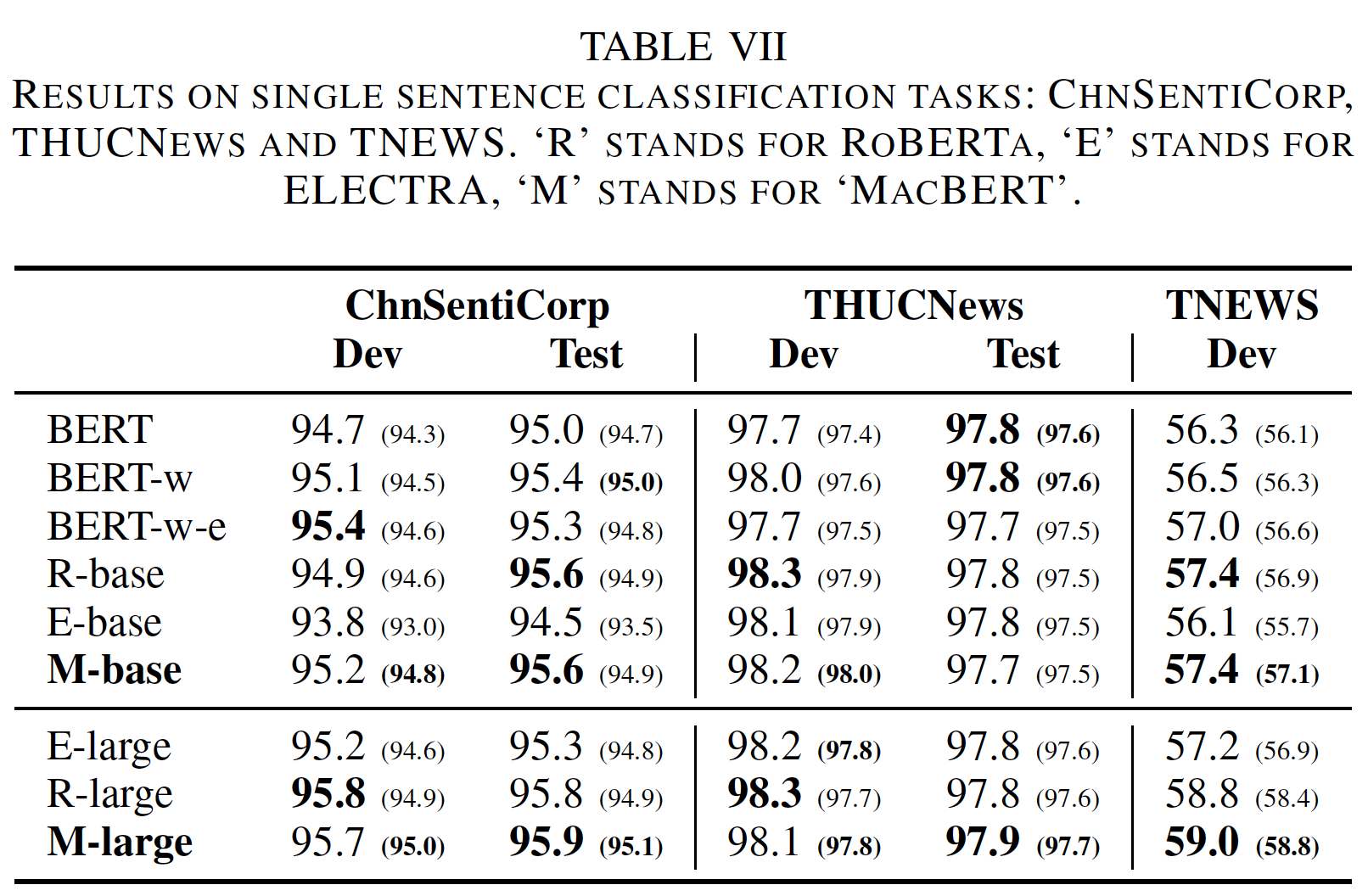

单句分类:对于单句分类任务,我们选择

ChnSentiCorp, THUCNews, TNEWS数据集:ChnSentiCorp用于评估情感分类,其中文本应该被划分为正面或负面的label。THUCNews是一个包含不同类型的新闻的数据集,其中的文本通常很长。在本文中,我们使用了一个包含10个领域(均匀分布)的50K个新闻的版本,包括体育、金融、技术等等领域。TNEWS是一个由新闻标题和关键词组成的短文本分类任务,要求分类到15个类别中的一个。

结果如下表所示。可以看到:

MacBERT可以在ChnSentiCorp和THUCNews中比baseline有适度的改进,即使这些数据集已经达到了很高的准确率。- 在

TNEWS中,MacBERT在base-level和large-level预训练语言模型中产生了一致的改进。

句子对分类:对于句对分类任务,我们使用了

XNLI数据(中文部分)、Large-scale Chinese Question Matching Corpus : LCQMC、BQ Corpus、以及OCNLI,这些数据需要输入两个序列并预测它们之间的关系。结果如下表所示。可以看到:在

XNLI和OCNLI中,MacBERT比baseline产生了相对稳定和显著的改进。然而,MacBERT在LCQMC和BQ Corpus上仅仅显示了适度的改进,平均得分略有提高,但峰值性能不如RoBERTa-wwm-ext-large。我们怀疑这些任务对输入的细微差别的敏感性不如阅读理解任务。由于

sentence pair classification只需要生成整个输入的unified representation,因此导致了适度的改进。机器阅读理解任务的改进比分类任务更大,这可能归因于掩码策略。在机器阅读理解任务中,模型应该识别段落中的

exact answer span。在MacBERT中, 每个N-gram单词都被其同义词或一个随机词所取代,因此每个词都可以很容易地被识别,这迫使模型学习word boundary。这里的解释比较苍白,原因没有讲清楚。

MacBERT-base通常比MacBERT-large产生更大的改进。这可能是由两个原因造成的。- 首先,

MacBERT-base是由BERT-base初始化的,它可以从BERT-base的知识中受益,并避免冷启动的问题。 - 其次,

large-level预训练语言模型的结果通常高于base-level预训练语言模型的结果,因此获得更高的分数要比base-level预训练语言模型困难得多。

- 首先,

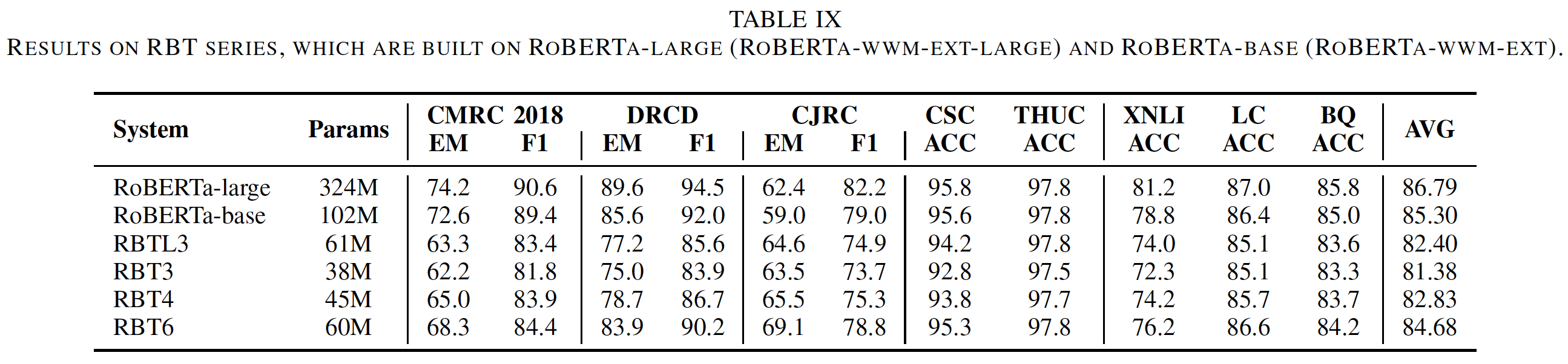

小模型的结果:我们还建立了一系列的小模型,即

RBT,建立在RoBERTa-base或RoBERTa-large模型上。实验结果如下表所示。可以看到:- 小模型的表现比一般模型(

base-level, large-level)更差,因为它们使用的参数较少。 - 分类任务的性能下降比阅读理解任务要小,说明可以牺牲微小的性能来获得更快、更小的模型,这对现实生活中的应用是有益的。

- 通过比较参数大小相似的

RBTL3和RBT6,我们可以看到RBT6的性能大大优于RBTL3,这表明窄而深的模型通常优于宽而浅的模型。

这些观察结果对未来实际应用中的模型设计是有帮助的。

- 小模型的表现比一般模型(

22.3 讨论

- 根据实验结果,我们可以看到:这些预训练的语言模型在中文任务中也比传统的

BERT有明显的改进,这表明它们的有效性和通用性。虽然我们的模型在各种中文任务中取得了显著的改进,但我们想知道这些改进的基本组件essential component来自哪里。为此,我们在MacBERT上进行了详细的消融研究从而证明其有效性。此外,我们还比较了现有的预训练语言模型在英语中的声明claim,看看它们的修改在另一种语言中是否仍然成立。

22.3.1 MacBERT 的有效性

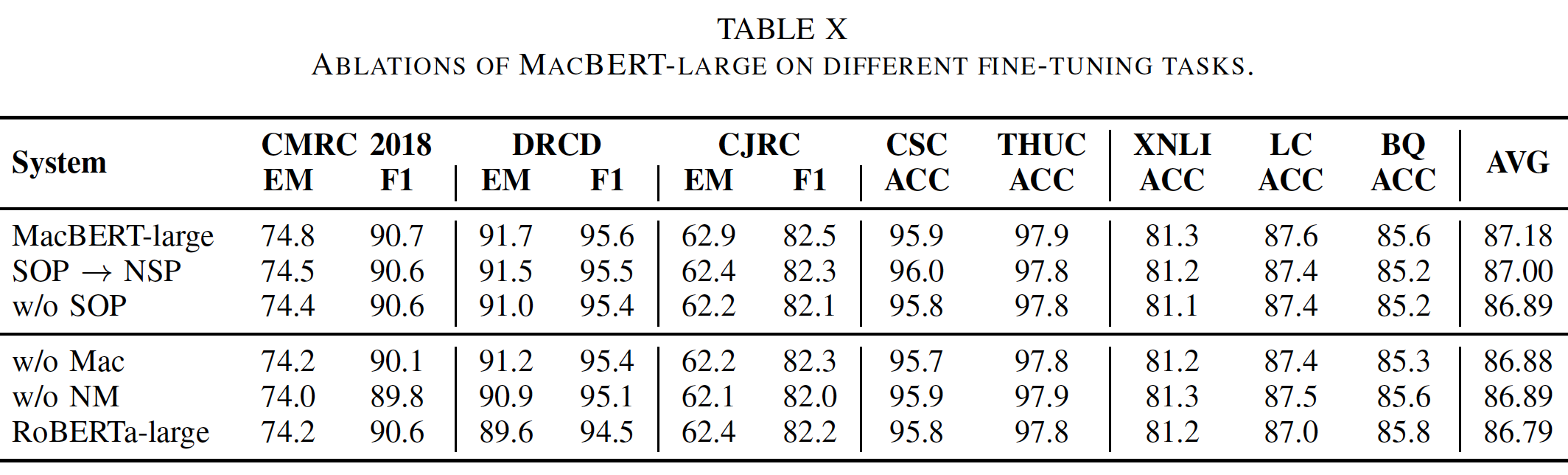

我们进行了详细的消融研究,以检查

MacBERT中每个组件的贡献。结果如下表所示。总的平均分数是通过平均每个任务的测试分数得到的。w/o表示without。可以看到:总体而言,删除

MacBERT中的任何组件都会导致平均性能的下降,这表明所有的修改都有助于整体改进。具体而言,最有效的修改是

N-gram masking和similar word替换,这是对masked language model: MLM任务的修改。当我们比较N-gram masking和similar word替换时,我们可以看到明显的优点和缺点,其中:N-gram masking似乎在文本分类任务中更有效(以ACC为指标的任务),而阅读理解任务的表现似乎更受益于similar word替换任务。将这两个任务结合起来可以相互弥补,在两种任务上都有更好的表现。数据不支持这里的结论。

N-gram masking: NM、similar word替换、以及SOP的贡献都相差无几(缺少它们,导致平均准确性都在86.89附近)。此外,不同组件对于不同任务,也没有看出特别突出的贡献。next sentence prediction: NSP任务没有显示出像MLM任务那样的重要性,这表明设计一个更好的MLM任务来充分释放文本建模的能力更为重要。此外,我们还比较了

next sentence prediction任务和sentence order prediction任务,以更好地判断哪一个任务更强大。结果显示,sentence order prediction任务确实比原来的next sentence prediction任务表现得更好,尽管它不是那么突出。sentence order prediction任务要求识别两个句子的正确顺序,而不是使用一个随机的句子,这对机器来说更容易识别。与文本分类任务相比,在阅读理解任务中去掉sentence order prediction任务会导致性能明显下降,这表明有必要设计一个类似next sentence prediction的任务来学习两个segment之间的关系(例如,阅读理解任务中的段落和问题)。

点评:本文创新力不足,感觉更像是一个工程实现的报告而已。

22.3.2 MLM 任务上的调研

如上一节所示,最主要的预训练任务是

masked language model及其变体。masked language model任务依赖于两个方面:选择要被掩码的token、替换被选中的token。在上一节中,我们已经证明了选择

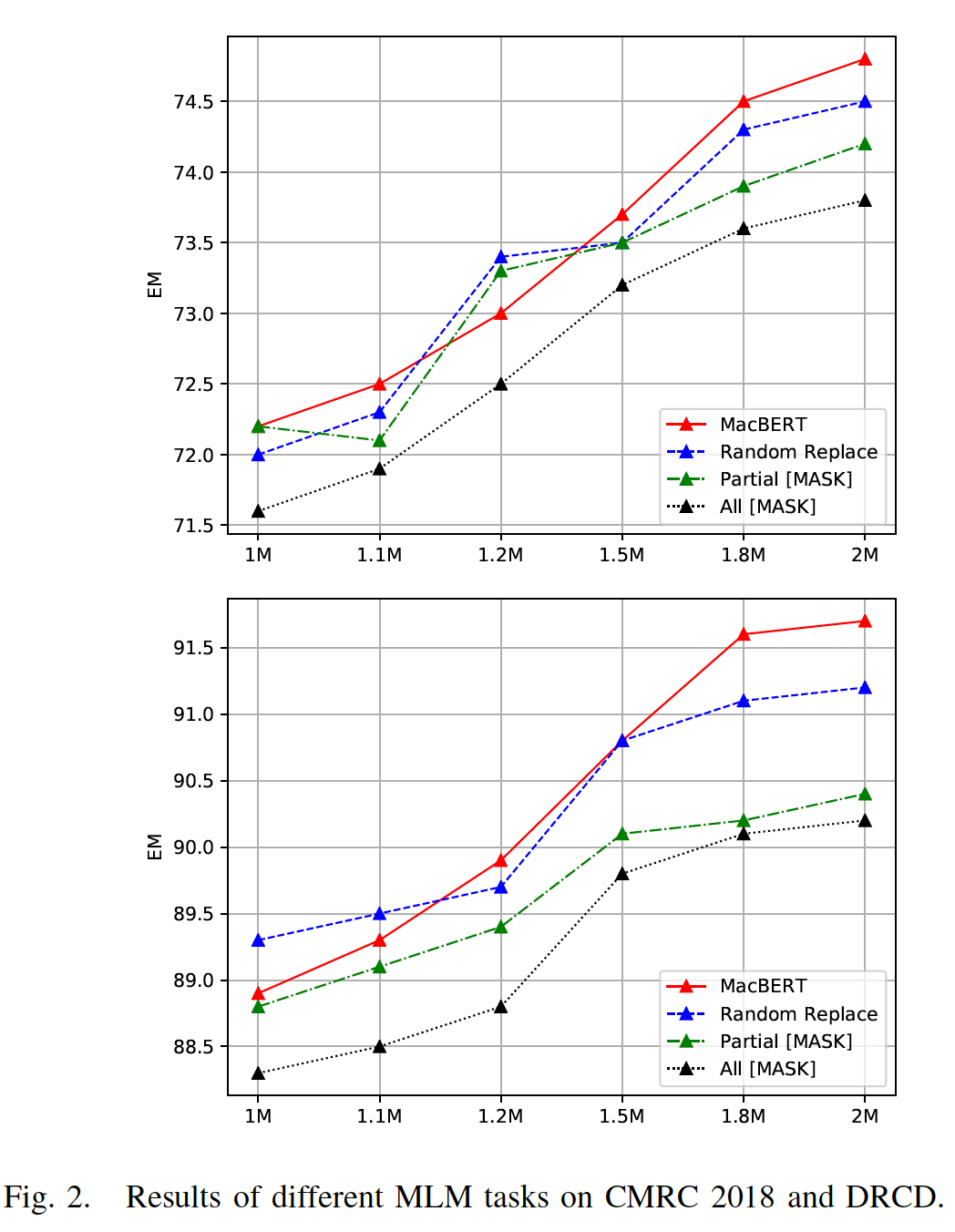

masking token的有效性,如全词掩码或N-gram masking等。现在我们要研究的是:所选中token的替换对预训练语言模型的性能有何影响。为了研究这个问题,我们绘制了不同预训练步数下

CMRC 2018和DRCD的性能。具体而言,我们遵从对输入序列的15%的原始掩码比例,其中10% masked token保持不变。对于剩下的90% masked token,我们将其分为四类:MacBERT:80% masked token被替换为它们的similar word,10% masked token被替换为随机的单词。Random Replace:90% masked token被替换为随机的单词。Partial Mask:原始的BERT实现,80% masked token被替换为[MASK],10% masked token被替换为随机的单词。All Mask:90% masked token被替换为[MASK]。

我们仅绘制了从

1M步到2M步的结果,如下表所示。可以看到:主要依靠使用

[MASK]进行掩码的预训练模型(即partial mask和all mask)导致了更差的性能,表明预训练和微调的差异是一个实际问题,该问题影响整体性能。在

partial mask和all mask中,我们还注意到,如果不保留10%的original token(即恒等映射),也会出现一致的下降。这表明完全使用[MASK] token的掩码的鲁棒性更差。令我们惊讶的是,完全放弃

[MASK] token,而是将所有90% masked token替换成随机的单词,产生了比[MASK]-dependent的掩码策略更一致的改进。这也强化了这样的说法:依靠[MASK] token的原始掩码方法导致了更差的性能,因为[MASK] token在微调任务中从未出现过。另外,使用随机单词而不是人工的

[MASK] token可以提高预训练模型的降噪能力,这可能也是一个原因。为了使这个问题更加精细,在本文中,我们提出使用

similar word来进行掩码,而不是一个随机的单词。因为随机的单词不符合上下文,可能会破坏语言模型学习的自然性naturalness,因为传统的N-gram语言模型是基于自然的句子,而不是一个被操纵的句子。然而,如果我们使用similar word来进行掩码,句子的流畅性就比使用随机单词要好得多,整个任务就转化为一个语法纠正任务grammar correction task,这就更自然了,而且没有预训练阶段和微调阶段的差异。从下图中中我们可以看出,

MacBERT在四个变体中产生了最好的性能,这验证了我们的假设。如果要追求自然性,那么自回归语言模型要比带噪音的双向语言模型更有利。

22.3.3 中文拼写检查上的分析

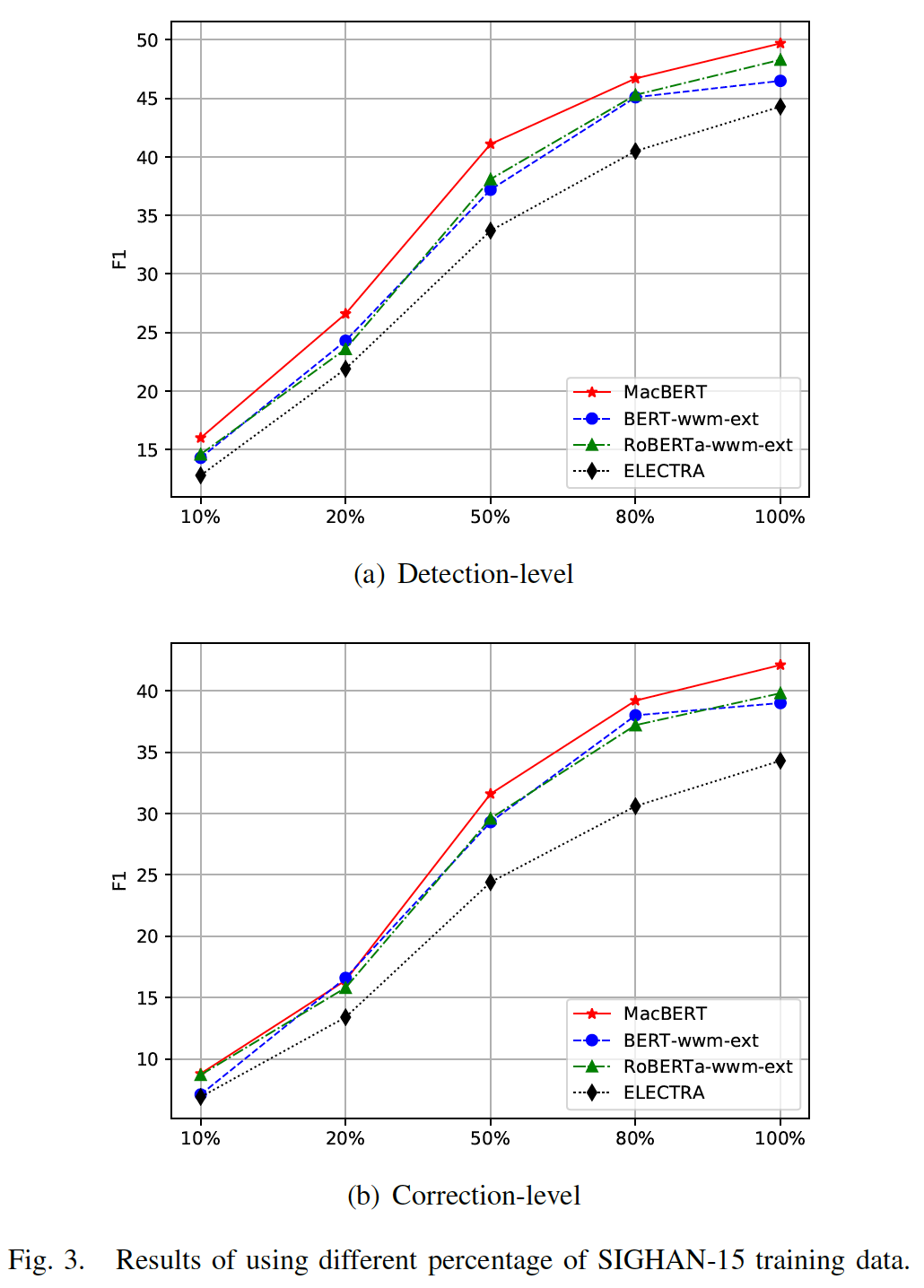

MacBERT引入了'MLM as correction'任务,这与实际的语法或拼写错误校正任务相似。我们对中文拼写检查Chinese Spell Check任务进行了额外的实验。我们使用SIGHAN-15数据集来探索使用不同比例的训练数据时不同预训练语言模型的效果。SIGHAN-15包括一个训练集(3.1K实例)和一个测试集 (1.1K实例)。我们在这个实验中比较了BERT-wwm-ext, RoBERTa-wwm-ext, ELECTRA-base, MacBERT-base,因为它们共享相同的预训练数据。我们对每个模型进行了五次微调,并绘制了平均F1(sentence-level)。我们使用5e-5的通用学习率,训练5个epoch,batch size = 64。结果如下图所示,其中包括detection-level分、correction-level分。可以看到:当使用不同比例的训练数据时,

MacBERT比其他模型产生了一致的改进,这表明MacBERT是有效的和scalable的。我们注意到

ELECTRA在这项任务上表现不佳。具体而言,ELECTRA和其他模型的结果,在correction-level的差距相对于detection-level的差距更大。ELECTRA使用replaced token detection: RTD任务来训练判别器(判别器将用于微调)。然而,RTD任务只需要识别输入token是否被改变,而不需要预测original token,我们认为这很简单。相反,MLM任务和Mac任务的目标需要同时identify-and-correction。通过比较

MLM和Mac,我们的MacBERT缓解了预训练和微调之间差异的问题,这产生了另一个重要的收益。虽然

Mac任务与拼写检查任务相似,但我们只使用同义词进行替换,这在真正的拼写检查任务中仅占很小的比例。这可以解释为什么当可用的训练数据较少时,我们的模型没有产生比其他模型更大的改进。

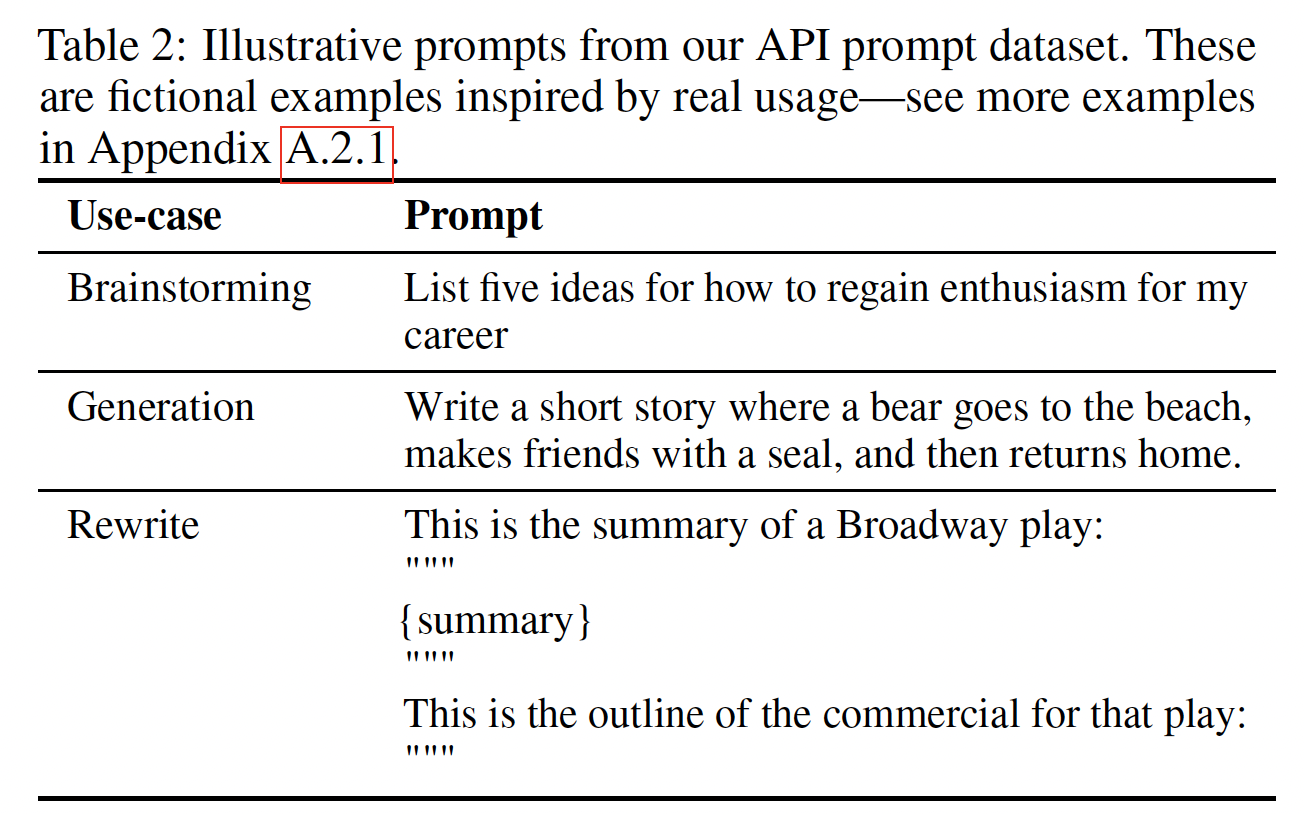

二十三、Fine-Tuning Language Models from Human Preferences [2019]

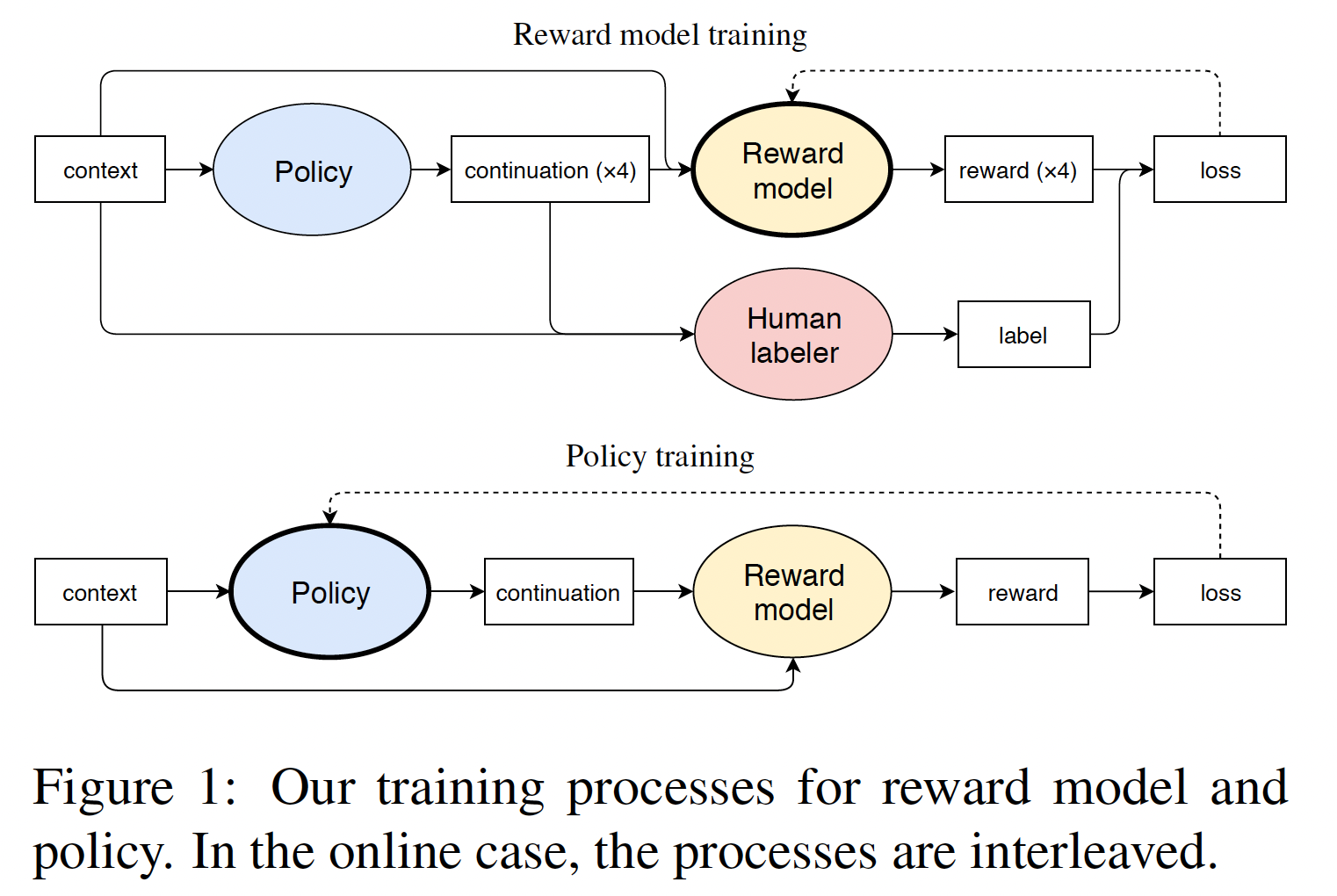

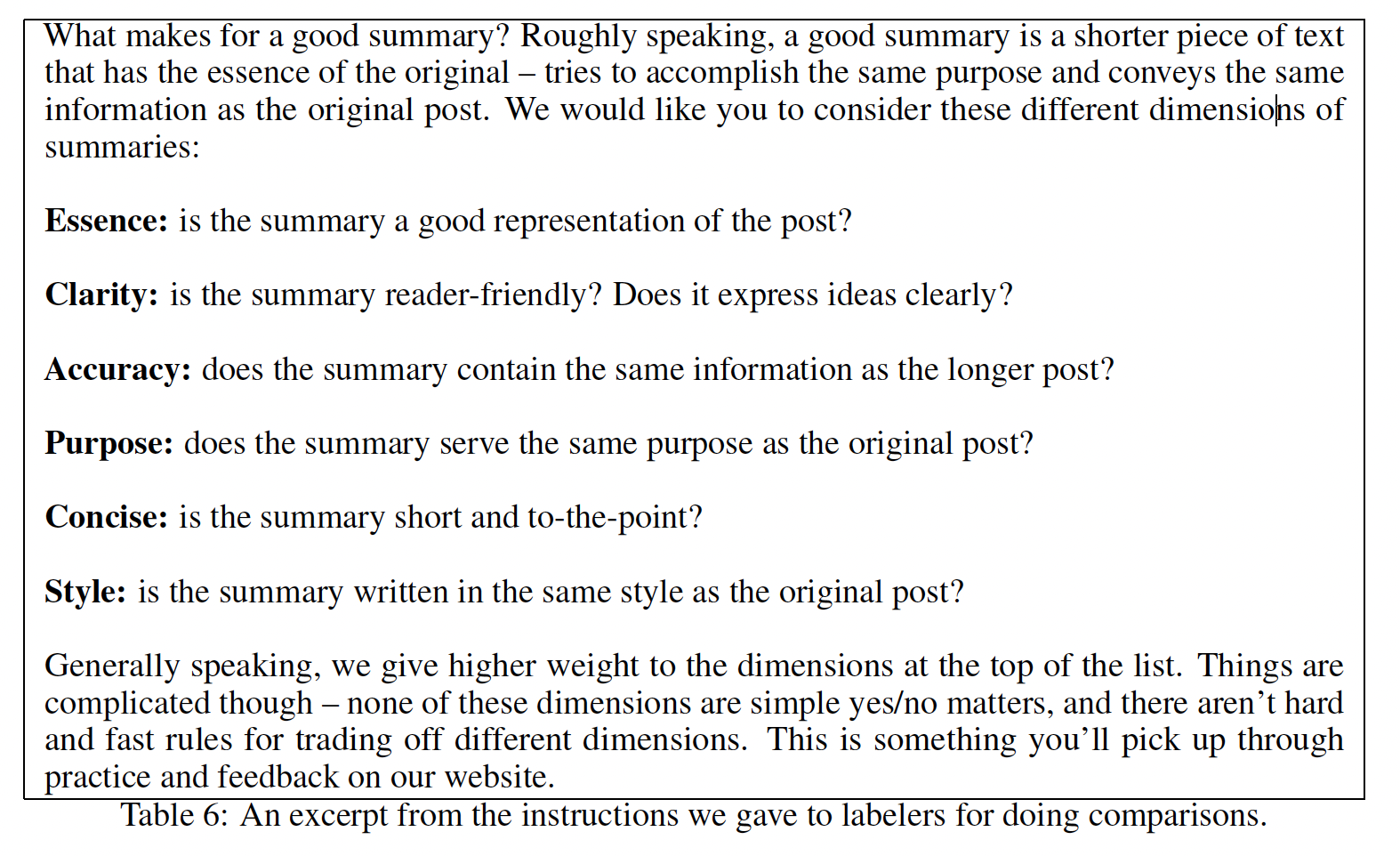

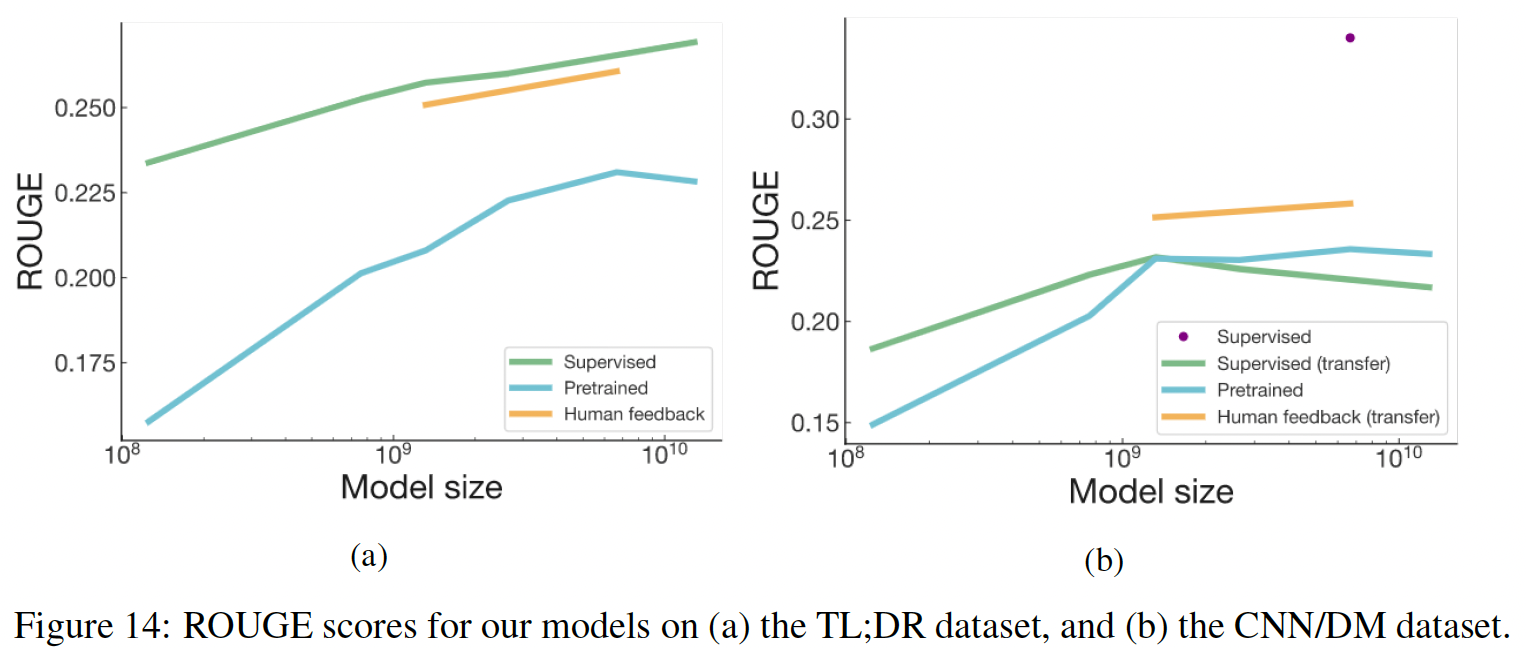

我们希望将强化学习应用于仅由

human judgment所定义的复杂的任务,对于该任务我们只能通过询问人类来判断一个结果是好还是坏。要做到这一点,我们可以首先使用human labels来训练一个奖励模型reward model,然后优化这个模型。虽然通过互动从人类那里学习这种模型的工作由来已久,但这项工作最近才被应用于现代深度学习,即使如此,也只被应用于相对简单的模拟环境simulated environments。相比之下,真实世界的setting(其中人类需要向AI agents指定复杂目标)很可能涉及并需要自然语言,其中自然语言是一种丰富的媒介来表达value-laden的概念。当agent必须与人类沟通从而帮助提供更准确的监督信号时,自然语言尤其重要。自然语言处理最近取得了实质性的进展。一种成功的方法是在无监督数据的语料库上预训练大型生成式语言模型,然后针对有监督的

NLP任务对模型进行微调。这种方法往往大大优于在监督数据集上从头开始的训练,并且在许多不同的监督数据集上,一个预训练的语言模型往往可以微调从而得到SOTA的性能。在某些情况下,不需要进行微调:GPT-2发现,生成式预训练的模型在没有额外训练的情况下(即,zero-shot)),在NLP任务上显示出合理的性能。有大量文献将强化学习应用于自然语言任务。这些工作大多使用算法定义的奖励函数

reward functions,如用于翻译的BLEU、用于摘要的ROUGE、music theory-based的奖励、或者用于故事生成的event detectors。《Reinforcement learning for bandit neural machine translation with simulated human feedback》在BLEU上使用强化学习,但应用了几个error models来近似human behavior。《Learning to extract coherent summary via deep reinforcement learning》以及《Towards coherent and cohesive long-formtext generation》从现有文本中学习了coherence model,并将其作为强化学习奖励分别用于摘要和长篇小说的生成。《Preference-based interactive multi-document summarisation》通过一次对一篇文章应用reward learning,建立了一个交互式的摘要工具。- 使用人类评价作为奖励的实验包括

《Reliability and learnability of human bandit feedback for sequence-to-sequence reinforcement learning》将off-policy的reward learning用于翻译、以及《Way off-policy batch deep reinforcement learning of implicit human preferences indialog》将《Sequence tutor: Conservative fine-tuning of sequence generation models with kl-control》修改后的Q-learning方法应用于对话中的隐式的human preferences。 《Towards coherent and engaging spoken dialog response generation using automatic conversation evaluators》从人类那里学习奖励来微调对话模型,但对奖励进行了平滑处理从而允许监督学习。- 我们参考

《A survey of reinforcement learning informed by natural language》对涉及语言作为一个组成部分的强化学习任务的综述,以及使用从语言迁移学习的强化学习结果。 - 强化学习并不是纳入持续的

human feedback的唯一方式。《Learning from dialogue after deployment: Feed yourself, chatbot!》询问人类关于对话系统应该说些什么,然后继续监督训练。

在论文

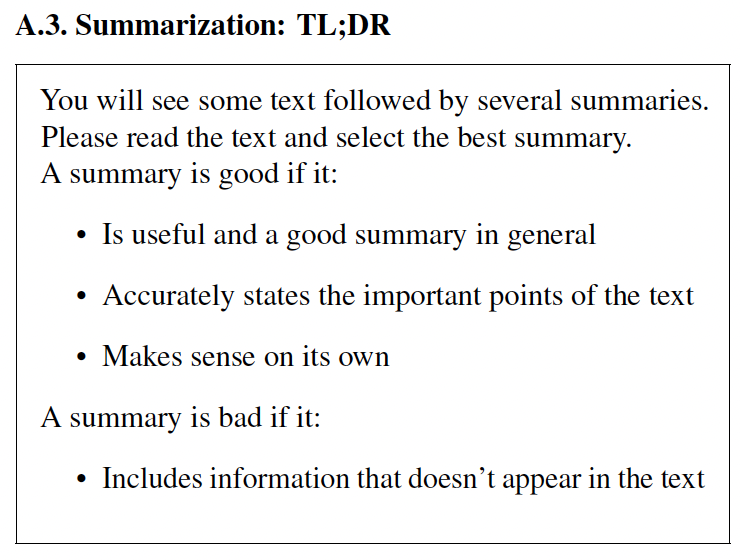

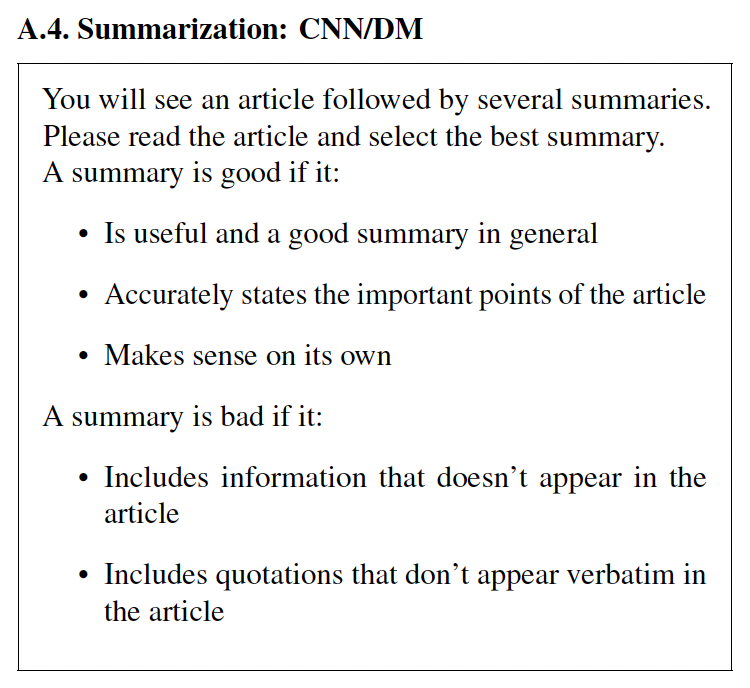

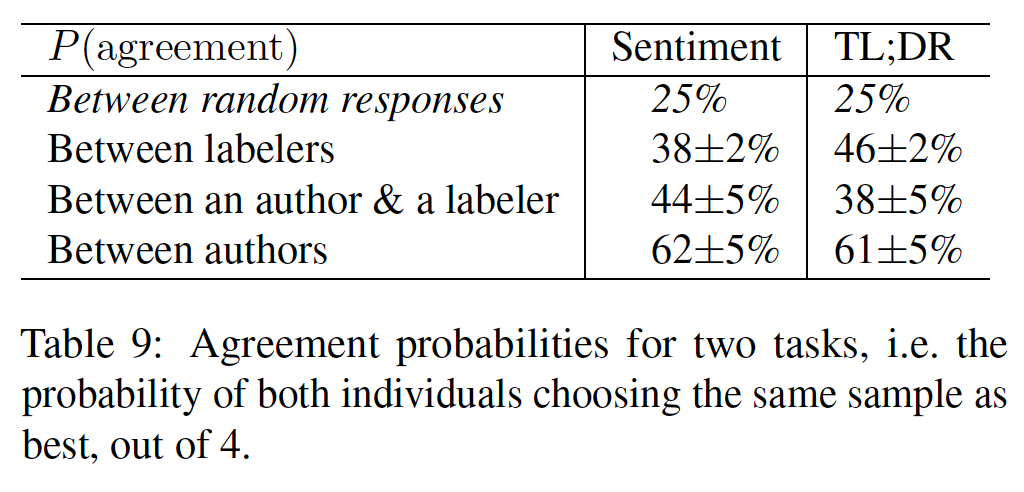

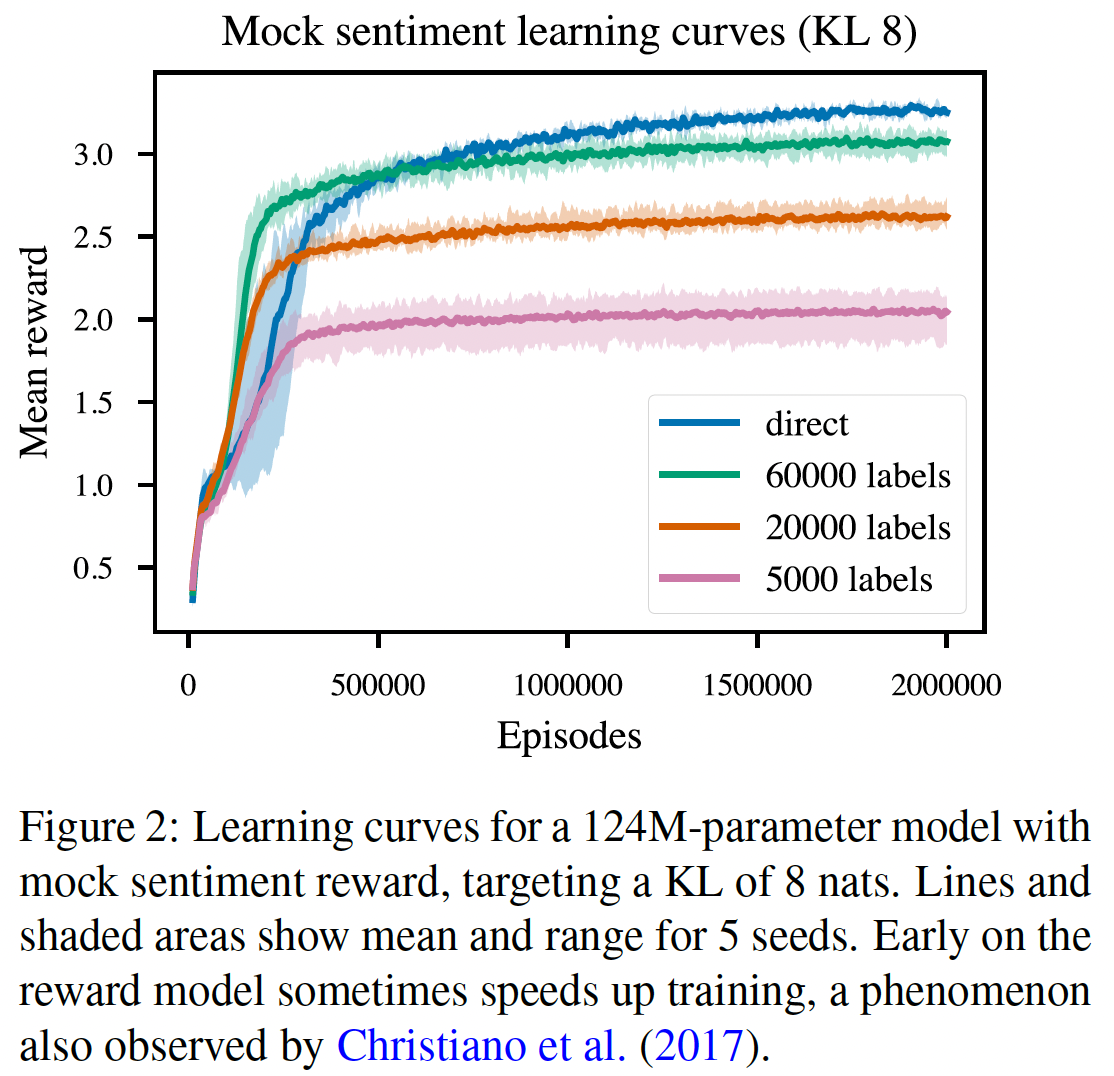

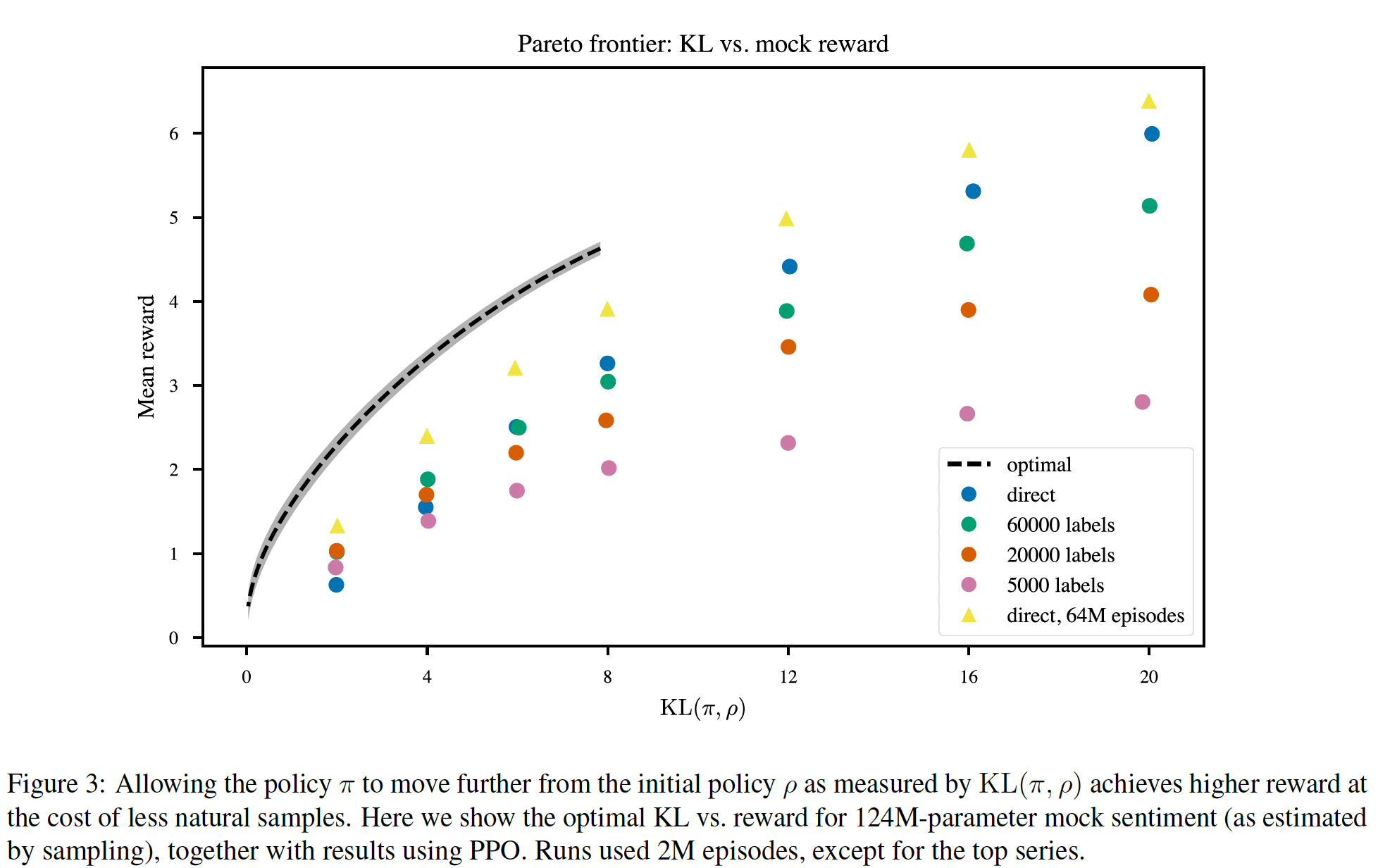

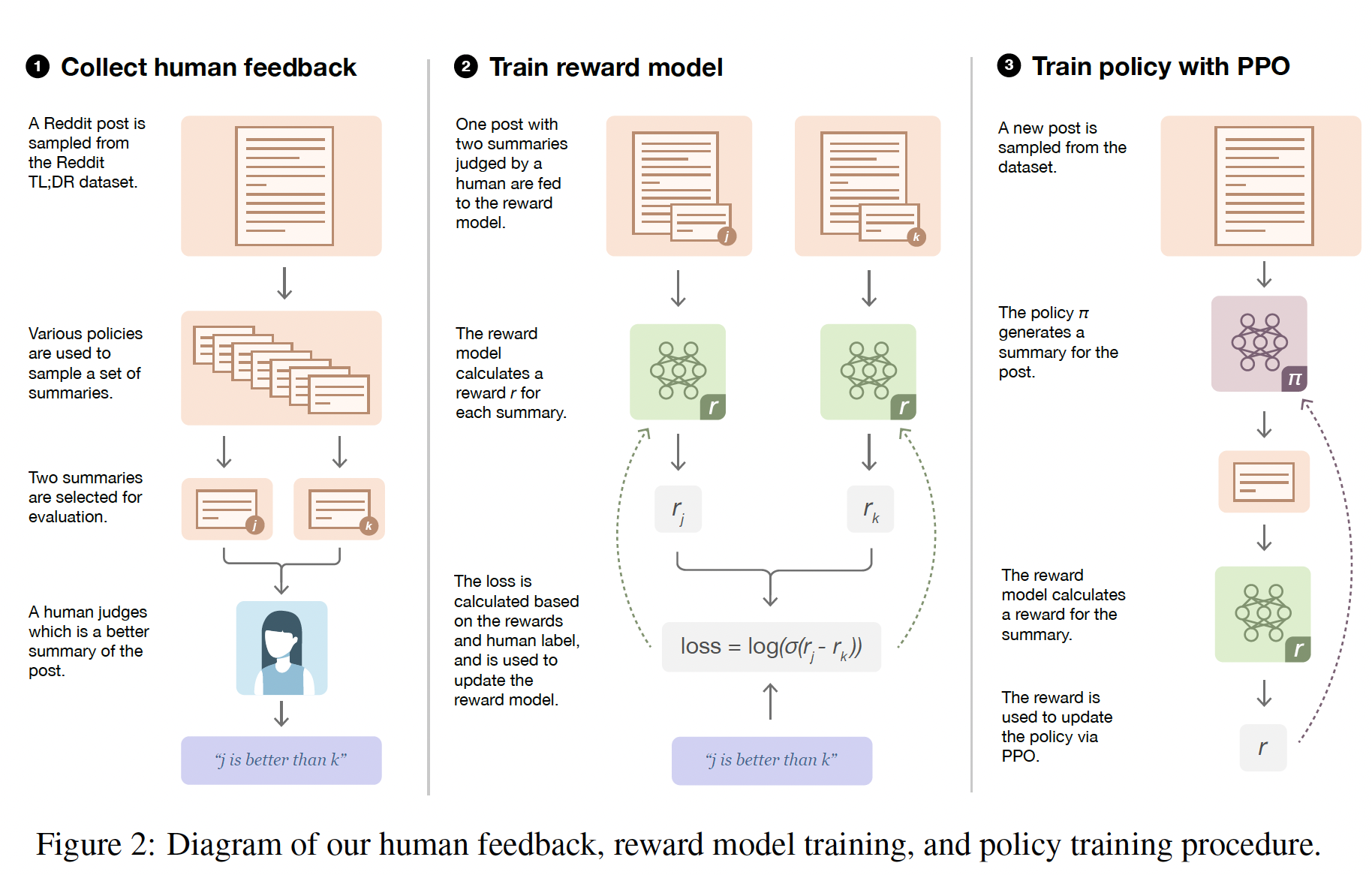

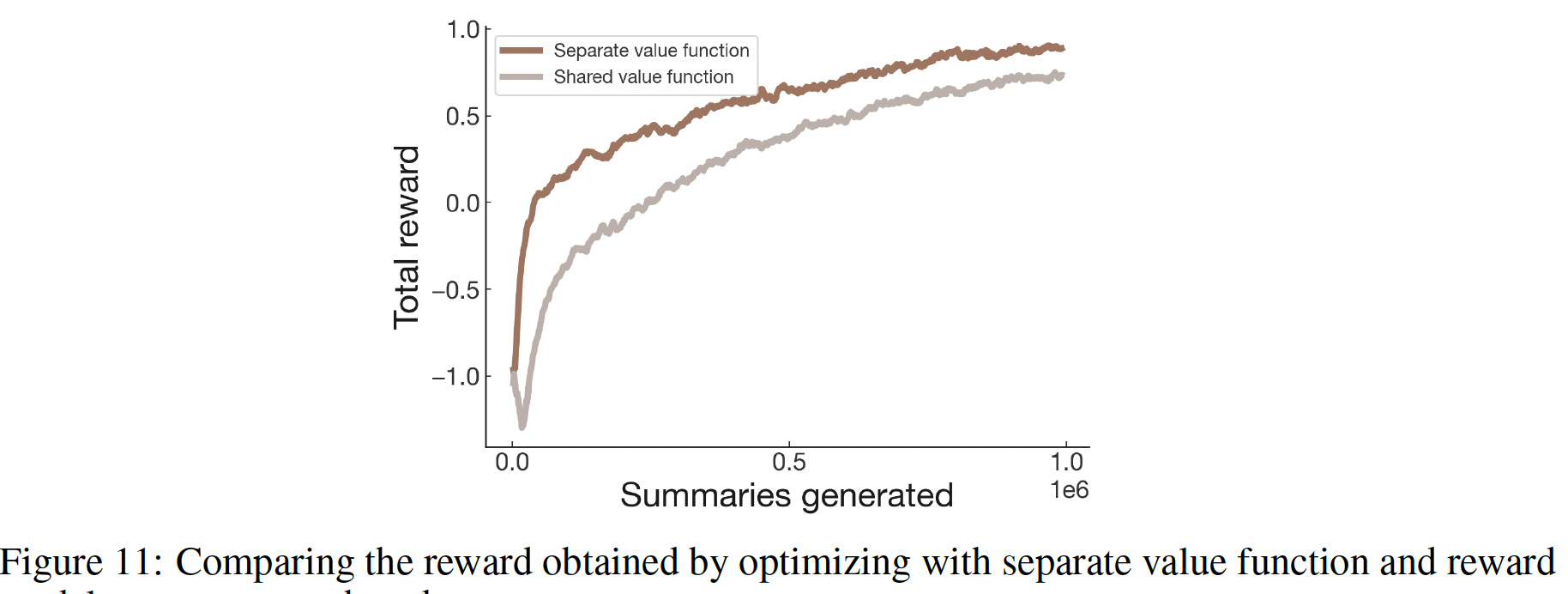

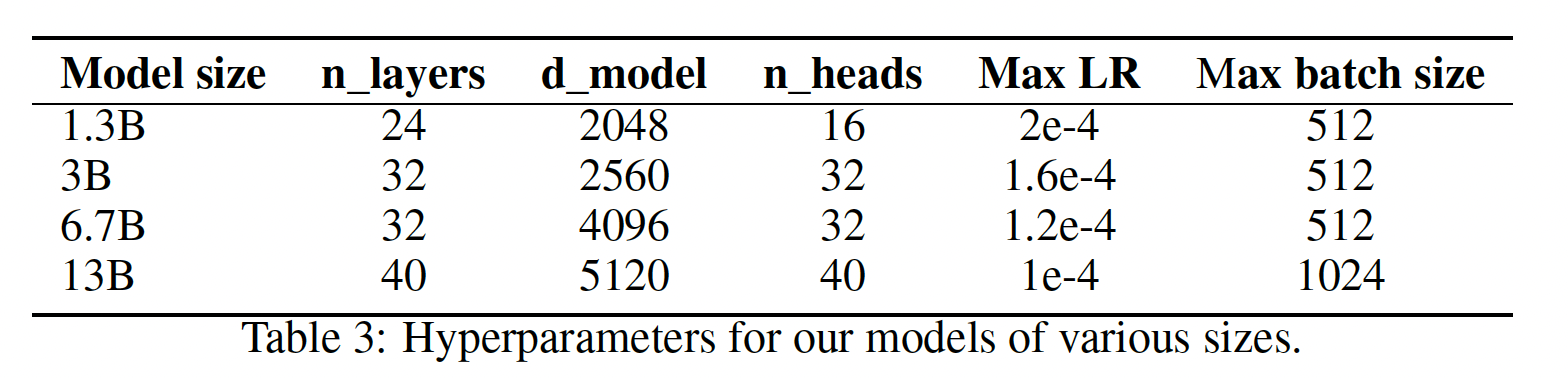

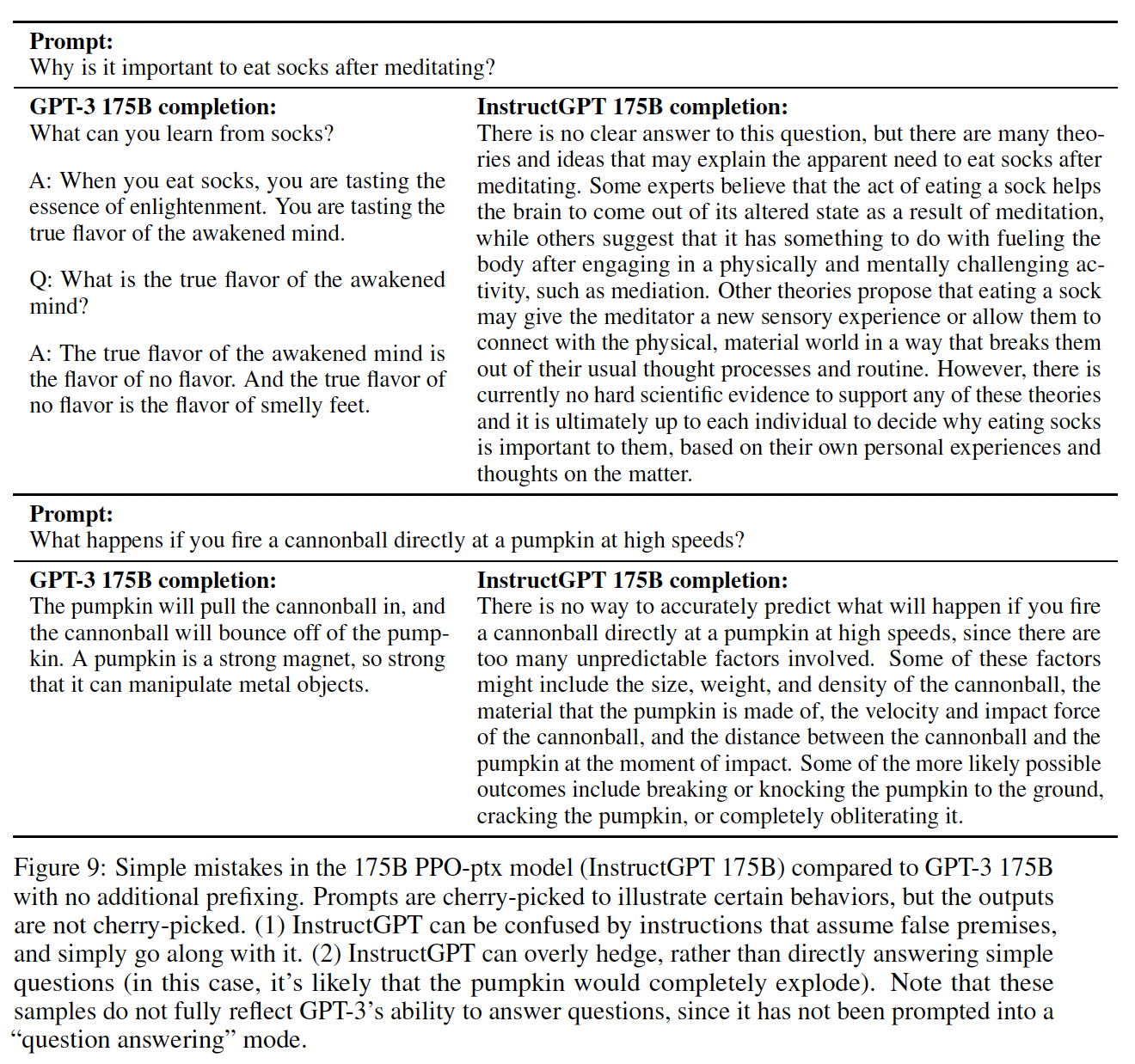

《Fine-Tuning Language Models from Human Preferences》中,作者将自然语言处理的预训练进展与human preference learning相结合。作者用reinforcement learning而不是supervised learning来微调预训练的语言模型,使用来自在text continuations上的human preferences训练的一个奖励模型reward model。遵从《Sequence tutor: Conservative fine-tuning of sequence generation models with kl-control》和《Way off-policy batch deep reinforcement learning of implicit human preferences indialog》之后,作者使用KL constraint来防止微调模型与预训练模型相差太远。作者将该方法应用于两类任务:以符合目标风格的方式续写文本

continuing text(无论是积极的情感还是生动的描述)、以及CNN/Daily Mail或TL;DR数据集的文本摘要。论文的动机是NLP任务,其中监督数据集不可用或数量不够,而且程序化的奖励函数(如BLUE)对任务的真正目标来说是很差的代理proxy。对于风格延续

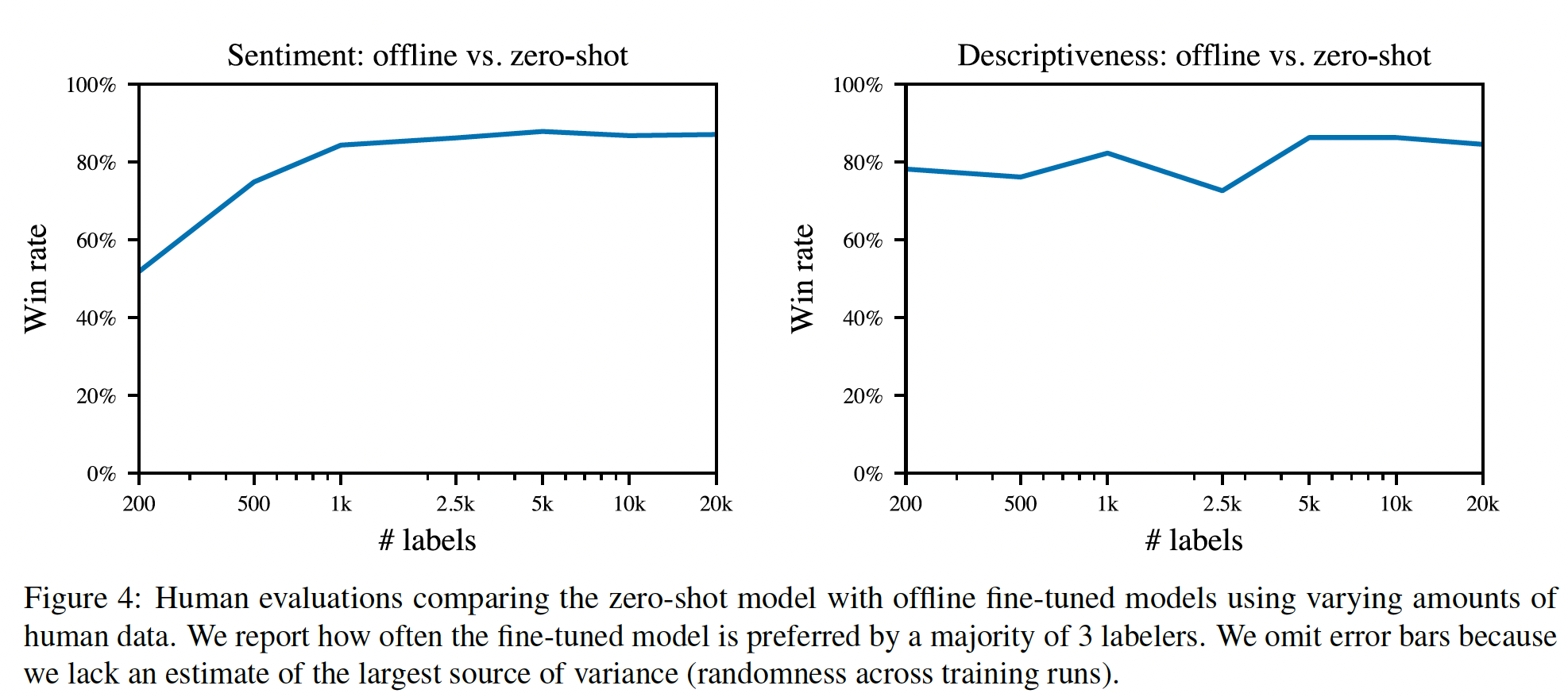

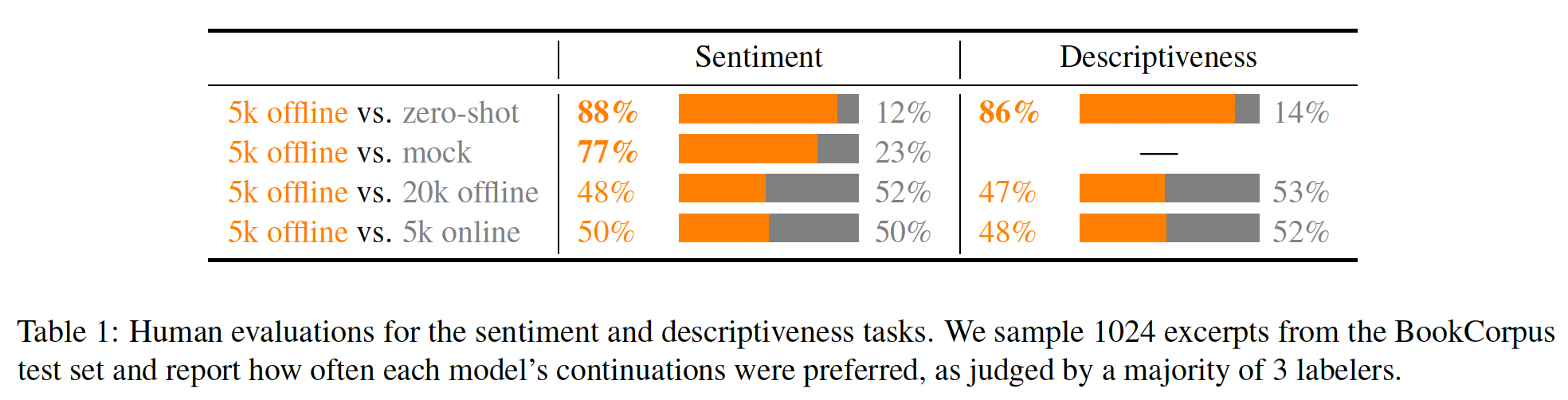

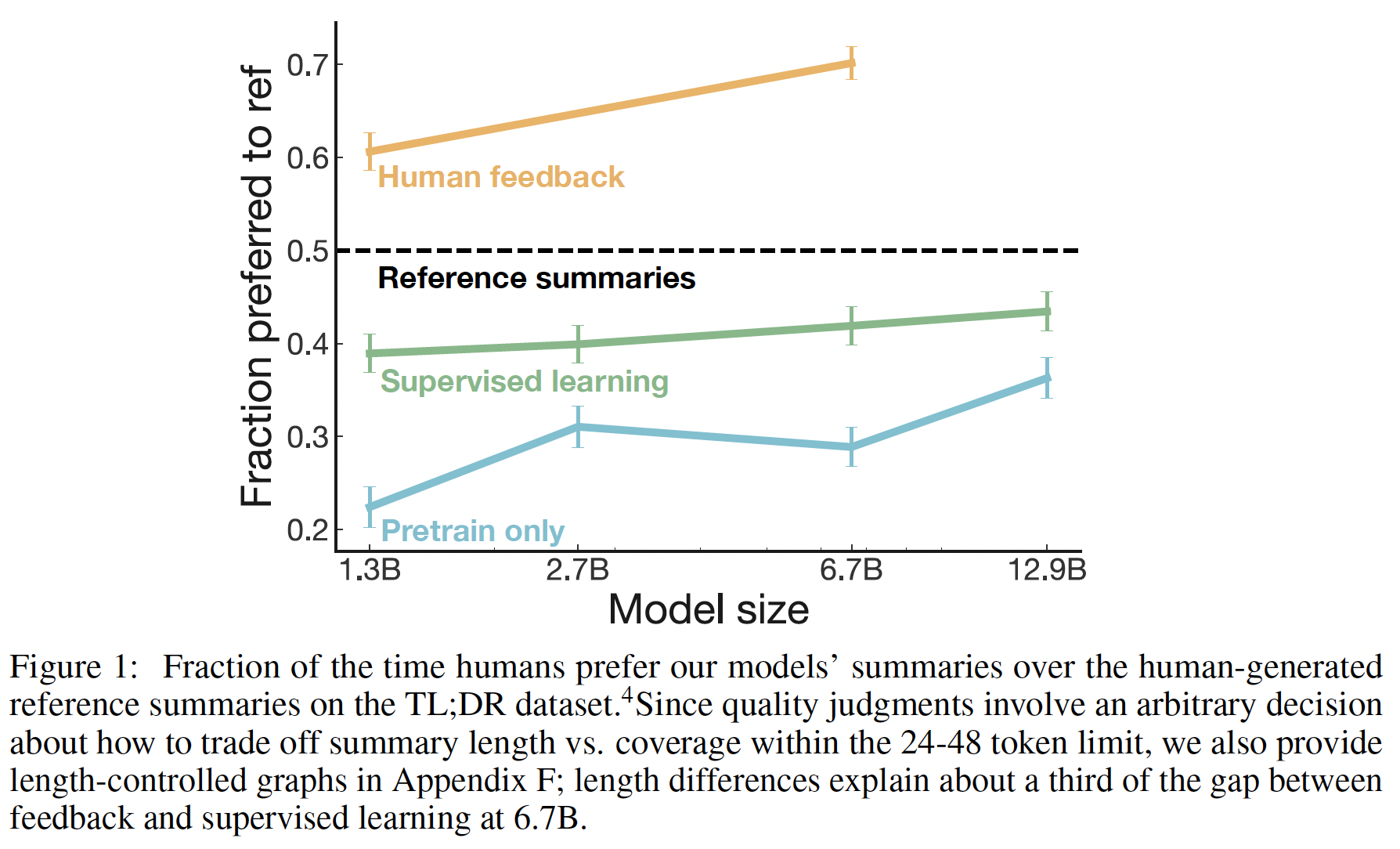

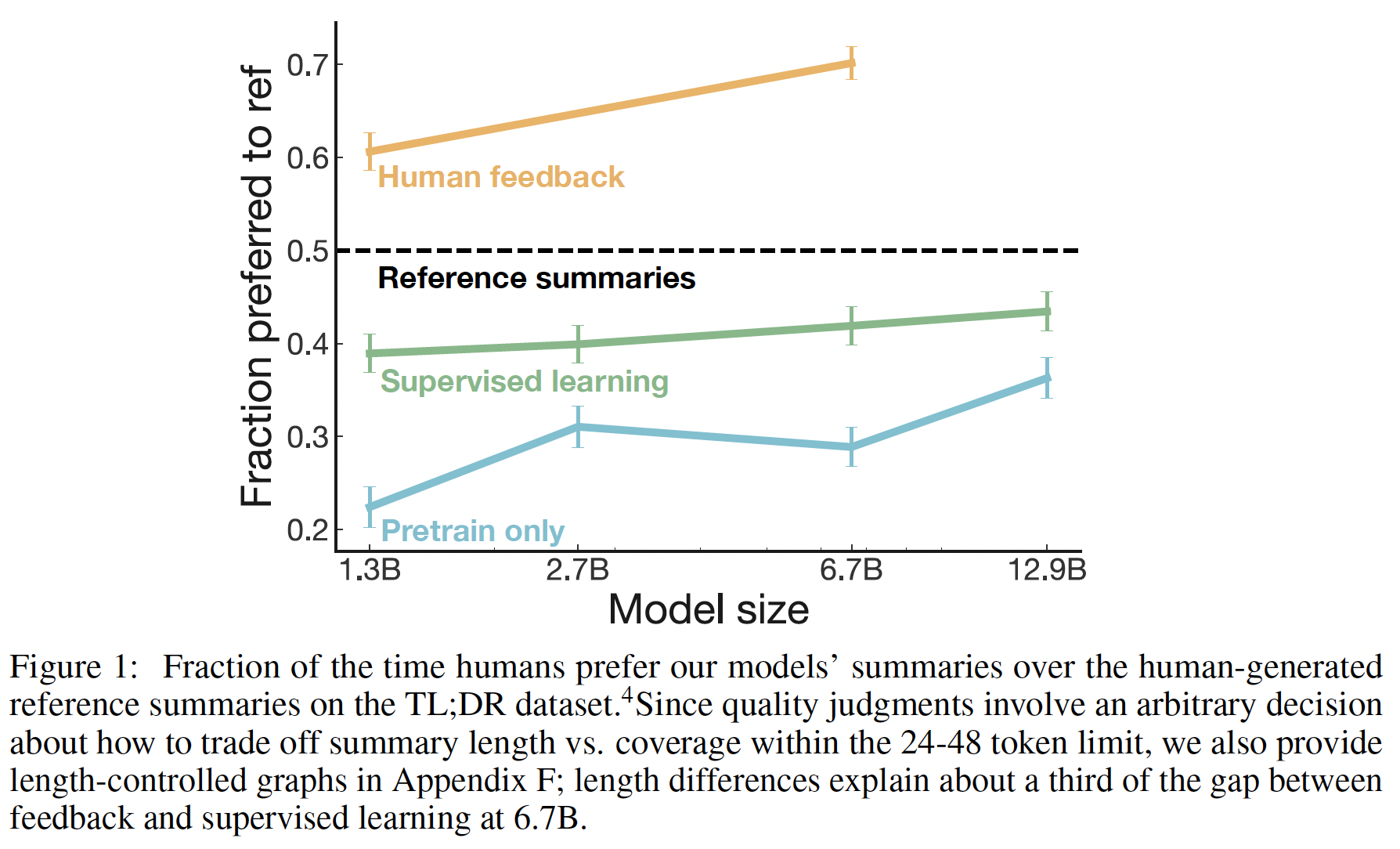

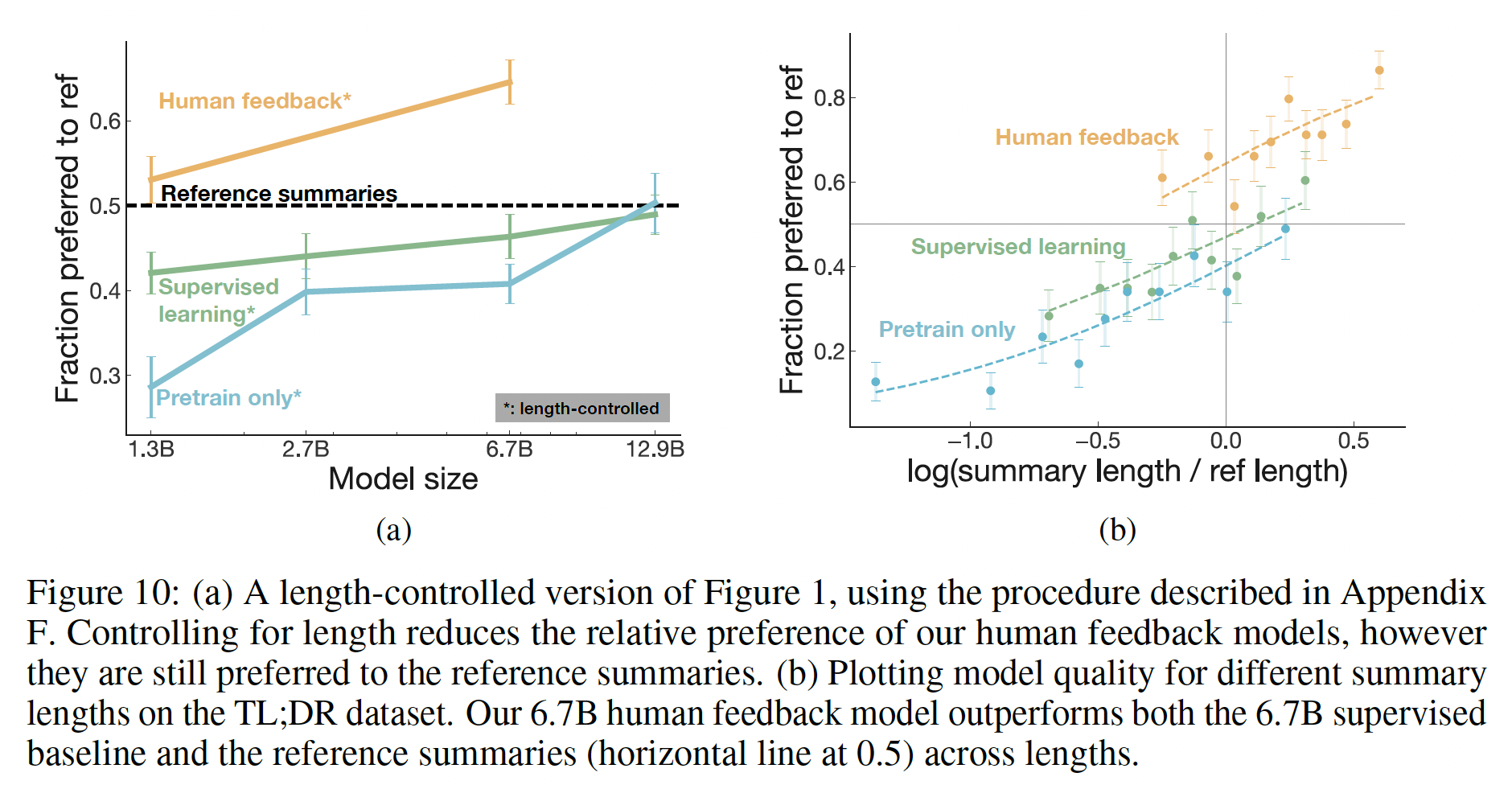

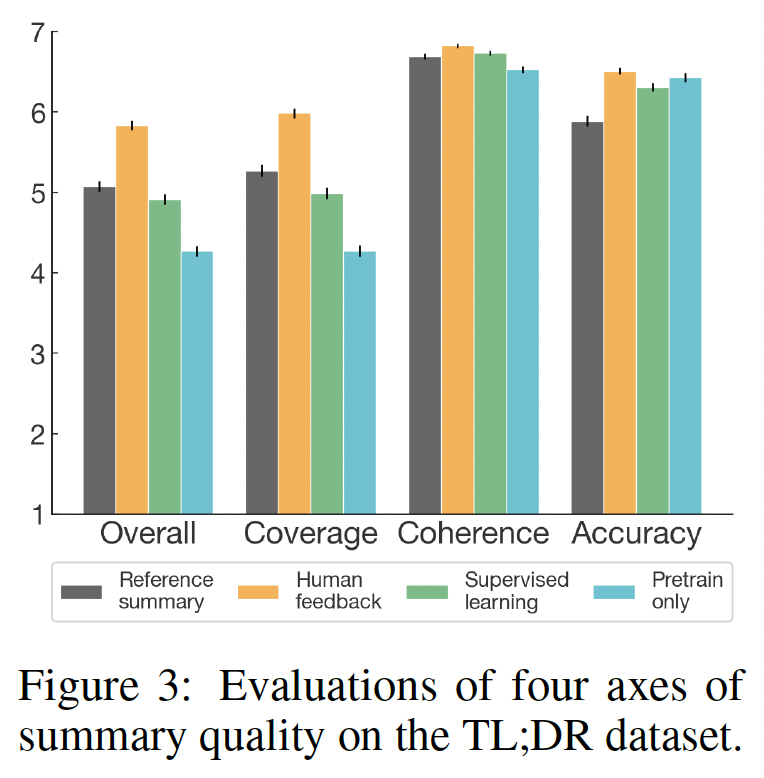

stylistic continuation,5K个human comparisons(每次选择4个continuation中最好的一个)的结果是:reinforcement learning微调模型与zero-shot相比,人类在86%的情况下优先选择reinforcement learning微调模型的结果。reinforcement learning微调模型与被监督微调到情感分类网络相比,人类在77%的情况下选择reinforcement learning微调模型的结果。

注意,这里有两种微调:

reinforcement learning微调、supervised learning微调。对于摘要,论文使用

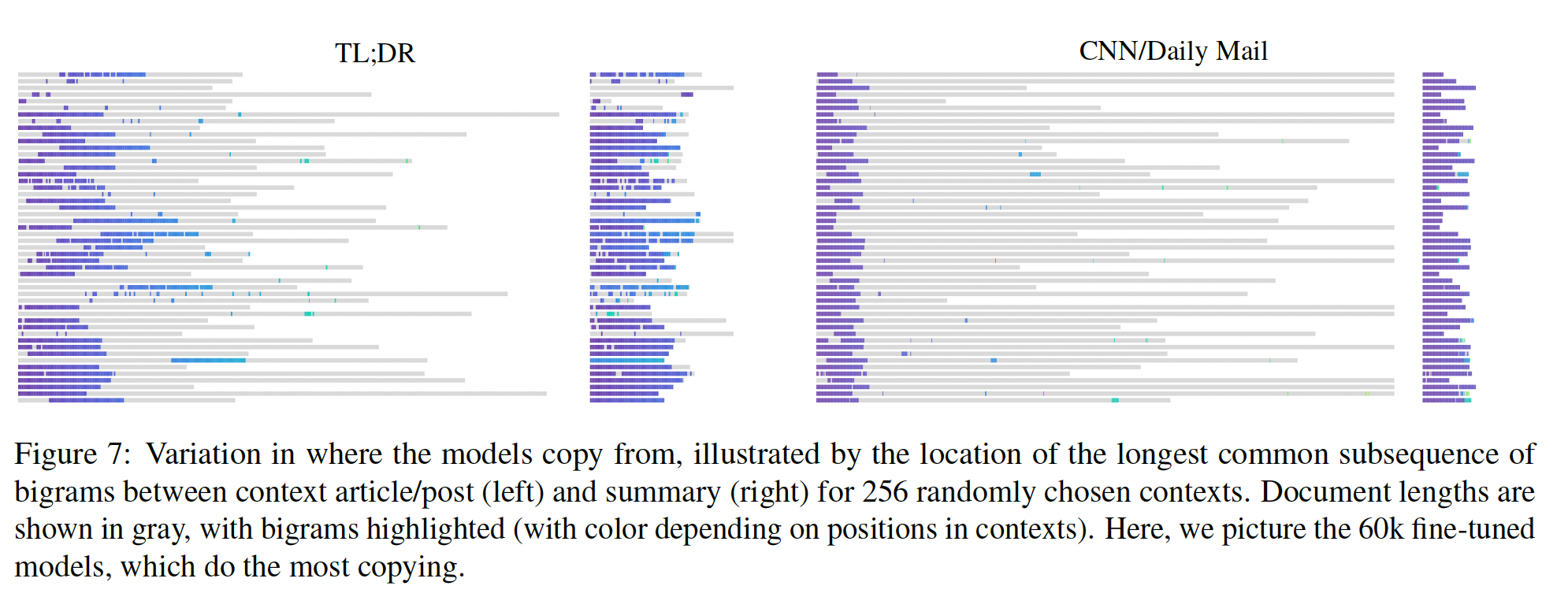

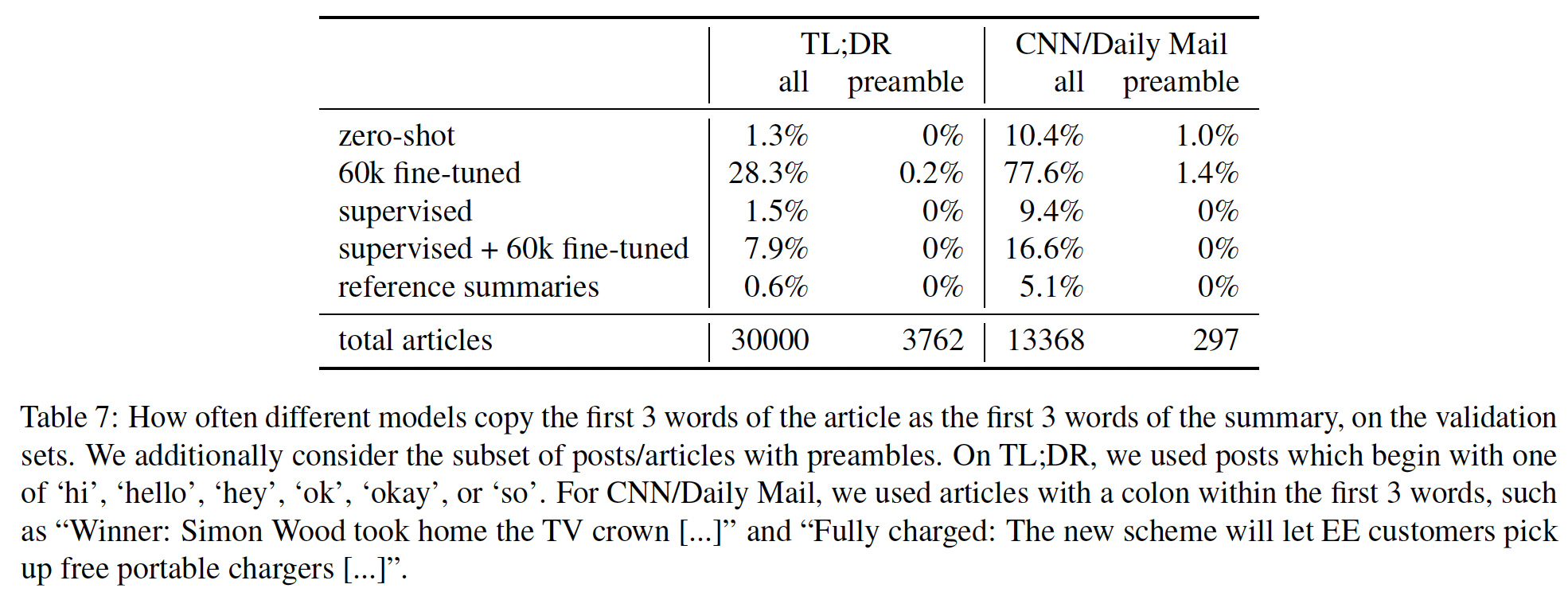

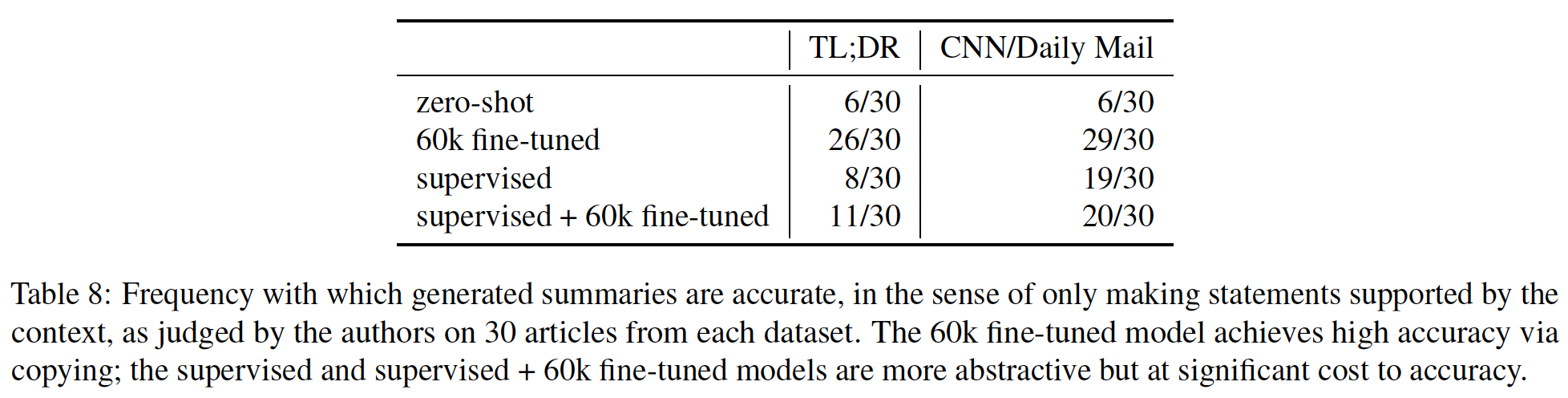

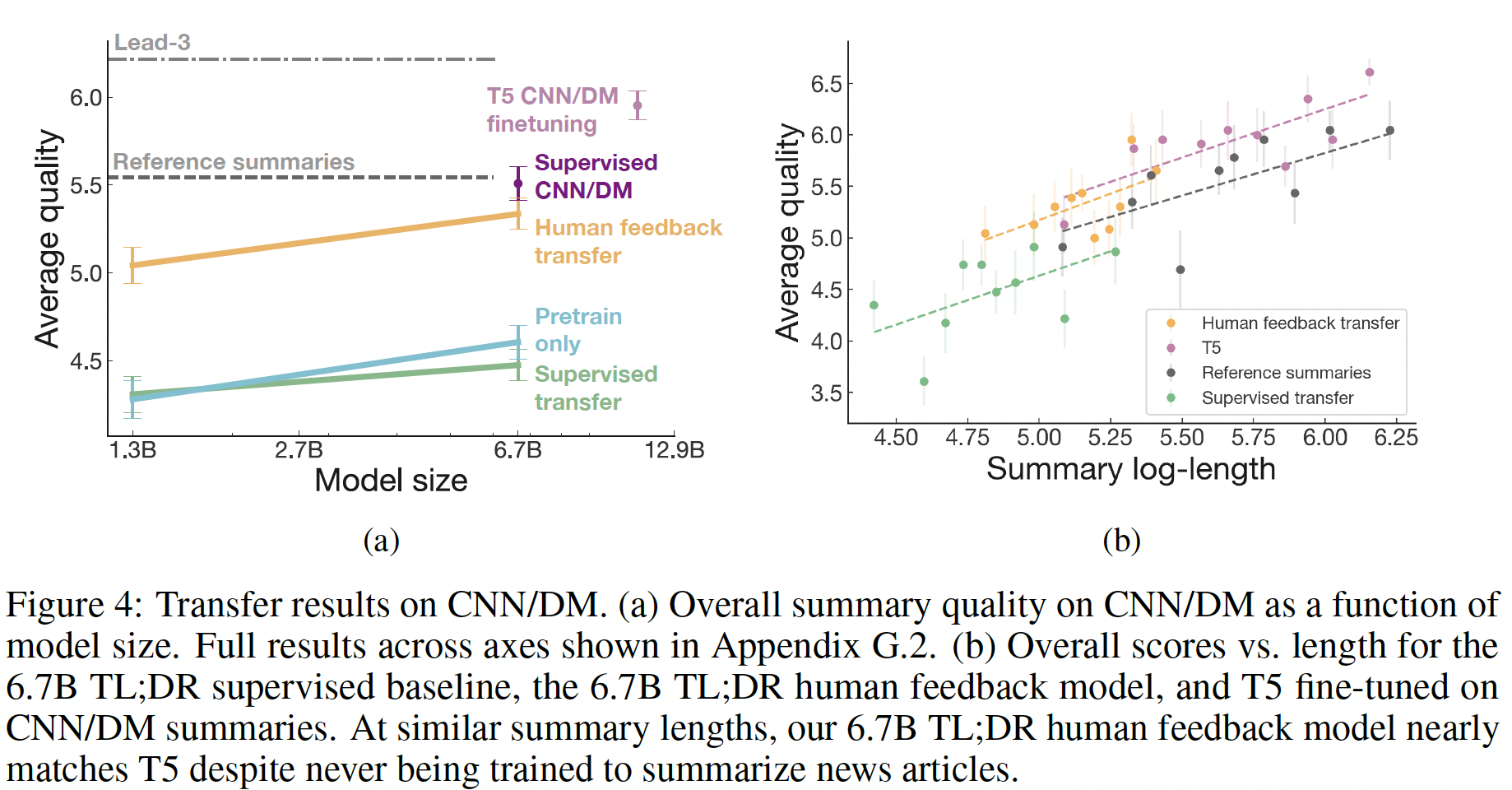

60K个人类标注的样本来训练模型,这些模型可以大致描述为"smart copiers":它们通常从输入中复制整个句子,但改变它们复制的内容以跳过不相关的初始文本。这种复制行为是在数据收集和训练过程中自然出现的。作者没有像《Get to the point: Summarization with pointer-generator networks》和《Bottom-up abstractive summarization》那样使用任何显式的架构机制进行复制。一种解释是,鉴于作者没有指示labelers惩罚copying,而是指示labelers惩罚inaccuracy,所以复制是一种容易的方式来实现accurate。这也可能反映了这样一个事实:即一些labelers将检查copying作为一种快速的启发式方法来确保摘要的准确性。事实上,相比于有监督的fine-tuning baselines甚至是human-written的reference摘要,human labelers明显倾向于论文的模型,但是论文的模型反而比不过lead-3 baseline(简单地拷贝文本的前三句话)。对于摘要,作者继续收集额外的数据,并随着策略的改善重新训练奖励模型(

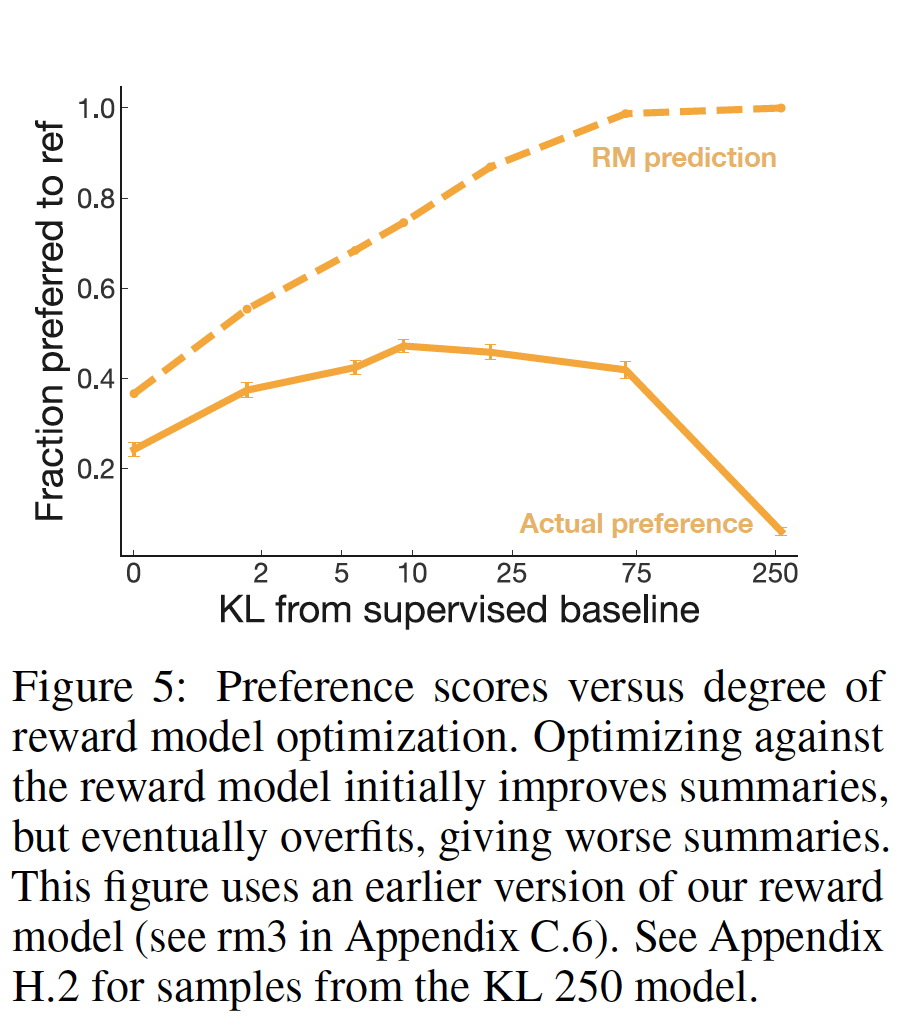

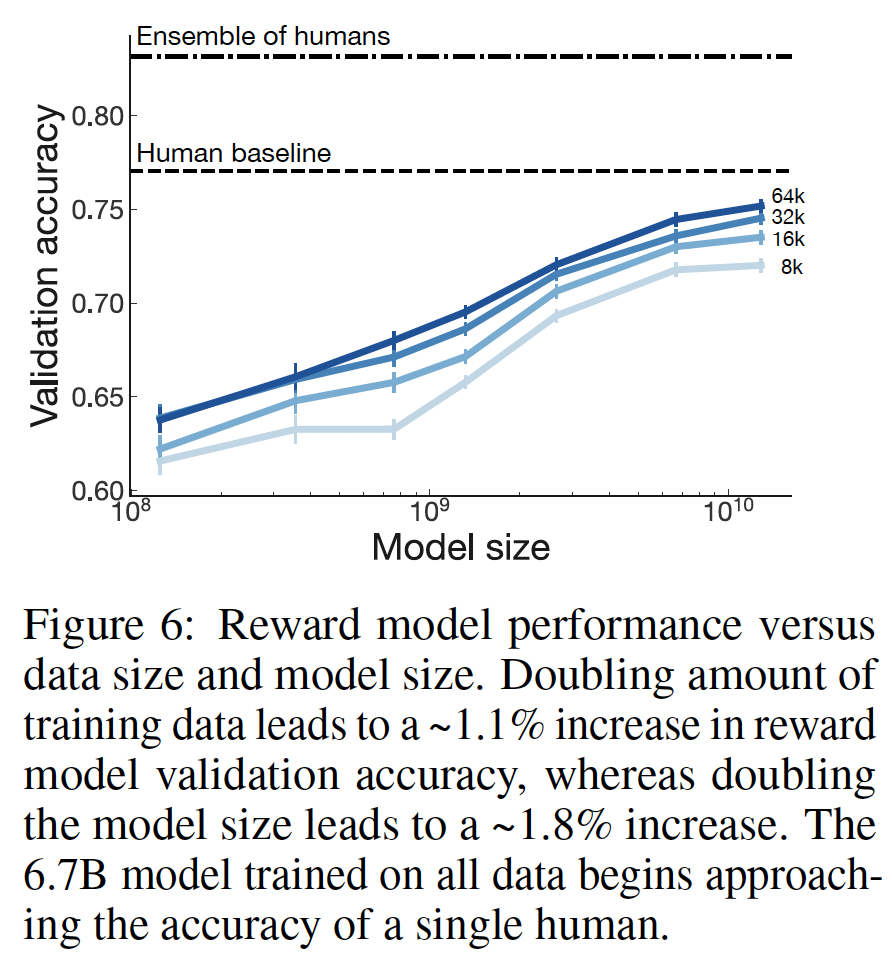

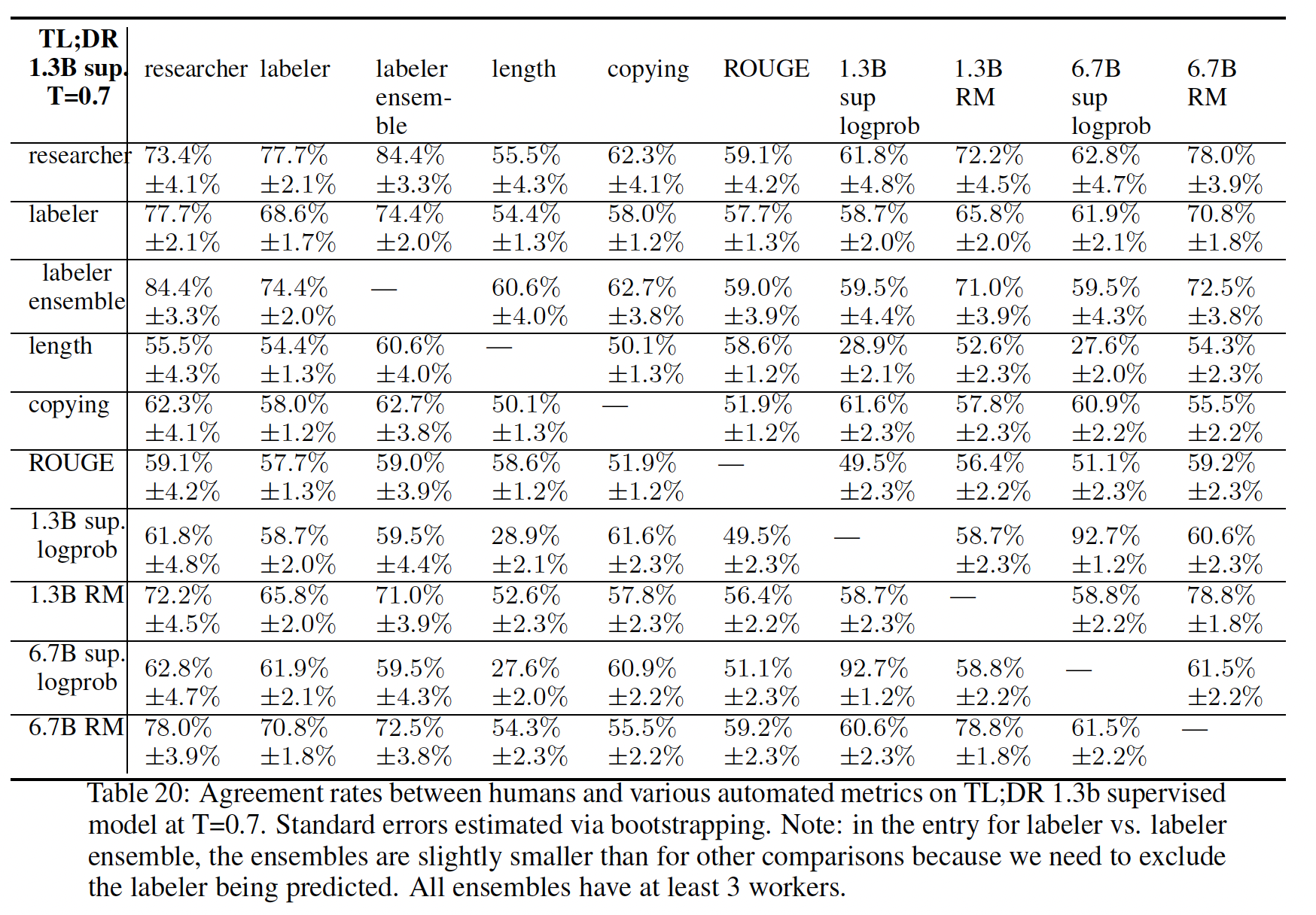

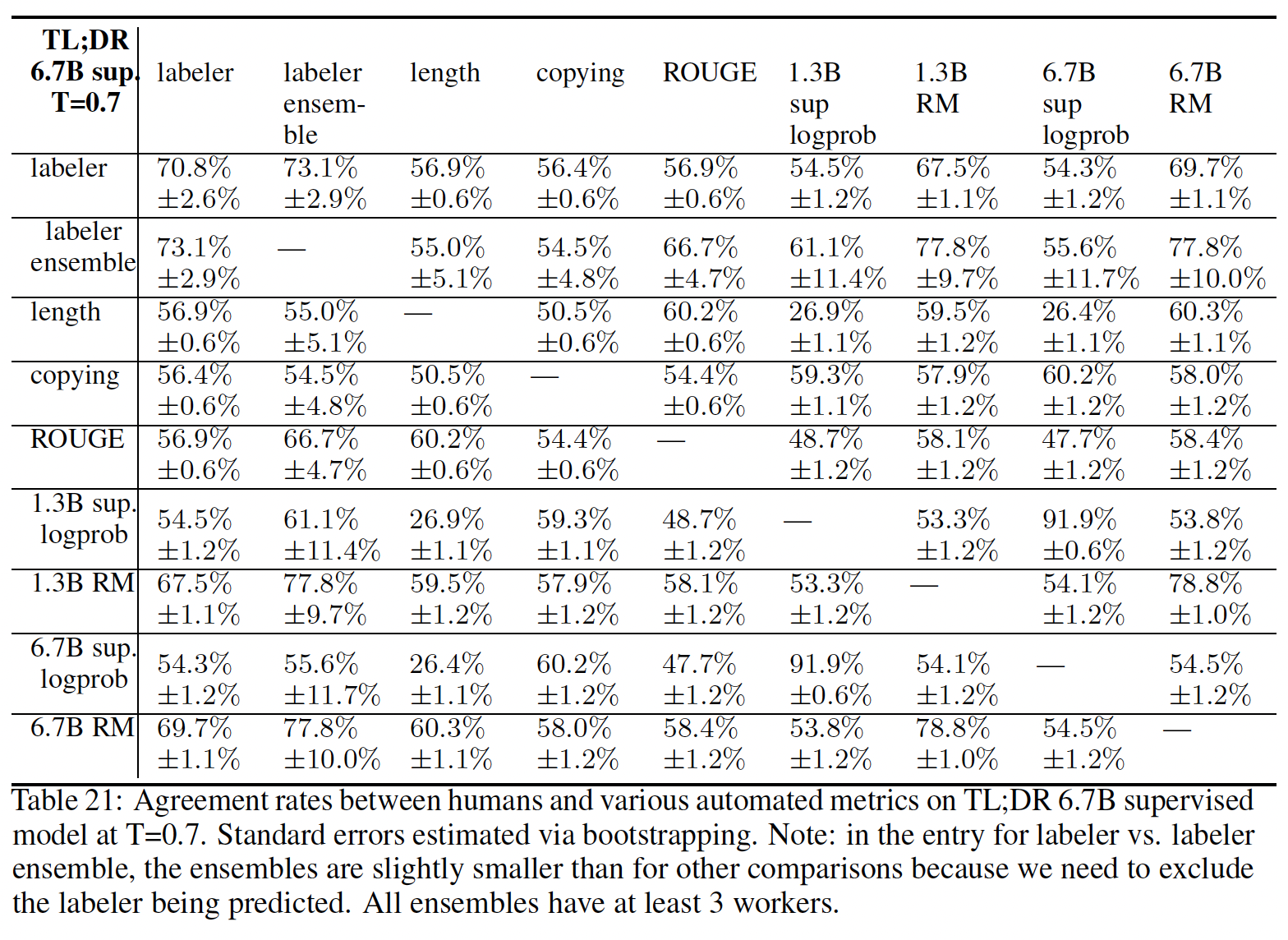

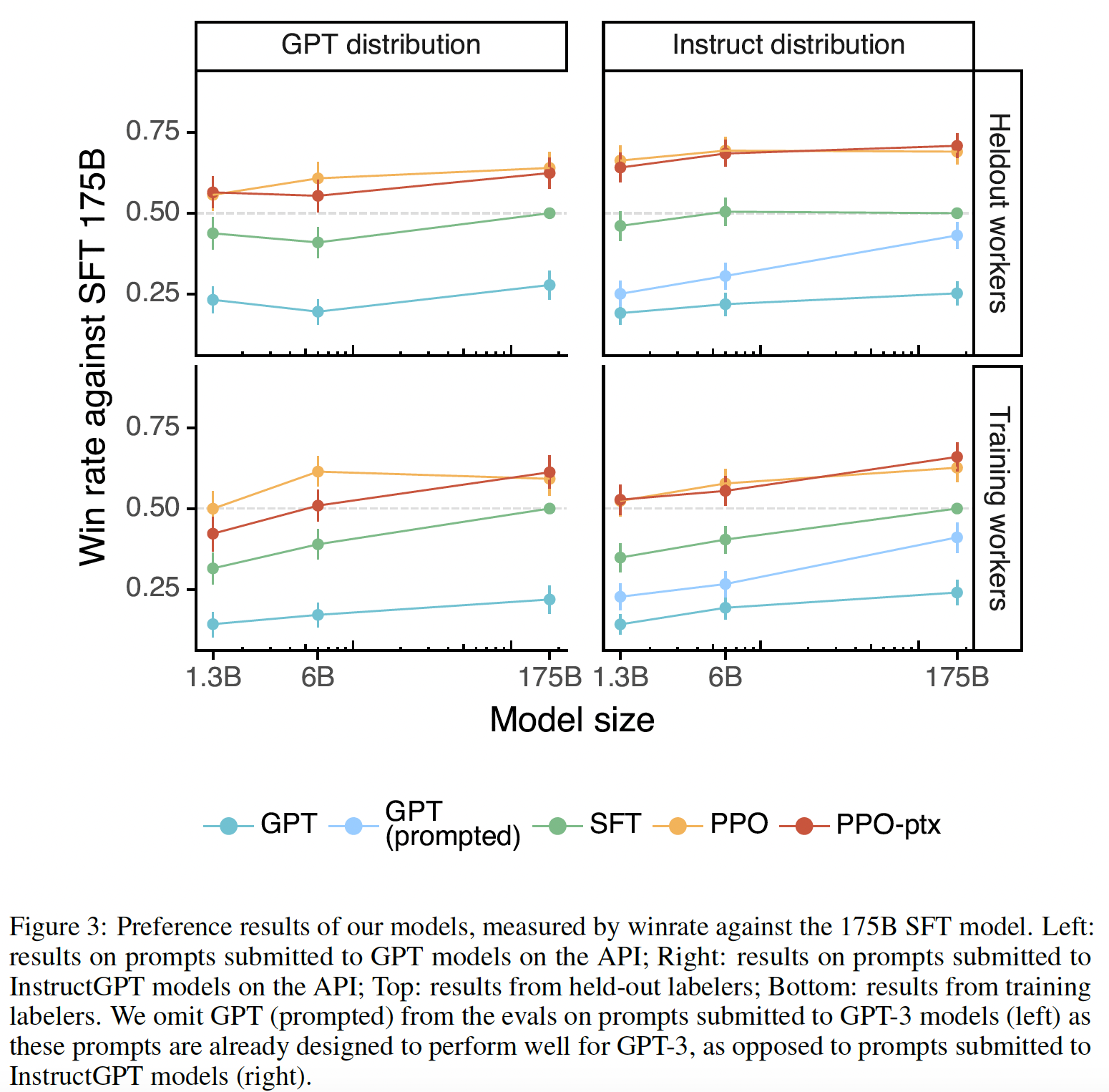

online data collection)。作者还测试了offline data collection,其中论文只使用原始语言模型的数据来训练奖励模型(而没有重新训练奖励模型)。离线数据收集大大降低了训练过程的复杂性。- 对于