二十四、MIMN[2019]

不断发展的互联网将我们带入具有个性化在线服务的数字世界。从在线系统收集的大量用户行为数据为我们提供了更好地了解用户偏好的绝佳机会。从技术上讲,从丰富的行为数据中捕获用户兴趣至关重要,因为它有助于典型的现实世界

application(如推荐系统、在线广告)的显著改进。这里我们限制在点击率Click-Through Rate: CTR预估建模的任务上。CTR预估在在线服务中起着至关重要的作用。这里讨论的解决方案也适用于许多相关任务,例如转化率conversion rate: CVR预估和用户偏好建模。在深度学习的推动下,人们已经提出了体系结构精心设计的、用于建模用户兴趣的深度

CTR模型,从而实现了state-of-the-art效果。这些模型大致可以分为两类:pooling-based的架构:它将用户的历史行为视为独立的信号,并应用sum/max/attention等池化操作来summarize用户的兴趣representation。sequential-modeling架构:它将用户的历史行为视为序列信号,并应用LSTM/GRU操作来summarize用户的兴趣representation。

但是在工业应用中,需要大量的精力将这些复杂的模型部署到在线

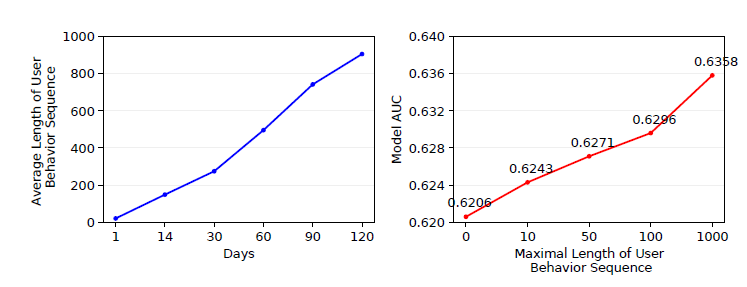

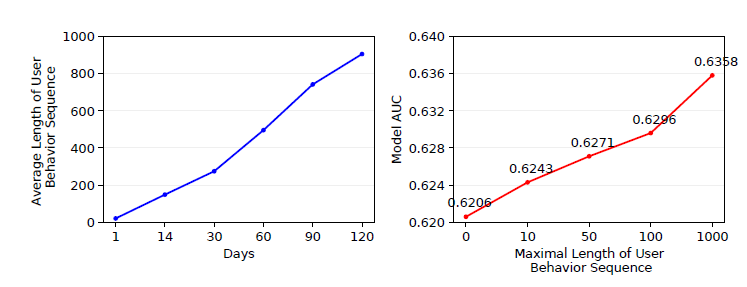

serving系统中以进行实时推断,其中每天都有数以亿计的用户访问该系统。当遇到非常长的用户行为序列数据时,问题变得更加困难:因为所有上述模型都需要在online serving系统中存储完整的用户行为序列(也称作特征),并在极短的延迟时间内获取它们以计算兴趣representation。这里,"长" 表示用户行为序列的长度高达1000甚至更多。实际上,系统延迟和存储成本随着用户行为序列的长度大致成线性关系。DIEN做了大量的工程工作来部署序列模型,但是它也就最大能处理长度为50的用户行为序列。下图给出了在阿里巴巴线展示广告系统online display advertising system中,用户行为序列的平均长度以及对应的CTR模型的性能。显然,解决长序列用户行为建模的挑战是值得的。

在论文

《Practice on Long Sequential User Behavior Modeling for Click-Through Rate Prediction》中,论文共同设计(co-design)了机器学习算法和在线serving系统来用于CTR预估任务,并介绍了工程实践。论文将用户行为建模和完整的CTR预估系统解耦,并相应地设计了特定的解决方案:serving系统的角度:论文设计一个叫做UIC: User Interest Center用户兴趣中心的独立模块,将用户兴趣建模中最耗资源的部分和整个模型解耦。UIC聚焦于在线serving的用户行为建模问题,它维护每个用户的最新兴趣representation。UIC的关键是它的更新机制。用户粒度的状态更新仅取决于实时的用户行为触发事件realtime user behavior trigger event,而不依赖于流量请求。也就是说,UIC对于实时CTR预估是无延迟的latency free。机器学习算法的角度:解耦

UIC模块无法解决存储问题,因为对于数以亿计的用户、且每个用户可能长达上千的用户行为序列的存储和推断仍然很困难。这里作者借鉴了NTM的记忆网络memory network的思想,并提出了一种叫做MIMN: (Multi-channel user Interest Memory Network(多通道用户兴趣记忆网络)的新颖架构。MIMN以增量的方式工作,可以很容易地使用UIC模块实现,这有助于解决存储挑战。此外,

MIMN通过记忆利用正则化memory utilization regularization和记忆归纳单元memory induction unit这两种设计改善了传统的NTM,使其在有限的存储空间下更有效地建模了用户行为序列,并大大提升了模型性能。

从理论上讲,

UIC和MIMN的共同设计方案co-design solution使得我们能够处理无限长度的用户行为序列数据的用户兴趣建模。实验表明:论文提出的方法在模型性能和系统效率上均具有优势。据作者所知,这是能够处理长达数千的用户行为序列数据的、最早的工业解决方案之一。目前该方案已经部署在阿里巴巴的display advertising system中。本文主要贡献:

论文介绍了一个工程实践(

hands-on practice):结合学习算法和serving系统的协同设计来完成CTR预估任务。该解决方案已经部署在世界领先的广告系统中,使我们能够处理长的用户行为序列建模。论文设计了一个新颖的

UIC模块,它将沉重(heavy)的用户兴趣计算与整个CTR预估过程分离。UIC对流量请求没有延迟,并允许任意复杂的模型计算,其中模型计算以离线模式工作。论文提出了一个新颖的

MIMN模型,它改进了原有的NTM架构,具有记忆利用正则化memory utilization regularization和记忆归纳单元memory induction unit两种设计,使其更适合用于兴趣的学习。MIMN很容易用UIC server实现,其中UIC server增量地更新用户的兴趣representation。论文对公共数据集和从阿里巴巴广告系统收集的工业数据集进行了仔细的实验。作者还详细分享了在部署所提出的解决方案的实际问题方面的经验。

相关工作:

Deep CTR Model:随着深度学习的快速发展,我们在计算机视觉、自然语言处理等诸多领域取得了进展。受这些成功的启发,人们提出了许多基于深度学习的CTR预估方法。与传统方法中的特征工程不同,这些方法利用神经网络来捕获特征交互。虽然这个思想看起来很简单,但是这些工作在CTR预估任务的发展上向前迈出了一大步。之后,工业社区更多地关注模型架构设计,而不是通过无穷无尽的特征工程来提高性能。除了学习特征交互之外,人们还提出了越来越多的方法来从丰富的历史行为数据中获取用户的洞察

insight。DIN指出用户的兴趣是多样化的,并且随着目标item的不同而不同。DIN中引入了注意力机制来捕获用户的兴趣。DIEN提出了一个辅助损失来从具体行为中捕获潜在的兴趣,并改进了GRU从而建模兴趣演变。

Long-term User Interest:《Learning implicit user interest hierarchy for context in personalization》认为长期兴趣意味着通用兴趣general interest,这是用户大脑根深蒂固的、对个性化很重要的因素。《Framework for selecting and delivering advertisements over a network based on combined short-term and long-term user behavioral interests》提出对用户对类目的长期兴趣建模。《Incremental update of long-term and short-term user profile scores in a behavioral targeting system》增量地建模长期和短期用户画像score,从而表达用户的兴趣。

所有这些方法都通过特征工程来建模长期兴趣,而不是通过自适应端到端的学习。

TDSSM提出联合建模长期用户兴趣和短期用户兴趣来提高推荐质量。不幸的是,这些基于深度学习的方法,如TDSSM、DIN、DIEN很难部署在面临极长用户行为序列的实时预估server中。存储压力、计算延迟将随着用户行为序列的长度线性增长。在工业application中,行为序列的长度通常很小(例如50),然而淘宝的活跃用户可能会在两周内留下长度超过1000的行为(如点击、转化等)。Memory Network:记忆网络已经被提出用于使用外部记忆组件external memory component提取知识。这个思想在NLP中得到了广泛的应用,如问答系统question answering system。一些工作利用记忆网络进行用户兴趣建模。然而,这些方法忽略了长期兴趣建模和实际部署问题。

24.1 模型

24.1.1 UIC

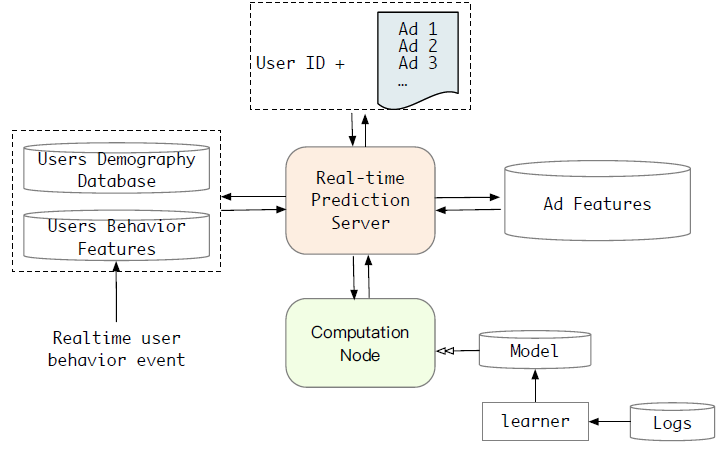

在现实世界的推荐系统或者广告系统中,点击率预估模块是至关重要的组件。通常点击率预估模块接收一组候选对象(如

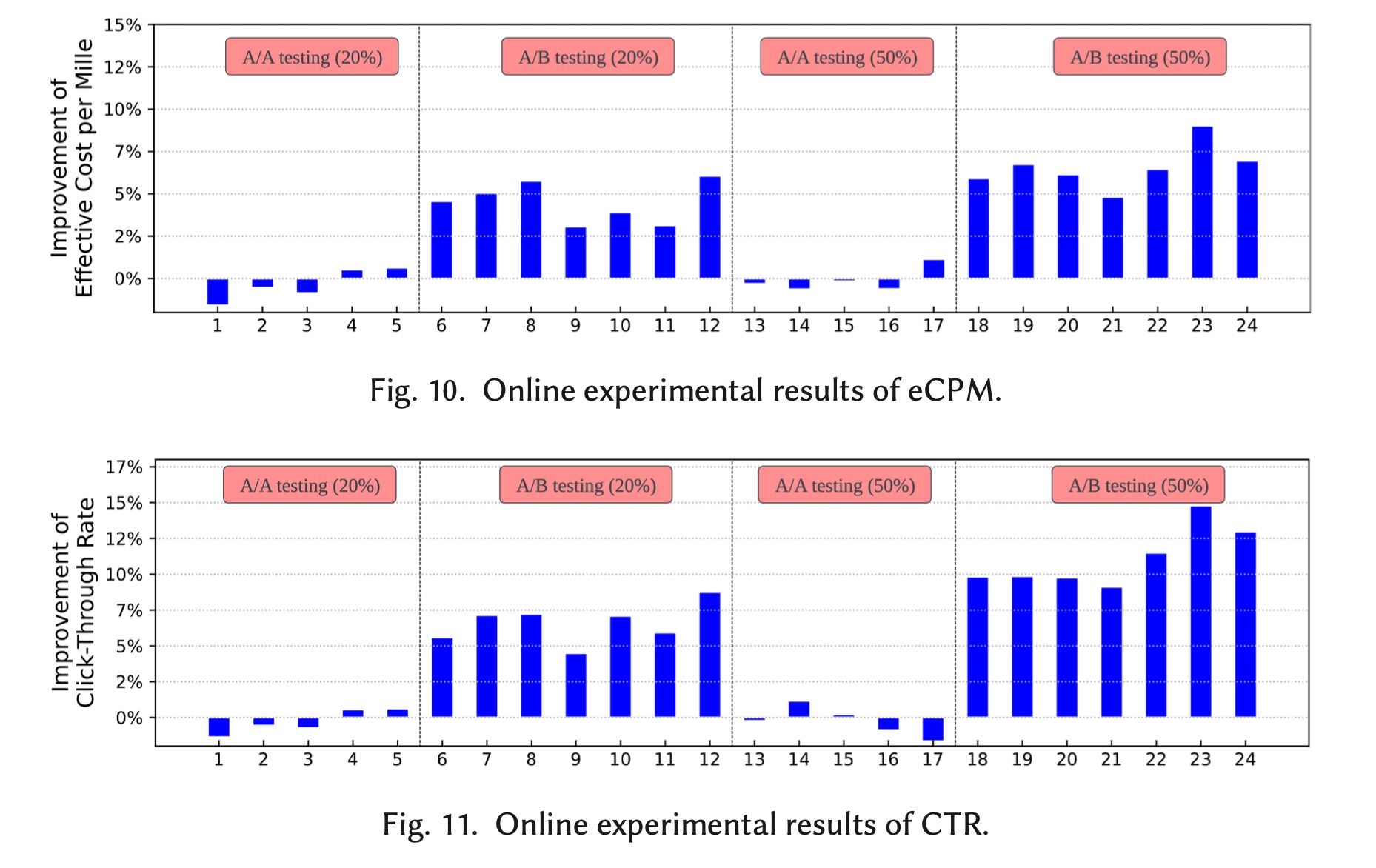

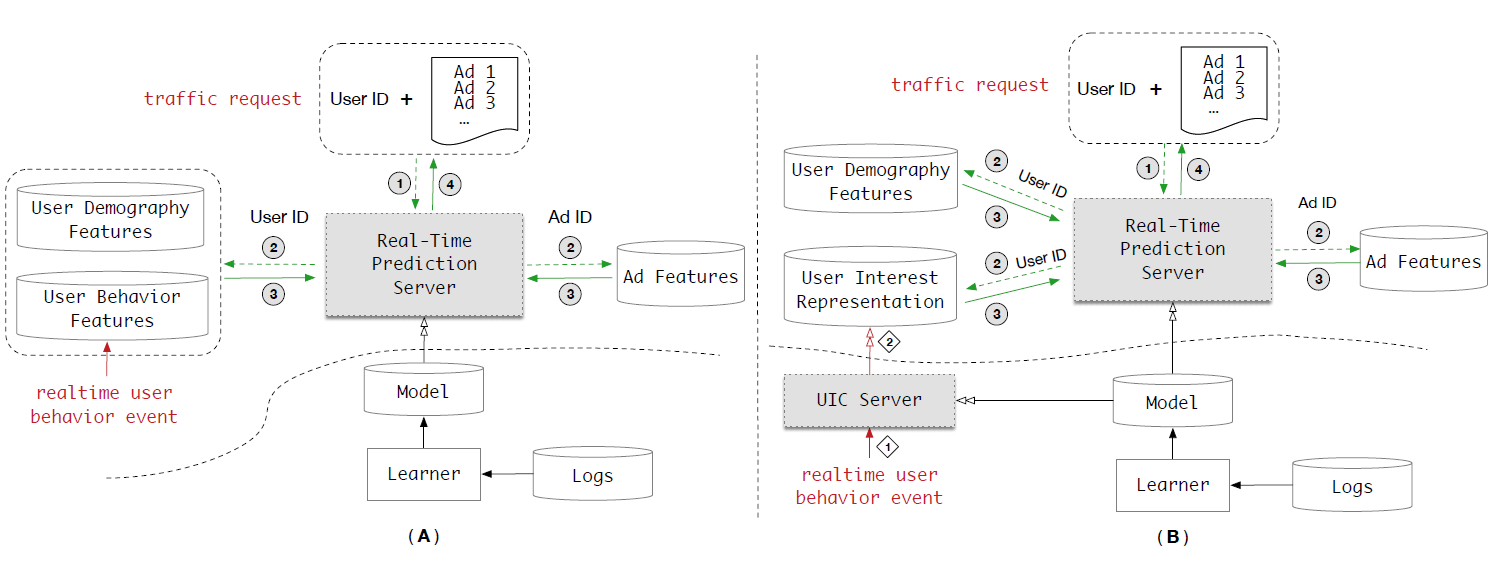

item或者广告),并通过执行实时的模型推断来返回相应的预估点击率。这一过程需要在严格的延迟时间内完成,实践中典型的延迟时间为10ms。下图简要介绍了在线展示广告系统

online display advertising system中用于CTR任务的实时预估(RealTime Prediction: RTP) 系统。为了便于读者理解,我们假设对RTP的请求输入仅包含用户和广告信息,忽略了上下文或其它信息。

在工业应用中,如电商行业的推荐系统,用户行为特征在特征集合中的贡献最大。例如,在我们的推荐系统中,接近

90%的特征是用户行为特征,剩余10%的特征是用户人口统计特征user demography featur和广告特征。这些用户行为数据包含丰富的信息,对于用户兴趣建模很有用。下图显示了我们系统中不同天数收集的用户行为序列的平均长度,以及使用不同长度的用户行为特征训练的

basic model(Embedding & MLP)的离线性能。无需任何其它努力,当使用长度为1000的用户行为序列时,basic model要比使用长度为100的用户行为序列,在AUC上提升0.6%。值得一提的是,仅0.3%的AUC提升对我们的业务而言就足够了。这种

AUC的提升表明:利用较长的用户行为序列数据具有很大的价值。

然而,利用长的用户行为序列数据带来了巨大的挑战。

实际上,数以亿计用户的行为特征非常庞大。为了在推荐系统中保持低延迟和高吞吐量,通常将行为特征存储在额外的分布式内存存储系统(

distributed in-memory storage system)中,例如我们系统中的TAIR(阿里巴巴实现的一个分布式key-value存储系统)。这些特征将被提取到预测服务器prediction server,并在流量请求到来时参与实时推断的计算。根据我们的实践经验,在我们的系统中实现

DIEN会花费很多工程工作。为了使得延迟和吞吐量都满足RTP系统的性能需求,用户行为序列的长度最高为150,无法达到长度为1000的情况。直接包含更多的用户行为数据非常困难,因为面临几个挑战。其中两个最关键的挑战包括:

存储约束:我们系统中有超过

6亿用户,每个用户的行为序列的最大长度为150。这将花费大约1TB的存储空间,该存储空间不仅存储product_id,也会存储其它相关的特征id(如shop_id、brand_id等)。当用户行为序列的长度最大为

1000时,将会消耗6TB的存储空间,并且该数量还会随着用户行为序列的长度而线性增加。如前所述,我们的系统中使用高性能存储来保持低延迟和高吞吐量,而维持如此大的存储太昂贵了。庞大的存储量也导致用户行为特征的相应计算和更新的成本很高。因此,较长的用户行为序列意味着无法接受的存储消耗。

延迟约束:众所周知,使用序列的深度网络

sequential deep network进行实时推断非常困难,尤其是在我们的请求量很大的情况下。DIEN部署了多种技术,可以将我们系统中DIEN serving的延迟降低到14ms,而每个worker的Query Per Second: QPS的容量capacity为500。然而,当用户行为序列的长度最大为

1000时,DIEN的延迟在500 QPS时会高达200ms。我们的展示广告系统很难容忍500 QPS下的30ms延迟限制。因此,在当前的系统架构下,无法获得长的用户行为序列的好处。

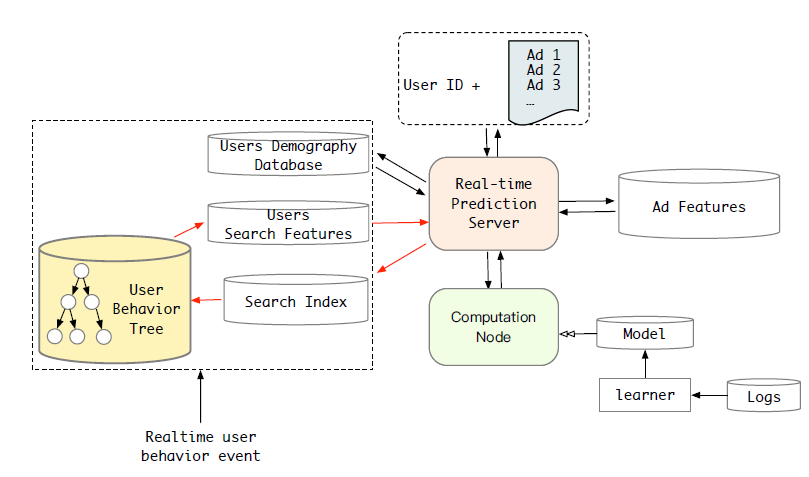

为解决上述针对长的用户行为序列建模的挑战,我们提出了共同设计(

co-design)机器学习算法和在线serving系统的解决方案。由于用户行为建模是CTR预估系统最具挑战性的部分,因此我们设计了一个User Interest Center: UIC模块来处理它。下图的

B部分说明了带有UIC server的、新设计的RTP系统。系统A和B之间的差异是用户兴趣representation的计算。在B中,UIC server为每个用户维护最新的兴趣representation。UIC的关键是其更新机制:用户状态的更新仅取决于实时用户行为触发事件,而不是取决于请求。 也就是说,UIC对于实时CTR预测是无延迟latency free的。在我们的系统中,UIC可以在500QPS下将长度1000的用户行为序列的DIEN模型的延迟从200ms降低到19ms。下图为

CTR任务的RTP系统示意图。通常RTP由三个关键组件构成:特征管理模块feature management module、模型管理模块model management module、预估服务器prediction server。系统A和B的主要区别在于用户兴趣representation的计算。在

A中,用户兴趣representation针对每个请求在prediction server内执行。在

B中,用户兴趣representation针对实时的用户行为事件在UIC server中独立执行。也就是说,用户兴趣representation的计算和流量请求解耦并且是latency free的。

24.1.2 MIMN

这里我们详细介绍用于长的用户行为序列建模的机器学习方法。

从长序列数据中学习是困难的。众所周知,简单的

RNN(RNN,GRU,LSTM)难以建模长的序列。注意力机制通过将序列数据中的必要信息

necessary information压缩到固定长度的张量中来提升模型的表达能力。例如,在DIN中,注意力机制通过soft-search隐状态序列(或者source行为序列)中与目标item相关的部分来工作。为了进行实时推断,注意力机制需要存储所有原始行为序列,这给在线系统的存储带来很大压力。

此外,注意力的计算成本随着行为序列的长度线性增长,这对于长的用户行为序列建模是不可接受的。

实际上,

RNN中的隐状态hidden state并非旨在存储source序列历史的全部信息,而是更多地关注预测目标(predicting target)。因此,最后一个隐状态可能会遗忘长期的信息long-term information。此外,存储所有隐状态是多余的。最近,人们提出了神经图灵机

Neural Turing Machine: NTM从source序列中捕获信息,并将其存储在固定大小的外部记忆中(external memory) 。在很多使用长序列数据进行建模的任务中,NTM相比RNN模型取得了显著提升。借鉴

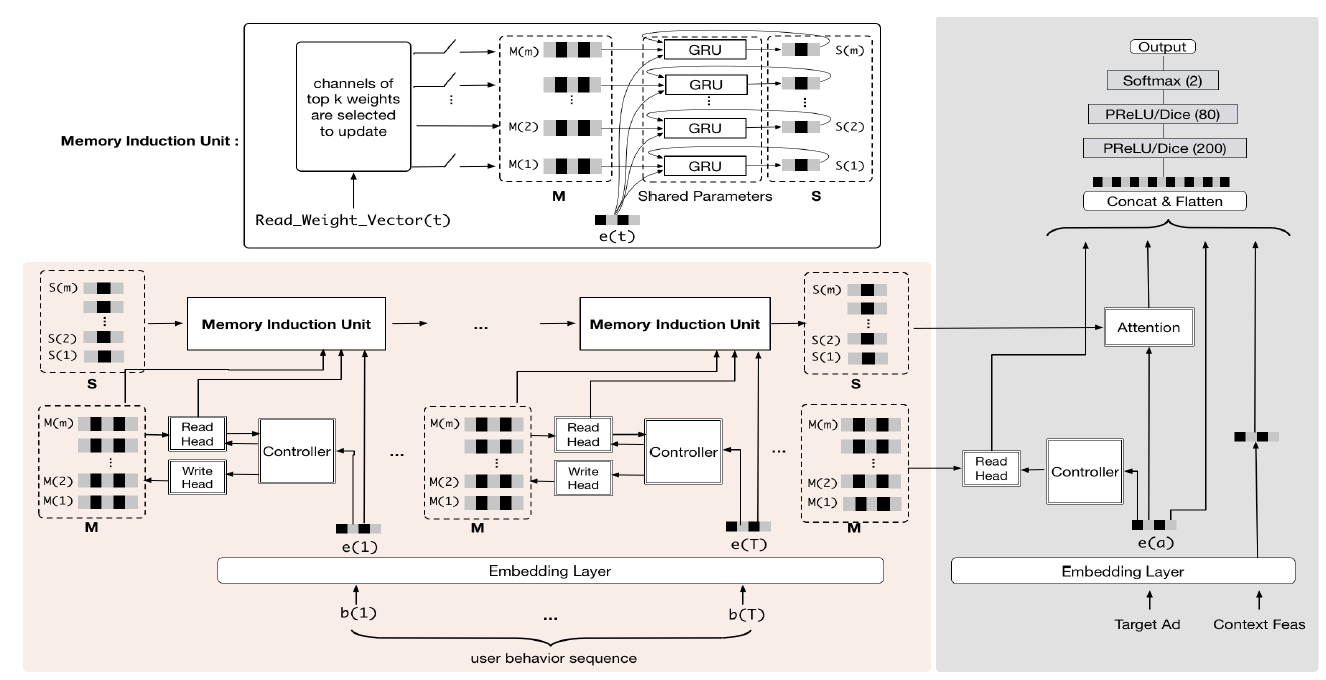

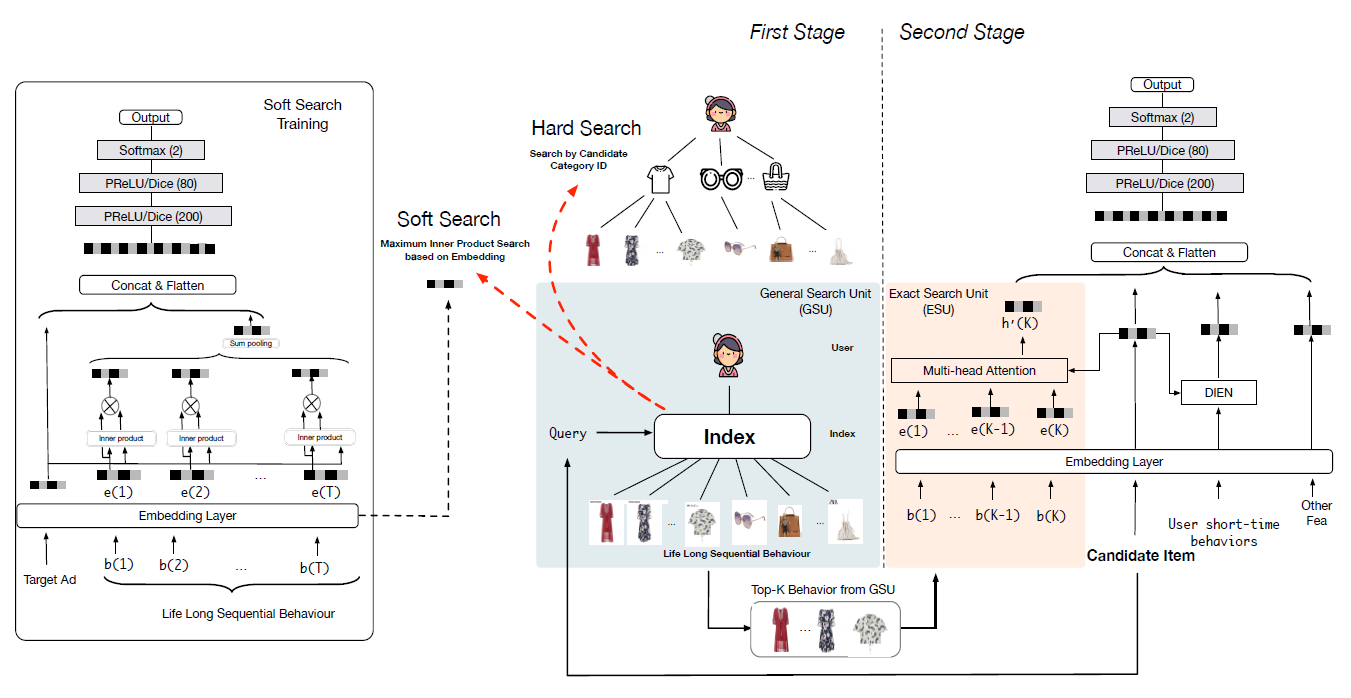

NTM的想法,本文中我们提出了一个基于记忆网络memory network-based的模型,该模型为处理长的用户行为序列建模提供了新的解决方案。我们将该模型命名为Multi-channel User Interest Memory Network: MIMN,如下图所示。MIMN由两个主要部分组成:左子网络聚焦于用户行为序列的用户兴趣建模;右子网络遵循传统的Embedding &MLP范式,该范式采用左子网络的输出以及其它特征作为输入。NIMN的贡献在于左子网络,它是由NTM模型驱动的,并且包含两个重要的记忆网络架构:基本的

NTM记忆单元,它具有标准的记忆读取(memory read)和记忆写入(memory write)操作。多通道

GRU的记忆归纳单元(memory induction unit),它用于基于先前学习的NTM记忆来捕获高阶信息。

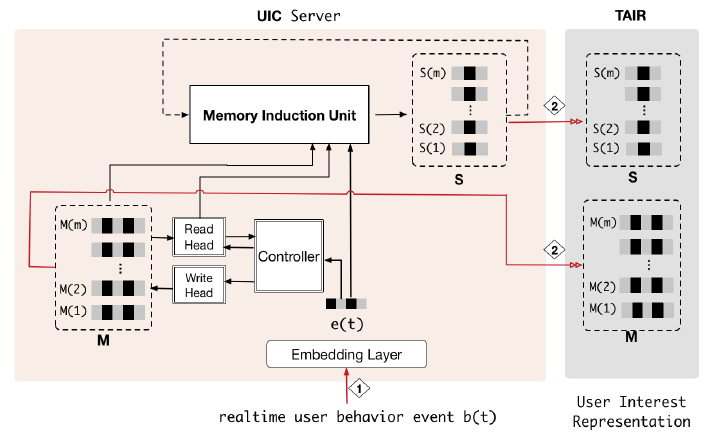

UIC存储MIMN的外部记忆张量(external memory tensor),并利用用户的每个新行为来更新该张量。这样,UIC从用户的行为序列中逐步捕获用户的兴趣。尽管

UIC存储固定长度的记忆张量而不是原始行为序列,但是考虑到存储压力时,必须限制存储张量的大小。本文中,我们提出了记忆利用正则化(memory utilization regularization),以通过memory utilization来提升UIC中的记忆张量的表达能力。另一方面,随着用户兴趣的变化以及随着时间的演变,我们提出使用记忆归纳单元(

memory induction unit)来帮助捕获高阶信息。NTM:标准的NTM通过记忆网络从序列数据中捕获并存储信息。在time stepmemory)的参数记作memory slotNTM的两个基本操作是记忆读取memory read和记忆写入memory write,它们通过一个控制器controller来和记忆交互。先

read后write还是先write后read?作者没有明确表达。读者猜测是先write再read,这样始终能够读取最新的状态。memory read有两个作用:选择

top-k重要的slots,从而更新MIU。输出

memory summarization

记忆读取

memory read:给定第embedding向量read keyaddress memory)。它首先遍历所有的记忆槽,生成一个权重向量其中:

然后计算加权的

memory summarization作为输出memory write:类似于memory read操作,我们生成用于memory write寻址的权重向量key:add vectorerase vectormemory的更新:其中:

erase matrix,slot提供一个加权的erase vectorslot权重为add matrix。slot提供一个加权的add vectorslot权重为dot product)。

Memory Utilization Regularization:实际上,basic NTM会遭受memory utilization unbalanced的问题,尤其是在用户兴趣建模的场景下。即,热门的item倾向于在用户行为序列中频繁出现,并且主导着memory的更新,从而使得memory的使用变得低效。NLP领域先前的一些工作已经提出使用LRU策略来平衡每个memory的利用(utilization)。由于LRU在处理过程的每个短序列中都非常注意平衡memory的利用,因此LRU几乎从来不会在相邻的时间步对相同的slot写入信息。但是,在我们的场景中,用户可能会与隶属于相同兴趣的几种行为进行交互,这会写入同一个

slot。LRU将会使得内容寻址混乱disorganize,并且不适合我们的任务。本文中,我们提出了一种称作

memory利用正则化(memory utilization regularization)的新策略,该策略被证明对用户兴趣建模是有效的。memory utilization regularization背后的思想是:将不同memory slot之间的write weight方差进行正则化,从而使得memory利用达到平衡。令

slot的更新后的权重,其中re-balanced的write weight:其中:

write weight,而write weight。slot之间的权重转移矩阵,它取决于:memory slot的累积利用(accumulated utilization) 。参数矩阵

其中:

slot数量。注意:上式中没有下标slot的累计write weight的方差最小化。memory slot上write weight的方差。

通过使用

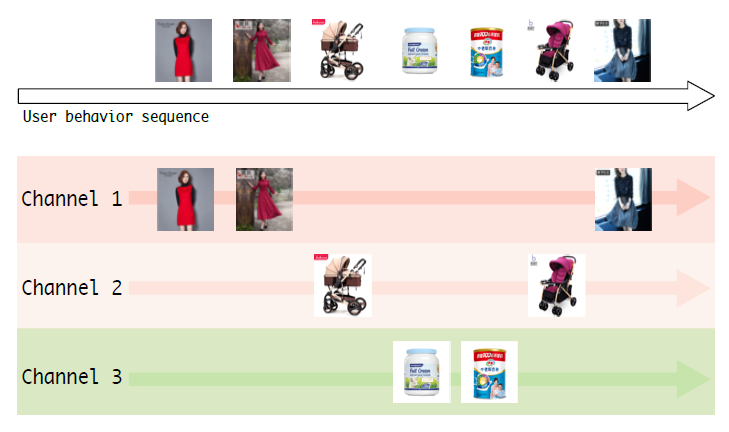

memory slot的利用都被提升从而得到平衡。因此,utilization regularization可以帮助memory tensor存储来自于source行为数据的更多信息。Memory Induction Unit:NTM中的memory旨在尽可能多地存储源数据中的原始信息。美中不足的是,它可能会错过捕获某些高级信息的机会,例如各部分兴趣的动态演变过程。为了进一步提升用户兴趣抽取的能力,MIMN设计了一个Memory Induction Unit: MIU。MIU还包含了一个内部的memoryNTM相同的槽数memory slot视为一个用户兴趣通道user interest channel。在时刻MIU:选择

其中

NTM的memory read中的权重向量。选择

top k是为了挑选重要的通道,从而过滤掉噪音信号。对于第

其中

NTM的第memory slot,embedding向量。注意:一般情况下

上式表明:

MIU既从原始行为输入中捕获信息,又从NTM模块存储的信息中捕获信息。这是一个归纳过程inductive process,如下图所示。

多通道

memory的GRU参数是共享的,因此不会增加参数量。embeddingattention-pooling从而得到固定长度的embedding向量,并用于后续的向量拼接和MLP。Online Serving:与DIEN,DIN应用注意力机制从而获得candidate-centric兴趣的representation不同,MIMN学会了显式地捕获和存储用户的多样化兴趣,并将其存储在每个用户的external memory中。这种memory-based架构无需在候选对象(如,我们系统中的目标广告)和用户行为序列之间进行交互式计算,并且可以增量执行,这使得它可扩展地用于长的用户行为序列建模。用于在线

serving的MIMN的实现非常简单。我们将整个模型拆分并实现到两个server中:左侧的子网是在

UIC server中实现的,如下图所示。它使用NTM和MIU进行计算量最大的用户兴趣建模。

右侧的子网可以在

RTP server中实现。

NTM和MIU模块均享受增量计算的优势:最新的memory state代表用户的兴趣,并更新到TAIR以进行实时CTR预估。当收到最新的用户行为事件时,UIC将再次计算用户兴趣representation,并更新到TAIR。这样,不需要存储用户行为数据。在我们的系统中,长用户行为序列的存储量可以从

6T减少到2.7T。UIC server和MIMN的co-design使得我们能够处理长的用户行为序列数据,序列长度可以扩展到数千。UIC用于用户兴趣representation的更新和整个模型的计算无关,从而使它对于实时CTR预估是无延迟latency free的。MIMN提出以增量的方式对用户兴趣进行建模,而无需像传统解决方案一样存储整个用户行为序列。此外,MIMN使用改进的memory architecture,可以实现出色的模型性能。

但是,它并不适合所有情况。我们建议将该解决方案应用于具有以下条件的应用程序:丰富的用户行为数据,以及实时用户行为事件的流量规模不能明显超过实时

CTR预测请求的流量规模。

24.2 实验

实验分为两个部分:

详细介绍了算法验证,包括数据集、实验配置、比较模型、以及相应的分析。

讨论并分享在阿里巴巴展示广告系统中部署所提出的解决方案的实践经验。

24.2.1 实验结论

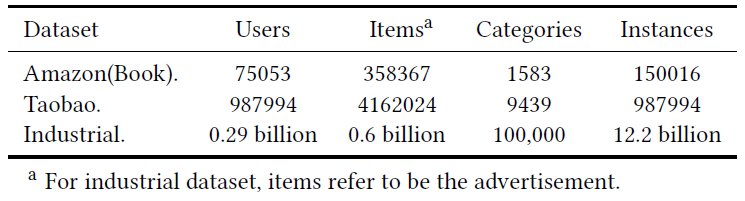

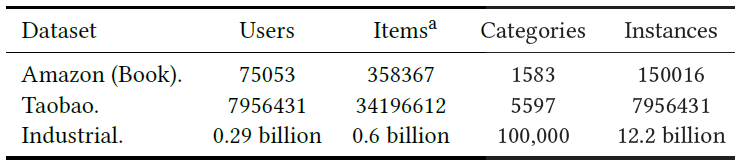

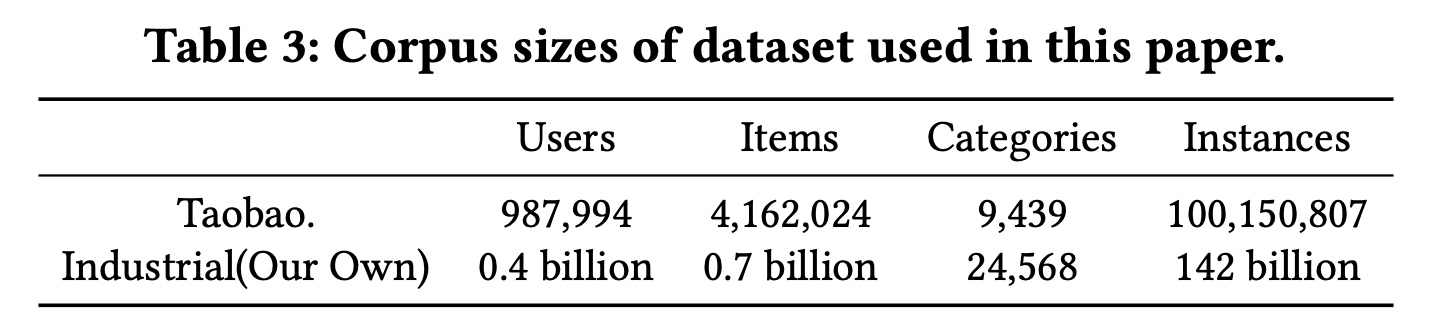

数据集:

Amazon Dataset:由Amazon提供的商品评论、商品元信息组成。我们使用Amazon数据集的Books子集。对于该数据集,我们将评论视为一种交互行为,并根据时间对一个用户的所有评论进行排序。假设用户

为了聚焦长的用户行为序列预测,我们过滤了行为序列长度小于

20的样本,并截断了行为序列长度为100(即超过100截断为100)。Taobao Dataset:收集自淘宝推荐系统的用户行为。数据集包含几种类型的用户行为,包括点击、购买等。它包含大约一百万用户的用户行为序列。我们采用每个用户的点击行为,并根据时间对其进行排序,从而尝试构建行为序列。假设用户

200。Industrial Dataset:收集自阿里巴巴在线展示广告系统。样本来自曝光日志,其中标签为这个曝光是 ”点击“ 或者”未点击“。训练集由过去49天的样本组成,测试集由下一天的样本组成。这是工业建模的经典配置。在这个数据集中,每天每个样本的用户行为特征包含之前

60天的历史行为序列,行为序列长度被截断为1000。

下表给出了这些数据集的统计信息。

实验配置:

对于所有模型,我们使用

Adam优化器。我们采用指数衰减,学习率从0.001开始、衰减速率为0.9。FCN: fully connected network的层数设置为:200 x 80 x 2。embedding维度设为16,和memory slot的维度相同。MIU中GRU的隐层维度设为32。NTM和MIU中的memory slot数量是一个在消融研究部分仔细检查过的参数。我们将

AUC视为衡量模型性能的指标。

baseline方法:我们将MIMN和state-of-the-art的CTR预估模型进行比较。Embedding & MLP:是CTR预估的basic深度学习模型。它需要sum池化操作才能整合行为embedding序列。DIN:是用户行为建模的早期工作,提出针对目标item条件下对用户行为进行软搜索soft-search。GRU4Rec:基于RNN的方法,并且是使用循环单元recurrent cell来建模用户行为序列的首次研究。ARNN:是GRU4Rec的一种变体,它使用注意力机制对所有隐状态进行加权和,从而得到更好的用户行为序列representation。RUM:使用external memory来存储用户的额行为特征。它还利用soft-writing和attention reading机制来和memory进行交互。我们使用feature-level RUM来存储序列信息。DIEN:将GRU和candidate-centric attention技巧融合,从而捕获用户兴趣的演变趋势,并实现了state-of-the-art性能。为了进行公平地比较,我们省略了辅助损失的技巧,以便更好地在

DIEN中进行embedding学习。否则应该针对上述所有模型都使用辅助损失技巧。

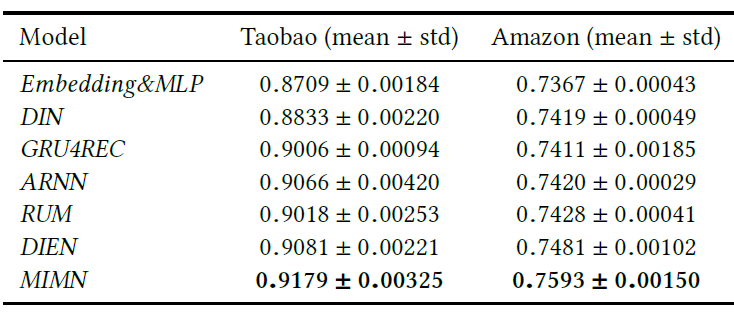

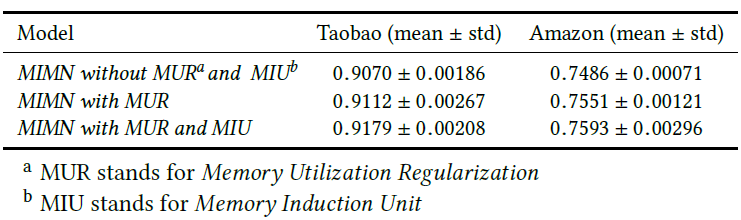

下表给出了所有模型的实验结果,每个实验重复

3次并报告均值和标准差。可以看到:所有其它模型都击败了

Embedding & MLP,这验证了针对用户行为建模的网络体系架构设计的有效性。MIMN以很大的AUC优势击败了所有模型。我们认为,这是由于memory-based架构的巨大容量capacity适用于建模用户行为。如前所述,长的用户行为序列数据背后的用户兴趣是多样的,且随着时间而动态演化。

MIMN使用多通道memory在两个方面学会了捕获用户兴趣:basic NTM中的memory使用平衡的利用balanced utilization来记忆兴趣。MIU中的memory通过归纳兴趣的序列关系进一步捕获高阶信息,其中兴趣是基于NTM的memory。

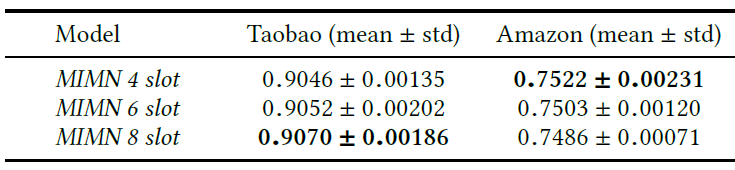

memory的slot数量:我们在具有不同数量的memory slot的MIMN上进行了实验。为简化起见,我们使用最基本的NTM体系结构来评估MIMN,省略了memory utilization regularization和memory induction unit。下表给出了结果。可以看到,

slot数量会影响模型性能:对于

Amazon数据集,最佳性能是slot数量为4时取得的。而对于

Taobao数据集,最佳性能是slot数量为8时取得的。

我们的分析结果表明,这与数据集中用户行为序列的长度有关。

memory中的每个slot都是随机初始化的。对于行为序列较长的数据集,例如

Taobao数据集,memory有更多的机会学习和达到稳定(stable)的representation。对于行为序列较短的数据集,例如

Amazon数据集,具有较大memory capacity的模型遭受学习不足的影响。尤其是当memory的所有slot的利用不平衡时,部分memory向量可能无法充分利用和更新,这意味着这些memory向量仍然保持接近于初始化状态。这会损害模型的性能。因此我们提出了

Memory Utilization Regularization来缓解该问题。

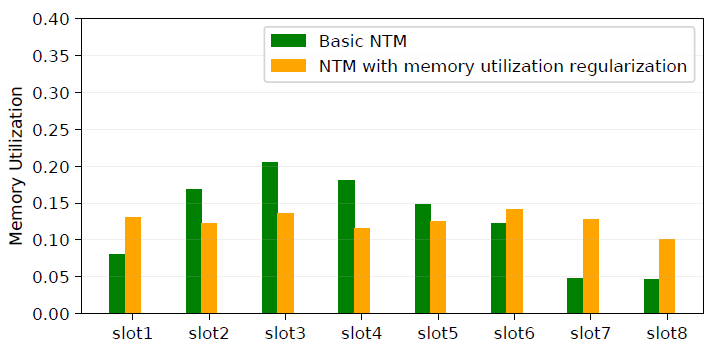

Memory Utilization Regularization:由于每个用户的兴趣强度不一致,并且memory进行了随机初始化,因此在basic NTM模型中,存储的利用可能不平衡。这个问题将损害memory的学习,使其不足以利用有限的memory存储。我们使用

memory utilization regularization技巧来帮助解决该问题。下图显式了memory utilization,它验证了所提出的正则化器的有效性。

这种平衡的效果还带来了模型性能的改善,如下表所示。

Memory Induction Unit:通过归纳从basic NTM的memory,带memory induction unit的MIMN能够捕获高阶信息并带来更多提升,如上表所示。它增强了用户兴趣抽取的能力,并有助于从长的用户行为序列数据中建模用户兴趣。工业数据集结果:

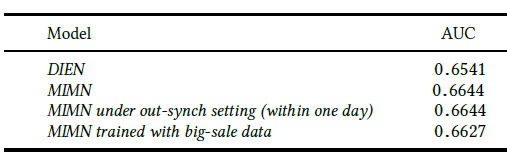

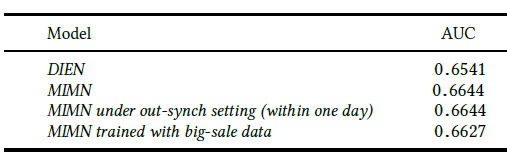

我们进一步对阿里巴巴在线展示广告系统收集的数据集进行实验。我们将

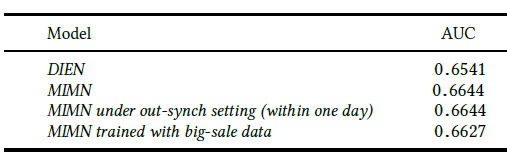

MIMN和DIEN模型进行了比较,下表给出了结果。MIMN以0.01的AUC提升超越了DIEN,这对于我们的业务而言意义重大。

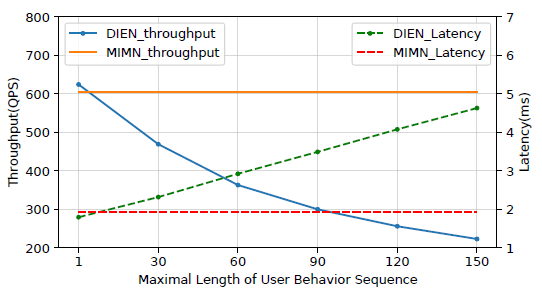

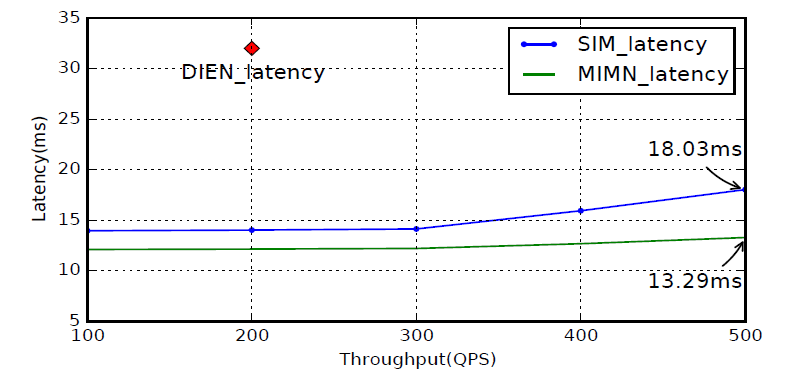

除了离线模型的性能,在系统方面

MIMN和DIEN模型之间还存在很大差异。下图给出了当MIMN和DIEN作为serving模型时实际CTR预估系统的性能。MIMN和UIC server的co-design在很大程度上击败了DIEN,前者具有随着不同行为序列长度保持恒定的延迟和吞吐量的特性。因此,MIMN可以在我们的系统中利用长度可达数千个的、长的用户行为序列数据,并享受模型性能的提升。相反,DIEN serving的系统会同时遭受延迟和系统吞吐量的困扰。由于系统的压力,作为我们最新产品模型的

DIEN中使用的用户行为序列长度仅为50。这再次验证了我们提出的解决方案的优越性。

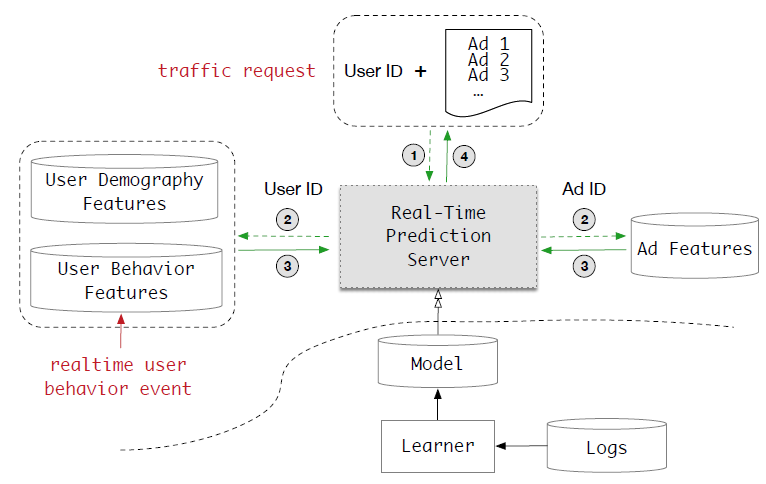

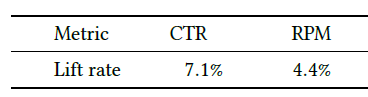

我们已经在阿里巴巴的展示广告系统中部署了提出的解决方案。我们在

2019-03-30 ~ 2019-05-10进行了严格的在线A/B测试实验,从而验证提出的MIMN模型。和

DIEN(我们的最新产品模型)相比,MIMN的CTR和RPM(Revenue Per Mille每千次收入)均提高了7.5%。我们将此归因于提出的co-design解决方案从长的用户行为序列中挖掘的额外信息。

24.2.2 部署经验

这里我们讨论在我们的在线系统中,部署

UIC和MIMN的实践经验。UIC Server和RTP Server的同步synchronization:如前所述,MIMN是通过UIC server和RTP server一起来实现的。因此,UIC server和RTP server之间存在不同步out-sync的问题。在周期性模型部署的实际系统中,两个

server的异步参数更新可能导致不正确的模型推断,这具有很大的风险。下表给出了模拟不同步场景实验的结果。注意,在该实验中,out-sync时间的间隔在一天之内,这是工业系统中的常见设置。实际上,在我们的真实系统中,模型部署被设计为每小时执行一次,这进一步降低了风险。可以看到

MIMN针对out-sync具有很好的鲁棒性。我们认为这是由于MIMN学到的用户兴趣的稳定表示stable representation,从而使得MIMN具有良好的泛化性能。

超大规模

big-scale数据的影响:如今很多电商网站都采用大促来吸引用户进行在线消费,例如阿里巴巴的”双十一“活动。在这种极端情况下,样本的分布以及用户行为和日常情况大相径庭。我们比较了系统中11.11大促日收集的训练数据、以及不包含11.11大促日的训练数据,这两种情况下MIMN的性能。结果如下表所示。我们发现:最好移除

big-scale数据。

Warm Up Strategy:尽管UIC旨在进行增量更新,但是从一开始就需要相当长时间才能进入稳定积累stable accumulation。 实际上我们采用预热策略warm up strategy来使用预先计算的用户兴趣表示来初始化UIC。即,我们为每个用户收集最近120天的历史行为(用户行为序列的平均长度为1000),并以离线模式使用训练好的MIMN来推断,然后将累积的memory推送到UIC中以便进行进一步的增量更新。该策略可以尽快地部署

MIMN,并取得合理的模型性能。Rollback Strategy:如果出现意外问题,如大规模在线作弊对训练样本的污染,UIC server的增量更新机制可能会遭受重大损失。 一个麻烦的挑战是寻找异常case发生的时间点。为了抵御这种风险,我们设计了一种回滚策略

rollback strategy,该策略将每天00:00学到的用户兴趣representation副本存储起来,并保存最近7天的副本。

二十五、SIM[2020]

点击率

Click-Through Rate: CTR预估建模在推荐系统recommender system和在线广告online advertising等工业应用中起着至关重要的作用。由于用户历史行为数据user historical behavior data的快速增长,以学习用户兴趣的意图representation为重点的用户兴趣建模user interest modeling被广泛引入CTR预估模型。然而,由于真实在线系统中计算负担和存储负担的限制,大多数提出的方法只能对长度最多数百的用户行为序列数据进行建模。事实证明,丰富的用户行为数据具有巨大的价值。例如,在全球领先的电商网站之一的淘宝网中,有

23%的用户在过去五个月内点击了1000多种商品。如何设计一种可行的解决方案来对长的用户行为序列数据long sequential user behavior data进行建模,这一直是一个开放而热门的话题,吸引了来自工业界和学术界的研究人员。研究的一个分支借鉴了

NLP领域的思想,提出使用memory network对长的用户行为序列数据进行建模,并取得了一些突破。阿里巴巴提出的MIMN是一项典型的工作,它是通过共同设计(co-design)学习算法和serving system来达到SOTA的。MIMN是第一个可以对长度可达1000的用户行为序列进行建模的工业级解决方案。具体而言,

MIMN将一个用户多样化diverse的兴趣增量地incrementally嵌入到固定大小的memory matrix中。该矩阵将通过每个新的行为进行更新,这样用户建模的计算就和CTR预估解耦。因此,对于在线serving而言,latency将不再是问题。而存储代价依赖于memory matrix的大小,该大小远远小于原始的用户行为序列。在长期兴趣建模

long-term interest modeling中可以找到类似的思想。然而,对于memory network-based方法来建模任意长的序列数据仍然是具有挑战性的。实际上我们发现:当用户行为序列的长度进一步增加,比如增加到10000甚至更多时,对给定一个特定的候选item的情况下,MIMN无法精确地捕获用户的兴趣。这是因为将用户所有的历史行为编码到固定大小的memory matrix会导致大量的噪声被包含在memory unit中。另一方面,正如

DIN在以前的工作中指出的,一个用户的兴趣是多样化diverse的,并且在面对不同候选item时会有所不同。DIN的关键思想是:在面对不同的候选item时,从用户行为序列中搜索有效信息,从而建模用户的特定兴趣special interest。通过这种方式,我们可以解决将用户所有兴趣编码为固定大小的参数parameter的挑战。DIN确实为使用用户行为序列数据的CTR建模带来了很大的提升。但是,如前所述,面对长的用户行为序列数据,DIN的搜索公式的计算成本和存储成本是不可行的。因此,我们能否应用类似的搜索技巧,并设计一种更有效的方法来从长的用户行为序列数据中提取知识?

在论文

《Search-based User Interest Modeling with Lifelong Sequential Behavior Data for Click-Through Rate Prediction》中,作者通过设计一个新的建模范式来解决这一挑战,并将其命名为基于搜索的兴趣模型Search-based Interest Model: SIM。SIM采用了DIN的思想,并且仅捕获与特定候选item相关的用户兴趣。在

SIM中,用户兴趣是通过两个级联cascaded的搜索单元search unit来提取的:通用搜索单元

General Search Unit: GSU:充当原始的、任意长的行为序列数据的通用搜索,并具有来自候选item的query信息,最终得到和候选item相关的用户行为序列子集Sub user Behavior Sequence: SBS。为了满足

latency和计算资源的严格限制,在GSU中使用了通用、但是有效的方法。根据我们的经验,可以将SBS的长度缩短为数百个,并且可以过滤原始的、长的用户行为序列数据中的大部分噪声信息。精准搜索单元

Exact Search Unit: ESU:对候选item和SBS之间的精确关系进行建模。在这里,我们可以轻松应用DIN或DIEN提出的类似方法。

论文主要贡献:

提出了一种新的范式

SIM,用于长的用户行为序列数据进行建模。级联的两阶段搜索机制的设计使得SIM具有更好的能力,可以在可扩展性scalability和准确性accuracy方面为长期的life-long用户行为序列数据建模。介绍了在大规模工业系统中实现

SIM的实践经验。自2019年以来,SIM已经部署在阿里巴巴展示广告系统display advertising system中,带来了7.1%的CTR提升和4.4%的RPM提升。现在SIM正在服务于主要流量。将长的用户行为序列数据建模的最大长度提高到

54000,比已发布的SOTA行业解决方案MIMN大54倍。

相关工作:

用户兴趣模型

User Interest Model:基于深度学习的方法在CTR预估任务中取得了巨大的成功。在早期,大多数前期作品使用深度神经网络来捕获来自不同

field的特征之间的交互,以便工程师可以摆脱枯燥的特征工程的工作。最近,我们称之为用户兴趣模型User Interest Model的一系列工作聚焦于从用户历史行为中学习潜在用户兴趣的representation,这些工作使用不同的神经网络架构(如CNN, RNN, Transformer, Capsule等等)。DIN强调用户的兴趣是多样化的,并引入了一种attention机制来捕获用户对不同target item的diverse兴趣。DIEN指出,用户历史行为之间的时间关系对于建模用户漂移drifting的兴趣非常重要。在DIEN中设计了一个基于GRU的、带辅助损失的兴趣抽取层interest extraction layer。MIND认为,使用单个向量来表示一个用户不足以捕获用户兴趣的变化的特性varying nature。在MIND中引入了胶囊网络Capsule network和动态路由方法dynamic routing method,从而学习用户兴趣的、以多个向量表示的representation。受到

self-attention架构在seq-to-seq learning任务重成功的启发,DSIN引入了Transformer来对用户的cross-session和in-session中的兴趣进行建模。

长期用户兴趣

Long-term User Interest:MIMN的论文中显示了在用户兴趣模型中考虑长期历史行为序列可以显著提高CTR模型的性能。尽管更长的用户行为序列为用户兴趣建模带来了更多有用的信息,但是它极大地增加了在线serving sysem的延迟和存储负担,同时也为point-wise的CTR预估带来了大量的噪声。一系列工作聚焦于解决长期用户兴趣建模中的挑战。长期用户兴趣建模通常基于非常长的、甚至是

life-long的历史行为序列来学习用户兴趣representation。《Lifelong Sequential Modeling with Personalized Memorization for User Response Prediction》提出了一种Hierarchical Periodic Memory Network,用于对每个用户进行life-long序列建模,其中对序列模式进行个性化memorization。《Adaptive user modeling with long and short-term preferences for personalized recommendation》选择一个attention-based框架来结合用户的长期偏好和短期偏好。他们采用了attentive Asymmetric-SVD范式来对长期兴趣建模。《Practice on Long Sequential User Behavior Modeling for Click-through Rate Prediction》提出了一种memory-based的架构,称作MIMN。该架构将用户的长期兴趣嵌入到固定大小的memory network中,从而解决用户兴趣数据的大容量存储问题。并且他们设计了一个UIC模块来增量记录新的用户行为,从而解决latency的限制。但是,

MIMN在memory network中放弃了target item的信息,而target item已经被证明对于用户兴趣建模很重要。

25.1 模型

通过建模用户行为数据来预估

CTR,这已经被证明是有效的。典型地,attention-based CTR模型(如DIN, DIEN)设计复杂的模型结构,并且包含attention机制,以通过从用户行为序列中搜索有效知识来捕获用户的多样化兴趣。其中搜索的input来自于不同的候选item。但是在现实世界的系统中,这些模型只能处理长度小于

150的短期short-term行为序列数据。另一方面,长期long-term用户行为数据很有价值,并且对长期兴趣进行建模可以为用户带来更多样化的推荐结果。我们似乎陷入了一个两难的境地:在现实世界的系统中,我们无法通过有效而复杂的方法来处理有价值

valuable的life-long用户行为数据。为应对这一挑战,我们提出了一种新的建模范式,称之为基于搜索的兴趣模型Search-based Interest Model: SIM。SIM遵循两阶段搜索策略,可以有效地处理长的用户行为序列。我们首先介绍

SIM的总体工作流程,然后详细介绍我们提出的两种搜索单元search unit。SIM遵循一个级联的two-stage search策略,其中包含两个单元:通用搜索单元General Search Unit: GSU、精确搜索单元Exact Search Unit: ESU。SIM的整体工作流如下图所示。第一阶段:我们利用

GSU从原始的长期行为序列中寻找top-K相关(relevant)的子行为序列,其复杂度为线性时间复杂度。这里K通常要比原始序列的长度要短得多。如果有时间和计算资源的限制,则可以执行一种有效的搜索方法来搜索相关

relevant的子行为序列。在后续内容中,我们提供了GSU的两种简单实现:软搜索soft-search和硬搜索hard-search。GSU采取一种通用general但有效effective的策略来减少原始的行为序列的长度,从而满足对时间和计算资源的严格限制。同时,长期用户行为序列中可能会破坏用户兴趣建模的大量噪声可以在第一阶段通过搜索策略进行过滤。第二阶段:

ESU将经过过滤的用户行为子序列作为输入,并进一步捕获精确的用户兴趣。由于长期用户行为序列的长度已经减少到数百,因此可以应用复杂体系结构的精巧(

sophisticated) 的模型,如DIN, DIEN等等。

然后遵循传统的

Embedding&MLP范式,将精确的长期用户兴趣的输出、以及Other Feature作为输入。注意:尽管我们分别介绍了这两个阶段,但是实际上它们是一起训练的。

长期用户行为序列是否包含短期用户行为序列?论文未说明这一点。看结构图的描述,似乎不包含。

25.1.1 General Search Unit

给定一个候选

item(即将被CTR模型打分的target item),只有一部分用户行为有价值。这部分用户行为与最终用户决策密切相关。挑选出这些相关relevant的用户行为有助于用户兴趣建模。然而,使用整个用户行为序列直接对用户兴趣进行建模将带来巨大的资源占用和响应延迟(

latency),这在实际应用中通常是无法接受的。为此,我们提出了一个通用搜索单元(general search unit: GSU),从而减少用户兴趣建模中用户行为的输入数量。这里,我们介绍两种通用的搜索单元:硬搜索hard-search和软搜索soft-search。给定用户行为的列表

item),item的相关性得分relevant scoretop-K的相关relevant行为作为行为子序列sub behaviour sequence。K的大小对模型性能的影响如何?论文并未进行消融实验。硬搜索和软搜索的区别在于相关的分

其中:

target item的类目。embedding向量,target item的embedding向量。item embedding的维度,对于软搜索,

GSU和ESU共享相同的embedding参数。

硬搜索

hard-search:硬搜索模型是非参数(non-parametric) 的。只有和候选item相同类目category的行为被挑选出来,然后得到一个子行为序列并发送给ESU。硬搜索非常简单,稍后在实验中我们证明它非常适合在线

serving。对于

hard-search,如何选择top-k?因为它的score要么为0、要么为1。这使得相同category的行为,其score全部为1。软搜索

soft-search:在软搜索模型中,首先将one-hot向量,然后嵌入到低维向量为了进一步加速成千上万个用户行为的

top-K搜索,基于embedding矩阵sublinear time的最大内积搜索maximum inner product search方法ALSH用于搜索和target item最相关的top-K行为。其中distinct行为的embedding向量组成。借助训练好的

embedding和最大内积搜索Maximum Inner Product Search: MIPS方法,成千上万个用户行为可以减少到数百个。需要注意的是:长期

long-term数据和短期short-term数据的分布是不同的。因此,在软搜索模型中直接使用从短期用户兴趣建模中学到的参数可能会误导长期用户兴趣建模。所以在本文中,软搜索模型的参数是在基于长期行为数据的辅助CTR预估任务下训练的,如上图左侧的软搜索训练soft search training所示。用户整体行为序列的

representation行为

representationtarget Ad向量Multi-Layer Perception: MLP的输入,从而建模辅助任务。注意,如果用户行为序列增长到一定程度,则不可能将整个用户行为序列馈入辅助任务的模型。这种情况下,可以从长的用户行为序列中随机采样子序列,子序列仍然遵循原始行为序列相同的分布。

作者提到 “对于软搜索,

GSU和ESU共享相同的embedding参数“,这意味着embedding layer的训练不仅依赖于main task,还依赖于这里的辅助任务。

25.1.2 Exact Search Unit

在第一个搜索阶段,我们从长期用户行为中选择和

target item最相关的top-K子用户行为序列Exact Search Unit: ESU。ESU是一个以attention-based的模型。考虑到这些选出来的用户行为横跨了很长时间,因此每个用户行为的贡献是不同的,所以涉及到每个行为的时间属性

temporal property。具体而言,target item和选出来的K个用户行为的时间间隔temporal distance信息。embedding矩阵embedding矩阵representation,记作time info用向量拼接还是直接逐元素相加?可以做个消融实验分析。我们利用

multi-head attention来捕获用户的多样化兴趣:其中:

attention score,head的attention。head的权重矩阵。

最终的用户长期

diverse兴趣表示为:head数量。然后MLP中用于点击率预估。最终模型同时使用了长期用户行为和短期用户行为,其中:

长期用户行为使用

ESU来抽取长期用户兴趣representation短期用户行为使用

DIEN来抽取短期用户兴趣representation

长期用户兴趣

representationrepresentationOther feature representation一起拼接作为后续MLP的输入。长期用户兴趣由长期用户行为来捕获,这里使用

GSU + ESU的原因是序列太长,DIEN无法处理。短期用户兴趣由短期用户行为来捕获,这里使用

DIEN是因为序列较短因此可以更精细地建模。对于较短的序列,没必要使用GSU来硬过滤。最后,我们在交叉熵损失函数下同时训练

GSU和ESU:其中:

如果

GSU为软搜索模型,则如果

GSU使用硬搜索模型,那么

ESU单元的损失,这也是SIM模型主任务的目标损失。GSU单元的损失。如果

GSU为硬搜索,则由于硬搜索没有参数,因此不考虑其损失。如果

GSU为软搜索,则它是SIM模型辅助任务的目标损失。辅助任务也是一个CTR预估任务,只是它采用了更简单的架构(没有multi-head、没有DIEN)、更少的特征(没有短期用户行为、没有Other feature)。

这个辅助损失函数本质上是强制

GSU部分学到的embedding是任务相关的。SIM、DeepMCP、DMR等模型都是类似的思想,要求模型的子结构也能够捕获到CTR相关的信息,从而使得约束了模型的解空间。

25.1.3 在线实现

这里我们介绍在阿里巴巴的展示广告系统

display advertising system中实现SIM的实际经验。life-long用户行为数据在线serving的挑战:工业级的推荐系统或广告系统需要在一秒钟内处理的大量的流量请求,这需要CTR模型实时响应。通常,serving latency应该小于30毫秒。下图简要说明了我们在线展示广告系统中用于CTR任务的实时预测Real Time Prediction: RTP系统。该系统由两个关键组件组成:计算节点(Computation Node)、预估server。考虑到

lifelong的用户行为,在实时工业系统中建立长期的用户兴趣model serving就变得更加困难。存储和延迟的限制可能是长期用户兴趣模型的瓶颈。实时请求的数据量(数据量 = 请求条数 x 单条请求的数据量)会随着用户行为序列长度的增加而线性增加。此外,我们的系统在流量高峰时每秒可为超过100万用户提供服务。因此,将长期模型部署到在线系统是一个巨大的挑战。

在线

serving系统:前面我们提出了两种类型的GSU:软搜索模型和硬搜索模型。对于软搜索模型和硬搜索模型,我们对从阿里巴巴在线展示广告系统收集的工业数据进行了广泛的离线实验。我们观察到软搜索模型生成的

top-K行为数据与硬搜索模型的结果极为相似。换句话讲,软搜索的大部分top-K行为通常属于target item相同类目category的。这是我们场景中数据的一个特色。在电商网站中,属于同一类目的item在大多数情况下是相似的。考虑到这一点,尽管在离线实验中软搜索模型的性能要比硬搜索模型稍好,但是在平衡性能提升和资源消耗之后,我们选择硬搜索模型将SIM部署到我们的广告系统中。对于硬搜索模型,包含所有长的用户行为序列数据的索引是关键组件。我们观察到,行为可以通过其所属类目自然访问到。为此,我们为每个用户建立一个两级的结构化索引

two-level structured index,并将其命名为用户行为树(user behavior tree: UBT),如下图所示。简而言之,

UBT遵循Key-Key-Value数据集结构:第一个key是user-id,第二个key是category id,最后一个value是属于每个类目的特定的行为item。UBT被实现为分布式系统,最大容量可达22TB,并且足够灵活以提供高吞吐量的query。然后,我们将

target item的category作为我们的硬搜索query。在

GSU之后,用户行为的长度可以从一万多个减少到数百个。因此,可以缓解在线系统中lifelong行为的存储压力。下图显示了

SIM的新CTR预估系统。新系统加入了一个硬搜索模块,以从长的用户行为序列数据中寻找target item相关的有效行为effective behaviors。注意:

GSU的UBT的索引可以离线构建。这样,在线系统中的GSU的响应时间可以非常短,与GSU的索引构建相比可以忽略。此外,其它用户特征可以并行计算。如何解决

category不平衡问题?例如,某些类目的商品特别多,另一些类目的商品很少。

25.2 实验

这里我们详细介绍了我们的实验,包括数据集、实验配置、模型比较、以及一些相应的分析。由于

SIM已经部署在我们的在线广告系统中,因此我们还会进行仔细的在线A/B test,并比较几个著名的工业级的模型。数据集:我们在两个公共数据集、以及阿里巴巴在线展示广告系统收集的工业数据集进行了模型比较。

Amazon Dataset:由Amazon的商品评论和元数据meta-data组成。我们使用Amazon数据集的Books子集,该子集包含75053个用户、358367个item、1583个类目category。对于该数据集,我们将评论视为一种交互行为,并按时间对一个用户的评论进行排序。

Amazon Books数据集的最大行为序列长度为100。我们将最近的10个用户行为划分为短期short-term用户序列特征,将最近的90个用户行为划分为长期long-term用户序列特征。这些预处理方法已经在相关作品中广泛使用。Taobao Dataset:是来自淘宝推荐系统的用户行为集合。数据集包含几种类型的用户行为,包括点击、购买等。它包含大约800万用户的用户行为序列。我们采用每个用户的点击行为,并根据时间对其进行排序从而构建用户行为序列。

Taobao Dataset的最大行为序列长度为500。我们将最近的100个用户行为划分为短期用户序列特征,将最近的400个用户行为划分为长期用户序列特征。数据集将很快公开。Industrial Dataset:是从阿里巴巴在线展示广告系统收集的。样本是由曝光日志构建的,标签为是否点击。训练集是由过去49天的样本组成,测试集是第50天的样本组成,这是工业建模的经典设置。在这个数据集中,每个样本的用户行为特征包含最近

180天的历史行为序列作为长期行为特征,以及最近14天的历史行为序列作为短期行为特征。超过30%的样本包含长度超过1万的行为序列数据。此外,行为序列的最大长度达到54000,这比MIMN中的行为序列长54倍。

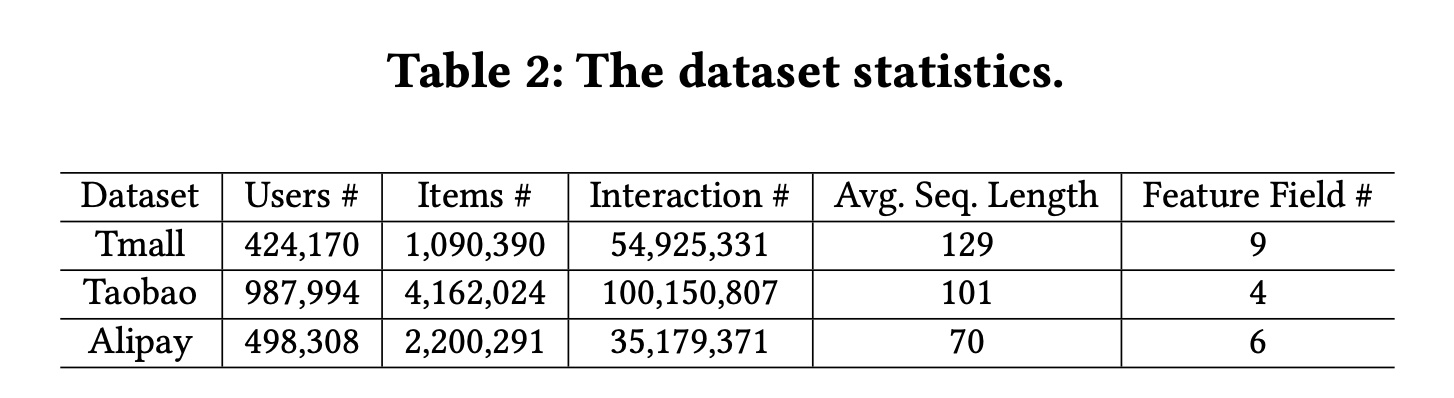

这些数据集的统计信息如下表所示。注意,对于

Industrial Dataset,item为广告。

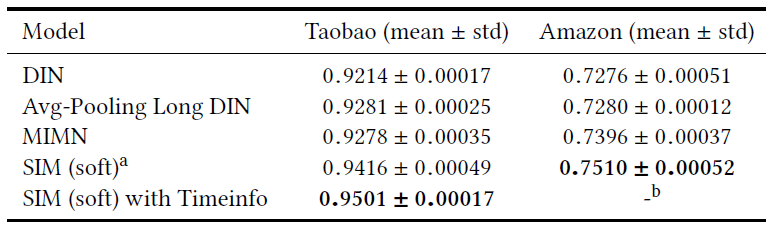

baseline方法:我们将SIM和以下主流的CTR预估模型进行比较。DIN:是用户行为建模的早期工作,旨在针对候选item进行用户行为的软搜索。和其它长期用户兴趣模型相比,DIN仅将短期用户行为作为输入。Avg-Pooling Long DIN:为了比较长期用户兴趣下的模型性能,我们对长期行为应用了均值池化操作(没有使用任何attention操作),并将long-term embedding、以及其它特征embedding拼接起来。MIMN:它巧妙地设计了模型体系结构从而捕获长期的用户兴趣,实现了SOTA性能。SIM(hard):我们提出的SIM模型,其中第一阶段使用硬搜索,并且在ESU中没有time embedding。SIM(soft):我们提出的SIM模型,其中第一阶段使用软搜索,并且在ESU中没有time embedding。SIM(hard/soft) with Timeinfo:我们提出的SIM模型,其中第一阶段使用硬搜索/软搜索,并且在ESU使用time embedding。

实验配置:我们采用与相关工作(即

MIMN)相同的实验配置,以便可以公平地比较实验结果。对所有模型,我们使用

Adam优化器。我们使用指数衰减,学习率从

0.001开始。全连接网络

FCN的layer设置为200 x 80 x 2。embedding维数设置为4。我们使用

AUC作为模型性能的评估指标。

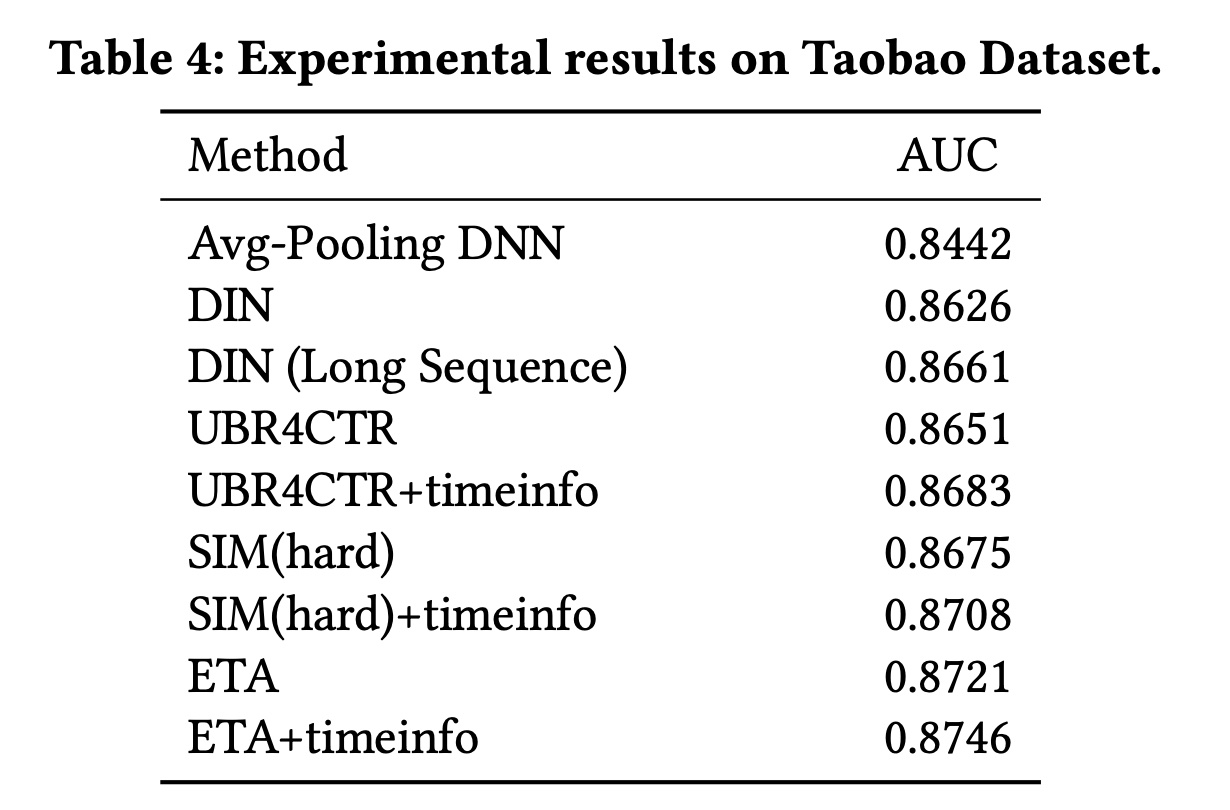

下表显式了所有模型在公共数据集上的比较结果。

a表示SIM采用软搜索且没有时间间隔的embedding。b没有在Amazon Dataset上实验,因为该数据集没有时间戳数据。和

DIN相比,具有长期用户行为特征的其它模型的性能要好得多。这表明长期用户行为对CTR预估任务很有帮助。和

MIMN相比,SIM取得了显著提升,因为MIMN将所有未过滤的用户历史行为编码到固定长度的memory中,这使得难以捕获多样化的长期用户兴趣。SIM使用两阶段搜索策略从庞大的历史行为序列中搜索相关的行为,并针对不同target item来建模多样化的长期用户兴趣。实验结果表明:

SIM优于所有其它长期兴趣模型。这充分证明了我们提出的两阶段搜索策略对于长期用户兴趣建模很有用。而且,包含time embeding可以实现进一步的提升。

在这个

Taobao数据集中,MIMN的指标与原始MIMN中的指标对不上,可能的原因是:这里的Taobao数据集与之前的Taobao数据集不同。

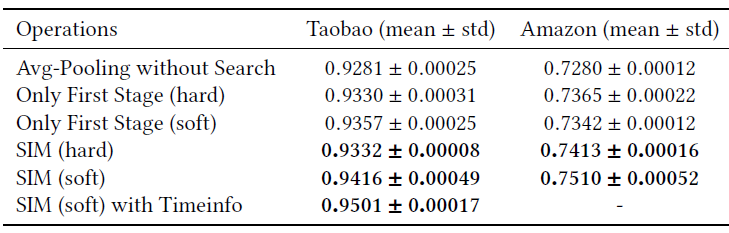

消融研究--两阶段搜索的有效性:如前所述,我们的

SIM模型使用两阶段搜索策略。第一阶段遵循通用搜索策略,从而过滤得到与

target item相关的历史行为。第二阶段对第一阶段的行为进行

attention-based的精确exact搜索,从而准确地accurately捕获用户对于target item的多样化的长期兴趣。

这里我们通过对长期历史行为应用不同操作的实验来评估所提出的两阶段搜索架构的有效性。这些不同的操作如下:

Avg-Pooling without Search:仅仅简单地应用均值池化来聚合长期行为embedding,没有使用任何过滤。它和Avg-Pooling Long DIN相同。Only First Stage(hard):在第一阶段对长期历史行为应用硬搜索,并通过对过滤后的结果应用均值池化从而得到固定大小的、聚合的embedding,从而作为MLP的输入。即没有第二阶段搜索策略。Only First Stage (soft)几乎和Only First Stage(hard),但是前者采用软搜索而不是硬搜索。我们根据预训练

pre-trained的embedding向量,离线计算target item和长期用户行为之间的内积相似度得分。然后根据相似度得分选择top 50个相关行为来进行软搜索。最后三个实验是我们提出的两阶段搜索架构的搜索模型。

实验结果如下表所示,可以看到:

与简单的均值池化

embedding相比,所有具有过滤策略的方法都极大地提高了模型性能。这表明在原始的长期行为序列中确实存在大量的噪声,而这些噪声可能会破坏长期用户兴趣的学习。和仅进行一阶段搜索的模型相比,我们提出的具有两阶段搜索策略的搜索模型通过在第二阶段引入

attention-based的搜索而取得了进一步的提升。这表明:精确地建模用户对target item的多样化的长期兴趣,有助于CTR预估任务。并且在第一阶段搜索之后,过滤后的行为序列通常比原始序列短得多,attention操作不会给在线RTP系统带来太多负担。包含

time embedding的模型得到了进一步的提升,这表明不同时期peroid的用户行为的贡献是不同的。

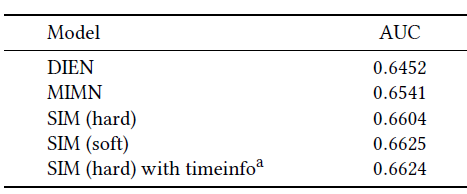

我们进一步对阿里巴巴在线展示广告系统收集的工业数据集进行实验,下表给出了实验结果。

a表示该模型目前已经部署在我们的在线serving系统,并且服务于主要的流量。SIM相比MIMN在AUC上提升了0.008,这对于我们的业务而言意义重大。和第一阶段使用硬搜索相比,第一阶段使用软搜索的性能更好。

在第一阶段,硬搜索和软搜索这两种搜索策略之间只有微小的差距。

在第一阶段应用软搜索会花费更多的计算资源和存储资源。因为软搜索需要在

online serving中使用最近邻搜索,而硬搜索只需要从离线构建的两级索引表中检索。因此,硬搜索更加有效且系统友好。对两种不同的搜索策略,我们对来自工业数据集的超过

100万个样本和10万个具有长期历史行为的用户进行了统计。结果表明:硬搜索策略保留的用户行为可以覆盖软搜索策略的75%。

最后,我们在第一阶段选择更简单的硬搜索策略,这是在效率

efficiency和性能performance之间的trade-off。

在线

A/B test:自2019年以来,我们已经在阿里巴巴的展示广告系统中部署了SIM。从2020-01-07 ~ 2020-02-07,我们进行了严格的在线A/B test实验,从而验证SIM模型。和MIMN(我们的最新模型)相比,SIM在阿里巴巴的展示广告场景中获得了巨大收益,如下表所示。现在,SIM已经在线部署并每天为主要场景流量提供服务,这为业务收入的显著增长做出了贡献。下表为

2020-01-07 ~ 2020-02-07期间,SIM相对于MIMN的在线效果提升,其中模型应用于淘宝App首页的“猜你喜欢” 栏目。

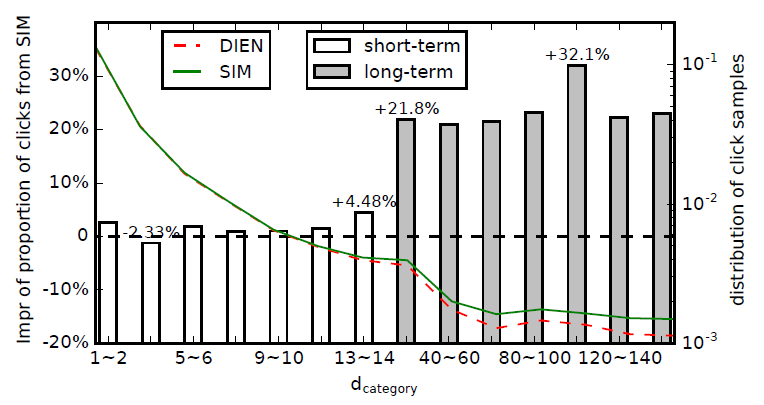

Rethinking Search Model:我们在用户长期兴趣建模方面做出了巨大努力,所提出的SIM在离线和在线评估方面都取得了良好的性能。但是 ,由于进行了精确的长期兴趣建模,SIM的性能会更好吗?SIM是否会倾向于推荐和人们长期兴趣相关的item?为回答这两个问题,我们制定了另一个指标,即点击样本的

Days till Last Same Category Behaviorcateogry的item上的最近行为距离当前点击事件的时间间隔。例如,用户

itemitemitem)。如果将点击事件记作Days till Last Same Category Behavior为5,即对于给定的模型,可以使用

long-term interest或短期兴趣short-term interest上的选择偏好(selection preference) 。经过在线

A/B test之后,我们根据提出的SIM和DIEN(这是短期的CTR预估模型的最新版本)的点击样本。点击样本越多则说明模型效果越好(模型找的越准)。根据

>14天)、短期的(<14天)。方框显示了不同SIM模型点击样本的提升比例(相对于DIEN模型)。曲线表示不同可以看到:在短期部分(

SIM和DIEN在过去14天中都具有短期的用户行为特征。在长期部分,SIM提升比例更大。

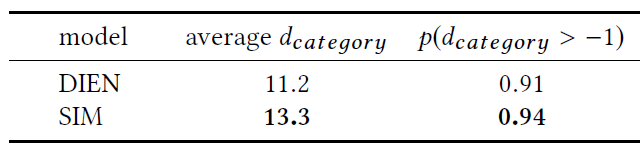

此外在工业数据集上,我们统计了

target item相同类目的历史行为的概率。结果如下表所示(在线a/b test对应的点击样本,在离线上统计到的)。结果表明:

SIM的提升确实是更好的长期兴趣建模的结果。并且和DIEN相比,SIM倾向于推荐与人们长期行为有关的item。

读者注:这里假设

A/B test时流量相等,因此点击量的差异等价于CTR的差异。部署的实践经验:这里我们介绍了在线

serving系统中实现SIM的实践经验。阿里巴巴的高流量是众所周知的,它在流量高峰时每秒为超过

100万用户提供服务。此外,对于每个用户,RTP系统需要计算数百个候选item的预估CTR。我们对整个离线用户行为数据建立一个两阶段索引,该索引每天都会更新:第一阶段是user id;在第二阶段,一个用户的life-long行为数据由该用户所交互的类目来索引。虽然候选

item的数量为数百,但是这些item的类目数量通常少于20。同时,来自GSU的每个类目的子行为序列的长度被截断为不超过200(原始的行为序列长度通常小于150)。这样,来自用户的每个请求的流量是有限的并且可以接受的。此外,我们通过

deep kernel fusion优化了ESU中multi-head attention的计算。下图显示了我们的实时

CTR预估系统相对于DIEN,MIMN,SIM流量的效率。值得注意的是:MIMN可以处理的最大用户行为长度是1000,而这里显示的性能是基于截断的行为数据(MIMN和DIEN中,用户行为的长度被截断为1000)。而

SIM中的用户行为的长度不会被截断,并且可以扩展到54000,使得最大长度可以扩展到54倍。针对一万个行为的SIM serving,相比于截断用户行为的MIMN serving,latency仅增加了5ms。DIEN的最大流量为200,因此图中只有一个点。

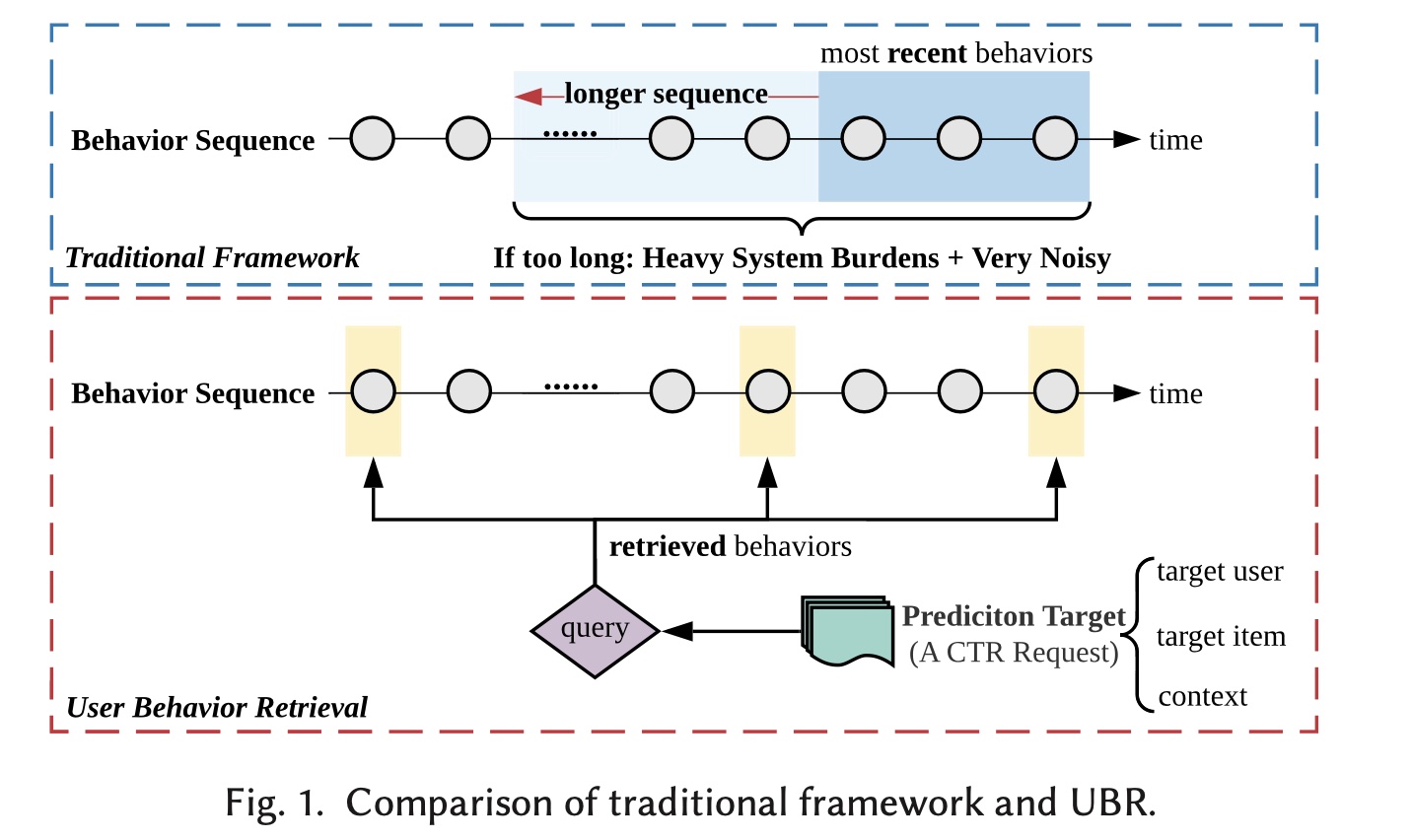

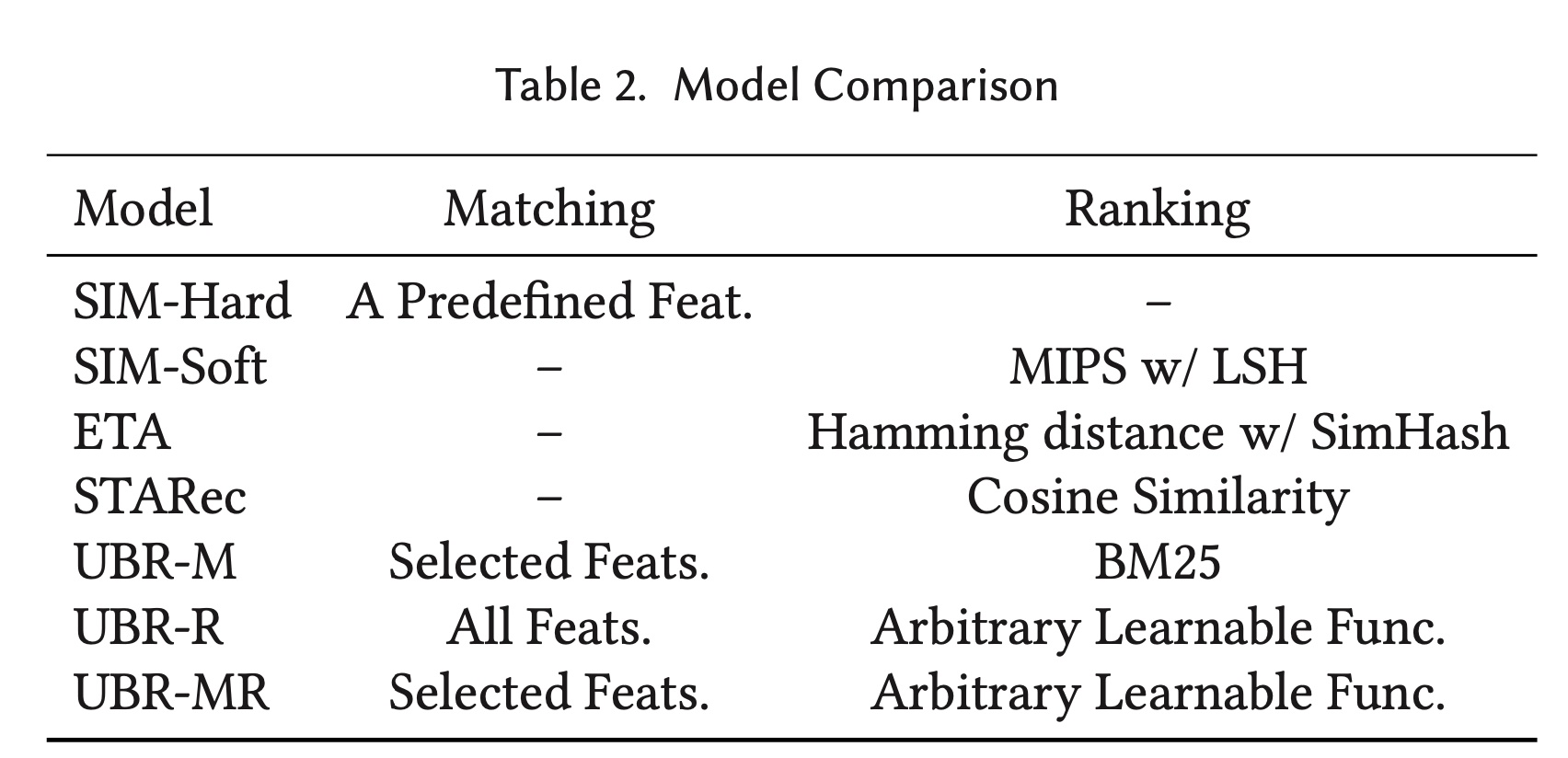

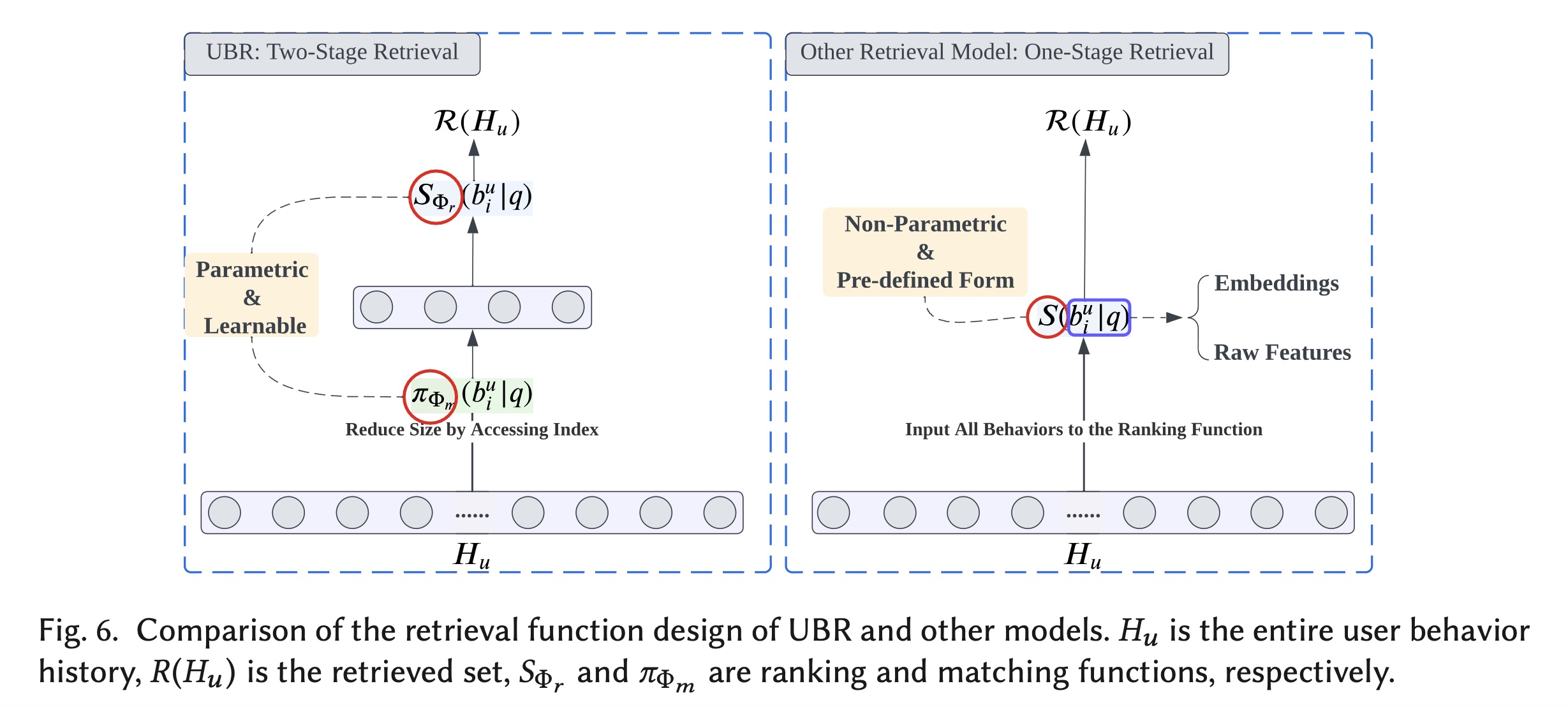

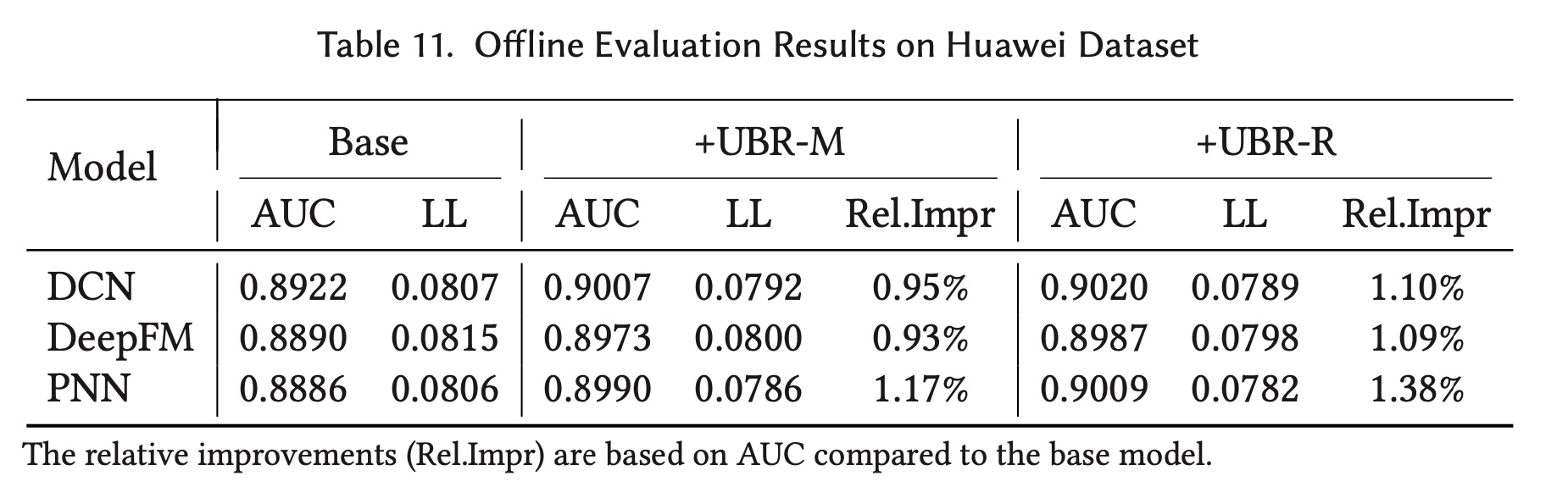

五十一、UBR4CTR [2020]

《User Behavior Retrieval for Click-Through Rate Prediction》

CTR prediction在现代的online personalization services中起着关键作用。在实践中,需要通过对用户行为序列进行建模来捕获用户的兴趣变化,以构建准确的CTR prediction模型。然而,随着用户在平台上积累越来越多的行为数据,对sequential models而言,利用每个用户的whole behavior history变得并非易事。首先,直接馈入长的行为序列将使在线推理时间和系统负载变得不可行。

其次,如此长的历史行为序列中存在大量噪音,导致

sequential model learning的失败。

当前的业界的解决方案主要截断序列并仅将近期行为馈入

prediction model,这导致一个问题,即:周期性或长期依赖性等sequential patterns未被纳入近期的若干个behaviors中,而是包含在很久以前的历史中。为了解决这些问题,在本文中,我们从数据的角度考虑它,而不仅仅是设计更复杂的模型,并提出了User Behavior Retrieval for CTR prediction: UBR4CTR框架。在UBR4CTR中:首先使用可学习的搜索方法从整个用户历史序列中检索最相关、最合适的

user behavior。然后将这些被检索到的行为(而不是简单地使用近期行为)馈入到

deep model中以进行最终预测。

以低成本将

UBR4CTR部署到industrial model pipeline中是非常可行的。在三个真实世界大型数据集上的实验证明了我们提出的框架和模型的优越性和有效性。CTR prediction在当今的在线个性化平台(例如电商、在线广告、推荐系统)中起着关键作用,其目标是预测用户在特定情境下点击特定item的概率。在线个性化平台经过十多年的发展,平台上记录的user behavior数量迅速增长。23%的用户在六个月内在淘宝上有超过1000次behavior(《Lifelong Sequential Modeling with Personalized Memorization for User Response Prediction》)。由于user behavior中存在丰富的时间模式(temporal patterns),因此建立一个有效且高效的模型,利用user behavior序列来获得准确的CTR prediction成为业界和学术界的一个重要问题。在深度学习时代,有许多

DNN-based的CTR prediction模型,例如Wide&Deep、FNN、DeepCross、DeepFM、PNN和xDeepFM,其中大多数已部署在商业的个性化平台上。这些模型强调挖掘特征交互(feature interactions),并被用于更好地利用数据的multi-categorical features。然而,这些模型忽略了user behavior的序列模型或时间模式(sequential or temporal patterns)。如

《Spatio-temporal models for estimating click-through rate》、《Vista: a visually, socially, and temporally-aware model for artistic recommendation》、《Recurrent neural networks with top-k gains for session-based recommendations》、《Collaborative filtering with temporal dynamics》所示,user behavior的temporal dynamics在预测用户未来兴趣方面起着关键作用。这些序列模式(sequential patterns)包括概念漂移(concept drifting)、长期behavior依赖性(long-term behavior dependency)、周期性模式(periodic patterns)等。因此,在CTR prediction和序列推荐任务中,人们提出了一些模型来捕获用户的序列模式。对于

CTR prediction,有attention-based的模型,如DIN和DIEN;有memory network-based的模型,如HPMN。对于序列推荐,人们提出了更多的

user behavior modeling方法,这是一项与CTR prediction非常相似的任务。有RNN-based的模型、CNN-based的模型、Transformer-based的模型、以及memory network-based的模型。

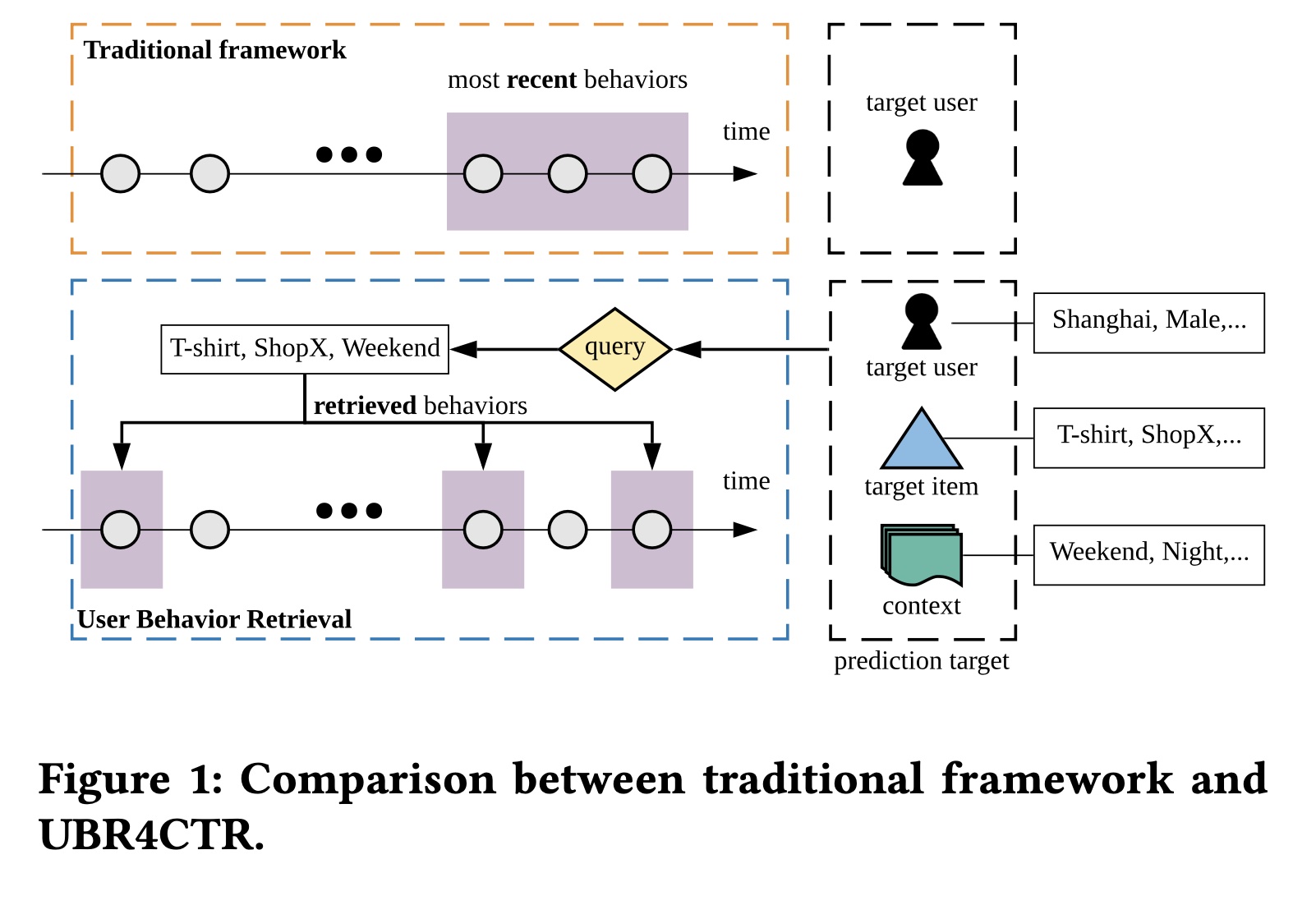

然而,上述大多数序列模型在实际应用中都有一个共同的问题。当平台记录了大量的

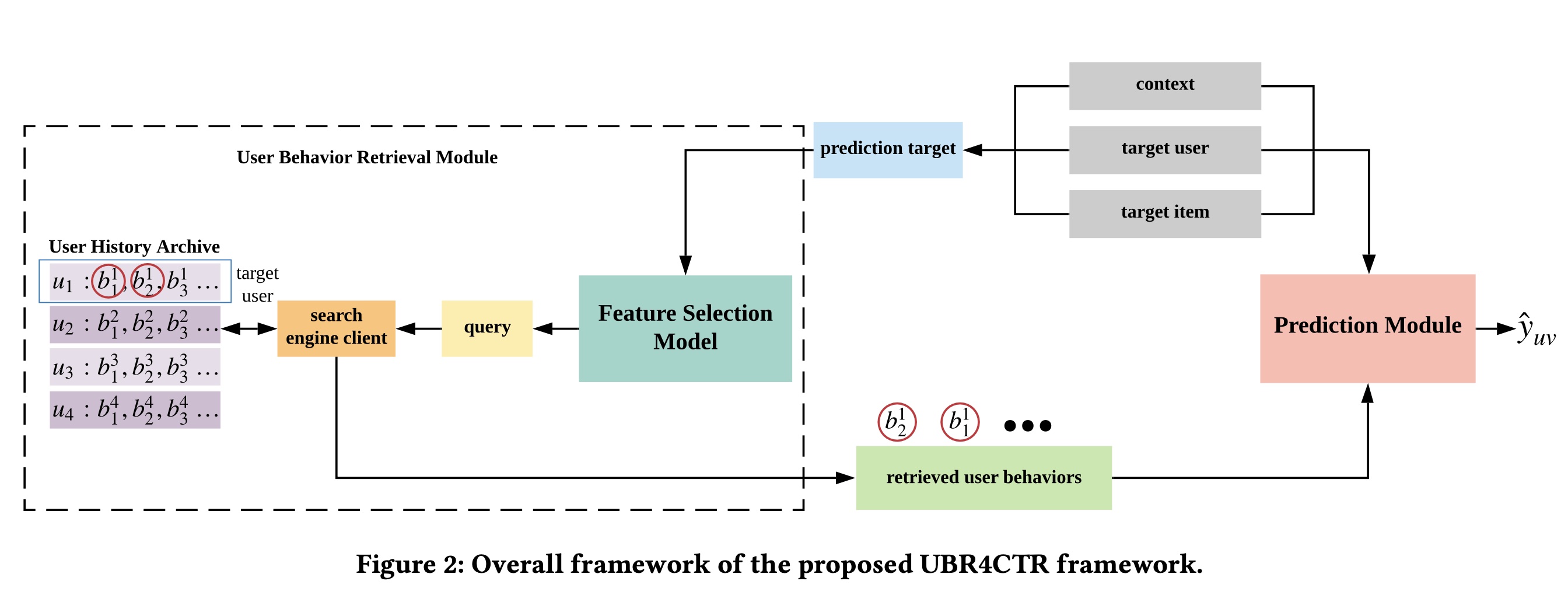

user behavior时,常见的工业解决方案是截断整个行为序列,只使用最近的behavior作为prediction model的输入,如Figure 1上半部分所示。online serving time的严格要求,加上系统负载和计算能力的瓶颈,限制了可使用的用户序列的长度。因此,在大多数情况下,使用的近期行为不超过50个(《Deep interest evolution network for click-through rate prediction》)。 使用最近behavior的传统框架可能会带来负面问题。很明显,有效的序列模式可能不仅仅包含在最近的行为序列中。它可以追溯到更远的历史,如周期性和长期依赖性。然而,如果我们尝试使用更长的序列,可能会引入大量不相关的behavior和噪音。更不用说更长的历史带来的时间复杂性和空间复杂性了。 在本文中,为了解决上述实际问题,我们尝试从数据的角度解决问题,而不是设计更复杂更精密的模型。具体来说,我们的目标是设计一个框架来检索对每个CTR prediction target最有用的有限数量的历史行为。如Figure 1所示,prediction target由三部分组成,即:target user、target item和相应的上下文。prediction target的特征包括用户的位置、性别、职业,以及item的category、品牌、商家,以及时间和场景等上下文特征。然后我们使用模型选择这些特征的一个子集,该子集构建一个query来检索相关的历史行为。用户的所有behavior都作为information items来存储在搜索引擎中,我们使用所生成的query从历史记录中进行搜索。被检索到的behavior用于CTR prediction。 对于同一用户的每个不同target item,我们将检索不同的behaviors来用于prediction,因为所生成的queries不同。对同一用户的不同items上的预测而言,与使用完全相同的最近behavior的传统框架相比,这是一个重大变化。最终的解决方案框架称为

User Behavior Retrieval for CTR: UBR4CTR。在UBR4CTR中,任务分为两个模块:第一个是可学习的检索模块,它由两个组件:

一个

self-attentive network,用于选择特征并形成query。以及一个搜索引擎,其中以倒排索引的方式存储

user behavior。

另一个模块是

prediction模块,其中构建了一个attention-based deep neural network,从而根据检索到的user behavior、以及prediction target的特征进行最终预测。

本文的贡献可以概括为三点:

我们揭示了一个重要事实,即在

user response prediction中,检索更相关的user behavior比仅仅使用最近的behavior更重要。我们没有设计更复杂的模型,而是将更多注意力放在检索用户的behavior数据上。我们提出了一个名为

UBR4CTR的新框架,该框架可以检索不同的behaviors从而用于同一用户在不同上下文中对不同items的CTR prediction。所有先前的序列模型仅使用用户最近的behavior。我们提出了一种search engine based的方法和一种有效的训练算法来学习检索适当的behavior数据。我们在三个现实世界的大型电商数据集上进行了大量的实验,并将我们的框架与传统框架中几个强大的

baselines进行了比较。结果验证了UBR4CTR框架的有效性。

UBR4CTR是SIM(hard)的扩展。在SIM(hard)中,我们使用catgory of target item作为query从而执行检索。而在UBR4CTR中,我们根据不同的input来自动选择合适的query来执行检索。但是,更复杂的query引入了更复杂的检索系统(一个搜索引擎客户端),增加了工程量。

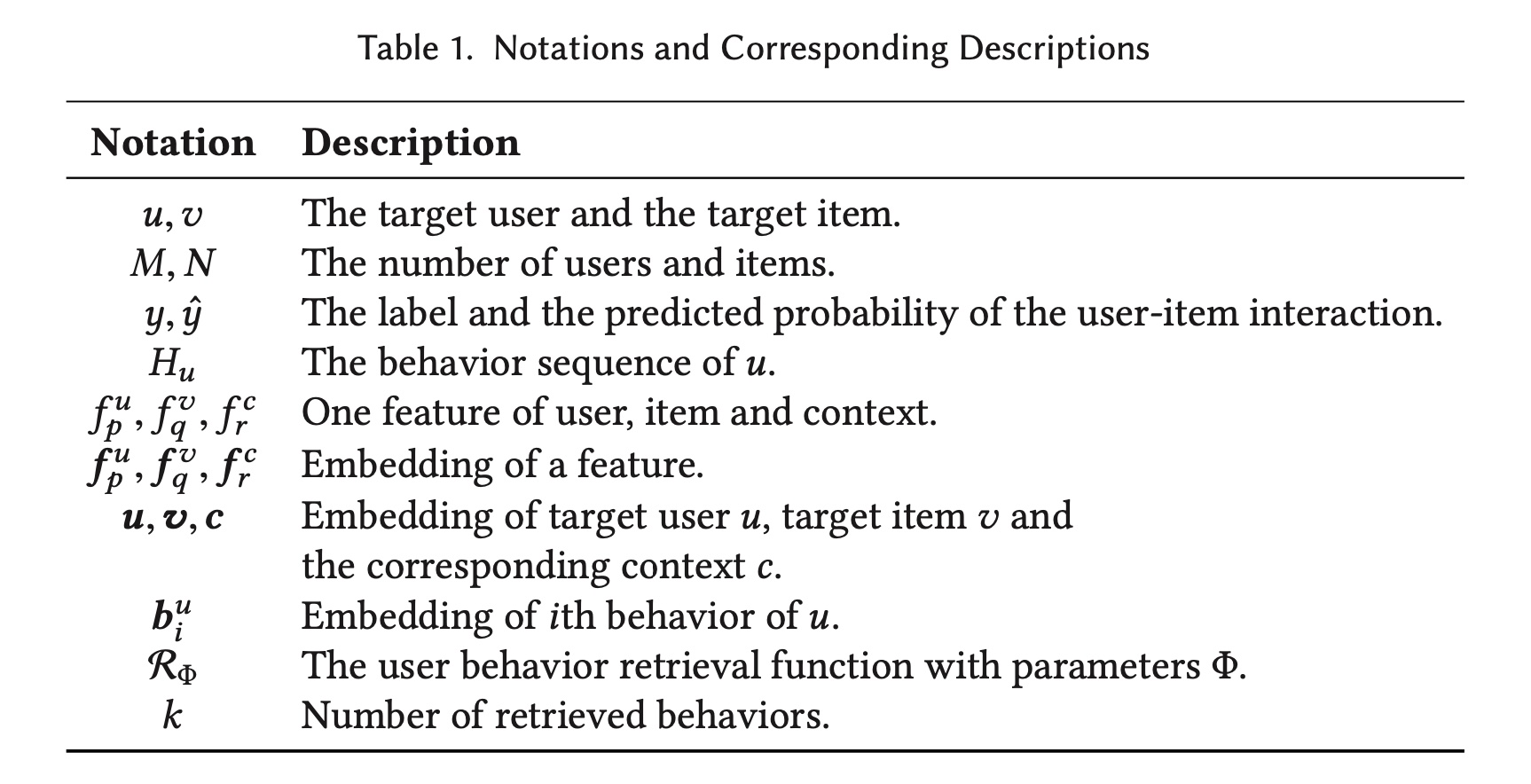

51.1 基础知识

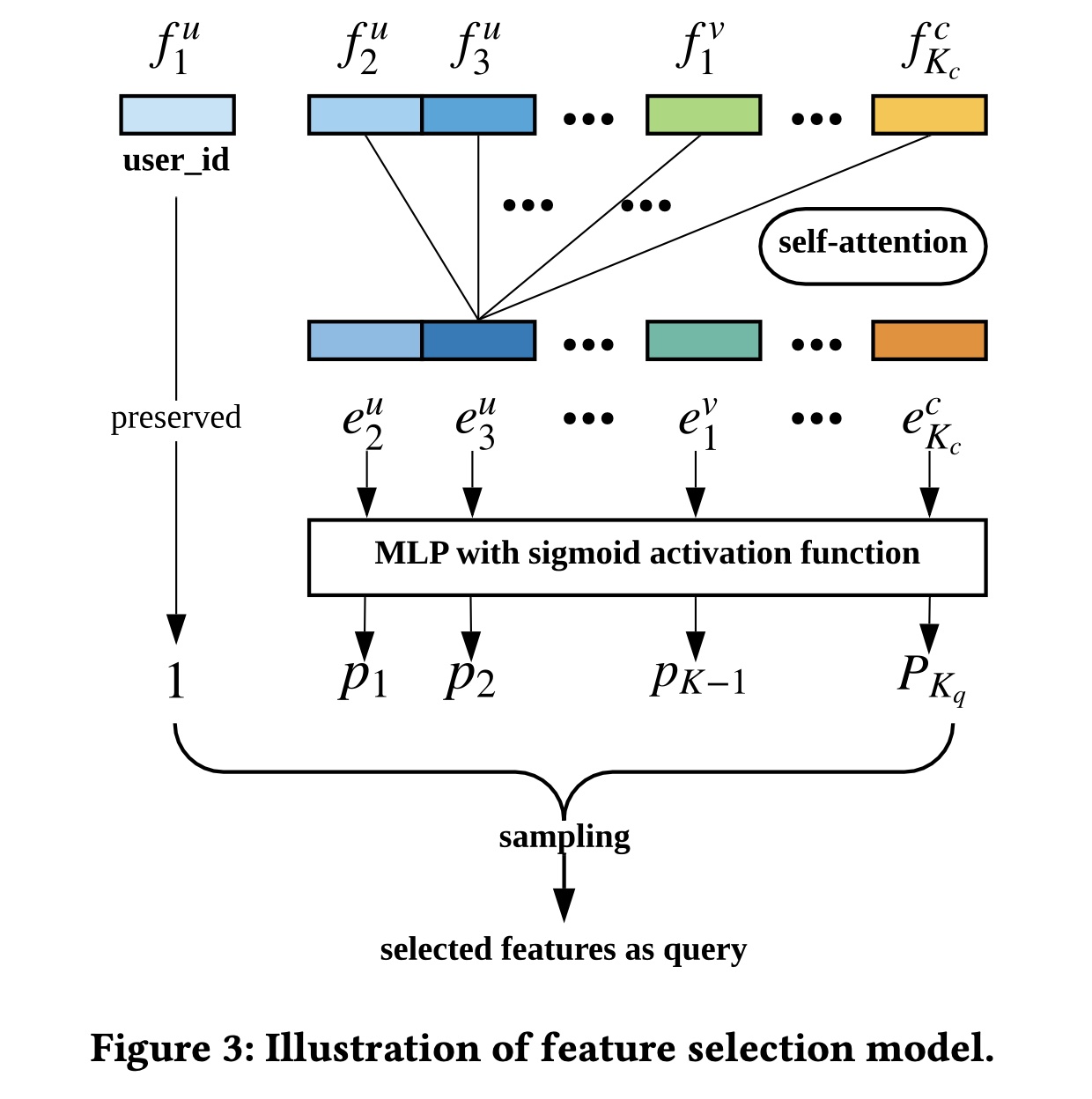

在本节中,我们将问题公式化并引入符号。在

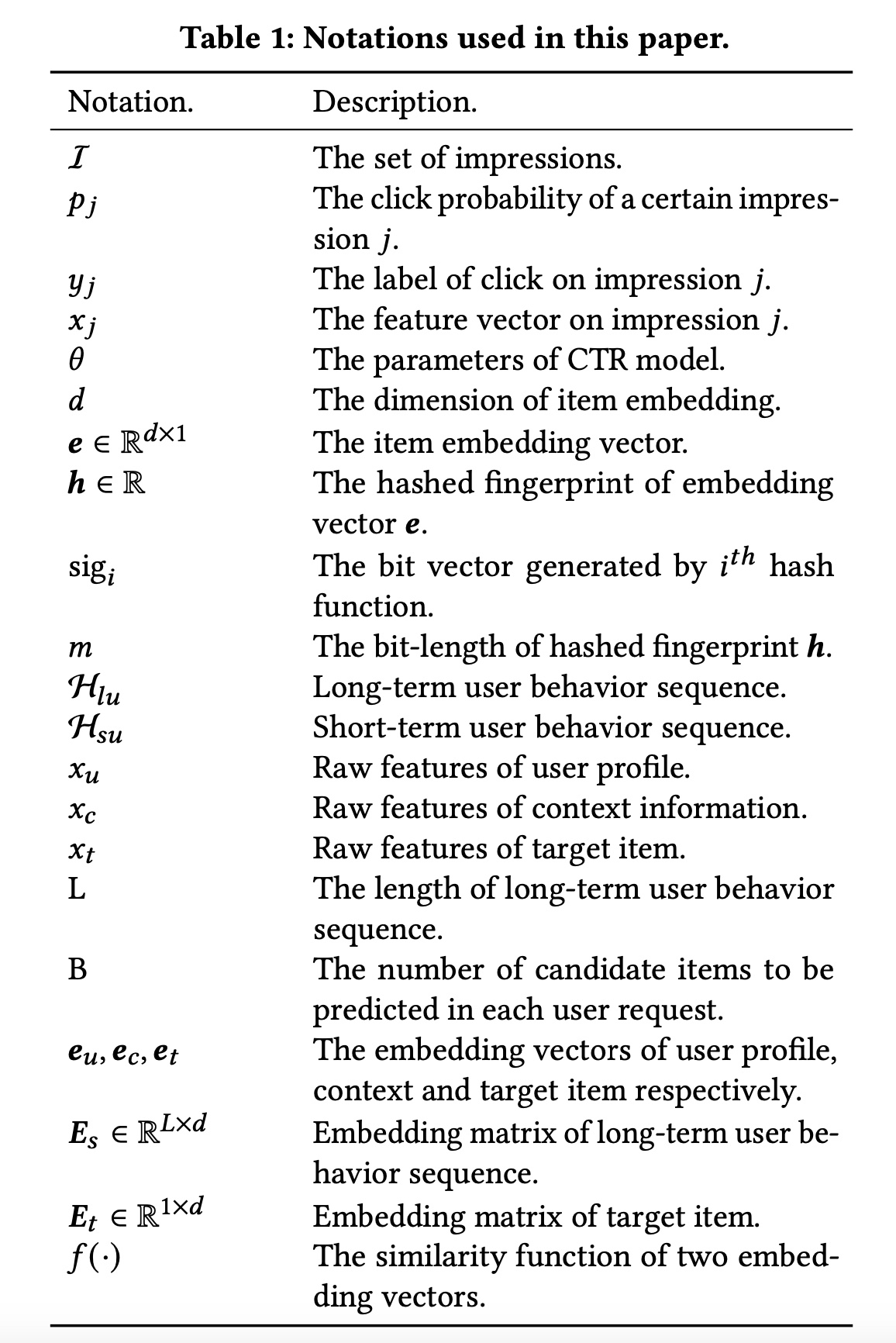

CTR prediction任务中,有itemsuser-item interactions记作此外,每个

user-item interaction都有一个时间戳和一个上下文,时间戳和上下文是interaction发生时刻的。因此数据被公式化为四元组,即item为了建模用户不断变化的兴趣,我们将用户历史行为组织为

behavior记录,按时间戳升序排序。点击率本质上是用户、item、以及上下文之间的匹配概率,因此每条behavioritem,在特征层面,每个用户

multiple categorical特征。如果有numerical特征,则将其离散化为categorical特征。类似地,

item、以及上下文的特征数量。这里的特征数量就是

field数量。例如,userfield。CTR prediction的目标是:根据target usertarget item其中:

我们在

Table 1中总结了符号和相应的描述。

51.2 方法论

本节将详细描述我们提出的

UBR4CTR(User Behavior Retrieval for CTR prediction)框架。我们首先给出整体框架的总体概述,然后详细描述user behavior retrieval模块和prediction模块。此外,以下各节将给出训练方法和一些时间复杂度分析。

51.2.1 整体框架

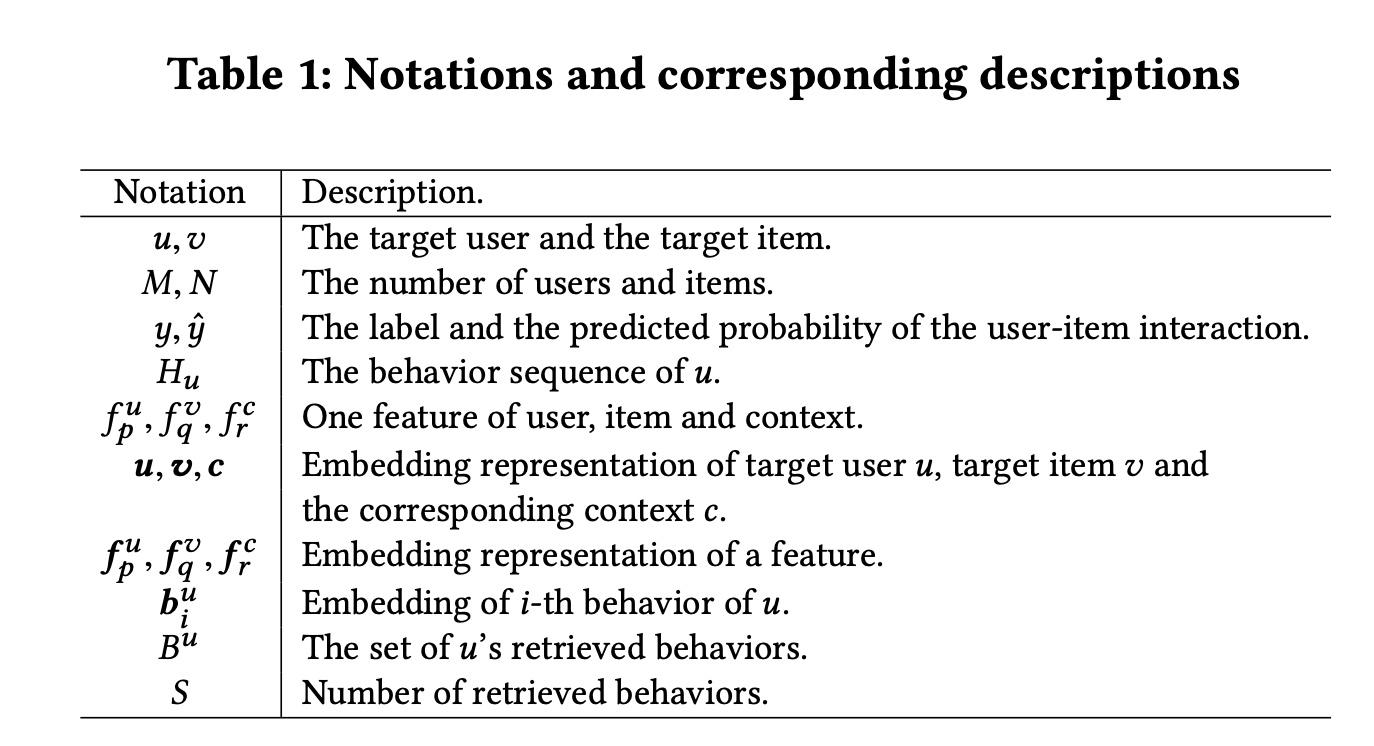

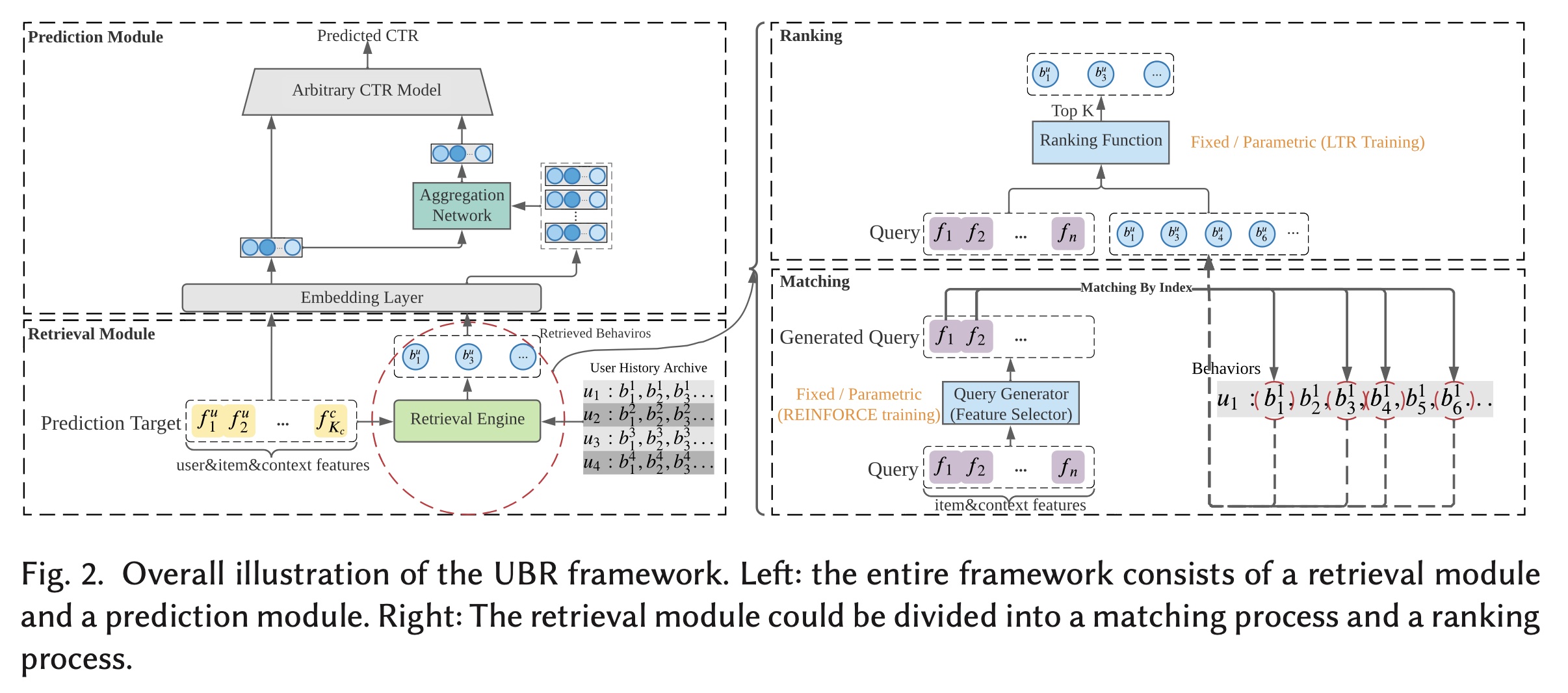

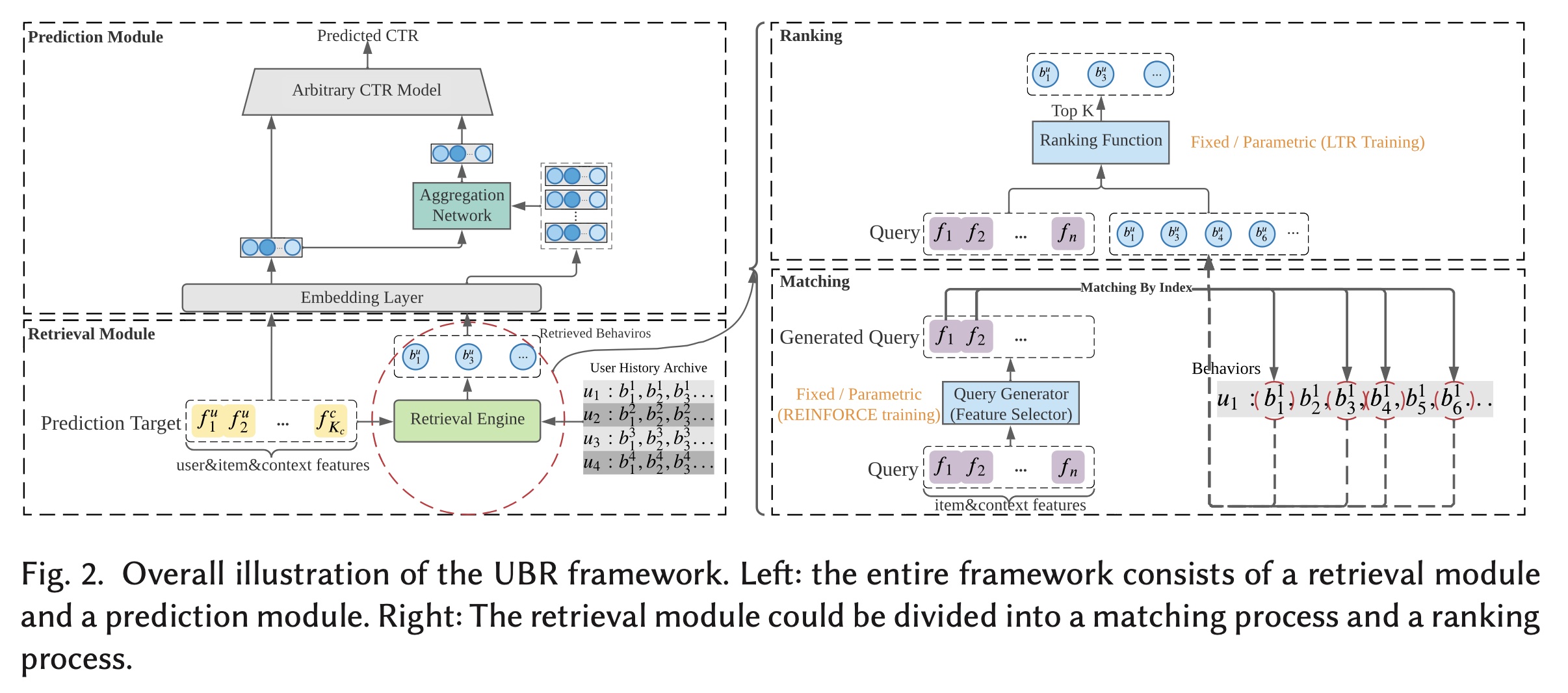

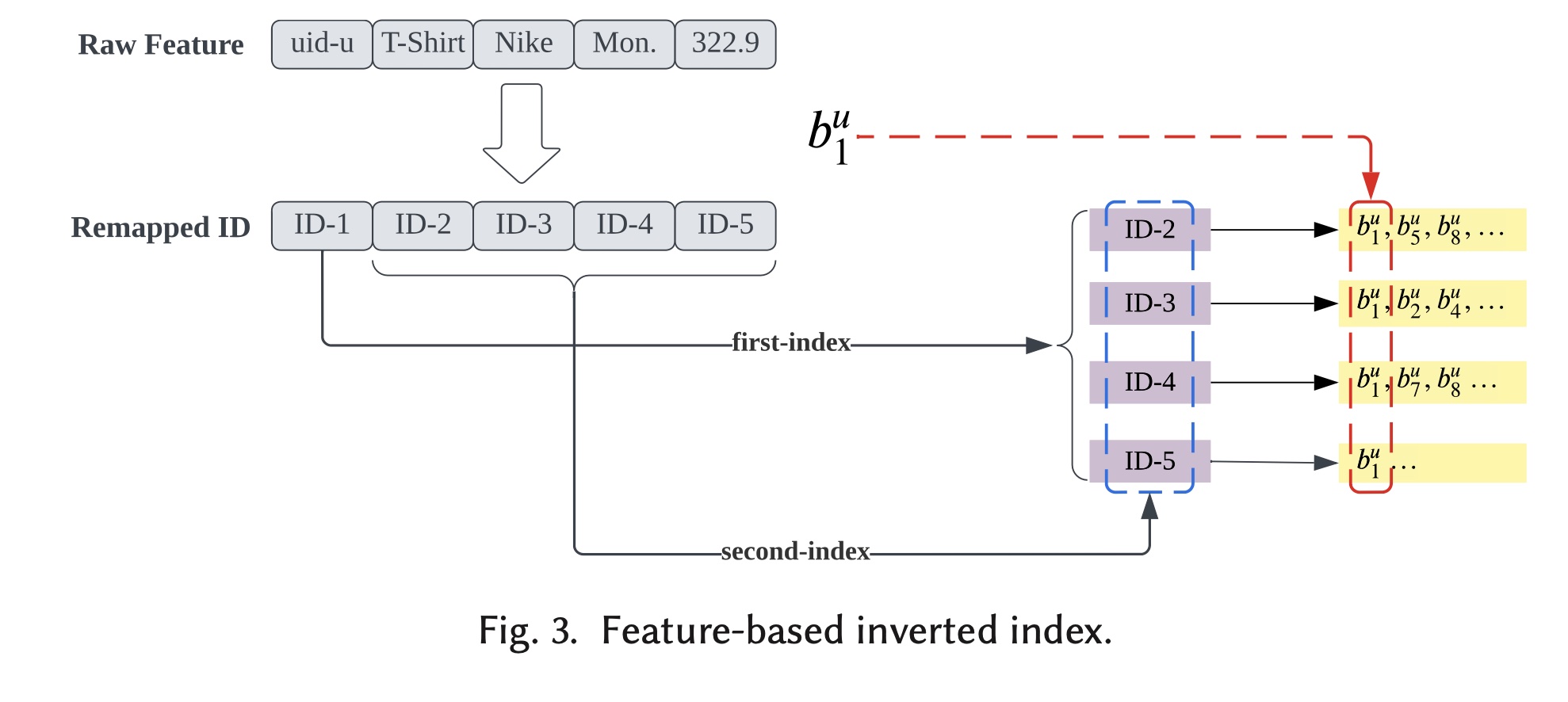

UBR4CTR的整体框架如Figure 2所示。该框架可分为两个主要模块:user behavior retrieval模块和prediction模块。user behavior retrieval模块由一个feature selection model、一个search engine client和一个user history archive组成。所有用户历史行为都存储在archive中,并以feature-based的倒排索引方式组织,这将在后续章节中详细说明。如

Figure 2所示,当我们需要在特定上下文中预测target user和target item之间的点击率时,所有这三部分信息结合在一起形成prediction target。prediction target本质上是由target user、target item和上下文的一系列特征组成。因此,prediction target随后被馈入到feature selection model中,该模型将选择适当的特征来形成一个query。feature selection model的详细设计见后续章节。然后,我们使用该query通过搜索search engine client在user history archive中进行搜索。search engine client检索出一定数量的user behaviors,然后这些被检索到的behaviors被prediction模块使用。在prediction模块中,我们使用attention-based的深度模型来区分每个behavior对点击概率的影响,并做出最终预测,这将在后续章节中讨论。

feature selection model和prediction model轮流进行训练。feature selection model的目标是选择最有用的特征子集。该子集的特征将组合起来生成一个query,该query用于检索与final prediction最相关的user behavior。

51.2.2 User Behavior Retrieval Module

在本节中,我们介绍用

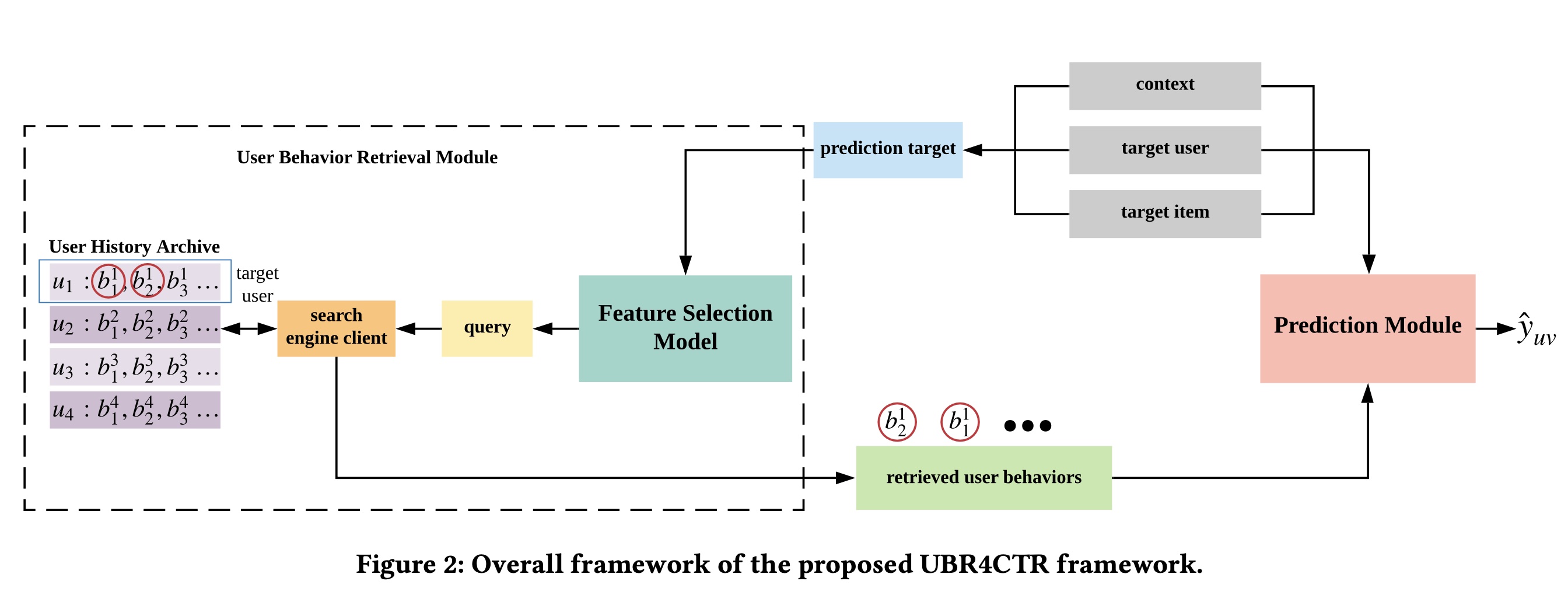

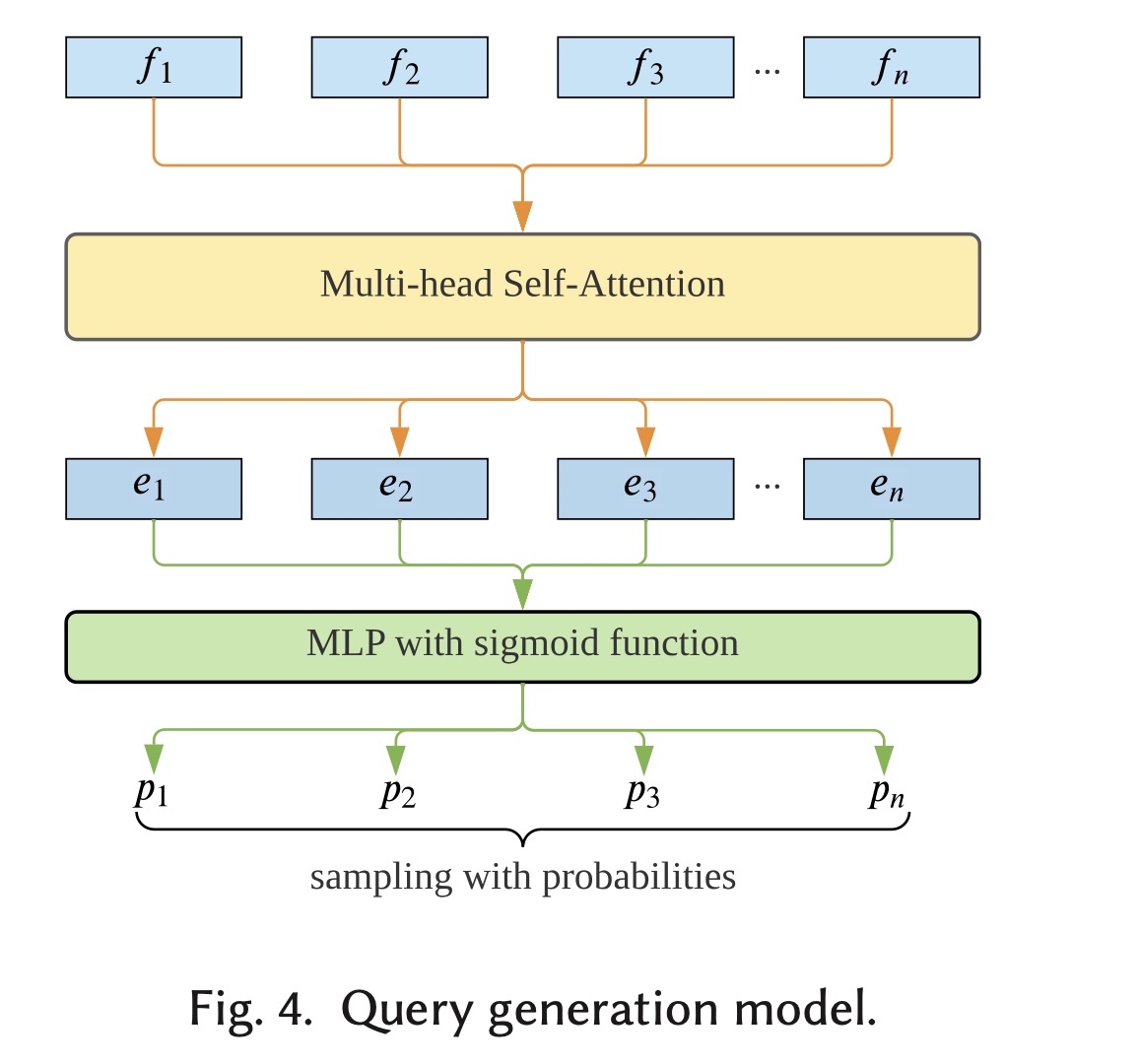

user behavior retrieval module,该模块由feature selection model和behavior searching过程组成。Feature Selection Model:如Figure 3所示,我们将target usertarget itemfeature selection model的输入。不失一般性,我们将user id特征。user id是一个特殊的特征,我们必须选择它,因为我们想要检索用户behavior。所有其他特征都拼接成一个整体。为简单起见,我们将所有特征注意:这里的

field。每个field的取值都是离散值。为了更好地建模特征之间的关系和交互模式,我们使用

self-attention机制。具体来说,我们定义:其中:

dense embedding representation;embedding size。这里的

feature embedding是否与Prediction Module共享?根据Prediction Module章节的描述,读者认为是共享的。self-attention定义为:multi-head self-attention定义为:其中:

head数量;然后,

multi-head self-attention的输出multi-layer perceptron:相应特征被选择的概率通过取

sigmoid函数获得:其中:

然后我们根据这些概率对特征进行采样,从而得到选择好的特征子集。请注意,

user id特征始终在子集中,因为我们必须从target user自己的behavior中检索。实际上被采样到的是

field;但是在下一步检索时,将这个field在这个样本上的取值作为条件。

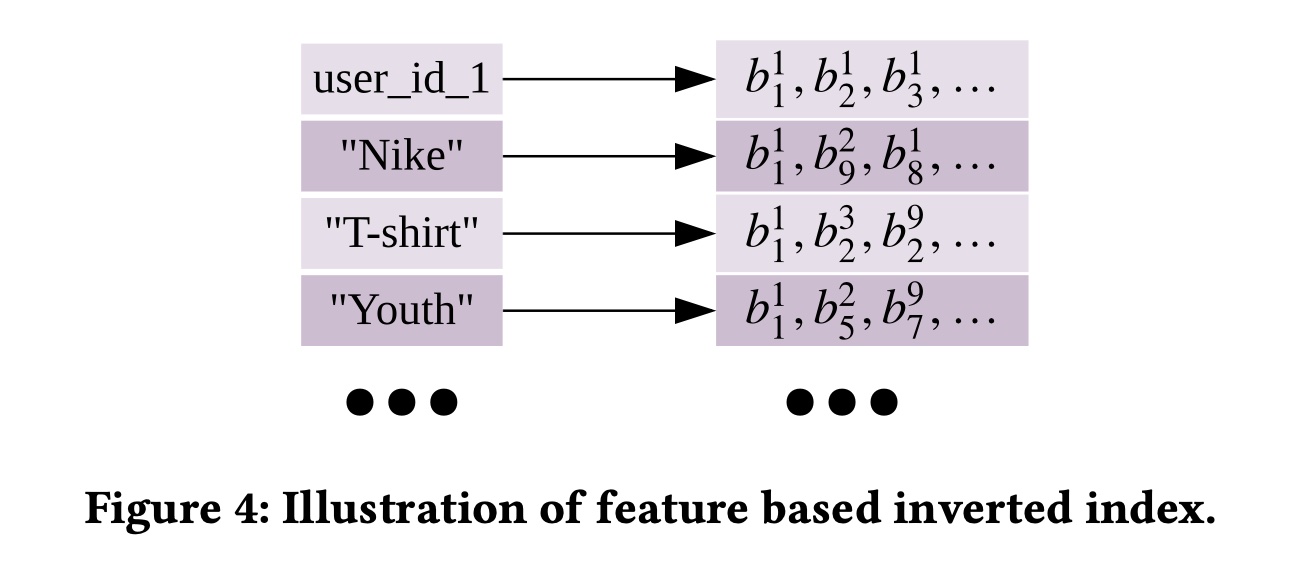

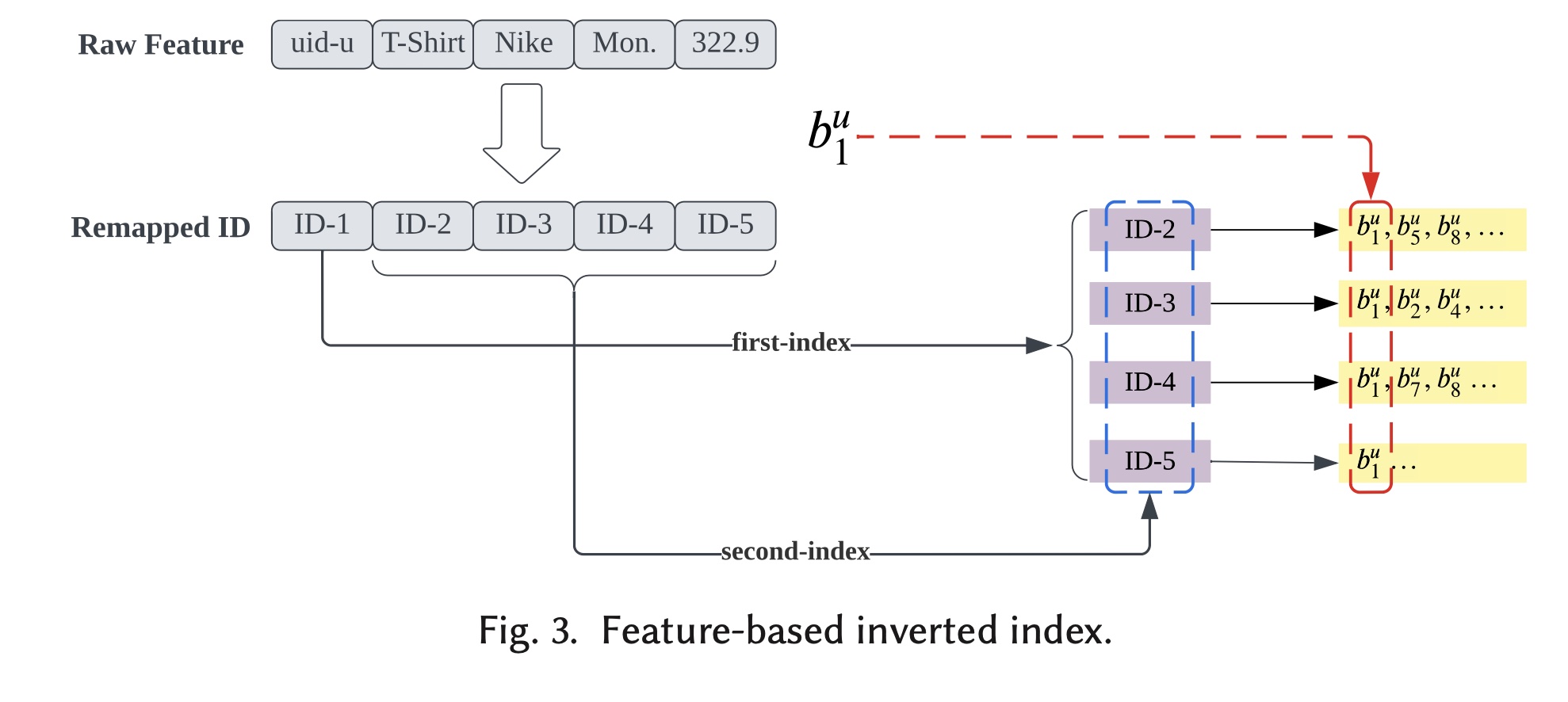

Behavior Searching:我们使用典型的搜索引擎方法来存储和检索user behavior。我们将每个user behavior视为一个文档,将每个特征视为一个term。倒排索引用于跟踪所有behavior,如Figure 4所示。每个feature value都与一个posting list相关联,该列表由具有此特定feature value的所有behavior组成。例如:"user_id_1"包含user id = 1的用户的所有behavior的posting list。"Nike"具有由brand id = "Nike"的所有behavior组成的posting list。

query的逻辑本质上表述为:其中:

user_id;所选中的query feature set为我们将

posting list与posting lists的并集进行相交,交集的结果就是candidate behavior set。然后我们使用BM25对候选集中的每个behavior document进行评分,并检索出top S个behavior document。querybehavior document其中:

1或0。behavior document的长度behavior中的特征数量,因此所有behavior document的长度相同。因此平均长度是每个文档的长度,并且可以进一步化简为:

考虑到

0或1,因此:因此

IDF定义为:其中:

behavior documents的总数,behavior documents总数。IDF项赋予常见特征比罕见特征更少的重要性。与常见特征相比,罕见特征对用户偏好的暗示更强,这是有道理的。 通过使用BM25对candidate behaviors进行排序,我们获得了top S的behavior documents作为所检索到的behavior,记作实际应用时会采用双层索引,最外层为

user_id,最内层为各个特征的取值,从而降低存储需求。

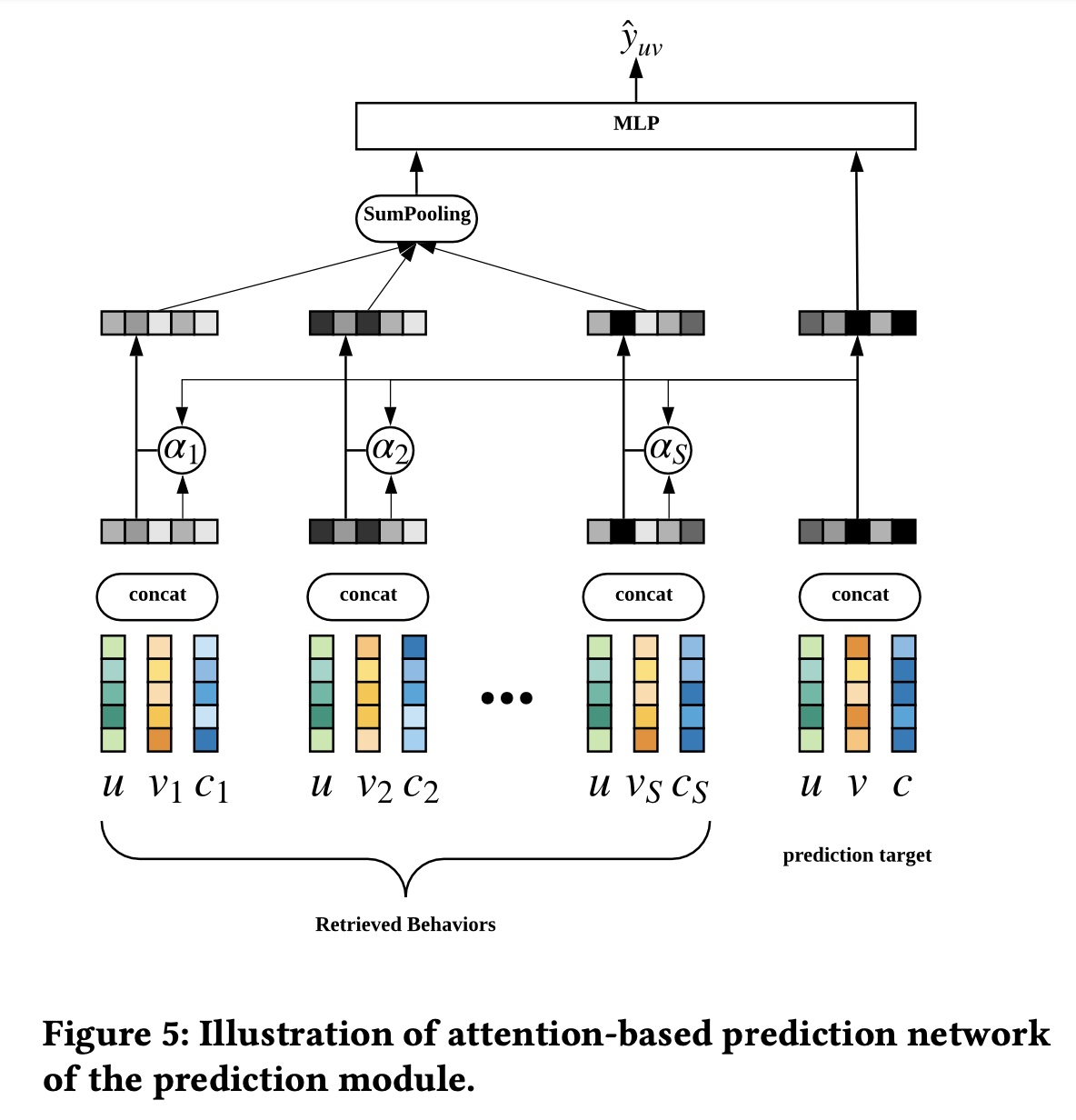

51.2.3 Prediction Module

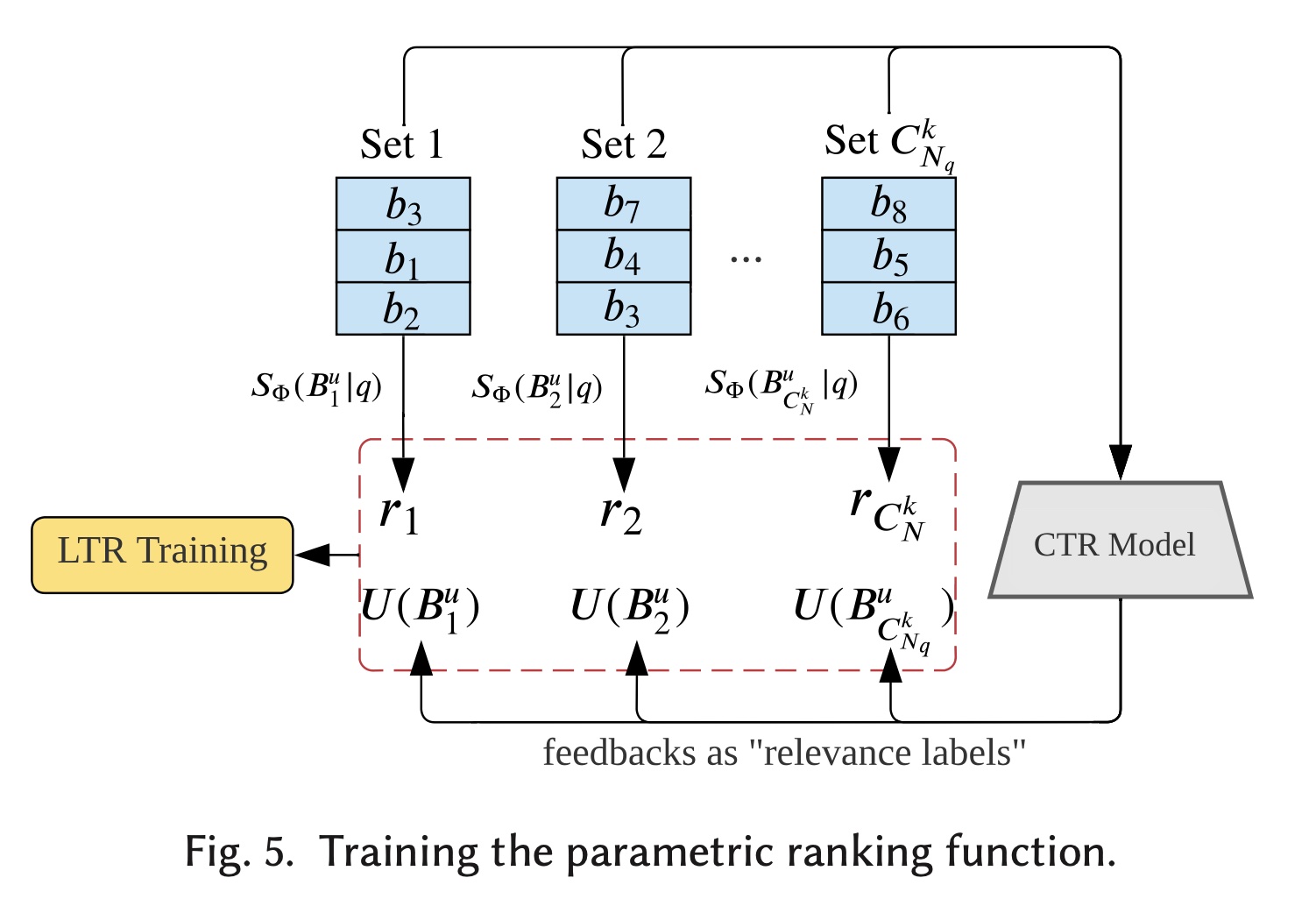

对于

prediction module,我们使用attention-based的深度神经网络来建模不同user behavior对final prediction的重要性。如

Figure 5所示,我们通过加权池化得到user representation其中:

user behaviorembedding向量,behavior document的数量。user behaviorprediction target向量。Att()是一个具有ReLU激活函数的多层深度网络。这个

prediction target向量user ID特征

final prediction计算如下:

其中: sigmoid 函数,其他层采用ReLU 作为激活函数。

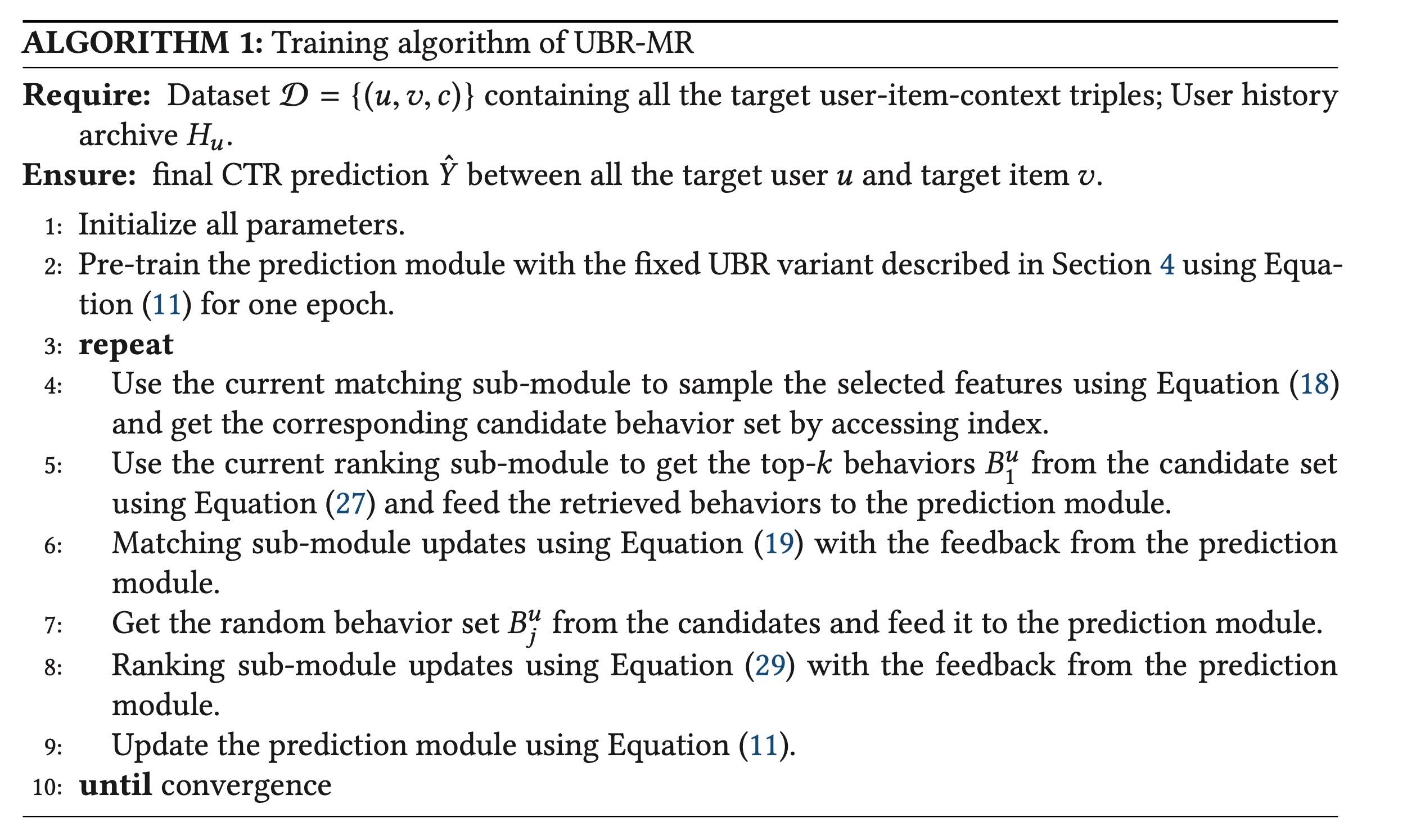

51.2.4 Model Training

由于目标是准确估计点击率,我们使用对数似然作为目标函数,其定义为:

其中:

LL(.)是在给定所检索到的user behaviortarget user-item pairquery。我们使用抽样来选择特征,然后被选中的特征形成query string。query string形成后,搜索结果(即,检索到的behavior)是确定性的。因此,我们可以认为这些behavior是从概率分布

优化

Prediction Module:为了优化attention-based预测网络其中:

注意,这里是负的对数似然,所以是

min。当我们优化

prediction network时,检索模块保持不变,因此如果函数优化检索模块:对于检索模块,只需要优化

feature selection model。随着采样过程的发展,我们不能直接使用SGD来优化它。相反,我们使用REINFORCE算法来处理离散优化(discrete optimization)。 具体而言,在保持prediction networkfeature selection model:我们将

query我们将检索模块

likelihood ratio来估计其梯度:这是对

query数量。由于整个检索模块的不确定性实际上来自

feature selection model,我们可以得出:其中:

其中:其中

query的第为了使用

reward训练一个更好的模型,我们在这里用相对信息增益 (Relative Information Gain: RIG)替换LL(·)作为奖励函数。RIG定义为RIG = 1 − NE,其中NE是归一化熵:其中

CTR。可以参考

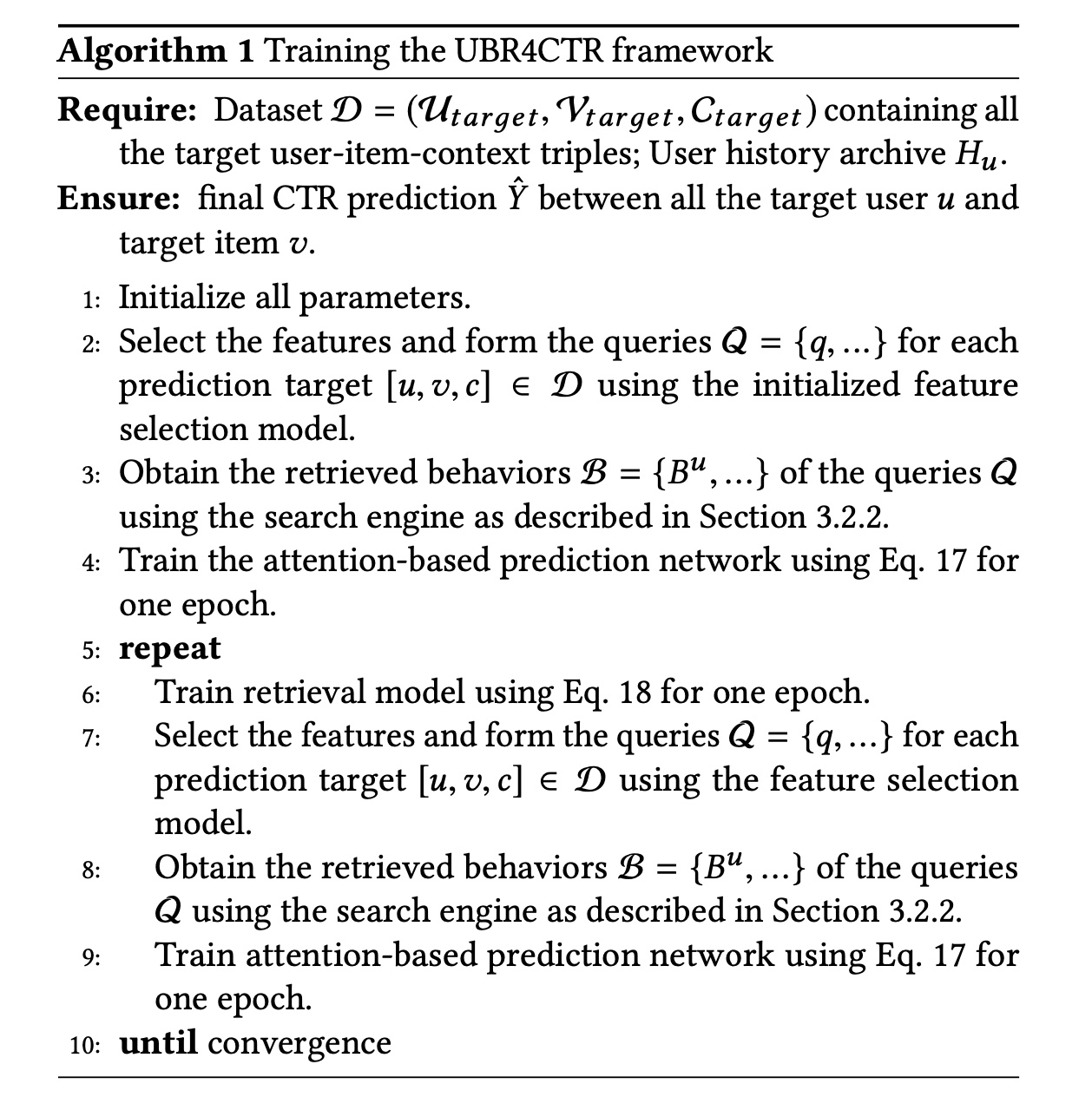

UBR模型,它是UBR4CTR的升级版。训练过程的伪代码:在本小节中,我们给出了训练过程的详细伪代码。

首先,我们使用

feature selection model对预测网络进行预热。feature selection model如何初始化?如果是随即初始化是否会带来不利影响?作者没有提及。读者猜测是不影响的,因为后续的迭代训练会对feature selection model进行优化。为什么要预热?因为

prediction model是feature selection model的奖励函数,它必须要有一定的准确性才能指导feature selection model的学习。预训练后,我们轮流优化两个模型,每个模型被训练一个

epoch之后,再训练另一个模型一个epoch,轮流往复。

Algorithm 1显示了训练过程。

51.2.5 模型分析

本节分析了该方法的时间复杂度和可行性。我们使用

user behavior的总数,使用unique features(相当于term)的总数。然后,user history archive中posting lists的平均长度为回想一下之前内容所描述的搜索操作,我们首先检索

postings,这需要然后交互操作需要

selected features数量的上限。接下来的

scoring操作不会增加复杂度,因为它与feature selection model中的self-attention的复杂度为attention-based prediction network需要attention操作都可以并行执行。

两个常数可以忽略,因此

UBR4CTR的总时间复杂度为

51.3 实验

在本节中,我们详细介绍了我们的实验设置和相应的结果。我们将我们的模型与几个强大的

baselines进行了比较,并实现了SOTA的性能。此外,我们已经发布了代码用于复现(https://github.com/qinjr/UBR4CTR)。 我们从三个研究问题(research question: RQ)开始,并用它们来引导以下讨论。RQ1:与其他baselines相比,UBR4CTR是否实现了最佳性能?RQ2:Algorithm 1的收敛性能如何?训练过程是否有效且稳定?RQ3:UBR4CTR中的检索模块有什么影响,retrieval size如何影响性能?

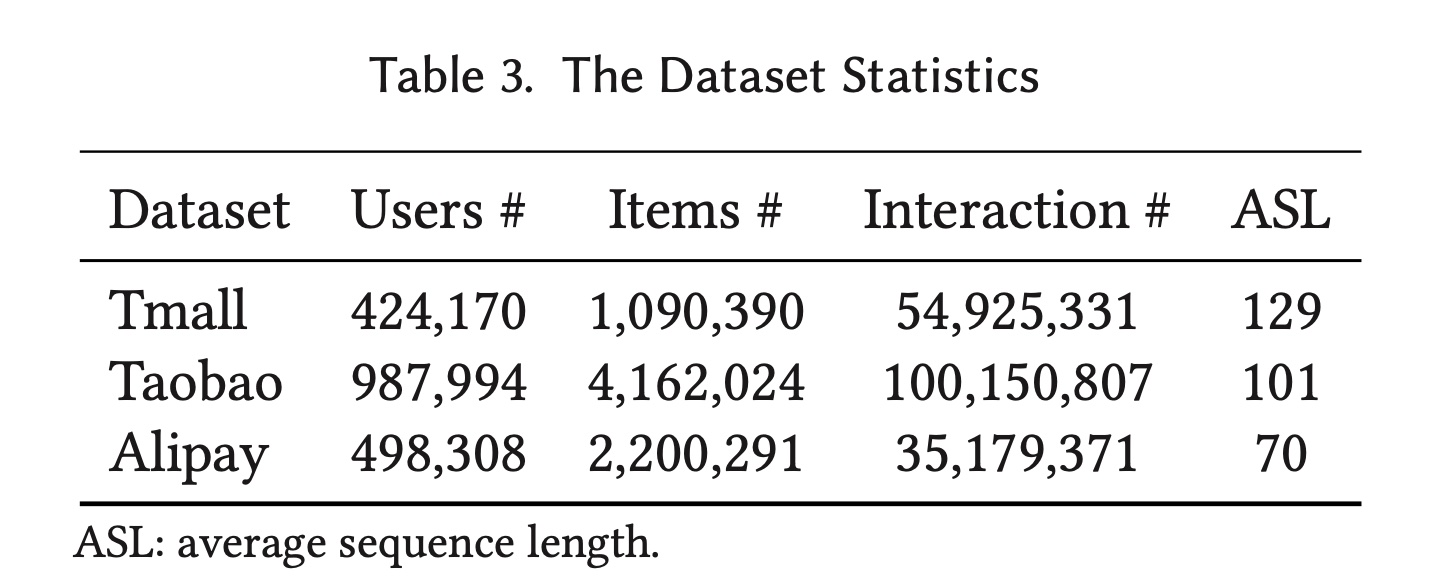

数据集:我们使用三个真实的、大型的

users online behaviors数据集,它们来自阿里巴巴集团三个不同平台。数据集的统计数据可以在Table 2中找到。Tmall数据集:由阿里巴巴集团提供,其中包含2015年5月至2015年11月天猫电商平台上的user behavior历史记录。Taobao数据集:包含来自中国最大的电商平台之一淘宝中检索到的user behavior数据。它包含2017年11月25日至12月3日的user behavior,包括点击、购买、添加到购物车、以及喜欢商品等几种behavior类型。Alipay数据集:由在线支付应用程序支付宝收集。用户的在线购物behavior是从2015年7月1日到2015年11月30日。

数据集预处理:

对于

UBR4CTR,数据集被处理成逗号分隔特征的格式。包含user, item and context features的一行被视为一个behavior document。对于

baselines,user behavior仅按时间戳排序。由于数据集不包含特定的上下文特征,我们使用behavior timestamp手动设计一些特征,以便能够捕获周期性。我们设计了一些特征,例如season id(春季、夏季等)、是否是周末、以及是哪个半月(上半月还是下半月)。

搜索引擎:数据集预处理后,使用逗号分隔的

tokenizer将它们插入搜索引擎。我们使用基于Apache Lucene的Elastic Search作为搜索引擎客户端。Train & Test Splitting:我们使用time step来拆分数据集。训练集包含第

user behavior,其中第behavior用于预测第behavior。类似地,验证集使用第

behavior来预测第behavior;测试集使用第behavior来预测第behavior。

超参数:

UBR4CTR的feature selection model的学习率从attention based prediction network的学习率从baseline模型的学习率和正则化项的搜索空间与UBR4CTR的prediction network相同。所有模型的

batch size均从

每个模型的超参数都经过调优并报告最佳性能。

评估指标:

CTR、Logloss。Baselines:我们将我们的框架和模型与来自sequential CTR prediction和推荐场景的七个不同的强基线进行比较。GRU4Rec基于GRU,它是第一个工作使用recurrent cells建模user behavior序列从而用于session-based推荐。Caser是一个CNNs-based的模型,它将用户序列视为图像,因此使用horizontal and vertical convolutional layers来捕获user behavior的时间模式。SASRec使用Transformer。它将user behavior视为tokens的一个序列,并使用自注意机制和position embedding来捕获behavior之间的依赖关系。HPMN是一个hierarchical periodic memory network,旨在处理非常长的用户历史序列。此外,user memory state可以增量更新。MIMN基于Neural Turing Machine,它建模了用户兴趣漂移的multiple channels。该模型作为user interest center的一部分实现,可以对非常长的user behavior序列进行建模。DIN是第一个在在线广告CTR prediction中使用注意力机制的模型。DIEN使用具有注意力机制的双层RNN来捕获不断变化的用户兴趣。它使用所计算出的attention values来控制第二个recurrent layer,称为AUGRU。UBR4CTR是我们提出的框架和模型。

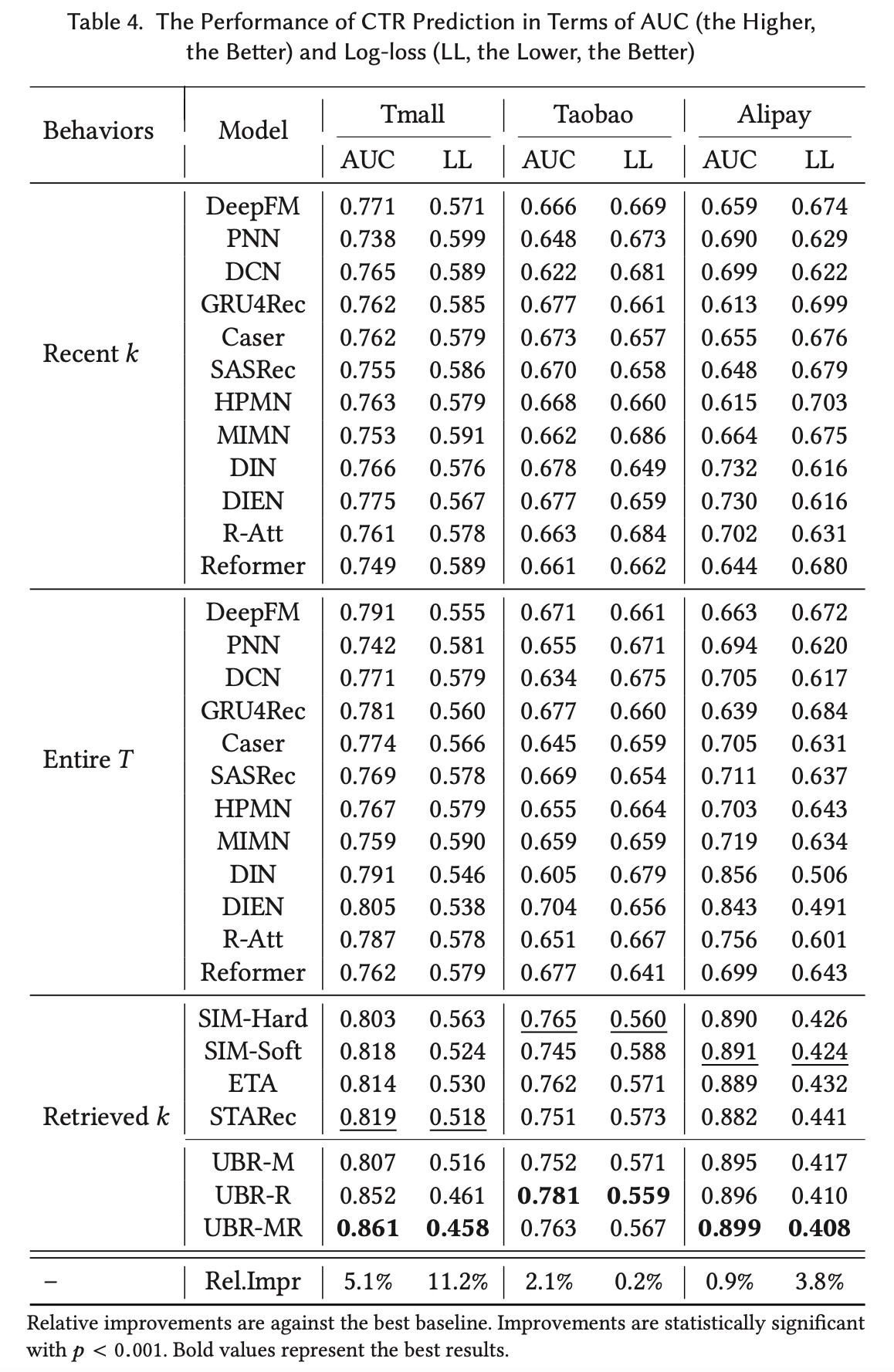

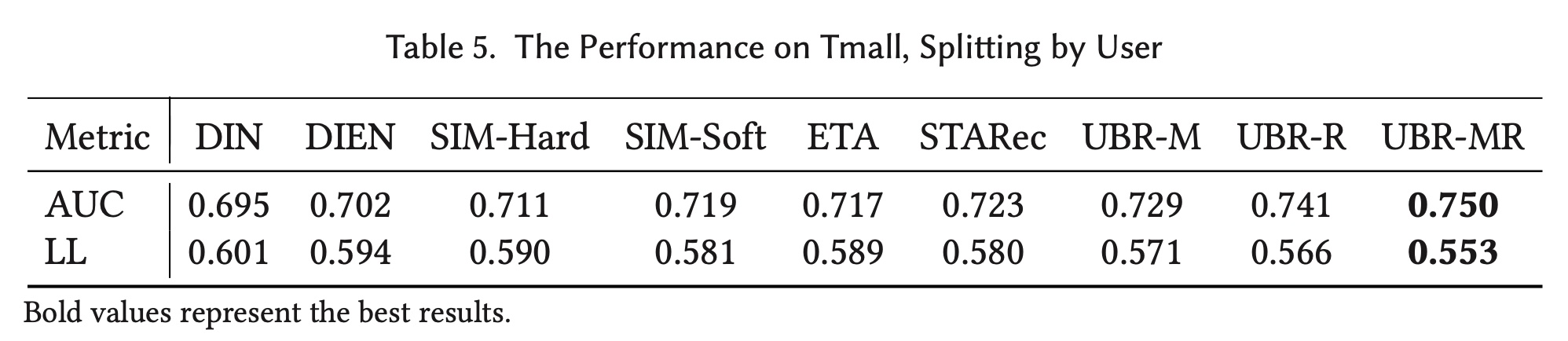

51.3.1 性能比较:RQ1

我们对

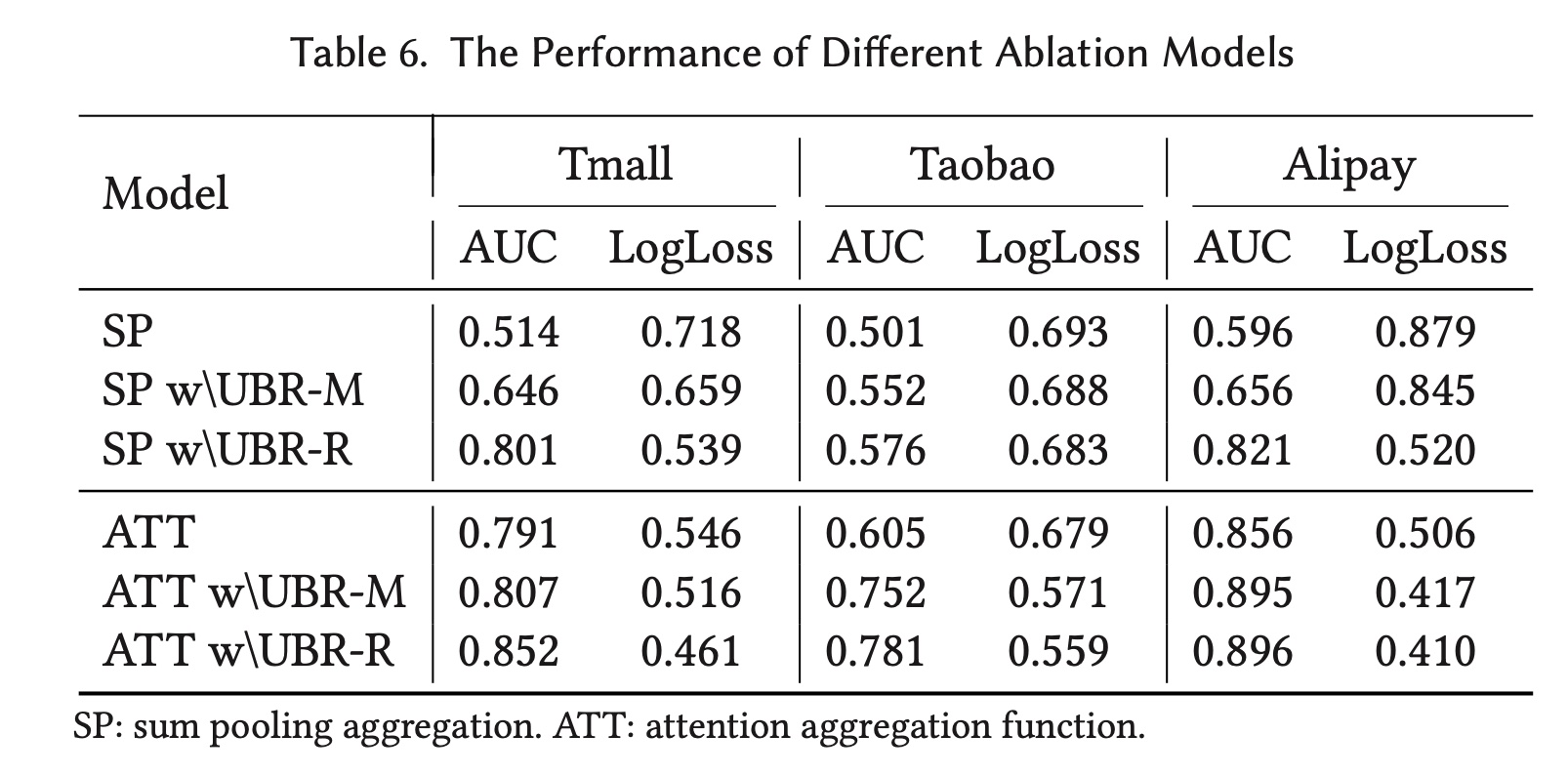

UBR4CTR和基线模型进行了两组比较。在第一组实验中,所有模型都使用相同数量的

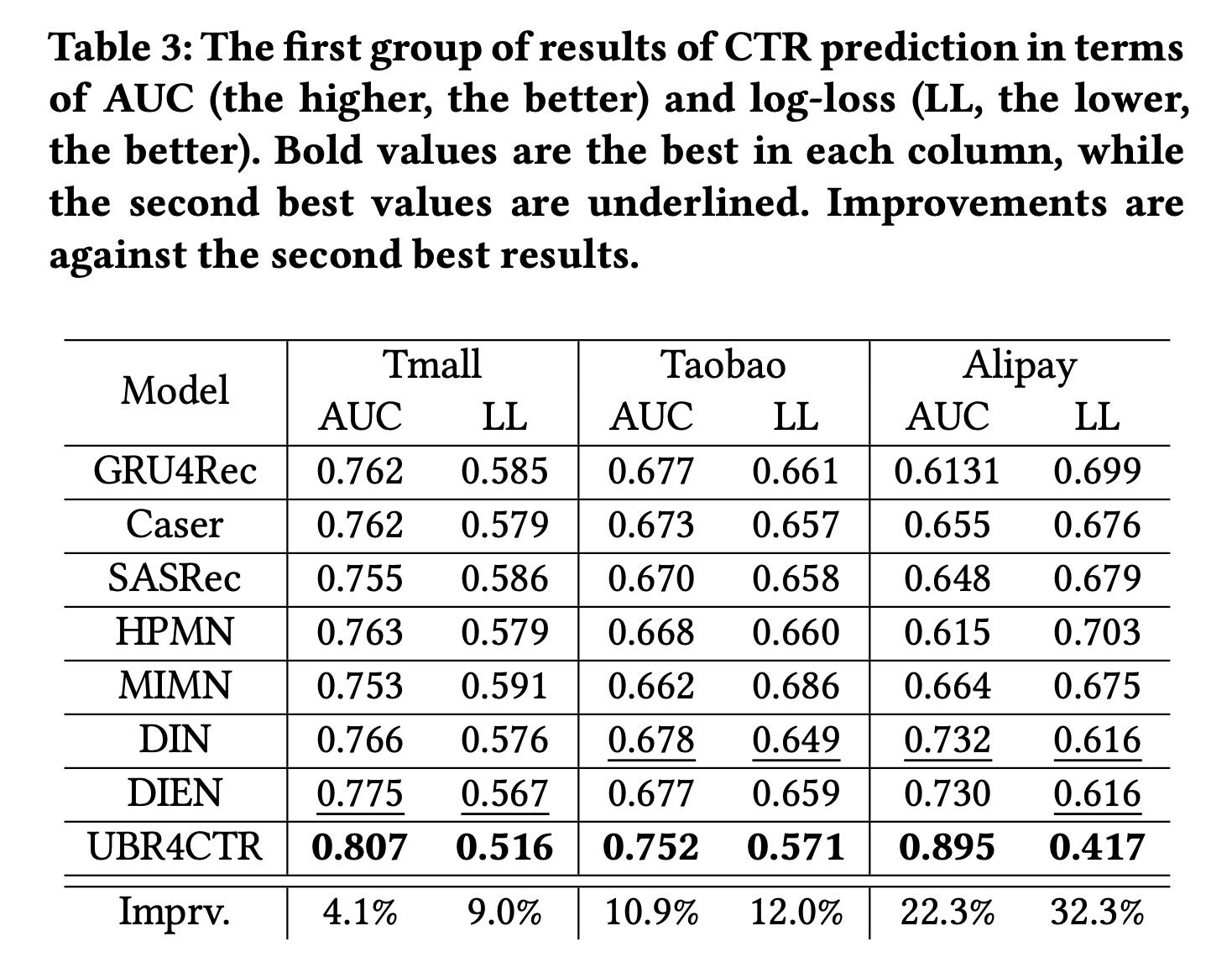

user behavior,对三个数据集分别为20、20、12。唯一的区别是:baselines使用的是最近的behavior(约占总长度的20%),而UBR4CTR从整个序列中检索了20%的behavior。实验结果如Table 3所示。从表中,我们可以发现以下事实:

(i):与baseline相比,UBR4CTR的性能显著提高。在三个数据集上AUC分别提高了4.1%、10.9%和22.3%,Logloss分别改善了9.0%、12.0%和32.3%。(ii):巨大的改进表明最近的behaviors没有包含足够的时间模式(temporal patterns),因此baselines无法有效地捕获它们。尽管有些baselines模型相当复杂和fancy,但如果它们试图捕获的模式不包含在最近的行为序列中,它们就无法很好地发挥作用。

根据

MIMN论文的报告,MIMN的效果是优于DIEN的。这里MIMN效果反而更差,因为这里对MIMN近使用最近的20个behaviors,而没有用所有的behaviors。这是不公平的比较。

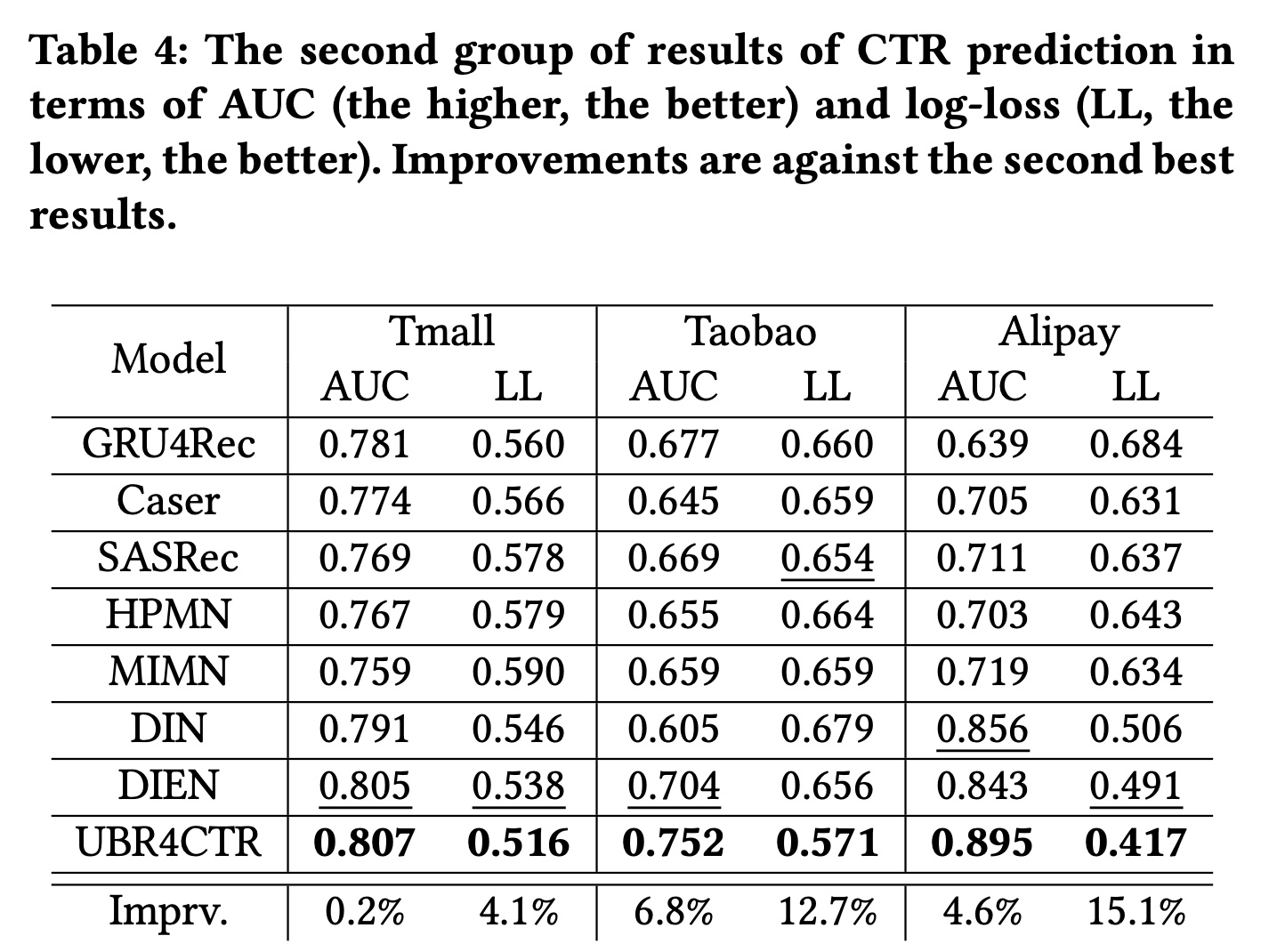

在第二组实验中,我们对

baselines模型使用不同的设置,对UBR4CTR的设置与第一组实验完全相同。我们将整个序列馈入到所有的baseline模型,其中这三个数据集的序列长度分别为100、100、60。它们是这些数据集中user behavior的最大长度。对于UBR4CTR,检索到的behavior大小保持不变,分别为20、20和12。结果如

Table 4所示。在Table 4中,UBR4CTR的性能与Table 3中相同,因为我们没有更改任何设置。从表中,我们可以发现以下事实:(i):UBR4CTR使用的behavior比其他baselines少80%,但仍然具有最佳性能。这表明较长的序列可能包含更多噪音和不相关信息,因此有必要从整个序列中仅获取最有用的数据。(ii):与Table 3相比,大多数baselines都取得了比其自身更好的性能,尤其是DIN和DIEN。这表明来自更远历史的behavior确实包含更丰富的信息和模式。并且这些模式更容易通过attention机制被捕获。(iii):虽然由于性能更好的baselines导致AUC的改进要小得多,但Logloss仍然有显著改善。原因是retrieval module的优化目标为RIG(相当于对数损失)。retrieval module的优化目标会影响最终模型的指标。

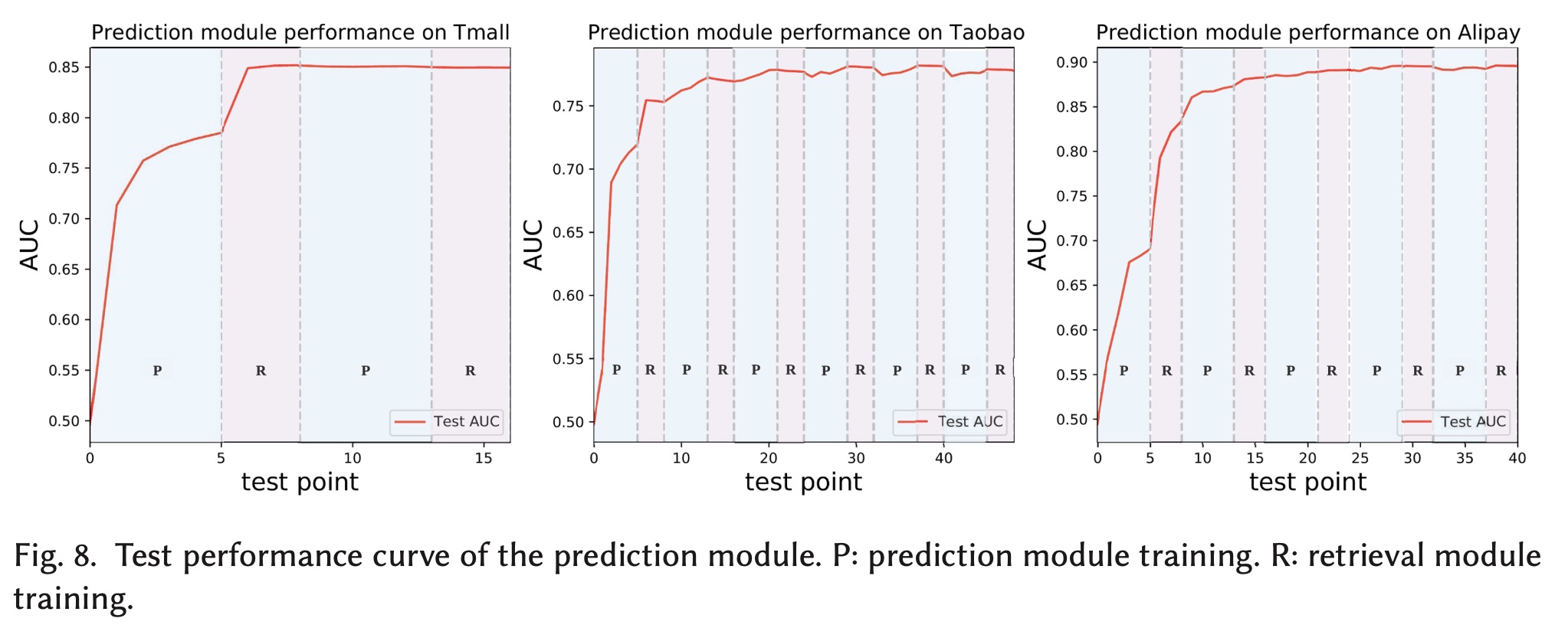

51.3.2 学习过程:RQ2

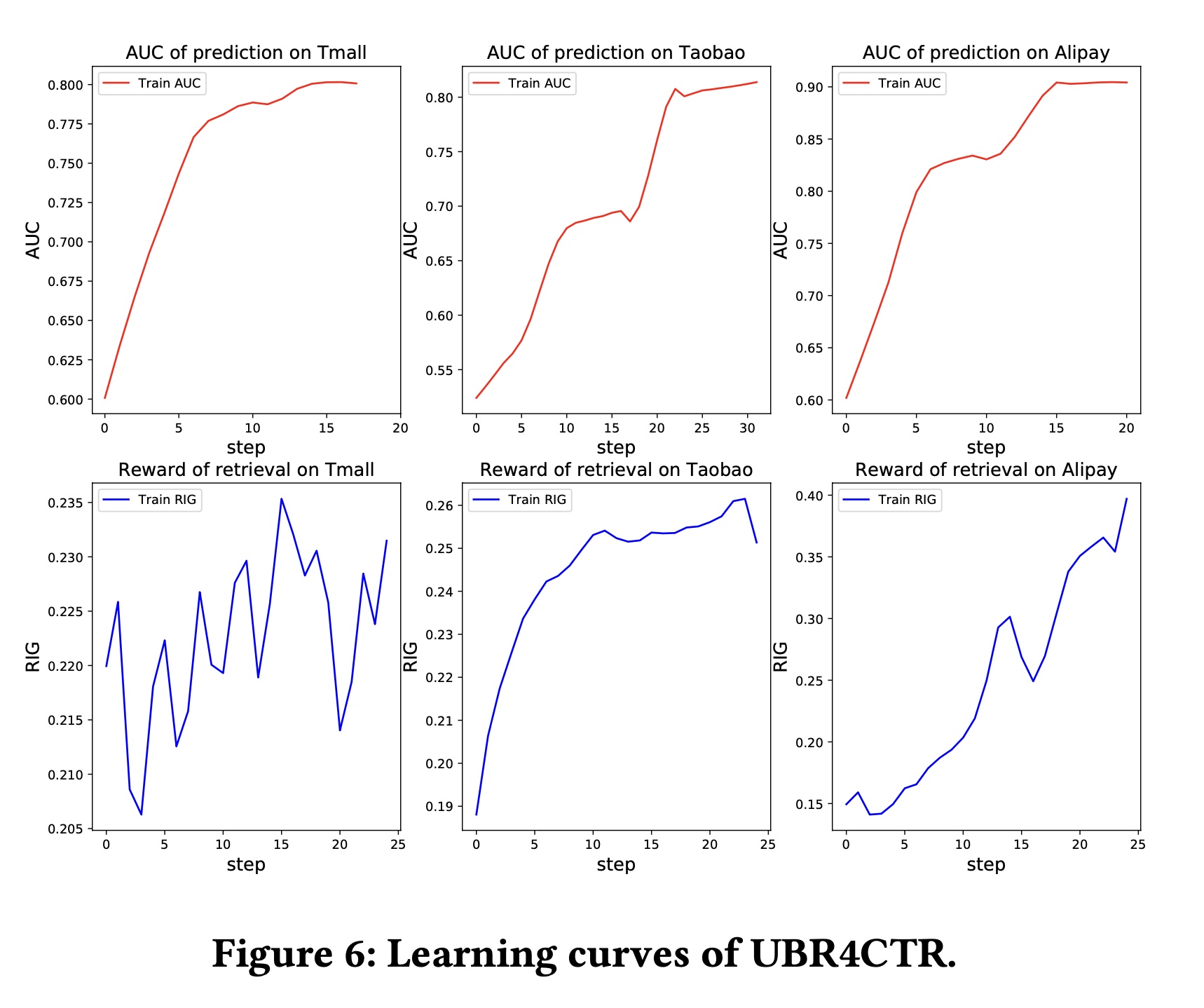

为了说明我们框架的收敛性,我们绘制了

UBR4CTR的learning curves。在Figure 6中,上面的三个子图分别是在三个数据集上训练时

attentive prediction network的AUC曲线。x轴的每个step对应于超过4%的训练集的迭代。下面的三个子图显示了

REINFORCE算法相对于检索模块的feature selection model的 “奖励”。“奖励”本质上是RIG,它是对数似然的一种变体。x轴的每个step表示超过4%的训练集的迭代。在训练过程中,奖励会增加,这意味着feature selection model实际上学习了有用的模式。

从

AUC图中,我们可以发现我们的模型有效地收敛了。对于prediction network,我们可以观察到在训练过程的中间有平坦区域,然后快速增加,尤其是在第二和第三个AUC图中。回想一下我们在Algorithm 1中描述的训练过程,检索模块是在prediction network之后训练的。这意味着当prediction network即将收敛时,检索模块开始训练,之后prediction network的性能将有所突破。

51.3.3 广泛研究:RQ3

在本节中,我们对我们的框架进行了一些广泛的和消融的研究。

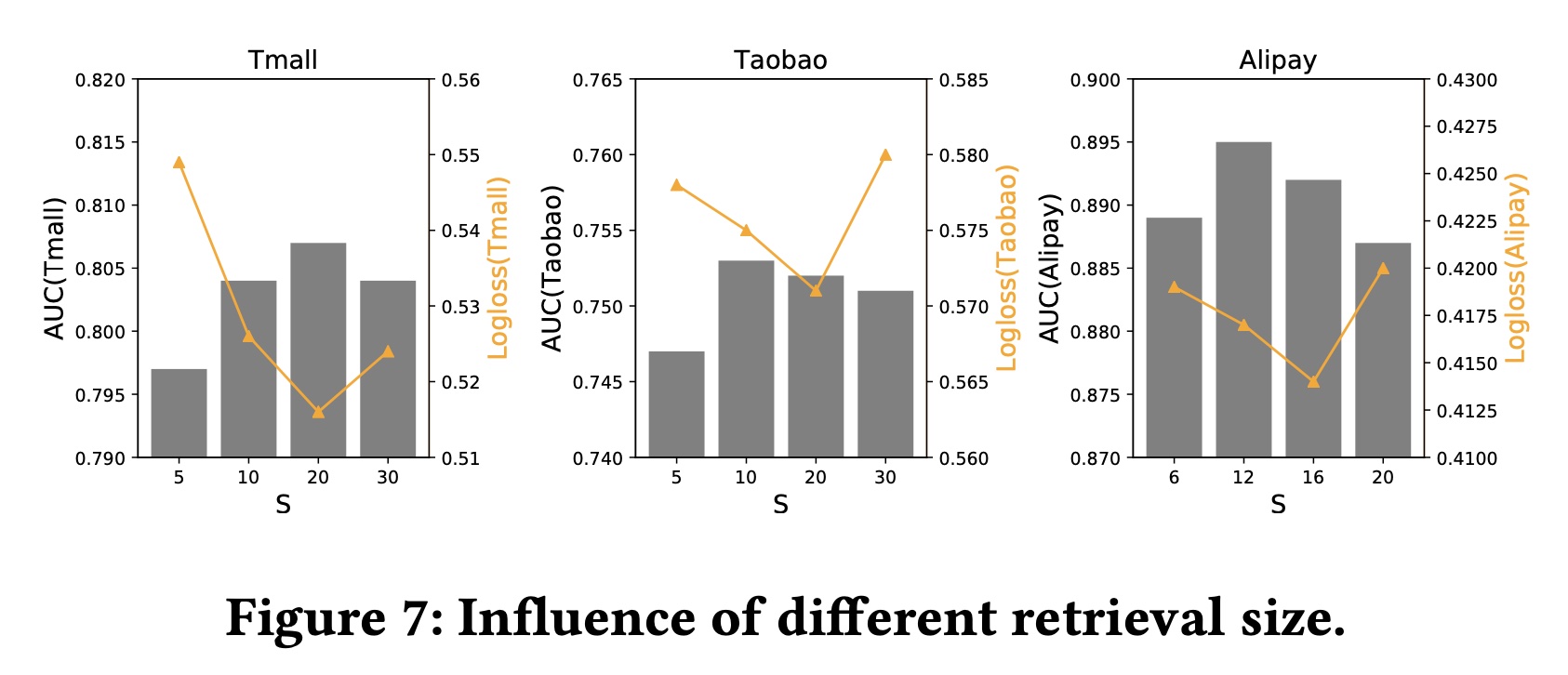

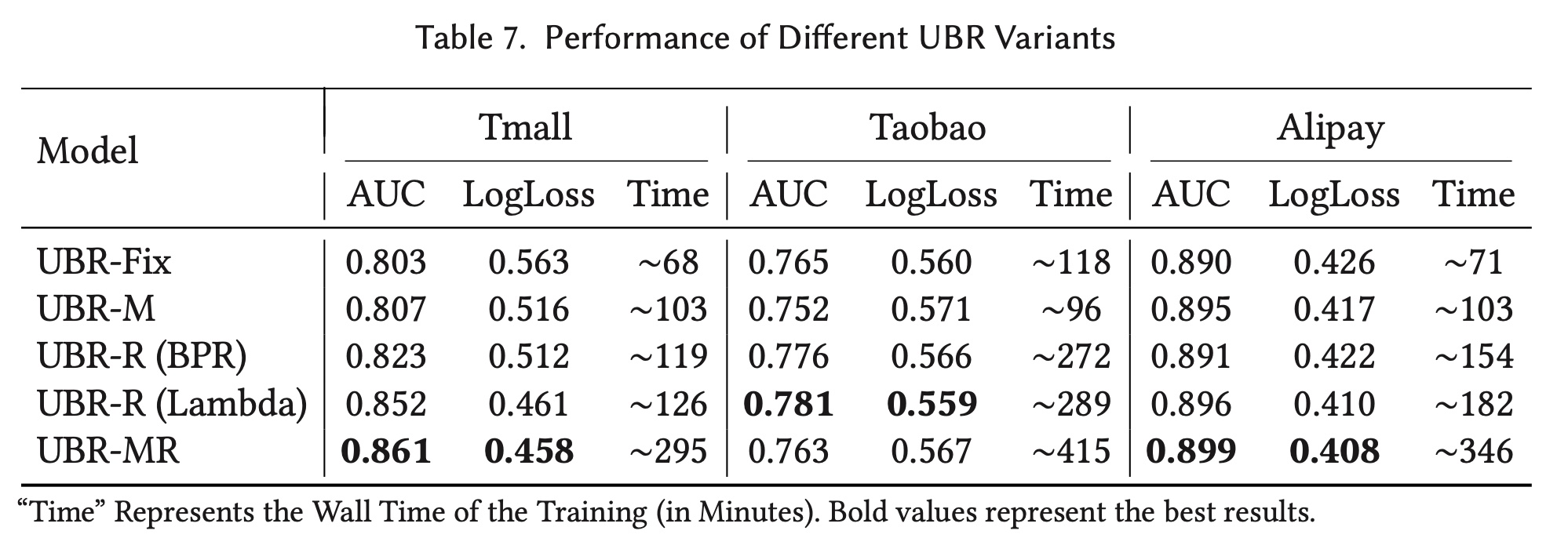

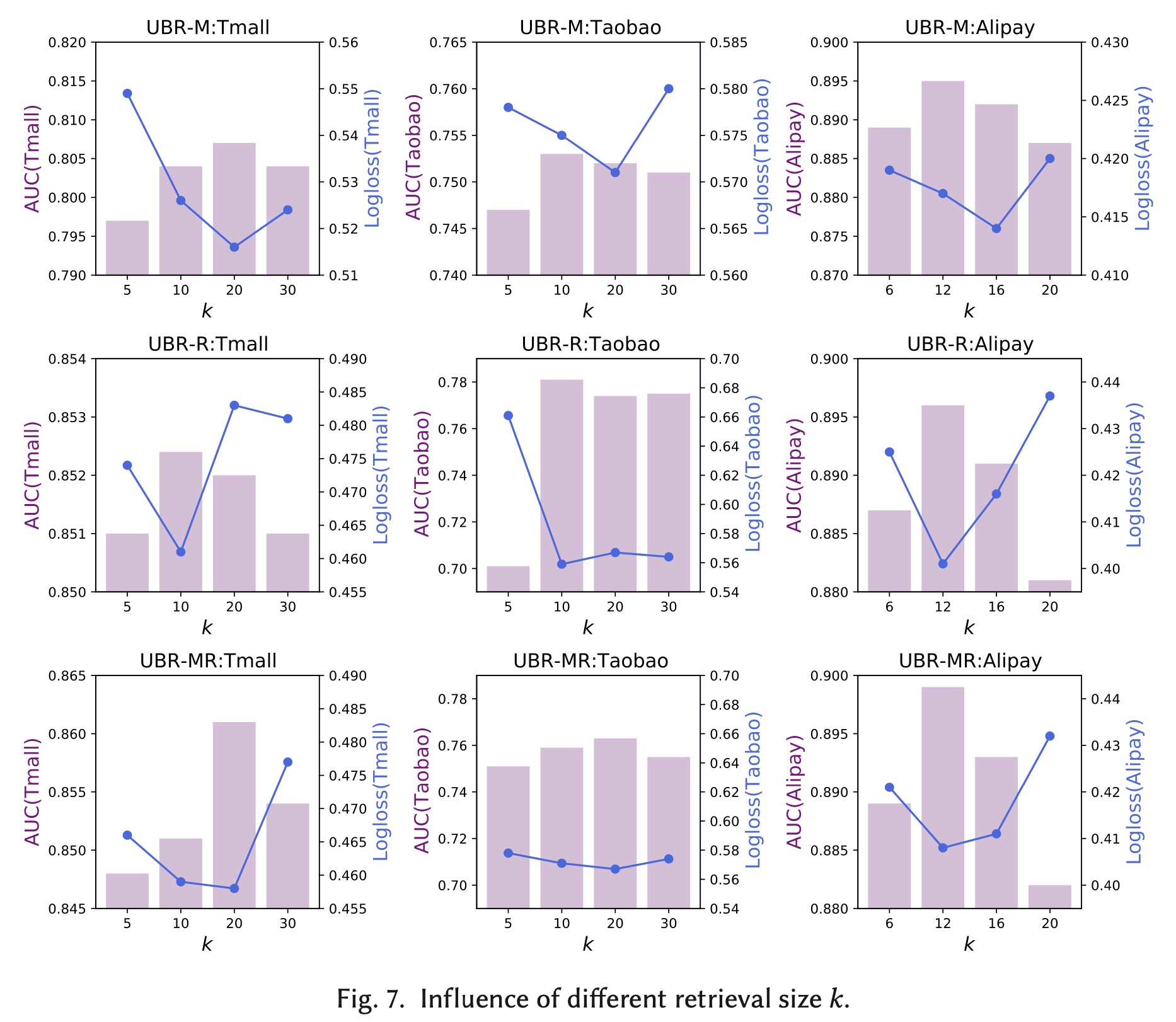

采样的特征数量

query数量Figure 7说明了不同retrieval sizes对预测性能的影响。从图中可以看出,AUC和Logloss的波动在绝对值方面并不是很严重。然而,每个数据集都存在一个最佳大小。这表明:太少的

retrieved behaviors可能未包含足够的behavior和信息。而太多的

retrieved behaviors也不总是提高性能,因为它会引入太多噪音。

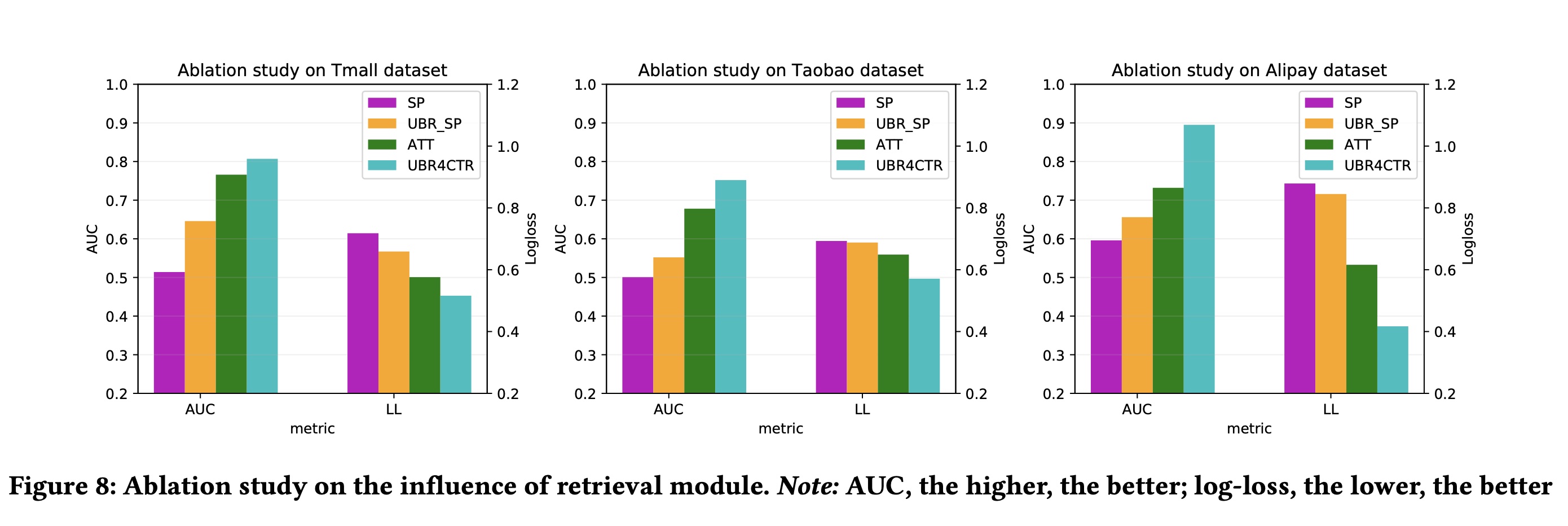

为了说明我们框架的检索模块的重要性,我们绘制了

sum pooling model和attention network,分别在具备和不具备user behaviors retrieval的情况下的性能比较。sum pooling model只是对user behavior做了一个非常简单的sum池化操作。结果如Figure 8所示。从图中我们发现:没有检索的

sum池化模型(SP)表现很差。一旦配备了检索模块,它的性能就会显著提高(UBR_SP)。同样的现象也适用于注意力网络,当配备了

behavior retrieval module时,其性能会大大提高(ATT vs. UBR4CTR)。

51.4 部署

UBR4CTR已在某主流银行旗下的daily item recommendation平台的engineering schedule中部署。本节主要讨论UBR4CTR框架在工业应用中的可行性。首先,将目前的模型流程切换到

UBR4CTR并不困难,因为UBR4CTR带来的主要变化是如何获取历史user behavior。要将model pipeline更新为UBR4CTR,需要构建历史user behavior的一个搜索引擎,而整个CTR prediction model pipeline基本保持不变,但增加了一个额外的检索模块。如Figure 2所示,prediction module与传统解决方案的prediction module并无不同。

效率是工业应用中的另一个重要关注点。我们在 ”模型分析“ 章节中分析了

UBR4CTR的时间复杂度,为RNN的sequential CTR models,它们的时间复杂度为GRU rolling)的成本。UBR4CTR的时间复杂度并非完全不可行,因为从系统负载的角度来看,

UBR4CTR更好,因为它不需要在内存中维护所有behavior。为维护所有behavior,这是传统方法的常见做法。此外,我们在实验中比较了我们的

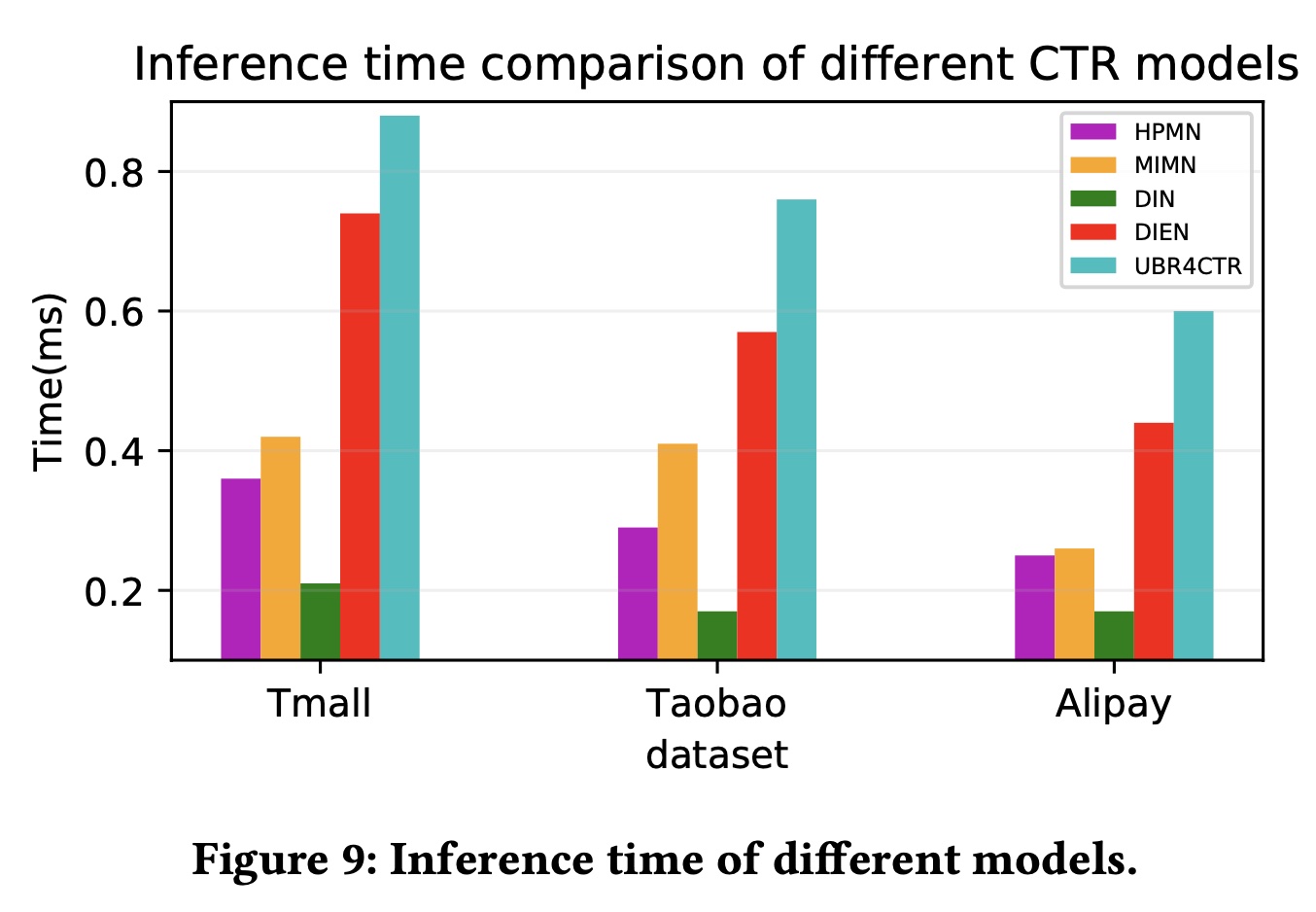

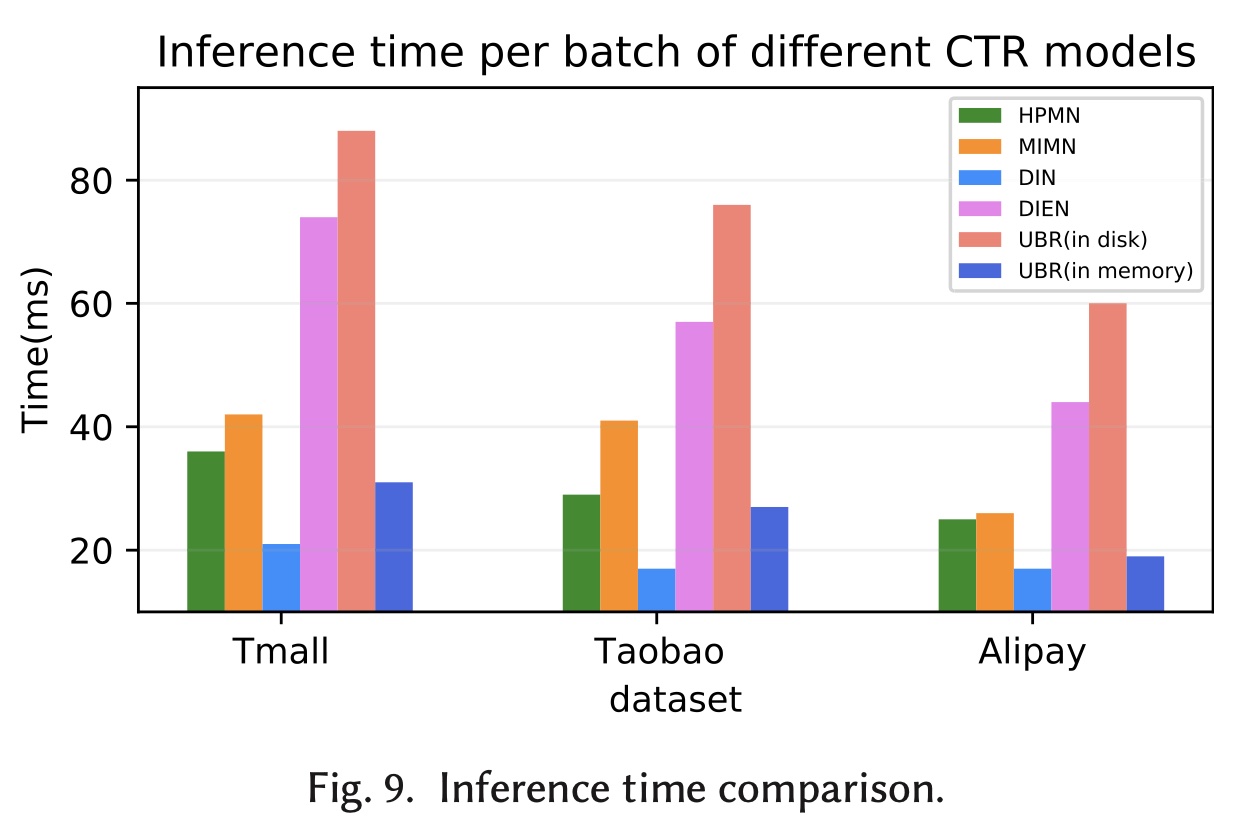

UBR4CTR和其他sequential CTR baselines之间的实际inference time。模型的平均inference time如Figure 9所示。时间是通过将测试数据集上的总时间(仅包含前向计算和behavior搜索的时间)除以prediction targets的数量来计算的。从图中可以看出,

UBR4CTR在三个数据集上的推理时间绝对值小于1ms,这对于online serving来说已经足够高效了。UBR4CTR的inference time是所有sequential CTR models中最长的,但差距并不大。具体而言,与已在阿里巴巴在线广告平台中部署的DIEN相比,UBR4CTR的平均inference time大约增加了15%到30%,可以通过进一步的infrastructure implementation来进行优化。

五十二、ETA [2021]

《End-to-End User Behavior Retrieval in Click-Through Rate Prediction Model》

CTR prediction是推荐系统的核心任务之一。它预测每个user-item pair的个性化的点击概率。最近,研究人员发现,通过考虑用户行为序列,尤其是长期用户行为序列,可以大大提高CTR模型的性能。某电商网站的报告显示,23%的用户在过去5个月内点击次数超过1000次。尽管有大量工作专注于建模用户行为序列,但是由于现实世界系统中严格的inference time的限制,很少有工作能够处理长期用户行为序列。人们提出了两阶段方法来突破极限以获得更好的性能:在第一阶段,设计一个辅助任务来从长期用户行为序列中检索

top-k相似的items。在第二阶段,在

target item和第一阶段选择的k个items之间进行经典的注意力机制。

然而,检索阶段和主体的

CTR任务之间存在information gap。这种目标分歧会大大降低长期用户序列的性能增益。在本文中,受Reformer的启发,我们提出了一种局部敏感哈希(locality-sensitive hashing: LSH)方法,称为End-to-end Target Attention: ETA,它可以大大降低训练和推理成本,并使得采用长期用户行为序列进行端到端的训练成为可能。离线和在线实验都证实了我们模型的有效性。我们将ETA部署到一个大型的真实世界电商系统中,与两阶段的长用户序列的CTR模型相比,商品交易总额(Gross Merchandise Value: GMV)额外提高了3.1%。推荐系统被广泛用于解决信息过载问题。在推荐系统中使用的所有深度学习模型中,

CTR prediction模型是最重要的模型之一。为了提高推荐系统的在线性能,工业界和学术界都非常重视提高CTR模型的AUC。在过去的十年中,CTR模型的性能得到了很大的提高。其中一个显著的里程碑是引入用户行为序列,特别是长期用户行为序列。根据《Lifelong Sequential Modeling with Personalized Memorization for User Response Prediction》的报告,电商网站中23%的用户在过去5个月内点击次数超过1000次。如何有效利用大量的且信息丰富的user behavior变得越来越重要,这也是本文的目标。人们提出了各种方法来建模用户行为序列。

早期的方法,如

sum/mean pooling方法、RNN-based的方法、CNN-based的方法、以及self-attention-based,将不同长度的用户行为序列编码为固定维度的hidden vector。然而,它们在对不同的target items进行打分时无法捕获用户的动态局部兴趣(dynamic local interests)。这些方法还通过编码所有的用户历史行为从而引入了噪音。为了克服全局池化方法的缺点,人们提出

DIN方法。DIN通过target attention机制根据不同的target items生成various user sequence representations,其中target item充当queryitem充当keyvalueDIN使用最近的50个behavior用于target attention,这忽略了长用户行为序列中的丰富信息,显然是次优的。最近,人们提出

SIM和UBR4CTR等SOTA方法。这些方法从较长的用户行为序列中捕获用户的动态兴趣。这些方法分两阶段进行:在第一阶段,设计一个辅助任务从长期用户行为序列中检索

top-k相似的items,以便提前准备好top-k相似的items。在第二阶段,

target item和第一阶段选定的k个items之间进行target attention。

然而,用于检索阶段的信息与

main CTR model不一致或已过时。例如:UBR4CTR和SIM使用category等属性从用户行为序列中选择与target item共享相同属性的items,这与CTR模型的目标不一致。SIM还尝试基于pre-trained embedding来构建离线倒排索引(offline inverted index)。在训练和推理过程中,模型可以搜索top-k“相似” 的items。但大多数CTR模型都采用online learning范式,并且embedding会不断被更新。因此,与在线CTR模型中的embedding相比,离线倒排索引中的pre-trained embedding已经过时。

无论是不一致的目标还是过时的

retrieval vector,都会阻止长期用户行为序列得到充分利用。

在本文中,我们提出了一种称为

ETA的方法,可以实现端到端的长期用户行为的检索,以缓解CTR prediction任务中上述information gap(即不一致的目标和过时的embedding)。我们使用SimHash为用户行为序列中的每个item生成指纹。然后使用汉明距离来帮助选择top-k的item从而用于target attention。我们的方法将retrieval复杂度从CTR模型要评分的target items数量,item embedding的维度。复杂度的降低有助于我们在训练和服务过程中移除离线辅助模型并进行实时检索。与SOTA模型相比,这大大提高了ranking improvements。我们论文的贡献可以概括为三点:我们针对

CTR prediction任务提出了一种端到端的Target Attention方法,称为End-to-end Target Attention: ETA。据我们所知,ETA是第一个以端到端方式使用CTR模型对长期用户行为序列进行建模的工作。离线实验和在线

A/B tests都表明,与SOTA模型相比,ETA实现了显著的性能提升。与两阶段CTR模型相比,将ETA部署到大型现实世界电商平台后,GMV额外提高了3.1%。进行了全面的消融研究,以揭示在

inference time限制的约束下更好地建模用户行为序列的实际经验。我们的方法还可以扩展到其他场景,扩展到需要处理极长序列的其他模型,例如长序列的时间序列预测模型。

其核心思想就是:用近似的

similarity(embedding经过LSH之后的汉明距离)来代替精确的similarity(embedding向量的内积)。

52.1 基础知识

在本节中,我们首先给出

CTR prediction任务的公式。然后我们介绍如何通过SimHash机制生成embedding向量的指纹。

52.1.1 Formulation

CTR prediction任务广泛应用于在线广告、推荐系统和信息检索。它旨在解决以下问题:给定一个impressionitem被展示给一个用户,使用特征向量user click(标记为CTR任务通常被建模为二分类问题。对于每个impressionitem是否被点击从而标记一个二元标签CTR模型以最小化交叉熵损失:其中:

impression的总数;label;

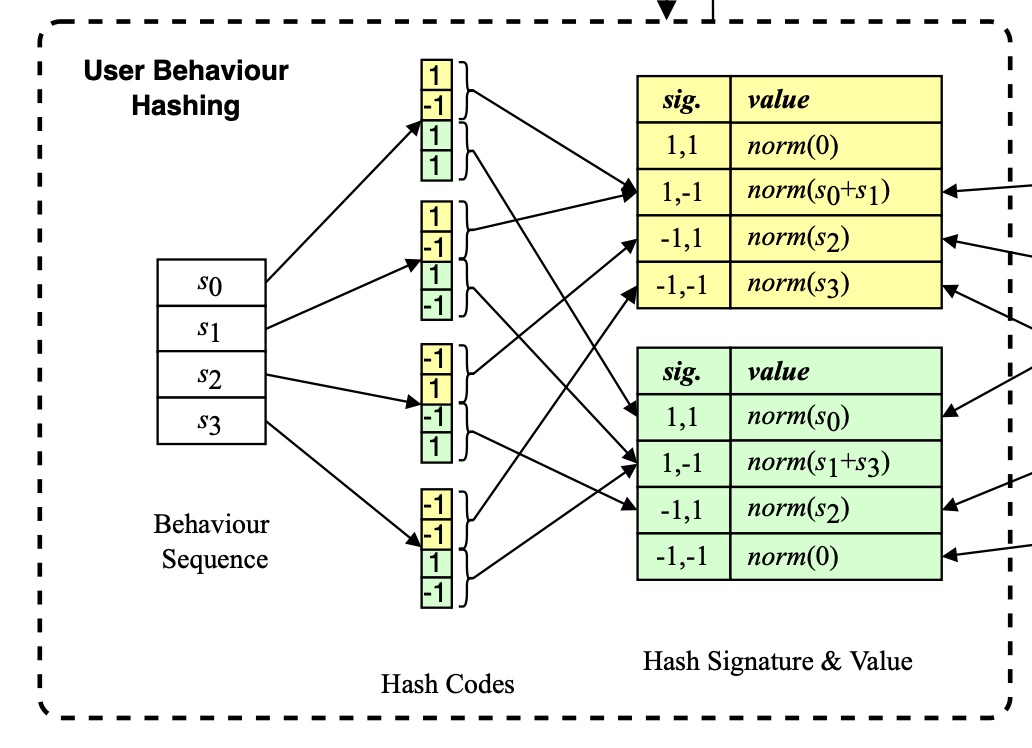

52.1.2 SimHash

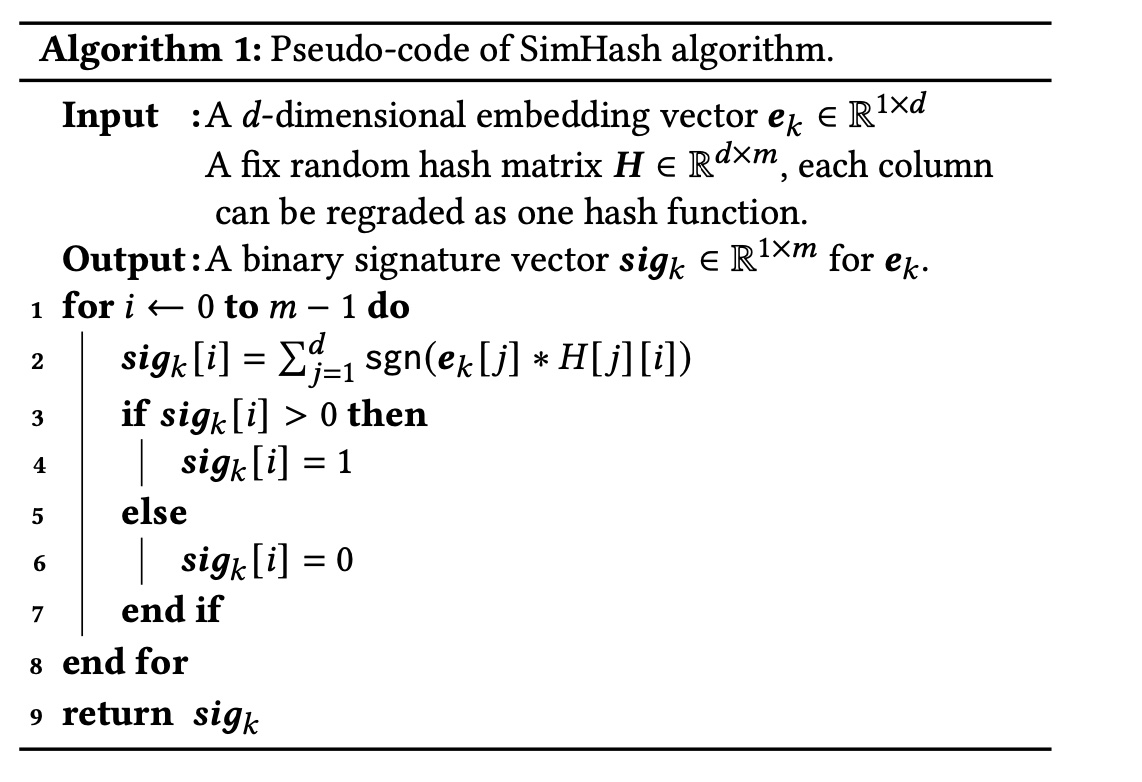

SimHash算法最早由《Similarity estimation techniques from rounding algorithms》提出,其中一个著名应用是《Detecting near-duplicates for web crawling》,它通过SimHash based的指纹检测重复的网页。SimHash函数将item的embedding vector作为输入,并生成其二进制指纹。Algorithm 1显示了SimHash的一种可能的实现的伪代码。不用那么啰嗦,可以直接用矩阵乘法来实现:

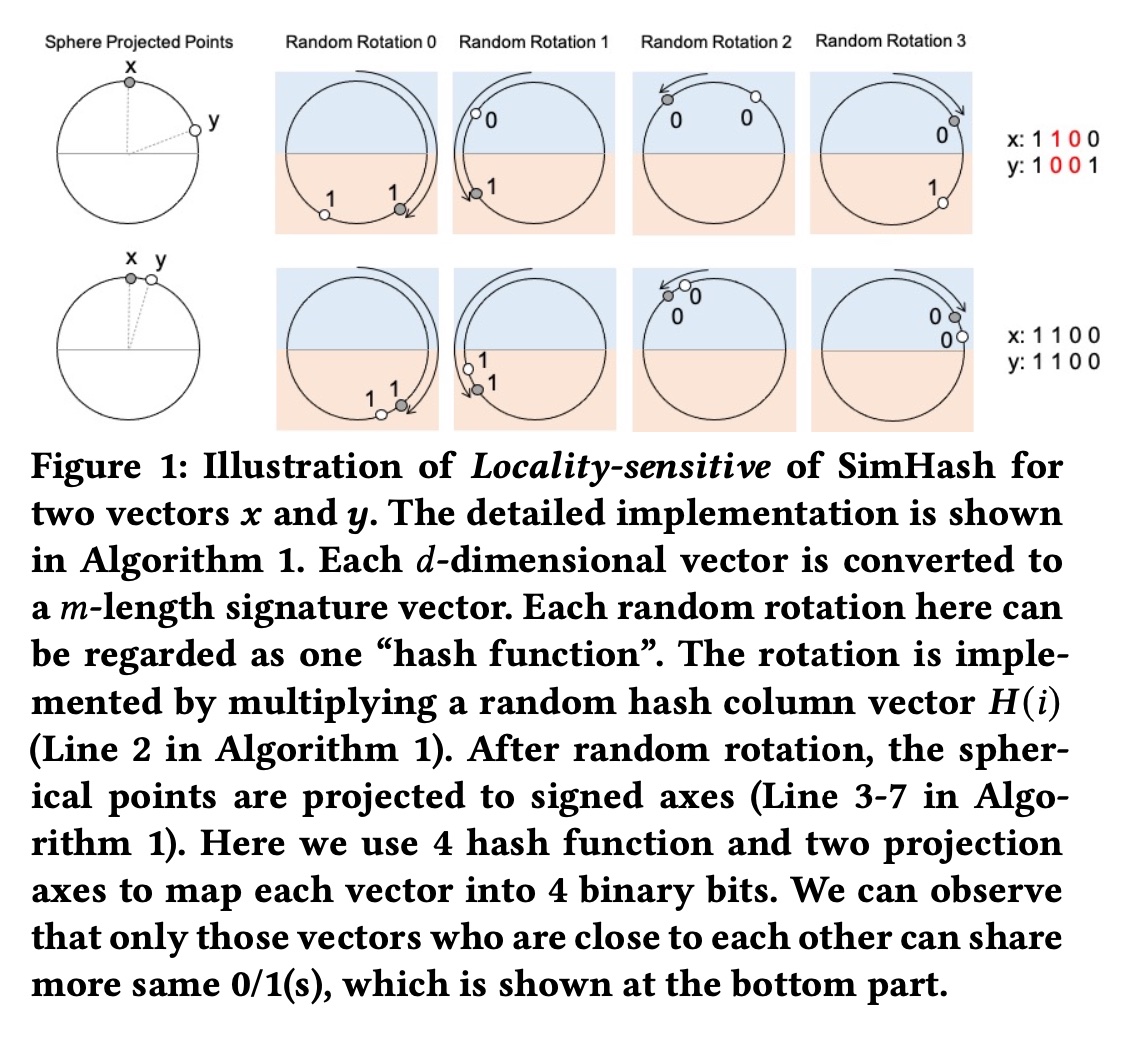

SimHash满足局部敏感特性(locality-sensitive properties):如果输入向量彼此相似,则SimHash的输出也相似,如Figure 1所示。Figure 1中的每个random rotation都可以看作一个“哈希函数”。旋转是通过将input embedding vector与随机投影列向量Algorithm 1的第2行所示。随机旋转后,球面上的点被投影到signed axes上(Algorithm 1中的第3-7行)。在Figure 1中,我们使用4个哈希函数和两个projection axes,将每个向量映射到一个具有4个元素的signature vector。signature vector中的每个元素要么是1,要么是0。可以进一步使用一个整数对该向量进行解码,以节省存储成本并加快后续的汉明距离计算。例如,

1001可以解码为整数9 = 1*8 + 0*4 + 0*2 + 1。从

Figure 1中我们可以观察到,附近的embedding向量可以以很高的概率获得相同的哈希签名(hashing signature),参见Figure 1下半部与Figure 1上半部的比较。这种观察结果就是所谓的“局部敏感”特性。利用局部敏感特性,embedding向量之间的相似性可以由哈希签名之间的相似性取代。换句话说,两个向量之间的内积可以用汉明距离代替。值得注意的是,

SimHash算法对每个旋转的 “哈希函数” 的选择不敏感。任何固定的random hash vectors就足够了(参见Algorithm 1中的embedding vectors。“

4个哈希函数和两个projection axes”?图中看起来只有一个轴啊,水平轴下方为1、上方为0。

52.2 模型

在本节中,我们首先介绍我们的

End-to-End Target Attention: ETA模型的详细架构。然后介绍ETA模型的不同子模块。最后,我们介绍部署ETA的实际经验。

52.2.1 模型概况

如

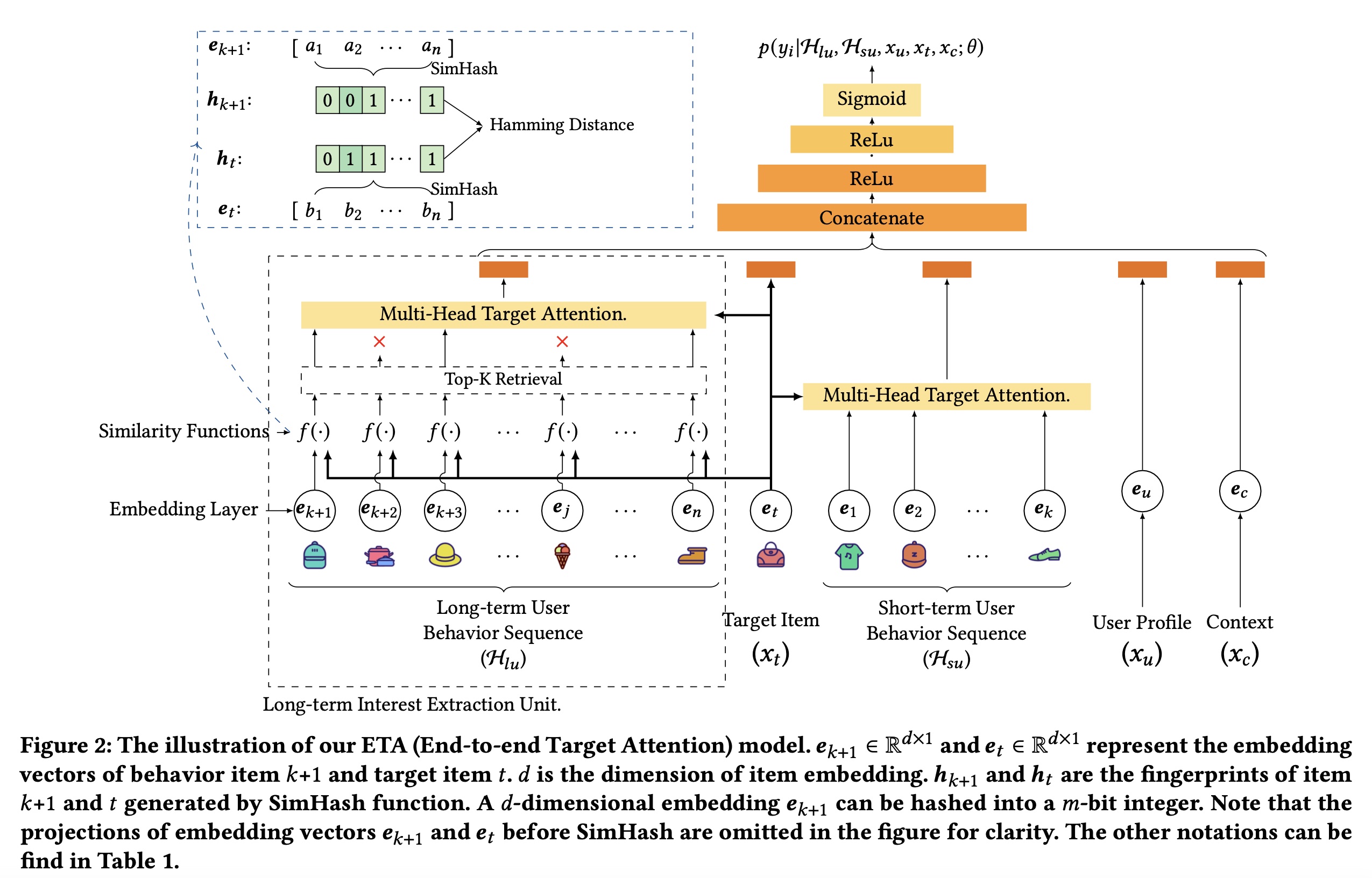

Figure 2所示,我们的模型以user/item-side features作为输入,输出某个user-item pair的点击概率。长期用户行为序列

user profiletarget item注意:长期用户行为序列

在

SIM模型中,长期用户行为序列是否包含短期用户行为序列?这个不清楚,SIM的原始论文未说明。在

MIMN和UBR4CTR模型中,只有长期用户行为序列,没有短期用户行为序列。有了这些特征,我们使用长期兴趣提取单元(

Long-term Interest Extraction Unit)、多头目标注意力(Multi-head Target Attention)和Embedding Layer分别将hidden vectors。然后将hidden vectors拼接在一起并馈入到Multi-layer Perception: MLP部分。在

MLP的最后一层,使用sigmoid函数将hiddenvector映射为标量user-item pair的点击概率。此概率可作为下游任务的ranking score。

本文中这些符号的含义:

52.2.2 Embedding Layer

对于不同类型的特征,我们采用不同的

embedding技术。原始输入特征主要分为两类:categorical特征和numerical特征。在我们的模型中,我们对

categorical特征使用one-hot encoding。对于

numerical特征,我们首先将特征划分到不同的numerical buckets中。然后我们应用one-hot encoding来识别不同的桶,这与《Interpretable Click-Through Rate Prediction through Hierarchical Attention》的方式类似。

请注意,由于有数十亿个

item ids,one-hot encoding vectors可能非常稀疏。因此,我们将所有one-hot embedding vectors映射到低维hidden vectors以减少参数数量。我们使用itemembedding vector。然后将所有user behavior items的embedding vectors打包成矩阵embedding size:

52.2.3 Multi-head Target Attention

多头注意力机制由

《Attention Is All You Need》首次提出,并广泛应用于CTR prediction任务。在CTR prediction任务中,target item作为queryitem作为keyvaluemulti-head target attention),缩写为TA。multi-head target attention的计算如下:其中:

target item的embedding矩阵;embedding矩阵。item的embedding size。注意,为了清晰起见,我们只选择了一个样本(即,一个target item),而不是一个batch的样本。head数量。矩阵

query、key、value。query, key, value。query中每一行的维度,也是key中每一行的维度;value中每一行的维度。softmax函数用于将内积值转化为

multi-head target attention的主要部分是dot-product attention。dot-product attention由两步组:首先,根据

target item和每个behavior item的相似度。其次,以归一化的相似度作为注意力权重,并计算所有

behavior items的weighted sum embedding。

52.2.4 Long-term Interest Extraction Unit

这部分是我们

ETA模型的主要贡献。它将用户行为序列的长度从数十扩展到数千甚至更长,从而捕获长期用户兴趣。如前所述,multi-head target attention的复杂度为target items的数量(也就是batch size),representation维度。在大型在线系统中,1000,128。因此,直接对数千个长期的user behavior进行multi-head target attention是不可行的。 根据softmax由最大元素主导;因此,对于每个query,我们只需要关注与query最相似的key,这也得到了《Reformer:Theefficient transformer》、《Search-based User Interest Modeling with Lifelong Sequential Behavior Data for Click-Through Rate Prediction》、《User Behavior Retrieval for Click-Through Rate Prediction》的证实。因此我们可以首先从行为序列中检索top-k items,并对这些k个behavior进行multi-head target attention。然而,一个好的检索算法应该满足两个约束:

1):检索部分的目标应该与整个CTR模型保持一致。只有这样,检索到的top-k items才能对CTR模型做出最大贡献。2):检索时间应满足严格的inference time限制,以确保该算法可以应用于实际系统,从而每秒处理数百万个request。

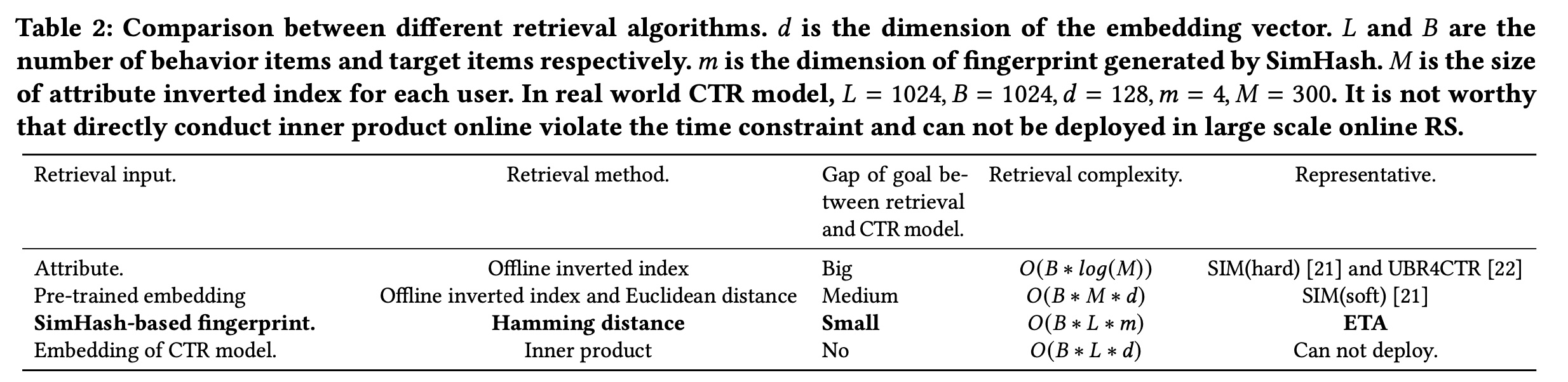

我们在

Table 2中比较了不同的检索算法。SIM和UBR4CTR构建离线倒排索引(offline inverted index),以便在训练和推理期间进行快速搜索。然而,它们用于构建索引的输入是item的属性信息(例如category)或item的pre-trained embedding,这与CTR模型中使用的embedding不同。这种差距违反了上述约束1),并可能导致性能下降。如果直接使用

CTR模型中的embedding并通过内积搜索k-nearest neighbor,则需要2),并且无法在线部署。我们的

ETA使用SimHash将两个向量的内积转换为汉明距离计算,如Figure 2所示。这使得它可以部署在现实世界的推荐系统中。此外,SimHash的局部敏感特性可以确保fingerprint始终可以与CTR模型中的original embedding保持同步。实验章节的评估部分表明这种兼容性可以大大提高性能。如何选择正确的哈希函数、以及检索部分和

ETA其余部分之间的联合学习将在后续章节中说明。

经过

SimHash函数和hamming distance layer后,我们从top-k相似的behavior items,然后执行前面提到的multi-head target attention以生成hidden vector。该向量作为长期用户兴趣的representation,并与其他向量一起输入到MLP layers中。long-term user interest extraction unit的公式如下:其中:

LTI和TA分别是long-term user interest extraction unit和multi-head target attention的缩写。embedding矩阵。target item

相似度函数:如

Figure 2所示,我们使用SimHash函数和汉明距离来计算两个embedding向量的相似度,而不是内积。SimHash函数将上述embedding layer的输出作为输入。对于每个输入的embedding向量,SimHash函数生成其compressed number作为指纹(fingerprint)。SimHash满足局部敏感特性:如果input features彼此相似,则hashing output也相似。因此,embedding向量之间的相似性可以用hashed fingerprints之间的相似性来代替。embedding向量可以编码为m-bit number。然后可以通过汉明距离来测量两个指纹之间的相似性。Top-K Retrieval:与基于内积的模型相比,top-k retrieval layer可以通过汉明距离更有效地找到与target item的top-k相似的user behavior items。两个整数的汉明距离定义为对应bits不同的不同bits positions的数量。为了得到两个

m-bit numbers的汉明距离,我们首先进行XOR运算,然后计算取值为1中的bits数量。如果我们将乘法定义为原子操作,则两个m-digit numbers的汉明距离的复杂度为top-k retrieval的总复杂度为target items的数量。值得注意的是,每次执行

SimHash函数时,hashed fingerprints都可以与模型一起存储在embedding table中。在推理期间,只需要embedding lookup,其复杂性可以忽略不计。

52.3 部署

在本节中,我们展示了如何训练具有检索部分的

ETA。然后我们介绍如何选择SimHash算法中使用的“哈希函数”。然后我们介绍工程优化技巧。Joint learning of retrieval part:在训练阶段,检索部分不需要更新梯度。检索的目标是为接下来的multi-head target attention部分选择query的最近邻的keys。在选择了query的top-k最近邻的keys之后,对这些top-k items的original embedding vectors进行正常的注意力机制和反向传播。检索的唯一事情是在训练开始时初始化一个固定的随机矩阵Algorithm 1)。只要input embedding vectorSimHash的签名就会相应更新。局部敏感特性确保在每次迭代中,使用CTR模型的latest embedding无缝地选择query的top-k nearest keys。因此,检索和CTR模型之间的gap of goal比其他检索方法(例如Table 2中所示的基于离线倒排索引的方法)小得多。从

CTR模型的角度来看,检索部分是透明的,但可以确保模型使用最邻近的items进行multi head attention。实验章节表明,这种无需任何pre-training或offline inverted index building的端到端训练可以大大提高CTR prediction任务的性能。“哈希函数”的选择:

SimHash是一种著名的局部敏感哈希 (locality-sensitive hashing: LSH)算法。SimHash的实现如Algorithm 1所示,其中我们使用固定的random hash vector作为“哈希函数”。任何将字符串映射为随机整数的传统散列函数都可以使用。但是,在我们的算法中,出于对矩阵计算的可扩展性和效率的考虑,我们选择了random hash vector和Algorithm 1的实现,这与Reformer相同。局部敏感哈希是通过随机旋转和投影实现的。随机旋转是指

embedding vector与一个固定的random hashing vectorsinged axes上从而获得binary signature,0附近随机生成。工程优化技巧:当在线部署模型时,

SimHash的计算可以进一步减少一步。针对embedding向量Algorithm 1计算出的长度为signature vectorsignature vector,因为1要么为0。因此,这样可以大大减少内存开销,加快汉明距离的计算速度。两个整数的计算时间可以在

52.4 实验

在本节中,我们进行实验来回答以下研究问题:

RQ1:我们的ETA模型是否优于baseline模型?RQ2:与baseline模型相比,我们的ETA模型的推理时间是多少?推理时间和性能一样重要,因为它决定了模型是否可以在线部署以供服务。RQ3:我们的ETA模型的哪一部分对性能和推理时间贡献最大?

数据集:为了对我们的

ETA模型和baseline模型进行全面比较,我们使用了公共数据集和工业数据集。还进行了在线A/B test。对于公共数据集,我们选择了Taobao数据集,baseline模型SIM和UBR4CTR也采用了该数据集。我们也准备了一个工业数据集作为公共数据集的补充。Table 3简要介绍了数据集。Taobao数据集:该数据集由《Joint optimization of tree-based index and deep model for recommender systems》首次发布,被广泛用作CTR prediction任务和序列推荐任务的公共基准。它由Taobao Mobile App的user behavior日志组成。user behavior包括点击、收藏、添加到购物车、以及购买。该数据集包含100M个实例。平均而言,每个用户大约有101次交互,每个item受到超过24次交互。最近的16个behavior作为短期用户行为序列,最近的256个behavior作为长期用户行为序列。工业数据集:该数据集是从我们自己的在线推荐系统收集的,它是我国顶级的移动

app之一。我们的工业数据集有三个优势:(i):我们的数据集包含impression interaction,这表示item展示给用户但未被用户点击。impression interaction自然是CTR模型的负样本。因此,不需要棘手的负采样。(ii):我们的工业数据集中的用户行为序列更长。有超过142B个实例,平均长度达到938,比公开的Taobao数据集长9倍。(iii):我们的工业数据集具有由多位软件工程师设计的更多特征,更接近现实世界的推荐系统模型。最近的48个behavior作为短期用户行为序列,最近的1024个behavior作为长期用户行为序列。在消融研究中,我们还尝试了长度为{256, 512, 2048}的长期用户行为序列。

baseline:我们将我们的模型与以下主流的CTR prediction baselines。选择每个baseline来回答上述一个或多个相关的研究问题。Avg-Pooling DNN:利用用户行为序列的最简单方法是均值池化,它将不同长度的用户行为序列编码为fixed-size hidden vector。该baseline可以看作是DIN的变体,用均值池化代替target attention,类似于YouTube。与DIN相比,该baseline主要用于显示target attention的必要性。DIN:DIN通过注意力机制来建模具有不同target items的个性化用户兴趣,该注意力机制称为target attention。但是,DIN仅利用短期用户行为序列。DIN (Long Sequence):是配备长期用户行为序列DIN。DIN相比,此baseline用于衡量长期用户行为序列本身的信息增益。SIM(hard):SIM是CTR prediction模型,它提出了一个search unit,以两阶段的方式从长期用户行为序列中提取用户兴趣。SIM(hard)是SIM的一种实现,它在第一阶段按category id搜索top-k behavior items。UBR4CTR:UBR4CTR也是一种两阶段方法,它在CTR prediction任务中利用长期用户行为序列。在UBR4CTR中,通过一个feature selection model准备好query,从而检索最相似的behavior items。它还准备了一个倒排索引以供在线使用。由于UBR4CTR和SIM几乎同时发布,因此它们无法相互比较。在我们的论文中,我们首次比较了UBR4CTR和SIM。SIM(hard)/UBR4CTR + timeinfo:是在对用户行为序列进行编码时带有time embedding的SIM(hard)/UBR4CTR。

在

《Search-based User Interest Modeling with Lifelong Sequential Behavior Data for Click-Through Rate Prediction》中,作者提出SIM(soft)作为基础算法SIM(hard)的变体。他们最终采用SIM(hard)方法作为online serving算法,并在线部署SIM(hard)+timeinfo来服务主要流量。这是因为SIM(hard)不需要pre-training,对系统演进和维护更友好。此外,SIM(hard)+timeinfo可以实现与SIM(soft)相当的性能。因此,我们选择SIM(hard)和SIM(hard)+timeinfo作为我们的强基线。MIMN与DIN是由同一个团队提出的。MIMN提出了一个multi-track offline user interest center来提取长期用户兴趣。在发布时,它通过利用长期用户行为序列实现了SOTA的性能。然而,MIMN被同一支队伍的SIM所击败。由于MIMN对我们的研究问题贡献不大,由于篇幅限制,我们省略了这个基线。评估指标:

离线实验:

AUC作为主要指标,推理时间作为补充指标。推理时间定义为:对某个模型请求的

a batch of items进行评分时的往返时间。我们通过在线部署被测试的模型来服务用户请求从而测量推理时间,这些用户请求是从产品环境中复制而来。为了比较公平性,机器和用户请求数量控制相同。在线

A/B test:CLICK和CTR。CLICK:被点击items的总数。CTR:衡量平台中用户的点击意愿。它的定义为CLICK/PV,其中PV定义为被展示的items的总数。

数据预处理:

Taobao数据集仅包含positive交互,例如评论、点击、收藏、添加到购物车、以及购买。我们使用与MIMN相同的数据预处理方法。首先,对于每个用户,我们选择最后一个

behavior作为正样本。然后,对于该用户,我们随机采样一个与正样本相同

category的新item作为负样本。其余的

behavior items用作特征。

根据正样本的时间戳

80%)、验证集(10%)和测试集(10%)。我们的工业数据集自然有正样本和负样本,因为我们记录了每个用户的所有

impressions。如果用户点击了该item,则impression被标记为正样本;否则,它被标记为负样本。我们使用过去两周的日志作为训练集,

following day的日志作为测试集,这与SIM类似。

实验设置:对于不同数据集上的每个模型,我们使用验证集来调优超参数以获得最佳性能。学习率从

L2正则化项从Adam优化器。Taobao数据集和我们的工业数据集的batch size分别为256、1024。

52.4.1 性能比较

Taobao数据集:Taobao据集上的评估结果如Table 4所示。从表中我们发现:与所有

baselines相比,我们的ETA具有一致的性能改进。ETA比SIM(hard)好0.46%,比DIN(Long Se-sequence)好0.6%。添加

time embedding后,ETA+timeinfo的性能比SIM(hard)+timeinfo高0.38%,比DIN(Long Sequence)高0.85%。在UBR4CTR上也可以观察到类似的结果(即,添加time embedding的效果更好)。

观察到

DIN(Long Sequence)与DIN相比,AUC提高了0.35%,这表明对长期用户行为序列进行建模对于CTR prediction是有效的。我们还发现

UBR4CTR的性能比DIN(Long Sequence)差。这是因为UBR4CTR的feature selection model仅选择特征(例如category、星期几)与target item相同的behavior。UBR4CTR中的这种过滤有助于从序列中去除噪音,但也会导致用户序列变短,当没有足够的items进行top-k retrieval时,这是有害的。我们发现

DIN比Avg-Pooling DNN的性能高出1.84%,这表明使用target attention来编码用户行为序列可以大大提高性能。

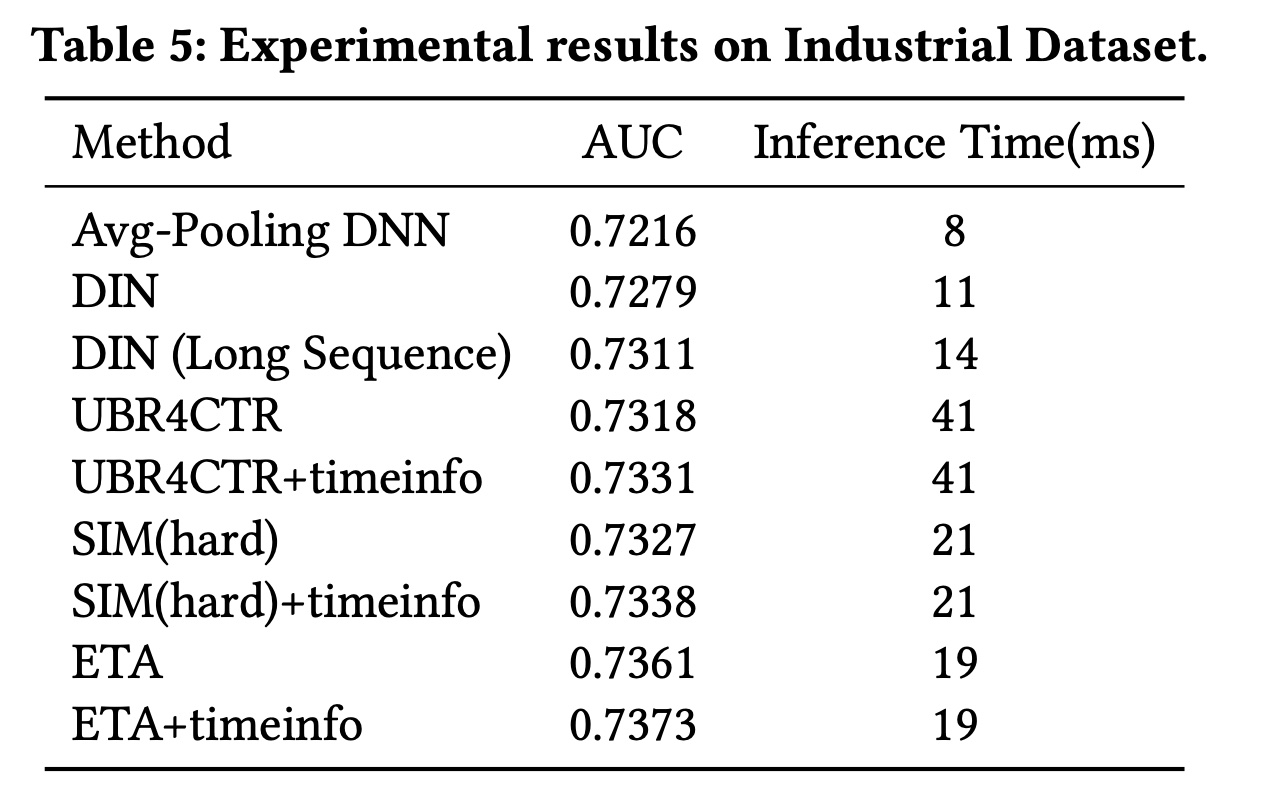

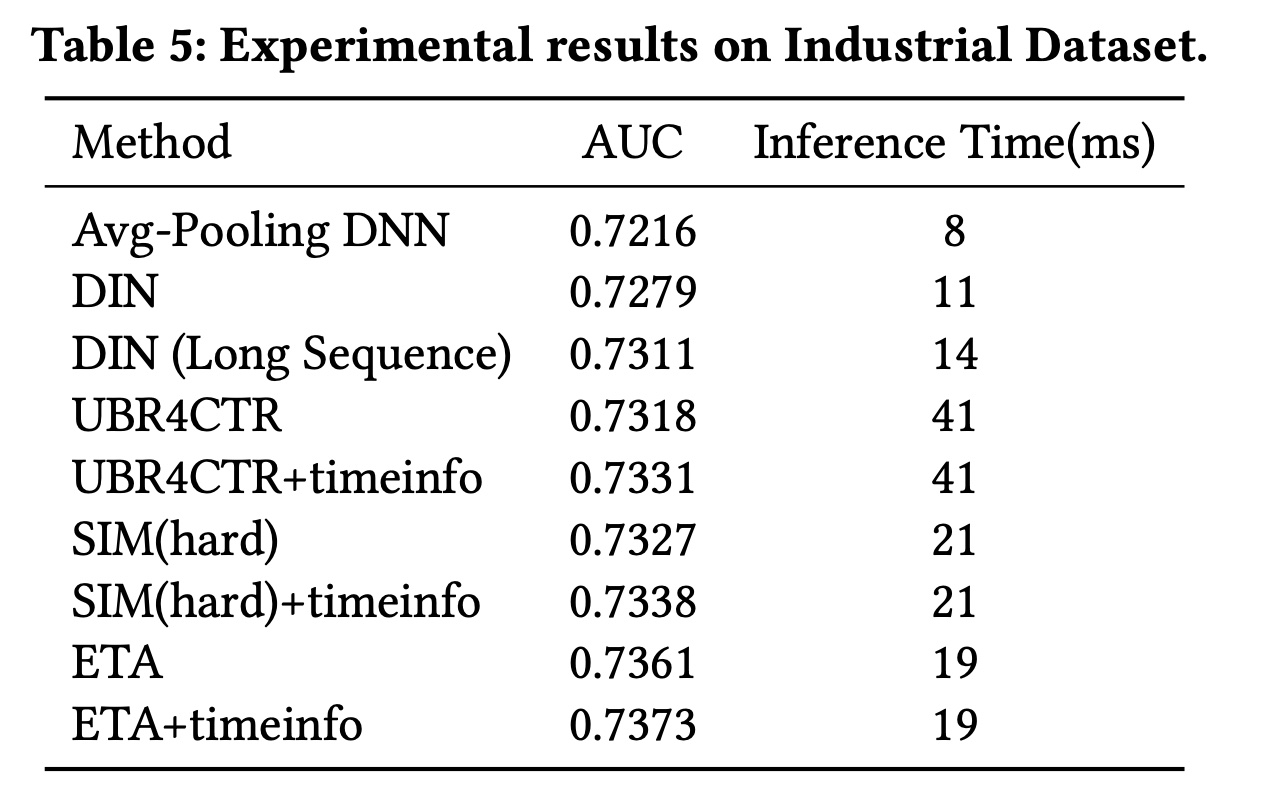

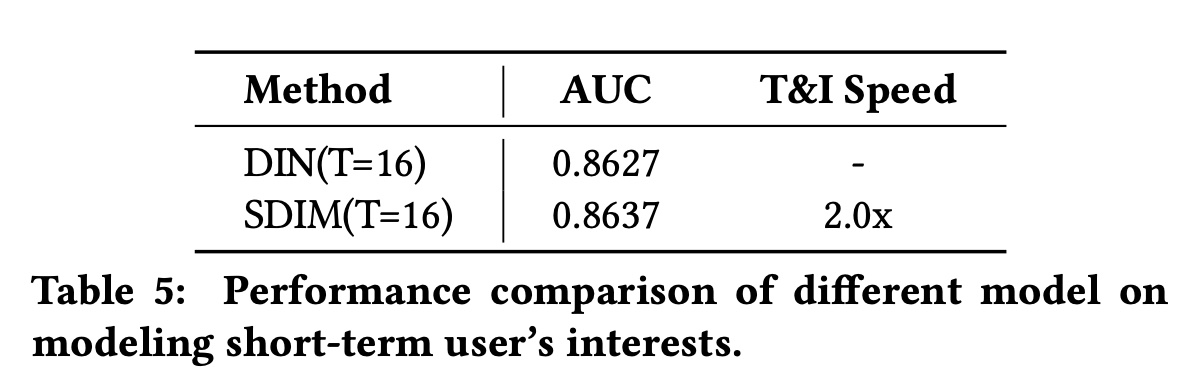

工业数据集:我们自己的工业数据集上的评估结果如

Table 5所示。请注意,CTR模型在AUC上的0.1%改进,可以在我们的在线推荐系统中带来数百万的真实点击和收入。与所有baselines相比,我们的ETA实现了最佳性能。与

SIM(hard)和UBR4CTR相比,我们的base ETA分别实现了0.34%和0.43%的改进。与

SIM(hard)+timeinfo和UBR4CTR+timinfo相比,我们的ETA+timeinfo分别实现了0.35%和0.42%的改进。与

Taobao数据集不同,在工业数据集上SIM(hard)+timeinfo成为最强的baseline,比DIN(Long Sequence)高出0.27%。这有两个原因。一方面,工业数据集中的用户序列长度足够大,对基于长期用户序列的模型友好。工业数据集的平均长度达到了

938,是Taobao数据集的9倍。另一方面,

DNN(Long Sequence)采用均值池化对整个序列进行无选择性地编码,与UBR4CTR、SIM、ETA等基于检索的模型相比,可能会引入噪音。

Taobao数据集上的最强baseline也是SIM(hard)+timeinfo。所以这个结论是错误的,其解释也是不可信的。我们还可以发现

SIM(hard)比UBR4CTR有0.09%的性能提升,这主要是由于对用户行为序列的处理方法不同造成的。在

SIM(hard)中,用户序列被拆分为两个独立的子序列,与Figure 2中的ETA类似:短期用户行为序列k个user behavior组成,从item 1到item k;长期用户行为序列item k+1到item n中选择的其他k个behavior而组成。但是,

UBR4CTR从item 1到item n选择item(Figure 2中的SIM(hard)以100%的概率选中,被UBR4CTR以feature selection model所决定的timeinfo在用户兴趣建模中起着重要作用,因为用户兴趣是动态的并且经常变化。因此SIM(hard)的表现优于UBR4CTR。

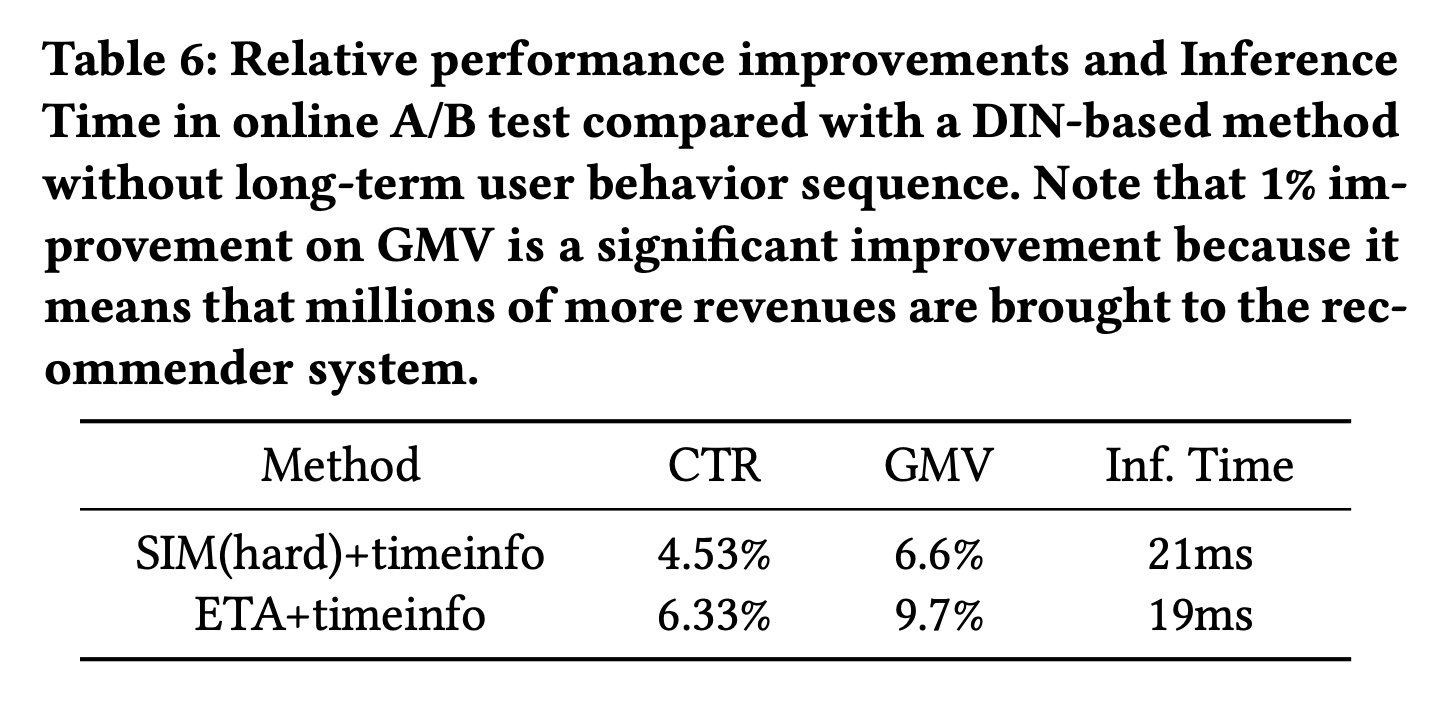

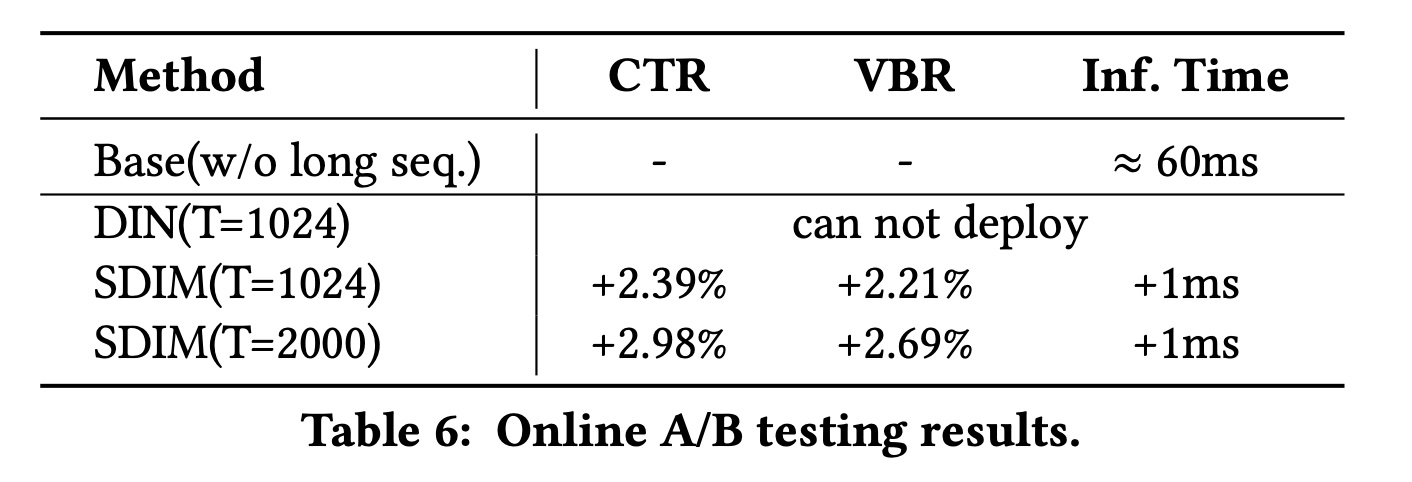

在线

A/B Test:在线A/B Test的评估结果如Table 6所示。Table 6显示了与DIN-based的方法相比的性能改进,其中DIN-based的方法没有长期用户行为序列。从Table 6中我们发现:与

DIN-based的方法相比,我们的ETA+timestamp在CTR上实现了6.33%的改进,并带来了9.7%的额外GMV。与最强的基线

SIM(hard)+timeinfo相比,我们的ETA+timeinfo在CTR上额外提高了1.8%,在 GMV 上提高了3.1%。

请注意,

GMV上1%的改进是一个显著的改进,因为这意味着为推荐系统带来了数百万的收入。

52.4.2 推理时间比较

虽然使用长期用户行为序列可以提高

CTR prediction的性能,但模型复杂度也会相应增加。我们测量了不同模型的推理时间,如Table 5所示。Avg-Pooling DNN的推理时间最短,为8 ms。它仅使用均值池化方法来编码近期的behavior items。将均值池化替换为

target attention后,DIN的推理时间增加了3ms(8ms到11ms)。引入长期用户行为序列后,

DIN (Long Sequence的推理时间又增加了3ms(11ms到14ms)。SIM和我们的ETA的推理时间相当,约为19 ~ 21 ms。UBR4CTR的推理时间最长,因为在检索阶段之前使用了额外的feature selection model,并且在线进行了相对耗时的IDF and BM25 based的程序来获取top-k items。

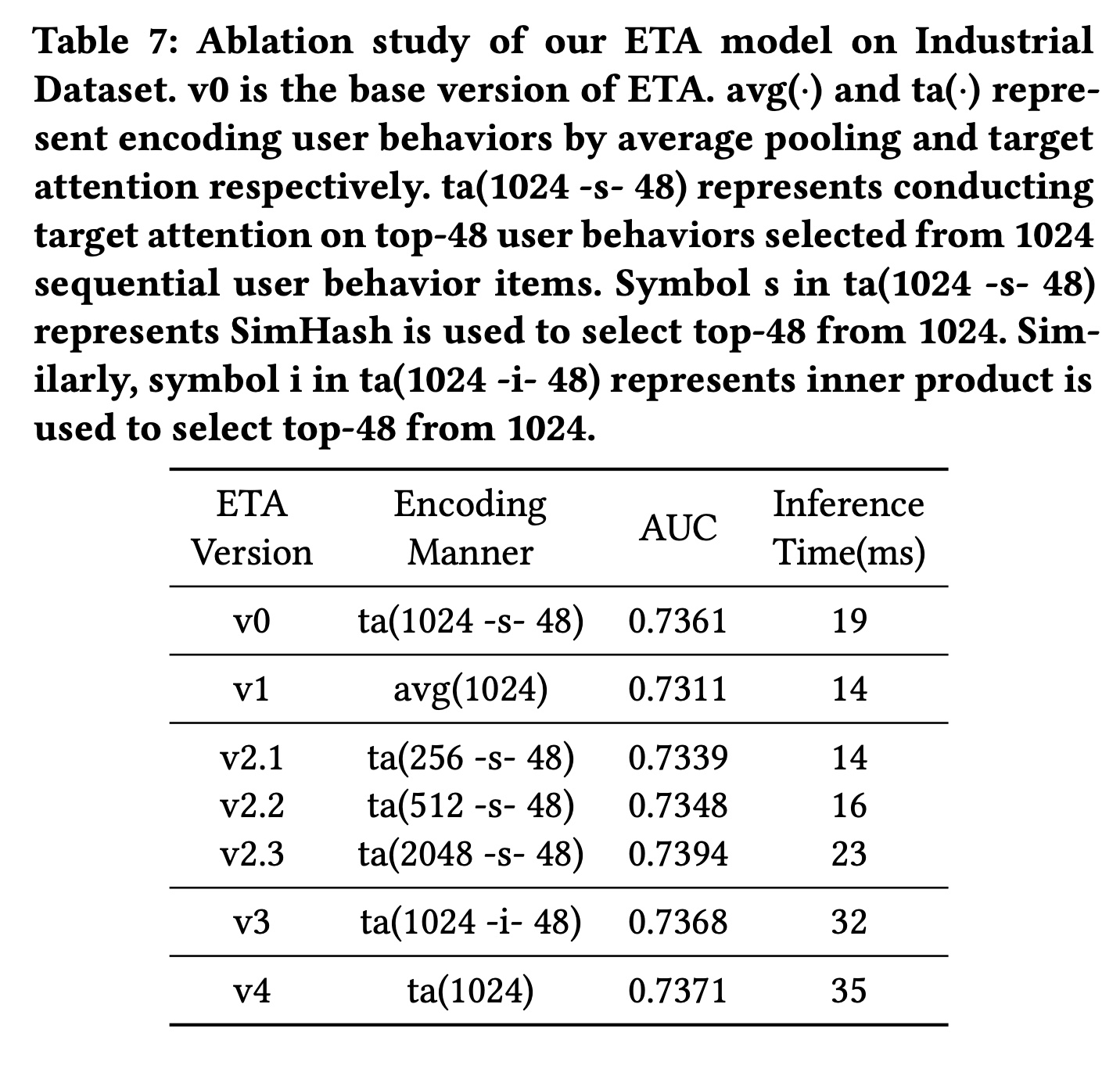

52.4.3 消融研究

消融研究结果如

Table 7所示,以回答问题RQ3。我们使用编码方式来区分ETA模型的不同版本(v0到v4)。请注意,v0是ETA的基本版本。编码方式列在Table 7的第二列中,其中:avg(·)和ta(·)分别表示通过均值池化和target attention对user behavior进行编码。ta(1024 -s- 48)表示对从1024长度的用户行为序列中选择的top-48 user behaviors进行target attention。ta(1024 -s- 48)中的符号s表示SimHash用于从1024个user behavior中选择top-48;类似地,ta(1024 -i- 48)中的符号i表示内积用于从1024个user behavior中选择top-48。

从

Table 7中,可以得出以下观察结果:(i):直接在原始1024长度的用户行为序列上进行multi-head target attention(v4)可以获得最佳性能,但同时具有最长的推理时间。与

v4相比,我们的base ETA(v0) 选择top-k behaviors进行attention,牺牲了大约0.1%的AUC,并将推理时间减少了46%。(ii):将v3与v0进行比较,在检索阶段用内积替换SimHash可使AUC提高0.07%。然而,推理时间增加了68%,这是我们严格的在线service level agreement: SLA所不可接受的。(iii):当我们改变用户行为序列的长度(v2.x与v0)时,观察到AUC和推理时间之间的权衡。可以根据在线推理时间的要求决定合适的序列长度。

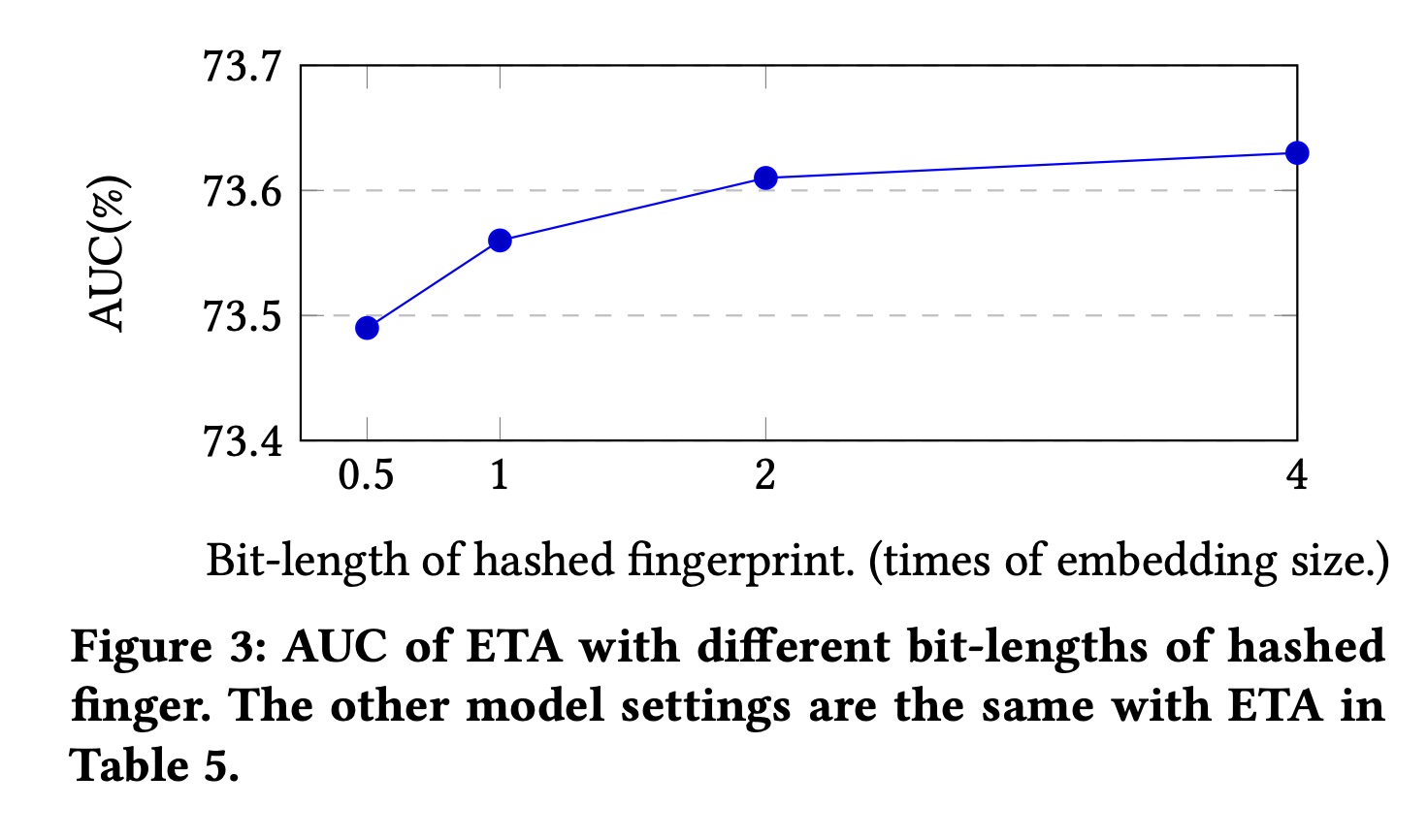

在

Figure 3中,我们还评估了SimHash所生成的哈希指纹bit-length下的性能。如前文所述,指纹的bit-length可以通过SimHash中使用的哈希函数数量来控制。我们可以发现:通过增加

bit-length可以提高AUC。但是,当

bit-length大于2倍embedding size时,AUC的改进变得微不足道。

五十三、SDIM [2022]

《Sampling Is All You Need on Modeling Long-Term User Behaviors for CTR Prediction》

丰富的

user behavior数据已被证明对CTR prediction应用程序具有重要价值,尤其是在工业推荐、搜索或广告系统中。然而,由于对online serving time的严格要求,真实世界的系统要充分利用长期用户行为并不容易。大多数先前的工作采用retrieval-based的策略,即首先检索少量用户行为以供后续使用。然而,retrieval-based的方法是次优的,会造成信息丢失,并且很难平衡检索算法的效果和效率(effectiveness and efficiency)。在本文中,我们提出了

Sampling-based Deep Interest Modeling: SDIM,一种简单而有效的sampling-based的端到端方法,用于建模长期用户行为。我们从多个哈希函数中采样以生成target item的hash signatures、以及用户行为序列中每个behavior item的hash signatures,并通过直接收集behavior items来获取用户兴趣,这些behavior items与target item具有相同的hash signatures。behavior item就是用户的历史行为序列中的feature item。我们从理论上和实验上表明,所提出的方法在建模长期用户行为方面与标准的

attention-based的模型性能相当,同时速度快得多。我们还介绍了SDIM在我们系统中的部署。具体来说,我们通过设计一个名为Behavior Sequence Encoding: BSE的独立模块,将最耗时的部分behavior(即,behavior sequence hashing)从CTR模型中分离出来。BSE对于CTR server来说是无延迟的,使我们能够建模极长的用户行为序列。离线和在线实验证明了SDIM的有效性。SDIM现在已经在线部署在美团APP的搜索系统中。CTR prediction是工业应用系统中的一项基本任务。用户兴趣建模(user interest modeling)旨在从历史行为数据中学习用户的隐含兴趣,已被广泛引入现实世界系统,并有助于显著改善ctr prediction。人们提出了各种模型来建模用户兴趣。其中,

DIN通过考虑给定的target item与历史行为的相关性来自适应地计算用户兴趣。DIN引入了一种新的注意力模块,称为target attention,其中target item充当queryuser behavior充当keyvalueDIN-based的方法近年来已成为建模用户兴趣的主流解决方案。然而,online serving time的严格要求限制了可以使用的用户行为序列的长度。因此,大多数工业系统截断了用户行为序列,只提供最近的50个行为用于用户兴趣建模,这导致了信息损失。随着互联网的快速发展,用户在电商平台上积累了越来越多的

behavior数据。以淘宝为例,他们报告23%的用户半年内在淘宝APP中的行为超过1000次。在美团APP中,有超过60%的用户一年内至少有1000次行为,有超过10%的用户一年内至少有5000次行为。对于工业系统来说,如何有效地利用更多的user behavior来更准确地估计用户兴趣变得越来越重要。最近,有人提出了一些方法来从长行为序列中建模用户的长期兴趣:

MIMN通过设计一个独立的User Interest Center: UIC模块,将user interest modeling从整个模型中分离出来。虽然UIC可以节省大量的online serving time,但它使得CTR模型无法从target item中挖掘信息,而这已被证明是用户兴趣建模的关键。因此,MIMN只能建模shallow user interests。SIM和UBR4CTR采用两阶段框架来处理长期用户行为。他们从序列中检索top-k相似的items,然后将这些items馈入后续的注意力模块。如《 End-to-End User Behavior Retrieval in Click-Through RatePrediction Model》所指出的,这些方法的retrieve objectives与CTR模型的目标不一致,并且离线倒排索引(offline inverted index)中的pre-trained embedding不适合online learning systems。为了提高检索算法的质量,

ETA(《 End-to-End User Behavior Retrieval in Click-Through RatePrediction Model》)提出了一种LSH-based的方法,以端到端的方式从user behavior中检索top-k相似的items。它们使用locality-sensitive hash: LSH将items转换成hash signatures(hash signatures),然后根据它们到target item的汉明距离检索top-k相似的items。LSH的使用大大降低了计算items之间相似度的代价,ETA取得了比SIM和UBR4CTR更好的结果。

SIM、UBR4CTR和ETA都是retrieval-based的方法。retrieval-based的方法具有以下缺点:从整个序列中检索

top-k相似的items是次优的,并且会产生对用户长期兴趣的有偏的估计。在用户具有丰富behavior的情况下,检索到的top-k items可能都与target item相似,并且estimated user interest representation将是不准确的。其核心在与:对于行为丰富的用户,应该取较大的

k从而捕获所有的informative行为;对于行为很少的用户,应该采用较小的k从而过滤掉噪音。但是实际应用中,k是全局统一的。此外,很难平衡检索算法的有效性和效率。以

SIM (hard)为例,他们使用简单的检索算法,因此其性能比其他方法差。相比之下,UBR4CTR在复杂的检索模块的帮助下实现了显著的改进,但其推理速度变得慢了4倍,这使得UBR4CTR无法在线部署,尤其是对于long-term user behaviors modeling。

在本文中,我们提出了一个简单的

hash sampling-based的方法来建模长期用户行为。首先,我们从多个哈希函数中采样,生成

target item的hash signatures、以及用户行为序列中每个item的hash signatures。然后,我们没有使用某种

metric来检索top-k相似的items,而是直接从整个序列中收集与target item共享相同hash signatures的behavior items来形成用户兴趣。

我们方法的内在思想是:用

LSH碰撞概率来近似用户兴趣的softmax distribution。我们从理论上表明,这种简单的sampling-based的方法产生了与softmax-based target attention非常相似的注意力模式,并实现了一致的模型性能,同时时间效率更高。因此,我们的方法类似于直接在原始的长序列上计算注意力,而没有信息损失。我们将提出的方法命名为Sampling-based Deep Interest Modeling: SDIM。传统的

softmax-based target attention:首先计算attention score,然后将历史行为序列根据attention score聚合起来。聚合的权重就是attention score distribution。这里的方法是:首先用

LSH去碰撞,然后将历史行为序列根据是否碰撞从而聚合起来。,权重是0/1,表示是否与target item的哈希值相同,即是否碰撞。因此这里的方法会考虑到与target item相似的所有item,并且不需要target attention计算。我们还介绍了在线部署

SDIM的实践。具体来说,我们将我们的框架分解成两个部分:Behavior Sequence Hashing(BSE) server、CTR server,其中这两个部分是分开部署的。行为序列哈希(behavior sequence hashing)是整个算法中最耗时的部分,该部分的解耦大大减少了serving time。更多细节将在后续章节介绍。我们在公共数据集和工业数据集上进行实验。实验结果表明:

SDIM获得了与标准的attention-based的方法一致的结果,并且在建模长期用户行为方面优于所有竞争baselines,并且具有相当大的加速。SDIM已经在中国最大的生活服务电商平台美团的搜索系统中部署,并带来了2.98%的CTR提升和2.69%的VBR提升,这对我们的业务非常重要。综上所述,本文的主要贡献总结如下:

我们提出了

SDIM,这是一个hash sampling-based的框架,用于为CTR prediction建模长期用户行为。我们证明了这种简单的sampling-based的策略产生了与target attention非常相似的注意力模式。我们详细介绍了我们在线部署

SDIM的实践。我们相信这项工作将有助于推进community,特别是在建模长期用户行为方面。在公共数据集和行业数据集上进行了大量实验,结果证明了

SDIM在效率和效果方面的优越性。SDIM已经部署在美团的搜索系统中,为业务做出了重大贡献。

本质上是通过

LSH实现了target attention。

53.1 基础知识

53.1.1 Task Formulation

CTR prediction是工业界的推荐、搜索和广告系统中的核心任务。CTR任务的目标是估计用户点击item的概率,定义如下:其中:

CTR模型中的可训练参数;label。给定输入特征

CTR模型:

53.1.2 Target Attention

target attention的概念最早由DIN提出,并广泛应用于CTR任务中的用户兴趣建模。target attention将target item作为query,将用户行为序列中的每个item作为key和value,并使用attention算子从用户行为序列中soft-search相关的部分。然后通过对用户行为序列进行加权和来获得用户兴趣。具体而言,将

target item指定为representations指定为request,CTR模型要评分的target items数量。hidden size。

令

target item的representation。target attention计算item的点积相似度,然后以归一化相似度作为权重,得到用户兴趣的representation:矩阵形式可以写成:

其中:

计算

target attention是不可行的。

53.1.3 Locality-Sensitive Hash (LSH) and SimHash

局部敏感哈希(

Locality-sensitive hash: LSH)是一种在高维空间中高效查找最近邻居的算法技术。LSH满足局部保持性(locality-preserving property):邻近的向量很可能获得相同的哈希值,而远处的向量则不会。得益于此特性,LSH-based的signature已广泛应用于互联网搜索系统等许多应用中。随机投影方案 (SimHash)是LSH的一种有效实现。SimHash的基本思想是:采样一个随机投影(由单位法向量+1或-1)。具体而言,给定一个输入其中:

hashed output位于哪一侧。对于两个向量

hash code的取值时,我们才说它们发生冲突:虽然单个哈希值可以用于估计相似度,但是我们可以使用多个哈希值,从而降低估计误差。在实践中,通常采用

SimHash(即,多轮哈希)算法,其中在第一步中,

SimHash随机采样其中:

这些哈希码被分为

为了降低不相似的

items具有相同哈希码的概率,该算法将每组hash signatures。有关更多详细信息,请参阅《Mining of Massive Datasets》。对于第

hash signatures相同时,其中:

“AND”运算符,最后,每个

hash signature对应的分组可以被看作是一次LSH,从而用于期望的计算,从而降低estimation的方差。注意:读者对这一段文字进行了重新润色。原始论文讲的不太清楚。

Figure 1底部显示了(4, 2)参数化的SimHash算法的示例,其中我们使用4个哈希函数并将每2个哈希码聚合为hash signatures(黄色和绿色)。

53.2 方法

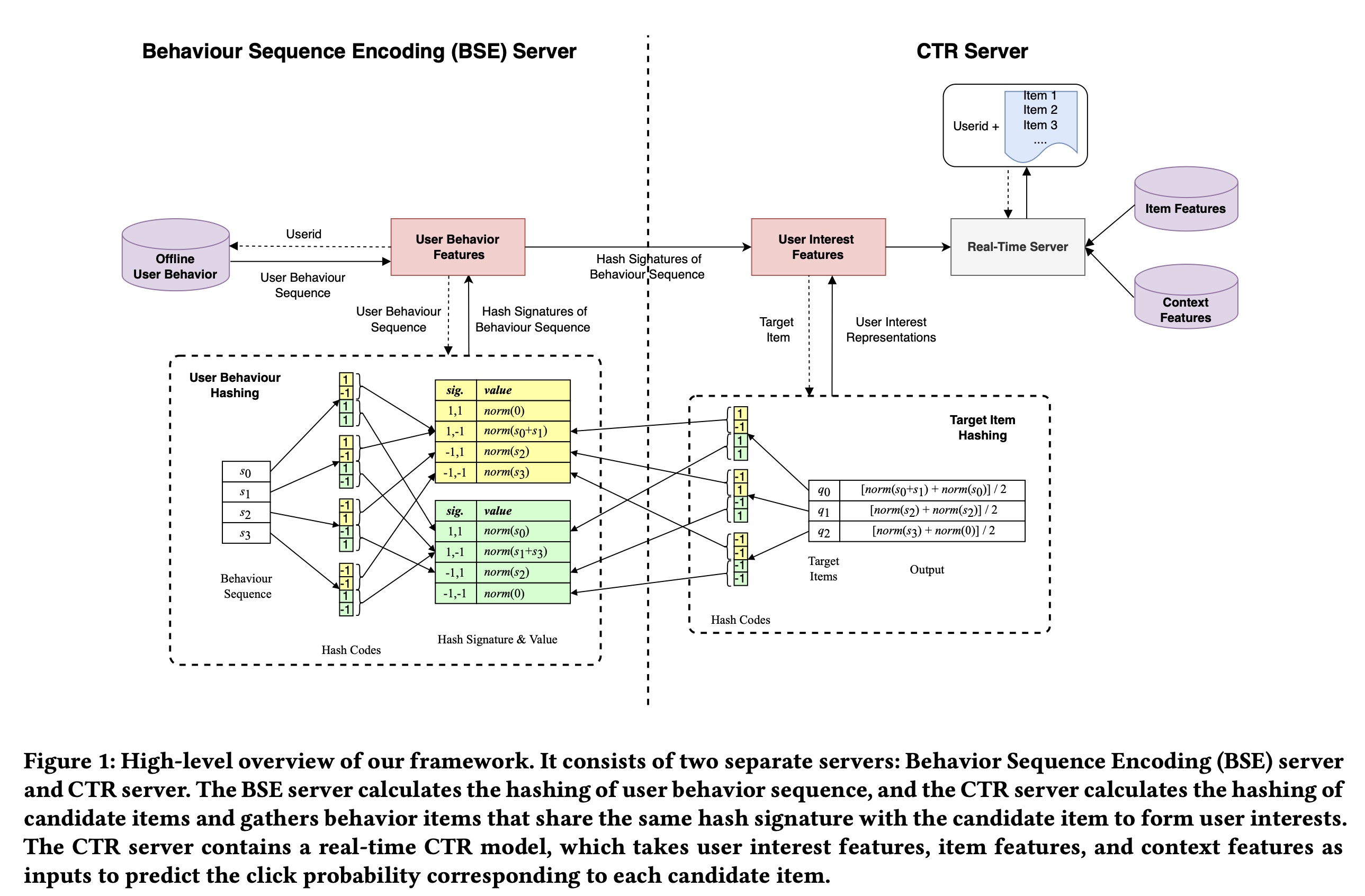

在本节中,我们介绍了我们的框架从而在系统中实现

SDIM。Figure 1中可以看到high-level的概述。该框架由两个独立的servers组成:Behavior Sequence Encoding (BSE) server和CTR server,稍后将详细介绍。

53.2.1 User Behavior Modeling via Hash-Based Sampling

Hash Sampling-Based Attention:第一步,我们采样多个哈希函数并生成user behavior items和target items的哈希码。与ETA类似,我们使用从正态分布中采样的固定的random hash vectors作为“哈希函数”。经过哈希处理后,ETA计算items之间的汉明距离(Hamming distance)作为用户兴趣分布(user interest distribution)的近似值,从而用于选择top-k相似的items。这里我们提出了一种更高效、更有效的方法来近似用户兴趣。 由于具有局部保留的属性(locality-preserving property),相似的向量落入同一个哈希桶的概率很高,因此user behavior items和target item之间的相似性可以通过它们具有相同哈希码(signature)的频率或碰撞概率来近似。这导致我们假设哈希碰撞的概率可以成为用户兴趣的有效估计器。 基于这一观察,我们提出了一种使用LSH来获取用户兴趣的新方法。经过哈希处理后,我们通过将具有相同的behavior itemsbehavior items都关联了同一个target item其中:

item。target itemhash signatures,则target iteml2正则化,用于对兴趣分布进行正则化。我们还尝试使用

l2正则化模型的性能相当。但是,l2正则化的实现效率更高,因此我们使用l2正则化。

Multi-Round Hashing:总是有一个小概率使得不相似的behavior items与target item共享相同哈希码,从而给模型带来噪音。为了降低这种可能性,我们使用前面描述的多轮哈希算法。 具体来说,我们使用SimHash算法。我们并行采样并执行hash signatures。只有当hash signature时,我们才认为它们发生碰撞:其中:

hash signatures的输出被平均,从而作为对用户兴趣的低方差的估计。它可以表示为:

53.2.2 Analysis of Attention Patterns

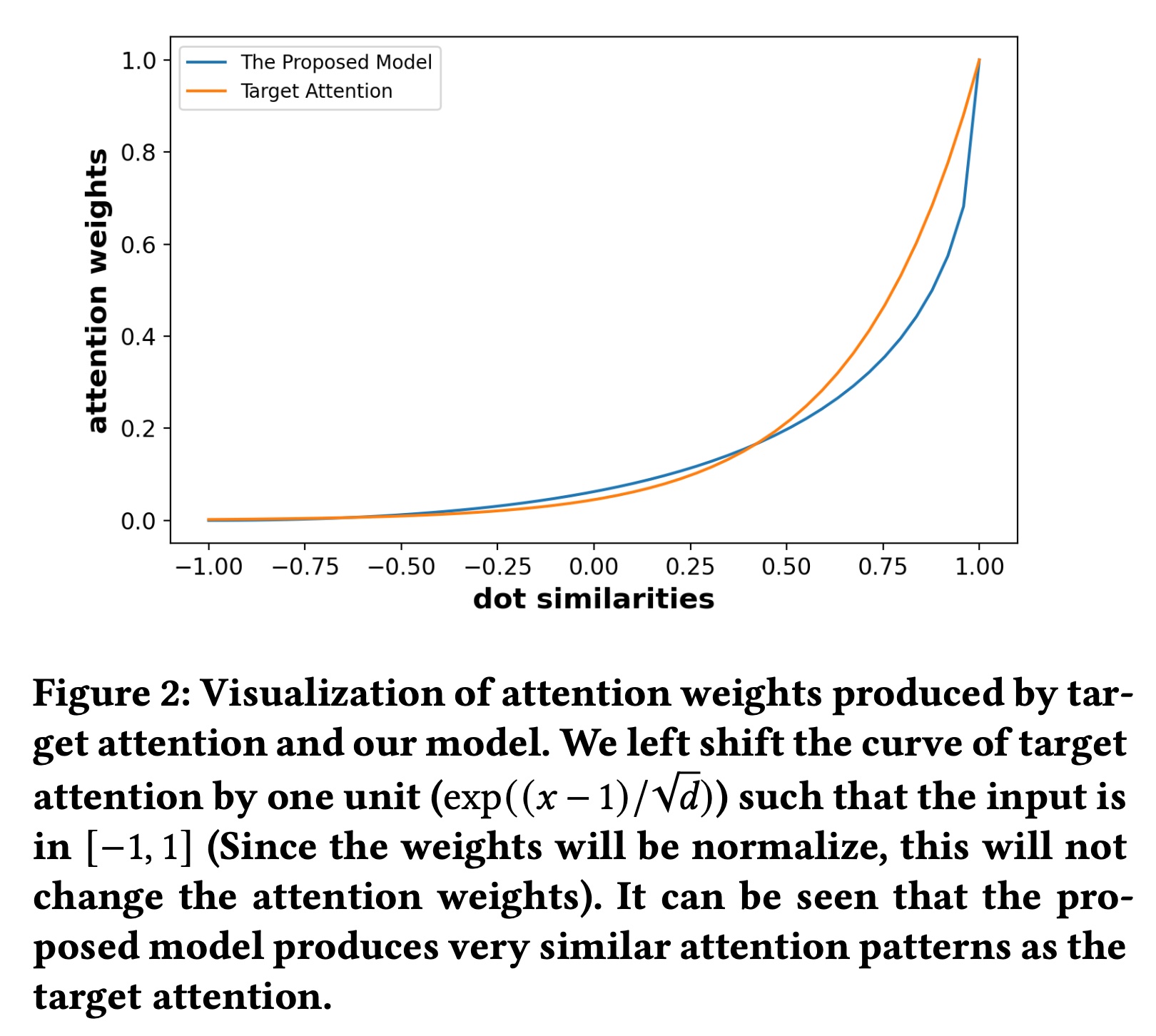

Hash Sampling-Based Attention的期望:在我们的方法中,随着《Similarity estimation techniques from rounding algorithms》):注意:在计算用户兴趣之前,我们对

因此,

SDIM产生的user interest representation的期望为:注意:原始论文的公式有问题,漏掉了

sum归一化而不是l2正则化。随着分组数量

estimation error会非常小。在实践中,我们对在线模型使用Figure2中绘制了SDIM产生的注意力权重target attention产生的注意力权重Figure2中我们可以看出,SDIM的注意力权重与target attention中的softmax函数很好地吻合,因此,从理论上讲,我们的方法可以获得非常接近target attention的输出。我们将提出的方法命名为SDIM,即Sampling-based Deep Interest Modeling。

SDIM中的宽度参数items提供更多注意力方面所起的作用。 记target itemitem随着

items。 让我们考虑两种极端情况:当

target item完全相同的items。如果我们使用category属性进行哈希处理,则算法的behavior类似于SIM(hard)。因此,我们的算法可以看作是SIM(hard)的扩展,它也会考虑category ID不同但非常相似的behavior items。当

target item和用user behavior items将始终具有相同的hash signatures。

因此,

SDIM非常灵活,可以通过分配不同的

53.2.3 Implementation and Complexity Analysis

在本小节中,我们将详细说明

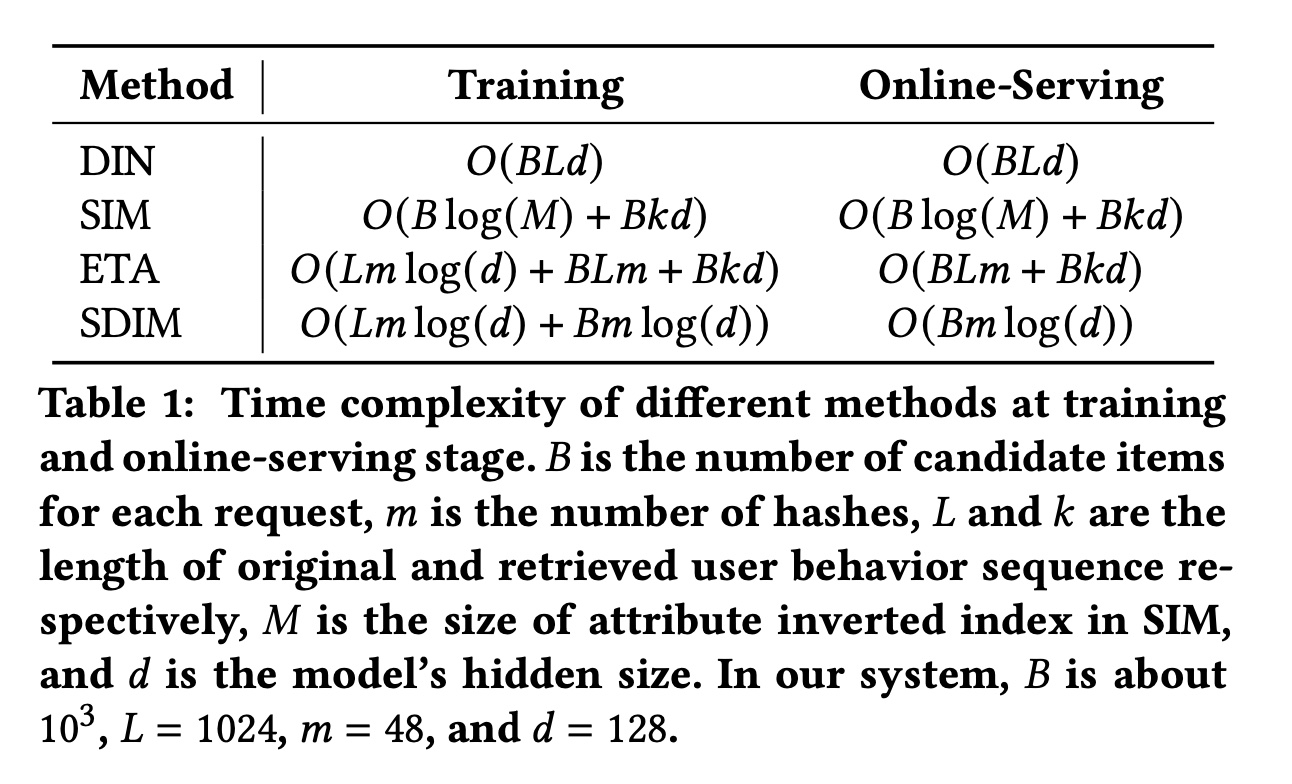

SDIM比标准的attention-based的方法快很多倍。让我们回顾一下

target attention中计算用户兴趣的公式,即,target vector与行为序列相乘来获得注意力权重,然后使用注意力权重对行为序列进行加权和。因此,在target attention中获取用户兴趣的representation需要两次矩阵乘法,该算法的时间复杂度为SDIM将用户兴趣的计算分解为两部分:behavior sequence hashing、target vector hashing。注意,用户行为序列是用户的固有特征,与target item无关,这意味着无论target item是什么,用户的behavior sequence hashing的结果都是固定的。因此,对于每个用户,我们只需要在每个request中计算一次用户行为序列的hash transform。因此,SDIM将时间复杂度从1,比标准的target attention快了相当多倍。经过哈希之后,与

target item共享相同hash signature的sequence items被选中,并被相加从而形成用户兴趣。在Tensorflow中,此步骤可以通过tf.batch_gather算子实现,该算子是Tensorflow的原子算子(atomic operator),时间成本可以忽略不计。SDIM最耗时的部分是行为序列的多轮哈希(multi-round hashing),即将Approximating Random Projection)算法降低到SDIM比标准的attention-based方法快得多。在我们的场景中,SDIM在训练user behavior modeling部分时实现了10到20倍的速度提升。

53.2.4 Deployment of the Whole System

本节将介绍如何成功在线部署

SDIM。如前所述,整个算法分为两部分:behavior sequence hashing、target vector hashing。behavior sequence hashing与target item无关,这促使我们构建一个专门的server来维护user-wise behavioral sequence hashes。我们将系统分为两部分:

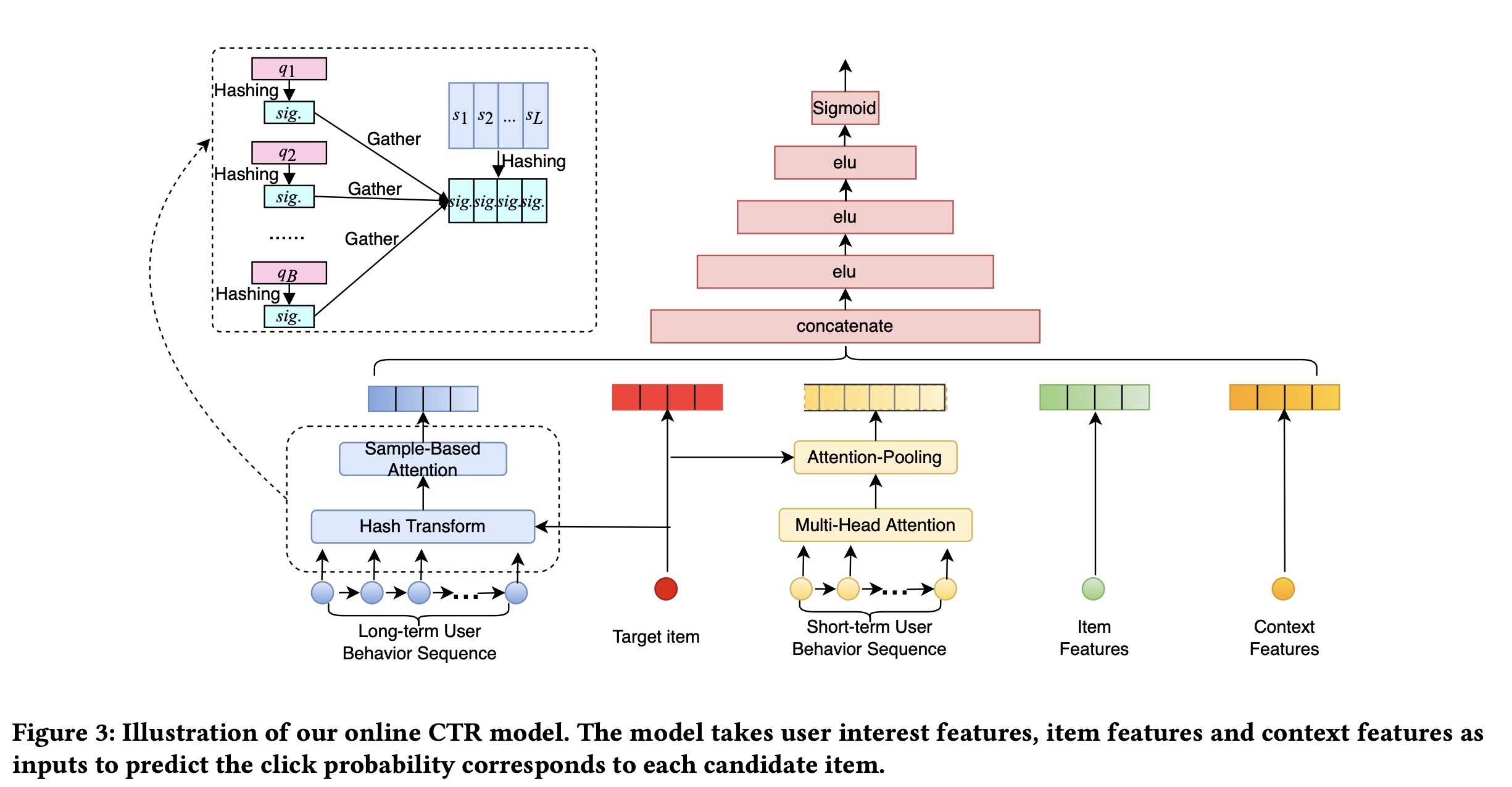

Behavior Sequence Encoding (BSE) server和CTR Server,如Figure 1所示。BSE Server负责维护user-wise behavior sequence hashes。当收到user behavior的list时,BSE server从多个哈希函数中采样,并为行为序列中的每个item生成hash signatures。然后根据item signatures将它们分配到不同的buckets中,每个buckets对应一个hash signature,如Figure 1所示。hash buckets被传递给CTR Server,从而建模target item-aware的用户兴趣。CTR Server负责预测target items的点击率。当收到target items(batch size = B)时,CTR Server会将每个target item进行哈希得到signatures,并从相应的buckets中收集item representations。用户兴趣特征与其他特征拼接起来,然后被馈入到复杂的CTR模型中,以获得每个target item的预测概率。我们的CTR模型的整体结构如Figure 3所示。该模型以target item特征、上下文特征、短期用户兴趣特征、以及长期用户兴趣特征作为输入,并使用multilayer perceptron来预测target items的点概率。根据论文实验章节的描述,长期用户行为序列包含了短期用户行为序列,二者不是正交的。

请注意,

SDIM不需要改变CTR模型的结构,它可以自然地插入现有的主流CTR架构中。所提出的框架在训练阶段是端到端的:user interest modeling与CTR模型的其余部分联合训练,我们只在online serving阶段单独部署它们。 将BSE Server和CTR Server解耦后,BSE的计算对于CTR Server来说是无延迟的。在实际应用中,我们将BSE Server放在CTR Server之前,并与retrieval模块并行计算。分开部署后,计算用户长期兴趣的时间成本只在于

target items的哈希,其时间复杂度为behavior的用户兴趣建模。从CTR Server的角度来看,这个时间复杂度就像增加了一个common feature一样。在Table 1中,我们比较了不同方法的时间复杂度。

我们的

serving系统与MIMN有些相似。最大的区别在于我们的系统可以建模用户的deep interests,而MIMN只能建模shallow interests。关于

Servers传输成本的注释:对于每个request,我们都需要将bucket representations从BSE Server传输到CTR Server。请注意,我们使用固定数量的哈希函数,因此无论用户的behavior有多长,我们只需要将bucket representations的固定长度的向量传输到CTR Server。在我们的在线系统中,此向量的大小为8KB,传输成本约为1ms。

53.3 实验

为了验证

SDIM的有效性,我们在公共数据集和真实工业数据集上进行了实验。对于公共数据集,我们遵循以前的工作选择Taobao数据集。对于工业数据集,我们使用从美团搜索系统收集的真实数据进行实验。Taobao数据集:淘宝数据集由《Learning Tree-based Deep Model for Recommender Systems》发布,在先前的工作(《Search-based User Interest Modeling with Lifelong Sequential Behavior Data for Click-Through Rate Prediction》、《User Behavior Retrieval for Click-Through Rate Prediction》)中被广泛用于离线实验。此数据集中的每个实例由五个field的特征组成:user ID, item ID, category ID, behavior type, and timestamp。遵循《User Behavior Retrieval for Click-Through Rate Prediction》,我们根据时间戳额外引入了“is_weekend”特征以丰富上下文特征。我们以与

MIMN和ETA相同的方式对数据进行预处理。具体来说,我们使用首次的behavior作为输入来预测第behavior。我们根据timestep将样本分为训练集(80%)、验证集(10%)和测试集(10%)。选择最近的16个behavior作为短期序列,选择最近的256个behavior作为长期序列。工业数据集:该数据集来自中国最大的生活服务电商平台美团

APP的平台搜索系统。我们选取连续14天的样本进行训练,选取接下来两天的样本进行评估和测试,训练样本数量约为10 Billion。选取最近的50个behavior作为短期序列,选取最近的1024个behavior作为长期序列。如果user behavior数量未达到此长度,则使用默认值将序列填充到最大长度。除了user behavior特征外,我们还引入了约20个重要的id特征来丰富输入。

评估指标:对于离线实验,我们遵循以前的工作,采用广泛使用的

AUC进行评估。我们还使用训练和推理速度 (Training & Inference Speed: T&I Speed) 作为补充指标来显示每个模型的效率。对于在线实验,我们使用点击率(Click-Through Rate: CTR) 和访问购买率(Visited-Buy Rate: VBR)作为在线指标。baseline方法:我们将SDIM与以下建模长期用户行为的主流工业模型进行比较:DIN:DIN是工业系统中建模用户兴趣的最流行模型之一。然而,由于DIN的时间复杂度高,它不适合用于建模长期用户行为。在这个baseline中,我们只使用短期用户行为特征,而不使用长期用户行为特征。DIN (Long Seq.):对于离线实验,为了测量长期用户行为序列的信息增益,我们为DIN配备了长行为序列。我们为Taobao数据集设置DIN (Avg-Pooling Long Seq.):该baseline由《End-to-End User Behavior Retrieval in Click-Through Rate Prediction Model》和《Search-based User Interest Modeling with Lifelong Sequential Behavior Data for Click-Through Rate Prediction》引入,其中DIN用于建模短期用户兴趣,而长期用户兴趣则通过对长期behavior进行均值池化操作获得。我们将此baseline表示为DIN(Avg-Pooling)。SIM(《Search-based User Interest Modeling with Lifelong Sequential Behavior Data for Click-Through Rate Prediction》):SIM首先通过category ID从整个序列中检索top-k相似的items,然后将target attention应用于top-k items从而获取用户兴趣。我们遵从以前的工作来比较SIM(hard),因为性能几乎与他们在线部署SIM(hard)相同。UBR4CTR(《User Behavior Retrieval for Click-Through Rate Prediction》):UBR4CTR是一种两阶段方法。在第一阶段,他们设计了一个

feature selection模块来选择特征来形成query,并以倒排索引的方式存储user behavior。在第二阶段,将检索到的

behavior馈入到target attention-based的模块以获取用户兴趣。

ETA(《End-to-End User Behavior Retrieval in Click-Through Rate Prediction Model》):ETA应用LSH将target item和用户行为序列编码为binary codes,然后计算item-wise hamming distance以选择top-k个相似的items用于后续的target attention。MIMN(《Practice on Long Sequential User Behavior Modeling for Click-Through Rate Prediction》) :与SIM是由同一个团队提出的。由于作者声称SIM击败了MIMN并且他们在线部署了SIM,因此我们仅与SIM进行比较,并省略了MIMN的baseline。

对于所有

baseline和SDIM,我们使用相同的特征(包括timeinfo特征)作为输入,并采用相同的模型结构,long-term user behavior modeling除外。所有模型都使用相同长度的长期用户行为:Taobao的

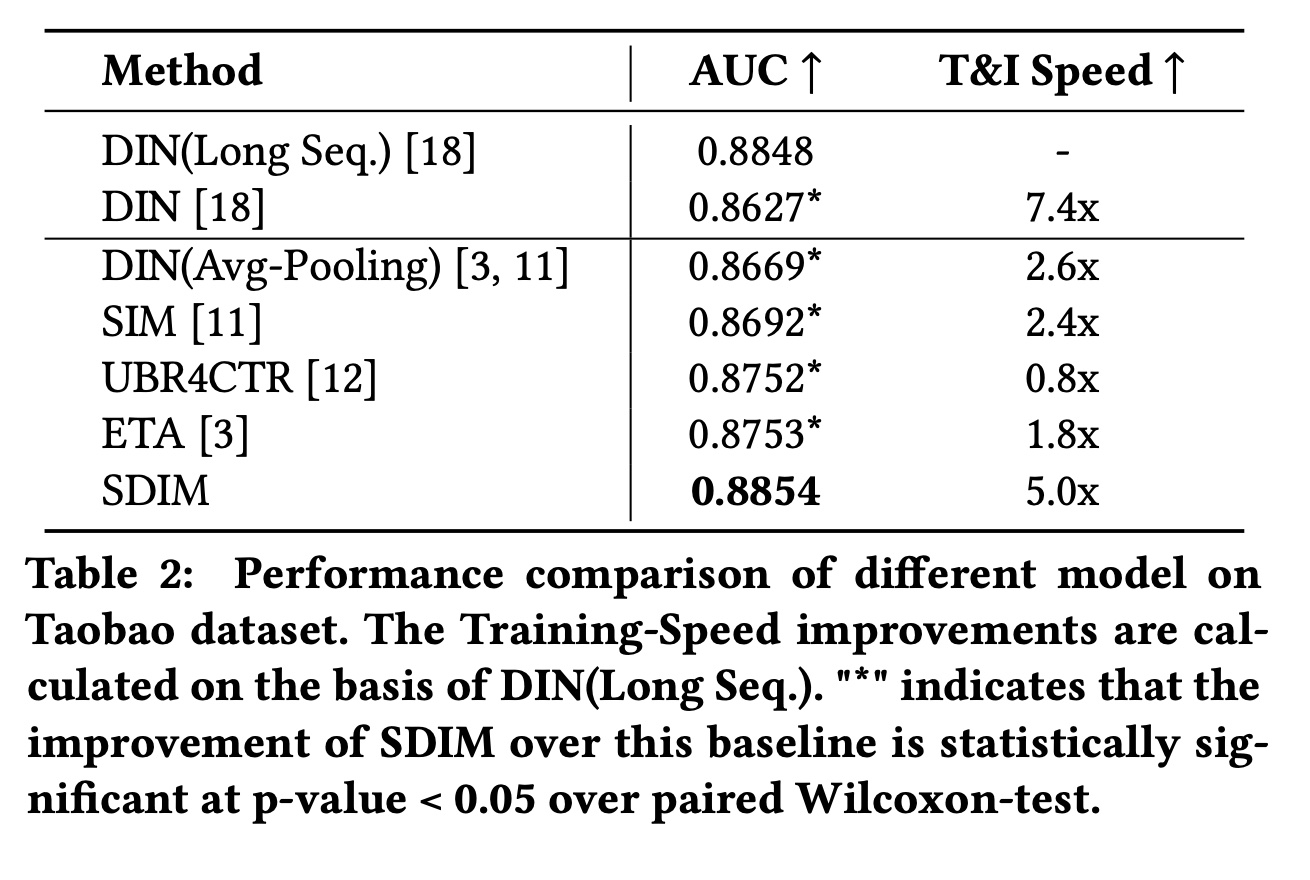

53.3.1 Taobao 数据集的结果

Table 2显示了不同模型在Taobao数据集上的总体结果。我们可以得出以下结论:(1):SDIM在建模长期用户行为方面的表现与DIN(Long Seq.)相当,但速度却是DIN(Long Seq.)的5倍。如上所述,SDIM可以模拟与target attention非常相似的注意力模式,因此SDIM可以匹敌甚至超越DIN(Long Seq.)的性能。(2):SDIM的表现优于所有用于建模长期用户行为的baseline模型。具体而言,SDIM比SIM高1.62%、比UBR4CTR高1.02%、比ETA高1.01%。我们还注意到,与

DIN相比,DIN(Long Seq.)的AUC提高了2.21%,这表明建模长期用户行为对于CTR prediction的重要性。SIM、UBR4CTR和ETA的性能不如DIN(Long Seq.),这是由于retrieval of user behaviors造成的信息丢失。这些retrieval操作可能有助于从序列中去除噪音,但当top-k retrieval没有足够的informative behavior时则是有害的。(3):SDIM比DIN(Long Seq.)、SIM和UBR4CTR的效率高得多。效率的提高可以归因于将算法的时间复杂度降低到SDIM也比ETA效率高得多。ETA也使用LSH对target item和行为序列进行哈希,哈希操作的时间复杂度与SDIM相同。哈希之后,ETA计算汉明距离并选择top-k items从而用于target attention,时间复杂度为SDIM仅引入了一个gather算子,然后是ETA效率高得多。

对于

T&I Speed指标,对比的基线为DIN(Long Seq.),它的速度为1.0。

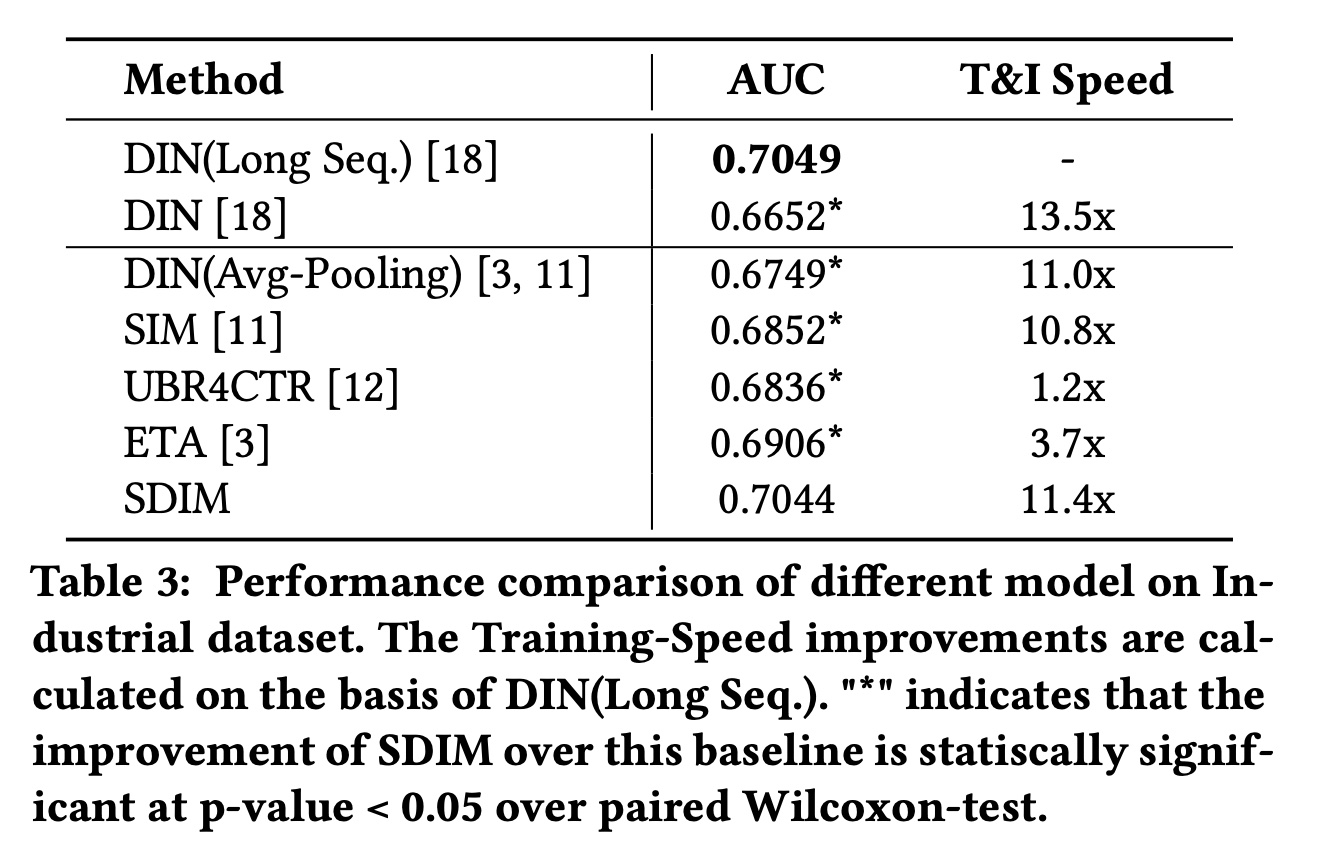

53.3.2 工业数据集的结果

Table 3显示了不同模型在工业数据集上的总体结果。与

Taobao数据集的结果类似,在工业数据集上,SDIM优于所有竞争基线,并且与DIN(Long Seq.)表现相当。我们的SDIM与SIM、UBR4CTR和ETA相比,分别实现了1.92%、2.08%、1.38%的改进,同时比这些方法快得多。由于工业数据集中的用户序列长度足够大,这对

retrieve-based的方法很友好,因此它们似乎应该与DIN(Long Seq.)表现相当。然而,Table 3中的结果表明它们的性能与DIN(Long Seq.)存在一些差距。我们认为这是因为用户的兴趣通常是多样化的,人们经常想购买新categories的item,尤其是在我们的food search案例中。当面对新category中的target item时,这些检索算法很难从用户的历史行为中准确地挑选出最有价值的item。与

Taobao数据集相比,工业数据集每次request包含的target items更多,因此SDIM在该数据集上可以获得更大的加速比。工业数据集的用户行为序列也更长(retrieve-based的方法也可以获得更大的加速比。

实验结果证明了

SDIM的优越性。

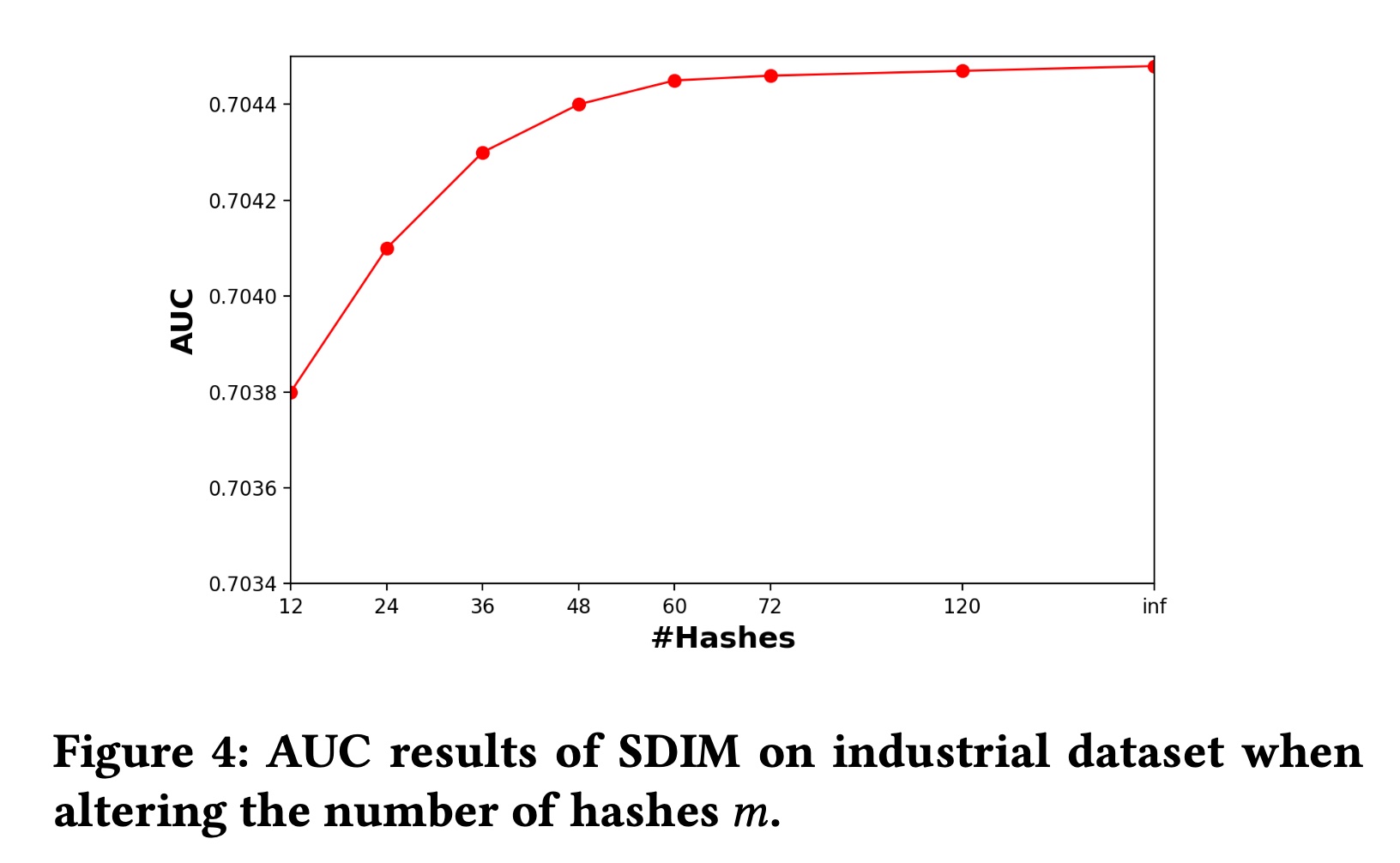

53.3.3 超参数分析

SDIM中有两个重要的超参数:哈希函数的数量hash signatures的宽度对

hashing-based attention的估计误差。随着sampled hash function数量的增加,estimated user interest将更接近公式为了评估

estimation error,我们评估SDIM的性能。我们还实现了SDIM的变体,它直接使用公式中的期望碰撞概率hash signatures数量趋于无限时SDIM的behavior。结果如Figure 4所示。可以看出,当

inference速度。但是这里没有不同trade-off。

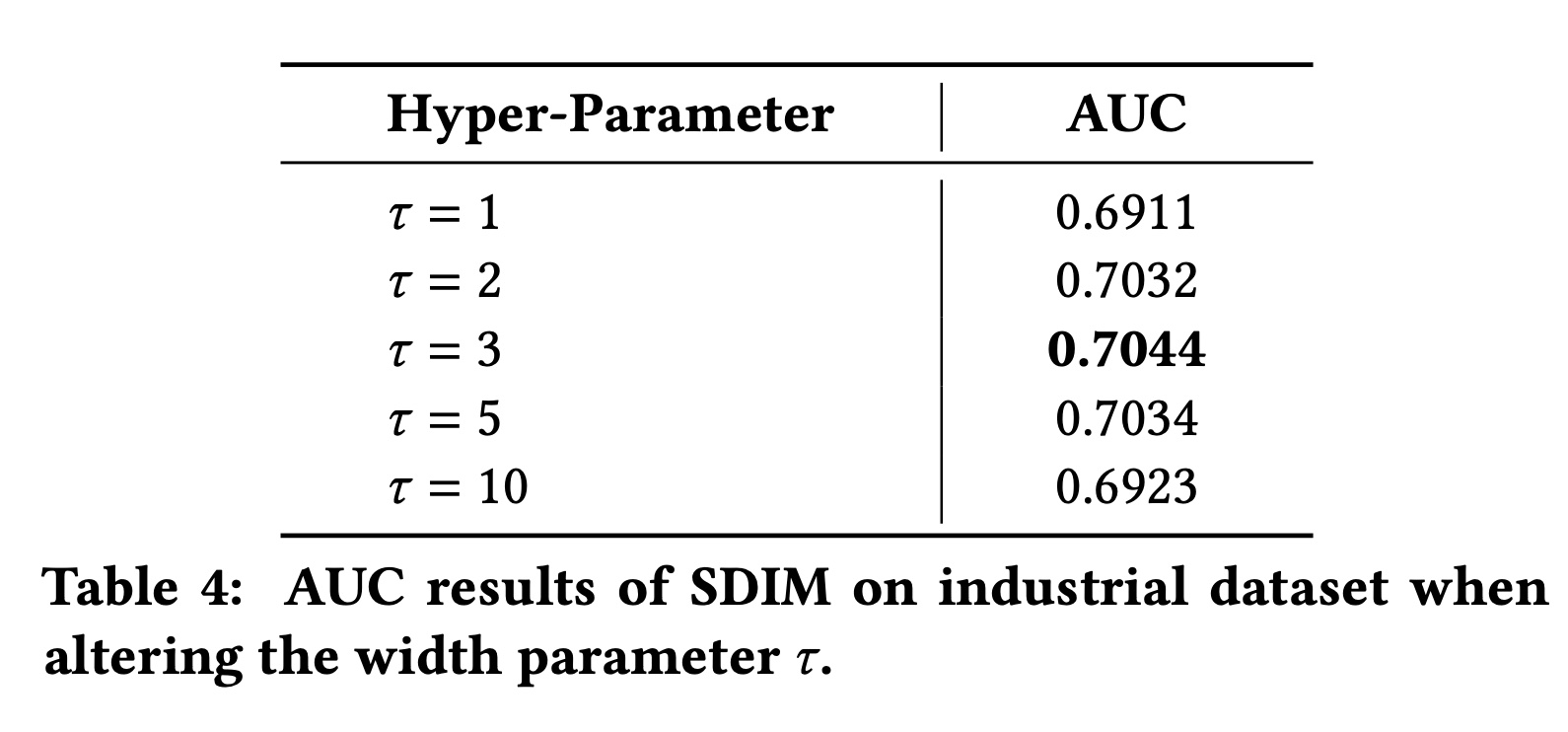

对

items更加关注。我们通过改变SDIM的不同注意力模式。结果如Table 4所示。从

Table 4中我们可以看出:当

SDIM表现良好。为了平衡有效性和效率,我们在在线模型中使用Table 1的算法复杂度分析结果)。当

behavior。相反,当

items才有机会用于用户兴趣,这对行为较少的用户不友好。

53.3.4 短期用户兴趣建模

我们还进行了额外的实验来测试

SDIM在建模短期user behavior方面的表现。但请注意,SDIM主要是为了解决工业推荐系统的长期用户兴趣建模的问题而提出的,人们可以直接插入full target attention或更复杂的模块来建模短序列。我们进行这个实验只是为了展示模型在特殊情况下的表现。我们在

Taobao数据集上进行了这个实验,结果如Table 5所示。结果表明,SDIM在建模短序列方面仍然可以达到与标准的target attention模型相当的结果,同时效率更高。是否可以把所有的

target attention(长期的、短期的)都换成SDIM?进一步地,是否可以把用户行为序列分成不同的区间,在每个区间都应用SDIM?

53.3.5 Online A/B Test

为验证

SDIM的有效性,我们还进行了严格的online A/B testing。对于online A/B testing,baseline模型是美团搜索系统中之前的在线CTR模型,该模型仅使用短期用户行为序列。测试模型采用与base模型相同的结构和特征,但在此基础上加入了long-term user interests modeling模块,该模块包含用户最近1024或2000次behavior。我们使用所提出的SDIM来建模长期用户兴趣,并将该测试模型表示为SDIM (T = 1024)和SDIM (T = 2000)。测试持续14天,每个模型分别分配10%的美团搜索流量。A/B testing结果如Table 6所示。SDIM (T=2000)与base模型相比,CTR提升2.98%(p-value < 0.001),VBR提升2.69%(p-value < 0.005),考虑到美团APP的流量巨大,这可以大大提高线上利润。SDIM (T=2000)的推理时间与Base(w/o long seq.)相比增加了1ms。推理时间的增加主要是由于BSE Server和CTR Server之间的传输时间。

我们还尝试部署模型,该模型直接使用

target attention来建模T = 1024的长期用户行为序列。然而,它的推理时间大大增加了约50%(25ms-30ms),这对于我们的系统来说是不可接受的。因此我们不能让这个模型在线上进行14天的A/B testing。SDIM的性能与这个模型相当,但节省了95%的在线推理时间。SDIM目前已在线部署并服务于美团首页搜索系统的主要流量。

五十四、UBR [2023] (UBR4CTR V2)

《Learning to Retrieve User Behaviors for Click-through Rate Estimation》

CTR estimation在现代在线个性化服务中起着至关重要的作用。通过建模用户行为序列来捕获用户兴趣的变化,对构建准确的CTR estimation模型至关重要。然而,随着用户在在线平台上积累了大量的behavior数据,当前的CTR模型必须截断用户行为序列并利用最近的behavior,这导致一个问题,即诸如周期性(periodicity)或长期依赖性(long-term dependency)之类的序列模式(sequential patterns)不被包含在最近的behavior中,而是包含在遥远的历史中。然而,直接使用整个用户序列并对其进行建模并非易事,原因有二:首先,非常长的输入序列会使在线

inference time和系统负载变得不可行。其次,非常长的序列包含很多噪音,因此

CTR模型很难有效地捕获有用的模式。

为了解决这个问题,我们从

input data的角度来考虑它,而不是设计更精巧但更复杂的模型。由于整个用户行为序列包含很多噪音,因此没有必要输入整个序列。相反,我们可以只检索其中的一小部分作为CTR模型的输入。在本文中,我们提出了用户行为检索(User Behavior Retrieval: UBR)框架,旨在根据每个CTR estimation request来学习从而检索最informative的user behavior。只检索一小部分behavior可以缓解utilizing very long sequences的两个问题(即推理效率和噪声输入)。UBR的显著特性在于它支持任意且可学习的检索函数,而不是使用固定的且预定义的函数,这与当前retrieval-based的方法不同。在三个大型真实数据集上的离线评估证明了

UBR框架的优越性和有效性。我们进一步在Huawei App Store部署了UBR,在线A/B test中实现了6.6%的eCPM增益,现在服务于Huawei App Store广告场景的主要流量。CTR estimation在当今的在线个性化平台(例如电商、在线广告、推荐系统)中起着关键作用,其目标是预测用户在特定上下文中点击特定item的概率。近年来,基于用户行为序列的CTR estimation模型引起了工业界和学术界越来越多的关注。这些基于user behavior的CTR模型旨在捕获包含在user behavior中的丰富的时间模式(temporal patterns),并学习用户兴趣的变化,从而获得准确的CTR estimations。这些序列模式包括概念漂移(concept drifting)、长期行为依赖性(long-term behavior dependency)、周期性模式(periodic patterns)等等。Deep Interest Network: DIN和Deep Interest Evolution Network: DIEN是在CTR prediction中,通过建模用户行为序列从而捕获用户兴趣的代表性模型。DIN结合了注意力机制来学习不同user behaviors的重要性,而DIEN利用GRU来捕获user behavior的dynamics。其他user behavior-based的CTR estimation模型(《Behavior sequence transformer for e-commerce recommendation in alibaba》、《Deep session interest network for click-through rate prediction》)具有相似的动机和结构。至于

CTR estimation的类似文献,在序列推荐(sequential recommendation)领域,有很多关于如何对用户行为序列进行建模的研究工作。有RNN-based的模型,如GRU4Rec、GRU4Rec+;有CNN-based的模型,如Caser;有Transformer-based的模型,如SASRec、TiSASRec;还有memory network-based的模型。随着在线个性化平台十多年的发展,平台上记录的

user behavior数量迅速增长。在淘宝上,仅在六个月内,就有23%的用户积累了超过1,000次behavior(《Lifelong sequential modeling with personalized memorization for user response prediction》)。尽管上述基于user behavior的CTR模型取得了巨大成功,但它们无法处理非常长的用户序列。如Figure 1上半部分所示,仅使用最近的行为进行CTR estimation(通常为50或100)。但是,如果仅使用最近的行为,序列中可能不包含长期依赖性或周期性等序列模式(sequential patterns)。一种直接的解决方案是将整个用户序列馈入到CTR模型中,但这不可行。它会给系统开销带来沉重的负担并牺牲推理效率。更糟糕的是,在非常长的行为序列中,这种做法会带来很多噪音。为了解决上述问题,一种解决方案是设计具有更多参数和更大容量的复杂模型,以支持更长的用户行为序列作为输入,如

Figure 1上半部分所示。HPMN和MIMN是两种用于处理长序列建模的memory network架构。然而,这些模型非常复杂,需要大量的工程工作才能在现实世界的在线系统中实现和部署。尽管HPMN或MIMN可以处理包含大约1,000个behavior的序列,但全量的用户序列通常要长得多。

与上述解决方案不同,我们尝试从数据角度解决问题,而不是设计更精巧但更复杂的模型。由于非常长的序列包含很多噪音,因此没有必要输入整个序列。相反,只有一小部分

behavior与prediction相关。因此,我们只需要检索相关的behavior。检索到的behavior取决于每个CTR estimation request。我们将每个request称为prediction target。如Figure 1所示,prediction target由三部分组成,即target user features(职业、地理位置等)、target item features(category、品牌等)、以及相应的上下文特征(场景等)。然后,这些特征将被视为query,并被用于从整个用户序列中检索behaviors。检索系统的目标是学习检索最相关的behavior data,从而辅助特定的request的prediction(即prediction target)。这样的检索过程利用索引结构,以整个用户历史行为作为检索池(retrieval pool),效率很高。为此,通过检索user behavior,长的用户序列可以有效地纳入CTR模型,而不会引入太多噪音。在本文中,我们提出了用于

CTR estimation的User Behavior Retrieval: UBR框架,从而对非常长的用户行为序列进行建模。由于现实世界在线个性化平台中的检索池通常很大,我们将检索过程分为两个子过程:matching和ranking,类似于信息检索系统。对于

matching过程,通过访问存储behaviors的索引可以快速检索一组候选behavior。此过程本质上是获取具有与prediction target所匹配特征的behaviors。获得

candidate behaviors后,ranking函数根据candidate behaviors与prediction target的相关性对其进行排序,并返回top-k个behavior。

然后,被检索到的

behaviors可以被任意CTR模型使用。本文的重点是整合可学习的参数化的检索函数,并提出相应的训练方法。在现有的